2 Rechner (Ubuntu und freeBSD (freeNAS)) mit zusätzlichen Netzwerkkarten im bestehenden LAN direkt verbinden - Routing?

Hallo!

Ich habe ein bestehendes LAN im Bereich 10.0.10.X mit einer pfSense (10.0.10.1), einem Gbit-Switch und einigen Rechnern (freeNAS, vdr, Desktop).

vdr hat die 10.0.10.6

freeNAS hat die 10.0.10.7

Ich habe nun sowohl vdr als auch freeNAS mit einer zusätzlichen 10Gbit-Karte ausgestattet und jeweils feste IP's ohne Gateway mit Netzmaske 255.255.255.0 konfiguriert.

vdr hat zusätzlich die 10.0.20.6

freeNAS hat zusätzlich die 10.0.20.7

Beide Rechner sollen weiterhin aus dem normalen LAN für andere Geräte über die alten Netzwerkkarten im Bereich 10.0.10.X erreichbar bleiben.

Die Kommunikation zwischen den beiden Systemen soll aber ausschließlich über das Netz 10.0.20.X laufen.

Im Moment bekommen alle Netzwerkkarten die gewünschten IP's und auch ein ping klappt im Bereich 10.0.20.X in beide Richtungen.

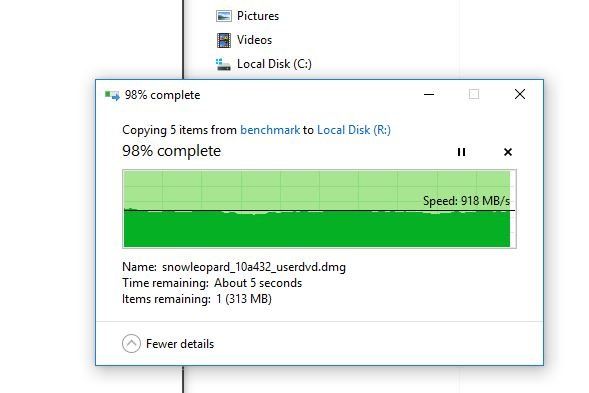

Wenn ich nun aber eine nfs-Freigabe vom freeNAS (nur 10.0.20.6 erlaubt für Zugriff) am vdr mounte, so klappt zwar der mount, aber beim Kopieren größerer Dateien geht die Geschwindigkeit irgendwann gegen Null und der Vorgang muß abgebrochen werden.

Was muß ich hier noch ändern um die beiden Systeme mit festen IP's nur über die 10Gbit-Nic's miteinander "sprechen" zu lassen?

Vielen Dank!

Ich habe ein bestehendes LAN im Bereich 10.0.10.X mit einer pfSense (10.0.10.1), einem Gbit-Switch und einigen Rechnern (freeNAS, vdr, Desktop).

vdr hat die 10.0.10.6

freeNAS hat die 10.0.10.7

Ich habe nun sowohl vdr als auch freeNAS mit einer zusätzlichen 10Gbit-Karte ausgestattet und jeweils feste IP's ohne Gateway mit Netzmaske 255.255.255.0 konfiguriert.

vdr hat zusätzlich die 10.0.20.6

freeNAS hat zusätzlich die 10.0.20.7

Beide Rechner sollen weiterhin aus dem normalen LAN für andere Geräte über die alten Netzwerkkarten im Bereich 10.0.10.X erreichbar bleiben.

Die Kommunikation zwischen den beiden Systemen soll aber ausschließlich über das Netz 10.0.20.X laufen.

Im Moment bekommen alle Netzwerkkarten die gewünschten IP's und auch ein ping klappt im Bereich 10.0.20.X in beide Richtungen.

Wenn ich nun aber eine nfs-Freigabe vom freeNAS (nur 10.0.20.6 erlaubt für Zugriff) am vdr mounte, so klappt zwar der mount, aber beim Kopieren größerer Dateien geht die Geschwindigkeit irgendwann gegen Null und der Vorgang muß abgebrochen werden.

Was muß ich hier noch ändern um die beiden Systeme mit festen IP's nur über die 10Gbit-Nic's miteinander "sprechen" zu lassen?

Vielen Dank!

Please also mark the comments that contributed to the solution of the article

Content-Key: 353321

Url: https://administrator.de/contentid/353321

Printed on: April 25, 2024 at 11:04 o'clock

25 Comments

Latest comment

Das erklärt alles was du zu tun hast:

Routing von 2 und mehr IP Netzen mit Windows, Linux und Router

Routing von 2 und mehr IP Netzen mit Windows, Linux und Router

- Neues IP Netz definieren (Hast du gemacht)

- IPv4 Forwarding auf dem Ubuntu aktivieren !

- Statische Route auf der pfSense definieren !

- Fertisch !

Was muß ich hier noch ändern

Nix...jedenfalls nix was das IP Routing anbetrifft. NFS solltest du mit UDP Enkapsulierung laufen lassen.Danach funktioniert am vdr der Internetzugang nichtmehr

Daraus kann man dann nur schliessen das du vergessen hast eine Default Route oder default Gateway am Ubuntu auf die pfSense zu setzen !!Ohne das ist es logisch das das dann in die Hose geht !

netstat -rn zeigt dir die Routing Tabelle auf dem Ubuntu ! Und ein traceroute -n 8.8.8.8 zeigt dir den Weg der IP Pakete Hop für Hop ins Internet.

Netzwerk ist echt nicht mein Ding

Das merkt man leider...und genau deshalb gibt es hier die oben genannten Tutorials

@aqui:

Er will ja, dass der Traffic nicht über den 1G-Switch läuft sondern über die 10G-Direktverbindung.

Da wäre eine Route über die pfSense vollkommen kontraindiziert

Das müsste auch eigentlich automatisch funktionieren, wenn er auf die 10G-Interfaces die 10.0.20.x/24 konfiguriert und die Freigabe über ebendiese IP-Adressen mounted.

Von daher wäre die Frage, auf welchen Interfaces du welche IP-Adressen konfiguriert hast und wie die Routingtabelle auf beiden Systemen aussieht ("ip -4 route list") - um sicherzustellen, dass der Traffic richtig fließt.

Wenn der Traffic korrekt fließt könnte es durchaus ein Kabel- oder Treiberproblem sein. Lasse dir mal mit "ifconfig" anzeigen, wie die Fehlercounter auf den 10G-Interfaces aussehen.

Er will ja, dass der Traffic nicht über den 1G-Switch läuft sondern über die 10G-Direktverbindung.

Da wäre eine Route über die pfSense vollkommen kontraindiziert

Das müsste auch eigentlich automatisch funktionieren, wenn er auf die 10G-Interfaces die 10.0.20.x/24 konfiguriert und die Freigabe über ebendiese IP-Adressen mounted.

Von daher wäre die Frage, auf welchen Interfaces du welche IP-Adressen konfiguriert hast und wie die Routingtabelle auf beiden Systemen aussieht ("ip -4 route list") - um sicherzustellen, dass der Traffic richtig fließt.

Wenn der Traffic korrekt fließt könnte es durchaus ein Kabel- oder Treiberproblem sein. Lasse dir mal mit "ifconfig" anzeigen, wie die Fehlercounter auf den 10G-Interfaces aussehen.

Da wäre eine Route über die pfSense vollkommen kontraindiziert

Der Einwand ist berechtigt aber kontraindiziert ist die Route denke ich nicht, denn sie sollte ja nicht stören. Sie dient lediglich dazu das Clients aus dem Netz an der pfSense die die pfSense als Gateway haben Geräte im "NAS Netz" erreichen können z.B. zu Management Zwecken etc.Der Ubuntu Server wird ja dann so oder so ein ICMP Redirect senden das die Clients danach dann direkt über den Ubuntu gehen.

Für den Ubuntu selber ist die Route egal, da er das NAS Netz ja direkt angeschlossen hat und so die Route für ihn gar nicht zum Tragen kommt. Er wird immer direkt das 10G NAS Interface (NIC) nutzen um Daten vom NAS zu holen.

Sein Design sieht ja vermutlich so aus:

(Internet)===(pfSense)---lokalesLAN---(NIC1_Ubuntu_NIC2)---NAS_LAN---(NAS)

Klassisches Design aus dem Tutorial also.

OK, keine Frage ! Da hast du natürlich absolut Recht. Das ist die grundsätzliche Frage.

Wenn dem so ist und es nicht gewollt ist, dann sollte diese statische Route auf der pfSense natürlich entfallen.

Oder sollte es gewollt sein....eine entsprechnde Firewall Regel eingerichtet sein die den Traffic aus diesem Netz ins NAS Netz entsprechend regelt.

Das muss der TO entscheiden.

Wenn dem so ist und es nicht gewollt ist, dann sollte diese statische Route auf der pfSense natürlich entfallen.

Oder sollte es gewollt sein....eine entsprechnde Firewall Regel eingerichtet sein die den Traffic aus diesem Netz ins NAS Netz entsprechend regelt.

Das muss der TO entscheiden.

Es könnte sein, dass die Network-Buffer für NFS nachjustiert werden müssen - du kannst über die Mount-Optionen "rsize" und "wsize" steuern, wie groß die Blöcke sind die Übertragen werden, bis ein ACK benötigt wird. Das reduziert theoretisch die CPU-Last, erhöht aber prinzipiell auch die Auswirkungen, wenn tatsächlich mal Pakete verloren gehen - dann kommt erstmal alles massiv ins Stocken.

Beobachte auch mal die Load-Average und CPU-Auslastung auf beiden Systemen während einer Dateiübertragung.

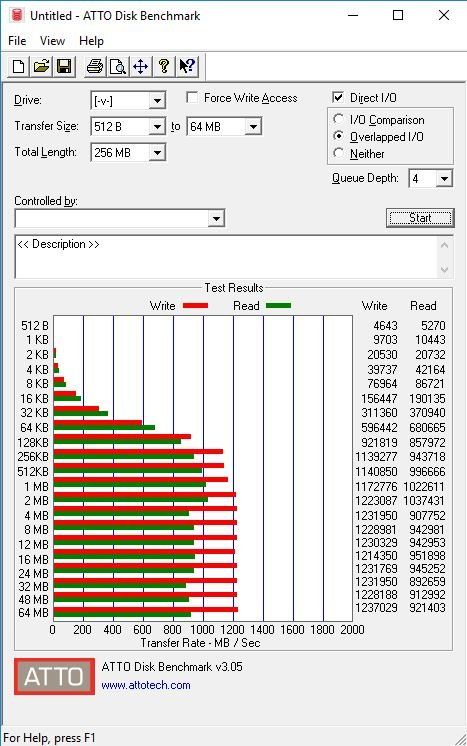

Vielleicht schaffen die Festplatten resp. der Controller auch einfach diese Geschwindigkeiten nicht, was bei theoretisch ~1 GByte/s zwar eher unwahrscheinlich ist, aber...

Nachdem die Systeme direkt verkabelt sind kannst du auch mal testweise die MTU auf 9000 Bytes erhöhen (sofern die NICs das mitmachen) und die rsize beim Mount auf Werte um 1152000 festlegen (das wären 128 x 9000 Bytes - also 128 Blöcke, die übertragen werden, ohne dass die Gegenstelle dies bestätigen muss).

Beobachte auch mal die Load-Average und CPU-Auslastung auf beiden Systemen während einer Dateiübertragung.

Vielleicht schaffen die Festplatten resp. der Controller auch einfach diese Geschwindigkeiten nicht, was bei theoretisch ~1 GByte/s zwar eher unwahrscheinlich ist, aber...

Nachdem die Systeme direkt verkabelt sind kannst du auch mal testweise die MTU auf 9000 Bytes erhöhen (sofern die NICs das mitmachen) und die rsize beim Mount auf Werte um 1152000 festlegen (das wären 128 x 9000 Bytes - also 128 Blöcke, die übertragen werden, ohne dass die Gegenstelle dies bestätigen muss).

sondern ich möchte sozusagen auf ein bestehendes Netz eine weitere Kommunikationsschnittstelle für 2 Rechner schaffen.

Nicht das wir uns dann da falsch verstehen !Das geht natürlich grundsätzlich aber nur solange die beiden 10G NICs isoliert und einzeln mit einer Patchstrippe verbunden sind. Es darf keinerlei Draht irgendwo ins andere IP Netz gesteckt werden.

Wenn das gegeben ist ist das OK und natürlich kann dann die Route in der FW entfallen.

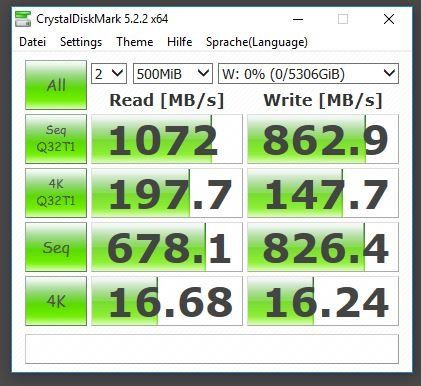

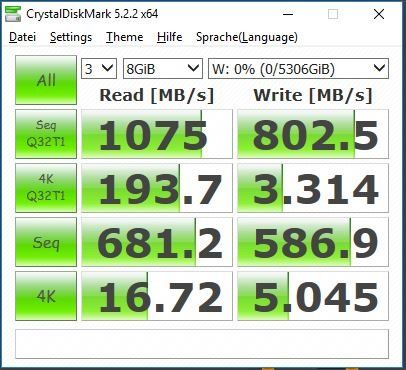

620MB = 5 Gig. Das ist kein berauschender Durchsatz !

Hast du auf dem NAS und dem Ubuntu Jumbo Frames auf den 10G NICs aktiviert ? Das solltest du zwingend machen.

https://www.cyberciti.biz/faq/rhel-centos-debian-ubuntu-jumbo-frames-con ...

Der Lord hat das ja richtigerweise schon angemerkt.

Du solltest auf beiden Systemen mit aktiviertem Jumbo mal NetIO laufen lassen:

https://web.ars.de/netio/

bzw.

Netzwerk Management Server mit Raspberry Pi

Das gibt wenigstens verlässliche Werte zurück die unabhängig vom Protokoll und der Paketsize ist.

Sofern auf beiden Systemen unixoide OS laufen rennt das da problemlos.

nahezu das Maximum an Geschwindigkeit - beide Seiten cachen ja auch.

Gemessen mit was ?? Hoffentlich dann ohne eine Protokollbindung wie SMB/CIFS, FTP, NFS usw. !Letztere verfälschen immer das Ergebnis.

Aber es hört sich in der Tat dann wirklich so an das das NAS hier NICHT der böse Buhmann ist.

Am VDR dann checken das die NIC auch im richtigen PCIe Slot mit den entsprechenden Lanes steckt !

Das Interrupt-Handling, insbesondere die Zuteilung von Soft-Interrupts ist eine Einstellung des Kernels. Wenn das unterschiedliche Distributionen sind, ist es durchaus möglich, dass auf dem VDR die Einstellungen suboptimal sind.

Sollten nicht genügend Interrupts zur Verfügung stehen, kannst du das anhand der Load-Average sehen, alternativ in "top" als "SI"-Wert.

Sollten nicht genügend Interrupts zur Verfügung stehen, kannst du das anhand der Load-Average sehen, alternativ in "top" als "SI"-Wert.

und ich bin eh am überlegen ob ich nicht komplett auf 10Gbit umstelle.

Uuhhh.... böses Faul ! Hattest du etwa nur die 10G Karte im NAS und im VDR nur 1 G ??Das wäre tödlich bei TCP pasierten Storage Protokollen weil es dann unweigerlich zum Buffer Bloating kommt:

https://en.wikipedia.org/wiki/Bufferbloat

Sowas funktioniert ausschliesslich nur wenn Layer 2 Flow Control auf NIC und Switch aktiviert ist.

Also die direkte Verbindung VDR - NAS sollte schon 10G auf beiden Seiten sein !

10G im Heimnetz macht wenig Sinn. Hier reicht es wenn du ggf. mit LACP LAGs arbeitest im VDR um etwas Lastverteilung dahin zu machen.