Optimierung Raidsystem Hyper-V Host

Hallo zusammen,

da ich hier gerade einen unserer Hyper-V Hosts räume, um diesen frisch zu installieren,

mache ich mir ebenfalls Gedanken über das Raidset.

Der Systembetreuer hat das Gerät mit Raid 6 ausgeliefert, was in meinen Augen nicht ideal ist und teilweise träge wirkt.

Das System macht beherbergt eigentlich alles, also von Fileserver über Applikationsserver bis Datenbankserver (SQL, Postgre, Actian, MariaDB).

...nur die Backups landen extern.

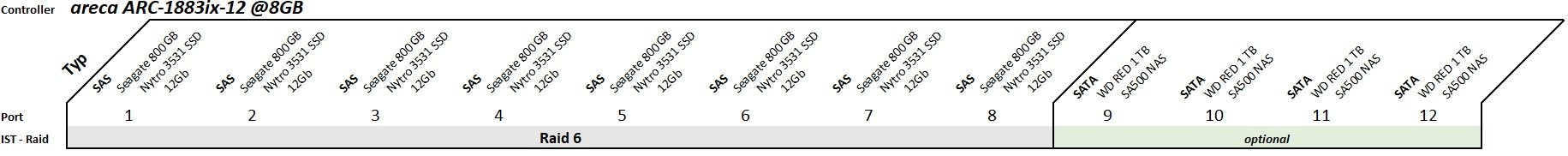

Sieht also aktuell so aus:

Grundlegend hätte ich gern auf ein Raid 10 gesetzt, da dies für SSDs entsprechend optimiert wurde?

Damit klaue ich mir aber 50% Speicherplatz, was ich mir leider nicht ganz erlauben kann.

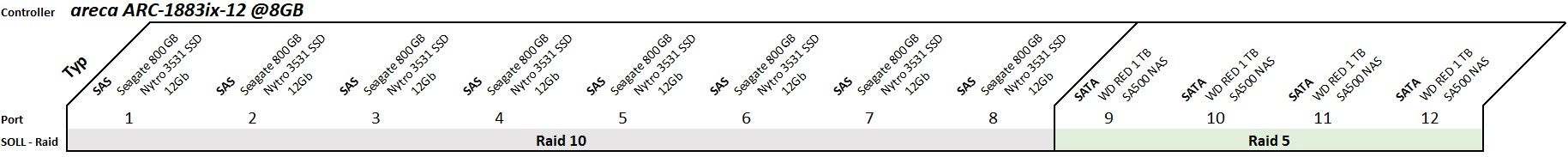

...außer, ich lagere einige Systeme auf die SATA SSDs aus:

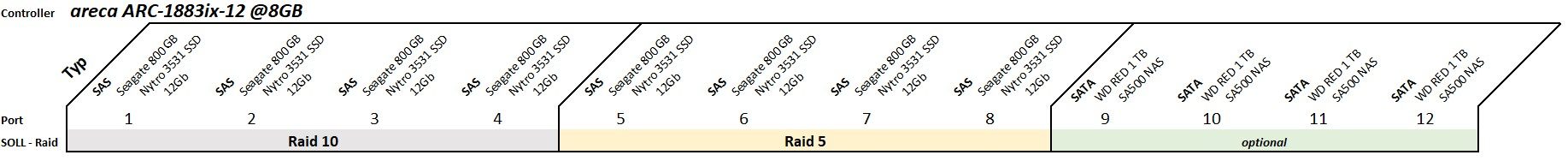

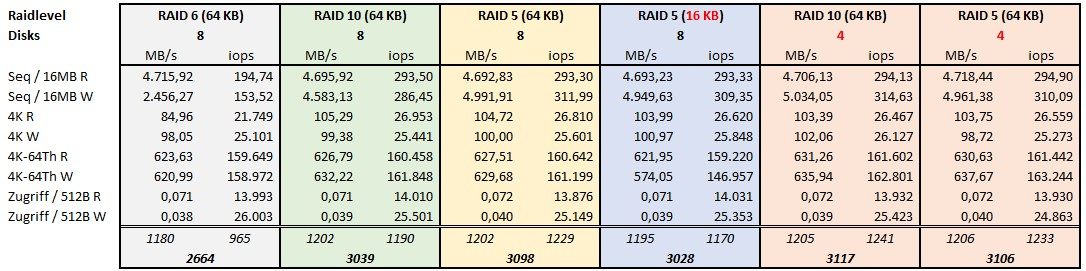

Alternativ könnte ich natürlich auch splitten, kann aber nicht beurteilen wie sich die Performance des Raid 10 dann macht?

Die ultimative Lösung wird es vermutlich nicht geben, also ist es immer ein Kompromiss, eine Ersatz SSD von den Nytros liegt im

Schrank, bei einem Ausfall kann also entsprechend zügig reagiert werden.

Bin auf eure Meinungen gespannt.

Grüße

ToWa

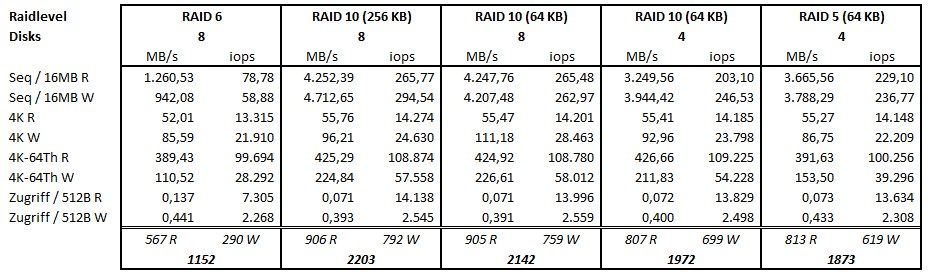

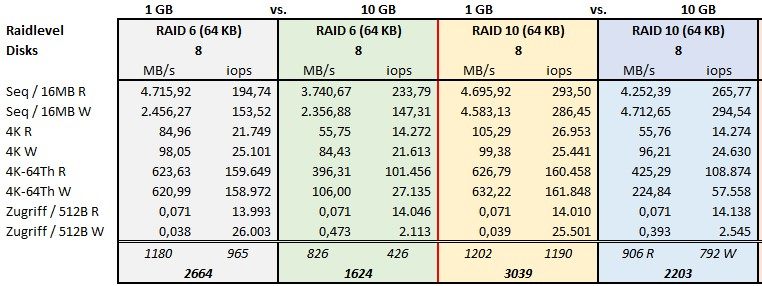

Edit: Benchmarkergebnisse: Optimierung Raidsystem Hyper-V Host

da ich hier gerade einen unserer Hyper-V Hosts räume, um diesen frisch zu installieren,

mache ich mir ebenfalls Gedanken über das Raidset.

Der Systembetreuer hat das Gerät mit Raid 6 ausgeliefert, was in meinen Augen nicht ideal ist und teilweise träge wirkt.

Das System macht beherbergt eigentlich alles, also von Fileserver über Applikationsserver bis Datenbankserver (SQL, Postgre, Actian, MariaDB).

...nur die Backups landen extern.

Sieht also aktuell so aus:

Grundlegend hätte ich gern auf ein Raid 10 gesetzt, da dies für SSDs entsprechend optimiert wurde?

Damit klaue ich mir aber 50% Speicherplatz, was ich mir leider nicht ganz erlauben kann.

...außer, ich lagere einige Systeme auf die SATA SSDs aus:

Alternativ könnte ich natürlich auch splitten, kann aber nicht beurteilen wie sich die Performance des Raid 10 dann macht?

Die ultimative Lösung wird es vermutlich nicht geben, also ist es immer ein Kompromiss, eine Ersatz SSD von den Nytros liegt im

Schrank, bei einem Ausfall kann also entsprechend zügig reagiert werden.

Bin auf eure Meinungen gespannt.

Grüße

ToWa

Edit: Benchmarkergebnisse: Optimierung Raidsystem Hyper-V Host

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-Key: 3249592275

Url: https://administrator.de/contentid/3249592275

Ausgedruckt am: 25.04.2024 um 15:04 Uhr

52 Kommentare

Neuester Kommentar

Du schreibst nicht, wie viel Speicherkapazität derzeit in Nutzung ist und mit wie viel du rechnest. Du darfst auch nicht vergessen das für Snapshots und eventuell mal den ein oder anderen Restore Platz da sein muss.

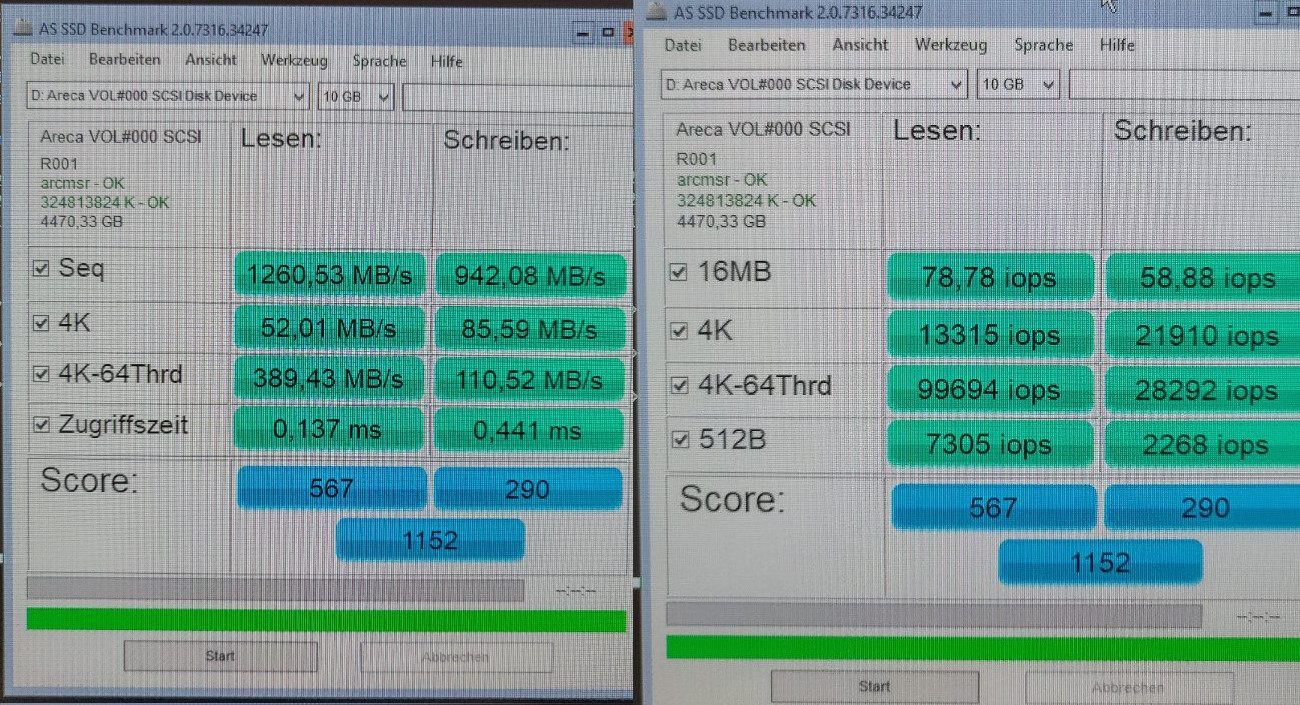

Hast du mal Benchmarks laufen lassen um RAID 5 bzw. 6 mit RAID 10 zu vergleichen? Was schafft den der Controller an Bandbreite?

Hast du mal Benchmarks laufen lassen um RAID 5 bzw. 6 mit RAID 10 zu vergleichen? Was schafft den der Controller an Bandbreite?

Ich würde mindestens 25% freien Platz (oder in Höhe der größten einzel VM) zu jeder Zeit für Snapshots und Restores bereit halten ansonsten kannst du kaum noch agieren wenn es mal ein Problem gibt. 0,4TB sind verdammt wenig. Wenn du jetzt auf 2 oder 3 Volumes splittest gilt das natürlich für jedes Volume genauso wie für die Gesamtumgebung, das wird bei mehr Volumes also irgendwo zu mehr ungenutztem Speicher führen und je kleiner die Volumes werden desto schneller sind auch mal die freien Kapazitäten aufgebraucht.

RAID 5 und RAID 6 werden sich in der Performance fast gar nicht unterscheiden.

Ein 4 Disk RAID 5 macht aus meiner Sicht allgemein wenig Sinn, das ist irgendwie so die Geiz ist Geil-Lösung.

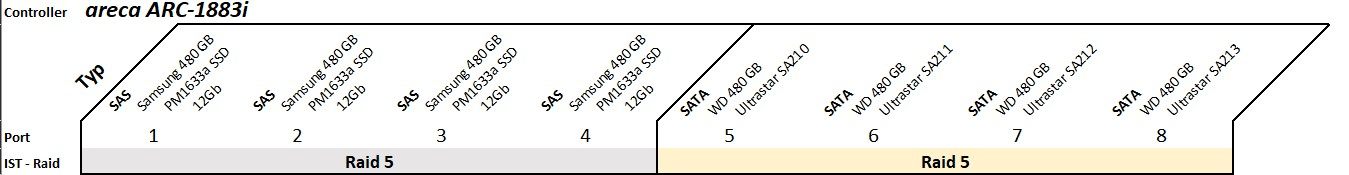

Wie werden denn die 4 HDDs derzeit genutzt?

RAID 5 und RAID 6 werden sich in der Performance fast gar nicht unterscheiden.

Ein 4 Disk RAID 5 macht aus meiner Sicht allgemein wenig Sinn, das ist irgendwie so die Geiz ist Geil-Lösung.

Wie werden denn die 4 HDDs derzeit genutzt?

Kenne WD Red nur als HDD aber mag sein das es auch SSD gibt. Dann sollten die auf jeden Fall für den Archiv Server her halten.

Die übrigen Platten würde ich wirklich mal einem Benchmark unterziehen um eine Vorstellung vom Unterscheid zwischen RAID 5 und RAID 10 zu bekommen. Die größte Gefahr für einen klassischen RAID geht aus meiner Sicht von einem Rebuild aus. Wenn eine Disk versagt und der Rebuild auf das cold oder hot spare läuft müssen beim RAID 5 alle Sektoren aller verbliebenen Platten fehlerfrei liefern, da gibt es ein hohes Risiko das ein weiterer Lesefehler deinen RAID kompromittiert. Ein RAID 6 kann einen weiteren Fehler verkraften, das hat schon seinen Reiz.

Ob die Datenbanken überhaupt von RAID 10 profitieren kann man pauschal nicht sagen. Datenbanken profitieren auf jeden Fall von RAM aber wie viel Disk IO machen deine Datenbanken? Das müsste man schon sehr genau betrachten um da einen Effekt zu sehen.

Die übrigen Platten würde ich wirklich mal einem Benchmark unterziehen um eine Vorstellung vom Unterscheid zwischen RAID 5 und RAID 10 zu bekommen. Die größte Gefahr für einen klassischen RAID geht aus meiner Sicht von einem Rebuild aus. Wenn eine Disk versagt und der Rebuild auf das cold oder hot spare läuft müssen beim RAID 5 alle Sektoren aller verbliebenen Platten fehlerfrei liefern, da gibt es ein hohes Risiko das ein weiterer Lesefehler deinen RAID kompromittiert. Ein RAID 6 kann einen weiteren Fehler verkraften, das hat schon seinen Reiz.

Ob die Datenbanken überhaupt von RAID 10 profitieren kann man pauschal nicht sagen. Datenbanken profitieren auf jeden Fall von RAM aber wie viel Disk IO machen deine Datenbanken? Das müsste man schon sehr genau betrachten um da einen Effekt zu sehen.

Teste lieber auf deiner Hardware wenn die Gelegenheit da ist.

Plane nicht zu knapp. Wenn du jetzt schon mit System in Ablösung planst kommen bestimmt auch neue Sachen dazu.

Ich würde sagen die Abnutzung bei SSDs ist, wegen diverser Techniken bei der Optimierung/Verwaltung der Zellen durch die SSD selbst, vermutlich nicht sehr linear in der Entwicklung, eher bei HDDs. Früher hat man gezielt HDDs aus verschiedenen Chargen verbaut weil genau das ein Problem war: Gleiche Nutzung, zeitgleicher Ausfall.

Plane nicht zu knapp. Wenn du jetzt schon mit System in Ablösung planst kommen bestimmt auch neue Sachen dazu.

Ich würde sagen die Abnutzung bei SSDs ist, wegen diverser Techniken bei der Optimierung/Verwaltung der Zellen durch die SSD selbst, vermutlich nicht sehr linear in der Entwicklung, eher bei HDDs. Früher hat man gezielt HDDs aus verschiedenen Chargen verbaut weil genau das ein Problem war: Gleiche Nutzung, zeitgleicher Ausfall.

Also für reine Schreib/Lesetests ist ATTO immer ganz easy gewesen. IOmeter müsste für Datenbankszenarien gut taugen leider bin ich nie wirklich dazu gekommen da mal richtig tief einzusteigen. Vielleicht gibt's hier noch was gutes:

https://www.thomas-krenn.com/de/wiki/I/O_Performance_Benchmarking_Tools_ ...

https://www.thomas-krenn.com/de/wiki/I/O_Performance_Benchmarking_Tools_ ...

Moin ToWa,

die Trägheit wird aber sicherlich nicht am RAID6 liegen, schon gar nicht, wenn du z.B. bereits schon lesend Probleme feststellen solltest.

Nein, RAID 10 ist keineswegs für SSD's optimiert und bringt insbesondere bei diesen auch keine höhere Performance, zumindest dann nicht, wenn du einen anständigen RAID-Controller für die SSD's verwendest.

Im Gegenteil, RAID 10 ist insbesondere beim Schreiben meistens viel lahmer wie ein RAID5.

Gruss Alex

da ich hier gerade einen unserer Hyper-V Hosts räume, um diesen frisch zu installieren,

mache ich mir ebenfalls Gedanken über das Raidset.

Der Systembetreuer hat das Gerät mit Raid 6 ausgeliefert, was in meinen Augen nicht ideal ist und teilweise träge wirkt.

mache ich mir ebenfalls Gedanken über das Raidset.

Der Systembetreuer hat das Gerät mit Raid 6 ausgeliefert, was in meinen Augen nicht ideal ist und teilweise träge wirkt.

die Trägheit wird aber sicherlich nicht am RAID6 liegen, schon gar nicht, wenn du z.B. bereits schon lesend Probleme feststellen solltest.

Grundlegend hätte ich gern auf ein Raid 10 gesetzt, da dies für SSDs entsprechend optimiert wurde?

Damit klaue ich mir aber 50% Speicherplatz, was ich mir leider nicht ganz erlauben kann.

Damit klaue ich mir aber 50% Speicherplatz, was ich mir leider nicht ganz erlauben kann.

Nein, RAID 10 ist keineswegs für SSD's optimiert und bringt insbesondere bei diesen auch keine höhere Performance, zumindest dann nicht, wenn du einen anständigen RAID-Controller für die SSD's verwendest.

Im Gegenteil, RAID 10 ist insbesondere beim Schreiben meistens viel lahmer wie ein RAID5.

Gruss Alex

Zum Thema Cache ist ja grade ein neuer Thread auf gemacht worden:

SSD RAID - Controller mit Cache oder ohne?

Was sowohl den spezifischen Controller als auch die Wahl des RAID Levels angeht würde ich mir erst mit Benchmarks einen Eindruck verschaffen. Ich tendiere aber eher zu RAID 5 oder 6. Grund: Du hantierst mit relativ wenig Reserven, ich gehe also davon aus das deine Datenmengen nicht sonderlich schnell wachsen. Datenbanken lesen ja meist so schon mehr als sie schreiben, bei dir wird das vermutlich deutlich sein. Daher eher RAID 5 für Leseperformance, auch für die DBs. Und es bietet dir schlicht mehr Spielraum beim Platz.

SSD RAID - Controller mit Cache oder ohne?

Was sowohl den spezifischen Controller als auch die Wahl des RAID Levels angeht würde ich mir erst mit Benchmarks einen Eindruck verschaffen. Ich tendiere aber eher zu RAID 5 oder 6. Grund: Du hantierst mit relativ wenig Reserven, ich gehe also davon aus das deine Datenmengen nicht sonderlich schnell wachsen. Datenbanken lesen ja meist so schon mehr als sie schreiben, bei dir wird das vermutlich deutlich sein. Daher eher RAID 5 für Leseperformance, auch für die DBs. Und es bietet dir schlicht mehr Spielraum beim Platz.

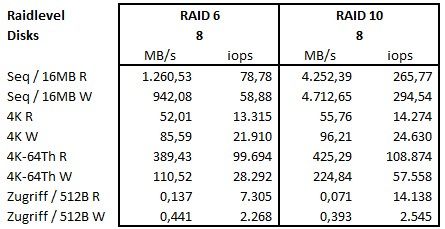

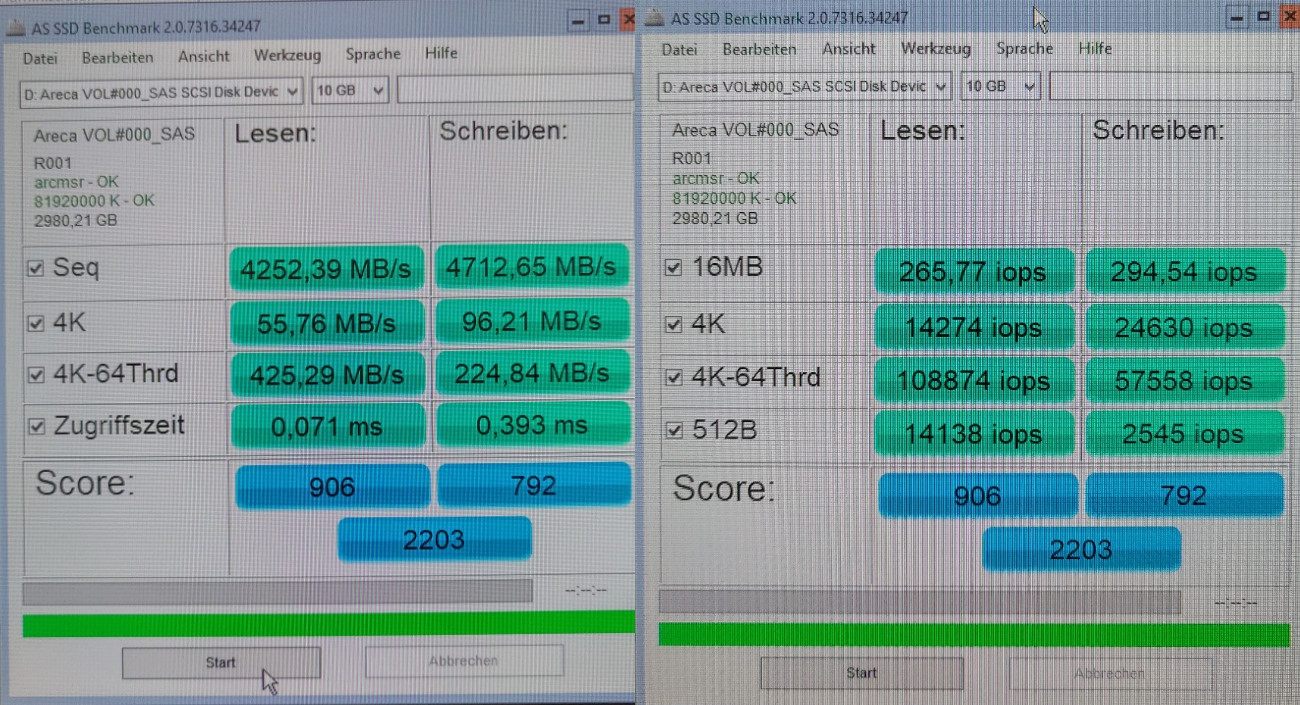

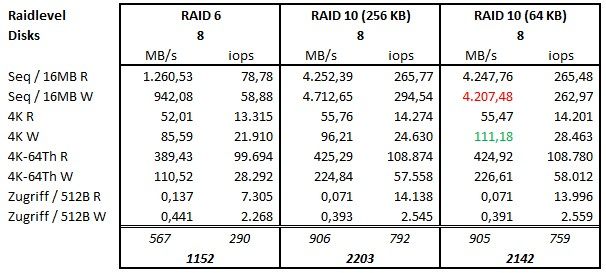

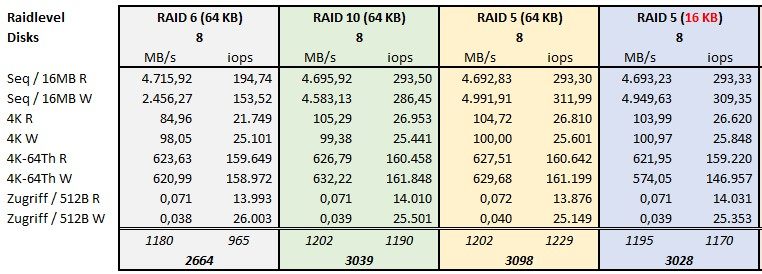

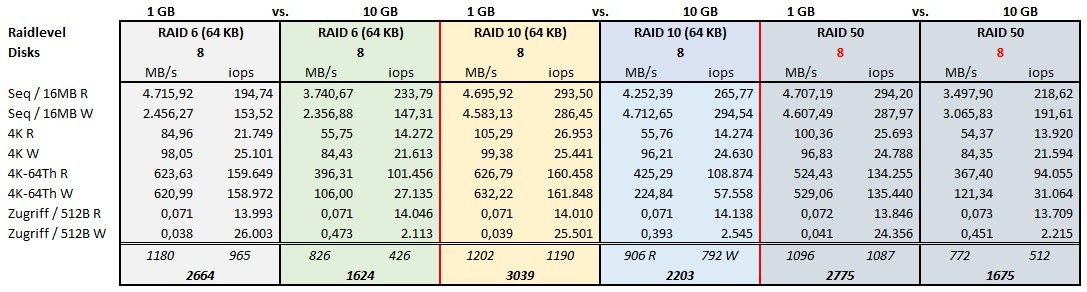

Merkwürdig wie sich die IOPS verteilen. Bei 4k-64Th ist write deutlich schneller bei RAID 10 read aber kaum. Und umgekehrt beim Zugriff write gleich und read deutlich schneller. Ich kriege von sowas Kopfschmerzen aber ja, RAID 10 scheint grundsätzlich schneller in dieser Konstellation.

PS: Eventuell nochmal in der VM testen.

PS: Eventuell nochmal in der VM testen.

Ass Disk mit 10 GB soll was Aussagen?

Ich würde mit IOMeter und der Realität entsprechenden Workloads das Setup überprüfen.

Ich würde mit IOMeter und der Realität entsprechenden Workloads das Setup überprüfen.

Moin dertowa,

bin im Stress, daher muss ich mich kurz fassen.

Bei deinem Test mit RAID6 VS RAID10 passt etwas nicht.

Bei dem RAID6 müsste sowohl die Lese- als auch die Schreibperformance deutlich höher sein!

In deiner Konstellation solltest du im RAID6 beim Lesen +- die summarische Performance von 6 einelnen SSD's erreichen und davon bist du mit deinen Ergebnissen weit entfernt.

Beim Schreiben sollte das ähnlich aussehen, hier musss der Controller zwar noch die Parität berechnen und auf zwei SSD's schreiben, das macht ein moderner Controller normalerweise quasi im Schlaf.

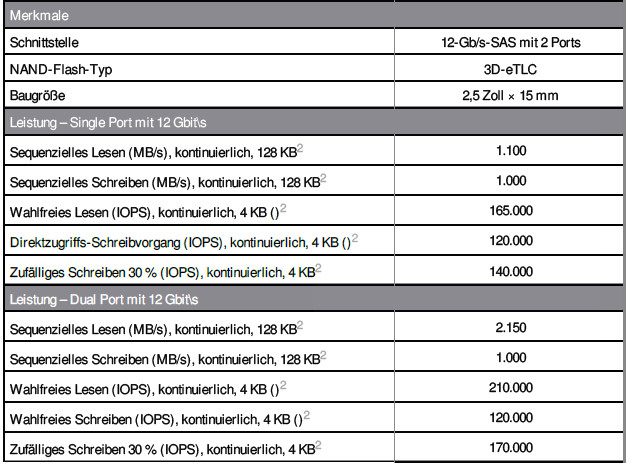

Wie schnell sind die SSD's am Controller angebunden 6G oder 12G?

Gruss Alex

bin im Stress, daher muss ich mich kurz fassen.

Bei deinem Test mit RAID6 VS RAID10 passt etwas nicht.

Bei dem RAID6 müsste sowohl die Lese- als auch die Schreibperformance deutlich höher sein!

In deiner Konstellation solltest du im RAID6 beim Lesen +- die summarische Performance von 6 einelnen SSD's erreichen und davon bist du mit deinen Ergebnissen weit entfernt.

Beim Schreiben sollte das ähnlich aussehen, hier musss der Controller zwar noch die Parität berechnen und auf zwei SSD's schreiben, das macht ein moderner Controller normalerweise quasi im Schlaf.

Wie schnell sind die SSD's am Controller angebunden 6G oder 12G?

Gruss Alex

Moin dertowa,

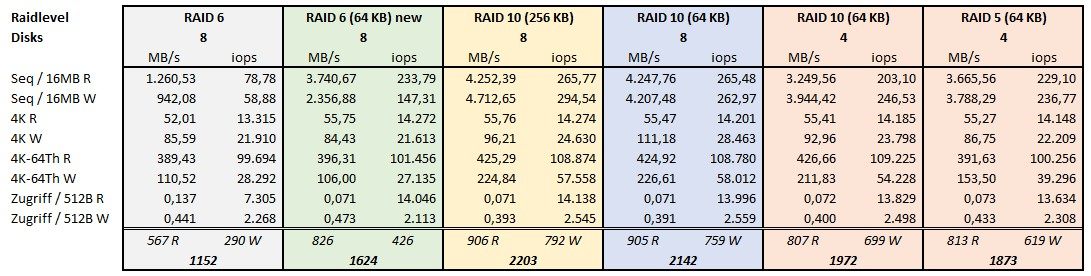

ja, das sieht doch schon deutlich besser aus.

Und mit RAID5 bekommst du nochmals mehr Bums. 😉

Mach übrigens das Strippe-Set so klein wie möglich, dann hast du beim Schreiben die beste random Performance.

SSD's die in einem RAID an einem Hardware-RAID-Controller hängen können grundsätzlich vom OS nicht getrimmt werden. Hier muss man dem Windows des Trimmen von Hand abgewöhnen.

Siehe.

https://www.easeus.com/resource/trim-ssd-windows-10.html

Nicht, wenn der Controller selbst seine Arbeit richtig macht.

Wenn das Enterprise-SSD's sind, dann nimm RAID5 und gut ist.

Die Dinger gehen im Vergleich zu Festplatten, so gut wie nie kaputt.

Habe in den letzten >10 Jahren schon xxx davon in SAN's verbaut (allesamt RAID5).

RAID6 nehme ich nur bei Backup-SAN's und HDD's. 🙃

Gruss Alex

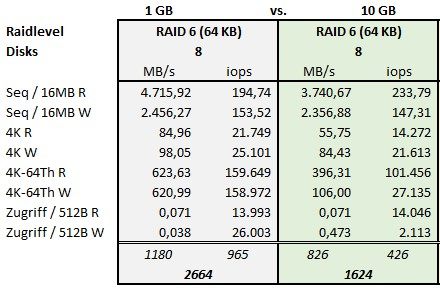

Ich könnte auch die 1 GB Datei nehmen, habe ich aber nicht gemacht, da der Controller 8 GB DDR3 RAM hat...

ja, das sieht doch schon deutlich besser aus.

Und mit RAID5 bekommst du nochmals mehr Bums. 😉

Mach übrigens das Strippe-Set so klein wie möglich, dann hast du beim Schreiben die beste random Performance.

Nach der Info des areca Support ist übrigens egal, die Seq-Werte kann ich ignorieren, da das Raidset offenbar nicht mit dem TRIM-Befehl versorgt wird/werden kann und die ermittelten Werte entsprechend normal sind.

https://www.it-daily.net/speicherguide/storage-spg/problem-ssds-mit-trim ...

https://www.it-daily.net/speicherguide/storage-spg/problem-ssds-mit-trim ...

SSD's die in einem RAID an einem Hardware-RAID-Controller hängen können grundsätzlich vom OS nicht getrimmt werden. Hier muss man dem Windows des Trimmen von Hand abgewöhnen.

Siehe.

https://www.easeus.com/resource/trim-ssd-windows-10.html

Bedeutet im Umkehrschluss, dass alle Volumes nach einiger Zeit Leistung einbüßen, aber auch, dass das nicht nur ein Gefühl ist, dass die VMs auf dem frisch installierten zweiten Host mit Raid 5 aus 4 SSDs performanter laufen.

Nicht, wenn der Controller selbst seine Arbeit richtig macht.

Nun stellt sich nur die Frage welchen Schluss ich daraus ziehe.

- Ich nehme vollständig Raid 10 um möglichst viel Performance in die Laufzeit reinzugeben

- Ich nehme die Variante Raid 10 & 5 um die Systeme auf unterschiedliche Volumes zu teilen und somit deutlich einfacher während der Laufzeit mal ein Volume zu plätten und neu zu intitialisieren

Wenn das Enterprise-SSD's sind, dann nimm RAID5 und gut ist.

Die Dinger gehen im Vergleich zu Festplatten, so gut wie nie kaputt.

Habe in den letzten >10 Jahren schon xxx davon in SAN's verbaut (allesamt RAID5).

RAID6 nehme ich nur bei Backup-SAN's und HDD's. 🙃

Gruss Alex

Moin dertowa,

12G lecker, dann sollte man aus den 8 SSD's aber noch deutlich mehr rausholen können.

Jup, das ist auch gut so und hoffentlich ist dieser per Akku/Power-CAP gepuffert.

Haben die Seagate-SSD's einen eigenen Cache und wenn ja, ist dieser am Areca überhaupt aktiviert?

Und bevor mich hier jetzt jemand wegen dem Drive-Cache und einem Strohmausfall belehren möchte.

Wir sprechen hier über (hoffentlich) Enterprise SSD's und hier verhält sich die Materie ganz anders als bei HDD's oder auch Konsumer-SSD's.

Beste Grüsse aus BaWü

Gruss Alex

die SSDs laufen mit 12G am Controller.

Seitens areca gibt es auch keine Einstellungsvorgaben die HDD und SSD am Controller unterscheiden, dieser erkennt was er da am Kabel hängen hat.

Seitens areca gibt es auch keine Einstellungsvorgaben die HDD und SSD am Controller unterscheiden, dieser erkennt was er da am Kabel hängen hat.

12G lecker, dann sollte man aus den 8 SSD's aber noch deutlich mehr rausholen können.

Wie gesagt die Leistung steigt wenn die Dateien kleiner werden, aber dann bin ich ja im Cache des Controllers unterwegs...

Jup, das ist auch gut so und hoffentlich ist dieser per Akku/Power-CAP gepuffert.

Haben die Seagate-SSD's einen eigenen Cache und wenn ja, ist dieser am Areca überhaupt aktiviert?

Und bevor mich hier jetzt jemand wegen dem Drive-Cache und einem Strohmausfall belehren möchte.

Wir sprechen hier über (hoffentlich) Enterprise SSD's und hier verhält sich die Materie ganz anders als bei HDD's oder auch Konsumer-SSD's.

Beste Grüsse aus BaWü

Gruss Alex

Was für eine PCIe Version und wie viele Lanes hat denn der Controller bzw. der Slot in dem der Controller läuft? Ist da eventuell die RAID 5 / 6 Performance limitiert?

https://en.wikipedia.org/wiki/PCI_Express

https://en.wikipedia.org/wiki/PCI_Express

Zitat von @dertowa:

Ich könnte auch die 1 GB Datei nehmen, habe ich aber nicht gemacht, da der Controller 8 GB DDR3 RAM hat...

Nach der Info des areca Support ist übrigens egal, die Seq-Werte kann ich ignorieren, da das Raidset offenbar nicht mit dem TRIM-Befehl versorgt wird/werden kann und die ermittelten Werte entsprechend normal sind.

https://www.it-daily.net/speicherguide/storage-spg/problem-ssds-mit-trim ...

Bedeutet im Umkehrschluss, dass alle Volumes nach einiger Zeit Leistung einbüßen, aber auch, dass das nicht nur ein Gefühl ist, dass die VMs auf dem frisch installierten zweiten Host mit Raid 5 aus 4 SSDs performanter laufen.

Nun stellt sich nur die Frage welchen Schluss ich daraus ziehe.

Zitat von @2423392070:

Ass Disk mit 10 GB soll was Aussagen?

Mir ging es erstmal als Richtwert um die Übertragungsraten und da IOMeter am Core Server nicht läuft hab ich keine Vergleichswerte von vorher.Ass Disk mit 10 GB soll was Aussagen?

Ich könnte auch die 1 GB Datei nehmen, habe ich aber nicht gemacht, da der Controller 8 GB DDR3 RAM hat...

Nach der Info des areca Support ist übrigens egal, die Seq-Werte kann ich ignorieren, da das Raidset offenbar nicht mit dem TRIM-Befehl versorgt wird/werden kann und die ermittelten Werte entsprechend normal sind.

https://www.it-daily.net/speicherguide/storage-spg/problem-ssds-mit-trim ...

Bedeutet im Umkehrschluss, dass alle Volumes nach einiger Zeit Leistung einbüßen, aber auch, dass das nicht nur ein Gefühl ist, dass die VMs auf dem frisch installierten zweiten Host mit Raid 5 aus 4 SSDs performanter laufen.

Nun stellt sich nur die Frage welchen Schluss ich daraus ziehe.

- Ich nehme vollständig Raid 10 um möglichst viel Performance in die Laufzeit reinzugeben

- Ich nehme die Variante Raid 10 & 5 um die Systeme auf unterschiedliche Volumes zu teilen und somit deutlich einfacher während der Laufzeit mal ein Volume zu plätten und neu zu intitialisieren

Sehe da auch keine Richtwerte.

Feature on demand kennst Du?

Zitat von @ukulele-7:

Was für eine PCIe Version und wie viele Lanes hat denn der Controller bzw. der Slot in dem der Controller läuft? Ist da eventuell die RAID 5 / 6 Performance limitiert?

https://en.wikipedia.org/wiki/PCI_Express

Was für eine PCIe Version und wie viele Lanes hat denn der Controller bzw. der Slot in dem der Controller läuft? Ist da eventuell die RAID 5 / 6 Performance limitiert?

https://en.wikipedia.org/wiki/PCI_Express

👍👍👍, sehr gute Frage!

Diese knapp 8 GB/s sind ja auch ein theoretischer Wert. Ich denke mal das Board wird das schaffen aber eventuell nicht die CPU des Controllers und eventuell auch nicht das Hauptsystem.

Das könnte man genauer bestimmen in dem 8 zu 6 Disks vergleicht mit ansonsten exakten Settings. Aber irgendwann will man es vielleicht auch gut sein lassen

Das könnte man genauer bestimmen in dem 8 zu 6 Disks vergleicht mit ansonsten exakten Settings. Aber irgendwann will man es vielleicht auch gut sein lassen

Zitat von @dertowa:

Was möchtest du bitte?

Mir ging es hier eigentlich nur um den "best practise" für einen Neuaufbau des Raidsets.

...dass die spontan genommenen Benchmarkwerte vor Löschung des Raidsets so weit auseinander klaffen war mir vorher nicht klar...

Auf dem System läuft alles, ich kann also nicht sagen "ich optimiere mal für Datenbanken" oder "ich brauche maximale Datenübertragung".

Noch mal, vom Systembuilder war das Teil in der Raid 6 Konfiguration, nach meiner bisherigen Auswertung sehe ich das aber nicht als ideal an.

Zitat von @2423392070:

Sehe da auch keine Richtwerte.

Feature on demand kennst Du?

Sehe da auch keine Richtwerte.

Feature on demand kennst Du?

Was möchtest du bitte?

Mir ging es hier eigentlich nur um den "best practise" für einen Neuaufbau des Raidsets.

...dass die spontan genommenen Benchmarkwerte vor Löschung des Raidsets so weit auseinander klaffen war mir vorher nicht klar...

Auf dem System läuft alles, ich kann also nicht sagen "ich optimiere mal für Datenbanken" oder "ich brauche maximale Datenübertragung".

Noch mal, vom Systembuilder war das Teil in der Raid 6 Konfiguration, nach meiner bisherigen Auswertung sehe ich das aber nicht als ideal an.

Ich habe dir mitgeteilt, dass deine Benchmark oder anders formuliert Richtwerte keine Aussagekraft haben.

Schwurbeln mit sinnfreien Tools und füttern von Tabellen soll was bewirken?

Dein Tool hat fast ausschließlich den Cache bedient und davon gelebt.

Übrigens arbeitet kein Server so, außer ein solches Tool läuft.

Das bedeutet, dass du keine Erkenntnisse hast die belastbar sind.

IOMeter sollte mindestens 16 Threads, eher 32 oder 64 machen, die dem Reallife-Verhalten entsprechen.

Wenn du nicht weißt, was Gehauen und Gestochen ist, dann nutze sowas z.b.: https://app.liveoptics.com/Register/HCI

Oder das Pendant von z. B. HPE oder Lenovo.

Es ist kostenlos.

Nach der Erkenntnis kannst du IOMeter dann so einstellen, dass es das Reallife mit Druck dem Storage abverlangt und dann kannst du das Optimum suchen, finden und bewerten.

IOMeter sollte mindestens 16 Threads, eher 32 oder 64 machen, die dem Reallife-Verhalten entsprechen.

Wenn du nicht weißt, was Gehauen und Gestochen ist, dann nutze sowas z.b.: https://app.liveoptics.com/Register/HCI

Oder das Pendant von z. B. HPE oder Lenovo.

Es ist kostenlos.

Nach der Erkenntnis kannst du IOMeter dann so einstellen, dass es das Reallife mit Druck dem Storage abverlangt und dann kannst du das Optimum suchen, finden und bewerten.

Mir wäre das Risiko zu groß schlauer zu werden oder es gar zu bereuen.

Zitat von @dertowa:

Habe gerade mal testweise die Volumes Raid 10 & 5 parallel mit dem AS SSD Benchmark befeuert.

Da komme ich auf 6000 MB/s sequenzielle Leserate über beide Sets.

Aber, je größer die Datei wird, desto langsamer wird es über beide Sets gesehen, da reicht dann der

Dual Core RAID-on-Chip (ROC) 1.2GHz processor wohl nicht mehr aus.

Habe gerade mal testweise die Volumes Raid 10 & 5 parallel mit dem AS SSD Benchmark befeuert.

Da komme ich auf 6000 MB/s sequenzielle Leserate über beide Sets.

Aber, je größer die Datei wird, desto langsamer wird es über beide Sets gesehen, da reicht dann der

Dual Core RAID-on-Chip (ROC) 1.2GHz processor wohl nicht mehr aus.

du bekommst bei RAID5 und RAID10 annähernd dieselbe Transferrate ... 🤔

Dann liegt die "Limitierung" zu 99,9% nicht an der ASIC der RAID-Controllers, sondern eher an der Bandbreite des für den Cache verwendeten RAM's.

Zitat von @2423392070:

Ich habe dir mitgeteilt, dass deine Benchmark oder anders formuliert Richtwerte keine Aussagekraft haben.

Schwurbeln mit sinnfreien Tools und füttern von Tabellen soll was bewirken?

Ich habe dir mitgeteilt, dass deine Benchmark oder anders formuliert Richtwerte keine Aussagekraft haben.

Schwurbeln mit sinnfreien Tools und füttern von Tabellen soll was bewirken?

Das ist keineswegs nutzloses Schwurbeln, sondern wertvolle Arbeit um die Funktionsweise und auch die Leistungsfähigkeit seines Systems selbst besser zu verstehen.

Dein Tool hat fast ausschließlich den Cache bedient und davon gelebt.

Übrigens arbeitet kein Server so, außer ein solches Tool läuft.

Übrigens arbeitet kein Server so, außer ein solches Tool läuft.

Ähm doch und nicht nur die, sondern auch die SAN's & Co.

Das letzte SAN das unser Haus verlassen hat, hatte 128G Cache per Controller und das obwohl es ein All-Flash ist.🤪Flash ist Flash und RAM ist eben RAM und das letztere davon ist eben immer noch viel schneller. 😉

Zitat von @2423392070:

Das bedeutet, dass du keine Erkenntnisse hast die belastbar sind.

IOMeter sollte mindestens 16 Threads, eher 32 oder 64 machen, die dem Reallife-Verhalten entsprechen.

Nach der Erkenntnis kannst du IOMeter dann so einstellen, dass es das Reallife mit Druck dem Storage abverlangt und dann kannst du das Optimum suchen, finden und bewerten.

Das bedeutet, dass du keine Erkenntnisse hast die belastbar sind.

IOMeter sollte mindestens 16 Threads, eher 32 oder 64 machen, die dem Reallife-Verhalten entsprechen.

Nach der Erkenntnis kannst du IOMeter dann so einstellen, dass es das Reallife mit Druck dem Storage abverlangt und dann kannst du das Optimum suchen, finden und bewerten.

IOMeter kann ich ebenfalls nur empfehlen, aber das Ding muss man auch bedienen und die Werte richtig interpretieren können.

Was das Multithreading angeht, ja bei vielen Benutzern ist eine hohe Multithread-Performance auch wichtig, aber was den einzelnen Benutzer angeht, so ist für diesen die Singlethread-Performance dennoch meist viel wichtiger.

Moin dertowa,

die obere Erklärung ins nur halbwegs korrekt.

Read Ahead bring keineswegs nur bei HDD's eine Vorteil sondern auch bei SSD's, aber eben nur für einen bestimmten Workload-Typ, nämlich sequentielle Lesezugriffe.

Und das war es dann auch schon, bei allen anderen Workloads und insbesondere bei Random-Access, bringt dieses Feature jedoch nur Nachteile, das es ständig den Cache mit nicht benötigten Daten vorbefüllt. Dadurch wird der Cache selbst mehr als nötig Belastet und auch die Datenträger müssen viel mehr Daten auslesen, als eigentlich vom darüberliegenden System angefragt wird.

Für die meisten Anwendungsfälle und insbesondere bei Datenbanken ist dieses Feature einfach nur Gift.

Beste Grüsse aus BaWü

Alex

Read ahead – reading data blocks that reside behind the currently requested data – is also a performance optimization that only offers genuine benefits for hard disks. In RAID 5 with four SSDs, activating read ahead slowed down the read IOPS these tests by 20 percent (from 175,000 to 140,000 read IOPS). In terms of throughput, you'll see no performance differences for reading with 64KB or 1,024KB blocks. Read ahead only offered benefits in our lab in throughput with 8KB blocks. Additionally, read ahead can only offer benefits in single-threaded read tests (e.g., with dd on Linux). However, both access patterns are atypical in server operations. My recommendation is therefore to run SSD RAIDs without read ahead.

Quelle: https://www.admin-magazine.com/Archive/2015/28/Tuning-SSD-RAID-for-optim ...

Quelle: https://www.admin-magazine.com/Archive/2015/28/Tuning-SSD-RAID-for-optim ...

die obere Erklärung ins nur halbwegs korrekt.

Read Ahead bring keineswegs nur bei HDD's eine Vorteil sondern auch bei SSD's, aber eben nur für einen bestimmten Workload-Typ, nämlich sequentielle Lesezugriffe.

Und das war es dann auch schon, bei allen anderen Workloads und insbesondere bei Random-Access, bringt dieses Feature jedoch nur Nachteile, das es ständig den Cache mit nicht benötigten Daten vorbefüllt. Dadurch wird der Cache selbst mehr als nötig Belastet und auch die Datenträger müssen viel mehr Daten auslesen, als eigentlich vom darüberliegenden System angefragt wird.

Für die meisten Anwendungsfälle und insbesondere bei Datenbanken ist dieses Feature einfach nur Gift.

Beste Grüsse aus BaWü

Alex

Zitat von @MysticFoxDE:

IOMeter kann ich ebenfalls nur empfehlen, aber das Ding muss man auch bedienen und die Werte richtig interpretieren können.

Was das Multithreading angeht, ja bei vielen Benutzern ist eine hohe Multithread-Performance auch wichtig, aber was den einzelnen Benutzer angeht, so ist für diesen die Singlethread-Performance dennoch meist viel wichtiger.

Zitat von @2423392070:

Das bedeutet, dass du keine Erkenntnisse hast die belastbar sind.

IOMeter sollte mindestens 16 Threads, eher 32 oder 64 machen, die dem Reallife-Verhalten entsprechen.

Nach der Erkenntnis kannst du IOMeter dann so einstellen, dass es das Reallife mit Druck dem Storage abverlangt und dann kannst du das Optimum suchen, finden und bewerten.

Das bedeutet, dass du keine Erkenntnisse hast die belastbar sind.

IOMeter sollte mindestens 16 Threads, eher 32 oder 64 machen, die dem Reallife-Verhalten entsprechen.

Nach der Erkenntnis kannst du IOMeter dann so einstellen, dass es das Reallife mit Druck dem Storage abverlangt und dann kannst du das Optimum suchen, finden und bewerten.

IOMeter kann ich ebenfalls nur empfehlen, aber das Ding muss man auch bedienen und die Werte richtig interpretieren können.

Was das Multithreading angeht, ja bei vielen Benutzern ist eine hohe Multithread-Performance auch wichtig, aber was den einzelnen Benutzer angeht, so ist für diesen die Singlethread-Performance dennoch meist viel wichtiger.

Es sollen Threads sein, die die Warteschlangen des Storage in Arbeit darstellen. Bei ESXI oder Hyper-Pfau auch Queue genannt.

Ein SAS Laufwerk kann 256 und der Treiber arbeitet auch damit.

Es ist sinnbefreit ein Tool laufen zu lassen, dass das RAID nicht auf diesen Umstand untersucht.

Zitat von @MysticFoxDE:

Das ist keineswegs nutzloses Schwurbeln, sondern wertvolle Arbeit um die Funktionsweise und auch die Leistungsfähigkeit seines Systems selbst besser zu verstehen.

Ähm doch und nicht nur die, sondern auch die SAN's & Co.

Das letzte SAN das unser Haus verlassen hat, hatte 128G Cache per Controller und das obwohl es ein All-Flash ist.🤪Flash ist Flash und RAM ist eben RAM und das letztere davon ist eben immer noch viel schneller. 😉

Zitat von @2423392070:

Ich habe dir mitgeteilt, dass deine Benchmark oder anders formuliert Richtwerte keine Aussagekraft haben.

Schwurbeln mit sinnfreien Tools und füttern von Tabellen soll was bewirken?

Ich habe dir mitgeteilt, dass deine Benchmark oder anders formuliert Richtwerte keine Aussagekraft haben.

Schwurbeln mit sinnfreien Tools und füttern von Tabellen soll was bewirken?

Das ist keineswegs nutzloses Schwurbeln, sondern wertvolle Arbeit um die Funktionsweise und auch die Leistungsfähigkeit seines Systems selbst besser zu verstehen.

Dein Tool hat fast ausschließlich den Cache bedient und davon gelebt.

Übrigens arbeitet kein Server so, außer ein solches Tool läuft.

Übrigens arbeitet kein Server so, außer ein solches Tool läuft.

Ähm doch und nicht nur die, sondern auch die SAN's & Co.

Das letzte SAN das unser Haus verlassen hat, hatte 128G Cache per Controller und das obwohl es ein All-Flash ist.🤪Flash ist Flash und RAM ist eben RAM und das letztere davon ist eben immer noch viel schneller. 😉

Das kann man nicht vergleichen.

Die Hosts die die LUNs halten sehen nicht, egal was in den Treiber eingestellt ist, dass die LUNs im Storage hinter dicken Cache liegen. Etwas anders ist das bei NVME over Fabric LUNs, da sind die LUNs mit der CPU direkt verbunden.

Windows weiß von dem Cache des Controllers und der Laufwerke und verhält sich entsprechend des Treibers. Daher ist die "Tiefe der Warteschlange" hin und wieder zu überprüfen und zu optimieren.

Moin unbelanglos,

die Materie mit den Queues ist mir durchaus bekannt.

In der heutigen Zeit und vor allem Dank des blöden RAM-Block-Cache des OS (vor allem bei Microsoft), landet ein Grossteil der IO's leider in diesem Cache und wird dort schlichtweg sequentialisiert. 🤢

Und beim Hyper-Pfau pfuscht eventuell auch noch der CSV-Cache (reiner Lesecache) dazwischen. 🤮

Diese Aussage ist so leider nicht korrekt.

Genau so wie die direkt angebundenen HDD's oder SSD's sollten auch die LUN's eines SAN's dem angebundenen Host sehr wohl mitteilen ob diese gecacht sind oder nicht.

Und auch hier pfuscht dir der angesprochene OS RAM-Block-Cache (bei Windows ist das Modified- & Standby Memory) leider dazwischen.

Ja, das war gestern.

Heute versucht Windows so gut wie alles über den Host-RAM zu schieben um ja nicht zu viele IO's auf dem Storage selbst zu erzeugen. Könnte ja gut sein, dass darunter ein S2D liegt und dieses mag zu viele (direct) IO's überhaupt nicht. 😉

Beste Grüsse aus BaWü

Alex

P.S. Der Hyper-Pfau gibt übrigens sämtlichen Write-IO der VM's als "write through" an die LUN's weiter und umgeht

damit meistens den Write-Cache der SAN's. 🤮🤮🤮

Es sollen Threads sein, die die Warteschlangen des Storage in Arbeit darstellen. Bei ESXI oder Hyper-Pfau auch Queue genannt.

Ein SAS Laufwerk kann 256 und der Treiber arbeitet auch damit.

Ein SAS Laufwerk kann 256 und der Treiber arbeitet auch damit.

die Materie mit den Queues ist mir durchaus bekannt.

In der heutigen Zeit und vor allem Dank des blöden RAM-Block-Cache des OS (vor allem bei Microsoft), landet ein Grossteil der IO's leider in diesem Cache und wird dort schlichtweg sequentialisiert. 🤢

Und beim Hyper-Pfau pfuscht eventuell auch noch der CSV-Cache (reiner Lesecache) dazwischen. 🤮

Die Hosts die die LUNs halten sehen nicht, egal was in den Treiber eingestellt ist, dass die LUNs im Storage hinter dicken Cache liegen.

Diese Aussage ist so leider nicht korrekt.

Genau so wie die direkt angebundenen HDD's oder SSD's sollten auch die LUN's eines SAN's dem angebundenen Host sehr wohl mitteilen ob diese gecacht sind oder nicht.

Etwas anders ist das bei NVME over Fabric LUNs, da sind die LUNs mit der CPU direkt verbunden.

Und auch hier pfuscht dir der angesprochene OS RAM-Block-Cache (bei Windows ist das Modified- & Standby Memory) leider dazwischen.

Windows weiß von dem Cache des Controllers und der Laufwerke und verhält sich entsprechend des Treibers. Daher ist die "Tiefe der Warteschlange" hin und wieder zu überprüfen und zu optimieren.

Ja, das war gestern.

Heute versucht Windows so gut wie alles über den Host-RAM zu schieben um ja nicht zu viele IO's auf dem Storage selbst zu erzeugen. Könnte ja gut sein, dass darunter ein S2D liegt und dieses mag zu viele (direct) IO's überhaupt nicht. 😉

Beste Grüsse aus BaWü

Alex

P.S. Der Hyper-Pfau gibt übrigens sämtlichen Write-IO der VM's als "write through" an die LUN's weiter und umgeht

damit meistens den Write-Cache der SAN's. 🤮🤮🤮