NVIDIA L40S - Die erste Erfahrung ist etwas bescheiden

Moin Zusammen,

diese Woche sind bei uns für ein Kundenprojekt 4 neue Server für ein Hyper-V Cluster eingetrudelt, in denen je eine NVIDIA L40S, sprich, eine GPU der 10K Klasse verbaut ist.

Und natürlich wollte ich als Erstes mal wissen, was die GPU so alles draufhat, vor allem nachdem NVIDIA selbst auf der Produkthomepage das folgende schreibt …

nvidia.com/de-de/data-center/l40s/

„Der leistungsstärkste Universal-Grafikprozessor“

+

„Der L40S-Grafikprozessor vereint leistungsstarke KI-Rechenleistung und erstklassige Grafik- und Medienbeschleunigung“

Daher habe ich gestern früh einen der Server schon mal ausgepackt, habe Server 2022 und sämtliche benötigten Treiber drauf geschmissen, habe die GPU mit der „displaymodeselector.exe“ in den „gpumode“ und auch die Treiber noch geschwind mit „nvidia-smi.exe“ auf WDDM umgestellt und schon war dem Gerättle für den ersten Test fertig.

Sprich, als nächstes habe ich den Passmark Performance Test drauf geschmissen und alle Tests mal laufen lassen.

Als erstes kam der CPU Test und die Ergebnisse dieses sahen dank der beiden in dem Server verbauten INTEL Xeon Gold 6544Y schon mal nicht schlecht aus und als nächstes waren auch schon die 2D Tests dran und als ich die Ergebnisse der ersten gesehen habe … habe ich die Idee mit der Schampus-Flasche leider gleich wieder verwerfen müssen und bin statt dessen an meine Workstation gegangen und habe auf dieser ebenfalls den Passmarkt Performance Test angeschmissen, weil ich das was ich bei dem neuen und mit einer L40S bestückten Server an Ergebnissen zu sehen bekommen habe, nicht wirklich glauben konnte. 😬

Bevor ich jedoch zu den Ergebnissen selbst komme, folgend noch ein paar wesentliche Details, sowohl zu einem der neuen Server als auch zu meiner etwas älteren, aber noch nach wie vor ganz flinken Workstation.

Workstation:

CPU --> i9-9820X

RAM --> 128 GB

GPU --> NVIDIA RTX 2080 Ti

Server:

CPU --> 2 x INTEL Xeon Gold 6544Y

RAM --> 1,5 TB

GPU --> NVIDIA L40S

Von der Hardware gesehen, ist meine ältere Workstation der neuen Serverhardware somit in jeglicher Hinsicht absolut hoffnungslos unterlegen.

Daher hat es mich auch sehr gewundert, als ich bei den Grafiktests auf einem der neuen Server die folgenden Ergebnisse zu sehen bekommen habe.

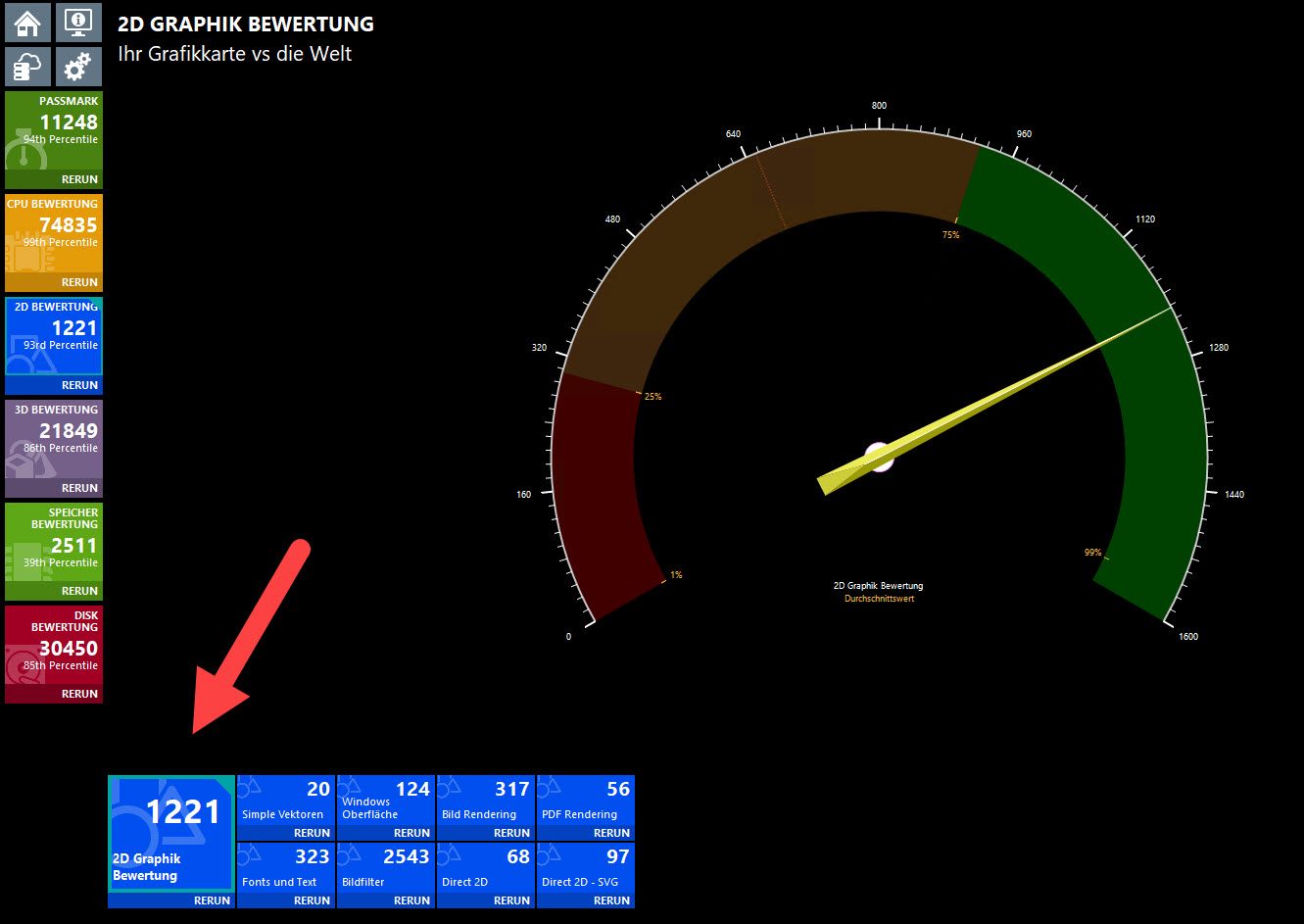

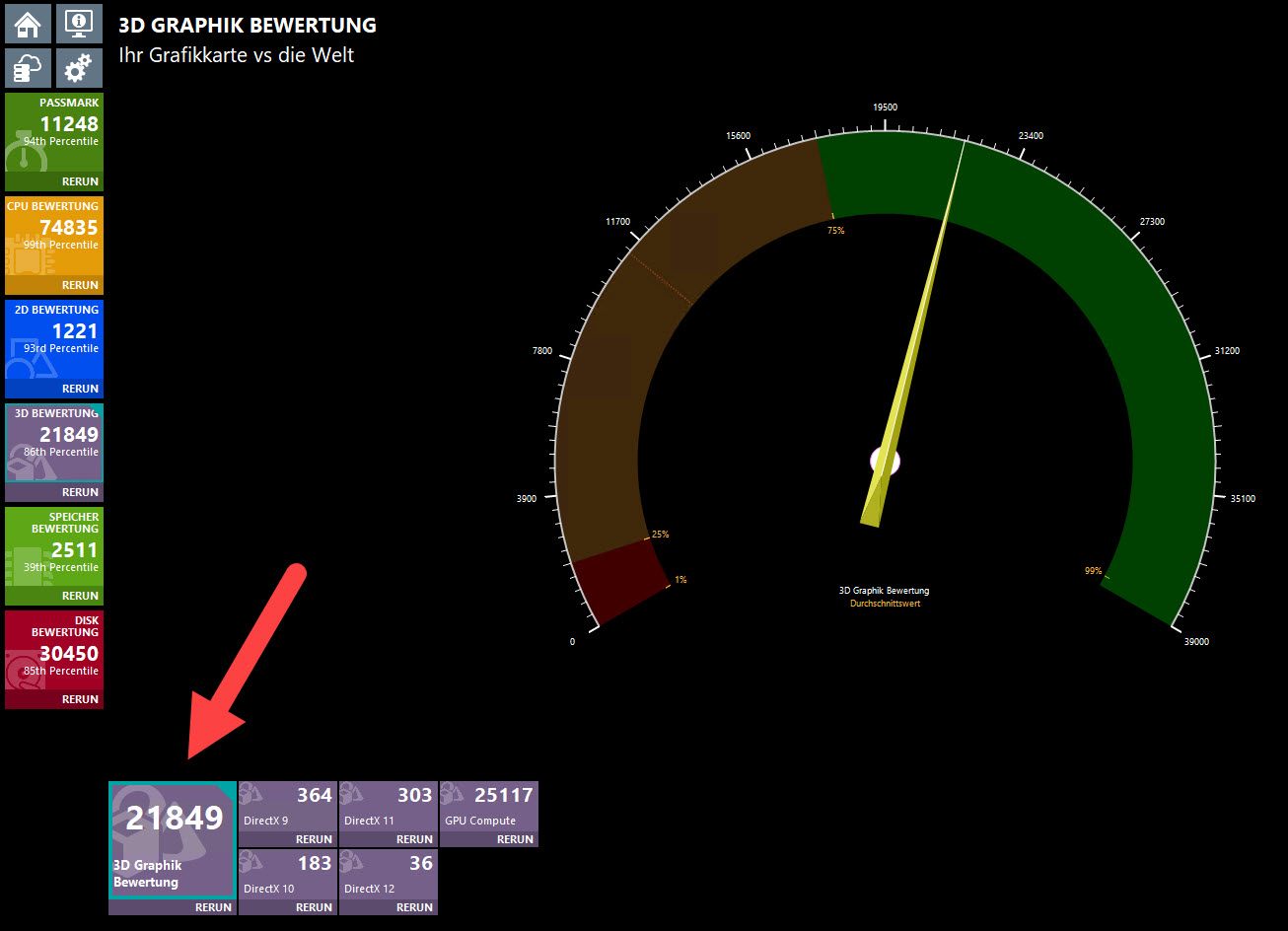

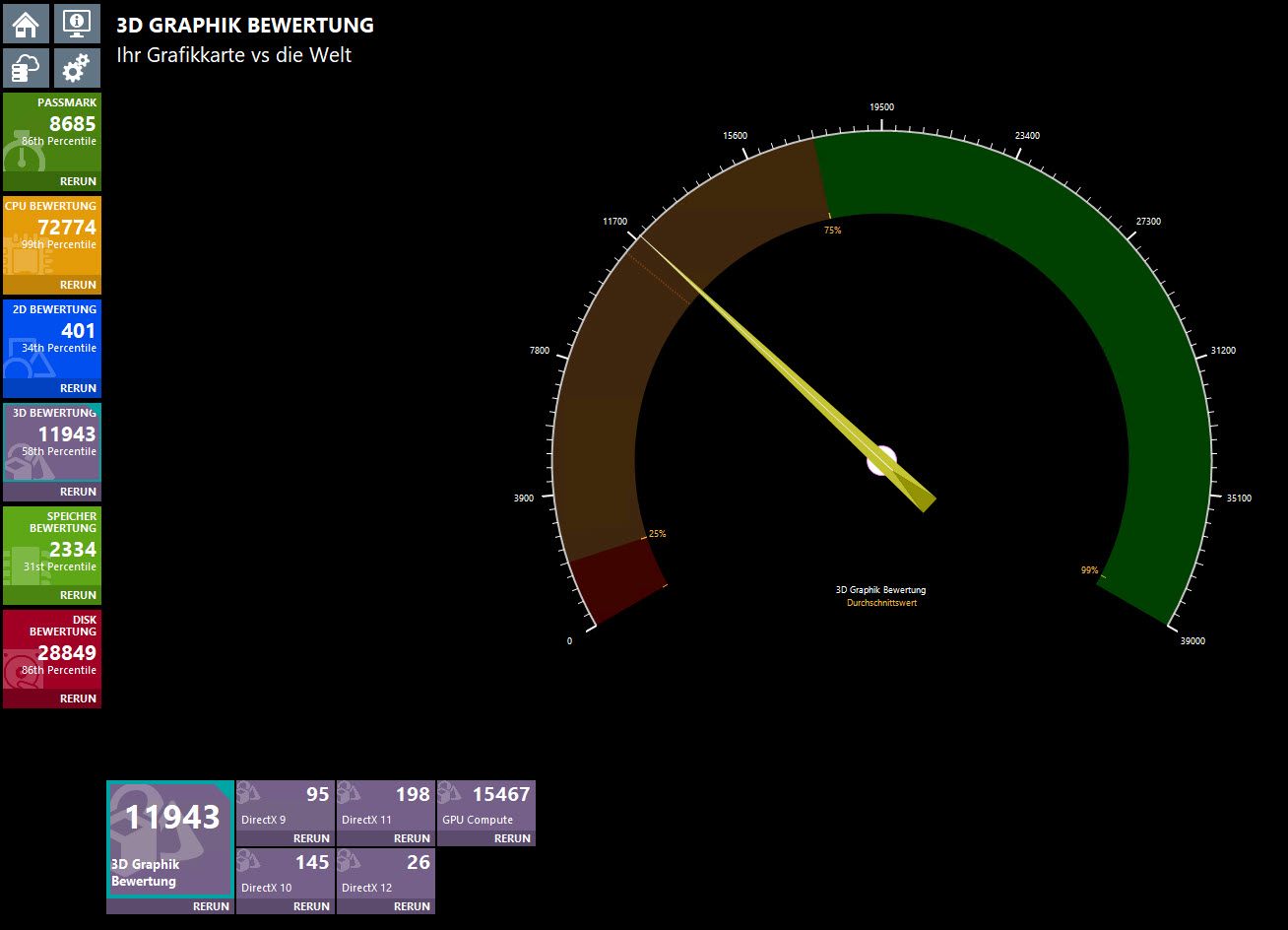

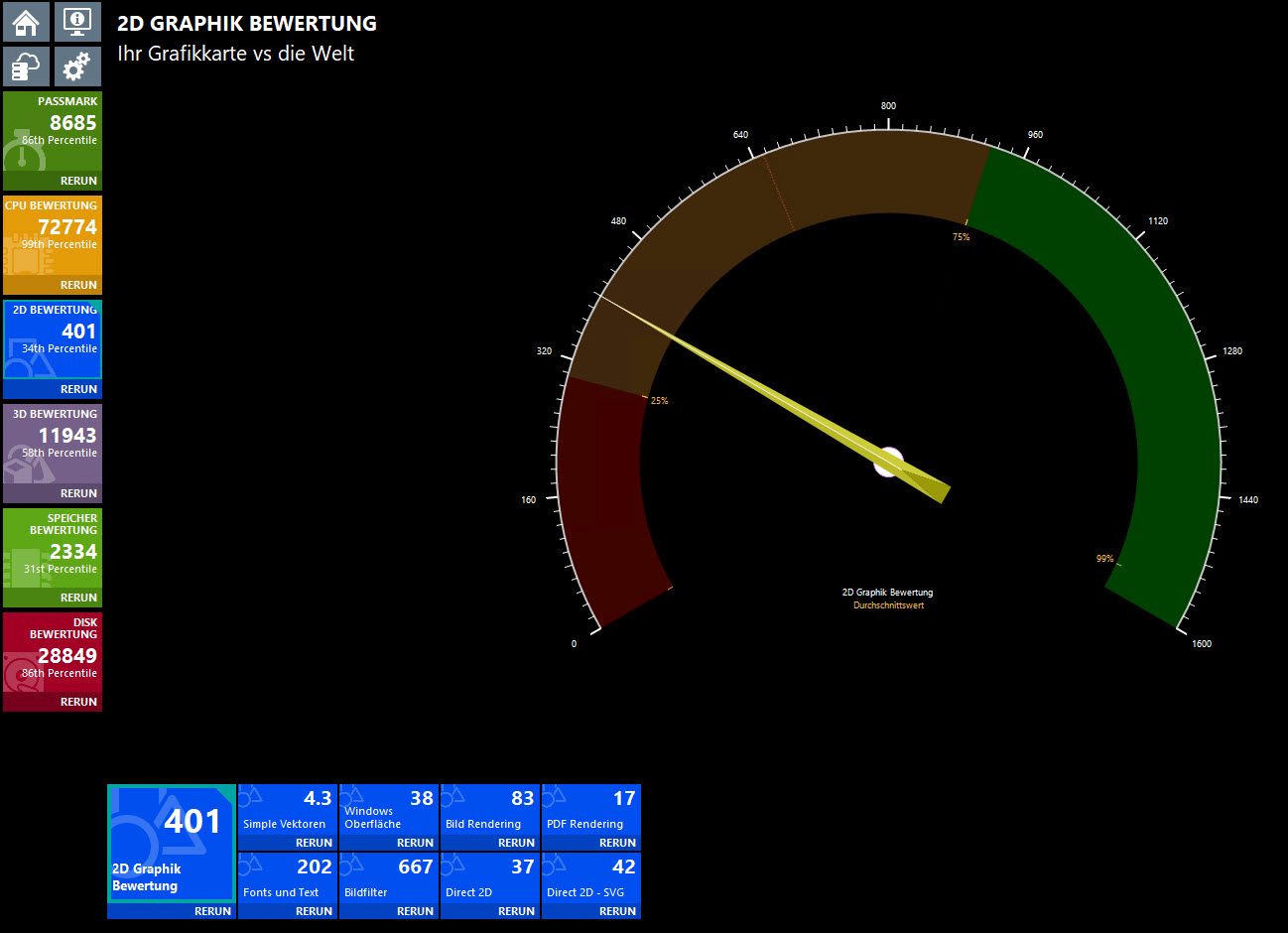

2D:

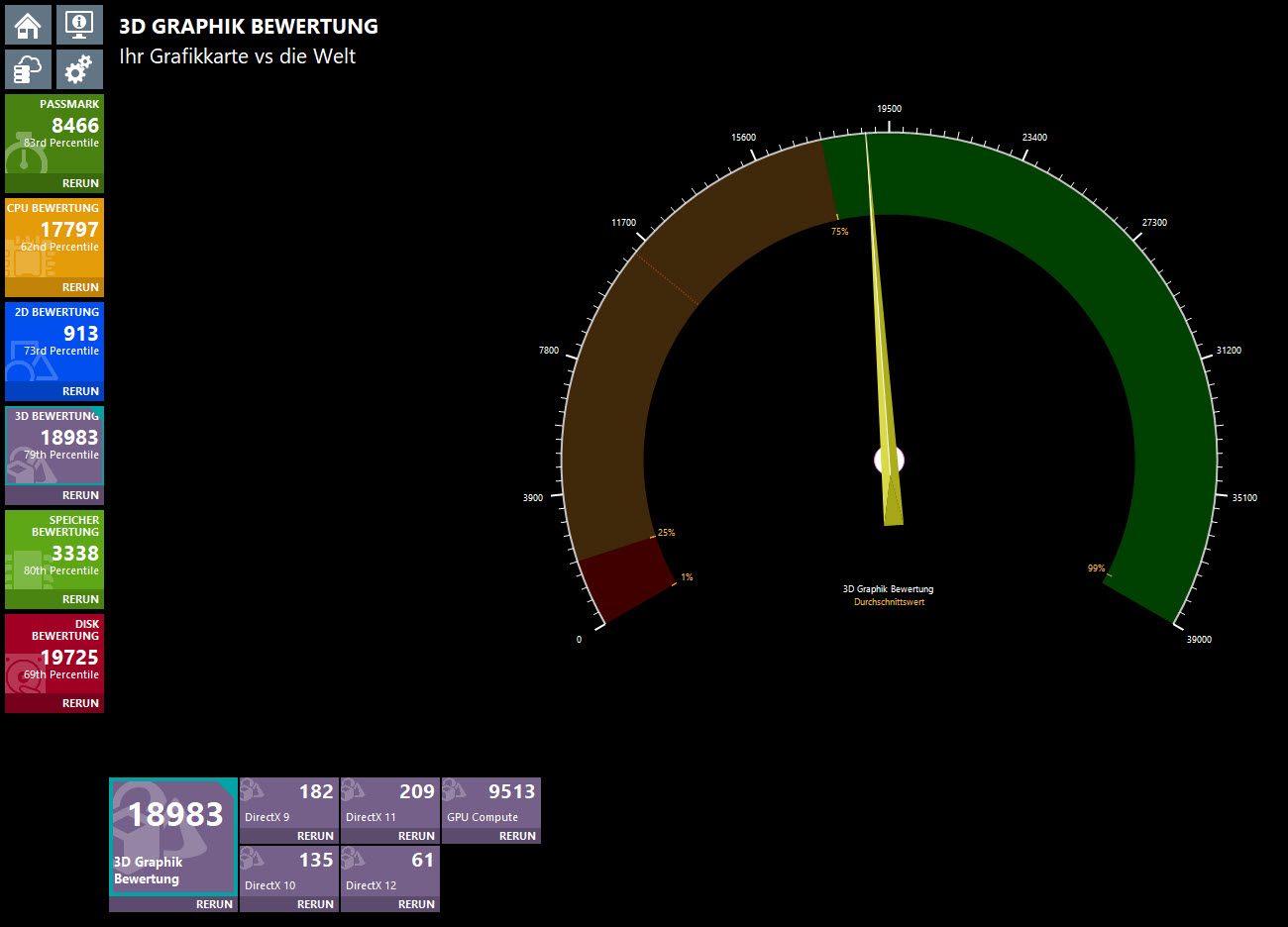

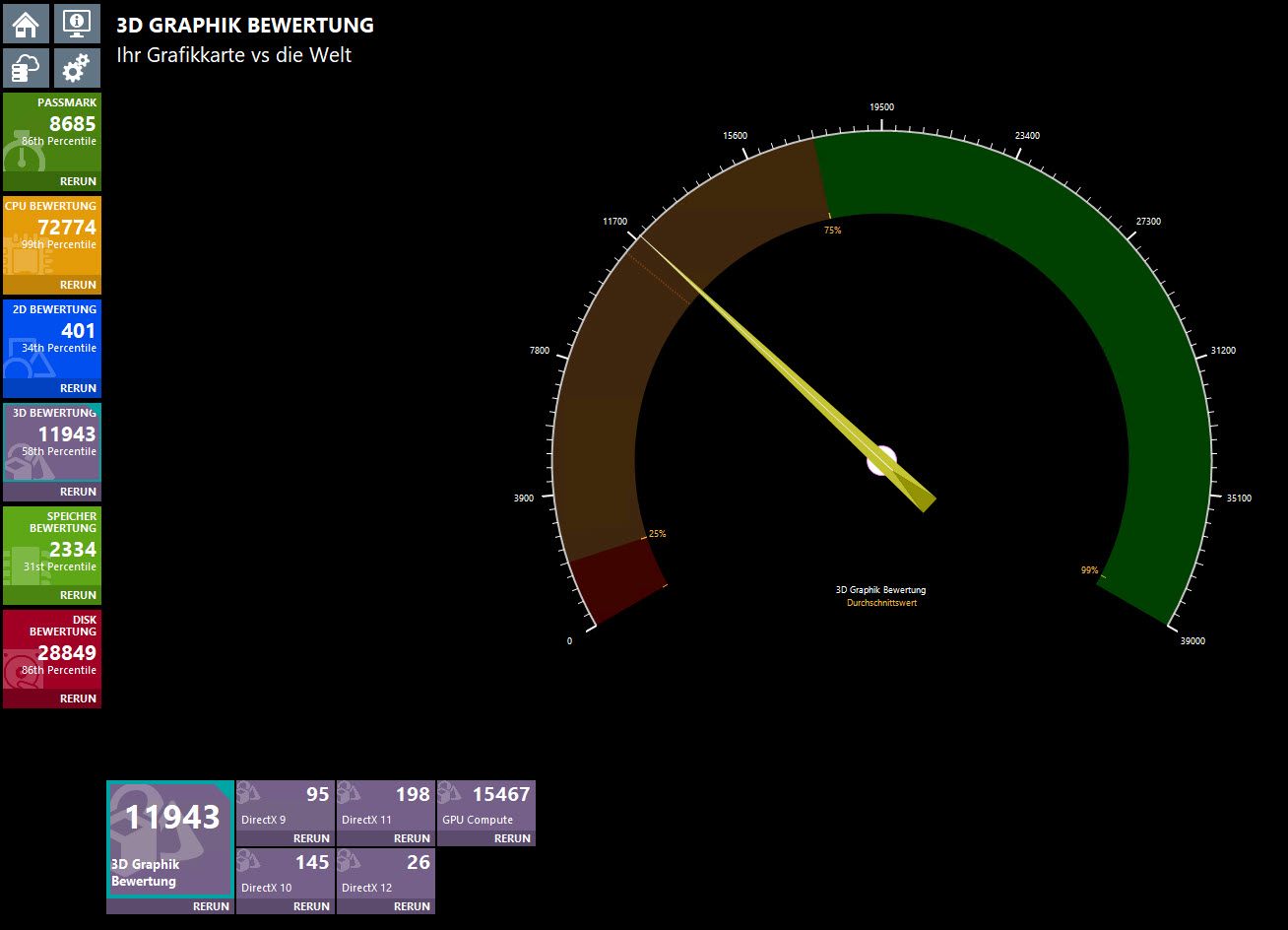

3D:

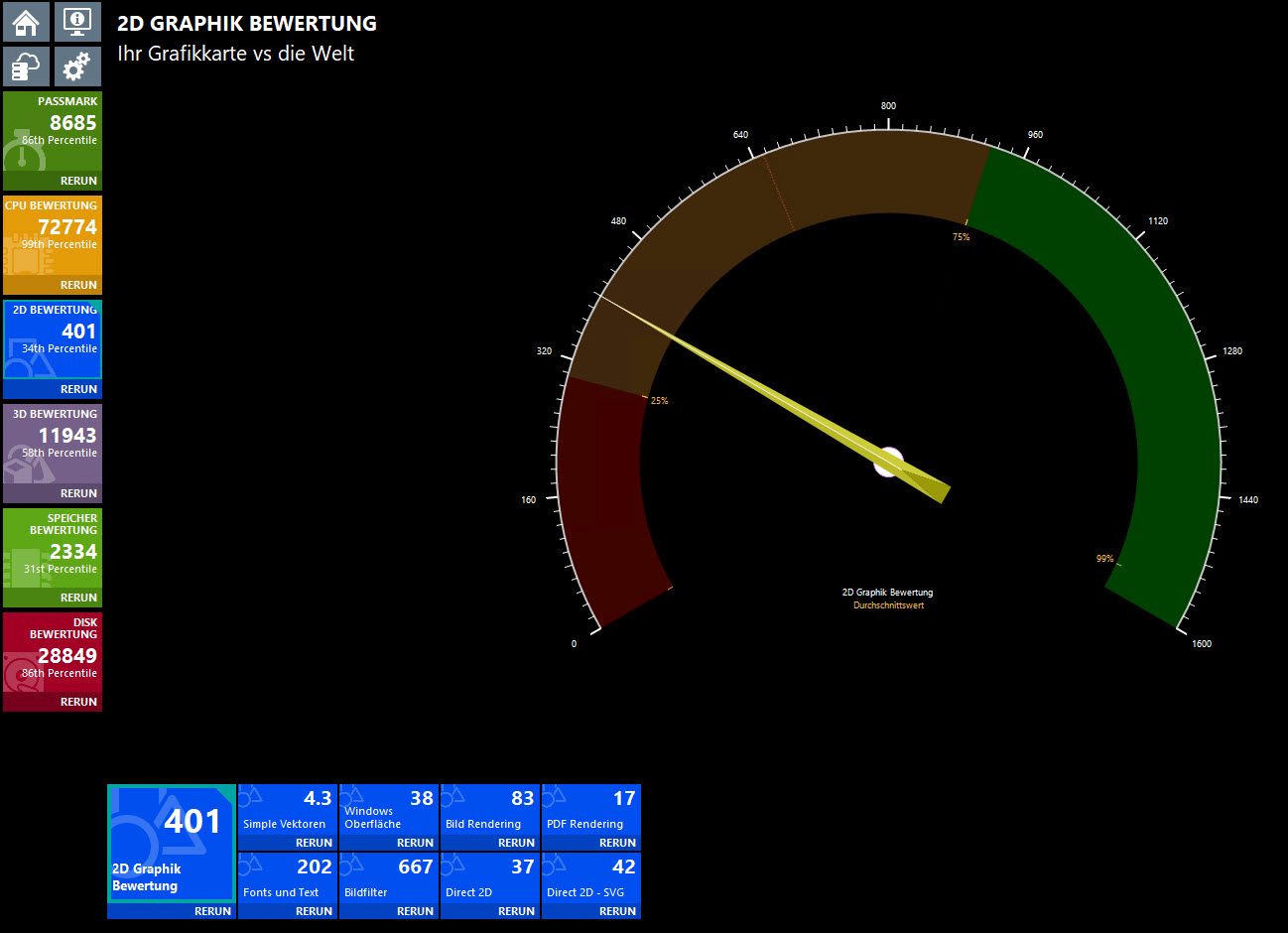

Und hier zum Vergleich die Bewertung der RTX 2080 Ti in meiner Workstation.

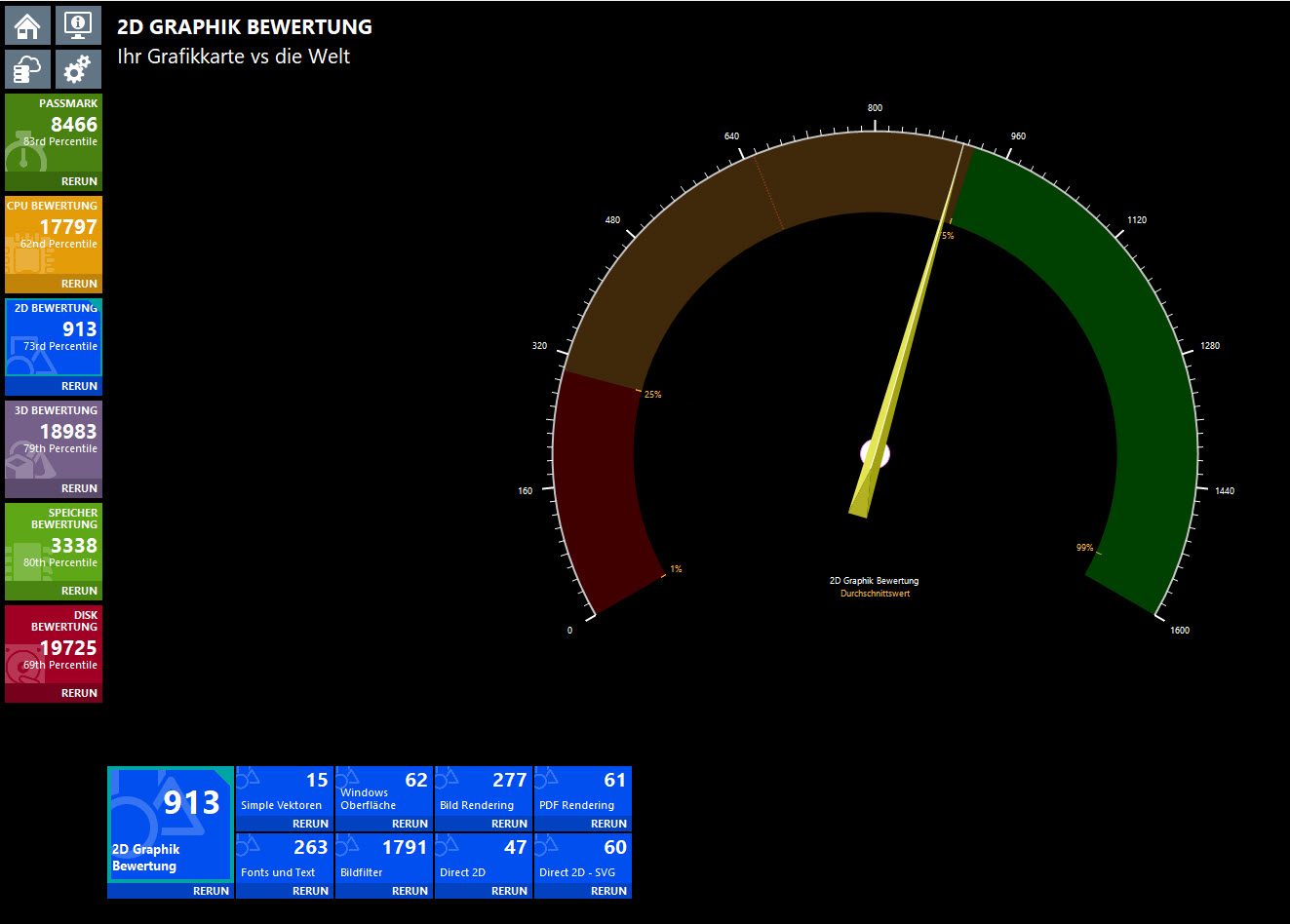

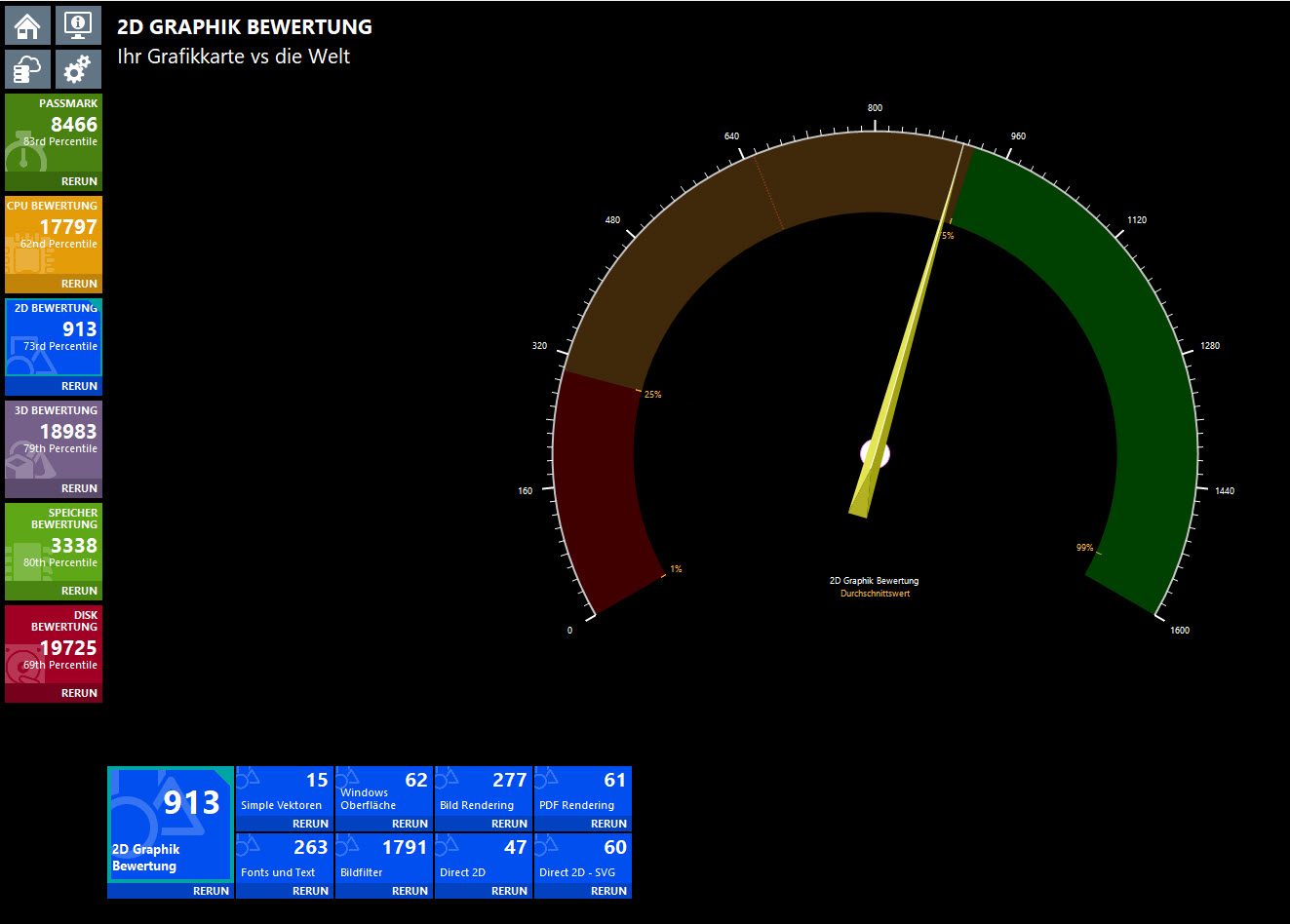

2D:

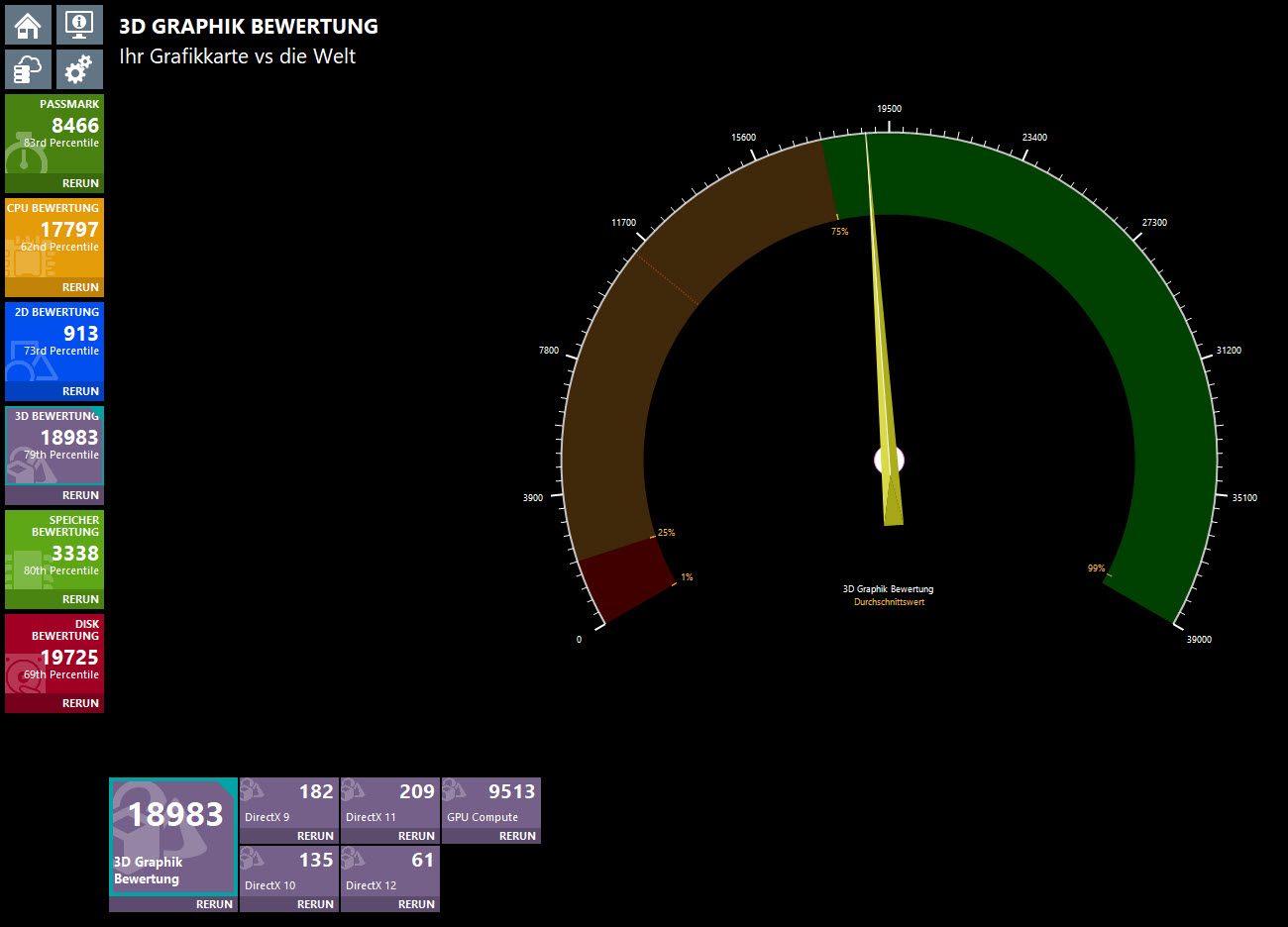

3D:

(Und nein, die Screenshots/Ergebnisse sind nicht vertauscht. 🙃)

(Und nein, die Screenshots/Ergebnisse sind nicht vertauscht. 🙃)

Wie ihr sehen könnt, hat die L40S gerade mal bei zwei Tests, dem „GPU Compute“ und dem „DirectX 12“ die Oberhand und bei allen anderen, ist sie der älteren und viel viel günstigeren RTX 2080 Ti, jedoch zum Teil extrem unterlegen. 😖

Nun zu den Fragen an die Runde:

Habe ich damit, dass eine L40S eine etwas bessere Grafikleistung bringen sollte, irgendwie eine falsche Erwartungshaltung?

Die RTX 2080 Ti ist immerhin schon etwa 5 Jahre alt und hat auch nur einen Bruchteil der L40S gekostet.

Habe ich noch irgendwo vielleicht eine wesentliche Handbremse übersehen?

Kann es sein, dass die L40S im „gpumode“ nur mit einem Bruchteil ihrer Ressourcen läuft?

Gruss Alex

diese Woche sind bei uns für ein Kundenprojekt 4 neue Server für ein Hyper-V Cluster eingetrudelt, in denen je eine NVIDIA L40S, sprich, eine GPU der 10K Klasse verbaut ist.

Und natürlich wollte ich als Erstes mal wissen, was die GPU so alles draufhat, vor allem nachdem NVIDIA selbst auf der Produkthomepage das folgende schreibt …

nvidia.com/de-de/data-center/l40s/

„Der leistungsstärkste Universal-Grafikprozessor“

+

„Der L40S-Grafikprozessor vereint leistungsstarke KI-Rechenleistung und erstklassige Grafik- und Medienbeschleunigung“

Daher habe ich gestern früh einen der Server schon mal ausgepackt, habe Server 2022 und sämtliche benötigten Treiber drauf geschmissen, habe die GPU mit der „displaymodeselector.exe“ in den „gpumode“ und auch die Treiber noch geschwind mit „nvidia-smi.exe“ auf WDDM umgestellt und schon war dem Gerättle für den ersten Test fertig.

Sprich, als nächstes habe ich den Passmark Performance Test drauf geschmissen und alle Tests mal laufen lassen.

Als erstes kam der CPU Test und die Ergebnisse dieses sahen dank der beiden in dem Server verbauten INTEL Xeon Gold 6544Y schon mal nicht schlecht aus und als nächstes waren auch schon die 2D Tests dran und als ich die Ergebnisse der ersten gesehen habe … habe ich die Idee mit der Schampus-Flasche leider gleich wieder verwerfen müssen und bin statt dessen an meine Workstation gegangen und habe auf dieser ebenfalls den Passmarkt Performance Test angeschmissen, weil ich das was ich bei dem neuen und mit einer L40S bestückten Server an Ergebnissen zu sehen bekommen habe, nicht wirklich glauben konnte. 😬

Bevor ich jedoch zu den Ergebnissen selbst komme, folgend noch ein paar wesentliche Details, sowohl zu einem der neuen Server als auch zu meiner etwas älteren, aber noch nach wie vor ganz flinken Workstation.

Workstation:

CPU --> i9-9820X

RAM --> 128 GB

GPU --> NVIDIA RTX 2080 Ti

Server:

CPU --> 2 x INTEL Xeon Gold 6544Y

RAM --> 1,5 TB

GPU --> NVIDIA L40S

Von der Hardware gesehen, ist meine ältere Workstation der neuen Serverhardware somit in jeglicher Hinsicht absolut hoffnungslos unterlegen.

Daher hat es mich auch sehr gewundert, als ich bei den Grafiktests auf einem der neuen Server die folgenden Ergebnisse zu sehen bekommen habe.

2D:

3D:

Und hier zum Vergleich die Bewertung der RTX 2080 Ti in meiner Workstation.

2D:

3D:

Wie ihr sehen könnt, hat die L40S gerade mal bei zwei Tests, dem „GPU Compute“ und dem „DirectX 12“ die Oberhand und bei allen anderen, ist sie der älteren und viel viel günstigeren RTX 2080 Ti, jedoch zum Teil extrem unterlegen. 😖

Nun zu den Fragen an die Runde:

Habe ich damit, dass eine L40S eine etwas bessere Grafikleistung bringen sollte, irgendwie eine falsche Erwartungshaltung?

Die RTX 2080 Ti ist immerhin schon etwa 5 Jahre alt und hat auch nur einen Bruchteil der L40S gekostet.

Habe ich noch irgendwo vielleicht eine wesentliche Handbremse übersehen?

Kann es sein, dass die L40S im „gpumode“ nur mit einem Bruchteil ihrer Ressourcen läuft?

Gruss Alex

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 73401773944

Url: https://administrator.de/forum/nvidia-l40s-die-erste-erfahrung-ist-etwas-bescheiden-73401773944.html

Ausgedruckt am: 18.07.2025 um 09:07 Uhr

10 Kommentare

Neuester Kommentar

Ich weiß nicht, was und wie der Benchmark genau misst. Aber du kannst dir mal "Mandelbulber" besorgen und 3D-Fraktale in schön hoher Auflösung mit allen möglichen Effekten aktiviert rendern lassen — dann siehst du wahrscheinlich deutlichere Unterschiede (du musst allerdings händisch in den Einstellungen CUDA explizit aktivieren).

Zitat von @MysticFoxDE:

Moin @schwob93,

das was ich bisher schon verändert habe, kann ich dir und auch allen anderen natürlich schon verraten.

OS Technisch:

Energiesparplan von Ausbalanciert auf Höchstleistung geändert.

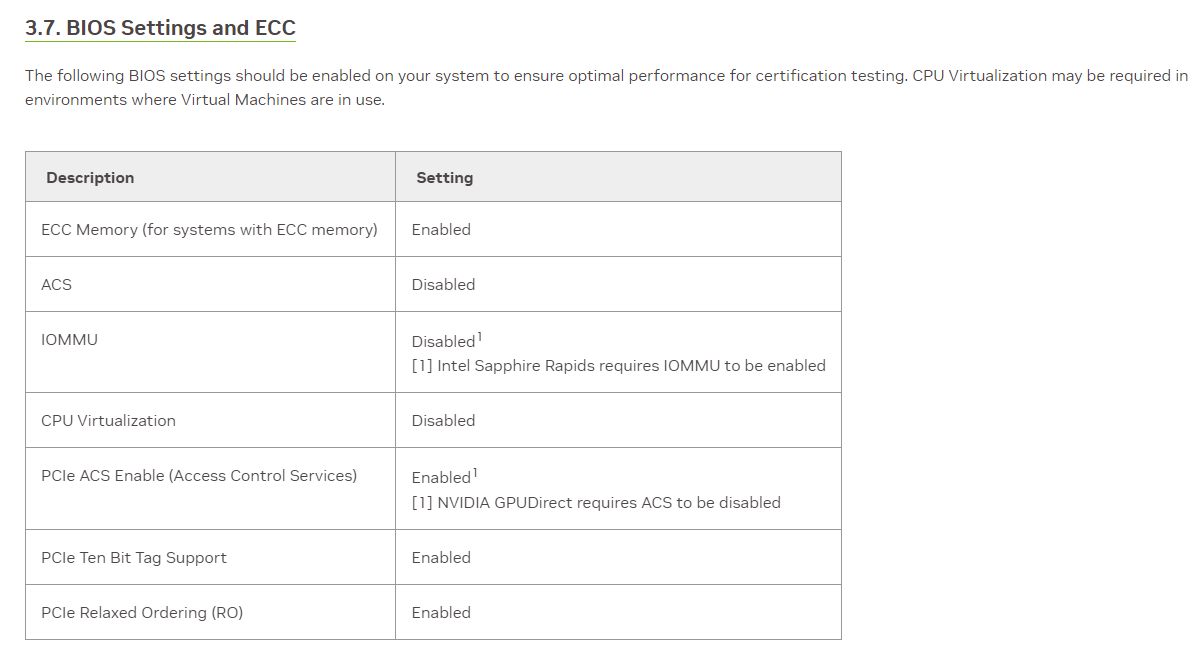

BIOS Technisch:

C6 State - deaktiviert

C1E State - deaktiviert

Package C State auf C0/C1 eingestellt

PP Tuning - auf BIOS umgestellt

CFG Mode - auf "Performance" gestellt

Das war bisher glaube ich das Gröbste, ich bin jedoch noch nicht gang fertig. 😔

Übrigens, die Einstellungen können je nach Serverhersteller etwas unterschiedlich heissen. 😬

Welche Server bekommst du den genau?

Gruss Alex

Moin @schwob93,

Kannst du beschreiben was du geändert hast, nächste Woche sollen meine bestellten Server auch mit NVIDIA GPU kommen.

das was ich bisher schon verändert habe, kann ich dir und auch allen anderen natürlich schon verraten.

OS Technisch:

Energiesparplan von Ausbalanciert auf Höchstleistung geändert.

BIOS Technisch:

C6 State - deaktiviert

C1E State - deaktiviert

Package C State auf C0/C1 eingestellt

PP Tuning - auf BIOS umgestellt

CFG Mode - auf "Performance" gestellt

Das war bisher glaube ich das Gröbste, ich bin jedoch noch nicht gang fertig. 😔

Übrigens, die Einstellungen können je nach Serverhersteller etwas unterschiedlich heissen. 😬

Welche Server bekommst du den genau?

Gruss Alex

Nächste Woche müsste der kleine Lenovo SR630v3 mit a2 oder l4 kommen, ich kann’s leider nicht mehr genau sagen.

Das wird ein hart installierter 2022 RDS, bin ich mal gespannt wie die Performance ist aber ich hab ja nun ein paar Anhaltspunkte, vielen Dank.

Die HyperV Cluster habe ich bisher immer ohne GPU gemacht, wie reichst du die GPU über HyperV durch? Ich war bis jetzt auf dem stand, soll erst mit Hyp2025 richtig gehen, daher hab ich hier immer esx mit NVIDIA Grid eingesetzt.