VMWare gemeinsamer Zugriff auf ISCSI Storage?

Frage zum gleichzeitigen Zugriff in einer VMWare Umgebung auf ein ISCSI Storage?

Hallo Leute,

Da die Virtualisierung ja heute nichts neues mehr ist, denkt unsere Geschäftsleitung auch über den Einsatz der Art Lösung unter Verwendung von VMWare nach. Wir haben also die Aufgabe bekommen uns vorab kundig zu machen und die eventuelle Umsetzung zu planen. Ich hoffe dass mir Admins mit recht guter Erfahrung aus diesem Bereich vielleicht behilflich sein können. Da Fibre Channel Komponenten doch sehr kontenintensiv sind ziehen wir den Einsatz von ISCSI in Erwägung. Wir denken da über einen Linux Server mit einem Raid HBA von Adaptec und zwei 10Gbit Netzwerkkarten, welcher als gemeinsames Storage dienen soll nach. Dieser soll über zwei Switche mit 10Gbit Ports redundant (MPIO) mit zwei VMWare Servern von Dell im VM Cluster betrieben werden.

Wir haben die Möglichkeit mit abgespeckten Komponenten das geplante Szenario aufzubauen. Leider sind wir bei unserer Vorüberlegung auf den Punkt "ISCSI und gemeinsamer Zugriff" gestoßen. Angenommen wir verwenden auf dem geplantem Storage ein Target mit einer großen LUN. Welche LUN Aufteilung in Bezug auf Lasteinbüßen sind zu erwarten, wer hat da Erfahrungen?

Können überhaupt mehrere VM Gäste gleichzeitig auf die gleiche LUN zugreifen? Bei einem NTFS basierenden Filesystem kann ja nur mittels eines Cluster FS gleichzeitig auf eine ISCSI LUN zugegriffen werden, da regelt das Cluster FS darunter den Zugriff.

Wie sieht es jedoch mit dem VMWare Dateisystem vmfs aus? Gelten hier ähnliche Beschränkungen?

Wer kann Empfehlungen zur I/O Last pro VM Gast bei der Verwendung von 15K HDD´s geben? Wie ist der Bezug des Lastverhalten zum gewählten Raid Level?

Im Einsatz sind momentan ~10 physische Server unter anderem Exchange, MS SQL, Oracle und der Rest normale Windows Server 2003 und 2008. Wer hat Erfahrungen und kann mit Tips behilflich sein was eventuell von bestimmten Systemen in einer VM absieht.

Welche Tips könnt ihr zum Thema Backups geben, wir forcieren momentan das Veeam Backup. Wie oder welchen Storageteil sollte man für die Backups verwenden. Sollte man dafür eine extra LUN erstellen?

Externe Geräte für die Sicherung wie Netapp´s etc. sind uns dann schon zu teuer, wir möchten das Storage dafür nutzen. Das Thema Multipathing befremdet uns auch noch etwas, wir wissen zwar wie es in der Theorie funktioniert jedoch die Praxis fehlt uns bislang.

Muss für die redundante Anbindung des Storage und der VMWare Server für jeden Pfad ein eigenes Subnetz verwendet werden. Und wenn uns bitte jemand mal diese VMkernel Geschichte etwas näher erläutern kann wäre super. Wir sollten wir die Netzwerkanbindung (VMWare Gäste, VMkernel, VMotion, ISCSI u.s.w) Netzwerktechnisch trennen (erstellen)?

Sollten vSwitche verwendet werden?

Es wäre wirklich toll wenn uns jemand mit Erfahrung aus diesem Bereich nützliche Tips geben könnte. Eventuell ein paar Bilder oder Links zur Veranschaulichung/Verdeutlichung wären sehr hilfreich.

Danke

Hallo Leute,

Da die Virtualisierung ja heute nichts neues mehr ist, denkt unsere Geschäftsleitung auch über den Einsatz der Art Lösung unter Verwendung von VMWare nach. Wir haben also die Aufgabe bekommen uns vorab kundig zu machen und die eventuelle Umsetzung zu planen. Ich hoffe dass mir Admins mit recht guter Erfahrung aus diesem Bereich vielleicht behilflich sein können. Da Fibre Channel Komponenten doch sehr kontenintensiv sind ziehen wir den Einsatz von ISCSI in Erwägung. Wir denken da über einen Linux Server mit einem Raid HBA von Adaptec und zwei 10Gbit Netzwerkkarten, welcher als gemeinsames Storage dienen soll nach. Dieser soll über zwei Switche mit 10Gbit Ports redundant (MPIO) mit zwei VMWare Servern von Dell im VM Cluster betrieben werden.

Wir haben die Möglichkeit mit abgespeckten Komponenten das geplante Szenario aufzubauen. Leider sind wir bei unserer Vorüberlegung auf den Punkt "ISCSI und gemeinsamer Zugriff" gestoßen. Angenommen wir verwenden auf dem geplantem Storage ein Target mit einer großen LUN. Welche LUN Aufteilung in Bezug auf Lasteinbüßen sind zu erwarten, wer hat da Erfahrungen?

Können überhaupt mehrere VM Gäste gleichzeitig auf die gleiche LUN zugreifen? Bei einem NTFS basierenden Filesystem kann ja nur mittels eines Cluster FS gleichzeitig auf eine ISCSI LUN zugegriffen werden, da regelt das Cluster FS darunter den Zugriff.

Wie sieht es jedoch mit dem VMWare Dateisystem vmfs aus? Gelten hier ähnliche Beschränkungen?

Wer kann Empfehlungen zur I/O Last pro VM Gast bei der Verwendung von 15K HDD´s geben? Wie ist der Bezug des Lastverhalten zum gewählten Raid Level?

Im Einsatz sind momentan ~10 physische Server unter anderem Exchange, MS SQL, Oracle und der Rest normale Windows Server 2003 und 2008. Wer hat Erfahrungen und kann mit Tips behilflich sein was eventuell von bestimmten Systemen in einer VM absieht.

Welche Tips könnt ihr zum Thema Backups geben, wir forcieren momentan das Veeam Backup. Wie oder welchen Storageteil sollte man für die Backups verwenden. Sollte man dafür eine extra LUN erstellen?

Externe Geräte für die Sicherung wie Netapp´s etc. sind uns dann schon zu teuer, wir möchten das Storage dafür nutzen. Das Thema Multipathing befremdet uns auch noch etwas, wir wissen zwar wie es in der Theorie funktioniert jedoch die Praxis fehlt uns bislang.

Muss für die redundante Anbindung des Storage und der VMWare Server für jeden Pfad ein eigenes Subnetz verwendet werden. Und wenn uns bitte jemand mal diese VMkernel Geschichte etwas näher erläutern kann wäre super. Wir sollten wir die Netzwerkanbindung (VMWare Gäste, VMkernel, VMotion, ISCSI u.s.w) Netzwerktechnisch trennen (erstellen)?

Sollten vSwitche verwendet werden?

Es wäre wirklich toll wenn uns jemand mit Erfahrung aus diesem Bereich nützliche Tips geben könnte. Eventuell ein paar Bilder oder Links zur Veranschaulichung/Verdeutlichung wären sehr hilfreich.

Danke

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 171673

Url: https://administrator.de/forum/vmware-gemeinsamer-zugriff-auf-iscsi-storage-171673.html

Ausgedruckt am: 21.07.2025 um 06:07 Uhr

6 Kommentare

Neuester Kommentar

Moin,

Ich würde daher 2 phy. Server nehmen mit 2x Xeon CPus, min. 32 GB RAM, 2x Festplatten â 15k im RAID 1, 2 Netzwerkkarten â 2 Ports (2x ISCSI, 2x LAN). Den RAM würde ich daran auslegen, wie viel virtuelle Serve beim Ausfall von einem phy. Server auf den anderen weiterlaufen soll.

Backups könnt ihr gerne auf eine andere LUN auf dem Storage machen. Aber bitte nachts komplett auf ein anderes System wegsichern bzw. über ein LTO5 Laufwerk. Denn was machst du wenn euer Linuxstorage abraucht?! Backup ist also auch weg!

Am Besten ihr gebt das in die Hände eines Systemhauses. Die Wissen was ihr braucht und welche Hardware/Software Sinn macht.

BTW: Ihr wollt eine VMWare ESX Umgebung mit vMotion, HA, DRS, etc... aufbauen - habt die Kohle für die VMWare Lizenzen + Wartung aber für eine Netapp 2020 mit Festplatten und Support geht euch das Geld aus. Ihr spart am falschen Ende!

Grüße,

Dani

Dieser soll über zwei Switche mit 10Gbit Ports redundant (MPIO) mit zwei VMWare Servern von Dell im VM Cluster betrieben werden.

Das ist meiner Ansicht nach ganz klar übertrieben. Weder euere "Linuxstorage" noch die Dell Server können so viel Daten lesen/schreiben. 1GBit redudant an die Dell-Server ist völlig ausreichend. Ich würde 2 Netzwerkkarten a 2 Ports verbauen. Somit hast du eine redudante Verbindung im iSCSI-Bereich. Natürlich macht das nur Sinn wenn du 2 Subnetze benutzt. Fällt ein Switch aus, gehen trotzdem keine Daten verloren. Schau also dass beide/ein Switches auf einer USV liegen, so das wirklich kein Abbruch statt findet. Kann böse enden...Wir denken da über einen Linux Server mit einem Raid HBA

Ich würde ein RAID 5 bzw. 6 empfehlen. Die Anzahl der Platten richtet sich nach der notwenigen I/O für euere 10 Server + 25% Reserver für Erweiterungen. Ich empfehle immer min. SAS Platten mit 15k.Angenommen wir verwenden auf dem geplantem Storage ein Target mit einer großen LUN. Welche LUN Aufteilung in Bezug auf Lasteinbüßen sind zu erwarten, wer hat da Erfahrungen?

Die Leistung hängt klar von vom Typ (z.B. SAS 15k) ab aber auch den Schreibleistungen der Server. Sprich es kommt primär auf Festplattenanzahl an. Die Leistung des Storagerechners spielt auch eine Rolle. Wir setzen dabei auf Netapp. Können überhaupt mehrere VM Gäste gleichzeitig auf die gleiche LUN zugreifen?

Klar, du legst als Dateisystem vmfs an und die LUNs bindest du auf die Server iva Multipathing ein. Somit kann jeder Server auf die LUN lesen/Schreiben. Da du keine Feature wie Datendeduplizierung nutzen kannst, wirst du min. die Festplattengröße benötigen wie die phy. Server grad schon benötigen. Da kommt schon was zusammen...Im Einsatz sind momentan ~10 physische Server unter anderem Exchange, MS SQL, Oracle und der Rest normale Windows Server 2003 und 2008. Wer hat Erfahrungen und kann mit Tips behilflich sein was eventuell von bestimmten Systemen in einer VM absieht.

Für alle genannten Produkte gibt es Systemvorraussetzungen und daran würde ich mich orientieren. Denn im Notfall beziehen sich viele Hersteller darauf. Bei Windows Server 2008 (R2) benötist du schon im Standardmodus z.B. 4GB RAM. Da komm schon was zusammen...Ich würde daher 2 phy. Server nehmen mit 2x Xeon CPus, min. 32 GB RAM, 2x Festplatten â 15k im RAID 1, 2 Netzwerkkarten â 2 Ports (2x ISCSI, 2x LAN). Den RAM würde ich daran auslegen, wie viel virtuelle Serve beim Ausfall von einem phy. Server auf den anderen weiterlaufen soll.

Und wenn uns bitte jemand mal diese VMkernel Geschichte etwas näher erläutern kann wäre super

Doku dazu lesen...Wir sollten wir die Netzwerkanbindung (VMWare Gäste, VMkernel, VMotion, ISCSI u.s.w) Netzwerktechnisch trennen (erstellen)?

iSCSI besteht aus Redudanzgründen 2 Subnetze sein. vMotion hat mit IP-Adressen gar nichts am Hut. Sondern hängt eher vom vCenter Server ab. An die VMWare Gäste wird der virtuelle Switch der das LAN managed konfiguriert. Du hast nachher 3 vSwitches (iSCSI Subnetz 1, iSCSI Subnetz 2, LAN Subnetz).

Backups könnt ihr gerne auf eine andere LUN auf dem Storage machen. Aber bitte nachts komplett auf ein anderes System wegsichern bzw. über ein LTO5 Laufwerk. Denn was machst du wenn euer Linuxstorage abraucht?! Backup ist also auch weg!

Am Besten ihr gebt das in die Hände eines Systemhauses. Die Wissen was ihr braucht und welche Hardware/Software Sinn macht.

BTW: Ihr wollt eine VMWare ESX Umgebung mit vMotion, HA, DRS, etc... aufbauen - habt die Kohle für die VMWare Lizenzen + Wartung aber für eine Netapp 2020 mit Festplatten und Support geht euch das Geld aus. Ihr spart am falschen Ende!

Grüße,

Dani

Hallo Torben,

Wir haben ein Volume auf einer Netapp mit 1TB Größe. Nachdem die DatenDeDp durchgelaufen ist, wurden ca. 414,89GB zusätzlich frei. Von den 1TB sind zusätzlich noch 150GB für Snapshots reserviert. D.h. ich habe 41% Speicherplatz gewonnen. Was natürlich beträchlich ist.

Natürlich geht dem vorraus, dass alle virtuelle Server die < Window Server 2008 oder Windows 7 sind noch ein DataAligement durchlaufen haben. Bei allen neuen Betriebssystemen passiert das automatisch bzw. von Microsoft optimiert.

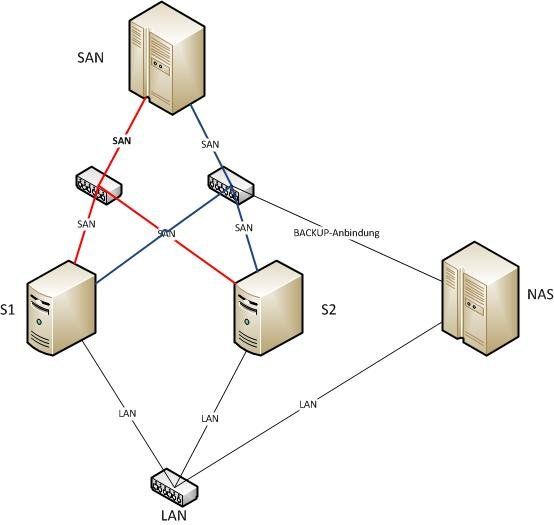

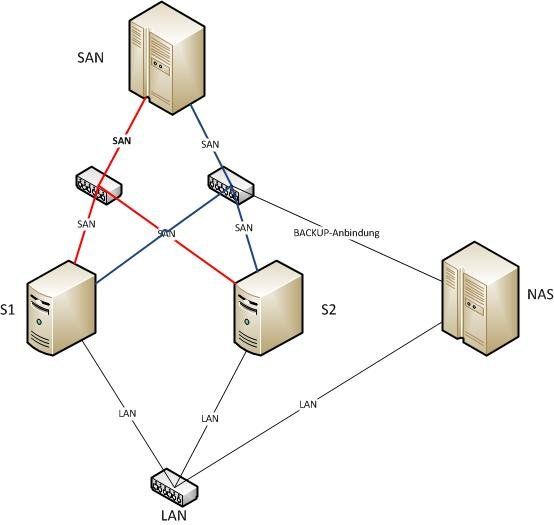

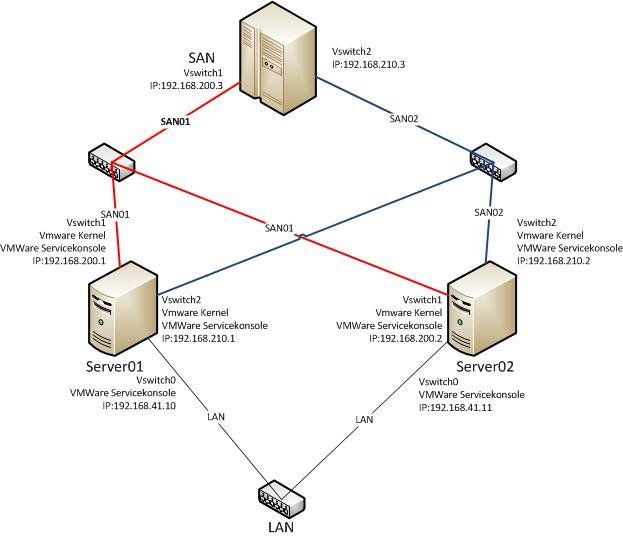

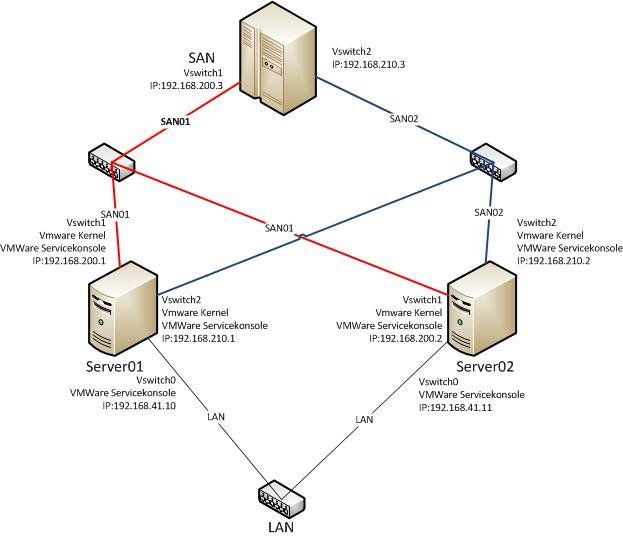

Du hast nachher auf VMWare z.B. 3 vSwitches.

vswitch0 = LAN (Dort brauchst du eine VMWare ServiceKonsole der du die IP-Adresse aus dem LAN zuordnest.)

vswitch1 = SAN01 (ServiceKonsole + VMKernel Port. Auch wird die SAN-IP-Adresse dem ServiceKonsole zugewiesen.)

vswitch2 = SAN02 (ServiceKonsole + VMKernel Port. Auch wird die SAN-IP-Adresse dem ServiceKonsole zugewiesen.)

Sowohl das LAN, SAN01 und SAN02 müssen unterschiedliche IP-Bereiche sein. Des Weiteren würde ich LAN von SAN trennen und SAN01/SAN02 ebenfalls durch 2 phy. Switches laufen lassen. Siehe Schaubild oben! Sowas findest du in den VMWare Whitepapers bzw. Best Practice Dokumenten.

Grüße,

Dani

Wie würdest du im Bsp. das LTO Laufwerk anbinden?,

Das LTO soltlest du an das Storage anbinden, denn dort liegen doch alle Daten. Du erwähntest dass das Feature Datendeduplizierung nicht verwendet werden kann, warum nicht?

Du musst aufpassen.. Datendeduplizierung != Datendeduplizierung. Die Netapp kann z.B. innerhalb einer VMWare Daten deduplizeren. Andere Storages können nur die VM als Datei dedpulzieren, wodurch viel Speicherplatz auf der Strecke bleibt. Beispiel:Wir haben ein Volume auf einer Netapp mit 1TB Größe. Nachdem die DatenDeDp durchgelaufen ist, wurden ca. 414,89GB zusätzlich frei. Von den 1TB sind zusätzlich noch 150GB für Snapshots reserviert. D.h. ich habe 41% Speicherplatz gewonnen. Was natürlich beträchlich ist.

Natürlich geht dem vorraus, dass alle virtuelle Server die < Window Server 2008 oder Windows 7 sind noch ein DataAligement durchlaufen haben. Bei allen neuen Betriebssystemen passiert das automatisch bzw. von Microsoft optimiert.

Wir haben gelesen das viele gar 6 oder 8 Netzwerkschnittstellen in ihren Servern verwenden

Hängt ganz klar von der Plattformgröße und Dedudanzanforderungen ab. 2 Netzwerkports pro Server braucht ihr alleine für iSCSI und deren Redudanz. Damit wenn iSCIS Netz1 ausfällt, die Server nicht stehen bleiben und somit evtl. defekte Datenbanken, etc.. entstehen können. in das normale Netzwerk kommen auch 2 min. Netzwerkanschlüsse. Diese könnte ihr bei Bedarf ohne Weiteres auf 4 erhöhen, falls es träge wird.Du hast nachher auf VMWare z.B. 3 vSwitches.

vswitch0 = LAN (Dort brauchst du eine VMWare ServiceKonsole der du die IP-Adresse aus dem LAN zuordnest.)

vswitch1 = SAN01 (ServiceKonsole + VMKernel Port. Auch wird die SAN-IP-Adresse dem ServiceKonsole zugewiesen.)

vswitch2 = SAN02 (ServiceKonsole + VMKernel Port. Auch wird die SAN-IP-Adresse dem ServiceKonsole zugewiesen.)

Sowohl das LAN, SAN01 und SAN02 müssen unterschiedliche IP-Bereiche sein. Des Weiteren würde ich LAN von SAN trennen und SAN01/SAN02 ebenfalls durch 2 phy. Switches laufen lassen. Siehe Schaubild oben! Sowas findest du in den VMWare Whitepapers bzw. Best Practice Dokumenten.

Grüße,

Dani

Guten Morgen,

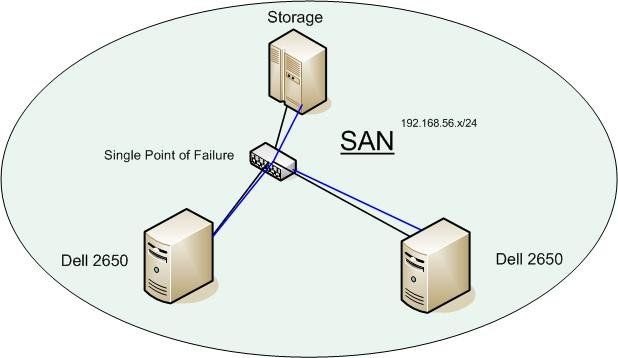

Das ist natürlich ärgerlich und die Wahrscheinlichkeit ist zwar gering jedoch wenn der Switch ausfällt, steht deine Serverlandschaft hin! Darum eine Active/Active Konfiguration mit zwei Switches und 2 Subnetzen. Das sollte eigentlich kein Problem sein...

Hier noch eine bessere Zeichnung. Jede Verbindung ist eine Netzwerkkartenport.

Man kann natürlich z.B. vom Server in Richtung LAN sagen: "ich benötige pro Server 2 Uplinks ins LAN". Einfach Karte einbauen, Patchen und danach den jeweiligen Netzwerkanschluss in den vswitch0 hängen.

Grüße,

Dani

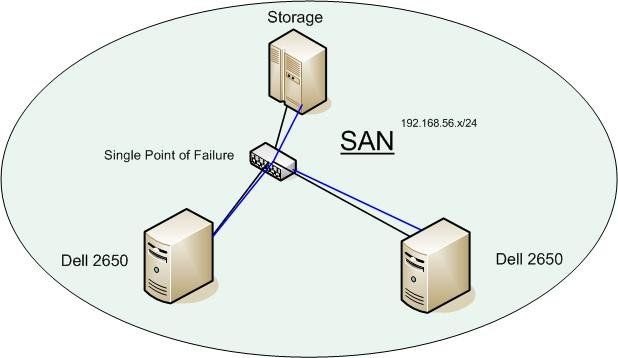

Kann man das Subnetting nicht weglassen und mit LAG/LCAP arbeiten geht das beim Software ISCSI?

Das geht auch... Bloß was machst du wenn der Switch ausfällt? Du hast ja dann nur einen Switch im SAN-Bereich.

Das ist natürlich ärgerlich und die Wahrscheinlichkeit ist zwar gering jedoch wenn der Switch ausfällt, steht deine Serverlandschaft hin! Darum eine Active/Active Konfiguration mit zwei Switches und 2 Subnetzen. Das sollte eigentlich kein Problem sein...

192.168.0.10/24 > Service Console 1 und VMKernel 1 (jeweils 1x physiche Netzwerkkarte)

192.168.0.11/24 > Service Console 2 und VMKernel 2 (jeweils 1x physiche Netzwerkkarte) für Redundanz MPIO

Genau... passt!192.168.0.11/24 > Service Console 2 und VMKernel 2 (jeweils 1x physiche Netzwerkkarte) für Redundanz MPIO

DIe Subnetze haben wohl nichts mit dem eigentlichen Subnetz der VM Gäste zu tun? Diese dienen lediglich zur Kommunikation innerhalb des HA Cluster.

Diese dienen der Kommunkikation zwischen Server und dem Storagesystem - für mehr nicht! Sollte man auch so lassen, da das der VMWare Doku entspricht.Hier noch eine bessere Zeichnung. Jede Verbindung ist eine Netzwerkkartenport.

Man kann natürlich z.B. vom Server in Richtung LAN sagen: "ich benötige pro Server 2 Uplinks ins LAN". Einfach Karte einbauen, Patchen und danach den jeweiligen Netzwerkanschluss in den vswitch0 hängen.

Grüße,

Dani