10GBE Filetransfer vom Windows2019 server aus funktioniert nicht

Hallo zusammen,

ich möchte einen simplen Dateitransfer vom Windows2019 server in 10GBE starten, was nicht funktioniert.

Setup:

- verschiedene Windows 10 Rechner

- Win2016 Server (Intel)

- Win2019 Server (AMD Opteron X3421)

- Netgear 10G switch

- Alle Asus 10G Karte mit RJ45

Aufgabe: Einfach nur eine 24GB Datei (oder mehrere kleinere 50MB) vom Server laden.

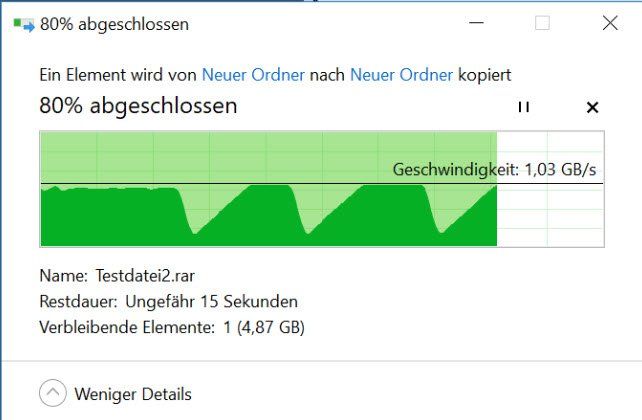

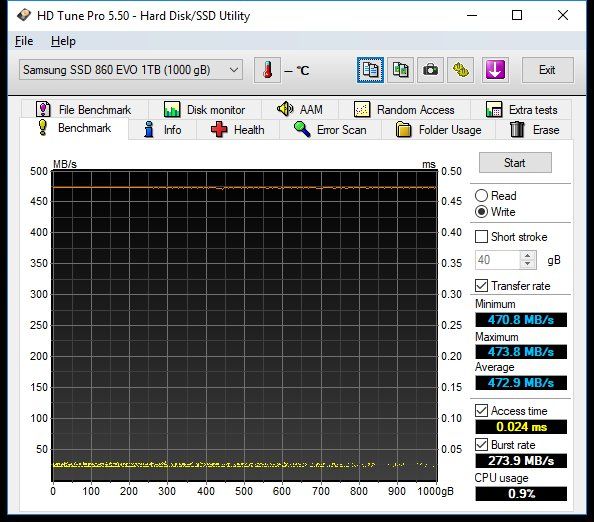

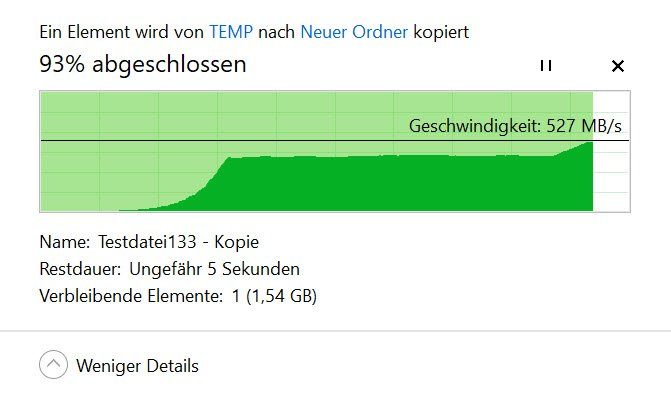

Win2016 Server -> Windows 10 Rechner konstant 500MByte/sec (horizontale Linie)

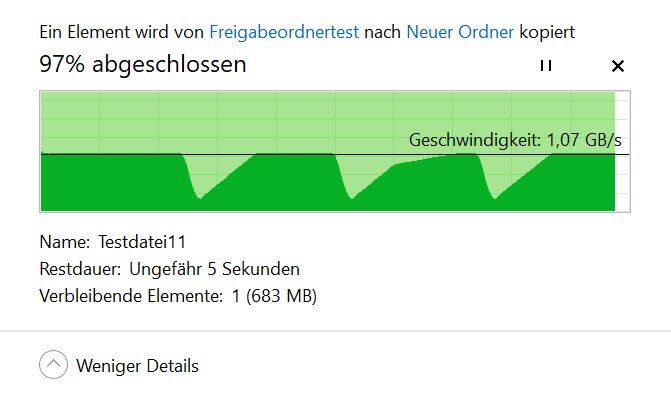

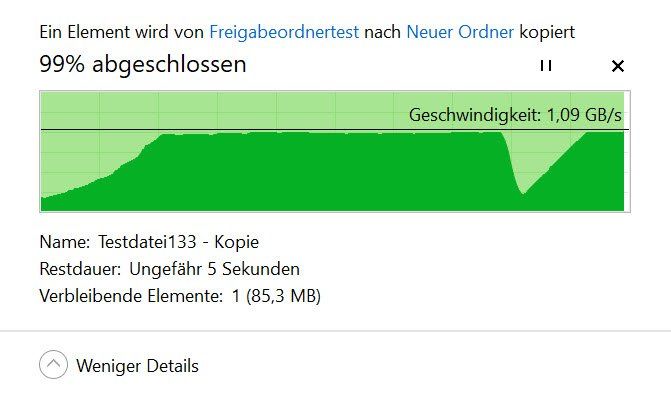

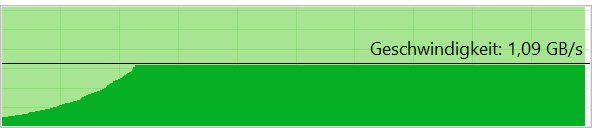

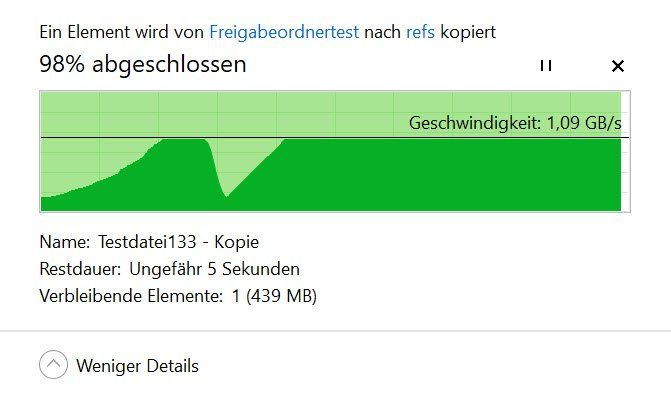

Windows 10 RechnerA -> Windows 10 RechnerB konstant 1,09GByte/sec (nvme) (horizontale Linie)

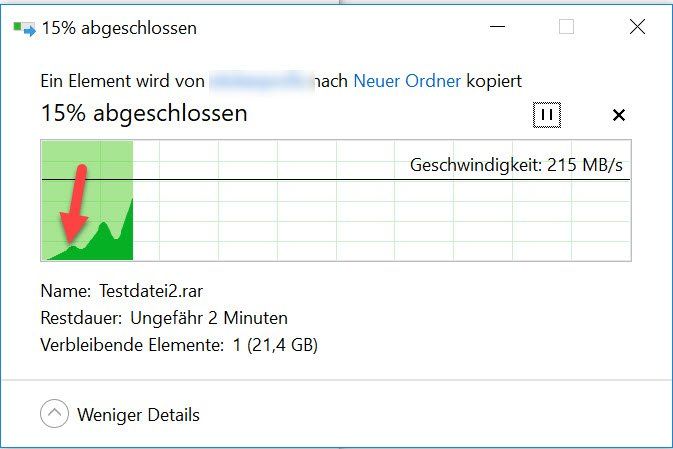

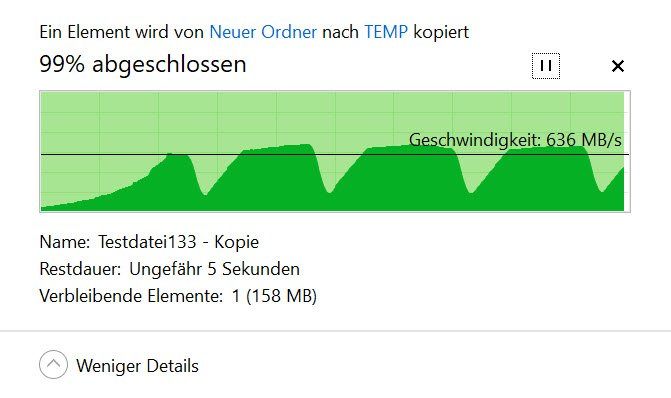

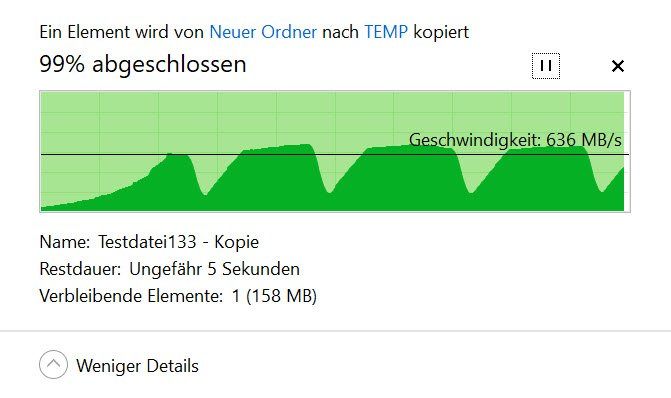

Windows 10 RechnerA -> Win2019 Server mit Stufen, wenn der SSD cache vermutlich voll ist

Problemfall:

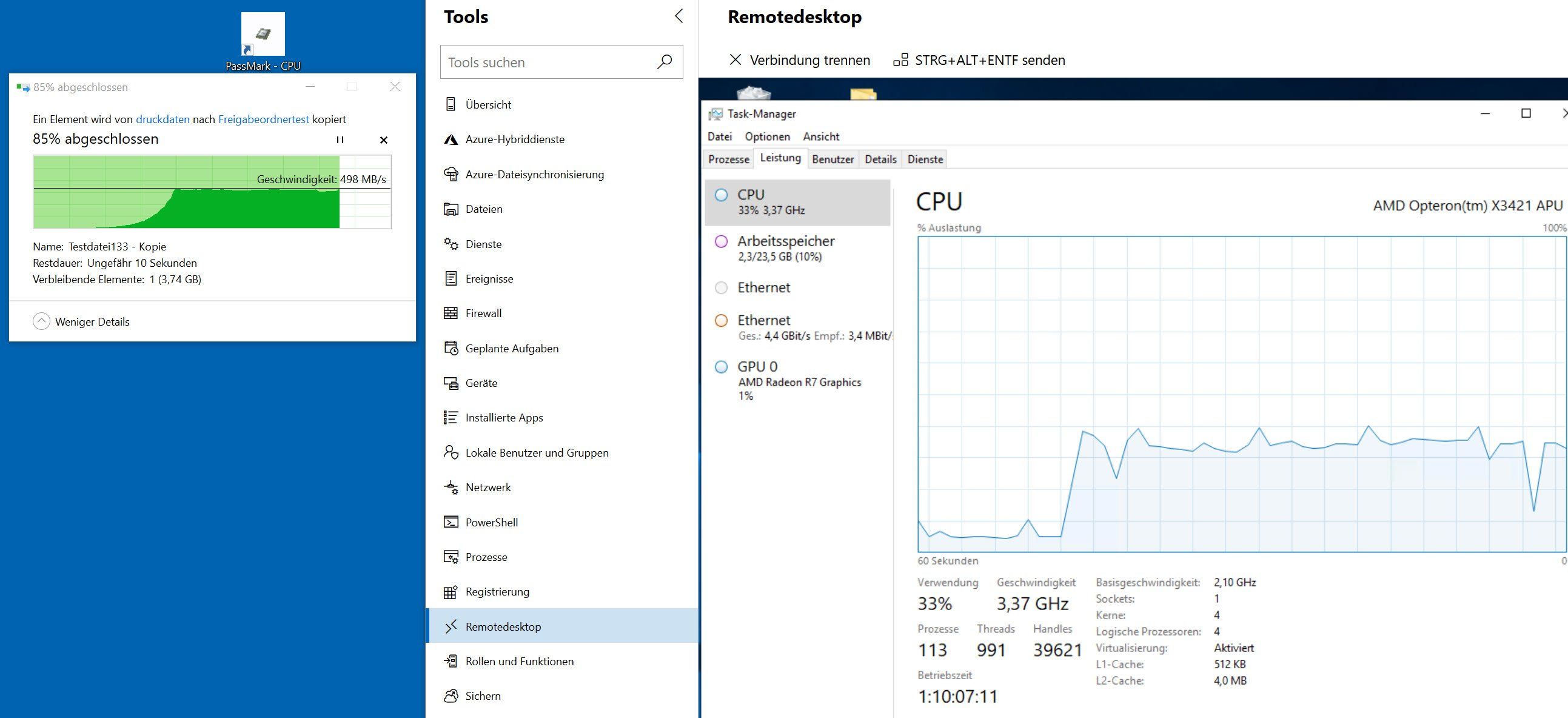

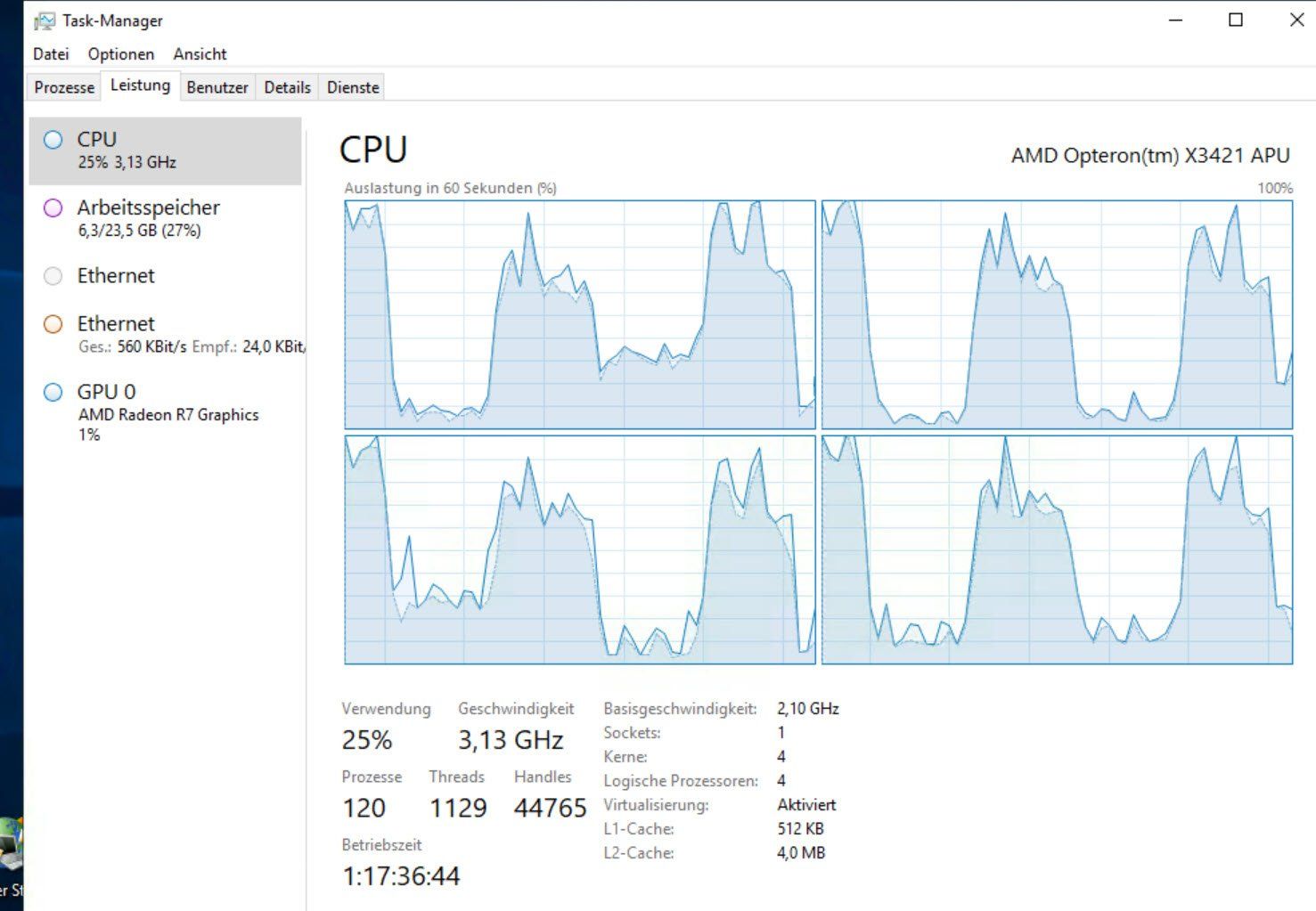

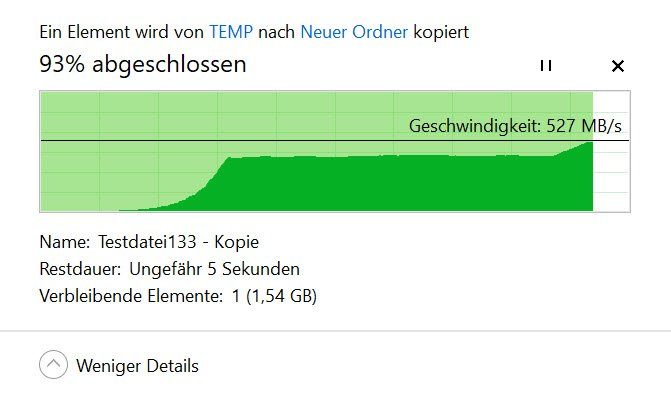

Win2019 Server -> Windows 10 Rechner unberechenbar, startet teilweise bei 500MB/sec, bleibt dort für 10 Sekunden, dann drop auf 360KB/sec . Oder „startet“ gleich mit 360KB/Sec. um dann nach 30 sec schneller zu werden

Oder: 20 50MB Dateien markiert, kopieren mit 500MB/sec, während dessen zusätzlich weitere Dateien kopiert, auf einmal Performance Einbruch auf Null (Zufall?)

- Alle Treibereinstellungen probiert, danach wieder auf Standard gestellt

- Die Kabel sind alle gecheckt, alternativ zur Festinstallation Cat7Kabel verlegt

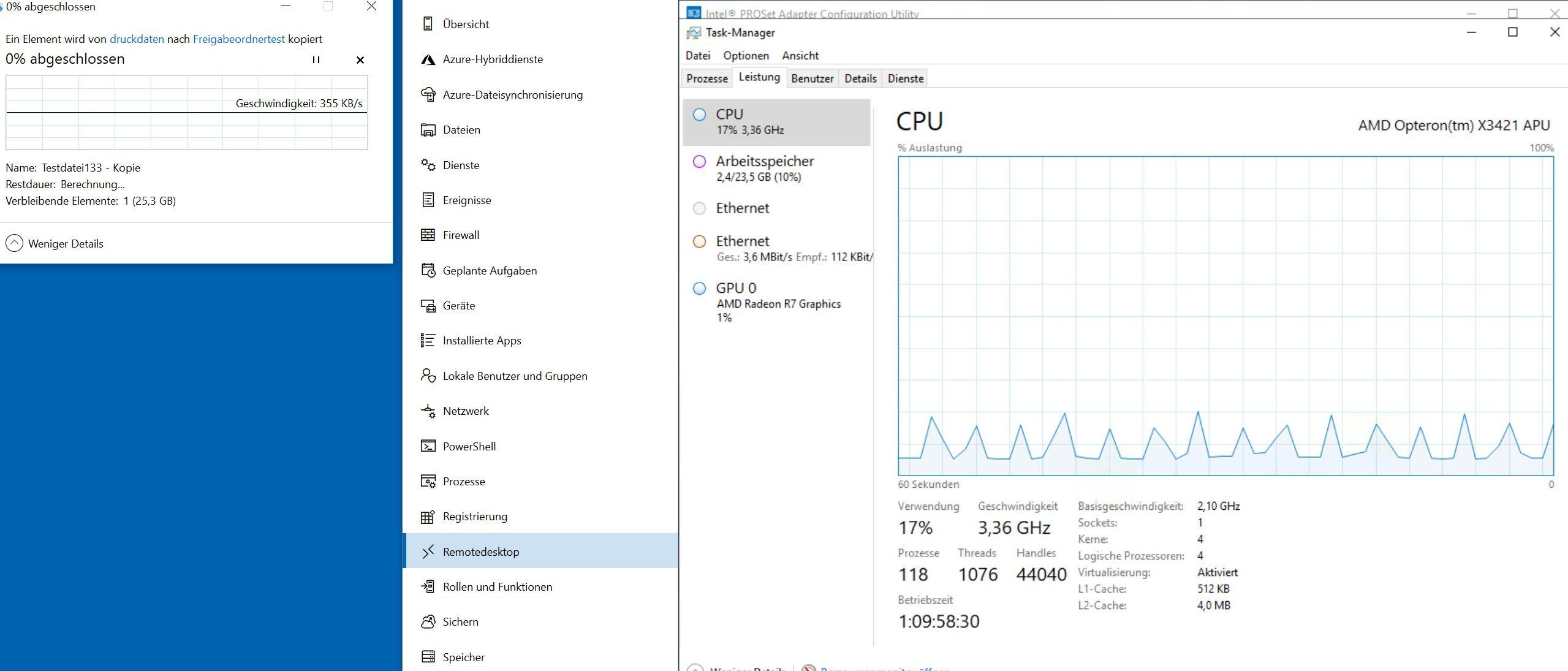

- Auf dem Win2019 Server kein hoher CPU Load zu sehen, jedenfalls lt. TaskManager

- Auf dem Win2019 Server (PCIE x8) die Asus Karte durch Intel Karte x550 T2 ersetzt

- Auf dem Win2019 Server von verschiedenen Festplatten geladen

- Wenn der NIC auf 1GBE gesetzt wird, gibt es keine Probleme

- Firewall am Server testweise deaktiviert

Das Problem scheint doch auf Server2019 fokussiert zu sein??!

Rollen:

- Dateiserver

- Speicherdienste

Features:

- Net framework4.7

- TCP Portfreigabe

- Windows Defender

- Windows Powershell

- Windows search

- Windows Server Sicherung

- WOW64

- windows admincenter

Es befinden sich merkwürdige wan miniport Einträge im Gerätemanager, auch nach Deinstallation wieder da, Standard?

Ich befürchte, wenn ich mir aus Zeitgründen trial and error - mäßig einfach einen anderen Server kaufe, dasselbe Problem wieder auftritt.

Vielleicht hat jemand eine Ahnung?

Hubertus

ich möchte einen simplen Dateitransfer vom Windows2019 server in 10GBE starten, was nicht funktioniert.

Setup:

- verschiedene Windows 10 Rechner

- Win2016 Server (Intel)

- Win2019 Server (AMD Opteron X3421)

- Netgear 10G switch

- Alle Asus 10G Karte mit RJ45

Aufgabe: Einfach nur eine 24GB Datei (oder mehrere kleinere 50MB) vom Server laden.

Win2016 Server -> Windows 10 Rechner konstant 500MByte/sec (horizontale Linie)

Windows 10 RechnerA -> Windows 10 RechnerB konstant 1,09GByte/sec (nvme) (horizontale Linie)

Windows 10 RechnerA -> Win2019 Server mit Stufen, wenn der SSD cache vermutlich voll ist

Problemfall:

Win2019 Server -> Windows 10 Rechner unberechenbar, startet teilweise bei 500MB/sec, bleibt dort für 10 Sekunden, dann drop auf 360KB/sec . Oder „startet“ gleich mit 360KB/Sec. um dann nach 30 sec schneller zu werden

Oder: 20 50MB Dateien markiert, kopieren mit 500MB/sec, während dessen zusätzlich weitere Dateien kopiert, auf einmal Performance Einbruch auf Null (Zufall?)

- Alle Treibereinstellungen probiert, danach wieder auf Standard gestellt

- Die Kabel sind alle gecheckt, alternativ zur Festinstallation Cat7Kabel verlegt

- Auf dem Win2019 Server kein hoher CPU Load zu sehen, jedenfalls lt. TaskManager

- Auf dem Win2019 Server (PCIE x8) die Asus Karte durch Intel Karte x550 T2 ersetzt

- Auf dem Win2019 Server von verschiedenen Festplatten geladen

- Wenn der NIC auf 1GBE gesetzt wird, gibt es keine Probleme

- Firewall am Server testweise deaktiviert

Das Problem scheint doch auf Server2019 fokussiert zu sein??!

Rollen:

- Dateiserver

- Speicherdienste

Features:

- Net framework4.7

- TCP Portfreigabe

- Windows Defender

- Windows Powershell

- Windows search

- Windows Server Sicherung

- WOW64

- windows admincenter

Es befinden sich merkwürdige wan miniport Einträge im Gerätemanager, auch nach Deinstallation wieder da, Standard?

Ich befürchte, wenn ich mir aus Zeitgründen trial and error - mäßig einfach einen anderen Server kaufe, dasselbe Problem wieder auftritt.

Vielleicht hat jemand eine Ahnung?

Hubertus

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 456936

Url: https://administrator.de/forum/10gbe-filetransfer-vom-windows2019-server-aus-funktioniert-nicht-456936.html

Ausgedruckt am: 18.07.2025 um 01:07 Uhr

59 Kommentare

Neuester Kommentar

Hallo,

verwende bitte mal netio für aussagekräftige Tests.

Dateien kopieren ist da nicht besonders hilfreich.

nwlab.net/art/netio/netio.html

Stefan

verwende bitte mal netio für aussagekräftige Tests.

Dateien kopieren ist da nicht besonders hilfreich.

nwlab.net/art/netio/netio.html

Stefan

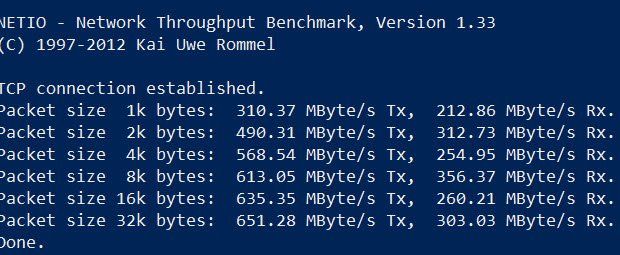

Es zeigt das der native Durchsatz nur der Karten und Switch ohne Protokoll Overhead im Mittel nicht über 4,8 Gbit/s beim Senden geht und nicht mehr als 2,4 Gbit/s beim Empfang.

Für eine 10Gig Verbindung sind das grottenschlechte Werte ! Weniger als 50% Gesamtperformance, das ist in der Tat sehr mickrig.

Es zeigt auch die typische Schwäche von Billigsthardware, die du ja einsetzt, das diese bei kleinen Paketen in die Knie geht. SMB/CIFS Datei Sharing unter Windows ist bekanntlich sehr ineffizient, da es Protokoll bedingt nur sehr kleine Pakete nutzt. Sicher auch ein Grund warum bei deinen Komponenten der Durchsatz so mickrig ist.

Dazu kommt das wir die verwendeten Chipsätze nicht kennen

Hier gibt es Billigchipsätze wie die von Realtek die einen Großteil des Pakethandlings der Rechner CPU aufbürden, was dann entsprechend an der Performance kratzt. Im Gegensatz zu Intel, Broadcom Chips die das in eigenem Silizium erledigen. Auch die Anzahl der PCIe Lanes die so eine Karte nutzt ist entscheidend. Schwachbrüstige Billigswitches mit mickriger CPU Leistung wie dein NetGear tun dann ein Übriges.

Dazu kommt vermutlich noch das der NetGear 10G Switch ein 10G-Base T Switch ist mit RJ-45, richtig ?

10G-Base T garantiert keine 10Gig sondern ist immer ein Negotiation Verfahren je nach Kabelqualität, Länge und Steckverbindungen. Ein Knick im Kabel oder unsauberer Stecker und schon kommen nur noch 5 oder 6 Gig an statt 10G. Generell ist es also keine gute Idee bei einer Server Vernetzung 10G-Base T zu verwenden (Cat Kabel). Hier solltest du immer SFP+ basierte Switches nehmen und dann mit Kupfer Twinax bzw. DAC Kabeln arbeiten, die ganz sicher immer 10G garantieren !

2 Dinge solltest du nochmal machen:

Wenn du den Switch mal ausschliessen willst wiederholst du die NetIO Messungen mal wen nur Client und Server mal direkt mit ihren Netzwerkkarten untereinander verbunden sind (Back to Back).

Damit kannst du dann genau sehen ob hier die Karten selber oder Switch oder beide der pöhse Buhmann ist !

Für eine 10Gig Verbindung sind das grottenschlechte Werte ! Weniger als 50% Gesamtperformance, das ist in der Tat sehr mickrig.

Es zeigt auch die typische Schwäche von Billigsthardware, die du ja einsetzt, das diese bei kleinen Paketen in die Knie geht. SMB/CIFS Datei Sharing unter Windows ist bekanntlich sehr ineffizient, da es Protokoll bedingt nur sehr kleine Pakete nutzt. Sicher auch ein Grund warum bei deinen Komponenten der Durchsatz so mickrig ist.

Dazu kommt das wir die verwendeten Chipsätze nicht kennen

Hier gibt es Billigchipsätze wie die von Realtek die einen Großteil des Pakethandlings der Rechner CPU aufbürden, was dann entsprechend an der Performance kratzt. Im Gegensatz zu Intel, Broadcom Chips die das in eigenem Silizium erledigen. Auch die Anzahl der PCIe Lanes die so eine Karte nutzt ist entscheidend. Schwachbrüstige Billigswitches mit mickriger CPU Leistung wie dein NetGear tun dann ein Übriges.

Dazu kommt vermutlich noch das der NetGear 10G Switch ein 10G-Base T Switch ist mit RJ-45, richtig ?

10G-Base T garantiert keine 10Gig sondern ist immer ein Negotiation Verfahren je nach Kabelqualität, Länge und Steckverbindungen. Ein Knick im Kabel oder unsauberer Stecker und schon kommen nur noch 5 oder 6 Gig an statt 10G. Generell ist es also keine gute Idee bei einer Server Vernetzung 10G-Base T zu verwenden (Cat Kabel). Hier solltest du immer SFP+ basierte Switches nehmen und dann mit Kupfer Twinax bzw. DAC Kabeln arbeiten, die ganz sicher immer 10G garantieren !

2 Dinge solltest du nochmal machen:

- Unbedingt Jumbo Framing im Setup des Switches und der NICs global aktivieren

- Damit nochmal die Messung wiederholen und dann einmal mit TCP und einmal mit UDP Framing (-t Parameter bei NetIO) und auch mal die Messrichting umkehren. NetIO im Server Mode auf dem Client.

Wenn du den Switch mal ausschliessen willst wiederholst du die NetIO Messungen mal wen nur Client und Server mal direkt mit ihren Netzwerkkarten untereinander verbunden sind (Back to Back).

Damit kannst du dann genau sehen ob hier die Karten selber oder Switch oder beide der pöhse Buhmann ist !

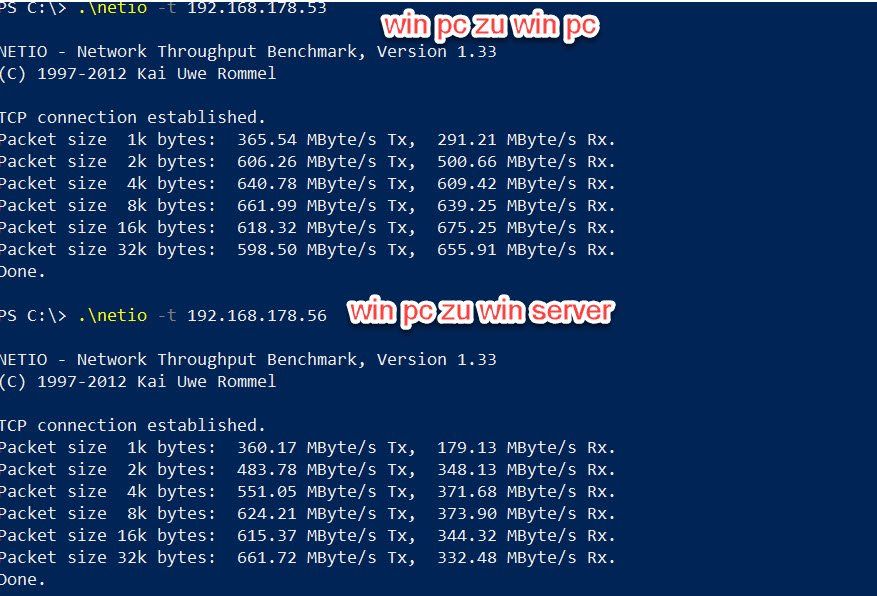

Moin,

ich fasse zusammen:

Performance zwischen den PCs

netio: OK, Dateifreigaben: Ok

Performance zwischen Server und PCs

netio: senden nur 50%, empfangen ok, Dateifreigaben: Arsch

Also muss irgendwas am Server sein:

- NIC defekt (mal mit einem PC gegentauschen)

- Kabel defekt (mal mit einem PC gegentauschen)

- Switch-Port defekt (mal mit einem PC gegentauschen)

- Treiberproblem (Update)

- Mainboard-Slot-Problem (Karte umstecken)

- Karte-Treiber-Mainboard-Kompatibilitäts-Problem (Win 2016 mal probieren, andere Karte (Modell, Hersteller) probieren

Stefan

ich fasse zusammen:

Performance zwischen den PCs

netio: OK, Dateifreigaben: Ok

Performance zwischen Server und PCs

netio: senden nur 50%, empfangen ok, Dateifreigaben: Arsch

Also muss irgendwas am Server sein:

- NIC defekt (mal mit einem PC gegentauschen)

- Kabel defekt (mal mit einem PC gegentauschen)

- Switch-Port defekt (mal mit einem PC gegentauschen)

- Treiberproblem (Update)

- Mainboard-Slot-Problem (Karte umstecken)

- Karte-Treiber-Mainboard-Kompatibilitäts-Problem (Win 2016 mal probieren, andere Karte (Modell, Hersteller) probieren

Stefan

Mal den Back to Back Test gemacht ?

Generell fährt man mit Mellanox Karten im Server nicht schlecht. Diese erreichen so gut wie immer 95% Wirespeed bei 10G auch auf älterer Intel Hardware:

ebay.de/itm/10G-Netzwerk-Kit-2x-Mellanox-ConnectX-3-10Gigabit-3- ...

und

amazon.de/Bewinner-Netzwerkkarte-Professional-Ethernet-Karte-Ver ...

Diese haben sinnigerweise auch SFP+ Ports wo man dann sauber mit Twinax und dediziert 10G arbeiten kann. Twinax Kabel werden im Set mitgeliefert wie man sieht.

Generell fährt man mit Mellanox Karten im Server nicht schlecht. Diese erreichen so gut wie immer 95% Wirespeed bei 10G auch auf älterer Intel Hardware:

ebay.de/itm/10G-Netzwerk-Kit-2x-Mellanox-ConnectX-3-10Gigabit-3- ...

und

amazon.de/Bewinner-Netzwerkkarte-Professional-Ethernet-Karte-Ver ...

Diese haben sinnigerweise auch SFP+ Ports wo man dann sauber mit Twinax und dediziert 10G arbeiten kann. Twinax Kabel werden im Set mitgeliefert wie man sieht.

Moin Hub22019,

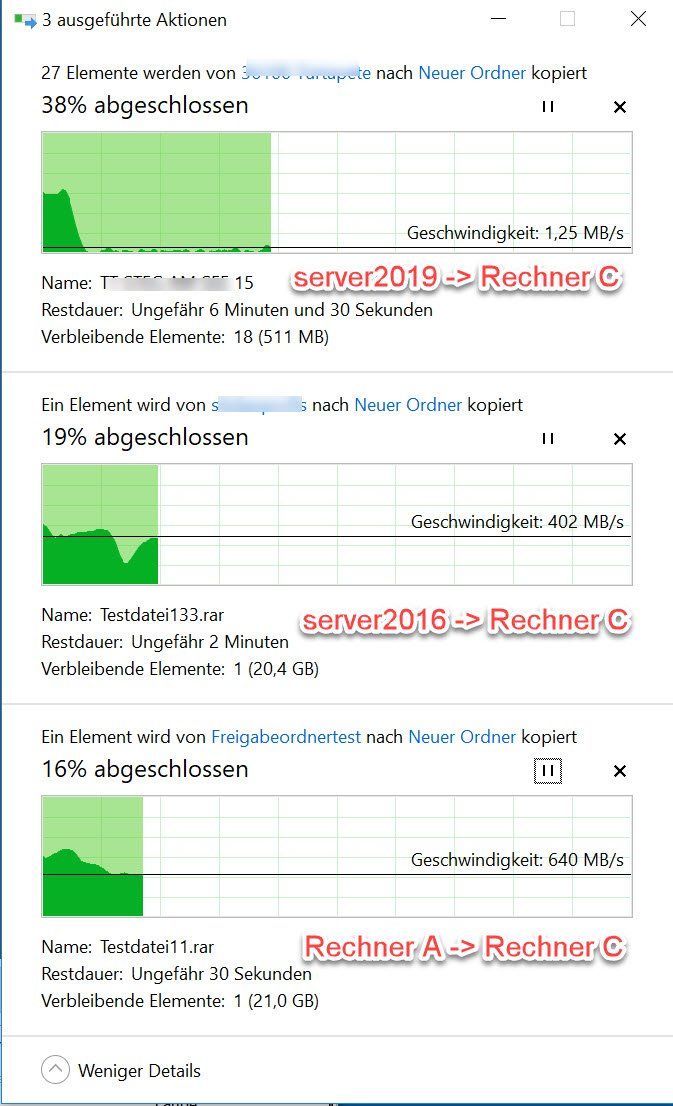

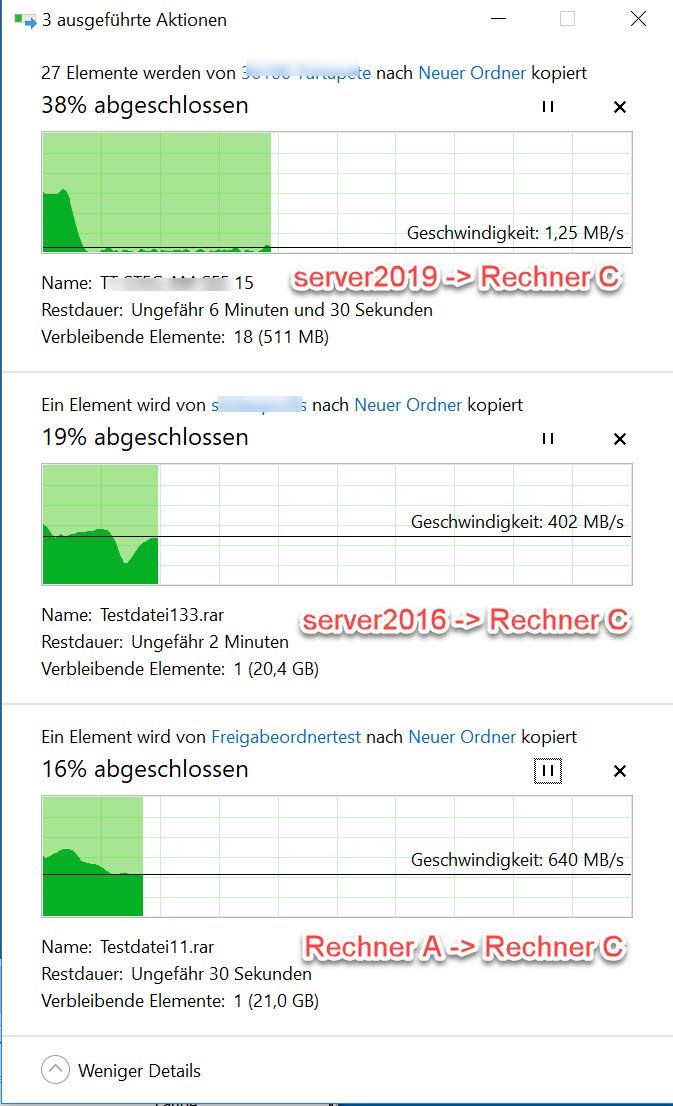

das sieht mir bei dir aber nach einem ganz anderen Problem aus wie bei uns ... 🤔

Bricht die Performance immer ein wenn du Rechner C verwendest oder generell sobald du einen dritten Client benutzt?

Gibt es Hardwareunterscheide zwischen Rechner A/B und Rechner C?

Hast du auf deinem 2019er Server die Hyper-V Rolle aktiviert?

Hast du die Energieeinstellungen wie im anderen Post beschrieben optimiert?

---

CMD mit Adminrechten aufmachen und dann die folgenden beiden Befehle ausführen.

1. "powercfg -duplicatescheme e9a42b02-d5df-448d-aa00-03f14749eb61"

2. "powercfg.exe -setactive 9d69a0c6-32fb-4d7a-b235-e37b7d0111c0"

3. Unter Energieeinstellungen nachsehen. 😉🤪

---

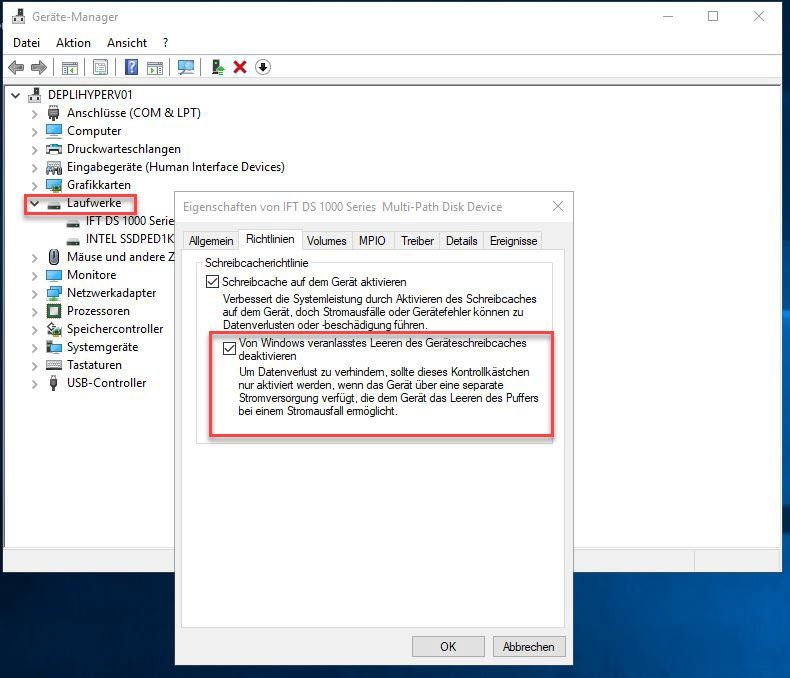

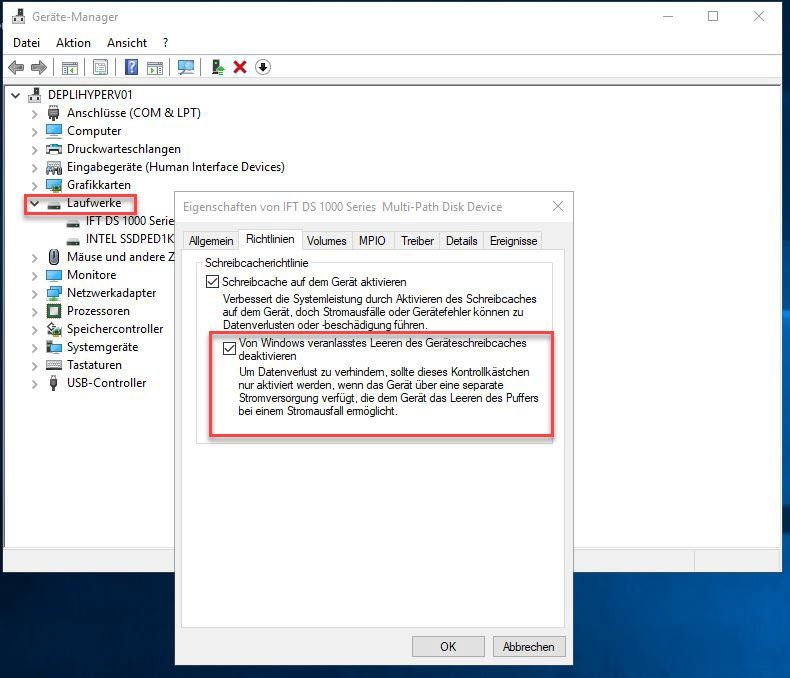

Ferner sollte man bei SSDs wenn möglich noch die folgende Einstellung vornehmen.

Grüsse aus BaWü

Alex

das sieht mir bei dir aber nach einem ganz anderen Problem aus wie bei uns ... 🤔

Bricht die Performance immer ein wenn du Rechner C verwendest oder generell sobald du einen dritten Client benutzt?

Gibt es Hardwareunterscheide zwischen Rechner A/B und Rechner C?

Hast du auf deinem 2019er Server die Hyper-V Rolle aktiviert?

Hast du die Energieeinstellungen wie im anderen Post beschrieben optimiert?

---

CMD mit Adminrechten aufmachen und dann die folgenden beiden Befehle ausführen.

1. "powercfg -duplicatescheme e9a42b02-d5df-448d-aa00-03f14749eb61"

2. "powercfg.exe -setactive 9d69a0c6-32fb-4d7a-b235-e37b7d0111c0"

3. Unter Energieeinstellungen nachsehen. 😉🤪

---

Ferner sollte man bei SSDs wenn möglich noch die folgende Einstellung vornehmen.

Grüsse aus BaWü

Alex

Moin Hub22019,

ich tippe ebenfalls auf ein Problem im Bereich des Netzwerks hin.

Welchen Netgear setzt du genau ein?

Hast du auf dem Switch mal "Flow Control" deaktiviert?

Stelle die Ports des Switches bitte mal testweise von "Auto-Negotiation" auf FIX 10G.

Neuste Firmware auf dem Switch?

VLAN auf dem Switch konfiguriert?

ACLs auf dem Switch konfiguriert?

Da du keine HV Rolle installiert hast, kannst du auch getrost alles Richtung SR-IOV und VMQ auf den NICs im Server deaktivieren auch im BIOS nachschauen.

Grüsse aus BaWü

Alex

ich tippe ebenfalls auf ein Problem im Bereich des Netzwerks hin.

Welchen Netgear setzt du genau ein?

Hast du auf dem Switch mal "Flow Control" deaktiviert?

Stelle die Ports des Switches bitte mal testweise von "Auto-Negotiation" auf FIX 10G.

Neuste Firmware auf dem Switch?

VLAN auf dem Switch konfiguriert?

ACLs auf dem Switch konfiguriert?

Da du keine HV Rolle installiert hast, kannst du auch getrost alles Richtung SR-IOV und VMQ auf den NICs im Server deaktivieren auch im BIOS nachschauen.

Grüsse aus BaWü

Alex

Moin Hub22019,

🤔🤔🤔

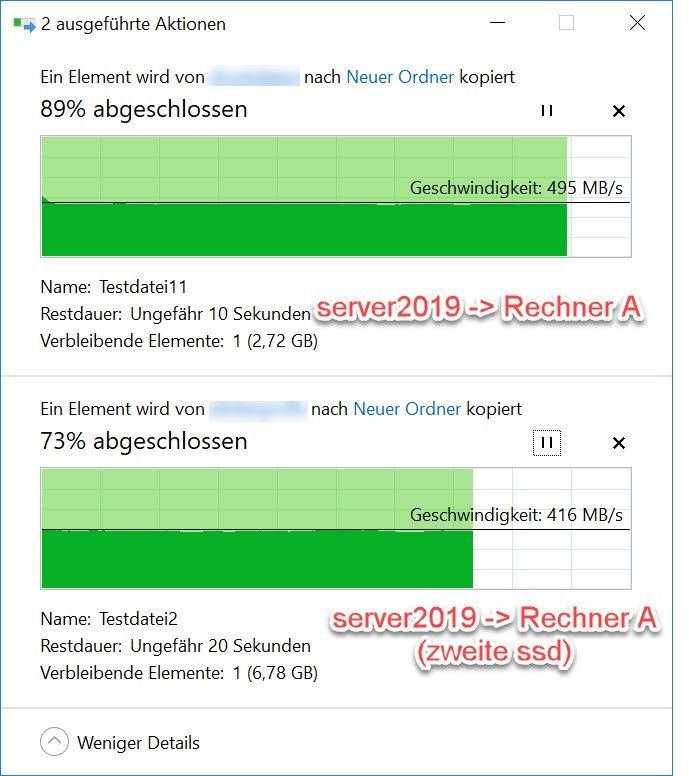

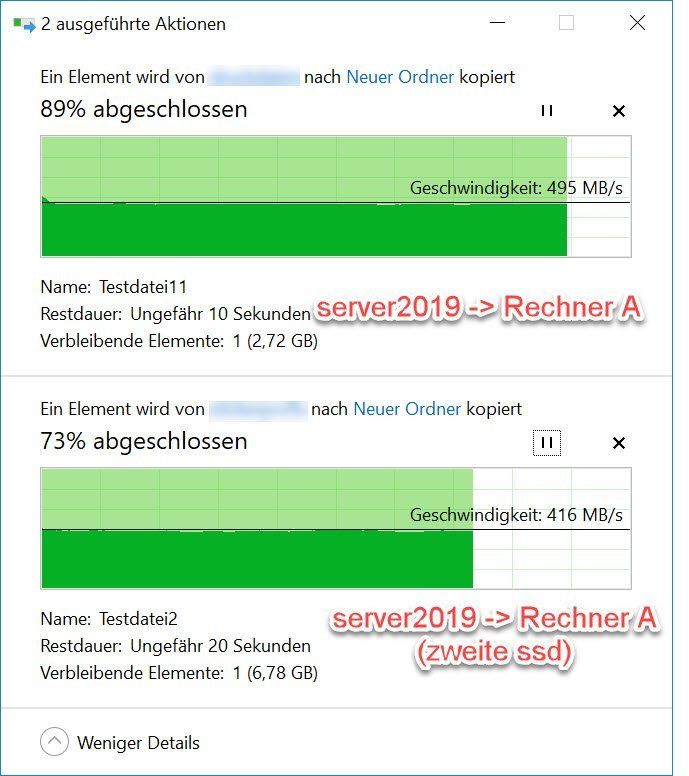

wenn ich so alles Revue passieren lasse, dann sollten wir uns so langsam auf den Server konzentrieren.

Du hast ja in den oberen Posts geschrieben, dass du die Probleme nur in Verbindung mit dem MicroserverG10 und 2019 hast.

Wenn du zwischen den Clients kopierst, dann gibt es keinerlei Probleme.

Richtig?

Wenn ja, dann können wir das Netzwerk vorerst als Problemkind eigentlich ausschliessen.

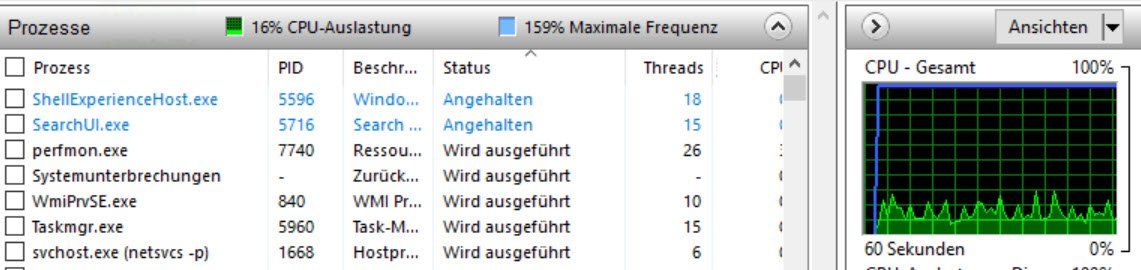

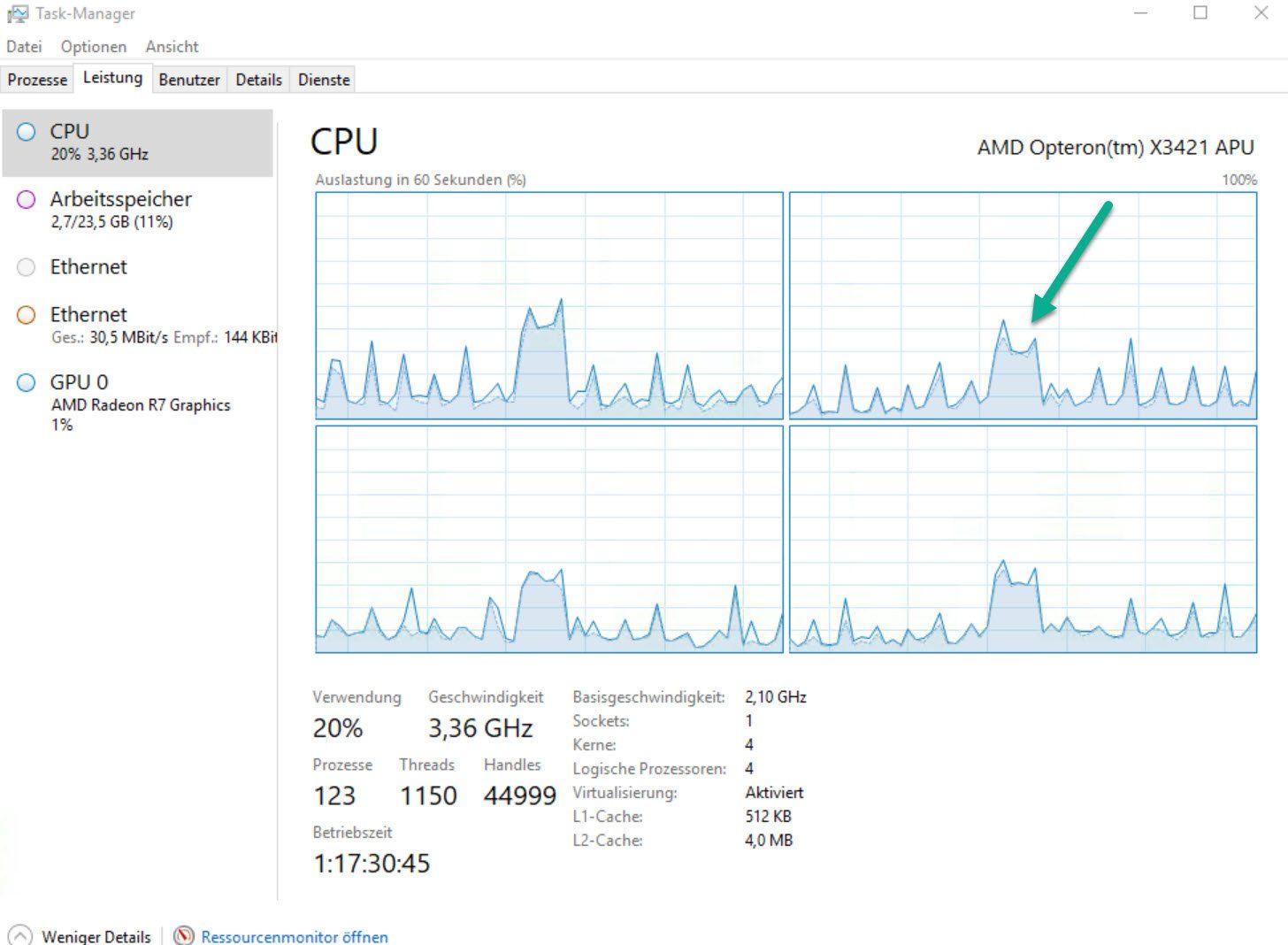

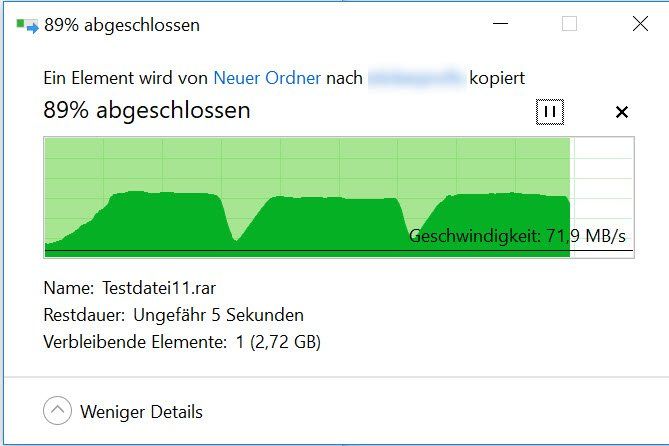

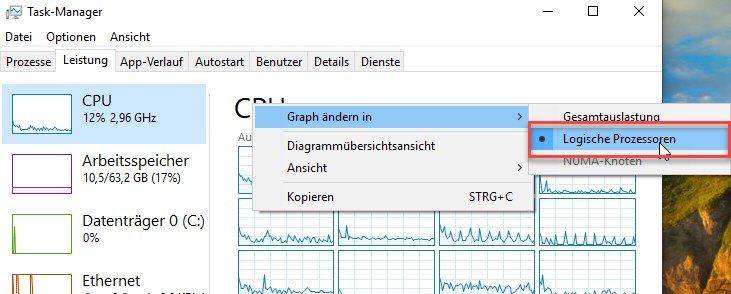

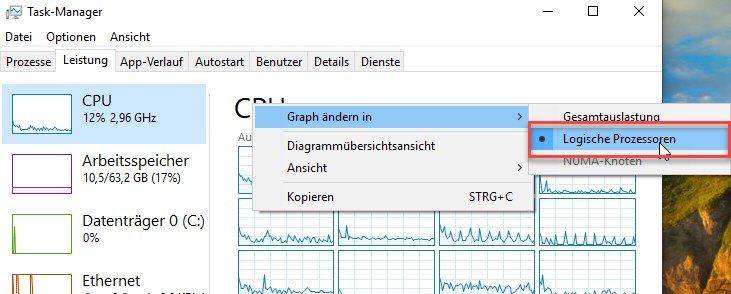

Die CPU Last des Servers ist ungewöhnlich.

Bitte den Test wiederholen, aber vorher die Ansicht im Taskmanager auf "Logische Prozessoren" umstellen.

Die CPU Last von 30-50% bei der Übertragung finde ich etwas zu hoch.

Wenn ich zwischen unseren Systemen (ungeswitcht) mit 10G hin und her kopiere, dann juckt das die CPU genau 0.

Man muss aber dazu sagen, das die von uns verwendeten CPUs in einer anderen Liga spielen, wie der AMD Opteron X3421 in dem Microserver.

Das letzte System wurde CPU technisch mit Xeon Gold 6144 ausgeliefert.

Das nächste System kommt in ~ 2 Wochen mit 2 x Xeon Gold 6254 im Blech ... 🤪

---

Welche SSDs verwendest du in dem MicroServer?

Grüsse aus BaWü

Alex

🤔🤔🤔

wenn ich so alles Revue passieren lasse, dann sollten wir uns so langsam auf den Server konzentrieren.

Du hast ja in den oberen Posts geschrieben, dass du die Probleme nur in Verbindung mit dem MicroserverG10 und 2019 hast.

Wenn du zwischen den Clients kopierst, dann gibt es keinerlei Probleme.

Richtig?

Wenn ja, dann können wir das Netzwerk vorerst als Problemkind eigentlich ausschliessen.

Die CPU Last des Servers ist ungewöhnlich.

Bitte den Test wiederholen, aber vorher die Ansicht im Taskmanager auf "Logische Prozessoren" umstellen.

Die CPU Last von 30-50% bei der Übertragung finde ich etwas zu hoch.

Wenn ich zwischen unseren Systemen (ungeswitcht) mit 10G hin und her kopiere, dann juckt das die CPU genau 0.

Man muss aber dazu sagen, das die von uns verwendeten CPUs in einer anderen Liga spielen, wie der AMD Opteron X3421 in dem Microserver.

Das letzte System wurde CPU technisch mit Xeon Gold 6144 ausgeliefert.

Das nächste System kommt in ~ 2 Wochen mit 2 x Xeon Gold 6254 im Blech ... 🤪

---

Welche SSDs verwendest du in dem MicroServer?

Grüsse aus BaWü

Alex

Moin Hubertus,

ich sehe, du hast das Problem selbst schon erkannt.

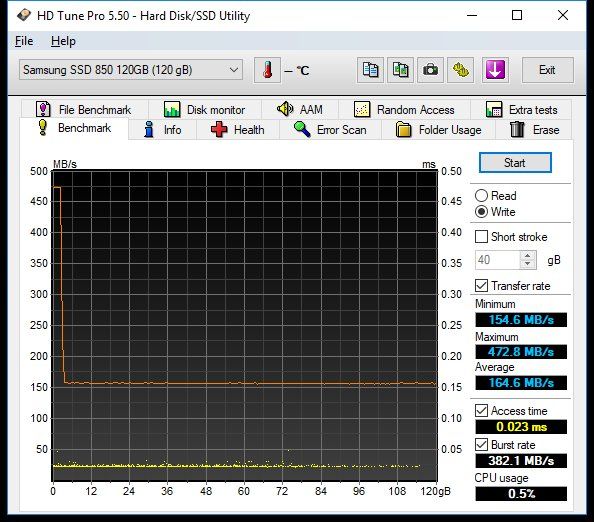

Weder die 860er noch die Ultrastar sind für deinen Einsatzzweck geeignet.

Samsung:

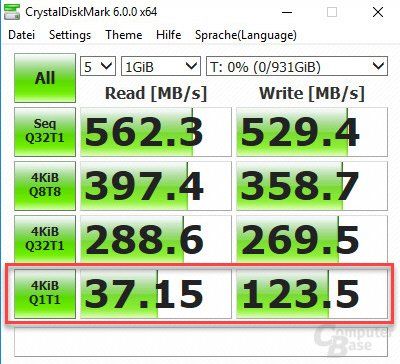

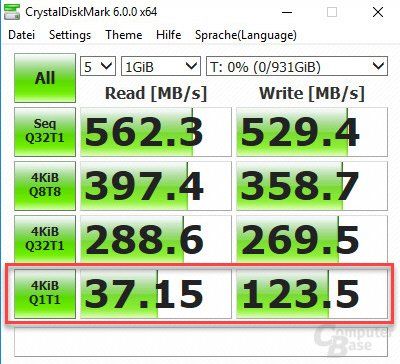

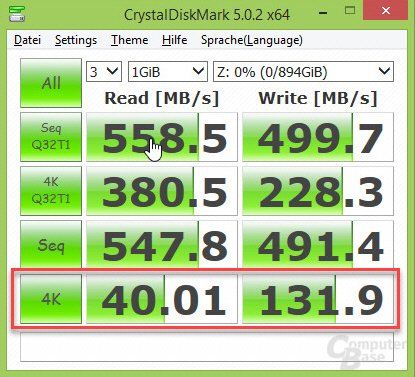

computerbase.de/2018-12/samsung-ssd-860-qvo-test/3/

Laut diesem Test schaft die Samsung bei einem Singlethread gerade mal 37,15 MB lesend und 123,5 MB schreibend ... ☹

SanDisk:

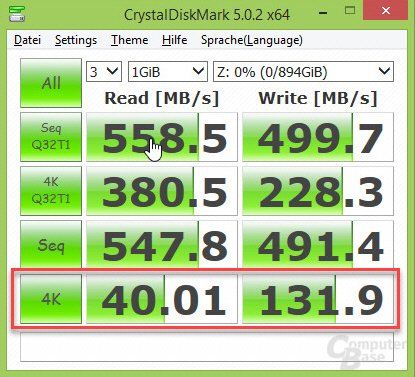

computerbase.de/2016-01/sandisk-ultra-ii-2-ssd-test/4/#abschnitt ...

Bei der SanDisk, sieht es nicht besser aus, diese schaft bei einem Singlethread nicht viel mehr, 40,01 lesend und 131,9 schreibend ... ☹

---

Wenn du nur eine SSD verwenden möchtest, so kommst du an PCIe/NVME nicht vorbei.

Für stabile Transferraten bei Singlethreads mit ~1000 MB/s, gibt es momentan nur eine Wahl.

Sparvariante:

ark.intel.com/content/www/us/en/ark/products/129833/intel-optane ...

Servervariante:

ark.intel.com/content/www/us/en/ark/products/97159/intel-optane- ...

Aber bitte nicht umfallen, wenn du die Preise googlest.

---

Wenn du ein schnelles Filersystem suchst, dann kann ich dir das folgende wärmstens empfehlen.

infortrend.com/global/products/families/gsepro/pro%20200

"GSEP208T000H-0032" mit Xeon-D 1517. 😀

Diese Unit darfst du nicht mit einer QNAP oder Synology vergleichen, daraus macht die performancetechnisch Hackfleisch aber ohne dabei aufwachen zu müssen. 🤪

Deine Anforderung packt diese auch mit HDD Bestückung, es müssen aber schon 8 sein.

z.B. 8 x HGST Ultrastar HE10 10TB.

Ich habe selbst die kleinere mit 5 x HGST Ultrastar HE10 10TB.

Die Platten sind im RAID6 konfiguriert und schaffen bei mir ~700-800 MB/s, habe die letzten Wochen bei Konvertierungen/Umstellungen einige TB's hin und her schieben dürfen ...

Wenn du die 8-Bay nimmst und RAID5 verwendest, dann schafft die Unit auch locker 2 x 10G mit HDDs zu bedienen.

Alternativ kannst du diese selbstverständlich auch mit SSDs bestücken.

z.B. Micron 5200er aber bitte die PROs keine ECO oder MAX.

Die Microns sind 100% supportet, jedoch funktionieren normalerweise auch andere SSDs in diesen Units.

Von meiner Seite würde ich alternativ eine Intel SATA SSDs aus der Enterprise-Serie empfehlen.

Die aktuellste ist die D3-S4610 mit TLC-Flash.

Bei Bestückung mit SSDs solltest du mind. 4 Stück nehmen (RAID5).

Die Infortrend hat von haus aus auch 2 x 10G, jedoch als SFP+, sie lässt sich aber mit 2 Zusatzkarten auf 4 x 10G RJ45 erweitern.

Sag bescheid wenn du mehr Infos benötigst.

Grüsse aus BaWü

Alex

ich sehe, du hast das Problem selbst schon erkannt.

Weder die 860er noch die Ultrastar sind für deinen Einsatzzweck geeignet.

Samsung:

computerbase.de/2018-12/samsung-ssd-860-qvo-test/3/

Laut diesem Test schaft die Samsung bei einem Singlethread gerade mal 37,15 MB lesend und 123,5 MB schreibend ... ☹

SanDisk:

computerbase.de/2016-01/sandisk-ultra-ii-2-ssd-test/4/#abschnitt ...

Bei der SanDisk, sieht es nicht besser aus, diese schaft bei einem Singlethread nicht viel mehr, 40,01 lesend und 131,9 schreibend ... ☹

---

Wenn du nur eine SSD verwenden möchtest, so kommst du an PCIe/NVME nicht vorbei.

Für stabile Transferraten bei Singlethreads mit ~1000 MB/s, gibt es momentan nur eine Wahl.

Sparvariante:

ark.intel.com/content/www/us/en/ark/products/129833/intel-optane ...

Servervariante:

ark.intel.com/content/www/us/en/ark/products/97159/intel-optane- ...

Aber bitte nicht umfallen, wenn du die Preise googlest.

---

Wenn du ein schnelles Filersystem suchst, dann kann ich dir das folgende wärmstens empfehlen.

infortrend.com/global/products/families/gsepro/pro%20200

"GSEP208T000H-0032" mit Xeon-D 1517. 😀

Diese Unit darfst du nicht mit einer QNAP oder Synology vergleichen, daraus macht die performancetechnisch Hackfleisch aber ohne dabei aufwachen zu müssen. 🤪

Deine Anforderung packt diese auch mit HDD Bestückung, es müssen aber schon 8 sein.

z.B. 8 x HGST Ultrastar HE10 10TB.

Ich habe selbst die kleinere mit 5 x HGST Ultrastar HE10 10TB.

Die Platten sind im RAID6 konfiguriert und schaffen bei mir ~700-800 MB/s, habe die letzten Wochen bei Konvertierungen/Umstellungen einige TB's hin und her schieben dürfen ...

Wenn du die 8-Bay nimmst und RAID5 verwendest, dann schafft die Unit auch locker 2 x 10G mit HDDs zu bedienen.

Alternativ kannst du diese selbstverständlich auch mit SSDs bestücken.

z.B. Micron 5200er aber bitte die PROs keine ECO oder MAX.

Die Microns sind 100% supportet, jedoch funktionieren normalerweise auch andere SSDs in diesen Units.

Von meiner Seite würde ich alternativ eine Intel SATA SSDs aus der Enterprise-Serie empfehlen.

Die aktuellste ist die D3-S4610 mit TLC-Flash.

Bei Bestückung mit SSDs solltest du mind. 4 Stück nehmen (RAID5).

Die Infortrend hat von haus aus auch 2 x 10G, jedoch als SFP+, sie lässt sich aber mit 2 Zusatzkarten auf 4 x 10G RJ45 erweitern.

Sag bescheid wenn du mehr Infos benötigst.

Grüsse aus BaWü

Alex

Zitat von @hub22019:

Hallo,

um ehrlich zu sein bin ich ziemlich "weichgekocht" 🤢🤢🤢🤢

Wer billig kauft, kauft dreimal.

Am besten ich hole mir was neues. Denke über einen Dell T640 nach, der hat gleich 10GBE an Bord.

Xeon Silver wird ja wohl schaffen eine nvme SSD über 10GBE an einen Clienten auszuspielen?

Gruß, Hubertus

Hallo,

um ehrlich zu sein bin ich ziemlich "weichgekocht" 🤢🤢🤢🤢

Wer billig kauft, kauft dreimal.

Am besten ich hole mir was neues. Denke über einen Dell T640 nach, der hat gleich 10GBE an Bord.

Xeon Silver wird ja wohl schaffen eine nvme SSD über 10GBE an einen Clienten auszuspielen?

Gruß, Hubertus

Moin Hubertus,

so wie am Anfang erwähnt, was ist mit den Platten.

Zu deinem Neukauf; denke ich, macht Sinn. Ich würde dir allerdings eher schon zum Gold raten, man stellt den Unterschied fest (Vergleich identischer Bauform, r640 zu r640 Silver und Gold) - und auf 5-7 Jahren Einsatzzeit amortisiert sich der Aufpreis locker, abgesehen davon macht das am Ende auch nicht so viel aus, wie ich in unterschiedlichen Kundenprojekten des letzten Jahres festgestellt hab.

Viele Grüße und ein angenehmes Pfingstwochenende,

Christian

certifiedit.net

Moin Christian,

"Ich würde dir allerdings eher schon zum Gold raten, man stellt den Unterschied fest (Vergleich identischer Bauform, r640 zu r640 Silver und Gold) - und auf 5-7 Jahren Einsatzzeit amortisiert sich der Aufpreis locker."

dem möchte ich ein bisschen widersprechen.

Wenn ich Hubertus und seine Anforderung richtig verstanden habe, so spielt die CPU eine nachrangige rolle.

Viel wichtiger ist es, das richtige Storage-System zu wählen und auch die passenden SSDs dazu!!!

Wenn wir bei dem besagten DELL T640 bleiben, so sollte bei diesem mindestens der PERC H730P+ (2GB CACHE) oder besser der PERC H740P (8GB CACHE) als RAID Adapter gewählt werden, ungecachte RAID Adapter wie der PERC H330+ sind hingegen vollkommen ungeeignet.

Die von mir oben erwähnte Infortrend, kann im vergleich zum DELL den grossteil ihres RAMs als Cache verwenden, bei 32GB wären es >20GB Cache.

Ferner sollten auch bei dem DELL mindestens 4 SSD's im RAID5 Verbund laufen, am besten SAS12G.

Die Xeon Silver 4112 sollte für Filetransfer vollkommen ausreichen, ich bevorzuge immer Tackt vor Cores !!!

(Ich habe das Gefühl, dass die meisten Softwareentwickler, bis heute leider noch nichts von Multithreading gehört haben ... ☹ )

Grüsse aus BaWü

Alex

"Ich würde dir allerdings eher schon zum Gold raten, man stellt den Unterschied fest (Vergleich identischer Bauform, r640 zu r640 Silver und Gold) - und auf 5-7 Jahren Einsatzzeit amortisiert sich der Aufpreis locker."

dem möchte ich ein bisschen widersprechen.

Wenn ich Hubertus und seine Anforderung richtig verstanden habe, so spielt die CPU eine nachrangige rolle.

Viel wichtiger ist es, das richtige Storage-System zu wählen und auch die passenden SSDs dazu!!!

Wenn wir bei dem besagten DELL T640 bleiben, so sollte bei diesem mindestens der PERC H730P+ (2GB CACHE) oder besser der PERC H740P (8GB CACHE) als RAID Adapter gewählt werden, ungecachte RAID Adapter wie der PERC H330+ sind hingegen vollkommen ungeeignet.

Die von mir oben erwähnte Infortrend, kann im vergleich zum DELL den grossteil ihres RAMs als Cache verwenden, bei 32GB wären es >20GB Cache.

Ferner sollten auch bei dem DELL mindestens 4 SSD's im RAID5 Verbund laufen, am besten SAS12G.

Die Xeon Silver 4112 sollte für Filetransfer vollkommen ausreichen, ich bevorzuge immer Tackt vor Cores !!!

(Ich habe das Gefühl, dass die meisten Softwareentwickler, bis heute leider noch nichts von Multithreading gehört haben ... ☹ )

Grüsse aus BaWü

Alex

Hi Alex,

danke für deinen Widerspruch, aber pure SSD/Plattenleistung bringt dir nichts, wenn die andere Seite wieder laggt, was hältst du vom Vorschlag, dass das ganze System ausgewogen konfiguriert sein sollte? (Du hast natürlich Recht mit dem RaidController, das heisst aber nicht, dass er auf die Silver gehen sollte).

Das A und O ist also ein insgesamt rund konfiguriertes System.

Viele Grüße,

Christian

certifiedit.net

danke für deinen Widerspruch, aber pure SSD/Plattenleistung bringt dir nichts, wenn die andere Seite wieder laggt, was hältst du vom Vorschlag, dass das ganze System ausgewogen konfiguriert sein sollte? (Du hast natürlich Recht mit dem RaidController, das heisst aber nicht, dass er auf die Silver gehen sollte).

Das A und O ist also ein insgesamt rund konfiguriertes System.

Viele Grüße,

Christian

certifiedit.net

Hi Christian,

"Das A und O ist also ein insgesamt rund konfiguriertes System."

Da kann ich nur Beipflichten. 👍

Wenn du einen meiner oberen Posts anschaust, dann siehst du, dass wir im Normalfall auch nicht gerade die kleinsten CPUs verbauen.

Ich kann die Anforderung vom Hubertus an den Server nur im Bezug auf den Filetransfer (grosse Dateien durch die Gegend schupsen ) und dafür benötigt er normalerweise nicht massenhaft Cores.

) und dafür benötigt er normalerweise nicht massenhaft Cores.

Habe die Tage mal auf einem unserer Kundensysteme mit 1GByte/s übers Netz rum gespielt, die CPU lief dabei immer auf 1-3% sowohl bei der Freigabe auf der Boot-Disk (Intel P4800X) als auch übers SAN (IFT DS1024B), lediglich die SAN CPU ging auf 15%-25%, was bei gleichzeitigem Lesen mit 1GByte/s (Server A) und gleichzeitigem Schreiben mit 1GByte/s (Server B) auf dasselbe SAN, vollkommen OK ist.

---

So wie ich auf eurer Homepage erkenne, arbeitet Ihr viel mit DELL & EMC, kennst du die Infortrend SANs?

Kann ich nur empfehlen, kosten weniger sind aber viel leistungsfähiger, vor allem bei AllFlash Bestückung.

Grüsse aus BaWü

Alex

n-g-i-s.com

"Das A und O ist also ein insgesamt rund konfiguriertes System."

Da kann ich nur Beipflichten. 👍

Wenn du einen meiner oberen Posts anschaust, dann siehst du, dass wir im Normalfall auch nicht gerade die kleinsten CPUs verbauen.

Ich kann die Anforderung vom Hubertus an den Server nur im Bezug auf den Filetransfer (grosse Dateien durch die Gegend schupsen

Habe die Tage mal auf einem unserer Kundensysteme mit 1GByte/s übers Netz rum gespielt, die CPU lief dabei immer auf 1-3% sowohl bei der Freigabe auf der Boot-Disk (Intel P4800X) als auch übers SAN (IFT DS1024B), lediglich die SAN CPU ging auf 15%-25%, was bei gleichzeitigem Lesen mit 1GByte/s (Server A) und gleichzeitigem Schreiben mit 1GByte/s (Server B) auf dasselbe SAN, vollkommen OK ist.

---

So wie ich auf eurer Homepage erkenne, arbeitet Ihr viel mit DELL & EMC, kennst du die Infortrend SANs?

Kann ich nur empfehlen, kosten weniger sind aber viel leistungsfähiger, vor allem bei AllFlash Bestückung.

Grüsse aus BaWü

Alex

n-g-i-s.com

Zitat von @hub22019:

Ich persönlich bin kein Freund von Raids, entweder habe ich das nicht verstanden oder/und es passt einfach nicht zu unserem kleinteiligen Einsatz.

Ich persönlich bin kein Freund von Raids, entweder habe ich das nicht verstanden oder/und es passt einfach nicht zu unserem kleinteiligen Einsatz.

Du hast es nicht verstanden.

- Backup-versionen werden ja täglich gezogen

Hat nichts mit RAID zu tun. RAID1 ist nämlich kein Backup!

- Dateiverlauf wird mehrmals täglich gezogen

Hat nichts mit RAID zu tun. s.o.

- Geschwindigkeit brauche ich nicht mehr, als was die Samsung bietet

Das ist i.d.R. auch nicht der Hauptzeck des RAIDs.

- Platzbedarf ist überschaubar

Das ist meist auch nicht das Ziel des Einsatzes von. z.B. RAID1 oder RAID10.

Also:

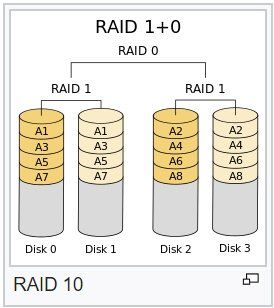

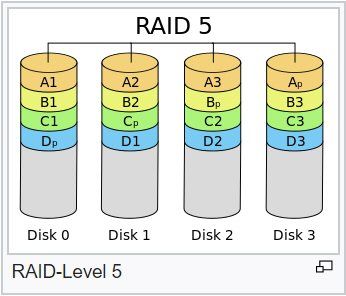

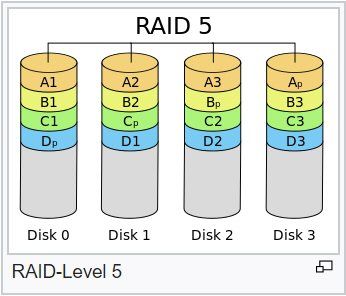

Sinn und Zweck eines Raids mit Redundanz (RAID1, RAID5, RAID6, RAID10) ist es, bei Ausfall einer Platte das System immer noch lauffähig ist, wenn auch mit einschränkungen. Man hat dann i.d.R. weder Datenverlust, noch Ausfallzeit für das einspielen eines backups. Man muß nur recht schnell wieder eine neue Platte in das RAID stecken, um die Redundanz wiederzubekommen.

lks

Moin Hubertus,

ein RAID (Controller) macht viel mehr als nur für Datensicherheit zu sorgen (Abgesehen RAID0).

Zum einen verteilt dieser einen Singlestream auf unterschiedliche Laufwerke und sorg dadurch dafür, dass dieser schneller abgearbeitet wird als bei einer einzelnen SSD.

Durch den Cache des Controllers wird unter Anderem bei entsprechenden Konfiguration sichergestellt, dass evtl. "Hänger" der einzelnen SSDs sich beim schreiben nicht zu sehr auf das Gesamtsystem auswirken, Stichwort "WRITE BACK".

tecchannel.de/a/ratgeber-raid-controller-optimal-konfigurieren,4 ...

Beim Lesen kannst du bei deiner Anforderung durch aktivieren des Features "READ AHEAD" ebenfalls positiv entgegenwirken.

tecchannel.de/a/ratgeber-raid-controller-optimal-konfigurieren,4 ...

Ich bin mir nicht ganz sicher, ob du mit der Samsung glücklich wirst.

Auf die Maximalperformance darfst du bei deiner Anforderung nicht spickeln, diese wirst du mit deiner Anforderung niemals abfragen können.

Siehe auch.

storagereview.com/samsung_pm1725a_ssd_review

Ist zwar der Vorgänger, aber so viel anders ist die b auch nicht, ausser einbisschen schneller.

Ganz ehrlich, ich mag die Samsungs absolut nicht, ich wurde vor einigen Jahren von einem Kunden auf dessen Verantwortung "gezwungen" welche in ein SAN einzubauen. Diese Entscheidung hat der Kunde relativ schnell bereut.

Die Dinger sind schon schnell wenn sie neu und leer sind, sobald der Füllgrad zunimmt wird die Performance zusehens unerträglich.

War zumindest meine Erfahrung. Mit Enterprise SSDs von Intel oder HGST ist mir das noch nie passiert.

Grüsse aus BaWü

Alex

ein RAID (Controller) macht viel mehr als nur für Datensicherheit zu sorgen (Abgesehen RAID0).

Zum einen verteilt dieser einen Singlestream auf unterschiedliche Laufwerke und sorg dadurch dafür, dass dieser schneller abgearbeitet wird als bei einer einzelnen SSD.

Durch den Cache des Controllers wird unter Anderem bei entsprechenden Konfiguration sichergestellt, dass evtl. "Hänger" der einzelnen SSDs sich beim schreiben nicht zu sehr auf das Gesamtsystem auswirken, Stichwort "WRITE BACK".

tecchannel.de/a/ratgeber-raid-controller-optimal-konfigurieren,4 ...

Beim Lesen kannst du bei deiner Anforderung durch aktivieren des Features "READ AHEAD" ebenfalls positiv entgegenwirken.

tecchannel.de/a/ratgeber-raid-controller-optimal-konfigurieren,4 ...

Ich bin mir nicht ganz sicher, ob du mit der Samsung glücklich wirst.

Auf die Maximalperformance darfst du bei deiner Anforderung nicht spickeln, diese wirst du mit deiner Anforderung niemals abfragen können.

Siehe auch.

storagereview.com/samsung_pm1725a_ssd_review

Ist zwar der Vorgänger, aber so viel anders ist die b auch nicht, ausser einbisschen schneller.

Ganz ehrlich, ich mag die Samsungs absolut nicht, ich wurde vor einigen Jahren von einem Kunden auf dessen Verantwortung "gezwungen" welche in ein SAN einzubauen. Diese Entscheidung hat der Kunde relativ schnell bereut.

Die Dinger sind schon schnell wenn sie neu und leer sind, sobald der Füllgrad zunimmt wird die Performance zusehens unerträglich.

War zumindest meine Erfahrung. Mit Enterprise SSDs von Intel oder HGST ist mir das noch nie passiert.

Grüsse aus BaWü

Alex

Moin Hubertus,

noch ein weiterer Trick, der bei auserwählten RAID-Kontroller & SANs möglich ist.

Die meisten SSDs können ihre Schreibperformance nur aufgrund des eigenen Schreib-Caches aufrechterhalten,

dieser wir bei den meisten SANs und auch RAID-Controller leider und auch zum Glück deaktiviert.

Zum Glück, weil ein aktivierter Disk-Cache insbesondere bei HDDs im Falle eine Stromausfalls zu fatalen Datenverlusten führen könnte.

Leider, weil bei SSDs ein (Gross)Teil Ihrer Leistungsfähigkeit dadurch ebenfalls flöten geht. 🐌

Auch bei den SSDs muss man aufpassen, die meisten SoHo SSDs und auch einige die sich mit "Enterprise" schimpfen haben ebenfalls ungepufferte Caches.

Alle Enterprise SSDs von Intel )Enhanced Power Loss Data Protection) haben z.B. einen Pufferkondensator, der es sicherstellt, dass im Falle eines Stromausfalls noch alle Daten aus dem Cache auf den Flash geschrieben werden.

Wenn du die Komponenten klug wählst, dann hast du im RAID deinen Cache + den Disk-Cache der jeweiligen SSDs.

Macht unter dem Srich, Turbo hinter Turbo ... 🏎💨🤪

Grüsse aus BaWü

Alex

noch ein weiterer Trick, der bei auserwählten RAID-Kontroller & SANs möglich ist.

Die meisten SSDs können ihre Schreibperformance nur aufgrund des eigenen Schreib-Caches aufrechterhalten,

dieser wir bei den meisten SANs und auch RAID-Controller leider und auch zum Glück deaktiviert.

Zum Glück, weil ein aktivierter Disk-Cache insbesondere bei HDDs im Falle eine Stromausfalls zu fatalen Datenverlusten führen könnte.

Leider, weil bei SSDs ein (Gross)Teil Ihrer Leistungsfähigkeit dadurch ebenfalls flöten geht. 🐌

Auch bei den SSDs muss man aufpassen, die meisten SoHo SSDs und auch einige die sich mit "Enterprise" schimpfen haben ebenfalls ungepufferte Caches.

Alle Enterprise SSDs von Intel )Enhanced Power Loss Data Protection) haben z.B. einen Pufferkondensator, der es sicherstellt, dass im Falle eines Stromausfalls noch alle Daten aus dem Cache auf den Flash geschrieben werden.

Wenn du die Komponenten klug wählst, dann hast du im RAID deinen Cache + den Disk-Cache der jeweiligen SSDs.

Macht unter dem Srich, Turbo hinter Turbo ... 🏎💨🤪

Grüsse aus BaWü

Alex

starker sägezahn nicht schön

Buffer Bloating auf der Infrastruktur ?!en.wikipedia.org/wiki/Bufferbloat

Hi Hubertus,

werde mich kurz fassen, da ich momentan absolut land unter bin.

Das Netzwerk hat mit deinem Problem nichts zu tun!

Der RAID-Controller ist OK.

Bei den SSDs würde ich dir eher zu 4 x SAS und nicht SATA raten, der grund ist die doppelte Bandbreite (SATA 6G VS SAS 12G) zwischen Controller und SSD.

4 Stück reichen Vollkommen aus, jedoch solltest du den Verbund in RAID5 und nicht in RAID10 machen, ist vor allem beim Schreiben schneller.

Eine zusätzliche Boot-SSD benötigst du eigentlich nicht, du kannst bei den meisten RAID-Kontroller mehrere Virtual-Disks/LUNs pro RAID-Verbund einrichten. VD0 (200GB) zum booten VD1 (Restkapazität) für Daten.

Grüsse aus BaWü

Alex

werde mich kurz fassen, da ich momentan absolut land unter bin.

Das Netzwerk hat mit deinem Problem nichts zu tun!

Der RAID-Controller ist OK.

Bei den SSDs würde ich dir eher zu 4 x SAS und nicht SATA raten, der grund ist die doppelte Bandbreite (SATA 6G VS SAS 12G) zwischen Controller und SSD.

4 Stück reichen Vollkommen aus, jedoch solltest du den Verbund in RAID5 und nicht in RAID10 machen, ist vor allem beim Schreiben schneller.

Eine zusätzliche Boot-SSD benötigst du eigentlich nicht, du kannst bei den meisten RAID-Kontroller mehrere Virtual-Disks/LUNs pro RAID-Verbund einrichten. VD0 (200GB) zum booten VD1 (Restkapazität) für Daten.

Grüsse aus BaWü

Alex

Das Netzwerk hat mit deinem Problem nichts zu tun!

Das ist sicher richtig, denn ein gruseliger NetGear Billig Router wird ja wohl kaum im 10Gig Datenpfad liegen...?!!Wenn Client und Server Back to Back angeschlossen sind ohne aktive Komponente hat das Netzwerk in der Tat keinerlei Einfluss...wenn man dann mal von den verwendeten NICs und ihrer Performance absieht.

Moin Aqui,

ja, ganz sicher!!! 😉🤪

Bei einer Übertragung zwischen den Clients selbst, treten ja auch keine Performanceprobleme auf.

Ich mag Netgear auch nicht besonders, wir verbauen ausslisslich ARUBA, aber mögen und funktionieren sind zwei paar Schuhe.

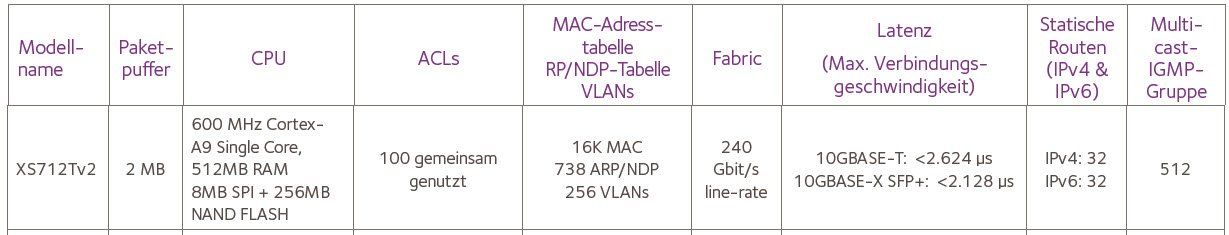

Wir sprechen hier von einer simplen Datenübertragung über einen 10G Switch, dessen Bandbreite mit 240 Gbit/s angegeben wird.

Kein Trunk, kein AC, kein VLAN, kein SNMP, kein IP Routing, ... warum sollte das deiner Meinung nach nicht gehen?

Die NICs sind OK und bringen auch die Performance, hat Hubertus doch schon X Mal bestätigt.

@Hubertus

hat du den RAM-DISK Test schon gemacht?

Grüsse aus BaWü

Alex

ja, ganz sicher!!! 😉🤪

Bei einer Übertragung zwischen den Clients selbst, treten ja auch keine Performanceprobleme auf.

Ich mag Netgear auch nicht besonders, wir verbauen ausslisslich ARUBA, aber mögen und funktionieren sind zwei paar Schuhe.

Wir sprechen hier von einer simplen Datenübertragung über einen 10G Switch, dessen Bandbreite mit 240 Gbit/s angegeben wird.

Kein Trunk, kein AC, kein VLAN, kein SNMP, kein IP Routing, ... warum sollte das deiner Meinung nach nicht gehen?

Die NICs sind OK und bringen auch die Performance, hat Hubertus doch schon X Mal bestätigt.

@Hubertus

hat du den RAM-DISK Test schon gemacht?

Grüsse aus BaWü

Alex

wir verbauen ausslisslich ARUBA

Igitt...die sind ja noch schlimmer ! Der Rest von HP ist einfach nur gruselig vom internen ASIC Design. Aber muss einen auch nicht groß wundern, denn das ist ja alles zugekaufter und OEMter Kram und keinerlei Eigentwicklung von HP. Aber auch verständlich, denn deren Kerngeschäft ist eben ja nicht das Netzwerk.

Aber na ja...jeder bekommt halt die Infrastruktur die er verdient

Wir sprechen hier von einer simplen Datenübertragung über einen 10G Switch, dessen Bandbreite mit 240 Gbit/s angegeben wird.

Ja, das sind wie immer banale Marketing Zahlen. Aber wenn du den internen Paket Walkthrough im verbauten ASIC dir mal genau ansiehst, dann wirst du sehen das es nicht stimmt. 10 Gig ASIC Ports werden hier interne mit 2 oder oft 4 physischen Ports geshared. Klar, denn denn die normale HP Clientel braucht solche Durchsätze nicht. In dedizierten Projekten verjauft HP übrigens niemals eigenes Equipment sondern fast ausschliesslich nur Arista, Cisco oder manchmal auch Juniper. Ein Schelm wer Böses dabei denkt...!Im Überlast Fall kommt es so intern zu Congestions was die Portbuffer dann auffangen müssten. Aber das an sich ist schon das Problem. Da HP Billigteile verbaut und spart sind die Portbuffer nur sehr klein und wenn die voll sind fängt der Switch an Pakete zu droppen so das es dann zu dem bekannten TCP Buffer Bloating kommt, den man oben sehr schön an dem Sägezahn sehen kann.

In solchen Umgebungen wo es wirklich auf Durchsatz ankommt sollte man niemals billige Access Switches einsetzen sondern idealerweise Cut Through Modelle mit Trill oder SBP. Sowas kommt aber bekanntermaßen nicht von HP !

Moin Aqui,

das aller Erste und das Allerwichtigste ist es immer die Kirche im Dorf zu lassen.

Hubertus hat ein paar Clients und einen Server, das ist definitiv die Domäne von Access Switchen und nicht Datacenter & Co.

Ja, ich weis Marketing ...

Komisch, ich kenne ein paar Kunden die sich aufgrund vom diesem Marketing zu einem CISCO-WLAN entschieden haben.

Dieses haben wir dann nach ein paar Monaten, gegen ein funktionierendes getauscht.

Aqui, bleib bitte auf dem Teppich, mache das ganze auch schon seit > 20 Jahren. 😉

Meine acht Jahre alte Tochter, hat schon > 5 Core-Switche der Terabit-Klasse zusammengebaut.

Grüsse aus BaWü

Alex

das aller Erste und das Allerwichtigste ist es immer die Kirche im Dorf zu lassen.

Hubertus hat ein paar Clients und einen Server, das ist definitiv die Domäne von Access Switchen und nicht Datacenter & Co.

Ja, ich weis Marketing ...

Komisch, ich kenne ein paar Kunden die sich aufgrund vom diesem Marketing zu einem CISCO-WLAN entschieden haben.

Dieses haben wir dann nach ein paar Monaten, gegen ein funktionierendes getauscht.

Aqui, bleib bitte auf dem Teppich, mache das ganze auch schon seit > 20 Jahren. 😉

Meine acht Jahre alte Tochter, hat schon > 5 Core-Switche der Terabit-Klasse zusammengebaut.

Grüsse aus BaWü

Alex

Moin Hubertus,

"Bist Du sicher, dass RAID5 schneller schreibt als RAID10? Ich habe eigentlich überall anderslautende Aussagen gefunden. Für bessere Performanceausbeute und Rebuild wird immer RAId 10 empfohlen, für bessere Platzausbeute Raid5."

RAID10 schafft maximal nur 50% der summarischen Schreibleistung aller verwendeten SSDs, da auf den anderen 50% lediglich eine Kopie der Daten abgelegt wird.

Bei RAID5 schreiben N-1 gleichzeitig die Daten weg.

Zwar muss beim RAID5 noch der Parity-Bit berechnet werden, dass machen moderne RAID-Controller aber im Schlaf.

Zwar muss beim RAID5 noch der Parity-Bit berechnet werden, dass machen moderne RAID-Controller aber im Schlaf.

Einfach mal ausprobieren. 😉

Aber bitte das RAID immer vollständig initialisieren lassen, bevor du mit Performancetests beginnst.

Grüsse aus BaWü

Alex

"Bist Du sicher, dass RAID5 schneller schreibt als RAID10? Ich habe eigentlich überall anderslautende Aussagen gefunden. Für bessere Performanceausbeute und Rebuild wird immer RAId 10 empfohlen, für bessere Platzausbeute Raid5."

RAID10 schafft maximal nur 50% der summarischen Schreibleistung aller verwendeten SSDs, da auf den anderen 50% lediglich eine Kopie der Daten abgelegt wird.

Bei RAID5 schreiben N-1 gleichzeitig die Daten weg.

Einfach mal ausprobieren. 😉

Aber bitte das RAID immer vollständig initialisieren lassen, bevor du mit Performancetests beginnst.

Grüsse aus BaWü

Alex

Hi Hubertus,

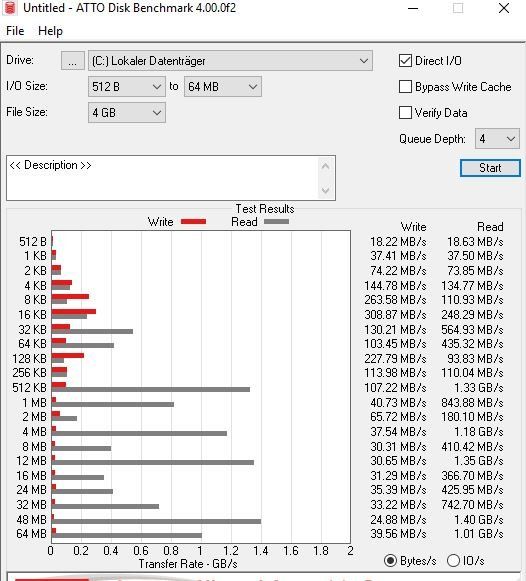

„ein Kurztest des raid controllers mit Mittelmaß SSDs in Raid5, Raid0 bringen total durchwachsene Ergebnisse, speziell write funktioniert nicht sauber, starke Pausen mit Sägezahn.“

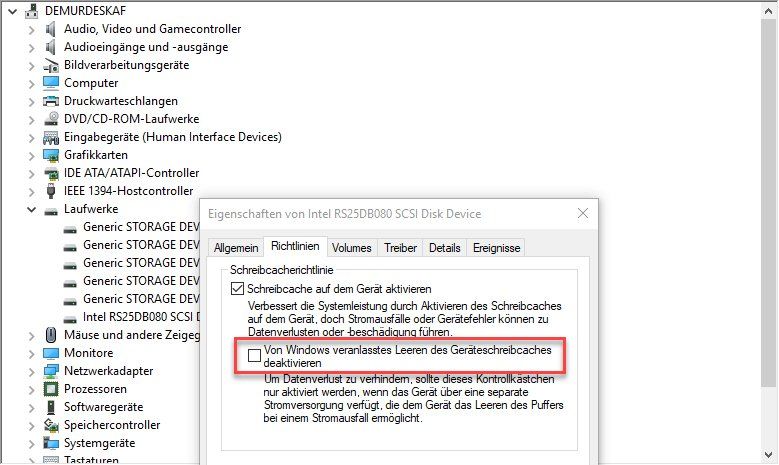

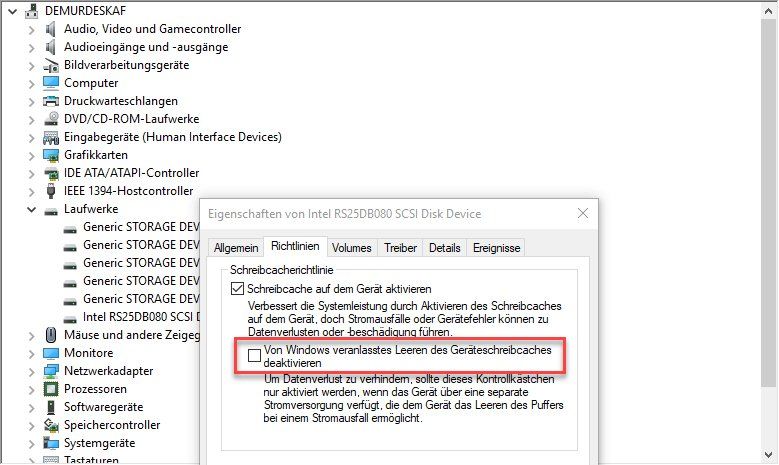

Das ist schon mal keine gute Nachricht. Das deutet darauf hin, dass der RAID-Controller den CACHE der SSDs deaktiviert hat. Dadurch hast du bei „Mittelmaß SSDs“ erst recht eine sehr bescheidene Schreibperformance.

Bei Intel und bei Broadcomcontroller kann man den DISK-CACHE in den Einstellungen des Controllers wieder aktivieren.

Bitte als erstes prüfen und gegebenen Falls wieder aktivieren, solltest du diese Option nicht finden dann ist der Controller für SSDs vollkommen ungeeignet.

In diesem Fall bekommst du über die nativen SATA Ports des Boards bessere Ergebnisse hin als über den RAID, da bei den SATA Ports der Cache der SSD normalerweise nicht deaktiviert wird.

Kommt der Sägezahn sofort, wenn du die Übertragung startest?

Wenn ja, dann wird der Cache des RAIDs ebenfalls nicht benutzt, dein RAID Verbund sollte auf „Write Back“ stehen und nicht auf „Write Through“.

???

Auf den Rest gehe ich noch später ein, meine Hausdrachen wachen demnächst auf und ich habe noch nichts zum Frühstück vorbereitet. 😊

Gruss Alex

„ein Kurztest des raid controllers mit Mittelmaß SSDs in Raid5, Raid0 bringen total durchwachsene Ergebnisse, speziell write funktioniert nicht sauber, starke Pausen mit Sägezahn.“

Das ist schon mal keine gute Nachricht. Das deutet darauf hin, dass der RAID-Controller den CACHE der SSDs deaktiviert hat. Dadurch hast du bei „Mittelmaß SSDs“ erst recht eine sehr bescheidene Schreibperformance.

Bei Intel und bei Broadcomcontroller kann man den DISK-CACHE in den Einstellungen des Controllers wieder aktivieren.

Bitte als erstes prüfen und gegebenen Falls wieder aktivieren, solltest du diese Option nicht finden dann ist der Controller für SSDs vollkommen ungeeignet.

In diesem Fall bekommst du über die nativen SATA Ports des Boards bessere Ergebnisse hin als über den RAID, da bei den SATA Ports der Cache der SSD normalerweise nicht deaktiviert wird.

Kommt der Sägezahn sofort, wenn du die Übertragung startest?

Wenn ja, dann wird der Cache des RAIDs ebenfalls nicht benutzt, dein RAID Verbund sollte auf „Write Back“ stehen und nicht auf „Write Through“.

???

Auf den Rest gehe ich noch später ein, meine Hausdrachen wachen demnächst auf und ich habe noch nichts zum Frühstück vorbereitet. 😊

Gruss Alex

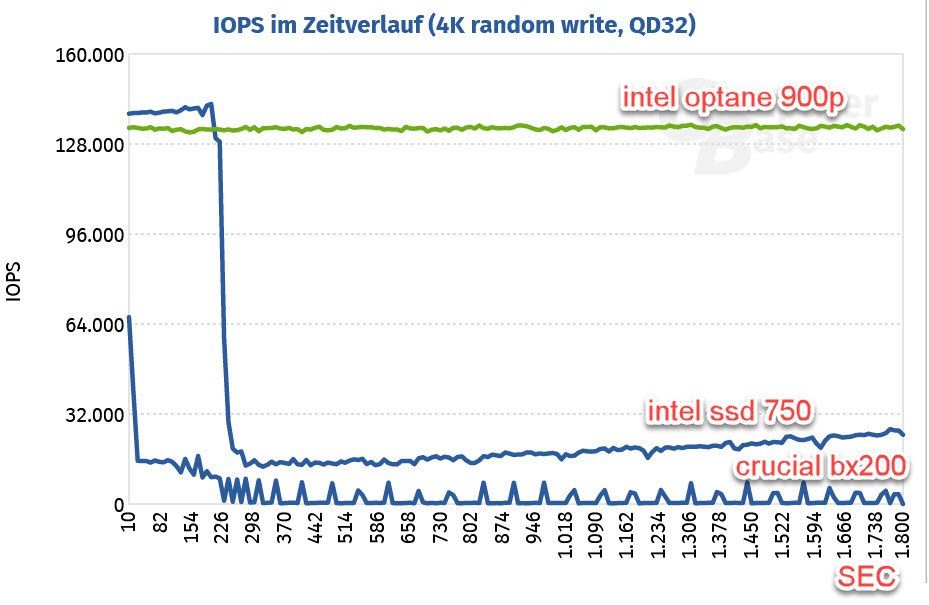

Hi Hubertus,

die Optane/XPOINT habe ich dir schon von Anfang an empfohlen. 😉

Zu den anderen beiden, weder die 750er von Intel noch die BX200 sind für einen RAID-Betrieb geeignet.

Bei Intel sollte man für RAID's immer eine SSD der Data Center Klasse wählen.

ark.intel.com/content/www/us/en/ark.html#@PanelLabel83425

Bei Crucial kann ich keine Empfehlung abgeben, da keine Erfahrung.

Gruss Alex

die Optane/XPOINT habe ich dir schon von Anfang an empfohlen. 😉

Zu den anderen beiden, weder die 750er von Intel noch die BX200 sind für einen RAID-Betrieb geeignet.

Bei Intel sollte man für RAID's immer eine SSD der Data Center Klasse wählen.

ark.intel.com/content/www/us/en/ark.html#@PanelLabel83425

Bei Crucial kann ich keine Empfehlung abgeben, da keine Erfahrung.

Gruss Alex

Moin Hubertus,

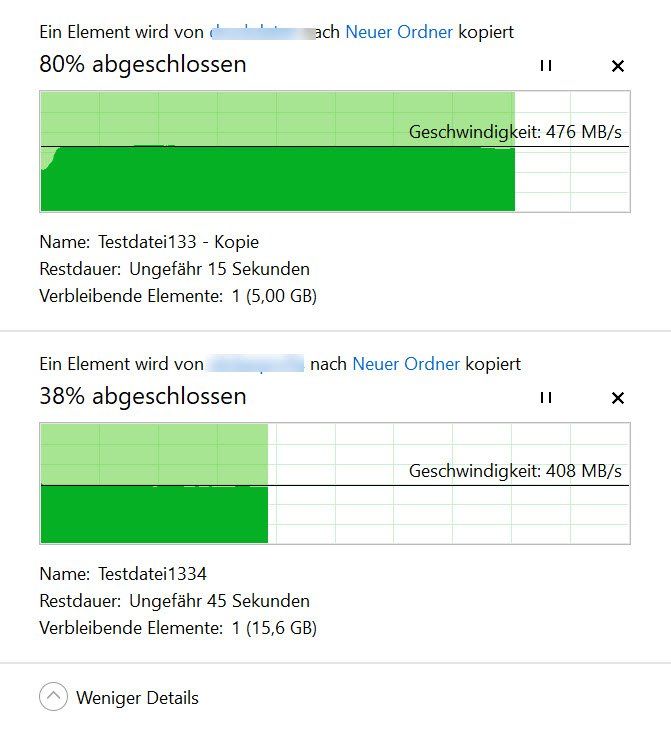

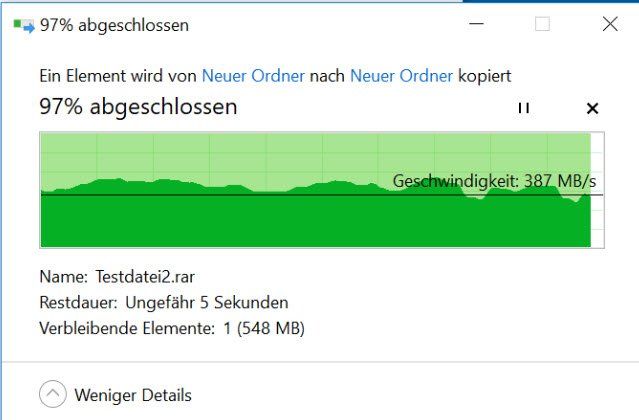

„1. SSD eigener Cache wieder aktiviert: download konstant, 816MB/sec , upload 486MB/sec (mit stoppuhr gemessen + filesize 24GB)

Sägezahn, aber die Pausen in den Tälern dauern nur noch 1 Sekunde. der Sägezahn kommt nach ca. 5GB, davor konstant (siehe screenshot vom 13.06.2019)“

Wir kommen der Lösung langsam näher. 😊

Sägezahn kommt immer, wenn der CACHE nicht benutzt oder geflutet ist.

Hast du deine Energieeinstellungen auf Hochleistung gesetzt? (sehr wichtig)

„Ich hatte gelesen: SSD eigenen cache bei raid definitiv deaktivieren, wegen Datenverlustproblem = Raid5 hinfällig.

Der Controller hat eine Batterie, die SSDs aber nicht.“

Ja das trifft auf fast alle SoHo SSDs zu, aber deshalb empfehle ich dir schon die ganze Zeit Enterprise-SSDs zu nehmen.

Diese haben das Problem nicht, zumindest nicht die von Intel und HGST/WD.

Bei Intel heisst das Feature „Enhanced Power Loss Data Protection“.

intel.com/content/dam/www/public/us/en/documents/technology-brie ...

In diesem PDF wird genau beschrieben, wie das Ganze funktioniert, ist zwar für ne alte 320er Serie, ist bei den neuen aber dasselbe.

„2. Gehe ich richtig in der Annahme, dass ich mind. 14 SAS Disks in Raid10 benötige, um überhaupt 800-1000 MB/sec zu erhalten?

Wir haben ja zwei Themen: Die Gesamtgeschwindigkeit und die native speed bei 4GB+“

Ich habe schon ein duzendes Mal auf unserer eigenen Hardware RAID 10 gegen RAID 5 getestet.

Jedes Mal war der RAID5 Verbund deutlich schneller, weshalb wir auch alle All-Flash Systeme auf RAID 5 fahren.

!!! A und O ist der richtige RAID-Controller und die passende SSD dazu, danach kommt erst der RAID-Level !!!

Lösung X:

SSD RAID5 4 x Enterprise-SSD (am besten SAS und nicht SATA):

PRO: bringt Leistung und Ausfallsicherheit

Grüsse aus BaWü

Alex

„1. SSD eigener Cache wieder aktiviert: download konstant, 816MB/sec , upload 486MB/sec (mit stoppuhr gemessen + filesize 24GB)

Sägezahn, aber die Pausen in den Tälern dauern nur noch 1 Sekunde. der Sägezahn kommt nach ca. 5GB, davor konstant (siehe screenshot vom 13.06.2019)“

Wir kommen der Lösung langsam näher. 😊

Sägezahn kommt immer, wenn der CACHE nicht benutzt oder geflutet ist.

Hast du deine Energieeinstellungen auf Hochleistung gesetzt? (sehr wichtig)

„Ich hatte gelesen: SSD eigenen cache bei raid definitiv deaktivieren, wegen Datenverlustproblem = Raid5 hinfällig.

Der Controller hat eine Batterie, die SSDs aber nicht.“

Ja das trifft auf fast alle SoHo SSDs zu, aber deshalb empfehle ich dir schon die ganze Zeit Enterprise-SSDs zu nehmen.

Diese haben das Problem nicht, zumindest nicht die von Intel und HGST/WD.

Bei Intel heisst das Feature „Enhanced Power Loss Data Protection“.

intel.com/content/dam/www/public/us/en/documents/technology-brie ...

In diesem PDF wird genau beschrieben, wie das Ganze funktioniert, ist zwar für ne alte 320er Serie, ist bei den neuen aber dasselbe.

„2. Gehe ich richtig in der Annahme, dass ich mind. 14 SAS Disks in Raid10 benötige, um überhaupt 800-1000 MB/sec zu erhalten?

Wir haben ja zwei Themen: Die Gesamtgeschwindigkeit und die native speed bei 4GB+“

Ich habe schon ein duzendes Mal auf unserer eigenen Hardware RAID 10 gegen RAID 5 getestet.

Jedes Mal war der RAID5 Verbund deutlich schneller, weshalb wir auch alle All-Flash Systeme auf RAID 5 fahren.

!!! A und O ist der richtige RAID-Controller und die passende SSD dazu, danach kommt erst der RAID-Level !!!

Lösung X:

SSD RAID5 4 x Enterprise-SSD (am besten SAS und nicht SATA):

PRO: bringt Leistung und Ausfallsicherheit

Grüsse aus BaWü

Alex

Zitat von @hub22019:

Wenn ich das stumpf in einen RAID Rechner eingebe, komme ich mit SAS Raid 5 auf: ca.350MB/sec?

Und das würde ja nicht reichen.

Wenn ich das stumpf in einen RAID Rechner eingebe, komme ich mit SAS Raid 5 auf: ca.350MB/sec?

Und das würde ja nicht reichen.

Was für ein RAID-Rechner und wieviele Platten?

lks

Hi Hubertus,

mit HDDs kommst du bei deinem Controller wahrscheinlich erst ab 6-8 Stück und RAID5 hin.

Der Cache des Controllers ist mit 2 GB einfach viel zu klein um die Platten bei der Geschwindigkeit ausreichend zu puffern.

Bei 1 1GByte/s ist dieser im schlimmsten Fall in zwei Sekunden voll.

Bei HHDs darf man ferner den DISK-CACHE im RAID-Betrieb AUF KEINEN FALL AKTIVIEREN. !!!

Das dar man nur wie schon oben geschrieben, nur bei entsprechenden gepufferten Server/Enterprise SSDs machen.

Mit 4 x Micron 5200er SSDs sollte es hingegen bei RAID5 sauber funktionieren.

!! Stripesize auf dem RAID = 64K !!

!! Datenpartition im OS mit ReFS mit Blocksize 64K formatieren !!

Grüsse aus BaWü

Alex

mit HDDs kommst du bei deinem Controller wahrscheinlich erst ab 6-8 Stück und RAID5 hin.

Der Cache des Controllers ist mit 2 GB einfach viel zu klein um die Platten bei der Geschwindigkeit ausreichend zu puffern.

Bei 1 1GByte/s ist dieser im schlimmsten Fall in zwei Sekunden voll.

Bei HHDs darf man ferner den DISK-CACHE im RAID-Betrieb AUF KEINEN FALL AKTIVIEREN. !!!

Das dar man nur wie schon oben geschrieben, nur bei entsprechenden gepufferten Server/Enterprise SSDs machen.

Mit 4 x Micron 5200er SSDs sollte es hingegen bei RAID5 sauber funktionieren.

!! Stripesize auf dem RAID = 64K !!

!! Datenpartition im OS mit ReFS mit Blocksize 64K formatieren !!

Grüsse aus BaWü

Alex

Moin Hubertus,

das sieht ja schon mal viel viel besser aus.

Hast du nach der Neuinstallation die folgenden Optimierungen vorgenommen ...

- Energieeinstellungen auf Hochleistung stellen oder auch Ultimative Leistung s.O.

- Leeren des Schreibcaches deaktivieren

- DiskCache der SSDs am RAID aktiviert?

- Falls ReadAhead aktiviert, bitte deaktivieren, bringt zwar beim Lesen einen kleinen vorteil, verlangsamt jedoch das Schreiben, da weniger Controller-Cache für die Schreibvorgänge zur Verfügung steht

---

Hast du die Tests gleich nach dem Aufsetzen gemacht?

Bei einem SSD Storage sollte man nach dem Initialisieren am besten, je nach Grösse 4-24h warten, bis man mit Performancetests beginnt.

Die SSDs benötigen nach der Initialisierung selbst ein bisschen Zeit für eine interne "Reorganisierung", erst danach steht die volle Performance am RAID zur Verfügung.

Grüsse aus BaWü

Alex

das sieht ja schon mal viel viel besser aus.

Hast du nach der Neuinstallation die folgenden Optimierungen vorgenommen ...

- Energieeinstellungen auf Hochleistung stellen oder auch Ultimative Leistung s.O.

- Leeren des Schreibcaches deaktivieren

- DiskCache der SSDs am RAID aktiviert?

- Falls ReadAhead aktiviert, bitte deaktivieren, bringt zwar beim Lesen einen kleinen vorteil, verlangsamt jedoch das Schreiben, da weniger Controller-Cache für die Schreibvorgänge zur Verfügung steht

---

Hast du die Tests gleich nach dem Aufsetzen gemacht?

Bei einem SSD Storage sollte man nach dem Initialisieren am besten, je nach Grösse 4-24h warten, bis man mit Performancetests beginnt.

Die SSDs benötigen nach der Initialisierung selbst ein bisschen Zeit für eine interne "Reorganisierung", erst danach steht die volle Performance am RAID zur Verfügung.

Grüsse aus BaWü

Alex