Erfahrungen mit Force10 und Mellanox Switchen

Hallo!

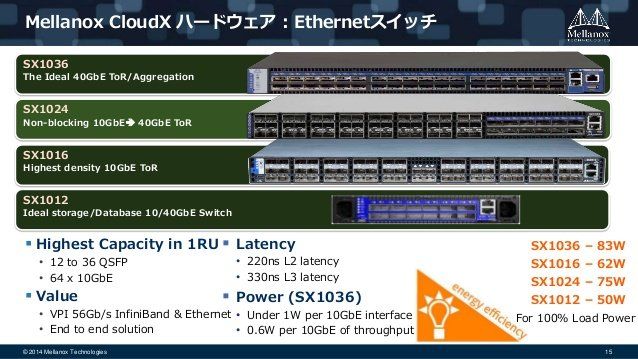

Ich bin gerade auf der Suche nach neuen Switchen - hauptsächlich im 40GBit/s-Umfeld.

Interessant finden ich aktuell die Geräte von Mellanox und Force10/Dell (S und Z-Serie - bisher von Force10).

Wir sind eure Erfahrungen mit den aktuellen Geräten der beiden Hersteller?

- Beide sind zumindest schon einmal vorbereitet, um eventuell ONIE-Betriebssysteme zu nutzen (sehe ich heute noch nicht, kann aber ja kommen).

- Bei beiden gibt es 10/40/100GbE mit Breakout-Kabeln. Beide

- Beide gehen stark auf MLAG/VLT

- Force10/Dell unterstützt noch einige, interessante Features mehr (Ring-Protokoll, mVLT)

Was mir bisher aufgefallen ist, was ich ziemlich unschön bei Force10/Dell finde, ist die Art VLANs zu konfigurieren. Bisher bin ich gewohnt:

Bei Force10 scheint es genau anders herum zu sein:

Es scheint auch keine schöne Option zu geben, einen "vollen Trunkport" zu erzeugen, der einfach immer alle VLANs durchlässt - auch nachträglich Angelegte.

Danke für eure Erfahrungen

Grüße

Phil

Ich bin gerade auf der Suche nach neuen Switchen - hauptsächlich im 40GBit/s-Umfeld.

Interessant finden ich aktuell die Geräte von Mellanox und Force10/Dell (S und Z-Serie - bisher von Force10).

Wir sind eure Erfahrungen mit den aktuellen Geräten der beiden Hersteller?

- Beide sind zumindest schon einmal vorbereitet, um eventuell ONIE-Betriebssysteme zu nutzen (sehe ich heute noch nicht, kann aber ja kommen).

- Bei beiden gibt es 10/40/100GbE mit Breakout-Kabeln. Beide

- Beide gehen stark auf MLAG/VLT

- Force10/Dell unterstützt noch einige, interessante Features mehr (Ring-Protokoll, mVLT)

Was mir bisher aufgefallen ist, was ich ziemlich unschön bei Force10/Dell finde, ist die Art VLANs zu konfigurieren. Bisher bin ich gewohnt:

interface XY

switchport trunk allowed vlan ....Bei Force10 scheint es genau anders herum zu sein:

interface vlan 100

tagged PORTXYEs scheint auch keine schöne Option zu geben, einen "vollen Trunkport" zu erzeugen, der einfach immer alle VLANs durchlässt - auch nachträglich Angelegte.

Danke für eure Erfahrungen

Grüße

Phil

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 349994

Url: https://administrator.de/forum/erfahrungen-mit-force10-und-mellanox-switchen-349994.html

Ausgedruckt am: 18.07.2025 um 06:07 Uhr

8 Kommentare

Neuester Kommentar

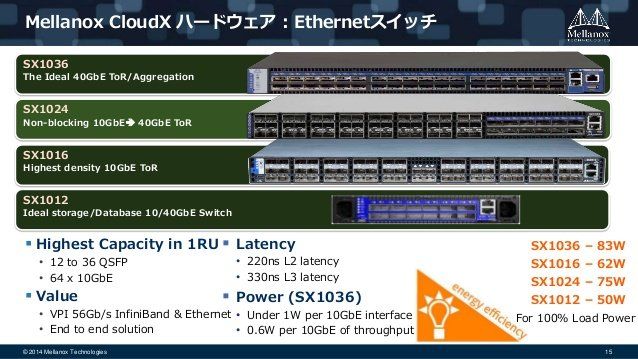

Mellanox ist ein absoluter Exot. Generell im Ethernet Bwereich unbekannt und mehr was im HPC Umfeld und Infiniband Vernetzung. Ethernet ist bei denen eher ne Nische.

Force 10 ist von Dell gekauft und deren Fokus ist nicht mehr Netzwerke. Entsprechend sieht man das an der massiv hinterherhinkenden Entwicklung. Frage was Dell in Zukunft mit dem Anhängsel macht. Siehe Feedback oben.

Brocade hat ein sehr gutes 40G Portfolio mit ICX 7450, 7750 und VDX Modellen. Speziell die VDX und deren VCS Fabrik wäre einen Blick wert, allerdings ist auch deren Zukunft nach dem Vewrkauf an Broadcom und der Zerteilung der IP Sparte eher ungewiss.

Bleibt dann eigentlich nur noch Arista und Cisco. Arista ist sicher auch einen Blick wert.

Force 10 ist von Dell gekauft und deren Fokus ist nicht mehr Netzwerke. Entsprechend sieht man das an der massiv hinterherhinkenden Entwicklung. Frage was Dell in Zukunft mit dem Anhängsel macht. Siehe Feedback oben.

Brocade hat ein sehr gutes 40G Portfolio mit ICX 7450, 7750 und VDX Modellen. Speziell die VDX und deren VCS Fabrik wäre einen Blick wert, allerdings ist auch deren Zukunft nach dem Vewrkauf an Broadcom und der Zerteilung der IP Sparte eher ungewiss.

Bleibt dann eigentlich nur noch Arista und Cisco. Arista ist sicher auch einen Blick wert.

Hallo zusammen,

vorab einmal etwas zu den Anbietern selber, bei Cisco und anderen Anbietern kann man einen Lehrgang

machen und sich zertifizieren lassen, bei Mellanox muss man bzw. sollte man einen Lehrgang oder eine

Schulung absolviert haben, sonst wird es schnell eng mit den Leuten die helfen können wenn mal etwas

nicht passt. Im Storage und SAN Umfeld sind nur wenige Unternehmen neben Mellanox, denn die steigen

gerade in das 200 GBit/s Umfeld ein bzw. damit richtig durch. Klar das dann ältere Hardware günstiger

zu erhalten ist! Aber selbst die ist den meisten Leuten immer noch viel zu teuer, allerdings auf der anderen

Seite auch immer schnell vergriffen, denn mit den Switchen und Karten von ein und dem selben Hersteller

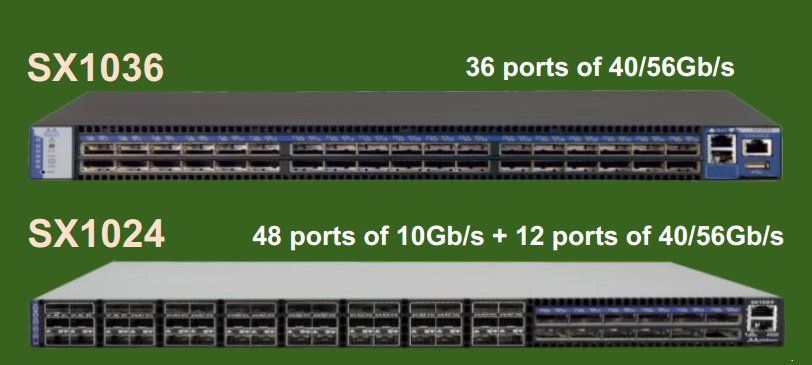

bleiben wir mal hier bei Mellanox, wird einem dann aber auch schon 56 GBit/s pro Port geboten und bei

Dual Port Karten sind das dann immerhin auch schon wieder ~112 GBit/s, das sollte auch mit

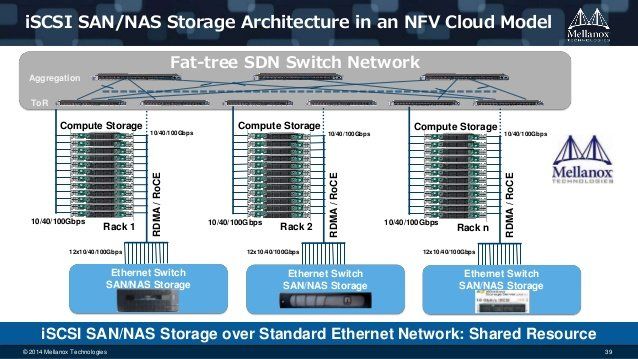

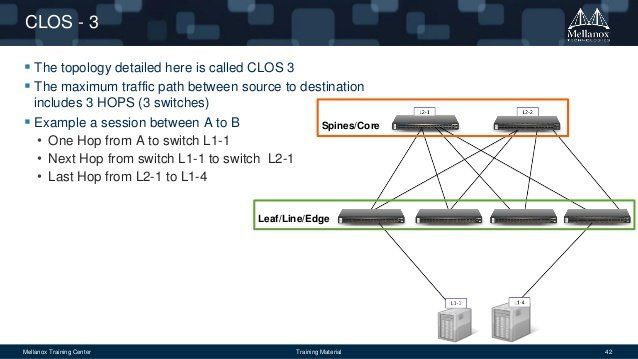

berücksichtigt werden. Mellanox arbeitet nach bzw. mit einem Spine Leaf Konzept, das heißt

dann aber auch für den Admin das er nicht nur Leaf Switche organisiert sondern auch die Spine

Switche anschafft, mittels derer man dann das extra SAN Netzwerk an das "normale"

Firmennetzwerk anbindet. Mal ein Beispiel dazu;

helfen kann, wenn es denn dazu kommen sollte, zum Beispiel Hamburgnet wäre hier wohl die

richtige Adresse für so eine professionelle Beratung.

ist mit Mellanox genauso gut beraten wie mit anderen Herstellern, und hat noch den Vorteil das man auf 56 GBit/s

ausweichen oder aufstocken kann, wenn man die Karten und Switche gleich richtig auswählt.

- 10 GBit/s mittels einer 10 GBit/s Karte

- 40 GBit/s mittels einer 40 GBit7s Karte

- 56 GBit/s mittels einer 56 GBit/s Karte (single Port)

- 2 x 56 GBit/s mittels einer 56 GBit/s Karte (dual Port)

oder sind dort die Zugriffszeiten im Storagebereich zu langsam?

auch haben oder bieten und dann eben mit einer homogenen Netzwerkinfrastruktur arbeiten!!! Dann ist

auch wirklich alles zueinander kompatibel, oder aber ein homogenes LAN und ein daran angeschlossenes

aber eigenes SAN Storage Netzwerk, macht auch Sinn und man hat dann auch mehr Möglichkeiten! Mit den

Dual Port Karten kann man bei Clustern natürlich einen Port an den Switch anschließen oder auch redundant

an die Leaf Switche anschließen, aber eben auch einen Port zum direkten synchronisieren benutzen dann

allerdings nur mit 40 GBit/s.

kann man dann auch mittels bezahlter Unterstützung von Profis sicherlich alle Probleme schnell lösen.

Sind eben eventuell Zusatzkosten mit im Spiel.

da sind die Euronen dann schon besser angelegt.

da gibt es sicherlich einige, aber eben auch nicht soooo viele weil das Marktsegment das eben nicht hergibt.

Nur die Grenzen verschieben sich eben auch gerne mal hin und wieder!!! Also ich möchte damit andeuten

und sagen, dass heute eben auch sehr viele bzw. mehr und mehr auch kleinere Firmen mit sehr vielen

Datenmengen und vor allem auch sehr großen Datenmengen umgehen müssen und diesen wollen,

sollen oder müssen dann auch schnell bewegt und angeboten werden. Das kann aber Cisco, Juniper

und Brocade auch alles mit abdecken, es kommt eben nur darauf an was man denn nun wirklich braucht

und wie lange es halten soll! Bei einer Investitionssumme von mehreren tausend Euros würde ich auch

gerne sehen wollen, dass sich die technik möglichst lange im Unternehmen hält und somit gut amortisiert!

aber das SAN oder der Storagebereich verreckt mir? Was nützt die Größe von Amazon, Google und Co. wenn

die Daten nicht schnell bereit gestellt werden?

Wenn man damit zwei oder mehr Server zu einem Cluster zusammen schließt und synchronisiert werden muss

und dann noch zwei oder mehrere SANs damit zugehören ist das schon nett mit den 56 GBit/s pro Port! Was habt

Ihr denn für Switche zur zeit bei Euch am laufen!?

Hier mal ein paar Meldungen von und über Mellanox:

Mellanox: (2016)

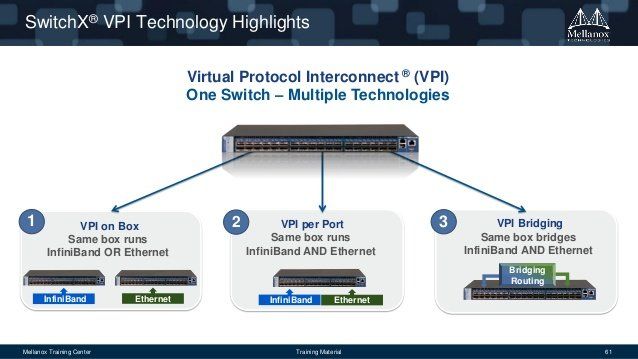

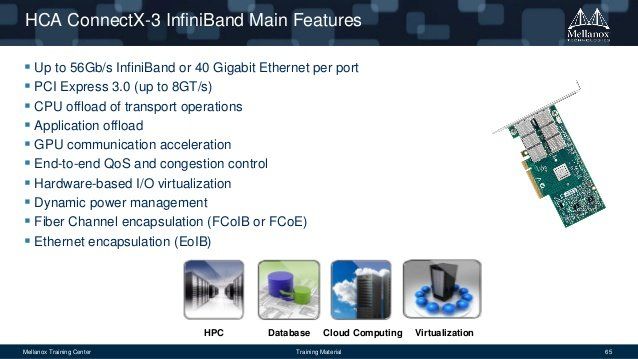

Virtual Protocol Interconnect (VPI) ermöglicht es standard Netzwerk-, Clustering-, Storage- und Managementprotokollen, nahtlos über jedes konvergente Netzwerk zu operieren, dank eines konsolidierten Softwarepaketes. Jeder Port kann via Infiniband, Ethernet, Data Center Bridging (DCB) Fabric und RDMA over Converged Ethernet (RoCE) operieren. VPI vereinfacht das I/O Systemdesign und erleichtert IT Managern die Einrichtung einer Infrastruktur, die den Herausforderungen dynamischer Rechenzentren gewachsen ist.

ComConsult: (2012)

Mellanox, der weltweit nach Umsatz führende Infiniband-Hersteller, hat seinen Gewinn im letzten Quartal erheblich gesteigert. Der Gewinn stieg um das 15-fache (!) gegenüber dem 2Q2011. Primärer Umsatzträger sind die SwitchX-ASICs und die dazu passenden ConnectX Adapter. Die Markteinführung des FDR-IB (FDR = Fourteen Data Rate 56 Gbit/s.) kann nur als grandios bezeichnet werden. Die Aussichten für die nächsten Quartale sind sogar noch besser. Spannend ist aber auch, dass der Besitzer konvergenter Ethernets von den IB-Qualitäten profitieren kann.

SearchStorage: (2010)

The merger leaves two InfininBand vendors — Mellanox and QLogic, which is primarily a Fibre Channel HBA vendor. Both have their sights on Ethernet as well, as Voltaire did before Mellanox bought it today for $176 million.

Liste und Preise von zertifizierter überholter Mellanox Hardware (also gebraucht)

Gruß

Dobby

vorab einmal etwas zu den Anbietern selber, bei Cisco und anderen Anbietern kann man einen Lehrgang

machen und sich zertifizieren lassen, bei Mellanox muss man bzw. sollte man einen Lehrgang oder eine

Schulung absolviert haben, sonst wird es schnell eng mit den Leuten die helfen können wenn mal etwas

nicht passt. Im Storage und SAN Umfeld sind nur wenige Unternehmen neben Mellanox, denn die steigen

gerade in das 200 GBit/s Umfeld ein bzw. damit richtig durch. Klar das dann ältere Hardware günstiger

zu erhalten ist! Aber selbst die ist den meisten Leuten immer noch viel zu teuer, allerdings auf der anderen

Seite auch immer schnell vergriffen, denn mit den Switchen und Karten von ein und dem selben Hersteller

bleiben wir mal hier bei Mellanox, wird einem dann aber auch schon 56 GBit/s pro Port geboten und bei

Dual Port Karten sind das dann immerhin auch schon wieder ~112 GBit/s, das sollte auch mit

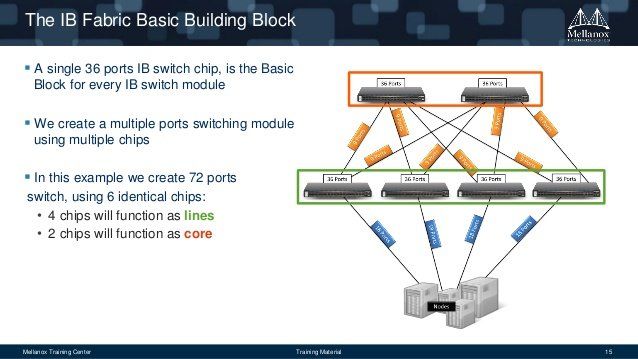

berücksichtigt werden. Mellanox arbeitet nach bzw. mit einem Spine Leaf Konzept, das heißt

dann aber auch für den Admin das er nicht nur Leaf Switche organisiert sondern auch die Spine

Switche anschafft, mittels derer man dann das extra SAN Netzwerk an das "normale"

Firmennetzwerk anbindet. Mal ein Beispiel dazu;

- 2 x Mellanox SX6036 (Spine) und 4 x SX6012 (Leaf)

- 1 x Mellanox SX6036 (Spine) und 2 x SX6012 (Leaf)

Ich bin gerade auf der Suche nach neuen Switchen - hauptsächlich im 40GBit/s-Umfeld.

Wie schon oben weiter beschrieben, würde ich mich an jemanden wenden der einem bei Mellanox richtighelfen kann, wenn es denn dazu kommen sollte, zum Beispiel Hamburgnet wäre hier wohl die

richtige Adresse für so eine professionelle Beratung.

Interessant finden ich aktuell die Geräte von Mellanox und Force10/Dell (S und Z-Serie - bisher von Force10).

Was nützt einem günstige Hardware mit schlechten Kritiken wenn der Laden 24/7 laufen muss?Wir sind eure Erfahrungen mit den aktuellen Geräten der beiden Hersteller?

Wer ein eigenes SAN Netzwerk aufziehen will und das dann an das bereits bestehende Netzwerk anbinden möchteist mit Mellanox genauso gut beraten wie mit anderen Herstellern, und hat noch den Vorteil das man auf 56 GBit/s

ausweichen oder aufstocken kann, wenn man die Karten und Switche gleich richtig auswählt.

- 10 GBit/s mittels einer 10 GBit/s Karte

- 40 GBit/s mittels einer 40 GBit7s Karte

- 56 GBit/s mittels einer 56 GBit/s Karte (single Port)

- 2 x 56 GBit/s mittels einer 56 GBit/s Karte (dual Port)

- Bei beiden gibt es 10/40/100GbE mit Breakout-Kabeln. Beide

- Beide gehen stark auf MLAG/VLT

Was brauchst Du bzw. Ihr denn nun wirklich? Braucht Ihr nur mehr Durchsatz im LAN und Storagebereich- Beide gehen stark auf MLAG/VLT

oder sind dort die Zugriffszeiten im Storagebereich zu langsam?

- Force10/Dell unterstützt noch einige, interessante Features mehr (Ring-Protokoll, mVLT)

Sicherlich nicht schlecht nur dann eben auch gleich bei Cisco fragen bzw. nachsehen ob die das nichtauch haben oder bieten und dann eben mit einer homogenen Netzwerkinfrastruktur arbeiten!!! Dann ist

auch wirklich alles zueinander kompatibel, oder aber ein homogenes LAN und ein daran angeschlossenes

aber eigenes SAN Storage Netzwerk, macht auch Sinn und man hat dann auch mehr Möglichkeiten! Mit den

Dual Port Karten kann man bei Clustern natürlich einen Port an den Switch anschließen oder auch redundant

an die Leaf Switche anschließen, aber eben auch einen Port zum direkten synchronisieren benutzen dann

allerdings nur mit 40 GBit/s.

Was mir bisher aufgefallen ist, was ich ziemlich unschön bei Force10/Dell finde, ist die Art VLANs zu

konfigurieren. Bisher bin ich gewohnt:

Wie gesagt für Cisco bekommt man hinterher mehr oder öfters Hilfestellungen, aber mit einer Schulungkonfigurieren. Bisher bin ich gewohnt:

kann man dann auch mittels bezahlter Unterstützung von Profis sicherlich alle Probleme schnell lösen.

Sind eben eventuell Zusatzkosten mit im Spiel.

Das mit Dell ist die große Frage, aber diese spiegelt sich auch im Preis wider.

Was soll es denn groß, wenn es funktionieren muss, und dann eventuell noch 24/7 oder redundant oben drauf,da sind die Euronen dann schon besser angelegt.

Das mit dem Exotenstatus sehe ich überall, aber ich frage mich, ob es schlecht ist.

Also Infinibandanbieter und Hardwarehersteller waren früher eben eher im größeren Umfeld zu finden undda gibt es sicherlich einige, aber eben auch nicht soooo viele weil das Marktsegment das eben nicht hergibt.

Nur die Grenzen verschieben sich eben auch gerne mal hin und wieder!!! Also ich möchte damit andeuten

und sagen, dass heute eben auch sehr viele bzw. mehr und mehr auch kleinere Firmen mit sehr vielen

Datenmengen und vor allem auch sehr großen Datenmengen umgehen müssen und diesen wollen,

sollen oder müssen dann auch schnell bewegt und angeboten werden. Das kann aber Cisco, Juniper

und Brocade auch alles mit abdecken, es kommt eben nur darauf an was man denn nun wirklich braucht

und wie lange es halten soll! Bei einer Investitionssumme von mehreren tausend Euros würde ich auch

gerne sehen wollen, dass sich die technik möglichst lange im Unternehmen hält und somit gut amortisiert!

Mellanox hat nach allem, was ich weiß, zumindest einen guten Ruf und die Produkte wirken interessant,

aber scheinbar ist die Marktdurchdringung klein.

Das würde ich nun weniger behaupten wollen denn was nützt mit einer Supercomputer der schnell rechnetaber scheinbar ist die Marktdurchdringung klein.

aber das SAN oder der Storagebereich verreckt mir? Was nützt die Größe von Amazon, Google und Co. wenn

die Daten nicht schnell bereit gestellt werden?

Was ich bisher gefunden habe, werden die Switche im Storageumfeld schon öfter eingesetzt, was ja nicht

schlecht sein muss.

Wofür benötigst Du (Ihr) denn diese Switche nun wirklich oder besser genau?schlecht sein muss.

Wenn man damit zwei oder mehr Server zu einem Cluster zusammen schließt und synchronisiert werden muss

und dann noch zwei oder mehrere SANs damit zugehören ist das schon nett mit den 56 GBit/s pro Port! Was habt

Ihr denn für Switche zur zeit bei Euch am laufen!?

Hier mal ein paar Meldungen von und über Mellanox:

Mellanox: (2016)

Virtual Protocol Interconnect (VPI) ermöglicht es standard Netzwerk-, Clustering-, Storage- und Managementprotokollen, nahtlos über jedes konvergente Netzwerk zu operieren, dank eines konsolidierten Softwarepaketes. Jeder Port kann via Infiniband, Ethernet, Data Center Bridging (DCB) Fabric und RDMA over Converged Ethernet (RoCE) operieren. VPI vereinfacht das I/O Systemdesign und erleichtert IT Managern die Einrichtung einer Infrastruktur, die den Herausforderungen dynamischer Rechenzentren gewachsen ist.

ComConsult: (2012)

Mellanox, der weltweit nach Umsatz führende Infiniband-Hersteller, hat seinen Gewinn im letzten Quartal erheblich gesteigert. Der Gewinn stieg um das 15-fache (!) gegenüber dem 2Q2011. Primärer Umsatzträger sind die SwitchX-ASICs und die dazu passenden ConnectX Adapter. Die Markteinführung des FDR-IB (FDR = Fourteen Data Rate 56 Gbit/s.) kann nur als grandios bezeichnet werden. Die Aussichten für die nächsten Quartale sind sogar noch besser. Spannend ist aber auch, dass der Besitzer konvergenter Ethernets von den IB-Qualitäten profitieren kann.

SearchStorage: (2010)

The merger leaves two InfininBand vendors — Mellanox and QLogic, which is primarily a Fibre Channel HBA vendor. Both have their sights on Ethernet as well, as Voltaire did before Mellanox bought it today for $176 million.

Liste und Preise von zertifizierter überholter Mellanox Hardware (also gebraucht)

Gruß

Dobby

Ich habe keine Spline-Leaf - auch keine klassische Core-/Aggregator-Infrastruktur

Es gibt wenige, aber recht performante Systeme, die auch ordentlich Last bekommen, da ich eine internationale

Infrastruktur von hier bediene.

Also das ist dann aber eher schon ein wenig in Richtung Brocade mit Trill, wenn man hier weder die eine nochInfrastruktur von hier bediene.

die andere Implementierung hat und Routing gar nicht vorhanden ist dann sollte man sich doch einmal Geräte

von Brocade anschauen.

Erkennst Du Dich (Euch) hier wieder, oder ist das etwas was für die Zukunft auch bei Euch laufen könnte?

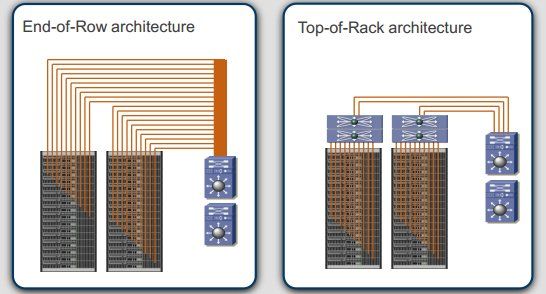

ToR vs EoR

ToR vs EoR

Entsprechend brauche ich eine Möglichkeit, die "wenigen Systeme" performant zu verbinden.

Sonst hängen an meinem "Mini-Backbone" noch einige Etagenswitche - auch diese redundant an je zwei N4000 mit RSTP.

- Nimm Dir dann lieber "normale" Anbieter die auch solche Sachen unterstützen und dann zusätzlich Mellanox- Oder nimm kein Melanox und realisiere es mit Force 10 oder Arista.

Ich nutze keinerlei L3-Funktionen!

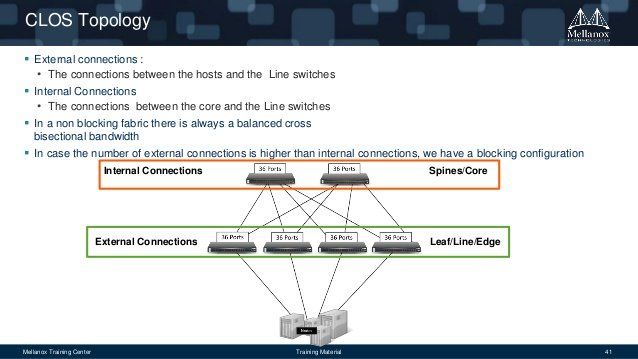

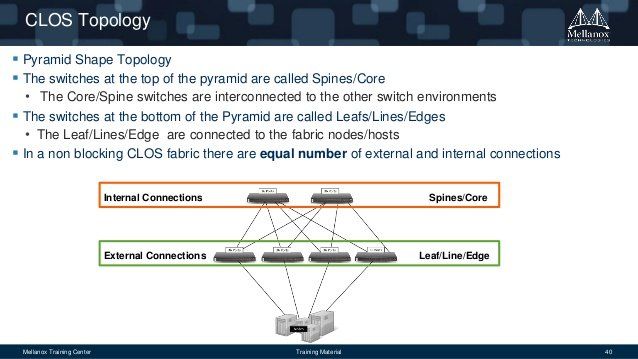

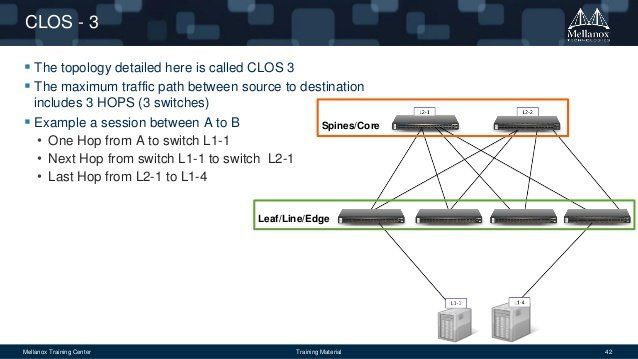

Hier mal zwei Slideshows auf Slideshare, die einem die Grundlagen zeigen und dann auch noch etwas überdie Einsatzzwecke von Mellanox & InfiniBand. Recht schnell durch geklickt, aber trotz alledem informativ.

InfiniBand Essentials

Mellanox for OpenStack

Beides in einem gibt es auch aber nicht wie Du es möchtest, bei Mellanox schließt immer die Hardware an

Director Switche (Leaf) an und diese dann an Edge Switche (Spine) und eben über diese werden dann die

Storage und SAN Geräte mit den Clustern verbunden.

Ich würde die Mellanox-Switche für SAN und LAN nutzen und eher auf die Ethernet-Schiene gehen.

Wenn ich es richtig sehe, unterstützen die neuen Ethernet-Serien auch keinen Mischbetrieb 56/40GbE

Da geht noch viel mehr.Wenn ich es richtig sehe, unterstützen die neuen Ethernet-Serien auch keinen Mischbetrieb 56/40GbE

Hier kommt wieder das Problem mit den wenigen Geräten bei mir.

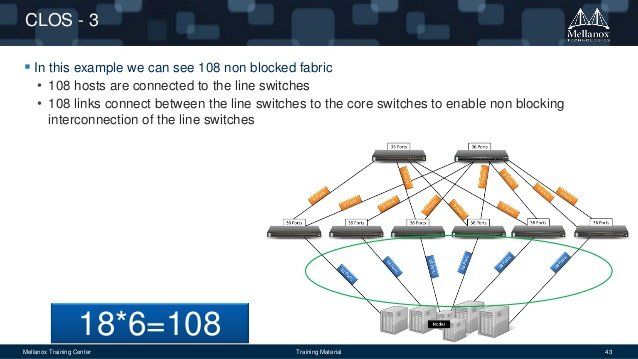

Dann ist CLOS3 eventuell das Ding für Euch. Es riecht vom kleinen 2 fach Cluster mit redundantem SANbis hin zu 108 Geräten in der Endausbaustufe.

Mein Storage-Netzwerk besteht aktuell aus ca. 15 Geräten. Dafür eine eigene Infrastruktur finde ich schwierig.

Gruß

Dobby