Performance Problem mit SSDs im RAID 5

Es handelt sich um einen Server, der hier mal die eierlegende

Wollmilchsau abgeben soll. Mit integriertem virtuellem DC, virtuellem

Fileserer, einigen RDS-Servern, einem MySQL-Server etc....

Betriebssystem: Windows 2012R2 Datacenter als Hyper-V-Server

RAM: 128 GB

Mainboard: Supermicro X10DRi-LN4+

Gehäuse: Supermicro SC213A-R740LPB

CPU: 2 x XEON E5-2640v3

RAID-Controller:

Zuerst Adaptec 71605 ungepuffert

Aktuell Adaptec 81605Z gepuffert

SSDs:

Raid 5 mit 9 x Samsung 850 Pro 1TB

Raid 1 mit 2 x Samsung 850 Pro 256GB

Ich weiß, ich weiß,.... Consumer-SSD's. Geld spielt eben immer eine Rolle.

Aufgesetzt habe ich den vor ca. 1 1/2 Jahren. Der lief seit mindestens

einem Jahr mit DC und einigen 2012er RDS- und 2003er Terminalservern

im Echtbetrieb. Zuletzt ging auch der Fileserver in Betrieb. Spürbare

Performance-Probleme gab es nie.

Abgesichert war der Server mit zwei parallelen USV's. Eine pro Netzteil.

Stromausfälle gab es schon. Da gab es nie ein Problem. Nun trat der

unwahrscheinliche Fall der Fälle ein. Ein sehr langer Stromausfall, den

die USV's nicht mehr überbrücken konnten. Um die Server zu schützen

fing ich nach einigen Minuten ohne Strom an, (auch) den Server

herunterzufahren. Er schaffte es aber nicht mehr, bevor die USV

abgeschaltet hat. Da hätte ich ihn wahrscheinlich besser völlig

ohne Last (aus)laufen lassen. Hätte, hätte,....

Seitdem habe ich das Drama hier. Das hat sich zunächst darin geäußert,

daß nach dem Reboot des Servers mehrere virtuelle Server nicht mehr

gebootet haben. Im Protokoll des Hyper-V-Servers fanden sich im

Sekundentakt "disk"-Fehler. Die VM's, die liefen, brachten ebenfalls

E/A-Fehler. Chkdsk sowohl auf den VM's als auch dem Hyper-V brachte

reichlich Fehler, die er angeblich korrigiert habe. Das hat nur nichts geholfen.

Die VM's waren hinüber. Ziemlich schlecht, aber noch keine Katastrophe.

Daten hatten wir ja keine verloren. Zudem haben wir zwei aktive Virtualisierungsserver.

Der andere (XEN mit HDDs) hat bei der Aktion nichts abbekommen.

Es ging jedoch weiter. Über das Wochenende hatte sich eine SSD aus dem

RAID 5 verabschiedet, das RAID 5 war degraded. Allerdings haben die

SSDs laut S.M.A.R.T. noch 99% der TBW. Also habe ich die angebliche fehlerhafte

SSD gezogen und wieder gesteckt. Das RAID hat anstandslos auf der angeblich

defekten SSD das Rebuild vollzogen. An den Fehlermeldungen in Windows

hat das leider nicht geändert. Hinzugekommen ist jedoch noch ein immer

wiederkehrender Eintrag im Protokoll des Controllers für das RAID5: "Bad Stripe".

Na danke. Sämtliche VMS bringen bei Chkdsk Fehler, die offensichtlich nicht

korrigiert werden können. Das war's dann für das RAID. Zurück auf Los. Sicherungen

der einzelnen Server hatte ich nicht. Nur von den Daten. Noch ein böser Fehler,

der mir nicht mehr passieren wird.

Also mache ich das RAID 5 platt und fange von vorne an. Das RAID 5 ist schnell

neu aufgesetzt. Es wird ein kompletter Verify gemacht. Die Platten und das RAID

sollten demnach wohl fehlerfrei sein. Das lief allerdings einige Stunden. Für meinen

Geschmack für ein RAID aus SSD's viel zu lange.

Dann habe ich Windows wieder neu installiert und erstmal mit sämtlichen Updates

versehen. Wenn schon, denn schon: Der RAID-Controller bekam die neueste Firmware,

die Windows-Treiber wurden ebenfalls auf den neuesten Stand gebracht. Für meine

Begriffe optimale Voraussetzungen für eine ordentliche Performance. Denkste!

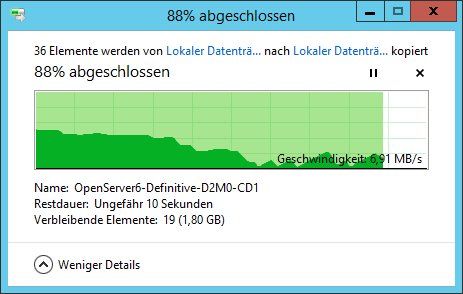

Habe ein paar einfache Kopierversuche mit ein paar GB an großen Dateien innerhalb des

RAID 5 gemacht und bin fast vom Stuhl gefallen. Die ersten ein oder zwei Sekunden

gingen noch zügig, dann brach die Leistung massivst ein. Die Schreibrate ging runter

bis nahezu auf 0 und schwankte dann zwischen max. ca. 100MB/s und einem

einstelligen Wert hin und her.

Da beim Build mit Verify (!) des neuen Arrays keine Fehler angezeigt wurden, konnte

ich mir einen Defekt an den SSDs einfach nicht vorstellen. Der nächste Verdächtige

war daher der Controller. Den habe ich dann gegen den obenstehenden, nagelneuen

Controller getauscht, natürlich einschließlich den dazu passenden, neuesten Treibern.

Wohlbemerkt: Bei beiden Controllern ist Write-Cache disabled!

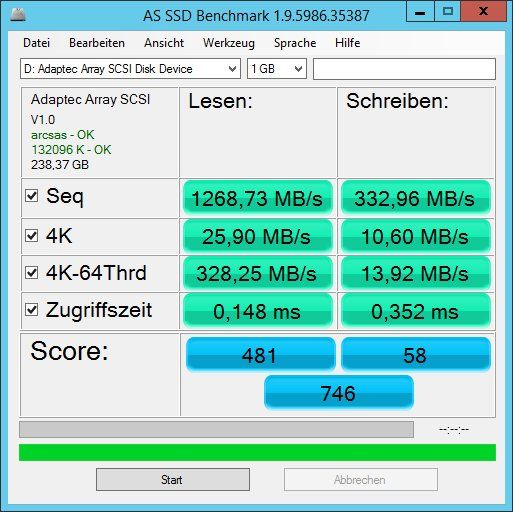

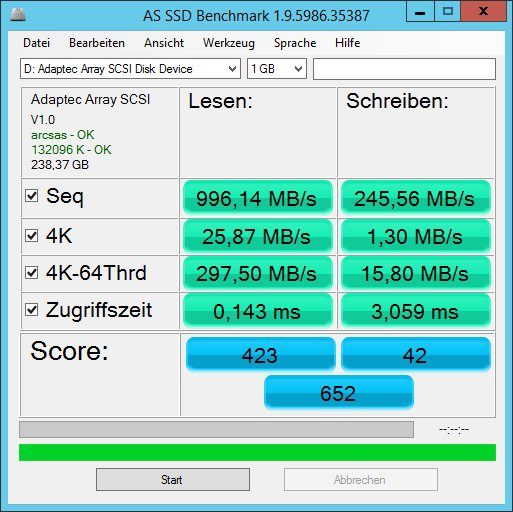

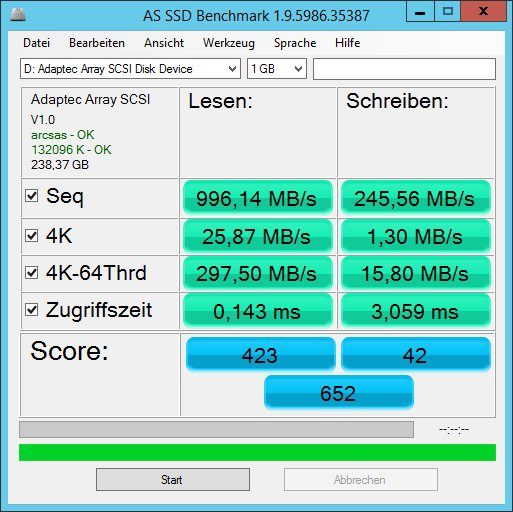

Das grausige Ergebnis trotz des neuen Controllers seht ihr hier. Das ist ein neu

aufgesetztes RAID5 aus 9 identischen Samsung 850Pro SSDs!!!

Der Server friert während dieser Messung oder bei o.g. Kopieraktion förmlich ein.

Es ist kaum mehr möglich, z.B. auch nur das Eregnisprotokoll zu starten. Auch wenn

ich vom allten Zustand leider keine solche Messungen habe, war DAS vorher ganz

sicher nie so. Alle VMs darauf liefen problemlos und ohne jeden Hänger. Selbst mit

parallel aktivem Fileserver auf der gleichen Hardware.

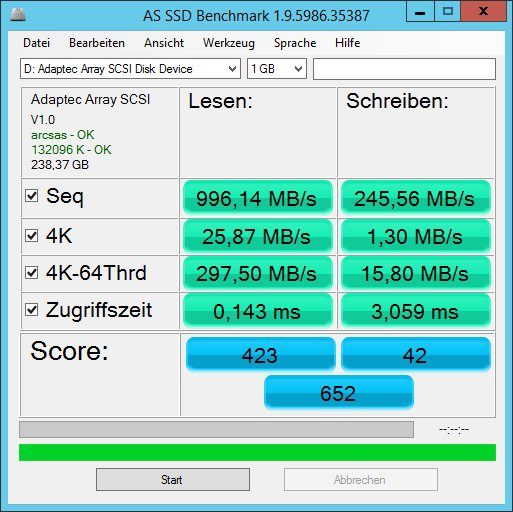

Die beiden separaten kleineren Platten im RAID1 sind auch ganz weit weg von "normal".

Auch das Ergebnis sehr ihr hier:

Und nun stehe ich richtig auf dem Schlauch. Mir ist bewußt, daß RAID 5 immer ein

Kompromiss aus Kosten und insbesondere Schreibleistung darstellt. Aber sowas???

Mittlerweile habe ich so einiges gegoogelt zum Thema Stomausfall und SSDs. Das

kann demnach tatsächlich zu einer breiten Spanne von Defekten bis hin zum

Totalausfall der SSD führen. Das wußte ich vorher nicht. Da so ein Vorfall nicht

vorgesehen war, verfügte auch weder der RAID-Controller über eine Pufferbatterie

/-kondensator noch waren die SSDs "power-loss-proteced".

Mangels besserer Ideen habe ich nach dem Tausch des Controllers gegen eine

mit Puffer nun auch noch einen Satz von 5 x Samsung PM863 (Enterprise-Ware,

power-loss-protected) bestellt, die die 9 x 1TB's ersetzen sollen. Allerdings bin ich

alles andere als sicher, daß das die Lösung des Problems ist. Falls doch, würde

das wohl bedeuten, daß die "alten" SSDs tatsächlich was abbekommen haben.

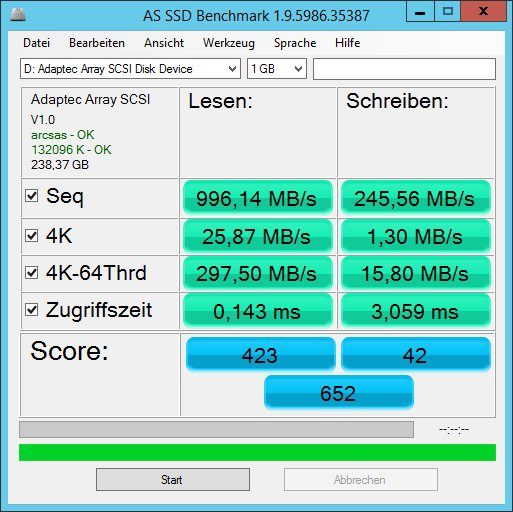

Zum Vergleich habe ich hier noch die gleiche Messung von meinem Laptop dran

gehängt. Da werkelt eine Samsung 850 EVO mit 1TB drin:

Sorry, war ein langer Vortrag. Aber ich denke, so sind viele Rückfragen schonmal im

Voraus geklärt.

Hat hier jemand hilfreiche Ideen dazu?

Oder auch Messwerte aus einer ähnlichen Konfiguration?

Bin für jede Hilfe dankbar!

Wollmilchsau abgeben soll. Mit integriertem virtuellem DC, virtuellem

Fileserer, einigen RDS-Servern, einem MySQL-Server etc....

Betriebssystem: Windows 2012R2 Datacenter als Hyper-V-Server

RAM: 128 GB

Mainboard: Supermicro X10DRi-LN4+

Gehäuse: Supermicro SC213A-R740LPB

CPU: 2 x XEON E5-2640v3

RAID-Controller:

Zuerst Adaptec 71605 ungepuffert

Aktuell Adaptec 81605Z gepuffert

SSDs:

Raid 5 mit 9 x Samsung 850 Pro 1TB

Raid 1 mit 2 x Samsung 850 Pro 256GB

Ich weiß, ich weiß,.... Consumer-SSD's. Geld spielt eben immer eine Rolle.

Aufgesetzt habe ich den vor ca. 1 1/2 Jahren. Der lief seit mindestens

einem Jahr mit DC und einigen 2012er RDS- und 2003er Terminalservern

im Echtbetrieb. Zuletzt ging auch der Fileserver in Betrieb. Spürbare

Performance-Probleme gab es nie.

Abgesichert war der Server mit zwei parallelen USV's. Eine pro Netzteil.

Stromausfälle gab es schon. Da gab es nie ein Problem. Nun trat der

unwahrscheinliche Fall der Fälle ein. Ein sehr langer Stromausfall, den

die USV's nicht mehr überbrücken konnten. Um die Server zu schützen

fing ich nach einigen Minuten ohne Strom an, (auch) den Server

herunterzufahren. Er schaffte es aber nicht mehr, bevor die USV

abgeschaltet hat. Da hätte ich ihn wahrscheinlich besser völlig

ohne Last (aus)laufen lassen. Hätte, hätte,....

Seitdem habe ich das Drama hier. Das hat sich zunächst darin geäußert,

daß nach dem Reboot des Servers mehrere virtuelle Server nicht mehr

gebootet haben. Im Protokoll des Hyper-V-Servers fanden sich im

Sekundentakt "disk"-Fehler. Die VM's, die liefen, brachten ebenfalls

E/A-Fehler. Chkdsk sowohl auf den VM's als auch dem Hyper-V brachte

reichlich Fehler, die er angeblich korrigiert habe. Das hat nur nichts geholfen.

Die VM's waren hinüber. Ziemlich schlecht, aber noch keine Katastrophe.

Daten hatten wir ja keine verloren. Zudem haben wir zwei aktive Virtualisierungsserver.

Der andere (XEN mit HDDs) hat bei der Aktion nichts abbekommen.

Es ging jedoch weiter. Über das Wochenende hatte sich eine SSD aus dem

RAID 5 verabschiedet, das RAID 5 war degraded. Allerdings haben die

SSDs laut S.M.A.R.T. noch 99% der TBW. Also habe ich die angebliche fehlerhafte

SSD gezogen und wieder gesteckt. Das RAID hat anstandslos auf der angeblich

defekten SSD das Rebuild vollzogen. An den Fehlermeldungen in Windows

hat das leider nicht geändert. Hinzugekommen ist jedoch noch ein immer

wiederkehrender Eintrag im Protokoll des Controllers für das RAID5: "Bad Stripe".

Na danke. Sämtliche VMS bringen bei Chkdsk Fehler, die offensichtlich nicht

korrigiert werden können. Das war's dann für das RAID. Zurück auf Los. Sicherungen

der einzelnen Server hatte ich nicht. Nur von den Daten. Noch ein böser Fehler,

der mir nicht mehr passieren wird.

Also mache ich das RAID 5 platt und fange von vorne an. Das RAID 5 ist schnell

neu aufgesetzt. Es wird ein kompletter Verify gemacht. Die Platten und das RAID

sollten demnach wohl fehlerfrei sein. Das lief allerdings einige Stunden. Für meinen

Geschmack für ein RAID aus SSD's viel zu lange.

Dann habe ich Windows wieder neu installiert und erstmal mit sämtlichen Updates

versehen. Wenn schon, denn schon: Der RAID-Controller bekam die neueste Firmware,

die Windows-Treiber wurden ebenfalls auf den neuesten Stand gebracht. Für meine

Begriffe optimale Voraussetzungen für eine ordentliche Performance. Denkste!

Habe ein paar einfache Kopierversuche mit ein paar GB an großen Dateien innerhalb des

RAID 5 gemacht und bin fast vom Stuhl gefallen. Die ersten ein oder zwei Sekunden

gingen noch zügig, dann brach die Leistung massivst ein. Die Schreibrate ging runter

bis nahezu auf 0 und schwankte dann zwischen max. ca. 100MB/s und einem

einstelligen Wert hin und her.

Da beim Build mit Verify (!) des neuen Arrays keine Fehler angezeigt wurden, konnte

ich mir einen Defekt an den SSDs einfach nicht vorstellen. Der nächste Verdächtige

war daher der Controller. Den habe ich dann gegen den obenstehenden, nagelneuen

Controller getauscht, natürlich einschließlich den dazu passenden, neuesten Treibern.

Wohlbemerkt: Bei beiden Controllern ist Write-Cache disabled!

Das grausige Ergebnis trotz des neuen Controllers seht ihr hier. Das ist ein neu

aufgesetztes RAID5 aus 9 identischen Samsung 850Pro SSDs!!!

Der Server friert während dieser Messung oder bei o.g. Kopieraktion förmlich ein.

Es ist kaum mehr möglich, z.B. auch nur das Eregnisprotokoll zu starten. Auch wenn

ich vom allten Zustand leider keine solche Messungen habe, war DAS vorher ganz

sicher nie so. Alle VMs darauf liefen problemlos und ohne jeden Hänger. Selbst mit

parallel aktivem Fileserver auf der gleichen Hardware.

Die beiden separaten kleineren Platten im RAID1 sind auch ganz weit weg von "normal".

Auch das Ergebnis sehr ihr hier:

Und nun stehe ich richtig auf dem Schlauch. Mir ist bewußt, daß RAID 5 immer ein

Kompromiss aus Kosten und insbesondere Schreibleistung darstellt. Aber sowas???

Mittlerweile habe ich so einiges gegoogelt zum Thema Stomausfall und SSDs. Das

kann demnach tatsächlich zu einer breiten Spanne von Defekten bis hin zum

Totalausfall der SSD führen. Das wußte ich vorher nicht. Da so ein Vorfall nicht

vorgesehen war, verfügte auch weder der RAID-Controller über eine Pufferbatterie

/-kondensator noch waren die SSDs "power-loss-proteced".

Mangels besserer Ideen habe ich nach dem Tausch des Controllers gegen eine

mit Puffer nun auch noch einen Satz von 5 x Samsung PM863 (Enterprise-Ware,

power-loss-protected) bestellt, die die 9 x 1TB's ersetzen sollen. Allerdings bin ich

alles andere als sicher, daß das die Lösung des Problems ist. Falls doch, würde

das wohl bedeuten, daß die "alten" SSDs tatsächlich was abbekommen haben.

Zum Vergleich habe ich hier noch die gleiche Messung von meinem Laptop dran

gehängt. Da werkelt eine Samsung 850 EVO mit 1TB drin:

Sorry, war ein langer Vortrag. Aber ich denke, so sind viele Rückfragen schonmal im

Voraus geklärt.

Hat hier jemand hilfreiche Ideen dazu?

Oder auch Messwerte aus einer ähnlichen Konfiguration?

Bin für jede Hilfe dankbar!

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 317844

Url: https://administrator.de/forum/performance-problem-mit-ssds-im-raid-5-317844.html

Ausgedruckt am: 19.07.2025 um 04:07 Uhr

14 Kommentare

Neuester Kommentar

Hallo pmadmin,

Probleme wirst du wahrscheinlich bekommen da Raid 5/6 die maximalen Schreib/Lesezyklen der SSDs sehr schnell aufbraucht. Die Lebenszeit der SSD´s werden durch die Paritätsdaten stark verkürzt.

webhostingtalk.com/showthread.php?t=1457939

serverfault.com/questions/513909/what-are-the-main-points-to-avo ...

rootforum.org/forum/viewtopic.php?t=54744

VG Xartor

Probleme wirst du wahrscheinlich bekommen da Raid 5/6 die maximalen Schreib/Lesezyklen der SSDs sehr schnell aufbraucht. Die Lebenszeit der SSD´s werden durch die Paritätsdaten stark verkürzt.

webhostingtalk.com/showthread.php?t=1457939

serverfault.com/questions/513909/what-are-the-main-points-to-avo ...

rootforum.org/forum/viewtopic.php?t=54744

VG Xartor

Moin,

Teste doch mal mit Write-Back Cache.

VG

Val

Wohlbemerkt: Bei beiden Controllern ist Write-Cache disabled!

Warum? Das bringt doch gerade bei Raid 5 Schreib-Performance!Teste doch mal mit Write-Back Cache.

VG

Val

Noch eine Anmerkung am Rande zu Deiner USV: Wenn der Server nach einer Zeit X es nicht mehr schafft sauber herunter zu fahren, ist die Zeit entweder zu lang oder die USV zu klein bemessen. Deswegen sollten die Server das auch automatisch machen (nach Meldung durch die USV) und nicht, wie von Dir oben beschrieben, manuell.

Gruß

Looser

Gruß

Looser

erst mal Guten Morgen

Betriebssystem: Windows 2012R2 Datacenter als Hyper-V-Server

RAM: 128 GB

Mainboard: Supermicro X10DRi-LN4+

Gehäuse: Supermicro SC213A-R740LPB

CPU: 2 x XEON E5-2640v3

RAID-Controller:

Zuerst Adaptec 71605 ungepuffert

Aktuell Adaptec 81605Z gepuffert

hm... ich persönlich komme auf Adaptec überhaupt nicht klar!

ich rate zu LSI MegaRAID SAS 9361-4i /-8 ... mit BBU/ Flash

Tip : nur Raid 1 oder Raid 10

Aufgesetzt habe ich den vor ca. 1 1/2 Jahren. Der lief seit mindestens

hat lange gehalten...

Seitdem habe ich das Drama hier. Das hat sich zunächst darin geäußert,

daß nach dem Reboot des Servers mehrere virtuelle Server nicht mehr

gebootet haben. Im Protokoll des Hyper-V-Servers fanden sich im

Sekundentakt "disk"-Fehler. Die VM's, die liefen, brachten ebenfalls

E/A-Fehler. Chkdsk sowohl auf den VM's als auch dem Hyper-V brachte

reichlich Fehler, die er angeblich korrigiert habe. Das hat nur nichts geholfen.

Die VM's waren hinüber. Ziemlich schlecht, aber noch keine Katastrophe.

Daten hatten wir ja keine verloren. Zudem haben wir zwei aktive Virtualisierungsserver.

Der andere (XEN mit HDDs) hat bei der Aktion nichts abbekommen.

Es ging jedoch weiter. Über das Wochenende hatte sich eine SSD aus dem

RAID 5 verabschiedet, das RAID 5 war degraded. Allerdings haben die

SSDs laut S.M.A.R.T. noch 99% der TBW. Also habe ich die angebliche fehlerhafte

SSD gezogen und wieder gesteckt. Das RAID hat anstandslos auf der angeblich

defekten SSD das Rebuild vollzogen. An den Fehlermeldungen in Windows

hat das leider nicht geändert. Hinzugekommen ist jedoch noch ein immer

wiederkehrender Eintrag im Protokoll des Controllers für das RAID5: "Bad Stripe".

Na danke. Sämtliche VMS bringen bei Chkdsk Fehler, die offensichtlich nicht

korrigiert werden können. Das war's dann für das RAID. Zurück auf Los. Sicherungen

der einzelnen Server hatte ich nicht. Nur von den Daten. Noch ein böser Fehler,

der mir nicht mehr passieren wird.

ich hoffe du lernst wirklich daraus

Also mache ich das RAID 5 platt und fange von vorne an. Das RAID 5 ist schnell

neu aufgesetzt. Es wird ein kompletter Verify gemacht. Die Platten und das RAID

sollten demnach wohl fehlerfrei sein. Das lief allerdings einige Stunden. Für meinen

Geschmack für ein RAID aus SSD's viel zu lange.

angeschlagene SSD´s Raid5 .. da machst du besser mal kein Verify...

Dann habe ich Windows wieder neu installiert und erstmal mit sämtlichen Updates

versehen. Wenn schon, denn schon: Der RAID-Controller bekam die neueste Firmware,

die Windows-Treiber wurden ebenfalls auf den neuesten Stand gebracht. Für meine

Begriffe optimale Voraussetzungen für eine ordentliche Performance. Denkste!

Habe ein paar einfache Kopierversuche mit ein paar GB an großen Dateien innerhalb des

RAID 5 gemacht und bin fast vom Stuhl gefallen. Die ersten ein oder zwei Sekunden

gingen noch zügig, dann brach die Leistung massivst ein. Die Schreibrate ging runter

bis nahezu auf 0 und schwankte dann zwischen max. ca. 100MB/s und einem

einstelligen Wert hin und her.

test mal die SSD´s mit dem Samsung Tool auf einen Windows PC .. am Sata Port des MB!

Da beim Build mit Verify (!) des neuen Arrays keine Fehler angezeigt wurden, konnte

ich mir einen Defekt an den SSDs einfach nicht vorstellen. Der nächste Verdächtige

war daher der Controller. Den habe ich dann gegen den obenstehenden, nagelneuen

Controller getauscht, natürlich einschließlich den dazu passenden, neuesten Treibern.

wie gesagt, mit Adaptec komme ich nicht klar- besser wäre ein LSI MegaRAID SAS 9361-X aufwärts...

und nur Raid 1 und 10...

Wohlbemerkt: Bei beiden Controllern ist Write-Cache disabled!

den kannst du anschalten...

Das grausige Ergebnis trotz des neuen Controllers seht ihr hier. Das ist ein neu

aufgesetztes RAID5 aus 9 identischen Samsung 850Pro SSDs!!!

Der Server friert während dieser Messung oder bei o.g. Kopieraktion förmlich ein.

Es ist kaum mehr möglich, z.B. auch nur das Eregnisprotokoll zu starten. Auch wenn

ich vom allten Zustand leider keine solche Messungen habe, war DAS vorher ganz

sicher nie so. Alle VMs darauf liefen problemlos und ohne jeden Hänger. Selbst mit

parallel aktivem Fileserver auf der gleichen Hardware.

Die beiden separaten kleineren Platten im RAID1 sind auch ganz weit weg von "normal".

Auch das Ergebnis sehr ihr hier:

Und nun stehe ich richtig auf dem Schlauch. Mir ist bewußt, daß RAID 5 immer ein

Kompromiss aus Kosten und insbesondere Schreibleistung darstellt. Aber sowas???

noch einmal... dem Adaptec traue ich eh nicht... aber sicher ist- deine SSD´s im Raid 5 sind Fertig mit Schönschreiben....

Mittlerweile habe ich so einiges gegoogelt zum Thema Stomausfall und SSDs. Das

kann demnach tatsächlich zu einer breiten Spanne von Defekten bis hin zum

Totalausfall der SSD führen. Das wußte ich vorher nicht. Da so ein Vorfall nicht

vorgesehen war, verfügte auch weder der RAID-Controller über eine Pufferbatterie

/-kondensator noch waren die SSDs "power-loss-proteced".

oh weh... aber daraus lernt man ja...

Mangels besserer Ideen habe ich nach dem Tausch des Controllers gegen eine

mit Puffer nun auch noch einen Satz von 5 x Samsung PM863 (Enterprise-Ware,

power-loss-protected) bestellt, die die 9 x 1TB's ersetzen sollen. Allerdings bin ich

alles andere als sicher, daß das die Lösung des Problems ist. Falls doch, würde

das wohl bedeuten, daß die "alten" SSDs tatsächlich was abbekommen haben.

baue alles in kleinen Raid 1 häpchen... und kein Raid5

Zum Vergleich habe ich hier noch die gleiche Messung von meinem Laptop dran

gehängt. Da werkelt eine Samsung 850 EVO mit 1TB drin:

Sorry, war ein langer Vortrag. Aber ich denke, so sind viele Rückfragen schonmal im

Voraus geklärt.

Hat hier jemand hilfreiche Ideen dazu?

wir haben hier Stapelweise SSD´s liegen - die In Raid 5 /6 betrieb waren- alle haben nach kurzer zeit aufgegeben.

mitlerweile schreiben wir in unseren Rechnungen und Lieferscheinen das SSD´s nicht für eine Raid 5/6 config geeignet sind- und Garantie verlust droht!

Frank

Zitat von @p-m-a-d-m-i-n:

Es handelt sich um einen Server, der hier mal die eierlegende

Wollmilchsau abgeben soll. Mit integriertem virtuellem DC, virtuellem

Fileserer, einigen RDS-Servern, einem MySQL-Server etc....

hmmmEs handelt sich um einen Server, der hier mal die eierlegende

Wollmilchsau abgeben soll. Mit integriertem virtuellem DC, virtuellem

Fileserer, einigen RDS-Servern, einem MySQL-Server etc....

Betriebssystem: Windows 2012R2 Datacenter als Hyper-V-Server

RAM: 128 GB

Mainboard: Supermicro X10DRi-LN4+

Gehäuse: Supermicro SC213A-R740LPB

CPU: 2 x XEON E5-2640v3

RAID-Controller:

Zuerst Adaptec 71605 ungepuffert

Aktuell Adaptec 81605Z gepuffert

ich rate zu LSI MegaRAID SAS 9361-4i /-8 ... mit BBU/ Flash

SSDs:

Raid 5 mit 9 x Samsung 850 Pro 1TB

uuuuh.. Raid 5 mit 9 x 850er Pro ... laufzeit ca. 3 bis max 12 Monate..Raid 5 mit 9 x Samsung 850 Pro 1TB

Tip : nur Raid 1 oder Raid 10

Raid 1 mit 2 x Samsung 850 Pro 256GB

Ich weiß, ich weiß,.... Consumer-SSD's. Geld spielt eben immer eine Rolle.

und die Rache kommt jetzt Ich weiß, ich weiß,.... Consumer-SSD's. Geld spielt eben immer eine Rolle.

Aufgesetzt habe ich den vor ca. 1 1/2 Jahren. Der lief seit mindestens

einem Jahr mit DC und einigen 2012er RDS- und 2003er Terminalservern

im Echtbetrieb. Zuletzt ging auch der Fileserver in Betrieb. Spürbare

Performance-Probleme gab es nie.

Abgesichert war der Server mit zwei parallelen USV's. Eine pro Netzteil.

Stromausfälle gab es schon. Da gab es nie ein Problem. Nun trat der

unwahrscheinliche Fall der Fälle ein. Ein sehr langer Stromausfall, den

die USV's nicht mehr überbrücken konnten. Um die Server zu schützen

fing ich nach einigen Minuten ohne Strom an, (auch) den Server

herunterzufahren. Er schaffte es aber nicht mehr, bevor die USV

abgeschaltet hat. Da hätte ich ihn wahrscheinlich besser völlig

ohne Last (aus)laufen lassen. Hätte, hätte,....

ja ja... im Echtbetrieb. Zuletzt ging auch der Fileserver in Betrieb. Spürbare

Performance-Probleme gab es nie.

Abgesichert war der Server mit zwei parallelen USV's. Eine pro Netzteil.

Stromausfälle gab es schon. Da gab es nie ein Problem. Nun trat der

unwahrscheinliche Fall der Fälle ein. Ein sehr langer Stromausfall, den

die USV's nicht mehr überbrücken konnten. Um die Server zu schützen

fing ich nach einigen Minuten ohne Strom an, (auch) den Server

herunterzufahren. Er schaffte es aber nicht mehr, bevor die USV

abgeschaltet hat. Da hätte ich ihn wahrscheinlich besser völlig

ohne Last (aus)laufen lassen. Hätte, hätte,....

Seitdem habe ich das Drama hier. Das hat sich zunächst darin geäußert,

daß nach dem Reboot des Servers mehrere virtuelle Server nicht mehr

gebootet haben. Im Protokoll des Hyper-V-Servers fanden sich im

Sekundentakt "disk"-Fehler. Die VM's, die liefen, brachten ebenfalls

E/A-Fehler. Chkdsk sowohl auf den VM's als auch dem Hyper-V brachte

reichlich Fehler, die er angeblich korrigiert habe. Das hat nur nichts geholfen.

Die VM's waren hinüber. Ziemlich schlecht, aber noch keine Katastrophe.

Daten hatten wir ja keine verloren. Zudem haben wir zwei aktive Virtualisierungsserver.

Der andere (XEN mit HDDs) hat bei der Aktion nichts abbekommen.

Es ging jedoch weiter. Über das Wochenende hatte sich eine SSD aus dem

RAID 5 verabschiedet, das RAID 5 war degraded. Allerdings haben die

SSDs laut S.M.A.R.T. noch 99% der TBW. Also habe ich die angebliche fehlerhafte

SSD gezogen und wieder gesteckt. Das RAID hat anstandslos auf der angeblich

defekten SSD das Rebuild vollzogen. An den Fehlermeldungen in Windows

hat das leider nicht geändert. Hinzugekommen ist jedoch noch ein immer

wiederkehrender Eintrag im Protokoll des Controllers für das RAID5: "Bad Stripe".

Na danke. Sämtliche VMS bringen bei Chkdsk Fehler, die offensichtlich nicht

korrigiert werden können. Das war's dann für das RAID. Zurück auf Los. Sicherungen

der einzelnen Server hatte ich nicht. Nur von den Daten. Noch ein böser Fehler,

der mir nicht mehr passieren wird.

Also mache ich das RAID 5 platt und fange von vorne an. Das RAID 5 ist schnell

neu aufgesetzt. Es wird ein kompletter Verify gemacht. Die Platten und das RAID

sollten demnach wohl fehlerfrei sein. Das lief allerdings einige Stunden. Für meinen

Geschmack für ein RAID aus SSD's viel zu lange.

Dann habe ich Windows wieder neu installiert und erstmal mit sämtlichen Updates

versehen. Wenn schon, denn schon: Der RAID-Controller bekam die neueste Firmware,

die Windows-Treiber wurden ebenfalls auf den neuesten Stand gebracht. Für meine

Begriffe optimale Voraussetzungen für eine ordentliche Performance. Denkste!

Habe ein paar einfache Kopierversuche mit ein paar GB an großen Dateien innerhalb des

RAID 5 gemacht und bin fast vom Stuhl gefallen. Die ersten ein oder zwei Sekunden

gingen noch zügig, dann brach die Leistung massivst ein. Die Schreibrate ging runter

bis nahezu auf 0 und schwankte dann zwischen max. ca. 100MB/s und einem

einstelligen Wert hin und her.

Da beim Build mit Verify (!) des neuen Arrays keine Fehler angezeigt wurden, konnte

ich mir einen Defekt an den SSDs einfach nicht vorstellen. Der nächste Verdächtige

war daher der Controller. Den habe ich dann gegen den obenstehenden, nagelneuen

Controller getauscht, natürlich einschließlich den dazu passenden, neuesten Treibern.

und nur Raid 1 und 10...

Wohlbemerkt: Bei beiden Controllern ist Write-Cache disabled!

Das grausige Ergebnis trotz des neuen Controllers seht ihr hier. Das ist ein neu

aufgesetztes RAID5 aus 9 identischen Samsung 850Pro SSDs!!!

Der Server friert während dieser Messung oder bei o.g. Kopieraktion förmlich ein.

Es ist kaum mehr möglich, z.B. auch nur das Eregnisprotokoll zu starten. Auch wenn

ich vom allten Zustand leider keine solche Messungen habe, war DAS vorher ganz

sicher nie so. Alle VMs darauf liefen problemlos und ohne jeden Hänger. Selbst mit

parallel aktivem Fileserver auf der gleichen Hardware.

Die beiden separaten kleineren Platten im RAID1 sind auch ganz weit weg von "normal".

Auch das Ergebnis sehr ihr hier:

Und nun stehe ich richtig auf dem Schlauch. Mir ist bewußt, daß RAID 5 immer ein

Kompromiss aus Kosten und insbesondere Schreibleistung darstellt. Aber sowas???

Mittlerweile habe ich so einiges gegoogelt zum Thema Stomausfall und SSDs. Das

kann demnach tatsächlich zu einer breiten Spanne von Defekten bis hin zum

Totalausfall der SSD führen. Das wußte ich vorher nicht. Da so ein Vorfall nicht

vorgesehen war, verfügte auch weder der RAID-Controller über eine Pufferbatterie

/-kondensator noch waren die SSDs "power-loss-proteced".

Mangels besserer Ideen habe ich nach dem Tausch des Controllers gegen eine

mit Puffer nun auch noch einen Satz von 5 x Samsung PM863 (Enterprise-Ware,

power-loss-protected) bestellt, die die 9 x 1TB's ersetzen sollen. Allerdings bin ich

alles andere als sicher, daß das die Lösung des Problems ist. Falls doch, würde

das wohl bedeuten, daß die "alten" SSDs tatsächlich was abbekommen haben.

Zum Vergleich habe ich hier noch die gleiche Messung von meinem Laptop dran

gehängt. Da werkelt eine Samsung 850 EVO mit 1TB drin:

Sorry, war ein langer Vortrag. Aber ich denke, so sind viele Rückfragen schonmal im

Voraus geklärt.

Hat hier jemand hilfreiche Ideen dazu?

mitlerweile schreiben wir in unseren Rechnungen und Lieferscheinen das SSD´s nicht für eine Raid 5/6 config geeignet sind- und Garantie verlust droht!

Oder auch Messwerte aus einer ähnlichen Konfiguration?

Bin für jede Hilfe dankbar!

Bin für jede Hilfe dankbar!

Frank

Der Preis für den Zuwachs bei nicht gepufferter Hardware ist die (noch) höhere Wahrscheinlichkeit, das zu erleben, was ich gerade erlebe.

Aber dein Controller ist doch jetzt gepuffert, also alles gut.Ich sehe es grundsätzlich ähnlich wie Frank und würde meine Daten auch eher einem aktuellen LSI Controller anvertrauen aber das hilft dir jetzt auch nicht weiter...

Was passiert wenn du nicht den Treiber von Adaptec verwendest sondern den von Windows selbst? Danach am besten mal die verschiedenen Dateigrößen im Benchmark testen.

Du bist dir aber sicher, dass dein Raid aktuell nicht degraded ist und deshalb Performance fehlt?

Deswegen würde ich niemals "Bastelserver" verwenden, sobald du ein Problem hast stehst du alleine ohne Support da.

Hab mal fix bei Thomas Krenn einen Server zusammen geklickt welcher dich mit ähnlicher Konfiguration, jedoch alles Enterprise SSD, ca. 13T€ gekostet hätte inkl. 5 Jahre Support!

Ob hier wirklich SSDs benötigt werden oder ob vllt. 2 Raids mit jeweils 4-5 10.000er Festplatten gereicht hätte ist die nächste Frage.

VG

Val

Hi,

Mit dem Windows-Treiber wird es eher noch langsamer. Das habe ich schon getestet. Auch ältere Treiber- und Firmwareversionen von Adaptec.

Das RAID ist nicht degraded.

und was ist mit Patrol Read ?

Wie schon geschrieben: Geld spielte und spielt eine Rolle. Vor 1 1/2 Jahren hätte ein vergleichbarer Server von HP noch rund 20T€ gekostet.

Meiner liegt bei ca. der Hälfte.

nutzt ja nix, wenn der server nicht rennt...

was hätte den gegen einen stapel Raid 1 gesprochen... hättest ja 3-4 anlegen können.. oder ?

Die Investition soll ja für einige Jahre nach vorne reichen. Da auf dem Hyper-V sowohl ein Fileserver (da hängen u.a. einige CAD-Plätze dran), ein MySQL-Server sowie irgendwann auch unser ERP-System laufen soll, habe ich in Sachen Performance bewußt weit oben ins Regal gegriffen.

nun, da wiedersprichst du dir gerade selber- wenn du weißt das deine SSD´s nach spätestens 12 Monaten durch sind... ist dein Investitionsplan fürn arsch... du fängst an neue zu kaufen.... und noch mal... und nochmal... also nix gespart und nur ärger...

ich kann dir echt nur raten - was die Hersteller auch tun... kein Raid 5/6 sondern Raid 1 oder 10...

und davon kannst du ja viele anlegen.. oder gleich große SSD´s kaufen!

Frank

Zitat von @p-m-a-d-m-i-n:

Der gepufferte Controller alleine nützt nichts, wenn im Falle eines Falles der nicht gepufferten SSD dahinter beim Schreiben der Saft ausgeht.

Ich hatte schon LSI als auch Adaptec im Einsatz. Probleme hatte ich bisher weder hier noch dort. Mit einer Ausnahme: Einen passenden Treiber für den LSI-Controller für den alten XEN-Server zu finden, war echt ein Akt. Fündig geworden bin ich nach Tagen damals auf einer alten 3Ware-Seite.

Die Kriterien waren:

- Low Profile wg. dem Gehäuse

- PCIe 3.0 x8 (Könnte bei einem späteren Vollausbau eine Rolle spielen)

- 16 Anschlüsse

Es gab und gibt keinen LSI-Controller, der darauf passt.

der vergleich passt nicht... es ist ja nicht die rede von irgendeinen LSI Raid Controller, sondern ein 93x aufwärts der mit SSD´s umgehen kann!Aber dein Controller ist doch jetzt gepuffert, also alles gut.

Der gepufferte Controller alleine nützt nichts, wenn im Falle eines Falles der nicht gepufferten SSD dahinter beim Schreiben der Saft ausgeht.

Ich sehe es grundsätzlich ähnlich wie Frank und würde meine Daten auch eher einem aktuellen LSI Controller anvertrauen aber das hilft dir jetzt auch nicht weiter...

Ich hatte schon LSI als auch Adaptec im Einsatz. Probleme hatte ich bisher weder hier noch dort. Mit einer Ausnahme: Einen passenden Treiber für den LSI-Controller für den alten XEN-Server zu finden, war echt ein Akt. Fündig geworden bin ich nach Tagen damals auf einer alten 3Ware-Seite.

Die Kriterien waren:

- Low Profile wg. dem Gehäuse

- PCIe 3.0 x8 (Könnte bei einem späteren Vollausbau eine Rolle spielen)

- 16 Anschlüsse

Es gab und gibt keinen LSI-Controller, der darauf passt.

Was passiert wenn du nicht den Treiber von Adaptec verwendest sondern den von Windows selbst? Danach am besten mal die verschiedenen Dateigrößen im Benchmark testen.

Mit dem Windows-Treiber wird es eher noch langsamer. Das habe ich schon getestet. Auch ältere Treiber- und Firmwareversionen von Adaptec.

Du bist dir aber sicher, dass dein Raid aktuell nicht degraded ist und deshalb Performance fehlt?

Das RAID ist nicht degraded.

Deswegen würde ich niemals "Bastelserver" verwenden, sobald du ein Problem hast stehst du alleine ohne Support da.

Hab mal fix bei Thomas Krenn einen Server zusammen geklickt welcher dich mit ähnlicher Konfiguration, jedoch alles Enterprise SSD, ca. 13T€ gekostet hätte inkl. 5 Jahre Support!

Hab mal fix bei Thomas Krenn einen Server zusammen geklickt welcher dich mit ähnlicher Konfiguration, jedoch alles Enterprise SSD, ca. 13T€ gekostet hätte inkl. 5 Jahre Support!

Wie schon geschrieben: Geld spielte und spielt eine Rolle. Vor 1 1/2 Jahren hätte ein vergleichbarer Server von HP noch rund 20T€ gekostet.

Meiner liegt bei ca. der Hälfte.

was hätte den gegen einen stapel Raid 1 gesprochen... hättest ja 3-4 anlegen können.. oder ?

Ob hier wirklich SSDs benötigt werden oder ob vllt. 2 Raids mit jeweils 4-5 10.000er Festplatten gereicht hätte ist die nächste Frage.

Die Investition soll ja für einige Jahre nach vorne reichen. Da auf dem Hyper-V sowohl ein Fileserver (da hängen u.a. einige CAD-Plätze dran), ein MySQL-Server sowie irgendwann auch unser ERP-System laufen soll, habe ich in Sachen Performance bewußt weit oben ins Regal gegriffen.

ich kann dir echt nur raten - was die Hersteller auch tun... kein Raid 5/6 sondern Raid 1 oder 10...

und davon kannst du ja viele anlegen.. oder gleich große SSD´s kaufen!

Frank

@p-m-a-d-m-i-n

Hallo,

das Thema ist von 2016, aber rein Interesse halber. Lese ich das richtig? Nach dam Tausch der SSD gab es dann keine weiteren Probleme, sodass wohl eine/alle SDDs defekt waren (ggf. durch den Stromausfall)? Kommt dann in meine Wissensdatenbank

Mit fehlte so ein letztes Fazit, weil das Thema doch sehr in RAID5 abgerutscht ist, obwohl auch bei SSDs für ein RAID5 nichts dagegen spricht.

Danke.

Hallo,

das Thema ist von 2016, aber rein Interesse halber. Lese ich das richtig? Nach dam Tausch der SSD gab es dann keine weiteren Probleme, sodass wohl eine/alle SDDs defekt waren (ggf. durch den Stromausfall)? Kommt dann in meine Wissensdatenbank

Mit fehlte so ein letztes Fazit, weil das Thema doch sehr in RAID5 abgerutscht ist, obwohl auch bei SSDs für ein RAID5 nichts dagegen spricht.

Danke.