100 Prozent CPU Last gleich Volllast, Pustekuchen, nicht bei Microsoft!!!

Moin Zusammen,

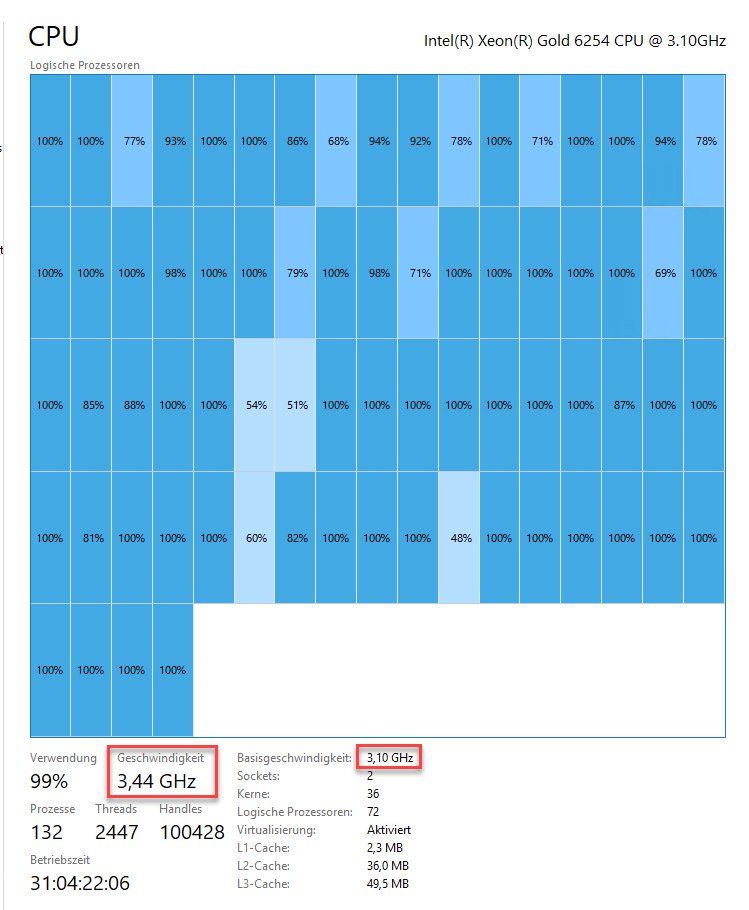

ich bin dem Letzt beim Debuggen einer Netzwerkproblematik auf ein meiner Ansicht nach sehr kritisches Problem in der Auslastungsdarstellung der CPU bei Microsofts Betriebssystemen (Server & Client) gestossen.

Viele Details habe ich schon vor ein paar Wochen angefangen unter dem folgenden Beitrag (englisch) bei Spiceworks zusammenzutragen.

community.spiceworks.com/topic/2271260-microsoft-taskmanager-sho ...

Folgend eine kurze Zusammenfassung in Deutsch:

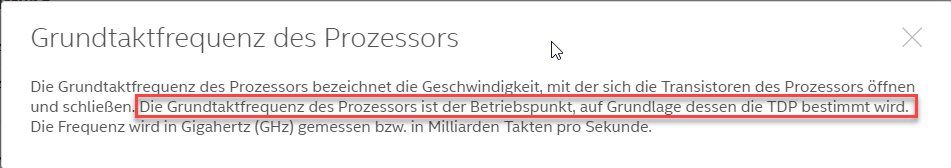

Microsoft berechnet die CPU-Auslastung immer in Referenz zu der Basisgeschwindigkeit des Prozessors, auch wenn dieser Dank Turbo & Co momentan eine viel höhere Geschwindigkeit bereitstellt. Dadurch kann die Auslastung der CPU weit über 100% gehen bis deren Leistung dann tatsächlich erschöpft ist. Ferner ist es alles andere als einfach das Problem überhaupt zu erkennen, da Microsoft selbst die Anzeige des Taskmanagers von 0%-100% skaliert hat und nicht darüber. 🤨🤢 Lediglich mit der Leistungüberwachung lässt sich dem Ganzen Schlamassel auf die Schliche kommen.

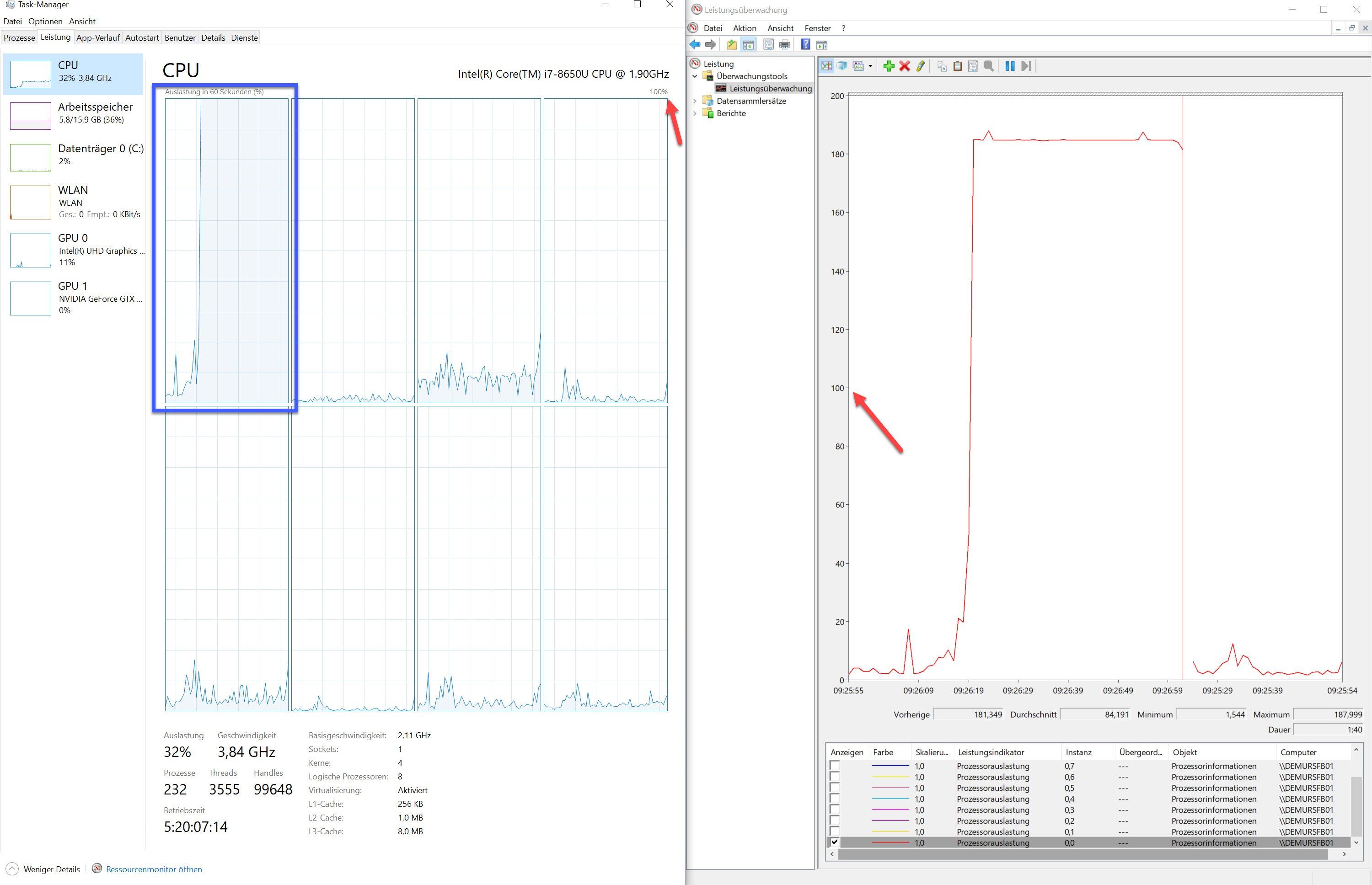

Folgend ein Beispiel des Problems anhand eines Surface Book’s.

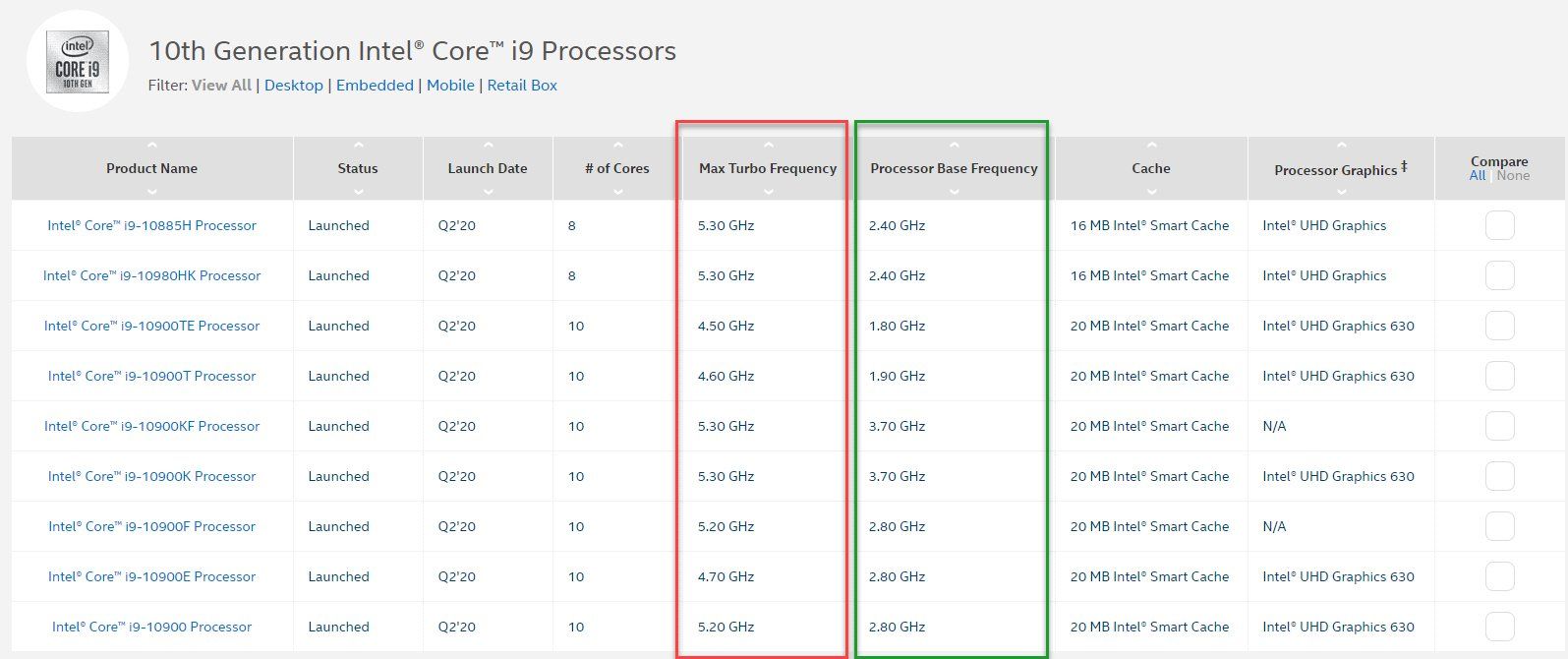

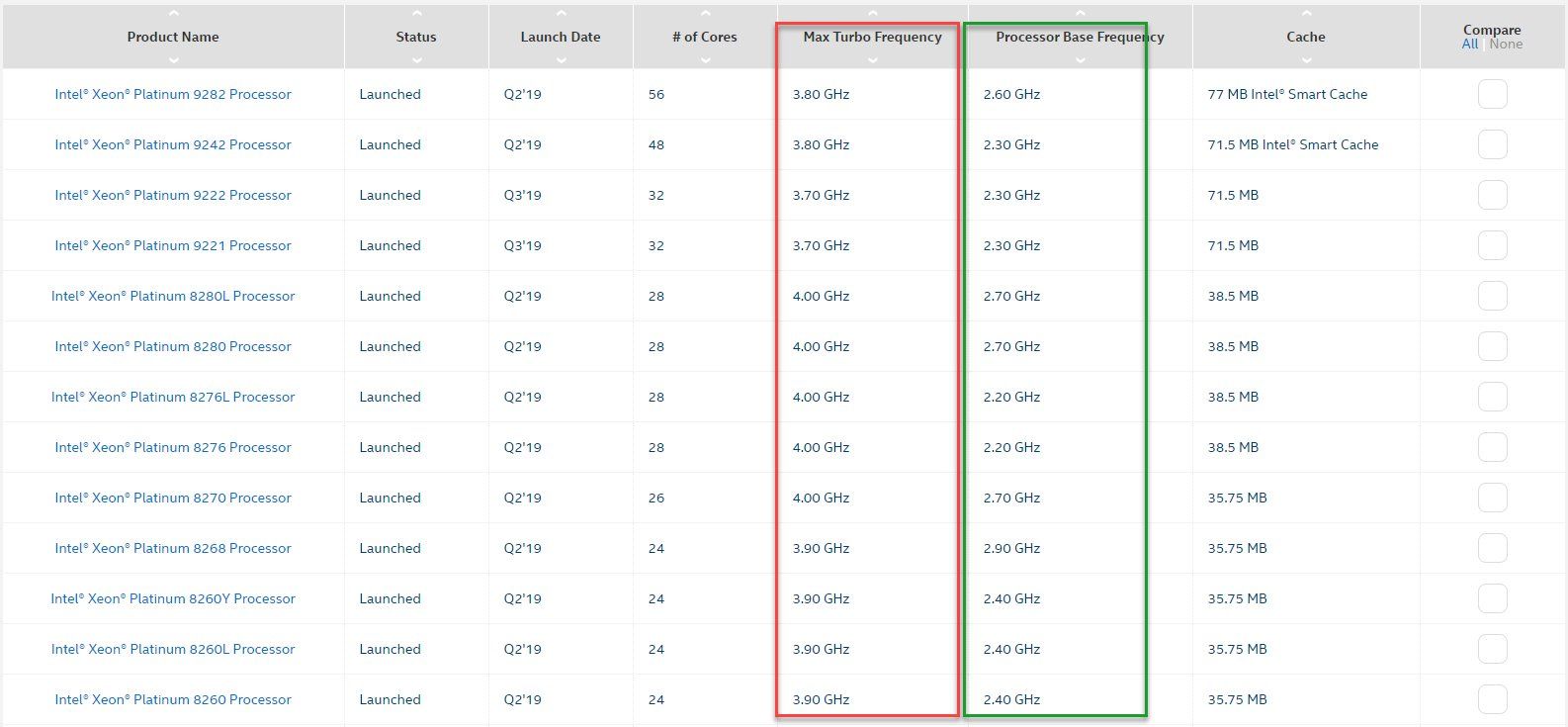

Das Surface Book hat einen Intel i7-8650U CPU verbaut, deren Basistakt laut ARK bei 1,9GHz liegt.

Dankt Turbo kann die CPU aber bis auf 4,2 GHz hochtackten.

Der Basistakt meines Surface ist mit 2,11 GHz zwar etwas höher als der von Intel angegeben, aber dies ist insbesondere für U-Prozessoren nichts Ungewöhnliches. Komplettsystemhersteller und oder Systemintegratoren können den Basistakt je nach verwendetem Kühlsystem erhöhen oder verringern.

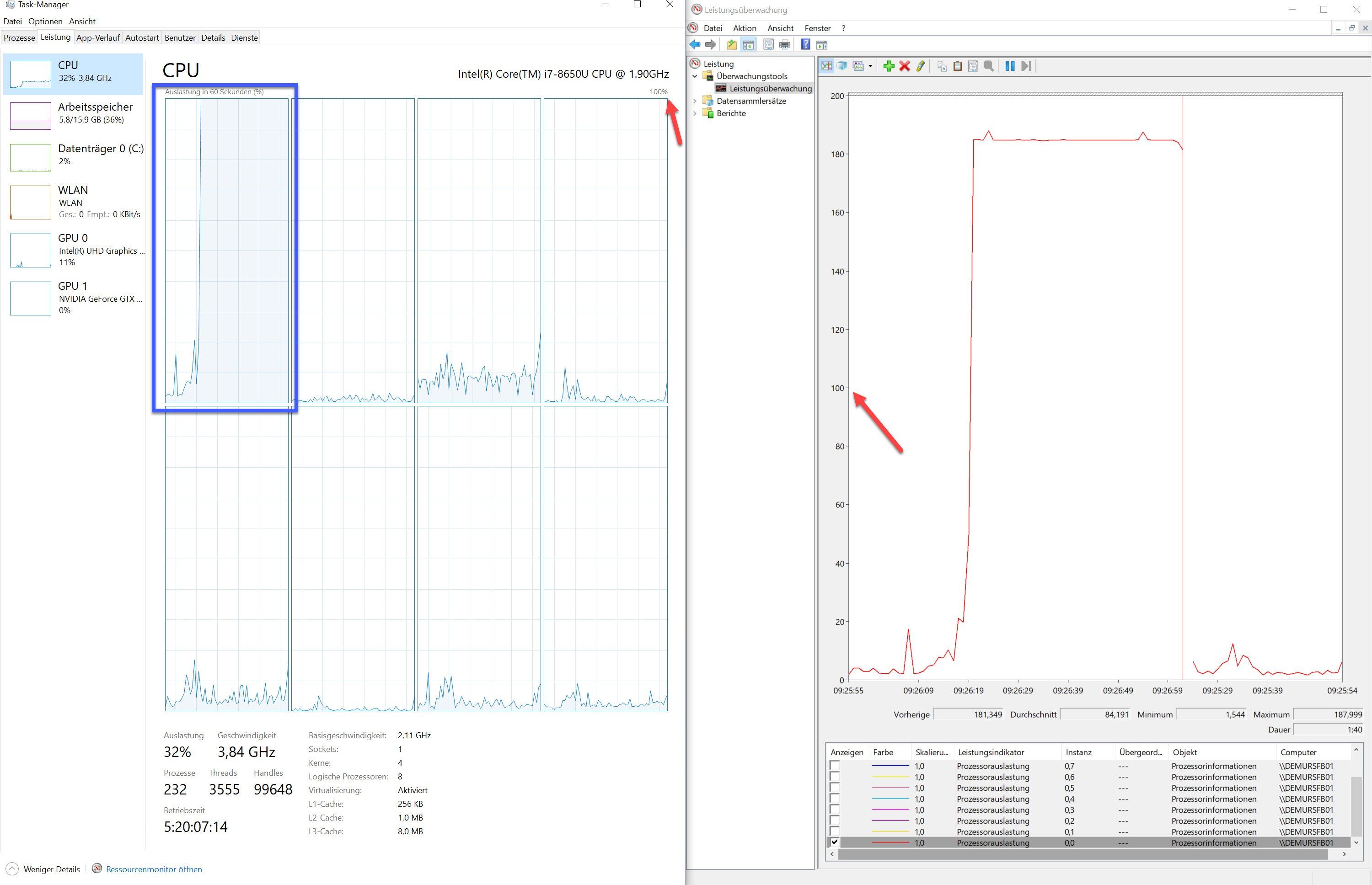

Der untere Screenshot zeigt den Task-Manager links und die Leistungsüberwachung rechts.

Bei der Leistungsüberwachung habe ich zwecks besserer Übersicht nur der Performancecounter der CPU-Auslastung für den ersten Kern aktiviert. Der Task-Manager verwendet ebenfalls denselben Zähler, um die Auslastung des ersten Kerns darzustellen (blau markiert). Zur Lasterzeugung habe ich ein BurnIn-Tool verwendet. Das Tool habe ich so konfiguriert, dass nur der erste Kern belastet wird.

Bei dem Task-Manager auf der rechten Seite des Screenshots steigt die Last wie Ihr seht auf 100% und mehr gibt es hier nicht zu sehen, da die Anzeige auf 100% begrenzt ist.

In der Leistungsüberwachung rechts sieht man jedoch, dass der Counter für die Auslastung des ersten Kerns nicht bei 100% ist, sondern bei mehr als 180%. 😮

Diese Form der Auslastungsanzeige ist meiner Ansicht nach, für jeden normalen Benutzer und fast jeden Administrator absolut irreführend.

Und es gibt ein weiteres Problem, das sich aus diesem Kontext ergibt.

Fast jedes Überwachungstool wie Nagios oder PRTG oder WhatsUp Gold oder ... zeigt die CPU-Auslastung demzufolge ebenfalls nicht richtig an, da diese meist dieselben Performancecounter benutzen wie auch das Betriebssystem selbst. 🤮

Alle oben genannten Systeme sind so konzipiert, dass die 100% CPU-Auslastung auch bedeutet, dass die CPU vollständig ausgelastet ist. Wir wissen jedoch jetzt, dass Microsoft hier eine andere Ansicht hat und dass eine 100% CPU-Auslastung keineswegs einer vollständigen Auslastung entspricht. 😖

Ich finde diesen Sachverhalt mehr als Kritisch. jedoch sind einige Usern bei Spiceworks davon überzeugt, dass dies alles schon so korrekt ist und ich lediglich einen Knick in meiner Logik hätte. 😱🙃

Wie denkt Ihr darüber?

Grüsse aus BaWü

Alex

ich bin dem Letzt beim Debuggen einer Netzwerkproblematik auf ein meiner Ansicht nach sehr kritisches Problem in der Auslastungsdarstellung der CPU bei Microsofts Betriebssystemen (Server & Client) gestossen.

Viele Details habe ich schon vor ein paar Wochen angefangen unter dem folgenden Beitrag (englisch) bei Spiceworks zusammenzutragen.

community.spiceworks.com/topic/2271260-microsoft-taskmanager-sho ...

Folgend eine kurze Zusammenfassung in Deutsch:

Microsoft berechnet die CPU-Auslastung immer in Referenz zu der Basisgeschwindigkeit des Prozessors, auch wenn dieser Dank Turbo & Co momentan eine viel höhere Geschwindigkeit bereitstellt. Dadurch kann die Auslastung der CPU weit über 100% gehen bis deren Leistung dann tatsächlich erschöpft ist. Ferner ist es alles andere als einfach das Problem überhaupt zu erkennen, da Microsoft selbst die Anzeige des Taskmanagers von 0%-100% skaliert hat und nicht darüber. 🤨🤢 Lediglich mit der Leistungüberwachung lässt sich dem Ganzen Schlamassel auf die Schliche kommen.

Folgend ein Beispiel des Problems anhand eines Surface Book’s.

Das Surface Book hat einen Intel i7-8650U CPU verbaut, deren Basistakt laut ARK bei 1,9GHz liegt.

Dankt Turbo kann die CPU aber bis auf 4,2 GHz hochtackten.

Der Basistakt meines Surface ist mit 2,11 GHz zwar etwas höher als der von Intel angegeben, aber dies ist insbesondere für U-Prozessoren nichts Ungewöhnliches. Komplettsystemhersteller und oder Systemintegratoren können den Basistakt je nach verwendetem Kühlsystem erhöhen oder verringern.

Der untere Screenshot zeigt den Task-Manager links und die Leistungsüberwachung rechts.

Bei der Leistungsüberwachung habe ich zwecks besserer Übersicht nur der Performancecounter der CPU-Auslastung für den ersten Kern aktiviert. Der Task-Manager verwendet ebenfalls denselben Zähler, um die Auslastung des ersten Kerns darzustellen (blau markiert). Zur Lasterzeugung habe ich ein BurnIn-Tool verwendet. Das Tool habe ich so konfiguriert, dass nur der erste Kern belastet wird.

Bei dem Task-Manager auf der rechten Seite des Screenshots steigt die Last wie Ihr seht auf 100% und mehr gibt es hier nicht zu sehen, da die Anzeige auf 100% begrenzt ist.

In der Leistungsüberwachung rechts sieht man jedoch, dass der Counter für die Auslastung des ersten Kerns nicht bei 100% ist, sondern bei mehr als 180%. 😮

Diese Form der Auslastungsanzeige ist meiner Ansicht nach, für jeden normalen Benutzer und fast jeden Administrator absolut irreführend.

Und es gibt ein weiteres Problem, das sich aus diesem Kontext ergibt.

Fast jedes Überwachungstool wie Nagios oder PRTG oder WhatsUp Gold oder ... zeigt die CPU-Auslastung demzufolge ebenfalls nicht richtig an, da diese meist dieselben Performancecounter benutzen wie auch das Betriebssystem selbst. 🤮

Alle oben genannten Systeme sind so konzipiert, dass die 100% CPU-Auslastung auch bedeutet, dass die CPU vollständig ausgelastet ist. Wir wissen jedoch jetzt, dass Microsoft hier eine andere Ansicht hat und dass eine 100% CPU-Auslastung keineswegs einer vollständigen Auslastung entspricht. 😖

Ich finde diesen Sachverhalt mehr als Kritisch. jedoch sind einige Usern bei Spiceworks davon überzeugt, dass dies alles schon so korrekt ist und ich lediglich einen Knick in meiner Logik hätte. 😱🙃

Wie denkt Ihr darüber?

Grüsse aus BaWü

Alex

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Kommentar vom Moderator tomolpi am 29.05.2020 um 16:19:07 Uhr

Jetzt ist aber wirklich dicht hier, wenn es auch nach meiner Ermahnung weitergeht...

Content-ID: 574337

Url: https://administrator.de/forum/100-prozent-cpu-last-gleich-volllast-pustekuchen-nicht-bei-microsoft-574337.html

Ausgedruckt am: 15.07.2025 um 16:07 Uhr

69 Kommentare

Neuester Kommentar

Hallo Alex,

in dem Fall solltest du die Finger von Basistakt CPUs lassen, zu dem ist die CPU Auslastung meist nur für - naja - Leute von wirklicher Relevanz, ein ordentlich gesiztes System läuft selten auf mehr als 20-30%, selbst im Schnitt nicht. Wichtiger sind im Normalen Computing Segment eher RAM und IOPS, die CPU dient für mich meist nur als Indikator für das schnelle Identifizieren des Alters des Systems.

Daher kann ich mich den Profis nur anschliessen, nebenbei, whatsapp ist was anderes als whatsup. Sorry, aber das ist schon ein Fingerzeig. Aber kleine Frage, wie oft schaust du denn die CPU Auslastung an? Arbeitest du im HPC Umfeld? (da gibst du dich dann mit i5 und i7 ab?).

Kritisch ist daran nichts, denn die CPU Auslastung, insbesondere auf einem von 8 Oder 16 ++, sagt relativ wenig aus.

Entspann dich.

Grüße

in dem Fall solltest du die Finger von Basistakt CPUs lassen, zu dem ist die CPU Auslastung meist nur für - naja - Leute von wirklicher Relevanz, ein ordentlich gesiztes System läuft selten auf mehr als 20-30%, selbst im Schnitt nicht. Wichtiger sind im Normalen Computing Segment eher RAM und IOPS, die CPU dient für mich meist nur als Indikator für das schnelle Identifizieren des Alters des Systems.

Daher kann ich mich den Profis nur anschliessen, nebenbei, whatsapp ist was anderes als whatsup. Sorry, aber das ist schon ein Fingerzeig. Aber kleine Frage, wie oft schaust du denn die CPU Auslastung an? Arbeitest du im HPC Umfeld? (da gibst du dich dann mit i5 und i7 ab?).

Kritisch ist daran nichts, denn die CPU Auslastung, insbesondere auf einem von 8 Oder 16 ++, sagt relativ wenig aus.

Entspann dich.

Grüße

- i9-9820X mit einem dauertackt von 4,5GHz über alle Kerne, dank ordentlicher WaKü auch bei Volllast, ist aber nur übergansweise.

Nein, das ist Bastler. Sorry und klar schaut sowas ziemlich oft in den CPU Takt, das ist wie Autobastler, die haben auch alle paar Tage Ihre Motorabdeckung offen, bringen tut es wenig.

Da kann ich absolut nicht zustimmen, ohne eine ausreichend demissionierte CPU, gibt es weder gute IO's noch kann man z.B. alle 10G NICs sauber auslasten u.s.w..

Das macht in einem ordentlichen Serversystem was anderes als die CPU, vielleicht ist da dein Kernproblem.

Da sag ich nur

> ein ordentlich gesiztes System läuft selten auf mehr als 20-30%, selbst im Schnitt nicht.

Hab ich da einen Nerv getroffen? Ich sagte nicht, dass die Kiste Bastler ist, sondern dein Habitus von wegen dauernd in die CPU Last zu schauen

Übrigens, AllFlash ist richtig toll, wenn die Anbindung nicht passt. denn wenn (es nur darauf ankäme) - wie kommst du dann logisch bei 1.000.000 IO/s schneller weg als bei 1.4Mio IO/s, und da schreist du wegen der Skala?

bin draussen.

Übrigens, AllFlash ist richtig toll, wenn die Anbindung nicht passt. denn wenn (es nur darauf ankäme) - wie kommst du dann logisch bei 1.000.000 IO/s schneller weg als bei 1.4Mio IO/s, und da schreist du wegen der Skala?

bin draussen.

Zitat von @MysticFoxDE:

Sei mir bitte nicht böse, aber urteile bitte nicht über Dinge die du nicht kennst und oder verstehst.

Ich stimme @certifiedit.net ja nicht oft zu, aber hier hat er Recht. Der Taskmanager ist für Debugging sowieso nicht das richtige Tool, das richtige Tool kennst du ja aber schon.Sei mir bitte nicht böse, aber urteile bitte nicht über Dinge die du nicht kennst und oder verstehst.

Die besagte Workstation hat Ihre Leistung schon mehr als genug unter beweis gestellt.

Das letzte Mal hat diese eine Migration einer Datenbank von Oracle auf MS SQL in gerade mal 8 Stunden verrichtet. (Testmigration)

Und das sagt jetzt was aus? Niemand kennt die Parameter der Migration, wenn du jetzt eine Dauer nennst ist die Aussage ziemlich nutzlos.Das letzte Mal hat diese eine Migration einer Datenbank von Oracle auf MS SQL in gerade mal 8 Stunden verrichtet. (Testmigration)

Das hauseigene und > 200K teure Hyper-V Cluster des Kunden welches über ein sehr leistungsfähiges AllFlash-SAN verfügt (1.4 Mio IO/s random) benötigte für denselben Workload mehr als 90 Stunden.

Naja, das Hyper-V System wird ja nicht leer gewesen sein. Ausserdem ist es wohl auch nicht für die Migration einer DB ausgelegt gewesen, würde jedenfalls für den Normalbetrieb keinen Sinn ergeben.Aus meiner Sicht ist dein dargestelltes Problem jedenfalls keines mit dem man sich beschäftigen sollte.

Hallo,

ich verstehe das Problem nicht.

Mich interessiert das dauerhaft verfügbare und verlässliche Minimum.

Alles Andere ist „Latte“. Zumal viele CPUs den Hochlastbereich nur für wenige Sekunden zur Verfügung stellen.

Gruß,

Jörg

ich verstehe das Problem nicht.

Mich interessiert das dauerhaft verfügbare und verlässliche Minimum.

Alles Andere ist „Latte“. Zumal viele CPUs den Hochlastbereich nur für wenige Sekunden zur Verfügung stellen.

Gruß,

Jörg

Hallo,

das ist zum Einen fachlich falsch und zum Anderen sehr überheblich und arrogant formuliert.

Frickel Du mal, ich bin raus.

Gruß,

Jörg

das ist zum Einen fachlich falsch und zum Anderen sehr überheblich und arrogant formuliert.

Frickel Du mal, ich bin raus.

Gruß,

Jörg

Hallo,

das „fachlich falsch“ war auf dein Bestreben bezogen, bei der Skalierung, Messung und beim Vergleich von Systemen den Turbotakt heranzuziehen.

Gruß,

Jörg

das „fachlich falsch“ war auf dein Bestreben bezogen, bei der Skalierung, Messung und beim Vergleich von Systemen den Turbotakt heranzuziehen.

Gruß,

Jörg

Hi,

um mal Deine ursprüngliche Frage zu beantworten.

Was Nagios, PRTG und Konsorten betrifft: Man muss die Überwachung doch eh für jeden Host einzeln dimensionieren. Es ist doch nur ein schöner Traum, dass man mit einem Satz Schwellwerten alle seine System gleich überwachen kann. Die Frage wäre also, ob man die Schwellwerte der Überwachungssoftware auch für mehr als 100% einstellen kann. Wenn ja, dann ist sie für meine Zwecke tauglich, wenn nein, dann nicht.

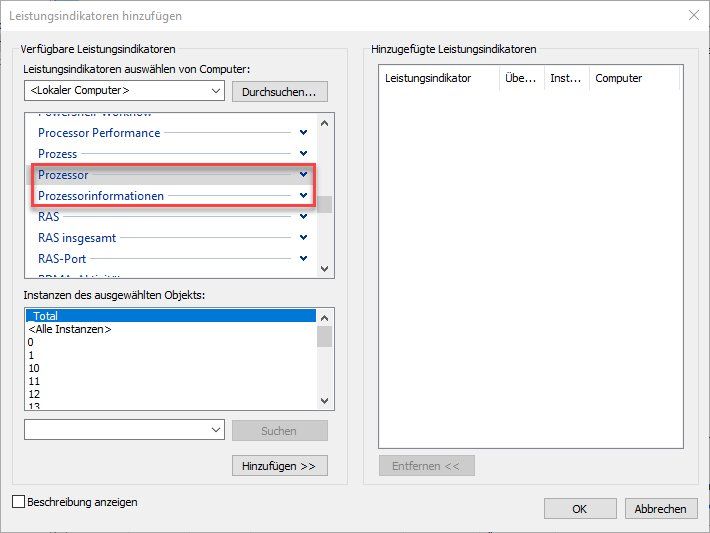

Ich für mich gehe davon aus, dass die Counter unter "Prozessor" schlichtweg etwas veraltet sind. Noch aus Zeiten, als die CPU's etwas einfacher gestrickt waren. Aber sie werden "so tief" im Code sein, dass man sie nicht einfach so ändern kann oder will. Weil wir das aber wissen, überwachen wir eben nicht mehr "Prozessor" sondern "Prozessorinformationen" und gut ist.

E.

um mal Deine ursprüngliche Frage zu beantworten.

Was Nagios, PRTG und Konsorten betrifft: Man muss die Überwachung doch eh für jeden Host einzeln dimensionieren. Es ist doch nur ein schöner Traum, dass man mit einem Satz Schwellwerten alle seine System gleich überwachen kann. Die Frage wäre also, ob man die Schwellwerte der Überwachungssoftware auch für mehr als 100% einstellen kann. Wenn ja, dann ist sie für meine Zwecke tauglich, wenn nein, dann nicht.

Ich für mich gehe davon aus, dass die Counter unter "Prozessor" schlichtweg etwas veraltet sind. Noch aus Zeiten, als die CPU's etwas einfacher gestrickt waren. Aber sie werden "so tief" im Code sein, dass man sie nicht einfach so ändern kann oder will. Weil wir das aber wissen, überwachen wir eben nicht mehr "Prozessor" sondern "Prozessorinformationen" und gut ist.

E.

Hallo,

im Grunde genommen ist es wie bei Autos: Da wird die Tankreserve auch nicht in die Reichweite kalkuliert.

Hier ist es ähnlich: Das System soll auch im Volllastbereich handlungsfähig bleiben. Ansonsten würde das Geraffel nämlich dauerhaft stehenbleiben...

Gruß,

Jörg

im Grunde genommen ist es wie bei Autos: Da wird die Tankreserve auch nicht in die Reichweite kalkuliert.

Hier ist es ähnlich: Das System soll auch im Volllastbereich handlungsfähig bleiben. Ansonsten würde das Geraffel nämlich dauerhaft stehenbleiben...

Gruß,

Jörg

Zitat von @117471:

im Grunde genommen ist es wie bei Autos: Da wird die Tankreserve auch nicht in die Reichweite kalkuliert.

Dieser Vergleich hinkt gewaltig.im Grunde genommen ist es wie bei Autos: Da wird die Tankreserve auch nicht in die Reichweite kalkuliert.

Die Tankreserve wäre eher mit einem Reserve-Speicher zu vergleichen. Und das automatische Hochtakten der CPU bei Bedarf eher mit dem Zuschalten des E-Motors beim Hybriden. Und letzteres kalkuliert man sehr wohl mit ein.

Hallo,

es geht hier um den Takt oberhalb der Definition.

Das, was definiert ist (und genau das) wird von Windows als 100% dargestellt.

Alles darüber ist Reserve. Zum Beispiel, damit man im Lastfall noch eine Fehlersuche und Entstörung vornehmen kann.

Gruß,

Jörg

es geht hier um den Takt oberhalb der Definition.

Das, was definiert ist (und genau das) wird von Windows als 100% dargestellt.

Alles darüber ist Reserve. Zum Beispiel, damit man im Lastfall noch eine Fehlersuche und Entstörung vornehmen kann.

Gruß,

Jörg

Hallo,

noch einmal: Es geht um den Turbo.

Aktuelle CPUs können sich übertakten - also schneller laufen als das, was AMD oder Intel als Nennleistung ausgibt.

Das, was Du meinst ist das normale Speedstepping.

Beispiel 3Ghz CPU: Die beginnt z.B. bei 300Mhz und endet z.B. bei 3Ghz. In diesem Fall sind 3Ghz die 100% und nicht 3,3Ghz, auf die sich der Prozessor im Notfall übertakten kann.

Gruß,

Jörg

noch einmal: Es geht um den Turbo.

Aktuelle CPUs können sich übertakten - also schneller laufen als das, was AMD oder Intel als Nennleistung ausgibt.

Das, was Du meinst ist das normale Speedstepping.

Beispiel 3Ghz CPU: Die beginnt z.B. bei 300Mhz und endet z.B. bei 3Ghz. In diesem Fall sind 3Ghz die 100% und nicht 3,3Ghz, auf die sich der Prozessor im Notfall übertakten kann.

Gruß,

Jörg

Intel schreibt dazu:

Max. Turbo-Taktfrequenz

Die maximale Turbo-Taktfrequenz ist die maximale Einzelkern-Taktfrequenz, zu der der Prozessor mit der Intel® Turbo-Boost-Technik und, falls vorhanden, mit Intel® Thermal Velocity Boost betrieben werden kann. Die Frequenz wird in Gigahertz (GHz) gemessen bzw. in Milliarden Takten pro Sekunde.

Intel® Turbo-Boost-Technik

Die Intel® Turbo-Boost-Technik erhöht dynamisch die Frequenz eines Prozessors nach Bedarf, indem die Temperatur- und Leistungsreserven ausgenutzt werden, um bei Bedarf mehr Geschwindigkeit und andernfalls mehr Energieeffizienz zu bieten.

Einen Hinweis, dass man diese Reserven nur im absoluten Notfall benutzen soll, habe ich bei Intel bisher noch nicht gefunden. Dass man dabei aufpassen muss, dass die Kiste nicht abbrennt, ist klar. Das gilt aber im Normalfall auch schon.Die maximale Turbo-Taktfrequenz ist die maximale Einzelkern-Taktfrequenz, zu der der Prozessor mit der Intel® Turbo-Boost-Technik und, falls vorhanden, mit Intel® Thermal Velocity Boost betrieben werden kann. Die Frequenz wird in Gigahertz (GHz) gemessen bzw. in Milliarden Takten pro Sekunde.

Intel® Turbo-Boost-Technik

Die Intel® Turbo-Boost-Technik erhöht dynamisch die Frequenz eines Prozessors nach Bedarf, indem die Temperatur- und Leistungsreserven ausgenutzt werden, um bei Bedarf mehr Geschwindigkeit und andernfalls mehr Energieeffizienz zu bieten.

Hallo,

auch hier hilft wieder ein Autovergleich: Die Nennleistung des Motors steht z.B. bei 3500 U/min zur Verfügung. Dennoch ist es nicht sinnvoll, den Motor möglichst auf dieser Drehzahl zu halten. Die Effektivität leidet und die Hardware altert im Zeitraffer - das kann man z.B. auch schön bei Grafikkarten sehen, die in Mining-PCs steckten. Aus genau diesem Grund verweigern viele Hersteller bei derartigen Nutzungen die Garantie.

Und, wie gesagt: Wenn Du Turbo Boost dauerhaft nutzt und dann wirklich mal eine Lastspitze kommt, dann steht das Ding.

Liebe Grüße,

Jörg

auch hier hilft wieder ein Autovergleich: Die Nennleistung des Motors steht z.B. bei 3500 U/min zur Verfügung. Dennoch ist es nicht sinnvoll, den Motor möglichst auf dieser Drehzahl zu halten. Die Effektivität leidet und die Hardware altert im Zeitraffer - das kann man z.B. auch schön bei Grafikkarten sehen, die in Mining-PCs steckten. Aus genau diesem Grund verweigern viele Hersteller bei derartigen Nutzungen die Garantie.

Und, wie gesagt: Wenn Du Turbo Boost dauerhaft nutzt und dann wirklich mal eine Lastspitze kommt, dann steht das Ding.

Liebe Grüße,

Jörg

Zitat von @MysticFoxDE:

Eben nicht, der von mir angeprangerte Counter kommt von "Prozessorinformationen" und nicht von "Prozessor". 😉

Ja, ich weiß. Wo ist jetzt der Haken?Eben nicht, der von mir angeprangerte Counter kommt von "Prozessorinformationen" und nicht von "Prozessor". 😉

Zitat von @MysticFoxDE:

Eben nicht, der von mir angeprangerte Counter kommt von "Prozessorinformationen" und nicht von "Prozessor". 😉

Eben nicht, der von mir angeprangerte Counter kommt von "Prozessorinformationen" und nicht von "Prozessor". 😉

Der Unterschied zwischen beiden Countern ist das der erste NUMA Informationen liefert und der zweite nicht.

/Thomas

Ja, sicher. Darum habe ich das doch erwähnt?

Ja

Hallo,

Ich habe auch nicht geschrieben, dass Ihr sie im Notfall benutzen sollt, sondern, dass der Prozessor sie im Notfall benutzt.

Achja - die "Ressourcen" fehlen den anderen Kernen übrigens; die dann entsprechend schlafend gelegt oder im Takt reduziert werden. Und, um beim Auto-Vergleich zu bleiben: Es entspricht in etwa dem "Range Extender" vom BMW i3, der dich mit Hilfe eines kleinen Dieselmotors ein paar Kilometer zur nächsten Steckdose anschiebt.

Ich bleibe dabei - die 100% entsprechen exakt der Nennleistung. Was darüber hinaus geht, interessiert bei der Skalierung von Systemen nicht. Wenn Du z.B. Internetanbindungen einkaufst, rechnest Du für deine Last bzw. dein Failover ja auch nur die vom Anbieter garantierte Mindestbandbreite und nicht die "Bis zu" Phantasien aus den Hochglanzprospekten.

Aber eigentlich ist es auch egal - dafür, dass ich euch kostenlos ausbilde, bekomme ich keinen feuchten Keks. Insofern: Frickelt Ihr mal weiter

Gruß,

Jörg

Zitat von @emeriks:

Einen Hinweis, dass man diese Reserven nur im absoluten Notfall benutzen soll, habe ich bei Intel bisher noch nicht gefunden.

Einen Hinweis, dass man diese Reserven nur im absoluten Notfall benutzen soll, habe ich bei Intel bisher noch nicht gefunden.

Ich habe auch nicht geschrieben, dass Ihr sie im Notfall benutzen sollt, sondern, dass der Prozessor sie im Notfall benutzt.

Achja - die "Ressourcen" fehlen den anderen Kernen übrigens; die dann entsprechend schlafend gelegt oder im Takt reduziert werden. Und, um beim Auto-Vergleich zu bleiben: Es entspricht in etwa dem "Range Extender" vom BMW i3, der dich mit Hilfe eines kleinen Dieselmotors ein paar Kilometer zur nächsten Steckdose anschiebt.

Ich bleibe dabei - die 100% entsprechen exakt der Nennleistung. Was darüber hinaus geht, interessiert bei der Skalierung von Systemen nicht. Wenn Du z.B. Internetanbindungen einkaufst, rechnest Du für deine Last bzw. dein Failover ja auch nur die vom Anbieter garantierte Mindestbandbreite und nicht die "Bis zu" Phantasien aus den Hochglanzprospekten.

Aber eigentlich ist es auch egal - dafür, dass ich euch kostenlos ausbilde, bekomme ich keinen feuchten Keks. Insofern: Frickelt Ihr mal weiter

Gruß,

Jörg

Hallo,

die prozentuale CPU-Auslastung ist ein einfacher, griffiger Wert, der eine schnelle Einschätzung der Last liefert und unter dem sich jeder "etwas" vorstellen kann (wie korrekt diese Vorstellung dann ist, ist eine andere Frage). Von daher ist es schade, wenn MS diesen Messwert "entwertet", weil er offensichtlich nicht mehr in der üblichen Vorstellung (100% = max) liegt.

Technisch sieht das anders aus.

Einerseits: %CPU ist ein Cooked-Counter. Es wird gemessen: Anzahl zugewiesene CPU-Zyklen zu Zeit X und zu Zeit Y, dann die Differenz durch Gesamtzahl verfügbarer CPU-Zyklen in der Zeit geteilt. Und letzteres ist der Punkt: Um zu wissen, wie viele Zyklen man pro Zeit hat, muss man halt einen Basistakt annehmen. Den auf den maximalen Turbo-Takt zu setzten würde umgekehrt auch nichts bringen: Dann hättest du, wenn die CPU erstmal "warm" ist ständig CPU-Auslastung < 100%, obwohl sie nicht schneller kann.

-> Das Verhalten ist technisch nachvollziehbar und wohl auch sinnvoll.

Andererseits: ist ja schön, dass der Wert so einfach ist & jeder sich etwas darunter vorstellen kann. Nur: wenn man einen zu komplexen Sachverhalt zu sehr vereinfacht, bedeutet das, dass man Fehler macht. Will heißen: Die %CPU Time sagt letztlich viel weniger über Systemlast, als man gemeinhin denkt. Dazu zählt nicht nur die schon erwähnte IOPS (Disk), RAM,... Sondern auch in der CPU gibt es noch einen haufen weiterer Werte, die etwas über die Last sagen. Mal einfach gesagt: es hat seinen Sinn, dass es in dem Perfcounter-set "Processor" zig verschiedene Counter gibt.

Grüße

Filipp

die prozentuale CPU-Auslastung ist ein einfacher, griffiger Wert, der eine schnelle Einschätzung der Last liefert und unter dem sich jeder "etwas" vorstellen kann (wie korrekt diese Vorstellung dann ist, ist eine andere Frage). Von daher ist es schade, wenn MS diesen Messwert "entwertet", weil er offensichtlich nicht mehr in der üblichen Vorstellung (100% = max) liegt.

Technisch sieht das anders aus.

Einerseits: %CPU ist ein Cooked-Counter. Es wird gemessen: Anzahl zugewiesene CPU-Zyklen zu Zeit X und zu Zeit Y, dann die Differenz durch Gesamtzahl verfügbarer CPU-Zyklen in der Zeit geteilt. Und letzteres ist der Punkt: Um zu wissen, wie viele Zyklen man pro Zeit hat, muss man halt einen Basistakt annehmen. Den auf den maximalen Turbo-Takt zu setzten würde umgekehrt auch nichts bringen: Dann hättest du, wenn die CPU erstmal "warm" ist ständig CPU-Auslastung < 100%, obwohl sie nicht schneller kann.

-> Das Verhalten ist technisch nachvollziehbar und wohl auch sinnvoll.

Andererseits: ist ja schön, dass der Wert so einfach ist & jeder sich etwas darunter vorstellen kann. Nur: wenn man einen zu komplexen Sachverhalt zu sehr vereinfacht, bedeutet das, dass man Fehler macht. Will heißen: Die %CPU Time sagt letztlich viel weniger über Systemlast, als man gemeinhin denkt. Dazu zählt nicht nur die schon erwähnte IOPS (Disk), RAM,... Sondern auch in der CPU gibt es noch einen haufen weiterer Werte, die etwas über die Last sagen. Mal einfach gesagt: es hat seinen Sinn, dass es in dem Perfcounter-set "Processor" zig verschiedene Counter gibt.

Grüße

Filipp

Zitat von @117471:

Aber eigentlich ist es auch egal - dafür, dass ich euch kostenlos ausbilde, bekomme ich keinen feuchten Keks. Insofern: Frickelt Ihr mal weiter

Was soll diese blöde Anmache? Habe ich Dir Anlass dazu gegeben?Aber eigentlich ist es auch egal - dafür, dass ich euch kostenlos ausbilde, bekomme ich keinen feuchten Keks. Insofern: Frickelt Ihr mal weiter

Wenn Du bocken willst, geh in die Ecke. Wenn spielen, in den Kindergarten. Aber lass uns damit in Ruhe!

Irgendwann brennt Dir ganz sicher mal der Arsch. Mal sehen, wer Dich dann anmacht.

Zitat von @MysticFoxDE:

OK, fileless in einem Tool verstecken. Hier steigt meine Logikengine definitiv aus. 😵

Ich schätze, die meinen hier Malware, welche den eigentlich schadhaften Code erst aus dem Web herunterladen (Über Stream oder wie auch immer), direkt in den Speicher, und ihn dann auch direkt ausführen. Sowas ist dann tatsächlich nicht einfach zu finden.OK, fileless in einem Tool verstecken. Hier steigt meine Logikengine definitiv aus. 😵

Hallo,

Zugegeben, das war etwas emotional. Allerdings ist diese Diskussion so weit von jeder betriebswirtschaftlichen, technischen, logischen und mathematischen Betrachtung entfernt, dass man wirklich nur noch mit Sarkasmus reagieren kann.

Tut mir leid.

D.h. ich bin dann schon mal "vorgemerkt" und bekomme eine "Retourkutsche"? O.K. - mit Ankündigung kann ich damit leben!

Liebe Grüße aus Bremen,

Jörg

Zugegeben, das war etwas emotional. Allerdings ist diese Diskussion so weit von jeder betriebswirtschaftlichen, technischen, logischen und mathematischen Betrachtung entfernt, dass man wirklich nur noch mit Sarkasmus reagieren kann.

Tut mir leid.

Irgendwann brennt Dir ganz sicher mal der Arsch. Mal sehen, wer Dich dann anmacht.

D.h. ich bin dann schon mal "vorgemerkt" und bekomme eine "Retourkutsche"? O.K. - mit Ankündigung kann ich damit leben!

Liebe Grüße aus Bremen,

Jörg

Hallo,

Aber sicher ist das kein Humbug. Der Prozessor läuft mir mehr Takt als vorgesehen. Die 100% beziehen sich auf den Basistakt, nicht auf den aktuellen Takt. Läuft er über dem Basistakt (z.B. im Turbomodus oder übertaktet) läuft er mit mehr als 100%.

Was ist daran - rein rechnerisch - so schwer zu verstehen?

Gruß,

Jörg

Zitat von @MysticFoxDE:

Aus der mathematischen, der logischen, der technischen und der physikalischen Betrachtung ist eine Auslastung von mehr als 100% schlichtweg ein absoluter Humbug.

Aus der mathematischen, der logischen, der technischen und der physikalischen Betrachtung ist eine Auslastung von mehr als 100% schlichtweg ein absoluter Humbug.

Aber sicher ist das kein Humbug. Der Prozessor läuft mir mehr Takt als vorgesehen. Die 100% beziehen sich auf den Basistakt, nicht auf den aktuellen Takt. Läuft er über dem Basistakt (z.B. im Turbomodus oder übertaktet) läuft er mit mehr als 100%.

Was ist daran - rein rechnerisch - so schwer zu verstehen?

Gruß,

Jörg

Hallo,

Japp, aber bei einer seriösen betriebswirtschatlichen Kalkulation ist grundsätzlich von dem auszugehen, was garantiert wird. Und das ist die Mindestleistung - ähnlich den "bis zu" Angaben bei Internetbandbreiten.

Wenn ich ein gewisses Maß an TFLOPs benötige und das genau kenne, dann kaufe ich genau die CPUs, die das dauerhaft als gleichbleibende Eigenschaft bringen. Unabhängig von allen positiv einwirkenden Faktoren wie optimaler Kühlung usw. Negativ einwirkende Faktoren gibt es übrigens nicht, da es sich ja - wie gesagt - um das garantierte Minimum handelt.

Eine "Messung" aufgrund dieser Werte ist nicht zuverlässig.

Zum Einen weißt Du nicht, unter welchen (historischen) Bedingungen zustande gekommen sind: Vielleicht wurde letztes Jahr die Klimatisierung im Serverraum umgebaut oder der Server hat zwei zusätzliche Festplatten bekommen?

Zum Anderen können Faktoren eintreten, die dein System beeinflussen (z.B. ein weiterer Server im Rack). Wenn dann keine Reserven mehr vorhanden sind, weil sich die Überlastsituation nicht in den Messwerten dargestellt hat, dann steht dein System.

Ich bearbeite übrigens zahlreiche Reklamationen, die auf deiner Fehleinschätzung beruhen. "Ganz selten" kommt das offenbar nicht vor

Gruß,

Jörg

Zitat von @MysticFoxDE:

In der heutigen Zeit kannst du diese Angabe als Mindestleistung ansehen, die der Prozessor unter den schlechtesten aber noch zulässigen Bedingungen erbringen sollte.

In der heutigen Zeit kannst du diese Angabe als Mindestleistung ansehen, die der Prozessor unter den schlechtesten aber noch zulässigen Bedingungen erbringen sollte.

Japp, aber bei einer seriösen betriebswirtschatlichen Kalkulation ist grundsätzlich von dem auszugehen, was garantiert wird. Und das ist die Mindestleistung - ähnlich den "bis zu" Angaben bei Internetbandbreiten.

Wenn ich ein gewisses Maß an TFLOPs benötige und das genau kenne, dann kaufe ich genau die CPUs, die das dauerhaft als gleichbleibende Eigenschaft bringen. Unabhängig von allen positiv einwirkenden Faktoren wie optimaler Kühlung usw. Negativ einwirkende Faktoren gibt es übrigens nicht, da es sich ja - wie gesagt - um das garantierte Minimum handelt.

Eine "Messung" aufgrund dieser Werte ist nicht zuverlässig.

Zum Einen weißt Du nicht, unter welchen (historischen) Bedingungen zustande gekommen sind: Vielleicht wurde letztes Jahr die Klimatisierung im Serverraum umgebaut oder der Server hat zwei zusätzliche Festplatten bekommen?

Zum Anderen können Faktoren eintreten, die dein System beeinflussen (z.B. ein weiterer Server im Rack). Wenn dann keine Reserven mehr vorhanden sind, weil sich die Überlastsituation nicht in den Messwerten dargestellt hat, dann steht dein System.

Ich bearbeite übrigens zahlreiche Reklamationen, die auf deiner Fehleinschätzung beruhen. "Ganz selten" kommt das offenbar nicht vor

Gruß,

Jörg

Zitat von @MysticFoxDE:

Arbeitest du evtl. bei Microsoft an der Hotline?

Kann ich mir aber nicht so wirklich vorstellen, du heisst weder Natasha, noch Svetlana und auch nicht Tanja und anscheinend wohnst du auch in Deutschland und nicht in Osteuropa oder dahinter. Das passt nicht wirklich zu der aktuellen Besetzung des Microsoft Supports, zumindest nicht zu dem, den ich die letzte Zeit sprechen durfte. 🙃

Arbeitest du evtl. bei Microsoft an der Hotline?

Kann ich mir aber nicht so wirklich vorstellen, du heisst weder Natasha, noch Svetlana und auch nicht Tanja und anscheinend wohnst du auch in Deutschland und nicht in Osteuropa oder dahinter. Das passt nicht wirklich zu der aktuellen Besetzung des Microsoft Supports, zumindest nicht zu dem, den ich die letzte Zeit sprechen durfte. 🙃

Microsoft hat in Deutschland ca. 2700 Mitarbeiter, zuzüglich Mitarbeitern mit Werkvertrag oder aus Zeitarbeit. Der überwiegende Teil davon wohnt in Deutschland und gegen Einwurf von entsprechenden Münzen bekommst du sogar einen persönlichen Ansprechpartner der sich exklusiv um dich kümmert.

/Thomas

Hallo,

unglaublich, wie man mit zwei Sätzen eine Antwort mit zwei A4-Seiten an #whataboutism generieren kann *lol*

Gruß,

Jörg

unglaublich, wie man mit zwei Sätzen eine Antwort mit zwei A4-Seiten an #whataboutism generieren kann *lol*

Gruß,

Jörg

Erstens, Autovergleiche sind außerhalb der Autoindustrie IMMER für'n Hintern, für einen sinnvollen Vergleich muss man vergleichbares vergleichen.

Zweitens, niemand zwingt dich Azure zu kaufen, du kannst auch weiterhin On Premises Produkte kaufen oder Linux nutzen oder AWS oder was auch immer dir beliebt. Du kannst einen Hersteller nach deinen Bedürfnissen aussuchen, ihn dazu zu bringen deine speziellen Bedürfnisse zu befriedigen funktioniert erst ab einem gewissen Umsatz.

Drittens, natürlich kannst du als (Silber und Gold) Partner kostenlose Tickets eröffnen, das geht schon seit 20 Jahren oder so.

Und last but not least, (fast) alle Mitarbeiter von MS Deutschland arbeiten entweder im Sales oder im Support.

/Thomas

Hallo,

Ganz einfach: Aus dem gleichen Grund, warum Versicherungen und Banken mit in C# gestrickten APIs auf Cobol-Algorithmen aus den 60er Jahren herumhacken. Es ist wie mit Linux und XF86 / Wayland: Je dicker die Staubschicht, desto weniger wird es hinterfragt.

Das Teil stammt der von Mark Russinovich, die dazugehörige Firma hat Microsoft bereits 2006 zerlegt und ausgeschlachtet. Der eigentliche, grundlegende Code für die Bemessung dürfte noch älter sein.

Liebe Grüße,

Jörg

Zitat von @MysticFoxDE:

Warum ermittelt HWiNFO & AIDA64, die Auslastungsinformationen nicht auch über diesen heiligen Auslastungscounter, sondern ermittelt diese auf dieselbe Art und Weise wie der „Prozess Explorer“?

Warum ermittelt HWiNFO & AIDA64, die Auslastungsinformationen nicht auch über diesen heiligen Auslastungscounter, sondern ermittelt diese auf dieselbe Art und Weise wie der „Prozess Explorer“?

Ganz einfach: Aus dem gleichen Grund, warum Versicherungen und Banken mit in C# gestrickten APIs auf Cobol-Algorithmen aus den 60er Jahren herumhacken. Es ist wie mit Linux und XF86 / Wayland: Je dicker die Staubschicht, desto weniger wird es hinterfragt.

Das Teil stammt der von Mark Russinovich, die dazugehörige Firma hat Microsoft bereits 2006 zerlegt und ausgeschlachtet. Der eigentliche, grundlegende Code für die Bemessung dürfte noch älter sein.

Liebe Grüße,

Jörg

Hallo,

tut mir leid, dass sich die Funktion der Software nicht mit deinen Vorstellungen deckt.

Entscheidend sind übrigens die Performance Counter des Betriebssystems. Aber das hast Du ja schon vor ein paar Tagen gelernt.

Im Übrigen arbeite ich nicht für Microsoft.

Gruß,

Jörg

tut mir leid, dass sich die Funktion der Software nicht mit deinen Vorstellungen deckt.

Entscheidend sind übrigens die Performance Counter des Betriebssystems. Aber das hast Du ja schon vor ein paar Tagen gelernt.

Im Übrigen arbeite ich nicht für Microsoft.

Gruß,

Jörg

Hallo,

Ganz einfach: Weil es - wie wir hier gerade feststellen - einen Interpretationsspielraum gibt. Ansonsten hätten wir nämlich die gleiche Meinung!

Meine Aussage ist, dass man für eine vergleichende Messung eine(!) fixe Größe benötigt, die vorab bekannt ist und bei allen Prozessoren der Modellreihe identisch ist. Und das ist nun mal der Takt, der auf der Verkaufsverpackung steht. Alles darüber hinaus ist toll und darf auch gerne als "Geschenk Gottes" gesehen und genutzt werden. Reproduzierbar ist es aber nicht.

Gruß,

Jörg

Zitat von @MysticFoxDE:

Aha, und warum hält sich Microsoft selbst beim Prozess Explorer nicht daran und warum hält HWiNFO und AIDA auch nichts davon?

Aha, und warum hält sich Microsoft selbst beim Prozess Explorer nicht daran und warum hält HWiNFO und AIDA auch nichts davon?

Ganz einfach: Weil es - wie wir hier gerade feststellen - einen Interpretationsspielraum gibt. Ansonsten hätten wir nämlich die gleiche Meinung!

Meine Aussage ist, dass man für eine vergleichende Messung eine(!) fixe Größe benötigt, die vorab bekannt ist und bei allen Prozessoren der Modellreihe identisch ist. Und das ist nun mal der Takt, der auf der Verkaufsverpackung steht. Alles darüber hinaus ist toll und darf auch gerne als "Geschenk Gottes" gesehen und genutzt werden. Reproduzierbar ist es aber nicht.

Gruß,

Jörg

Bleibt die Frage warum sich das Füchsle so ausgiebig mit diesem Nichtproblem beschäftigt?

Hallo,

weil Andere diesen Schmarrn ebenfalls lesen und dann herumnölen, dass der fertig konfektioniert gekaufte Server gefälligst mehr Leistung zu erbringen hat als über die Spezifikationen abgedeckt ist.

Und weil man sich ganz doll wichtig tun kann, indem man krude Verschwörungstheorien entwickelt und so tut, als wäre man superschlau.

Gruß,

Jörg

weil Andere diesen Schmarrn ebenfalls lesen und dann herumnölen, dass der fertig konfektioniert gekaufte Server gefälligst mehr Leistung zu erbringen hat als über die Spezifikationen abgedeckt ist.

Und weil man sich ganz doll wichtig tun kann, indem man krude Verschwörungstheorien entwickelt und so tut, als wäre man superschlau.

Gruß,

Jörg