2 Rechner (1xWin+1xLinux) über Thunderbold verbunden. Extrem langsame Geschindigkeit

Hi,

hat einer schon 2 Rechner (Win+ubuntu) mit Thunderbold verbunden?

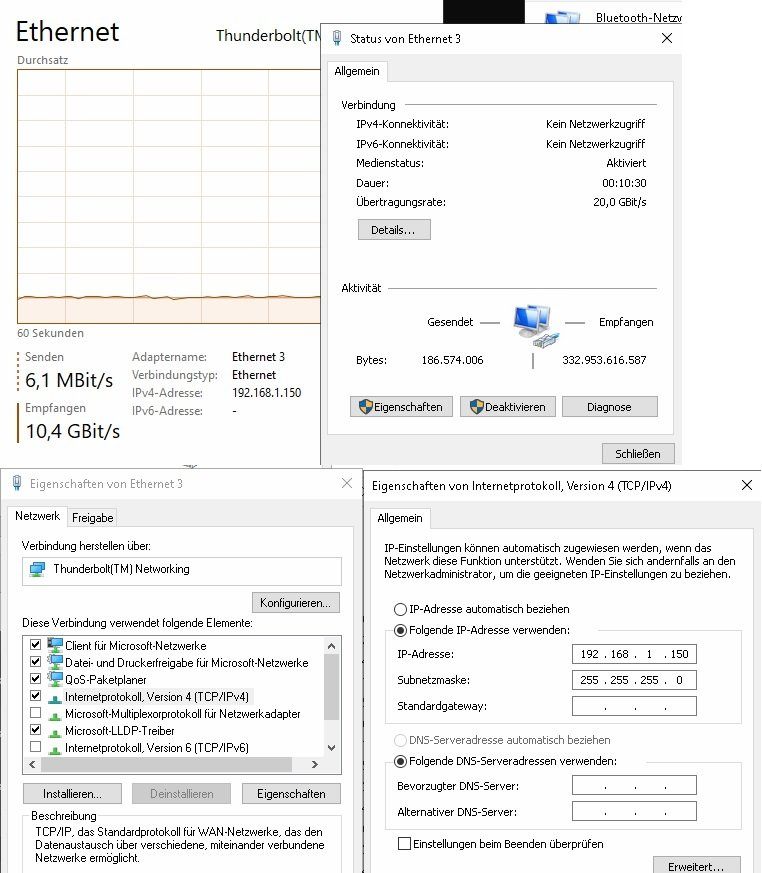

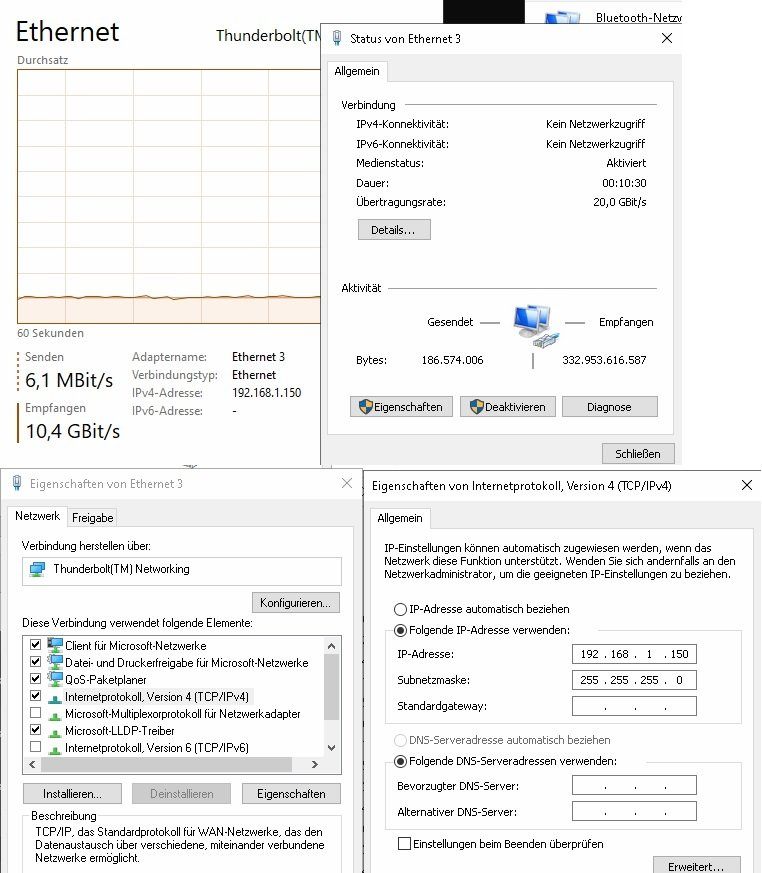

In Windows war es einfach. Netzwerkkarte hat sich erstellt. Diese dann noch entsprechend konfiguriert:

In Linux war es nicht ganz so trival.

Über "ip addr" erstmal die Schnittstelle rausbekommen und diese dann mittels "sudo ifconfig thunderbolt0 up" aktiviert.

Dann noch ein paar ifconfig-Befehle hinterher.

Jetzt sieht es so aus:

2 Probleme fallen mir auf:

1: Thunderbold 3. Ergo 20Gbits. In Windows passt das auch. Wird als 20Gbits angezeigt.

Schaut man sich aber nochmal das Bild an, schieb er durchweg nur 10Gbits.

2: Diese kommen aber nicht wirklich an. Ich hab mit dd mal eine 100GB Datei erstellt. Auch nach 10min war die noch nicht fertig.

Schaut man nun nochmal Linux die letze Ausgabe an hat er bereits 716GB gesendet (sollte aber nur um die 100GB sein)

Ich vermute mal das MTU nicht passt (?)

Da sehr große Datein verschoben werden äre JumboFrame vlt. garnicht so falsch. Da das ganze aber schon mit MTU1500 Probleme hat, brauch ich mit 9000 oder so garnicht erst testen.

Die Frage nun: Ist es wirklich der MTU Wert oder denkt ihr es liegt an was anderem ?

Falls MTU: wie bekomme ich den den optimalen Wert raus ?

hat einer schon 2 Rechner (Win+ubuntu) mit Thunderbold verbunden?

In Windows war es einfach. Netzwerkkarte hat sich erstellt. Diese dann noch entsprechend konfiguriert:

In Linux war es nicht ganz so trival.

Über "ip addr" erstmal die Schnittstelle rausbekommen und diese dann mittels "sudo ifconfig thunderbolt0 up" aktiviert.

Dann noch ein paar ifconfig-Befehle hinterher.

Jetzt sieht es so aus:

7: thunderbolt0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000

link/ether 12:7e:72:e4:27:c1 brd ff:ff:ff:ff:ff:ff

inet 192.168.1.151/24 brd 192.168.1.255 scope global thunderbolt0

valid_lft forever preferred_lft forever

inet6 fe80::107e:72ff:fee4:27c1/64 scope link

valid_lft forever preferred_lft forever

bzw:

thunderbolt0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.1.151 netmask 255.255.255.0 broadcast 192.168.1.255

inet6 fe80::107e:72ff:fee4:27c1 prefixlen 64 scopeid 0x20<link>

ether 12:7e:72:e4:27:c1 txqueuelen 1000 (Ethernet)

RX packets 7222841 bytes 404801982 (404.8 MB)

RX errors 0 dropped 5 overruns 0 frame 0

TX packets 14905335 bytes 716545775059 (716.5 GB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 02 Probleme fallen mir auf:

1: Thunderbold 3. Ergo 20Gbits. In Windows passt das auch. Wird als 20Gbits angezeigt.

Schaut man sich aber nochmal das Bild an, schieb er durchweg nur 10Gbits.

2: Diese kommen aber nicht wirklich an. Ich hab mit dd mal eine 100GB Datei erstellt. Auch nach 10min war die noch nicht fertig.

Schaut man nun nochmal Linux die letze Ausgabe an hat er bereits 716GB gesendet (sollte aber nur um die 100GB sein)

Ich vermute mal das MTU nicht passt (?)

Da sehr große Datein verschoben werden äre JumboFrame vlt. garnicht so falsch. Da das ganze aber schon mit MTU1500 Probleme hat, brauch ich mit 9000 oder so garnicht erst testen.

Die Frage nun: Ist es wirklich der MTU Wert oder denkt ihr es liegt an was anderem ?

Falls MTU: wie bekomme ich den den optimalen Wert raus ?

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 667370

Url: https://administrator.de/forum/2-rechner-1xwin-1xlinux-ueber-thunderbold-verbunden-extrem-langsame-geschindigkeit-667370.html

Ausgedruckt am: 18.07.2025 um 03:07 Uhr

7 Kommentare

Neuester Kommentar

Moin,

das kann natürlich auch an was ganz anderem liegen: Kabellänge, Kabelqualität, irgendwelche Gerätschaften (wie den Hub aus Deinem anderem Thread) dazwischen usw.

Du könntest auch mal ein paar Details zu den verwendeten PCs/Laptops (Hersteller, Modell usw.) preisgeben, dann kann man eventuell besser helfen. Was für eine SSD-Technik (Anschluss) wird auf beiden Seiten verwendet? Ggf, ist SMB/CIFS auch nicht der ideale Testkandidat.

Gruß

cykes

das kann natürlich auch an was ganz anderem liegen: Kabellänge, Kabelqualität, irgendwelche Gerätschaften (wie den Hub aus Deinem anderem Thread) dazwischen usw.

Du könntest auch mal ein paar Details zu den verwendeten PCs/Laptops (Hersteller, Modell usw.) preisgeben, dann kann man eventuell besser helfen. Was für eine SSD-Technik (Anschluss) wird auf beiden Seiten verwendet? Ggf, ist SMB/CIFS auch nicht der ideale Testkandidat.

Gruß

cykes

Ggf, ist SMB/CIFS auch nicht der ideale Testkandidat.

Richtig. Weil es eins der schlechtesten und ineffizientesten Protokolle dafür ist wegen der kleinen Pakete.Sinnvoll misst man mit iPerf3 was einem dann wirklich verlässliche Nettwerte gibt pro Paketgröße statt diese sinnfreie Frickelei mit SMB/CIFS. Zudem kann man mit mehreren Streams messen.

computerweekly.com/de/tipp/Mit-iPerf3-Netzwerkbandbreite-Jitter- ...

usw.

Moin,

Das wesentliche wurde von den Kollegen ja schon gesagt:

Erstmal die beiden Kisten direkt mit Thunderbolt verbinden, ohne Ethernet! und dann mit iperf3 mal messen. Dann sieht man erstmal, wie die Performance ist. Danach kann man mit Ethernet udn Hub Komponenten dazunehmen udn schauen, ob iperf3 imerm ncoh die gleiche Performance bescheinigt.

Erst als letzten Schritt würde ich die Messung mit SMB/CIFS druchführen.

lks

Das wesentliche wurde von den Kollegen ja schon gesagt:

Erstmal die beiden Kisten direkt mit Thunderbolt verbinden, ohne Ethernet! und dann mit iperf3 mal messen. Dann sieht man erstmal, wie die Performance ist. Danach kann man mit Ethernet udn Hub Komponenten dazunehmen udn schauen, ob iperf3 imerm ncoh die gleiche Performance bescheinigt.

Erst als letzten Schritt würde ich die Messung mit SMB/CIFS druchführen.

lks