RAM-Zugriff auf einem neuen High-Performance Server, teilweise um Welten langsamer als auf einer Workstation

Moin Zusammen,

mir ist gestern beim Optimieren eines neuen Servers eine Sonderheit aufgefallen, die ich mir so beim besten Willen, momentan absolut nicht erklären kann.

Und zwar ist die RAM Performance meiner fast zwei Jahre alten Workstation, teilweise um Faktoren besser, als die eines neuen High-Performance Servers. 🤔

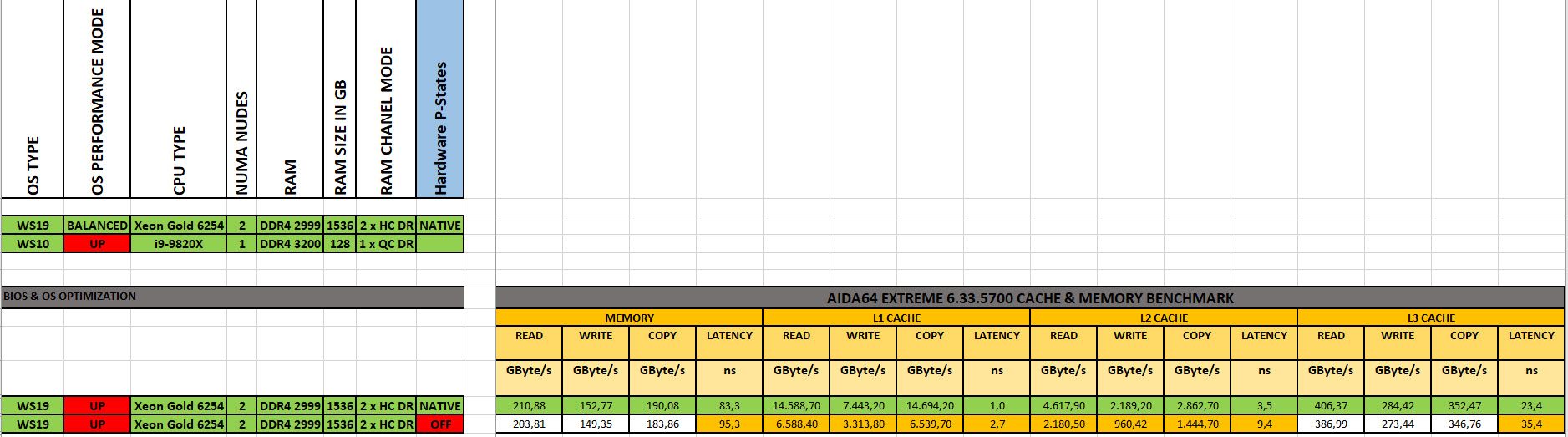

Zu den Hardwaredetails.

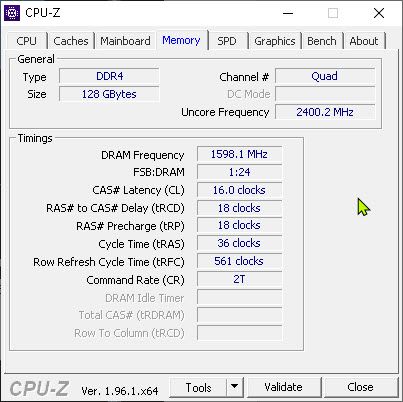

Workstation (W10 21H1 ENT):

CPU: i9-9820X

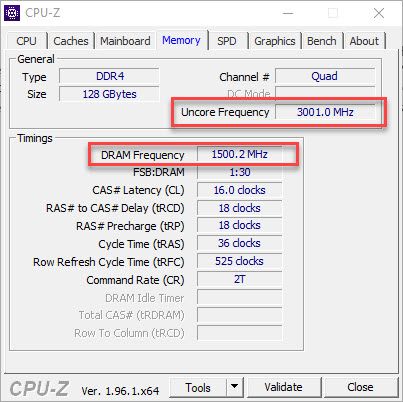

RAM: 128GB DDR4 3200 (Quad Chanel Betrieb)

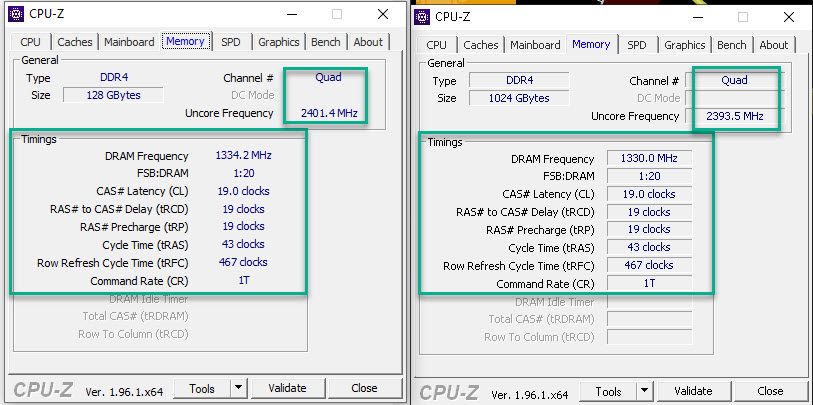

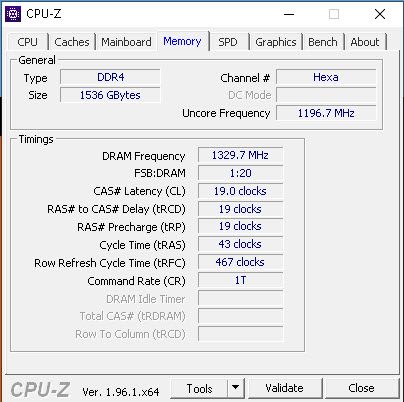

Server (WS2019 1809 DATACENTER):

CPU: 2 x Xeon Gold 6254

RAM:1536GB DDR4 2999 (!!Hexa Chanel Betrieb!!)

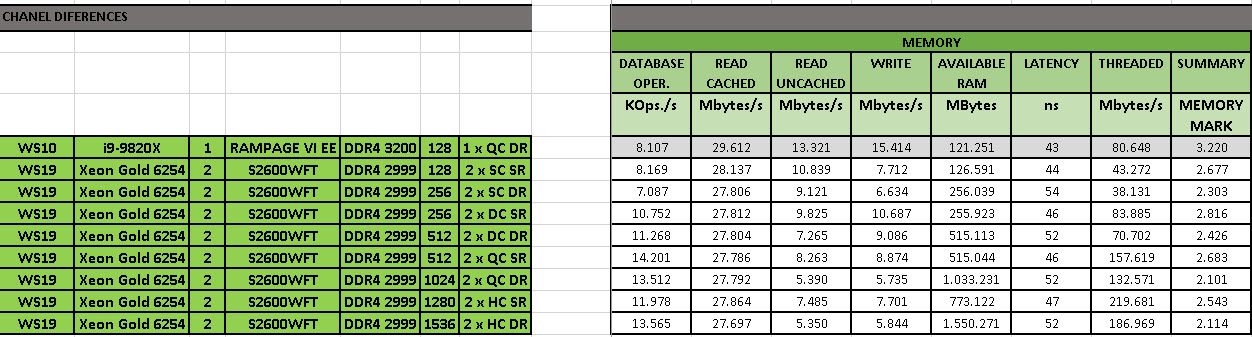

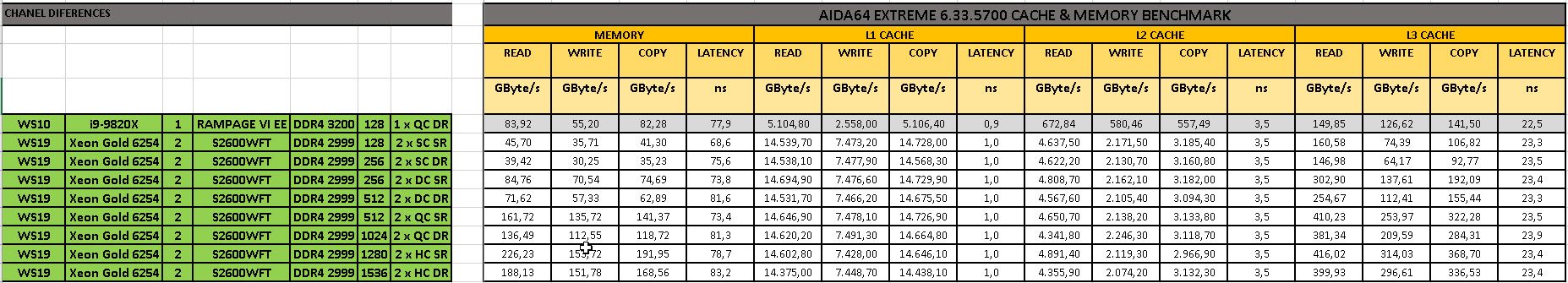

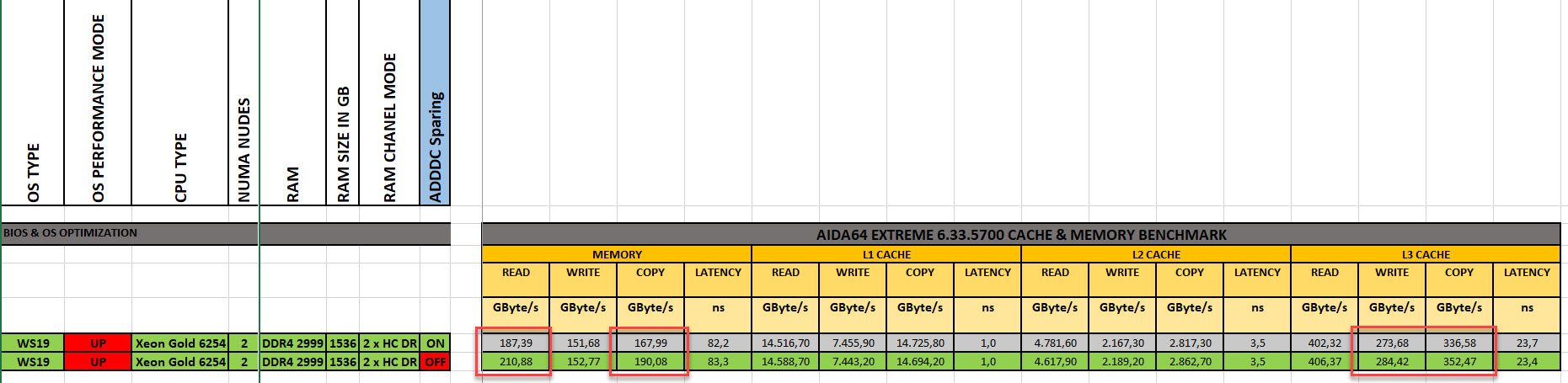

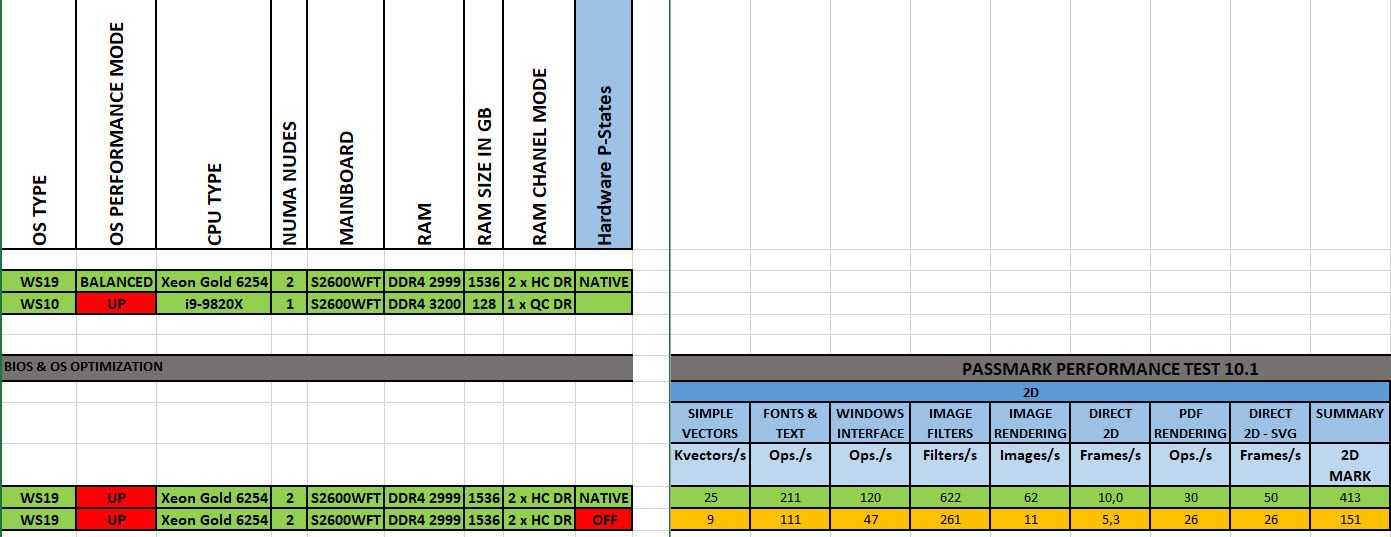

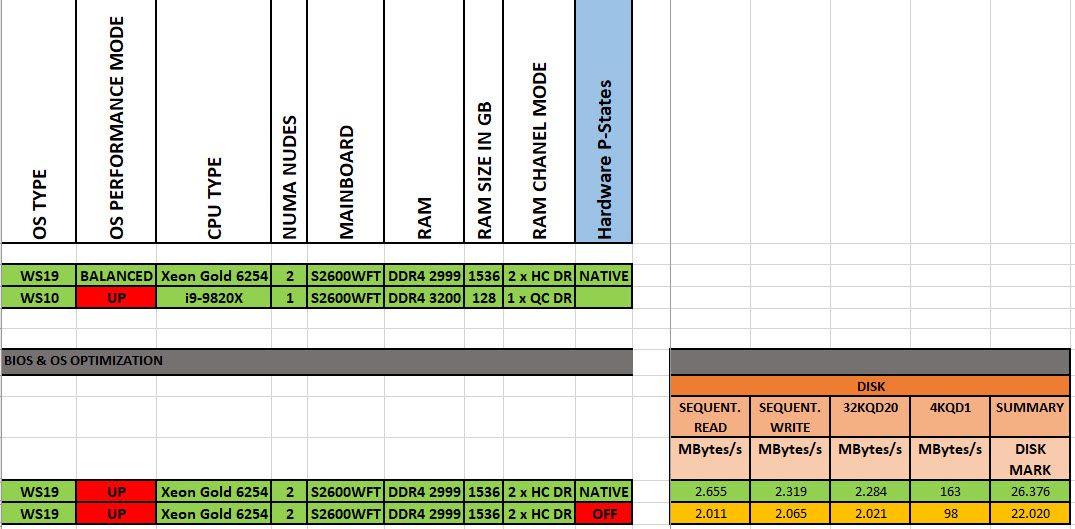

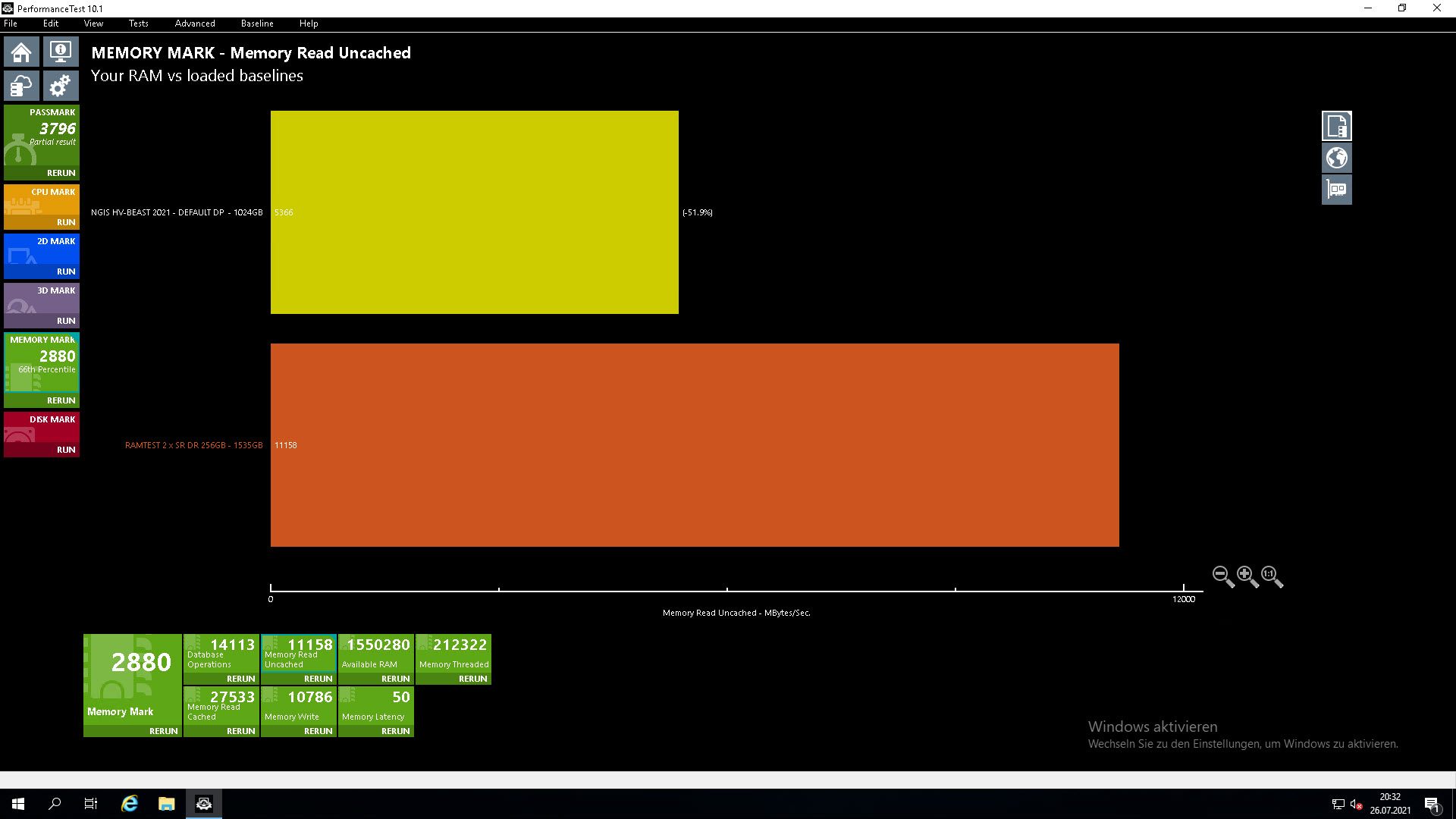

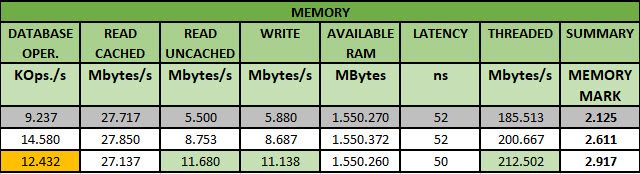

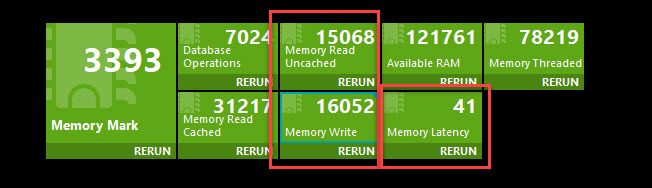

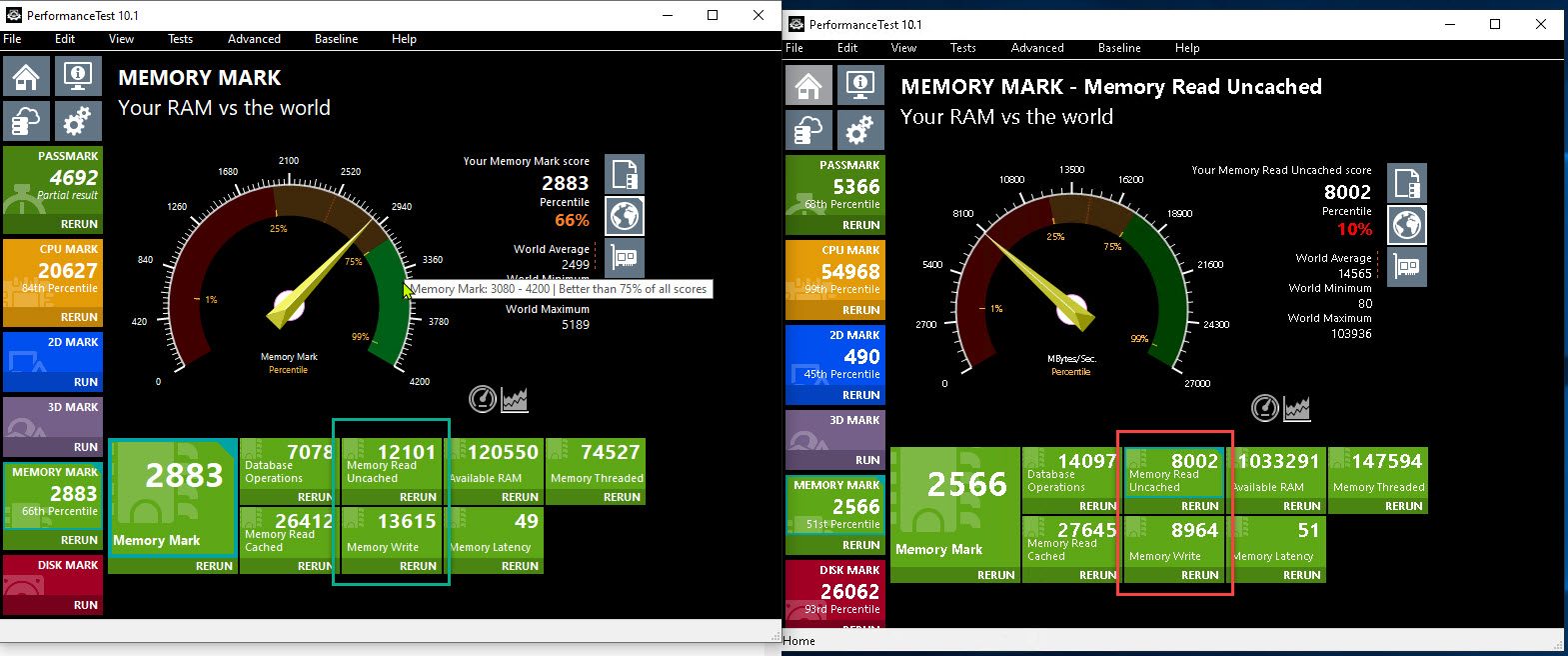

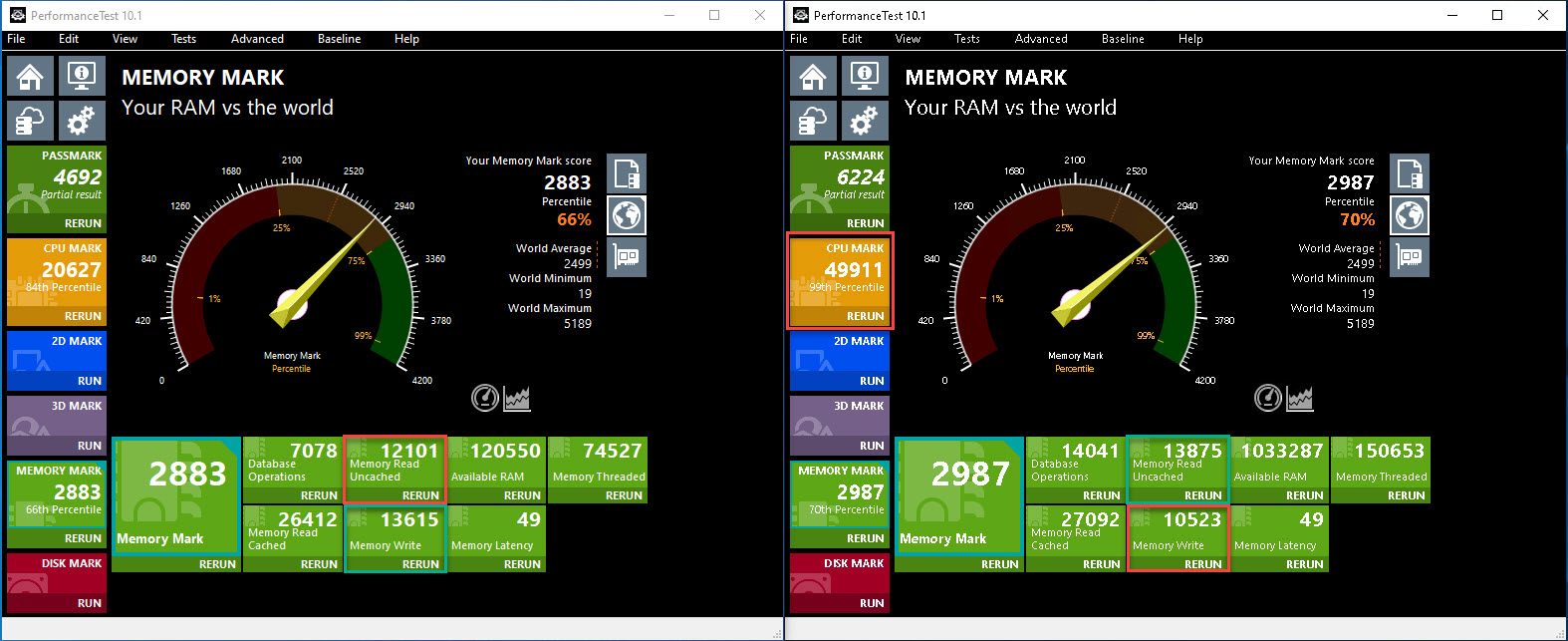

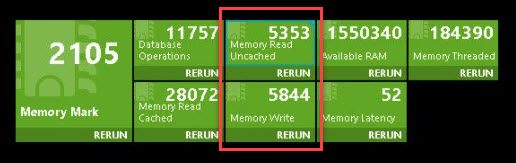

Zum Ermitteln der „Over All“ Performance habe ich einen PassMark Performance Test genommen.

Mir ist bewusst, dass es für Einzeldisziplinen noch bessere Benchmakprogramme gibt, mit dem Performance Test von PassMark bekomme ich jedoch aus einem Programm schnell eine Performanceübersicht über viele Bereiche (CPU/GPU/RAM/DISK) ohne dafür duzend von Einzelanwendungen laufen lassen zu müssen.

Das ich den Server gegen eine Workstation benchmarke war übrigens ein reiner Zufall, ich habe zuerst das Benchmarking gegen eine andere Baseline gemacht, die ich schon vor Monaten bei der Optimierung eines anderen Systems erstellt habe. Dabei ist mir jedoch aufgefallen, dass die RAM Performance an einigen Stellen viel geringer aussieht, als das was ich dem Letzt beim Benchmarken meiner Workstation gesehen habe. So habe ich kurzerhand den Benchmark auf der Workstation wiederholt, habe die Ergebnisse exportiert und diese zum besseren Vergleichen auf dem PerformanceTest, der auf dem Server läuft, wieder importiert.

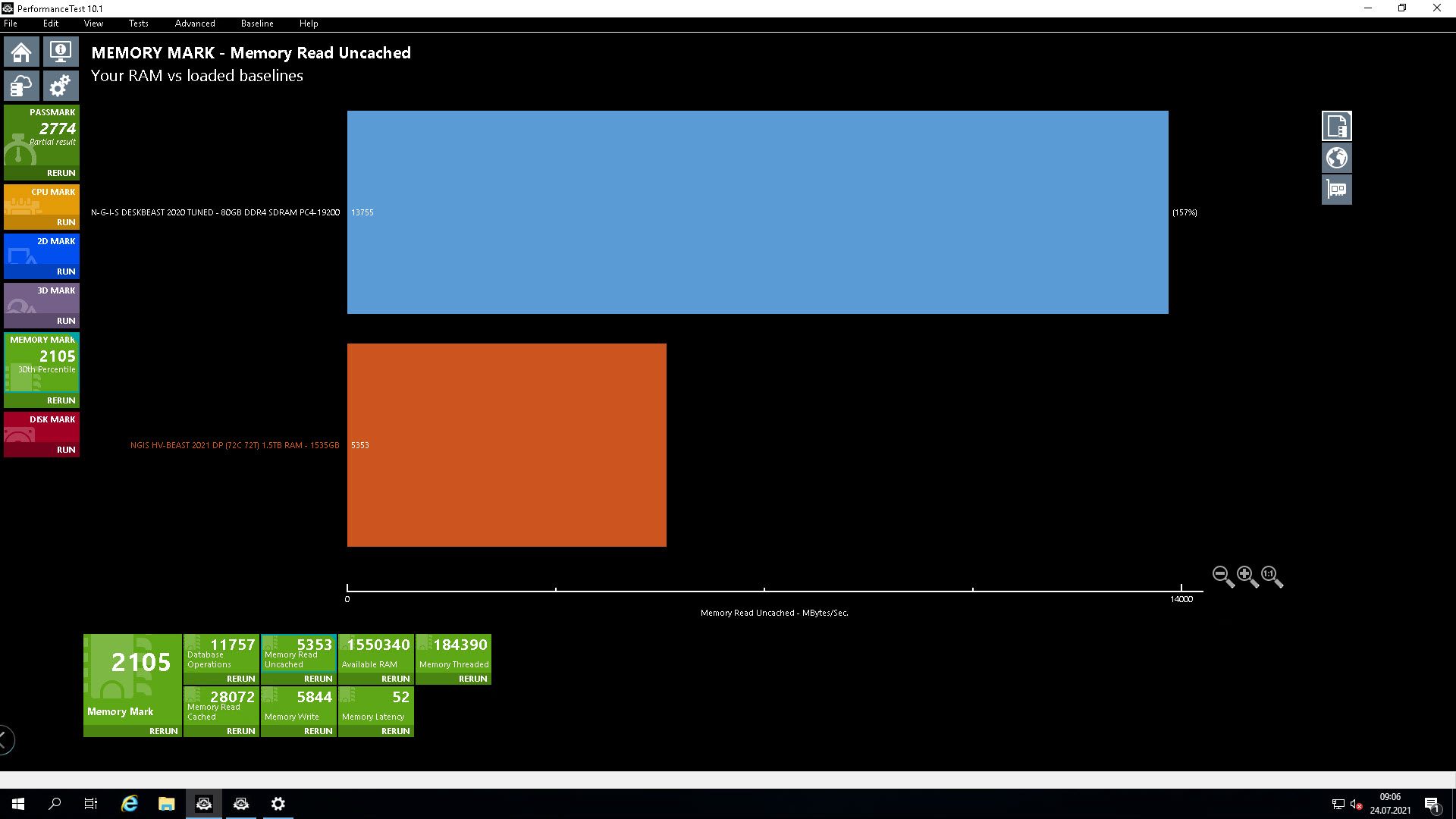

Und die beiden folgende Ergebnisse bereiten mir das Kopfzerbrechen.

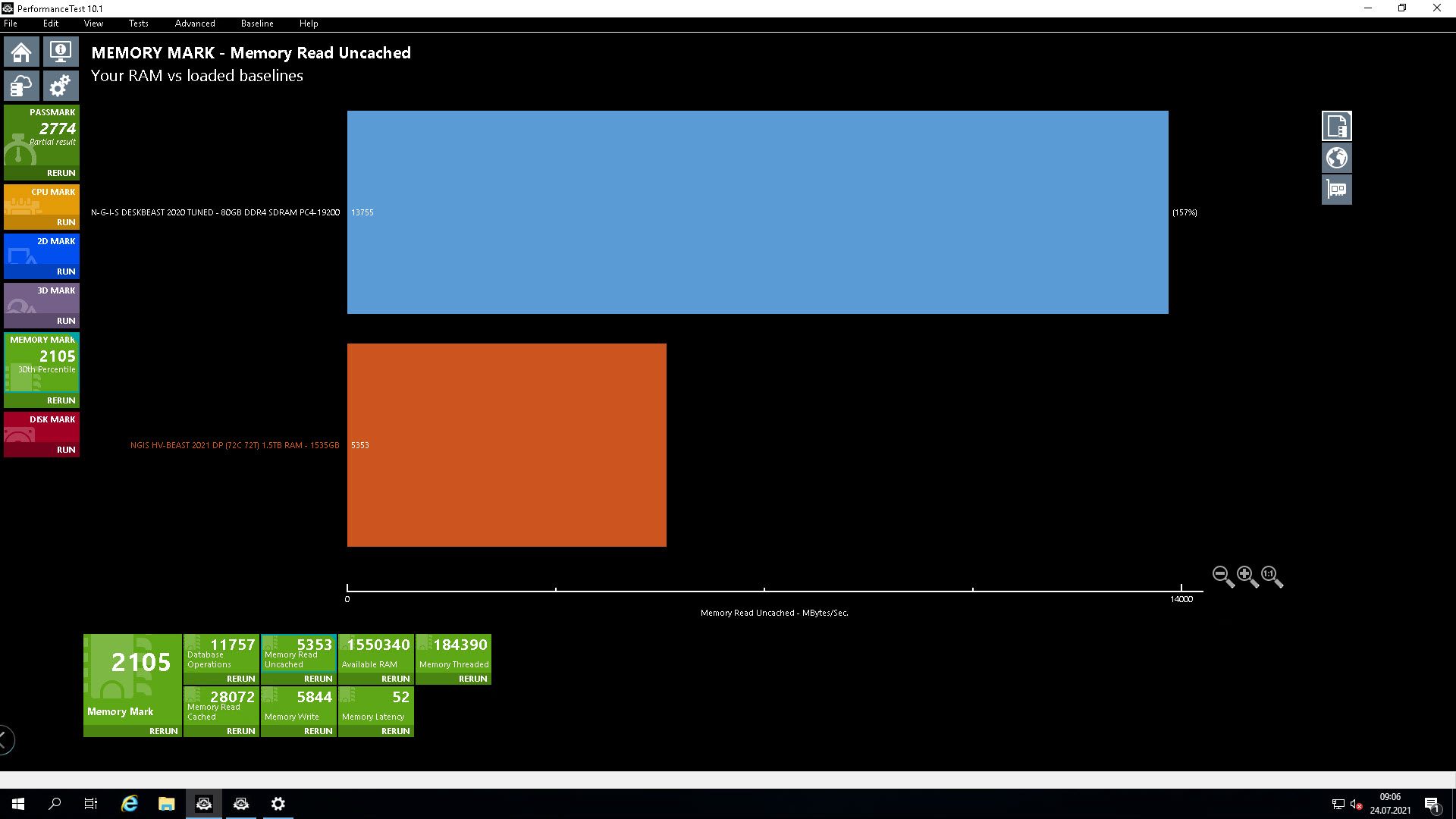

RAM Lesen ungepuffert:

Wie Ihr sehen könnt, kommt meine Workstation bei diesem Test auf 13755MB/s und der Server auf gerade mal 5366 MB/s. 😬

Wie Ihr sehen könnt, kommt meine Workstation bei diesem Test auf 13755MB/s und der Server auf gerade mal 5366 MB/s. 😬

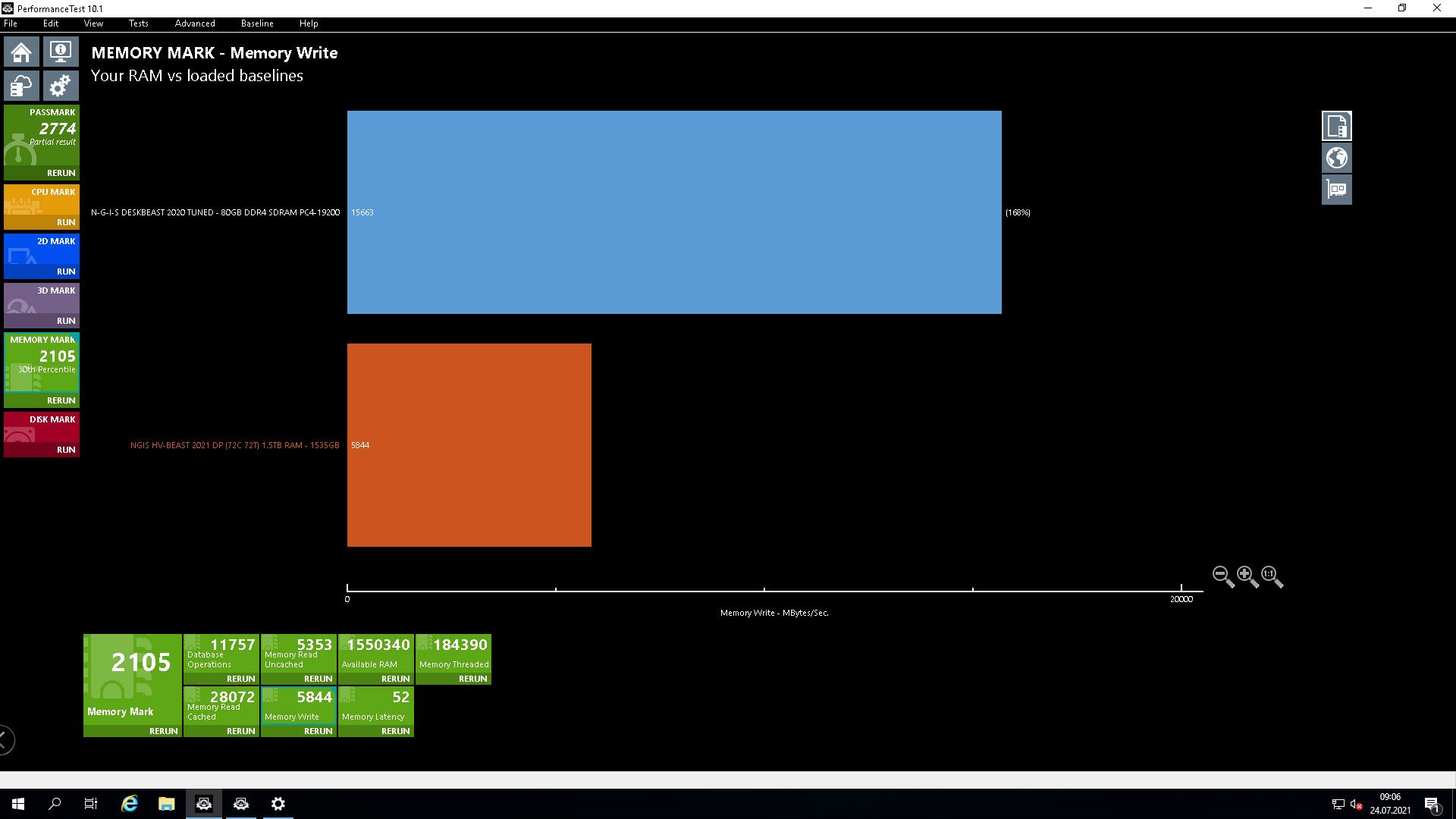

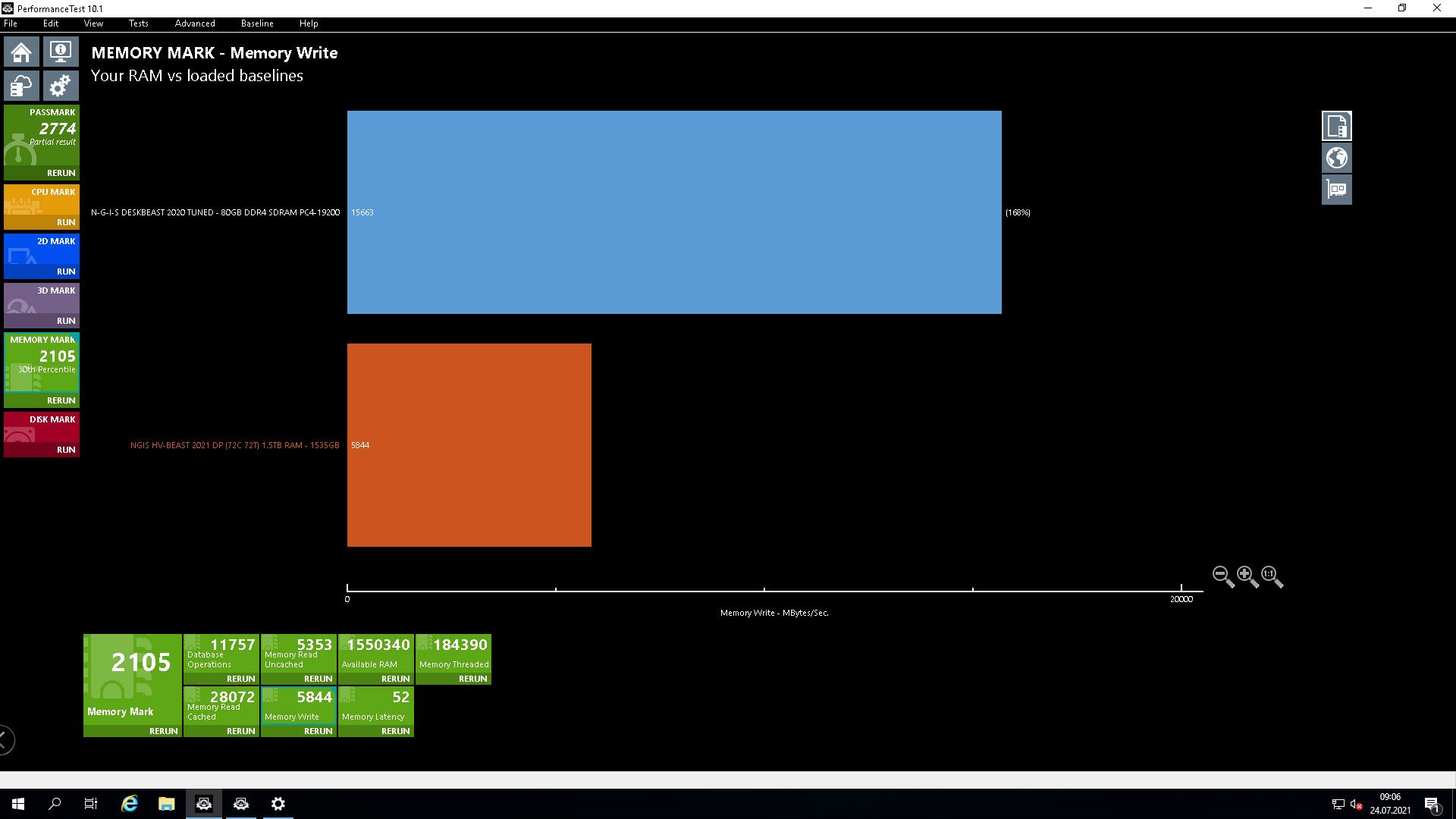

RAM Schreiben ungepuffert:

Bei Schreiben sieht es nicht besser aus. Die Workstation kommt bei diesem Test auf 15663MB/s, der Server kommt im Default auf 5772 MB/s. 🤢

Bei Schreiben sieht es nicht besser aus. Die Workstation kommt bei diesem Test auf 15663MB/s, der Server kommt im Default auf 5772 MB/s. 🤢

Es ist beides Mal 1:1 derselbe Workload, daher verstehe ich absolut nicht, warum dieser auf der Workstation derart viel schneller ist, obwohl der RAM im Server, zwar technisch etwas langsamer ist (ca. 10%), dafür aber über eine 50% höhere Bandbreite angebunden ist (über beide CPU’s gesehen sind es sogar 200% mehr).

Hat jemand eine Idee warum das so ist?

Und vielleicht noch eine, wie man diesen Murks beseitigen kann?

Beste Grüsse aus BaWü

Alex

mir ist gestern beim Optimieren eines neuen Servers eine Sonderheit aufgefallen, die ich mir so beim besten Willen, momentan absolut nicht erklären kann.

Und zwar ist die RAM Performance meiner fast zwei Jahre alten Workstation, teilweise um Faktoren besser, als die eines neuen High-Performance Servers. 🤔

Zu den Hardwaredetails.

Workstation (W10 21H1 ENT):

CPU: i9-9820X

RAM: 128GB DDR4 3200 (Quad Chanel Betrieb)

Server (WS2019 1809 DATACENTER):

CPU: 2 x Xeon Gold 6254

RAM:1536GB DDR4 2999 (!!Hexa Chanel Betrieb!!)

Zum Ermitteln der „Over All“ Performance habe ich einen PassMark Performance Test genommen.

Mir ist bewusst, dass es für Einzeldisziplinen noch bessere Benchmakprogramme gibt, mit dem Performance Test von PassMark bekomme ich jedoch aus einem Programm schnell eine Performanceübersicht über viele Bereiche (CPU/GPU/RAM/DISK) ohne dafür duzend von Einzelanwendungen laufen lassen zu müssen.

Das ich den Server gegen eine Workstation benchmarke war übrigens ein reiner Zufall, ich habe zuerst das Benchmarking gegen eine andere Baseline gemacht, die ich schon vor Monaten bei der Optimierung eines anderen Systems erstellt habe. Dabei ist mir jedoch aufgefallen, dass die RAM Performance an einigen Stellen viel geringer aussieht, als das was ich dem Letzt beim Benchmarken meiner Workstation gesehen habe. So habe ich kurzerhand den Benchmark auf der Workstation wiederholt, habe die Ergebnisse exportiert und diese zum besseren Vergleichen auf dem PerformanceTest, der auf dem Server läuft, wieder importiert.

Und die beiden folgende Ergebnisse bereiten mir das Kopfzerbrechen.

RAM Lesen ungepuffert:

RAM Schreiben ungepuffert:

Es ist beides Mal 1:1 derselbe Workload, daher verstehe ich absolut nicht, warum dieser auf der Workstation derart viel schneller ist, obwohl der RAM im Server, zwar technisch etwas langsamer ist (ca. 10%), dafür aber über eine 50% höhere Bandbreite angebunden ist (über beide CPU’s gesehen sind es sogar 200% mehr).

Hat jemand eine Idee warum das so ist?

Und vielleicht noch eine, wie man diesen Murks beseitigen kann?

Beste Grüsse aus BaWü

Alex

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 1082958739

Url: https://administrator.de/forum/ram-zugriff-auf-einem-neuen-high-performance-server-teilweise-um-welten-langsamer-als-auf-einer-workstation-1082958739.html

Ausgedruckt am: 21.07.2025 um 06:07 Uhr

97 Kommentare

Neuester Kommentar

Grundlagen der wissenschaftlichen Arbeit, Vergleichbarkeit so gut es geht herstellen. Mein Mathelehrer vor Dekaden nannte das mal Äpfel mit Birnen.

a) Beide Betriebssysteme auf einem Level halten -W10 vs W10 oder WS19 vs WS19

b) Kann das Benchmarktool mit den Leistungsfunktionen des Servers klar kommen oder gibt es ggf. sogar ein Problem mit "zu viel" Ram?

c) verzerrt zu viel Speicher das Ergebnis?

d) ECC vs non ECC?

... aber das sollte man eigentlich beim tunen wissen?

a) Beide Betriebssysteme auf einem Level halten -W10 vs W10 oder WS19 vs WS19

b) Kann das Benchmarktool mit den Leistungsfunktionen des Servers klar kommen oder gibt es ggf. sogar ein Problem mit "zu viel" Ram?

c) verzerrt zu viel Speicher das Ergebnis?

d) ECC vs non ECC?

... aber das sollte man eigentlich beim tunen wissen?

Ein guter Wissenschaftler kann und sollte aus zwei Umgebungen die ähnlich aber nicht ganz gleich sind, aber auch Rückschlüsse ziehen können. 😉

Inwiefern du die Vergleichbarkeit steigern kannst wurde oben durch mehrere Parteien genannt.

Wage es, installier auf der Workstation ein WS2019, pass den Speicher an.

Theoretisch ja, praktisch kann der PerformanceTest den RAM jedoch zu 100% sehen und ich bin auch nicht der erste der einen Server mit 1,5TB RAM damit benchmarkt.

Theoretisch konnten wir früher auch 4TB+ Festplatten sehen, nur einbinden war über eine gewisse Zeit ein massives Problem.

Theoretisch ja, praktisch dürfte das nicht sein.

wie falsifizierst du das theoretische ja?

Unser System ist jetzt schon das Schnellste unter allen öffentlichen PassMark Baselines (selbe CPU Bestückung). 😎

Das ist schön, aber irrelevant. Denn dir geht es schliesslich nicht darum ob es das schnellste ist, sondern warum es in Relation zur Workstation proportional langsam ist. Also wenn es dir nicht darum geht den "Dicken" zu markieren, sondern wirklich ums wissenschaftliche Ergebnis, warum ist es langsamer führt das zu obigen Kommentaren die du in die Prüfung/Testkonstellation überführen musst.

PS: Noch dazu sei angemerkt, dass auch fraglich ist, wer alles seine Testergebnisse in die öffentlichen Baselines schiebt. Den meisten geht es dann doch eher um den Effekt auf die Abarbeitung der Tätigkeiten als darauf die Rangliste anzuführen.

Moin,

mehr Speicher, insbesondere 1,5TB verhält sich anders als 128GB. da treten dann Effekte auf, die man mit wenig Speicher gar nicht hat.

Auch ist es auf Server so, daß man ggf die volle Bandbreite erst nutzen kann, wenn man entsprechend viele Zugrifffe parallel macht und nicht nur als Einzelthread. Du solltet prüfen, ob Dein Benchmark auch alle Cores auslastet. Das ist wie mit 500PS unter der Haube. Sowohl ein Porsche Taycan als auch ein Fendt 1050 Vario haben 500PS. Aber je nachdem, welche Disziplin Du nimmst, hat mal der eine und mal der andere "bessere Werte".

lks

mehr Speicher, insbesondere 1,5TB verhält sich anders als 128GB. da treten dann Effekte auf, die man mit wenig Speicher gar nicht hat.

Auch ist es auf Server so, daß man ggf die volle Bandbreite erst nutzen kann, wenn man entsprechend viele Zugrifffe parallel macht und nicht nur als Einzelthread. Du solltet prüfen, ob Dein Benchmark auch alle Cores auslastet. Das ist wie mit 500PS unter der Haube. Sowohl ein Porsche Taycan als auch ein Fendt 1050 Vario haben 500PS. Aber je nachdem, welche Disziplin Du nimmst, hat mal der eine und mal der andere "bessere Werte".

lks

Zitat von @MysticFoxDE:

Mir gings es bei der Aussage nicht darum den Dicken zu markieren, sondern eher darum, dass auch die anderen vergleichbaren Serversysteme deren Benchmarkergebnisse ich zum Vergleich online abrufen kann, an dieser Ecke warum auch immer auch nicht besser sind.

Mir gings es bei der Aussage nicht darum den Dicken zu markieren, sondern eher darum, dass auch die anderen vergleichbaren Serversysteme deren Benchmarkergebnisse ich zum Vergleich online abrufen kann, an dieser Ecke warum auch immer auch nicht besser sind.

Es gibt da einen Spruch aus der Elektrotechnik: "Wer mißt, mißt Mist!" (gesprochen kommt das besser rüber).

Man sollte erst schauen, ob die Meßmethode geeignet ist, das zu messen, was man beabsichtigt. In Deinem fall wäre Erstmal zu schauen, welche Speicherperformance der Benchmark denn genau mißt und wie diese zusammenkommt. Erst dann kann man die Meßergebnisse bewerten. Ansonsten sind alle Benchmarks nur Schätzeisen, die zwar einen Anhaltspunkt liefern können, aber auch manchmal komplett danebenliegen.

Um mal meinen vergleiche von oben zu nehmen: Wenn Du Geschwindigtkeit alleine mißt, ist der Porsche eindeutig schneller, selbst einer mit deutlich geringeren Leistung, weil der Fendt nur

So ähnlich ist es auch mit dem Speicher. Solange Du nur wenige GB durch die Gegend schiebst ist Deine Workstation schneller, Aber die Vorteile Deines Servers kommen vermutich erst dann zu tragen, wenn Du sehr viele Threads mit sehr viel GB-Schaufelei hast.

Deswegen solltest Du vielleicht mal schauen, ob es einen geeigneteren Benchmark gibt.

lks

Wenn dein Auto theoretisch 200PS hätte und du praktisch nur 50 abrufen könntest, dann würdest du das also nicht hinterfragen?

wenn meines Nachbars identisches bei 200PS die 200PS abrufen kann und ich nicht, ja. Wenn es sich wie beim Fendt Vergleich verhält gilt es entsprechende Anpassungen vorzunehmen oder es eben stehen zu lassen. Nicht jeder Test Algorhythmus eignet sich für jedes zu bewertende Szenario.

Eine Workstation hat im Zweifel andere Anwendungsfälle als ein Server und darauf ist dessen Leistung optimiert.

Zitat von @MysticFoxDE:

Moin Frank,

ist ein Intel R2208WFTZSR, sprich A++ Brand. 😜

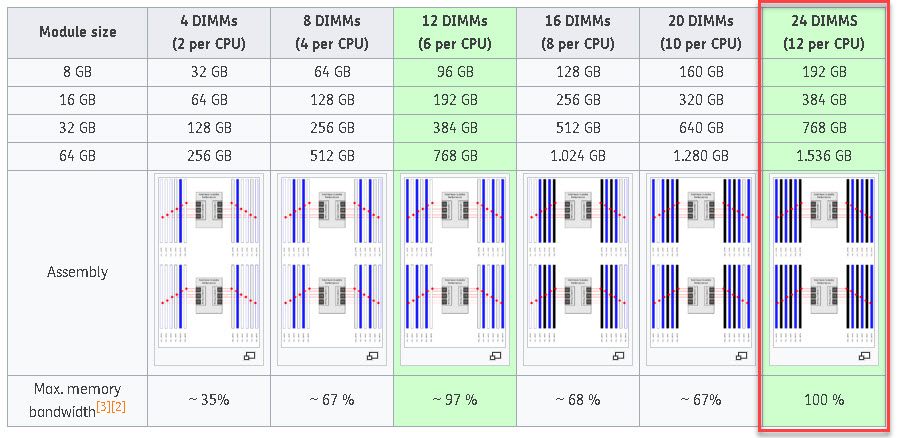

Habe zuvor schon mit 1 TB (Quad Chanel) getestet und das brachte auch keine nenenswerte Veränderung ausser das die Werte noch grottiger geworden sind.

Wenn ich den Server mit 128GB bestücke, dass sind das ein Riegel pro CPU und dann läuft der RAM im Single Chanel.

Warum sollte das den besser sein?

nicht besser, sondern anders.... dann natürlich mit 265 usw...Moin Frank,

was ist das für ein Server?

ist ein Intel R2208WFTZSR, sprich A++ Brand. 😜

ich sehe du hast 1,5 TB Ram verbaut, bestücke mal nur mit 128 GB RAM und teste bitte!

Habe zuvor schon mit 1 TB (Quad Chanel) getestet und das brachte auch keine nenenswerte Veränderung ausser das die Werte noch grottiger geworden sind.

Wenn ich den Server mit 128GB bestücke, dass sind das ein Riegel pro CPU und dann läuft der RAM im Single Chanel.

Warum sollte das den besser sein?

Das widerspricht allem was ich bisher selbst gesehen und darüber auch gelesen habe.

ich glaube nur, was ich selber getestet habe, und nicht was ich irgendwo gelesen habe.....je nach Server und RAM Modus bist du bei vollausbau bis zu 25 % langsamer...

ich hatte ähnliches Problem, was mit einm Bios Update behoben werde konnte...

ich hatte ähnliches Problem, was mit einm Bios Update behoben werde konnte...

Aufgrund eines BUG ja, ansonsten sollte mir bei einer Vollbestückung der Speicherbänke auch 100% der möglichen RAM-Bandbreite der CPU zur Verfügung stehen.

ich bin mir nicht mal sicher ob CPU-Z gescheit 1,5 TB messen kann.... ich würde zum vergleich unter Linux Testen.

Beste Grüsse aus BaWü

Alex

Frank

Zitat von @MysticFoxDE:

Moin Lks,

😧, OK ist ja gut, ich sehe schon, ich komme nicht drumherum etwas praktisches RAM-Domino zu spielen um mal wieder die Theorie auch wirklich durch harte Praxis zu belegen.

sach ich doch Moin Lks,

mehr Speicher, insbesondere 1,5TB verhält sich anders als 128GB. da treten dann Effekte auf, die man mit wenig Speicher gar nicht hat.

😧, OK ist ja gut, ich sehe schon, ich komme nicht drumherum etwas praktisches RAM-Domino zu spielen um mal wieder die Theorie auch wirklich durch harte Praxis zu belegen.

es wird schon unterschiede geben, ob du 8,16, 32,oder 64 GB Module nutzt!

Auch ist es auf Server so, daß man ggf die volle Bandbreite erst nutzen kann, wenn man entsprechend viele Zugrifffe parallel macht und nicht nur als Einzelthread. Du solltet prüfen, ob Dein Benchmark auch alle Cores auslastet. Das ist wie mit 500PS unter der Haube. Sowohl ein Porsche Taycan als auch ein Fendt 1050 Vario haben 500PS. Aber je nachdem, welche Disziplin Du nimmst, hat mal der eine und mal der andere "bessere Werte".

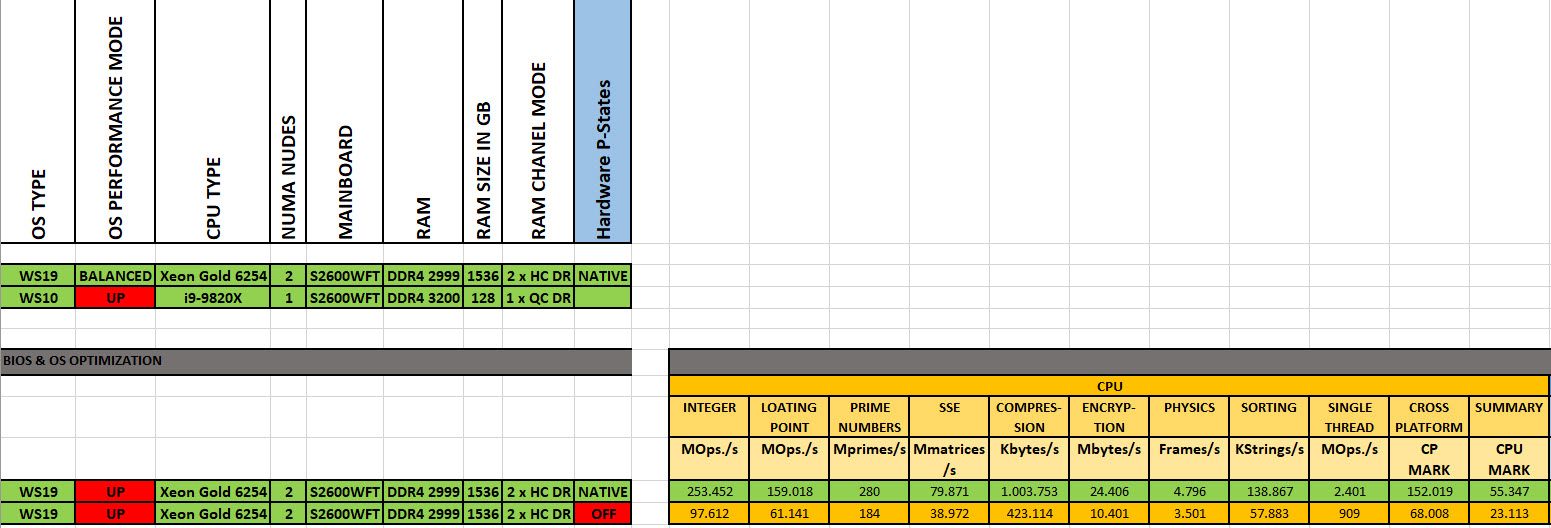

Ich weis, dass die Server erst bei parallelen Zugriffen ihre volle Leistung entfalten können, aber darum geht es mir nicht.

Der PassMark PerformanceTest macht bei RAM Test etwas absolut simples. Bei lesen liest dieser 512 MB grosse Blöcke aus dem RAM und bei schreiben geht's eben in die umgekehrte Richtung. Nicht spannendes, einfach nur Daten in RAM rein und wieder raus lesen, ist jetzt auch keine Hexenwissenschaft.

Und genau dieser einfache Prozess/Workload (Single Thread), wird von meiner Workstation viel schneller abgearbeitet als von dem Server, obwohl weder dessen RAM noch CPU, der der Workstation sonderlich unterlegen sind. 🤔

Beste Grüsse aus BaWü

Alex

Frank

Zitat von @MysticFoxDE:

😧, OK ist ja gut, ich sehe schon, ich komme nicht drumherum etwas praktisches RAM-Domino zu spielen um mal wieder die Theorie auch wirklich durch harte Praxis zu belegen.

Du solltest auch mal einen Test mir nur 1 CPU durchführen.😧, OK ist ja gut, ich sehe schon, ich komme nicht drumherum etwas praktisches RAM-Domino zu spielen um mal wieder die Theorie auch wirklich durch harte Praxis zu belegen.

Wenn Dein Test Single-Threaded ist, kann er auf die andere Hälte des RAMs nur über Umwege zugreifen.

Vieleicht ist das schon Dein Problem.

Stefan

Zitat von @Mystery-at-min:

hat doch mit dem Problem nun wenig zu tun? Du stehst vor einem Problem, willst du die Anmerkung aufgreifen? Dann tus, wirf die Ergebnisse rein, wenn nicht, dann nicht. Sorry, aber das klingt doch schon ein wenig danach den "dicken" raushängen zu lassen. Musst das...?

hat doch mit dem Problem nun wenig zu tun? Du stehst vor einem Problem, willst du die Anmerkung aufgreifen? Dann tus, wirf die Ergebnisse rein, wenn nicht, dann nicht. Sorry, aber das klingt doch schon ein wenig danach den "dicken" raushängen zu lassen. Musst das...?

wiso den "dicken" raushängen lassen? und vor allem wobei?

Frank

Ich weiß nicht wieso du deinen eigenen Beitrag so auf Abwegen führst. Einen solchen Server kauft man normal nicht für Single Thread Handling. Schon deswegen weil doppelte CPU und viele cores. Da lohnen sich weniger Cores und Single CPU mehr p/l.

Zu dem du möchtest zig Tonnen von a nach b bringen, Kauf einen Truck. Du möchtest in für Geschwindigkeit von a nach b, Kauf dir einen Sportwagen.

Was machen die Ergebnisse?

Zu dem du möchtest zig Tonnen von a nach b bringen, Kauf einen Truck. Du möchtest in für Geschwindigkeit von a nach b, Kauf dir einen Sportwagen.

Was machen die Ergebnisse?

Zitat von @MysticFoxDE:

noch eine kleine Anmerkung zu dieser Passage.

Die Multithread-Leistung ist beim Server selbstverständlich auch wichtig, die Singlethread Leistung bleibt in den meisten Anwendungsfällen jedoch das Wesentlichere.

Einen normalen User interessiert es absolut nicht, ob das neue System welches sich sein Arbeitgeber angeschafft hat, theoretisch nun die doppelte Anzahl Tasks parallel fahren kann, bevor die CPU die 100% erreicht.

Wenn die eine Singlethread Applikation, die er täglich hauptsächlich benutzt, auf dem neuen System auf einmal doppelt so lange benötigt, weil dessen Singlethreadleistung geringer ist als die des vorherigen Systems, dann hopft er dir als Admin trotz deines neuen Multithreading Monsters, dennoch ordentlich mit Anlauf ins Genick. Und kurze Zeit später auch die GL.

Daher, parallel heisst noch lange nicht schneller.

noch eine kleine Anmerkung zu dieser Passage.

Die Multithread-Leistung ist beim Server selbstverständlich auch wichtig, die Singlethread Leistung bleibt in den meisten Anwendungsfällen jedoch das Wesentlichere.

Einen normalen User interessiert es absolut nicht, ob das neue System welches sich sein Arbeitgeber angeschafft hat, theoretisch nun die doppelte Anzahl Tasks parallel fahren kann, bevor die CPU die 100% erreicht.

Wenn die eine Singlethread Applikation, die er täglich hauptsächlich benutzt, auf dem neuen System auf einmal doppelt so lange benötigt, weil dessen Singlethreadleistung geringer ist als die des vorherigen Systems, dann hopft er dir als Admin trotz deines neuen Multithreading Monsters, dennoch ordentlich mit Anlauf ins Genick. Und kurze Zeit später auch die GL.

Daher, parallel heisst noch lange nicht schneller.

Nun machst Du aber ein ganz anders Faß auf. Die meisten Server die ich kenne, werden nicht wegen der Singlethreaded-Leistung gekauft, sondern weil da viele Leute gleichzeitig Ihre Arbeit in annehmbarer Zeit erledigen können (z.B. Terminalserver). Wenn man einzelnen User viel Leistun geben will, stellt man denen Workstations hin oder wenn das ganz doch auf dem Server passieren soll, dann andere Serverarchitektur, die auf Singlethreaded-Leistung statt auf Multithreaded optimiert ist.

Es ist wie mit dem (hinkenden) Autobeispiel. Wenn viele Leute gleichzeitig von A nach B kommen sollen nimmt man Busse. Wenn dies aber zeitkritisch ist, also sehr schnell gehen muß, nimmt man Kleinbusse oder gar PKW, die aber weil man mehr davon braucht, teurer sind als der ganz große Bus.

Die frage ist doch, für welchen Einsatzzweck der Server gedacht ist? Virtualisierungserver für ganz viele VMs, die sich in den 1,5TB RAM austoben dürfen oder als Datenbankserver der alles im Speicher hält oder als "Numbercruncher" (oder gar was ganz anderes). Dementsprechend wäre zu eruieren, ob der Server das passende für die Anwendung ist.

lks

Moin,

vielleicht hilft es ja, mit dem Intel Memory Latency Checker etwas tiefer zu graben.

Beispiele:

Bandbreite

Latenz

Burn-In Tests wie Prime95 Torture Test wurden gemacht?

Rein rechnerisch sollte die Bandbreite deutlich höher sein. Der Verdacht eines Speicherkonfliktes liegt nahe.

Gruß Grinskeks

Gruß

Grinskeks

vielleicht hilft es ja, mit dem Intel Memory Latency Checker etwas tiefer zu graben.

Beispiele:

Bandbreite

- mlc –max_bandwidth

- mlc –peak_injection_bandwidth

Latenz

- mlc –idle_latency

- mlc –loaded_latency

Burn-In Tests wie Prime95 Torture Test wurden gemacht?

Rein rechnerisch sollte die Bandbreite deutlich höher sein. Der Verdacht eines Speicherkonfliktes liegt nahe.

Gruß Grinskeks

Gruß

Grinskeks

Jetzt spinnen wir die tollen Vergleiche nach und praktisch hast du in der IT Technik auch nur Physik.

In deinem Vergleich hast du mir weniger Breite auch weniger Luftwiderstand. Denn dein Vergleich hinkt, du fährst hin mit einem sechs spuren Breiten (und längeren!) Und gesicherten Kfz und zurück mit einem vierspuren breitem. Nennen wir es (Bus)Management Overhead. Aber das ist dir zu theoretisch ;)

Und nein du kannst ein System eben nicht für Multi und Single Thread Anwendung ohne Kompromisse optimieren. Das das gewünscht oder fehlgelaufen sein soll ist dein Problem.

Versteh auch nicht, dass du hier den input brauchst wenn du das doch so gut kannst.;)

Bei 120vms hast du am ende die Multi Thread Anforderungen. Also macht das Benchmark vermutlich keinen Sinn, ist am Ende also Spielerei. Würde sagen du erarbeitest jetzt mal die Zahlen :D.

Wer misst....

In deinem Vergleich hast du mir weniger Breite auch weniger Luftwiderstand. Denn dein Vergleich hinkt, du fährst hin mit einem sechs spuren Breiten (und längeren!) Und gesicherten Kfz und zurück mit einem vierspuren breitem. Nennen wir es (Bus)Management Overhead. Aber das ist dir zu theoretisch ;)

Und nein du kannst ein System eben nicht für Multi und Single Thread Anwendung ohne Kompromisse optimieren. Das das gewünscht oder fehlgelaufen sein soll ist dein Problem.

Versteh auch nicht, dass du hier den input brauchst wenn du das doch so gut kannst.;)

Bei 120vms hast du am ende die Multi Thread Anforderungen. Also macht das Benchmark vermutlich keinen Sinn, ist am Ende also Spielerei. Würde sagen du erarbeitest jetzt mal die Zahlen :D.

Wer misst....

Ich habe doch schon X Mal gesagt, dass es mir explizit um einen bestimmten Workload geht, und dieser wechselt zwischen den Autobahnseiten nicht mal so seine "Kerneigenschaften". 😉

Dann ist dein KFZ vielleicht einfach das falsche und das wurde oben schon von mehreren angeführt.

Wenn du in deinem Leben solche Benchmarks schon mal wissenschaftlich und gewissenhaft erstellt hättest, dann würdest du jetzt nicht die ganze Zeit hetzen. 😉

Hetzen? Ich hinterfrage einfach nur, was das mehr und mehr widersprüchliche (merkten auch mehrere an) soll. Aber dann klär uns auf, DU solltest doch wissen, was das Ziel ist, durch Äpfel vs Birnen Vergleiche wird das aber nicht klar.

Also, du erwartest, dass ein LKW mit größerer Last die gleiche Vmax erreicht wie ein Sportwagen?

Und wenn das Bild mies ist wird es nicht besser durch eine bessere Brille.

Zitat von @MysticFoxDE:

Dazu hätte ich ne kleine Frage.

Welche der folgenden CPU’s würdest du für einen Server (Hypervisor/Mixbetrieb) eher bevorzugen?

A: 6 Cores mit a 4 GHz

B: 12 Cores mit a 2 GHz

also nur aus der sicht von Oracle, würde ich A: 6 Cores mit a 4 GHz wählen wollen!A: 6 Cores mit a 4 GHz

B: 12 Cores mit a 2 GHz

jetzt verstehe ich auch dein Problem mit dem speicher durchsatz...

für den Rest natürlich B:

haben alle 3 Server die gleichen werte?

Beste Grüsse aus BaWü

Alex

Hi,

um die Vergleichbarkeit herzustellen, müssten bei Windows 10 zumindest die Speicherkompression abgeschaltet und das Prozessortiming auf Hintergrunddienste gestellt werden. Da es dann immernoch zwei verschiedene Kernel-Versionen sind, könnte sich eine Server-Installation auf der Workstation schon lohnen.

Grüße

Richard

um die Vergleichbarkeit herzustellen, müssten bei Windows 10 zumindest die Speicherkompression abgeschaltet und das Prozessortiming auf Hintergrunddienste gestellt werden. Da es dann immernoch zwei verschiedene Kernel-Versionen sind, könnte sich eine Server-Installation auf der Workstation schon lohnen.

Grüße

Richard

Hallo,

mal eine gemeine Frage: Kann die Antwort auf diese Frage Dir helfen?

A) Es ist ein "Anzeigeproblem" aufgrund der Art wie dieser Test funktioniert und der Server ist im Betrieb normal schnell.

Dann musst Du nix machen.

B1) Es ist kein Anzeigeproblem, aber es hat auf den Betrieb keine Auswirkung

Dann musst Du nix machen.

B2) Es ist kein Anzeigeproblem und es hat Auswirkungen weil der Server langsammer ist als der alte Server.

Was tun? Außer ärgern?

Den Server zurückgeben wirst Du vermutlich nicht können.

Es ist auch nicht wahrscheinlich, dass es eine Bios/Windows/Treiber-Einstellung giebt die solch dramatische Auswirkungen hat.

Stefan

mal eine gemeine Frage: Kann die Antwort auf diese Frage Dir helfen?

A) Es ist ein "Anzeigeproblem" aufgrund der Art wie dieser Test funktioniert und der Server ist im Betrieb normal schnell.

Dann musst Du nix machen.

B1) Es ist kein Anzeigeproblem, aber es hat auf den Betrieb keine Auswirkung

Dann musst Du nix machen.

B2) Es ist kein Anzeigeproblem und es hat Auswirkungen weil der Server langsammer ist als der alte Server.

Was tun? Außer ärgern?

Den Server zurückgeben wirst Du vermutlich nicht können.

Es ist auch nicht wahrscheinlich, dass es eine Bios/Windows/Treiber-Einstellung giebt die solch dramatische Auswirkungen hat.

Stefan

Zitat von @MysticFoxDE:

Moin Frank,

jetzt verstehe ich auch dein Problem mit dem speicher durchsatz...

Aber auch ein MS-SQL oder ein MySQL oder ein Exchange und selbst eine RDS Umgebung würde von A mehr profitieren wie von B.

Nicht unbedingt.Moin Frank,

Welche der folgenden CPU’s würdest du für einen Server (Hypervisor/Mixbetrieb) eher bevorzugen?

A: 6 Cores mit a 4 GHz

B: 12 Cores mit a 2 GHz

also nur aus der sicht von Oracle, würde ich A: 6 Cores mit a 4 GHz wählen wollen!A: 6 Cores mit a 4 GHz

B: 12 Cores mit a 2 GHz

jetzt verstehe ich auch dein Problem mit dem speicher durchsatz...

Wenn Du 64 User auf einem RDS hast, bist Du mit mehr Kernen langsammen besser dran. Auch bei einem My/MSSQL Server mit vielen Verbindungen. Due skalierst viel besser die Leistung zwischen den Kernen.

Aber es gibt natürlich auch Anwendungen die selber nicht gut skalieren wo mehr GHz dann helfen.

Es kommt immer darauf an.

Btw. Weniger schnelle Kerne sind deutlich günstiger bei den MS Lizenzen.

Stefan

Auch gibt es immer mal wieder "lustige" Probleme wenn man an das Performance-Maximum geht.

youtube.com/watch?v=xWjOh0Ph8uM

Und nicht jeder hat die Kontakte und Zeit diesen Problemen auf den Grund zu gehen.

Stefan

youtube.com/watch?v=xWjOh0Ph8uM

Und nicht jeder hat die Kontakte und Zeit diesen Problemen auf den Grund zu gehen.

Stefan

Zitat von @MysticFoxDE:

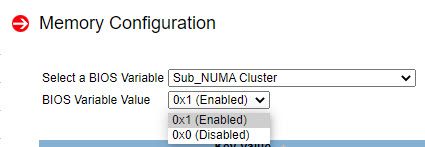

Doch, vor allem das BIOS mit seinen fragwürdigen Standardeinstellungen, ist mir momentan quasi das grösste Dorn im Auge.

Ich bin gespannt ob oder welche Lösung am Ende dabei rauskommt und ich drücke Dir alle 3 Daumen.Doch, vor allem das BIOS mit seinen fragwürdigen Standardeinstellungen, ist mir momentan quasi das grösste Dorn im Auge.

Zitat von @MysticFoxDE:

3 headed monkey behind your back...Ich bin gespannt ob oder welche Lösung am Ende dabei rauskommt und ich drücke Dir alle 3 Daumen.

Bist du ein Alien oder muss ich einfach etwas versauter denken? 😜Zitat von @MysticFoxDE:

Der Kernel vom Server 2019 ist zu > 99% identisch mit dem Kernel von Windows 10 1809, auf W10 ist dieser lediglich etwas kastriert(😬). 🙃

Der Kernel vom Server 2019 ist zu > 99% identisch mit dem Kernel von Windows 10 1809, auf W10 ist dieser lediglich etwas kastriert(😬). 🙃

Das stimmt, aber Du hast doch 21H1 auf der Workstation.

Es ist auch nicht wahrscheinlich, dass es eine Bios/Windows/Treiber-Einstellung giebt die solch dramatische Auswirkungen hat.

Doch, vor allem das BIOS mit seinen fragwürdigen Standardeinstellungen, ist mir momentan quasi das grösste Dorn im Auge.

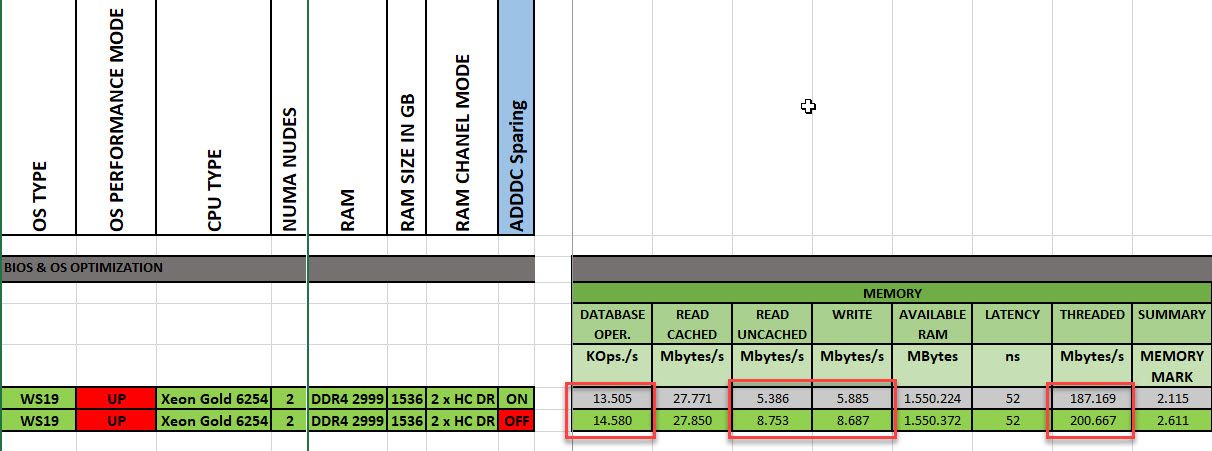

ich bin natürlich davon ausgegangen, das du das Bios Optimiert hast, und dein Blech nicht mit Standard einstellungen rennt!

nüchtern betrachtet (also nur mit restalkohol) denke ich das deine Bleche nur auf 50% laufen!

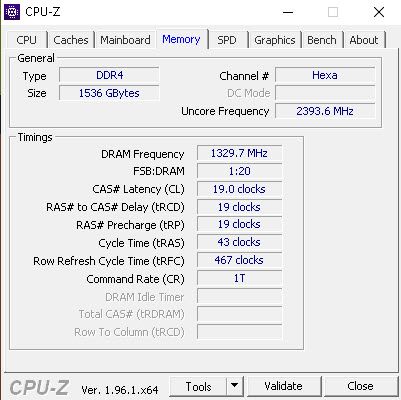

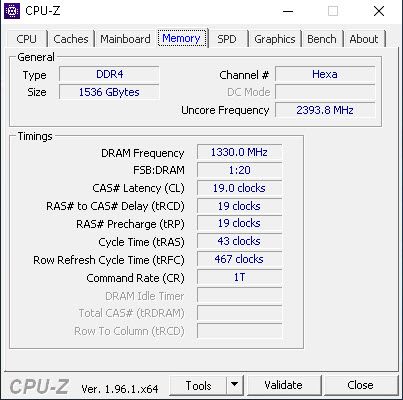

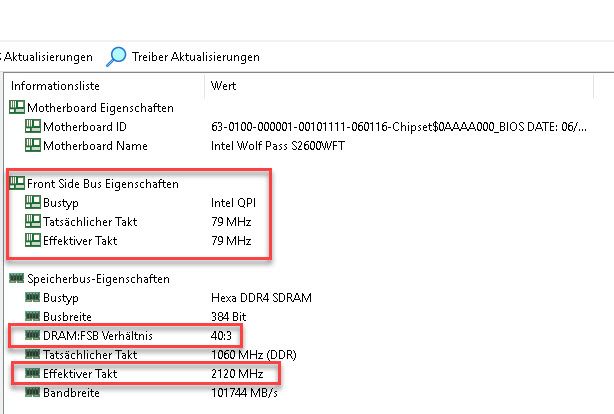

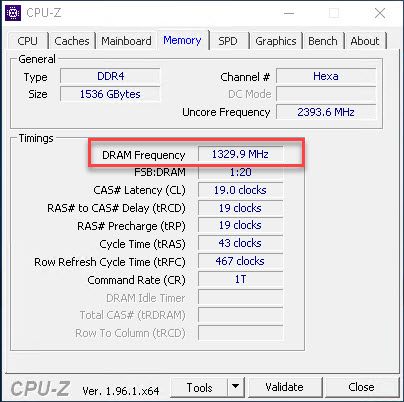

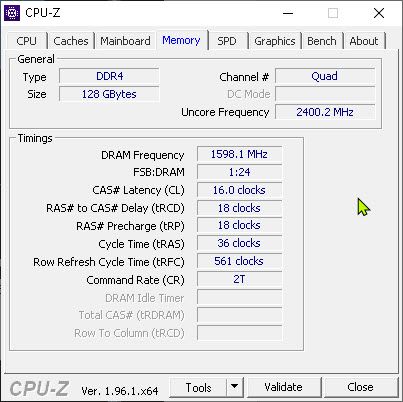

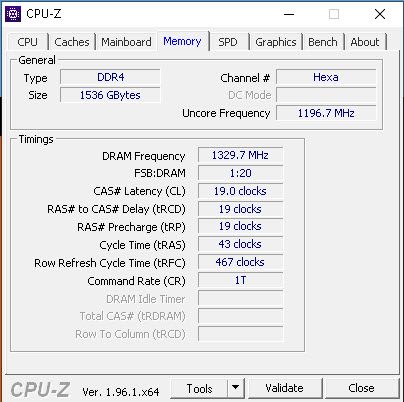

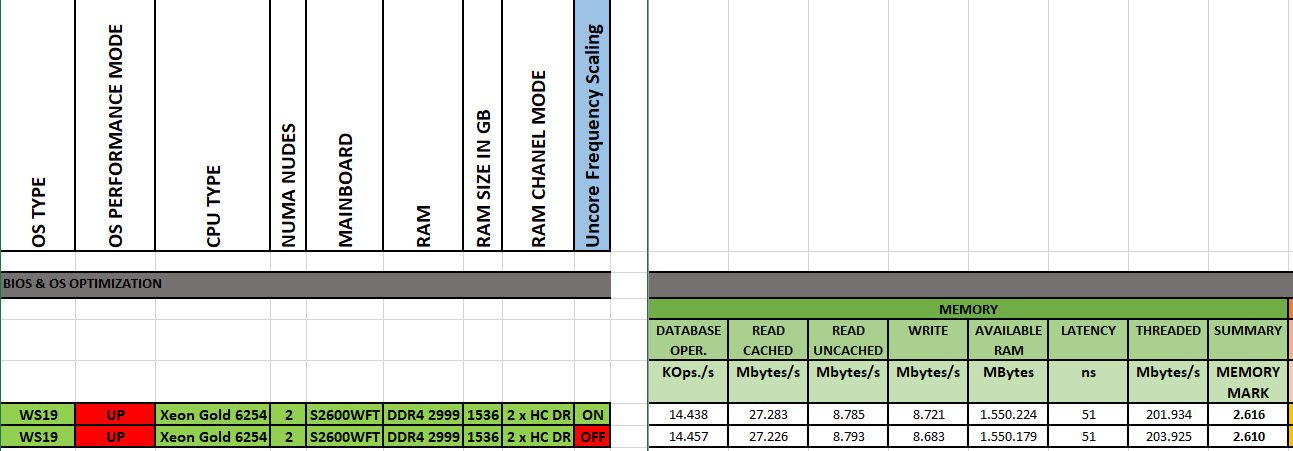

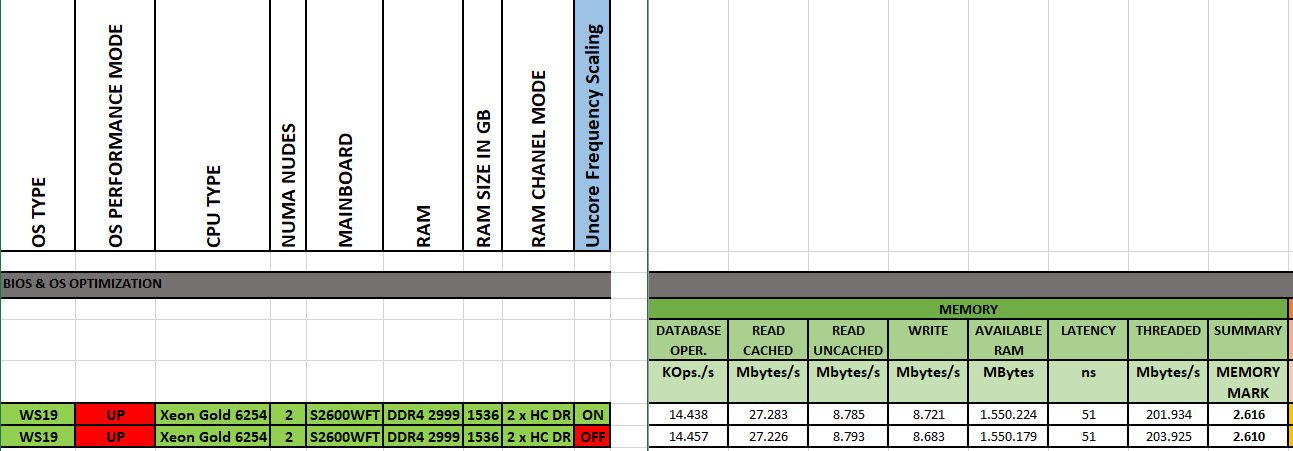

was mir eben aufgefallen ist, das deine Uncore-Frequenz ist sehr niedrig!

schau mal im Bios nach "Uncore Frequency" sollte auf Dynamic stehen! bzw. Uncore Frequency Scaling = Disabled!

jegliches Power Management sollte "disabled" sein, besonders der "CPU Interconnect Bus Link"

CPU Performance auf MAX....

Beste Grüsse aus BaWü

Alex

Zitat von @MysticFoxDE:

Moin Frank,

Ich hatte es schon optimiert gehabt. Leider hat das an dem besagten Problem nichts verändert.

Um zu prüfen, ob ich mir mit den vorherigen Optimierungen nicht leicht selbst ins Knie geschossen habe, habe ich das BIOS daher testweise wieder auf default gestellt. Stand jetzt ist nur das PerformanceProfile im BIOS auf Performance gestellt und das OS läuft auf "Ultimative Leistung".

ich denke da muss mehr gemacht werden, ich hatte ja geschrieben worauf du achten sollst!Moin Frank,

Doch, vor allem das BIOS mit seinen fragwürdigen Standardeinstellungen, ist mir momentan quasi das grösste Dorn im Auge.

hm...ich hatte gestern ja schon mein verdacht auf das Bios sinniert!

ich bin natürlich davon ausgegangen, das du das Bios Optimiert hast, und dein Blech nicht mit Standard einstellungen rennt!

ich bin natürlich davon ausgegangen, das du das Bios Optimiert hast, und dein Blech nicht mit Standard einstellungen rennt!

Ich hatte es schon optimiert gehabt. Leider hat das an dem besagten Problem nichts verändert.

Um zu prüfen, ob ich mir mit den vorherigen Optimierungen nicht leicht selbst ins Knie geschossen habe, habe ich das BIOS daher testweise wieder auf default gestellt. Stand jetzt ist nur das PerformanceProfile im BIOS auf Performance gestellt und das OS läuft auf "Ultimative Leistung".

nüchtern betrachtet (also nur mit restalkohol) denke ich das deine Bleche nur auf 50% laufen!

Die CPU bring schon die volle Leistung, nur die RAM-Performance ist beim Singlethreading alles andere als zufriedenstellend.was mir eben aufgefallen ist, das deine Uncore-Frequenz ist sehr niedrig!

schau mal im Bios nach "Uncore Frequency" sollte auf Dynamic stehen! bzw. Uncore Frequency Scaling = Disabled!

jegliches Power Management sollte "disabled" sein, besonders der "CPU Interconnect Bus Link"

CPU Performance auf MAX....

schau mal im Bios nach "Uncore Frequency" sollte auf Dynamic stehen! bzw. Uncore Frequency Scaling = Disabled!

jegliches Power Management sollte "disabled" sein, besonders der "CPU Interconnect Bus Link"

CPU Performance auf MAX....

deine Uncore-Frequenz ist viel zu langsam, da sollte meines wissens 2999 stehen!

das system läuft asynchron!

Genau die Dinge wollte ich gestern eigentlich Schritt für Schritt durchgehen, wurde aber durch mehrere Personen auf Chaneling Abwege gebracht. 🙃

Ist aber nicht so wild, es stand eh schon lange auf der ToDo Liste, der RAM Performance eines Servers, unter unterschiedlichen Chanelbelegungen mal etwas genauer auf den Zahn zu füllen und nicht nur der Theorie zu vertrauen und seit gestern ist dieser Punkt nun erledigt. 😀

Beste Grüsse aus BaWü

Alex

Frank

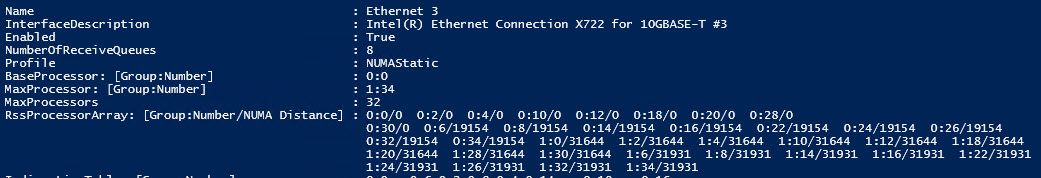

Das ist relativ sicher das Problem und das Stichwort zum Nachlesen was das genau ist etc. lautet

NUMA = Non Uniform Memory Access

de.wikipedia.org/wiki/Non-Uniform_Memory_Access

Die Hälfte des RAMs hängt an jeweils einer CPU, die andere kann zwar darauf zugreifen, aber das ist langsam(er).

Wenn die Applikation nicht NUMA Aware ist, dann passiert sowas halt.

Und bei solchen Benchmarkprogrammen wage ich zu bezweifeln, daß die Entwickler an 1,5 TB Maschinen mit NUMA auch nur gedacht haben, die werden meistens ja nur für overclocked Gaming PCs verwendet.

NUMA = Non Uniform Memory Access

de.wikipedia.org/wiki/Non-Uniform_Memory_Access

Die Hälfte des RAMs hängt an jeweils einer CPU, die andere kann zwar darauf zugreifen, aber das ist langsam(er).

Wenn die Applikation nicht NUMA Aware ist, dann passiert sowas halt.

Und bei solchen Benchmarkprogrammen wage ich zu bezweifeln, daß die Entwickler an 1,5 TB Maschinen mit NUMA auch nur gedacht haben, die werden meistens ja nur für overclocked Gaming PCs verwendet.

Moin,

hast du schon geprüft, wie die Cores im Vergleich takten und welche Spannung anliegt, wenn Hardware P-States off sind? Welcher "Default"-State greift dann überhaupt (P0?).

Das ist alles irgendwo Teil der Intel Speedstep Geschichte und wird doch munter (d.h. sehr schnell und oft) zwischen Hardware und Software ausgehandelt - macht das eventuell keinen Sinn, dies "einseitig" zu deaktivieren und muss dafür was auf OS-Ebene getan werden?

Gibt es noch andere ACPI-Schalter, die hier zu setzen sind?

Echt interessant, was da gerade passiert.

hast du schon geprüft, wie die Cores im Vergleich takten und welche Spannung anliegt, wenn Hardware P-States off sind? Welcher "Default"-State greift dann überhaupt (P0?).

Das ist alles irgendwo Teil der Intel Speedstep Geschichte und wird doch munter (d.h. sehr schnell und oft) zwischen Hardware und Software ausgehandelt - macht das eventuell keinen Sinn, dies "einseitig" zu deaktivieren und muss dafür was auf OS-Ebene getan werden?

Gibt es noch andere ACPI-Schalter, die hier zu setzen sind?

Echt interessant, was da gerade passiert.

Zitat von @MysticFoxDE:

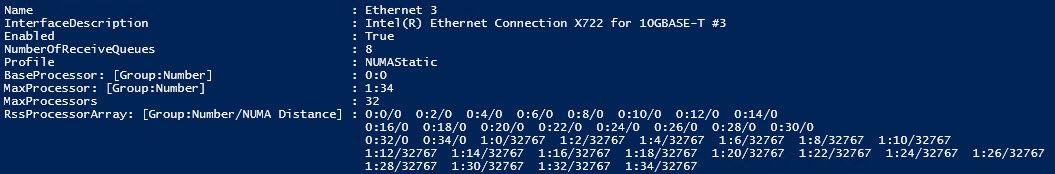

Diese negative Performanceanomalie kam dadurch zustande, das ich im BIOS zwar die P-States deaktiviert/optimiert habe, aber nicht gleichzeitig auch das C-State Handling. Das C-State Handling erlaubte dem OS weiterhin sich zwischen C0 und C6(Retention) auszutoben. So wie es aussieht, tut der Server 2019 (und eventuell auch W10, da gleiches Powermanagement) wohl die C-States nicht korrekt ansteuern, sobald die P-States per BIOS deaktiviert wurden.

Diese negative Performanceanomalie kam dadurch zustande, das ich im BIOS zwar die P-States deaktiviert/optimiert habe, aber nicht gleichzeitig auch das C-State Handling. Das C-State Handling erlaubte dem OS weiterhin sich zwischen C0 und C6(Retention) auszutoben. So wie es aussieht, tut der Server 2019 (und eventuell auch W10, da gleiches Powermanagement) wohl die C-States nicht korrekt ansteuern, sobald die P-States per BIOS deaktiviert wurden.

Genaugennommen als durch falsche Rumfummelei.

Aber Du hättest in der Eröffnungsfrage wenigstens dazusagen können, welche rumfummeleien Du gemacht hast und was die Werte in den Defaulteinstellungen gewesen wären geworden sein.

Dann hätten wir nicht darüber philosophoieren müssen, was denn nun die Kristallkugel sagen würden.

Aber gut, wenn Du Du das rausgefunden hast. Hilft uns vielleicht bei der nächsten Serverinstallation.

lks

Zitat von @MysticFoxDE:

Ich habe dann als nächstes, das C-State Handling dem OS ebenfalls entzogen und die möglichen C-States noch zusätzlich mit nur „C0/C1“ vorgegeben und schwups wwar die Performance auch wieder da, sogar noch eine kleine Schippe besser. 😁

Beste Grüsse aus BaWü

Alex

ist dein Problem jetzt behoben?

wie hoch ist jetzt deine Uncore-Frequenz?

Frank

Moin..

ich hab dir ja gesagt, das deine Uncore-Frequenz zu niedrig ist.... ist sie aber immernoch, da ist noch luft nach oben!

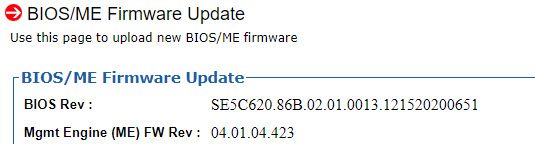

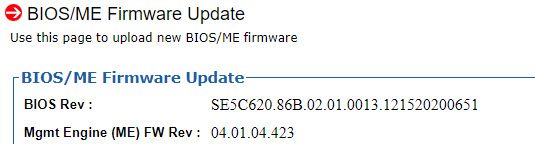

ich habe 8 stück R2208WFTZSR bei einem Kunden, die laufen alle auf 2999....

was ich nicht verstehe, wir haben im Bios nicht wie du die C & P State geändert! welche BIOS- und Firmware version nutzt du?

und welchen speicher hast du genau verbaut?

Frank

ich hab dir ja gesagt, das deine Uncore-Frequenz zu niedrig ist.... ist sie aber immernoch, da ist noch luft nach oben!

Uncore-Frequenz sollte auf 2999 stehen, und auf deine SPD werte warte ich noch 😁

ich habe 8 stück R2208WFTZSR bei einem Kunden, die laufen alle auf 2999....

was ich nicht verstehe, wir haben im Bios nicht wie du die C & P State geändert! welche BIOS- und Firmware version nutzt du?

und welchen speicher hast du genau verbaut?

Frank

Zitat von @MysticFoxDE:

Moin Frank,

das Abschalten von "Uncore Frequency Scaling" hatte absolut keine Performancerelevante Auswirkung.

Hat mich ehrlich gesagt selbst etwas erstaunt.

Beste Grüsse aus BaWü

Alex

auf deine Bios version bin ich gespannt....Moin Frank,

wie hoch ist jetzt deine Uncore-Frequenz?

das Abschalten von "Uncore Frequency Scaling" hatte absolut keine Performancerelevante Auswirkung.

Hat mich ehrlich gesagt selbst etwas erstaunt.

Beste Grüsse aus BaWü

Alex

leider kann / darf ich an keins der System ran, aber am WE steht neine Wartung an

Frank

moin...

und da warte ich noch

Mal unabhängig von 2999 oder 2666 mit ~2393 ist diese dennoch nicht ganz korrekt. 🤔

sach ich doch 🤭

Die sind dann aber auch nicht mit RAM vollgepackt.

nee sind se nicht, stimmt!

HYNIX HMAA8GL7CPR4N-WM

ok... danke für die Info

Beste Grüsse aus BaWü

Alex

Grüße aus Duisburg

Frank

Zitat von @MysticFoxDE:

Moin,

aber nicht wenn das Board mit 24 Riegeln bestückt ist, dann gehen bei dieser CPU und auch anderen max. nur noch 2666.

stimmt... habe ich nicht bedacht Moin,

ich hab dir ja gesagt, das deine Uncore-Frequenz zu niedrig ist.... ist sie aber immernoch, da ist noch luft nach oben!

aber nicht wenn das Board mit 24 Riegeln bestückt ist, dann gehen bei dieser CPU und auch anderen max. nur noch 2666.

Uncore-Frequenz sollte auf 2999 stehen, und auf deine SPD werte warte ich noch 😁

Mal unabhängig von 2999 oder 2666 mit ~2393 ist diese dennoch nicht ganz korrekt. 🤔

ich habe 8 stück R2208WFTZSR bei einem Kunden, die laufen alle auf 2999....

Die sind dann aber auch nicht mit RAM vollgepackt.

was ich nicht verstehe, wir haben im Bios nicht wie du die C & P State geändert! welche BIOS- und Firmware version nutzt du?

Neuste die verfügbar ist.

und welchen speicher hast du genau verbaut?

HYNIX HMAA8GL7CPR4N-WM

Beste Grüsse aus BaWü

Alex

Frank

Zitat von @MysticFoxDE:

@ Intel

Ist es als einer der weltgrössten IT-Konzerne wirklich so schwer, simple Plausis in die BIOS-Konfiguration mit einzubauen? 🤨

Moin,@ Intel

Ist es als einer der weltgrössten IT-Konzerne wirklich so schwer, simple Plausis in die BIOS-Konfiguration mit einzubauen? 🤨

schwer nicht, aber das Interesse fehlt.

Deren primären Vorgaben sind (in dieser Reihenfolge):

- Stabiles System

- Stabiles System (wirklich stabil)

- Wenig Support-Anfrage

- Leise (Bei 19" sind Leise und Schnell vertauscht)

- Schnell

Es rufen vermutlich wenige Kunden an weil der Server zu langsam ist, weil die meisten das gar nicht mitbekommen.

Server zu langsam? Dann kauf doch das nächst größere Modell oder noch 2-3 Server mehr. fertig.

Das was Du da machst ist vermutlich die Außnahme.

Sowohl von Deiner Qualifikation als auch der Hartnäckigkeit.

Stefan

Zitat von @StefanKittel:

Es rufen vermutlich wenige Kunden an weil der Server zu langsam ist, weil die meisten das gar nicht mitbekommen.

Server zu langsam? Dann kauf doch das nächst größere Modell oder noch 2-3 Server mehr. fertig.

Das was Du da machst ist vermutlich die Außnahme.

Sowohl von Deiner Qualifikation als auch der Hartnäckigkeit.

Stefan

Server zu langsam? Dann kauf doch das nächst größere Modell oder noch 2-3 Server mehr. fertig.

Das was Du da machst ist vermutlich die Außnahme.

Sowohl von Deiner Qualifikation als auch der Hartnäckigkeit.

Stefan

Es sollte aber die Regel sein!

Wenn in der Kette über Planung, Hardwarebeschaffung, Softwarespezifikation und Monitoring nur eine Nase sitzt (und die sitzt garantiert irgendwo), stimmt die Leistung wieder nicht und kompensiert wird das dann über zeitintensives gefuddel.

Von den vielen kleinen Unternehmen, die ein, zwei Server über Dell & co. zusammengeklickt haben ganz zu schweigen.

Man muss nicht um jedes Prozent kämpfen, aber ich habe häufig gesehen, dass Kunden einen sehr hohen Leidensdruck haben und gar nicht wissen, dass ein Großteil an Performance auf der Strecke bleibt, weil nicht richtig geplant, beschafft, konfiguriert und gemessen wird.

Das fällt in größeren Umgebungen sicherlich nicht so auf oder interessiert keinen, dabei ist das Optimierungspotential enorm.

Gruß

Grinskeks

Moin,

Ich befürchte du hast mich teilweise falsch verstanden.

Gute Performance ist essentiell und wir brauchen mehr Leute die das im Blick haben.

Ich halte es für etabliert, dass ein Server nichtoptimiert beim Kunden ankommt und viele ihn 1:1 so nutzen. Etwaige Beratungen der Lieferanten haben oft technisch kein hohes Niveau.

Die Standardkonfigs sind meist sehr defensiv ausgelegt, was ich aus Herstellersicht nachvollziehen kann.

Zudem werden bei der Beschaffung oft Fehler gemacht, weil das Know how fehlt.

Das du dir Gedanken machst, das System optimal konfigurierst und dann auch misst

sollte die Regel sein. Jeder sollte das tun.

Mitunter Schuld an der Misere sind auch Systemvorraussetzungen, die oft allgemeiner nicht sein könnten: Cores, Takt, RAM, VRam, Speicherplatz. Oftmals zu gering angegeben und höchst unspezifisch.

Gruß

Grinskeks

Ich befürchte du hast mich teilweise falsch verstanden.

Gute Performance ist essentiell und wir brauchen mehr Leute die das im Blick haben.

Ich halte es für etabliert, dass ein Server nichtoptimiert beim Kunden ankommt und viele ihn 1:1 so nutzen. Etwaige Beratungen der Lieferanten haben oft technisch kein hohes Niveau.

Die Standardkonfigs sind meist sehr defensiv ausgelegt, was ich aus Herstellersicht nachvollziehen kann.

Zudem werden bei der Beschaffung oft Fehler gemacht, weil das Know how fehlt.

Das du dir Gedanken machst, das System optimal konfigurierst und dann auch misst

sollte die Regel sein. Jeder sollte das tun.

Mitunter Schuld an der Misere sind auch Systemvorraussetzungen, die oft allgemeiner nicht sein könnten: Cores, Takt, RAM, VRam, Speicherplatz. Oftmals zu gering angegeben und höchst unspezifisch.

Gruß

Grinskeks

Zitat von @MysticFoxDE:

Das sehe ich etwas anders. Es ist ja auch nicht die Regel, dass man nach einem Fahrzeugkauf sofort zum Leistungsstand fährt und erstmal prüft ob die Motorleistung auch genau dem entspricht, was man bestellt hat und was auch in den Fahrzeugpapieren angegeben ist. Und wenn es doch jemand mal genauer wissen möchten, dann muss er halt eben zu einem „Spezialisten“ und diese sauber vermessen lassen.

Das sehe ich etwas anders. Es ist ja auch nicht die Regel, dass man nach einem Fahrzeugkauf sofort zum Leistungsstand fährt und erstmal prüft ob die Motorleistung auch genau dem entspricht, was man bestellt hat und was auch in den Fahrzeugpapieren angegeben ist. Und wenn es doch jemand mal genauer wissen möchten, dann muss er halt eben zu einem „Spezialisten“ und diese sauber vermessen lassen.

Beim Autokauf ist es in der Regel auch weniger komplex, da ich mich für eine vordefinierte und vor allem standardisierte Leistung entscheide, die ein Komplettpaket darstellt. Vergleiche sind zudem einfacher, da es nennenswerte Stückzahlen mit gleicher Konfiguration gibt.

Auch hier ist das Steuergerät des Fahrzeugs nicht auf Performance ausgelegt - aber die angegebene Leistung ist zumindest erwartbar. Chiptuner holen trotzdem nochmal einiges raus (mehr Leistung, Drehmoment, geringerer Verbrauch etc.)

Richtig vergleichbar wäre es, wenn ich mir aus allen verfügbaren Chassis, Motoren, Turboladern, Getrieben etc. zusammenstelle, was optisch und technisch passt und dann erwarte, dass das Steuergerät schon dafür sorgt, dass alles optimal unterstützt wird.

Ich gebe dir Recht - die Hersteller sind in der Pflicht, es besser zu machen. Etablierte und standardisierte Messmethoden und Vorgaben würde es einfacher machen. Leider reichen PS, Drehmoment(kurve), VMax und Bremsweg nicht aus und es gibt keinen, der das regulieren kann / möchte.

Gruß

Grinskeks

Zitat von @MysticFoxDE:

Die Standardkonfigs sind meist sehr defensiv ausgelegt, was ich aus Herstellersicht nachvollziehen kann.

Ich nicht. Es gibt schon Performanceprofile im BIOS und diese habe ich überall auf „Performance“ gestellt und dennoch bekomme ich keine. 😡Ich schon,

ich ahne folgendes, was bei solchen Anbietern eigentlich nicht auftreten dürfte.

Der Server wird optimal konstruiert und die erste Serie gefertigt.

Dann findet Jemand einen Bug und liefert eine Umgehung des Bugs.

Vieleicht sagt nun ein versierter Techniker: Das wird auswirkungen auf die Performance haben.

Das müssen wir testen, dokumentieren und schauen wie wir den Bug besser beheben können.

Antwort Abteilungsleiter Technik: Ne, dass Ding steht ja schon beim Kunden. Ich brauche jetzt ASAP sofort einen Fix den wir noch schnell in mit einem BIOS-Update reinhauen können.

Techniker: Dann müssen wir das aber zumindest dokumentieren und in den BIOS-Profilen anpassen damit die Leute damit umgehen können.

Antwort Abteilungsleiter Technik: Ne, das würde ein schlechtes Licht auf uns werfen. Das bekommt schon keiner mit.

Ende der Fahnenstange...

Wenn solche technischen Problem aktuell vorhanden sind, wie konnten die damals zum Mond fliegen? Nur mit Lötkolben, 2-3 Chips und Tape?

Moin...

ich kann da nix großartig ändern, wenn müssen alle System in abprache mit dem Pax Hersteller aktualisiert werden.

dazu gehören aber auch Labor Tests, mit das system später auch so rennt, wie es soll!

ich habe gestern aber mal den speed gemessen, ich bin etwa 20 % schneller als dein system unter server 2019 datacenter!

unter Linux ist es erwartungsgemäß sogar über 30 % Schneller!

was aber auch am höheren speicher takt liegt!

ich hoffe das ich kurzfristig noch Systeme nachbekomme, dann werde ich bei uns im labor selber mal Testen.

ich bin überzeugt, das die aktuelle Bios version buggy ist, was ja nich das erste mal wäre... oder das system ist falsch aktualisiert worden... da gibbet abhängigkeiten, die würden schon dein verhalten erklären! das haben wir schon alles durch.

Frank

Zitat von @MysticFoxDE:

Moin Frank,

ich habe jetzt keine Zeit um alle Feinheiten zu erklären, muss noch meine Hausdrachen füttern.

Wenn du an die Server ran gehst, dann schalte doch testweise auch mal den 3StrikeTimer aus,

ich habe heute den halben Tag bez. der Timer getestet und dieser Spuckt bei den Performancethema und Server 2019 auch gewaltig in die Suppe.

Ob es an der HW oder an Windows liegt weis ich noch nicht.

Sowohl Microsoft hat beim Kernel 1809 am Timing rumgefummelt als auch Intel bei den neuen XEONS. 🤢

Siehst du auf deinen Servern noch einen HPET Timer?

Oh oh, die Hausdrachen laufen schon fauchen durch die Gegend, ich muss. 😜

Beste Grüsse aus BaWü

Alex

also ich habe auf allen 6 Systemen die Bios/Firmwarer Version 02.01.0010.Moin Frank,

leider kann / darf ich an keins der System ran, aber am WE steht neine Wartung an

ich habe jetzt keine Zeit um alle Feinheiten zu erklären, muss noch meine Hausdrachen füttern.

Wenn du an die Server ran gehst, dann schalte doch testweise auch mal den 3StrikeTimer aus,

ich habe heute den halben Tag bez. der Timer getestet und dieser Spuckt bei den Performancethema und Server 2019 auch gewaltig in die Suppe.

Ob es an der HW oder an Windows liegt weis ich noch nicht.

Sowohl Microsoft hat beim Kernel 1809 am Timing rumgefummelt als auch Intel bei den neuen XEONS. 🤢

Siehst du auf deinen Servern noch einen HPET Timer?

Oh oh, die Hausdrachen laufen schon fauchen durch die Gegend, ich muss. 😜

Beste Grüsse aus BaWü

Alex

ich kann da nix großartig ändern, wenn müssen alle System in abprache mit dem Pax Hersteller aktualisiert werden.

dazu gehören aber auch Labor Tests, mit das system später auch so rennt, wie es soll!

ich habe gestern aber mal den speed gemessen, ich bin etwa 20 % schneller als dein system unter server 2019 datacenter!

unter Linux ist es erwartungsgemäß sogar über 30 % Schneller!

was aber auch am höheren speicher takt liegt!

ich hoffe das ich kurzfristig noch Systeme nachbekomme, dann werde ich bei uns im labor selber mal Testen.

ich bin überzeugt, das die aktuelle Bios version buggy ist, was ja nich das erste mal wäre... oder das system ist falsch aktualisiert worden... da gibbet abhängigkeiten, die würden schon dein verhalten erklären! das haben wir schon alles durch.

Frank

Zitat von @MysticFoxDE:

Moin Frank,

herzlichen Dank für die Rückinfo.

was genau ist schneller, der RAM?

ja...auch!Moin Frank,

herzlichen Dank für die Rückinfo.

ich habe gestern aber mal den speed gemessen, ich bin etwa 20 % schneller als dein system unter server 2019 datacenter!

unter Linux ist es erwartungsgemäß sogar über 30 % Schneller!

was aber auch am höheren speicher takt liegt!

unter Linux ist es erwartungsgemäß sogar über 30 % Schneller!

was aber auch am höheren speicher takt liegt!

was genau ist schneller, der RAM?

Wenn ja, gegen welchen Wert bezieht sich deine Aussage, gegen meine anfänglichen ~ 5.500 MB/s?

nein...das die beiden Linux Server bei gleicher Hardwarekonfiguration schneller sind als die windows bleche!

SQL trennt welten, und das nicht nur gefühlt!

alle Systeme haben die gleichen Bios Revisionen, gleiche einstellungen und natürlich gleiche Hardware!

wir haben wochenlang mit dem PAX Hersteller getestet, bis ein Setup festgelegt wurde!

ich werde nächste woche mal mit dem Kunden reden, ob ich Messergebnise als screenshot mitnehmen darf!

du verstehst sicher, das mir da der datenschutz im nacken sitzt, und das ich jegliches Bildmaterial absegnen lassen muss!

Frank

Beste Grüsse aus Murrhardt

Alex

Zitat von @MysticFoxDE:

Moin Frank,

kleiner Nachtrag.

ich beobachte den Performanceverlust über diverse Systeme hinweg schon etwas länger und auch auf der Vorgängerserie ist dieser, nach der Installation eines Server 2019, auch bereits extrem aufgetreten.

das sehe ich auch so, mitlerweile finde ich die gesamtleistung von Hyper-V 2019 grenzwertig, sowie als Server OS!Moin Frank,

kleiner Nachtrag.

ich bin überzeugt, das die aktuelle Bios version buggy ist, was ja nich das erste mal wäre...

ich beobachte den Performanceverlust über diverse Systeme hinweg schon etwas länger und auch auf der Vorgängerserie ist dieser, nach der Installation eines Server 2019, auch bereits extrem aufgetreten.

wenn SQL im Spiel ist, wird es echt zum Drama... incl. Netzwerk...

oder das system ist falsch aktualisiert worden...

Ich habe das aktuelle Testsystem schon mehrfach geprüft, die BIOS'e wurde so wie es aussieht überall sauber aktualisiert.

Habe auch schon mehrfacht auf Werkseinstellung gesetzt und mittlerweile so gut wie alle CPU und RAM Parameter einzeln durchgetestet. 😩

da gibbet abhängigkeiten, die würden schon dein verhalten erklären!

Ein paar habe ich auch schon gefunden die suboptimal Eingestellt waren, um das durchzukauen mache ich aber einen neuen Post auf. Das würde den jetzigen, von dem eigentlichen RAM Thema, zu sehr ablenken.

Gruss Alex

Zitat von @MysticFoxDE:

Moin Frank,

wenn SQL im Spiel ist, wird es echt zum Drama... incl. Netzwerk...

Das liegt aber nicht an dem SQL, der ist schon seit Jahren top.

Nach all dem was ich die letzten beiden Jahre gesehen und auch analysiert habe, geht die Performance schon beim System baden und nicht erst durch den SQL, sondern mit

nicht wegen SQL, sondern wenn du daMoin Frank,

ich beobachte den Performanceverlust über diverse Systeme hinweg schon etwas länger und auch auf der Vorgängerserie ist dieser, nach der Installation eines Server 2019, auch bereits extrem aufgetreten.

das sehe ich auch so, mitlerweile finde ich die gesamtleistung von Hyper-V 2019 grenzwertig, sowie als Server OS!wenn SQL im Spiel ist, wird es echt zum Drama... incl. Netzwerk...

Das liegt aber nicht an dem SQL, der ist schon seit Jahren top.

Nach all dem was ich die letzten beiden Jahre gesehen und auch analysiert habe, geht die Performance schon beim System baden und nicht erst durch den SQL, sondern mit

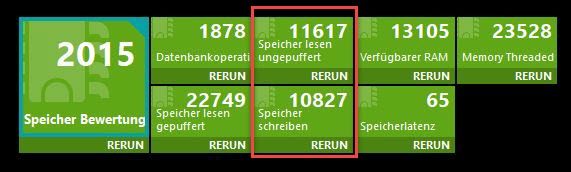

Wenn die RAM Performance, das Timing Handling und auch die Netzwerkkonfiguration des OS nicht i.O. sind, dann kannst du vom SQL selbst auch keine Leistung erwarten.

Warum zur Hölle wird per default auf so gut wie jeder NIC auf diesem Planeten RSC und LSO aktiviert, obwohl es für die meisten Anwendungsgebiete und auch SQL oder Oracle DB Server und auch deren Clients, ein absolutes Gift ist. 😡

jo, das stimmt..Warum zur Hölle wird per default auf so gut wie jeder NIC auf diesem Planeten RSC und LSO aktiviert, obwohl es für die meisten Anwendungsgebiete und auch SQL oder Oracle DB Server und auch deren Clients, ein absolutes Gift ist. 😡

oder das system ist falsch aktualisiert worden...

Ich habe das aktuelle Testsystem schon mehrfach geprüft, die BIOS'e wurde so wie es aussieht überall sauber aktualisiert.

Habe auch schon mehrfacht auf Werkseinstellung gesetzt und mittlerweile so gut wie alle CPU und RAM Parameter einzeln durchgetestet. 😩

Nur das wir hier vom selben Reden, ich meinte die Reihenfolge in der die ROM’s des Mainboards aktualisiert werden (System ROM --> ME --> BMC --> FRUSDR).

Oder was hast du gemeint?

da gibbet abhängigkeiten, die würden schon dein verhalten erklären!

Ein paar habe ich auch schon gefunden die suboptimal Eingestellt waren, um das durchzukauen mache ich aber einen neuen Post auf. Das würde den jetzigen, von dem eigentlichen RAM Thema, zu sehr ablenken.

Habe ja auch gerade drei Tupfer gleiche Server im Rücken, die ich noch die nächsten zwei Wochen nach Lust und Laune quellen kann. 😁

Gruss Alex

Frank