RDMA mit Nexus 5548up

Hallo allerseits.

Ich habe mal wieder ein Problem.

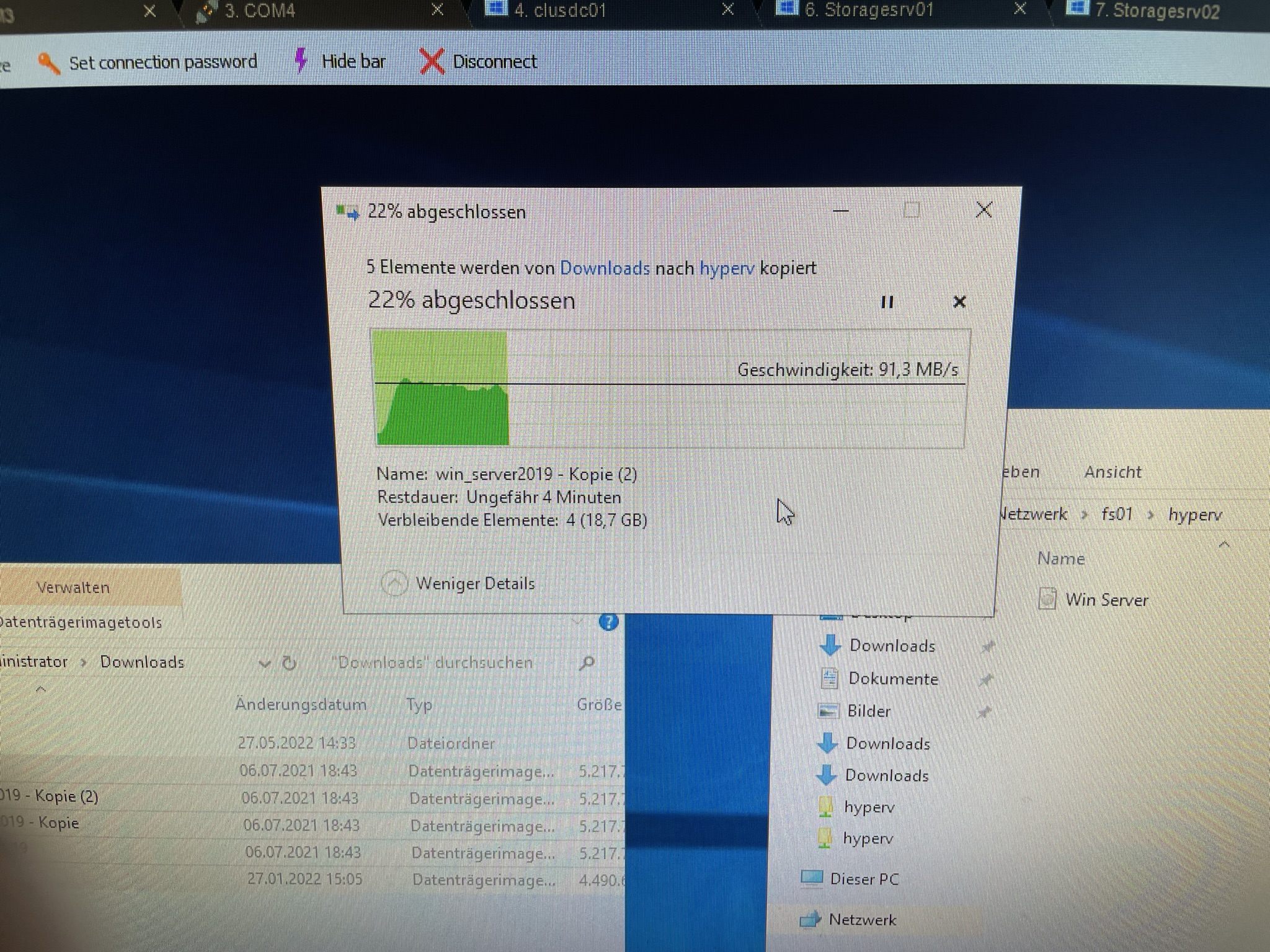

Richte eben mein HyperV CLuster ein.

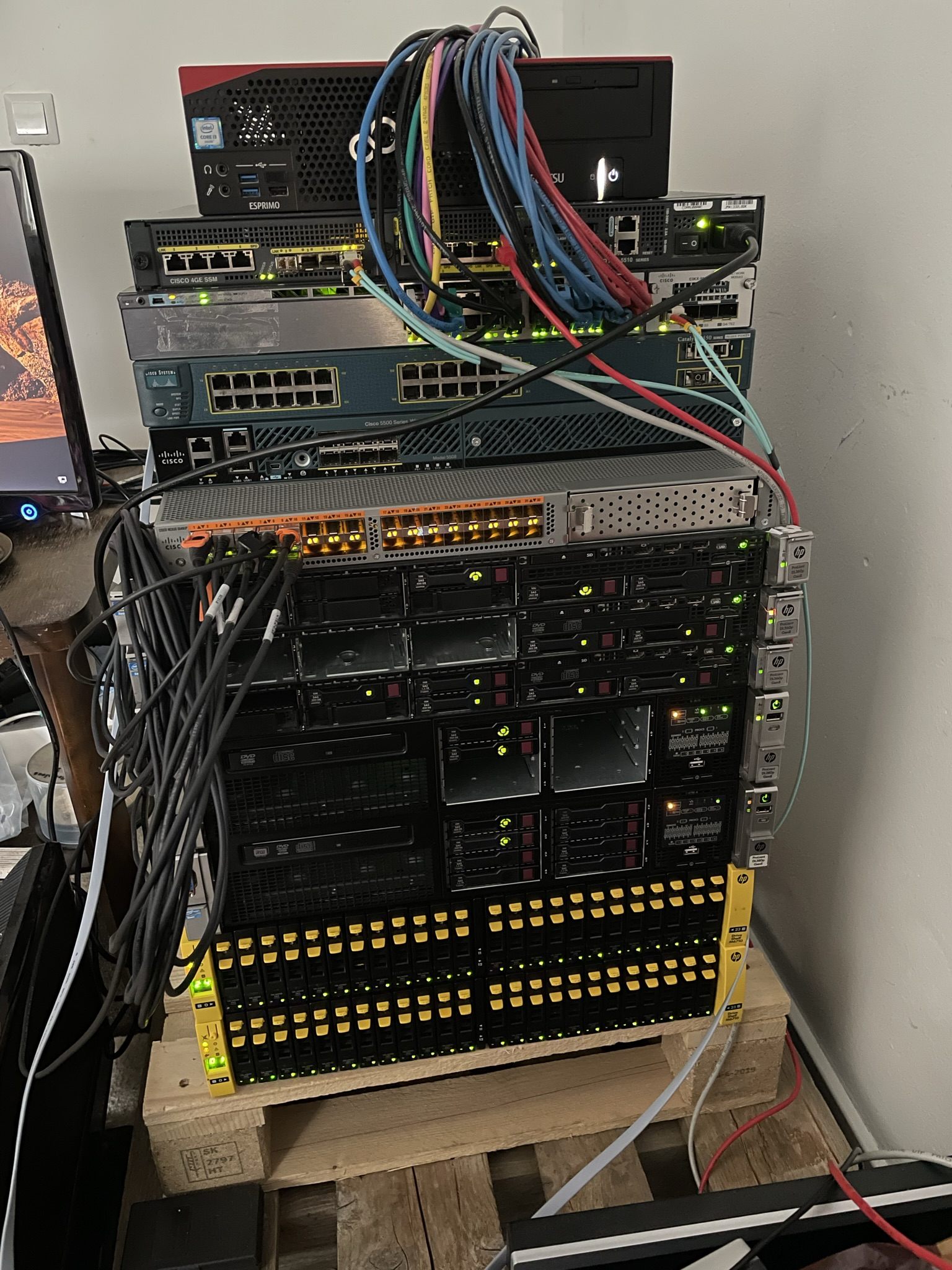

Cluster besteht aus: 3 HP DL360p G8 mit je 2 Intel Xeon 2660 V2 10 Core und 64GB RAM

Jeder Server hat eine Mellanox ConnectX3 Dual 10Gbit Netywerkkarte verbaut und eine zweite 10Gbit Dual Karte(Die kann aber kein RDMA)

Angeschloßen ist dieses 10Gbit Netzwerk(ConnectX3 Karten) an einen Cisco Nexus 5548up Switch.

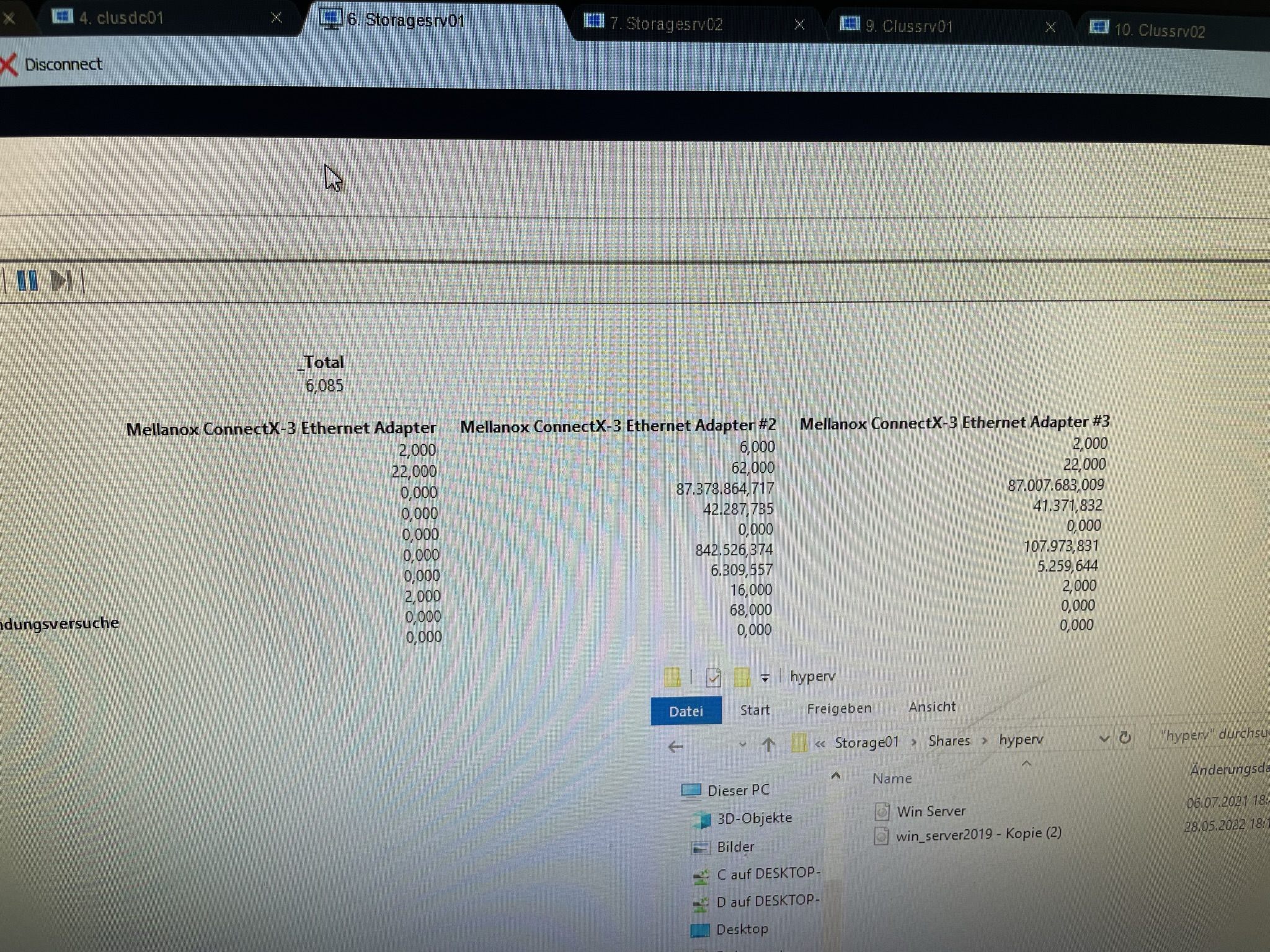

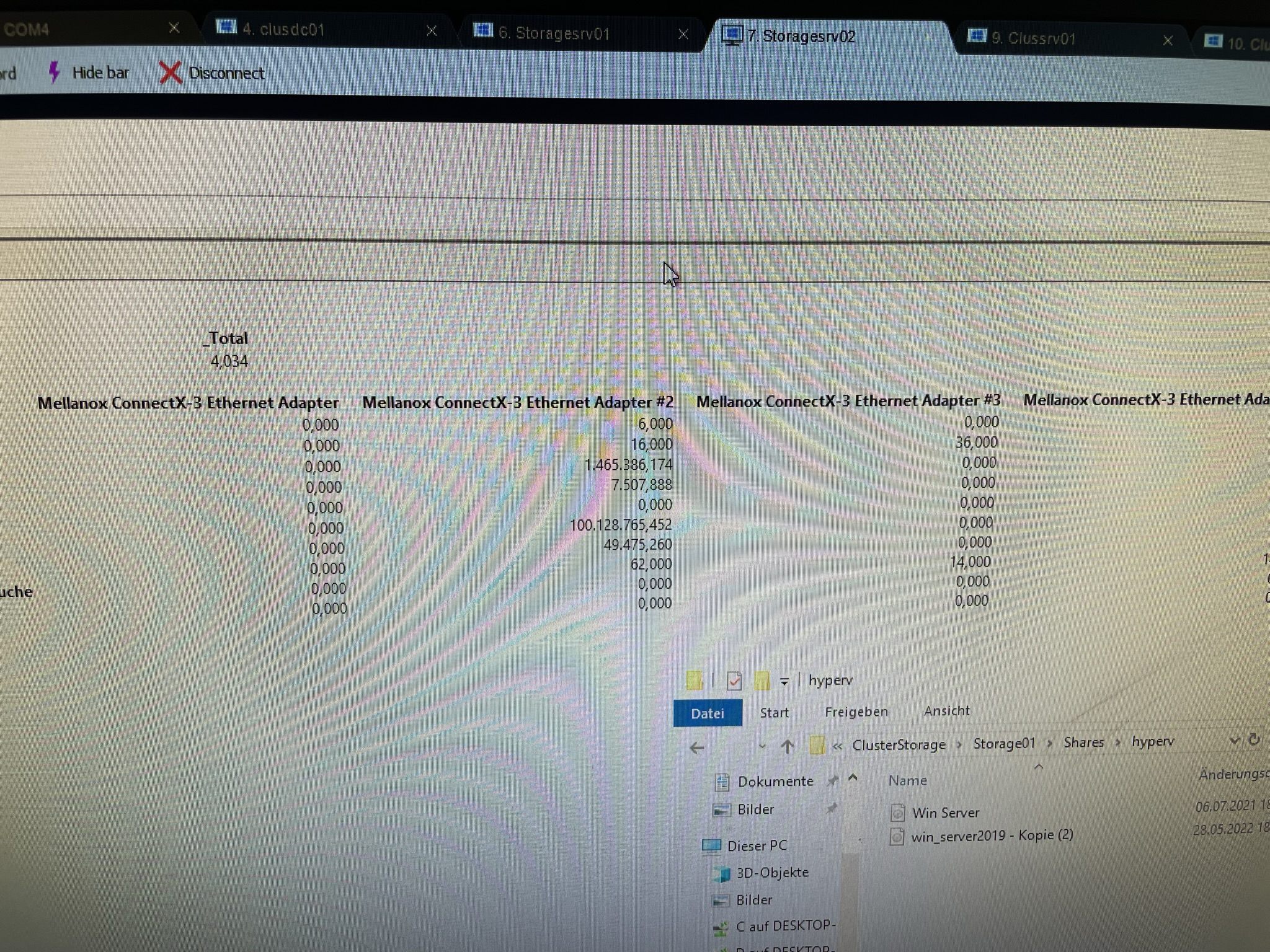

Verbinde ich 2 Server direkt mit Twinax-Kabeln, wird mir RDMA Traffic im perfmon korrekt angezeigt.

Also Windowsseitig alles richtig konfiguriert.

Nur über den Switch kommt kein RDMA Traffic zustande.

Hier mal die COnfig vom Switch:

Ohne Switch, direkt angeschlossen geht RDMA traffic, am Switch nicht.

Hab ich den Switch falsch konfiguriert?

Könnte mir bitte jemand bei der Konfiguration behilflich sein?

Ich habe mal wieder ein Problem.

Richte eben mein HyperV CLuster ein.

Cluster besteht aus: 3 HP DL360p G8 mit je 2 Intel Xeon 2660 V2 10 Core und 64GB RAM

Jeder Server hat eine Mellanox ConnectX3 Dual 10Gbit Netywerkkarte verbaut und eine zweite 10Gbit Dual Karte(Die kann aber kein RDMA)

Angeschloßen ist dieses 10Gbit Netzwerk(ConnectX3 Karten) an einen Cisco Nexus 5548up Switch.

Verbinde ich 2 Server direkt mit Twinax-Kabeln, wird mir RDMA Traffic im perfmon korrekt angezeigt.

Also Windowsseitig alles richtig konfiguriert.

Nur über den Switch kommt kein RDMA Traffic zustande.

Hier mal die COnfig vom Switch:

Nexus5K(config)# sh run

!Command: show running-config

!Time: Thu May 26 14:33:49 2022

version 5.0(3)N2(2b)

no feature telnet

no telnet server enable

feature lldp

username admin password 5 $1$BooxXhUp$ffgxsJ6J3PX02R1GDLtgO. role network-admin

no password strength-check

ssh key rsa 2048

ip domain-lookup

switchname Nexus5K

class-map type qos class-fcoe

class-map type qos match-all roce

match cos 5

class-map type queuing roce

match qos-group 5

class-map type queuing class-fcoe

match qos-group 1

class-map type queuing class-all-flood

match qos-group 2

class-map type queuing class-ip-multicast

match qos-group 2

policy-map type qos roce

class roce

set qos-group 5

class class-fcoe

set qos-group 1

policy-map type queuing roce

class type queuing roce

bandwidth percent 70

class type queuing class-fcoe

bandwidth percent 20

class type queuing class-default

bandwidth percent 10

class-map type network-qos roce

match qos-group 5

class-map type network-qos class-fcoe

match qos-group 1

class-map type network-qos class-all-flood

match qos-group 2

class-map type network-qos class-ip-multicast

match qos-group 2

policy-map type network-qos roce

class type network-qos roce

pause no-drop

mtu 9000

class type network-qos class-fcoe

pause no-drop

mtu 2158

class type network-qos class-default

mtu 9216

multicast-optimize

system qos

service-policy type qos input roce

service-policy type queuing input roce

service-policy type queuing output roce

service-policy type network-qos roce

snmp-server user admin network-admin auth md5 0xdf70cfdc76ddb562a87e519c32757594

priv 0xdf70cfdc76ddb562a87e519c32757594 localizedkey

rmon event 1 log description FATAL(1) owner PMON@FATAL

rmon event 2 log description CRITICAL(2) owner PMON@CRITICAL

rmon event 3 log description ERROR(3) owner PMON@ERROR

rmon event 4 log description WARNING(4) owner PMON@WARNING

rmon event 5 log description INFORMATION(5) owner PMON@INFO

snmp-server community Nexus group network-operator

vrf context management

vlan 1

vlan 200

name Stotage1

vlan 300

name Storage2

interface Ethernet1/1

priority-flow-control mode on

switchport access vlan 200

interface Ethernet1/2

priority-flow-control mode on

switchport access vlan 300

interface Ethernet1/3

priority-flow-control mode on

switchport access vlan 200

interface Ethernet1/4

priority-flow-control mode on

switchport access vlan 300

interface Ethernet1/5

priority-flow-control mode on

switchport access vlan 200

interface Ethernet1/6

priority-flow-control mode on

switchport access vlan 300

interface Ethernet1/7

interface Ethernet1/8

interface Ethernet1/9

interface Ethernet1/10

interface Ethernet1/11

interface Ethernet1/12

interface Ethernet1/13

interface Ethernet1/14

interface Ethernet1/15

interface Ethernet1/16

interface Ethernet1/17

interface Ethernet1/18

interface Ethernet1/19

interface Ethernet1/20

interface Ethernet1/21

interface Ethernet1/22

interface Ethernet1/23

interface Ethernet1/24

interface Ethernet1/25

interface Ethernet1/26

interface Ethernet1/27

interface Ethernet1/28

interface Ethernet1/29

interface Ethernet1/30

interface Ethernet1/31

interface Ethernet1/32

interface mgmt0

vrf member management

line console

line vty

boot kickstart bootflash:/n5000-uk9-kickstart.5.0.3.N2.2b.bin

boot system bootflash:/n5000-uk9.5.0.3.N2.2b.bin

Nexus5K(config)#Ohne Switch, direkt angeschlossen geht RDMA traffic, am Switch nicht.

Hab ich den Switch falsch konfiguriert?

Könnte mir bitte jemand bei der Konfiguration behilflich sein?

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 2904534576

Url: https://administrator.de/forum/rdma-mit-nexus-5548up-2904534576.html

Ausgedruckt am: 16.07.2025 um 03:07 Uhr

10 Kommentare

Neuester Kommentar

Sieht auf'n ersten Blick gut aus. Es kann sein dass das Switch RDMA1 und 2 unterscheidet und diesbezüglich noch etwas Parameter will.

Ich bin kein Cisco Pro mehr seit 2014, daher müsste ich jetzt erst Whitepapers wälzen...

Aber was mir noch auffällt ist, dass ggf ein DCB Parameter pro Port fehlt. Auch könnte es an FCoE Parametern pro Port fehlen. Die Ports müssen ja wissen, dass sie mit den globalen Parametern was zu tun haben.

Ich denke du solltest dir die Ports 1-6 angucken. Da liegt der Hase im Pfeffer.

Aber was mir noch auffällt ist, dass ggf ein DCB Parameter pro Port fehlt. Auch könnte es an FCoE Parametern pro Port fehlen. Die Ports müssen ja wissen, dass sie mit den globalen Parametern was zu tun haben.

Ich denke du solltest dir die Ports 1-6 angucken. Da liegt der Hase im Pfeffer.

Es könnte noch mehr fehlen... Außerdem verstehe ich einen Satz so, dass du es Lizenz nötig ist/sein kann.

cisco.com/c/en/us/td/docs/switches/datacenter/nexus5000/sw/opera ...

cisco.com/c/en/us/td/docs/switches/datacenter/nexus5000/sw/opera ...

IOMeter und 16 Wartenschlagen mit unterschiedlichen Blockgrößen usw... Oder noch mehr.

Ja, SSDs bringen auch bei 6GBit SAS etwas.

Ja, SSDs bringen auch bei 6GBit SAS etwas.

Du willst doch wissen, was blocktechnisch die Möhre kann! SAS hat, wenn Treiber, Os und Schnittstellen passen, einige Vorteile gegenüber SATA. Auch wenn SATA Platten im Shelf sind.

Die Warteschlangen sind hier "Worker" youtube.com/watch?v=qtwlKLVxwuw

Hier gängige IO Größen beim Benchmarken: img.raymond.cc/blog/wp-content/uploads/2008/02/atto_disk_benchma ...

Wenn du weißt, was deine Kiste roh kann, kannst Du dein Dateisystem ggf ändern, wenn Potential zur Optimierung hat.

Die Warteschlangen sind hier "Worker" youtube.com/watch?v=qtwlKLVxwuw

Hier gängige IO Größen beim Benchmarken: img.raymond.cc/blog/wp-content/uploads/2008/02/atto_disk_benchma ...

Wenn du weißt, was deine Kiste roh kann, kannst Du dein Dateisystem ggf ändern, wenn Potential zur Optimierung hat.