Thinkserver RD440 mit XenServer 6.2 (Schlechte IO Performance)

Hallo zusammen

vielleicht kann mir jemand bei einem Performanceproblem auf unserem neuen Thinkserver RD440 helfen. Die aktuelle Konfiguration die auch nach Citrix HCL kompatibel ist:

Thinkserver RD440

2 physical CPUs (each 12 cores)

64GB RAM

4 x 600GB SAS 15k disks RAID 5

4x 1TB SAS 7,2k disks RAID 5

1x Hardware RAID 500 Adapter II (LSI MegaRaid SAS 9240)

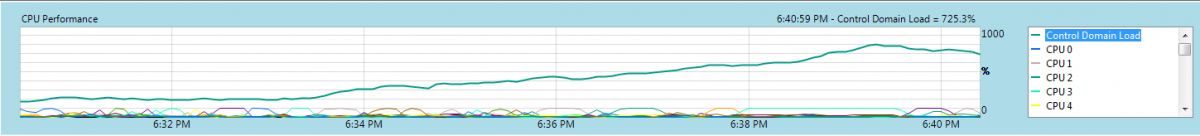

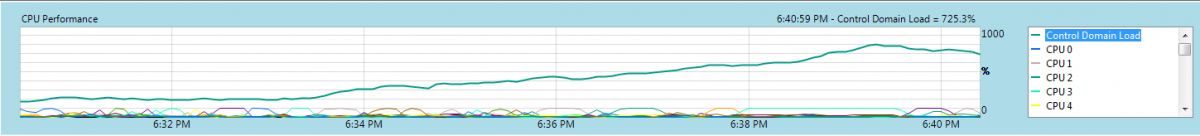

CPU Load:

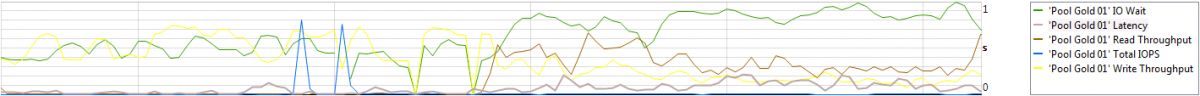

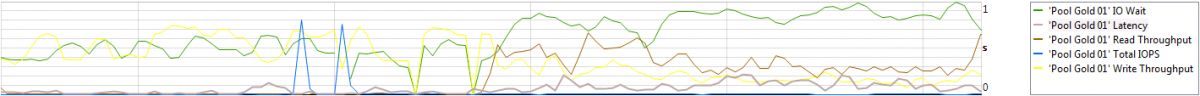

Disk Performance:

Aktuell haben wir eine extrem hohe Storage Latenz, was dazu führt, dass unsere VMs massiv langsam reagieren und teilweise sogar einfrieren. Unter Last liegt die Latenz zwischen 30 und 100ms auf den lokalen Platten!. Ich habe bereits versucht den Dom0 zu tunen, um hier ein Bottleneck auszuschließen. Aktuell ist der Dom0 mit 6 vCPUs non-pinnend und 4GB RAM konfiguriert. (support.citrix.com/servlet/KbServlet/download/33698-102-696928/x ..). Dies hat aber bisher noch zu keiner Verbesserung geführt. Nach Rücksprache mit Lenovo haben wir bereits den RAID Controller auf den aktuellen Firmwarestand gebracht und die Xen spezifischen Controller Treiber installiert.

Auffällig ist, dass der Prozess ksoftirqd unter Volllast im dom0 läuft und zwar immer dann, wenn Schreib und Leseoperationen auf der Festplatte ausgeführt werden.

Hat jemand eine Idee, wie wir hier weiter vorgehen können?

Danke vorab!

Gruß,

Fabian

vielleicht kann mir jemand bei einem Performanceproblem auf unserem neuen Thinkserver RD440 helfen. Die aktuelle Konfiguration die auch nach Citrix HCL kompatibel ist:

Thinkserver RD440

2 physical CPUs (each 12 cores)

64GB RAM

4 x 600GB SAS 15k disks RAID 5

4x 1TB SAS 7,2k disks RAID 5

1x Hardware RAID 500 Adapter II (LSI MegaRaid SAS 9240)

CPU Load:

Disk Performance:

Aktuell haben wir eine extrem hohe Storage Latenz, was dazu führt, dass unsere VMs massiv langsam reagieren und teilweise sogar einfrieren. Unter Last liegt die Latenz zwischen 30 und 100ms auf den lokalen Platten!. Ich habe bereits versucht den Dom0 zu tunen, um hier ein Bottleneck auszuschließen. Aktuell ist der Dom0 mit 6 vCPUs non-pinnend und 4GB RAM konfiguriert. (support.citrix.com/servlet/KbServlet/download/33698-102-696928/x ..). Dies hat aber bisher noch zu keiner Verbesserung geführt. Nach Rücksprache mit Lenovo haben wir bereits den RAID Controller auf den aktuellen Firmwarestand gebracht und die Xen spezifischen Controller Treiber installiert.

Auffällig ist, dass der Prozess ksoftirqd unter Volllast im dom0 läuft und zwar immer dann, wenn Schreib und Leseoperationen auf der Festplatte ausgeführt werden.

Hat jemand eine Idee, wie wir hier weiter vorgehen können?

Danke vorab!

Gruß,

Fabian

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 266885

Url: https://administrator.de/forum/thinkserver-rd440-mit-xenserver-6-2-schlechte-io-performance-266885.html

Ausgedruckt am: 05.08.2025 um 07:08 Uhr

8 Kommentare

Neuester Kommentar

Hallo Fabian,

wie viele VMs laufen auf dieser Büchse ?

Welche Aufgaben haben diese VMs ?

Was wurde geändert seit der Installation ?

War das immer schon so ?

Ich würde mal vermuten, aus Kostengründen die großen langsamen Platten genommen, oder ?

Grundsätzlich würde ich mehr kleinere Platten mit 10k oder 15k bevorzugen.

Einfache Grundregel, je mehr spindeln um so mehr IO.

Ist die Firmware der Servers und der Platten auf dem aktuellen Stand ?

Sind alle Patches des Xen-Servers aktuell ?

Gruß

Anton

wie viele VMs laufen auf dieser Büchse ?

Welche Aufgaben haben diese VMs ?

Was wurde geändert seit der Installation ?

War das immer schon so ?

Ich würde mal vermuten, aus Kostengründen die großen langsamen Platten genommen, oder ?

Grundsätzlich würde ich mehr kleinere Platten mit 10k oder 15k bevorzugen.

Einfache Grundregel, je mehr spindeln um so mehr IO.

Ist die Firmware der Servers und der Platten auf dem aktuellen Stand ?

Sind alle Patches des Xen-Servers aktuell ?

Gruß

Anton

Zitat von @Infomatrixx:

Aber jetzt seien wir mal ehrlich ein SAS

RAID 5 mit 4 Platten muss doch mehr als 12 MB/s schaffen !

Aber jetzt seien wir mal ehrlich ein SAS

RAID 5 mit 4 Platten muss doch mehr als 12 MB/s schaffen !

Ist das Array fertig initialisiert? Oder läuft da noch im Hintergrund die Initialisierung? Evtl. auch die Konsistenzprüfung im Hintergrund. Festplattencache im Controller aktiviert? Muss evtl. erzwungen werden. Nehme an dein Controller hat wie der referenzierte LSI keinen Cache?

Was ist mit den Einstellungen auf dem Volume selbst? Stripe Size? Vorauslesen?

Um es anders zu sagen: Wenn das Array noch am initialisieren ist, dann können die 12MB/s bei einem Raid 5 durchaus sein.

Veranschlagen wir mal 30% BGI reine Schreibvorgänge bei 4 verbrauchten IOPS pro effektivem Schreibvorgang, eingerechnet dass die VMs auch noch lesen und schreiben, du also massiv Kopfbewegung, sprich eher Random Zugriffe als Sequentials hast, und du oben drauf nicht mal auf die Cache Hits im nicht vorhandenen Controller Cache hoffen kannst.... Ohja.

Wenn dann die VHDs noch dynamisch sind.... ohne Worte ;)

Mach aus dem RAID 5 für die VMs lieber ein RAID 10. Schreibzugriffe haben dann nur noch eine IOPS Penalty von Faktor 2, statt der aktuellen 4.

Zitat von @Infomatrixx:

Also Initialisierung ist schon durch, kann also ausgeschlossen werden. Strip size ist 64KB. Der Raid Controller hat keinen Battery

Write Cache und daher ist der Write Cache deaktiviert.

Also Initialisierung ist schon durch, kann also ausgeschlossen werden. Strip size ist 64KB. Der Raid Controller hat keinen Battery

Write Cache und daher ist der Write Cache deaktiviert.

Und dann wunderst du dich?!! Über deine Performance? Ein deaktivierter Schreibcache auf der Festplatte bedeutet dass deine Warteschlangen sequentiell abgearbeitet werden. Als ob du deine Queue Depth permanent 1 wäre. Sprich, die I/O Vorgänge können nicht von der Festplatte optimiert werden.....

Nach einem Test mit einem XEN Benchmark komme ich im Lesen (Random) auf immerhin 55MB/s und 10-20MB im Schreiben (Random und

Sequential).

Sequential).

Xen Benchmark also auf dem in Xen sichtbaren Volume, nicht aus einer VM heraus. Und ich nehme an dass sonst nichts auf dem Datenträger aktiv war, sprich die VMs die drauf liegen aus waren?

Die Werte scheinen mir bei obiger Information nicht unrealistisch.

Jetzt werde ich mir mal Gedanken machen, wie ich es am unkompliziertesten auf RAID10 bekomme

Wird nichts am Cache Problem lösen.Fazit: Tu dir einen Gefallen und nimm einen RAID Controller mit Cache und BBU. Dann noch die Umstellung auf Raid 10 und du wirst erstaunt sein wie das Ding abgeht.

:edit: Nachtrag: Der "RAID 500 Adapter II" basiert auf dem LSI SAS 2008, und der RAID 5 wurde per "Key" zugekauft & läuft nicht wirklich in Performance. :/edit:

Zitat von @Infomatrixx:

> Zitat von @psannz:

> Fazit: Tu dir einen Gefallen und nimm einen RAID Controller mit Cache und BBU. Dann noch die Umstellung auf Raid 10

und du

> wirst erstaunt sein wie das Ding abgeht.

Wahrscheinlich die beste Lösung. Ich werde mal schauen, wo ich den auf die Schnelle herbekomme ...

> Zitat von @psannz:

> Fazit: Tu dir einen Gefallen und nimm einen RAID Controller mit Cache und BBU. Dann noch die Umstellung auf Raid 10

und du

> wirst erstaunt sein wie das Ding abgeht.

Wahrscheinlich die beste Lösung. Ich werde mal schauen, wo ich den auf die Schnelle herbekomme ...

Wenn du bei Orginal Lenovo bleiben möchtest bietet die Serie den "RAID 700 Adapter II", oder besser den "RAID 710 Adapter". Letzterer neben bietet 1 GB Cache (statt 512MB beim 700er) mit CacheCade 2.0 eine SSD Cache Technik die unabhängig von XEN läuft (für den Fall dass evtl. IntelliCache nicht lizneziert ist).

Kauf bitte auch das zugehörige BBU mit. Dann kannst du auch getrost den Cache auf den Festplatten selbst aktivieren.