Benchmark nicht valide oder VM Layer Bottleneck vorhanden

Hallo zusammen,

im Zuge der Anschaffung einer neuen Datenbank Software setzt der Hersteller zum Benchmarken den ATTO Disk Benchmark ein (mit default Settings starten).

Hier werden Werte von 20.000 IOPs im 8k Bereich erwartet.

Unsere aktuelle Infrastruktur:

Die zugehörigen VMs laufen auf zwei dedizierten ESX 7 Servern (DELL PowerEdge R750)

Angebunden mit 2x 10GBE iSCSi an ein Pure X50 FullFlash Array (laut Specs 300.000 IOPs bei 32k)

Der ATTO Benchmark liefert nun ca 6.000 IOPs bei 8k. Damit erfordern wir also nicht die Anforderungen.

Teil des Projektes ist auch eine Datenbank Konvertierung die aufgrund der Größe ca 1 Woche laufen würde.

Um dies zu beschleunigen haben wir in einen der beiden Server eine 3.2 TB Samsung PM1735 NVMe verbaut (8GB/s lesen, 1.5 Mio IOPs), VMFS 6 Volume erstellt und die VM als ganzes per Storage Migration darauf verschoben

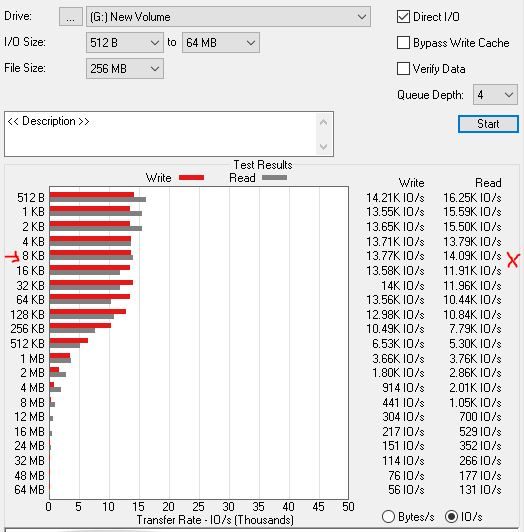

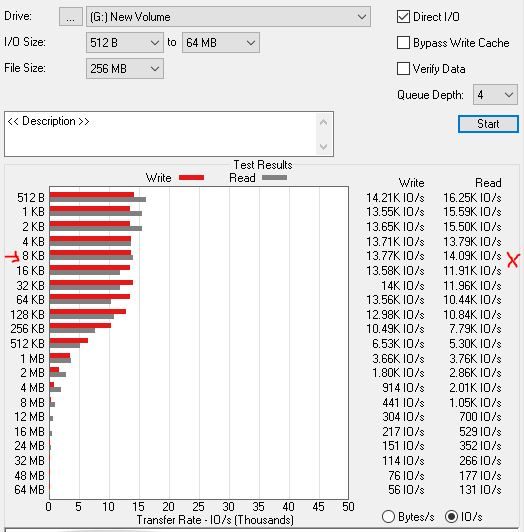

Auch hier liefert der ATTO Benchmark nur 14.000 IOPs bei 8k.

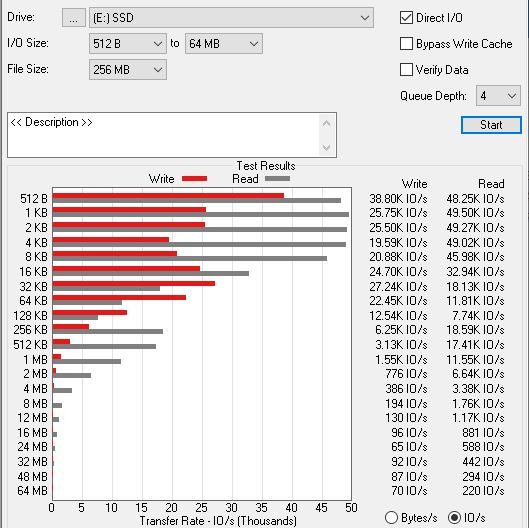

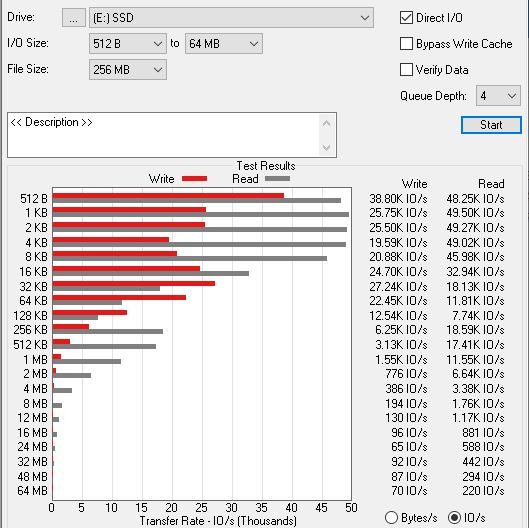

Auf einem Baremetal Windows Server komme ich bei einem RAID5 SSD Volume auf Werte von 46.000 IOPs bei 8k

Nun zu meinen ganzen Fragen:

Ist ein solcher Benchmark (mit den Default Settings) in einer VM überhaupt valide?

Gibt es ESXi Settings die einen solchen Gap beheben würden?

Welche Ergebnisse erzielt ihr?

Da auch die IOPs auf der lokalen NVME nicht anzukommen scheinen, habe ich meine Fehlersuche nicht am iSCSI angesetzt.

Die VM hat bereits einen virtuellen NVME Controller. Unterschiede sind nur marginal.

Anzahl CPU, Sockel und RAM hatten auch keinen Einfluss auf das Ergebnis.

Ressourcen Profile, die etwas beschneiden könnten, sind auch nicht aktiv konfiguriert worden.

Und jetzt bräuchte ich etwas Erleuchtung…

im Zuge der Anschaffung einer neuen Datenbank Software setzt der Hersteller zum Benchmarken den ATTO Disk Benchmark ein (mit default Settings starten).

Hier werden Werte von 20.000 IOPs im 8k Bereich erwartet.

Unsere aktuelle Infrastruktur:

Die zugehörigen VMs laufen auf zwei dedizierten ESX 7 Servern (DELL PowerEdge R750)

Angebunden mit 2x 10GBE iSCSi an ein Pure X50 FullFlash Array (laut Specs 300.000 IOPs bei 32k)

Der ATTO Benchmark liefert nun ca 6.000 IOPs bei 8k. Damit erfordern wir also nicht die Anforderungen.

Teil des Projektes ist auch eine Datenbank Konvertierung die aufgrund der Größe ca 1 Woche laufen würde.

Um dies zu beschleunigen haben wir in einen der beiden Server eine 3.2 TB Samsung PM1735 NVMe verbaut (8GB/s lesen, 1.5 Mio IOPs), VMFS 6 Volume erstellt und die VM als ganzes per Storage Migration darauf verschoben

Auch hier liefert der ATTO Benchmark nur 14.000 IOPs bei 8k.

Auf einem Baremetal Windows Server komme ich bei einem RAID5 SSD Volume auf Werte von 46.000 IOPs bei 8k

Nun zu meinen ganzen Fragen:

Ist ein solcher Benchmark (mit den Default Settings) in einer VM überhaupt valide?

Gibt es ESXi Settings die einen solchen Gap beheben würden?

Welche Ergebnisse erzielt ihr?

Da auch die IOPs auf der lokalen NVME nicht anzukommen scheinen, habe ich meine Fehlersuche nicht am iSCSI angesetzt.

Die VM hat bereits einen virtuellen NVME Controller. Unterschiede sind nur marginal.

Anzahl CPU, Sockel und RAM hatten auch keinen Einfluss auf das Ergebnis.

Ressourcen Profile, die etwas beschneiden könnten, sind auch nicht aktiv konfiguriert worden.

Und jetzt bräuchte ich etwas Erleuchtung…

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 4743956910

Url: https://administrator.de/forum/benchmark-nicht-valide-oder-vm-layer-bottleneck-vorhanden-4743956910.html

Ausgedruckt am: 05.07.2025 um 07:07 Uhr

17 Kommentare

Neuester Kommentar

Nein. Big Bullshit.

Wie ist das iSCSI genau konfiguriert und verbunden?

Wie ist das iSCSI genau konfiguriert und verbunden?

Das Benchmark Tool ist schon witzig.

Welche Switches sind wie konfiguriert? Selbiges Frage ich für die Hosts.

Welche Switches sind wie konfiguriert? Selbiges Frage ich für die Hosts.

Die Realität im SAN Access wird durch das Tool nicht erfasst.

Wie sind die Hosts genau konfiguriert?

Wie sind die Hosts genau konfiguriert?

Wir nutzen IOMeter. Teilweise mit hunderten Workern.

Wir wissen aber auch über unsere SAN bescheid.

Stichwort Anzahl Warteschlange, Paketgrößen und deren Verteilung und Latenzen.

Deine Hosts haben keine zufällige Konfig der HBA/CNAs.

Da kann man ganz viel nicht konfigurieren und offensichtlich auch nicht wissen.

Wir wissen aber auch über unsere SAN bescheid.

Stichwort Anzahl Warteschlange, Paketgrößen und deren Verteilung und Latenzen.

Deine Hosts haben keine zufällige Konfig der HBA/CNAs.

Da kann man ganz viel nicht konfigurieren und offensichtlich auch nicht wissen.

Ich glaube unsere Templates sagen weniger für euch aus?

Wir testen damit 12x25GBit über Low latancy FCoE Switches auf das SAN.

Die Frage ist eigentlich, wie die Paketgrößen sind.

Dann legst du worker an und skalierst bis etwas auffällt.

Weißt du überhaupt wie viele Warteschlangen in Warteschlangen möglich sind im Moment?

Wie die Pfade sich dabei belegen?

virtunetsystems.com/how-does-queue-depth-affect-latency-and-iops ...

Wir testen damit 12x25GBit über Low latancy FCoE Switches auf das SAN.

Die Frage ist eigentlich, wie die Paketgrößen sind.

Dann legst du worker an und skalierst bis etwas auffällt.

Weißt du überhaupt wie viele Warteschlangen in Warteschlangen möglich sind im Moment?

Wie die Pfade sich dabei belegen?

virtunetsystems.com/how-does-queue-depth-affect-latency-and-iops ...

Die nvme ist doch kein Vergleich.

Du suchst deine IOPS die dein SAN wohl kann.

Du suchst deine IOPS die dein SAN wohl kann.

Er funktioniert dort mehr oder weniger auch so, aber im Rahmen des Hyypervisors, bzw dessen Setups, bzw dessen Limits.

Gucke dir Mal die Bedeutung von IOPS und deren Bezug zu Zeit. Dann die Betrachtung zur Größe der Blöcke und dann die Kombination.

Gucke dir Mal die Bedeutung von IOPS und deren Bezug zu Zeit. Dann die Betrachtung zur Größe der Blöcke und dann die Kombination.

Durchsatz passt, IOPS nicht?

Und ja, eine verzerrende Größe ist der Cache, deshalb auch IOMeter mit einem Setup und dauer des Tests, dass der Cache mit eingerechnet ist.

Und ist immer noch unklar, wie deine Hosts per iSCSI auf dem SAN stehen.

Und ja, eine verzerrende Größe ist der Cache, deshalb auch IOMeter mit einem Setup und dauer des Tests, dass der Cache mit eingerechnet ist.

Und ist immer noch unklar, wie deine Hosts per iSCSI auf dem SAN stehen.