Core Switch vs. seperater SAN Switch

Hallo zusammen,

ich bin gerade bei der Planung für unser neues Storage System. Erstmal nichts besonders anspruchsvolles.

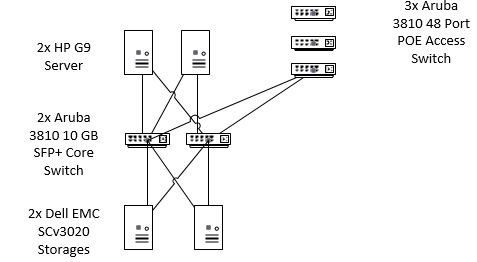

2x HP G9 Server mit ESXI 6.5 mit einem VCenter

2x Dell EMC SCv3020 Storages als Cluster

2x Aruba 3810 10GB SFP+ als Core Switch

3x Aruba 3810 48 Port POE als Access Switch

10x ISCSI LUNs

20 VMs auf die beiden EXSI Hosts verteilt

alles mit 10 GB Etnernet LWL angebunden

Bisher hieß es doch immer das für das Storage immer ein eigener Switch verwendet werden sollte. Nun war ich vor kurzem auf einer VMware Schulung und da hieß es dies sei nicht notwendig.

Ich habe das mal grob gemalt wie sich der Dozent von VMware das vorgestellt hat. Seht ihr das auch so oder würdet ihr das anders machen und zusätzlich 2 SAN Switches nur für die beiden Storages verwenden. Selbstverständlich würde das alles mit VLANs getrennt werden.

Viele Grüße

ich bin gerade bei der Planung für unser neues Storage System. Erstmal nichts besonders anspruchsvolles.

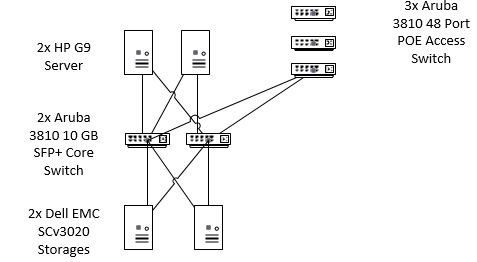

2x HP G9 Server mit ESXI 6.5 mit einem VCenter

2x Dell EMC SCv3020 Storages als Cluster

2x Aruba 3810 10GB SFP+ als Core Switch

3x Aruba 3810 48 Port POE als Access Switch

10x ISCSI LUNs

20 VMs auf die beiden EXSI Hosts verteilt

alles mit 10 GB Etnernet LWL angebunden

Bisher hieß es doch immer das für das Storage immer ein eigener Switch verwendet werden sollte. Nun war ich vor kurzem auf einer VMware Schulung und da hieß es dies sei nicht notwendig.

Ich habe das mal grob gemalt wie sich der Dozent von VMware das vorgestellt hat. Seht ihr das auch so oder würdet ihr das anders machen und zusätzlich 2 SAN Switches nur für die beiden Storages verwenden. Selbstverständlich würde das alles mit VLANs getrennt werden.

Viele Grüße

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 507260

Url: https://administrator.de/forum/core-switch-vs-seperater-san-switch-507260.html

Ausgedruckt am: 18.07.2025 um 10:07 Uhr

4 Kommentare

Neuester Kommentar

Bisher hieß es doch immer das für das Storage immer ein eigener Switch verwendet werden sollte

Das war mal so aber mit modernen Fabric basierten Switches die mit TRILL oder SPF Technik arbeiten ist das in der Tat nicht mehr nötig da du darin Storage Traffic sehr leicht und effizient priorisieren kannst.Das ist in einem gesharten Netz zwingend, denn Storage Traffic muss dort aus gutem Grund absolute Priorität haben. Fast immer sind solche Fabric basierten Switches Cut Through Switches mit sehr geringer Latency die nicht mehr nach einem ollen Store and Forward Prinzip funktionieren. TRILL oder SPF Technik ersetzt auch Spanning Tree so das eine Vollvermaschung in solchen Netzen möglich wird mit aktiven, redundanten Links wie man es aus Fibre Channel Designs auch kennt.

In so fern haben die VmWare Leute schon recht. Der langfristige Trend geht eh von Fiber Channel (SAN) weg auf Ethernet.

Ob man dann mit billigen HP ProCurve Switches gut beraten ist wohl eher nicht. Die VmWare Dozenten haben sicher auch nicht solche Switch HW gemeint. Wohl eher Extreme VDX, Arista oder Cisco Nexus Switches und solche Kaliber.

Mit den billigen Consumer HPs wohl eher nicht. Mit solcher HW sollte man dann doch besser auf ein SAN mit Fibre Channel setzen oder ein separates Storage Netz was vom RZ Backbone getrennt ist.

Moin,

also auch wenn das technisch möglich ist und in 99,9% der Einsatzszenarien auch gut funktioniert. Aber wenn der erste Packetstorm aus dem LAN oder xSTP-Fehler die SAN Storage ausbremst ist Schluss mit lustig. Ich würde daher LAN und SAN immer durch separate Switche/Fabrics abbilden. Letztendlich ist das aber natürlich auch eine Geldfrage.

lg,

Slainte

also auch wenn das technisch möglich ist und in 99,9% der Einsatzszenarien auch gut funktioniert. Aber wenn der erste Packetstorm aus dem LAN oder xSTP-Fehler die SAN Storage ausbremst ist Schluss mit lustig. Ich würde daher LAN und SAN immer durch separate Switche/Fabrics abbilden. Letztendlich ist das aber natürlich auch eine Geldfrage.

lg,

Slainte

<3 TRILL ... leider sind die jetzt Extreme und nicht mehr Brocade

Ähnliches Technik hat auch Dell mit den Force10 10G Geräten, allerdings kleiner Dimensioniert wie bei den VDX'n.

Und ja du kannst alles über einen Switch laufen lassen, dann würde ich aber NFS statt iSCSI verwenden (auch wenn das Protokoll langsamer ist) - vor allem wenn du keine HighEnd Switche zur Verfügung hast - ist halt dann kein BlockLevel basierende Anbindung mehr, mit all seinen Vor- und Nachteilen, auch eine Frage der IO Last

Dazu gibt es im VMWare Forum auch einen relativ aktuellen Thread - wobei die Frage immer wieder kommt:

communities.vmware.com/thread/607260

Edit / Add: hyper-v.io/whos-got-bigger-balls-testing-nfs-vs-iscsi-performanc ... mal so als Info was die Performance-Unterschiede ausmachen, habe es jetzt aber auch nur überflogen.

Gruß

@clSchak

Ähnliches Technik hat auch Dell mit den Force10 10G Geräten, allerdings kleiner Dimensioniert wie bei den VDX'n.

Und ja du kannst alles über einen Switch laufen lassen, dann würde ich aber NFS statt iSCSI verwenden (auch wenn das Protokoll langsamer ist) - vor allem wenn du keine HighEnd Switche zur Verfügung hast - ist halt dann kein BlockLevel basierende Anbindung mehr, mit all seinen Vor- und Nachteilen, auch eine Frage der IO Last

Dazu gibt es im VMWare Forum auch einen relativ aktuellen Thread - wobei die Frage immer wieder kommt:

communities.vmware.com/thread/607260

Edit / Add: hyper-v.io/whos-got-bigger-balls-testing-nfs-vs-iscsi-performanc ... mal so als Info was die Performance-Unterschiede ausmachen, habe es jetzt aber auch nur überflogen.

Gruß

@clSchak