Hyper-V Cluster, Failover bei VMs mit mehreren Netzwerkkarten schlägt fehl

2x Dell R710 mit Hyper-V Server 2008 R2

1x Dell R310 mit Server 2008 R2 Enterprise

1x Dell MD3200i Storage

Hallo zusammen,

ich habe ein Problem bei der Konfiguration eines Hyper-V Clusters. Vorab habe ich eine Clusteranalyse gemacht welche in allen Punkten mit erfolreichem Ergebnis durchgeführt wurde.

Konfiguration:

Clusternode1: HVS1

Quests: Server 2008 R2, Debian Linux

Clusternode2: HVS2

Exchange 2010, Server 2008 R2

Netzwerke der HV-Nodes:

SAN1 192.168.130.0/24

SAN2 192.168.131.0/24

SAN3 192.168.132.0/24

SAN4 192.168.133.0/24

DMZ 10.0.0.0/24

LAN 172.30.0.0/16 (Clusternetzwerk)

MD3200i Anbindung:

verwendet werden die 4 "Standard" Subnetze:

192.168.130.0/24

192.168.131.0/24

192.168.132.0/24

192.168.133.0/24

Switch 1, Controller 1: NIC1, NIC3 / Controller 2: NIC1, NIC3

Switch 2, Controller 1: NIC2, NIC4 / Controller 2: NIC2, NIC4

Auf den Switchen ist bisher noch ein VLAN etc. pro Subnetz konfiguriert, jedoch sollte das keinen Unterschied machen denke ich.

Die Hyper-V Server sind mit jeweils 2 NICs auf jedem Switch, d.h. 4Gbit über Multipathing pro Server. Dazu wurde die Dell Software (Treiber etc.) auf jedem Server installiert. MPIO ist auf "geringste Warteschlangentiefe" konfiguriert. In MPIO ist pro MD3200i-Controller eine Session mit jeweils 4 MCS Verbindungen konfiguriert. Dabei ist auf HVS1 die erste Session mit MD3200i-Controller2 verbunden, HVS2 hat die erste Session auf MD3200i-Controller 2 (wobei ich nicht weiß ob dies relevant ist).

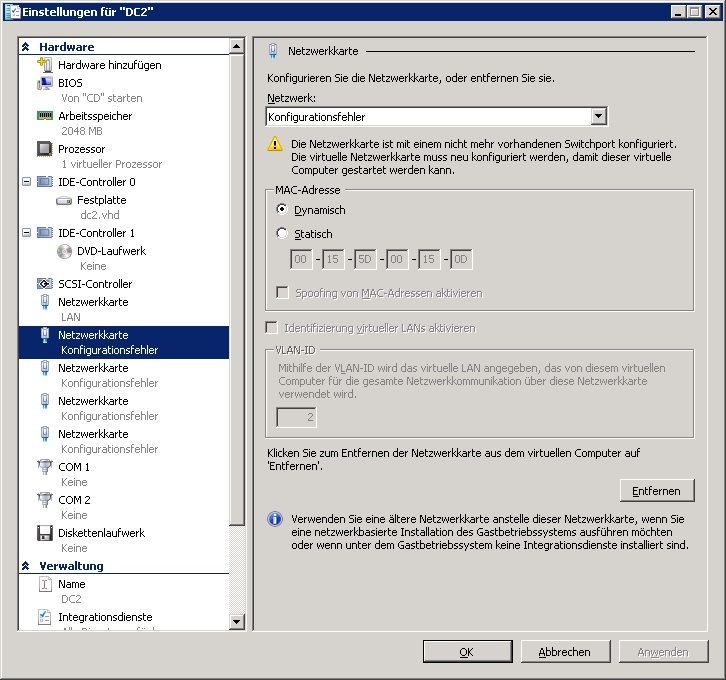

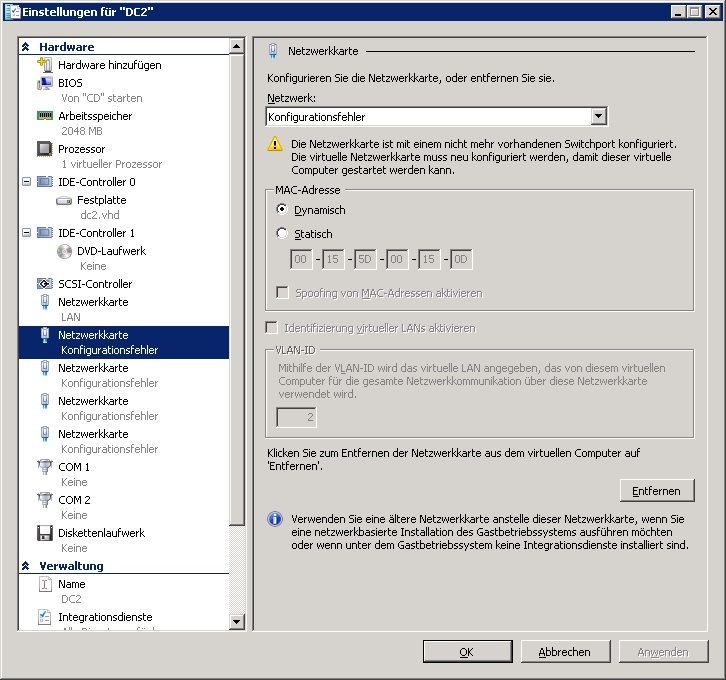

Generell wird ein Failover korrekt durchgeführt wenn ein Hyper-V Server rebooted. Allerdings gibt es einen Fehler bei VMs mit mehreren virtuellen NICs. Eine VM is bspw. ein Proxyserver und ist mit der Schnittstelle LAN und DMZ verbunden. Eine weitere VM ist mit LAN und allen 4 SAN-Schnittstellen verbunden, da auf dieser VM ein seperates LUN auf dem Storage angebunden ist. Bei diesen Maschinen schlägt das Failover fehl. In der Konfiguration der VMs ist mir folgendes aufgefallen:

Wenn die VM wieder auf dem ursprünglichen Clusternode ausgeführt wird funktioniert die Konfiguration wieder korrekt. Komisch an dem Phänomen ist, dass VMs mit nur einer Verbindung korrekt migriert werden. Bei dieser Maschine sieht man auch dass die Lan Schnittstelle korrekt konfiguriert ist, alle andern Schnittstellen schlagen fehl. Dazu ist zu sagen, dass ich die VM im Nachhinein editiert habe, um weitere Schnittstellen hinzuzufügen.

Hat jemand eine Idee?

Lg, Lownex

1x Dell R310 mit Server 2008 R2 Enterprise

1x Dell MD3200i Storage

Hallo zusammen,

ich habe ein Problem bei der Konfiguration eines Hyper-V Clusters. Vorab habe ich eine Clusteranalyse gemacht welche in allen Punkten mit erfolreichem Ergebnis durchgeführt wurde.

Konfiguration:

Clusternode1: HVS1

Quests: Server 2008 R2, Debian Linux

Clusternode2: HVS2

Exchange 2010, Server 2008 R2

Netzwerke der HV-Nodes:

SAN1 192.168.130.0/24

SAN2 192.168.131.0/24

SAN3 192.168.132.0/24

SAN4 192.168.133.0/24

DMZ 10.0.0.0/24

LAN 172.30.0.0/16 (Clusternetzwerk)

MD3200i Anbindung:

verwendet werden die 4 "Standard" Subnetze:

192.168.130.0/24

192.168.131.0/24

192.168.132.0/24

192.168.133.0/24

Switch 1, Controller 1: NIC1, NIC3 / Controller 2: NIC1, NIC3

Switch 2, Controller 1: NIC2, NIC4 / Controller 2: NIC2, NIC4

Auf den Switchen ist bisher noch ein VLAN etc. pro Subnetz konfiguriert, jedoch sollte das keinen Unterschied machen denke ich.

Die Hyper-V Server sind mit jeweils 2 NICs auf jedem Switch, d.h. 4Gbit über Multipathing pro Server. Dazu wurde die Dell Software (Treiber etc.) auf jedem Server installiert. MPIO ist auf "geringste Warteschlangentiefe" konfiguriert. In MPIO ist pro MD3200i-Controller eine Session mit jeweils 4 MCS Verbindungen konfiguriert. Dabei ist auf HVS1 die erste Session mit MD3200i-Controller2 verbunden, HVS2 hat die erste Session auf MD3200i-Controller 2 (wobei ich nicht weiß ob dies relevant ist).

Generell wird ein Failover korrekt durchgeführt wenn ein Hyper-V Server rebooted. Allerdings gibt es einen Fehler bei VMs mit mehreren virtuellen NICs. Eine VM is bspw. ein Proxyserver und ist mit der Schnittstelle LAN und DMZ verbunden. Eine weitere VM ist mit LAN und allen 4 SAN-Schnittstellen verbunden, da auf dieser VM ein seperates LUN auf dem Storage angebunden ist. Bei diesen Maschinen schlägt das Failover fehl. In der Konfiguration der VMs ist mir folgendes aufgefallen:

Wenn die VM wieder auf dem ursprünglichen Clusternode ausgeführt wird funktioniert die Konfiguration wieder korrekt. Komisch an dem Phänomen ist, dass VMs mit nur einer Verbindung korrekt migriert werden. Bei dieser Maschine sieht man auch dass die Lan Schnittstelle korrekt konfiguriert ist, alle andern Schnittstellen schlagen fehl. Dazu ist zu sagen, dass ich die VM im Nachhinein editiert habe, um weitere Schnittstellen hinzuzufügen.

Hat jemand eine Idee?

Lg, Lownex

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 164549

Url: https://administrator.de/forum/hyper-v-cluster-failover-bei-vms-mit-mehreren-netzwerkkarten-schlaegt-fehl-164549.html

Ausgedruckt am: 24.07.2025 um 04:07 Uhr

2 Kommentare

Neuester Kommentar