PCIe NVMe RAID - Welchen Hypervisor ?

Hallo zusammen,

ich würde gern meinen Server aufrüsten, da mir die Festplatten Performance mittlerweile zu gering ausfällt.

Bei der Umsetzung gibt es leider ein paar Stolpersteine. Daher wollte ich mal ein paar Erfahrungen einholen...

2x Intel Xeon E5-2630 V4, 128GB RAM

ASRockRack Server Board C612

Geplant ist, das SAS RAID 10 durch vier SSDs als RAID 10 zu ersetzen.

Hierfür gibt es folgenden Adapter: asus.com/Motherboard-Accessories/HYPER-M-2-X16-CARD-V2/

Damit lassen sich vier M.2 SSDs an einem x16 PCIe Slot betreiben, sofern die Hardware PCIe Bifurcation unterstützt.

ESXi unterstützt kein Software RAID. Daher wäre bei der Nutzung von M.2 SSDs ein kompatibler NVMe Hardware RAID Controller nötig. Kostenpunkt 800€ aufwärts.

Das ist mir zu teuer. Theoretisch könnte man auch jeder VM (wenn RAID benötigt) vier virtuelle Festplatten zuweisen, die dann auf jeder SSD einzeln liegen. Ich denke aber nicht, dass das der optimale Weg ist, auch im Hinblick auf die Performance (Overhead etc.). Intel VROC gäbe es noch, was allerdings die Intel C612 Plattform nicht unterstützt.

Gibt es noch andere Lösungsansätze bei ESXi?

Nun gibt es natürlich auch noch andere Hypervisor-Systeme wie z.B. Proxmox.

Hier wäre ein NVMe RAID mit vier SSDs ohne Probleme möglich. Mit Proxmox habe ich allerdings noch nicht viel gemacht. Daher auch hier die Frage, ob das schon mal jemand so umgesetzt hat. Was geht, was geht nicht im Vergleich zu ESXi. Außerdem: Wie sieht es mit der Performance aus? VMware macht hier schon einen sehr guten Job.

Vielen Dank im Voraus!

Gruß

ich würde gern meinen Server aufrüsten, da mir die Festplatten Performance mittlerweile zu gering ausfällt.

Bei der Umsetzung gibt es leider ein paar Stolpersteine. Daher wollte ich mal ein paar Erfahrungen einholen...

2x Intel Xeon E5-2630 V4, 128GB RAM

ASRockRack Server Board C612

- 1x LSI 9260-8i (6x SAS 300GB 10k als RAID 10)

- 2x LSI 9240-8i (IT Mode für Passthrough: 9x Seagate 8TB, 2x 250GB SSD)

- 1x 4 Port Intel Gigabit Adapter

- 1x 2 Port Intel 10G Adapter

- pfsense als Router

- Synology DSM als NAS

- Einige Windows und Linux (Exchange, Webserver etc.)

- Unifi Controller

Geplant ist, das SAS RAID 10 durch vier SSDs als RAID 10 zu ersetzen.

Hierfür gibt es folgenden Adapter: asus.com/Motherboard-Accessories/HYPER-M-2-X16-CARD-V2/

Damit lassen sich vier M.2 SSDs an einem x16 PCIe Slot betreiben, sofern die Hardware PCIe Bifurcation unterstützt.

ESXi unterstützt kein Software RAID. Daher wäre bei der Nutzung von M.2 SSDs ein kompatibler NVMe Hardware RAID Controller nötig. Kostenpunkt 800€ aufwärts.

Das ist mir zu teuer. Theoretisch könnte man auch jeder VM (wenn RAID benötigt) vier virtuelle Festplatten zuweisen, die dann auf jeder SSD einzeln liegen. Ich denke aber nicht, dass das der optimale Weg ist, auch im Hinblick auf die Performance (Overhead etc.). Intel VROC gäbe es noch, was allerdings die Intel C612 Plattform nicht unterstützt.

Gibt es noch andere Lösungsansätze bei ESXi?

Nun gibt es natürlich auch noch andere Hypervisor-Systeme wie z.B. Proxmox.

Hier wäre ein NVMe RAID mit vier SSDs ohne Probleme möglich. Mit Proxmox habe ich allerdings noch nicht viel gemacht. Daher auch hier die Frage, ob das schon mal jemand so umgesetzt hat. Was geht, was geht nicht im Vergleich zu ESXi. Außerdem: Wie sieht es mit der Performance aus? VMware macht hier schon einen sehr guten Job.

Vielen Dank im Voraus!

Gruß

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 574150

Url: https://administrator.de/forum/pcie-nvme-raid-welchen-hypervisor-574150.html

Ausgedruckt am: 15.07.2025 um 19:07 Uhr

18 Kommentare

Neuester Kommentar

Es gibt Nutzer, die verwenden eine Storage VM.Dh.der Storage (egal ob HDD, SSD) wird per passtrough (SAS HBA, Pcie x16 zu 4 m.2 Karte etc.)an eine VM durchgreicht und diese verwaltet dann den Storage -> vorzugsweise eine mit ZFS.Hier wird dann der entsprechende Raid Level aus den einzelnen Datenträgern gebildet und als Pool zusammengefasst.Aufr diesem werden dann entsprechende Dateisysteme erstellt.Diese werden dann per NFS/iSCSI je nach dem was man braucht an vSphere zurückgegeben.Hierrauf kommen dann die VMs.

Die Storage VM muss natürlich auf einen Store, der direkt am ESXI ist.

Die Storage VM muss natürlich auf einen Store, der direkt am ESXI ist.

Zitat von @Luckysh0t:

Es gibt Nutzer, die verwenden eine Storage VM.Dh.der Storage (egal ob HDD, SSD) wird per passtrough (SAS HBA, Pcie x16 zu 4 m.2 Karte etc.)an eine VM durchgreicht und diese verwaltet dann den Storage -> vorzugsweise eine mit ZFS.Hier wird dann der entsprechende Raid Level aus den einzelnen Datenträgern gebildet und als Pool zusammengefasst.Aufr diesem werden dann entsprechende Dateisysteme erstellt.Diese werden dann per NFS/iSCSI je nach dem was man braucht an vSphere zurückgegeben.Hierrauf kommen dann die VMs.

Die Storage VM muss natürlich auf einen Store, der direkt am ESXI ist.

Es gibt Nutzer, die verwenden eine Storage VM.Dh.der Storage (egal ob HDD, SSD) wird per passtrough (SAS HBA, Pcie x16 zu 4 m.2 Karte etc.)an eine VM durchgreicht und diese verwaltet dann den Storage -> vorzugsweise eine mit ZFS.Hier wird dann der entsprechende Raid Level aus den einzelnen Datenträgern gebildet und als Pool zusammengefasst.Aufr diesem werden dann entsprechende Dateisysteme erstellt.Diese werden dann per NFS/iSCSI je nach dem was man braucht an vSphere zurückgegeben.Hierrauf kommen dann die VMs.

Die Storage VM muss natürlich auf einen Store, der direkt am ESXI ist.

Da hast du aber das Henne / Ei Problem.

Und wenn die eine VM eine Macke hat, laufen alle anderen VM auch nicht.

Zitat von @KernelMaker:

Ich würde auch gern weiterhin auf ESXi setzen. Das läuft wirklich super.

Nur geht da eben kein Software RAID.

Hyper-V wäre auch eine Option. Hier ist aber die Frage, ob das PCIe Passthrough und Xpenology laufen.

Ich würde auch gern weiterhin auf ESXi setzen. Das läuft wirklich super.

Nur geht da eben kein Software RAID.

Hyper-V wäre auch eine Option. Hier ist aber die Frage, ob das PCIe Passthrough und Xpenology laufen.

Xpenology ja,

PCIe passtrough nein.

Zitat von @KernelMaker:

Ich würde auch gern weiterhin auf ESXi setzen. Das läuft wirklich super.

Nur geht da eben kein Software RAID.

Hyper-V wäre auch eine Option. Hier ist aber die Frage, ob das PCIe Passthrough und Xpenology laufen.

Ich würde auch gern weiterhin auf ESXi setzen. Das läuft wirklich super.

Nur geht da eben kein Software RAID.

Hyper-V wäre auch eine Option. Hier ist aber die Frage, ob das PCIe Passthrough und Xpenology laufen.

Den LSI 9460 bekommt man in der Bucht für 350-400€.

Der unterstützt NVMe SSD

@wuebra

Das hat man bei einem HW Raid Controller auch, oder bei jedem anderen SW RAID.

Wenn die Zentrale Kopmonente hops geht steht meistens alles.Und der TO hat wohl weder ein vSphere Cluster noch ein Storage Cluster um dies abzufangen ^^

Sollte es im privaten Umfeld sein, könnte man Solaris nutzen ggf. OmniOS, wenn man tatsächlich etwas freies nutzen möchte .Die gehören so mit zu den stabilsten OS die ich kenne - wenn man mal vom verbugten AES-NI Support von OmniOS absieht (Die Performance mit verschlüsselten Filesystemen ist unterirdisch) xD

Und nach der initialen Einrichtung fast man diese nicht mehr an - außer man möchte den Storage erweitern etc.

Und möchte man eine WebGUI gibt es für genannte Derivate z. nappit zum nachinstallieren.Danach müssten diese VMs nicht mal mehr eine Verbindung ans Internet haben - nur zum Host/LAN.

Das hat man bei einem HW Raid Controller auch, oder bei jedem anderen SW RAID.

Wenn die Zentrale Kopmonente hops geht steht meistens alles.Und der TO hat wohl weder ein vSphere Cluster noch ein Storage Cluster um dies abzufangen ^^

Sollte es im privaten Umfeld sein, könnte man Solaris nutzen ggf. OmniOS, wenn man tatsächlich etwas freies nutzen möchte .Die gehören so mit zu den stabilsten OS die ich kenne - wenn man mal vom verbugten AES-NI Support von OmniOS absieht (Die Performance mit verschlüsselten Filesystemen ist unterirdisch) xD

Und nach der initialen Einrichtung fast man diese nicht mehr an - außer man möchte den Storage erweitern etc.

Und möchte man eine WebGUI gibt es für genannte Derivate z. nappit zum nachinstallieren.Danach müssten diese VMs nicht mal mehr eine Verbindung ans Internet haben - nur zum Host/LAN.

Zitat von @KernelMaker:

Auf die Idee bin ich noch gar nicht gekommen ;) Eigentlich clever

Und das funktioniert gut? Wie ist da die Performance?

Ich kann es einfach mal ausprobieren wenn die neuen SSDs da sind. Das wäre sogar im aktuellen System "Plug 'n Play" zu testen.

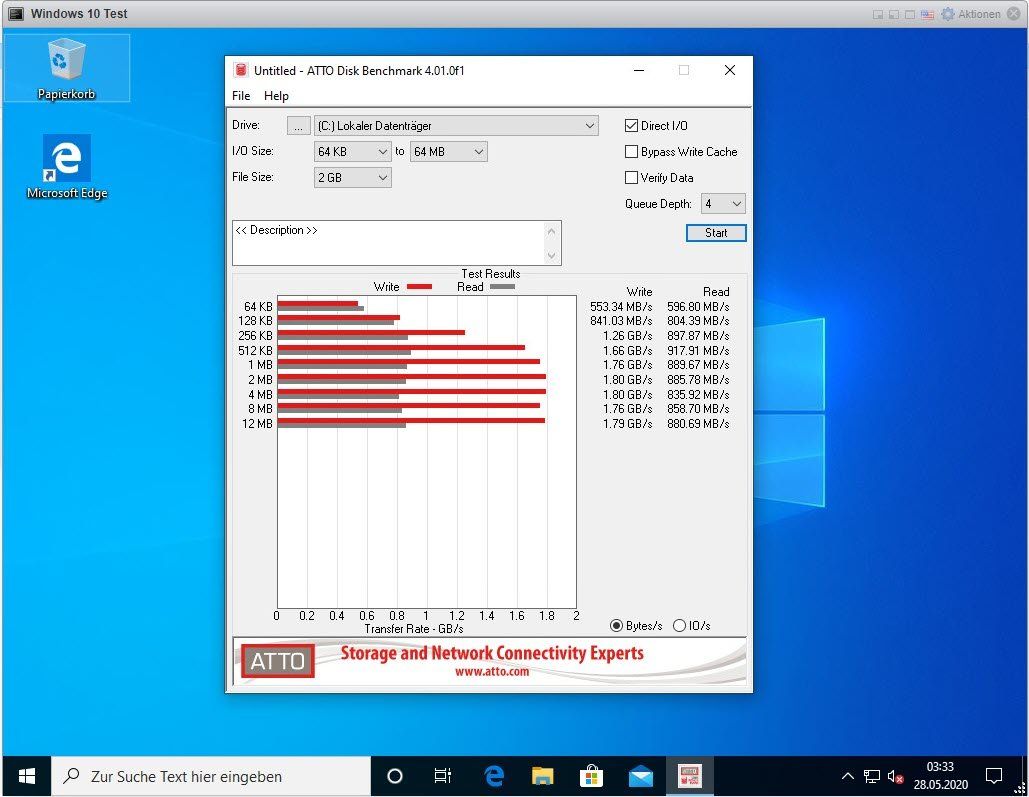

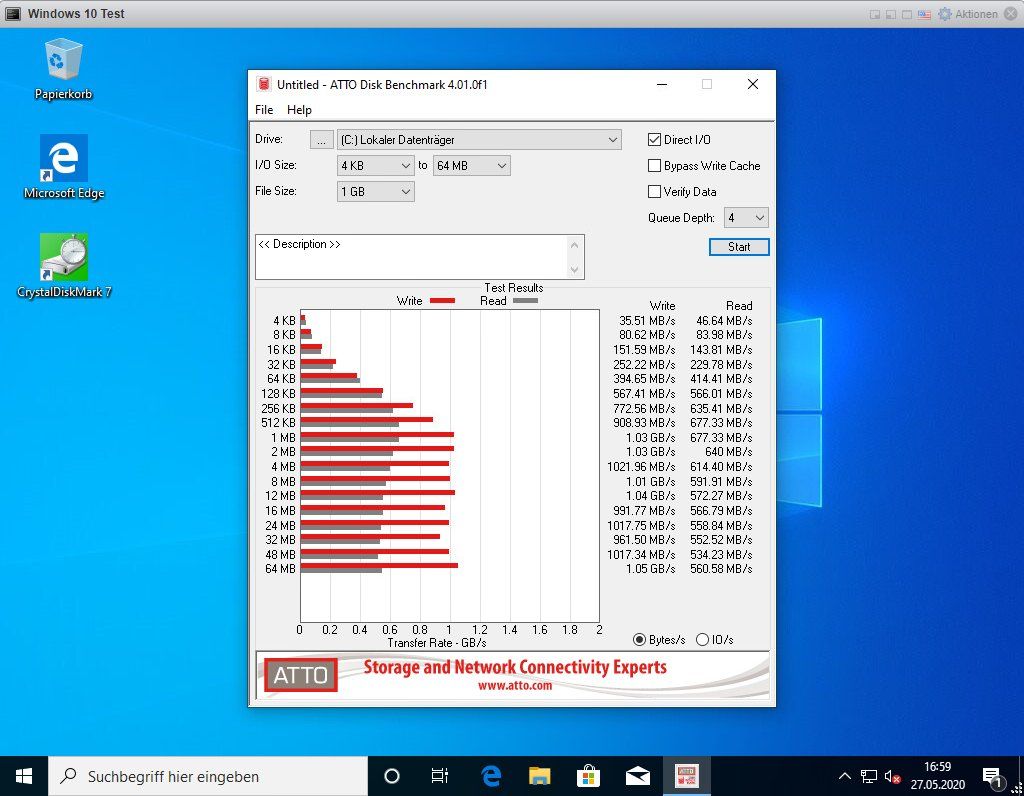

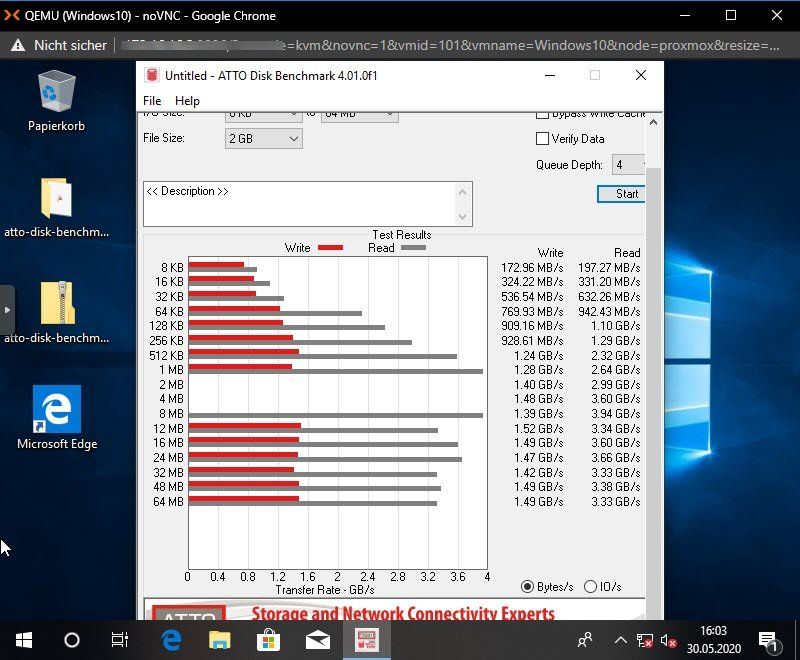

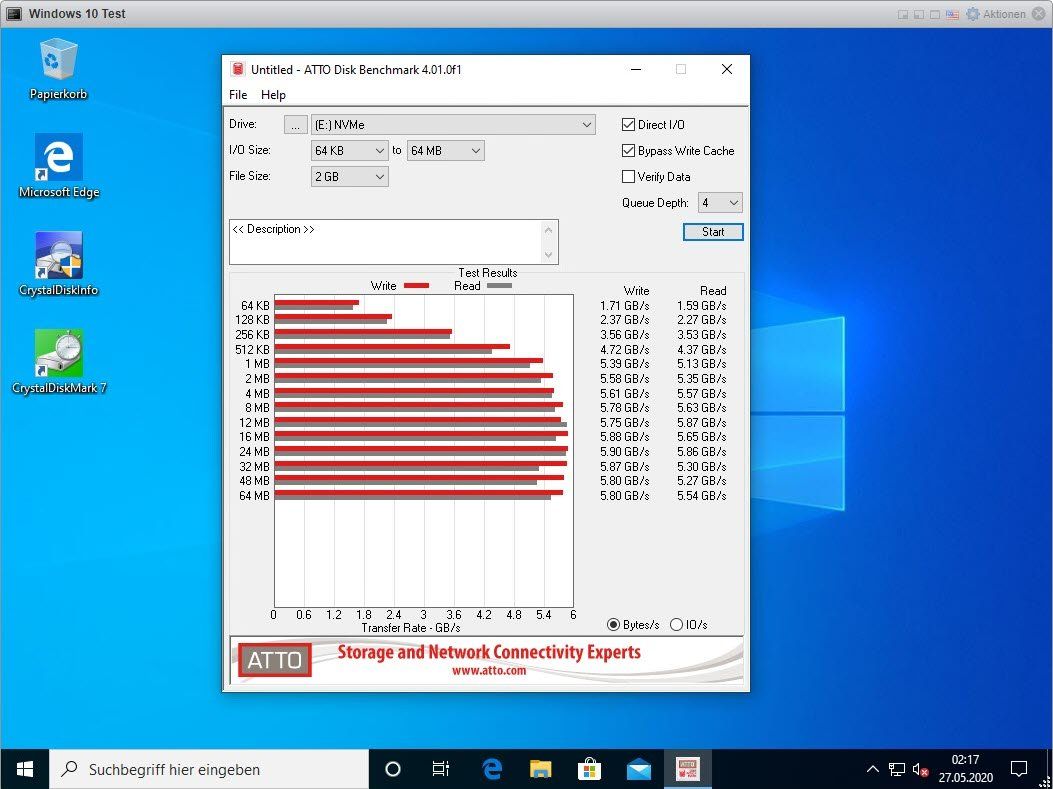

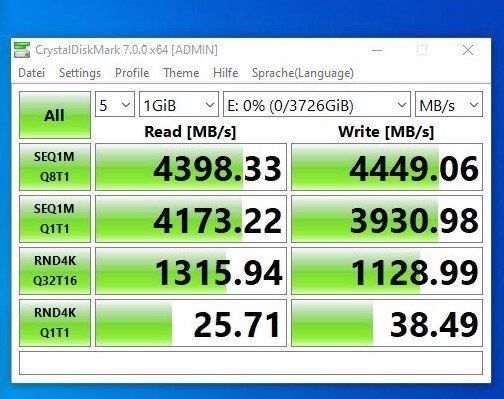

Das ist dann schon eine Ansage: Über die virtuelle Netzwerkkarte der Storage VM und den VMKernel Port von ESXi müssten dann ~ 40 Gbit/s Bandbreite (vielleicht sogar mehr) zur Verfügung stehen.

Wie verhält sich das mit der Startreihenfolge? ESXi wäre vor der Storage VM hochgefahren und erwartet daher bereits das iSCSI Drive mit den VM-Daten.

Auf die Idee bin ich noch gar nicht gekommen ;) Eigentlich clever

Und das funktioniert gut? Wie ist da die Performance?

Ich kann es einfach mal ausprobieren wenn die neuen SSDs da sind. Das wäre sogar im aktuellen System "Plug 'n Play" zu testen.

Das ist dann schon eine Ansage: Über die virtuelle Netzwerkkarte der Storage VM und den VMKernel Port von ESXi müssten dann ~ 40 Gbit/s Bandbreite (vielleicht sogar mehr) zur Verfügung stehen.

Wie verhält sich das mit der Startreihenfolge? ESXi wäre vor der Storage VM hochgefahren und erwartet daher bereits das iSCSI Drive mit den VM-Daten.

Du musst halt der VM schon etwas RAM geben, da ZFS diesen u.a als Schreibcache nutzt.Aber ab 16 GB sollte ausreichen - mehr kann man immer noch geben, wenn vorhanden und man Engpässe bemerkt.Nicht wunder, der RAM wird quasi komplett belegt, also wird ESXi durchaus meckern xD.

Ich würde als Anbindung NFS empfehlen, anstelle von iSCSI.Wenn du die Snapshots von ZFS nutzt kannst du so über "vorherige Versionen" aus dem Windowskontextmenü einzelnde Ordner/Dateien etc bequem wiederherstellen.Musst es nur eben auch in Windows einbinden (SMB/CIFS) und Snapshots nutzen.Funktioniert natürlich auch für FIlesysteme die tatsächlich Nutzdaten beinhalten.Dieses Storage stellt dann auf entsprechenden Pools VM Store und Nutzdaten für Clients im Lan bereit.Deine XPEnology VM ist somit eigentlich auch nicht mehr nötig, wenn du nichtgerade spezifische DSM Programme nutzt.

Ein Kumpel nutzt dass so, und wir haben da nicht wirklich Probleme festgestellt mit dem Start.Ist halt Sinnvoll der Storage VM einen Autostart einzutragen und die anderen dann manuel zu starten - ob dass dann nun per GUI oder PowerCLI per script von deinem Client ist egal.Hauptsache der Storage ist da ^^

Zitat von @KernelMaker:

Geplant ist, das SAS RAID 10 durch vier SSDs als RAID 10 zu ersetzen.

Hierfür gibt es folgenden Adapter: asus.com/Motherboard-Accessories/HYPER-M-2-X16-CARD-V2/

Damit lassen sich vier M.2 SSDs an einem x16 PCIe Slot betreiben, sofern die Hardware PCIe Bifurcation unterstützt.

Geplant ist, das SAS RAID 10 durch vier SSDs als RAID 10 zu ersetzen.

Hierfür gibt es folgenden Adapter: asus.com/Motherboard-Accessories/HYPER-M-2-X16-CARD-V2/

Damit lassen sich vier M.2 SSDs an einem x16 PCIe Slot betreiben, sofern die Hardware PCIe Bifurcation unterstützt.

++++ Nun zum Problem: ++++

ESXi unterstützt kein Software RAID. Daher wäre bei der Nutzung von M.2 SSDs ein kompatibler NVMe Hardware RAID Controller nötig. Kostenpunkt 800€ aufwärts.

ESXi unterstützt kein Software RAID. Daher wäre bei der Nutzung von M.2 SSDs ein kompatibler NVMe Hardware RAID Controller nötig. Kostenpunkt 800€ aufwärts.

Das ist mir zu teuer. Theoretisch könnte man auch jeder VM (wenn RAID benötigt) vier virtuelle Festplatten zuweisen, die dann auf jeder SSD einzeln liegen. Ich denke aber nicht, dass das der optimale Weg ist, auch im Hinblick auf die Performance (Overhead etc.). Intel VROC gäbe es noch, was allerdings die Intel C612 Plattform nicht unterstützt.

Gibt es noch andere Lösungsansätze bei ESXi?

Schuster bleib bei deinen Leisten... der Hyper M2 Adapter hat phantastische Stornoquoten weil der zu den allermeisten Mainboards inkompatibel ist, selbst wenn die Boards "Bifurcation" könnten funkioniert der Adapter nicht auf Multi-CPU Boards.

VROC setzt dem gewissermaßen noch eine Krone auf, aber wenn man mal die Füße auf dem Boden lassen will... scheinbar sollte das nicht allzuviel kosten, und dann würd ich die NVME Geschichte mal ganz schnell wieder vergessen, und ein paar SSD SATA Disks an den vorhandenen Controller anschließen, falls er abwärtskompatibel zu SATA ist.

NVME ist kein Allheilmittel für Festplattenperformance-Probleme - analysier erstmal deine Probleme bevor du direkt mal was mit NVME machst. Datenbankserver mögen keine hohen Latenzen, Fileserver wiederum benötigen Datendurchsatz bis an die Leistungsgrenze des Ethernetadapters im Client... das solltest du erstmal genauer auseinanderfriemeln.

Und schaut man mal ganz in die Tiefe, dann stellt man fest, daß die 3,5 GB/Sekunde Datentransferrate bei einer NVME Disk nur aus dem mit DRAM in der NVME Disk abgedeckten Cache erzielbar sind, das sind dann 5-10% der Gesamtkapazität. Danach fallen auch NVMEs auf drei Geschwindgkeitsstufen herab, die oft so mit 500 MB/Sec, dann 250 MB/sec und 120 MB/Sec liegen bei TLC, die mit QLC haben noch einen Gang mehr nach "unten" und sind dann bei 60 zuende wie die 970 QVO von Samsung.

Im harten Serverbetrieb, wo man konstante Performance braucht, verwendet man dann auch SLC, und die sind dann gleich richtig teuer. Die Intel Optane 1 TB als SLC Version kostet deshalb auch vierstellige Beträge, hat dafür aber auch sechsstellige TBW Werte. Aber du knauserst ja shcon mit dem 800 Euro teuren Controller... wie gesagt hol dir SATAt SSDs oder SAS SSDs für den vorhandenen Controller.

Zum Rumspielen gibts einzelne Adapter für m.2 (z.B. das Icybox ist kompatibel zu ESX 6.7) und nimm dann eine anstänidge m.2 Platte, die Billigteile haben noch so allerlei Kinderkrankzeiten, die werden heiß, verschwinden sporadisch ausm Bios u.s.w., da würde ich eher zu einer guten SSD tendieren. Ich selbst hab EINE Samsung Evo 970 in einem Icybox Adpater unter ESXI 6.7 und der ist zentral als Storage im Hypervisor verfügbar... im Vergleich zu einer SATA SSD war z.B. eine SAP Installation viermal so schnell fertig und die Datenbnakperformance bei sequenziellen Zugriffen auf nicht gecachten Inhalt sind noch mal doppelt so schnell weil NVME nun mal ein direkter Zugriff der CPU auf den Flash-Speicher ist, wohingegen bei SATA und SAS eine ganze Menge Protokoll-Overhead mit im Spiel ist.