10G Netzwerk konfigurieren für maximalen Datendurchsatz

Guten Morgen,

in unserem Betrieb wurde das Netzwerk auf 10G (Kupfer) umgerüstet. Grund dafür sind große Laserscandaten die sehr viel Speicherplatz in Anspruch nehmen. (ca. 50-200GB pro Projekt). Die Daten sollen auf dem Speicher liegen, auch während sie vom CAD verarbeitet werden.

Die gesamte Verkabelung wurde erneuert, jede Workstation hat eine Doppeldose bekommen. Aktuell sind die Workstations noch mit "nur" einem Netzwerkkabel angeschlossen.

Der Speicher ist ein QNAP NAS:

QNAP TS-1885U

10G Netzwerkkarte

(Intel Ethernet Controller 10G X550T 2x RJ45)

6x 4TB HD SVR SAS von Toshiba

Switch Netgear ProSafe XS716T

Workstations

AMD Ryzen Threadripper 1950X (16-Cores)

64 GB RAM SVR PC266 Samsung ECC

2x SSD M.2 2280 512GB PCIex4 Samsung PM981 NVMe

Netzwerkkarte Emulex OneConnect OCe14102-NT (2x RJ45)

Am QNAP Nas habe ich bei den beiden 10G Netzwerkadaptern die Jumbo Frames auf 9000 gesetzt, an der Netzwerkkarte in den Erweiterten Eigenschaften die Packet Size auf 9014. Denoch kann ich aktuell nur mit ca. 200-250MB vom QNAP auf meine SSD kopieren...

Hat jemand von euch Erfahrungen mit 10G Netzwerken und kann mir einen Tipp geben, wo mein Flaschenhals liegt?

in unserem Betrieb wurde das Netzwerk auf 10G (Kupfer) umgerüstet. Grund dafür sind große Laserscandaten die sehr viel Speicherplatz in Anspruch nehmen. (ca. 50-200GB pro Projekt). Die Daten sollen auf dem Speicher liegen, auch während sie vom CAD verarbeitet werden.

Die gesamte Verkabelung wurde erneuert, jede Workstation hat eine Doppeldose bekommen. Aktuell sind die Workstations noch mit "nur" einem Netzwerkkabel angeschlossen.

Der Speicher ist ein QNAP NAS:

QNAP TS-1885U

10G Netzwerkkarte

(Intel Ethernet Controller 10G X550T 2x RJ45)

6x 4TB HD SVR SAS von Toshiba

Switch Netgear ProSafe XS716T

Workstations

AMD Ryzen Threadripper 1950X (16-Cores)

64 GB RAM SVR PC266 Samsung ECC

2x SSD M.2 2280 512GB PCIex4 Samsung PM981 NVMe

Netzwerkkarte Emulex OneConnect OCe14102-NT (2x RJ45)

Am QNAP Nas habe ich bei den beiden 10G Netzwerkadaptern die Jumbo Frames auf 9000 gesetzt, an der Netzwerkkarte in den Erweiterten Eigenschaften die Packet Size auf 9014. Denoch kann ich aktuell nur mit ca. 200-250MB vom QNAP auf meine SSD kopieren...

Hat jemand von euch Erfahrungen mit 10G Netzwerken und kann mir einen Tipp geben, wo mein Flaschenhals liegt?

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 515106

Url: https://administrator.de/forum/10g-netzwerk-konfigurieren-fuer-maximalen-datendurchsatz-515106.html

Ausgedruckt am: 05.08.2025 um 12:08 Uhr

43 Kommentare

Neuester Kommentar

Hi,

wie viele Workstations habt ihr? Ein Storage mit gerade mal 6 HDDs ist da schnell am Limit. Mehr wie 250MB/s würde ich da bei mehr als 3 Workstations auch nicht erwarten.

Wie immer wird uns aber der Raid Level verschwiegen. Bedenke auch, dass bereits das "stumpfe" Arbeiten auf dem Storage bereits IOs verursacht und so automatisch bremst.

Lösung: Mehr Platten ins NAS und dann Raid Level auf Rad 10 stellen.

wie viele Workstations habt ihr? Ein Storage mit gerade mal 6 HDDs ist da schnell am Limit. Mehr wie 250MB/s würde ich da bei mehr als 3 Workstations auch nicht erwarten.

Wie immer wird uns aber der Raid Level verschwiegen. Bedenke auch, dass bereits das "stumpfe" Arbeiten auf dem Storage bereits IOs verursacht und so automatisch bremst.

Lösung: Mehr Platten ins NAS und dann Raid Level auf Rad 10 stellen.

Da haben wir den Salat. Raid 5 bremst zusätzlich, da sich die Verwaltungsplatten auf alle Platten verteilen müssen wenn einer schreibt.

250MB/s sind sogar richtig gut wenn man bedenkt, dass sobald einer irgendwas schreiben will, zeitgleich alle Platten schreiben und auch noch lesen müssen.

Die Platten arbeiten nicht mit 6Gbps. Das ist nur die SAS Schnittstelle. Bottleneck sind die HDDs und der falsche Raid Level.

250MB/s sind sogar richtig gut wenn man bedenkt, dass sobald einer irgendwas schreiben will, zeitgleich alle Platten schreiben und auch noch lesen müssen.

Die Platten arbeiten nicht mit 6Gbps. Das ist nur die SAS Schnittstelle. Bottleneck sind die HDDs und der falsche Raid Level.

Zitat von @hukiman:

Okay, und das RAID Level jetzt nochmal im nachhinein zu ändern wird warscheinlich eine größere Aktion werden. Und auch vom Speicherplatz wäre es natürlich ein großer Verlust...

Was für einen Durchsatz kann ich beim RAID 10 im Vergleich zum RAID 5 erwarten?

Das NAS hat auch noch 6 Steckplätze für SSD-Festplatten frei, macht es Sinn hier Cache Speicher einzusetzen und das RAID 5 zu belassen?

Okay, und das RAID Level jetzt nochmal im nachhinein zu ändern wird warscheinlich eine größere Aktion werden. Und auch vom Speicherplatz wäre es natürlich ein großer Verlust...

Was für einen Durchsatz kann ich beim RAID 10 im Vergleich zum RAID 5 erwarten?

Das NAS hat auch noch 6 Steckplätze für SSD-Festplatten frei, macht es Sinn hier Cache Speicher einzusetzen und das RAID 5 zu belassen?

Raid umbauen ist nicht möglich. Ich würde empfehlen die Daten irgendwo zu sichern, HDDs nachkaufen und das Raid auf 10 stellen.

SSD Cache kann helfen. Ich würde aber zuerst das falsche Raid Level angehen.

Zitat von @hukiman:

Wenn ich die Workstation mit 2x RJ45 anschliesse, genügt es dann am Switch die LinkAggregation einzustellen oder muss an den Windows Einstellungen auch noch etwas angepasst werden?

Wenn ich die Workstation mit 2x RJ45 anschliesse, genügt es dann am Switch die LinkAggregation einzustellen oder muss an den Windows Einstellungen auch noch etwas angepasst werden?

Das wird dir nix bringen. Du erhälst 2 mal 10G getrennt. Sprich z.B. dein Kopiervorgang wird immer nur auf einem Adapter laufen.

Warum willst du das auch? Du kannst nichtmals 10G auslasten.

Davon abgesehen ist 10G über Kupfer eh nicht die ideale Wahl. Wie lang sind die Kabel insgesamt zum Switch? Bei 10G über RJ45 Kupfer kann die Geschwindigkeit stark schwanken.

LWL wäre hier die deutlich bessere und performantere Wahl gewesen.

Moin,

Sorry, wer macht son Mist, 10G auf Kupfer? Zu viele physikalischen Faktoren lassen grüßen...

Die Antwort hast du dir schon selbst gegeben

NAS auf SSDs am besten NVMe umstellen, dann wird das was mit dem Auslasten von 10GBit/s.

in unserem Betrieb wurde das Netzwerk auf 10G (Kupfer) umgerüstet.

Sorry, wer macht son Mist, 10G auf Kupfer? Zu viele physikalischen Faktoren lassen grüßen...

Hat jemand von euch Erfahrungen mit 10G Netzwerken und kann mir einen Tipp geben, wo mein Flaschenhals liegt?

Die Antwort hast du dir schon selbst gegeben

6x 4TB HD SVR SAS von Toshiba

NAS auf SSDs am besten NVMe umstellen, dann wird das was mit dem Auslasten von 10GBit/s.

Moin,

mit welchem Protokoll greifen denn die WS auf die NAS zu? Evtl. kannst du auf iSCSI umstellen, das hat weniger Overhead als z.B. SMB (v2)

Zu den Jumbo Frames: Jumbos bringen dir nur etwas wenn ALLE Netzwerkgeräte entsprechend konfiguriert sind, also NAS, Switch und die Workstations!

Und: Wirf mal hier: arstechnica.com/civis/viewtopic.php?t=1123534 einen Blick rein, da wurde das Thema schon ausführlich und fachkundig diskutiert.

/EDIT:

lg,

Slainte

mit welchem Protokoll greifen denn die WS auf die NAS zu? Evtl. kannst du auf iSCSI umstellen, das hat weniger Overhead als z.B. SMB (v2)

Zu den Jumbo Frames: Jumbos bringen dir nur etwas wenn ALLE Netzwerkgeräte entsprechend konfiguriert sind, also NAS, Switch und die Workstations!

Und: Wirf mal hier: arstechnica.com/civis/viewtopic.php?t=1123534 einen Blick rein, da wurde das Thema schon ausführlich und fachkundig diskutiert.

/EDIT:

Das wird dir nix bringen. Du erhälst 2 mal 10G getrennt. Sprich z.B. dein Kopiervorgang wird immer nur auf einem Adapter laufen.

Das stimmt nur, wenn SMBv2 verwendet wird, via iSCSI kann man z.B: MPIO verwenden.lg,

Slainte

Also die Umstellung auf Raid 10 werdet ihr sicher schon merken. SSD Write/Cash würde ich mit 2*1TB SSDs ansetzen. Readonly geht auch nur mit einer SSD aber wenn man da eh schon drann ist, würde ich RW Cash bevorzugen und ja, bringt ne Menge.

Aber mal was anderes: Habt ihr überhaupt Performance Probleme? Ich meine klar, das Storage ist falsch eingerichtet, Kupfer ist die falsche Wahl aber dauert irgendetwas zu lange?

Bin jetzt auch kein CAD Experte, aber da spielt sich doch eh viel im RAM ab. Meine CAD Clients machen zu 90% alles lokal auf ihren SSDs und schieben das ganze dann erst am Ende irgendwohin.

Bringt ja nix wenn du da jetzt nur wegen einer schwachen Samba Performance upgradest, obwohl ja alles läuft. Oder ist der finale "Kopier Vorgang" dir einfach zu träge?

Immer den Invest mit dem Nutzen vergleichen.

Aber mal was anderes: Habt ihr überhaupt Performance Probleme? Ich meine klar, das Storage ist falsch eingerichtet, Kupfer ist die falsche Wahl aber dauert irgendetwas zu lange?

Bin jetzt auch kein CAD Experte, aber da spielt sich doch eh viel im RAM ab. Meine CAD Clients machen zu 90% alles lokal auf ihren SSDs und schieben das ganze dann erst am Ende irgendwohin.

Bringt ja nix wenn du da jetzt nur wegen einer schwachen Samba Performance upgradest, obwohl ja alles läuft. Oder ist der finale "Kopier Vorgang" dir einfach zu träge?

Immer den Invest mit dem Nutzen vergleichen.

Du kannst dir im Storage vermutlich auch irgendwo die aktuellen IOs und IO Waittimes / Latenzen / Wartezeiten anschauen. Dann weißt du mehr.

Aber das klingt für mich wirklich einfach dem Raid 5. Wenn zwei Rechner da drauf schreiben wird das vermutlich schon langsam.

Trotzdem nochmal zum Netzwerk: Wie lang sind die Kabelstrecken? 10G über Kupfer ist seeehr empfindlich. Ein schlechtes Patchkabel dazwischen und schon hast du wieder nur 1G.

Aber das klingt für mich wirklich einfach dem Raid 5. Wenn zwei Rechner da drauf schreiben wird das vermutlich schon langsam.

Trotzdem nochmal zum Netzwerk: Wie lang sind die Kabelstrecken? 10G über Kupfer ist seeehr empfindlich. Ein schlechtes Patchkabel dazwischen und schon hast du wieder nur 1G.

Zitat von @hukiman:

Hallo Slainte,

danke für den Link, demnach bringt es also doch etwas 2 Ports zu werden an der Workstation... Dort wurde auch SMB verwendet für durchsätze von fast 1,5GB/s, dass wäre schonmal ein großer Schritt in die richtige Richtung...

Hallo Slainte,

danke für den Link, demnach bringt es also doch etwas 2 Ports zu werden an der Workstation... Dort wurde auch SMB verwendet für durchsätze von fast 1,5GB/s, dass wäre schonmal ein großer Schritt in die richtige Richtung...

Eine Protokollumstellung wird nach deinen Screens auch nichts bringen. Also nichts spürbares. Wir reden hier vielleicht über 10MB/s Gewinn.

Im Idealfall volle 10G. Iwas zwischen 800MB/s-1GB/s. Da könnte dann halt das Protokoll wirklich einen Unterschied machen. Ich halte SMB für euren Zweck aber mal für ausreichend.

Falls noch nicht geschehen, konfiguriere dir bitte bei der Raid Neu Konfig dann auch eine Hot Spare Platte rein. Kannst du die Daten nicht irgendwo zwischenparken und das umkonfigurieren? Zur Not auf nen paar externen HDDs. Oder backupen und restoren...

Dann kannst du das testen bevor du Neukaufst.

Falls noch nicht geschehen, konfiguriere dir bitte bei der Raid Neu Konfig dann auch eine Hot Spare Platte rein. Kannst du die Daten nicht irgendwo zwischenparken und das umkonfigurieren? Zur Not auf nen paar externen HDDs. Oder backupen und restoren...

Dann kannst du das testen bevor du Neukaufst.

Moin,

was genau für ein Typ sind denn die HDDs?

Ich nehme mal Seagate Exos 7E8 4 TB SAS als Vergleich.

Die schaffen laut Hersteller 215 MB/Sek.

Die CPU im NAS hat viel Leistung, als würde ich bei R5 Datenraten bis 400 MB/Sek erwarten.

Das erreich Festplatten aber nur beim sequentiellem Lesen und Schreiben. Und R5 ist beim schreiben langsammer als lesen.

Thin bedeutet beim NAS aber eine hohe fragmentierung.

Auch der gleichzeitige Zugriff von nur 2 Personen reduziert die Datenrate sehr deutlich.

Auch kann das Netzwerk natürlich noch ein Problem sein.

Wurde das Netzwerk nach dem Update auf 10G mal gemessen?

Also mit einem richtigem Netzwerkmeßgerät? Besonders Kupfer und 10G ist sehr anfällig und wird meist nur für Längen unter 10m verwendet.

1. Netzwerk messen/testen

Zum testen kannst mal netio (nwlab.net/art/netio/netio.html) verwenden um die Geschwindigkeit zwischen verschiedenen PCs zu messen. Egal was das NAS kann, mehr kommt nicht an.

2. SSD zum testen

Bau einfach mal eine einfache SSD im NAS ein und lege diese als altes normales Volumen an.

Dann schaue welche Datenraten Du damit erreichst. Dann weist Du die Differenz zu den HDDs im R5.

Planung

Ja, SSD in der Größenordnung sind teuer.

Du könnst vieleicht 2x 1-2 TB Enterprise SSD einbauen und als Schreibt- und Lese-Cache definieren.

Stefan

was genau für ein Typ sind denn die HDDs?

Ich nehme mal Seagate Exos 7E8 4 TB SAS als Vergleich.

Die schaffen laut Hersteller 215 MB/Sek.

Die CPU im NAS hat viel Leistung, als würde ich bei R5 Datenraten bis 400 MB/Sek erwarten.

Das erreich Festplatten aber nur beim sequentiellem Lesen und Schreiben. Und R5 ist beim schreiben langsammer als lesen.

Thin bedeutet beim NAS aber eine hohe fragmentierung.

Auch der gleichzeitige Zugriff von nur 2 Personen reduziert die Datenrate sehr deutlich.

Auch kann das Netzwerk natürlich noch ein Problem sein.

Wurde das Netzwerk nach dem Update auf 10G mal gemessen?

Also mit einem richtigem Netzwerkmeßgerät? Besonders Kupfer und 10G ist sehr anfällig und wird meist nur für Längen unter 10m verwendet.

1. Netzwerk messen/testen

Zum testen kannst mal netio (nwlab.net/art/netio/netio.html) verwenden um die Geschwindigkeit zwischen verschiedenen PCs zu messen. Egal was das NAS kann, mehr kommt nicht an.

2. SSD zum testen

Bau einfach mal eine einfache SSD im NAS ein und lege diese als altes normales Volumen an.

Dann schaue welche Datenraten Du damit erreichst. Dann weist Du die Differenz zu den HDDs im R5.

Planung

Ja, SSD in der Größenordnung sind teuer.

Du könnst vieleicht 2x 1-2 TB Enterprise SSD einbauen und als Schreibt- und Lese-Cache definieren.

Stefan

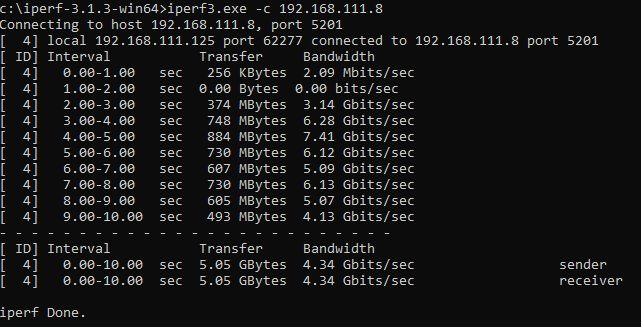

was die Kollegen sagen bzgl RAID ist zwar richtig, aber bevor du jetzt Geld in die Hand nimmst, solltest du erst mal testen ob die Netzwerkverbindungen überhaupt auf 10GBit kommen.

Wenn du da z.B schon nur 3 GBit hast, dann können deine Platten liefern was sie wollen.

Für Netzwerktests kannst du auf der qnap iperf nehmen.

Wenn das passt, dann testest du mal die tatsächliche CIFS Geschwindigkeit mit FIO

Wenn du da z.B schon nur 3 GBit hast, dann können deine Platten liefern was sie wollen.

Für Netzwerktests kannst du auf der qnap iperf nehmen.

Wenn das passt, dann testest du mal die tatsächliche CIFS Geschwindigkeit mit FIO

Zitat von @SeaStorm:

was die Kollegen sagen bzgl RAID ist zwar richtig, aber bevor du jetzt Geld in die Hand nimmst, solltest du erst mal testen ob die Netzwerkverbindungen überhaupt auf 10GBit kommen.

Wenn du da z.B schon nur 3 GBit hast, dann können deine Platten liefern was sie wollen.

Für Netzwerktests kannst du auf der qnap iperf nehmen.

Wenn das passt, dann testest du mal die tatsächliche CIFS Geschwindigkeit mit FIO

was die Kollegen sagen bzgl RAID ist zwar richtig, aber bevor du jetzt Geld in die Hand nimmst, solltest du erst mal testen ob die Netzwerkverbindungen überhaupt auf 10GBit kommen.

Wenn du da z.B schon nur 3 GBit hast, dann können deine Platten liefern was sie wollen.

Für Netzwerktests kannst du auf der qnap iperf nehmen.

Wenn das passt, dann testest du mal die tatsächliche CIFS Geschwindigkeit mit FIO

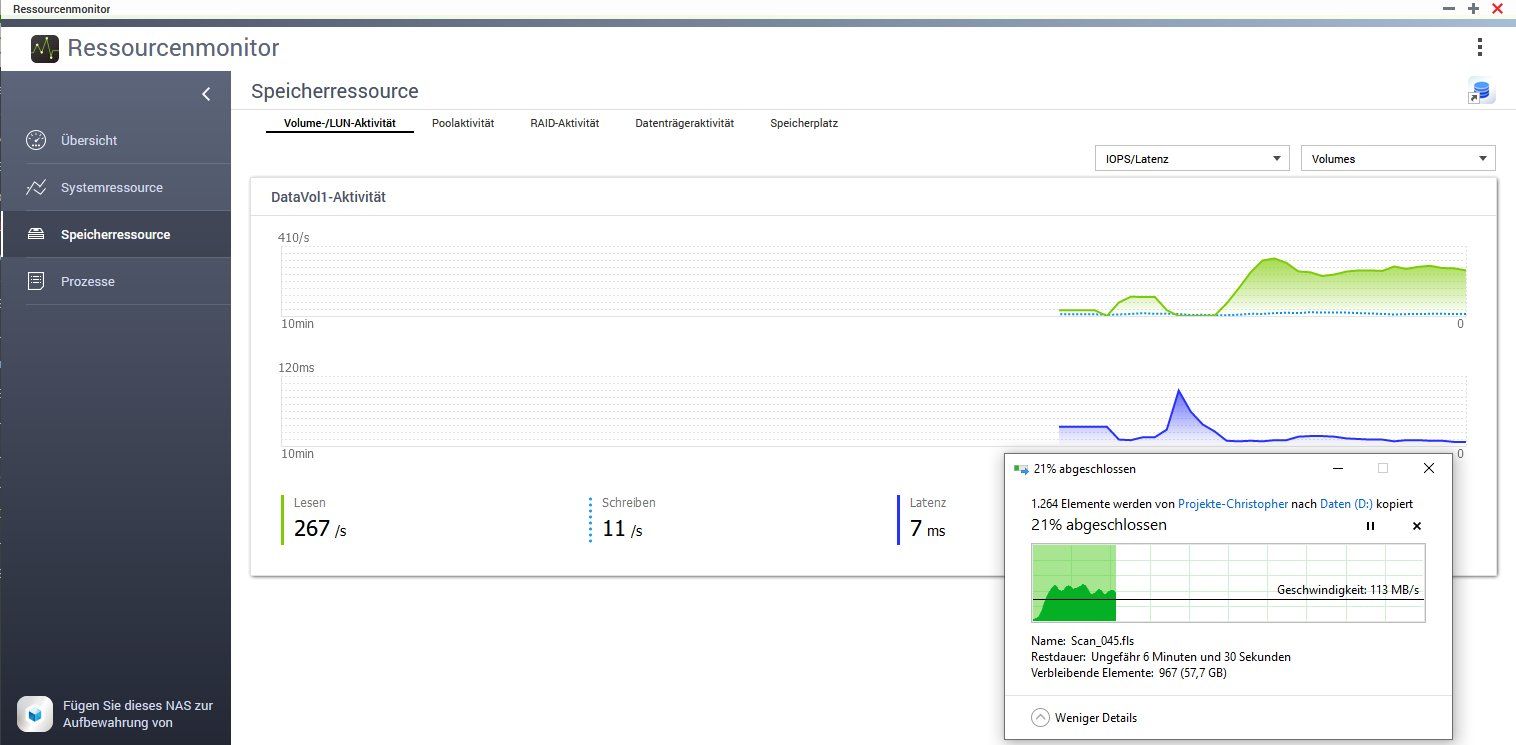

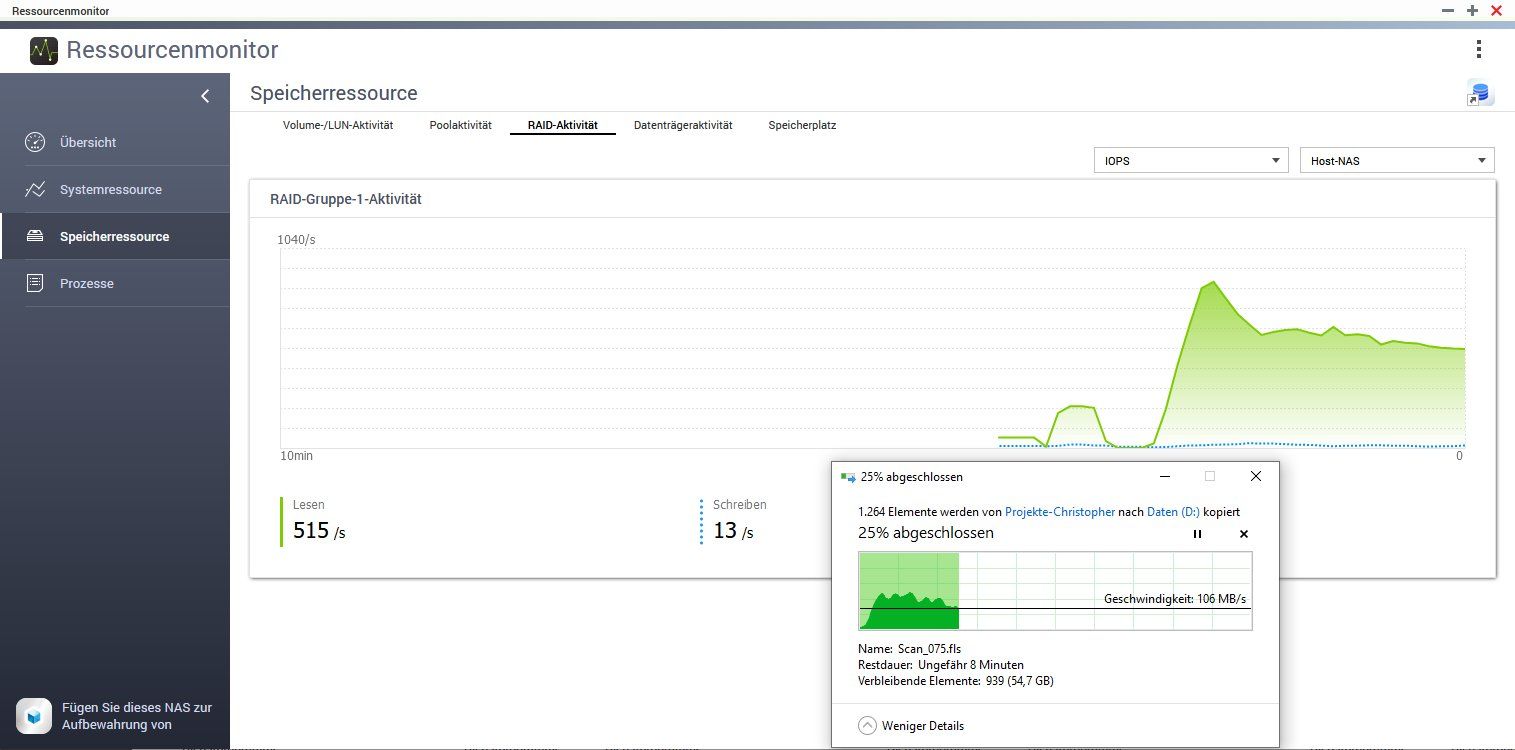

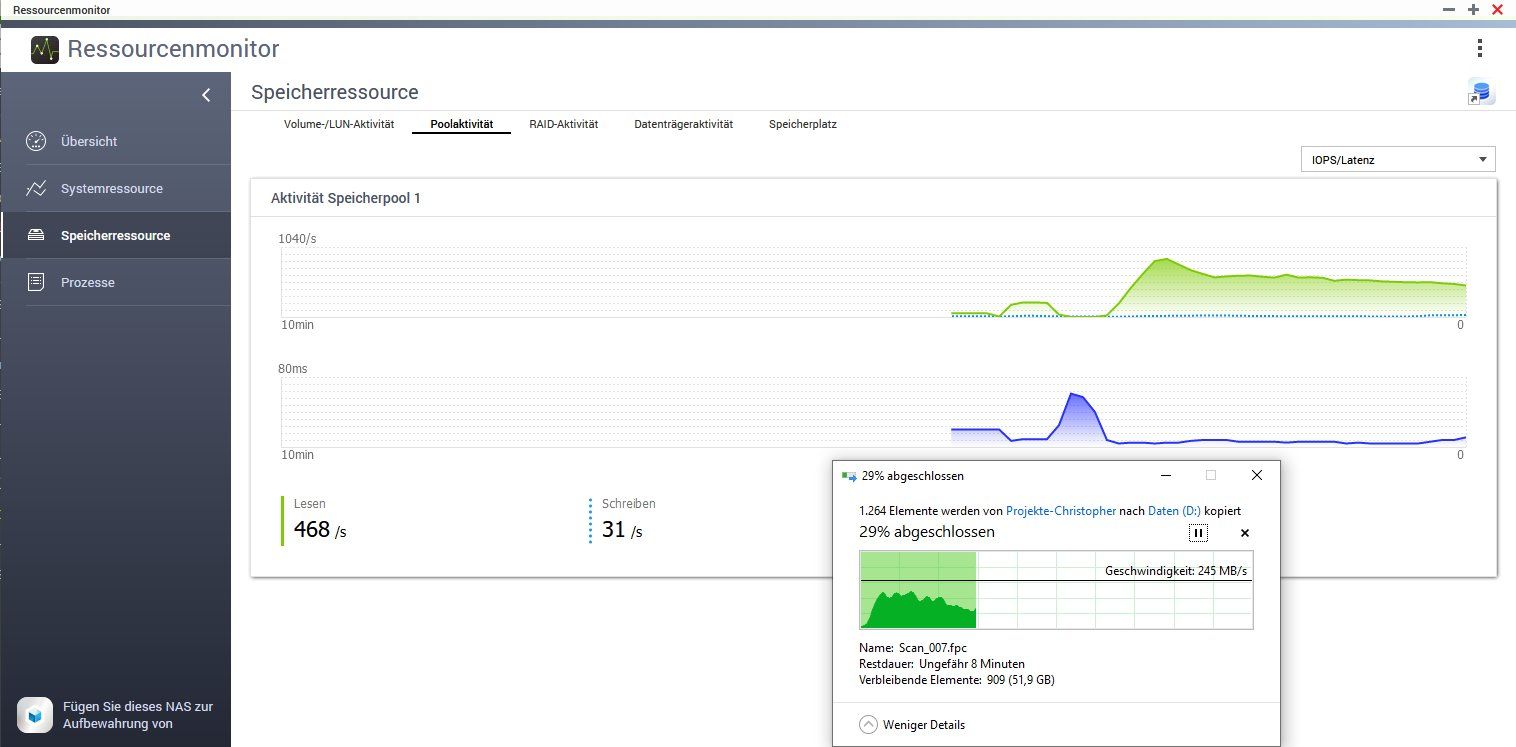

Hatte ich ja auch schon geschrieben. Du siehst aber schon das dem NAS die Puste ausgeht. Sobald zu den Schreibenden IOPs noch lesende dazu kommen bricht der Speed auf 100MB/s ein. Das ist ziemlich typisch. Ich tippe auch auf viele kleine Files. Hier könnte SSD Caching natürlich enorm helfen.

Zitat von @hukiman:

Habe eben das iperf laufen lassen...

Die Werte können sich sehen lassen würde ich sagen

Warum? Weil du nur knapp 5GBit/s erreichst?Habe eben das iperf laufen lassen...

Die Werte können sich sehen lassen würde ich sagen

Aber zumindest kann man mal sagen, das die Kiste etwas mehr so im Bereich 400-450MB/s erreichen sollte, was die Netzwerkgeschwindigkeit angeht.

Mein nächster Versuch wäre jetzt, da mal eine (SAS)SSD rein zu hängen und zu gucken ob es von der aus schneller geht. Wenn ja, darf man davon ausgehen, das die HDDs nicht genügend Power haben

Hallo,

Du kannst dafür ein Twinax-Kabel verwenden.

Dann spart man sich die SPF+-Adapter.

Ja, das funktioniert so.

Du musst der Verbindung zum NAS nur einen anderen IP-Adressbereich geben.

Also z.B. 192.168.0.0/24 für das normale LAN und 192.168.1.0/24 für die 10G-Karte im PC und SPF+ im NAS.

Oder ein kleiner 10G Switch

Viele Grüße

Stefan

Du kannst dafür ein Twinax-Kabel verwenden.

Dann spart man sich die SPF+-Adapter.

Ja, das funktioniert so.

Du musst der Verbindung zum NAS nur einen anderen IP-Adressbereich geben.

Also z.B. 192.168.0.0/24 für das normale LAN und 192.168.1.0/24 für die 10G-Karte im PC und SPF+ im NAS.

Oder ein kleiner 10G Switch

Viele Grüße

Stefan

Switch Netgear ProSafe XS716T

Der ist auch schon ein Problem per se aber 70% Last sollten seine Ports schon können. Performancetechnisch sind solche Billigswitches generell keine gute Wahl wenn es um Durchsatz geht.Ganz wichtig ist hier das du Jumbo Framing auf ALLEN Ports aktivierst an diesem Switch und auf den maximal möglichen Wert einstellst !

Ist nur die Frage ob Read-Intensive SSDs für deine Anwendung die richtigen sind. Statt dir über die RAID5 Performance Gedanken zu machen solltest du dir erstmal die Unterschiede der SSD Typen und die Bedeutung für unterschiedliche Anwendungsfälle erarbeiten.

/Thomas

Oder würdet ihr bei SATA Platten bleiben um die Kosten im Rahmen zu halten?

Soll's jetzt schnell sein, oder billig? Die SATA Platten bringen die IOPS nicht die du für 10G und mehren Hosts brauchst.RAID5 ist ungeeignet für SSD, wg. der erhöhten Schreibbelastung. RAID1 oder 10 ist da um längen besser (und auch schneller). Meine Empfehlung währen 4SSDs im RAID10 plus eine als Hotspare.

Zitat von @hukiman:

okay alles klar. Ja, wenn ich die 10G nur mit SAS Platten erreiche steht SATA ja außer Frage

okay alles klar. Ja, wenn ich die 10G nur mit SAS Platten erreiche steht SATA ja außer Frage

Nichtmal mit SAS-Platten erreichst du die 10GBit/s, Physik und Mechanik lassen grüßen. Gibs auf, nimm endlich NVMe-SSDs und gut ist ;)