Collapsed-Core-Architektur und Storage Traffic

Hallo allerseits.

Mich beschäftig eine Frage.

Im Labor ist eine Collapsed-Core Architektur vorhanden.

Am Core Switch(Ein Nexus 5548) sind alle HV und FileSrv Nodes angebunden. 3 HV Nodes und 2 FileSrv Nodes.

Da komme ich auf 10 Ports über die der Storage-Traffic mit RDMA drüber läuft.

Dann sind auf dem Core Switch auch noch 6 Ports für die Virtuellen Maschinen besetzt.

Meine Frage lautet: Ist es Sinnvoll, für den Storage Traffic einen separaten Switch zu verwenden um den Core zu entlasten?

Ist der Nexus dafür ausgelegt, Storage Traffic, Server und Client Traffic zu bewältigen?

Beispielsweise einen Mellanox Switch?

Grüße!

Mich beschäftig eine Frage.

Im Labor ist eine Collapsed-Core Architektur vorhanden.

Am Core Switch(Ein Nexus 5548) sind alle HV und FileSrv Nodes angebunden. 3 HV Nodes und 2 FileSrv Nodes.

Da komme ich auf 10 Ports über die der Storage-Traffic mit RDMA drüber läuft.

Dann sind auf dem Core Switch auch noch 6 Ports für die Virtuellen Maschinen besetzt.

Meine Frage lautet: Ist es Sinnvoll, für den Storage Traffic einen separaten Switch zu verwenden um den Core zu entlasten?

Ist der Nexus dafür ausgelegt, Storage Traffic, Server und Client Traffic zu bewältigen?

Beispielsweise einen Mellanox Switch?

Grüße!

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 3189345820

Url: https://administrator.de/forum/collapsed-core-architektur-und-storage-traffic-3189345820.html

Ausgedruckt am: 15.07.2025 um 07:07 Uhr

10 Kommentare

Neuester Kommentar

Hätten die dedizierten Storages Switches denn Vorteile gegenüber dem Konvergierten?

Damit war jetzt nicht gemeint ob es redundante Pfade gibt, sondern ob die Hardware besondere Latenzen oder Protokolle bietet.

Das zwei Switches bessert sind als ein Switch liegt auf der Hand.

Das zwei Switches bessert sind als ein Switch liegt auf der Hand.

Hallo,

wir betreiben an einem Nexus 5548 ein All-Flash Array per iSCSi,7 ESX Server mit ca 200 VMs, 6 XenServer mit 90 VDIs und ein paar Etagen Switche.

Durchsatz ist da absolut kein Problem! Das Ding ist jedoch nächstes Jahr EOL.

Laut WhitePaper schafft die Switch/Backplane 960 Gbps:

cisco.com/c/en/us/products/collateral/switches/nexus-5548p-switc ...

Hast du Probleme festgestellt und tippst hier auf den Flaschenhals?

Gruß

wir betreiben an einem Nexus 5548 ein All-Flash Array per iSCSi,7 ESX Server mit ca 200 VMs, 6 XenServer mit 90 VDIs und ein paar Etagen Switche.

Durchsatz ist da absolut kein Problem! Das Ding ist jedoch nächstes Jahr EOL.

Laut WhitePaper schafft die Switch/Backplane 960 Gbps:

cisco.com/c/en/us/products/collateral/switches/nexus-5548p-switc ...

Hast du Probleme festgestellt und tippst hier auf den Flaschenhals?

Gruß

Hi,

ich betreue die Nexus im Rahmen meiner normalen IT-Tätigkeiten und bin kein Cisco/Netzwerk-Spezialist. Kann mich aber noch an die Implementation vor ca 8 Jahren erinnern, wo ähnliche Fragen aufkamen...

(Bitte dringend korrigieren falls nun hier Fehlinformationen entstehen!!!)

Sofern der Storage Traffic auf einem eigenen Port geswitched wird, spielt QoS keine Rolle.

Wir haben zudem noch eine Nexus 9300 mit gleichen Hosts / Systemen. Messbarer Durchsatz und Antwortzeiten sind absolut identisch. Ich kann mir nicht vorstellen, dass hier der Switch der Flaschenhals ist.

Falls doch, wird es am 10G liegen und nicht dem Modell. D.h. du müsstest zu 25G oder 40G greifen.

Viel Erfolg.

Gruß

ich betreue die Nexus im Rahmen meiner normalen IT-Tätigkeiten und bin kein Cisco/Netzwerk-Spezialist. Kann mich aber noch an die Implementation vor ca 8 Jahren erinnern, wo ähnliche Fragen aufkamen...

(Bitte dringend korrigieren falls nun hier Fehlinformationen entstehen!!!)

Sofern der Storage Traffic auf einem eigenen Port geswitched wird, spielt QoS keine Rolle.

Wir haben zudem noch eine Nexus 9300 mit gleichen Hosts / Systemen. Messbarer Durchsatz und Antwortzeiten sind absolut identisch. Ich kann mir nicht vorstellen, dass hier der Switch der Flaschenhals ist.

Falls doch, wird es am 10G liegen und nicht dem Modell. D.h. du müsstest zu 25G oder 40G greifen.

Viel Erfolg.

Gruß

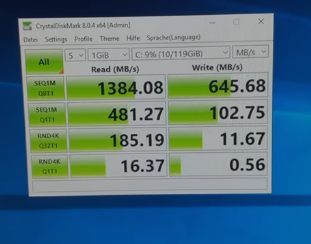

Untersuche das ganze Mal mit dem IOMeter Stück für Stück.

Queu Depth usw ist alles optimal?

Queu Depth usw ist alles optimal?