Debian 10: Arbeitsspeicher läuft langsam voll

Hi,

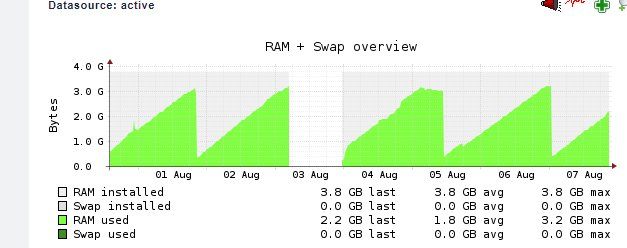

seit meiner Neuinstallation von Debian 10 auf eine neue SSD habe ich das Problem, dass mein RAM langsam aber sicher vollläuft. Das geht dann soweit, dass er dann via SSH nicht mehr erreichbar ist und auch die Konsole nur noch sehr verzögert auf Eingaben reagiert. Anmelden kann dann gerne mal 10 Sekunden dauern. Begrüßt werde ich dann dort mit einer entsprechenden Zeile:

plumbr.io/blog/memory-leaks/out-of-memory-kill-process-or-sacrif ... - bei mir ist's immer MySQL - allerdings wird es dadurch auch nicht besser, nach meinem Verständnis hat er den Prozess dann schon gekillt oder er scheitert daran.

Auf dem Server läuft:

- Routing (Transfernetz zur FRITZ!Box)

- OpenVPN-Server und -Clients für Standortverbindungen und Remotezugriff

- Nextcloud + MariaDB

- Dnsmasq

- FreeRADIUS

Ich bin jetzt schon hingegangen und habe o.g. Dienste mal beendet und geschaut was passiert - leider wächst die Auslastung weiter.

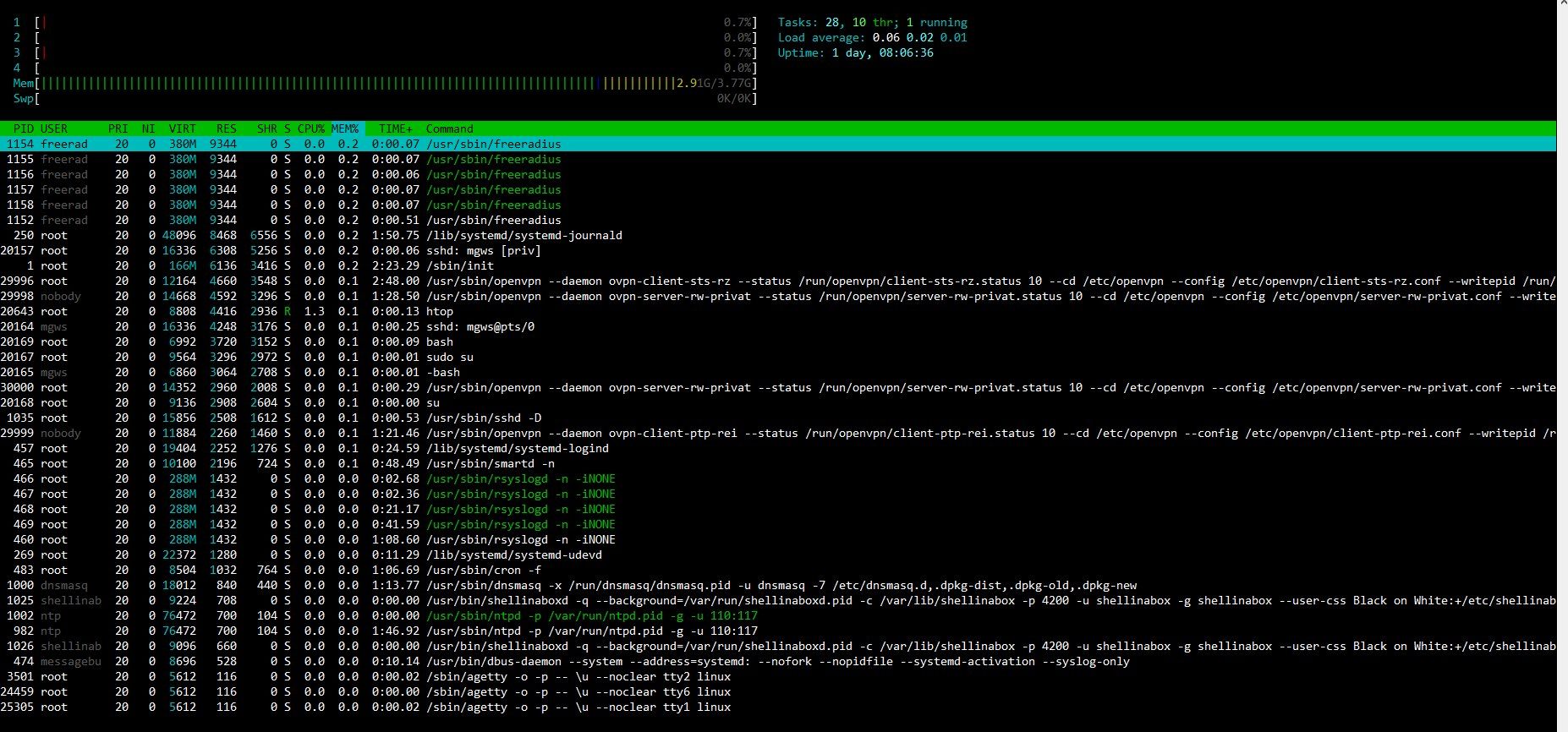

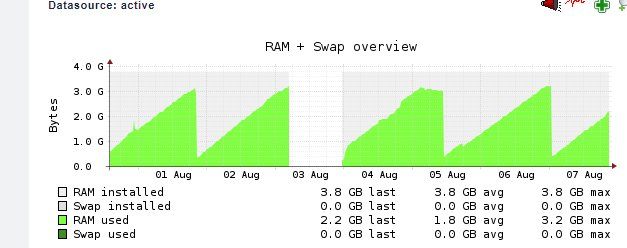

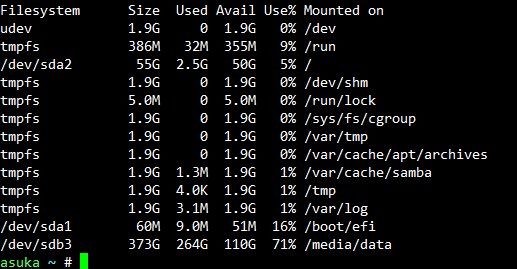

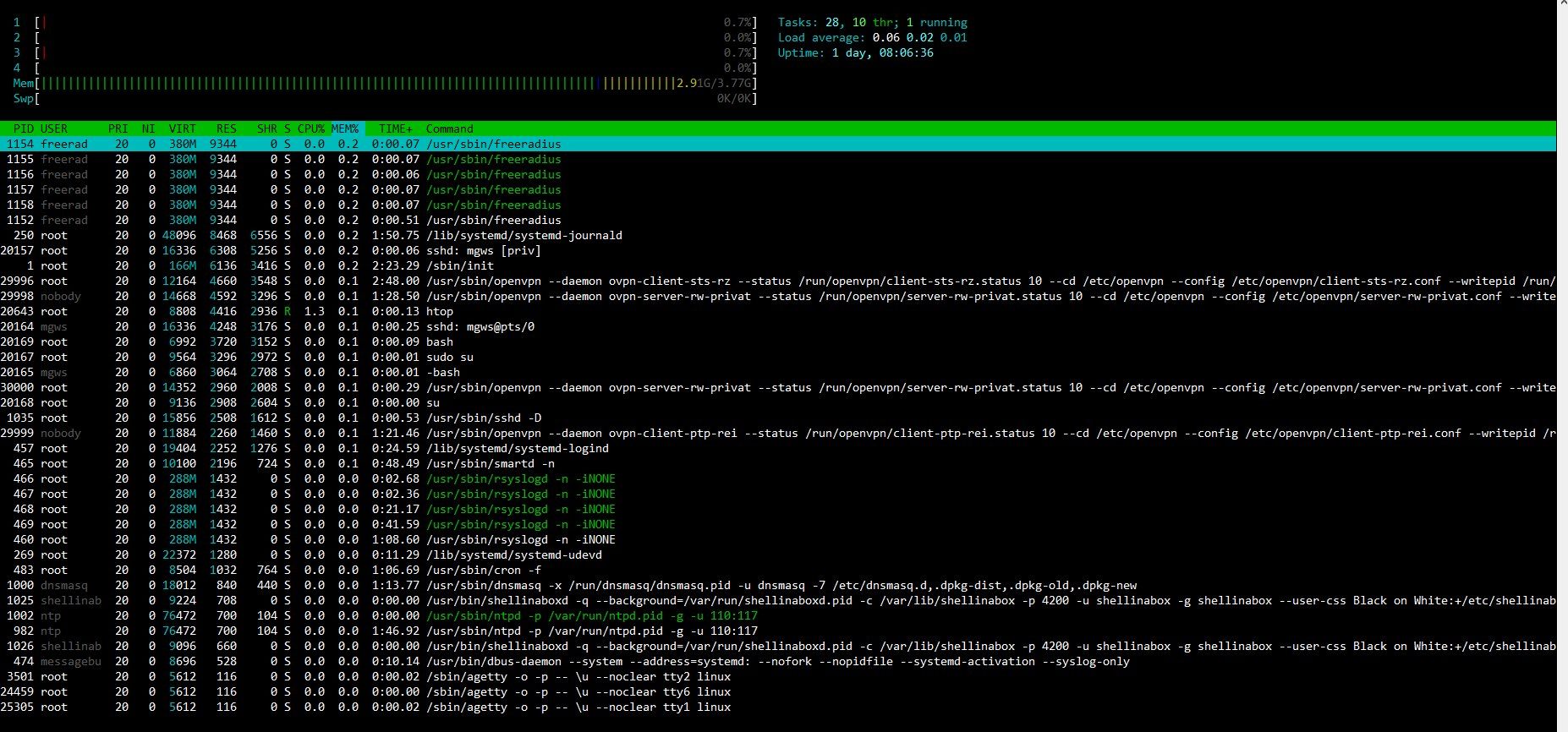

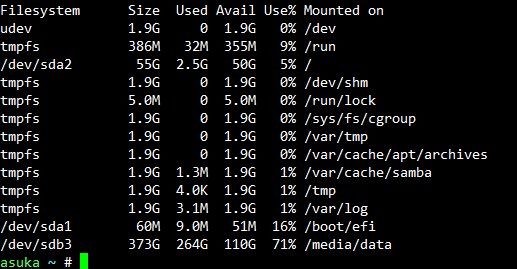

Im HTOP sehe ich nur eine hohe Auslastung oben, aber keinen Prozess mit einer hohen Auslastung. TMPFSs habe ich einige, auch hier ist via df -h aber alles mit wenigen MB belegt. Gleichen Aufbau hatte ich unter Deb 9 auch.

Ansätze, wie ich das Problem weiter eingrenzen oder gar beheben kann? Meiner Meinung bleibt nur die SSD oder irgendwas "systemiges" von Debian 10 in Frage..

Sofern wichtig: SSD ist eine 60GB von KingDian

seit meiner Neuinstallation von Debian 10 auf eine neue SSD habe ich das Problem, dass mein RAM langsam aber sicher vollläuft. Das geht dann soweit, dass er dann via SSH nicht mehr erreichbar ist und auch die Konsole nur noch sehr verzögert auf Eingaben reagiert. Anmelden kann dann gerne mal 10 Sekunden dauern. Begrüßt werde ich dann dort mit einer entsprechenden Zeile:

plumbr.io/blog/memory-leaks/out-of-memory-kill-process-or-sacrif ... - bei mir ist's immer MySQL - allerdings wird es dadurch auch nicht besser, nach meinem Verständnis hat er den Prozess dann schon gekillt oder er scheitert daran.

Auf dem Server läuft:

- Routing (Transfernetz zur FRITZ!Box)

- OpenVPN-Server und -Clients für Standortverbindungen und Remotezugriff

- Nextcloud + MariaDB

- Dnsmasq

- FreeRADIUS

Ich bin jetzt schon hingegangen und habe o.g. Dienste mal beendet und geschaut was passiert - leider wächst die Auslastung weiter.

Im HTOP sehe ich nur eine hohe Auslastung oben, aber keinen Prozess mit einer hohen Auslastung. TMPFSs habe ich einige, auch hier ist via df -h aber alles mit wenigen MB belegt. Gleichen Aufbau hatte ich unter Deb 9 auch.

Ansätze, wie ich das Problem weiter eingrenzen oder gar beheben kann? Meiner Meinung bleibt nur die SSD oder irgendwas "systemiges" von Debian 10 in Frage..

Sofern wichtig: SSD ist eine 60GB von KingDian

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 482567

Url: https://administrator.de/forum/debian-10-arbeitsspeicher-laeuft-langsam-voll-482567.html

Ausgedruckt am: 02.08.2025 um 11:08 Uhr

9 Kommentare

Neuester Kommentar

Moin,

Daß RAm unter linux bis zum "Anschlag" genutzt wird, ist normal. Alles was nciht durch Prozesse benötigt wird, wird als cache genutzt, sofern es benötige wird. Bei mir z.B.

Wie sieht denn "free" bei Dir aus?

Nach dem load zu urteilen tut sich bei Dir eigentlich nicht viel. Und 4GB sind halt nicht mehr "zeitgemäß". Die sind halt sehr schnell durch cache und Puffer aufgebraucht.

lks

Daß RAm unter linux bis zum "Anschlag" genutzt wird, ist normal. Alles was nciht durch Prozesse benötigt wird, wird als cache genutzt, sofern es benötige wird. Bei mir z.B.

~$ free

Gesamt belegt frei gemns. Puffer/Cache verfügbar

Speicher: 32927960 7521028 973472 223328 24433460 23899676

Auslagerungsspeicher: 33538044 1254836 32283208

Wie sieht denn "free" bei Dir aus?

Nach dem load zu urteilen tut sich bei Dir eigentlich nicht viel. Und 4GB sind halt nicht mehr "zeitgemäß". Die sind halt sehr schnell durch cache und Puffer aufgebraucht.

lks

Hallo 01Bear,

grundsätzlich seh ich das anders als @Lochkartenstanzer, 4GB sollten für die Anwendung (solange keine nnn User) locker reichen und selbst wenn sollte dass das System nicht so aufblähen, dass du dich nichtmal mehr einloggen kannst. Da ist anderes im argen. Daher, schonmal auf Schadsoftware oder Miskonfiguration gecheckt? (MariaDB auf 200% des nutzbaren Rams o-ä?)

Viele Grüße,

Christian

certifiedit.net

grundsätzlich seh ich das anders als @Lochkartenstanzer, 4GB sollten für die Anwendung (solange keine nnn User) locker reichen und selbst wenn sollte dass das System nicht so aufblähen, dass du dich nichtmal mehr einloggen kannst. Da ist anderes im argen. Daher, schonmal auf Schadsoftware oder Miskonfiguration gecheckt? (MariaDB auf 200% des nutzbaren Rams o-ä?)

Viele Grüße,

Christian

certifiedit.net