DPM2019 mit MBS und Refs wird immer langsamer !

Hallo zusammen,

ich habe hier einen Backup-Server mit Server 2019 Std. .

Darauf läuft seit neuem DPM2019 und ich habe testweise das soooo angeprisene MBS direkt mal getestet und ein ReFs Speicherpool laut Anleitung

Hinzufügen von Modern Backup Storage zu DPM

erstellt.

Es sollen hier "lediglich" etwa knapp 4TB an Daten kurzfristig tgl. gesichert werden und dann später langfristig auf BAND (LTO6 / LTO7).

Alles in Allem ist mein Problem eigentlich ganz schnell erklärt:

1. die Erstellung des Replikates dauerte auf dem ReFs Volume um Welten länger als auf einem popeligen NTFS Volume, welches ich vorher in Versionen unter DPM2019 hatte

2. seit ich ReFs einsetze ist der ganze Server sowas von am Kriechen

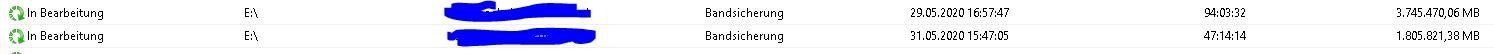

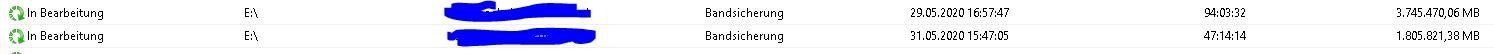

3. die Sicherung aufs Band über eine reine 10GB FibreChanel Karte ist auf Diskette schneller (seit 95h sichert er noch immer eine Sicherung aufs Band) die Daten holt er sich ja vom ReFs Volume.

(siehe Bild).

Das kann ich echt nciht glauben und es berichten so einige über das Phänomen.

Gibt es da etwas zu Schrauben oder muss ich noch irgendetwas beachten ?

Gruß

Enrico

ich habe hier einen Backup-Server mit Server 2019 Std. .

Darauf läuft seit neuem DPM2019 und ich habe testweise das soooo angeprisene MBS direkt mal getestet und ein ReFs Speicherpool laut Anleitung

Hinzufügen von Modern Backup Storage zu DPM

erstellt.

Es sollen hier "lediglich" etwa knapp 4TB an Daten kurzfristig tgl. gesichert werden und dann später langfristig auf BAND (LTO6 / LTO7).

Alles in Allem ist mein Problem eigentlich ganz schnell erklärt:

1. die Erstellung des Replikates dauerte auf dem ReFs Volume um Welten länger als auf einem popeligen NTFS Volume, welches ich vorher in Versionen unter DPM2019 hatte

2. seit ich ReFs einsetze ist der ganze Server sowas von am Kriechen

3. die Sicherung aufs Band über eine reine 10GB FibreChanel Karte ist auf Diskette schneller (seit 95h sichert er noch immer eine Sicherung aufs Band) die Daten holt er sich ja vom ReFs Volume.

(siehe Bild).

Das kann ich echt nciht glauben und es berichten so einige über das Phänomen.

Gibt es da etwas zu Schrauben oder muss ich noch irgendetwas beachten ?

Gruß

Enrico

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 576281

Url: https://administrator.de/forum/dpm2019-mit-mbs-und-refs-wird-immer-langsamer-576281.html

Ausgedruckt am: 05.07.2025 um 13:07 Uhr

17 Kommentare

Neuester Kommentar

N'Abend.

Ja, da glänzt MS nicht wirklich, der DPM war schon immer eher das "Stiefkind", was die (Weiter-)Entwicklung angeht.

Ich habe mir hiermit beholfen:

charbelnemnom.com/2016/10/how-to-reduce-dpm-2016-storage-consump ...

Den Teil für DeDup weglassen und nur den Weg nachvollziehen, wie er die Speicherpools für DPM anlegt. Das hat den Performance-Knoten mit ReFS zum einen Teil gelöst. Der andere Teil war (und ist) die brachiale Aufstockung des RAMs auf dem DPM-Server (2016 lief mit 16GB, 2019 erst mal 128GB halbwegs rund).

Und dann gibt's da noch nen lesenswerten Thread im TechNet:

social.technet.microsoft.com/Forums/en-US/7e4e4da4-1168-46cd-900 ...

Cheers,

jsysde

Ja, da glänzt MS nicht wirklich, der DPM war schon immer eher das "Stiefkind", was die (Weiter-)Entwicklung angeht.

Ich habe mir hiermit beholfen:

charbelnemnom.com/2016/10/how-to-reduce-dpm-2016-storage-consump ...

Den Teil für DeDup weglassen und nur den Weg nachvollziehen, wie er die Speicherpools für DPM anlegt. Das hat den Performance-Knoten mit ReFS zum einen Teil gelöst. Der andere Teil war (und ist) die brachiale Aufstockung des RAMs auf dem DPM-Server (2016 lief mit 16GB, 2019 erst mal 128GB halbwegs rund).

Und dann gibt's da noch nen lesenswerten Thread im TechNet:

social.technet.microsoft.com/Forums/en-US/7e4e4da4-1168-46cd-900 ...

Cheers,

jsysde

N'Abend.

Ich wünsche viel Erfolg - und starke Nerven....

Cheers,

jsysde

Zitat von @eb1980:

[...]Des weiteren lässt sich der Code von der Seite nicht kopieren...voll ärgerlich.

Jupp. Nervt. Pro-Tipp: Quelltext der Seite anzeigen lassen.... [...]Des weiteren lässt sich der Code von der Seite nicht kopieren...voll ärgerlich.

[...]Meinst Du das klappt auch auf einer physischen Maschine so ?

Tut es. Der oben beschriebene DPM war (oder ist noch? Ich arbeite nicht mehr in dem Unternehmen) auch eine physikalische (da hing auch gleich die Tape Library dran).Ich wünsche viel Erfolg - und starke Nerven....

Cheers,

jsysde

Mahlzeit.

Wie viel RAM hat dein DPM-Server?

S. mein Post weiter oben - ich musste von 16GB auf 128GB raufgehen, damit ReFS einigermaßen mitgespielt hat.

Hast du dir die möglichen Paramter und Registry-Settings aus dem TechNet-Artikel angeschaut?

Ich weiß, das ist ne Menge Arbeit und viel Trial-and-Error - aber leider der einzige Weg (wenn du bei DPM bleiben willst).

Cheers,

jsysde

Wie viel RAM hat dein DPM-Server?

S. mein Post weiter oben - ich musste von 16GB auf 128GB raufgehen, damit ReFS einigermaßen mitgespielt hat.

Hast du dir die möglichen Paramter und Registry-Settings aus dem TechNet-Artikel angeschaut?

Ich weiß, das ist ne Menge Arbeit und viel Trial-and-Error - aber leider der einzige Weg (wenn du bei DPM bleiben willst).

Cheers,

jsysde

N'Abend.

ReFS braucht anscheinend deutlich mehr RAM als MS offiziell empfiehlt, insbesondere wenn man riesige Datenmengen im TB-Bereich damit verwaltet. Als ich die Firma verlassen habe, war der Zustand zumindest soweit stabil, dass die ~90TB Disk-2-Disk-Storage auf den per iSCSI verbundenen Synology-NAS (drei Stück) schnell und zuverlässig vom DPM angesprochen werden konnten. Ich hatte seinerzeit mehrere 18TB große LUNs auf die Synologys verteilt per MPIO angebunden, auf jeder LUN 16TB große Storage Spaces Volumes nach dem Muster von Charbel.

Wie gesagt, der DPM lief in der 2012er-Version mit 16GB RAM deutlich schneller und stabiler, aber ich musste (zumindest einen unserer DPMs) auf 2016 hochziehen, damit der SharePoint 2016 gesichert werden konnte. Mehr Infos kann ich dir leider nicht mehr liefern, ich hab' da keinen Kontakt und Einblick mehr.

Cheers,

jsysde

Zitat von @eb1980:

[...]Es kann aber doch nicht sein, dass ein bisschen mehr Speicher gleich einen Quantensprung auslöst.

Ich kann dir dafür auch keine plausible, technische Erklärung mehr liefern. Ich habe seit >12 Monaten nicht mehr produktiv mit DPM zu tun (hab den Job gewechselt). Aber auch andere Kollegen (inkl. zwei, drei MVPs und DPM-Gurus) haben mit dem gleichen Problem gekämpft und es mit der Aufrüstung auf eigentlich lächerlich viel RAM zumindest teilweise umgangen.[...]Es kann aber doch nicht sein, dass ein bisschen mehr Speicher gleich einen Quantensprung auslöst.

ReFS braucht anscheinend deutlich mehr RAM als MS offiziell empfiehlt, insbesondere wenn man riesige Datenmengen im TB-Bereich damit verwaltet. Als ich die Firma verlassen habe, war der Zustand zumindest soweit stabil, dass die ~90TB Disk-2-Disk-Storage auf den per iSCSI verbundenen Synology-NAS (drei Stück) schnell und zuverlässig vom DPM angesprochen werden konnten. Ich hatte seinerzeit mehrere 18TB große LUNs auf die Synologys verteilt per MPIO angebunden, auf jeder LUN 16TB große Storage Spaces Volumes nach dem Muster von Charbel.

Wie gesagt, der DPM lief in der 2012er-Version mit 16GB RAM deutlich schneller und stabiler, aber ich musste (zumindest einen unserer DPMs) auf 2016 hochziehen, damit der SharePoint 2016 gesichert werden konnte. Mehr Infos kann ich dir leider nicht mehr liefern, ich hab' da keinen Kontakt und Einblick mehr.

Cheers,

jsysde

Mahlzeit.

Erstellen eines Replikats (initiales Backup) bedeutet: Einfach mal alles 1:1 kopieren. Basta. Reines Lesen hier, Schreiben dort.

Konsistenzprüfung: Vergleich der laufenden Maschine(n) mit _allen!_ bis dato gemachten/vorhandenen Backups. Mal hier lesen, mal dort lesen, Delta bilden, abgleichen.

Dass das ^^ länger dauert als ein reiner Kopiervorgang ist imho sogar sehr logisch.

Cheers,

jsysde

Zitat von @eb1980:

[...]Was mir auffällt ist das eine konsistenzprüfung mehr als 4x so lang braucht wie die Erstellung des Replikates selbst.

Voll unlogisch aber nuja.

Was ist daran unlogisch?[...]Was mir auffällt ist das eine konsistenzprüfung mehr als 4x so lang braucht wie die Erstellung des Replikates selbst.

Voll unlogisch aber nuja.

Erstellen eines Replikats (initiales Backup) bedeutet: Einfach mal alles 1:1 kopieren. Basta. Reines Lesen hier, Schreiben dort.

Konsistenzprüfung: Vergleich der laufenden Maschine(n) mit _allen!_ bis dato gemachten/vorhandenen Backups. Mal hier lesen, mal dort lesen, Delta bilden, abgleichen.

Dass das ^^ länger dauert als ein reiner Kopiervorgang ist imho sogar sehr logisch.

Cheers,

jsysde

N'Abend.

Wenn du die gefunden hast, kannst du die ultimative Lösung sicherlich gewinnbringend an den Mann bringen.

Was mir grad noch einfällt: Wie groß ist denn deine DPM-Datenbank? Und wo liegt, auf der gleichen Maschine oder im Netz/auf nem anderen Server? Wie ist das Logging eingestellt für die DB (ich würde hier "simple" empfehlen und dann die Logs verkleinern)?

Wenn dich das alles nicht weiter bringt bleibt nur der Call bei Microsoft oder ein Hilferuf an einen der Gurus wie Robert Hedblom & Co.

Cheers,

jsysde

Wenn du die gefunden hast, kannst du die ultimative Lösung sicherlich gewinnbringend an den Mann bringen.

Was mir grad noch einfällt: Wie groß ist denn deine DPM-Datenbank? Und wo liegt, auf der gleichen Maschine oder im Netz/auf nem anderen Server? Wie ist das Logging eingestellt für die DB (ich würde hier "simple" empfehlen und dann die Logs verkleinern)?

Wenn dich das alles nicht weiter bringt bleibt nur der Call bei Microsoft oder ein Hilferuf an einen der Gurus wie Robert Hedblom & Co.

Cheers,

jsysde

N'Abend.

Hält man sich an die Anleitung von Charbel läuft es am Ende des Tages tatsächlich sehr flott und zuverlässig (und eliminiert einige lästige Unarten von NTFS-Volumes). Eine Empfehlung an die breite Masse ist das aber sicherlich nicht.

Cheers,

jsysde

Zitat von @eb1980:

Ich hätte bei Server 2012 und DPM 2012 bleiben sollen.

Habe mich von den Versprechungen seitens MS beirren lassen und auf ReFs (MBS) verführen lassen.

Das kommt ganz drauf an, was du sichern willst/musst - manche Produkte (z.B. SharePoint 2019) bekommst du mit DPM 2012 nicht gesichert. Und die Versprechungen von MS keine "leeren" Versprechungen: ReFS ist tatsächlich deutlich schneller - wenn man die Voraussetzungen alle erfüllt und das ist die eigentliche Krux. Leider lässt sich jedes Volume "mal eben" mit ReFS formatieren.Ich hätte bei Server 2012 und DPM 2012 bleiben sollen.

Habe mich von den Versprechungen seitens MS beirren lassen und auf ReFs (MBS) verführen lassen.

Hält man sich an die Anleitung von Charbel läuft es am Ende des Tages tatsächlich sehr flott und zuverlässig (und eliminiert einige lästige Unarten von NTFS-Volumes). Eine Empfehlung an die breite Masse ist das aber sicherlich nicht.

Cheers,

jsysde