Jumbo Frames auf VMware, SAN und Switches

Hallo Leute,

ich möchte dieses Wochenende auf unserem System Jumboframes aktivieren also vom SAN über die Switches bis hin zu den ESXi Hosts.

Ich habe alles elemente auf Jumbo frame tauglichkeit geprüft aber frage mich noch folgendes:

bei uns geht der iSCSI und normale Server Traffic über den switch und dieser Traffic ist nicht über VLANs getrennt.

Wenn ich jetzt für die iSCSI kommunikation die Jumboframes aktiviere stört es dann die normale kommunikation ?

also müsste ich die Ports für ISCSI in ein VLAN hängen und die anderen Public ports in eine anderes VLAN ?

Der Switch hat grundsätztlich auf allen Ports JumboFrames aktiviert und da es jetzt auch ohne geht wird es einfach im einzelfall entscheiden und da sehe ich eigentlich keine Problem.

Desweiteren:

Im Client also dem Windows2008 System selbst muss ich bei der Netzwerkkarte nicht Jumboframes aktivieren oder ? es reicht wenn es auf dem SAN, dem Switch und auf dem ESX Host einstelle oder ?

viele Grüße,

uLmi

ich möchte dieses Wochenende auf unserem System Jumboframes aktivieren also vom SAN über die Switches bis hin zu den ESXi Hosts.

Ich habe alles elemente auf Jumbo frame tauglichkeit geprüft aber frage mich noch folgendes:

bei uns geht der iSCSI und normale Server Traffic über den switch und dieser Traffic ist nicht über VLANs getrennt.

Wenn ich jetzt für die iSCSI kommunikation die Jumboframes aktiviere stört es dann die normale kommunikation ?

also müsste ich die Ports für ISCSI in ein VLAN hängen und die anderen Public ports in eine anderes VLAN ?

Der Switch hat grundsätztlich auf allen Ports JumboFrames aktiviert und da es jetzt auch ohne geht wird es einfach im einzelfall entscheiden und da sehe ich eigentlich keine Problem.

Desweiteren:

Im Client also dem Windows2008 System selbst muss ich bei der Netzwerkkarte nicht Jumboframes aktivieren oder ? es reicht wenn es auf dem SAN, dem Switch und auf dem ESX Host einstelle oder ?

viele Grüße,

uLmi

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 177185

Url: https://administrator.de/forum/jumbo-frames-auf-vmware-san-und-switches-177185.html

Ausgedruckt am: 18.07.2025 um 00:07 Uhr

72 Kommentare

Neuester Kommentar

Hi

damit alleine ist es aber nicht getan, nur JumboFrames einzustellen, als erstes muss der Switch das supporten und auch können (was billige Hersteller wie Netgear, HP, usw.) und vor allem auch supporten, du wirst massiven Broadcast/Multicast Trafic durch das iSCSI auf den Switchen haben und die meisten gehen dann in die Knie, ferner bist du mit deinem Vorgaben schon gezwungen mit PVST zu arbeiten (was auch nicht jeder Switch kann), dann sollten die Switche auch sowas wie sFlow, gescheit viel Puffer, non Blocking, FlowControl usw. können damit da auch noch Leistung da ist wenn wirklich mal alle Ports unter Feuer ist.

Bei den Servern dann nicht FlowControl vergessen

Was mich am meisten wundert - das dein Switch noch nicht in die Knie gegangen ist - iSCSI Traffic muss auf jedenfall separat vom Netz laufen, da sonst alle Clients "gestört" werden und wenn es dann nicht einmal per QoS Priorisiert wird gehen die evtl auch noch Pakete verloren und die Latenc vom iSCSI geht nach oben (Prerofrmancetechnisch ein grauß) ... damit laufen dann auch die Server extrem langsam würde ich jetzt mal tippen.

Und bei den Clients Windows 2008 (Vista!?) haben im iSCSI Netz rein garnichts zu suchen - per VLAN trennen und in keiner Weise Kontakt zum iSCSI Netz - wenn die sich was mounten sollen dann über eine separate Netzwekkarte die ggf. für iSCSI optimiert ist - auch bei den Server ist es immer der beste Weg das Storage über komplett eigenständige Uplinks zu verbinden und nicht über eine Karte per VLAN getrennt ...

Just my 2 Cent

Besser: iSCSI und Standard-LAN Switche auf separaten Kisten laufen lassen, es sein denn du hast gescheite Hardware die das kann

damit alleine ist es aber nicht getan, nur JumboFrames einzustellen, als erstes muss der Switch das supporten und auch können (was billige Hersteller wie Netgear, HP, usw.) und vor allem auch supporten, du wirst massiven Broadcast/Multicast Trafic durch das iSCSI auf den Switchen haben und die meisten gehen dann in die Knie, ferner bist du mit deinem Vorgaben schon gezwungen mit PVST zu arbeiten (was auch nicht jeder Switch kann), dann sollten die Switche auch sowas wie sFlow, gescheit viel Puffer, non Blocking, FlowControl usw. können damit da auch noch Leistung da ist wenn wirklich mal alle Ports unter Feuer ist.

Bei den Servern dann nicht FlowControl vergessen

Was mich am meisten wundert - das dein Switch noch nicht in die Knie gegangen ist - iSCSI Traffic muss auf jedenfall separat vom Netz laufen, da sonst alle Clients "gestört" werden und wenn es dann nicht einmal per QoS Priorisiert wird gehen die evtl auch noch Pakete verloren und die Latenc vom iSCSI geht nach oben (Prerofrmancetechnisch ein grauß) ... damit laufen dann auch die Server extrem langsam würde ich jetzt mal tippen.

Und bei den Clients Windows 2008 (Vista!?) haben im iSCSI Netz rein garnichts zu suchen - per VLAN trennen und in keiner Weise Kontakt zum iSCSI Netz - wenn die sich was mounten sollen dann über eine separate Netzwekkarte die ggf. für iSCSI optimiert ist - auch bei den Server ist es immer der beste Weg das Storage über komplett eigenständige Uplinks zu verbinden und nicht über eine Karte per VLAN getrennt ...

Just my 2 Cent

Besser: iSCSI und Standard-LAN Switche auf separaten Kisten laufen lassen, es sein denn du hast gescheite Hardware die das kann

auch nur an der Stelle wo du ein iSCSI LUN direkt mounten möchtest - für die VM die im ESX läuft ist das egal - wo wir auf iSCSI Storage umgestellt haben hat jeder Anbieter separate Switche genommen und auch durch's lesen (wie z.B. hier im Forum) wurde immer darauf hingewiesen es über separate Switche zu machen - ich kenne deine Hardwware jetzt nicht und weis auch nicht über wieiviele Server und Storage Nodes wir sprechen - wenn du aber alles über einen Switch machen willst musst du auf jedenfall Enterprise Hardware haben (Cisco, Brocade, Extrem ....) die supporten so etwas weil die auch entsprechende Leistung haben.

Was hast du denn momentan für Switche im Einsatz?

Was hast du denn momentan für Switche im Einsatz?

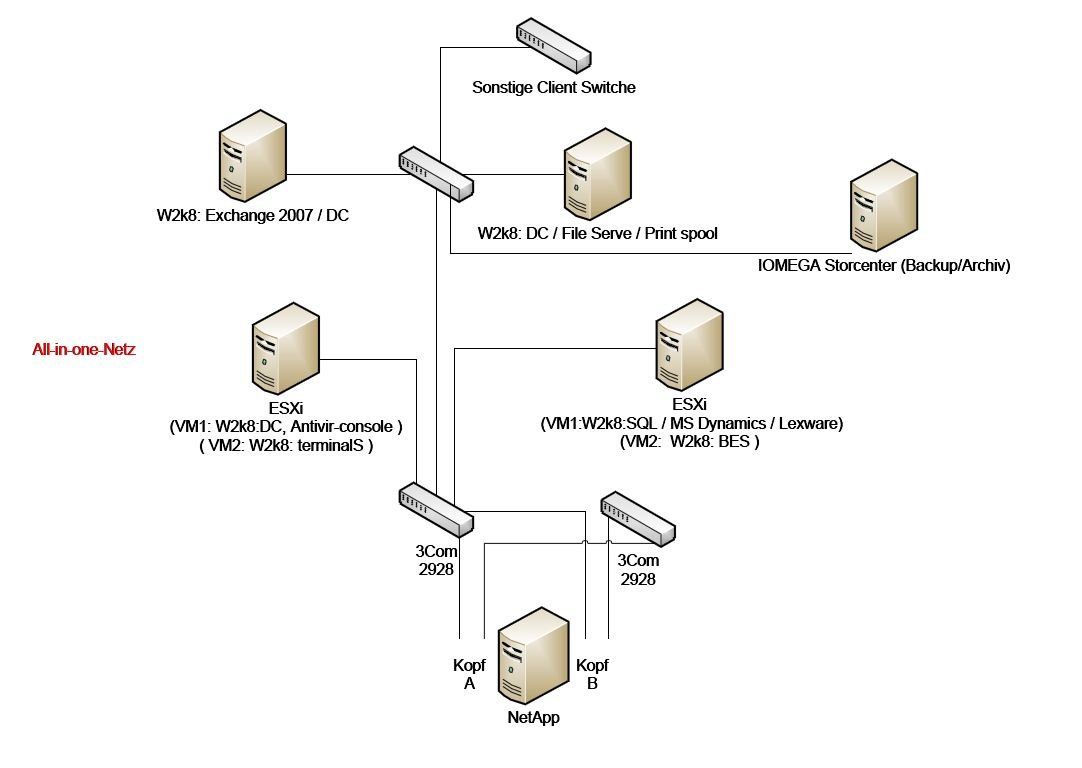

1 x DC, 1 x Exchange mit 200GB, 1 x SQL mit 40GB und ein paar weitere Windows Server mit kleineren diensten.

SQL braucht IOs - alleine das wird schon einiges an Performance kosten, 3 ESXi Hosts mit 12 Server (geschätzt) - die Switche sind auch nicht seitens HP dafür vorgesehen, da empfehlen die eher 2910al Switche - wenn du wirklich über ein Switch beides machen willst, dann würde ich 2 x Brocade FCX624S im Stack nehmen (ja ich bevorzuge Brocade - es gibt aber auch von anderen Herstellern wie z.B. Cisco, Extrem, Juniper, Force10... gleiche/bessere Geräte) - die supporten das - aber besser ist wirklich das getrennt zu machen, wenn du bei HP bleiben möchtest entsprechend die 2910al (die kann man aber nicht stacken - das nennt sich bei HP MESH oder so) -alternativ sollte auch die FWS Serie von Brocade funktionieren - eine günstige alternative wäre Dell (wobei die Qualitätiv nix besser wie HP sind - aber bessere Leistungsdaten haben) - die Serie 6224/6248.

Und um die Ausfallsicherheit zu wahren: immer mind. 2 Switche (ich kenne jetzt die NetApp Geräte nicht - aber auf dauer würde ich eine 2. holen und die dann spiegeln/replizieren)

haste gesehen ich hab oben noch was hinzugefügt ?

jap gesehen Der Lieferant der das eingerichtet hat meinte es gäbe keine probleme wenn der iSCSI traffic und der Public Traffic der Server im selben "netz" auf dem selben switch ablaufen

bei kleine Umgebungen mag das gehen, aber nicht wenn Festplattenlastige Anwendungen wie SQL usw. laufen1x DC, ...

da würde ich schon mal mindestens einen mehr machen Und die HP Kisten machen fast alles in Software, teure Geräte können das direkt in Hardware - darum geht z.B. ein HP bei einem Loop auch direkt aus ... naja 100% Last

Moin,

Die Netapp 2020 hat leider pro Kopf nur zwei Netzwerkports. Hast du ein oder zwei Koepfe?

Gleich eine zweite Netapp zu kaufen halte ich für übertrieben. An deiner Stelle würde ich über FC jede Nacht auf LTO-Bändern sichern. Da sollte nicht die rießige Datenmenge anfallen.

BTW: Wie viel Platten hast du in der Netapp?

Grüße,

Dani

wenn du wirklich über ein Switch beides machen willst, dann würde ich 2 x Brocade FCX624S im Stack nehmen (ja ich bevorzuge Brocade

Sorry, aber das ist laut VMWare White Paper nicht 100%ig supportet.Eigentlich wollte ich nur wissen ob ich zwingend die ISCSI ports von den Public ports trennen muss wenn ich den ISCSI verkehr auf Jumboframes hochdrehe.

Lass es mich so sagen, man trennt immer beide Netze physkalisch , egal ob JF oder nicht.Die Netapp 2020 hat leider pro Kopf nur zwei Netzwerkports. Hast du ein oder zwei Koepfe?

Gleich eine zweite Netapp zu kaufen halte ich für übertrieben. An deiner Stelle würde ich über FC jede Nacht auf LTO-Bändern sichern. Da sollte nicht die rießige Datenmenge anfallen.

BTW: Wie viel Platten hast du in der Netapp?

Grüße,

Dani

Zitat von @Dani:

Moin,

> wenn du wirklich über ein Switch beides machen willst, dann würde ich 2 x Brocade FCX624S im Stack nehmen (ja ich

bevorzuge Brocade

Sorry, aber das ist laut VMWare White Paper nicht 100%ig supportet.

ich habe es auch nicht empfohlen :> ich würde auch eine strikte Trennung von iSCSI und Produktivnetz nehmen -(und die zweite NetApp nur schon mal als Gedanke für zukünftige Investitionen)Moin,

> wenn du wirklich über ein Switch beides machen willst, dann würde ich 2 x Brocade FCX624S im Stack nehmen (ja ich

bevorzuge Brocade

Sorry, aber das ist laut VMWare White Paper nicht 100%ig supportet.

OT jap Dani verkauft NetApple und ich Bonecrate :o) /OT

Passieren tut eigentlich nichts wenn du JF einschaltest - zur Sicherheit mach das via Konsole dann kannst es, was unwahrscheinlich ist, einschalten und bei Bedarf wieder ausschalten

Und was Dani meinte: das direkt von der NetApp Backups zieht per Snapshot oder wie auch immer und das direkt auf Band wegschreibst. *zwecks Datensicherung*

Passieren tut eigentlich nichts wenn du JF einschaltest - zur Sicherheit mach das via Konsole dann kannst es, was unwahrscheinlich ist, einschalten und bei Bedarf wieder ausschalten

Und was Dani meinte: das direkt von der NetApp Backups zieht per Snapshot oder wie auch immer und das direkt auf Band wegschreibst. *zwecks Datensicherung*

wenn ich das per VLAN trenne ist das doch getrennt oder Nicht?

Ja es geht, aber frag den Netapp- und VMWaresupport ob Sie dir im Worstcase auch helfen. Denn wie schon gesagt ist das nicht BestPractice. Unn denk auch weiter: Somit steigt die Last auf den Switches und somit kann es soweit kommen, dass bei iSCSI Datenpakete verloren gehen. Falls das auch noch eine SQL-DB treffen sollte, solltest du ein gutes Backup haben das beim Recovery auch funktioniert. Wie schon gesagt kauf die die HP 2910al und baue zwei getrennte Netze.ja die NetApp hat nur 2 ports pro Kopf, ich habe 2 Köpfe in Active/Active laufen.

Hmm... Da wirst du bezüglich Redudanz einen Tod noch sterben müssen. seid ihr vertriebler oder was

Nö, aber man sollte über den Tellerrand schauen. Zukunftsweisend denken!Leider nicht, sonst würde ich auch solche Autos fahren.

nicht wegen JF - sondern das dir die NetApp ausfällt - und bedenke das was Dani geschrieben hat bzgl. SQL (da habe ich jetzt ich jetzt nicht mal dran gedacht) - kaufe dir einfach einen gescheiten Switch fürs iSCSI dazu - das wird dir jede Menge Ärger ersparen - die 2910al bekommst schon für "schmales" Geld:

ebay.de/sch/i.html?_from=R40&_trksid=p5197.m570.l1313&_n ...

heise.de/preisvergleich/?fs=2910al&in=&x=0&y=0

ebay.de/sch/i.html?_from=R40&_trksid=p5197.m570.l1313&_n ...

heise.de/preisvergleich/?fs=2910al&in=&x=0&y=0

dabei würde ich die redundanz verlieren

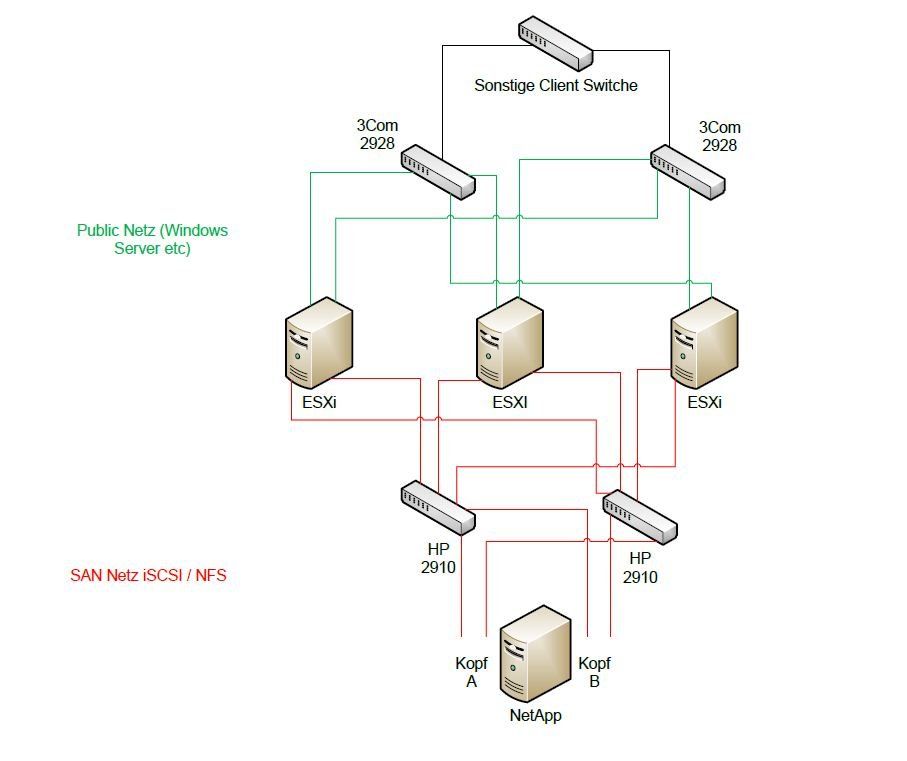

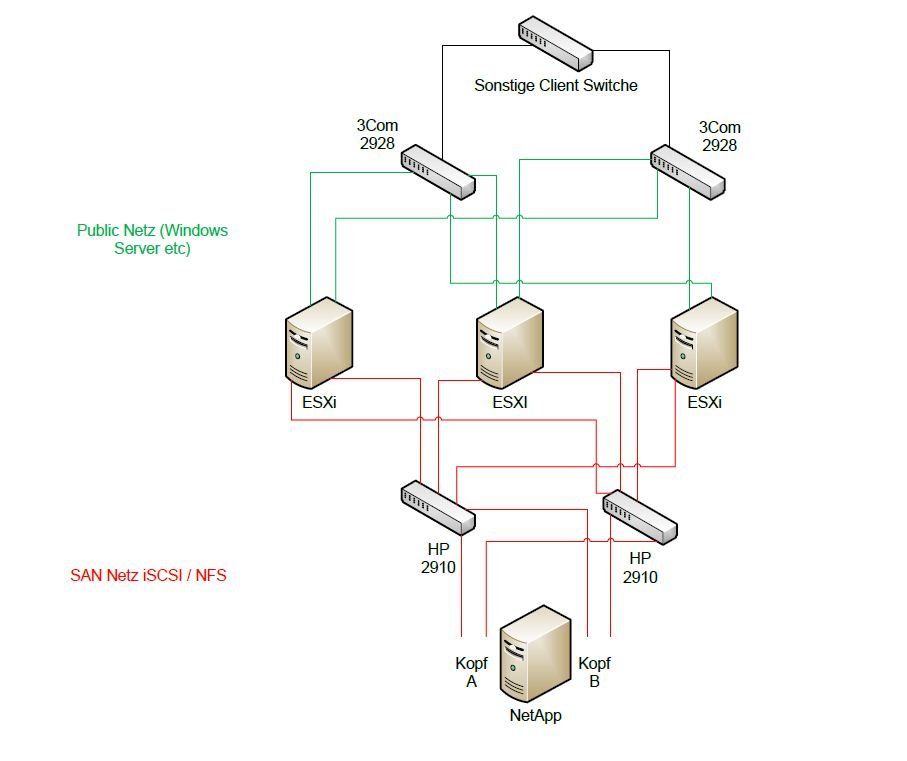

Das würdst du auch so... rechne mal nach: Die Netapp je Kopf zwei Netzwerkports. Wenn du zwei iSCSI - Switches nehmen würdst wären beide Ports für SAN blockiert und du kannst dein normales LAN nicht anbinden. Davon hab ich schon weiter oben geredet. Bilderlösung!!Andere Frage: Liest du überhaupt die Whitepaper von VMware und Netapp?

wären die dann rein für das ISCSI netz ?

Ja, nur für iSCSI!Die Rechnung bei sowas ist doch die Wirtschaftlichkeit. Welche Server / Anwendungen müssen laufen, Wie hoch darf die Ausfallzeit von Netapp/Server durch defekt im Jahr sein, wie schnell muss ein Recovery der Umgebung erfolgen und was kostet deine Arbeitszeit. Zum Schluss die einzelnen Werte addieren/abziehen und dann seht ihr was die Umgebung kosten darf/soll/muss.

sondern das dir die NetApp ausfällt

Naja, dabei müssten pro Aggregat mehr als 2 Platten ausfallen oder aber beide Köpfe parallel defekt sein. Beide Fälle haben wir bei uns noch nie erlebt.Grüße,

Dani

ja die wären dann fürs reine iSCSI Netz - und 900EUR ist nicht unbedingt teuer  - immer Ware nach Geld - wenn du allerdings irgendwann auf 10Gb willst - dann nimm direkt Cisco oder Brocade - die werden dann in der Summe günstiger wie HP (da ist 10gb Technik sehr teuer - und die beiden Supporten Gbic vom freien Markt)

- immer Ware nach Geld - wenn du allerdings irgendwann auf 10Gb willst - dann nimm direkt Cisco oder Brocade - die werden dann in der Summe günstiger wie HP (da ist 10gb Technik sehr teuer - und die beiden Supporten Gbic vom freien Markt)

Mal zur Info: heise.de/preisvergleich/?fs=FCX624&in=&x=0&y=0

wobei die Preise ... naja - ich würde es auf jedenfall beim Systemhaus anfragen bzw. die Hersteller mal anrufen und fragen was die "größeren" Zwischenhändler sind - da bekommst weitaus bessere Preise wie im "Onlineshop".

- ich würde es auf jedenfall beim Systemhaus anfragen bzw. die Hersteller mal anrufen und fragen was die "größeren" Zwischenhändler sind - da bekommst weitaus bessere Preise wie im "Onlineshop".

Was ich aber mal machen würde, lass den Juppie antanzen der das bei euch geplant hat und mal klarstellen was er da geplant hat ... eigentlich is es ein Planungsfehler - das ganze (iSCSI und Produktiv-Netz) über ein Netz laufen zu lassen und das bei "den" Switchen (wie bereits geschrieben - unteres Preis-/Leistungsegement bei HP)

Mal zur Info: heise.de/preisvergleich/?fs=FCX624&in=&x=0&y=0

wobei die Preise ... naja

Was ich aber mal machen würde, lass den Juppie antanzen der das bei euch geplant hat und mal klarstellen was er da geplant hat ... eigentlich is es ein Planungsfehler - das ganze (iSCSI und Produktiv-Netz) über ein Netz laufen zu lassen und das bei "den" Switchen (wie bereits geschrieben - unteres Preis-/Leistungsegement bei HP)

moin,

@ Dani...

Nein, der liesst ja nichtmal, was ihr Ihm geschrieben hat..

Meine ganz persönliche Meinung?

Da ist ein schwäbischer Schotte an der anderen Seite der Leitung, der gerne von uns hören möchte, dass Geiz so geil ist und seine Idee die beste der Welt ist.

Von daher - kann ich Ihm nur zustimmen und würde trotzdem schonmal nachsehen, ob der Reisepass noch gültig ist und ob es im Moment ein Land gibt, dass IT Spezialisten braucht.

Gruß

Na wie gut, dass heute erst Freitag ist...

@ Dani...

Nein, der liesst ja nichtmal, was ihr Ihm geschrieben hat..

Meine ganz persönliche Meinung?

Da ist ein schwäbischer Schotte an der anderen Seite der Leitung, der gerne von uns hören möchte, dass Geiz so geil ist und seine Idee die beste der Welt ist.

Von daher - kann ich Ihm nur zustimmen und würde trotzdem schonmal nachsehen, ob der Reisepass noch gültig ist und ob es im Moment ein Land gibt, dass IT Spezialisten braucht.

Gruß

ich möchte dieses Wochenende

allerdings irgendwann auf 10Gb willst - dann nimm direkt Cisco oder Brocade

Schön und gut. Aber davor benötigt er eine neue Netapp. Da reisen es die Switches auch nicht mehr raus. Mal zur Info: heise.de/preisvergleich/?fs=FC ...

Versandkosten nicht vergessen. Was ich aber mal machen würde, lass den Juppie antanzen

Ich würde IHn anrufen und mitteilen, dass die Planung von einem anderen Systemhaus durchgeführt wird!Grüße,

Danni

Ich weis jetzt nicht wie gut du dich mit deinem Chef verstehst - ich würde einfach den 2910al bestellen und einbauen, wenn der Chef dann fragt mit der Wahrheit direkt rausrücken - wenn du die verantwortung dafür übernehmen sollst das alles funktioniert, bekommst vielleicht nen Einlauf aber mehr nicht - ich denke nicht das bei einem 40+ MA Unternehmen kosten von unter 1000 EUR derbe ins Gewicht fallen und das Unternehmen in den Ruin treiben.

Damit wirst du dir sehr viel Stress ersparen und von der Gewindkeit her spürbare verbesserungen erleben und mit weitaus weniger Ärger leben können.

@Dani

10Gb für die Verbindung von z.B. zwei Serverräumen - wir haben alles mit 2x10Gb verbunden - die Leitung ist zwar nicht ausgelastet (rund 25-50% im Peak je 10Gb Leitung) aber nicht nur die Storagenodes machen Traffic und irgendwann hat man evtl. 3 Node und schon kann man es brauchen ;o

Damit wirst du dir sehr viel Stress ersparen und von der Gewindkeit her spürbare verbesserungen erleben und mit weitaus weniger Ärger leben können.

@Dani

10Gb für die Verbindung von z.B. zwei Serverräumen - wir haben alles mit 2x10Gb verbunden - die Leitung ist zwar nicht ausgelastet (rund 25-50% im Peak je 10Gb Leitung) aber nicht nur die Storagenodes machen Traffic und irgendwann hat man evtl. 3 Node und schon kann man es brauchen ;o

Ja 2 Ports, einer pro switch...wo ist das problem ?

Ich denke mein Bildlink oben sagt alles. Wenn du iSCSI dedudant haben möchtest, benötgist du 2 Ports pro Netapp Kopf. Da es aber phy. getrennt von LAN ist, fehlen dir an der Netapp ein Netzwerkport pro Kopf. Du wirst bisher CIFS direkt über die Netapp bereitstellen. Somit müsstest du Abstriche auf beim iSCSI machen. Was aber wiederrum zur Folge hätte, dass du den iSCSI Switch ebenfalls auf die USV hängen solltest.verstehe auch nicht warum es immer gleich die riesen katastrophe in euren augen ist...

Die Erfahrung lehrt einfach, dass wennn alles läuft keiner sich Gedanken macht. Aber wenn die EDV mal nicht geht, ist an DICH die Frage woran es liegt. Und diesen Worstcase erleben wir leider viel zu oft bei Neukunden.würde mich jetzt auch wundern bei RAID-DP, und diversen HOTspares Netto 6 von 12 HDD auch sehr geil

Ich frag jetzt lieber nicht warum deine Konfiguration der Netapp so aussieht.

vom gesamtem iSCSI eigentlich ... (Edit/Add: als Antwort auf deine letzte Frage "...Finge von Jumboframes lassen?")

bestellt dir 2 HP 2910al baue die ein - mach einen auf reudiger Hund beim Cheffe und alles wird gut - und mit der Planung das kenne ich nur zu gut auch die sparsamen Cheffs - wobei "meiner" sehr umgänglich geworden ist und man anhand von praktischen Beispielen (idealerweise mit einer "Bildersprache" die irgendeinen Bezug zu Fußball oder Autos hat) und auch auf die Kosteneinsparungen hinweist, immer ans Ziel gekommen bin (nur meine 60 Zoll "Monitoring" Bildschirm habe ich nicht bekommen ;( )

- und mit der Planung das kenne ich nur zu gut auch die sparsamen Cheffs - wobei "meiner" sehr umgänglich geworden ist und man anhand von praktischen Beispielen (idealerweise mit einer "Bildersprache" die irgendeinen Bezug zu Fußball oder Autos hat) und auch auf die Kosteneinsparungen hinweist, immer ans Ziel gekommen bin (nur meine 60 Zoll "Monitoring" Bildschirm habe ich nicht bekommen ;( )

Und zum WE: bie mir nicht ich war gestern auch bis 23 Uhr in der Firma weil unser BackupServer das zeitliche gesegnet hat *es leben der 4h Support!* und der wieder laufen musste - und am WE stehen bei uns immer die Dinge an die man wegen 3 Schicht Betrieb nicht in der Woche machen kann - aber auch nicht jedes

ich war gestern auch bis 23 Uhr in der Firma weil unser BackupServer das zeitliche gesegnet hat *es leben der 4h Support!* und der wieder laufen musste - und am WE stehen bei uns immer die Dinge an die man wegen 3 Schicht Betrieb nicht in der Woche machen kann - aber auch nicht jedes

bestellt dir 2 HP 2910al baue die ein - mach einen auf reudiger Hund beim Cheffe und alles wird gut

Und zum WE: bie mir nicht

Das sieht schon mal passend aus - so hast auf jedenfall beide Netze getrennt.

Die Freigbaben die momentan auf der NetApp liegen würde ich das iSCSI Laufwerk in einem Windows Server mappen (iSCSI Initiator Target) und nicht durch die VM als Laufwerk anfügen und dann freigeben.

Die nächste Anschaffung wären dann noch weitere Netzwerkkarten für die Server (bei uns hat jeder ESX Host 4 x iSCSI Netz und 4-8x reguläres LAN)

Die Freigbaben die momentan auf der NetApp liegen würde ich das iSCSI Laufwerk in einem Windows Server mappen (iSCSI Initiator Target) und nicht durch die VM als Laufwerk anfügen und dann freigeben.

Die nächste Anschaffung wären dann noch weitere Netzwerkkarten für die Server (bei uns hat jeder ESX Host 4 x iSCSI Netz und 4-8x reguläres LAN)

Ich hab so ein Konstrukt seit ca. 1 Jahr am laufen mit 2 x HP-Switche ProCurve 1800-24G für das iSCSI-Netz und das produktive Netz was über VLAN getrennt ist.

Das hat mir damals so der NetApp-Techniker eingerichtet und das ganze läuft ohne Probleme.

Auf den 3 ESX'n laufen bei mir ca. 8 VMs gemischt mit DC's, SQL und IIS-Servern und vom Netzwerk gibt es keine Probleme.

Die ESX'n sind über NFS mit der NetApp verbunden und darauf laufen die VMs. Dann noch ein CIFS/SMB Share auf der NetApp für die Server auf die alle zugreifen dürfen.

In dem NetApp-Management bei der Auslastung langweilt sich die NetApp eher.

Im Nachhinein würde ich aber für sowas nicht mehr eine teure NetApp kaufen, habe noch 2 Dell-SAN's im Einsatz und die tun es auch.

Vor allem weil ich DeDup ausgeschaltet habe weil es bei VMs wenig Vorteile bringt also nicht soviel Platz spart wie angepriesen.

Nachtrag:

Der Techniker hat mir damals das mit iSCSI und LUN ausgeredet da es Vorteile hat wenn man es NFS benutzt. Wenn Du 1 LUN hast wo alle VMs

drauf laufen und Du einen Desaster-Fall hast muss Du aus dem Backup/Snapshot die komplette LUN wiederherstellen. Bei NFS kannst Du einzelne

VMs aus dem Snapshot wiederherstellen. Weiterhin meinte er das der Performance-Verlust durch NFS unter 5 % ist gegenüber von iSCSI.

Das hat mir damals so der NetApp-Techniker eingerichtet und das ganze läuft ohne Probleme.

Auf den 3 ESX'n laufen bei mir ca. 8 VMs gemischt mit DC's, SQL und IIS-Servern und vom Netzwerk gibt es keine Probleme.

Die ESX'n sind über NFS mit der NetApp verbunden und darauf laufen die VMs. Dann noch ein CIFS/SMB Share auf der NetApp für die Server auf die alle zugreifen dürfen.

In dem NetApp-Management bei der Auslastung langweilt sich die NetApp eher.

Im Nachhinein würde ich aber für sowas nicht mehr eine teure NetApp kaufen, habe noch 2 Dell-SAN's im Einsatz und die tun es auch.

Vor allem weil ich DeDup ausgeschaltet habe weil es bei VMs wenig Vorteile bringt also nicht soviel Platz spart wie angepriesen.

Nachtrag:

Der Techniker hat mir damals das mit iSCSI und LUN ausgeredet da es Vorteile hat wenn man es NFS benutzt. Wenn Du 1 LUN hast wo alle VMs

drauf laufen und Du einen Desaster-Fall hast muss Du aus dem Backup/Snapshot die komplette LUN wiederherstellen. Bei NFS kannst Du einzelne

VMs aus dem Snapshot wiederherstellen. Weiterhin meinte er das der Performance-Verlust durch NFS unter 5 % ist gegenüber von iSCSI.

Ist nicht für interne User, darauf laufen Portale die im Internet erreichbar sind.

Da jeder Anwendungszweck anders ist muss man mit dem Projekt wachsen, bei neuen Projekten trenne ich die Netzwerk zu den SAN's auch.

Mit Monitoring kann man Engpässe rechtzeitig abfangen dann kann man mit einer kleinen Struktur beginnen und Sie dann weiter ausbauen.

Wenn nicht genügend Budget vorhanden ist, ich kenne das Problem nur zu gut.

Da jeder Anwendungszweck anders ist muss man mit dem Projekt wachsen, bei neuen Projekten trenne ich die Netzwerk zu den SAN's auch.

Mit Monitoring kann man Engpässe rechtzeitig abfangen dann kann man mit einer kleinen Struktur beginnen und Sie dann weiter ausbauen.

Wenn nicht genügend Budget vorhanden ist, ich kenne das Problem nur zu gut.

Hab kurz nachgesehen, Jumboframes sind bei mir nicht aktiv.

Was erhoffst Du Dir von den JF?

Vielleicht solltest Du bevor Du JF aktivierst das ganze noch in einer kleinen Testumgebung testen, habe ich vor kurzem gemacht mit einem

iSCSI-Server unter Debian und einem weiteren Debian worauf XEN lief. Geht auch einfacher z.B. mit FreeNas,Openfiller usw.

Wennst noch alte Kisten rumstehen hast kannst das sogar mit denen testen.

Was erhoffst Du Dir von den JF?

Vielleicht solltest Du bevor Du JF aktivierst das ganze noch in einer kleinen Testumgebung testen, habe ich vor kurzem gemacht mit einem

iSCSI-Server unter Debian und einem weiteren Debian worauf XEN lief. Geht auch einfacher z.B. mit FreeNas,Openfiller usw.

Wennst noch alte Kisten rumstehen hast kannst das sogar mit denen testen.

meine problem ist das eine Fucking Lexware Anwednung so elend lahm ist. alle anderen sachen laufen akzeptable. ich erhoffe mich

durch JF halt dieses problem zu erschlagen und allgemein mehr leistung zu bekommen.

durch JF halt dieses problem zu erschlagen und allgemein mehr leistung zu bekommen.

wieviele Leyware User sind das denn? (die Software geht bei vielen Usern einfach in die Knie egal welche Hardware darunter liegt)

Ich frag mich langsam ob ich japanisch rede...

Whitepaper ist auch dir ein Fremdwort? Warum meint ihr, dass Hersteller die möglichen supporteten Konstellationen dort niederschreiben? Das Sie niemand liest? Unsere Inhouse Netapp- und VMWareingenieure verweisen bei jedem Projekt mit iSCSI immer auf das Whitepaper und richten sowas nur mit Unterschrift meines Chefs bzw. des Kunden ein.

@flitzenderelch

War es vllt. ein netappzertifizierter Systemhaustechniker?!

Whitepaper ist auch dir ein Fremdwort? Warum meint ihr, dass Hersteller die möglichen supporteten Konstellationen dort niederschreiben? Das Sie niemand liest? Unsere Inhouse Netapp- und VMWareingenieure verweisen bei jedem Projekt mit iSCSI immer auf das Whitepaper und richten sowas nur mit Unterschrift meines Chefs bzw. des Kunden ein.

@flitzenderelch

War es vllt. ein netappzertifizierter Systemhaustechniker?!

Vor allem weil ich DeDup ausgeschaltet habe weil es bei VMs wenig Vorteile bringt also nicht soviel Platz spart wie angepriesen.

Hängt von dem eingesetzten Betriebssystemen ab und dem Alignment auf virtuellen Platten (Stichwort Blockgröße)! Damit haben wir bisher überall über 50% herausgeholt. Achja, Netapp macht als einzigster Hersteller Dedup innerhalb der VM und nicht nur auf die vmdk-Files.

Wir wäre es wenn du deine Netappkonfiguration schreibst. Wichtig wäre z.B. wie viele Platten du in einem Aggregat hat, welches RAID-System, wie viel Spare Platten, nutzt du SATA, SAS oder FC Platten und wie viel Umdrehungen haben die Platten. Wichtig ist auch noch die Ontap Version. Denn die musste man mit ESXi 4.1U1 auch hochziehen.

Hast du dich bei der Netappkonfiguration an das I/O Datenblatt von Netapp gehalten (Low, Middle und Havyserver)?!

Hast du dich bei der Netappkonfiguration an das I/O Datenblatt von Netapp gehalten (Low, Middle und Havyserver)?!

Puh du frägst Sachen, weiß nicht mehr ob das so einer war ist schon 1 Jahr her.

Das ausschalten von DeDup wurde mir auch von einem Techniker von der NetApp-Service-Hotline angeraten, da die Firmware auf der NetApp keine Volumes größer

500GB mit DeDup zulässt. Da ich aber größere gebraucht habe war das sein Tip.

Wenn ein Techniker von dem Hersteller kommt und mir das so einrichtet das es passt, warum sollte ich dann das Whitepaper lesen.

Der Techniker müsste das Whitepaper ja dann aus dem FF können und dann müsste er mich ja darauf hinweisen dass das so wie er es

konfiguriert hat nicht mit dem Whitepaper übereinstimmt und es zu Performance-Problemen / nicht genügend Ausfallsicherheit usw. kommen kann.

D.h. wiederum für mich: Dann hätte der das so nicht einrichten dürfen!

DeDup:

Hat bei mir leider nicht soviel rausgeholt, wie gewünscht.

Auch bei meinem CIFS/SMB-Share war die % nicht so hoch.

Das ausschalten von DeDup wurde mir auch von einem Techniker von der NetApp-Service-Hotline angeraten, da die Firmware auf der NetApp keine Volumes größer

500GB mit DeDup zulässt. Da ich aber größere gebraucht habe war das sein Tip.

Wenn ein Techniker von dem Hersteller kommt und mir das so einrichtet das es passt, warum sollte ich dann das Whitepaper lesen.

Der Techniker müsste das Whitepaper ja dann aus dem FF können und dann müsste er mich ja darauf hinweisen dass das so wie er es

konfiguriert hat nicht mit dem Whitepaper übereinstimmt und es zu Performance-Problemen / nicht genügend Ausfallsicherheit usw. kommen kann.

D.h. wiederum für mich: Dann hätte der das so nicht einrichten dürfen!

DeDup:

Hat bei mir leider nicht soviel rausgeholt, wie gewünscht.

Auch bei meinem CIFS/SMB-Share war die % nicht so hoch.

Schade... dacht ich mir fast.

Das ist so nicht wahr! Eine LUN darf nicht größer sein als 500GB für Dedup. Aber Dedup wird seit einer bestimmten ONTAP Version über das Volume gesteuert und das darf sehr groß sein. Darum regelmäßig Releaseinfo lesen.

Das ausschalten von DeDup wurde mir auch von einem Techniker von der NetApp-Service-Hotline angeraten, da die Firmware auf der NetApp keine Volumes größer

500GB mit DeDup zulässt. Da ich aber größere gebraucht habe war das sein Tip.Das ist so nicht wahr! Eine LUN darf nicht größer sein als 500GB für Dedup. Aber Dedup wird seit einer bestimmten ONTAP Version über das Volume gesteuert und das darf sehr groß sein. Darum regelmäßig Releaseinfo lesen.

Hast Du mal über das VCenter die Auslastung des rechten ESXi (eigentlich von allen ESXi) beobachtet?

Vor allem Festplatten/IO Auslastung.

Hier würdest Du Engpässe erkennen.

Was sagt die Auslastung der NetApp?

Exchange und DC auf einem Server? Sowas macht man nicht!

Whitepaper von MS

Wenn Du auf einen Ex2010 wechselst geht die Performance auf der DB um einiges runter, Microsoft hat hier ernome (gute) Änderungen vorgenommen.

Hab vor kurzem selbst von Ex07 auf EX2010 umgestellt.

Vor allem Festplatten/IO Auslastung.

Hier würdest Du Engpässe erkennen.

Was sagt die Auslastung der NetApp?

Exchange und DC auf einem Server? Sowas macht man nicht!

Whitepaper von MS

Wenn Du auf einen Ex2010 wechselst geht die Performance auf der DB um einiges runter, Microsoft hat hier ernome (gute) Änderungen vorgenommen.

Hab vor kurzem selbst von Ex07 auf EX2010 umgestellt.

Keine zwei Köpfe in der Netapp verbaut?

Du weißt aber das es Abhängigkeiten zwischen ONTAP-Version und VMWare ESX(i)-Version gibt, die bei nicht einhalten der Versionkombinationen Probleme verursachen kann?

Um wirklich festzustellen ob es an den Platten liegt, erzeug künstliche Last (z.B. verschiedende Server große Dateien schreiben lassen). Somit siehst du bei der Netapp gleich was der I/O sagt. Somit lässt sich feststellen ob es an der Netapp liegt oder nicht.

Wir haben mit Lexware auf ESX keinerlei Probleme. Bei uns sind es ca. 23 Benutzer.

Du weißt aber das es Abhängigkeiten zwischen ONTAP-Version und VMWare ESX(i)-Version gibt, die bei nicht einhalten der Versionkombinationen Probleme verursachen kann?

Um wirklich festzustellen ob es an den Platten liegt, erzeug künstliche Last (z.B. verschiedende Server große Dateien schreiben lassen). Somit siehst du bei der Netapp gleich was der I/O sagt. Somit lässt sich feststellen ob es an der Netapp liegt oder nicht.

Wir haben mit Lexware auf ESX keinerlei Probleme. Bei uns sind es ca. 23 Benutzer.

Hallo zusammen,

das aktivieren von Jumbo Frames alleine bringt noch gar nichts. Das bedeutet nur, dass der oder die Switche ETH-Pakete bis zu einer Größe von 4000 oder 9000 Bytes forwarden, je nachdem was das OS des/der Switche dafür anbieten.

Die Jumbo-Frames werden erst nach konfiguration der Treiber der Netzwerkkarten übertragen. Dabei kann man gemischt normale und Jumbo Frames fahren.

Die tatsächliche Größe der Frames, die in einem Paket übertragen werden, werden im Bereich TCP bei 3-way Handshake ausgehandelt. (MTU-Size)

Im Bereich udp wäre mir nicht bekannt, dass Jumbo Frames genutzt werden, (aber ich bin nicht allwissend).

Ob das einstellen der Jumbo-Frames tatsächlich etwas bringt, ist so einfach nicht zu beantworten.

Das hängt von vielen Fatoren ab.

Netzwerkkarte (billigteil a la Realtek und konsorten, oder spzifische Serverkarten mit entsprechendem Proc, Memory, und entsprechender Anbindung an den Bus des Servers )

Aufgebohrter PC als Billigserver oder potente Serverhardware

Switch mit entsprechender Leistung, CPU, Buffer, Buffer per Port, forwardingstrategien, ets. etc. etc.

Brauchbare Netzwerkverkabelung ( in Deutschland mindestens Cat5e oder besser, geschirmt, geschirmte Patchkabel, etc.), oder Anbindung an per LWL 50/125 Multimode oder 9/125 Monomode Fasern, keine alten 62,5/125 Mulitmode Fasern mehr,

Alter der Verkabelung, entsprechende 5-Leiter Stromverkabelung nach VDE, Saubere Erdung der Verkabelung.

Also, es spielen viele Faktoren eine Rolle.

Gruß

Anton

das aktivieren von Jumbo Frames alleine bringt noch gar nichts. Das bedeutet nur, dass der oder die Switche ETH-Pakete bis zu einer Größe von 4000 oder 9000 Bytes forwarden, je nachdem was das OS des/der Switche dafür anbieten.

Die Jumbo-Frames werden erst nach konfiguration der Treiber der Netzwerkkarten übertragen. Dabei kann man gemischt normale und Jumbo Frames fahren.

Die tatsächliche Größe der Frames, die in einem Paket übertragen werden, werden im Bereich TCP bei 3-way Handshake ausgehandelt. (MTU-Size)

Im Bereich udp wäre mir nicht bekannt, dass Jumbo Frames genutzt werden, (aber ich bin nicht allwissend).

Ob das einstellen der Jumbo-Frames tatsächlich etwas bringt, ist so einfach nicht zu beantworten.

Das hängt von vielen Fatoren ab.

Netzwerkkarte (billigteil a la Realtek und konsorten, oder spzifische Serverkarten mit entsprechendem Proc, Memory, und entsprechender Anbindung an den Bus des Servers )

Aufgebohrter PC als Billigserver oder potente Serverhardware

Switch mit entsprechender Leistung, CPU, Buffer, Buffer per Port, forwardingstrategien, ets. etc. etc.

Brauchbare Netzwerkverkabelung ( in Deutschland mindestens Cat5e oder besser, geschirmt, geschirmte Patchkabel, etc.), oder Anbindung an per LWL 50/125 Multimode oder 9/125 Monomode Fasern, keine alten 62,5/125 Mulitmode Fasern mehr,

Alter der Verkabelung, entsprechende 5-Leiter Stromverkabelung nach VDE, Saubere Erdung der Verkabelung.

Also, es spielen viele Faktoren eine Rolle.

Gruß

Anton

nie nach verdienen - immer danach fragen wieviel er bekommt nicht wieviel er verdient :D - und was du meinst sind iSCSI Offloadkarten - die hat jeder Hersteller im Programm, worauf ich bei der Installation der ESX achten würde, versuche Installations CD's der HErstreller für ESX zu bekommen, dann sind direkt die richtigen Treiber enthalten.

@clSchak

Psssst... Hättest was abbekommen.

@uLmi

Psssst... Hättest was abbekommen.

@uLmi

whitepapers steht auch noch ne menge bezüglich storage provisionierung und vmware settings. das wird ne menge ich freue mich schon ..

Jo, ist aber alles machbar. Vergiss nicht die Netapp Whitepaper zu lesen. Dort stehen auch noch wichtige Dinge zu ONTAP und VMWare Versionen.