MTU zwischen ESXi und QLogic BMC57810 mit 10GBit DACs 4088 oder 9014 vs 9000

Hallo,

ich probiere gerade mit meinem neuem Home-Lab und 10GBit rum.

Wenn ich zwei PCs mit jeweils einer BMC57810 und dem Switch TP-Link TL-SG3428XMP mit einem DAC verbinde komme ich mit netio auf ca. 550 MB/Sek.

Daran kann man sicher noch ein bisschen feilen, aber das ist erst mal egal.

Ich hab hier einen gebrauchten Fujitsu TX13020M2 mit 4Kern Xeon und 64GB ECC RAM und auch so einer BMC57810.

Dort läuft ESXi 7.0 und darin eine VM mit pfsense.

Jetzt komme ich zu einem Problem.

In ESXI ist die maximale MTU 9000.

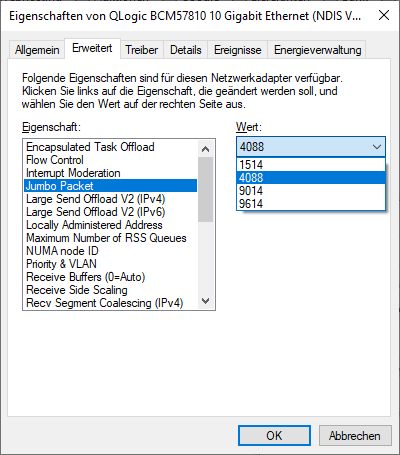

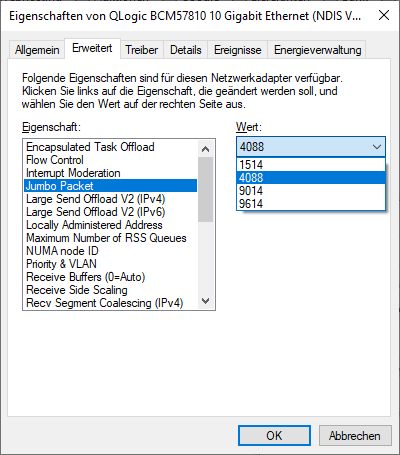

Bei den BMC57810 kann ich aber nur 1514, 4088, 9014 und 9614 einstellen.

Es ist eine Auswahlbox. Ich kann keine Werte eintragen.

9014 ist zu groß und sorgt in Verbindung mit dem ESXi zu fragmentierung und bei netio zu Werte von eher 30 MB/Sek.

Aktuell verwende ich eine MTU von 4088 bei der Netzwerkkarte. Damit komme ich so Werte von ca. 250 MB/Sek.

Immer noch schneller als 1 GBit, aber trotzdem irgendwie doof.

Hat Jemand einen Tipp?

Stefan

ich probiere gerade mit meinem neuem Home-Lab und 10GBit rum.

Wenn ich zwei PCs mit jeweils einer BMC57810 und dem Switch TP-Link TL-SG3428XMP mit einem DAC verbinde komme ich mit netio auf ca. 550 MB/Sek.

Daran kann man sicher noch ein bisschen feilen, aber das ist erst mal egal.

Ich hab hier einen gebrauchten Fujitsu TX13020M2 mit 4Kern Xeon und 64GB ECC RAM und auch so einer BMC57810.

Dort läuft ESXi 7.0 und darin eine VM mit pfsense.

Jetzt komme ich zu einem Problem.

In ESXI ist die maximale MTU 9000.

Bei den BMC57810 kann ich aber nur 1514, 4088, 9014 und 9614 einstellen.

Es ist eine Auswahlbox. Ich kann keine Werte eintragen.

9014 ist zu groß und sorgt in Verbindung mit dem ESXi zu fragmentierung und bei netio zu Werte von eher 30 MB/Sek.

Aktuell verwende ich eine MTU von 4088 bei der Netzwerkkarte. Damit komme ich so Werte von ca. 250 MB/Sek.

Immer noch schneller als 1 GBit, aber trotzdem irgendwie doof.

Hat Jemand einen Tipp?

Stefan

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 1703617448

Url: https://administrator.de/forum/mtu-zwischen-esxi-und-qlogic-bmc57810-mit-10gbit-dacs-4088-oder-9014-vs-9000-1703617448.html

Ausgedruckt am: 19.07.2025 um 03:07 Uhr

5 Kommentare

Neuester Kommentar

Welches Protokoll wird da genutzt?

Im Falle von TCP dürfte es an sich nie zu Fragmentierung kommen, weil ja im Handshake die MSS ausgehandelt und der niedrigst mögliche Wert auf der Verbindung genutzt wird.

Eigentlich sollte also die Einstellung 9014 nicht zu Fragmentierung führen, aber die maximal mögliche MTU (9000) ausreizen.

Bist du dir sicher, dass wirklich Fragmentierung auftritt und nicht doch ein anderes Problem dahinter steckt?

Im Falle von TCP dürfte es an sich nie zu Fragmentierung kommen, weil ja im Handshake die MSS ausgehandelt und der niedrigst mögliche Wert auf der Verbindung genutzt wird.

Eigentlich sollte also die Einstellung 9014 nicht zu Fragmentierung führen, aber die maximal mögliche MTU (9000) ausreizen.

Bist du dir sicher, dass wirklich Fragmentierung auftritt und nicht doch ein anderes Problem dahinter steckt?

Zitat von @StefanKittel:

Wenn ich bei den Netzwerkkarten der beiden PCs 9014 eintrage komme ich auf deutlich niedrigere Werte als mit 4088.

Deshalb galt 1. Gedanke der MTU und dass man bei ESXi nur 9000 eintragen kann.

Bist du dir sicher, dass wirklich Fragmentierung auftritt und nicht doch ein anderes Problem dahinter steckt?

nöWenn ich bei den Netzwerkkarten der beiden PCs 9014 eintrage komme ich auf deutlich niedrigere Werte als mit 4088.

Deshalb galt 1. Gedanke der MTU und dass man bei ESXi nur 9000 eintragen kann.

Kannst du das mit Wireshark einmal verifizieren?

In der PFsense kann ich ja auch noch die MSS eintragen.

Aber da verlasse ich meinen Wohlfühlbereich.

MSS sind die maximalen Nutzdaten oder?

Aber da verlasse ich meinen Wohlfühlbereich.

MSS sind die maximalen Nutzdaten oder?

Wie ist diese pfSense involviert? Welche MTU ist dort auf den Interfaces konfiguriert?

Wenn die z.B. dazwischen steckt, aber nur mit 1500 Bytes arbeitet und dafür fragmentiert, wäre das natürlich der Performance-Killer.

netio mit TCP

Ist uralt und nicht mehr empfehlenswert zum Testen. Du solltest besser iPerf3 verwenden und dann mehrere Streams eröffnen was realistischer ist.MTU kann man auf der pfSense nur auf dem Parent Interface bzw. bei LAGs nur auf dem laggx Interface setzen was dann automatisch auch für alle virtuellen Interfaces dadrüber gilt.

forum.netgate.com/topic/141714/mtu-settings/10

Lesenswert ist ggf. das hier noch zum Thema: PfSense RX Error auf WAN