Problem mit Bonjour (mDNS) im VPN

Hallo Ihr Lieben,

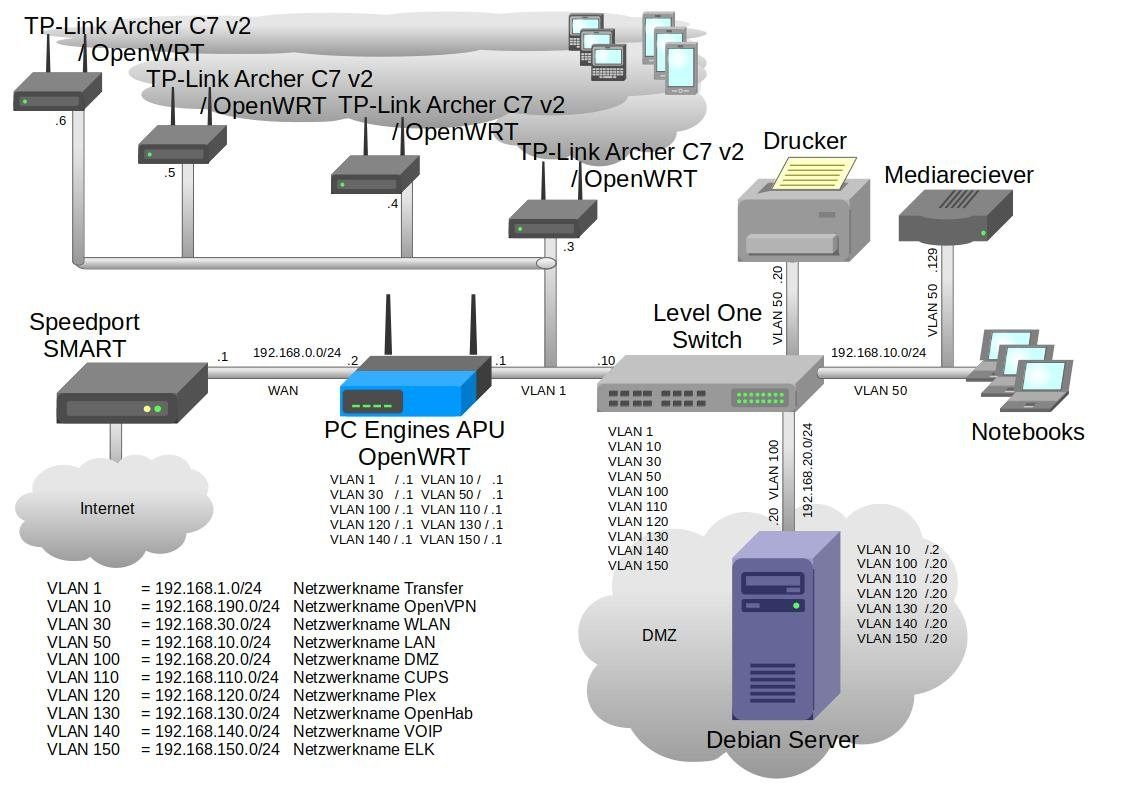

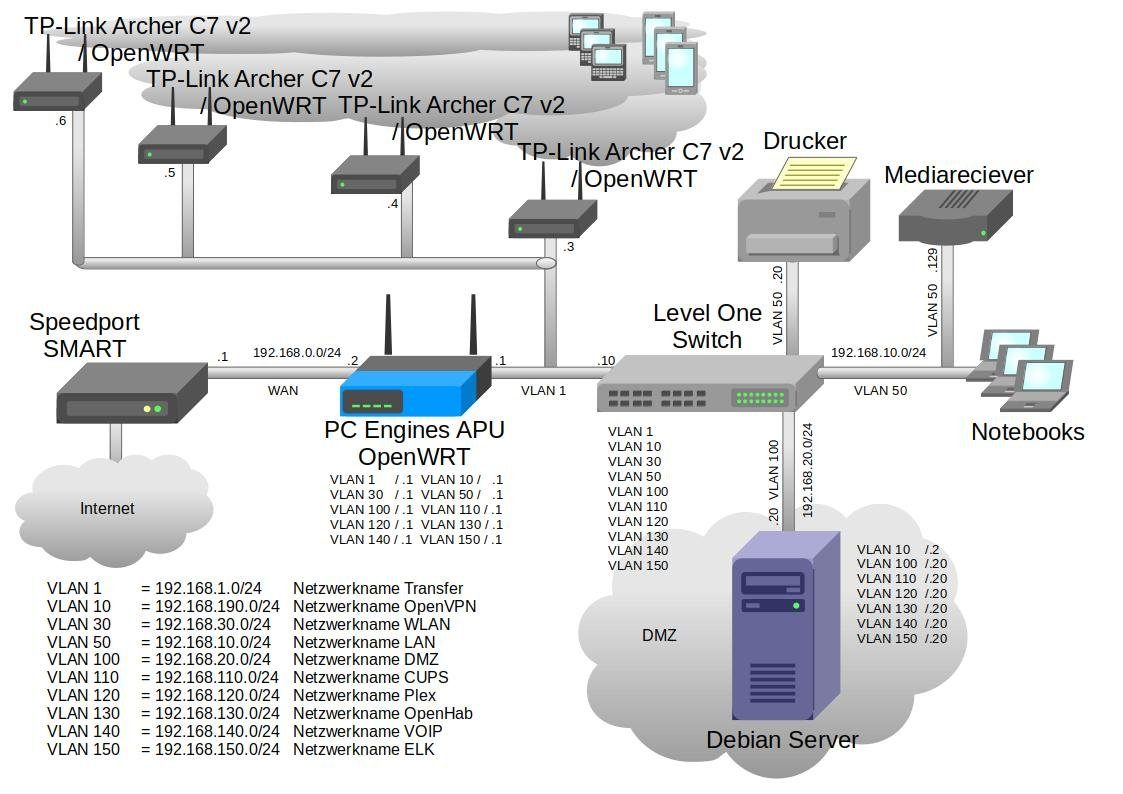

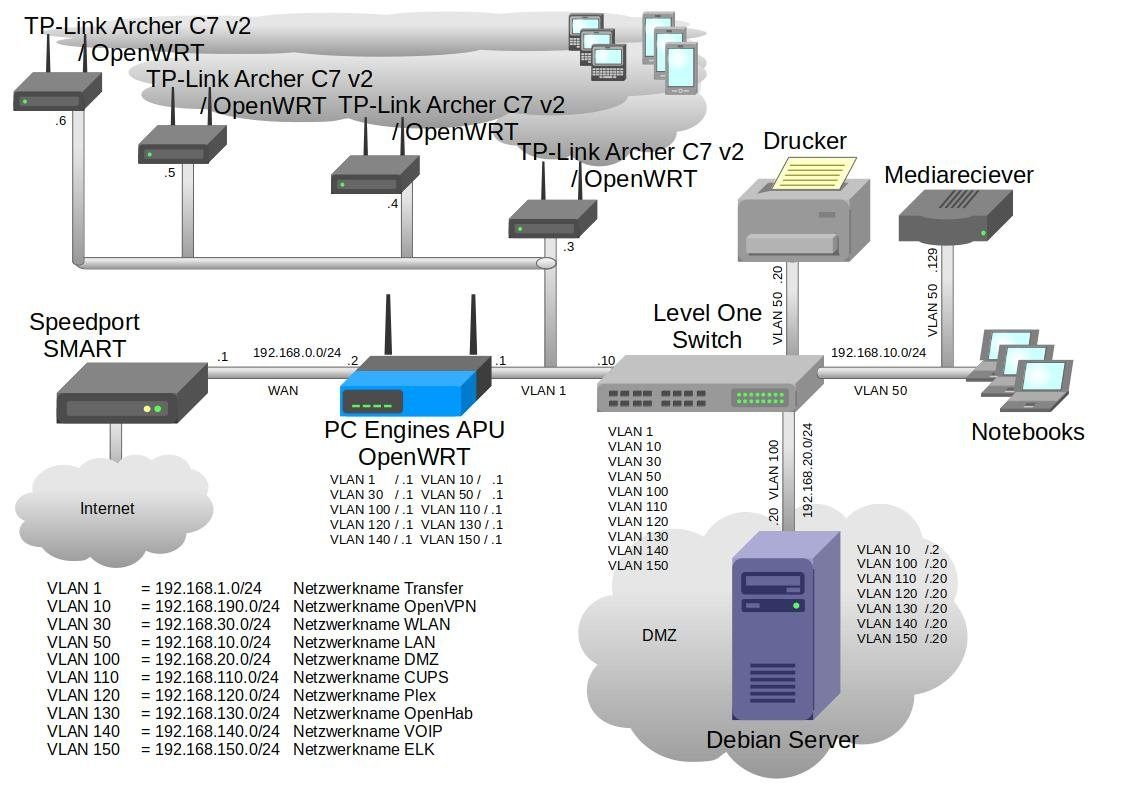

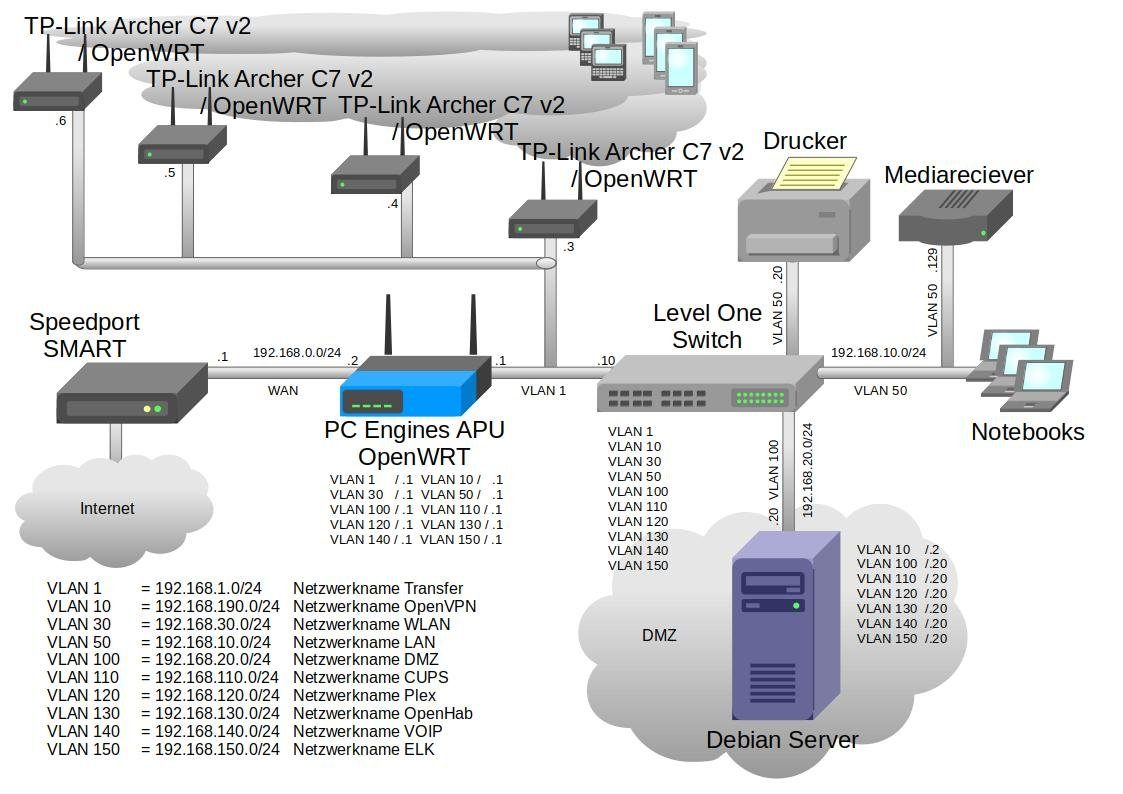

wenn ich mich mit meinen Samsung Smartphone im VPN Netz befinde bekomme ich nicht mein Netzwerkdrucker angezeigt. Im WLAN schon. Wie sieht mein netz aus?

Mein OpenVPN Server läuft auf ein Debian Buster Server. Der Dienst wird an der IP-Adresse 192.168.190.2, VLAN 110 bereitgestellt. Alle OpenVPN Verbidungen werden über TAP hergestellt. Über TUN habe ich es noch nicht hinbekommen, weil ich die IP-Adressen zentral vergeben möchte und Unicast / Multicast ins VPN sende um IPTV zu sehen.

Folgende Dienste werden mir im VPN Netz auf dem Debian Server angezeigt. Unter anderem mein Netzwerkdrucker den ich gerne für alle meine benutzten Endgeräte (IOS, Android, WIN10, Linux) verfügbar haben möchte:

Die Route auf dem Debian Server:

Und noch die Interface Informationen meines Debian Server

Auf meinen zentralen Router habe ich folgendes Programm installiert um Drucker in verschiedenen Netzsegemente bekannt zu machen:

Meine avahi-daemon.conf ist wie folgt konfiguriert:

Ein avahi-brows -at zeigt mir folgende Ergebnisse:

Auf der OpenWRT Firewall habe ich für die Zone OpenVPN folgendes eingestellt:

Mein VPN Client Pro App auf mein Samsung Phone hat folgende Netzwerk Informationen:

Leider sehe ich auf mein Samsung Phone keine Netzwerkdrucker. Stimmt was am Regelwerk der Firewall nicht, oder an der avahi-daemon.conf? Findet Ihr den Fehler? Ein tcpdump kann ich Euch leider nicht zur Verfügung stellen, weil im aktuellen Build ich das Programm nicht gebildet bekomme. Da scheint es ein Bug zu geben.

Lieben Gruß von Stefan Harbich

wenn ich mich mit meinen Samsung Smartphone im VPN Netz befinde bekomme ich nicht mein Netzwerkdrucker angezeigt. Im WLAN schon. Wie sieht mein netz aus?

Mein OpenVPN Server läuft auf ein Debian Buster Server. Der Dienst wird an der IP-Adresse 192.168.190.2, VLAN 110 bereitgestellt. Alle OpenVPN Verbidungen werden über TAP hergestellt. Über TUN habe ich es noch nicht hinbekommen, weil ich die IP-Adressen zentral vergeben möchte und Unicast / Multicast ins VPN sende um IPTV zu sehen.

Folgende Dienste werden mir im VPN Netz auf dem Debian Server angezeigt. Unter anderem mein Netzwerkdrucker den ich gerne für alle meine benutzten Endgeräte (IOS, Android, WIN10, Linux) verfügbar haben möchte:

root@dsme01:~# avahi-browse -at

+ bond0.110 IPv6 f8:ff:c2:ad:5b:4f@fe80::faff:c2ff:fead:5b4f _apple-mobdev2._tcp local

+ bond0.110 IPv4 f8:ff:c2:ad:5b:4f@fe80::faff:c2ff:fead:5b4f _apple-mobdev2._tcp local

+ bond0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ bond0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ bond0.110 IPv6 AirPrint HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ bond0.110 IPv6 AirPrint HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ bond0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ bond0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ bond0.110 IPv4 AirPrint HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ bond0.110 IPv4 AirPrint HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ bond0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipps._tcp local

+ bond0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipps._tcp local

+ bond0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipps._tcp local

+ bond0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipps._tcp local

+ bond0.110 IPv4 openhab-ssl (4) _openhab-server-ssl._tcp local

+ bond0.110 IPv4 openhab-ssl (3) _openhab-server-ssl._tcp local

+ bond0.110 IPv4 openhab (4) _openhab-server._tcp local

+ bond0.110 IPv4 openhab (3) _openhab-server._tcp local

+ bond0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _printer._tcp local

+ bond0.110 IPv6 CUPS @ cups _http._tcp local

+ bond0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _printer._tcp local

+ bond0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _printer._tcp local

+ bond0.110 IPv4 CUPS @ cups _http._tcp local

+ bond0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _printer._tcp local

root@dsme01:~# netstat -tulpen | grep 1194root@dsme01:~# route

Kernel-IP-Routentabelle

Ziel Router Genmask Flags Metric Ref Use Iface

default 192.168.20.1 0.0.0.0 UG 0 0 0 bond0

192.168.20.0 0.0.0.0 255.255.255.0 U 0 0 0 bond0

192.168.110.0 0.0.0.0 255.255.255.0 U 0 0 0 bond0.110

192.168.120.0 0.0.0.0 255.255.255.0 U 0 0 0 bond0.120

192.168.130.0 0.0.0.0 255.255.255.0 U 0 0 0 bond0.130

192.168.140.0 0.0.0.0 255.255.255.0 U 0 0 0 bond0.140

192.168.150.0 0.0.0.0 255.255.255.0 U 0 0 0 bond0.150

192.168.190.0 0.0.0.0 255.255.255.0 U 0 0 0 br0root@dsme01:~# ifconfig

bond0: flags=5187<UP,BROADCAST,RUNNING,MASTER,MULTICAST> mtu 1500

inet 192.168.20.20 netmask 255.255.255.0 broadcast 192.168.20.255

inet6 fe80::225:90ff:fed6:60c7 prefixlen 64 scopeid 0x20<link>

ether 00:25:90:d6:60:c7 txqueuelen 1000 (Ethernet)

RX packets 13700176 bytes 12664829409 (11.7 GiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 8488361 bytes 4415075261 (4.1 GiB)

TX errors 0 dropped 34 overruns 0 carrier 0 collisions 0

bond0.10: flags=4419<UP,BROADCAST,RUNNING,PROMISC,MULTICAST> mtu 1500

inet6 fe80::225:90ff:fed6:60c7 prefixlen 64 scopeid 0x20<link>

ether 00:25:90:d6:60:c7 txqueuelen 1000 (Ethernet)

RX packets 3686774 bytes 3214302672 (2.9 GiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 648921 bytes 239498011 (228.4 MiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

bond0.110: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.110.20 netmask 255.255.255.0 broadcast 192.168.110.255

inet6 fe80::225:90ff:fed6:60c7 prefixlen 64 scopeid 0x20<link>

ether 00:25:90:d6:60:c7 txqueuelen 1000 (Ethernet)

RX packets 161819 bytes 54641415 (52.1 MiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 82861 bytes 15750403 (15.0 MiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

bond0.120: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.120.20 netmask 255.255.255.0 broadcast 192.168.120.255

inet6 fe80::225:90ff:fed6:60c7 prefixlen 64 scopeid 0x20<link>

ether 00:25:90:d6:60:c7 txqueuelen 1000 (Ethernet)

RX packets 172939 bytes 26650764 (25.4 MiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 80845 bytes 13832112 (13.1 MiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

bond0.130: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.130.20 netmask 255.255.255.0 broadcast 192.168.130.255

inet6 fe80::225:90ff:fed6:60c7 prefixlen 64 scopeid 0x20<link>

ether 00:25:90:d6:60:c7 txqueuelen 1000 (Ethernet)

RX packets 149728 bytes 13021043 (12.4 MiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 75293 bytes 13623216 (12.9 MiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

bond0.140: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.140.20 netmask 255.255.255.0 broadcast 192.168.140.255

inet6 fe80::225:90ff:fed6:60c7 prefixlen 64 scopeid 0x20<link>

ether 00:25:90:d6:60:c7 txqueuelen 1000 (Ethernet)

RX packets 902349 bytes 172958466 (164.9 MiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 391263 bytes 86492364 (82.4 MiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

bond0.150: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.150.20 netmask 255.255.255.0 broadcast 192.168.150.255

inet6 fe80::225:90ff:fed6:60c7 prefixlen 64 scopeid 0x20<link>

ether 00:25:90:d6:60:c7 txqueuelen 1000 (Ethernet)

RX packets 150466 bytes 13061858 (12.4 MiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 75295 bytes 13623897 (12.9 MiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

br0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 192.168.190.2 netmask 255.255.255.0 broadcast 192.168.190.255

inet6 fe80::225:90ff:fed6:60c7 prefixlen 64 scopeid 0x20<link>

ether 00:25:90:d6:60:c7 txqueuelen 1000 (Ethernet)

RX packets 1519586 bytes 336341816 (320.7 MiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 154067 bytes 23711631 (22.6 MiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

eth1: flags=6211<UP,BROADCAST,RUNNING,SLAVE,MULTICAST> mtu 1500

ether 00:25:90:d6:60:c7 txqueuelen 1000 (Ethernet)

RX packets 12147175 bytes 12133525505 (11.3 GiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 689488 bytes 106382166 (101.4 MiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

device interrupt 20 memory 0xdfb00000-dfb20000

eth2: flags=6211<UP,BROADCAST,RUNNING,SLAVE,MULTICAST> mtu 1500

ether 00:25:90:d6:60:c7 txqueuelen 1000 (Ethernet)

RX packets 1553001 bytes 531303904 (506.6 MiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 7798873 bytes 4308693095 (4.0 GiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

device interrupt 16 memory 0xdf900000-df920000

lo: flags=73<UP,LOOPBACK,RUNNING> mtu 65536

inet 127.0.0.1 netmask 255.0.0.0

inet6 ::1 prefixlen 128 scopeid 0x10<host>

loop txqueuelen 1 (Lokale Schleife)

RX packets 10900082 bytes 57948346150 (53.9 GiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 10900082 bytes 57948346150 (53.9 GiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

tap0: flags=4419<UP,BROADCAST,RUNNING,PROMISC,MULTICAST> mtu 1500

inet6 fe80::5c5a:baff:fedd:e1bf prefixlen 64 scopeid 0x20<link>

ether 5e:5a:ba:dd:e1:bf txqueuelen 100 (Ethernet)

RX packets 1396 bytes 219159 (214.0 KiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 10133 bytes 2304100 (2.1 MiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0avahi-utilsroot@rome01:~# cat /etc/avahi/avahi-daemon.conf

[server]

host-name=rome01

#host-name=foo

domain-name=local

use-ipv4=yes

#use-ipv6=no

## use-ipv6=yes

allow-interfaces=eth0.110,br-wlan,eth0.10

## check-response-ttl=no

## use-iff-running=no

## enable-dbus=no

[publish]

#publish-addresses=yes

#publish-hinfo=yes

#publish-workstation=yes

#publish-workstation=no

#publish-domain=yes

#publish-dns-servers=192.168.1.1

#publish-resolv-conf-dns-servers=yes

[reflector]

enable-reflector=yes

## enable-reflector=no

#reflect-ipv=no

[rlimits]

#rlimit-as=

#rlimit-core=0

#rlimit-data=4194304

#rlimit-fsize=0

#rlimit-nofile=30

#rlimit-stack=4194304

#rlimit-nproc=3root@rome01:~# avahi-browse -at

+ eth0.10 IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ eth0.10 IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ eth0.10 IPv6 AirPrint HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ eth0.10 IPv6 AirPrint HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ eth0.10 IPv4 AirPrint HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ eth0.10 IPv4 AirPrint HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ eth0.10 IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ eth0.10 IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ eth0.110 IPv6 AirPrint HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ eth0.110 IPv6 AirPrint HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ eth0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ eth0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ eth0.110 IPv4 AirPrint HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ eth0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ eth0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ eth0.110 IPv4 AirPrint HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ br-wlan IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ br-wlan IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ br-wlan IPv6 AirPrint HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ br-wlan IPv6 AirPrint HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ br-wlan IPv4 AirPrint HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ br-wlan IPv4 AirPrint HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ br-wlan IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipp._tcp local

+ br-wlan IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipp._tcp local

+ eth0.10 IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipps._tcp local

+ eth0.10 IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipps._tcp local

+ eth0.10 IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipps._tcp local

+ eth0.10 IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipps._tcp local

+ eth0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipps._tcp local

+ eth0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipps._tcp local

+ eth0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipps._tcp local

+ eth0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipps._tcp local

+ br-wlan IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipps._tcp local

+ br-wlan IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipps._tcp local

+ br-wlan IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _ipps._tcp local

+ br-wlan IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _ipps._tcp local

+ eth0.10 IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _printer._tcp local

+ eth0.10 IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _printer._tcp local

+ eth0.10 IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _printer._tcp local

+ eth0.10 IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _printer._tcp local

+ eth0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _printer._tcp local

+ eth0.110 IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _printer._tcp local

+ eth0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _printer._tcp local

+ eth0.110 IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _printer._tcp local

+ br-wlan IPv6 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _printer._tcp local

+ br-wlan IPv6 HP_Color_LaserJet_CM1312nfi_MFP @ cups _printer._tcp local

+ br-wlan IPv4 HP_Color_LaserJet_CM1312nfi_MFP_fax @ cups _printer._tcp local

+ br-wlan IPv4 HP_Color_LaserJet_CM1312nfi_MFP @ cups _printer._tcp local

+ eth0.10 IPv6 CUPS @ cups _http._tcp local

+ eth0.10 IPv4 CUPS @ cups _http._tcp local

+ eth0.110 IPv6 CUPS @ cups _http._tcp local

+ eth0.110 IPv4 CUPS @ cups _http._tcp local

+ br-wlan IPv6 CUPS @ cups _http._tcp local

+ br-wlan IPv4 CUPS @ cups _http._tcp local

+ eth0.10 IPv4 openhab (4) _openhab-server._tcp local

+ eth0.10 IPv4 openhab (3) _openhab-server._tcp local

+ eth0.110 IPv4 openhab (4) _openhab-server._tcp local

+ eth0.110 IPv4 openhab (3) _openhab-server._tcp local

+ br-wlan IPv4 openhab (4) _openhab-server._tcp local

+ br-wlan IPv4 openhab (3) _openhab-server._tcp local

+ eth0.10 IPv4 openhab-ssl (4) _openhab-server-ssl._tcp local

+ eth0.10 IPv4 openhab-ssl (3) _openhab-server-ssl._tcp local

+ eth0.110 IPv4 openhab-ssl (4) _openhab-server-ssl._tcp local

+ eth0.110 IPv4 openhab-ssl (3) _openhab-server-ssl._tcp local

+ br-wlan IPv4 openhab-ssl (4) _openhab-server-ssl._tcp local

+ br-wlan IPv4 openhab-ssl (3) _openhab-server-ssl._tcp localroot@rome01:~# cat /etc/config/firewall

config zone

option name 'openvpn'

option output 'ACCEPT'

option network 'openvpn'

option log '1'

option input 'REJECT'

option forward 'REJECT'

config rule

option target 'ACCEPT'

option src 'openvpn'

option proto 'udp'

option dest_port '5353'

option name 'Allow-OpenVPN-mDNS-Server'

option src_ip '192.168.190.1'

option dest_ip '224.0.0.251'

config rule

option target 'ACCEPT'

option src 'openvpn'

option name 'Allow-OpenVPN-mDNS-Clients'

option proto 'udp'

option src_port '5353'

option dest_port '5353' IPv4 tun address:

192.168.190.65/24

IPv4 tun routes:

192.168.20.0/24 via 192.168.190.2

192.168.190.0/24

0.0.0.0/1 via 192.168.190.1

128.0.0.0/1 via 192.168.190.1

DNS server:

192.168.20.20

DNS suffixes:

intern.example.comLieben Gruß von Stefan Harbich

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 533589

Url: https://administrator.de/forum/problem-mit-bonjour-mdns-im-vpn-533589.html

Ausgedruckt am: 01.08.2025 um 05:08 Uhr

6 Kommentare

Neuester Kommentar

Tolle Netzwerk Skizze ! Womit ist das gemacht ?

Selbst OpenVPN rät in seinen Design Empfehlungen dringenst davon ab, denn es transportiert den gesamten Broad- und Multicast Traffic aller per TAP angeschlossenen Tunnel was die VPN Performance natürlich auf Grasnarben Niveau bringt.

TUN ist der millionenfache Standard. Wieso du das nicht hinbekommst ist völlig unverständlich. Ein simpler Klassiker wie du hier an einer einfachen Raspberry Pi Konfig sehen kannst:

Clientverbindung OpenVPN Mikrotik

Sehr wahrscheinlich hast du den typischen Anfängerfehler begangen und das Routing der VPN Netze vergessen oder falsch gemacht bei einem OVPN Server im internen Netz ?!

OpenVPN Server installieren auf pfSense Firewall, Mikrotik. DD-WRT oder GL.inet Router

(2tes und 3tes Bild)

Aber auch hier:

Problem mit site 2 site VPN

Drucken über VPN - CCD Files

Obwohl man das bei dem semiprofessionellen Design deines Netzes fast nicht glauben kann.

Das solltest du auf Dauer aber dringend fixen und auf Routing umstellen wenn dein Netzwerk und VPN performant und skalierbar bleiben soll !

Aber mal zurück zur eigentlichen Thread Thematik:

mDNS nutzt bekanntlich eine Multicast Link Local Adresse 224.0.0.251 (de.wikipedia.org/wiki/Zeroconf#Multicast_DNS)

Diese Adressen sind intern festgenagelt auf einen TTL von 1 sind also in segmentierten IP Netzen, wie deinen, generell nicht routebar. Auch nicht mit PIM Multicast Routing, da sie durch die festgenagelte TTL eben keine Router Hops überwinden können. Sie funktionieren also rein nur in einem flachen Layer 2 Netz.

Die Kardinalsfrage ist nun also welches des lokalen LAN oder VLAN Segmente du über das TAP Interface im OVPN zusammen bridgest ?? Denn nur dort kann mDNS (Bonjour) funktionieren. Nicht aber in den gerouteten anderen VLANs.

Hast du das auf dem Radar ?

Wenn Drucker und (Samsung) Client also in separaten und damit gerouteten IP Netzen sind dann brauchst du im Client Netz einen separaten AVAHI Daemon der dort die Ziel IP des Druckers im Client Segment per Multicast verteilt.

Netzwerk Management Server mit Raspberry Pi

Wäre hilfreich zu sehen ob die mDNS Multicasts am anderen Ende des gebridgten Netzes auch ankommen. Wie gesagt es funktioniert ohne separaten AVAHI Daemon rein nur in gebridgten Umgebungen wegen der Link Local MC Adresse.

Alle OpenVPN Verbidungen werden über TAP hergestellt. Über TUN habe ich es noch nicht hinbekommen

Nicht dein Ernst, oder ?? Du machst Layer 2 Bridging im OpenVPN Tunnel ?? Wie gruselig !Selbst OpenVPN rät in seinen Design Empfehlungen dringenst davon ab, denn es transportiert den gesamten Broad- und Multicast Traffic aller per TAP angeschlossenen Tunnel was die VPN Performance natürlich auf Grasnarben Niveau bringt.

TUN ist der millionenfache Standard. Wieso du das nicht hinbekommst ist völlig unverständlich. Ein simpler Klassiker wie du hier an einer einfachen Raspberry Pi Konfig sehen kannst:

Clientverbindung OpenVPN Mikrotik

Sehr wahrscheinlich hast du den typischen Anfängerfehler begangen und das Routing der VPN Netze vergessen oder falsch gemacht bei einem OVPN Server im internen Netz ?!

OpenVPN Server installieren auf pfSense Firewall, Mikrotik. DD-WRT oder GL.inet Router

(2tes und 3tes Bild)

Aber auch hier:

Problem mit site 2 site VPN

Drucken über VPN - CCD Files

Obwohl man das bei dem semiprofessionellen Design deines Netzes fast nicht glauben kann.

Das solltest du auf Dauer aber dringend fixen und auf Routing umstellen wenn dein Netzwerk und VPN performant und skalierbar bleiben soll !

und Unicast / Multicast ins VPN sende um IPTV zu sehen.

Deshalb das TAP Interface. OK, letztlich aber auch falsch, denn IPTV Multicast kannst du über PIM auch immer über ein geroutetes IP Netz problemlos übertragen. IGMP Snooping ist dann ebenso Pflicht im Netz...Aber mal zurück zur eigentlichen Thread Thematik:

mDNS nutzt bekanntlich eine Multicast Link Local Adresse 224.0.0.251 (de.wikipedia.org/wiki/Zeroconf#Multicast_DNS)

Diese Adressen sind intern festgenagelt auf einen TTL von 1 sind also in segmentierten IP Netzen, wie deinen, generell nicht routebar. Auch nicht mit PIM Multicast Routing, da sie durch die festgenagelte TTL eben keine Router Hops überwinden können. Sie funktionieren also rein nur in einem flachen Layer 2 Netz.

Die Kardinalsfrage ist nun also welches des lokalen LAN oder VLAN Segmente du über das TAP Interface im OVPN zusammen bridgest ?? Denn nur dort kann mDNS (Bonjour) funktionieren. Nicht aber in den gerouteten anderen VLANs.

Hast du das auf dem Radar ?

Wenn Drucker und (Samsung) Client also in separaten und damit gerouteten IP Netzen sind dann brauchst du im Client Netz einen separaten AVAHI Daemon der dort die Ziel IP des Druckers im Client Segment per Multicast verteilt.

Netzwerk Management Server mit Raspberry Pi

Stimmt was am Regelwerk der Firewall nicht

Vermutlich nicht, denn auf den rein internen Interfaces die nur lokale interne Netze verbinden macht man ja niemals weder NAT noch Firewalling. In sofern kann es das normal nicht sein.Ein tcpdump kann ich Euch leider nicht zur Verfügung stellen, weil im aktuellen Build ich das Programm nicht gebildet bekomme.

Muss auch nicht sein denn ein apt install tcpdump installiert dir das bequem aus dem Repository. Wäre hilfreich zu sehen ob die mDNS Multicasts am anderen Ende des gebridgten Netzes auch ankommen. Wie gesagt es funktioniert ohne separaten AVAHI Daemon rein nur in gebridgten Umgebungen wegen der Link Local MC Adresse.

Der OpenVPN Client (z.B. mein Android Smartphone) konnte per VLC kein IPTV schauen

Hier steht wie man das selber testen kann mit PIM Routing:Fehlersuche im lokalem Netzwerk (RSTP, MRP, Multicast)

bzw. hier am Beispiel eines MT Routers:

UPNP mit Mikrotik Routerboard hEX PoE und D-Link DGS-1210-24 Switch

Sehr komisch, obwohl tcpdump im Verzeichnis /usr/sbin installiert wurde. Warum auch immer???

Ruf es mal mit dem kompletten Pfad /usr/sbin/tcpdump -i eth2 auf dann sollte es ganz sicher laufen ! Dir fehlt vermutlich /usr/sbin im Suchpfad ?!

@sharbich wie siehts denn mittlerweile aus? Haste es hinbekommen und lässt deine Nachwelt noch teilhaben an deiner Lösung? :D

@sharbich anscheinend nicht ...

Hier steht wie man es hinbekommt. Zumindestens bei der pfSense/OPNsense:

Apple AirPrint über VLANs

Ansonsten hilft,wie immer, ein kleiner Raspberry Pi (Zero) als mDNS Proxy:

Netzwerk Management Server mit Raspberry Pi

Apple AirPrint über VLANs

Ansonsten hilft,wie immer, ein kleiner Raspberry Pi (Zero) als mDNS Proxy:

Netzwerk Management Server mit Raspberry Pi