ESXi-Server mit 2 Netzwerkanschlüssen an HP-Switch mit Comware anschließen

Moin,

ich habe hier zwei HP Switche als Stack mit Comware. An diesen beiden Switchen sollen 2 ESXi-Server angeschlossen werden. Beide ESXi-Server haben jeweils Intelkarten mit Doppelanschlüssen eingebaut. Ich möchte von den ESXi-Servern, jeweils ein Kabel am Switch 1 anschließen und das andere Kabel soll an Switch 2 gehen.

Das soll der Ausfallsicherheit dienen.

Jetzt bin ich mir nicht sicher, wie ich den phys. Switch einstellen muss.

Bei den Procurven-Geräten hatte ich damals verschiedene Trunks (TRK1, TRK2) konfiguriert.

Soll ich hier für ESXi-1 mit einer Link-Aggregation 1 und für den anderen Server mit einer Link-Aggregation 2 arbeiten?

Oder die 4 Ports als Trunk konfigurieren?

Für die Version mit LAG, sähe das dann so aus:

interface bridge-aggregation 1

link-aggregation mode dynamic

quit

interf T1/0/1

port link-aggregation group 1

quit

interf T2/0/1

port link-aggregation group 1

quit

interface bridge-aggre 1

description "LAG vom ESXi-1"

port link-type trunk

undo port trunk permit vlan 1

port trunk permit vlan 100

quit

Für ESXi-2 eine weitere LAG.

Und ohne LAG so:

interface range T1/0/1,T1/0/2,T2/0/1,T2/0/2

port link-type trunk

port trunk permit vlan 100

undo port trunk permit vlan 1

ich habe hier zwei HP Switche als Stack mit Comware. An diesen beiden Switchen sollen 2 ESXi-Server angeschlossen werden. Beide ESXi-Server haben jeweils Intelkarten mit Doppelanschlüssen eingebaut. Ich möchte von den ESXi-Servern, jeweils ein Kabel am Switch 1 anschließen und das andere Kabel soll an Switch 2 gehen.

Das soll der Ausfallsicherheit dienen.

Jetzt bin ich mir nicht sicher, wie ich den phys. Switch einstellen muss.

Bei den Procurven-Geräten hatte ich damals verschiedene Trunks (TRK1, TRK2) konfiguriert.

Soll ich hier für ESXi-1 mit einer Link-Aggregation 1 und für den anderen Server mit einer Link-Aggregation 2 arbeiten?

Oder die 4 Ports als Trunk konfigurieren?

Für die Version mit LAG, sähe das dann so aus:

interface bridge-aggregation 1

link-aggregation mode dynamic

quit

interf T1/0/1

port link-aggregation group 1

quit

interf T2/0/1

port link-aggregation group 1

quit

interface bridge-aggre 1

description "LAG vom ESXi-1"

port link-type trunk

undo port trunk permit vlan 1

port trunk permit vlan 100

quit

Für ESXi-2 eine weitere LAG.

Und ohne LAG so:

interface range T1/0/1,T1/0/2,T2/0/1,T2/0/2

port link-type trunk

port trunk permit vlan 100

undo port trunk permit vlan 1

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 394868

Url: https://administrator.de/forum/esxi-server-mit-2-netzwerkanschluessen-an-hp-switch-mit-comware-anschliessen-394868.html

Ausgedruckt am: 12.07.2025 um 17:07 Uhr

13 Kommentare

Neuester Kommentar

Moin,

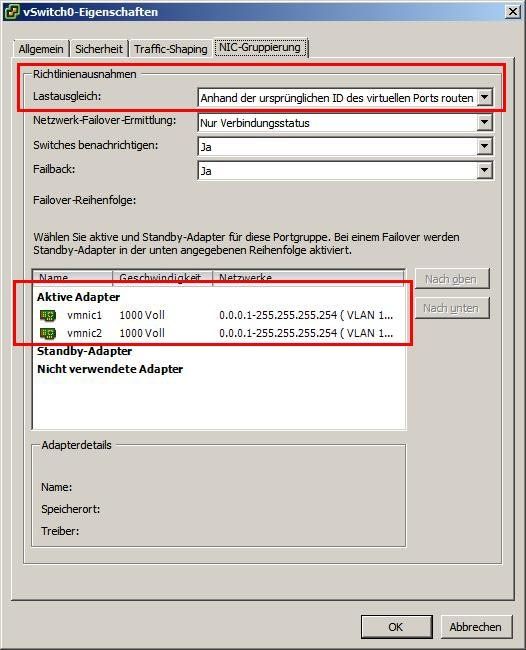

Du erstellst am ESXi einen vSwitch und packst die beiden NICs d'ran. Den Rest mach ESXi.

Du erstellst am ESXi einen vSwitch und packst die beiden NICs d'ran. Den Rest mach ESXi.

/EDIT: Zur KLarstellung: Die Switchport brauchen keine LAG/LACP/TRUNK o.ä. lediglich die gewünschten VLANS musst du tagged auf die Switchports konfigurieren.

lg,

Slainte

Jetzt bin ich mir nicht sicher, wie ich den phys. Switch einstellen muss.

Gar nichts /EDIT: Zur KLarstellung: Die Switchport brauchen keine LAG/LACP/TRUNK o.ä. lediglich die gewünschten VLANS musst du tagged auf die Switchports konfigurieren.

lg,

Slainte

Das soll der Ausfallsicherheit dienen.

Wie denn ??- Als LACP LAG (Link Aggregation und Failover)

- Als simples Active Standby Szenario

Da ist deine Beschreibung leider recht oberflächlich.

Vermutung nach den Zusatzinfos unten ist also ein LACP LAG !

Der ist immer beidseitig, sprich den musst du auch auf deinem Switch entsprechend einrichten sonst kommt der nicht zustande.

Wie das bei den HP Gruselgurken geht steht z.B. hier:

Netzwerk Management Server mit Raspberry Pi

Der ESXi kann grundsätzlich LAG/LACP, aber den ESXi zu konfigurieren macht eigentlich nur Sinn, wenn man echtes (CISCO-)Etherchannel verwendet.

Wenn man am ESXi keinen LACP konfiguriert, dann verteilt er die vNICs der VMs in der Reihenfolge wie sie hochgefahren werden "round-robin" auf alle aktiven NICs die auf der Portgroup konfiguriert sind. Fällt ein Link aus, "springen" die vNICs auf den anderen - und das ist bei LAG/LACP auch nicht anders (halt nur Sessionbasiert ... führt jetzt zuweit). Eine Session/Link kann in beiden Fällen nur soviel Bandbreite konsumieren, wie EIN Member-NIC in der LAG hergibt.

Nachlesen kann man das in der Networking Doku von VMWare ESXi bei VMWare (link hab ich gerade keinen zur Hand)

Wenn man am ESXi keinen LACP konfiguriert, dann verteilt er die vNICs der VMs in der Reihenfolge wie sie hochgefahren werden "round-robin" auf alle aktiven NICs die auf der Portgroup konfiguriert sind. Fällt ein Link aus, "springen" die vNICs auf den anderen - und das ist bei LAG/LACP auch nicht anders (halt nur Sessionbasiert ... führt jetzt zuweit). Eine Session/Link kann in beiden Fällen nur soviel Bandbreite konsumieren, wie EIN Member-NIC in der LAG hergibt.

Nachlesen kann man das in der Networking Doku von VMWare ESXi bei VMWare (link hab ich gerade keinen zur Hand)

LACP wird nur in vSphere 5.1, 5.5 und 6.0 mithilfe von vSphere Distributed Switches und Cisco Nexus 1000V

Ist auch hier beschrieben:rickardnobel.se/lacp-and-esxi-5-1/