Eternus DX100 S3 ESXi 7x Time out VMFS format

Hallo,

habe ein Problem:

FJT Eternus DX 100 S3

ProLiant DL560 Gen8 + HP Smart Array P822

P822 auf neueste Firmeware gebracht und HBA aktiviert. Probleme mit Claim über Vendor gelöst. Claim Error kommt seitdem nicht mehr.

1 TB Test Device auf den ESXi 7.0 U2 zu sehen. Formatieren bricht ab. Im GUI nur ATS Fehler zu sehen.

Via Command Line einmal versucht Speicher einzurichten. Partitionierung i.O. Beim Formatieren läuft es auf einen Timeout. Hier bin ich am verzweifeln. Heartbeat für vmfs5/ 6 auch einmal deakativiert. Aber es kommt noch wie vor der Timeout.

Eternus hat als Response "default". Mir fällt gerade nichts mehr ein.

mfg Crusher

PS:

ScsiClaimrule: 1495: Path vmhba1:C2:T1:L0 is claimed by plugin NMP, but current claimrule number 65531 indicates that it should be claimed by plugin HPP.

ScsiClaimrule: 1495: Path vmhba1:C2:T0:L0 is claimed by plugin NMP, but current claimrule number 65531 indicates that it should be claimed by plugin HPP.

Fixed mit

esxcli storage core claimrule add -r 49 -t vendor -V FUJITSU -M ETERNUS_DXL -P NMP --force-reserved

VMFS Heartbeat:

esxcli system settings advanced set -i 0 -o /VMFS3/UseATSForHBOnVMFS5

Immer noch ATS bzw. Time out Fehler

Fehler beim Erstellen von VMFS-Datenspeicher test - Vorgang fehlgeschlagen, Diagnosebericht: Unable to create Filesystem, please see VMkernel log for more details: Failed to check device /dev/disks/naa.600000e00d2800000028318400000000:4 capable of ATS

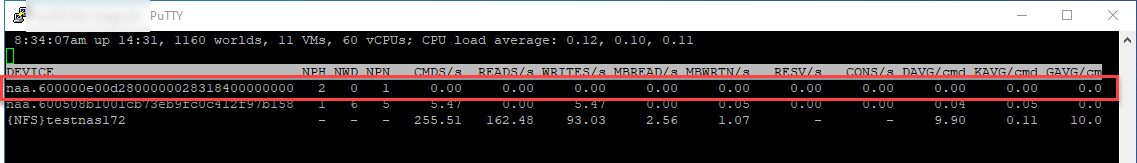

[root@esxi02:~] vmkfstools -C vmfs6 -S WD101 "/vmfs/devices/disks/naa.600000e00d2800000028318400000000"

create fs deviceName:'/vmfs/devices/disks/naa.600000e00d2800000028318400000000', fsShortName:'vmfs6', fsName:'WD101'

deviceFullPath:/dev/disks/naa.600000e00d2800000028318400000000 deviceFile:naa.600000e00d2800000028318400000000

Error executing ATS on /dev/disks/naa.600000e00d2800000028318400000000: Connection timed out

Failed to check device /dev/disks/naa.600000e00d2800000028318400000000 capable of ATS

Usage: vmkfstools -C [vmfs5|vmfs6|vfat] /vmfs/devices/disks/vml... or,

vmkfstools -C [vmfs5|vmfs6|vfat] /vmfs/devices/disks/naa... or,

vmkfstools -C [vmfs5|vmfs6|vfat] /vmfs/devices/disks/mpx.vmhbaA:T:L:P

Error: Connection timed out

habe ein Problem:

FJT Eternus DX 100 S3

ProLiant DL560 Gen8 + HP Smart Array P822

P822 auf neueste Firmeware gebracht und HBA aktiviert. Probleme mit Claim über Vendor gelöst. Claim Error kommt seitdem nicht mehr.

1 TB Test Device auf den ESXi 7.0 U2 zu sehen. Formatieren bricht ab. Im GUI nur ATS Fehler zu sehen.

Via Command Line einmal versucht Speicher einzurichten. Partitionierung i.O. Beim Formatieren läuft es auf einen Timeout. Hier bin ich am verzweifeln. Heartbeat für vmfs5/ 6 auch einmal deakativiert. Aber es kommt noch wie vor der Timeout.

Eternus hat als Response "default". Mir fällt gerade nichts mehr ein.

mfg Crusher

PS:

ScsiClaimrule: 1495: Path vmhba1:C2:T1:L0 is claimed by plugin NMP, but current claimrule number 65531 indicates that it should be claimed by plugin HPP.

ScsiClaimrule: 1495: Path vmhba1:C2:T0:L0 is claimed by plugin NMP, but current claimrule number 65531 indicates that it should be claimed by plugin HPP.

Fixed mit

esxcli storage core claimrule add -r 49 -t vendor -V FUJITSU -M ETERNUS_DXL -P NMP --force-reserved

VMFS Heartbeat:

esxcli system settings advanced set -i 0 -o /VMFS3/UseATSForHBOnVMFS5

Immer noch ATS bzw. Time out Fehler

Fehler beim Erstellen von VMFS-Datenspeicher test - Vorgang fehlgeschlagen, Diagnosebericht: Unable to create Filesystem, please see VMkernel log for more details: Failed to check device /dev/disks/naa.600000e00d2800000028318400000000:4 capable of ATS

[root@esxi02:~] vmkfstools -C vmfs6 -S WD101 "/vmfs/devices/disks/naa.600000e00d2800000028318400000000"

create fs deviceName:'/vmfs/devices/disks/naa.600000e00d2800000028318400000000', fsShortName:'vmfs6', fsName:'WD101'

deviceFullPath:/dev/disks/naa.600000e00d2800000028318400000000 deviceFile:naa.600000e00d2800000028318400000000

Error executing ATS on /dev/disks/naa.600000e00d2800000028318400000000: Connection timed out

Failed to check device /dev/disks/naa.600000e00d2800000028318400000000 capable of ATS

Usage: vmkfstools -C [vmfs5|vmfs6|vfat] /vmfs/devices/disks/vml... or,

vmkfstools -C [vmfs5|vmfs6|vfat] /vmfs/devices/disks/naa... or,

vmkfstools -C [vmfs5|vmfs6|vfat] /vmfs/devices/disks/mpx.vmhbaA:T:L:P

Error: Connection timed out

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 2725023220

Url: https://administrator.de/forum/eternus-dx100-s3-esxi-7x-time-out-vmfs-format-2725023220.html

Ausgedruckt am: 03.08.2025 um 00:08 Uhr

7 Kommentare

Neuester Kommentar

Moin,

also irgendwie werde ich - auch nach 5x durchlesen - nicht so ganz schlau aus Deinen Ausführungen.

Könntest Du die Frage vielleicht ein wenig sortierter formulieren?

Die wichtigste Frage wäre zunächst: Ist das ein Produktivsystem oder Deine (private) Spielwiese bzw. Testumgebung?

Weitere Fragen/Anmerkungen:

- Umgebung etwas ausführlicher beschreiben ...

- Wie wird das Storage angesprochen (NFS, iSCSI ...)?

- Welche Platte(n) sind im Storage verbaut (Hersteller, Modell, Schnittstelle)?

- Der Gen8 HP Server ist offiziell ja nicht mehr in der HCL für VMWare 7.x ...

- Werden für den P822 passende Treiber/Firmnwarekombinationen verwendet?

Grundsätzlich kann es sein, dass Du ATS komplett ausschalten musst, ein paar Links zur VMWare KB zum Thema:

-> kb.vmware.com/s/article/2113956?lang=de

-> kb.vmware.com/s/article/2146451

-> kb.vmware.com/s/article/83249

(hier bitte aber noch weiter recherchieren, Du hast die Kiste vor der Nase)

In jedem Fall auch mal ins vmkernel.log schauen, was da so an Fehlern aufläuft.

Gruß

cykes

also irgendwie werde ich - auch nach 5x durchlesen - nicht so ganz schlau aus Deinen Ausführungen.

Könntest Du die Frage vielleicht ein wenig sortierter formulieren?

Die wichtigste Frage wäre zunächst: Ist das ein Produktivsystem oder Deine (private) Spielwiese bzw. Testumgebung?

Weitere Fragen/Anmerkungen:

- Umgebung etwas ausführlicher beschreiben ...

- Wie wird das Storage angesprochen (NFS, iSCSI ...)?

- Welche Platte(n) sind im Storage verbaut (Hersteller, Modell, Schnittstelle)?

- Der Gen8 HP Server ist offiziell ja nicht mehr in der HCL für VMWare 7.x ...

- Werden für den P822 passende Treiber/Firmnwarekombinationen verwendet?

Grundsätzlich kann es sein, dass Du ATS komplett ausschalten musst, ein paar Links zur VMWare KB zum Thema:

-> kb.vmware.com/s/article/2113956?lang=de

-> kb.vmware.com/s/article/2146451

-> kb.vmware.com/s/article/83249

(hier bitte aber noch weiter recherchieren, Du hast die Kiste vor der Nase)

In jedem Fall auch mal ins vmkernel.log schauen, was da so an Fehlern aufläuft.

Gruß

cykes

Moin,

nur kurz hierzu:

Bin mir nicht sicher, ob es das von Fujitsu in der Form gibt.

Gruß

cykes

nur kurz hierzu:

Allgemein liegt mein FJT PDF für Eternuns und ESXi vor. Laut dem ist aber bei den neueren ESXi Modellen wenig zu tun.

fujitsu.com/global/support/products/computing/storage/downlo ...

Da stolper ich auch drüber. Leider werde ich aus der Readme nicht schlau. finde die VIB nirgends. Dachte ggf. in FJT Custom VMware Image? Durch die Claimrule hab ich mir eingebildet Multipathing Problem gelöst zu haben.

Steht im Prinzip in der Readme drin:fujitsu.com/global/support/products/computing/storage/downlo ...

Da stolper ich auch drüber. Leider werde ich aus der Readme nicht schlau. finde die VIB nirgends. Dachte ggf. in FJT Custom VMware Image? Durch die Claimrule hab ich mir eingebildet Multipathing Problem gelöst zu haben.

How to download and install

1. For use of this software, please contact with FUJITSU sales representativ

Da Du keinen solchen hast, bliebe nur der Weg über die Suche im Fujitsu customized VMWare ESXi Image oder über ein Update Repository (aka vibsdepot), falls vorhanden. Für HPE wäre das bspw. vibsdepot.hpe.com/1. For use of this software, please contact with FUJITSU sales representativ

Bin mir nicht sicher, ob es das von Fujitsu in der Form gibt.

Gruß

cykes