Machbarkeitsstudie Grosse KI-Modelle für Deutschland, 2023

Moin,

in einer 371 Seiten starken im Auftrag des Deutschen Bundestages erstellten Machbarkeitsstudie "Großee KI-Modelle für Deutschland" leam.ai/feasibility-study-leam-2023/ präsentiert "Akademie für künstliche Intelligenz AKI gGmbH im KI Bundesverband" ihre Vorstellungen darüber, welche Hausaufgaben Deutschland und EU zu erledigen haben, um wettbewerbsfähig zu bleiben bzw. um Digitale Souveränität zu erlangen.

Meine persönliche Meinung ist, dass es sich lohnen würde statt oder parallel zu solchen von den Behörden initiierten Leuchtturm-Proekten wie LEAM - Large European AI Models (es gab ja vor nicht zu langer Zeit ein Leuchtturm-Proekt GAIA-X, 11.04.2020 - s. dazu auch Gaia-X ist tot - also beinahe , 12.03.2021 ) einfach an der Basis bei Content-Anbietern wie administrator.de/ sich ernsthaft über Geschäftsmodelle Gedanken machen, wie solche Seiten sich in Zukunft tragen könnten, wenn man sich mit anderen Content-Anbietern - bspw. im deutschsprachigen Raum zusammenschließt und ein Chatbot-Netzwerk bildet. Wenn ich dann als Besucher, hier administrator.de/ [1] suche und [1] mir keine brauchbare Antwort liefern kann, dann leitet [1] die Suchanfrage unbemerkt für mich an andere Sprachmodelle im Chatbot-Netzwerk weiter. Die Antwort vom Chatbot-Netzwerk wird mir dann ad-hoc auf administrator.de präsentiert.

Gruss, itebob

in einer 371 Seiten starken im Auftrag des Deutschen Bundestages erstellten Machbarkeitsstudie "Großee KI-Modelle für Deutschland" leam.ai/feasibility-study-leam-2023/ präsentiert "Akademie für künstliche Intelligenz AKI gGmbH im KI Bundesverband" ihre Vorstellungen darüber, welche Hausaufgaben Deutschland und EU zu erledigen haben, um wettbewerbsfähig zu bleiben bzw. um Digitale Souveränität zu erlangen.

Meine persönliche Meinung ist, dass es sich lohnen würde statt oder parallel zu solchen von den Behörden initiierten Leuchtturm-Proekten wie LEAM - Large European AI Models (es gab ja vor nicht zu langer Zeit ein Leuchtturm-Proekt GAIA-X, 11.04.2020 - s. dazu auch Gaia-X ist tot - also beinahe , 12.03.2021 ) einfach an der Basis bei Content-Anbietern wie administrator.de/ sich ernsthaft über Geschäftsmodelle Gedanken machen, wie solche Seiten sich in Zukunft tragen könnten, wenn man sich mit anderen Content-Anbietern - bspw. im deutschsprachigen Raum zusammenschließt und ein Chatbot-Netzwerk bildet. Wenn ich dann als Besucher, hier administrator.de/ [1] suche und [1] mir keine brauchbare Antwort liefern kann, dann leitet [1] die Suchanfrage unbemerkt für mich an andere Sprachmodelle im Chatbot-Netzwerk weiter. Die Antwort vom Chatbot-Netzwerk wird mir dann ad-hoc auf administrator.de präsentiert.

Gruss, itebob

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 6183163593

Url: https://administrator.de/forum/machbarkeitsstudie-grosse-ki-modelle-fuer-deutschland-2023-6183163593.html

Ausgedruckt am: 19.07.2025 um 03:07 Uhr

15 Kommentare

Neuester Kommentar

admin.de ist seit wann Contentanbieter?

Gucke dir Mal hier die wiederkehrenden Standarddiskussionen an, dann siehtst du die menschliche Intelligenz.

Und dann so woher die Künstliche kommen?

Gucke dir Mal hier die wiederkehrenden Standarddiskussionen an, dann siehtst du die menschliche Intelligenz.

Und dann so woher die Künstliche kommen?

Sowas gibts doch quasi schon. Aber das hat mit KI im ersten Moment so rein gar nix zu tun.

Das, was dir vorschwebt sind eher verbundene bzw. freigegebene Datenbanken. Man kann da auch Algorithmen erstellen, dass bei Nichttreffern eine Suche in weiteren Datenbanken angestoßen wird. Da brauchts aber keine KI dazu. Man kann dan KI benutzen, um solche Anfragen dann gleich zielgerichtet weiterzuleiten. Klappt halt jetzt auch schon über Tags oder ähnliches ohne KI.

Knackpunkt sind da eher die Schnittstellen und die verwendeten Ontologien. Man braucht einen Standard. Dann lassen sich feigegebene Daten einfach teilen und auch monetarisieren.

Das Fraunhofer Institut hat da zum Beispiel IDS am Start.

Ob das bei Contentanbietern aber momentan auf Gehör stoßen wird wage ich zu bezweifeln. Das Geschäftsmodell von denen ist ja im Augenblick alleiniger Anbieter für Content X zu sein.

Zukünftig sehe ich in sowas aber eher als ein Muss an. Bestes Beispiel sind die deutschen Printmedien. Die bieten zwar alle schon den Content online an und wollen Geld dafür. User wollen aber oftmals gar keine feste Bindung an einen Anbieter, sondern nur mal schnell eine gesuchte Information. Und dafür wollen sie dann auch zahlen. Aber halt nur einmalig und auch nicht hochpreisig.

Bei Geschichten wie IDS können sich Plattformen bilden, die eben gesuchte Informationen aus Content-Datenbanken abrufen und dem Enduser zur Verfügung stellen können. Die Monetarisierung läuft auf der Plattform, Contentanbieter erhält seinen eingestellten Preis. Ebenso bleibt die Datenhoheit weiterhin beim Contentanbieter. Der gibt Daten fei, wie er das wünscht und an wen er das wünscht.

Das, was dir vorschwebt sind eher verbundene bzw. freigegebene Datenbanken. Man kann da auch Algorithmen erstellen, dass bei Nichttreffern eine Suche in weiteren Datenbanken angestoßen wird. Da brauchts aber keine KI dazu. Man kann dan KI benutzen, um solche Anfragen dann gleich zielgerichtet weiterzuleiten. Klappt halt jetzt auch schon über Tags oder ähnliches ohne KI.

Knackpunkt sind da eher die Schnittstellen und die verwendeten Ontologien. Man braucht einen Standard. Dann lassen sich feigegebene Daten einfach teilen und auch monetarisieren.

Das Fraunhofer Institut hat da zum Beispiel IDS am Start.

Ob das bei Contentanbietern aber momentan auf Gehör stoßen wird wage ich zu bezweifeln. Das Geschäftsmodell von denen ist ja im Augenblick alleiniger Anbieter für Content X zu sein.

Zukünftig sehe ich in sowas aber eher als ein Muss an. Bestes Beispiel sind die deutschen Printmedien. Die bieten zwar alle schon den Content online an und wollen Geld dafür. User wollen aber oftmals gar keine feste Bindung an einen Anbieter, sondern nur mal schnell eine gesuchte Information. Und dafür wollen sie dann auch zahlen. Aber halt nur einmalig und auch nicht hochpreisig.

Bei Geschichten wie IDS können sich Plattformen bilden, die eben gesuchte Informationen aus Content-Datenbanken abrufen und dem Enduser zur Verfügung stellen können. Die Monetarisierung läuft auf der Plattform, Contentanbieter erhält seinen eingestellten Preis. Ebenso bleibt die Datenhoheit weiterhin beim Contentanbieter. Der gibt Daten fei, wie er das wünscht und an wen er das wünscht.

Sicherheit, Datenschutz, persönliche Vorlieben usw...

Einfach die Freitage betrachten. Da konzentriert sich das alles, aus unbekanntem Grund.

Vielleicht kann die KI den Freitag aufklären.

Einfach die Freitage betrachten. Da konzentriert sich das alles, aus unbekanntem Grund.

Vielleicht kann die KI den Freitag aufklären.

Akademie für künstliche Intelligenz AKI gGmbH

Adresse: Im Haus der BundespressekonferenzGenau mein Humor

Wieder so eine "NGO", in der sich nen SPD-naher Ex-SWR-Journalist und ne Grünen-nahe Ex-Politik-Studentin von Geschäftsführer-Posten zu Geschäftsführerposten hangeln (lassen). Will lieber gar nicht wissen, ob an Staatsknete "interessierte Industrieunternehmen" oder der Steuerzahler direkt diesen Lobbyismus finanzieren muss!

Schon mal was von DeepL gehört?

Ah, du kennst DeepL also nicht. Oke, dann versteh ich das mit dem KI in Deutschland nicht denkbar.

@itebob:

Du vermischt da die zwei Sachen.

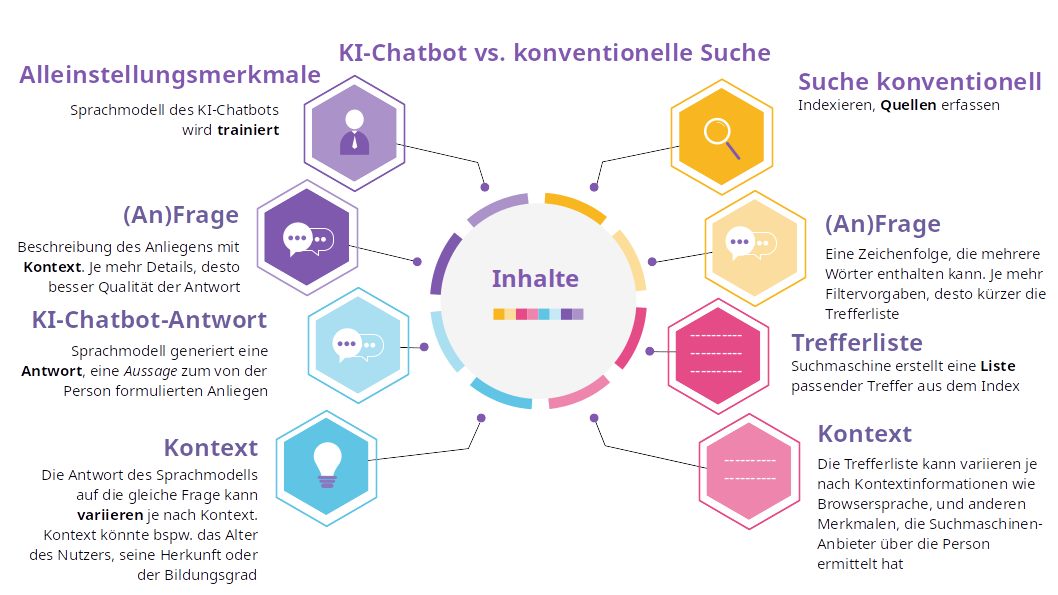

Das eine ist eine KI als Suchmaschine à la ChatGPT zu nutzen. Das andere sind verbundene Datenbanken.

Beides funktioniert unabhängig von einander.

Und das was du ursprünglich angedacht hast, also Contentanbieter vernetzen und Anfragen weiterzuleiten, funktioniert halt jetzt schon und benötigt keine KI.

Trotzdem bleibt aber der eine Punkt, dass eine KI als Suchmaschine zu verwenden eine sehr, sehr, sehr (hier noch weitere "sehr" einfügen) schlechte Idee ist.

Zumindest kurz- bis mittelfristig. Knackpunkt ist hier "wird trainiert".

Trainiert heißt im Grunde nix anderes als: Antwort wird gefiltert. Und noch schlimmer: dieser Filter wird bei Chatbots eben nach ChatGPT-Vorbild durch die Allgemeinheit gebildet. Wir sprechen hier von einer Schwarmdummheit.

Oder um es anders zu sagen: mach TikTok auf und du siehst, wer dir die Antworten gibt. Zu jedem Thema.

Auch bei klassischen Suchmaschinen wird der Suchalgorithmus beeinflusst. Aber nicht von Dritten (außer natürlich vom Eigentümer), sondern von einem selber (Meta-Daten eben). Der Riesenvorteil ist jedoch, dass hier eine Menge von Ergebnissen (der Index eben) ausgegeben wird. Im Idealfall kann man die Filterung per Meta-Daten komplett ausschalten.

Bei einer KI an sich kann dieser Filter eben nicht weggelassen werden, da die KI darauf basiert.

Erst wenn man sicherstellen kann, dass sich ene KI nicht direkt von Außen beeinflussen lässt, ist daran zu denken, die KI als Suchmaschine zu ersetzen. Ob man mit einer KI nicht lieber eine Suchmaschine füttert, wäre eine weitere Überlegung. ber ob da sinnvoll ist?

Wie schlecht die aktuellen Beispiel-KIs sind, kann man ja selber ausprobieren. Fancy Zeug spucken die ja aus. Aber wenns um den Wahrheitsgehalt der Aussagen geht, wirds oft schon extrem dünn, bis schlichtweg falsch.

Du vermischt da die zwei Sachen.

Das eine ist eine KI als Suchmaschine à la ChatGPT zu nutzen. Das andere sind verbundene Datenbanken.

Beides funktioniert unabhängig von einander.

Und das was du ursprünglich angedacht hast, also Contentanbieter vernetzen und Anfragen weiterzuleiten, funktioniert halt jetzt schon und benötigt keine KI.

Trotzdem bleibt aber der eine Punkt, dass eine KI als Suchmaschine zu verwenden eine sehr, sehr, sehr (hier noch weitere "sehr" einfügen) schlechte Idee ist.

Zumindest kurz- bis mittelfristig. Knackpunkt ist hier "wird trainiert".

Trainiert heißt im Grunde nix anderes als: Antwort wird gefiltert. Und noch schlimmer: dieser Filter wird bei Chatbots eben nach ChatGPT-Vorbild durch die Allgemeinheit gebildet. Wir sprechen hier von einer Schwarmdummheit.

Oder um es anders zu sagen: mach TikTok auf und du siehst, wer dir die Antworten gibt. Zu jedem Thema.

Auch bei klassischen Suchmaschinen wird der Suchalgorithmus beeinflusst. Aber nicht von Dritten (außer natürlich vom Eigentümer), sondern von einem selber (Meta-Daten eben). Der Riesenvorteil ist jedoch, dass hier eine Menge von Ergebnissen (der Index eben) ausgegeben wird. Im Idealfall kann man die Filterung per Meta-Daten komplett ausschalten.

Bei einer KI an sich kann dieser Filter eben nicht weggelassen werden, da die KI darauf basiert.

Erst wenn man sicherstellen kann, dass sich ene KI nicht direkt von Außen beeinflussen lässt, ist daran zu denken, die KI als Suchmaschine zu ersetzen. Ob man mit einer KI nicht lieber eine Suchmaschine füttert, wäre eine weitere Überlegung. ber ob da sinnvoll ist?

Wie schlecht die aktuellen Beispiel-KIs sind, kann man ja selber ausprobieren. Fancy Zeug spucken die ja aus. Aber wenns um den Wahrheitsgehalt der Aussagen geht, wirds oft schon extrem dünn, bis schlichtweg falsch.

Ein Sprachmodell ist wieder was anderes. Ein Sprachmodell sagt z.B. bei einem angefangenen Satz das wahrscheinlichste nächste Wort voraus. Bei einer Anfrage will man aber keine wahrscheinliche Treffer, sondern einen Treffer.

Zum Verständnis: die Ausgabe kann ein Sprachmodell verwenden, um die angenehm lesbar zu machen. Der Inhalt der Ausgabe darf aber nix mit dem Sprachmodell zu tun haben.

Noch gar nicht so lange her hat FAIR (Meta Fundamental AI Research Diplomacy Team) einen Agent namens Cicero entwickelt, der bei Diplomacy-Spielen knapp über 25% (was dem ungefähren doppelten Wert des sonstigen Durchschnitts ausmacht, also eine extreme Verbesserung) der Spiele gewonnen hat. science.org/doi/10.1126/science.ade9097

Das eben, weil sie ein Sprachmodell auf die KI aufgesetzt haben. Die KI selber hatte als rule set der Spiel-Theorie (Nash-Gleichgewicht). Nur die Ausgabe wurde dann über dieses Sprachmodell geleitet, sodass die menschlichen Gegenspieler damit verhandeln konnten.

Also auch hier: zwei unterschiedliche Sachen.

KIs sind momentan noch extremst spezifisch.

Dein "Muster erkennen" ist das gleiche wie "filtern".

Zum Verständnis: die Ausgabe kann ein Sprachmodell verwenden, um die angenehm lesbar zu machen. Der Inhalt der Ausgabe darf aber nix mit dem Sprachmodell zu tun haben.

Noch gar nicht so lange her hat FAIR (Meta Fundamental AI Research Diplomacy Team) einen Agent namens Cicero entwickelt, der bei Diplomacy-Spielen knapp über 25% (was dem ungefähren doppelten Wert des sonstigen Durchschnitts ausmacht, also eine extreme Verbesserung) der Spiele gewonnen hat. science.org/doi/10.1126/science.ade9097

Das eben, weil sie ein Sprachmodell auf die KI aufgesetzt haben. Die KI selber hatte als rule set der Spiel-Theorie (Nash-Gleichgewicht). Nur die Ausgabe wurde dann über dieses Sprachmodell geleitet, sodass die menschlichen Gegenspieler damit verhandeln konnten.

Also auch hier: zwei unterschiedliche Sachen.

KIs sind momentan noch extremst spezifisch.

Dein "Muster erkennen" ist das gleiche wie "filtern".