Sophos SG und nun?

Hallo zusammen,

bin neu hier, aber das aus guten Grund. Hoffe ihr seid lieb zu mir .

.

Aktuell suche ich den richtigen oder zumindest den annähernd optimalsten Lösungsweg.

Wie ihr vielleicht aus dem Titel erkennen könnt geht es um eine gute und schon etwas alte Sophos SG 210.

Da schon in wenigen Wochen die Lizenz ausläuft (keine Sorge ich habe schon Angebote vorliegen) bin ich auf der suche nach preislichen oder aber performanteren Systemen.

Warum ist das Thema Performanz angesprochen? Das aktuelle Netzwerk besteht vollständig aus Ubiquiti-Komponenten. 2x US-16-XG, 3x USW-Pro-48- PoE und 3x UAP-HD-Pro. Und natürlich dem UCK-G2-Plus. Davor ist sitzt die oben genannte SG.

Die SG mach, wie Sophos es nennt nur Basisfunktionalität. Also Email Protection, Network Protection, Web Protection, Webserver Protection und Wireless Protection. Genutzt werden hierbei effektiv Firewall-Regeln, IPS, SMTP, Mail Quarantäne, WPS für den Mailserver, SSL-VPN über den Sophos Connect Client, OpenVPN. Bis zur Umstellung auf Ubiquiti und den neune Systemen wurde hier auch noch der Webfilter betrieben und auch der DHCP war in Verwendung.

In allem nicht gerade viel, aber durch die Anbindung der Firewall über 2x lag von je 2GbE liegt hier der Flaschenhals eindeutig begraben, da die gesamten Regeln für das interne Netzwerk auch nur hier verankert sind. Somit geht jeder interne Traffic erst an die Firewall und dann zurück, was leider zur Folge hat, das selbst das übertragen von Dateien mit maximal 100MB/s von statten gehen.

Nachdem ich mir im Vergleich einmal die Anbieter angeschaut habe, ist es mir nicht leicht gefallen eine Wahl zu treffen. Um den Flaschenhals GbE weg zu bekommen, ist bei den meisten Anbietern ein hoher Modelleinstieg nötig, wenn SFP+-Module nicht sogar nur als Option angeboten werden. Deshalb wirklich auf Hardware setzen?

Nun zur Grundlage der Diskussion bzw. den Fragen die sich mir aktuell stellen.

1. Da die Netzwerkkomponenten einheitlich sind und Ubiquiti mit dem UXG-Pro zum UCK-G2-PLUS eine gute Komponente bietet. Oder darüber hinaus gleich auf die UDM-Pro oder UDM-SE setzten? Wie gut sind die Firewall-Regeln umsetzbar? IPS ausreichend? SMTP Alternativen sind bekannt, aber gern auch euren Input dazu, da ich was das angeht völliges Neuland betrete.

2. Hardware UTM oder da wir Dell ESXi mit VMware haben, eine virtualisierte Form davon?

Ich danke euch allen schon für euren Input, Meinungen, aber auch Kritik!

bin neu hier, aber das aus guten Grund. Hoffe ihr seid lieb zu mir

Aktuell suche ich den richtigen oder zumindest den annähernd optimalsten Lösungsweg.

Wie ihr vielleicht aus dem Titel erkennen könnt geht es um eine gute und schon etwas alte Sophos SG 210.

Da schon in wenigen Wochen die Lizenz ausläuft (keine Sorge ich habe schon Angebote vorliegen) bin ich auf der suche nach preislichen oder aber performanteren Systemen.

Warum ist das Thema Performanz angesprochen? Das aktuelle Netzwerk besteht vollständig aus Ubiquiti-Komponenten. 2x US-16-XG, 3x USW-Pro-48- PoE und 3x UAP-HD-Pro. Und natürlich dem UCK-G2-Plus. Davor ist sitzt die oben genannte SG.

Die SG mach, wie Sophos es nennt nur Basisfunktionalität. Also Email Protection, Network Protection, Web Protection, Webserver Protection und Wireless Protection. Genutzt werden hierbei effektiv Firewall-Regeln, IPS, SMTP, Mail Quarantäne, WPS für den Mailserver, SSL-VPN über den Sophos Connect Client, OpenVPN. Bis zur Umstellung auf Ubiquiti und den neune Systemen wurde hier auch noch der Webfilter betrieben und auch der DHCP war in Verwendung.

In allem nicht gerade viel, aber durch die Anbindung der Firewall über 2x lag von je 2GbE liegt hier der Flaschenhals eindeutig begraben, da die gesamten Regeln für das interne Netzwerk auch nur hier verankert sind. Somit geht jeder interne Traffic erst an die Firewall und dann zurück, was leider zur Folge hat, das selbst das übertragen von Dateien mit maximal 100MB/s von statten gehen.

Nachdem ich mir im Vergleich einmal die Anbieter angeschaut habe, ist es mir nicht leicht gefallen eine Wahl zu treffen. Um den Flaschenhals GbE weg zu bekommen, ist bei den meisten Anbietern ein hoher Modelleinstieg nötig, wenn SFP+-Module nicht sogar nur als Option angeboten werden. Deshalb wirklich auf Hardware setzen?

Nun zur Grundlage der Diskussion bzw. den Fragen die sich mir aktuell stellen.

1. Da die Netzwerkkomponenten einheitlich sind und Ubiquiti mit dem UXG-Pro zum UCK-G2-PLUS eine gute Komponente bietet. Oder darüber hinaus gleich auf die UDM-Pro oder UDM-SE setzten? Wie gut sind die Firewall-Regeln umsetzbar? IPS ausreichend? SMTP Alternativen sind bekannt, aber gern auch euren Input dazu, da ich was das angeht völliges Neuland betrete.

2. Hardware UTM oder da wir Dell ESXi mit VMware haben, eine virtualisierte Form davon?

Ich danke euch allen schon für euren Input, Meinungen, aber auch Kritik!

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 8151912937

Url: https://administrator.de/forum/sophos-sg-und-nun-8151912937.html

Ausgedruckt am: 19.07.2025 um 01:07 Uhr

21 Kommentare

Neuester Kommentar

Ich gehe nur auf den einen erwähnen Punkt von dir ein -> interner Traffic über SG. Die generelle Frage ist, muss der ganze Traffic da durch oder nur bestimmte VLANs? Ist es überschaubar, dann evtl. das Routing intern umbauen. Wenn du aber alles von/nach über die FW routen willst/musst, dann wäre eine VM auf dem ESXi wohl die günstigere Lösung zur HW-Appliance.

Moin,

mal ein/ zwei Grundgedanken (vor dem Hintergrund, dass ich null Plan von Ubiquity hab):

Welche Rolle spielt eure Firewall im Gesamtkonzept?

Kannst du einen mehrtägigen Ausfall verkraften, weil da ein Bug in einer Software ist und der Hersteller sich Zeit lässt oder musst du kurze Reaktions-/ -Lösungszeiten haben?

Welche Funktionen brauchst du?

Reicht dir ein "normaler" Contentfilter ("WebProxy") oder musst du auch Features wie Beispielsweise Sophos' Intercept X haben?

Wie sollen die AV-Lösungen der Clients eingebunden werden? Müssen die mit der UTM zusammenspielen können?

Was muss der WAP leisten können oder habt ihr dafür eine andere Lösung (z. B. Citrix' Netscaler?)

Kläre erstmal, was ihr braucht bevor du nach der Lösung schaust.

Also Nachfolger der UTM könnte für (je nach Anforderung) die XGS (mit SFP+ Ports) passen.

Es könnte aber auch eine NetGate oder Fortinet mit passender Hardware sein....

ICH für meinen Geschmack mag es, wenn die Firewall auf einer Appliance für sich läuft. Ggf. noch virtuell, aber auf einem eigenen Blech. VMs für die Unternehmensnutzdaten und VMs für die Security würde ich persönlich nie auf dem selben Hypervisor (Cluster) laufen lassen. Ist aber auch eher eine Glaubenssache, schätze ich.

mal ein/ zwei Grundgedanken (vor dem Hintergrund, dass ich null Plan von Ubiquity hab):

Welche Rolle spielt eure Firewall im Gesamtkonzept?

Kannst du einen mehrtägigen Ausfall verkraften, weil da ein Bug in einer Software ist und der Hersteller sich Zeit lässt oder musst du kurze Reaktions-/ -Lösungszeiten haben?

Welche Funktionen brauchst du?

Reicht dir ein "normaler" Contentfilter ("WebProxy") oder musst du auch Features wie Beispielsweise Sophos' Intercept X haben?

Wie sollen die AV-Lösungen der Clients eingebunden werden? Müssen die mit der UTM zusammenspielen können?

Was muss der WAP leisten können oder habt ihr dafür eine andere Lösung (z. B. Citrix' Netscaler?)

Kläre erstmal, was ihr braucht bevor du nach der Lösung schaust.

Also Nachfolger der UTM könnte für (je nach Anforderung) die XGS (mit SFP+ Ports) passen.

Es könnte aber auch eine NetGate oder Fortinet mit passender Hardware sein....

ICH für meinen Geschmack mag es, wenn die Firewall auf einer Appliance für sich läuft. Ggf. noch virtuell, aber auf einem eigenen Blech. VMs für die Unternehmensnutzdaten und VMs für die Security würde ich persönlich nie auf dem selben Hypervisor (Cluster) laufen lassen. Ist aber auch eher eine Glaubenssache, schätze ich.

Moin...

ein ordentlicherr L3 Switch der sich um das Routing kümmert, natürlich auch um deine VLANs, und dein Problem ist behoben!

Frank

Somit geht jeder interne Traffic erst an die Firewall und dann zurück, was leider zur Folge hat, das selbst das übertragen von Dateien mit maximal 100MB/s von statten gehen.

also dann würde ich mal über dein Netzwerk Design nachdenken...ein ordentlicherr L3 Switch der sich um das Routing kümmert, natürlich auch um deine VLANs, und dein Problem ist behoben!

Frank

Somit geht jeder interne Traffic erst an die Firewall und dann zurück, was leider zur Folge hat, das selbst das übertragen von Dateien mit maximal 100MB/s von statten gehen.

Intern? MByte oder Mbit/s, mit was gemessen? iPerf oder „smb“? Als reine Netzwerkperformance kann das doch gar nicht sein? Was sagt denn die Auslastung der Sophos?ein ordentlicherr L3 Switch

USW-Pro-48- PoE

Ist doch ein Layer3 Switch: dl.ubnt.com/ds/usw_pro_poe_dsUSW-Pro-48- PoE

Sind alle Switche direkt an der Sophos oder die 16er L2 „dazwischen“?

Hi

wer nutzt im 10GB+ Netzen eine FW als Core-Router? Ernsthaft? Dafür sind L3 da und die können das deutlich günstiger und performanter, eine 10GB fähige FW die auch den Durchsatz liefert, ist wohl 3-4x so teuer wie ein simpler L3 Switch mit RIP/OSPF und den passenden Switch scheinst ja zu haben @Visucius

Für den "großen" Traffic nutzen wir intern, zur Netzabschottung, pfSense auf normaler Dell Hardware mit 40G Links, der schiebt ohne Probleme >2Gb/s durchs Netz, das gleiche als FW von {Random-Hersteller} die >=40G macht: davon kannst mehrere Server kaufen

Für die internen Firewalls würde ich tendenziell immer eine VM bzw. pfSense / OpnSense auf Blech einer kostenpflichtigen Appliance vorziehen, dann kannst Problemlos und für "relativ" schmales Geld auch >40G gehen, da wird eher die CPU zum Nadelör wie der Link.

Gruß

@clSchak

wer nutzt im 10GB+ Netzen eine FW als Core-Router? Ernsthaft? Dafür sind L3 da und die können das deutlich günstiger und performanter, eine 10GB fähige FW die auch den Durchsatz liefert, ist wohl 3-4x so teuer wie ein simpler L3 Switch mit RIP/OSPF und den passenden Switch scheinst ja zu haben @Visucius

Für den "großen" Traffic nutzen wir intern, zur Netzabschottung, pfSense auf normaler Dell Hardware mit 40G Links, der schiebt ohne Probleme >2Gb/s durchs Netz, das gleiche als FW von {Random-Hersteller} die >=40G macht: davon kannst mehrere Server kaufen

Für die internen Firewalls würde ich tendenziell immer eine VM bzw. pfSense / OpnSense auf Blech einer kostenpflichtigen Appliance vorziehen, dann kannst Problemlos und für "relativ" schmales Geld auch >40G gehen, da wird eher die CPU zum Nadelör wie der Link.

Gruß

@clSchak

Moin @DeSchneller,

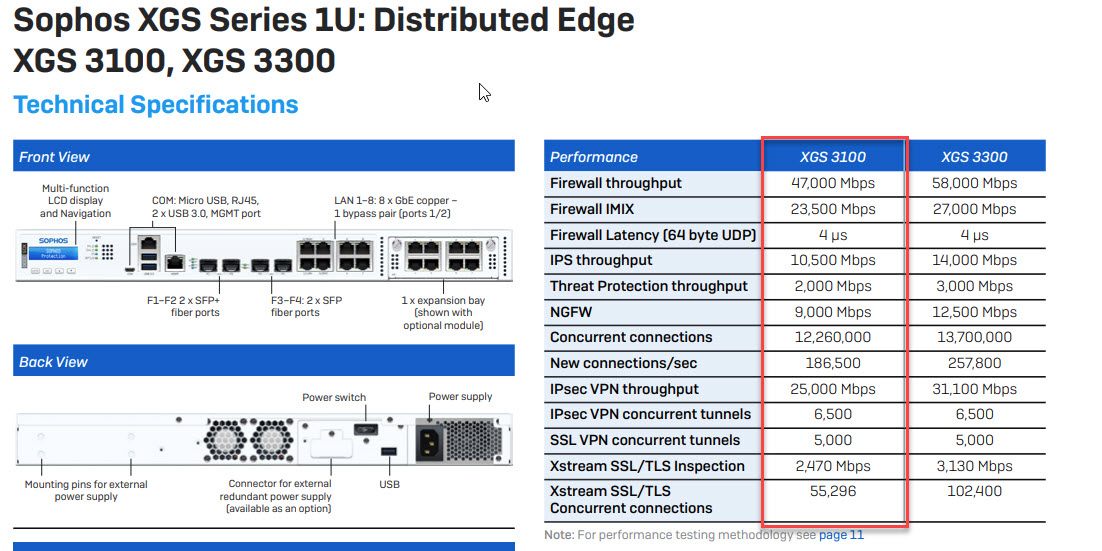

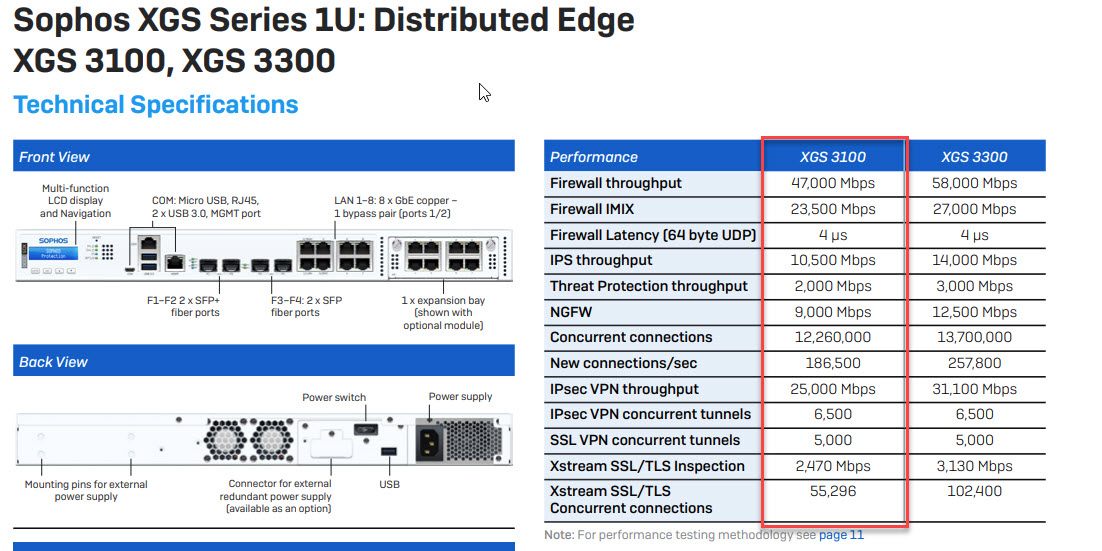

bei dem was du da treibst würde ich dir mindestens eine XGS 3100 empfehlen, die hat auch schon von Haus aus zwei SFP+ Ports. 😉

Und ja nicht als VM, die sind kaum bezahlbar.

Gruss Alex

bei dem was du da treibst würde ich dir mindestens eine XGS 3100 empfehlen, die hat auch schon von Haus aus zwei SFP+ Ports. 😉

Und ja nicht als VM, die sind kaum bezahlbar.

Gruss Alex

Moin @clSchak,

ähm, sei mir nicht bösen, aber das weder vorne noch hinten korrekt.

Zwischen zwei Netzsegmente, egal ob intern intern oder intern extern, gehört stand heute eine FW oder noch besser eine NGFW oder ein SGW, aber auf keinen Fall ein L3 Core, das ist Schnee von gestern.

Siehe auch diverse Dokus/Vorgaben des BSI.

bsi.bund.de/DE/Themen/Unternehmen-und-Organisationen/Standards-u ...

und

Gruss Alex

wer nutzt im 10GB+ Netzen eine FW als Core-Router? Ernsthaft? Dafür sind L3 da und die können das deutlich günstiger und performanter, eine 10GB fähige FW die auch den Durchsatz liefert, ist wohl 3-4x so teuer wie ein simpler L3 Switch mit RIP/OSPF und den passenden Switch scheinst ja zu haben @Visucius

ähm, sei mir nicht bösen, aber das weder vorne noch hinten korrekt.

Zwischen zwei Netzsegmente, egal ob intern intern oder intern extern, gehört stand heute eine FW oder noch besser eine NGFW oder ein SGW, aber auf keinen Fall ein L3 Core, das ist Schnee von gestern.

Siehe auch diverse Dokus/Vorgaben des BSI.

bsi.bund.de/DE/Themen/Unternehmen-und-Organisationen/Standards-u ...

und

Gruss Alex

@MysticFoxDE nach/von Extern ist eine NGFW schon sinnvoll. Intern-intern muss es nicht sein, da man dort in der Regel nicht die Inhalte filtert/steuert sondern rein den Zugriff von/nach VLAN. Dazu muss es keine FW-Regel geben, wenn auf dem L3-Stack die entsprechenden Trunks zu den L2-Access-Switchen nur bestimmte VLANs zulassen.

Moin @DerMaddin,

gerade bei einer Sophos XGS und auch am besten den passenden Virenscanner, würde ich auf keinen Fall was anderes als die XGS zwischen die Segmente hängen, weil dadurch viele positiven Effekte von "Synchronized Security", nicht mehr gegeben sind.

Wenn die XGS vollständig zwischen den Segmenten hängt und deren FW Regeln auf den Heartbeat des Clients reagieren, dann wird ein infizierter Client sofort an der FW gesperrt und zwar nicht nur intern extern, sondern auch intern intern. 😉

Gruss Alex

@MysticFoxDE nach/von Extern ist eine NGFW schon sinnvoll. Intern-intern muss es nicht sein, da man dort in der Regel nicht die Inhalte filtert/steuert sondern rein den Zugriff von/nach VLAN. Dazu muss es keine FW-Regel geben, wenn auf dem L3-Stack die entsprechenden Trunks zu den L2-Access-Switchen nur bestimmte VLANs zulassen.

gerade bei einer Sophos XGS und auch am besten den passenden Virenscanner, würde ich auf keinen Fall was anderes als die XGS zwischen die Segmente hängen, weil dadurch viele positiven Effekte von "Synchronized Security", nicht mehr gegeben sind.

Wenn die XGS vollständig zwischen den Segmenten hängt und deren FW Regeln auf den Heartbeat des Clients reagieren, dann wird ein infizierter Client sofort an der FW gesperrt und zwar nicht nur intern extern, sondern auch intern intern. 😉

Gruss Alex

Zitat von @DeSchneller:

Die SG mach, wie Sophos es nennt nur Basisfunktionalität. Also Email Protection, Network Protection, Web Protection, Webserver Protection und Wireless Protection. Genutzt werden hierbei effektiv Firewall-Regeln, IPS, SMTP, Mail Quarantäne, WPS für den Mailserver, SSL-VPN über den Sophos Connect Client, OpenVPN. Bis zur Umstellung auf Ubiquiti und den neune Systemen wurde hier auch noch der Webfilter betrieben und auch der DHCP war in Verwendung.

Erstmal würde ich gerne einwerfen das deine SG nicht nur "Basisfunktionalität" macht, ich kann mir nicht vorstellen das Sophos das so schreibt. Was wären denn dann keine Basisfunktionalitäten mehr?Die SG mach, wie Sophos es nennt nur Basisfunktionalität. Also Email Protection, Network Protection, Web Protection, Webserver Protection und Wireless Protection. Genutzt werden hierbei effektiv Firewall-Regeln, IPS, SMTP, Mail Quarantäne, WPS für den Mailserver, SSL-VPN über den Sophos Connect Client, OpenVPN. Bis zur Umstellung auf Ubiquiti und den neune Systemen wurde hier auch noch der Webfilter betrieben und auch der DHCP war in Verwendung.

Dann klingt die Threaderöffnung schon so als suchst du nur Bestätigung um die Sophos durch Ubiquiti zu ersetzen. Dazu kann ich inhaltlich nichts sagen weil ich nur Access Points von Ubiquiti nutze (und die nerven mich schon zu Tode), ich würde da aber erstmal ein großes Fragezeichen dran machen.

Als Problem hast du deinen Uplink ausgemacht, klar 2x 1GbE Trunk ist nicht so schön, habe ich aber auch. Die Frage ist doch reicht das oder schiebst du wirklich so viele Daten durch das Netz (ggf. auch nur kurzzeitig)? Wenn sich das mit ja beantworten lässt, dann brauchst du eine dickere Firewall.

Quote from @MysticFoxDE:

Moin @clSchak,

ähm, sei mir nicht bösen, aber das weder vorne noch hinten korrekt.

Zwischen zwei Netzsegmente, egal ob intern intern oder intern extern, gehört stand heute eine FW oder noch besser eine NGFW oder ein SGW, aber auf keinen Fall ein L3 Core, das ist Schnee von gestern.

Siehe auch diverse Dokus/Vorgaben des BSI.

bsi.bund.de/DE/Themen/Unternehmen-und-Organisationen/Standards-u ...

und

Gruss Alex

Moin @clSchak,

wer nutzt im 10GB+ Netzen eine FW als Core-Router? Ernsthaft? Dafür sind L3 da und die können das deutlich günstiger und performanter, eine 10GB fähige FW die auch den Durchsatz liefert, ist wohl 3-4x so teuer wie ein simpler L3 Switch mit RIP/OSPF und den passenden Switch scheinst ja zu haben @Visucius

ähm, sei mir nicht bösen, aber das weder vorne noch hinten korrekt.

Zwischen zwei Netzsegmente, egal ob intern intern oder intern extern, gehört stand heute eine FW oder noch besser eine NGFW oder ein SGW, aber auf keinen Fall ein L3 Core, das ist Schnee von gestern.

Siehe auch diverse Dokus/Vorgaben des BSI.

bsi.bund.de/DE/Themen/Unternehmen-und-Organisationen/Standards-u ...

und

Gruss Alex

ja, habe ich doch auch geschrieben, aber dafür würde ich keine Hersteller Appliance nehmen (egal ob Sophos, Cisco, Watchguard, Fortinet oder was auch immer), dann kannst den Laden direkt zu machen weil die Geräte jenseits der 10G unverhältnismäßig teuer sind , habe ich ja auch geschrieben, das wir z.B. dort pfSense verwenden weil eine Sophos mit >40G unverhältnismäßig teuer ist (40G liegt bei >40k €), und du musst mindestens zwei Geräte zwecks HA haben, ansonsten ist das Ausfallrisiko zu groß und ggf. führt das einspielen von Updates zu einer erheblichen Downtime.

Moin @clSchak,

ja OK, so hört sich das Ganze schon anständig an. 😁

Wofür benötigt ihr eigentlich 40G?

Wir hatten früher auch Uplinks >10G bei unseren Kunden realisiert, haben diese aber nun alle wieder auf 1x10G zurück gebaut, weil es mit diesen ständig nur Probleme gab.

Danach ist auch Lustigerweise die Anwendungsperformance stellenweise besser geworden. 🙃

Gruss Alex

ja, habe ich doch auch geschrieben, aber dafür würde ich keine Hersteller Appliance nehmen (egal ob Sophos, Cisco, Watchguard, Fortinet oder was auch immer), dann kannst den Laden direkt zu machen weil die Geräte jenseits der 10G unverhältnismäßig teuer sind , habe ich ja auch geschrieben, das wir z.B. dort pfSense verwenden weil eine Sophos mit >40G unverhältnismäßig teuer ist (40G liegt bei >40k €), und du musst mindestens zwei Geräte zwecks HA haben, ansonsten ist das Ausfallrisiko zu groß und ggf. führt das einspielen von Updates zu einer erheblichen Downtime.

ja OK, so hört sich das Ganze schon anständig an. 😁

Wofür benötigt ihr eigentlich 40G?

Wir hatten früher auch Uplinks >10G bei unseren Kunden realisiert, haben diese aber nun alle wieder auf 1x10G zurück gebaut, weil es mit diesen ständig nur Probleme gab.

Danach ist auch Lustigerweise die Anwendungsperformance stellenweise besser geworden. 🙃

Gruss Alex

40G: "Problem" bei den "großen" Leitungen ist ja: 40G = 4x10G in einem Modul, ebenso 100G = 4x25G und manche Systeme sind da nicht immer ganz Kompatibel mit.

Deinen o.g. Effekt konnte ich sogar nachstellen: mit Intel 40G hat man, bei uns, weniger Performance wie ein Adapter von Broadcom - wobei ich nicht ausschließen möchte das es evtl. an den Einstellungen der Treiber liegt.

Unsere 40G Links werden normalerweise nur beim Backup ansatzweise auf Last gefahren (ca. 30%), da ist dann eher der Raid-Controller im Backupserver das Nadelöhr. Im Regelbetrieb reichen 10G für alles aus, auch für die Gebäude mit >100 Clients, wir haben lediglich unsere Workstation direkt per 10G angebunden, sind aber auch Rackworkstation und lediglich der ZeroClient steht dann im Büro.

Wobei ich aber auch sagen muss, dort wo 100G möglich ist, setzen wir es auch ein, die Module sind preislich nicht wesentlich teurer (wenn man 3rd Party einsetzt), bei uns lediglich die Verbindung zwischen den RZ, ansonsten läuft nichts auf 100G. Brauchen? Nein, aber das waren im Projekt keine 300 EUR an Mehrkosten, da hat dann "haben ist besser wie brauchen" gegriffen

Deinen o.g. Effekt konnte ich sogar nachstellen: mit Intel 40G hat man, bei uns, weniger Performance wie ein Adapter von Broadcom - wobei ich nicht ausschließen möchte das es evtl. an den Einstellungen der Treiber liegt.

Unsere 40G Links werden normalerweise nur beim Backup ansatzweise auf Last gefahren (ca. 30%), da ist dann eher der Raid-Controller im Backupserver das Nadelöhr. Im Regelbetrieb reichen 10G für alles aus, auch für die Gebäude mit >100 Clients, wir haben lediglich unsere Workstation direkt per 10G angebunden, sind aber auch Rackworkstation und lediglich der ZeroClient steht dann im Büro.

Wobei ich aber auch sagen muss, dort wo 100G möglich ist, setzen wir es auch ein, die Module sind preislich nicht wesentlich teurer (wenn man 3rd Party einsetzt), bei uns lediglich die Verbindung zwischen den RZ, ansonsten läuft nichts auf 100G. Brauchen? Nein, aber das waren im Projekt keine 300 EUR an Mehrkosten, da hat dann "haben ist besser wie brauchen" gegriffen

Moin @clSchak,

ja und auch dann, wenn du z.B. mit 10G am Server losfährst, dann auf 40G oder 100G zwischen den Cores wechselst, danach wieder von Core zum Unterverteilungsswitch wieder auf 10G und zum Schluss mit 1G Richtung Client zum Ende fährst. Und oder umgekehrt. 🙃

Dann hast du auf dem Server vielleicht noch RSS mit 16 Queues aktiviert und auf dem Client hats du mit Glück vielleicht nur 4 zur Verfügung u.s.w.

Meine persönliche Erfahrung ist, dass das Leben oberhalb der 10G Grenze, in Wahrheit leider gar nicht so einfach ist, wie es von den Herstellern gerne beworben wird. 😔

Gruss Alex

40G: "Problem" bei den "großen" Leitungen ist ja: 40G = 4x10G in einem Modul, ebenso 100G = 4x25G und manche Systeme sind da nicht immer ganz Kompatibel mit.

ja und auch dann, wenn du z.B. mit 10G am Server losfährst, dann auf 40G oder 100G zwischen den Cores wechselst, danach wieder von Core zum Unterverteilungsswitch wieder auf 10G und zum Schluss mit 1G Richtung Client zum Ende fährst. Und oder umgekehrt. 🙃

Dann hast du auf dem Server vielleicht noch RSS mit 16 Queues aktiviert und auf dem Client hats du mit Glück vielleicht nur 4 zur Verfügung u.s.w.

Meine persönliche Erfahrung ist, dass das Leben oberhalb der 10G Grenze, in Wahrheit leider gar nicht so einfach ist, wie es von den Herstellern gerne beworben wird. 😔

Gruss Alex

auch wenn es jetzt OT wird: du brauchst >10G nur im Backend (VMWare <-> VMWare <-> Backup <-> Storage) oder Switching (Core <-> Aggregation) und beim Storage auch nur, wenn du kein FibreChannel machst

VMWare selbst stellt ja mit den VMXNET3 Adapter auch nur 10G zur Verfügung, ich habe hier jetzt keinen Client der irgendwo direkt an einem 40G Link rankommt. "Blech"-Windowsserver sind alle mit 10G angeschlossen, lediglich der Veeam Server hat zwei 40G Links als "Blech" Windows Server und da ist der lokale Raid-Controller das Nadelöhr.

Aggregation-Switche <-> Edge/Access sind nur mit 2 x 10G angebunden und auch nur, damit diese mit beiden RZ verbunden sind. Regulärew Clients sind alle mit 1G angebunden, was auch ausreicht.

VMWare selbst stellt ja mit den VMXNET3 Adapter auch nur 10G zur Verfügung, ich habe hier jetzt keinen Client der irgendwo direkt an einem 40G Link rankommt. "Blech"-Windowsserver sind alle mit 10G angeschlossen, lediglich der Veeam Server hat zwei 40G Links als "Blech" Windows Server und da ist der lokale Raid-Controller das Nadelöhr.

Aggregation-Switche <-> Edge/Access sind nur mit 2 x 10G angebunden und auch nur, damit diese mit beiden RZ verbunden sind. Regulärew Clients sind alle mit 1G angebunden, was auch ausreicht.

Moin @clSchak,

der Ansicht bin ich keineswegs.

Ja, dem kann ich auch aus unserer Erfahrung heraus, voll und ganz zustimmen.

Aber sowohl bei "VMWare <-> Backup <-> Storage" als auch bei "Core <-> Aggregation" sehe ich noch keinen Grund das SGW (SecurityGateway) an der Performance deren Links auszurichten.

Was Backup angeht, so hängt die SGW bei uns nur zwischen dem Veeam und den zu sichernden Netzen, damit Veeam z.B. wegen dem VSS direkt an diese rankommt und oder wegen Einzelobjektwiederherstellung.

In die andere Richtung, sprich, z.B. vom produktivem Netz zum Veeam, ist jeglicher Zugriff per SGW gesperrt.

Der Veeam Server selbst läuft immer in einem separaten Managementnetz (incl. separater Verwaltungsdomäne), in dem sich managementtechnisch auch die Hypervisoren befinden. Beim Backup kratz der Veeam die zu sichernden Daten eh durch seine Agents direkt an den Hypervisoren ab, die dann direkt von den HV's zum Backup-SAN/NAS wandern.

Das Backup-SAN/NAS steht wiederum nochmals in einem separaten Netzsegment, auf welches nur die Hypervisoren und der Veeam Server selber, direkten Zugriff haben (separate NIC's, respektive vNIC beim Veeam), sprich nicht geroutet wegen Performance.

Auf das Management Netz selber, kommt man im besten Fall nur noch über separate Managementclients, die ausschliesslich nur für die Administration dieses Managementnetzes (Hypervisoren & Backup) verwendet werden und die von der und vor allem produktiven Umgebung, komplett abgeschottet sind.

Somit ist ein Eindringen bis zum absolut heiligen Fundament (Hypervisoren/Backup), quasi unmöglich, zumindest Remote.

OK, ich verstehe jetzt aber nicht so ganz, warum du der Ansicht bist, das für deine Umgebung eine max. XGS 3100 nicht ausreichend wäre. Vor allem wenn die Clients eh nur mit 1G angebunden sind und der WAN Uplink, wahrscheinlich auch nicht schneller ist und die Server auch nur mit 10G laufen, die wenn ich das richtig verstanden habe, eh so gut wie nie ausgereizt werden.

Schau mal die Leistungsdaten der 3100 an ...

... dass sollte meiner Ansicht nach, für die von dir beschrieben Umgebung schon voll ausreichend sein.

... dass sollte meiner Ansicht nach, für die von dir beschrieben Umgebung schon voll ausreichend sein.

Und über die Anschaffungskosten von ~30K und über 3 Jahre gesehen, sprich 10K/Jahr, kann man bei eurer Unternehmensgrösse, glaube ich auch nicht meckern. 😉

Ja, OK, die Konfig kommt noch dazu, aber die ist auch bei den kleineren Modellen genau so fällig.

Gruss Alex

auch wenn es jetzt OT wird:

der Ansicht bin ich keineswegs.

du brauchst >10G nur im Backend (VMWare <-> VMWare <-> Backup <-> Storage) oder Switching (Core <-> Aggregation) und beim Storage auch nur, wenn du kein FibreChannel machst

Ja, dem kann ich auch aus unserer Erfahrung heraus, voll und ganz zustimmen.

Aber sowohl bei "VMWare <-> Backup <-> Storage" als auch bei "Core <-> Aggregation" sehe ich noch keinen Grund das SGW (SecurityGateway) an der Performance deren Links auszurichten.

Was Backup angeht, so hängt die SGW bei uns nur zwischen dem Veeam und den zu sichernden Netzen, damit Veeam z.B. wegen dem VSS direkt an diese rankommt und oder wegen Einzelobjektwiederherstellung.

In die andere Richtung, sprich, z.B. vom produktivem Netz zum Veeam, ist jeglicher Zugriff per SGW gesperrt.

Der Veeam Server selbst läuft immer in einem separaten Managementnetz (incl. separater Verwaltungsdomäne), in dem sich managementtechnisch auch die Hypervisoren befinden. Beim Backup kratz der Veeam die zu sichernden Daten eh durch seine Agents direkt an den Hypervisoren ab, die dann direkt von den HV's zum Backup-SAN/NAS wandern.

Das Backup-SAN/NAS steht wiederum nochmals in einem separaten Netzsegment, auf welches nur die Hypervisoren und der Veeam Server selber, direkten Zugriff haben (separate NIC's, respektive vNIC beim Veeam), sprich nicht geroutet wegen Performance.

Auf das Management Netz selber, kommt man im besten Fall nur noch über separate Managementclients, die ausschliesslich nur für die Administration dieses Managementnetzes (Hypervisoren & Backup) verwendet werden und die von der und vor allem produktiven Umgebung, komplett abgeschottet sind.

Somit ist ein Eindringen bis zum absolut heiligen Fundament (Hypervisoren/Backup), quasi unmöglich, zumindest Remote.

VMWare selbst stellt ja mit den VMXNET3 Adapter auch nur 10G zur Verfügung, ich habe hier jetzt keinen Client der irgendwo direkt an einem 40G Link rankommt. "Blech"-Windowsserver sind alle mit 10G angeschlossen, lediglich der Veeam Server hat zwei 40G Links als "Blech" Windows Server und da ist der lokale Raid-Controller das Nadelöhr.

Aggregation-Switche <-> Edge/Access sind nur mit 2 x 10G angebunden und auch nur, damit diese mit beiden RZ verbunden sind. Regulärew Clients sind alle mit 1G angebunden, was auch ausreicht.

Aggregation-Switche <-> Edge/Access sind nur mit 2 x 10G angebunden und auch nur, damit diese mit beiden RZ verbunden sind. Regulärew Clients sind alle mit 1G angebunden, was auch ausreicht.

OK, ich verstehe jetzt aber nicht so ganz, warum du der Ansicht bist, das für deine Umgebung eine max. XGS 3100 nicht ausreichend wäre. Vor allem wenn die Clients eh nur mit 1G angebunden sind und der WAN Uplink, wahrscheinlich auch nicht schneller ist und die Server auch nur mit 10G laufen, die wenn ich das richtig verstanden habe, eh so gut wie nie ausgereizt werden.

Schau mal die Leistungsdaten der 3100 an ...

Und über die Anschaffungskosten von ~30K und über 3 Jahre gesehen, sprich 10K/Jahr, kann man bei eurer Unternehmensgrösse, glaube ich auch nicht meckern. 😉

Ja, OK, die Konfig kommt noch dazu, aber die ist auch bei den kleineren Modellen genau so fällig.

Gruss Alex

Moin @DeSchneller,

ähm, die XGS ist ein L2-L7 SGW, also ja, es sollte dazu in der Lage sein.

Bedenke aber, dass nicht jedes Netzsegment ums verrecken geroutet werden muss und wenn doch, dass dann beim gerouteten Datenverkehr, meistens bei weitem nicht die Datenraten anfallen, die viele Admins oft befürchten.

Wie ich schon oben angesprochen habe, eine XGS bietet dir von L2 bis L7. 😉

Ja klar ... Vorteil ...

Zuerst werden die Preise für die Subscription kräftig angezogen (ist als Letztes geschehen), dann die Appliance's dazu eine Zeitlang verschenken damit die Preiserhöhung der Subscription nicht gleich zu sehr auffällt. Dann fällt in ein paar Monaten der Bonus mit der geschenkten Hardware weg und einige Zeit später wird die Hardware selbst auch teurer. Und dann fängt das Ganze wieder von vorne an.

Dieses Spielchen hat somit nicht wirklich etwas mit einem tatsächlichen Vorteil für dich zu tun, sondern langfristig gesehen eher mit dem Gegenteil, weil du unter dem Strich für dasselbe immer mehr bezahlen musst. 😉

Aber ja, diesen Trick verwendet nicht nur Sophos, sondern die meisten Anderen auch. 😔

Gruss Alex

Deshalb war ja grundlegend die Idee das Gateway einzusetzen, dass dann eben die komplette VLAN-Trennung vornimmt und das natürlich dann auch an die Switche verteilt. Damit wäre das L3-Problem doch gelöst oder?

ähm, die XGS ist ein L2-L7 SGW, also ja, es sollte dazu in der Lage sein.

Bedenke aber, dass nicht jedes Netzsegment ums verrecken geroutet werden muss und wenn doch, dass dann beim gerouteten Datenverkehr, meistens bei weitem nicht die Datenraten anfallen, die viele Admins oft befürchten.

Ja das Angebot über die SG3100 liegt mir bereits vor! Deshalb ja auch die Frage ob die UDM die selbe "Sicherheit" nach außen bietet!? Wäre dann ja auch L3!

Wie ich schon oben angesprochen habe, eine XGS bietet dir von L2 bis L7. 😉

Aktuell habe ich bei der Sophos den Vorteil, dass der Wechsel von SG auf XGS nur die Kosten für die Lizenz anfallen! Die Hardware bekommt man geschenkt  !

!

Ja klar ... Vorteil ...

Zuerst werden die Preise für die Subscription kräftig angezogen (ist als Letztes geschehen), dann die Appliance's dazu eine Zeitlang verschenken damit die Preiserhöhung der Subscription nicht gleich zu sehr auffällt. Dann fällt in ein paar Monaten der Bonus mit der geschenkten Hardware weg und einige Zeit später wird die Hardware selbst auch teurer. Und dann fängt das Ganze wieder von vorne an.

Dieses Spielchen hat somit nicht wirklich etwas mit einem tatsächlichen Vorteil für dich zu tun, sondern langfristig gesehen eher mit dem Gegenteil, weil du unter dem Strich für dasselbe immer mehr bezahlen musst. 😉

Aber ja, diesen Trick verwendet nicht nur Sophos, sondern die meisten Anderen auch. 😔

Gruss Alex

Es geht ja nicht nur um die Clientnetze die mit 1G angebunden sind, zur Abschottung Client <-> Server gebe ich dir da recht, aber innerhalb der Verwaltungsnetze nicht.

Und ein Gerät reicht nicht aus, du musst HA fahren ab einer gewissen größe um Ausfälle kompensieren zu können, wenn du nicht nur reines Paketfiltering machen möchtest sondern ggf. weitere "Network Protection" Features nutzen willst die eine Sophos bietet, dann wird das auch mal schnell teuer. Ich sagte nicht, dass wir uns das als Firma nicht leisten können, aber die genannte 40G Auslastung im Backup geht durch den pfSense Cluster bei uns :> und das "Blech" der Server war deutlich günstiger wie eine Sophos. Wobei man am Ende sagen muss, wenn man alle Zeiten, Support usw. einrechnet, ist der Preis nahezu gleich, aber man hat ein paar mehr Möglichkeiten mit pfSense/OpnSense.

Wir werden aber auch in absehbarer Zeit auf OpnSense wechseln, aber erst wenn die Hardware "fällig" ist. Nach außen ist eine XG330 im Endausbau im HA am werkelen, ebenso der Großteil der Site2Site VPN Verbindungen ist mittlerweile auf Sophos umgestellt.

Und ein Gerät reicht nicht aus, du musst HA fahren ab einer gewissen größe um Ausfälle kompensieren zu können, wenn du nicht nur reines Paketfiltering machen möchtest sondern ggf. weitere "Network Protection" Features nutzen willst die eine Sophos bietet, dann wird das auch mal schnell teuer. Ich sagte nicht, dass wir uns das als Firma nicht leisten können, aber die genannte 40G Auslastung im Backup geht durch den pfSense Cluster bei uns :> und das "Blech" der Server war deutlich günstiger wie eine Sophos. Wobei man am Ende sagen muss, wenn man alle Zeiten, Support usw. einrechnet, ist der Preis nahezu gleich, aber man hat ein paar mehr Möglichkeiten mit pfSense/OpnSense.

Wir werden aber auch in absehbarer Zeit auf OpnSense wechseln, aber erst wenn die Hardware "fällig" ist. Nach außen ist eine XG330 im Endausbau im HA am werkelen, ebenso der Großteil der Site2Site VPN Verbindungen ist mittlerweile auf Sophos umgestellt.