Windows Fileserver Performance Optimierung - zweite Netzwerkkarte - zweite IP Adresse

Hallo zusammen,

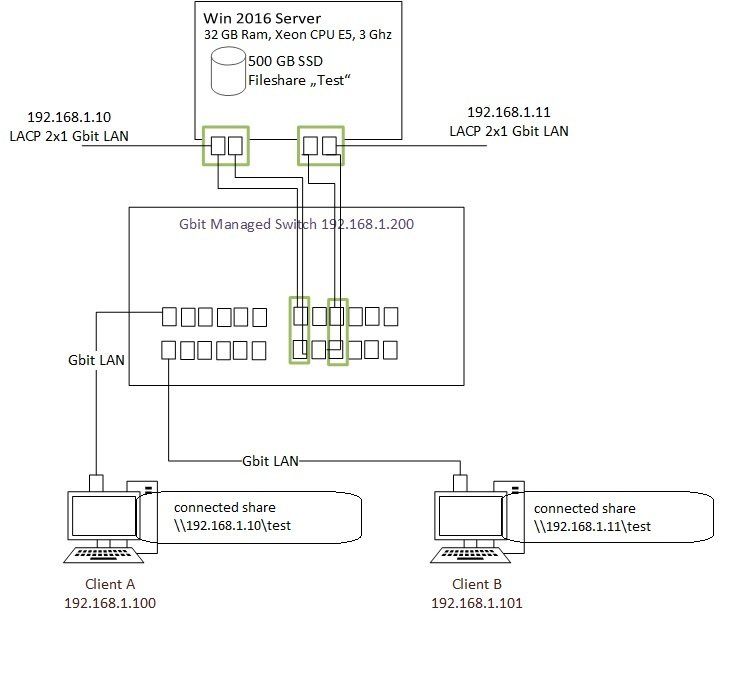

um einen Windows 2016 Fileserver etwas performanter zu gestalten hatte ich mal versucht

den Server einfach mit einer zweiten gbit Netzwerkkarte und zweiter IP Adresse im gleichen Subnetz

zu konfigurieren. Soweit hat auch alles geklappt, die zweite Netzwerkkarte bekommt nur kein Gateway eingetragen.

Die Idee war das von einem Client "A" über die IP Adresse / Netzwerkkarte "I" des Servers

das Netzlaufwerk verbunden wird und von einem Client "B" das gleiche Netzlaufwerk über die IP Adresse / Netzwerkkarte "II"

des Servers eingebunden wird. Bei der Datenübertragung dann also theoretisch 2x1 gbit unabhängig möglich sein sollte.

Beim Testen war es aber so das der Datendurchsatz nicht schneller war als bei einer IP Adresse / Netzwerkkarte

und Zugriffs von beiden Clients am Server.

Bei Ansicht des Ressourcenmonitors am Server fällt auf das der Netzwerktraffik

sich auch immer auf die zweite Netzwerkkarte zu ca. 50% verlagert, selbst wenn nur ein Client "A"

das Netzlaufwerk über IP Adresse / Netzwerkkarte "I" verbunden hat und Daten kopiert, hat auch IP Adresse / Netzwerkkarte "II" davon 50% Traffik.

Macht es überhaupt Sinn auf die Art und Weise etwas mehr Peformance heraus zu holen

und wie kommt es das der Traffic sich trotz unterschiedlicher IP Einbindung des Netzlaufwerkes

trotz auf beidem Karten verteilt und nicht die doppelte Performance möglich ist?

Bin gespannt

um einen Windows 2016 Fileserver etwas performanter zu gestalten hatte ich mal versucht

den Server einfach mit einer zweiten gbit Netzwerkkarte und zweiter IP Adresse im gleichen Subnetz

zu konfigurieren. Soweit hat auch alles geklappt, die zweite Netzwerkkarte bekommt nur kein Gateway eingetragen.

Die Idee war das von einem Client "A" über die IP Adresse / Netzwerkkarte "I" des Servers

das Netzlaufwerk verbunden wird und von einem Client "B" das gleiche Netzlaufwerk über die IP Adresse / Netzwerkkarte "II"

des Servers eingebunden wird. Bei der Datenübertragung dann also theoretisch 2x1 gbit unabhängig möglich sein sollte.

Beim Testen war es aber so das der Datendurchsatz nicht schneller war als bei einer IP Adresse / Netzwerkkarte

und Zugriffs von beiden Clients am Server.

Bei Ansicht des Ressourcenmonitors am Server fällt auf das der Netzwerktraffik

sich auch immer auf die zweite Netzwerkkarte zu ca. 50% verlagert, selbst wenn nur ein Client "A"

das Netzlaufwerk über IP Adresse / Netzwerkkarte "I" verbunden hat und Daten kopiert, hat auch IP Adresse / Netzwerkkarte "II" davon 50% Traffik.

Macht es überhaupt Sinn auf die Art und Weise etwas mehr Peformance heraus zu holen

und wie kommt es das der Traffic sich trotz unterschiedlicher IP Einbindung des Netzlaufwerkes

trotz auf beidem Karten verteilt und nicht die doppelte Performance möglich ist?

Bin gespannt

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 383308

Url: https://administrator.de/forum/windows-fileserver-performance-optimierung-zweite-netzwerkkarte-zweite-ip-adresse-383308.html

Ausgedruckt am: 18.07.2025 um 05:07 Uhr

14 Kommentare

Neuester Kommentar

Moin...

Trunking

was hast du für einen switch?

Die Idee war das von einem Client "A" über die IP Adresse / Netzwerkkarte "I" des Servers

das Netzlaufwerk verbunden wird und von einem Client "B" das gleiche Netzlaufwerk über die IP Adresse / Netzwerkkarte "II"

des Servers eingebunden wird. Bei der Datenübertragung dann also theoretisch 2x1 gbit unabhängig möglich sein sollte.

Beim Testen war es aber so das der Datendurchsatz nicht schneller war als bei einer IP Adresse / Netzwerkkarte

und Zugriffs von beiden Clients am Server.

nee... so wird das ja auch nix....

wie hast du den gemessen?

wenn überhaubt mit iPerf3

Bei Ansicht des Ressourcenmonitors am Server fällt auf das der Netzwerktraffik

sich auch immer auf die zweite Netzwerkkarte zu ca. 50% verlagert, selbst wenn nur ein Client "A"

das Netzlaufwerk über IP Adresse / Netzwerkkarte "I" verbunden hat und Daten kopiert, hat auch IP Adresse / Netzwerkkarte "II" davon 50% Traffik.

über was für einen Server reden wir eigentlich?

SSD Raid.... Sata / SAS 5200er spindeln... etc...

was für dateien, viele große.. oder kleine dateien...

SMB1/ SMB2/SMB3 ?

Macht es überhaupt Sinn auf die Art und Weise etwas mehr Peformance heraus zu holen

hm....

Bin gespannt

Frank

Zitat von @melters:

Hallo zusammen,

um einen Windows 2016 Fileserver etwas performanter zu gestalten hatte ich mal versucht

den Server einfach mit einer zweiten gbit Netzwerkkarte und zweiter IP Adresse im gleichen Subnetz

zu konfigurieren. Soweit hat auch alles geklappt, die zweite Netzwerkkarte bekommt nur kein Gateway eingetragen.

Netter versuch...nun das wird so nix... wenn überhaubt mit einem 10 Gbit Netzwerk... oder bei 1 Gbit, wenn die hardware mitmacht, port trunking....Hallo zusammen,

um einen Windows 2016 Fileserver etwas performanter zu gestalten hatte ich mal versucht

den Server einfach mit einer zweiten gbit Netzwerkkarte und zweiter IP Adresse im gleichen Subnetz

zu konfigurieren. Soweit hat auch alles geklappt, die zweite Netzwerkkarte bekommt nur kein Gateway eingetragen.

Trunking

was hast du für einen switch?

Die Idee war das von einem Client "A" über die IP Adresse / Netzwerkkarte "I" des Servers

das Netzlaufwerk verbunden wird und von einem Client "B" das gleiche Netzlaufwerk über die IP Adresse / Netzwerkkarte "II"

des Servers eingebunden wird. Bei der Datenübertragung dann also theoretisch 2x1 gbit unabhängig möglich sein sollte.

Beim Testen war es aber so das der Datendurchsatz nicht schneller war als bei einer IP Adresse / Netzwerkkarte

und Zugriffs von beiden Clients am Server.

wie hast du den gemessen?

wenn überhaubt mit iPerf3

Bei Ansicht des Ressourcenmonitors am Server fällt auf das der Netzwerktraffik

sich auch immer auf die zweite Netzwerkkarte zu ca. 50% verlagert, selbst wenn nur ein Client "A"

das Netzlaufwerk über IP Adresse / Netzwerkkarte "I" verbunden hat und Daten kopiert, hat auch IP Adresse / Netzwerkkarte "II" davon 50% Traffik.

SSD Raid.... Sata / SAS 5200er spindeln... etc...

was für dateien, viele große.. oder kleine dateien...

SMB1/ SMB2/SMB3 ?

Macht es überhaupt Sinn auf die Art und Weise etwas mehr Peformance heraus zu holen

und wie kommt es das der Traffic sich trotz unterschiedlicher IP Einbindung des Netzlaufwerkes

trotz auf beidem Karten verteilt und nicht die doppelte Performance möglich ist?

weil jede verbindung nur nur max1 Gbit kann...trotz auf beidem Karten verteilt und nicht die doppelte Performance möglich ist?

Bin gespannt

Hallo,

entschuldige, kann es sein, daß Du von der Materie noch nicht soviel Kenntnisse hast?

Nun, schreibst Du zwar daß Du einen Windows Server 2016 als Fileserver einsetzt, aber wie dieser angebunden ist, wissen wir nicht.

Das ist nun mal eine der essentiellen Informationen, die fehlen.

Und wie Frank aka Vision2015 schon geschrieben hat, müßtest Du Trunking bzw. LACP einsetzen. Und dazu muss auch der zugehörige Switch konfiguriert werden.

P.S. Wie Du eine Frage richtig stellst. Wenn Du diese Tipps beherzigst, dann können wir besser helfen.

Gruss Penny

entschuldige, kann es sein, daß Du von der Materie noch nicht soviel Kenntnisse hast?

Nun, schreibst Du zwar daß Du einen Windows Server 2016 als Fileserver einsetzt, aber wie dieser angebunden ist, wissen wir nicht.

Das ist nun mal eine der essentiellen Informationen, die fehlen.

Und wie Frank aka Vision2015 schon geschrieben hat, müßtest Du Trunking bzw. LACP einsetzen. Und dazu muss auch der zugehörige Switch konfiguriert werden.

P.S. Wie Du eine Frage richtig stellst. Wenn Du diese Tipps beherzigst, dann können wir besser helfen.

Gruss Penny

Hi,

das geht nur und macht nur Sinn unter bestimmten Bedingungen.

Dass man an der 2. NIC kein extra GW eintragen kann, ist logisch, wenn an diese NIC eine Adresse aus dem selben Netz wie bei der anderen NIC gebunden ist. Du könntest hier höchstens ein 2. Subnetz erstellen, aber das würde ich mir sehr gut überlegen! Da kann alles nur noch schlimmer werden.

Wenn beide NIC Adressen im selben Netz haben und der Server sich mit beiden Adressen im DNS registriert hat, dann werden die Clients den Namen des Servers theoretisch nach Round-Robin auflösen, so dass es sein kann, dass die Clients "gleichmäßig verteilt" jeweils eine andere Adresse des Servers bekommen. Die Clients sprechen den Server dann also über verschiedene NIC an. Der Server wird aber immer über die am höchsten gebundene NIC dieser beiden antworten. D.h. alle Antworten in dieses Netz gehen über nur eine der beiden NIC raus. Damit bist Du wieder auf die Bandbreite dieser einen NIC limitiert und der erhoffte Effekt ist dahin.

Wenn, dann macht das also wie oben erwähnt nur Sinn, wenn die Clients aus verschiedenen Netzen kommen und der Server mit je einer NIC in einem dieser Netze ist oder der Traffic durch Routing an die NIC verteilt wird und der Server durch entsprechende Routing-Einträge weiß, an welches Netz er wie kommt. Allerdings musst Du hier aufpassen, dass die Clients dann immer die richtige (passende) IP-Adresse aus dem DNS aufgelöst bekommen.

E.

das geht nur und macht nur Sinn unter bestimmten Bedingungen.

Dass man an der 2. NIC kein extra GW eintragen kann, ist logisch, wenn an diese NIC eine Adresse aus dem selben Netz wie bei der anderen NIC gebunden ist. Du könntest hier höchstens ein 2. Subnetz erstellen, aber das würde ich mir sehr gut überlegen! Da kann alles nur noch schlimmer werden.

Wenn beide NIC Adressen im selben Netz haben und der Server sich mit beiden Adressen im DNS registriert hat, dann werden die Clients den Namen des Servers theoretisch nach Round-Robin auflösen, so dass es sein kann, dass die Clients "gleichmäßig verteilt" jeweils eine andere Adresse des Servers bekommen. Die Clients sprechen den Server dann also über verschiedene NIC an. Der Server wird aber immer über die am höchsten gebundene NIC dieser beiden antworten. D.h. alle Antworten in dieses Netz gehen über nur eine der beiden NIC raus. Damit bist Du wieder auf die Bandbreite dieser einen NIC limitiert und der erhoffte Effekt ist dahin.

Wenn, dann macht das also wie oben erwähnt nur Sinn, wenn die Clients aus verschiedenen Netzen kommen und der Server mit je einer NIC in einem dieser Netze ist oder der Traffic durch Routing an die NIC verteilt wird und der Server durch entsprechende Routing-Einträge weiß, an welches Netz er wie kommt. Allerdings musst Du hier aufpassen, dass die Clients dann immer die richtige (passende) IP-Adresse aus dem DNS aufgelöst bekommen.

E.

D.h. die am "höchsten gebundene NIC" ist statisch eingetragen und wechselst nicht aufgrund von hoher Auslastung auf die zweite NIC?

In der Tat sind beide IPs dem DNS Namen des Servers zugeordnet, da scheint dann Reverse Lookup zu greifen.

Was hat hier Reverse Lookup damit zu tun? Benutzen die Clients den Servernamen oder die IP-Adresse beim Zugriff auf den Server?In der Tat sind beide IPs dem DNS Namen des Servers zugeordnet, da scheint dann Reverse Lookup zu greifen.

Was würde denn passieren wenn eine IP ohne DNS Eintrag verwendet würde, müsste dann nicht explizit dieser per IP angesprochen NIC genutzt werden? (Klar, ist eine nicht ganz saubere Lösung)

Wenn der Client nicht den Namen anspricht sondern die IP-Adresse, dann ja. Aber auch nur eingehend. Ausgehend sollte das dann wieder über die "höchste" NIC gehen.Es bestätigt sich aber insgesamt warum extra Storagesysteme mit lun und MPIO Anbindung mit Lastverteilung seine daseinsberechtigung haben

Jetzt verwechselst Du Äppel mit Bürnen.Selbst wenn Du jetzt am Server ein Storage über FC oder iSCSI angebunden hättest, egal ob über einen Pfad oder mehrere mit MPIO, so würde das doch nichts daran ändern, dass die Clients weiterhin über dieselbe Netzwerkanbindung mit dem Server sprechen müssen, wie vorher.

Moin...

was sagt den iperf3 ?

poste doch mal bitte die ergebnisse!

pste mal bitte ein

von der switch console!

normalerweise würden alle Nic´s in einem Trunk zusammengefasst, also hätte dein server eigentlich nur eine IP!

was für eine NIC ist in deinem server verbaut?

Frank

was sagt den iperf3 ?

poste doch mal bitte die ergebnisse!

>was hast du für einen switch?

Einen managed HP Switch der die genannten Features auch unterstützt

und was genau für ein HP Switch? wie wurde den LACP, eingerichtet?Einen managed HP Switch der die genannten Features auch unterstützt

pste mal bitte ein

show lacpnormalerweise würden alle Nic´s in einem Trunk zusammengefasst, also hätte dein server eigentlich nur eine IP!

was für eine NIC ist in deinem server verbaut?

Frank

Also nochmal. Storageanbindung hat erstmal nichts mit der LAN-Performance zwischen Client und Server zu tun. Wenn der Storage über iSCSI schneller ist als der lokale Storage, dann und nur dann könnte das eine positive Auswirkung für die Clients haben. Auch auch nur dann, wenn das iSCSI dann über eigene NICs geht, weil es sonst den Verbindungen zu den Clients die Bandbreite wegnimmt.

Die Gesamtmenge an Daten ist für die Performance eines Server i.A. irrelevant. Interessant ist nur, wieviel Daten bewegt werden.

Insofern könnte auch eine Aufteilung in 20 TB : 1 GB Nutzen bringen, wenn 3 Benutzer mit diesen 1 GB mehr Stress produzieren, als 100 andere mit den verbleibenden 20 TB.

Es kan auch schon Sinn genug ergeben, wenn man die Daten innerhalb des Servers auf mehrere HDD's verteilt. Entweder in einem großen RAID oder in mehreren kleinen. Aber darüber nachzudenken macht wiederrum nur Sinn, wenn man dort den Flaschenhalks vermutet. Wenn das Problem in der Verbindung zu vermuten ist, dann könnte eine Aufteilung über mehrere Server Sinn ergeben.

Hast Du überthaupt schon einmal gemessen, wo genau bei Euch der Flaschenhals ist? Das könnten ja auch die auf 100 Mbit/s eingestellten NICs am Client sein. Oder eine falsch konfigurierte/programmierte Datenbank, welche zuviele IOpS produziert?

Insofern könnte auch eine Aufteilung in 20 TB : 1 GB Nutzen bringen, wenn 3 Benutzer mit diesen 1 GB mehr Stress produzieren, als 100 andere mit den verbleibenden 20 TB.

Es kan auch schon Sinn genug ergeben, wenn man die Daten innerhalb des Servers auf mehrere HDD's verteilt. Entweder in einem großen RAID oder in mehreren kleinen. Aber darüber nachzudenken macht wiederrum nur Sinn, wenn man dort den Flaschenhalks vermutet. Wenn das Problem in der Verbindung zu vermuten ist, dann könnte eine Aufteilung über mehrere Server Sinn ergeben.

Hast Du überthaupt schon einmal gemessen, wo genau bei Euch der Flaschenhals ist? Das könnten ja auch die auf 100 Mbit/s eingestellten NICs am Client sein. Oder eine falsch konfigurierte/programmierte Datenbank, welche zuviele IOpS produziert?

Moin...

hast du die IPerf Messung gemacht?

wenn ja, wie war das ergebnis?

und auch da... mit iperf messen... in der regel gibbet viele konfigurations fehler... diese vermute ich auch bei dir!

Frank

Zitat von @melters:

Die NICs an den Clients laufen alle mit Gbit, scheint wirklich der Engpass an der Anbindung des Servers zu sein sobald viele Zugriff erfolgen.

nur weil alle NIC´s Gigabit anzeigen, müssen die nicht unbedingt auch GBit übertragen!Zitat von @emeriks:

Hast Du überthaupt schon einmal gemessen, wo genau bei Euch der Flaschenhals ist? Das könnten ja auch die auf 100 Mbit/s eingestellten NICs am Client sein. Oder eine falsch konfigurierte/programmierte Datenbank, welche zuviele IOpS produziert?

Hast Du überthaupt schon einmal gemessen, wo genau bei Euch der Flaschenhals ist? Das könnten ja auch die auf 100 Mbit/s eingestellten NICs am Client sein. Oder eine falsch konfigurierte/programmierte Datenbank, welche zuviele IOpS produziert?

Die NICs an den Clients laufen alle mit Gbit, scheint wirklich der Engpass an der Anbindung des Servers zu sein sobald viele Zugriff erfolgen.

hast du die IPerf Messung gemacht?

wenn ja, wie war das ergebnis?

Ich denke als kurzfristige Lösung wird es helfen den Zugriff / Datenablage Storage auf zwei Server aufzuteilen,

also getrennte ISCSI eingebundene Bereiche, mittelfristig scheint mir aber nur eine Investition in 10Gbit bei

der künftig geplanten Masse an Daten sinnvoll zu sein. Mittlerweile ist die Technik ja auch bezahlbarer geworden.

ja... nur auch bei 10 GBit gibbet einiges zu beachten! wenn es geht kauf nix über Kupfer, sondern SFP+also getrennte ISCSI eingebundene Bereiche, mittelfristig scheint mir aber nur eine Investition in 10Gbit bei

der künftig geplanten Masse an Daten sinnvoll zu sein. Mittlerweile ist die Technik ja auch bezahlbarer geworden.

und auch da... mit iperf messen... in der regel gibbet viele konfigurations fehler... diese vermute ich auch bei dir!

Frank