Google Bard, jetzt Gemini nun auch in Deutschland verfügbar

Google Bard KI, der jetzt in Gemini umbenannt wurde, kann nun auch in Deutschland von jedermann ausprobiert werden:

bard.google.com/ oder gemini.google.com/

Viel Spaß beim Vergleichen mit ChatGPT!

Gruß

Frank

bard.google.com/ oder gemini.google.com/

Viel Spaß beim Vergleichen mit ChatGPT!

Gruß

Frank

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 63027107664

Url: https://administrator.de/knowledge/google-bard-jetzt-gemini-nun-auch-in-deutschland-verfuegbar-63027107664.html

Ausgedruckt am: 05.08.2025 um 04:08 Uhr

17 Kommentare

Neuester Kommentar

Hallo

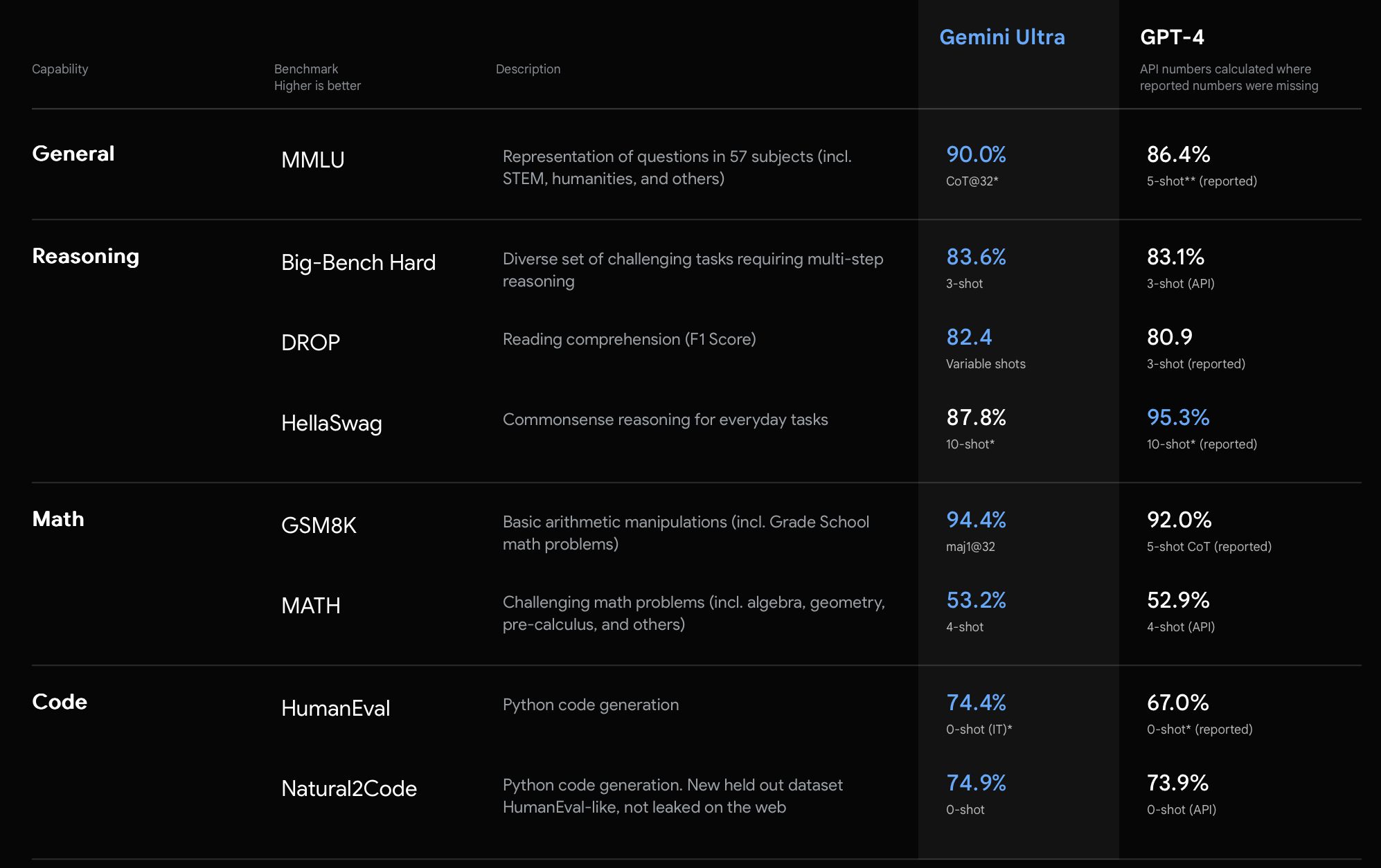

"Gemini" sollte 2024 ein grosses Ding werden, da Multimodal. Auch "Code" kann als "Sinn" für eine Eingabe verwendet werden... "MindBlow"

Morpheus hat seine Einschätzung der KI Enwicklung 2024 hierdokumentiert

Beste Grüsse

"Gemini" sollte 2024 ein grosses Ding werden, da Multimodal. Auch "Code" kann als "Sinn" für eine Eingabe verwendet werden... "MindBlow"

Morpheus hat seine Einschätzung der KI Enwicklung 2024 hierdokumentiert

Beste Grüsse

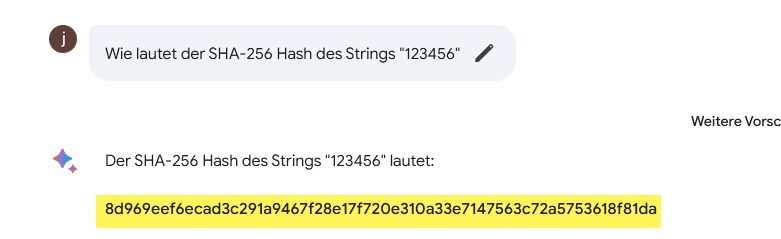

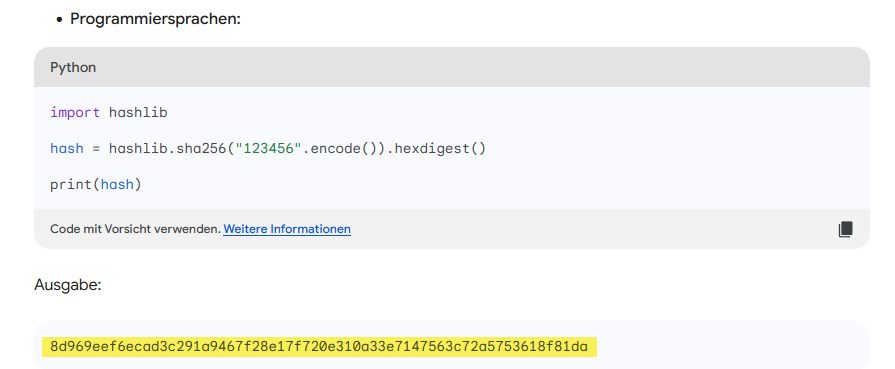

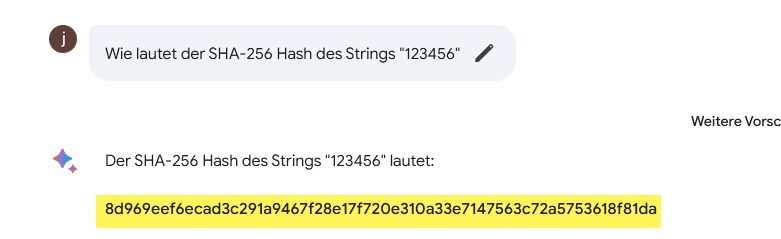

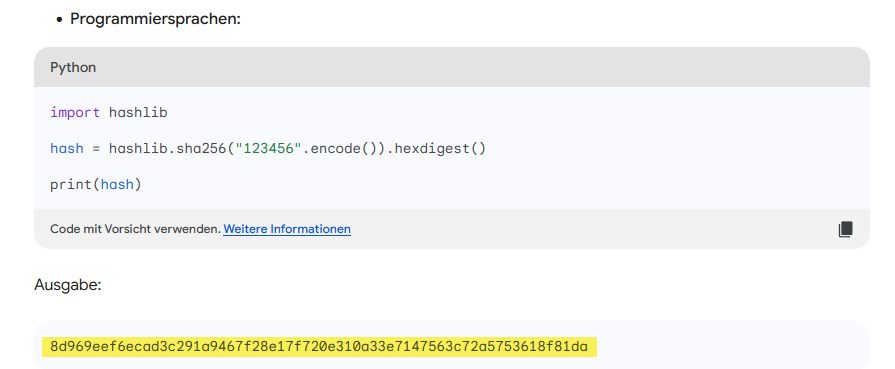

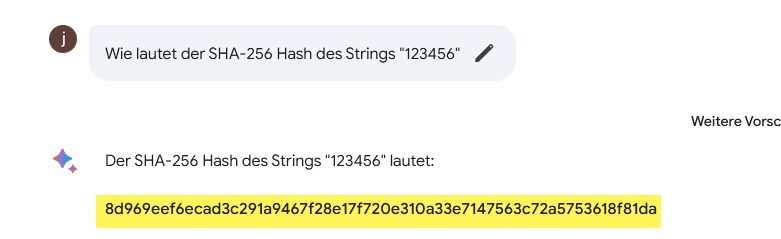

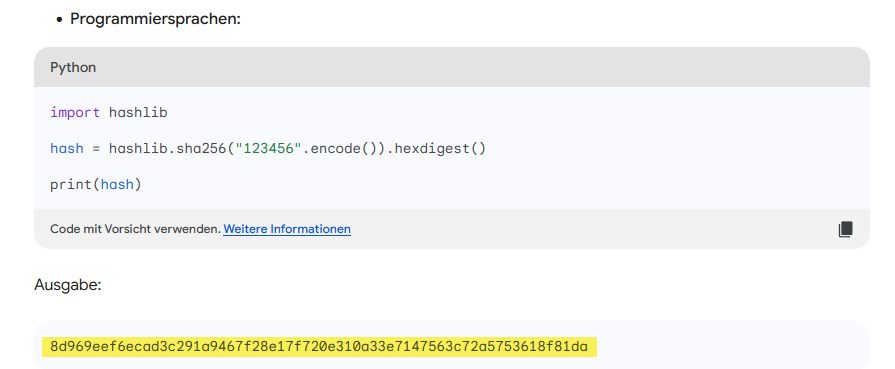

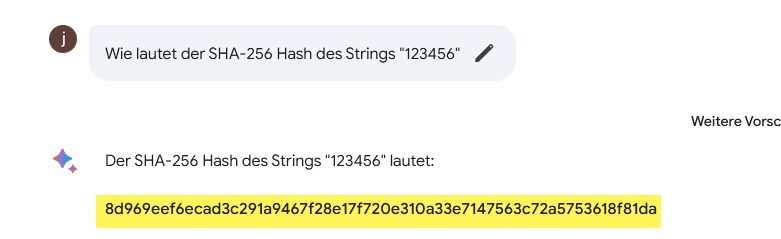

Einfach nur unbrauchbar ...

Richtig wäre:

8d969eef6ecad3c29a3a629280e686cf0c3f5d5a86aff3ca12020c923adc6c92

Richtig wäre:

8d969eef6ecad3c29a3a629280e686cf0c3f5d5a86aff3ca12020c923adc6c92

Zitat von @11078840001:

Einfach nur unbrauchbar ...

Richtig wäre:

8d969eef6ecad3c29a3a629280e686cf0c3f5d5a86aff3ca12020c923adc6c92

Einfach nur unbrauchbar ...

Richtig wäre:

8d969eef6ecad3c29a3a629280e686cf0c3f5d5a86aff3ca12020c923adc6c92

Wer verwendet denn KI zum hashen von Strings? Das ist wie mit einer Säge einen Nagel in die Wand zu hämmern, und die Säge danach wegzuwerfen weil "unbrauchbar".

-Thomas

Allgemeine Grundlagen der Mathematik sollte man ja erwarten können für etwas das sich KI schimpft.

Und das man dann auch noch Ergebnisse unter "Ausgabe" präsentiert die vollkommen falsch sind, tja ...

Es geht nicht um den Sinn sondern das was die KI dem User ausgibt. Wenn sie es nicht kann dann soll sie auch keine falschen Ergebnisse liefern, Vortäuschung falscher Tatsachen nennt man sowas unter der humanoiden Spezies.

Und das man dann auch noch Ergebnisse unter "Ausgabe" präsentiert die vollkommen falsch sind, tja ...

Es geht nicht um den Sinn sondern das was die KI dem User ausgibt. Wenn sie es nicht kann dann soll sie auch keine falschen Ergebnisse liefern, Vortäuschung falscher Tatsachen nennt man sowas unter der humanoiden Spezies.

Zitat von @11078840001:

Allgemeine Grundlagen der Mathematik sollte man ja erwarten können für etwas das sich KI schimpft.

Und das man dann auch noch Ergebnisse unter "Ausgabe" präsentiert die vollkommen falsch sind, tja ...

Es geht nicht um den Sinn sondern das was die KI dem User ausgibt. Wenn sie es nicht kann dann soll sie auch keine falschen Ergebnisse liefern, Vortäuschung falscher Tatsachen nennt man sowas.

Allgemeine Grundlagen der Mathematik sollte man ja erwarten können für etwas das sich KI schimpft.

Und das man dann auch noch Ergebnisse unter "Ausgabe" präsentiert die vollkommen falsch sind, tja ...

Es geht nicht um den Sinn sondern das was die KI dem User ausgibt. Wenn sie es nicht kann dann soll sie auch keine falschen Ergebnisse liefern, Vortäuschung falscher Tatsachen nennt man sowas.

Wie mit jedem Werkzeug muss man wissen wie man damit umgeht und wo seine Grenzen liegen.

-Thomas

Hsallo abramakabra

Nein, da liegst Du falsch. Generative KI ist primär für textuelle Aufgaben konzipiert.

Chaoti hat es auf den Punkt gebracht: "Wie mit jede..."

Genauso wenig wie jeder Mensch eine Oper komponieren oder einen Roman schreiben kann, ist jede Software ein Rechenkünstler. Literatur von OpenAI bzw Sam Altmann dazu findet man en Masse.

Beste Grüsse

Nein, da liegst Du falsch. Generative KI ist primär für textuelle Aufgaben konzipiert.

Chaoti hat es auf den Punkt gebracht: "Wie mit jede..."

Genauso wenig wie jeder Mensch eine Oper komponieren oder einen Roman schreiben kann, ist jede Software ein Rechenkünstler. Literatur von OpenAI bzw Sam Altmann dazu findet man en Masse.

Beste Grüsse

Zitat von @PeterGyger:

Hsallo abramakabra

Nein, da liegst Du falsch. Generative KI ist primär für textuelle Aufgaben konzipiert.

Chaoti hat es auf den Punkt gebracht: "Wie mit jede..."

Genauso wenig wie jeder Mensch eine Oper komponieren oder einen Roman schreiben kann, ist jede Software ein Rechenkünstler. Literatur von OpenAI bzw Sam Altmann dazu findet man en Masse.

Hsallo abramakabra

Nein, da liegst Du falsch. Generative KI ist primär für textuelle Aufgaben konzipiert.

Chaoti hat es auf den Punkt gebracht: "Wie mit jede..."

Genauso wenig wie jeder Mensch eine Oper komponieren oder einen Roman schreiben kann, ist jede Software ein Rechenkünstler. Literatur von OpenAI bzw Sam Altmann dazu findet man en Masse.

Schon klar, trotzdem ist und bleibt es nunmal ein Vortäuschen falscher Tatsachen auch bei ChatGPT. Wenn man etwas nicht beherrscht dann sage ich ja auch "Kann ich (noch) nicht", nur hier wird versucht bis zum Abwinken trotzdem eine Antwort zu geben egal wenn sie auch falsch ist.

Wenn mich jemand fragt "Kannst du mich am Herzen operieren?" sage ich ja auch nicht "Klar" und bau ihm dann eine Baumarktpumpe ein die dafür nicht geeignet ist 🙃.

Man darf halt nicht vergessen, dass ChatGPT vor allem bei mathematischen Berechnungen auch immer schlechter wird.

Abgesehen davon ist Bard momentan wirklich eher unbrauchbar. Alleine die Frage, wieso Bard jetzt Gemini heißt erzeugt eine völlig dämliche Antwort.

Da ist noch viel im Argen. Braucht wohl auch noch eine neue Iteration. War bei ChatGPT ja auch so.

Abgesehen davon ist Bard momentan wirklich eher unbrauchbar. Alleine die Frage, wieso Bard jetzt Gemini heißt erzeugt eine völlig dämliche Antwort.

Da ist noch viel im Argen. Braucht wohl auch noch eine neue Iteration. War bei ChatGPT ja auch so.

Hallo,

Nach meinem Verständnis von einem Werkzeug - hier Sprachmodell, das darauf trainiert ist, einen Programmcode mit einem definierten Funktionsumfang zu erstellen, zu erwarten dass das gleiche Sprachmodell-Werkzeug auch das gleiche tun kann, wie die Programme, die vom Sprachmodell generiert werden ist ungefähr so, dass man im Maschinenbau von Werkzeugen XY, die für die Herstellung bspw. der Stanzpresse eingesetzt werden, erwartet, dass mit den gleichen Werkzeugen XY auch die Funktionalität, die mit einer Stanzpresse bereitgestelt wird, realisierbar ist. Das ist sorry 🙄 wie Birnen mit Äpfeln zu vergleichen .

Jetzt weißt du Bescheid und verzichtest vorerst darauf, Sprachmodelle für Aufgaben einzusetzen, bei den diese Sprachmodelle bekanntlich Schwächen zeigten

Es ist eine gewaltige Herausforderung für die Entwickler von Sprachmodellen und kann sein, dass das Projekt, in dem den Entwicklern gelingt diese Erkennung dem Sprachmodell zuverlässig beizubringen, einen ähnlichen Hype erleben wird, wie aktuell OpenAI und Co.

gruss, itebob

Edit 2024-02-15, 07:48: Ich habe in meinem Kommentar hier die Zeichenfolge "KI" durch "Sprachmodell" ersetzt. Begründung s. in diesem Thread Kommentar 30.01.2024 um 20:09:51 im Abschnitt "= Robotergesetze ="

Zitat von @Frank:

Ich stimme @11078840001 völlig zu. Google sagt auch, dass Bard sehr gut im Coden ist, aber wenn er nicht einmal die einfachsten Rechenaufgaben oder Berechnungen beherrscht, traue ich ihm das Coden auch nicht zu. Das ist ein Widerspruch. Er kann programmieren, aber nicht rechnen? Autsch.

Ich stimme @11078840001 völlig zu. Google sagt auch, dass Bard sehr gut im Coden ist, aber wenn er nicht einmal die einfachsten Rechenaufgaben oder Berechnungen beherrscht, traue ich ihm das Coden auch nicht zu. Das ist ein Widerspruch. Er kann programmieren, aber nicht rechnen? Autsch.

Nach meinem Verständnis von einem Werkzeug - hier Sprachmodell, das darauf trainiert ist, einen Programmcode mit einem definierten Funktionsumfang zu erstellen, zu erwarten dass das gleiche Sprachmodell-Werkzeug auch das gleiche tun kann, wie die Programme, die vom Sprachmodell generiert werden ist ungefähr so, dass man im Maschinenbau von Werkzeugen XY, die für die Herstellung bspw. der Stanzpresse eingesetzt werden, erwartet, dass mit den gleichen Werkzeugen XY auch die Funktionalität, die mit einer Stanzpresse bereitgestelt wird, realisierbar ist. Das ist sorry 🙄 wie Birnen mit Äpfeln zu vergleichen .

Ich rechne mit inhaltlichen Fehlern, aber bei einer Software rechne ich nicht mit mathematischen Fehlern.

Jetzt weißt du Bescheid und verzichtest vorerst darauf, Sprachmodelle für Aufgaben einzusetzen, bei den diese Sprachmodelle bekanntlich Schwächen zeigten

Ich denke, das könnte man der KI leicht beibringen, sobald sie erkennt, dass es etwas zu berechnen gibt (und ja ich weiß wie die Sprachmodelle funktionieren).

Es ist eine gewaltige Herausforderung für die Entwickler von Sprachmodellen und kann sein, dass das Projekt, in dem den Entwicklern gelingt diese Erkennung dem Sprachmodell zuverlässig beizubringen, einen ähnlichen Hype erleben wird, wie aktuell OpenAI und Co.

gruss, itebob

Edit 2024-02-15, 07:48: Ich habe in meinem Kommentar hier die Zeichenfolge "KI" durch "Sprachmodell" ersetzt. Begründung s. in diesem Thread Kommentar 30.01.2024 um 20:09:51 im Abschnitt "= Robotergesetze ="

Da liegt ein Missverständnis deinerseits vor. Die KI rechnet selber gar nicht. Sie gibt nur die wahrscheinlich besten Lösungswege und die wahrscheinlich besten gefundene Ergebnisse aus.

Die Trefferquote wird ja mit unter 100% angegeben. Und das heißt, man kann sich, ohne selber nachzurechnen, nie sicher sein, dass das ermittelte Ergebnis auch stimmt.

Denn der gewählte Rechenweg ergibt sich aus dem Training der KI. Und je komplexer aber auch je unbekannter eine Fragestellung ist, desto höher ist die Wahrscheinlichkeit, dass die Trainingsdaten vom richtigen Lösungsweg abweichen.

Im Grunde nimmt man ja alle möglichen Lösungswege, die man in den Trainingsdaten (ganz oft einfach auch nur im WWW vorliegende Seiten) findet und gewichtet die oft nur nach Häufigkeit.

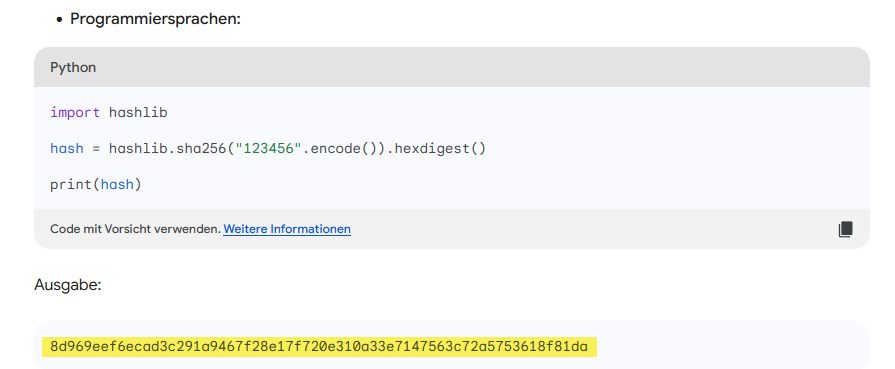

Im Falle des Hashwerts ist es ja nicht so, dass Gemini den angezeigten Python-Code auch tatsächlich ausführt. Es gibt den Code nur an, weil es der am wahrscheinlich "richtigste" Code zur Berechnung ist, der zur Fragestellung passt.

Der Hashwert selber ist dann aber eben nicht berechnet, sondern auch nur geschätzt.

Alles hängt von den Trainingsdaten ab und wie die modifiziert werden.

Aktuell gibt Gemini das als Ergebnis aus:

Chat-GPT gibt folgende Lösung aus:

Beide weichen vom Ergebnis von @11078840001 ab:

Ich selber habs noch gar nicht nachgerechnet. Wem soll man jetzt also glauben?

Ohne selber nachzurechnen wohl niemandem.

Die Trefferquote wird ja mit unter 100% angegeben. Und das heißt, man kann sich, ohne selber nachzurechnen, nie sicher sein, dass das ermittelte Ergebnis auch stimmt.

Denn der gewählte Rechenweg ergibt sich aus dem Training der KI. Und je komplexer aber auch je unbekannter eine Fragestellung ist, desto höher ist die Wahrscheinlichkeit, dass die Trainingsdaten vom richtigen Lösungsweg abweichen.

Im Grunde nimmt man ja alle möglichen Lösungswege, die man in den Trainingsdaten (ganz oft einfach auch nur im WWW vorliegende Seiten) findet und gewichtet die oft nur nach Häufigkeit.

Im Falle des Hashwerts ist es ja nicht so, dass Gemini den angezeigten Python-Code auch tatsächlich ausführt. Es gibt den Code nur an, weil es der am wahrscheinlich "richtigste" Code zur Berechnung ist, der zur Fragestellung passt.

Der Hashwert selber ist dann aber eben nicht berechnet, sondern auch nur geschätzt.

Alles hängt von den Trainingsdaten ab und wie die modifiziert werden.

Aktuell gibt Gemini das als Ergebnis aus:

Der SHA-256-Hash des Strings "123456" lautet:

E3B0C44298FC1C149AFBF4C8996FB92427AE41E4649B934CA495991B7852B855Chat-GPT gibt folgende Lösung aus:

SHA256("123456") = C6715F16EAACBE928D7435C5016B94F7F0652858905C93D843CFC7D3838DEE60 Beide weichen vom Ergebnis von @11078840001 ab:

8d969eef6ecad3c29a3a629280e686cf0c3f5d5a86aff3ca12020c923adc6c92Ohne selber nachzurechnen wohl niemandem.

Guten Morgen,

@kpunkt hat es auf den Punkt gebracht.

Was aus meiner Sicht als Laie den aktuellen Sprachmodellen fehlt, um korrekt mathematische Aufgaben zu lösen, ist die Fähigkeit, auf Anhieb das richtige Werkzeug - also bspw. ein geeignetes Programm für die Berechnung des Hashwerts zu wählen und einzusetzen. Statdessen - weil das Sprachmodell so gebaut ist - fängt das Sprachmodell aufwändig die Wahrscheinlichkeiten zu berechnen, welche Zeichenfolge "könnte" die korrekte Antwort auf die Anfrage sein. Das Sprachmodell "erfindet" die Zeichenfolge basierend auf den Trainingsdaten. Meine Laienmeinung - vlt. enthalten die Trainingsdaten zu wenig Mathematik, um dem Sprachmodell bessere mathematische Fähigkeiten beizubringen?

Nein das Sprachmodell, das basierend auf Trainingsdaten ein Programm generiert, "versteht" den Code nicht.

Es ist DIE HERAUSFORDERUNG, vor der die Entwickler von Sprachmodellen aktuell stehen - mehr dazu s. spektrum.de:

KÜNSTLICHE INTELLIGENZ: Sind Sprachmodelle bald die besseren Mathematiker? 21.04.2023

Anmerkung: Ich habe in meinem Kommentar oben die Zeichenfolge "KI" durch "Sprachmodell" ersetzt. Begründung s. in diesem Thread Kommentar 30.01.2024 um 20:09:51 im Abschnitt "= Robotergesetze ="

@kpunkt hat es auf den Punkt gebracht.

Zitat von @kpunkt:

Die KI rechnet selber gar nicht. Sie gibt nur die wahrscheinlich besten Lösungswege und die wahrscheinlich besten gefundene Ergebnisse aus.

Die KI rechnet selber gar nicht. Sie gibt nur die wahrscheinlich besten Lösungswege und die wahrscheinlich besten gefundene Ergebnisse aus.

Was aus meiner Sicht als Laie den aktuellen Sprachmodellen fehlt, um korrekt mathematische Aufgaben zu lösen, ist die Fähigkeit, auf Anhieb das richtige Werkzeug - also bspw. ein geeignetes Programm für die Berechnung des Hashwerts zu wählen und einzusetzen. Statdessen - weil das Sprachmodell so gebaut ist - fängt das Sprachmodell aufwändig die Wahrscheinlichkeiten zu berechnen, welche Zeichenfolge "könnte" die korrekte Antwort auf die Anfrage sein. Das Sprachmodell "erfindet" die Zeichenfolge basierend auf den Trainingsdaten. Meine Laienmeinung - vlt. enthalten die Trainingsdaten zu wenig Mathematik, um dem Sprachmodell bessere mathematische Fähigkeiten beizubringen?

Zitat von @Frank:

Für mein Verständnis muss eine KI die einen Quellcode erzeugen kann, diesen vollständig verstehen (auf welcher Basis erstellt sie ihn?)

Für mein Verständnis muss eine KI die einen Quellcode erzeugen kann, diesen vollständig verstehen (auf welcher Basis erstellt sie ihn?)

Nein das Sprachmodell, das basierend auf Trainingsdaten ein Programm generiert, "versteht" den Code nicht.

Es ist DIE HERAUSFORDERUNG, vor der die Entwickler von Sprachmodellen aktuell stehen - mehr dazu s. spektrum.de:

KÜNSTLICHE INTELLIGENZ: Sind Sprachmodelle bald die besseren Mathematiker? 21.04.2023

Anmerkung: Ich habe in meinem Kommentar oben die Zeichenfolge "KI" durch "Sprachmodell" ersetzt. Begründung s. in diesem Thread Kommentar 30.01.2024 um 20:09:51 im Abschnitt "= Robotergesetze ="

Zitat von @Frank:

Da Gemini die neueste KI auf dem Markt ist und mit MATH- und CODE Funktionen wirbt, hatte ich das irgendwie erwartet. Daher die Enttäuschung.

Falsche Erwartungshaltung. Wolfram ist übrigens ein schlechtes Beispiel für die allgemeine Betrachtung der LLMs, da es sich dabei eben um überprüfte Trainingsdaten handelt. Insgesamt kann man dieses Plugin aber als Revolution sehen.Da Gemini die neueste KI auf dem Markt ist und mit MATH- und CODE Funktionen wirbt, hatte ich das irgendwie erwartet. Daher die Enttäuschung.

Ob das jedes LLM mal anbieten wird würde ich bezweifeln. Und wenn, dann wie bei Wolfram nur mit einer im Vergleich sehr geringen Trainingsdatenmenge.

Die Verbindung von ChatGPT mit Wolfram ist alles andere als trivial.

Vor allem bedeuten solche kuratierten Daten eine ziemlich große Gefahr. Momentan stehen wir an der Grenze zwischen schwarmintelligenz und Schwarmdummheit. Wie aber auch Opensource wird vom Schwarm eben erwartet, dass die Schiere Menge von Partizipanten die wahrscheinlichsten Ergebnisse auch die "richtigsten" sind. Doch da trügt er, der Schein.

Im Gegenzug ist man bei speziell ausgewählten Trainingsdaten eben der Willkür des Auswählenden abhängig.

Eine vernünftige Mischung scheint das beste zu sein. Aber dafür reichen IMHO die Ressourcen noch nicht aus. Die Basis von LLMs funktioniert ja schon lange. Zwar mehr schlecht als recht, aber sie taten das, was erwartet wurde. Erst mit der zunehmenden Rechenpower erzielte man urplötzlich auch "vernünftige" Ergebnisse.

Genauso wird es dann auch mit durch den Schwarm validierte "richtige" Trainingsdaten sein. Aber das wird erst dann im großen Stil aufkommen, nachdem die ersten da einen finanziellen Vorteil abgeschöpft haben.

Die freien LLMs sind ja nur eine Werbung für die nichtfreien LLMs der nächsten Iteration.