SOPHOS - XG(S) - SSD-Lebensdauer prüfen

Moin Zusammen,

dank der SSD’s sind nicht nur Clients oder Server, sondern auch die SGW’s diverser Hersteller etwas flinker geworden. 😁

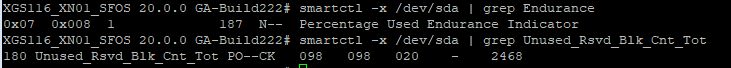

Leider hält so eine SSD ja bekanntlich nicht unendlich. Diese Tatsache hat aber Sophos und auch andere SGW-Hersteller glaube ich nicht so ganz auf ihrem Schirm, denn ich habe bisher noch nie bei einem SGW eine entsprechende Warnung gesehen, dass die eingebaute SSD bald den Geist aufgeben könnte. 😔

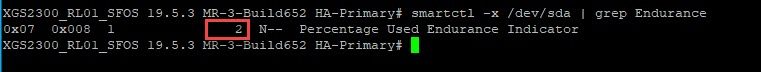

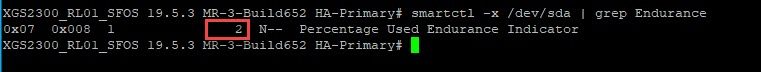

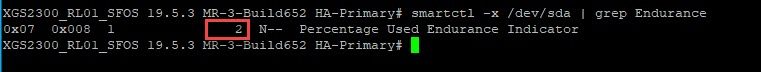

Dabei ist es nicht so, dass die Informationen der SSD nicht so einfach ausgelesen werden können, im Gegenteil, mit dem folgenden Einzeiler bekommt ihr ratz fatz bei einer Sophos XG/XGS …

… die Lebensdauer der eingebauten SSD zurück geliefert. 😉

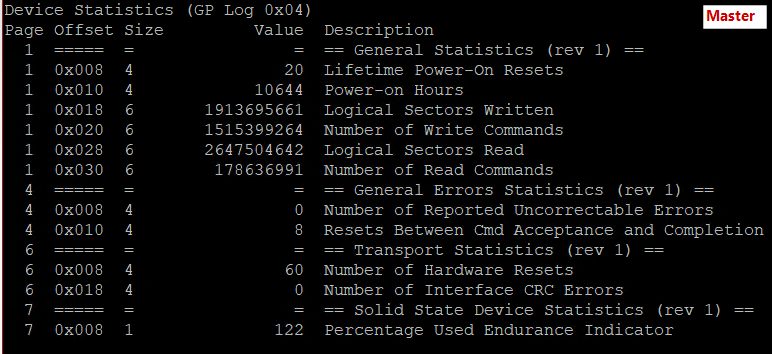

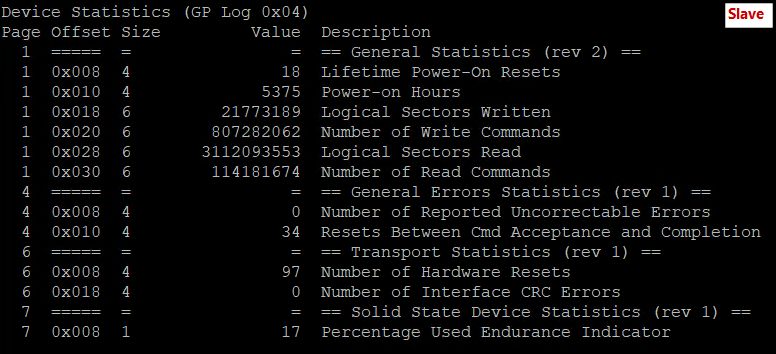

Die im oberen Beispiel gezeigte SSD ist z.B. aktuell nur zu 2% verbraucht.

Sollte hier jedoch ein Wert von > 80 erscheinen, kann ich nur empfehlen die entsprechende Appliance so schnell wie möglich austauschen zu lassen, da diese wie gesagt, ohne jegliche Vorwarnung in den nächsten Monaten von jetzt auf naher, eh den Geist aufgibt!

Und wenn man in einem solchen Fall kein HA Cluster hat, steht der Laden ratz fatz für ein paar Tage und man verliert zudem sämtliche Daten auf dem laufenden SGW wie z.B. Logs aber auch die Mails, die noch in der Quarantäne und oder der Mailqueue zwischenhängen. 😬

Das Letztere geschieht übrigens auch bei einem HA Cluster, da weder die Mailqueue noch die Quarantäne, zwischen den Nodes synchronisiert werden. 😭

Das zuletzt genannte ist übrigens nicht nur ein Problem bei Sophos, sondern ist z.B. bei Fortigates 1:1 genau dasselbe.

Es gibt übrigens eine ganz schnelle Variante, eine ausgefallene Sophos XG(S) wieder zum Leben zu erwecken, aber, solltet ihr das folgende ohne die Absprache mit dem Sophos Support machen, so erlischt die Garantie für die entsprechende Appliance!

Um eine durch SSD defekt ausgefallene Sophos XGS (Display leuchtet zwar aber zeigt nichts an) wieder zum Leben zu erwecken, muss man lediglich die in dem Gerät verbaute SSD gegen eine gleichwertige oder grössere tauschen und die Appliance mit USB Stick neu bespielen.

Aber, wie gesagt, ohne Absprache mit dem Hersteller, erlischt bei einem solchen Eingriff augenblicklich die Gerätegarantie!

So, ich hoffe nun, dass ihr beim Prüfen eurer Appliances, keinen allzu grossen Schock bekommt.

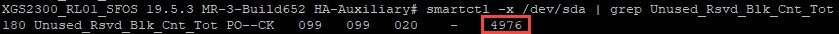

Und ja, auch ganz wichtig, bei einem HA-Cluster bitte die Lebensdauer der SSD auf alle Nodes und nicht nur dem aktiven prüfen. 😉

Gruss Alex

dank der SSD’s sind nicht nur Clients oder Server, sondern auch die SGW’s diverser Hersteller etwas flinker geworden. 😁

Leider hält so eine SSD ja bekanntlich nicht unendlich. Diese Tatsache hat aber Sophos und auch andere SGW-Hersteller glaube ich nicht so ganz auf ihrem Schirm, denn ich habe bisher noch nie bei einem SGW eine entsprechende Warnung gesehen, dass die eingebaute SSD bald den Geist aufgeben könnte. 😔

Dabei ist es nicht so, dass die Informationen der SSD nicht so einfach ausgelesen werden können, im Gegenteil, mit dem folgenden Einzeiler bekommt ihr ratz fatz bei einer Sophos XG/XGS …

smartctl -x /dev/sda | grep Endurance… die Lebensdauer der eingebauten SSD zurück geliefert. 😉

Die im oberen Beispiel gezeigte SSD ist z.B. aktuell nur zu 2% verbraucht.

Sollte hier jedoch ein Wert von > 80 erscheinen, kann ich nur empfehlen die entsprechende Appliance so schnell wie möglich austauschen zu lassen, da diese wie gesagt, ohne jegliche Vorwarnung in den nächsten Monaten von jetzt auf naher, eh den Geist aufgibt!

Und wenn man in einem solchen Fall kein HA Cluster hat, steht der Laden ratz fatz für ein paar Tage und man verliert zudem sämtliche Daten auf dem laufenden SGW wie z.B. Logs aber auch die Mails, die noch in der Quarantäne und oder der Mailqueue zwischenhängen. 😬

Das Letztere geschieht übrigens auch bei einem HA Cluster, da weder die Mailqueue noch die Quarantäne, zwischen den Nodes synchronisiert werden. 😭

Das zuletzt genannte ist übrigens nicht nur ein Problem bei Sophos, sondern ist z.B. bei Fortigates 1:1 genau dasselbe.

Es gibt übrigens eine ganz schnelle Variante, eine ausgefallene Sophos XG(S) wieder zum Leben zu erwecken, aber, solltet ihr das folgende ohne die Absprache mit dem Sophos Support machen, so erlischt die Garantie für die entsprechende Appliance!

Um eine durch SSD defekt ausgefallene Sophos XGS (Display leuchtet zwar aber zeigt nichts an) wieder zum Leben zu erwecken, muss man lediglich die in dem Gerät verbaute SSD gegen eine gleichwertige oder grössere tauschen und die Appliance mit USB Stick neu bespielen.

Aber, wie gesagt, ohne Absprache mit dem Hersteller, erlischt bei einem solchen Eingriff augenblicklich die Gerätegarantie!

So, ich hoffe nun, dass ihr beim Prüfen eurer Appliances, keinen allzu grossen Schock bekommt.

Und ja, auch ganz wichtig, bei einem HA-Cluster bitte die Lebensdauer der SSD auf alle Nodes und nicht nur dem aktiven prüfen. 😉

Gruss Alex

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 73763751381

Url: https://administrator.de/tutorial/sophos-xgs-ssd-lebensdauer-pruefen-73763751381.html

Ausgedruckt am: 16.07.2025 um 10:07 Uhr

47 Kommentare

Neuester Kommentar

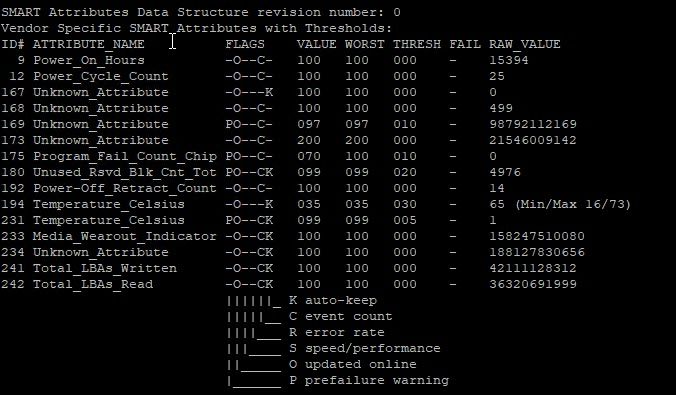

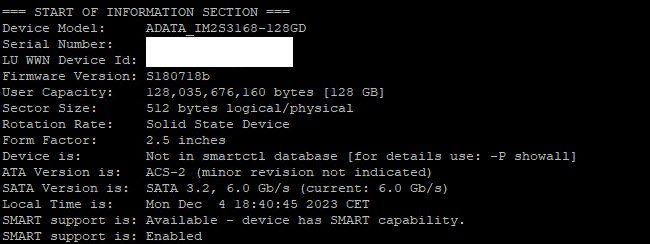

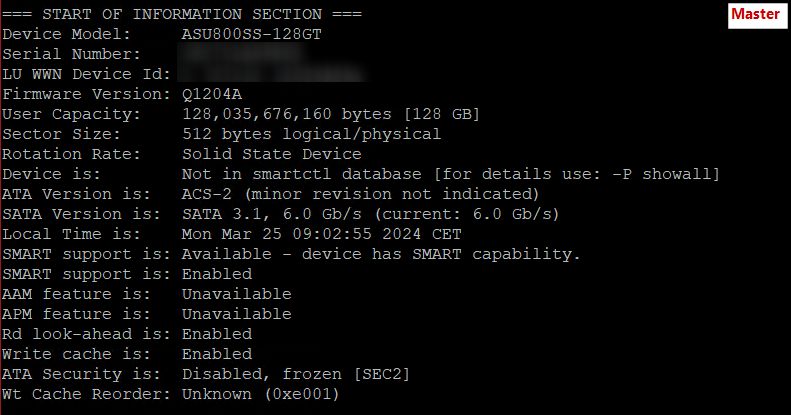

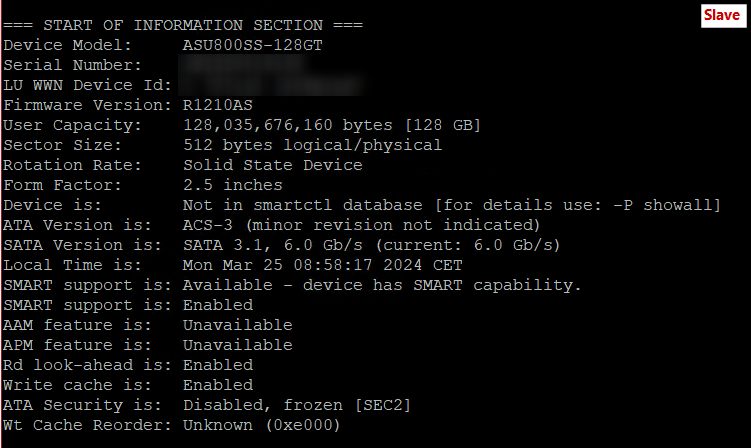

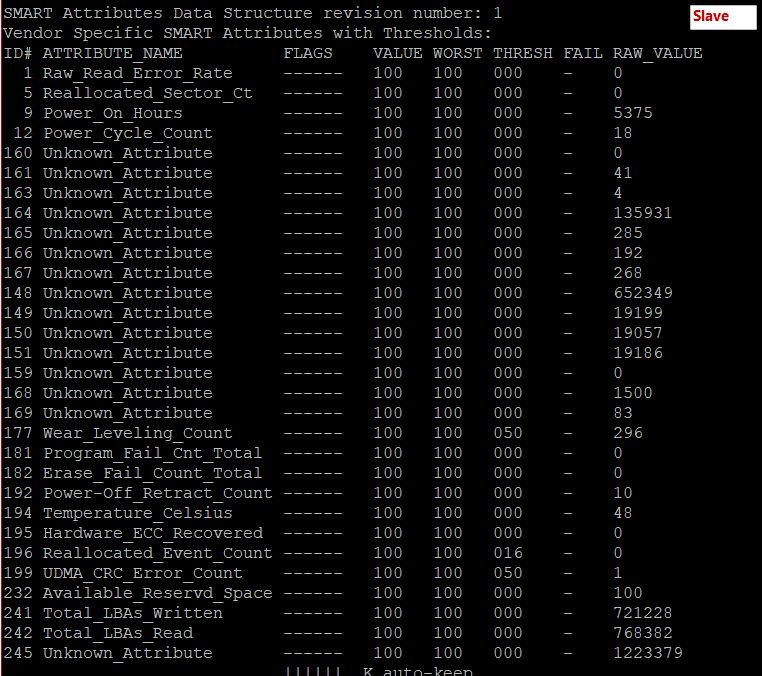

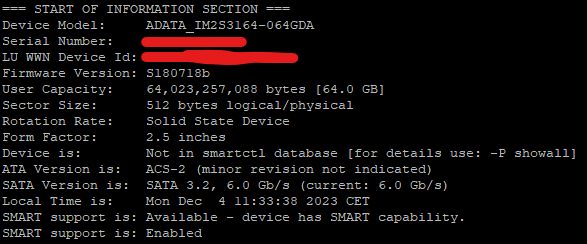

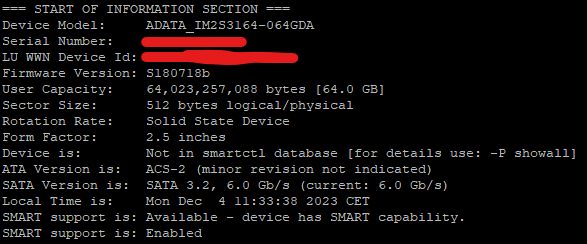

In meinem Fall hat die M.2 SSD den Wert 178 (maximal möglich 255). Die XGS ist zwei Jahre alt und die verbaute ADATA IM23164 SSD hat bereits 17 TBW erreicht laut SMART Attribut #241. Jedoch glaube ich den Werten nicht, da ich auch das hier sehen kann...

Aufgrund fehlender smartctl DB-Einträge und fehlerhafter Angabe, dass es eine 2.5" SSD sein soll, können die Werte auch falsch interpretiert worden sein.

@MysticFoxDE wie alt ist eure XGS2300, wieviel TBW und was für eine SSD ist drin?

Aufgrund fehlender smartctl DB-Einträge und fehlerhafter Angabe, dass es eine 2.5" SSD sein soll, können die Werte auch falsch interpretiert worden sein.

@MysticFoxDE wie alt ist eure XGS2300, wieviel TBW und was für eine SSD ist drin?

@DerMaddin

@MysticFoxDE

Das heißt wenn ich über den Befehl (smartctl -x /dev/sda | grep Endurance) ein Wert von 67 auslese, das es dann doch nicht so schlimm ist? Da der maximal Wert bei 255 liegt?

@MysticFoxDE

Das heißt wenn ich über den Befehl (smartctl -x /dev/sda | grep Endurance) ein Wert von 67 auslese, das es dann doch nicht so schlimm ist? Da der maximal Wert bei 255 liegt?

So zumindest in der Theorie. Das alles sind statistische Werte die mathematisch errechnet werden. Habe dazu einen interessanten Artikel gefunden:

ni.com/de/support/documentation/supplemental/12/understanding-li ...

Leider finde ich keine TBW-Angaben zu meiner SSD in der XGS, ADATA schreibt nur MTBF, was nun nicht sehr aussagekräftig ist. Laut den Rechenbeispielen im Artikel, komme ich aber auch ca. 26 TBW, was auch den 178 Wert halbwegs erklären könnte. Ist aber alles wirklich nur Statistik.

ni.com/de/support/documentation/supplemental/12/understanding-li ...

Leider finde ich keine TBW-Angaben zu meiner SSD in der XGS, ADATA schreibt nur MTBF, was nun nicht sehr aussagekräftig ist. Laut den Rechenbeispielen im Artikel, komme ich aber auch ca. 26 TBW, was auch den 178 Wert halbwegs erklären könnte. Ist aber alles wirklich nur Statistik.

@MysticFoxDE

smartctl 6.3 2015-02-08 r4039 [x86_64-linux-3.12.74-0.434058663.g1ba2494.rb7-smp 64] (SUSE RPM)

Copyright (C) 2002-14, Bruce Allen, Christian Franke, www.smartmontools.org

=== START OF INFORMATION SECTION ===

Model Family: Intel 530 Series SSDs

Device Model: INTEL SSDSC2BW120A4

Firmware Version: DC32

User Capacity: 120,034,123,776 bytes [120 GB]

Sector Size: 512 bytes logical/physical

Rotation Rate: Solid State Device

Device is: In smartctl database [for details use: -P show]

ATA Version is: ACS-2 (minor revision not indicated)

SATA Version is: SATA 3.0, 6.0 Gb/s (current: 6.0 Gb/s)

Local Time is: Wed Dec 6 10:16:39 2023 CET

SMART support is: Available - device has SMART capability.

SMART support is: Enabled

AAM feature is: Unavailable

APM level is: 254 (maximum performance)

Rd look-ahead is: Enabled

Write cache is: Enabled

ATA Security is: Disabled, frozen [SEC2]

Wt Cache Reorder: Unavailable

=== START OF READ SMART DATA SECTION ===

SMART overall-health self-assessment test result: FAILED!

Drive failure expected in less than 24 hours. SAVE ALL DATA.

See vendor-specific Attribute list for failed Attributes.

General SMART Values:

Offline data collection status: (0x05) Offline data collection activity

was aborted by an interrupting command f rom host.

Auto Offline Data Collection: Disabled.

Self-test execution status: ( 33) The self-test routine was interrupted

by the host with a hard or soft reset.

Total time to complete Offline

data collection: ( 2930) seconds.

Offline data collection

capabilities: (0x7f) SMART execute Offline immediate.

Auto Offline data collection on/off supp ort.

Abort Offline collection upon new

command.

Offline surface scan supported.

Self-test supported.

Conveyance Self-test supported.

Selective Self-test supported.

SMART capabilities: (0x0003) Saves SMART data before entering

power-saving mode.

Supports SMART auto save timer.

Error logging capability: (0x01) Error logging supported.

General Purpose Logging supported.

Short self-test routine

recommended polling time: ( 1) minutes.

Extended self-test routine

recommended polling time: ( 48) minutes.

Conveyance self-test routine

recommended polling time: ( 2) minutes.

SCT capabilities: (0x0025) SCT Status supported.

SCT Data Table supported.

SMART Attributes Data Structure revision number: 10

Vendor Specific SMART Attributes with Thresholds:

ID# ATTRIBUTE_NAME FLAGS VALUE WORST THRESH FAIL RAW_VALUE

5 Reallocated_Sector_Ct -O--CK 100 100 000 - 0

9 Power_On_Hours_and_Msec -O--CK 100 100 000 - 14184h+08m+32.060s

12 Power_Cycle_Count -O--CK 100 100 000 - 25

170 Available_Reservd_Space PO--CK 001 001 010 NOW 0

171 Program_Fail_Count -O--CK 100 100 000 - 0

172 Erase_Fail_Count -O--CK 100 100 000 - 0

174 Unexpect_Power_Loss_Ct -O--CK 100 100 000 - 14

183 SATA_Downshift_Count -O--CK 100 100 000 - 8

184 End-to-End_Error PO--CK 100 100 090 - 0

187 Uncorrectable_Error_Cnt -O--CK 100 100 000 - 0

190 Airflow_Temperature_Cel -O--CK 026 049 000 - 26 (Min/Max 19/49)

192 Power-Off_Retract_Count -O--CK 100 100 000 - 14

199 UDMA_CRC_Error_Count -O--CK 100 100 000 - 0

225 Host_Writes_32MiB -O--CK 100 100 000 - 2523546

226 Workld_Media_Wear_Indic -O--CK 100 100 000 - 65535

227 Workld_Host_Reads_Perc -O--CK 100 100 000 - 31

228 Workload_Minutes -O--CK 100 100 000 - 65535

232 Available_Reservd_Space PO--CK 001 001 010 NOW 0

233 Media_Wearout_Indicator -O--CK 030 030 000 - 0

241 Host_Writes_32MiB -O--CK 100 100 000 - 2523546

242 Host_Reads_32MiB -O--CK 100 100 000 - 1172920

249 NAND_Writes_1GiB -O--CK 100 100 000 - 297087

||||||_ K auto-keep

|||||__ C event count

||||___ R error rate

|||____ S speed/performance

||_____ O updated online

|______ P prefailure warning

General Purpose Log Directory Version 1

SMART Log Directory Version 1 [multi-sector log support]

Address Access R/W Size Description

0x00 GPL,SL R/O 1 Log Directory

0x04 GPL,SL R/O 1 Device Statistics log

0x06 SL R/O 1 SMART self-test log

0x07 GPL R/O 1 Extended self-test log

0x09 SL R/W 1 Selective self-test log

0x10 GPL R/O 1 NCQ Command Error log

0x11 GPL,SL R/O 1 SATA Phy Event Counters

0x30 GPL,SL R/O 16 IDENTIFY DEVICE data log

0x80-0x9f GPL,SL R/W 16 Host vendor specific log

0xb7 GPL,SL VS 16 Device vendor specific log

0xe0 GPL,SL R/W 1 SCT Command/Status

0xe1 GPL,SL R/W 1 SCT Data Transfer

SMART Extended Comprehensive Error Log (GP Log 0x03) not supported

SMART Error Log not supported

SMART Extended Self-test Log Version: 0 (1 sectors)

Num Test_Description Status Remaining LifeTime(hours) LBA _of_first_error

# 1 Offline Interrupted (host reset) 10% 12860 -

# 2 Offline Interrupted (host reset) 10% 10771 -

# 3 Offline Interrupted (host reset) 10% 10771 -

# 4 Offline Interrupted (host reset) 10% 10771 -

# 5 Offline Interrupted (host reset) 10% 10554 -

# 6 Offline Interrupted (host reset) 10% 10543 -

# 7 Offline Interrupted (host reset) 10% 10267 -

# 8 Offline Interrupted (host reset) 10% 9713 -

# 9 Offline Interrupted (host reset) 10% 7625 -

#10 Offline Interrupted (host reset) 10% 7625 -

#11 Offline Interrupted (host reset) 10% 7625 -

#12 Offline Interrupted (host reset) 10% 4075 -

#13 Offline Interrupted (host reset) 10% 3909 -

#14 Offline Interrupted (host reset) 10% 1565 -

#15 Offline Interrupted (host reset) 10% 1338 -

#16 Offline Interrupted (host reset) 10% 110 -

#17 Offline Interrupted (host reset) 10% 31 -

#18 Offline Interrupted (host reset) 10% 31 -

#19 Offline Interrupted (host reset) 10% 24 -

SMART Selective self-test log data structure revision number 0

Note: revision number not 1 implies that no selective self-test has ever been ru n

SPAN MIN_LBA MAX_LBA CURRENT_TEST_STATUS

1 0 0 Not_testing

2 0 0 Not_testing

3 0 0 Not_testing

4 0 0 Not_testing

5 0 0 Not_testing

Selective self-test flags (0x0):

After scanning selected spans, do NOT read-scan remainder of disk.

If Selective self-test is pending on power-up, resume after 0 minute delay.

SCT Status Version: 3

SCT Version (vendor specific): 0 (0x0000)

SCT Support Level: 1

Device State: Active (0)

Current Temperature: 26 Celsius

Power Cycle Min/Max Temperature: 19/49 Celsius

Lifetime Min/Max Temperature: 19/72 Celsius

Under/Over Temperature Limit Count: 0/0

SCT Temperature History Version: 0 (Unknown, should be 2)

Temperature Sampling Period: 1 minute

Temperature Logging Interval: 10 minutes

Min/Max recommended Temperature: 0/ 0 Celsius

Min/Max Temperature Limit: 0/ 0 Celsius

Temperature History Size (Index): 0 (413)

Temperature History is empty

SCT Error Recovery Control command not supported

Device Statistics (GP Log 0x04)

Page Offset Size Value Description

1 ===== = = == General Statistics (rev 2) ==

1 0x008 4 31 Lifetime Power-On Resets

1 0x010 4 14186 Power-on Hours

1 0x018 6 165401514110 Logical Sectors Written

1 0x028 6 76885315478 Logical Sectors Read

4 ===== = = == General Errors Statistics (rev 1) ==

4 0x008 4 0 Number of Reported Uncorrectable Errors

4 0x010 4 450 Resets Between Cmd Acceptance and Completion

5 ===== = = == Temperature Statistics (rev 1) ==

5 0x008 1 26 Current Temperature

5 0x010 1 25 Average Short Term Temperature

5 0x018 1 26 Average Long Term Temperature

5 0x020 1 49 Highest Temperature

5 0x028 1 25 Lowest Temperature

5 0x030 1 45 Highest Average Short Term Temperature

5 0x038 1 25 Lowest Average Short Term Temperature

5 0x040 1 28 Highest Average Long Term Temperature

5 0x048 1 25 Lowest Average Long Term Temperature

5 0x050 4 0 Time in Over-Temperature

5 0x058 1 70 Specified Maximum Operating Temperature

5 0x060 4 0 Time in Under-Temperature

5 0x068 1 0 Specified Minimum Operating Temperature

6 ===== = = == Transport Statistics (rev 1) ==

6 0x008 4 450 Number of Hardware Resets

6 0x010 4 15 Number of ASR Events

6 0x018 4 0 Number of Interface CRC Errors

7 ===== = = == Solid State Device Statistics (rev 1) ==

7 0x008 1 61 Percentage Used Endurance Indicator

SATA Phy Event Counters (GP Log 0x11)

ID Size Value Description

0x0001 2 0 Command failed due to ICRC error

0x0003 2 0 R_ERR response for device-to-host data FIS

0x0004 2 0 R_ERR response for host-to-device data FIS

0x0006 2 0 R_ERR response for device-to-host non-data FIS

0x0007 2 0 R_ERR response for host-to-device non-data FIS

0x0008 2 0 Device-to-host non-data FIS retries

0x0009 2 1 Transition from drive PhyRdy to drive PhyNRdy

0x000a 2 17 Device-to-host register FISes sent due to a COMRESET

0x000f 2 0 R_ERR response for host-to-device data FIS, CRC

0x0010 2 0 R_ERR response for host-to-device data FIS, non-CRC

0x0012 2 0 R_ERR response for host-to-device non-data FIS, CRC

0x0013 2 0 R_ERR response for host-to-device non-data FIS, non-CRC

0x0002 2 0 R_ERR response for data FIS

0x0005 2 0 R_ERR response for non-data FIS

0x000b 2 0 CRC errors within host-to-device FIS

0x000d 2 0 Non-CRC errors within host-to-device FIS

Moin Alex,

wir haben ein HA-Cluster läuft seit 7 Jahren, ohne Probleme.

Spätestens in zwei Jahren hat sich mit Sophos SG ja eh erlegt. Ich habe aber schon Kontakt aufgenommen das wir noch Backup Geräte bekommen, also die gleichen Modelle falls eines direkt mal abschmiert.

Du Schreibst das Du das schon erlebt hast, waren das auch SG Geräte mit Intel SSD, oder andere?

wir haben ein HA-Cluster läuft seit 7 Jahren, ohne Probleme.

Spätestens in zwei Jahren hat sich mit Sophos SG ja eh erlegt. Ich habe aber schon Kontakt aufgenommen das wir noch Backup Geräte bekommen, also die gleichen Modelle falls eines direkt mal abschmiert.

Du Schreibst das Du das schon erlebt hast, waren das auch SG Geräte mit Intel SSD, oder andere?

Ausgehend von dem Beitrag ist es möglich, allerdings bei XG(S), aber wenn es da geht warum sollte es bei SG nicht gehen.

@DerMaddin

Gut dann wäre ja hier die einfachste Methode einfach die SSD zu spiegeln und eine neue einzubauen.

Muss es außerdem eine identische Festplatte sein, also gleiches Modell mit gleicher Größe, oder ist das egal?

Nicht das da irgend eine Software oder Mechanismus das noch überprüft?!

Im Moment ist ja die Intel 120GB SSD drin, die würde ich dann gegen eine Samsung EVO 870 ersetzen.

Gut dann wäre ja hier die einfachste Methode einfach die SSD zu spiegeln und eine neue einzubauen.

Muss es außerdem eine identische Festplatte sein, also gleiches Modell mit gleicher Größe, oder ist das egal?

Nicht das da irgend eine Software oder Mechanismus das noch überprüft?!

Im Moment ist ja die Intel 120GB SSD drin, die würde ich dann gegen eine Samsung EVO 870 ersetzen.

@MysticFoxDE

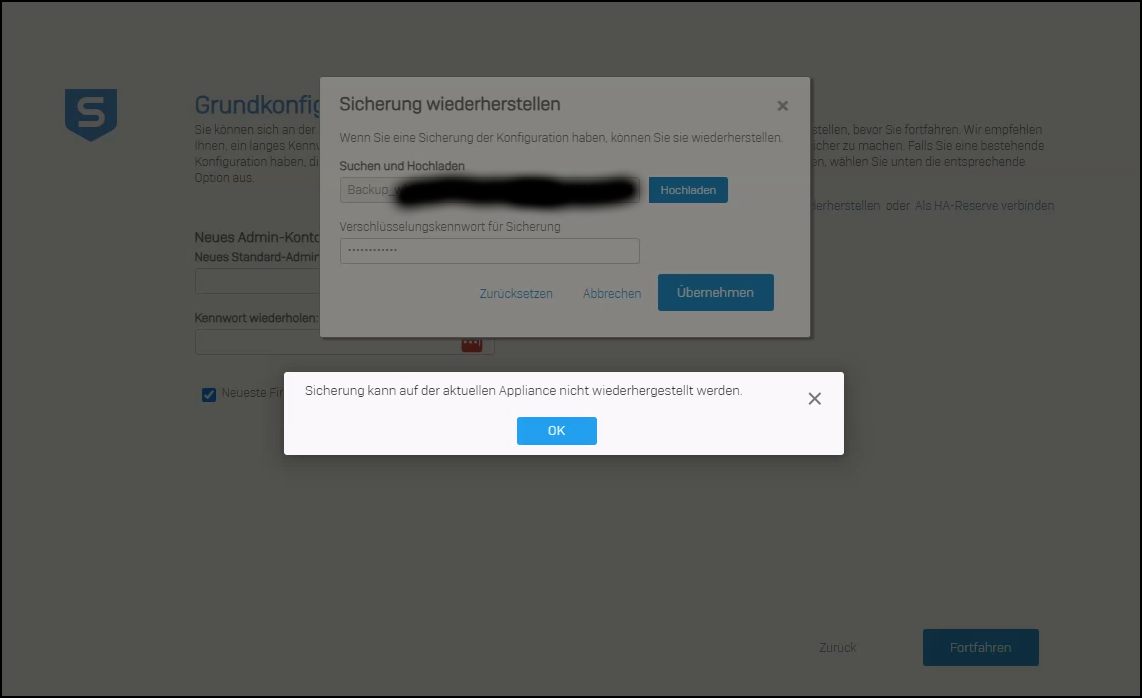

Schlechte Neuigkeiten...

Das SSD klonen ist komplett gescheitert.

Ich habe zwei mal die Original Intel SSD gespiegelt, einmal mit Acronis und einmal mit Clonezilla.

Beide haben mir gesagt das das spiegeln erfolgreich war und beide Festplatten booten nicht korrekt!

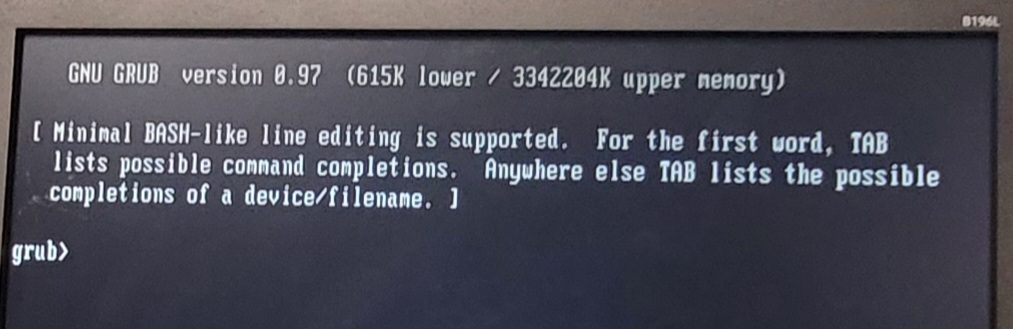

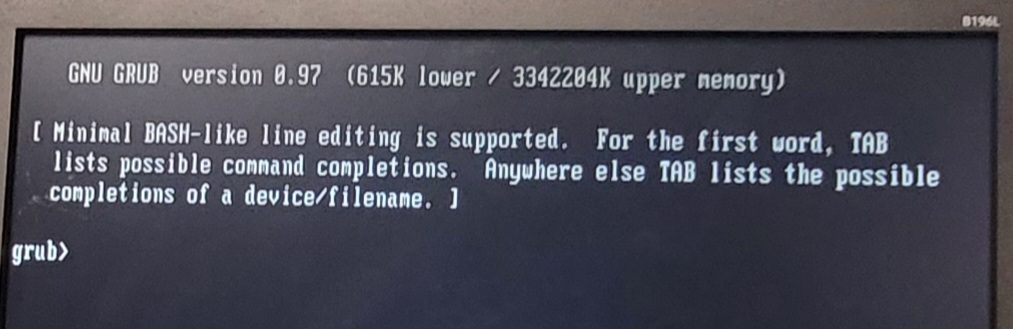

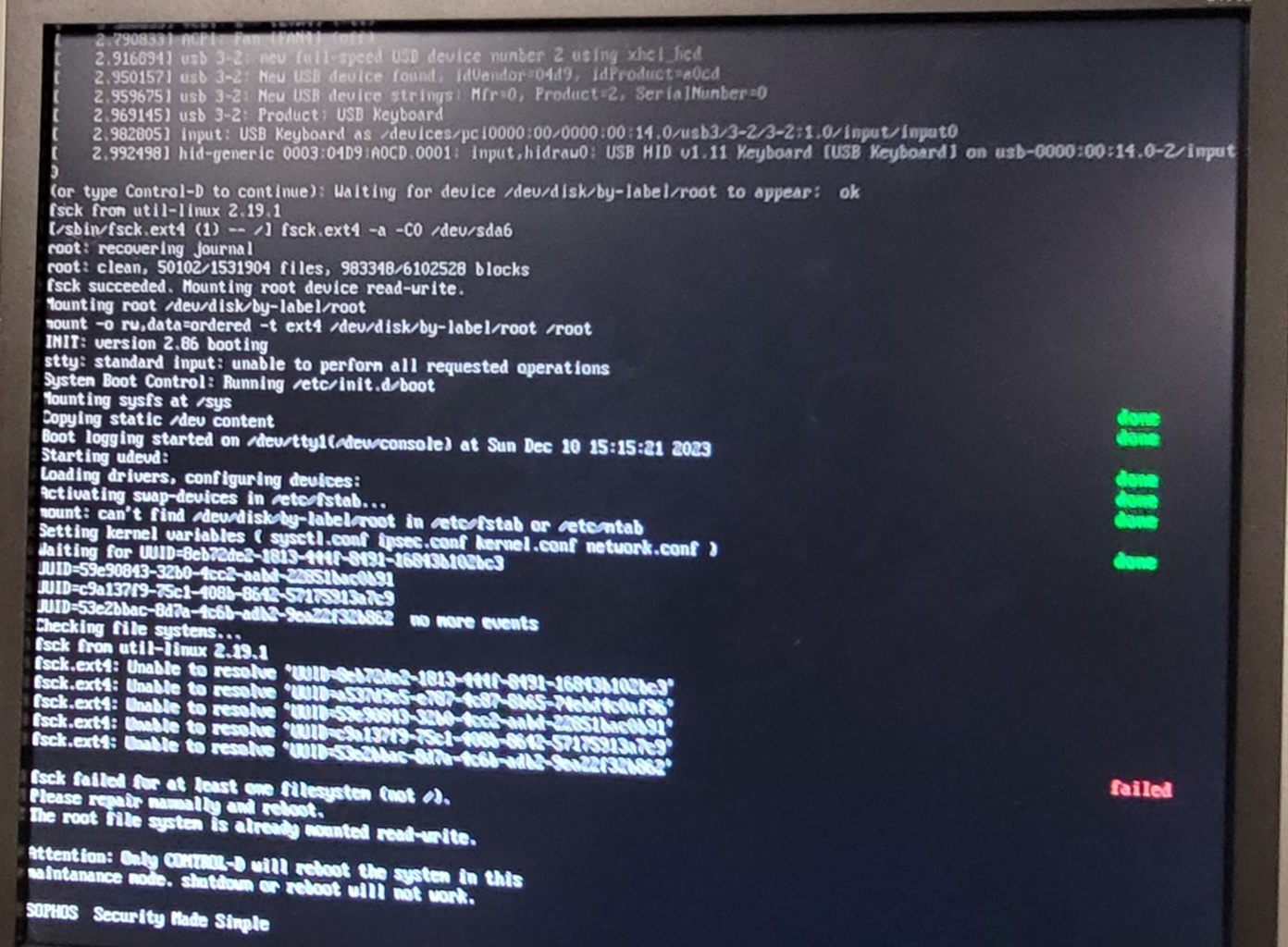

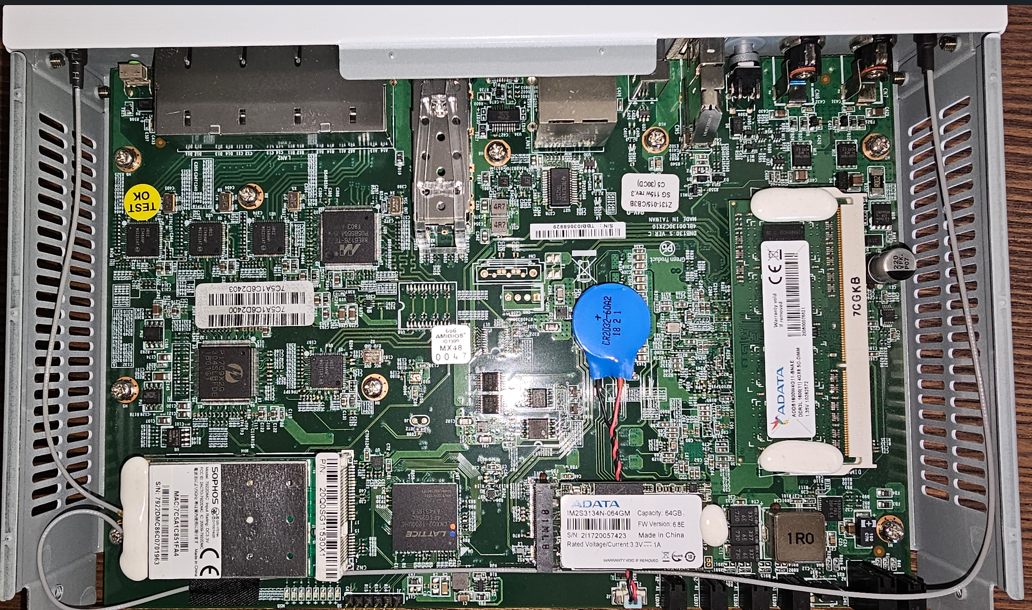

Dazu kommt noch das die Original Platte nicht mehr bootet, wenn ich diese Einbaue kommt diese Meldung:

Wenn ich die gespiegelte Samsung Platte nehme und einbauen kommt die gleiche Meldung (beides wurde über Clonezilla gespiegelt)

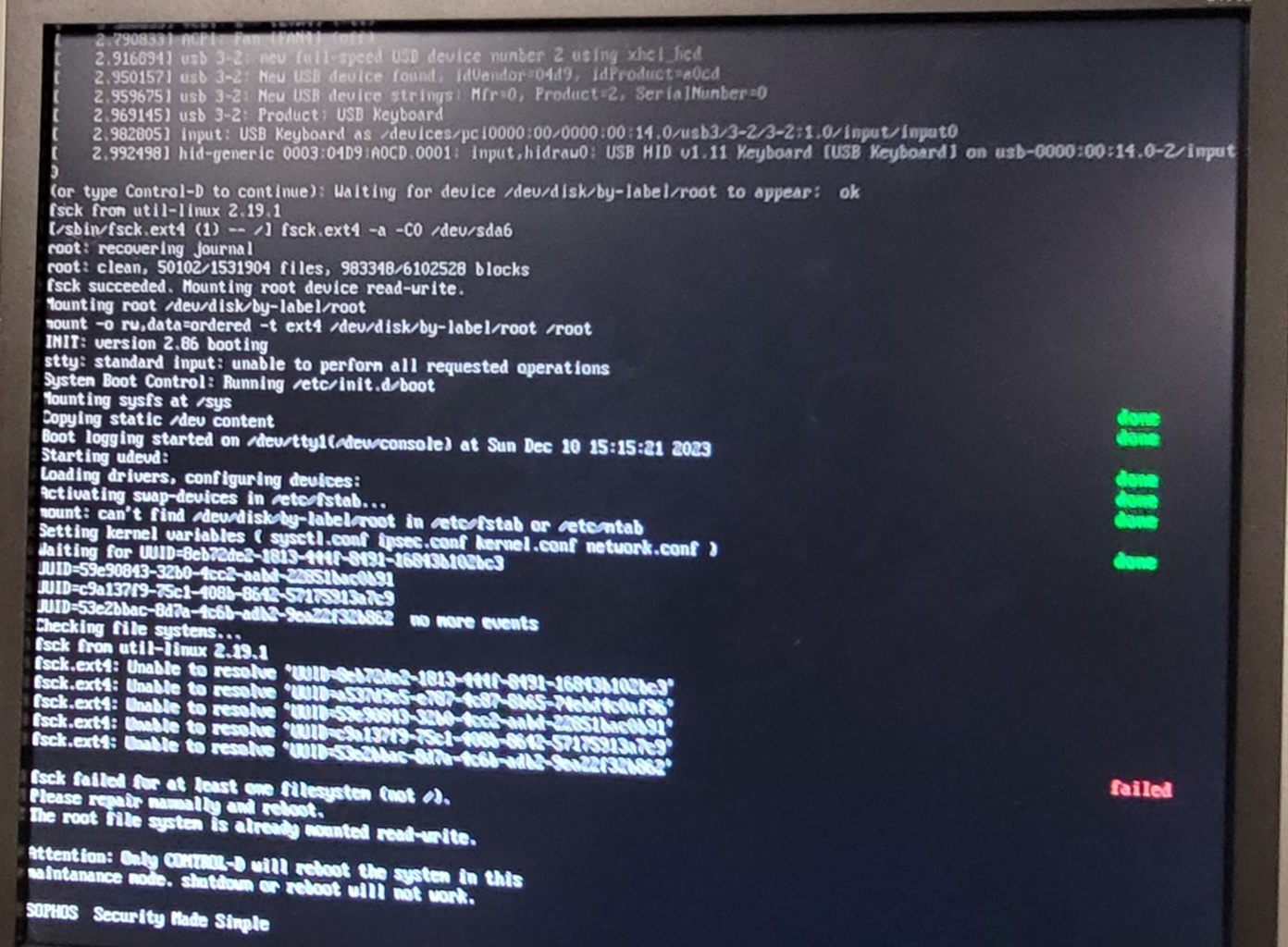

Die Platte die mit Acronis, per GPT geklont wurde kommt schon weiter aber da gibt es die Meldung:

Beide Varianten laden nicht das Sophos UTM System, die Firewall bleibt Offline.

Also einfach Klonen und einbauen ist hier nicht... hätte mir den Sonntag auch anders vorgestellt.

Schlechte Neuigkeiten...

Das SSD klonen ist komplett gescheitert.

Ich habe zwei mal die Original Intel SSD gespiegelt, einmal mit Acronis und einmal mit Clonezilla.

Beide haben mir gesagt das das spiegeln erfolgreich war und beide Festplatten booten nicht korrekt!

Dazu kommt noch das die Original Platte nicht mehr bootet, wenn ich diese Einbaue kommt diese Meldung:

Wenn ich die gespiegelte Samsung Platte nehme und einbauen kommt die gleiche Meldung (beides wurde über Clonezilla gespiegelt)

Die Platte die mit Acronis, per GPT geklont wurde kommt schon weiter aber da gibt es die Meldung:

Beide Varianten laden nicht das Sophos UTM System, die Firewall bleibt Offline.

Also einfach Klonen und einbauen ist hier nicht... hätte mir den Sonntag auch anders vorgestellt.

Hi Alex,

Ich habe in meinem Leben gefühlte 1000 Backups gemacht, egal ob mit Acronis oder Clonezilla.

Das dabei die Originalplatte nicht mehr richtig bootet habe ich noch nie erlebt.

Blöd nur, dass es jetzt bei einer so wichtigen Festplatte wie der Firewall nicht funktioniert.

Wir haben einen HA-Cluster, die andere Firewall läuft jetzt primär. Am Montag werde ich versuchen die UTM per Stick zurückzusetzen und neu zu installieren, Backup einspielen und gut ist... Mehr Überraschungen kann ich im Moment nicht gebrauchen.

Ich habe in meinem Leben gefühlte 1000 Backups gemacht, egal ob mit Acronis oder Clonezilla.

Das dabei die Originalplatte nicht mehr richtig bootet habe ich noch nie erlebt.

Blöd nur, dass es jetzt bei einer so wichtigen Festplatte wie der Firewall nicht funktioniert.

Wir haben einen HA-Cluster, die andere Firewall läuft jetzt primär. Am Montag werde ich versuchen die UTM per Stick zurückzusetzen und neu zu installieren, Backup einspielen und gut ist... Mehr Überraschungen kann ich im Moment nicht gebrauchen.

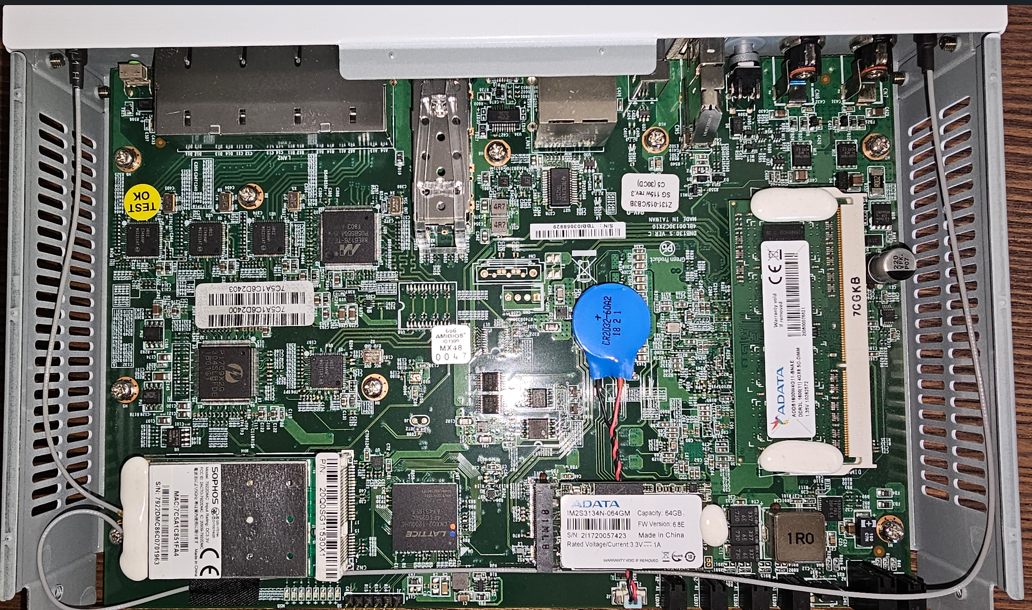

Ich habe mal aus Interesse eine alte SG115w aufgeschraubt und war in doppelter Hinsicht erstaunt. Einerseits sehe ich, dass RAM, Wifi-Modul und M.2 SSD mit Lack "gesichert" sind. Scheinbar eine Maßnahme, um sich bei Garantieansprüchen versichern zu können, dass der Kunde nichts verändert hat, andererseits ist bereits eine der vier Schrauben mit Sicherungslack und mit einem "Warranty Void" Aufkleber versehen.

Dann aber sehe ich auch eine ADATA SSD IM2S3134N-064G und was laut den Specs zu Tage kommt, erstaunt mich sehr. MLC und kein TLC Flash-Typ. Also wesentlich langlebiger. Scheint so als wäre das geplante Obsoleszenz.

Wollte unsere XGS nicht aufschrauben, da noch in Garantie und Support aber weiß jemand, ob bei den XGS auch so mit Lack "gesichert" ist?

Dann aber sehe ich auch eine ADATA SSD IM2S3134N-064G und was laut den Specs zu Tage kommt, erstaunt mich sehr. MLC und kein TLC Flash-Typ. Also wesentlich langlebiger. Scheint so als wäre das geplante Obsoleszenz.

Wollte unsere XGS nicht aufschrauben, da noch in Garantie und Support aber weiß jemand, ob bei den XGS auch so mit Lack "gesichert" ist?

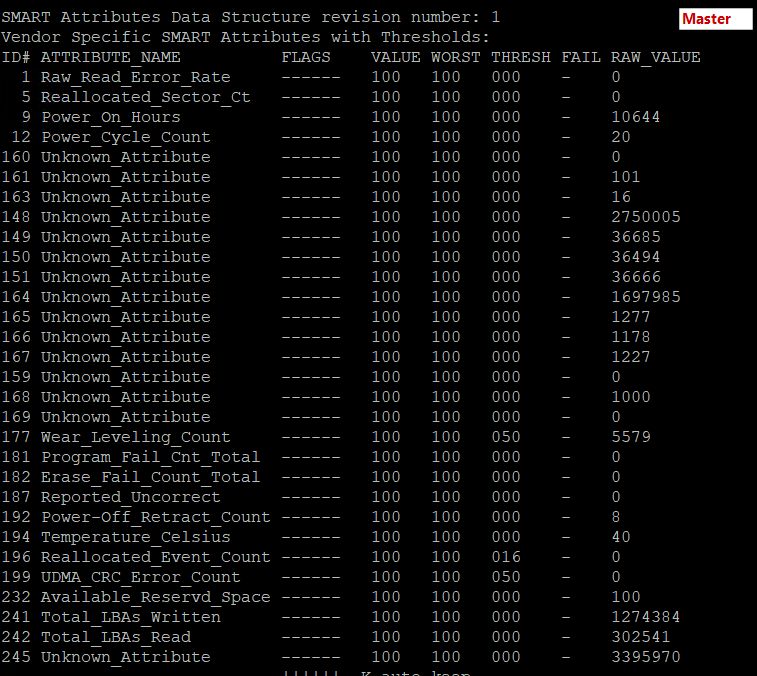

XGS126_XN01_SFOS 20.0.0 GA-Build222# smartctl -x /dev/sda | grep Endurance

0x07 0x008 1 98 N-- Percentage Used Endurance IndicatorVolltreffer 98%.. wow!

smartctl -x /dev/sda | grep Unused_Rsvd_Blk_Cnt_Tot

180 Unused_Rsvd_Blk_Cnt_Tot PO--CK 100 100 020 - 2490Danke (mal wieder) Alex!

Könnte mich jemand mit einem Link auf die richtige Sophos UTM Software für meine einzelne XGS126 versorgen?

Logo! Here we go..

XGS126_XN01_SFOS 20.0.0 GA-Build222# smartctl -x /dev/sda

smartctl 7.1 2019-12-30 r5022 [x86_64-linux-4.14.302] (localbuild)

Copyright (C) 2002-19, Bruce Allen, Christian Franke, www.smartmontools.org

=== START OF INFORMATION SECTION ===

Device Model: ADATA_IM2S3164-064GDA

Serial Number:

LU WWN Device Id:

Firmware Version: S180718z

User Capacity: 64,023,257,088 bytes [64.0 GB]

Sector Size: 512 bytes logical/physical

Rotation Rate: Solid State Device

Form Factor: 2.5 inches

Device is: Not in smartctl database [for details use: -P showall]

ATA Version is: ACS-2 (minor revision not indicated)

SATA Version is: SATA 3.2, 6.0 Gb/s (current: 6.0 Gb/s)

Local Time is: Tue Mar 19 15:35:06 2024 CET

SMART support is: Available - device has SMART capability.

SMART support is: Enabled

AAM feature is: Unavailable

APM feature is: Unavailable

Rd look-ahead is: Enabled

Write cache is: Enabled

DSN feature is: Unavailable

ATA Security is: Disabled, NOT FROZEN [SEC1]

Wt Cache Reorder: Enabled

=== START OF READ SMART DATA SECTION ===

SMART overall-health self-assessment test result: PASSED

General SMART Values:

Offline data collection status: (0x02) Offline data collection activity

was completed without error.

Auto Offline Data Collection: Disabled.

Self-test execution status: ( 0) The previous self-test routine completed

without error or no self-test has ever

been run.

Total time to complete Offline

data collection: ( 33) seconds.

Offline data collection

capabilities: (0x7b) SMART execute Offline immediate.

Auto Offline data collection on/off support.

Suspend Offline collection upon new

command.

Offline surface scan supported.

Self-test supported.

Conveyance Self-test supported.

Selective Self-test supported.

SMART capabilities: (0x0003) Saves SMART data before entering

power-saving mode.

Supports SMART auto save timer.

Error logging capability: (0x01) Error logging supported.

General Purpose Logging supported.

Short self-test routine

recommended polling time: ( 2) minutes.

Extended self-test routine

recommended polling time: ( 2) minutes.

Conveyance self-test routine

recommended polling time: ( 2) minutes.

SCT capabilities: (0x0039) SCT Status supported.

SCT Error Recovery Control supported.

SCT Feature Control supported.

SCT Data Table supported.

SMART Attributes Data Structure revision number: 0

Vendor Specific SMART Attributes with Thresholds:

ID# ATTRIBUTE_NAME FLAGS VALUE WORST THRESH FAIL RAW_VALUE

9 Power_On_Hours -O--C- 100 100 000 - 19157

12 Power_Cycle_Count -O--C- 100 100 000 - 14

167 Unknown_Attribute -O---K 100 100 000 - 0

168 Unknown_Attribute -O--C- 100 100 000 - 0

169 Unknown_Attribute PO--C- 097 097 010 - 3932190

173 Unknown_Attribute -O--C- 200 200 000 - 631424680624

175 Program_Fail_Count_Chip PO--C- 100 100 010 - 0

180 Unused_Rsvd_Blk_Cnt_Tot PO--CK 100 100 020 - 2490

192 Power-Off_Retract_Count -O--C- 100 100 000 - 9

194 Temperature_Celsius -O---K 046 046 030 - 54 (Min/Max 20/65)

231 Temperature_Celsius PO--CK 066 066 005 - 34

233 Media_Wearout_Indicator -O--CK 100 100 000 - 99112924928

234 Unknown_Attribute -O--CK 100 100 000 - 143592546240

241 Total_LBAs_Written -O--CK 100 100 000 - 31827019211

242 Total_LBAs_Read -O--CK 100 100 000 - 7573113070

||||||_ K auto-keep

|||||__ C event count

||||___ R error rate

|||____ S speed/performance

||_____ O updated online

|______ P prefailure warning

General Purpose Log Directory Version 1

SMART Log Directory Version 1 [multi-sector log support]

Address Access R/W Size Description

0x00 GPL,SL R/O 1 Log Directory

0x01 SL R/O 1 Summary SMART error log

0x02 SL R/O 51 Comprehensive SMART error log

0x03 GPL R/O 64 Ext. Comprehensive SMART error log

0x04 GPL,SL R/O 8 Device Statistics log

0x06 SL R/O 1 SMART self-test log

0x07 GPL R/O 1 Extended self-test log

0x09 SL R/W 1 Selective self-test log

0x10 GPL R/O 1 NCQ Command Error log

0x11 GPL R/O 1 SATA Phy Event Counters log

0x30 GPL,SL R/O 9 IDENTIFY DEVICE data log

0x80-0x9f GPL,SL R/W 16 Host vendor specific log

0xe0 GPL,SL R/W 1 SCT Command/Status

0xe1 GPL,SL R/W 1 SCT Data Transfer

SMART Extended Comprehensive Error Log Version: 1 (64 sectors)

No Errors Logged

SMART Extended Self-test Log Version: 1 (1 sectors)

No self-tests have been logged. [To run self-tests, use: smartctl -t]

SMART Selective self-test log data structure revision number 1

SPAN MIN_LBA MAX_LBA CURRENT_TEST_STATUS

1 0 0 Not_testing

2 0 0 Not_testing

3 0 0 Not_testing

4 0 0 Not_testing

5 0 0 Not_testing

Selective self-test flags (0x0):

After scanning selected spans, do NOT read-scan remainder of disk.

If Selective self-test is pending on power-up, resume after 0 minute delay.

SCT Status Version: 3

SCT Version (vendor specific): 1 (0x0001)

Device State: Active (0)

Current Temperature: 54 Celsius

Power Cycle Min/Max Temperature: ?/56 Celsius

Lifetime Min/Max Temperature: ?/ ? Celsius

Under/Over Temperature Limit Count: 0/0

SCT Temperature History Version: 2

Temperature Sampling Period: 1 minute

Temperature Logging Interval: 1 minute

Min/Max recommended Temperature: -127/127 Celsius

Min/Max Temperature Limit: -127/127 Celsius

Temperature History Size (Index): 478 (414)

Index Estimated Time Temperature Celsius

415 2024-03-19 07:38 54 ***********************************

... ..( 43 skipped). .. ***********************************

459 2024-03-19 08:22 54 ***********************************

460 2024-03-19 08:23 55 ************************************

461 2024-03-19 08:24 54 ***********************************

... ..( 19 skipped). .. ***********************************

3 2024-03-19 08:44 54 ***********************************

4 2024-03-19 08:45 55 ************************************

5 2024-03-19 08:46 54 ***********************************

... ..( 53 skipped). .. ***********************************

59 2024-03-19 09:40 54 ***********************************

60 2024-03-19 09:41 55 ************************************

61 2024-03-19 09:42 54 ***********************************

... ..( 23 skipped). .. ***********************************

85 2024-03-19 10:06 54 ***********************************

86 2024-03-19 10:07 55 ************************************

87 2024-03-19 10:08 54 ***********************************

... ..( 53 skipped). .. ***********************************

141 2024-03-19 11:02 54 ***********************************

142 2024-03-19 11:03 55 ************************************

143 2024-03-19 11:04 54 ***********************************

144 2024-03-19 11:05 54 ***********************************

145 2024-03-19 11:06 54 ***********************************

146 2024-03-19 11:07 55 ************************************

147 2024-03-19 11:08 55 ************************************

148 2024-03-19 11:09 54 ***********************************

... ..( 2 skipped). .. ***********************************

151 2024-03-19 11:12 54 ***********************************

152 2024-03-19 11:13 55 ************************************

153 2024-03-19 11:14 54 ***********************************

... ..( 7 skipped). .. ***********************************

161 2024-03-19 11:22 54 ***********************************

162 2024-03-19 11:23 55 ************************************

163 2024-03-19 11:24 55 ************************************

164 2024-03-19 11:25 54 ***********************************

... ..( 6 skipped). .. ***********************************

171 2024-03-19 11:32 54 ***********************************

172 2024-03-19 11:33 55 ************************************

173 2024-03-19 11:34 54 ***********************************

... ..( 11 skipped). .. ***********************************

185 2024-03-19 11:46 54 ***********************************

186 2024-03-19 11:47 55 ************************************

187 2024-03-19 11:48 54 ***********************************

188 2024-03-19 11:49 54 ***********************************

189 2024-03-19 11:50 55 ************************************

... ..( 9 skipped). .. ************************************

199 2024-03-19 12:00 55 ************************************

200 2024-03-19 12:01 54 ***********************************

201 2024-03-19 12:02 55 ************************************

... ..( 2 skipped). .. ************************************

204 2024-03-19 12:05 55 ************************************

205 2024-03-19 12:06 54 ***********************************

206 2024-03-19 12:07 55 ************************************

... ..( 15 skipped). .. ************************************

222 2024-03-19 12:23 55 ************************************

223 2024-03-19 12:24 54 ***********************************

224 2024-03-19 12:25 55 ************************************

225 2024-03-19 12:26 54 ***********************************

226 2024-03-19 12:27 55 ************************************

... ..( 4 skipped). .. ************************************

231 2024-03-19 12:32 55 ************************************

232 2024-03-19 12:33 54 ***********************************

233 2024-03-19 12:34 55 ************************************

... ..( 9 skipped). .. ************************************

243 2024-03-19 12:44 55 ************************************

244 2024-03-19 12:45 54 ***********************************

245 2024-03-19 12:46 55 ************************************

... ..( 38 skipped). .. ************************************

284 2024-03-19 13:25 55 ************************************

285 2024-03-19 13:26 54 ***********************************

286 2024-03-19 13:27 55 ************************************

... ..( 12 skipped). .. ************************************

299 2024-03-19 13:40 55 ************************************

300 2024-03-19 13:41 54 ***********************************

301 2024-03-19 13:42 55 ************************************

... ..( 61 skipped). .. ************************************

363 2024-03-19 14:44 55 ************************************

364 2024-03-19 14:45 54 ***********************************

365 2024-03-19 14:46 55 ************************************

... ..( 17 skipped). .. ************************************

383 2024-03-19 15:04 55 ************************************

384 2024-03-19 15:05 54 ***********************************

385 2024-03-19 15:06 55 ************************************

... ..( 2 skipped). .. ************************************

388 2024-03-19 15:09 55 ************************************

389 2024-03-19 15:10 54 ***********************************

390 2024-03-19 15:11 55 ************************************

... ..( 21 skipped). .. ************************************

412 2024-03-19 15:33 55 ************************************

413 2024-03-19 15:34 54 ***********************************

414 2024-03-19 15:35 54 ***********************************

SCT Error Recovery Control:

Read: 80 (8.0 seconds)

Write: 80 (8.0 seconds)

Device Statistics (GP Log 0x04)

Page Offset Size Value Flags Description

0x01 ===== = = === == General Statistics (rev 1) ==

0x01 0x008 4 14 --- Lifetime Power-On Resets

0x01 0x010 4 19157 --- Power-on Hours

0x01 0x018 6 31827019211 --- Logical Sectors Written

0x01 0x020 6 721579271 --- Number of Write Commands

0x01 0x028 6 7573113070 --- Logical Sectors Read

0x01 0x030 6 55249209 --- Number of Read Commands

0x01 0x038 6 17652561885824 --- Date and Time TimeStamp

0x07 ===== = = === == Solid State Device Statistics (rev 1) ==

0x07 0x008 1 98 N-- Percentage Used Endurance Indicator

|||_ C monitored condition met

||__ D supports DSN

|___ N normalized value

Pending Defects log (GP Log 0x0c) not supported

SATA Phy Event Counters (GP Log 0x11)

ID Size Value Description

0x0001 2 0 Command failed due to ICRC error

0x0003 2 0 R_ERR response for device-to-host data FIS

0x0004 2 0 R_ERR response for host-to-device data FIS

0x0006 2 0 R_ERR response for device-to-host non-data FIS

0x0007 2 0 R_ERR response for host-to-device non-data FIS

0x0008 2 0 Device-to-host non-data FIS retries

0x0009 4 0 Transition from drive PhyRdy to drive PhyNRdy

0x000a 4 3 Device-to-host register FISes sent due to a COMRESET

0x000f 2 0 R_ERR response for host-to-device data FIS, CRC

0x0010 2 0 R_ERR response for host-to-device data FIS, non-CRC

0x0012 2 0 R_ERR response for host-to-device non-data FIS, CRC

0x0013 2 0 R_ERR response for host-to-device non-data FIS, non-CRC

@MysticFoxDE

Ja, das Update habe ich installiert am 26. Januar. Ausgehend von meinem Post im Dezember hat sich der Endurance Wert in knapp 100 Tagen um 9 Punkte/Prozent verschlechtert.

Ja, das Update habe ich installiert am 26. Januar. Ausgehend von meinem Post im Dezember hat sich der Endurance Wert in knapp 100 Tagen um 9 Punkte/Prozent verschlechtert.

Alles komisch. Aber egal wie, der Sophos Partner wurde informiert. Er sollte besser ein Gerät haben, wenn jetzt ein Ausfall kommt, basierend auf den übermittelten Daten.

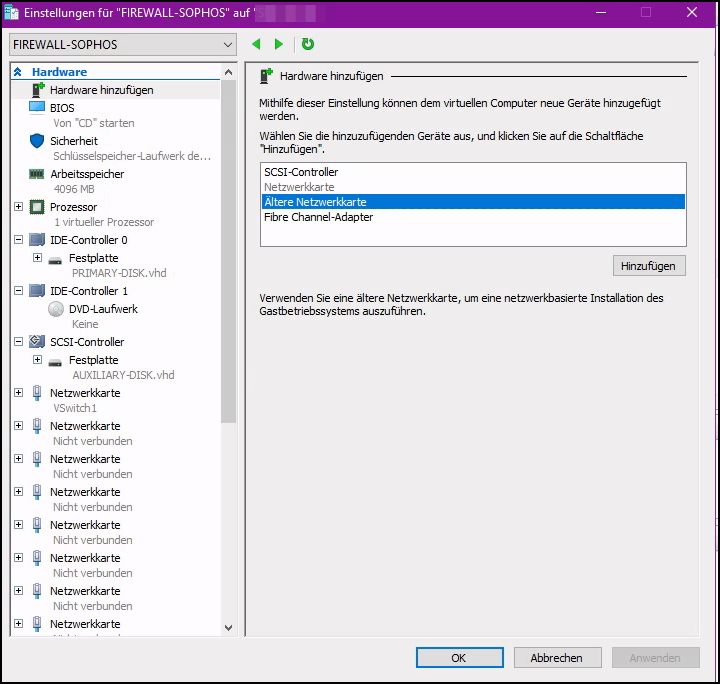

Sag mal, verstehe ich das richtig, dass ich mir auch eine HyperV Sophos hochziehen und dort das XGS Backup einspielen kann?

Sophos HyperV VM: docs.sophos.com/nsg/sophos-firewall/19.5/Help/en-us/webhelp/onli ...

Download Quelle: sophos.com/en-us/support/downloads/firewall-installers

Sag mal, verstehe ich das richtig, dass ich mir auch eine HyperV Sophos hochziehen und dort das XGS Backup einspielen kann?

Sophos HyperV VM: docs.sophos.com/nsg/sophos-firewall/19.5/Help/en-us/webhelp/onli ...

Download Quelle: sophos.com/en-us/support/downloads/firewall-installers

Jaein  Also, mit sechs ging es nicht. Acht gerade nochmal probiert (geht aber auch nicht). Bin jetzt ich verunsichert.

Also, mit sechs ging es nicht. Acht gerade nochmal probiert (geht aber auch nicht). Bin jetzt ich verunsichert.

Wie viele vNICS, würdest Du denn hier annehmen? Und hätten die auch verbunden sein müssen? Ich hatte nur die erste vNIC angebunden (vSwitch) um auf den SOPHOS webconfigurator zu gelangen. Fragen über Fragen.

Wie viele vNICS, würdest Du denn hier annehmen? Und hätten die auch verbunden sein müssen? Ich hatte nur die erste vNIC angebunden (vSwitch) um auf den SOPHOS webconfigurator zu gelangen. Fragen über Fragen.

Zitat von @a.esposito:

sehr geil, vielen Dank!

Frage: kann man den Wert evtl. per SNMP oder Powershell abfragen? Wäre genial für unser Pässler PRTG dann würde ich auf einem Blick das alles gleich sehen....

sehr geil, vielen Dank!

Frage: kann man den Wert evtl. per SNMP oder Powershell abfragen? Wäre genial für unser Pässler PRTG dann würde ich auf einem Blick das alles gleich sehen....

Get-Physicaldisk | Get-StorageReliabilityCounter | fl *Get-CimInstance -Namespace root\wmi -class MSStorageDriver_FailurePredictData