Dropped Packets

Hallo,

ich jage gerade einem Netzwerkproblem hinterher und bin dabei auf ein Indiz gestoßen was mich eventuell zu meinem Ziel/Behebung führen könnte. Bin mir aber nicht 100% sicher ob meine Annahme stimmt. Alles fing damit das ich bei erhöhter Last mitten am Tag an meinem pfSense-Router einen großen Paketloss auf dem physischen Interface verzeichnete. In der Größenordnung 38 Pakete pro Sekunde für circa 2 Minuten.

Danach war am Abend noch ein kleinerer Fall, aber kein Vergleich. Jetzt lasse ich mir per SNMP-Traps regelmäßig rausschreiben wann Paketverluste, Paketfehler oder Packets Drops passieren. Da fiel nun auf das da einige Pakete einfach verworfen werden am Core-Switch und zwar auf der Tx- Seite.

Am Core offenbart es sich so:

Mal als Beispiel nehmen ich mal 1/1/7 (Cisco SG300 mit 1x1Gbit LWL) wo es scheinbar überhaupt keine Probleme gibt:

Und dann mal zum Vergleich der 1/1/9 (Cisco SG200 mit 1x1Gbit LWL) wo vermehrt Pakete gedroppt werden:

Bei beiden ist die Auslastung im unteren einstelligen Prozentbereich gewesen im Moment als beim letzten Mal Pakete gedroppt wurden.

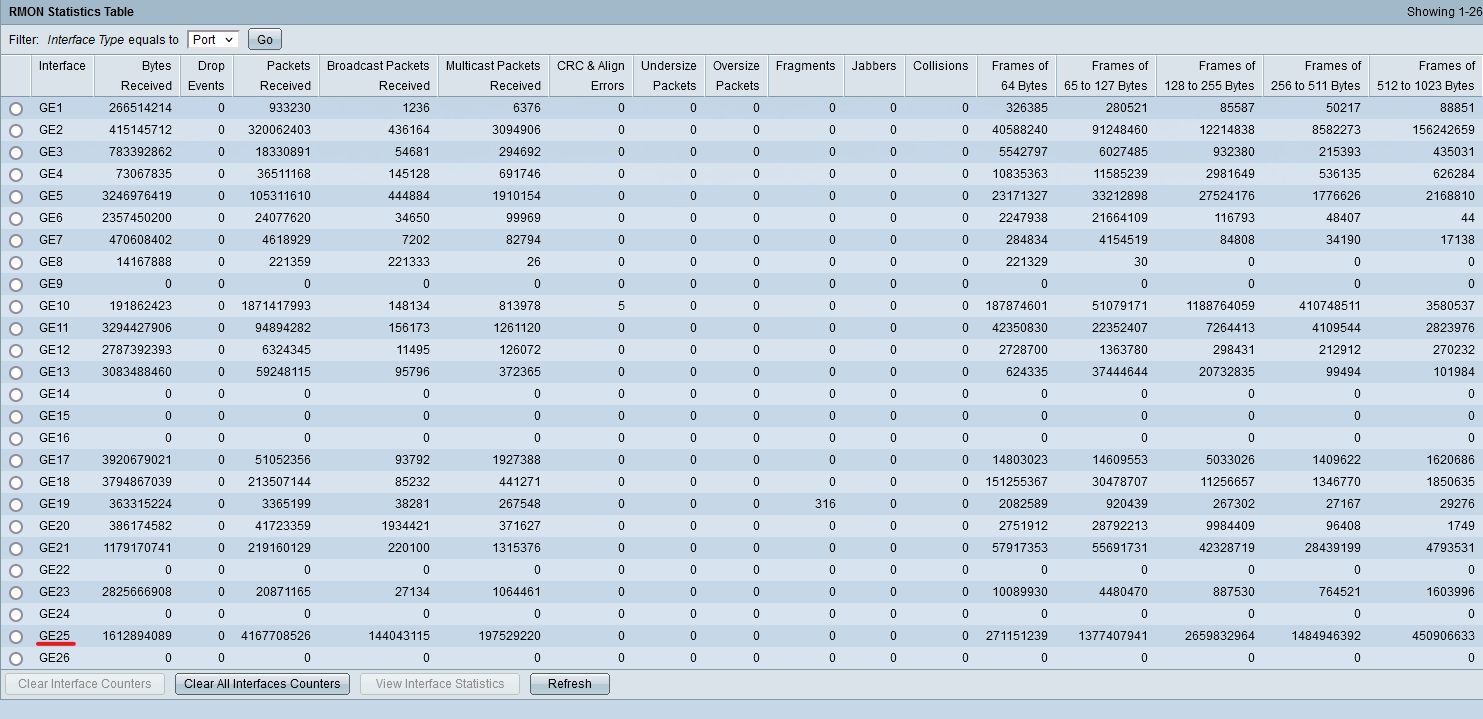

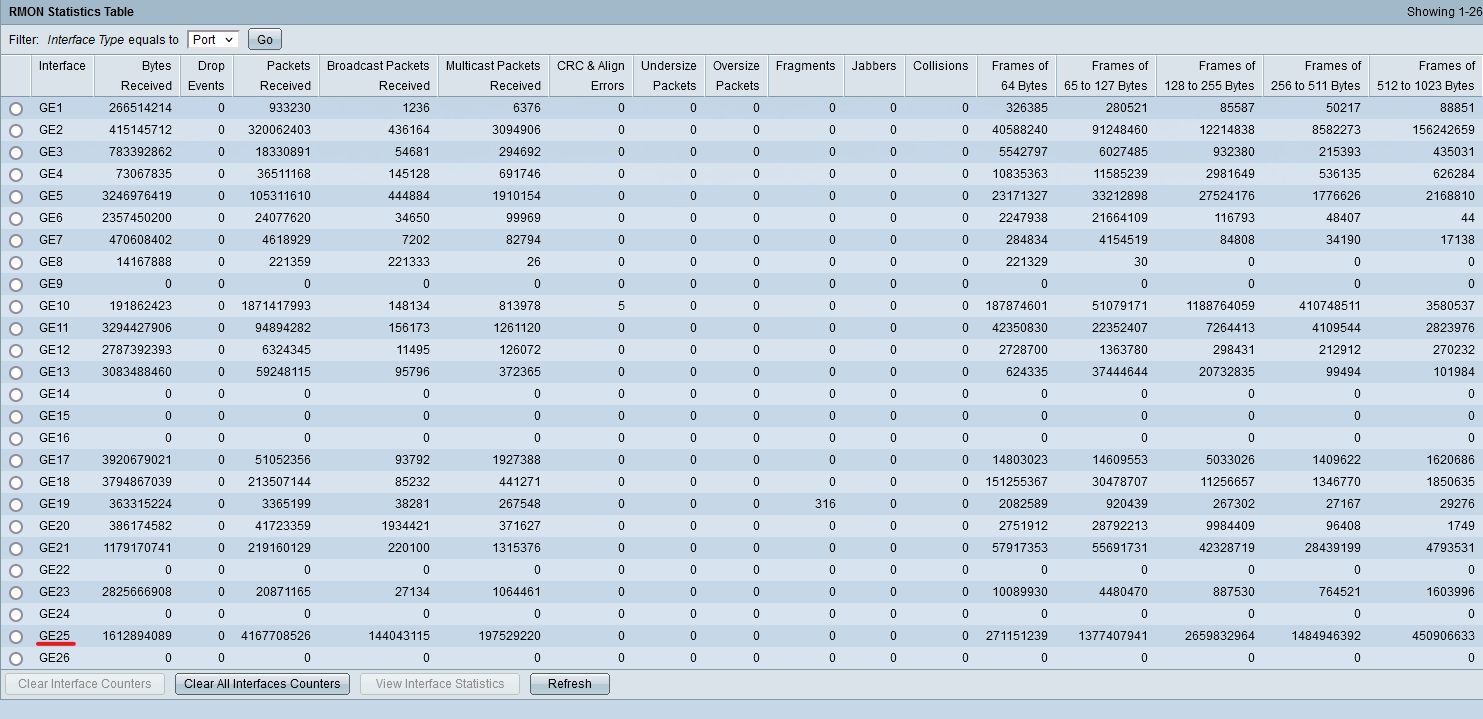

So sieht es auf dem genannten SG200 aus:

Wie man sieht kein Drop Event verzeichnet.

Bei Tx Discards würde ja, so mein Verständnis, bedeuten das der Buffer des Senders voll läuft und daraufhin Pakete verworfen werden. Was sich mir nicht erschließt, da es sich hier um einen ICX7750 handelt und die Auslastung nachweißlich ein Witz ist.

Kann es sein das entweder die Module mitterlweile eine Macke haben, als eventuell die Optiken "erblinden" oder es eine anderweitige physische Beschädigung gibt? Oder sind die Werte in einem "Normbereich" und es hat eventuell völlig andere Ursachen?

Gruß

ich jage gerade einem Netzwerkproblem hinterher und bin dabei auf ein Indiz gestoßen was mich eventuell zu meinem Ziel/Behebung führen könnte. Bin mir aber nicht 100% sicher ob meine Annahme stimmt. Alles fing damit das ich bei erhöhter Last mitten am Tag an meinem pfSense-Router einen großen Paketloss auf dem physischen Interface verzeichnete. In der Größenordnung 38 Pakete pro Sekunde für circa 2 Minuten.

Danach war am Abend noch ein kleinerer Fall, aber kein Vergleich. Jetzt lasse ich mir per SNMP-Traps regelmäßig rausschreiben wann Paketverluste, Paketfehler oder Packets Drops passieren. Da fiel nun auf das da einige Pakete einfach verworfen werden am Core-Switch und zwar auf der Tx- Seite.

Am Core offenbart es sich so:

SSH@ICX7750-48F Switch#sh tech-support packet-loss

==========================================================================

BEGIN : show tech-support packet-loss

CONTEXT : SSH#1 : PP total Tx stats

TIME STAMP : 10:00:42.429 CET Fri Sep 30 2022

HW/SW INFO : ICX7750-48F/SWS08090k

==========================================================================

PP total stats :

Packet drop count due to congestion per egress port

Port lg1: Tx packets 2708863147 Dropped packets 0

Port lg4: Tx packets 169259291 Dropped packets 0

Port lg5: Tx packets 194201942 Dropped packets 16763

Port 1/1/4: Tx packets 670659303 Dropped packets 7948

Port 1/1/5: Tx packets 915107079 Dropped packets 282474

Port 1/1/6: Tx packets 524308518 Dropped packets 12779

Port 1/1/7: Tx packets 184875665 Dropped packets 0

Port 1/1/8: Tx packets 681823035 Dropped packets 152576

Port 1/1/9: Tx packets 224963445 Dropped packets 87766

Port lg2: Tx packets 1571499410 Dropped packets 0

Port lg3: Tx packets 46212909 Dropped packets 587

Port 1/2/1: Tx packets 1360612164 Dropped packets 0

Port 1/2/4: Tx packets 65043504 Dropped packets 0

Port lg4: Tx packets 138342842 Dropped packets 0

Port lg5: Tx packets 101386488 Dropped packets 1526

Port lg2: Tx packets 1092119426 Dropped packets 0

Port lg3: Tx packets 73080814 Dropped packets 157

Port 2/2/1: Tx packets 1454957721 Dropped packets 0

Port 2/2/4: Tx packets 21014682 Dropped packets 0

==========================================================================

TIME STAMP : 10:00:42.447 CET Fri Sep 30 2022

END : show tech-support packet-loss

TIME TAKEN : 424137 ticks (17813754 nsec)

==========================================================================

==========================================================================

BEGIN : show statistics brief

CONTEXT : SSH#1 : PACKET COUNTERS

TIME STAMP : 10:00:42.486 CET Fri Sep 30 2022

HW/SW INFO : ICX7750-48F/SWS08090k

==========================================================================Mal als Beispiel nehmen ich mal 1/1/7 (Cisco SG300 mit 1x1Gbit LWL) wo es scheinbar überhaupt keine Probleme gibt:

UC Egress queues:

Queue counters Queued packets Dropped Packets

0 94386374 0

1 1126708 0

2 16230461 0

3 977264 0

4 1555240 0

5 852532 0

6 10875 0

7 1937421 0

MC Egress queues:

Queue counters Queued packets Dropped Packets

0 42995614 0

1 6364004 0

2 1871510 0

3 591089 0

4 16013428 0Und dann mal zum Vergleich der 1/1/9 (Cisco SG200 mit 1x1Gbit LWL) wo vermehrt Pakete gedroppt werden:

UC Egress queues:

Queue counters Queued packets Dropped Packets

0 132858958 87766

1 10692060 0

2 1531949 0

3 698104 0

4 4607547 0

5 4564757 0

6 12193 0

7 1937703 0

MC Egress queues:

Queue counters Queued packets Dropped Packets

0 44078894 0

1 6602589 0

2 837886 0

3 591127 0

4 16013726 0Bei beiden ist die Auslastung im unteren einstelligen Prozentbereich gewesen im Moment als beim letzten Mal Pakete gedroppt wurden.

So sieht es auf dem genannten SG200 aus:

Wie man sieht kein Drop Event verzeichnet.

Bei Tx Discards würde ja, so mein Verständnis, bedeuten das der Buffer des Senders voll läuft und daraufhin Pakete verworfen werden. Was sich mir nicht erschließt, da es sich hier um einen ICX7750 handelt und die Auslastung nachweißlich ein Witz ist.

Kann es sein das entweder die Module mitterlweile eine Macke haben, als eventuell die Optiken "erblinden" oder es eine anderweitige physische Beschädigung gibt? Oder sind die Werte in einem "Normbereich" und es hat eventuell völlig andere Ursachen?

Gruß

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 4108715824

Url: https://administrator.de/forum/dropped-packets-4108715824.html

Ausgedruckt am: 27.07.2025 um 23:07 Uhr

33 Kommentare

Neuester Kommentar

Beide Switches sind Store and Forward Switches. Sprich sie würden fehlformatierte oder ungültige Pakete nicht über ihr Backbone weitergeben. Die Errors beschränken sich also immer auf den Punkt zu Punkt Link, was bedeutet das es entscheidend ist WAS an den betroffenen Ports angeschlossen ist mit welchem Traffic Profil. Andere Switches, Endgeräte wie PCs, Server oder Drucker usw.

Grundsätzlich gilt das 1-2,5% von Paket Losses bezogen auf die Gesamtlast an dem Port bei Ethernet tolerabel sind. Bei Durchschnittslasten im unteren einstelligen Bereich sollten, wie du schon richtig sagst, normalerweise keine bis marginale Losses auftreten und die Counter eher 0 zeigen.

Was du meist nicht siehst sind kurzfristige Bursts die die Last auf 70% oder mehr an einem Port hochbringen und dann im Überlastfall auch höhere Drops verursachen können in kurzen Zeiträumen die unter deinem Polling Intervall liegen.

Da ist man dann wieder bei dem Thema was ist dort angeschlossen und ob das Endgerät solche Bursts generieren kann.

Außer Lastproblematiken gibt es noch andere Gründe

Formatfehler resultieren meist daraus wenn reine Access Ports eingehend .1q Pakete bekommen die sie droppen oder wenn dort Fabric Traffic wie TRILL oder SPB Frames eingehen die nicht Ethernet konform sind. Alles zeigt dann auf Konfig Fehler. Meist sind es .1q Frames die an reinen Access Ports landen.

Es gibt also deutlich mehr Gründe als nur Congestion oder Last auf die du achten musst.

Grundsätzlich gilt das 1-2,5% von Paket Losses bezogen auf die Gesamtlast an dem Port bei Ethernet tolerabel sind. Bei Durchschnittslasten im unteren einstelligen Bereich sollten, wie du schon richtig sagst, normalerweise keine bis marginale Losses auftreten und die Counter eher 0 zeigen.

Was du meist nicht siehst sind kurzfristige Bursts die die Last auf 70% oder mehr an einem Port hochbringen und dann im Überlastfall auch höhere Drops verursachen können in kurzen Zeiträumen die unter deinem Polling Intervall liegen.

Da ist man dann wieder bei dem Thema was ist dort angeschlossen und ob das Endgerät solche Bursts generieren kann.

Außer Lastproblematiken gibt es noch andere Gründe

- Kaputte Checksummen oder Header Checksummen

- Kaputte Frame Check Sequence

- Runt oder Giant Pakets (Formatfehler)

- Hardware oder Software Fehler und Bugs

- DoS Attacken

Formatfehler resultieren meist daraus wenn reine Access Ports eingehend .1q Pakete bekommen die sie droppen oder wenn dort Fabric Traffic wie TRILL oder SPB Frames eingehen die nicht Ethernet konform sind. Alles zeigt dann auf Konfig Fehler. Meist sind es .1q Frames die an reinen Access Ports landen.

Es gibt also deutlich mehr Gründe als nur Congestion oder Last auf die du achten musst.

Wenn die Lastspitzen immer zu gleichen Zeiten auftreten kannst du das ja einfach testen indem du die Statistik Counter mit clear count danach löschst. Bleiben sie bis zur nächsten Spitze auf 0 und gehen nach der Lastspitze wieder hoch ist es ein Last/Congestion Problem.

Kann aber auch Staub usw. sein wie man hier sehr schön sehen kann.

PfSense RX Error auf WAN

an dem besagten Core-Switch ICX7750 sind Switche angeschlossen

Hast du den oder die auf Single Span umgestellt, denn die SGs können kein PVST was die ICXe per Default machen?!ICX7750 bei 10Gbit-Verbindungen im Default im Cut-Through

OK, 7750 hatte ich überlesen, der ja. Verwechselt mit 7150, 7250, sorry. Der gibt dann aber Errors weiter aber eben rein nur auf den 10G Ports. Da wird Troubleshooting dann etwas mehr tricky.Ich werde dort mal die Schnittstellen tauschen und weiter beobachten

Wäre ein erster Ansatz. SFPs kosten ja nix mehr und du hast sicher noch Spare in der Schublade. Das sie blind werden ist bei MM, 50µ Optiken eher selten es sei denn man hat sehr kurze Kabel. Bei SM, 9µ Optiken ist das aber ein ernstes Thema wenn man dort kurze Längen hat. Da sollte man dann dämpfen oder die Kabel zumindestens eng aufrollen zur Dämpfung.Kann aber auch Staub usw. sein wie man hier sehr schön sehen kann.

Formatfehler kann ich mir nicht vorstellen

Wie gesagt, das kann auch sein wenn eine Seite Access ist und die andere .1q aber das PVID VLAN passt dann mit dem Access. Vermeintlich geht alles aber die .1q Seite sendet Tags was dann zu einseitigen Drops auf der Access Seite führt. Meist Flüchtigkeitsfehler bei der Konfig.Bei defekten Checksummen, denke ich widerum an ein Problem bei der pfSense

War da nicht mal irgendwas mit EEE Paketen...?!PfSense RX Error auf WAN

Hallo zusammen,

also seit der pfSense 2.6 werden alle Erros angezeigt und vorher eben nicht alle. Von daher sind nun einige

Benutzer verunsichert. Wobei man hier aber auch noch einmal zwischen den Fehlern und verworfenen

Paketen und den fehlerhaften Paketen unterschieden muss.

Egal was Du hier von benutzen oder umsetzen willst oder eben auch nicht, nicht gleich aufgeben!!!

Das ist das wichtigste überhaupt! Manchmal ist es oder sind es eben mehrere Punkte die man angehen

muss um das Ziel zu erreichen und viele, leider sehr viele Leute nehmen eine oder zwei Sachen in Anlauf

und sind dann sehr enttäuscht und geben auf!

Mal ein Beispiel man muss versuchen das eine Tuning mit dem anderen in Einklang zu bringen;

- NumBufferSize erhöhen und die Anzahl der Queues plus deren Länge

- Original Firmware drauf und die NumBuffSize erhöhen bzw. verkleinern plus die MTU

- 10 GBit/s NICs von Broadcom von oben nach unten (BufferSize) und Intel von unten nach oben versuchen

Bei Broadcom ist da machen es die 30.000 ButterSize und bei Intel die 1.000.000 BufferSize (als Beispiel)

Wenn die Puffer für die NICs voll sind, dann verwirft die pfSense die noch ankommenden Pakete eben auch,

d.h. wenn dann immer noch viele Pakete hinzukommen sollten. Man kann da aber an der Größe des Puffers

noch etwas einstellen, damit das eben nicht mehr das Fall ist.

Hier ist eben mehr RAM besser weil man dann eben mehr Speicher für Anzahl und Größe des Puffers,

für mehr und längere Queues zuweisen kann. Ist dann noch Snort, Squid und pfBlocker-NG mit im

Spiel wenn auch nur Teilweise, kann man auch dort mehr Speicher zuweisen bzw. mit mehr Speicher

kann es nicht zu einem Engpass kommen. Squid Cache RAM, Snort Rules update RAMDisk, ClamAV

riles (Signatures). Hat man eine oder mehrere HDD/SSDs dann wäre da noch die Swap Partition zu

nennen und die kann man pro HDD/SSD auf 4 GB setzen, wenn dann der RAM einmal eng wird,

wird eben ausgelagert und es stört Niemanden ob da 2 GB voll sind oder nicht, aber es hilft dem

System wenn etwas ausgelagert werden muss. Wann laufen denn die Updates dazu bei Dir?

Die Queues und zwar deren Länge und deren Größe sind dann noch zu erwähnen, die kann man auch etwas

vergrößern oder eben verkleinern, das kann dann auch noch einmal zu einer Durchsatz- oder Geschwindigkeitssteigerung beitragen, bzw. dass der gesamte Network-Flow etwas harmonischer verläuft.

pfSense Hardware Tuning and Troubleshooting

dann könnte man auch einmal darüber nachdenken, die original Firmware drauf zu "flashen", das schafft auch

recht oft bei Problemen Abhilfe. Also bei Intel Karten dann die original Intel Firmware, als Beispiel. Auch eine

aktualisierte Firmware kann es sein oder den Erfolg bringen.

Bei kopieren von großen und kleinen Dateien, kann mal die MTU an allen beteiligten Geräten überprüfen

ob die auch alle gleich groß eingestellt sind bzw. dann eben so einstellen.

Missing link route for a local target

Netzwerkdesign

LWL Optiken reinigen

NEOCLEAN-E LC/MU 1,25mm One-Push Reinigungsstift, 750+ Reinigungsvorgänge

Wenn Du den nicht schon hast

LWL Leitung nachmessen:

FOPM-202 Optischer Hand-Leistungsmesser (-50~+26dBm) mit 2,5mm FC/SC/ST-Anschluss FOPM-202 Optischer Hand-Leistungsmesser (-50~+26dBm) mit 2,5mm FC/SC/ST-Anschluss

Sind auch für andere Anschlüsse als SC/ST Verfügbar

Dobby

also seit der pfSense 2.6 werden alle Erros angezeigt und vorher eben nicht alle. Von daher sind nun einige

Benutzer verunsichert. Wobei man hier aber auch noch einmal zwischen den Fehlern und verworfenen

Paketen und den fehlerhaften Paketen unterschieden muss.

Egal was Du hier von benutzen oder umsetzen willst oder eben auch nicht, nicht gleich aufgeben!!!

Das ist das wichtigste überhaupt! Manchmal ist es oder sind es eben mehrere Punkte die man angehen

muss um das Ziel zu erreichen und viele, leider sehr viele Leute nehmen eine oder zwei Sachen in Anlauf

und sind dann sehr enttäuscht und geben auf!

Mal ein Beispiel man muss versuchen das eine Tuning mit dem anderen in Einklang zu bringen;

- NumBufferSize erhöhen und die Anzahl der Queues plus deren Länge

- Original Firmware drauf und die NumBuffSize erhöhen bzw. verkleinern plus die MTU

- 10 GBit/s NICs von Broadcom von oben nach unten (BufferSize) und Intel von unten nach oben versuchen

Bei Broadcom ist da machen es die 30.000 ButterSize und bei Intel die 1.000.000 BufferSize (als Beispiel)

Wenn die Puffer für die NICs voll sind, dann verwirft die pfSense die noch ankommenden Pakete eben auch,

d.h. wenn dann immer noch viele Pakete hinzukommen sollten. Man kann da aber an der Größe des Puffers

noch etwas einstellen, damit das eben nicht mehr das Fall ist.

Hier ist eben mehr RAM besser weil man dann eben mehr Speicher für Anzahl und Größe des Puffers,

für mehr und längere Queues zuweisen kann. Ist dann noch Snort, Squid und pfBlocker-NG mit im

Spiel wenn auch nur Teilweise, kann man auch dort mehr Speicher zuweisen bzw. mit mehr Speicher

kann es nicht zu einem Engpass kommen. Squid Cache RAM, Snort Rules update RAMDisk, ClamAV

riles (Signatures). Hat man eine oder mehrere HDD/SSDs dann wäre da noch die Swap Partition zu

nennen und die kann man pro HDD/SSD auf 4 GB setzen, wenn dann der RAM einmal eng wird,

wird eben ausgelagert und es stört Niemanden ob da 2 GB voll sind oder nicht, aber es hilft dem

System wenn etwas ausgelagert werden muss. Wann laufen denn die Updates dazu bei Dir?

Die Queues und zwar deren Länge und deren Größe sind dann noch zu erwähnen, die kann man auch etwas

vergrößern oder eben verkleinern, das kann dann auch noch einmal zu einer Durchsatz- oder Geschwindigkeitssteigerung beitragen, bzw. dass der gesamte Network-Flow etwas harmonischer verläuft.

pfSense Hardware Tuning and Troubleshooting

- NIC Hersteller und Modell herausfinden

- Den installierten Treiber ausfindig machen

- Die dazugehörigen Tuneables dazu anschauen.

Aber wenn ich mir das so überlege und das mir so durchlese was du schreibst, könnte tatsächlich meine

PHY an der pfSense (10Gbit LWL) einen Treffer haben. Ich werde dort mal die Schnittstellen tauschen

und weiter beobachten.

Wenn das Netzwerkkarten (NICs) sind, die eventuell gebraucht gekauft wurden, also von HP, Dell oder FujitsuPHY an der pfSense (10Gbit LWL) einen Treffer haben. Ich werde dort mal die Schnittstellen tauschen

und weiter beobachten.

dann könnte man auch einmal darüber nachdenken, die original Firmware drauf zu "flashen", das schafft auch

recht oft bei Problemen Abhilfe. Also bei Intel Karten dann die original Intel Firmware, als Beispiel. Auch eine

aktualisierte Firmware kann es sein oder den Erfolg bringen.

Bei kopieren von großen und kleinen Dateien, kann mal die MTU an allen beteiligten Geräten überprüfen

ob die auch alle gleich groß eingestellt sind bzw. dann eben so einstellen.

- Kein Route zum Target Network oder keine default route

Missing link route for a local target

- Veralteter Pfad oder Angabe zu/bei einer Regel

- NIC Buffer sind voll (zu klein)

Netzwerkdesign

- Wären nicht zwei oder mehr Routingpunkte im Netzwerk besser?

- Muss bei einem Backup oder Kopiervorgang immer alles voll durch die Firewall laufen?

LWL Optiken reinigen

NEOCLEAN-E LC/MU 1,25mm One-Push Reinigungsstift, 750+ Reinigungsvorgänge

Wenn Du den nicht schon hast

LWL Leitung nachmessen:

FOPM-202 Optischer Hand-Leistungsmesser (-50~+26dBm) mit 2,5mm FC/SC/ST-Anschluss FOPM-202 Optischer Hand-Leistungsmesser (-50~+26dBm) mit 2,5mm FC/SC/ST-Anschluss

Sind auch für andere Anschlüsse als SC/ST Verfügbar

Dobby

Beide befinden sich im selben VLAN, der Transfer findet also nicht über die pfSense statt.

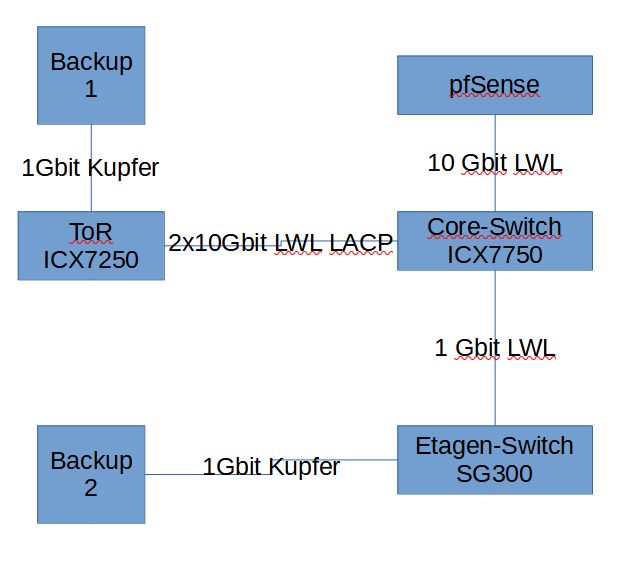

- Sind die beiden Sync Hosts Backup 1 und 2 ? Transfer geht also via ToR-CoreSW-Etage.

- Zeigen beide bzw. alle beteiligten Ports im gesamten Pfad der Sync Partner dieselben Discard Raten?

- Welches Images nutzt du auf den beteiligten Switches?

Recommended ist die 8.0.95 mit dem aktuellsten Patchrelease. Nicht das das ursächlich ist aber unter die 8.0.95 solltest du nicht mehr gehen!

Es wäre generell hilfreich wenn alle beteiligten Komponenten die latest und greatest hätten.

Auffällig ist das die Discards verstärkt am SoHo Switch auftreten.

Was bei den SoHos öfter mal passiert ist ein MDI-X Mismatch was dann in höhere Collision Rates resultiert bei steigender Last. Würde also ggf. einmal Sinn machen die Speed und Duplex Parameter an Backup 2 testweise einmal auf statische Werte zu setzen.

Congestion Probleme und Überlauf Probleme der Port RX und TX Queues am SG200 kann es ja eigentlich nicht geben da die Rate von Backup 1 identisch ist.

Problematisch ist das nur dann, wenn in solchen Sync Momenten noch anderer Traffic an Backup 2 kumuliert. SoHo Switches haben deutlich kleinere Port Buffer als deine Premium Switches. Sind die überlastet werden Pakets dort schlicht und einfach gedroppt und deine Counter gehen hoch. Es ist also auch etwas eine Frage der Voluminas an Backup 2.

Hast du ggf. einen Spare ICX den du mal testweise gegen den SG tauschen kannst?

Es wäre generell hilfreich wenn alle beteiligten Komponenten die latest und greatest hätten.

Auffällig ist das die Discards verstärkt am SoHo Switch auftreten.

Was bei den SoHos öfter mal passiert ist ein MDI-X Mismatch was dann in höhere Collision Rates resultiert bei steigender Last. Würde also ggf. einmal Sinn machen die Speed und Duplex Parameter an Backup 2 testweise einmal auf statische Werte zu setzen.

Congestion Probleme und Überlauf Probleme der Port RX und TX Queues am SG200 kann es ja eigentlich nicht geben da die Rate von Backup 1 identisch ist.

Problematisch ist das nur dann, wenn in solchen Sync Momenten noch anderer Traffic an Backup 2 kumuliert. SoHo Switches haben deutlich kleinere Port Buffer als deine Premium Switches. Sind die überlastet werden Pakets dort schlicht und einfach gedroppt und deine Counter gehen hoch. Es ist also auch etwas eine Frage der Voluminas an Backup 2.

Hast du ggf. einen Spare ICX den du mal testweise gegen den SG tauschen kannst?

Das ist in der Tat interessant. Könnte aber daran liegen das der Cut Through Switch dort auch kaputte Pakets weiterreicht. Aber eigentlich müsste der neue ICX die dann auch anzeigen. Das eine (Paket Buffer) widerspricht irgendwie dem anderen (kaputte Pakets).

Der Link auf den 350X ist der mit Kupfer oder Glas realisiert?! Wenn Glas hier ggf. mal die Optik tauschen. Es gibt übrigens ein aktuelles Firmware Update für die SG3xx-X Serie die einige Fixes in dem Bereich hat!

Der Link auf den 350X ist der mit Kupfer oder Glas realisiert?! Wenn Glas hier ggf. mal die Optik tauschen. Es gibt übrigens ein aktuelles Firmware Update für die SG3xx-X Serie die einige Fixes in dem Bereich hat!

aber ich komme nicht mehr in die Verwaltung.

Du bist zu sehr Klicki Bunti bezogen! 😉 CLI mit PuTTY per SSH oder Telnet geht immer.Das liegt aber nicht immer am Cisco sondern oft auch am Browser, da die Oberfläche Java verwendet. Achte da also drauf das du das latest und greatest dort hast. Und mal den Browsercache und den Verlauf löschen, dann klappts danach meist wieder problemlos. Die CBS Nachfolger sind da übrigens deutlich schneller.

Scheinbar hat das Teil auch irgendeinen Treffer. PoE an der Karre reagiert gar nicht mehr.

Das scheint in der Tat wohl ein Serienfehler zu sein. Das hatte ich hier schon bei 3 dieser Teile ebenso. weil das bei jeder Produktserie irgendein ein anderes OS drauf war.

Das ist richtig aber das CLI ist zu 98% Cisco IOS oder IOS-XE identisch! 😉 Kommt man also sehr schnell mit klar.Bei dem einen kann man das nicht, bei einem kann man jenes nicht.

Eigentlich nein. Die CLI Syntax ist vollkommen identisch zw. den Modellen. Wenn aber ein Feature in einem Model nicht unterstützt wird ist das CLI Kommando dann auch nicht da, was ja verständlich ist. Die Syntax zw. SG und CBS ist identisch. Die letzten 2 Images sind Hybridimages die auf beiden HW Plattformen laufen. Folglich ist auch die Syntax gleich.bekommen die Hersteller mal ihre Probleme auf die Kette. Leider Fehlanzeige.

Liegt ja nicht an den Herstellern sondern an der Chipknappheit generell. Die normalisiert sich ja gerade aber bis man das in den Lieferketten spürt wird das noch ½ Jahr dauern, mindestens.... Die können die Geräte dadurch schlicht und einfach nicht produzieren weil Zulieferteile fehlen. Sieh dir die derzeitigen Lieferzeiten der renomierten Hersteller an!! Das gilt ebenso für Netzteile und andere Komponenten die aus fremden Zulieferketten kommen. Der Fluch der Globalisierung. 😉 Ist ja nicht nur bei Mikrotik so...das Drama gibts ja auch beim Raspberry Pi und anderen...350€ irre. Es gibt endlos Beispiele dazu. Ist aber in der Tat ein ganz anderes Thema...Bisher sieht es auch gut aus, was das Thema Discards angeht.

Das gute alte Winblows Motto...reboot tut gut hilt manchmal auch bei der Infrastruktur. 🤣Hoffen wir mal das es so bleibt.

Was erstmal logisch klingen mag, aber bei der Auslastung hätte die 1Gbit LWL nicht überfordert sein dürfen.

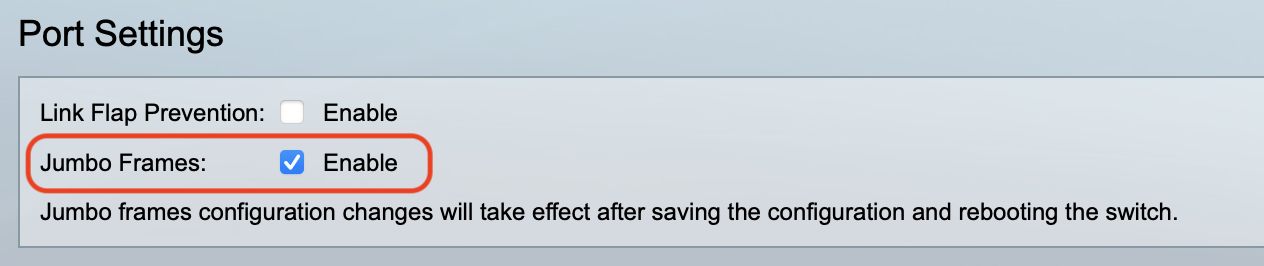

Hast du auf dem 350X das Jumbo Framing aktiviert?? Sollte man bei Geräten mit 10G Interfaces und höher generell IMMER machen.

Vermutlich muss ich den kompletten Switch auf Store-and-Forward umstellen

Den ASIC Mode kannst du niemals per Konfig umstellen. Das ist immer fest im Silizium verankert. Weisst du als Profi ja auch selber. 😉Der ICX7750 kann beide Modis.

Ooops...wie peinlich! Shame on me... 🙈ich müsste jeden Client und jeden Switch im Netz auf Jumbo Frames bringen, korrekt?

Nope, Clients handeln das dynamisch aus. Stichwort Path MTU DiscoveryEs sei denn sie sind im (alten) Treiber auf 1500er MTU festgenagelt. Zumindestens bei Server und Storage sollte man das immer prüfen.

oder sendet nur der Switch dann zum nächsten einfach mit Jumbo?

Nein, der gesamte Pfad muss das können. Bei der PMTUD gewinnt immer das kleinste gemeinsame Vielfache. 😉

Ich habe das hier einmal live auf 2 ICX 7150 kontrolliert. An einem ist ein Host mit einer 10G XFG Optik dran und beide Switches sind mit einem 10G SFP+ Link verbunden. Am 2ten hängt ein NAS ebenfalls mit 10G.

Über 1 ½ Wochen mit diversen Peak Lasten mal gemonitored und alle Errorcounter aller beteiligten Interfaces bleiben da auf 0. (Firmware 8.0.95h)

(Zur Zeit des Screenshots war nix los.  )

)

Über 1 ½ Wochen mit diversen Peak Lasten mal gemonitored und alle Errorcounter aller beteiligten Interfaces bleiben da auf 0. (Firmware 8.0.95h)

300 second input rate: 610904 bits/sec, 75 packets/sec, 0.00% utilization

300 second output rate: 82784 bits/sec, 41 packets/sec, 0.00% utilization

1239212 packets input, 800684873 bytes, 0 no buffer

Received 66293 broadcasts, 63196 multicasts, 1109723 unicasts

0 input errors, 0 CRC, 0 frame, 0 ignored

0 runts, 0 giants

979537 packets output, 475115697 bytes, 0 underruns

Transmitted 16135 broadcasts, 15071 multicasts, 948331 unicasts

0 output errors, 0 collisions

Relay Agent Information option: Disabled

Protected: No

MAC Port Security: Disabled

This port is not being monitored for queue drops

Egress queues:

Queue counters Queued packets Dropped Packets

0 969483 0

1 0 0

2 0 0

3 0 0

4 4656 0

5 302 0

6 3225 0

7 1871 0

Ne pfSense (APU Basis) ist übrigens an dem o.a. Switch auch dran. Hängt aber per Cu an einem SG350-X der dann mit 10G auf den ICX terminiert. Leider ohne LAG, deshalb ist das etwas Äpfel mit Birnen...

Beide aber der pfSense Cu Port am 350er und der 10G Koppelport sind vollkommen unauffällig. Dort ist ein permanenter Datenfluss bedingt durch die Internet Kopplung (1G sym) und auch da bleiben alle Counter auf 0 und haben noch nie hochgezählt.

Vermutlich ist das irgendein Endgerät was eine defekte NIC oder ein defekten PHY hat und der Cut Through Switch das weiterreicht. Schwer zu troubleshooten... Am effizientesten ist Top Talker mal auf andere Ports an Store and Forward Hardware umzuhängen und zu checken ob die Counter sich ändern. Da das bei dir in sehr kurzen Zeitabständen hochzählt müsste es ja etwas sein was schon ein relevantes Traffic Volumina erzeugt.

Beide aber der pfSense Cu Port am 350er und der 10G Koppelport sind vollkommen unauffällig. Dort ist ein permanenter Datenfluss bedingt durch die Internet Kopplung (1G sym) und auch da bleiben alle Counter auf 0 und haben noch nie hochgezählt.

Vermutlich ist das irgendein Endgerät was eine defekte NIC oder ein defekten PHY hat und der Cut Through Switch das weiterreicht. Schwer zu troubleshooten... Am effizientesten ist Top Talker mal auf andere Ports an Store and Forward Hardware umzuhängen und zu checken ob die Counter sich ändern. Da das bei dir in sehr kurzen Zeitabständen hochzählt müsste es ja etwas sein was schon ein relevantes Traffic Volumina erzeugt.

store-and-forward konfigurieren. Danach werde ich die ganze Sache nochmal beobachten.

Das ist in der Tat spannend. Wie gesagt ein größeres Netz hier im Core und Distribution mit ICX (alle SaF), 10G Backbone und Access diverse Cisco SG250X/250X über Monate keinerlei Hochzählen irgendwelcher Error Counter. Egal welcher Switch und Port.