FibreChannel VMWare ESX und Cisco UCS

Guten Abend zusammen,

bereits seit einiger Zeit läuft bei uns eine Migration der "alten VMWare Umgebung" auf eine neue.

Kurz mal die alte und neue Umgebung erläutert:

ALT

VMware Version: 6.0.0

Bestehend aus 5x Fujistu Primergy RX2540 M1, 1x Fujitsu DX 200 S3 (davon haben wir zwei, die Spiegeln sich, mit je 2 Shelfs), 1x Fujsitu DX 60 S2 (Backups) und 1x Fujistu DX 100 S3 (Offsite Backup)

Das ganze wird verbunden über 5x Brocade 300 FibreChannel Switche.

NEU

VMWare Version: 7.0.2

Besteht aus einem Cisco HyperFlex Cluster mit 4x HX240C-M5SX und einem UCSC-C240-M5S.

Das ganze wird verbunden mit einer Cisco UCS Fabric "6454"

Netzwerk / Storage Systeme:

5x Brocade 300

Fabric OS: 7.3.1b

Leider haben wir keine Support / Anbieter für das Gerät.

Zu gerne hätte ich noch die letzte Verfügbare Firmware installiert....

1x Fujitsu DX 60 S2

Model: ET062DCFU

Firmware: V20L16-0000

Speicherplatz: 2x RAID6 à 8,2 TB

2x Fujsitu DX 200 S3

Model: ET203AU

Firmware: V10L32-0000

Speicherplatz: 4x RAID6 à 4,8 TB

1x Fujsitu DX 100 SX

Alles unbekannt, da ich über die Dokumentieren IP Adressen nicht an das System komme....

Das Storage steht auch leider an einem 60km entfernten Standort und "Never Touch a Running System" ;)

Speicherplatz: 2xRAID6 à 16 TB

Auch bei den Fujitsu Eternus DX "XXX" wird es wohl Firmware Updates geben, aber kein weiß wie das von statten geht und mit welcher Downtime zu rechnen ist.

Auch hier mangelt es an einem Kompetenten Dienstleister.

Während der Migration wollten wir gerne auf die Fujitsu DX "60/100/200" von dem Cisco Cluster zugreifen. Leider gab es da nicht mehr bekannte Probleme bezüglich der Anbindung. Lediglich die DX60 konnte am Cisco Cluster konfiguriert werden.

Mir fehlt leider das Verständnis für den Bereich "Fibre Channel". Ich habe bis jetzt nur mit NetApps auf NFS Basis gearbeitet...

Was soll erreicht werden:

Die alte Fujitsu Umgebung soll noch dieses Jahr vom Netz genommen werden, da aber die Fujsitu DX Systeme noch "gut sind" würden wir die gerne noch als Datengrab weiter verwenden. Sei es für DEV VM's auf dem Cisco Cluster oder für ISO Dateien, Fileserver etc.

Ich habe nun mal die Konfiguration durchgeschaut und bin überfragt.

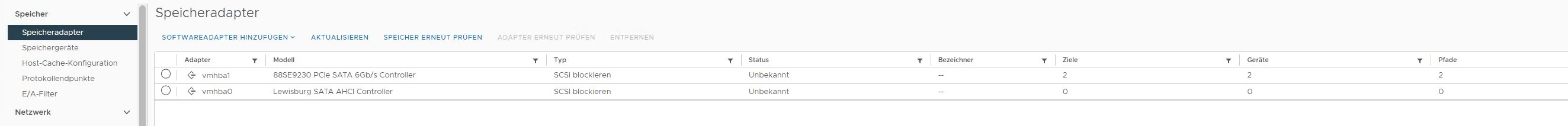

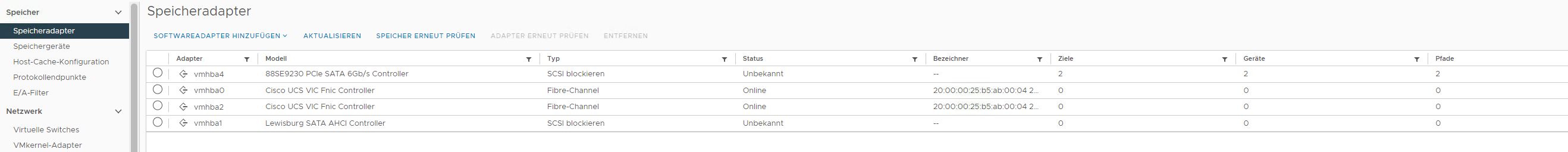

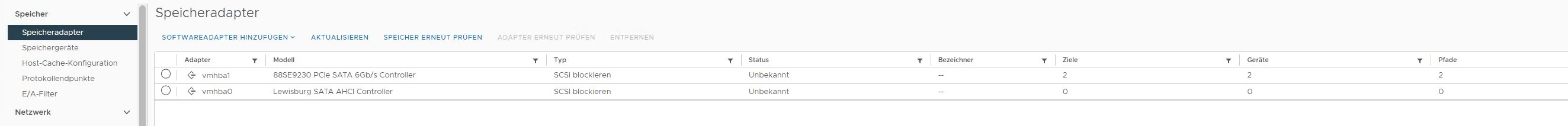

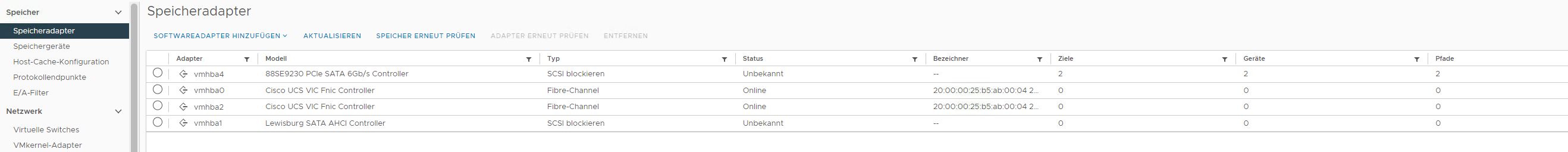

4 der 5 Cisco Server haben unter "Konfiguration -> Speicheradapter" ein VMHBA"X" als Cisco VIC FCoE die Fujitu DX 60 konfiguriert.

Wie bekomme ich das nun auch noch auf den 5. Server und wie bekomme ich die anderen (Fujsitu DX 100 / 200) auf dem Cisco Cluster erreicht?

Zur Zeit hat die Cisco UCS Umgebung 2x FibreChannel Links auf 2x Brocade 300 Switche.

Alleine bei der Konfiguration der Brocades fühle ich mich unwohl und das Know How endet Schlagartig.

Kurzfassung:

Problem 1:

Zuordnung der DX 60 auf allen Cisco HyperFlex Systemen.

Beispielhaft mal ein Node mit Verbindung und einer ohne.

Problem 2:

Wie bekomme ich die DX200 / 100 noch auf den Cisco Cluster hinzugefügt.

Hier einmal zwei Beispielkonfigurationen der Brocade 300 Switche.

SWITCH 01

SWITCH 04

Für mich stellt sich aktuell einfach die primäre Frage:

Ist Fibre Channel noch state of the art?

Macht es wirtschaftlich gesehen Sinn die Systeme weiter zu betreiben oder sollte ich Sie einfach abschalten und dem E-Schrott zufügen?

Gibt es ggf. einen Dienstleister in der Region Hannover der sich mit den Systemen "Cisco HyperFlex, Cisco UCS, Fujitu DX Storage, VMware und FibreChannel & Brocade 300 auskennt, den ihr empfehlen könnt?

Ich bedanke mich ganz herzlich für das lesen und hoffe, dass diese Frage nicht zu einer "Freitagsfrage" wird.

Freundlichen Grüße!

bereits seit einiger Zeit läuft bei uns eine Migration der "alten VMWare Umgebung" auf eine neue.

Kurz mal die alte und neue Umgebung erläutert:

ALT

VMware Version: 6.0.0

Bestehend aus 5x Fujistu Primergy RX2540 M1, 1x Fujitsu DX 200 S3 (davon haben wir zwei, die Spiegeln sich, mit je 2 Shelfs), 1x Fujsitu DX 60 S2 (Backups) und 1x Fujistu DX 100 S3 (Offsite Backup)

Das ganze wird verbunden über 5x Brocade 300 FibreChannel Switche.

NEU

VMWare Version: 7.0.2

Besteht aus einem Cisco HyperFlex Cluster mit 4x HX240C-M5SX und einem UCSC-C240-M5S.

Das ganze wird verbunden mit einer Cisco UCS Fabric "6454"

Netzwerk / Storage Systeme:

5x Brocade 300

Fabric OS: 7.3.1b

Leider haben wir keine Support / Anbieter für das Gerät.

Zu gerne hätte ich noch die letzte Verfügbare Firmware installiert....

1x Fujitsu DX 60 S2

Model: ET062DCFU

Firmware: V20L16-0000

Speicherplatz: 2x RAID6 à 8,2 TB

2x Fujsitu DX 200 S3

Model: ET203AU

Firmware: V10L32-0000

Speicherplatz: 4x RAID6 à 4,8 TB

1x Fujsitu DX 100 SX

Alles unbekannt, da ich über die Dokumentieren IP Adressen nicht an das System komme....

Das Storage steht auch leider an einem 60km entfernten Standort und "Never Touch a Running System" ;)

Speicherplatz: 2xRAID6 à 16 TB

Auch bei den Fujitsu Eternus DX "XXX" wird es wohl Firmware Updates geben, aber kein weiß wie das von statten geht und mit welcher Downtime zu rechnen ist.

Auch hier mangelt es an einem Kompetenten Dienstleister.

Während der Migration wollten wir gerne auf die Fujitsu DX "60/100/200" von dem Cisco Cluster zugreifen. Leider gab es da nicht mehr bekannte Probleme bezüglich der Anbindung. Lediglich die DX60 konnte am Cisco Cluster konfiguriert werden.

Mir fehlt leider das Verständnis für den Bereich "Fibre Channel". Ich habe bis jetzt nur mit NetApps auf NFS Basis gearbeitet...

Was soll erreicht werden:

Die alte Fujitsu Umgebung soll noch dieses Jahr vom Netz genommen werden, da aber die Fujsitu DX Systeme noch "gut sind" würden wir die gerne noch als Datengrab weiter verwenden. Sei es für DEV VM's auf dem Cisco Cluster oder für ISO Dateien, Fileserver etc.

Ich habe nun mal die Konfiguration durchgeschaut und bin überfragt.

4 der 5 Cisco Server haben unter "Konfiguration -> Speicheradapter" ein VMHBA"X" als Cisco VIC FCoE die Fujitu DX 60 konfiguriert.

Wie bekomme ich das nun auch noch auf den 5. Server und wie bekomme ich die anderen (Fujsitu DX 100 / 200) auf dem Cisco Cluster erreicht?

Zur Zeit hat die Cisco UCS Umgebung 2x FibreChannel Links auf 2x Brocade 300 Switche.

Alleine bei der Konfiguration der Brocades fühle ich mich unwohl und das Know How endet Schlagartig.

Kurzfassung:

Problem 1:

Zuordnung der DX 60 auf allen Cisco HyperFlex Systemen.

Beispielhaft mal ein Node mit Verbindung und einer ohne.

Problem 2:

Wie bekomme ich die DX200 / 100 noch auf den Cisco Cluster hinzugefügt.

Hier einmal zwei Beispielkonfigurationen der Brocade 300 Switche.

SWITCH 01

[Switch Configuration Begin : 0]

SwitchName =

Fabric ID = 128

[Boot Parameters]

boot.name:

boot.ipa:

boot.mac:10:00:50:eb:1a:0a:8c:41

boot.device:eth0

boot.gateway.ipa:

[Configuration]

Custom.index:0

FabricID:128

acl.clear:0

ag.fporttrunking:0

ag.port.nfportfailback:0x0

ag.port.nfportfailover:0x0

ag.port.nsfporttopo.0:0x0

ag.port.nsfporttopo.1:0x0

ag.port.nsfporttopo.10:0x0

ag.port.nsfporttopo.11:0x0

ag.port.nsfporttopo.12:0x0

ag.port.nsfporttopo.13:0x0

ag.port.nsfporttopo.14:0x0

ag.port.nsfporttopo.15:0x0

ag.port.nsfporttopo.16:0x0

ag.port.nsfporttopo.17:0x0

ag.port.nsfporttopo.18:0x0

ag.port.nsfporttopo.19:0x0

ag.port.nsfporttopo.2:0x0

ag.port.nsfporttopo.20:0x0

ag.port.nsfporttopo.21:0x0

ag.port.nsfporttopo.22:0x0

ag.port.nsfporttopo.23:0x0

ag.port.nsfporttopo.24:0x0

ag.port.nsfporttopo.25:0x0

ag.port.nsfporttopo.26:0x0

ag.port.nsfporttopo.27:0x0

ag.port.nsfporttopo.28:0x0

ag.port.nsfporttopo.29:0x0

ag.port.nsfporttopo.3:0x0

ag.port.nsfporttopo.30:0x0

ag.port.nsfporttopo.31:0x0

ag.port.nsfporttopo.32:0x0

ag.port.nsfporttopo.33:0x0

ag.port.nsfporttopo.34:0x0

ag.port.nsfporttopo.35:0x0

ag.port.nsfporttopo.36:0x0

ag.port.nsfporttopo.37:0x0

ag.port.nsfporttopo.38:0x0

ag.port.nsfporttopo.39:0x0

ag.port.nsfporttopo.4:0x0

ag.port.nsfporttopo.40:0x0

ag.port.nsfporttopo.41:0x0

ag.port.nsfporttopo.42:0x0

ag.port.nsfporttopo.43:0x0

ag.port.nsfporttopo.44:0x0

ag.port.nsfporttopo.45:0x0

ag.port.nsfporttopo.46:0x0

ag.port.nsfporttopo.47:0x0

ag.port.nsfporttopo.5:0x0

ag.port.nsfporttopo.6:0x0

ag.port.nsfporttopo.7:0x0

ag.port.nsfporttopo.8:0x0

ag.port.nsfporttopo.9:0x0

alpaList:1

audit.cfg.class:10,

audit.cfg.severity:4

audit.cfg.state:0

auth.policy:0

auth.policy.dev:3

cer.internal_port_code:1

cipher.https:!ECDH:!DH:HIGH:-MD5:!CAMELLIA:!SRP:!PSK:!AESGCM

cipher.ssh:3des-cbc,aes128-cbc,aes192-cbc,aes256-cbc

fabric.domain:1

fabric.dport.onDemand:0

fabric.dynamic_dport_feature:1

fabric.ficonmode:0

fabric.fidcheckdisable:0

fabric.hifmode:0

fabric.ididmode:0

fabric.name:

fabric.npivProbeMode:0

fabric.nport_10bit_upd_scn:0

fabric.ops.BBCredit:16

fabric.ops.E_D_TOV:2000

fabric.ops.R_A_TOV:10000

fabric.ops.bladeFault_on_hwErrlevel:0

fabric.ops.dataFieldSize:2112

fabric.ops.max_hops:7

fabric.ops.mode.fcpProbeDisable:0

fabric.ops.mode.isolate:0

fabric.ops.mode.longDistance:0

fabric.ops.mode.noClassF:0

fabric.ops.mode.pidFormat:1

fabric.ops.mode.tachyonCompat:0

fabric.ops.mode.unicastOnly:0

fabric.ops.mode.useCsCtl:0

fabric.ops.vc.class.2:2

fabric.ops.vc.class.3:3

fabric.ops.vc.config:0xc0

fabric.ops.vc.linkCtrl:0

fabric.ops.vc.multicast:7

fabric.ops.wan_tov:0

fabric.principalSwSelMode:0

fabric.rdp_poll_cycle:0

fabric.remoteFosexec:0

fabric.wwnPidMode:0

fc4.fcp.productId:FC Switch

fc4.fcp.vendorId:BROCADE

fcAL.alwaysSendRSCN:0

fcAL.fanFrameDisable:0

fcAL.openSendCLS:4

fcAL.useAltBBCredit:0

fdd.acceptcfg.auth:1

fdd.acceptcfg.dcc:1

fdd.acceptcfg.fcs:1

fdd.acceptcfg.ipf:1

fdd.acceptcfg.pwd:1

fdd.acceptcfg.scc:1

fdd.fabwidecfg:

fdd.hash.dcc:0

fdd.hash.fbw:0

fdd.hash.fcs:0

fdd.hash.pwd:0

fdd.hash.scc:0

fdd.hashpresent.dcc:0

fdd.hashpresent.fbw:0

fdd.hashpresent.fcs:0

fdd.hashpresent.pwd:0

fdd.hashpresent.scc:0

featuredb.status:1

ficu.DHBsize:0

ficu.EBCDICcodePage:37

ficu.MIHPTO:180

ficu.faf.hdata:0

ficu.faf.keyctr:0

ficu.faf.modereg:0

ficu.fmsmode:0

flannel.ops.frameColMethod:piling

flannel.ops.openBBCredit:4

gen.fabos:0

gen.zone:0

ms.PlatEnable:0

ms.TDEnable:0

ms.TolerantFBEnabled:0

ns.DomRscnToDevForSwChg.enable:0

ns.EndDeviceRscnFormat:1

oemLogo:0

perf.framemon.enabled:1

perf.framemon.names:scsi,scsiread,scsiwrite,scsirw,scsi2reserve,scsi3reserve,ip,abts,baacc

perf.framemon.num:9

perf.framemonc.abts:0|4,0xFF,0x81;12,0xFF,0x0;|0||

perf.framemonc.baacc:0|4,0xFF,0x84;12,0xFF,0x00;|0||

perf.framemonc.ip:0|12,0xFF,0x05;|0||

perf.framemonc.scsi:0|12,0xFF,0x08;|0||

perf.framemonc.scsi2reserve:0|12,0xFF,0x08;4,0xFF,0x06;40,0xFF,0x16,0x56;|0||

perf.framemonc.scsi3reserve:0|12,0xFF,0x08;4,0xFF,0x06;40,0xFF,0x5F;41,0xFF,0x01|0||

perf.framemonc.scsiread:0|12,0xFF,0x08;4,0xFF,0x06;40,0xFF,0x08,0x28;|0||

perf.framemonc.scsirw:0|12,0xFF,0x08;4,0xFF,0x06;40,0xFF,0x08,0x28,0x0A,0x2A;|0||

perf.framemonc.scsiwrite:0|12,0xFF,0x08;4,0xFF,0x06;40,0xFF,0x0A,0x2A;|0||

portNpivLimit:

quickLoop.holdOpenInit:0

quickLoop.noAlpaZero:0

quickLoop.peerWWN:00:00:00:00:00:00:00:00

quickLoop.portBitmap:0x0000000000000000

quickLoop.softInit:0

rasm.filter:5

rlsDisable:1

route.delayReroute:0

route.embeddedPortBcast:1

route.lossless:0

route.stickyRoutes:0

rpcd.callback.enabled:0

rpcd.callback.secret:secret

rpcd.enabled:1

rpcd.ssl.enabled:0

rte.intCostFactor:100

sec.fstov:5000

sec.mode:0

sec.versioStamp:

sec.versionStamp:0

secrpc.enabled:0

shell.delete:0

shell.quiet:0

sigmad.cfs:0x0

switch.defaultPortname:0

switch.domain_id_offset:96

switch.edgeHoldTime:220

switch.fdmiHostname:0

switch.interopMode:0

switch.largeEntry.cap:0

switch.login.enforce_login:0

switch.login.flogisPerSec:0

switch.login.freeFdiscs:0

switch.login.max_flogi_count:100

switch.login.stageInterval:0

switch.mcdtDefaultZone:0

switch.mcdtFabricMode:0

switch.mcdtSafeZone:0

switch.status.policy.ErrorPorts.down:0

switch.status.policy.ErrorPorts.marginal:0

switch.status.policy.Fans.down:2

switch.status.policy.Fans.marginal:1

switch.status.policy.FaultyPorts.down:6

switch.status.policy.FaultyPorts.marginal:2

switch.status.policy.Flash.down:0

switch.status.policy.Flash.marginal:1

switch.status.policy.MarginalPorts.down:6

switch.status.policy.MarginalPorts.marginal:2

switch.status.policy.MissingSFPs.down:0

switch.status.policy.MissingSFPs.marginal:0

switch.status.policy.PowerSupplies.down:1

switch.status.policy.PowerSupplies.marginal:1

switch.status.policy.Temperatures.down:2

switch.status.policy.Temperatures.marginal:1

switch.status.policy.percentage.ErrorPorts.down:0.00

switch.status.policy.percentage.ErrorPorts.marginal:0.00

switch.status.policy.percentage.FaultyPorts.down:25.00

switch.status.policy.percentage.FaultyPorts.marginal:10.00

switch.status.policy.percentage.MarginalPorts.down:25.00

switch.status.policy.percentage.MarginalPorts.marginal:10.00

switch.status.policy.percentage.MissingSFPs.down:0.00

switch.status.policy.percentage.MissingSFPs.marginal:0.00

switch.xisluse:0

thresh.alarmsfilter:1

ts.clockServer:100.100.0.150

ts.clockServerIndex:-1

ts.clockServerIndexList:-1

ts.clockServerList:100.100.0.150

xlativeModeDisable:0

zoning.check.nodeNameDisabled:0

zoning.conOpenTransDet:1

zoning.standardMode:0

zoning.targetPeerZoning:0

[Bottleneck Configuration]

bottleneck.enabled:0

[NP Configuration]

[FCOE_SW_CONF]

[Zoning]

cfg.std_cfg:esxi0001_vmhba1__DX60_CM0_P1;esxi0001_vmhba1__DX60_CM1_P0;esxi0002_vmhba1__DX60_CM0_P1;esxi0002_vmhba1__DX60_CM1_P0;esxi0003_vmhba1__DX60_CM0_P1;esxi0003_vmhba1__DX60_CM1_P0;esxi0004_vmhba1_DX60_CM0_P1;esxi0004_vmhba1_DX60_CM1_P0;esxi0005_vmhba1_DX60_CM0_P1;esxi0005_vmhba1_DX60_CM1_P0;SAN01_CM1_CA1_P1__SAN02_CM1_CA1_P1_REC;esxi0001_vmhba1__SAN01_CM0_CA0_P1;esxi0002_vmhba1__SAN01_CM0_CA0_P1;esxi0003_vmhba1__SAN01_CM0_CA0_P1;esxi0004_vmhba1__SAN01_CM0_CA0_P1;esxi0005_vmhba1__SAN01_CM0_CA0_P1;esxi0001_vmhba1__SAN01_CM1_CA0_P0;esxi0002_vmhba1__SAN01_CM1_CA0_P0;esxi0003_vmhba1__SAN01_CM1_CA0_P0;esxi0004_vmhba1__SAN01_CM1_CA0_P0;esxi0005_vmhba1__SAN01_CM1_CA0_P0;esxi0001_vmhba1_DX100FAL_CM0_CA0_P0;esxi0002_vmhba1_DX100FAL_CM0_CA0_P0;esxi0003_vmhba1_DX100FAL_CM0_CA0_P0;esxi0004_vmhba1_DX100FAL_CM0_CA0_P0;esxi0005_vmhba1_DX100FAL_CM0_CA0_P0;esxi0001_vmhba1_DX100FAL_CM1_CA0_P0;esxi0002_vmhba1_DX100FAL_CM1_CA0_P0;esxi0003_vmhba1_DX100FAL_CM1_CA0_P0;esxi0004_vmhba1_DX100FAL_CM1_CA0_P0;esxi0005_vmhba1_DX100FAL_CM1_CA0_P0;vrz_esxi0030_vmhba0__DX60_CM0_P1;vrz_esxi0030_vmhba0__DX60_CM1_P0;vrz_esxi0031_vmhba0__DX60_CM0_P1;vrz_esxi0031_vmhba0__DX60_CM1_P0;vrz_esxi0032_vmhba0__DX60_CM0_P1;vrz_esxi0032_vmhba0__DX60_CM1_P0;vrz_esxi0033_vmhba0__DX60_CM0_P1;vrz_esxi0033_vmhba0__DX60_CM1_P0;vrz_esxi0030_vmhba0__SAN01_CM0_CA0_P1;vrz_esxi0030_vmhba0__SAN01_CM1_CA0_P0;vrz_esxi0031_vmhba0__SAN01_CM0_CA0_P1;vrz_esxi0031_vmhba0__SAN01_CM1_CA0_P0;vrz_esxi0032_vmhba0__SAN01_CM0_CA0_P1;vrz_esxi0032_vmhba0__SAN01_CM1_CA0_P0;vrz_esxi0033_vmhba0__SAN01_CM0_CA0_P1;vrz_esxi0033_vmhba0__SAN01_CM1_CA0_P0;vrz_esxi0030_vmhba0__DX100FAL_CM0_CA0_P0;vrz_esxi0030_vmhba0__DX100FAL_CM1_CA0_P0;vrz_esxi0031_vmhba0__DX100FAL_CM0_CA0_P0;vrz_esxi0031_vmhba0__DX100FAL_CM1_CA0_P0;vrz_esxi0032_vmhba0__DX100FAL_CM0_CA0_P0;vrz_esxi0032_vmhba0__DX100FAL_CM1_CA0_P0;vrz_esxi0033_vmhba0__DX100FAL_CM0_CA0_P0;vrz_esxi0033_vmhba0__DX100FAL_CM1_CA0_P0

zone.SAN01_CM1_CA1_P1__SAN02_CM1_CA1_P1_REC:SAN02_CM1_CA1_P1;SAN01_CM1_CA1_P1

zone.esxi0001_vmhba1_DX100FAL_CM0_CA0_P0:DX100FAL_CM0_CA0_P0;esxi0001_vmhba1

zone.esxi0001_vmhba1_DX100FAL_CM1_CA0_P0:DX100FAL_CM1_CA0_P0;esxi0001_vmhba1

zone.esxi0001_vmhba1__DX60_CM0_P1:DX60_CM0_P1;esxi0001_vmhba1

zone.esxi0001_vmhba1__DX60_CM1_P0:DX60_CM1_P0;esxi0001_vmhba1

zone.esxi0001_vmhba1__SAN01_CM0_CA0_P1:esxi0001_vmhba1;SAN01_CM0_CA0_P1

zone.esxi0001_vmhba1__SAN01_CM1_CA0_P0:esxi0001_vmhba1;SAN01_CM1_CA0_P0

zone.esxi0002_vmhba1_DX100FAL_CM0_CA0_P0:DX100FAL_CM0_CA0_P0;esxi0002_vmhba1

zone.esxi0002_vmhba1_DX100FAL_CM1_CA0_P0:DX100FAL_CM1_CA0_P0;esxi0002_vmhba1

zone.esxi0002_vmhba1__DX60_CM0_P1:DX60_CM0_P1;esxi0002_vmhba1

zone.esxi0002_vmhba1__DX60_CM1_P0:DX60_CM1_P0;esxi0002_vmhba1

zone.esxi0002_vmhba1__SAN01_CM0_CA0_P1:esxi0002_vmhba1;SAN01_CM0_CA0_P1

zone.esxi0002_vmhba1__SAN01_CM1_CA0_P0:esxi0002_vmhba1;SAN01_CM1_CA0_P0

zone.esxi0003_vmhba1_DX100FAL_CM0_CA0_P0:DX100FAL_CM0_CA0_P0;esxi0003_vmhba1

zone.esxi0003_vmhba1_DX100FAL_CM1_CA0_P0:DX100FAL_CM1_CA0_P0;esxi0003_vmhba1

zone.esxi0003_vmhba1__DX60_CM0_P1:DX60_CM0_P1;esxi0003_vmhba1

zone.esxi0003_vmhba1__DX60_CM1_P0:DX60_CM1_P0;esxi0003_vmhba1

zone.esxi0003_vmhba1__SAN01_CM0_CA0_P1:esxi0003_vmhba1;SAN01_CM0_CA0_P1

zone.esxi0003_vmhba1__SAN01_CM1_CA0_P0:esxi0003_vmhba1;SAN01_CM1_CA0_P0

zone.esxi0004_vmhba1_DX100FAL_CM0_CA0_P0:DX100FAL_CM0_CA0_P0;esxi0004_vmhba1

zone.esxi0004_vmhba1_DX100FAL_CM1_CA0_P0:DX100FAL_CM1_CA0_P0;esxi0004_vmhba1

zone.esxi0004_vmhba1_DX60_CM0_P1:DX60_CM0_P1;esxi0004_vmhba1

zone.esxi0004_vmhba1_DX60_CM1_P0:DX60_CM1_P0;esxi0004_vmhba1

zone.esxi0004_vmhba1__SAN01_CM0_CA0_P1:esxi0004_vmhba1;SAN01_CM0_CA0_P1

zone.esxi0004_vmhba1__SAN01_CM1_CA0_P0:esxi0004_vmhba1;SAN01_CM1_CA0_P0

zone.esxi0005_vmhba1_DX100FAL_CM0_CA0_P0:DX100FAL_CM0_CA0_P0;esxi0005_vmhba1

zone.esxi0005_vmhba1_DX100FAL_CM1_CA0_P0:DX100FAL_CM1_CA0_P0;esxi0005_vmhba1

zone.esxi0005_vmhba1_DX60_CM0_P1:DX60_CM0_P1;esxi0005_vmhba1

zone.esxi0005_vmhba1_DX60_CM1_P0:DX60_CM1_P0;esxi0005_vmhba1

zone.esxi0005_vmhba1__SAN01_CM0_CA0_P1:esxi0005_vmhba1;SAN01_CM0_CA0_P1

zone.esxi0005_vmhba1__SAN01_CM1_CA0_P0:esxi0005_vmhba1;SAN01_CM1_CA0_P0

zone.vrz_esxi0030_vmhba0__DX100FAL_CM0_CA0_P0:vrz_esxi0030_vmhba0;DX100FAL_CM0_CA0_P0

zone.vrz_esxi0030_vmhba0__DX100FAL_CM1_CA0_P0:vrz_esxi0030_vmhba0;DX100FAL_CM1_CA0_P0

zone.vrz_esxi0030_vmhba0__DX60_CM0_P1:vrz_esxi0030_vmhba0;DX60_CM0_P1

zone.vrz_esxi0030_vmhba0__DX60_CM1_P0:vrz_esxi0030_vmhba0;DX60_CM1_P0

zone.vrz_esxi0030_vmhba0__SAN01_CM0_CA0_P1:vrz_esxi0030_vmhba0;SAN01_CM0_CA0_P1

zone.vrz_esxi0030_vmhba0__SAN01_CM1_CA0_P0:vrz_esxi0030_vmhba0;SAN01_CM1_CA0_P0

zone.vrz_esxi0031_vmhba0__DX100FAL_CM0_CA0_P0:vrz_esxi0031_vmhba0;DX100FAL_CM0_CA0_P0

zone.vrz_esxi0031_vmhba0__DX100FAL_CM1_CA0_P0:vrz_esxi0031_vmhba0;DX100FAL_CM1_CA0_P0

zone.vrz_esxi0031_vmhba0__DX60_CM0_P1:vrz_esxi0031_vmhba0;DX60_CM0_P1

zone.vrz_esxi0031_vmhba0__DX60_CM1_P0:vrz_esxi0031_vmhba0;DX60_CM1_P0

zone.vrz_esxi0031_vmhba0__SAN01_CM0_CA0_P1:vrz_esxi0031_vmhba0;SAN01_CM0_CA0_P1

zone.vrz_esxi0031_vmhba0__SAN01_CM1_CA0_P0:vrz_esxi0031_vmhba0;SAN01_CM1_CA0_P0

zone.vrz_esxi0032_vmhba0__DX100FAL_CM0_CA0_P0:vrz_esxi0032_vmhba0;DX100FAL_CM0_CA0_P0

zone.vrz_esxi0032_vmhba0__DX100FAL_CM1_CA0_P0:vrz_esxi0032_vmhba0;DX100FAL_CM1_CA0_P0

zone.vrz_esxi0032_vmhba0__DX60_CM0_P1:vrz_esxi0032_vmhba0;DX60_CM0_P1

zone.vrz_esxi0032_vmhba0__DX60_CM1_P0:vrz_esxi0032_vmhba0;DX60_CM1_P0

zone.vrz_esxi0032_vmhba0__SAN01_CM0_CA0_P1:vrz_esxi0032_vmhba0;SAN01_CM0_CA0_P1

zone.vrz_esxi0032_vmhba0__SAN01_CM1_CA0_P0:vrz_esxi0032_vmhba0;SAN01_CM1_CA0_P0

zone.vrz_esxi0033_vmhba0__DX100FAL_CM0_CA0_P0:vrz_esxi0033_vmhba0;DX100FAL_CM0_CA0_P0

zone.vrz_esxi0033_vmhba0__DX100FAL_CM1_CA0_P0:vrz_esxi0033_vmhba0;DX100FAL_CM1_CA0_P0

zone.vrz_esxi0033_vmhba0__DX60_CM0_P1:vrz_esxi0033_vmhba0;DX60_CM0_P1

zone.vrz_esxi0033_vmhba0__DX60_CM1_P0:vrz_esxi0033_vmhba0;DX60_CM1_P0

zone.vrz_esxi0033_vmhba0__SAN01_CM0_CA0_P1:vrz_esxi0033_vmhba0;SAN01_CM0_CA0_P1

zone.vrz_esxi0033_vmhba0__SAN01_CM1_CA0_P0:vrz_esxi0033_vmhba0;SAN01_CM1_CA0_P0

alias.DX100FAL_CM0_CA0_P0:50:00:00:e0:da:76:a0:20

alias.DX100FAL_CM1_CA0_P0:50:00:00:e0:da:76:a0:30

alias.DX60_CM0_P1:50:00:00:e0:d0:1d:ca:07

alias.DX60_CM1_P0:50:00:00:e0:d0:1d:ca:86

alias.SAN01_CM0_CA0_P1:50:00:00:e0:da:04:55:21

alias.SAN01_CM0_CA1_P0:50:00:00:e0:da:04:55:24

alias.SAN01_CM1_CA0_P0:50:00:00:e0:da:04:55:30

alias.SAN01_CM1_CA1_P1:50:00:00:e0:da:04:55:35

alias.SAN02_CM1_CA1_P1:50:00:00:e0:da:20:94:35

alias.esxi0001_vmhba1:21:00:00:24:ff:0b:cb:76

alias.esxi0002_vmhba1:21:00:00:24:ff:0d:dc:09

alias.esxi0003_vmhba1:21:00:00:24:ff:0e:6f:ae

alias.esxi0004_vmhba1:21:00:00:24:ff:0e:aa:4d

alias.esxi0005_vmhba1:21:00:00:24:ff:0e:aa:63

alias.vrz_esxi0030_vmhba0:20:00:00:25:b5:ab:a0:03

alias.vrz_esxi0031_vmhba0:20:00:00:25:b5:ab:a0:02

alias.vrz_esxi0032_vmhba0:20:00:00:25:b5:ab:a0:01

alias.vrz_esxi0033_vmhba0:20:00:00:25:b5:ab:a0:00

defzone:allaccess

enable:std_cfg

[Defined Security policies]

[Active Security policies]

[iSCSI]

[cryptoDev]

[FICU SAVED FILES]

[VS_SW_CONF]

vs.hdr:01abcdef000000010000000000000068

vs.num_entries:0

[MAPS CONFIG DB]

maps.enabled:0

[Banner]

[End]

[Switch Configuration End : 0]SWITCH 04

VRZ-NW0028:admin> configshow

[Switch Configuration Begin : 0]

SwitchName =

Fabric ID = 128

[Boot Parameters]

boot.name:

boot.ipa:

boot.mac:10:00:50:eb:1a:b2:3e:9c

boot.device:eth0

boot.gateway.ipa:

[Configuration]

Custom.index:0

acl.clear:0

ag.fporttrunking:0

ag.port.nfportfailback:0x0

ag.port.nfportfailover:0x0

ag.port.nsfporttopo.0:0x0

ag.port.nsfporttopo.1:0x0

ag.port.nsfporttopo.10:0x0

ag.port.nsfporttopo.11:0x0

ag.port.nsfporttopo.12:0x0

ag.port.nsfporttopo.13:0x0

ag.port.nsfporttopo.14:0x0

ag.port.nsfporttopo.15:0x0

ag.port.nsfporttopo.16:0x0

ag.port.nsfporttopo.17:0x0

ag.port.nsfporttopo.18:0x0

ag.port.nsfporttopo.19:0x0

ag.port.nsfporttopo.2:0x0

ag.port.nsfporttopo.20:0x0

ag.port.nsfporttopo.21:0x0

ag.port.nsfporttopo.22:0x0

ag.port.nsfporttopo.23:0x0

ag.port.nsfporttopo.24:0x0

ag.port.nsfporttopo.25:0x0

ag.port.nsfporttopo.26:0x0

ag.port.nsfporttopo.27:0x0

ag.port.nsfporttopo.28:0x0

ag.port.nsfporttopo.29:0x0

ag.port.nsfporttopo.3:0x0

ag.port.nsfporttopo.30:0x0

ag.port.nsfporttopo.31:0x0

ag.port.nsfporttopo.32:0x0

ag.port.nsfporttopo.33:0x0

ag.port.nsfporttopo.34:0x0

ag.port.nsfporttopo.35:0x0

ag.port.nsfporttopo.36:0x0

ag.port.nsfporttopo.37:0x0

ag.port.nsfporttopo.38:0x0

ag.port.nsfporttopo.39:0x0

ag.port.nsfporttopo.4:0x0

ag.port.nsfporttopo.40:0x0

ag.port.nsfporttopo.41:0x0

ag.port.nsfporttopo.42:0x0

ag.port.nsfporttopo.43:0x0

ag.port.nsfporttopo.44:0x0

ag.port.nsfporttopo.45:0x0

ag.port.nsfporttopo.46:0x0

ag.port.nsfporttopo.47:0x0

ag.port.nsfporttopo.5:0x0

ag.port.nsfporttopo.6:0x0

ag.port.nsfporttopo.7:0x0

ag.port.nsfporttopo.8:0x0

ag.port.nsfporttopo.9:0x0

alpaList:1

audit.cfg.class:10,

audit.cfg.severity:4

audit.cfg.state:0

auth.policy:0

auth.policy.dev:3

cer.internal_port_code:1

cipher.https:!ECDH:!DH:HIGH:-MD5:!CAMELLIA:!SRP:!PSK:!AESGCM

cipher.ssh:3des-cbc,aes128-cbc,aes192-cbc,aes256-cbc

fabric.domain:3

fabric.dport.onDemand:0

fabric.dynamic_dport_feature:1

fabric.ficonmode:0

fabric.fidcheckdisable:0

fabric.hifmode:0

fabric.ididmode:0

fabric.name:

fabric.npivProbeMode:0

fabric.nport_10bit_upd_scn:0

fabric.ops.BBCredit:16

fabric.ops.E_D_TOV:2000

fabric.ops.R_A_TOV:10000

fabric.ops.bladeFault_on_hwErrlevel:0

fabric.ops.dataFieldSize:2112

fabric.ops.max_hops:7

fabric.ops.mode.fcpProbeDisable:0

fabric.ops.mode.isolate:0

fabric.ops.mode.longDistance:0

fabric.ops.mode.noClassF:0

fabric.ops.mode.pidFormat:1

fabric.ops.mode.tachyonCompat:0

fabric.ops.mode.unicastOnly:0

fabric.ops.mode.useCsCtl:0

fabric.ops.vc.class.2:2

fabric.ops.vc.class.3:3

fabric.ops.vc.config:0xc0

fabric.ops.vc.linkCtrl:0

fabric.ops.vc.multicast:7

fabric.ops.wan_tov:0

fabric.principalSwSelMode:0

fabric.rdp_poll_cycle:0

fabric.remoteFosexec:0

fabric.wwnPidMode:0

fc4.fcp.productId:FC Switch

fc4.fcp.vendorId:BROCADE

fcAL.alwaysSendRSCN:0

fcAL.fanFrameDisable:0

fcAL.openSendCLS:4

fcAL.useAltBBCredit:0

fdd.acceptcfg.auth:1

fdd.acceptcfg.dcc:1

fdd.acceptcfg.fcs:1

fdd.acceptcfg.ipf:1

fdd.acceptcfg.pwd:1

fdd.acceptcfg.scc:1

fdd.fabwidecfg:

fdd.hash.dcc:0

fdd.hash.fbw:0

fdd.hash.fcs:0

fdd.hash.pwd:0

fdd.hash.scc:0

fdd.hashpresent.dcc:0

fdd.hashpresent.fbw:0

fdd.hashpresent.fcs:0

fdd.hashpresent.pwd:0

fdd.hashpresent.scc:0

featuredb.status:1

ficu.DHBsize:0

ficu.EBCDICcodePage:37

ficu.MIHPTO:180

ficu.faf.hdata:0

ficu.faf.keyctr:0

ficu.faf.modereg:0

ficu.fmsmode:0

flannel.ops.frameColMethod:piling

flannel.ops.openBBCredit:4

gen.fabos:0

gen.zone:0

lsportCfg:0,0x10000000,0x40000000,0x0,0x0;1,0x10000000,0x40000000,0x0,0x0;2,0x10000000,0x40000000,0x0,0x0;3,0x10000000,0x40000000,0x0,0x0;4,0x10000000,0x40000000,0x0,0x0;5,0x10000000,0x40000000,0x0,0x0;6,0x10000000,0x40000000,0x0,0x0;7,0x10000000,0x40000000,0x0,0x0;8,0x10000000,0x40000000,0x0,0x0;9,0x10000000,0x40000000,0x0,0x0;10,0x10000000,0x40000000,0x0,0x0;11,0x10000000,0x40000000,0x0,0x0;12,0x10000000,0x40000000,0x0,0x0;13,0x10000000,0x40000000,0x0,0x0;14,0x1a000000,0x40000000,0x500000,0x0;15,0x1a000000,0x40000000,0x500000,0x0;16,0x10000000,0x40000000,0x0,0x0;17,0x10000000,0x40000000,0x0,0x0;18,0x10000000,0x40000000,0x0,0x0;19,0x10000000,0x40000000,0x0,0x0;20,0x10000000,0x40000000,0x0,0x0;21,0x10000000,0x40000000,0x0,0x0;22,0x10000000,0x40000000,0x0,0x0;23,0x10000000,0x40000000,0x0,0x0;

ms.PlatEnable:0

ms.TDEnable:0

ms.TolerantFBEnabled:0

ns.DomRscnToDevForSwChg.enable:0

ns.EndDeviceRscnFormat:1

oemLogo:0

perf.framemon.enabled:1

perf.framemon.names:scsi,scsiread,scsiwrite,scsirw,scsi2reserve,scsi3reserve,ip,abts,baacc

perf.framemon.num:9

perf.framemonc.abts:0|4,0xFF,0x81;12,0xFF,0x0;|0||

perf.framemonc.baacc:0|4,0xFF,0x84;12,0xFF,0x00;|0||

perf.framemonc.ip:0|12,0xFF,0x05;|0||

perf.framemonc.scsi:0|12,0xFF,0x08;|0||

perf.framemonc.scsi2reserve:0|12,0xFF,0x08;4,0xFF,0x06;40,0xFF,0x16,0x56;|0||

perf.framemonc.scsi3reserve:0|12,0xFF,0x08;4,0xFF,0x06;40,0xFF,0x5F;41,0xFF,0x01|0||

perf.framemonc.scsiread:0|12,0xFF,0x08;4,0xFF,0x06;40,0xFF,0x08,0x28;|0||

perf.framemonc.scsirw:0|12,0xFF,0x08;4,0xFF,0x06;40,0xFF,0x08,0x28,0x0A,0x2A;|0||

perf.framemonc.scsiwrite:0|12,0xFF,0x08;4,0xFF,0x06;40,0xFF,0x0A,0x2A;|0||

portCfg:0,0x10000000,0x40000000,0x0,0x0;1,0x10000000,0x40000000,0x0,0x0;2,0x10000000,0x40000000,0x0,0x0;3,0x10103000,0x40018000,0x0,0x0;4,0x10000000,0x40000000,0x0,0x0;5,0x10000000,0x40000000,0x0,0x0;6,0x10000000,0x40000000,0x0,0x0;7,0x10000000,0x40000000,0x0,0x0;8,0x10000000,0x40000000,0x0,0x0;9,0x10000000,0x40000000,0x0,0x0;10,0x10000000,0x40000000,0x0,0x0;11,0x10000000,0x40000000,0x0,0x0;12,0x10000000,0x40000000,0x0,0x0;13,0x10000000,0x40000000,0x0,0x0;14,0x1a000000,0x40000000,0x500000,0x0;15,0x1a000000,0x40000000,0x500000,0x0;16,0x10000000,0x40000000,0x0,0x0;17,0x10000000,0x40000000,0x0,0x0;18,0x10000000,0x40000000,0x0,0x0;19,0x10000000,0x40000000,0x0,0x0;20,0x10000000,0x40000000,0x0,0x0;21,0x10000000,0x40000000,0x0,0x0;22,0x10000000,0x40000000,0x0,0x0;23,0x10000000,0x40000000,0x0,0x0;

portCfgDisableReason.0:

portCfgDisableReason.1:

portCfgDisableReason.10:

portCfgDisableReason.11:

portCfgDisableReason.12:

portCfgDisableReason.13:

portCfgDisableReason.14:

portCfgDisableReason.15:

portCfgDisableReason.16:

portCfgDisableReason.17:

portCfgDisableReason.18:

portCfgDisableReason.19:

portCfgDisableReason.2:

portCfgDisableReason.20:

portCfgDisableReason.21:

portCfgDisableReason.22:

portCfgDisableReason.23:

portCfgDisableReason.3:

portCfgDisableReason.4:

portCfgDisableReason.5:

portCfgDisableReason.6:

portCfgDisableReason.7:

portCfgDisableReason.8:

portCfgDisableReason.9:

portDistance.3:100

portFrameSize.3:0

portLongdistOption.3:1

portNpivLimit:

quickLoop.holdOpenInit:0

quickLoop.noAlpaZero:0

quickLoop.peerWWN:00:00:00:00:00:00:00:00

quickLoop.portBitmap:0x0000000000000000

quickLoop.softInit:0

rasm.filter:5

rlsDisable:1

route.delayReroute:0

route.embeddedPortBcast:1

route.lossless:0

route.stickyRoutes:0

rpcd.callback.enabled:0

rpcd.callback.secret:secret

rpcd.enabled:1

rpcd.ssl.enabled:0

rte.intCostFactor:100

sec.fstov:5000

sec.mode:0

sec.versioStamp:

sec.versionStamp:0

secrpc.enabled:0

shell.delete:0

shell.quiet:0

sigmad.cfs:0x0

switch.defaultPortname:0

switch.domain_id_offset:96

switch.edgeHoldTime:220

switch.fdmiHostname:0

switch.interopMode:0

switch.largeEntry.cap:0

switch.login.enforce_login:0

switch.login.flogisPerSec:0

switch.login.freeFdiscs:0

switch.login.max_flogi_count:100

switch.login.stageInterval:0

switch.mcdtDefaultZone:0

switch.mcdtFabricMode:0

switch.mcdtSafeZone:0

switch.status.policy.ErrorPorts.down:0

switch.status.policy.ErrorPorts.marginal:0

switch.status.policy.Fans.down:2

switch.status.policy.Fans.marginal:1

switch.status.policy.FaultyPorts.down:6

switch.status.policy.FaultyPorts.marginal:2

switch.status.policy.Flash.down:0

switch.status.policy.Flash.marginal:1

switch.status.policy.MarginalPorts.down:6

switch.status.policy.MarginalPorts.marginal:2

switch.status.policy.MissingSFPs.down:0

switch.status.policy.MissingSFPs.marginal:0

switch.status.policy.PowerSupplies.down:1

switch.status.policy.PowerSupplies.marginal:1

switch.status.policy.Temperatures.down:2

switch.status.policy.Temperatures.marginal:1

switch.status.policy.percentage.ErrorPorts.down:0.00

switch.status.policy.percentage.ErrorPorts.marginal:0.00

switch.status.policy.percentage.FaultyPorts.down:25.00

switch.status.policy.percentage.FaultyPorts.marginal:8.33

switch.status.policy.percentage.MarginalPorts.down:25.00

switch.status.policy.percentage.MarginalPorts.marginal:8.33

switch.status.policy.percentage.MissingSFPs.down:0.00

switch.status.policy.percentage.MissingSFPs.marginal:0.00

switch.xisluse:0

thresh.alarmsfilter:1

thresh.cust.filter.abts.unit:Frame(s)

thresh.cust.filter.baacc.unit:Frame(s)

thresh.cust.filter.ip.unit:Frame(s)

thresh.cust.filter.scsi.unit:Frame(s)

thresh.cust.filter.scsi2reserve.unit:Frame(s)

thresh.cust.filter.scsi3reserve.unit:Frame(s)

thresh.cust.filter.scsiread.unit:Frame(s)

thresh.cust.filter.scsirw.unit:Frame(s)

thresh.cust.filter.scsiwrite.unit:Frame(s)

thresh.filterabts.actLevel:1

thresh.filterabts.thLevel:1

thresh.filterbaacc.actLevel:1

thresh.filterbaacc.thLevel:1

thresh.filterip.actLevel:1

thresh.filterip.thLevel:1

thresh.filterscsi.actLevel:1

thresh.filterscsi.thLevel:1

thresh.filterscsi2reserve.actLevel:1

thresh.filterscsi2reserve.thLevel:1

thresh.filterscsi3reserve.actLevel:1

thresh.filterscsi3reserve.thLevel:1

thresh.filterscsiread.actLevel:1

thresh.filterscsiread.thLevel:1

thresh.filterscsirw.actLevel:1

thresh.filterscsirw.thLevel:1

thresh.filterscsiwrite.actLevel:1

thresh.filterscsiwrite.thLevel:1

thresh.monitoring.brcdsfp:0

ts.clockServer:100.100.0.150

ts.clockServerIndex:-1

ts.clockServerIndexList:-1

ts.clockServerList:100.100.0.150

xlativeModeDisable:0

zoning.check.nodeNameDisabled:0

zoning.conOpenTransDet:1

zoning.standardMode:0

zoning.targetPeerZoning:0

[Bottleneck Configuration]

bottleneck.enabled:0

[NP Configuration]

[FCOE_SW_CONF]

[Zoning]

cfg.std_cfg:esxi0001_vmhba1__DX60_CM0_P1;esxi0001_vmhba1__DX60_CM1_P0;esxi0002_vmhba1__DX60_CM0_P1;esxi0002_vmhba1__DX60_CM1_P0;esxi0003_vmhba1__DX60_CM0_P1;esxi0003_vmhba1__DX60_CM1_P0;esxi0004_vmhba1_DX60_CM0_P1;esxi0004_vmhba1_DX60_CM1_P0;esxi0005_vmhba1_DX60_CM0_P1;esxi0005_vmhba1_DX60_CM1_P0;SAN01_CM1_CA1_P1__SAN02_CM1_CA1_P1_REC;esxi0001_vmhba1__SAN01_CM0_CA0_P1;esxi0002_vmhba1__SAN01_CM0_CA0_P1;esxi0003_vmhba1__SAN01_CM0_CA0_P1;esxi0004_vmhba1__SAN01_CM0_CA0_P1;esxi0005_vmhba1__SAN01_CM0_CA0_P1;esxi0001_vmhba1__SAN01_CM1_CA0_P0;esxi0002_vmhba1__SAN01_CM1_CA0_P0;esxi0003_vmhba1__SAN01_CM1_CA0_P0;esxi0004_vmhba1__SAN01_CM1_CA0_P0;esxi0005_vmhba1__SAN01_CM1_CA0_P0;esxi0001_vmhba1_DX100FAL_CM0_CA0_P0;esxi0002_vmhba1_DX100FAL_CM0_CA0_P0;esxi0003_vmhba1_DX100FAL_CM0_CA0_P0;esxi0004_vmhba1_DX100FAL_CM0_CA0_P0;esxi0005_vmhba1_DX100FAL_CM0_CA0_P0;esxi0001_vmhba1_DX100FAL_CM1_CA0_P0;esxi0002_vmhba1_DX100FAL_CM1_CA0_P0;esxi0003_vmhba1_DX100FAL_CM1_CA0_P0;esxi0004_vmhba1_DX100FAL_CM1_CA0_P0;esxi0005_vmhba1_DX100FAL_CM1_CA0_P0;vrz_esxi0030_vmhba0__DX60_CM0_P1;vrz_esxi0030_vmhba0__DX60_CM1_P0;vrz_esxi0031_vmhba0__DX60_CM0_P1;vrz_esxi0031_vmhba0__DX60_CM1_P0;vrz_esxi0032_vmhba0__DX60_CM0_P1;vrz_esxi0032_vmhba0__DX60_CM1_P0;vrz_esxi0033_vmhba0__DX60_CM0_P1;vrz_esxi0033_vmhba0__DX60_CM1_P0;vrz_esxi0030_vmhba0__SAN01_CM0_CA0_P1;vrz_esxi0030_vmhba0__SAN01_CM1_CA0_P0;vrz_esxi0031_vmhba0__SAN01_CM0_CA0_P1;vrz_esxi0031_vmhba0__SAN01_CM1_CA0_P0;vrz_esxi0032_vmhba0__SAN01_CM0_CA0_P1;vrz_esxi0032_vmhba0__SAN01_CM1_CA0_P0;vrz_esxi0033_vmhba0__SAN01_CM0_CA0_P1;vrz_esxi0033_vmhba0__SAN01_CM1_CA0_P0;vrz_esxi0030_vmhba0__DX100FAL_CM0_CA0_P0;vrz_esxi0030_vmhba0__DX100FAL_CM1_CA0_P0;vrz_esxi0031_vmhba0__DX100FAL_CM0_CA0_P0;vrz_esxi0031_vmhba0__DX100FAL_CM1_CA0_P0;vrz_esxi0032_vmhba0__DX100FAL_CM0_CA0_P0;vrz_esxi0032_vmhba0__DX100FAL_CM1_CA0_P0;vrz_esxi0033_vmhba0__DX100FAL_CM0_CA0_P0;vrz_esxi0033_vmhba0__DX100FAL_CM1_CA0_P0

zone.SAN01_CM1_CA1_P1__SAN02_CM1_CA1_P1_REC:SAN02_CM1_CA1_P1;SAN01_CM1_CA1_P1

zone.esxi0001_vmhba1_DX100FAL_CM0_CA0_P0:DX100FAL_CM0_CA0_P0;esxi0001_vmhba1

zone.esxi0001_vmhba1_DX100FAL_CM1_CA0_P0:DX100FAL_CM1_CA0_P0;esxi0001_vmhba1

zone.esxi0001_vmhba1__DX60_CM0_P1:DX60_CM0_P1;esxi0001_vmhba1

zone.esxi0001_vmhba1__DX60_CM1_P0:DX60_CM1_P0;esxi0001_vmhba1

zone.esxi0001_vmhba1__SAN01_CM0_CA0_P1:esxi0001_vmhba1;SAN01_CM0_CA0_P1

zone.esxi0001_vmhba1__SAN01_CM1_CA0_P0:esxi0001_vmhba1;SAN01_CM1_CA0_P0

zone.esxi0002_vmhba1_DX100FAL_CM0_CA0_P0:DX100FAL_CM0_CA0_P0;esxi0002_vmhba1

zone.esxi0002_vmhba1_DX100FAL_CM1_CA0_P0:DX100FAL_CM1_CA0_P0;esxi0002_vmhba1

zone.esxi0002_vmhba1__DX60_CM0_P1:DX60_CM0_P1;esxi0002_vmhba1

zone.esxi0002_vmhba1__DX60_CM1_P0:DX60_CM1_P0;esxi0002_vmhba1

zone.esxi0002_vmhba1__SAN01_CM0_CA0_P1:esxi0002_vmhba1;SAN01_CM0_CA0_P1

zone.esxi0002_vmhba1__SAN01_CM1_CA0_P0:esxi0002_vmhba1;SAN01_CM1_CA0_P0

zone.esxi0003_vmhba1_DX100FAL_CM0_CA0_P0:DX100FAL_CM0_CA0_P0;esxi0003_vmhba1

zone.esxi0003_vmhba1_DX100FAL_CM1_CA0_P0:DX100FAL_CM1_CA0_P0;esxi0003_vmhba1

zone.esxi0003_vmhba1__DX60_CM0_P1:DX60_CM0_P1;esxi0003_vmhba1

zone.esxi0003_vmhba1__DX60_CM1_P0:DX60_CM1_P0;esxi0003_vmhba1

zone.esxi0003_vmhba1__SAN01_CM0_CA0_P1:esxi0003_vmhba1;SAN01_CM0_CA0_P1

zone.esxi0003_vmhba1__SAN01_CM1_CA0_P0:esxi0003_vmhba1;SAN01_CM1_CA0_P0

zone.esxi0004_vmhba1_DX100FAL_CM0_CA0_P0:DX100FAL_CM0_CA0_P0;esxi0004_vmhba1

zone.esxi0004_vmhba1_DX100FAL_CM1_CA0_P0:DX100FAL_CM1_CA0_P0;esxi0004_vmhba1

zone.esxi0004_vmhba1_DX60_CM0_P1:DX60_CM0_P1;esxi0004_vmhba1

zone.esxi0004_vmhba1_DX60_CM1_P0:DX60_CM1_P0;esxi0004_vmhba1

zone.esxi0004_vmhba1__SAN01_CM0_CA0_P1:esxi0004_vmhba1;SAN01_CM0_CA0_P1

zone.esxi0004_vmhba1__SAN01_CM1_CA0_P0:esxi0004_vmhba1;SAN01_CM1_CA0_P0

zone.esxi0005_vmhba1_DX100FAL_CM0_CA0_P0:DX100FAL_CM0_CA0_P0;esxi0005_vmhba1

zone.esxi0005_vmhba1_DX100FAL_CM1_CA0_P0:DX100FAL_CM1_CA0_P0;esxi0005_vmhba1

zone.esxi0005_vmhba1_DX60_CM0_P1:DX60_CM0_P1;esxi0005_vmhba1

zone.esxi0005_vmhba1_DX60_CM1_P0:DX60_CM1_P0;esxi0005_vmhba1

zone.esxi0005_vmhba1__SAN01_CM0_CA0_P1:esxi0005_vmhba1;SAN01_CM0_CA0_P1

zone.esxi0005_vmhba1__SAN01_CM1_CA0_P0:esxi0005_vmhba1;SAN01_CM1_CA0_P0

zone.vrz_esxi0030_vmhba0__DX100FAL_CM0_CA0_P0:vrz_esxi0030_vmhba0;DX100FAL_CM0_CA0_P0

zone.vrz_esxi0030_vmhba0__DX100FAL_CM1_CA0_P0:vrz_esxi0030_vmhba0;DX100FAL_CM1_CA0_P0

zone.vrz_esxi0030_vmhba0__DX60_CM0_P1:vrz_esxi0030_vmhba0;DX60_CM0_P1

zone.vrz_esxi0030_vmhba0__DX60_CM1_P0:vrz_esxi0030_vmhba0;DX60_CM1_P0

zone.vrz_esxi0030_vmhba0__SAN01_CM0_CA0_P1:vrz_esxi0030_vmhba0;SAN01_CM0_CA0_P1

zone.vrz_esxi0030_vmhba0__SAN01_CM1_CA0_P0:vrz_esxi0030_vmhba0;SAN01_CM1_CA0_P0

zone.vrz_esxi0031_vmhba0__DX100FAL_CM0_CA0_P0:vrz_esxi0031_vmhba0;DX100FAL_CM0_CA0_P0

zone.vrz_esxi0031_vmhba0__DX100FAL_CM1_CA0_P0:vrz_esxi0031_vmhba0;DX100FAL_CM1_CA0_P0

zone.vrz_esxi0031_vmhba0__DX60_CM0_P1:vrz_esxi0031_vmhba0;DX60_CM0_P1

zone.vrz_esxi0031_vmhba0__DX60_CM1_P0:vrz_esxi0031_vmhba0;DX60_CM1_P0

zone.vrz_esxi0031_vmhba0__SAN01_CM0_CA0_P1:vrz_esxi0031_vmhba0;SAN01_CM0_CA0_P1

zone.vrz_esxi0031_vmhba0__SAN01_CM1_CA0_P0:vrz_esxi0031_vmhba0;SAN01_CM1_CA0_P0

zone.vrz_esxi0032_vmhba0__DX100FAL_CM0_CA0_P0:vrz_esxi0032_vmhba0;DX100FAL_CM0_CA0_P0

zone.vrz_esxi0032_vmhba0__DX100FAL_CM1_CA0_P0:vrz_esxi0032_vmhba0;DX100FAL_CM1_CA0_P0

zone.vrz_esxi0032_vmhba0__DX60_CM0_P1:vrz_esxi0032_vmhba0;DX60_CM0_P1

zone.vrz_esxi0032_vmhba0__DX60_CM1_P0:vrz_esxi0032_vmhba0;DX60_CM1_P0

zone.vrz_esxi0032_vmhba0__SAN01_CM0_CA0_P1:vrz_esxi0032_vmhba0;SAN01_CM0_CA0_P1

zone.vrz_esxi0032_vmhba0__SAN01_CM1_CA0_P0:vrz_esxi0032_vmhba0;SAN01_CM1_CA0_P0

zone.vrz_esxi0033_vmhba0__DX100FAL_CM0_CA0_P0:vrz_esxi0033_vmhba0;DX100FAL_CM0_CA0_P0

zone.vrz_esxi0033_vmhba0__DX100FAL_CM1_CA0_P0:vrz_esxi0033_vmhba0;DX100FAL_CM1_CA0_P0

zone.vrz_esxi0033_vmhba0__DX60_CM0_P1:vrz_esxi0033_vmhba0;DX60_CM0_P1

zone.vrz_esxi0033_vmhba0__DX60_CM1_P0:vrz_esxi0033_vmhba0;DX60_CM1_P0

zone.vrz_esxi0033_vmhba0__SAN01_CM0_CA0_P1:vrz_esxi0033_vmhba0;SAN01_CM0_CA0_P1

zone.vrz_esxi0033_vmhba0__SAN01_CM1_CA0_P0:vrz_esxi0033_vmhba0;SAN01_CM1_CA0_P0

alias.DX100FAL_CM0_CA0_P0:50:00:00:e0:da:76:a0:20

alias.DX100FAL_CM1_CA0_P0:50:00:00:e0:da:76:a0:30

alias.DX60_CM0_P1:50:00:00:e0:d0:1d:ca:07

alias.DX60_CM1_P0:50:00:00:e0:d0:1d:ca:86

alias.SAN01_CM0_CA0_P1:50:00:00:e0:da:04:55:21

alias.SAN01_CM0_CA1_P0:50:00:00:e0:da:04:55:24

alias.SAN01_CM1_CA0_P0:50:00:00:e0:da:04:55:30

alias.SAN01_CM1_CA1_P1:50:00:00:e0:da:04:55:35

alias.SAN02_CM1_CA1_P1:50:00:00:e0:da:20:94:35

alias.esxi0001_vmhba1:21:00:00:24:ff:0b:cb:76

alias.esxi0002_vmhba1:21:00:00:24:ff:0d:dc:09

alias.esxi0003_vmhba1:21:00:00:24:ff:0e:6f:ae

alias.esxi0004_vmhba1:21:00:00:24:ff:0e:aa:4d

alias.esxi0005_vmhba1:21:00:00:24:ff:0e:aa:63

alias.vrz_esxi0030_vmhba0:20:00:00:25:b5:ab:a0:03

alias.vrz_esxi0031_vmhba0:20:00:00:25:b5:ab:a0:02

alias.vrz_esxi0032_vmhba0:20:00:00:25:b5:ab:a0:01

alias.vrz_esxi0033_vmhba0:20:00:00:25:b5:ab:a0:00

defzone:allaccess

enable:std_cfg

[Defined Security policies]

[Active Security policies]

[iSCSI]

[cryptoDev]

[FICU SAVED FILES]

[VS_SW_CONF]

vs.hdr:01abcdef000000010000000000000068

vs.num_entries:0

[MAPS CONFIG DB]

maps.enabled:0

[Banner]

[End]

[Switch Configuration End : 0]Für mich stellt sich aktuell einfach die primäre Frage:

Ist Fibre Channel noch state of the art?

Macht es wirtschaftlich gesehen Sinn die Systeme weiter zu betreiben oder sollte ich Sie einfach abschalten und dem E-Schrott zufügen?

Gibt es ggf. einen Dienstleister in der Region Hannover der sich mit den Systemen "Cisco HyperFlex, Cisco UCS, Fujitu DX Storage, VMware und FibreChannel & Brocade 300 auskennt, den ihr empfehlen könnt?

Ich bedanke mich ganz herzlich für das lesen und hoffe, dass diese Frage nicht zu einer "Freitagsfrage" wird.

Freundlichen Grüße!

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 4049427474

Url: https://administrator.de/forum/fibrechannel-vmware-esx-und-cisco-ucs-4049427474.html

Ausgedruckt am: 31.07.2025 um 07:07 Uhr

9 Kommentare

Neuester Kommentar

Wenn du mit den 8GBit Ports der Brocade 300 hinkommst, dann ist das gute Hardware.

Du musst das Zoning erweitern, dass deine neue Hardware Zugang zu den Zones bekommt.

Oder ein bissl Hardware abklemmen, dass Ports in den Zonen frei wird.

Dann mit einem unlizensierten ESXI die VMs bewegen.

Du musst das Zoning erweitern, dass deine neue Hardware Zugang zu den Zones bekommt.

Oder ein bissl Hardware abklemmen, dass Ports in den Zonen frei wird.

Dann mit einem unlizensierten ESXI die VMs bewegen.

Switch auf Switch geht, kann aber besondere Bedingungen haben.

Das Zoning aus der Konfig verstehst Du?

Das Zoning aus der Konfig verstehst Du?

Den Brocade musst du ja auch nicht verändern, sondern das Zoning am Cisco adaptieren, dass deine HBAs die WWPN und LUNs sehen kann.

Konzentriere dich auf das Cisco Switch und gucke erstmal ob du GBics hast die einen Link bekommen.

Konzentriere dich auf das Cisco Switch und gucke erstmal ob du GBics hast die einen Link bekommen.

Es sieht ja so aus als wäre alles vorher mit zwei Pfaden gelaufen.

Wenn deine Hosts alle ein richtig konfiguriertes MPIO haben, kannst du jeweils ein patchkabel abmachen und hast somit direkten Zugang zu jeder Zone, ohne dass etwas passiert und die Maschinen können weiterlaufen.

Dazu muss allerdings das MPIO richtig laufen.

Wenn deine Hosts alle ein richtig konfiguriertes MPIO haben, kannst du jeweils ein patchkabel abmachen und hast somit direkten Zugang zu jeder Zone, ohne dass etwas passiert und die Maschinen können weiterlaufen.

Dazu muss allerdings das MPIO richtig laufen.

Eine Sache noch. Die Pfade zu den neuen Ciscos dürfen keine Schreibzugriffe machen auf die LUNs.

Hast du ggf. ein brauchbares Manual für mich?

broadcom.com/support/fibre-channel-networkingDurch den Aufkauf von Brocade durch Broadcom sind alle Brocade FC Dokus usw. dort gelandet. Dort findest du auch das Handbuch zu deiner FOS Version zum Download.

Alternativ auch bei den OEM Verkäufern von Brocade wie Dell, HP, IBMn NetApp usw.