Grafikkartenzuweisung zu einer Hyper-V-VM 2016 vs 2019

Moin.

Ich hoffe hier Leute zu finden, die Direct Device Assignment erfolgreich durchgeführt haben und derzeit nutzen. Wenn Ihr das nicht nutzt, wartet doch zumindest mit Euren Kommentaren bitte ein wenig ab. Ich selbst habe herade erst meine Tests abgeschlossen und die Resultate sind verwirrend.

Serverboard: Supermicro X10-SRA-f (onboard-Grafik vorhanden)

Grafikkarte: Nvidia Quadro K4000

Test1: Hyper-V sowie Gast-OS: 2019 Server

Test2: Hyper-V sowie Gast-OS: 2016 Server

Bei Test1 kann ich die VM nicht einmal dazu überreden, mit der zugewiesenen Karte überhaupt zu starten. Nach erfolgreicher Zuweisung behauptet die VM beim Start

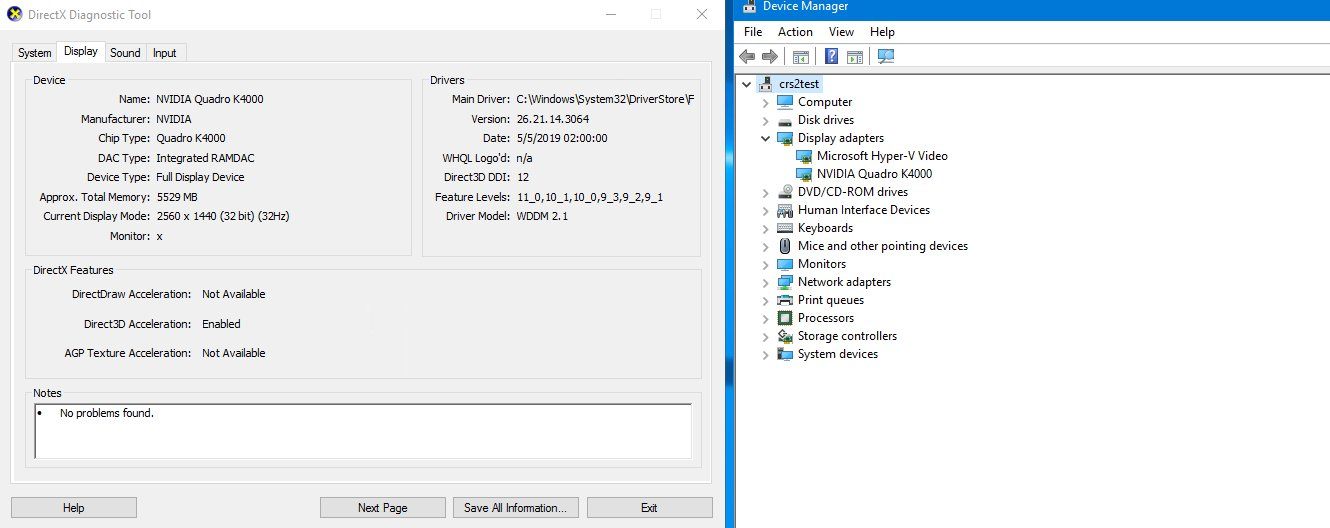

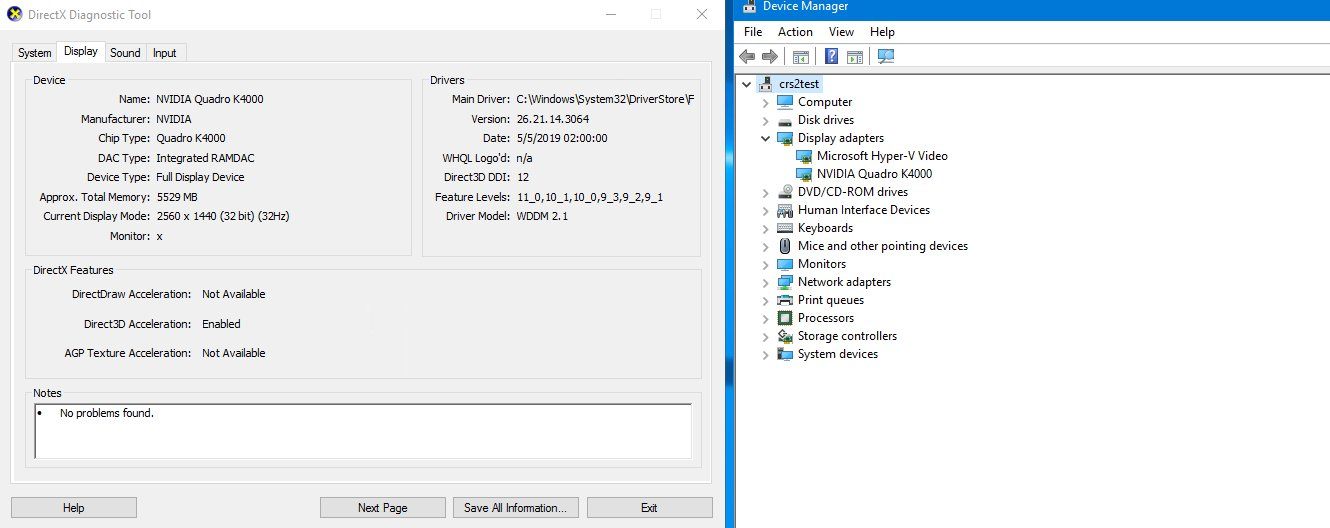

Bei Test2 kann ich immerhin sagen, dass es kurzzeitig geht: Ich weise die Karte zu, ich installiere sie in der Gast VM, das Quadro-Treibersetup fordert zum Neustart auf und danach zeigt sich folgendes Bild im Gast:

Soweit so gut.

Soweit so gut.

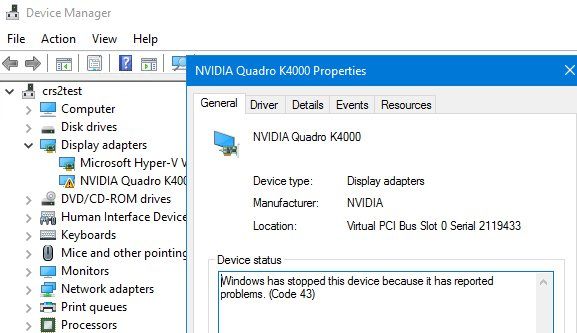

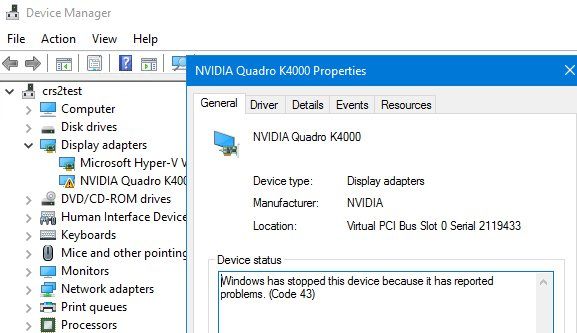

Nach dem zweiten Reboot der VM jedoch, startet der Treiber der Karte nicht mehr:

Das verwirrte mich so sehr, dass ich den Krempel neu aufgesetzt habe - mit dem selben Ergebnis. Zweiter Reboot nach der Treiberinstallation im Gast - Karte mag nicht mehr.

Was haltet Ihr davon?

Ich hoffe hier Leute zu finden, die Direct Device Assignment erfolgreich durchgeführt haben und derzeit nutzen. Wenn Ihr das nicht nutzt, wartet doch zumindest mit Euren Kommentaren bitte ein wenig ab. Ich selbst habe herade erst meine Tests abgeschlossen und die Resultate sind verwirrend.

Serverboard: Supermicro X10-SRA-f (onboard-Grafik vorhanden)

Grafikkarte: Nvidia Quadro K4000

Test1: Hyper-V sowie Gast-OS: 2019 Server

Test2: Hyper-V sowie Gast-OS: 2016 Server

Bei Test1 kann ich die VM nicht einmal dazu überreden, mit der zugewiesenen Karte überhaupt zu starten. Nach erfolgreicher Zuweisung behauptet die VM beim Start

Could not allocate the PCI Express device with the Plug and Play Device Instance path 'PCIP\10DE 11FA&SUBSYS....' because it is already in use by another VM.

was lustig ist, denn dieser Hypervisor hat jemals nur diese eine VM gehabt und auf der Powershell wird die Karte als dieser VM zugehörig gelistet.Bei Test2 kann ich immerhin sagen, dass es kurzzeitig geht: Ich weise die Karte zu, ich installiere sie in der Gast VM, das Quadro-Treibersetup fordert zum Neustart auf und danach zeigt sich folgendes Bild im Gast:

Nach dem zweiten Reboot der VM jedoch, startet der Treiber der Karte nicht mehr:

Das verwirrte mich so sehr, dass ich den Krempel neu aufgesetzt habe - mit dem selben Ergebnis. Zweiter Reboot nach der Treiberinstallation im Gast - Karte mag nicht mehr.

Was haltet Ihr davon?

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 456399

Url: https://administrator.de/forum/grafikkartenzuweisung-zu-einer-hyper-v-vm-2016-vs-2019-456399.html

Ausgedruckt am: 17.07.2025 um 07:07 Uhr

19 Kommentare

Neuester Kommentar

Ist schon eine Weile her . Hab aber noch meine Notizen von damals gefunden . Weiß aber gerade nicht , ob das der letzte Stand war.

______________________________________________

Neue VM erstellen und ausgeschaltet lassen.

Automatische Stopaktion ausschalten auf virtuellen Computer ausschalten stellen

Hardware Deaktivieren im Gerätemanager

Geräteinstanzpfad für das deaktivierte Gerät raussuchen und folgenden Befehl verwenden:

Disable-Pnpdevice -InstanceID "PCI\VEN_10DE&DEV_13F2&SUBSYS_115E10DE&REV_A1\6&F0CE26E&0&00800000"

$LocationPath = (Get-PnpDeviceProperty -KeyName DEVPKEY_Device_LocationPaths -InstanceId "PCI\VEN_10DE&DEV_13F2&SUBSYS_115E10DE&REV_A1\6&F0CE26E&0&00800000").Data

Dismount-VMHostAssignableDevice -LocationPath $LocationPath -Force -Verbose

Get-VMHostAssignableDevice

Locationpath notieren :

Set-VM VMNAME -GuestControlledCacheTypes $true

Set-VM VMNAME -GuestControlledCacheTypes $True -LowMemoryMappedIoSpace 2000MB -HighMemoryMappedIoSpace 4000MB

Get-VM VMNAME | fl *

Add-VMAssignableDevice -LocationPath "PCIROOT(3A)#PCI(0000)#PCI(0000)#PCI(1000)#PCI(0000)" -VMName VMNAME

_______________________________________________________

Gibt Dein Server Hersteller denn den Server für GPU Pass-Through durch . Das kann nämlich nicht jeder.

thomas-krenn.com/de/wiki/Virtualisierungsfunktion_SR-IOV_aktivie ...

Gruss

______________________________________________

Neue VM erstellen und ausgeschaltet lassen.

Automatische Stopaktion ausschalten auf virtuellen Computer ausschalten stellen

Hardware Deaktivieren im Gerätemanager

Geräteinstanzpfad für das deaktivierte Gerät raussuchen und folgenden Befehl verwenden:

Disable-Pnpdevice -InstanceID "PCI\VEN_10DE&DEV_13F2&SUBSYS_115E10DE&REV_A1\6&F0CE26E&0&00800000"

$LocationPath = (Get-PnpDeviceProperty -KeyName DEVPKEY_Device_LocationPaths -InstanceId "PCI\VEN_10DE&DEV_13F2&SUBSYS_115E10DE&REV_A1\6&F0CE26E&0&00800000").Data

Dismount-VMHostAssignableDevice -LocationPath $LocationPath -Force -Verbose

Get-VMHostAssignableDevice

Locationpath notieren :

Set-VM VMNAME -GuestControlledCacheTypes $true

Set-VM VMNAME -GuestControlledCacheTypes $True -LowMemoryMappedIoSpace 2000MB -HighMemoryMappedIoSpace 4000MB

Get-VM VMNAME | fl *

Add-VMAssignableDevice -LocationPath "PCIROOT(3A)#PCI(0000)#PCI(0000)#PCI(1000)#PCI(0000)" -VMName VMNAME

_______________________________________________________

Gibt Dein Server Hersteller denn den Server für GPU Pass-Through durch . Das kann nämlich nicht jeder.

thomas-krenn.com/de/wiki/Virtualisierungsfunktion_SR-IOV_aktivie ...

Gruss

Zitat von @DerWoWusste:

SR-IOV ist aktiv.

Welche Karte nutzt Du? Die ID müsste eine Tesla M60 sein, stimmt's?

SR-IOV ist aktiv.

Welche Karte nutzt Du? Die ID müsste eine Tesla M60 sein, stimmt's?

Ja sind Tesla M60 Karten die wir nutzen .

Zitat von @DerWoWusste:

Ok, auf Server 2019 das selbe Problem wie auf 2016!

Win10 als Gast, geht.

Server OS als Gast: geht nicht.

Was sagt uns das, Microsoft?

Keine Ahnung, warum die Server OS' da anspruchsvoller sind (nach dem 2. Reboot )

)

Ok, auf Server 2019 das selbe Problem wie auf 2016!

Win10 als Gast, geht.

Server OS als Gast: geht nicht.

Was sagt uns das, Microsoft?

Keine Ahnung, warum die Server OS' da anspruchsvoller sind (nach dem 2. Reboot

Doofe Frage , aber du hast schon den Treiber für Server genommen ?

Hast du das Problem auch mit dem Standardtreiber von Windows ?

Gruss

Zitat von @DerWoWusste:

Kommen wir mal zur simplen Frage an alle:

Mit welcher Kombination von Host-OS, Gast-OS und Grafikkarte läuft es bei Euch?

Kommen wir mal zur simplen Frage an alle:

Mit welcher Kombination von Host-OS, Gast-OS und Grafikkarte läuft es bei Euch?

2016/2016 + Tesla M60.

Zitat von @DerWoWusste:

Interessant. Und irgendwas, was bei Dir anders sein könnte als bei mir, Core-OS als Hypervisor, anderer Build als 1607...?

Interessant. Und irgendwas, was bei Dir anders sein könnte als bei mir, Core-OS als Hypervisor, anderer Build als 1607...?

Meine Server sind für den Aufbau freigegeben und seitens des Herstellers freigegeben.

Entweder du prüfst deine Voraussetzungen selbst. Oder du wendest dich an den Hersteller.

Die Hardware muss eben ein paar spezielle Sachen hören . Den MS Link hatte ich weiter oben ja schon gepostet .

Gruss

Zitat von @itisnapanto:

Zitat von @DerWoWusste:

Ok, auf Server 2019 das selbe Problem wie auf 2016!

Win10 als Gast, geht.

Server OS als Gast: geht nicht.

Ok, auf Server 2019 das selbe Problem wie auf 2016!

Win10 als Gast, geht.

Server OS als Gast: geht nicht.

viellicht kann das auch einfach der Grafiktreiber im Gast nicht oder es ist dort aktiv deaktiviert... wenn es ein Server-Gast ist und eine Karte die nur per Zufall für sowas geeignet ist weil zufällig ein artverwandter oder fast identischer Graphikchip drauf ist den auch für sowas zertifizierte Karten haben. Ich kenn des schon von GTX 690 Karten, bei denen das nur wuppte wenn man die durch das Umlöten von vier SMD Wiederständen zu einer Grid K2 oder zu einer Tesla gemacht hat. Wobei die Tesla Variante den Vorteil hat daß die DVI und sonstigen Ausgänge im Betrieb mit einer physischen Umgebung weiterhin nutzbar sind, die K2 nicht.

Mit einer GTX 660 hatte ich sowas (DDA) auch mal am Laufen bis am Tag X ein Fragezeichen im Gerätemanager meine Bemühungen zunichte gemacht hat. Und da sucht man sich dann tot und erhält auch von niemandem Support.