Neustrukturierung VDI - 230 Virtuelle Desktops mit vGPU

Hallo zusammen,

nachdem wir nun Storage-seitig und SAN-seitig die Weichen gestellt haben (es ist eine Alletra MP Block geworden, angebunden per QSFP28 an 100 G SAN-CoreSwitch), wollte ich mich mit euch austauschen, wie eure Mienung bzgl. der VDI ist, dessen Storage die Alletra MP stellt.

IST-Situation:

Windows Domäne, hybrid. Server 2019 mit Hyper-V und darüber stellen wir mehrere Terminalserver mit Tesla-Karten (von M60 über V100 und RTX 6000) und GPU-Passtrough (bei M60 eher witzlos, da "verfällt" eine GPU pro M60 Karte) für unsere User zur Verfügung. M365 E3-Plan.

SOLL-Szenario:

Das ist eher semi-performant, ein vGPU-Szenario mit nvidia vWS oder vPC-Lizenzierung mit einzelnen VMs für jeden einzelnen User, ist performanter. Zudem wird der Support für Office auf TS in Server 2019er wohl eingestellt werden.

Folgende Kriterien:

- 230 VMs mit Windows 11

- davon sollen ca. 150 für 3D genutzt werden, insbesondere Revit. Keine AI-Berechnungen oder ähnliches, reines 3D und Rendering (ja, es gibt welche, die CPU-lastig sind und andere die GPU-lastig sind)

Fragen:

- Die nvidia GRID Server, für mehrere VMs, ca. 16 pro Server, L40 oder L4 Karten? Anzahl? RAM und CPUs für die Hosts sind erstmal kein Thema, das muss dementsprechend ausgelegt sein, 25G Netzwerkkarte.

- Sizing und Lizenzierung Workstations: vWS oder vPC für die virtuellen Workstations die Revit, 3D und Rendering übernehmen? RAM 32 GB, 500 GB Storage (Cachen von Gebäudemodellen etc.), 8-16 CPU Cores, vGPU Profile um die 8 GB

- Sizing: für die virtuellen Office VMs: RAM 8-16 GB, 500 GB Storage, 4-8 CPU Cores, keine vGPU

- Ach, und auch mal interessehalber, da es bei uns in der Abteilung heisse Diskussionen gab: Server 2025 Hyper-V mit GPU-P eine Option und über z.B. Citrix veröffentlichen? Oder lieber XenServer, statt Hyper-V?

Falls ich Angaben vergessen haben sollte, bitte darauf hinweisen, dann lege ich nach!

Viele Grüße und ein Danke!

nachdem wir nun Storage-seitig und SAN-seitig die Weichen gestellt haben (es ist eine Alletra MP Block geworden, angebunden per QSFP28 an 100 G SAN-CoreSwitch), wollte ich mich mit euch austauschen, wie eure Mienung bzgl. der VDI ist, dessen Storage die Alletra MP stellt.

IST-Situation:

Windows Domäne, hybrid. Server 2019 mit Hyper-V und darüber stellen wir mehrere Terminalserver mit Tesla-Karten (von M60 über V100 und RTX 6000) und GPU-Passtrough (bei M60 eher witzlos, da "verfällt" eine GPU pro M60 Karte) für unsere User zur Verfügung. M365 E3-Plan.

SOLL-Szenario:

Das ist eher semi-performant, ein vGPU-Szenario mit nvidia vWS oder vPC-Lizenzierung mit einzelnen VMs für jeden einzelnen User, ist performanter. Zudem wird der Support für Office auf TS in Server 2019er wohl eingestellt werden.

Folgende Kriterien:

- 230 VMs mit Windows 11

- davon sollen ca. 150 für 3D genutzt werden, insbesondere Revit. Keine AI-Berechnungen oder ähnliches, reines 3D und Rendering (ja, es gibt welche, die CPU-lastig sind und andere die GPU-lastig sind)

Fragen:

- Die nvidia GRID Server, für mehrere VMs, ca. 16 pro Server, L40 oder L4 Karten? Anzahl? RAM und CPUs für die Hosts sind erstmal kein Thema, das muss dementsprechend ausgelegt sein, 25G Netzwerkkarte.

- Sizing und Lizenzierung Workstations: vWS oder vPC für die virtuellen Workstations die Revit, 3D und Rendering übernehmen? RAM 32 GB, 500 GB Storage (Cachen von Gebäudemodellen etc.), 8-16 CPU Cores, vGPU Profile um die 8 GB

- Sizing: für die virtuellen Office VMs: RAM 8-16 GB, 500 GB Storage, 4-8 CPU Cores, keine vGPU

- Ach, und auch mal interessehalber, da es bei uns in der Abteilung heisse Diskussionen gab: Server 2025 Hyper-V mit GPU-P eine Option und über z.B. Citrix veröffentlichen? Oder lieber XenServer, statt Hyper-V?

Falls ich Angaben vergessen haben sollte, bitte darauf hinweisen, dann lege ich nach!

Viele Grüße und ein Danke!

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 669970

Url: https://administrator.de/forum/neustrukturierung-vdi-230-virtuelle-desktops-mit-vgpu-669970.html

Ausgedruckt am: 26.07.2025 um 13:07 Uhr

24 Kommentare

Neuester Kommentar

Moin,

Terminalserver bzw. RDS ist klassisch erst einmal keine VDI. Höchstens du sprichst von der expliziten Rolle. Was ich aber auf Grund deiner Beschreibung aktuell nicht glaube. Platzhirsch ist Citrix und Ommissa (ehemals VMware). Davon lese ich nichts...

Abgesehen davon hast du dann x Server. Wobei du noch Wartungsarbeiten/Ausfall eines Servers einkalkulieren solltest. Weil die Wartung kommt.... monatlich.

Genug geschwafelt.. es gibt von mir zu dem Thema VDI mehrere ausführliche Kommentare. Welche nach wie vor ihre Gültigkeit haben. Bitte die Suche des Forums benutzen.

Gruß,

Dani

Terminalserver bzw. RDS ist klassisch erst einmal keine VDI. Höchstens du sprichst von der expliziten Rolle. Was ich aber auf Grund deiner Beschreibung aktuell nicht glaube. Platzhirsch ist Citrix und Ommissa (ehemals VMware). Davon lese ich nichts...

Ach, und auch mal interessehalber, da es bei uns in der Abteilung heisse Diskussionen gab: Server 2025 Hyper-V mit GPU-P eine Option und über z.B. Citrix veröffentlichen?

Sorry, aber wo ist der IT Architekt, der die Umgebung plant und fortschreibt? Hört sich für mich so an, als hätten alle ein bisschen Basiswissen, ihre Vorlieben, aber von VDI wie man sie kennt keine praktische Erfahrung = gefährliches Halbwissen.Oder lieber XenServer, statt Hyper-V?

Naja, XenServer ist nichts anderes wie der Hypervisor, z.B. ESXi. In beiden Fällen hast du nach Definition noch keine VDI. Sondern erst mit dem entsprechenden Produkten. Wie soll denn sonst die Verwaltung, Orchestrierung ,etc. erfolgen bzw. seine Stärke ausspielen?Zudem wird der Support für Office auf TS in Server 2019er wohl eingestellt werden.

Das ist dein kleinstes Problem. Die Lizenzierung von Windows, Office, etc. wird in einer VDI nochmals komplexer, wie sie bereits schon ist. Da solltest du das notwendige Kleingeld zur Seite legen.- Sizing und Lizenzierung Workstations: vWS oder vPC für die virtuellen Workstations die Revit, 3D und Rendering übernehmen? RAM 32 GB, 500 GB Storage (Cachen von Gebäudemodellen etc.), 8-16 CPU Cores, vGPU Profile um die 8 GB

Wie kommst du auf die Werte? Habt ihr mal eine Modellrechnung für 150 bzw. 230 VMs angestrebt. Gerade auf die CPU Kerne zu beachten, dass jeder VDI Hersteller hier klare Überbuchunglimits hat und diese auch zu berücksichtigen sind. Beim RAM wird es noch schlimmer... da kannst du eigentlich gar nicht überbuchen.Abgesehen davon hast du dann x Server. Wobei du noch Wartungsarbeiten/Ausfall eines Servers einkalkulieren solltest. Weil die Wartung kommt.... monatlich.

Die nvidia GRID Server, für mehrere VMs, ca. 16 pro Server, L40 oder L4 Karten?

Welche Kartentyp hängt doch von den Anforderungen der Software ab und damit auch die Limitierung der Serverhardware. Du bekommst nicht in jedes Servermodell die gleiche Anzahl von GRID Karten rein. Da gibt es von Hersteller zu Hersteller unterschiede. Damit einher variiert auch die Anzahl der VMs pro Server und damit auch die Gesamtanzahl der Server.Genug geschwafelt.. es gibt von mir zu dem Thema VDI mehrere ausführliche Kommentare. Welche nach wie vor ihre Gültigkeit haben. Bitte die Suche des Forums benutzen.

Gruß,

Dani

Moin,

Mit Windows Server 2019/2022 wird vGPU unterstützt, aber nach wie vor keine Live Migration von Hypervisor A auf B. Was bei einer VDI doch elementar wichtig ist. Genauso ist IO-SRV unabdingbar für die Nutzung. Sprich die Hardware muss das supporten.

Unsere Umgebung ist keinster weise ein Referenz für euch. Baut einen PoC auf, definiert eure Anforderungen und Rahmenbedingungen, testet die Produkte der drei Hersteller durch, bewertet diese und trefft dann eine fundierte Entscheidung.

Gruß,

Dani

Nun nochmal meine Frage an dich Dani, hast du Erfahrungen mit Server 2025 und GPU-P und L4 oder L40/L40S Karten für oben genannte Fragestellung und Anforderungen an die virtuellen Desktops.

nein. Kommt mir auch nichts in Haus. Haben schon genug Probleme mit Microsoft Produkten in anderen Bereichen. Das (VDI) muss bei uns 24/7 laufen und im Fehlerfall benötige ich einen Support von Hersteller der schnell, agil ist. Weil ein Ausfall der VDI bzw. Teile davon kostet uns Arbeitszeit und damit auch Geld. Dazu sei gesagt, dass wir über Microsoft Premier Support verfügen und kommt trotzdem nicht an VMware/Broadcom Support ran.Hast du eine direkte Meinung zu Hyper-V oder XenServer als Basis für die VMs, vGPU oder eben GPU-P?

Microsoft Hyper-V hat im Vergleich zu Citrix/Broadcom einen zu großen Overhead was Performance, Updating, Wartung, Security, etc. angeht. Von Harding will ich gar nicht sprechen...Mit Windows Server 2019/2022 wird vGPU unterstützt, aber nach wie vor keine Live Migration von Hypervisor A auf B. Was bei einer VDI doch elementar wichtig ist. Genauso ist IO-SRV unabdingbar für die Nutzung. Sprich die Hardware muss das supporten.

Oder gar einen anderen Ansatz?

Wir setzen VMware Horizon seit 10 Jahren ein. Weil wir eben nicht nur eine VM benötigen, sondern auch die Features um eine VM herum. Deployment und Updating, sicherere Zugriff über das Internet, Master Images, etc.Unsere Umgebung ist keinster weise ein Referenz für euch. Baut einen PoC auf, definiert eure Anforderungen und Rahmenbedingungen, testet die Produkte der drei Hersteller durch, bewertet diese und trefft dann eine fundierte Entscheidung.

Gruß,

Dani

Hallo,

wir habe seit 2011 ein VDI Umgebung mit Rund 400 Concurrent Usern.

Dies auf Horizon Basis.

Seit 2018 setzen wir auf GPU mit der alt bewährten M10 (2x pro Host). 1B Profil (1GB GPU Ram/VM) mit vPC Lic.

In diesem Jahr sind wir dann CPU mässig an unser Limit gekommen.

Die Host's hatten zeitweise 100% CPU Last.

Dann sind wir auf ein Thema aufmerksam gemacht worden, dass wenn diese oben genannten 1GB zu mehr wie 80% ausgelastet sind, die CPU sehr darunter leiden muss.

Fragt mich nicht nach den genauen Gründen. Aber wohl eher ein undokumentiertes "Problem".

Auf jeden Fall hat uns dies dazu bewegt die User mal wieder OHNE GPU Unterstützung arbeiten zu lassen.

Wir haben es einfach deaktiviert, ohne die User zu informieren. No Risk no Fun war die Devise.

Was soll ich sagen, es hat eine Abteilung wirklich bemerkt, da sie wirklich auf GPU angewiesen sind.

Die restlichen 95% arbeiten seit dem wieder ohne GPU Unterstützung.

Und der Hit dabei ist, dass die CPU Last der Host's DEUTLICH zurückgegangen ist.

Also alles wieder im grünen Bereich.

Die User die die GPU brauchen, haben nun ein 2GB Profil erhalten und alle sind happy.

Somit wird ein zukünftiger Hardwareersatz anders aussehen. Nämlich nur noch 2 HOST's mit GPU und die anderen ohne.

Spart uns eine Menge Geld für GPU und vor allem für die vPC Lizenzen. vWS brauchen wir bisher zum Glück nicht wirklich. Ist einfach auch viel zu teuer.

die 2 Host's mit GPU bin ich auch noch unsicher, ob dies eine A16 werden soll, oder doch besser gleich eine L40s.

Ich brauche Stand heute sicherlich keine L40s Performance, aber der Host muss ja auch wieder mindestens 5-6 Jahre laufen. Und da bin ich mir nicht sicher, ob die A16 dann in 4 Jahren noch das "richtige" ist.

Unser VM's (non-Persitent) sehen folgend aus.

4 vCPU und 16 GB Ram, aktuell auf dem Weg Richtung Win 11 24H2

Zum Thema GPU RAM / VM

wir haben überwiegend größere Monitore im Einsatz, was vermutlich dazu geführt hat, dass die 1GB an die Grenzen kamen. Die 2 GB sehen wir heute schon als Pflicht an.

Die User haben einen 34 Zoll (3440x1440) oder 2x 27 Zoll (2x 2560x1440) zum Arbeiten.

Von meinem 49 Zoll (5120x1440) Spielzeug sehen wir mal ab.

Ich hoffe das Hilft etwas.

wir habe seit 2011 ein VDI Umgebung mit Rund 400 Concurrent Usern.

Dies auf Horizon Basis.

Seit 2018 setzen wir auf GPU mit der alt bewährten M10 (2x pro Host). 1B Profil (1GB GPU Ram/VM) mit vPC Lic.

In diesem Jahr sind wir dann CPU mässig an unser Limit gekommen.

Die Host's hatten zeitweise 100% CPU Last.

Dann sind wir auf ein Thema aufmerksam gemacht worden, dass wenn diese oben genannten 1GB zu mehr wie 80% ausgelastet sind, die CPU sehr darunter leiden muss.

Fragt mich nicht nach den genauen Gründen. Aber wohl eher ein undokumentiertes "Problem".

Auf jeden Fall hat uns dies dazu bewegt die User mal wieder OHNE GPU Unterstützung arbeiten zu lassen.

Wir haben es einfach deaktiviert, ohne die User zu informieren. No Risk no Fun war die Devise.

Was soll ich sagen, es hat eine Abteilung wirklich bemerkt, da sie wirklich auf GPU angewiesen sind.

Die restlichen 95% arbeiten seit dem wieder ohne GPU Unterstützung.

Und der Hit dabei ist, dass die CPU Last der Host's DEUTLICH zurückgegangen ist.

Also alles wieder im grünen Bereich.

Die User die die GPU brauchen, haben nun ein 2GB Profil erhalten und alle sind happy.

Somit wird ein zukünftiger Hardwareersatz anders aussehen. Nämlich nur noch 2 HOST's mit GPU und die anderen ohne.

Spart uns eine Menge Geld für GPU und vor allem für die vPC Lizenzen. vWS brauchen wir bisher zum Glück nicht wirklich. Ist einfach auch viel zu teuer.

die 2 Host's mit GPU bin ich auch noch unsicher, ob dies eine A16 werden soll, oder doch besser gleich eine L40s.

Ich brauche Stand heute sicherlich keine L40s Performance, aber der Host muss ja auch wieder mindestens 5-6 Jahre laufen. Und da bin ich mir nicht sicher, ob die A16 dann in 4 Jahren noch das "richtige" ist.

Unser VM's (non-Persitent) sehen folgend aus.

4 vCPU und 16 GB Ram, aktuell auf dem Weg Richtung Win 11 24H2

Zum Thema GPU RAM / VM

wir haben überwiegend größere Monitore im Einsatz, was vermutlich dazu geführt hat, dass die 1GB an die Grenzen kamen. Die 2 GB sehen wir heute schon als Pflicht an.

Die User haben einen 34 Zoll (3440x1440) oder 2x 27 Zoll (2x 2560x1440) zum Arbeiten.

Von meinem 49 Zoll (5120x1440) Spielzeug sehen wir mal ab.

Ich hoffe das Hilft etwas.

Moin @Lakotode,

Moin @Roland567,

Das kommt davon, dass die User durch grössere Auflösung und oder Farbtiefe immer mehr VRAM benötigen und wenn dieser ausgelutscht ist, dann steigt automatisch die CPU-Last und oder eine neue Anwendung startet erst gar nicht.

Wir haben erst jüngst ein 4 Node System mit je einer L40S ausgeliefert, die aufgeteilt in je 8 Teile, also 6GB Profil, auf diverse RDS-Sessionhosts die GPU-Last von ~250 User abfangen sollten.

Ähm, ja, das wird so jedoch nicht wirklich etwas, weil selbst die vier L40S nicht ausreichend VRAM und auch GPU Leistung, für die entsprechenden User bringen. 😭

Sprich, selbst mit einer L40S, ist die Sache nicht wirklich so einfach. 😔

Ohh, das riecht nach VDI und nicht RDS, ähm, ja, da ist die Sache noch um einiges komplizierter. 😬

Eine L40S hat 48GB VRAM, sprich, bei einem 4GB Profil, kannst du damit gerade mal 12 VDI VM's bedienen. 🙃

Ähm, das wird fürchte ich etwas eng für 230 VDI User.

😯 ... 😱 ... ähm, je höher die Auflösung und auch die verwendete Farbtiefe umso mehr VRAM benötigt eine VDI oder RDS Session.

Weitere Infos siehe auch ...

docs.nvidia.com/vgpu/sizing/virtual-workstation/latest/methodolo ...

docs.nvidia.com/vgpu/sizing/virtual-workstation/latest/right-gpu ...

... es gibt aber auch noch eine andere Doku, die das Thema etwas besser beschreibet, die finde ich jetzt auf die schnelle jedoch nicht.

(Poste nach wenn gefunden.)

Gruss Alex

Moin @Roland567,

wir habe seit 2011 ein VDI Umgebung mit Rund 400 Concurrent Usern.

Dies auf Horizon Basis.

Seit 2018 setzen wir auf GPU mit der alt bewährten M10 (2x pro Host). 1B Profil (1GB GPU Ram/VM) mit vPC Lic.

In diesem Jahr sind wir dann CPU mässig an unser Limit gekommen.

Die Host's hatten zeitweise 100% CPU Last.

Dann sind wir auf ein Thema aufmerksam gemacht worden, dass wenn diese oben genannten 1GB zu mehr wie 80% ausgelastet sind, die CPU sehr darunter leiden muss.

Interessante Info, war mir unbekannt. Danke für den Hinweis!Dies auf Horizon Basis.

Seit 2018 setzen wir auf GPU mit der alt bewährten M10 (2x pro Host). 1B Profil (1GB GPU Ram/VM) mit vPC Lic.

In diesem Jahr sind wir dann CPU mässig an unser Limit gekommen.

Die Host's hatten zeitweise 100% CPU Last.

Dann sind wir auf ein Thema aufmerksam gemacht worden, dass wenn diese oben genannten 1GB zu mehr wie 80% ausgelastet sind, die CPU sehr darunter leiden muss.

Fragt mich nicht nach den genauen Gründen. Aber wohl eher ein undokumentiertes "Problem".

Das kommt davon, dass die User durch grössere Auflösung und oder Farbtiefe immer mehr VRAM benötigen und wenn dieser ausgelutscht ist, dann steigt automatisch die CPU-Last und oder eine neue Anwendung startet erst gar nicht.

Was soll ich sagen, es hat eine Abteilung wirklich bemerkt, da sie wirklich auf GPU angewiesen sind.

Die restlichen 95% arbeiten seit dem wieder ohne GPU Unterstützung.

Und der Hit dabei ist, dass die CPU Last der Host's DEUTLICH zurückgegangen ist.

Also alles wieder im grünen Bereich.

Die User die die GPU brauchen, haben nun ein 2GB Profil erhalten und alle sind happy.

Danke für die Info! ich denke, dass wir bei ca. 16-20 Usern pro Host und 2GB Profil fahren könnten. Genaueres wird aber das PoC ergeben. Fürs Rendern und 3D würde ich zu mind. 4GB-Profilen tendieren, was meinst du?Die restlichen 95% arbeiten seit dem wieder ohne GPU Unterstützung.

Und der Hit dabei ist, dass die CPU Last der Host's DEUTLICH zurückgegangen ist.

Also alles wieder im grünen Bereich.

Die User die die GPU brauchen, haben nun ein 2GB Profil erhalten und alle sind happy.

Wir haben erst jüngst ein 4 Node System mit je einer L40S ausgeliefert, die aufgeteilt in je 8 Teile, also 6GB Profil, auf diverse RDS-Sessionhosts die GPU-Last von ~250 User abfangen sollten.

Ähm, ja, das wird so jedoch nicht wirklich etwas, weil selbst die vier L40S nicht ausreichend VRAM und auch GPU Leistung, für die entsprechenden User bringen. 😭

Sprich, selbst mit einer L40S, ist die Sache nicht wirklich so einfach. 😔

Gleiche Konfig, bei den Render/3D vWS/vPCs vielleicht 4-8 vCPU, die Provisionierung würde ich dann dementsprechend planen und die Host-CPUs danach auslegen. Ich denke, dabei wird auch HPE unterstützen und so würde ich dann auch das PoC aufbauen.

Ohh, das riecht nach VDI und nicht RDS, ähm, ja, da ist die Sache noch um einiges komplizierter. 😬

Eine L40S hat 48GB VRAM, sprich, bei einem 4GB Profil, kannst du damit gerade mal 12 VDI VM's bedienen. 🙃

Ähm, das wird fürchte ich etwas eng für 230 VDI User.

Zum Thema GPU RAM / VM

wir haben überwiegend größere Monitore im Einsatz, was vermutlich dazu geführt hat, dass die 1GB an die Grenzen kamen. Die 2 GB sehen wir heute schon als Pflicht an.

Die User haben einen 34 Zoll (3440x1440) oder 2x 27 Zoll (2x 2560x1440) zum Arbeiten.

Bei uns sind es 2x27 WQHD, also ebenfalls gleiches Setup, einige der 3D Kollegen nutzen ebenfalls 49", was in dem Fall 2x WQHD entspricht. Wobei die nominellen Pixel bei nVidia ja nochmals anders berechnet werden, das habe ich mir aber noch nicht genauer angesehen.wir haben überwiegend größere Monitore im Einsatz, was vermutlich dazu geführt hat, dass die 1GB an die Grenzen kamen. Die 2 GB sehen wir heute schon als Pflicht an.

Die User haben einen 34 Zoll (3440x1440) oder 2x 27 Zoll (2x 2560x1440) zum Arbeiten.

😯 ... 😱 ... ähm, je höher die Auflösung und auch die verwendete Farbtiefe umso mehr VRAM benötigt eine VDI oder RDS Session.

Weitere Infos siehe auch ...

docs.nvidia.com/vgpu/sizing/virtual-workstation/latest/methodolo ...

docs.nvidia.com/vgpu/sizing/virtual-workstation/latest/right-gpu ...

... es gibt aber auch noch eine andere Doku, die das Thema etwas besser beschreibet, die finde ich jetzt auf die schnelle jedoch nicht.

(Poste nach wenn gefunden.)

Gruss Alex

Guten Morgen,

Frage zu 2 oder 4 GB Profil:

Ob 2GB oder besser 4GB Profil kann ich leider nicht beantworten.

Sicherlich solltest du dies im Auge behalten und darauf achten, dass die GPU-Ram Auslastung nicht über 80% geht.

Wir nutzten dafür das ControlUp

Es war übrigens ein Techniker von dieser Firma, welcher uns den Hinweis zu dem 80% Problem geliefert hat.

Ohne ihn würden wir heute noch mit der 100% CPU Last "rumrennen".

Software der GPU User

Es handelt sich dabei eigentlich "nur" um ein Facility Management Tool "CAFM Waveware", in welchem aber das BIM abgebildet ist. (Building Information Modeling)

Hier bewegt sich ohne GPU so wirklich gar NICHTS mehr, wenn sie die Gebäude Ansicht einblenden.

Betreffend A16 hatte ich vor ein paar Monaten den Hinweis von HPE, dass dies nächstes Jahr schon abgekündet wird.

Habe ich auch selbst im HPE Konfigurator beim Händler gesehen !!!

Aber bei späterer Nachfrage bei HPE hieß es dann wieder, dass diese doch noch länger auf dem Markt sein werde, da ja erst seit 2021 am dem Markt. Die M10 gab es wohl auch länger.

Allerdings habe ich im HPE Konfigurator auch gesehen, dass die L40s ein Jahr später, also 2026 ebenfalls schon abgelöst werden soll. (zu L4 haben ich keine Hinweise)

(zu L4 haben ich keine Hinweise)

Also alles in allem ein "schwieriges Thema" hier auf das "richtige" Pferd zu setzen.

Vor allem, wenn man sich die Hintertür offen lassen möchte, ggf. später noch weitere Host's damit auszustatten.

Bezüglich vPC zu vWS.

Da die vWS das 3-fache kostet (50 zu 150$), lohnt es sich auf jeden Fall hier ganz genau zu testen.

Logisch möchte Nvidia die vWS verkaufen (selbstredend im Subskription).

Aber wenn dir ein "dickes vPC" Profil reicht, ist dass allemal eine Alternative.

Für den Preisunterschied kannst dir eher die "bessere" GPU Hardware leisten.

Die Hardware kaufst du ja nur ein Mal, die Lizenzen jedes Jahr wieder fällig!!

hope it helps

Gruß Roland

Frage zu 2 oder 4 GB Profil:

Ob 2GB oder besser 4GB Profil kann ich leider nicht beantworten.

Sicherlich solltest du dies im Auge behalten und darauf achten, dass die GPU-Ram Auslastung nicht über 80% geht.

Wir nutzten dafür das ControlUp

Es war übrigens ein Techniker von dieser Firma, welcher uns den Hinweis zu dem 80% Problem geliefert hat.

Ohne ihn würden wir heute noch mit der 100% CPU Last "rumrennen".

Software der GPU User

Es handelt sich dabei eigentlich "nur" um ein Facility Management Tool "CAFM Waveware", in welchem aber das BIM abgebildet ist. (Building Information Modeling)

Hier bewegt sich ohne GPU so wirklich gar NICHTS mehr, wenn sie die Gebäude Ansicht einblenden.

Betreffend A16 hatte ich vor ein paar Monaten den Hinweis von HPE, dass dies nächstes Jahr schon abgekündet wird.

Habe ich auch selbst im HPE Konfigurator beim Händler gesehen !!!

Aber bei späterer Nachfrage bei HPE hieß es dann wieder, dass diese doch noch länger auf dem Markt sein werde, da ja erst seit 2021 am dem Markt. Die M10 gab es wohl auch länger.

Allerdings habe ich im HPE Konfigurator auch gesehen, dass die L40s ein Jahr später, also 2026 ebenfalls schon abgelöst werden soll.

Also alles in allem ein "schwieriges Thema" hier auf das "richtige" Pferd zu setzen.

Vor allem, wenn man sich die Hintertür offen lassen möchte, ggf. später noch weitere Host's damit auszustatten.

Bezüglich vPC zu vWS.

Da die vWS das 3-fache kostet (50 zu 150$), lohnt es sich auf jeden Fall hier ganz genau zu testen.

Logisch möchte Nvidia die vWS verkaufen (selbstredend im Subskription).

Aber wenn dir ein "dickes vPC" Profil reicht, ist dass allemal eine Alternative.

Für den Preisunterschied kannst dir eher die "bessere" GPU Hardware leisten.

Die Hardware kaufst du ja nur ein Mal, die Lizenzen jedes Jahr wieder fällig!!

hope it helps

Gruß Roland

Moin @Roland567,

über 5 Jahre kostet die vWS ...

servershop-bayern.de/NVIDIA-GRID-RTX-vWS-Subscription-License-1- ...

... sogar um die 850,- € Netto.

Und wenn du diese später noch um weitere 5 Jahre ergänzen möchtest, dann kostet die entprechende Renewel-Lizenz ...

servershop-bayern.de/NVIDIA-GRID-RTX-vWS-Subscription-Renew-Lice ...

... mit ~990,- € sogar noch ~ 140,- € mehr. 🙃

Das was NVIDIA hier mitllerweile bei den vGPU Lizenzen treibt, ist meiner Ansicht nach einfach nur Abzocke. 😔

Gruss Alex

Da die vWS das 3-fache kostet (50 zu 150$), lohnt es sich auf jeden Fall hier ganz genau zu testen.

über 5 Jahre kostet die vWS ...

servershop-bayern.de/NVIDIA-GRID-RTX-vWS-Subscription-License-1- ...

... sogar um die 850,- € Netto.

Und wenn du diese später noch um weitere 5 Jahre ergänzen möchtest, dann kostet die entprechende Renewel-Lizenz ...

servershop-bayern.de/NVIDIA-GRID-RTX-vWS-Subscription-Renew-Lice ...

... mit ~990,- € sogar noch ~ 140,- € mehr. 🙃

Das was NVIDIA hier mitllerweile bei den vGPU Lizenzen treibt, ist meiner Ansicht nach einfach nur Abzocke. 😔

Gruss Alex

Hallo Alex,

Was erwartest du, wenn es praktisch keinen Mitbewerber in dieser Hinsicht gibt?!?

Hardwarealternativen gibt es sicherlich, ABER dies dann in die VDI mit non-persistent Desktops bringen, ist dann wohl die Herausforderung "schlecht hin". Vermutlich die Königsdisziplin, so zumindest mein Gefühl.

Mir wäre aktuell zumindest kein anderen Anbieter bekannt, der dies ebenfalls managen kann.

Aber ich lasse mich sehr gerne eines besseren belehren.

Bräuchte vielleint einen eigenen neuen Beitrag zu dem Thema

Was erwartest du, wenn es praktisch keinen Mitbewerber in dieser Hinsicht gibt?!?

Hardwarealternativen gibt es sicherlich, ABER dies dann in die VDI mit non-persistent Desktops bringen, ist dann wohl die Herausforderung "schlecht hin". Vermutlich die Königsdisziplin, so zumindest mein Gefühl.

Mir wäre aktuell zumindest kein anderen Anbieter bekannt, der dies ebenfalls managen kann.

Aber ich lasse mich sehr gerne eines besseren belehren.

Bräuchte vielleint einen eigenen neuen Beitrag zu dem Thema

Moin @Roland567,

ja, mit dem Mitbewerb, zumindest in diesem Bereichm sieht es leider nicht wirklich gut aus. 😔

AMD hat zwar mit den RADEON PRO auch GraKa's mit bis zu 48GB VRAM und auch ordentlich GPU Leistung im Program, do die kann man nur per DDA einer VM zuweisen, sprich, nix mit GPU-Partitionierung.

Intel wollte zwar mit "Iris Xe" auch mal was bringen, doch das wird fürchte ich nicht wirklich was werden.

Und MS selbst ...

learn.microsoft.com/de-de/windows-server/virtualization/hyper-v/ ...

... listet aktuell auch nur NVIDIA GPU's. 😭🤢🤮

Ja, von der Matherie her ist das sicherlich eine der Königsdisziplinen der IT ... aber ... das was NVIDIA hier an Qualität liefert und das auch noch zu dem Preis, ist meider Ansicht nach schlichtweg unter aller Sau.

Der Kunde den ich zuvor mit den L40S erwähnt habe, ist mittlerweile etwas am Kotzen. 😬

Weil er schon diverseste Tickets bei NVIDIA offen hat und sich mittlerweile eher wie ein Alpha-Testphase-Kanninchen vorkommt. 😔

Gruss Alex

Was erwartest du, wenn es praktisch keinen Mitbewerber in dieser Hinsicht gibt?!?

ja, mit dem Mitbewerb, zumindest in diesem Bereichm sieht es leider nicht wirklich gut aus. 😔

AMD hat zwar mit den RADEON PRO auch GraKa's mit bis zu 48GB VRAM und auch ordentlich GPU Leistung im Program, do die kann man nur per DDA einer VM zuweisen, sprich, nix mit GPU-Partitionierung.

Intel wollte zwar mit "Iris Xe" auch mal was bringen, doch das wird fürchte ich nicht wirklich was werden.

Und MS selbst ...

learn.microsoft.com/de-de/windows-server/virtualization/hyper-v/ ...

... listet aktuell auch nur NVIDIA GPU's. 😭🤢🤮

Vermutlich die Königsdisziplin, so zumindest mein Gefühl.

Ja, von der Matherie her ist das sicherlich eine der Königsdisziplinen der IT ... aber ... das was NVIDIA hier an Qualität liefert und das auch noch zu dem Preis, ist meider Ansicht nach schlichtweg unter aller Sau.

Der Kunde den ich zuvor mit den L40S erwähnt habe, ist mittlerweile etwas am Kotzen. 😬

Weil er schon diverseste Tickets bei NVIDIA offen hat und sich mittlerweile eher wie ein Alpha-Testphase-Kanninchen vorkommt. 😔

Gruss Alex

Moin,

In Summe über die VMs hinweg wirst deutlich weniger CPU Kerne benötigen bzw. die Dichte der VMs erhöhen können. Weil die Berechnungen eben nicht auf diese CPU ausgelagert werden. Was schlussendlich auch der Zufriedenheit der User beiträgt.

Abgesehen davon wirst du das nur mit eine PoC herausfinden, ob ein das 2GB Profil für die nächsten Jahre reicht. Und bitte nicht auf Spitz-auf_-Knopf rechnen. Das rächt sich...

Gruß,

Dani

Wir setzen HPE Server und DELL ein. Habe mich mal mit den ASUS GPU-Servern beschäftigt, mit Epic CPUs. Mal sehen.

achte bitte darauf, dass sich alle Komponenten wieder in der jeweiligen Support Matrix wiederfinden und auch das die nächsten 5 Jahre. Um so mehr Hersteller du im Boot hast, um so komplizierter wird es. Gerade bei komplexen Problemen und Fehler im Betrieb.Ich denke, dass die L4 Karten sich gut für Profile mit 2GB VRAM eignen und mittelmäßiger 3D-Last, also n bisschen Video, Multimedia etc., eignen, während L40s als Allrounder und größeren VRAM-Profilen im Bereich 3D/KI passen sollte.

Da bist du meiner Meinung nach schon am unteren Ende der Fahnenstange. Bei uns haben 0815 Office Arbeitsplätze inzwischen 4GB. Weil Microsoft Office, der Browser (Youtube, Facebook, etc.) ERP/CRM, etc. alle irgendwo die Grafikkarte beanspruchen. Zumal du auch den Vergleich zu meinen Fatclient ziehen solltest...In Summe über die VMs hinweg wirst deutlich weniger CPU Kerne benötigen bzw. die Dichte der VMs erhöhen können. Weil die Berechnungen eben nicht auf diese CPU ausgelagert werden. Was schlussendlich auch der Zufriedenheit der User beiträgt.

Abgesehen davon wirst du das nur mit eine PoC herausfinden, ob ein das 2GB Profil für die nächsten Jahre reicht. Und bitte nicht auf Spitz-auf_-Knopf rechnen. Das rächt sich...

Gruß,

Dani

Moin @Lakotode,

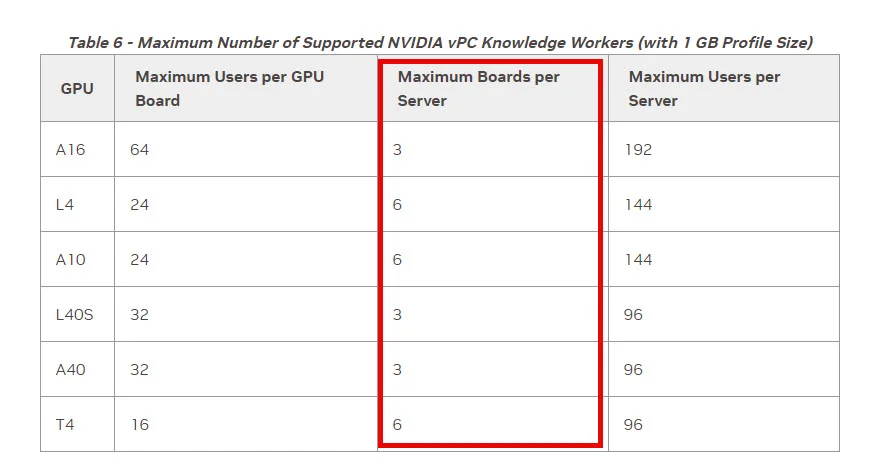

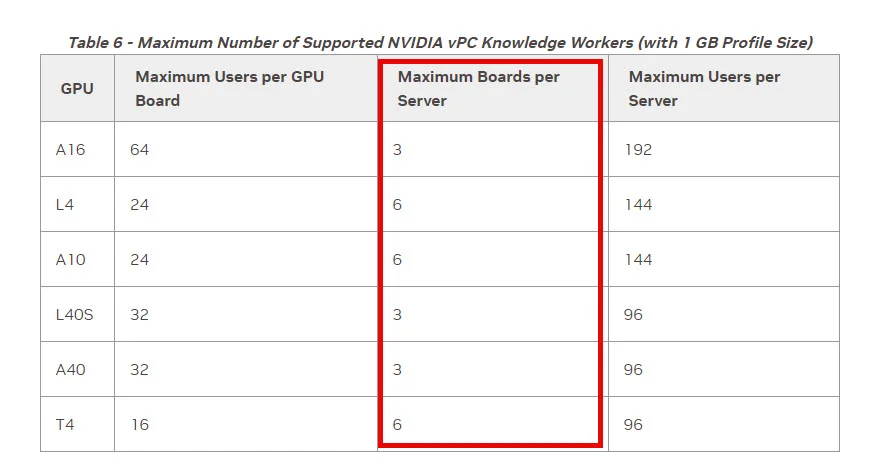

vorsicht mit der Anzahl der GPU's, denn die hängt nicht nur von dem Server selber ab, sondern auch von der GPU selbst.

docs.nvidia.com/vgpu/sizing/virtual-workstation/latest/right-gpu ...

docs.nvidia.com/vgpu/sizing/virtual-workstation/latest/right-gpu ...

Na ja ... wir haben am Anfang das 6GB Profil der L40S bereits schon mit 5 User voll genagelt gehabt und zwar nur mit max. 2 Full-HD Displays pro User. 😭

Wie schon oben abgesprochen, wenn du dich für die L4 entscheidest, dann kannst du nur 6 davon pro System verbauen und bei L40S sind es sogar nur 3 pro Server.

Gruss Alex

Ja, klar, wir sprechen über mehrere Hosts. Je nach Server und Hersteller sind ja mehrere Karten nutzbar, 2, 4 usw. Bei den größeren vGPU-Profilen reduziert sich die Anzahl der User natürlich.

vorsicht mit der Anzahl der GPU's, denn die hängt nicht nur von dem Server selber ab, sondern auch von der GPU selbst.

Ja, ganz genau und hier gibt nvidia aber ganz gute Infos, welches Profil zu welchen Auflösungen/Displays passt/unterstützt.

Na ja ... wir haben am Anfang das 6GB Profil der L40S bereits schon mit 5 User voll genagelt gehabt und zwar nur mit max. 2 Full-HD Displays pro User. 😭

Ja na klar, wir reden über 2-8 Karten je nach Servermodell. Ich würde jedoch aus Redundanzgründen eher kleiner sizen und verteilen.

Wie schon oben abgesprochen, wenn du dich für die L4 entscheidest, dann kannst du nur 6 davon pro System verbauen und bei L40S sind es sogar nur 3 pro Server.

Gruss Alex

Moin @Lakotode,

ja, genau das mit den Kosten sehe ich auch sehr kritisch. Denn wenn man alle Kosten der VDI Hardware mit berücksichtigt, sprich, Server (CPU/ RAM/NIC's), Storage, GPU's und vor allem auch die entsprechenden Lizenzen, dann komme ich nicht wirklich unter den Preis einer erwachsenen Power-Workstation mit z.B. einer P2000. 😔

Diese läuft wenn die Hardware richtig gewählt ist, dann auch definitiv schneller wie eine VDI Lösung und man kann sich darauf auch genauso z.B. per RDP über VPN auch aus der Ferne drauf schalten.

Wir haben die letzten GPU Server auf Basis von Gigabyte Byrebones assemblieren lassen und ich habe an diese bisher nicht wirklich etwas zum Aussetzen gefunden, ausser, dass die Dinger höllisch laut sind, das trifft jedoch für jedes luftgekühlte GPU-System zu.

Ich weiss nicht, ob man das so pauschal sagen kann, auf jeden Fall bekommst du für den Preis von einer L40S, fast 3 L4 GPU's und die 3 L4 GPU's haben mit 3 x 24GB auf jeden Fall dann mehr VRAM und die drei L4 fressen zusammen auch noch weniger Strom wie eine L40S. 🙃

Das verstehe ich jetzt nicht so ganz, denn 4-8GB Profile kann ja auch die L4 bereitstellen, nur eben halb so viele wie eine L40S, da die L4 mit 24 GB ja auch nur halb so viel VRAM wie eine L40S hat.

Testen würde ich ein vPC Profil und vWS. So wie Roland schrieb, reicht vPC, allerdings untertützt die Lizenz nur bis max. 2GB VRAM Profile. Zumindest laut: nvidia.com/content/dam/en-zz/Solutions/design-visualization/solu ... Aber für einen Teil sollte das reichen. Tendenz aber eher zur vWS.

Teste auf jeden Fall beides, denn wenn dir auch die vPC oder vApp reicht, dann musst du ja nicht unnötigt Geld für die vWS bezahlen.

> Ach, ich werde auch Dani folgen und XenServer im PoC nutzen. Mit Hyper-V wäre es einfacher, gerade bei wenigen TS-VMs (nicht RDP!!! ;)). Aber bei der Anzahl nach der Umstrukturierung denke, ich genau wie Dani, dass XenServer da die bessere Wahl ist.

Ähm, wenn Hyper-V, dann bitte nur mit Server 2025, den mit 2022 ist das GPU Händling eher grausam.

Gruss Alex

Korrekt, VDI mit vernünftiger - und vor allem funktionierender - vGPU oder GPU-P ist sicherlich nicht das einfachste. Zumal der Kostenvorteil - rein hardwaretechnisch + nvidia vXX Lizenzierung - gegenüber klassischen FatClients nicht mehr so heftig ist, wie er gerne von nvidia angepriesen wird.

ja, genau das mit den Kosten sehe ich auch sehr kritisch. Denn wenn man alle Kosten der VDI Hardware mit berücksichtigt, sprich, Server (CPU/ RAM/NIC's), Storage, GPU's und vor allem auch die entsprechenden Lizenzen, dann komme ich nicht wirklich unter den Preis einer erwachsenen Power-Workstation mit z.B. einer P2000. 😔

Diese läuft wenn die Hardware richtig gewählt ist, dann auch definitiv schneller wie eine VDI Lösung und man kann sich darauf auch genauso z.B. per RDP über VPN auch aus der Ferne drauf schalten.

Wir setzen HPE Server und DELL ein. Habe mich mal mit den ASUS GPU-Servern beschäftigt, mit Epic CPUs. Mal sehen.

Wir haben die letzten GPU Server auf Basis von Gigabyte Byrebones assemblieren lassen und ich habe an diese bisher nicht wirklich etwas zum Aussetzen gefunden, ausser, dass die Dinger höllisch laut sind, das trifft jedoch für jedes luftgekühlte GPU-System zu.

Ich denke, dass die L4 Karten sich gut für Profile mit 2GB VRAM eignen und mittelmäßiger 3D-Last, also n bisschen Video, Multimedia etc., eignen, während L40s als Allrounder und größeren VRAM-Profilen im Bereich 3D/KI passen sollte.

Ich weiss nicht, ob man das so pauschal sagen kann, auf jeden Fall bekommst du für den Preis von einer L40S, fast 3 L4 GPU's und die 3 L4 GPU's haben mit 3 x 24GB auf jeden Fall dann mehr VRAM und die drei L4 fressen zusammen auch noch weniger Strom wie eine L40S. 🙃

Denke also, dass ab 4-8GB VRAM die L40(s) die besser Wahl sind. Zumindest laut den technischen Dokumenten von nvidia.

Das verstehe ich jetzt nicht so ganz, denn 4-8GB Profile kann ja auch die L4 bereitstellen, nur eben halb so viele wie eine L40S, da die L4 mit 24 GB ja auch nur halb so viel VRAM wie eine L40S hat.

Das PoC könnte also ein ASUS GPU-Server ESC4000-E11/E12 werden und 4x L40s.

Testen würde ich ein vPC Profil und vWS. So wie Roland schrieb, reicht vPC, allerdings untertützt die Lizenz nur bis max. 2GB VRAM Profile. Zumindest laut: nvidia.com/content/dam/en-zz/Solutions/design-visualization/solu ... Aber für einen Teil sollte das reichen. Tendenz aber eher zur vWS.

Teste auf jeden Fall beides, denn wenn dir auch die vPC oder vApp reicht, dann musst du ja nicht unnötigt Geld für die vWS bezahlen.

> Ach, ich werde auch Dani folgen und XenServer im PoC nutzen. Mit Hyper-V wäre es einfacher, gerade bei wenigen TS-VMs (nicht RDP!!! ;)). Aber bei der Anzahl nach der Umstrukturierung denke, ich genau wie Dani, dass XenServer da die bessere Wahl ist.

Ähm, wenn Hyper-V, dann bitte nur mit Server 2025, den mit 2022 ist das GPU Händling eher grausam.

Gruss Alex

Moin @Lakotode,

wir haben bei den letzten Systemen die folgenden Gigabyte Chassis als Basis genommen.

gigabyte.com/de/Enterprise/Rack-Server/R283-SF1-AAL1

Diese sind extra für GPU Betrieb ausgelegt, siehe alleine schon die PSU-Leistung. 😉

Vergiss bitte die DL380 Gen11, da diese Serverreihe, weder PSU noch Lüftertechnisch, für GPU's wirklich ausgelegt ist!

Wenn HPE, dann kommt für dich eigentlich nur das folgende Model in Frage ...

buy.hpe.com/de/de/compute/rack-servers/proliant-dl300-servers/pr ...

... und ob das bereits schon verfügbar ist wage ich mal zu bezweifeln, da die "Intel Xeon 6" CPU's die dieses Model unterstützt, gerade erst frisch herausgekommen sind.

By the way …

intel.com/content/www/us/en/ark/products/series/240357/intel-xeo ...

… sehe ich das richtig, dass die kleinste CPU dieser Serie bei 64 Kernen anfängt und es keine Variante gibt, deren Basistakt über 3GHz liegt. 😦😖

Ähm … @intel … was soll dieser Murks?

Na ja, abgesehen von einer etwas anderen Gehäuse.- und oder BIOS-GUI-Farbe, gibt es hier meiner Erfahrung nach, nicht wirklich viele Unterschiede, zumindest was die Leistung bei gleicher Bestückung angeht.

Ich glaube …

… hier hat sich eher das Asus Marketing zu sehr ausgetobt. 🙃

Was meinst du genau mit anders designt?

Also ja, die L4 ist natürlich etwas schwächer wie die L40S, beide GPU’s basieren jedoch auf derselben Architektur, sprich, Lovelace.

Da bin ich aber sehr gespannt wann du diese bekommst und ob überhaupt.

Wir haben auf unsere damaligen Anfragen bei NVIDIA, zum Teil überhaupt keine Antwort vom Pre-Sales bekommen und die Techniker von NVIDIA wollte damals nicht mit uns sprechen, da wir noch keine GPU’s für das Projekt gekauft haben. 😔😭

Ähm, ja, im Nachgang, also nachdem wir die GPU’s schon da hatten, konnte ich dann auch ohne Probleme einen NVIDIA-Techniker sprechen und dieser hat mir dann auch genauer erklärt, wie das mit dem VRAM funktioniert. 🙃

Wie kommst du darauf, dass man für 4G unbedingt vPC benötigt?

Denn einer der Tipps die uns der NVIDIA Techniker gegeben hat damit wir die Userdichte auf einem GPU beschleunigten RDS erhöhen können, war das Profil von 6GB auf 8GB zu erhöhen und anstelle von vWS, vApp zu benutzen.

Und ja, das hat durchaus funktioniert. 🙃

Und warum machst du das Ganze nicht nativ mit RDS?

Dabei kannst du übrigens auch einiges an NVIDIA Lizenzen einsparen. 😁

Die normalen CAL’s ja, aber die RDS-CAL‘s sind soweit ich weiss, selbst nicht im E5 enthalten.

Bei VDI benötigst du die aber auch nicht wirklich, bei RDS hingegen schon.

Gruss Alex

Ich recherchiere bei Gigabtyte, danke für den Tipp! (Nachtrag: AAAH. Barebones !!! Dachte, dass ei ein Servertyp von Gigabyte... Wunderte mich ein klein bisschen)

wir haben bei den letzten Systemen die folgenden Gigabyte Chassis als Basis genommen.

gigabyte.com/de/Enterprise/Rack-Server/R283-SF1-AAL1

Diese sind extra für GPU Betrieb ausgelegt, siehe alleine schon die PSU-Leistung. 😉

Und ich weiß halt auch noch nicht, ob der Vorteil von GPU-Servern gegenüber "klassischen" Servern - wie etwa DL380 Gen11 - einen heftigen Mehrwert hat ist.

Vergiss bitte die DL380 Gen11, da diese Serverreihe, weder PSU noch Lüftertechnisch, für GPU's wirklich ausgelegt ist!

Wenn HPE, dann kommt für dich eigentlich nur das folgende Model in Frage ...

buy.hpe.com/de/de/compute/rack-servers/proliant-dl300-servers/pr ...

... und ob das bereits schon verfügbar ist wage ich mal zu bezweifeln, da die "Intel Xeon 6" CPU's die dieses Model unterstützt, gerade erst frisch herausgekommen sind.

By the way …

intel.com/content/www/us/en/ark/products/series/240357/intel-xeo ...

… sehe ich das richtig, dass die kleinste CPU dieser Serie bei 64 Kernen anfängt und es keine Variante gibt, deren Basistakt über 3GHz liegt. 😦😖

Ähm … @intel … was soll dieser Murks?

Ich würde ungern noch einen dritten Hersteller im RZ haben, neben DELL und HPE.

Na ja, abgesehen von einer etwas anderen Gehäuse.- und oder BIOS-GUI-Farbe, gibt es hier meiner Erfahrung nach, nicht wirklich viele Unterschiede, zumindest was die Leistung bei gleicher Bestückung angeht.

Aber wenn man sich das bei ASUS ansieht, dann haben sie zB eine Flüssigkeitskühlung an Board, mindestens optional.

Ich glaube …

… hier hat sich eher das Asus Marketing zu sehr ausgetobt. 🙃

Dein Vorschlag erscheint mir logisch, wobei die Karten vom Aufbau her ja anders designt sind.

Was meinst du genau mit anders designt?

Also ja, die L4 ist natürlich etwas schwächer wie die L40S, beide GPU’s basieren jedoch auf derselben Architektur, sprich, Lovelace.

Sobald ich da eine Antwort bekomme, poste ich diese hier!

Da bin ich aber sehr gespannt wann du diese bekommst und ob überhaupt.

Wir haben auf unsere damaligen Anfragen bei NVIDIA, zum Teil überhaupt keine Antwort vom Pre-Sales bekommen und die Techniker von NVIDIA wollte damals nicht mit uns sprechen, da wir noch keine GPU’s für das Projekt gekauft haben. 😔😭

Aber das was du schreibst klingt logisch, mindestens was VRAM und Profile betrifft!

Ähm, ja, im Nachgang, also nachdem wir die GPU’s schon da hatten, konnte ich dann auch ohne Probleme einen NVIDIA-Techniker sprechen und dieser hat mir dann auch genauer erklärt, wie das mit dem VRAM funktioniert. 🙃

Ich muss wohl vWS einsetzen, da Revit als Mindestanforderung 4GB VRAM voraussetzt und das unsere hauptsächlich verwendete Software ist. Weiß aber ehrlich gesagt ga rnicht, was passiert, wenn ich Revit auf einer Workstation mit 2GB Karte starten will... Ich teste das mal mit einem FatClient. Denn dann sollte vPC absolut reichen!

Wie kommst du darauf, dass man für 4G unbedingt vPC benötigt?

Denn einer der Tipps die uns der NVIDIA Techniker gegeben hat damit wir die Userdichte auf einem GPU beschleunigten RDS erhöhen können, war das Profil von 6GB auf 8GB zu erhöhen und anstelle von vWS, vApp zu benutzen.

Und ja, das hat durchaus funktioniert. 🙃

> Ach, ich werde auch Dani folgen und XenServer im PoC nutzen. Mit Hyper-V wäre es einfacher, gerade bei wenigen TS-VMs (nicht RDP!!! ;)). Aber bei der Anzahl nach der Umstrukturierung denke, ich genau wie Dani, dass XenServer da die bessere Wahl ist.

Und warum machst du das Ganze nicht nativ mit RDS?

Dabei kannst du übrigens auch einiges an NVIDIA Lizenzen einsparen. 😁

Ja, hie rkommt nur 2025 in Betracht, würde jetzt auch nicht mehr auf 2022 setzen, bei diesem Thema. Zum Glück sind in den größeren M365-Plänen Cals enthalten...

Die normalen CAL’s ja, aber die RDS-CAL‘s sind soweit ich weiss, selbst nicht im E5 enthalten.

Bei VDI benötigst du die aber auch nicht wirklich, bei RDS hingegen schon.

Gruss Alex

Hallo zusammen,

muss mich da glaub auch nochmals kurz einbringen.

Also Intel ist für mich im Moment kein Thema mehr, falls ich dies noch nicht erwähnt hätte.

Ich kaufe die letzten Jahr nur noch AMD. Der EPYC ist Top

Meine nächsten VDI Server haben AMD EPYC 5th Gen mit 9355 oder 9375F.

Die Ausschreibung ist bereits in Ausarbeitung.

Die CPUs haben Power, haben genug Core's und sind Preislich dafür in Ordnung UND sind noch im "grünen" Range, was den Stromverbrauch angeht.

Noch ein Thema zu den HPE Server, DL385 Gen11 (DL380a Gen11 für Intel)

Es gibt da auf jeden Fall ein extra Ordernummern, welche für GPU ausgelegt sind.

Die haben dann auch 4 PSU's und vermutlich weiteres.

SKU

DL385 Gen11 - P54198-B21

Der DL380a Gen11 ist das "a" nur für GPU gedacht.

Also eigentlich alles Ready für GPU Ausbau.

Wir hatten bei DL380Gen10 nie Probleme mit unseren beiden M10 pro Server.

Liquid-cooling gehört vermutlich die Zukunft, doch gibt z.B. HPE im Moment nur 5 Jahre "Lebensdauer" an, was ich für mich als zu wenig sehen. Ich/wir haben unsere Server definitiv deutlich länge im Einsatz.

Nach dem VDI Leben gibt es meist noch ein Leben in einem anderen Bereich, wo sie meist noch Power genug haben, wie z.B. im Backup Bereich und anderes.

muss mich da glaub auch nochmals kurz einbringen.

Also Intel ist für mich im Moment kein Thema mehr, falls ich dies noch nicht erwähnt hätte.

Ich kaufe die letzten Jahr nur noch AMD. Der EPYC ist Top

Meine nächsten VDI Server haben AMD EPYC 5th Gen mit 9355 oder 9375F.

Die Ausschreibung ist bereits in Ausarbeitung.

Die CPUs haben Power, haben genug Core's und sind Preislich dafür in Ordnung UND sind noch im "grünen" Range, was den Stromverbrauch angeht.

Noch ein Thema zu den HPE Server, DL385 Gen11 (DL380a Gen11 für Intel)

Es gibt da auf jeden Fall ein extra Ordernummern, welche für GPU ausgelegt sind.

Die haben dann auch 4 PSU's und vermutlich weiteres.

SKU

DL385 Gen11 - P54198-B21

Der DL380a Gen11 ist das "a" nur für GPU gedacht.

Also eigentlich alles Ready für GPU Ausbau.

Wir hatten bei DL380Gen10 nie Probleme mit unseren beiden M10 pro Server.

Liquid-cooling gehört vermutlich die Zukunft, doch gibt z.B. HPE im Moment nur 5 Jahre "Lebensdauer" an, was ich für mich als zu wenig sehen. Ich/wir haben unsere Server definitiv deutlich länge im Einsatz.

Nach dem VDI Leben gibt es meist noch ein Leben in einem anderen Bereich, wo sie meist noch Power genug haben, wie z.B. im Backup Bereich und anderes.

Moin @Roland567,

ja, die AMD's werden immer besser, aber bisher kann Intel noch mithalten und ich hoffe, dass die die Kurve noch hinbekommen. Denn eine Welt mit nur einem (CPU) Hersteller, würde am Ende des Tages, wahrscheinlich keinem von uns wirklich besser gefallen. 😔

Du hast Recht, in den folgenden QuickSpecs (129 Seiten 🙃) der DL385 Gen11 Reihe ...

hpe.com/psnow/doc/a50004300enw.pdf

... wird das auch erwähnt.

Man benötigt für eine GPU bestückung jedoch unbedingt ein "CTO" Chassis.

Na ja, alleine, dass man bei HPE so tief graben muss um rauszufinden ob deren Server GPU's unterstützen, finde ich im Jahr 2024 schon etwas suboptimal.

Stimmt, ...

hpe.com/psnow/doc/PSN1014696168DEDE.pdf

... danke für die Info/Korrektur.

Für die meisten unserer Kunden kommt LC im Server wahrscheinlich nicht in Frage, da es stand heute im Vergleich zu einer klassischen Luftkühlung, noch viel zu aufwendig, wartungsintensiv und auch teuer ist.

By the way, laut den QuickSecs unterstützen die DL385er auch DLC.

Gruss Alex

Also Intel ist für mich im Moment kein Thema mehr, falls ich dies noch nicht erwähnt hätte.

Ich kaufe die letzten Jahr nur noch AMD. Der EPYC ist Top

Meine nächsten VDI Server haben AMD EPYC 5th Gen mit 9355 oder 9375F.

Die Ausschreibung ist bereits in Ausarbeitung.

Die CPUs haben Power, haben genug Core's und sind Preislich dafür in Ordnung UND sind noch im "grünen" Range, was den Stromverbrauch angeht.

Ich kaufe die letzten Jahr nur noch AMD. Der EPYC ist Top

Meine nächsten VDI Server haben AMD EPYC 5th Gen mit 9355 oder 9375F.

Die Ausschreibung ist bereits in Ausarbeitung.

Die CPUs haben Power, haben genug Core's und sind Preislich dafür in Ordnung UND sind noch im "grünen" Range, was den Stromverbrauch angeht.

ja, die AMD's werden immer besser, aber bisher kann Intel noch mithalten und ich hoffe, dass die die Kurve noch hinbekommen. Denn eine Welt mit nur einem (CPU) Hersteller, würde am Ende des Tages, wahrscheinlich keinem von uns wirklich besser gefallen. 😔

Noch ein Thema zu den HPE Server, DL385 Gen11 (DL380a Gen11 für Intel)

Es gibt da auf jeden Fall ein extra Ordernummern, welche für GPU ausgelegt sind.

Die haben dann auch 4 PSU's und vermutlich weiteres.

SKU

DL385 Gen11 - P54198-B21

Es gibt da auf jeden Fall ein extra Ordernummern, welche für GPU ausgelegt sind.

Die haben dann auch 4 PSU's und vermutlich weiteres.

SKU

DL385 Gen11 - P54198-B21

Du hast Recht, in den folgenden QuickSpecs (129 Seiten 🙃) der DL385 Gen11 Reihe ...

hpe.com/psnow/doc/a50004300enw.pdf

... wird das auch erwähnt.

and the newly designed chassis supporting 8 single wide (SW) or 4 double wide (DW) GPUs*

Man benötigt für eine GPU bestückung jedoch unbedingt ein "CTO" Chassis.

Na ja, alleine, dass man bei HPE so tief graben muss um rauszufinden ob deren Server GPU's unterstützen, finde ich im Jahr 2024 schon etwas suboptimal.

Der DL380a Gen11 ist das "a" nur für GPU gedacht.

Stimmt, ...

hpe.com/psnow/doc/PSN1014696168DEDE.pdf

... danke für die Info/Korrektur.

Liquid-cooling gehört vermutlich die Zukunft, doch gibt z.B. HPE im Moment nur 5 Jahre "Lebensdauer" an, was ich für mich als zu wenig sehen. Ich/wir haben unsere Server definitiv deutlich länge im Einsatz.

Für die meisten unserer Kunden kommt LC im Server wahrscheinlich nicht in Frage, da es stand heute im Vergleich zu einer klassischen Luftkühlung, noch viel zu aufwendig, wartungsintensiv und auch teuer ist.

By the way, laut den QuickSecs unterstützen die DL385er auch DLC.

Direct Liquid Cooling (DLC) is now supported

Gruss Alex