Proxmox - Auf der Suche nach IT Support

Hallo liebe Community,

ich habe mich hier neu angemeldet. Ich lese schon eine ganze Weile mit und bin immer wieder begeistert ob eures Fachwissens, was mir schon oft geholfen hat.

Nun hoffe ich jemand zufinden (direkt oder auf Empfehlung, der mir mit meiner Proxmox/PFSENSE Installation helfen kann (bezahlt natürlich)

Warum gehts?

Meine Proxmox Instanz läuft auf einem MinisForum HM90. Es sind ca 10 kleinere und mittlere VM/LXC am laufen, die meinen privaten Bedarf bedienen. Eine Instanz ist eine PFSENSE.

Leider kämpfe ich seit Monaten mit wiederkehrenden Problemen die in der Konsequenz zur vollständigen Störung der Maschine führen und ca alle 2-3 Monate einen Neustart des Hosts bedeuten.

Mir fehlt leider die Zeit, den Problemen auf den Grund zu gehen. Was mir bereits aufgefallen ist:

- über die Monate steigt der IO Delay stark an. Am Ende sind wir bei 80%. Mit dem Neustart ist alles wieder gut

- zum Zeitpunkt des Ausfalls, hat PFsense starke Peaks in der CPU Auslastung

- zum Zeitpunkt des Ausfalls steigt der Netzwerk Traffic stark an

- ein ZFS Verbund scheint Degraded, allerdings sind die SMART Werte in Ordnung.

Falls es also ein Konfigurationsthema seien sollte, dann erhoffe ich mir jemanden zu finden, der mit mir zusammen den Fehler findet und mein System korrekt einstellen kann.

Also falls ihr selber oder in eurem Bekanntenkreis jemanden kennt, der ein paar bezahlte Stunden per VPN auf mein System schauen kann, bitte gerne melden.

Grüße

Thorben

ich habe mich hier neu angemeldet. Ich lese schon eine ganze Weile mit und bin immer wieder begeistert ob eures Fachwissens, was mir schon oft geholfen hat.

Nun hoffe ich jemand zufinden (direkt oder auf Empfehlung, der mir mit meiner Proxmox/PFSENSE Installation helfen kann (bezahlt natürlich)

Warum gehts?

Meine Proxmox Instanz läuft auf einem MinisForum HM90. Es sind ca 10 kleinere und mittlere VM/LXC am laufen, die meinen privaten Bedarf bedienen. Eine Instanz ist eine PFSENSE.

Leider kämpfe ich seit Monaten mit wiederkehrenden Problemen die in der Konsequenz zur vollständigen Störung der Maschine führen und ca alle 2-3 Monate einen Neustart des Hosts bedeuten.

Mir fehlt leider die Zeit, den Problemen auf den Grund zu gehen. Was mir bereits aufgefallen ist:

- über die Monate steigt der IO Delay stark an. Am Ende sind wir bei 80%. Mit dem Neustart ist alles wieder gut

- zum Zeitpunkt des Ausfalls, hat PFsense starke Peaks in der CPU Auslastung

- zum Zeitpunkt des Ausfalls steigt der Netzwerk Traffic stark an

- ein ZFS Verbund scheint Degraded, allerdings sind die SMART Werte in Ordnung.

Falls es also ein Konfigurationsthema seien sollte, dann erhoffe ich mir jemanden zu finden, der mit mir zusammen den Fehler findet und mein System korrekt einstellen kann.

Also falls ihr selber oder in eurem Bekanntenkreis jemanden kennt, der ein paar bezahlte Stunden per VPN auf mein System schauen kann, bitte gerne melden.

Grüße

Thorben

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 81581701793

Url: https://administrator.de/forum/proxmox-auf-der-suche-nach-it-support-81581701793.html

Ausgedruckt am: 26.07.2025 um 14:07 Uhr

17 Kommentare

Neuester Kommentar

Mal ganz allgemein: Der HM80 ist Consumer-Hardware, aus Erfahrung gab es in Sachen Stabilität bei den Treibern in der Vergangenheit immer wieder Probleme. Nicht weil Proxmox dran Schuld wäre und da nichts nachpflegt, sondern einfach generell ein Linux-Problem vorliegt und Treiber für obskure Hardware-Konfigurationen meistens nicht vorliegen. Der HM80 als auch der 90er sind in sofern eben speziell, was leider in der Natur von solchen Mini-PCs oder auch Notebooks liegt.

Hallo Thorben,

aus Erfahrung mit Proxmox seit es die erste Version gab, liegt es nicht an der Hardware,

sondern oftmals an Resourcen-Verbrauch durch Angriffe. Ich würde Dein System anders

absichern - einfach mal versuchsweise. Dies funktioniert auf Ebene der Proxmox - Firewall

des Hosts.

Wenn Dich das interessiert, dann meld Dich mal.

Grüße

Detlef

aus Erfahrung mit Proxmox seit es die erste Version gab, liegt es nicht an der Hardware,

sondern oftmals an Resourcen-Verbrauch durch Angriffe. Ich würde Dein System anders

absichern - einfach mal versuchsweise. Dies funktioniert auf Ebene der Proxmox - Firewall

des Hosts.

Wenn Dich das interessiert, dann meld Dich mal.

Grüße

Detlef

Die Resourcen des Hypervisors hast du an die pfSense VM durchgereicht?

Promox Settings an Firewall VM durchreichen

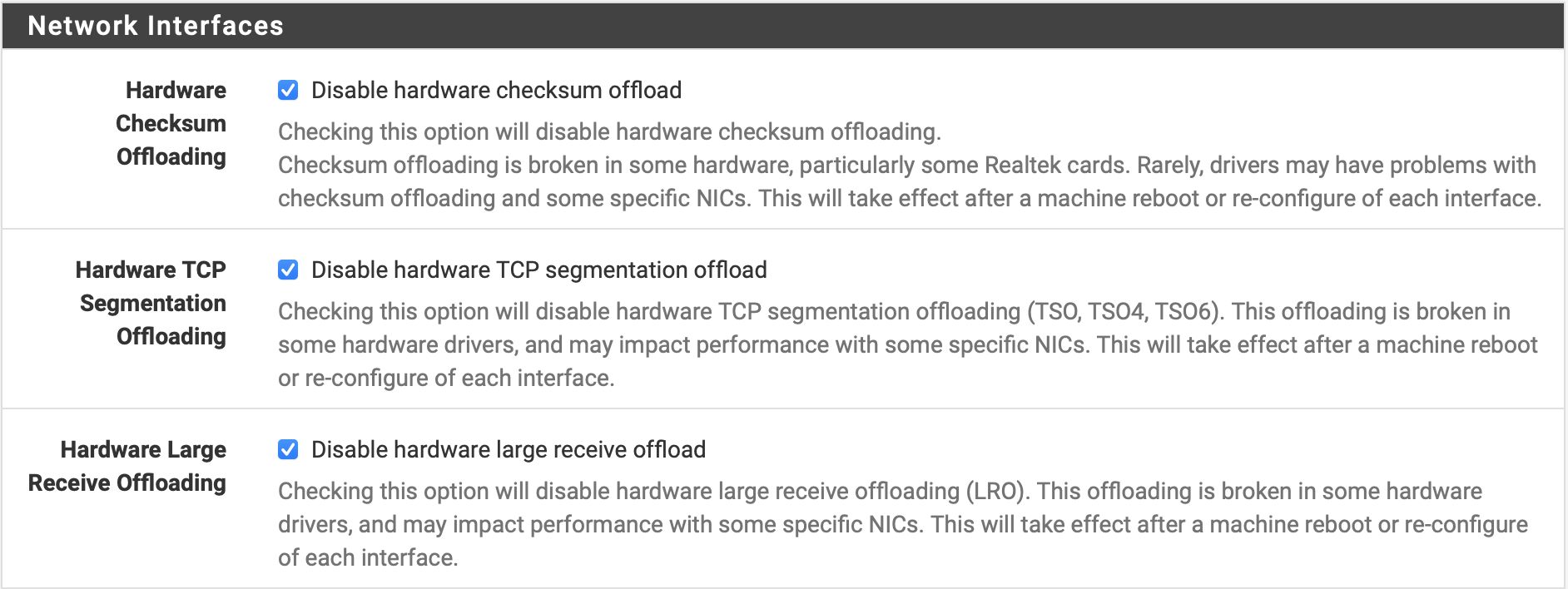

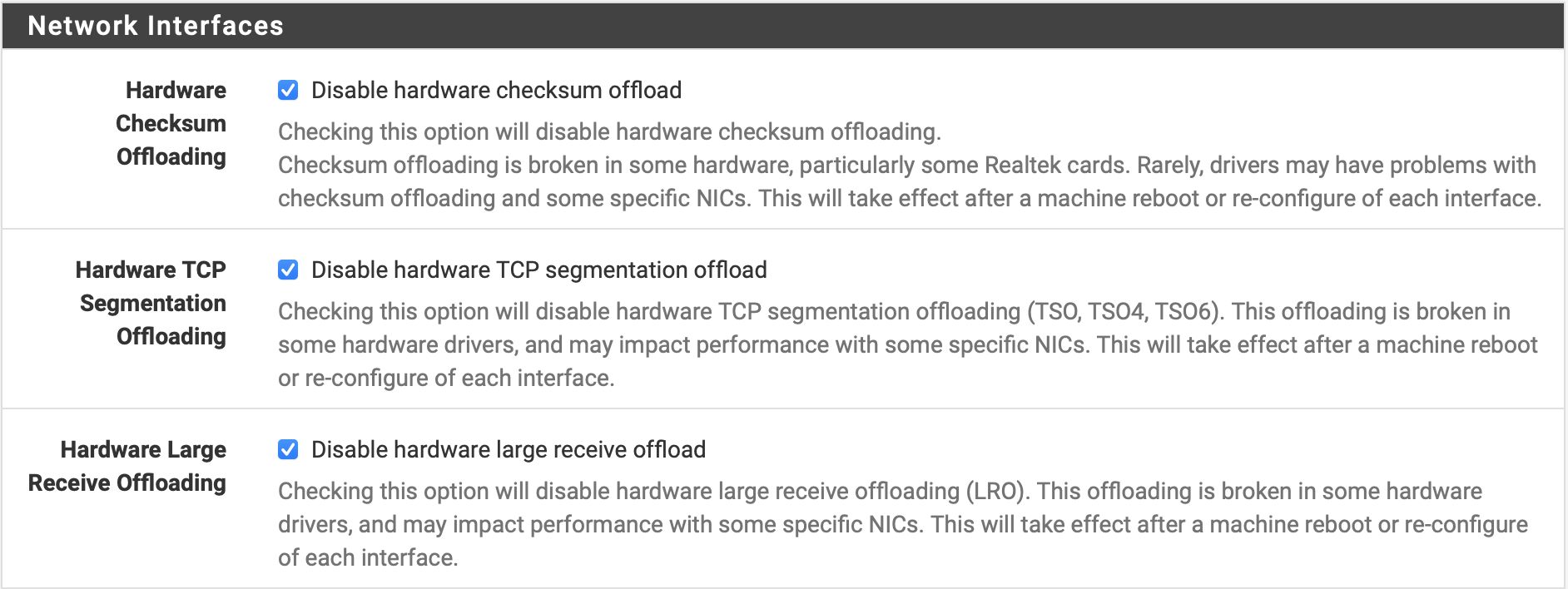

Ein weiterer wichtigier Punkt der häufig bei der Firewall Virtualisierung gemacht wird ist das NIC Offloading erstmal zu deaktivieren.

Das ist in hohem Maße davon abhängig welche virtuellen Adapter verwendet werden und in welchen Versionen.

Das ist in hohem Maße davon abhängig welche virtuellen Adapter verwendet werden und in welchen Versionen.

Welche Dramen das verursachen kann zeigt dir das Beispiel Windows.

Promox Settings an Firewall VM durchreichen

Ein weiterer wichtigier Punkt der häufig bei der Firewall Virtualisierung gemacht wird ist das NIC Offloading erstmal zu deaktivieren.

Welche Dramen das verursachen kann zeigt dir das Beispiel Windows.

Also bei meinem HM80 mit Proxmox VE hatte ich unter bestimmten Umständen ausfälle der Disken die zu einem crash geführt haben.

Ich hatte vor ein paar Monaten den Support kontaktiert und die Information erhalten des dies mit den Energieeinstellungen zusammen hängen könnte.

Ich habe mir hierzu folgende Notizen gemacht:

HM80 SATA SSD I/O Error

Falls es zu I/O errors kommt, kann es helfen die SCSI/SATA Power Policy anzupassen.

Temporär testen kann man dies indem man den Wert in den Dateien auf max_performance setzt.

Um das Permanent zu machen kann eine udev Regel erstellt werden

Weitere Information finden sich im ArchWiki: wiki.archlinux.org/title/Power_management#SATA_Active_Link_Power ...

Aus meinem Support E-Mail mit Minisforum

Ich hatte vor ein paar Monaten den Support kontaktiert und die Information erhalten des dies mit den Energieeinstellungen zusammen hängen könnte.

Ich habe mir hierzu folgende Notizen gemacht:

HM80 SATA SSD I/O Error

Falls es zu I/O errors kommt, kann es helfen die SCSI/SATA Power Policy anzupassen.

Temporär testen kann man dies indem man den Wert in den Dateien auf max_performance setzt.

/sys/class/scsi_host/host*/link_power_management_policy

max_performance/etc/udev/rules.d/hd_power_save.rules

ACTION=="add", SUBSYSTEM=="scsi_host", KERNEL=="host*", ATTR{link_power_management_policy}="max_performance" Aus meinem Support E-Mail mit Minisforum

Engineers recommend that you modify the following path files,

/sys/class/scsi_host/host1/link_power_management_policy

- and change the configuration to:

max_performance

/sys/class/scsi_host/host1/link_power_management_policy

- and change the configuration to:

max_performance

Knapp zusammenfassen, möchte ich grundsätzliche Erfahrungen (gilt natürlich nur für öffentliche Proxmox-Hosts) und da sollte man zuerst suchen:

a) Belastungen, die über das Netz rein kommen, sind in den meisten Fällen schuld - Ich habe diverse Lösungen, um diese Probleme gen 0 zu reduzieren

b) dann kommt Speicherbelastung, die kann sich auch fehlerhaft bemerkbar machen als Netzbelastung

c) Wenn der normale RAM nicht ausreicht, versucht Proxmox zu swappen - wird der Swap zu hoch verwendet, geht das hoch in der Netzwerkbelastung, obwohl es eigentlich nur die Disks belastet und zeigt sich auch im IO

d) geht der IO zu hoch, geht LoadAverage immer weiter hoch und auch die CPU wird zusätzlich massiv belastet

e) Das System schaukelt sich auf, weil Jobs nicht fertig werden und sich die Kette der laufenden Prozesse immer weiter erhöht und alle Prozesse dann auch wieder auf die CPUs verteilt werden müssen und dann kommen noch mehr Prozesse dazu usw.

f) früher habe ich mir den Wolf gesucht mit Analyse-Tools wie htop, atop usw

Verbesserungen erreicht man, indem man sehr schnelle Platten hat, als nVME und am besten mit ZFS - je mehr Disks um so besser

Ausreichend Speicher hat und ich sag mal aus Erfahrung bei SSD/nVME 30-50% des RAMs zusätzlich an Swap in kleinen Swapparts von 2 GB verfügbar hält

ZFS ist superschnell und sehr sicher, aber man braucht mehr RAM und muß den RAM beobachten und für ZFS optimieren.

Jegliche kleinere Netzwerkbelastung führt leicht zur Aufschaukelung, wenn das System nicht vorher schon perfekt lief. Daher sind Angriffe von Außen, die bei öffentlichen Systemen immer erfolgen, weitgehend zu vermeiden. Und dazu habe ich diverse intelligente Lösungen geschrieben

a) Belastungen, die über das Netz rein kommen, sind in den meisten Fällen schuld - Ich habe diverse Lösungen, um diese Probleme gen 0 zu reduzieren

b) dann kommt Speicherbelastung, die kann sich auch fehlerhaft bemerkbar machen als Netzbelastung

c) Wenn der normale RAM nicht ausreicht, versucht Proxmox zu swappen - wird der Swap zu hoch verwendet, geht das hoch in der Netzwerkbelastung, obwohl es eigentlich nur die Disks belastet und zeigt sich auch im IO

d) geht der IO zu hoch, geht LoadAverage immer weiter hoch und auch die CPU wird zusätzlich massiv belastet

e) Das System schaukelt sich auf, weil Jobs nicht fertig werden und sich die Kette der laufenden Prozesse immer weiter erhöht und alle Prozesse dann auch wieder auf die CPUs verteilt werden müssen und dann kommen noch mehr Prozesse dazu usw.

f) früher habe ich mir den Wolf gesucht mit Analyse-Tools wie htop, atop usw

Verbesserungen erreicht man, indem man sehr schnelle Platten hat, als nVME und am besten mit ZFS - je mehr Disks um so besser

Ausreichend Speicher hat und ich sag mal aus Erfahrung bei SSD/nVME 30-50% des RAMs zusätzlich an Swap in kleinen Swapparts von 2 GB verfügbar hält

ZFS ist superschnell und sehr sicher, aber man braucht mehr RAM und muß den RAM beobachten und für ZFS optimieren.

Jegliche kleinere Netzwerkbelastung führt leicht zur Aufschaukelung, wenn das System nicht vorher schon perfekt lief. Daher sind Angriffe von Außen, die bei öffentlichen Systemen immer erfolgen, weitgehend zu vermeiden. Und dazu habe ich diverse intelligente Lösungen geschrieben

Ja, daß ist super wichtig, daß das ZFS korrekt läuft, wie Gentooist schrieb !!! Wenn es sich um große Datenmengen handelt, ist es sinnvoll evtl zuerst alle virtuellen Server herunter zu fahren und dann den RAM-Speicher frei zu machen. Und danach das ZFS bereinigen. Zu viel Mist im ZFS kann auch dazu führen, daß man Daten verliert! Daher ist es wichtig, daß es sauber ist, weil es ansonsten auch Kapazitäten frisst!

zpool status / list kontrollieren.

Bitte dazu unbedingt die vielen Anleitungen zu ZFS studieren, ob ggf. ein scrub notwendig ist, wie lange ist er her usw. - bei mir läuft der normalerweise monatlich automatisch und brauchte 9 Minuten. Das ist auch abhängig vom Type der Platten, auf denen ZFS läuft und ob nur 2 Platten verwendet werden oder mehrere. Wieder zurück natürlich, unbedingt die Menge des freien Speichers zu prüfen, denn ZFS braucht davon am liebsten viel, aber das lässt sich sehr gut begrenzen!

Auch ist zu prüfen, ob und wie Du was sauber oder verstellt hast, bezüglich Deduplizierung und Komprimierung!

Beachte, daß von oberer Ebene vererbt wird und die einzelnen Server oder SnapShots ggf. eine andere Einstellung haben können. Wenn Du SATA hast, dann ist Dedup und Komprimierung sicher nicht sinnvoll. Bei nvme lasse ich es dedup aus, compress on, wenn genug Platz auf dem Server vorhanden ist. Hier arbeitest Du mit zfs get dedup / compress - Wichtig ist, daß swap kein dedup und zle haben sollte! dedup auf nvme oder ssd sollte auch kein großes Problem sein. Dedup braucht Kapazität und viel RAM, spart aber Disk-Speicher! Da muß man Erfahrungen auch sammeln.

zpool status / list kontrollieren.

Bitte dazu unbedingt die vielen Anleitungen zu ZFS studieren, ob ggf. ein scrub notwendig ist, wie lange ist er her usw. - bei mir läuft der normalerweise monatlich automatisch und brauchte 9 Minuten. Das ist auch abhängig vom Type der Platten, auf denen ZFS läuft und ob nur 2 Platten verwendet werden oder mehrere. Wieder zurück natürlich, unbedingt die Menge des freien Speichers zu prüfen, denn ZFS braucht davon am liebsten viel, aber das lässt sich sehr gut begrenzen!

Auch ist zu prüfen, ob und wie Du was sauber oder verstellt hast, bezüglich Deduplizierung und Komprimierung!

Beachte, daß von oberer Ebene vererbt wird und die einzelnen Server oder SnapShots ggf. eine andere Einstellung haben können. Wenn Du SATA hast, dann ist Dedup und Komprimierung sicher nicht sinnvoll. Bei nvme lasse ich es dedup aus, compress on, wenn genug Platz auf dem Server vorhanden ist. Hier arbeitest Du mit zfs get dedup / compress - Wichtig ist, daß swap kein dedup und zle haben sollte! dedup auf nvme oder ssd sollte auch kein großes Problem sein. Dedup braucht Kapazität und viel RAM, spart aber Disk-Speicher! Da muß man Erfahrungen auch sammeln.

Wie genau sieht denn dein Festplatten-Setup aus? Die Infos fände ich gerade bei IOWait Problemen recht wichtig.

Also auf was für Platten läuft der Proxmox Host, was ist das für ein ZFS-Pool (HDD via USB?) usw.

Falls du dein ZFS via USB laufen haben solltest, bin ich mir zu 99% sicher, dass das dein Problem sein wird.

Also auf was für Platten läuft der Proxmox Host, was ist das für ein ZFS-Pool (HDD via USB?) usw.

Falls du dein ZFS via USB laufen haben solltest, bin ich mir zu 99% sicher, dass das dein Problem sein wird.

aber das Durchreichen von Resourcen des Hypervisors habe ich nirgends gelesen und daher auch nicht eingestellt.

Ein fataler Fehler! Insbesondere was AES-NI anbetrifft! bezüglich dieser Einstellung gelesen zu haben, das beim HM90 davon abgeraten wird.

Ziemlicher Unsinn...aber egal. Die Kryptofunktionen arbeiten dann alle in Software und fressen massiv Performance was dann deutlch zulasten des Gesamtsystems geht.als Model bei der VM habe ich "VirtlO (paravirtualized) gewählt.

Musst du checken. Hier sind "vmxnet3" im Einsatz welche auch Offloading supporten und so performanter laufen in einer VM.Last hier auf einem einfachen Intel NUC mit 2 weiteren VMs (Debian, Win10) unter 10%.

Hallo, den Swap mit 70% ist m.E. zu hoch. Das musst Du beobachten. Wenn zu viel auf den virtuellen Maschinen geswappt wird, geht die Performance den Bach runter und man sieht es als Network-Traffic, wie ich schon geschrieben habe.

Wenn Du ZFS einsetzt, dann braucht der Host für ZFS viel RAM, insbesondere Dedup und Kompremierung und das musst Du prüfen, ob dieser weg genommen wird, vom System. Das kannst Du nicht vom Proxmox GUI aus prüfen, sondern nur direkt mit htop und was Performance anbetrifft auch mit atop. Allerdings wirst Du ramdösig, wenn Du nicht verstehst, was da abläuft - (ZFS macht da merkwürdige Dinge und da muß man nicht zu viel versuchen, sondern wissen, daß man Swap vermeiden sollte! Ich muß bei Produktions-Hosts im laufenden Betrieb alle paar Wochen mal den swap abschalten und gleich wieder einschalten. mit swapoff -a && spapon -a und dann ist der Host wieder 100% schnell. Wenn swapoff "hängt", dann die blockierenden VEs herunter fahren. Warum da manche Prozesse nicht den Swap wieder frei geben, weiß ich nicht. Es trifft bei allen VEs auf und ist nicht auf spezielle Konfigurationen begrenzt und es passiert auch nicht immer, aber oft nach Überlastungen, wie Angriffe von Außen.

und da muß man nicht zu viel versuchen, sondern wissen, daß man Swap vermeiden sollte! Ich muß bei Produktions-Hosts im laufenden Betrieb alle paar Wochen mal den swap abschalten und gleich wieder einschalten. mit swapoff -a && spapon -a und dann ist der Host wieder 100% schnell. Wenn swapoff "hängt", dann die blockierenden VEs herunter fahren. Warum da manche Prozesse nicht den Swap wieder frei geben, weiß ich nicht. Es trifft bei allen VEs auf und ist nicht auf spezielle Konfigurationen begrenzt und es passiert auch nicht immer, aber oft nach Überlastungen, wie Angriffe von Außen.

ZFS ist so ausgelegt, daß alles, wenn es richtig konfiguriert ist, auch im Laufenden Betrieb erfolgen kann. Du musst also nicht die Virtuellen Maschinen runter fahren, um ein Scrub zu machen. Aber solltest Du die Kabel wechseln, empfehle ich vorher die Maschine herunter zu fahren, weil das kann extrem in den Fingern knistern, bis zum Admin-Tod! Einen Trim habe ich noch nie angeschmissen, aber Proxmox - Backup hat so eine Prune-Funktion und die sollte nur dann laufen, wenn nichts an anderen Jobs läuft, weil sie massiv das System belastet für etliche Stunden.

Wenn die Virtuellen Einheiten nicht auf das ZFS Disks zugreifen, was in Fehler geht, würde ich auch nicht bei den virtuellen Einheiten suchen. Das Durchreichen von Hardware sollte möglichst gar nicht erfolgen und trotzdem läuft in der Regel alles, außer vielleicht Crypto-Schürfung etc. Ansonsten kann es auch eine Festplatte / SSD sein, die da Probleme macht?

Und Performance, ohne speziell die Maschine zu kennen, würde ich immer erst auf "mittel/Standard" einstellen. Das sollte eigentlich mit dieser Einstellung immer laufen, es sei denn, der Beipack-Zettel empfiehlt bei speziellen Konfigurationen etwas anderes. Optimieren kann man immer später noch.

Ich würde, um auszuschließen, daß der Host von außen zu stark belastet wird, diesen vorübergehend in der Firewall sperren. Normalerweise kann dies sehr gut in Proxmox Firewall eingestellt werden. Du mußt dann Deinem eigenen Client bevor Du alles sperrst, jedoch als IP Zugriff gewähren, sonst hängst Du Dich ggf. ab!

Fehlersuche kann richtig zeitaufwendig sein und manchmal sogar zum Wahnsinn treiben!

Wenn Du ZFS einsetzt, dann braucht der Host für ZFS viel RAM, insbesondere Dedup und Kompremierung und das musst Du prüfen, ob dieser weg genommen wird, vom System. Das kannst Du nicht vom Proxmox GUI aus prüfen, sondern nur direkt mit htop und was Performance anbetrifft auch mit atop. Allerdings wirst Du ramdösig, wenn Du nicht verstehst, was da abläuft - (ZFS macht da merkwürdige Dinge

ZFS ist so ausgelegt, daß alles, wenn es richtig konfiguriert ist, auch im Laufenden Betrieb erfolgen kann. Du musst also nicht die Virtuellen Maschinen runter fahren, um ein Scrub zu machen. Aber solltest Du die Kabel wechseln, empfehle ich vorher die Maschine herunter zu fahren, weil das kann extrem in den Fingern knistern, bis zum Admin-Tod! Einen Trim habe ich noch nie angeschmissen, aber Proxmox - Backup hat so eine Prune-Funktion und die sollte nur dann laufen, wenn nichts an anderen Jobs läuft, weil sie massiv das System belastet für etliche Stunden.

Wenn die Virtuellen Einheiten nicht auf das ZFS Disks zugreifen, was in Fehler geht, würde ich auch nicht bei den virtuellen Einheiten suchen. Das Durchreichen von Hardware sollte möglichst gar nicht erfolgen und trotzdem läuft in der Regel alles, außer vielleicht Crypto-Schürfung etc. Ansonsten kann es auch eine Festplatte / SSD sein, die da Probleme macht?

Und Performance, ohne speziell die Maschine zu kennen, würde ich immer erst auf "mittel/Standard" einstellen. Das sollte eigentlich mit dieser Einstellung immer laufen, es sei denn, der Beipack-Zettel empfiehlt bei speziellen Konfigurationen etwas anderes. Optimieren kann man immer später noch.

Ich würde, um auszuschließen, daß der Host von außen zu stark belastet wird, diesen vorübergehend in der Firewall sperren. Normalerweise kann dies sehr gut in Proxmox Firewall eingestellt werden. Du mußt dann Deinem eigenen Client bevor Du alles sperrst, jedoch als IP Zugriff gewähren, sonst hängst Du Dich ggf. ab!

Fehlersuche kann richtig zeitaufwendig sein und manchmal sogar zum Wahnsinn treiben!

Proxmox ist eigentlich ein Produkt für den professionellen Einsatz, also Hosts, bei denen grundsätzlich der Host seine Arbeit leisten soll, also nicht in irgendwelchen Zeiten, energetisch schlafen gelegt wird. Von der Seite her, sollten aus meinem Bauchgefühl heraus, alle Einstellungen, die z.B. die Festplatten in einen Ruhemodus versetzen, abgeschaltet werden.

Das kann natürlich bei Deinem Gerät default-seitig ganz anders gemeint sein. Da wird default-seitig das Gerät möglichst in diesen Ruhemodus versetzt, weil man auf Grund des Gerätes selbst davon ausgeht, daß es nicht als Host verwendet wird, sondern vielleicht als Heimcomputer. Ein solcher soll sich schlafen legen, wenn der Anwender ihn nicht benutzt, um möglichst Strom zu sparen. Wenn man diesen Computer, der dann eigentlich als Heimcomputer verwendet wird, als Host verwendet, dann ist natürlich klar, daß sich das beißt und dafür die Einstellungen verändert werden müssen.

Ich gebe dabei aber zu beachten, daß dann aber auch sichergestellt werden muß, das die Temperaturen im Gerät und um das Gerät herum, dem Gerät und seinen Innereien gefallen muß! Man kann also nicht z.B. in meinem Büro ein paar Hosts aufstellen, die hier in Granada bei sommerlichen Temperaturen von 45 Grad ohne Klimaanlage klar kommen sollen. Die würden vielleicht gerade mal einen Tag laufen und dann wäre der Ausfall vorprogrammiert.

Selbst ich muß vom Büro ins klimatisierte Wohnzimmer flüchten und dann evtl. weniger auf einem Notebook arbeiten - oder besser Urlaub machen!

Wenn Du gut bist, hast Du das aber schon alles gut geprüft vorher.

Das kann natürlich bei Deinem Gerät default-seitig ganz anders gemeint sein. Da wird default-seitig das Gerät möglichst in diesen Ruhemodus versetzt, weil man auf Grund des Gerätes selbst davon ausgeht, daß es nicht als Host verwendet wird, sondern vielleicht als Heimcomputer. Ein solcher soll sich schlafen legen, wenn der Anwender ihn nicht benutzt, um möglichst Strom zu sparen. Wenn man diesen Computer, der dann eigentlich als Heimcomputer verwendet wird, als Host verwendet, dann ist natürlich klar, daß sich das beißt und dafür die Einstellungen verändert werden müssen.

Ich gebe dabei aber zu beachten, daß dann aber auch sichergestellt werden muß, das die Temperaturen im Gerät und um das Gerät herum, dem Gerät und seinen Innereien gefallen muß! Man kann also nicht z.B. in meinem Büro ein paar Hosts aufstellen, die hier in Granada bei sommerlichen Temperaturen von 45 Grad ohne Klimaanlage klar kommen sollen. Die würden vielleicht gerade mal einen Tag laufen und dann wäre der Ausfall vorprogrammiert.

Selbst ich muß vom Büro ins klimatisierte Wohnzimmer flüchten und dann evtl. weniger auf einem Notebook arbeiten - oder besser Urlaub machen!

Wenn Du gut bist, hast Du das aber schon alles gut geprüft vorher.