SMB 3.0 "langsame" Übertragungsgeschwindigkeit

Hallo zusammen.

Wir haben hier ein qnap allflash nvme storage direkt mit einem neuen Server verbunden. Wir möchten gern intensive lese und schreibzugriffe per smb auf dem storage durchführen.

Dazu haben wir die qnap und auch den Server direkt mit einer 100G QSFP28 Schnittstelle ausgestattet und direkt miteinander verbunden.

Auf beiden Seiten habe ich Jumboframes aktiviert.

Als Betriebsystem auf dem Server kommt Windows Server 2022 zum Einsatz.

Hardware Server:

2x AMD EPYC 9124

256GB RAM

NVME Allflash Raid 5 (Lokal lesend >20GB/s schreibend >12GB/s @1mb Blocksize)

Intel E810 QSFP28 Netzwerkkarte

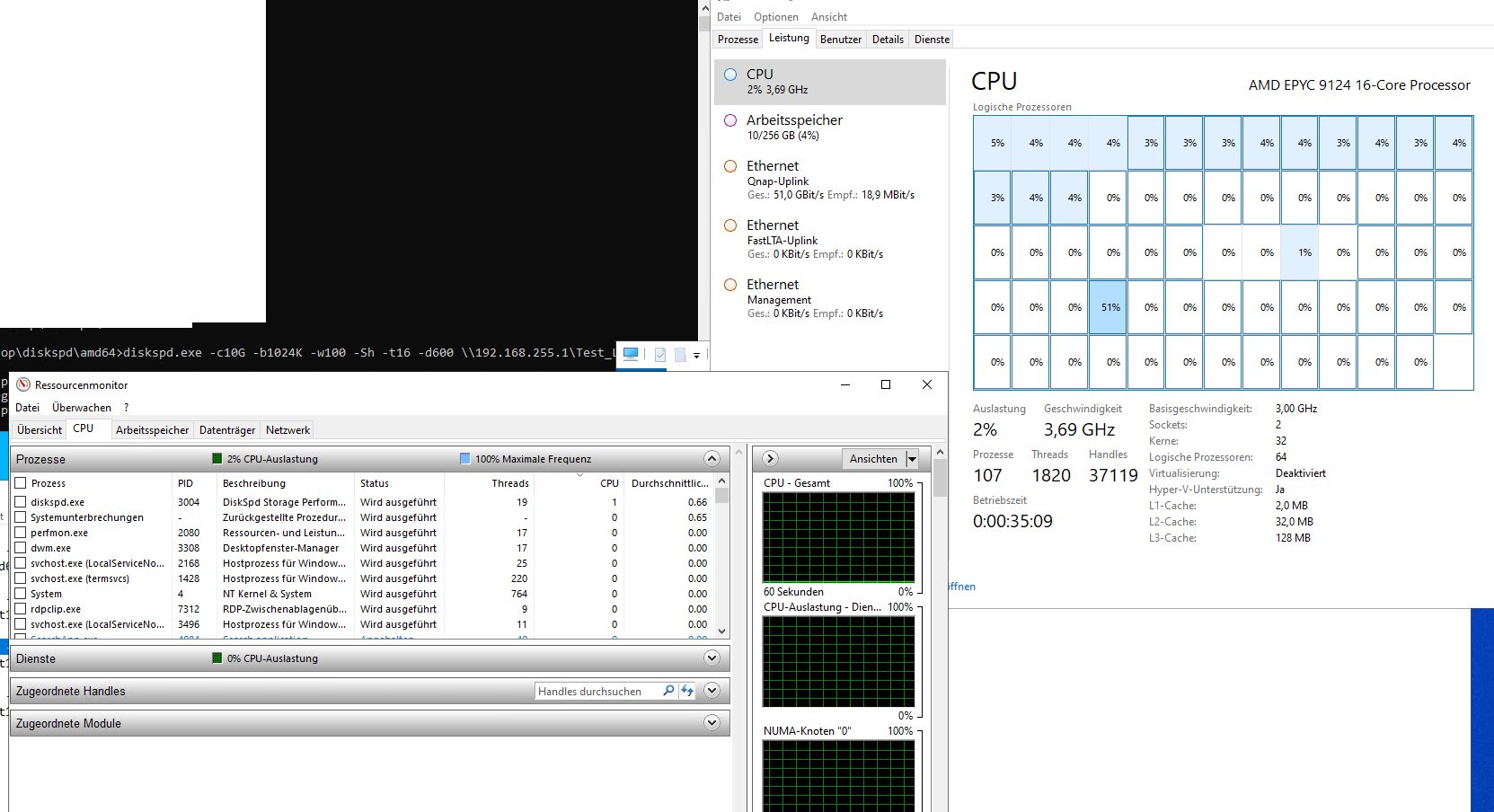

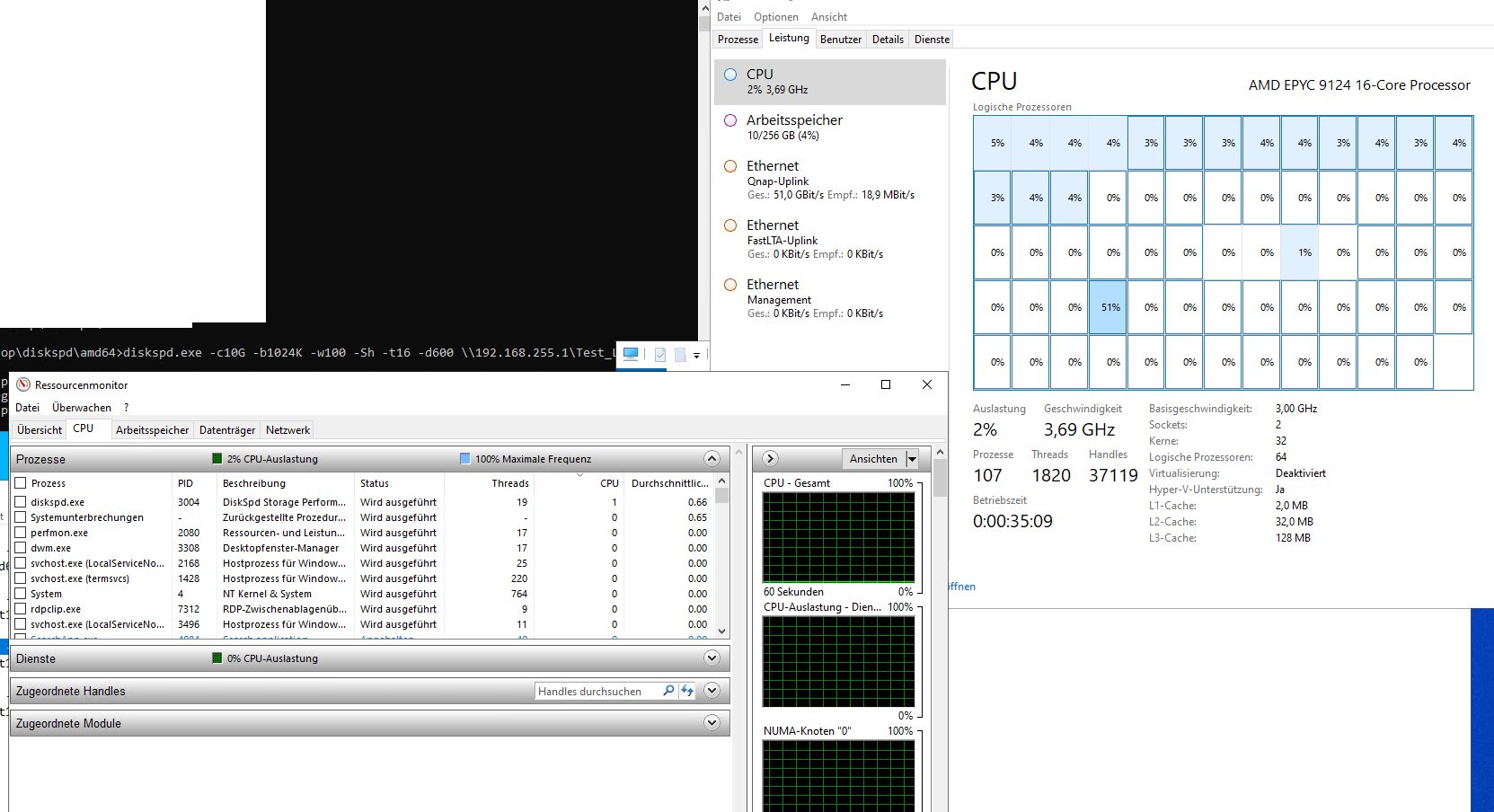

Folgende Messwerte konnte ich mittels Microsoft SPD aus Sicht des Servers zum qnap Storage ermitteln:

schreibend @1mb Blocksize zu qnap storage: ~50-60Gbit/s

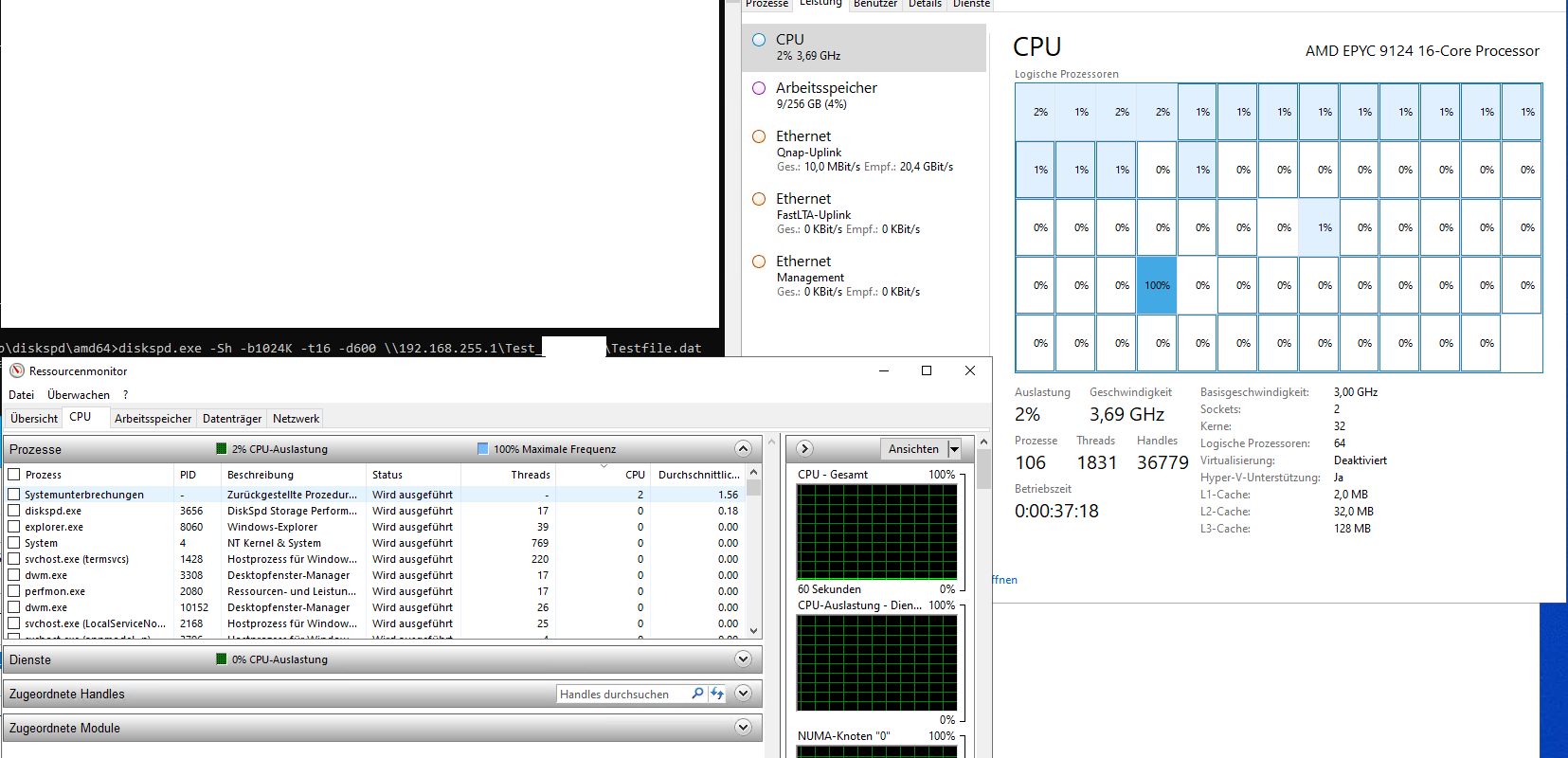

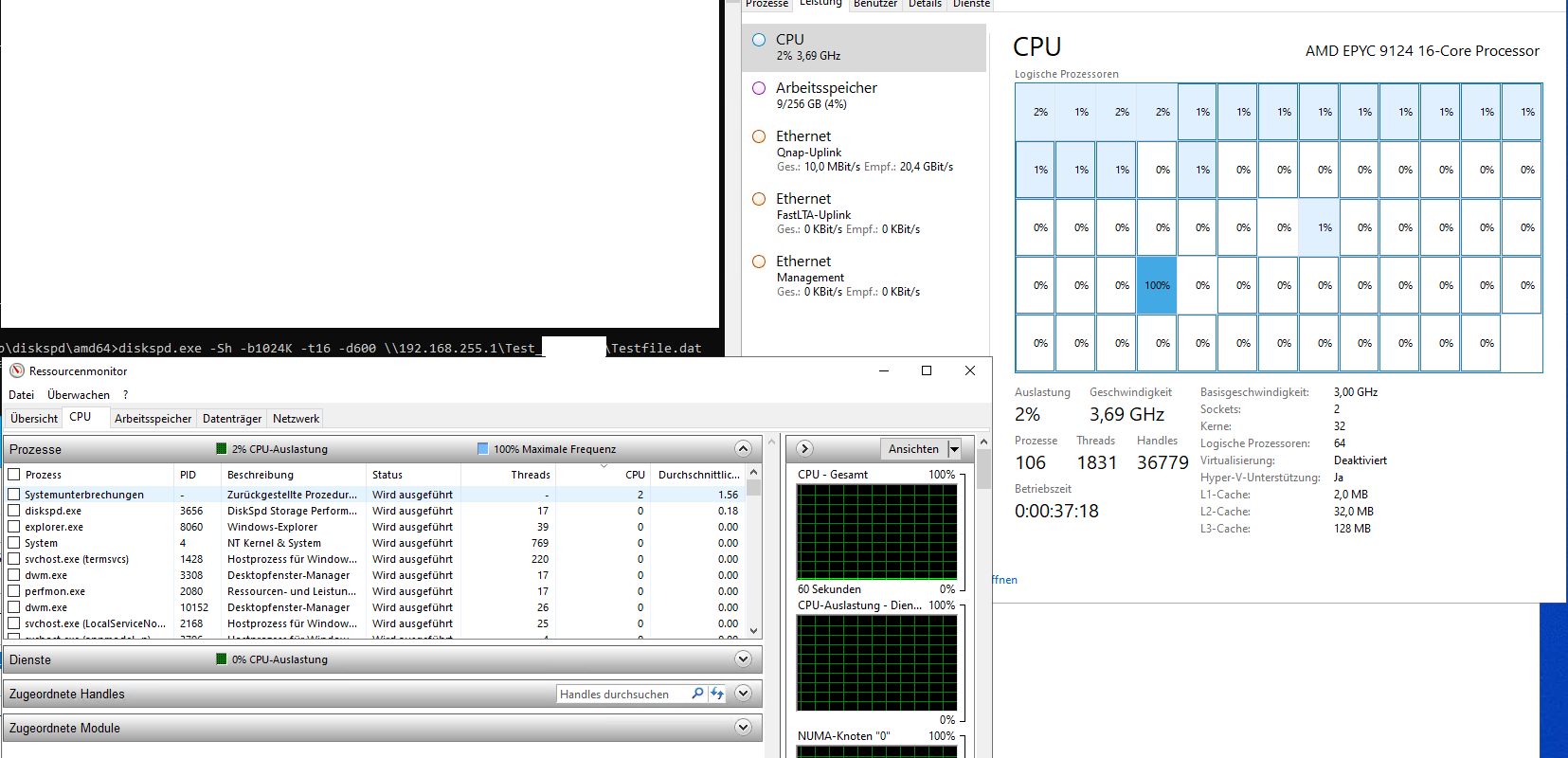

lesend @1mb Blocksize von qnap: ~20Gbit/s

Auffällig ist dabei das beim lesen vom Storage ein CPU Core vom Windows Server konstant bei 100% hängt.

Ich beführchte eine Core-limitierung einer Windows Applikation.... Was ich jedoch recht verwunderlich finde, da SFP28 mit 25Gbit/s im Datacenter schon lange Standard ist. und die Windowsserver lesens über SMB nicht mal das erreichen.

Hat jemand schon mal etwas ähnliches aufgebaut und hat vlt. einen Tipp?

grüße

Wir haben hier ein qnap allflash nvme storage direkt mit einem neuen Server verbunden. Wir möchten gern intensive lese und schreibzugriffe per smb auf dem storage durchführen.

Dazu haben wir die qnap und auch den Server direkt mit einer 100G QSFP28 Schnittstelle ausgestattet und direkt miteinander verbunden.

Auf beiden Seiten habe ich Jumboframes aktiviert.

Als Betriebsystem auf dem Server kommt Windows Server 2022 zum Einsatz.

Hardware Server:

2x AMD EPYC 9124

256GB RAM

NVME Allflash Raid 5 (Lokal lesend >20GB/s schreibend >12GB/s @1mb Blocksize)

Intel E810 QSFP28 Netzwerkkarte

Folgende Messwerte konnte ich mittels Microsoft SPD aus Sicht des Servers zum qnap Storage ermitteln:

schreibend @1mb Blocksize zu qnap storage: ~50-60Gbit/s

lesend @1mb Blocksize von qnap: ~20Gbit/s

Auffällig ist dabei das beim lesen vom Storage ein CPU Core vom Windows Server konstant bei 100% hängt.

Ich beführchte eine Core-limitierung einer Windows Applikation.... Was ich jedoch recht verwunderlich finde, da SFP28 mit 25Gbit/s im Datacenter schon lange Standard ist. und die Windowsserver lesens über SMB nicht mal das erreichen.

Hat jemand schon mal etwas ähnliches aufgebaut und hat vlt. einen Tipp?

grüße

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 7608250497

Url: https://administrator.de/forum/smb-3-0-langsame-uebertragungsgeschwindigkeit-7608250497.html

Ausgedruckt am: 02.08.2025 um 11:08 Uhr

6 Kommentare

Neuester Kommentar

Moin...

Kann man sich am Windows Server anzeigen lassen ob die SMB Verbindung auf iWARP zurückgreift?

In der Intel E810 am Windows-Server ist das an. Jedoch steht auf der qnap Webseite nach wie vor "in Kürze verfügbar".

qnap.com/de-de/product/qxg-100g2sf-e810

Ich vermute das genau das noch nicht funktioniert und es daher zu hoher CPU Last kommt....

Frank

Zitat von @HamBam2:

Ich hab mal reingeschaut. Bei mir werden die Verbindungen wenigstens als Datacenter erkannt.

Leider ist das Script nicht für Server geeignet.

nein, ist es nicht, aber es bringt dich dahin, wo du hinwillst!Ich hab mal reingeschaut. Bei mir werden die Verbindungen wenigstens als Datacenter erkannt.

Leider ist das Script nicht für Server geeignet.

Kann man sich am Windows Server anzeigen lassen ob die SMB Verbindung auf iWARP zurückgreift?

In der Intel E810 am Windows-Server ist das an. Jedoch steht auf der qnap Webseite nach wie vor "in Kürze verfügbar".

qnap.com/de-de/product/qxg-100g2sf-e810

Ich vermute das genau das noch nicht funktioniert und es daher zu hoher CPU Last kommt....

och menno. Schau im Taskmanager nach welcher Prozeß das ist... auf Server 2022 meist der Defender.

Ansonsten kostet SMB signing / SMB encryption signifikante Mengen an Rechenzeit, dazu kommen die jüngsten Upddates von Microsoft zum Thema SMB hardening...

Edit 12 Gigabyte pro Sekunde und das nennt der TO langsam? Das ist die Maximalperformance einer 100 Gigabit-Schnittstelle. Wenn die in FSP läuft 200 Gigabit effektiv, QSFP 400 Gigabit, aber dann hängt da am Ende ein Storagecontroller, der dann auch am Ende seiner Leistungsfähigkeit ist.

Ehrlich, diese Probleme möcht ich mal haben... im Serverbetrieb ist 1 Gigabyte pro Sekunde schon mehr als ausreichend.

Ansonsten kostet SMB signing / SMB encryption signifikante Mengen an Rechenzeit, dazu kommen die jüngsten Upddates von Microsoft zum Thema SMB hardening...

Edit 12 Gigabyte pro Sekunde und das nennt der TO langsam? Das ist die Maximalperformance einer 100 Gigabit-Schnittstelle. Wenn die in FSP läuft 200 Gigabit effektiv, QSFP 400 Gigabit, aber dann hängt da am Ende ein Storagecontroller, der dann auch am Ende seiner Leistungsfähigkeit ist.

Ehrlich, diese Probleme möcht ich mal haben... im Serverbetrieb ist 1 Gigabyte pro Sekunde schon mehr als ausreichend.

Serie: SMB 3.0

SMB 3.0 "langsame" Übertragungsgeschwindigkeit6