Analyse: Windows FileServer wird regelmäßig außer Gefehl gesetzt

Guten Tag liebe Community,

habe ein Problem, dass nun doch immer häufiger ein FileServer von uns regelmäßig nicht mehr richtig funktioniert.

Wir vermuten, dass ein unbekannter Prozess - Zeitweise - richtig stark entweder in der Prozessorauslastung und/oder den Arbeitsspeicher belastet.

Man merkt es bis nur noch daran, dass der Zugriff auf den Fileserver auf seine Datenfreigaben nicht mehr korrekt funktioniert(es lädt teilweise garnicht oder braucht mehrere Minuten)

Können wir diesen Prozess mit "perfmon" versuchen zu erfassen? Mit welchen Parametern würde ich arbeiten? Hab ihr Seiten, die mir vielleicht sogar eine Schrittweise Anleitung erklären würden? Mir fällt es schwer im Moment ohne richtiges Wissen diesen Prozess zu um zingeln.

VG Dani

habe ein Problem, dass nun doch immer häufiger ein FileServer von uns regelmäßig nicht mehr richtig funktioniert.

Wir vermuten, dass ein unbekannter Prozess - Zeitweise - richtig stark entweder in der Prozessorauslastung und/oder den Arbeitsspeicher belastet.

Man merkt es bis nur noch daran, dass der Zugriff auf den Fileserver auf seine Datenfreigaben nicht mehr korrekt funktioniert(es lädt teilweise garnicht oder braucht mehrere Minuten)

Können wir diesen Prozess mit "perfmon" versuchen zu erfassen? Mit welchen Parametern würde ich arbeiten? Hab ihr Seiten, die mir vielleicht sogar eine Schrittweise Anleitung erklären würden? Mir fällt es schwer im Moment ohne richtiges Wissen diesen Prozess zu um zingeln.

VG Dani

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 663170

Url: https://administrator.de/forum/analyse-windows-fileserver-wird-regelmaessig-ausser-gefehl-gesetzt-663170.html

Ausgedruckt am: 31.07.2025 um 12:07 Uhr

16 Kommentare

Neuester Kommentar

sorry ich bin kein Perfmon Experte. Ich würde erst mal zusehen, dass ich die Abstürze verhindere. Kannst du temporär den RAM anheben? Hat der ESXi Host selbst noch genügen RAM Puffer? Wie viel RAM hat der Host? Deine Beschreibung klingt irgendwie so danach, als ob dem Host die Puste ausgeht.

Hast du nichts auffälliges im System Eventlog von der VM? Scheint ja sehr periodisch zu sein. Das bestimmt irgend nen abgedrehter Task, der da los läuft.

Hast du nichts auffälliges im System Eventlog von der VM? Scheint ja sehr periodisch zu sein. Das bestimmt irgend nen abgedrehter Task, der da los läuft.

So genau kann ich dir das nicht sagen. Steht bestimmt irgendwo bei Vmware. Aber ich würde glaube ich mal so mit 2-4GB rechnen je nach Host. Ist ein Shared Storage im Einsatz? Oder benutzt du interne Platten? Welche ESXi Version ist im Einsatz? Custom Image?

Seit wann habt ihr das Problem? Was für ein Virenscanner läuft da?

Moin,

Braucht man hier auch nicht zu sein. Die Informationen wurden ja schon vom TO geliefert.

Da stürzt nichts ab. Es wird nur langsamer als eine Schildkröte mit Gehbehinderung.

Das wäre die Lösung.

Nein, hat er nicht. Der Host hat 12Gig (Graph 2 des TO).

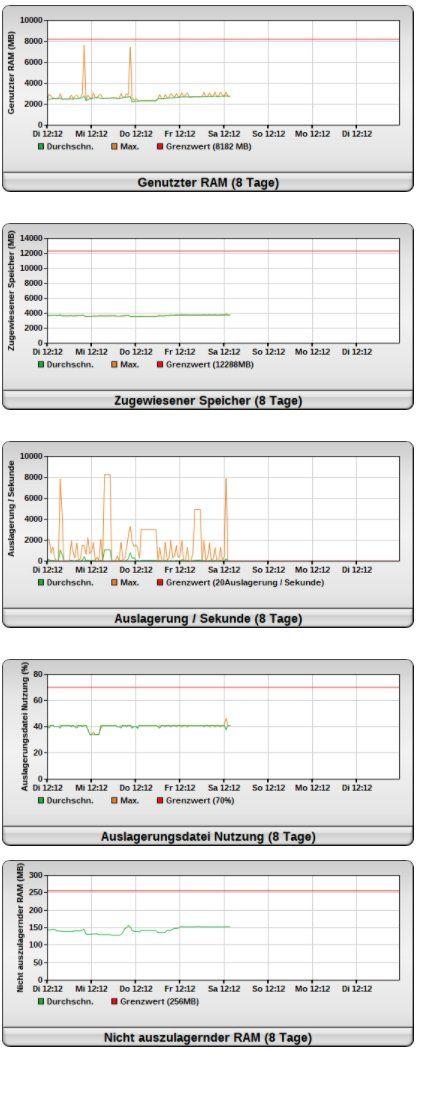

Das klingt nicht nur so, sondern ist so. Der Fileserver hat 4Gig Arbeitsspeicher (Graph 2). Er nutzt bis zu 8Gig (Graph 1). Deshalb muss er auslagern wie blöd (Graph 3). Die Auslagerungsdatei wird zu 40% im Durchschnitt genutzt (Graph 4). Dass dann ein Fileserver nur noch sehr, sehr langsam reagiert, ist kein Wunder. Auslagern ist bei einem Server tödlich für die Performance.

Nö, das ist das vollkommen normale Verhalten eines Fileservers, der unter Speichermangel leidet. Lösung: Mehr Speicher reinstopfen.

hth

Erik

Braucht man hier auch nicht zu sein. Die Informationen wurden ja schon vom TO geliefert.

Ich würde erst mal zusehen, dass ich die Abstürze verhindere.

Da stürzt nichts ab. Es wird nur langsamer als eine Schildkröte mit Gehbehinderung.

Kannst du temporär den RAM anheben?

Das wäre die Lösung.

Hat der ESXi Host selbst noch genügen RAM Puffer?

Nein, hat er nicht. Der Host hat 12Gig (Graph 2 des TO).

Wie viel RAM hat der Host? Deine Beschreibung klingt irgendwie so danach, als ob dem Host die Puste ausgeht.

Das klingt nicht nur so, sondern ist so. Der Fileserver hat 4Gig Arbeitsspeicher (Graph 2). Er nutzt bis zu 8Gig (Graph 1). Deshalb muss er auslagern wie blöd (Graph 3). Die Auslagerungsdatei wird zu 40% im Durchschnitt genutzt (Graph 4). Dass dann ein Fileserver nur noch sehr, sehr langsam reagiert, ist kein Wunder. Auslagern ist bei einem Server tödlich für die Performance.

Hast du nichts auffälliges im System Eventlog von der VM? Scheint ja sehr periodisch zu sein. Das bestimmt irgend nen abgedrehter Task, der da los läuft.

Nö, das ist das vollkommen normale Verhalten eines Fileservers, der unter Speichermangel leidet. Lösung: Mehr Speicher reinstopfen.

hth

Erik

Zitat von @erikro:

Moin,

Braucht man hier auch nicht zu sein. Die Informationen wurden ja schon vom TO geliefert.

Da stürzt nichts ab. Es wird nur langsamer als eine Schildkröte mit Gehbehinderung.

Das wäre die Lösung.

Nein, hat er nicht. Der Host hat 12Gig (Graph 2 des TO).

Das klingt nicht nur so, sondern ist so. Der Fileserver hat 4Gig Arbeitsspeicher (Graph 2). [...]

Moin,

Braucht man hier auch nicht zu sein. Die Informationen wurden ja schon vom TO geliefert.

Ich würde erst mal zusehen, dass ich die Abstürze verhindere.

Da stürzt nichts ab. Es wird nur langsamer als eine Schildkröte mit Gehbehinderung.

Kannst du temporär den RAM anheben?

Das wäre die Lösung.

Hat der ESXi Host selbst noch genügen RAM Puffer?

Nein, hat er nicht. Der Host hat 12Gig (Graph 2 des TO).

Wie viel RAM hat der Host? Deine Beschreibung klingt irgendwie so danach, als ob dem Host die Puste ausgeht.

Das klingt nicht nur so, sondern ist so. Der Fileserver hat 4Gig Arbeitsspeicher (Graph 2). [...]

Argh. Glaub ich brauch ne neue Brille. Habs nicht gesehen. Thx. Da hab ich ja den richtigen Riecher gehabt :D

Moin,

Pauschal kann man das nicht beantworten, dazu wären ein paar mehr Informationen nötig:

Gruß

cykes

Pauschal kann man das nicht beantworten, dazu wären ein paar mehr Informationen nötig:

- Welche ESXI-Version ist das genau?

- Welche Lizenz läuft auf dem Host?

Der ESXI hat noch genug RAM , der hat weit über 100GB

Auf dem Host läuft doch sicher nicht nur der Fileserver!? Wie ist der (Host-)RAM auf die VMs verteilt? Wie sieht es mit Snapshots der Fileserver-VM aus, hängen da noch Generationen von Snapshots fest (bspw. von fehlgeschlagenen Backups)?Gruß

cykes

Ohne mich da jetzt durchzukämpfen haben wir dir doch die Lösung bereits gesagt. Zu wenig RAM im Host und auf der VM!

Auch: 11 (Windows??) VMs auf nem 16GB Host? Wer kam denn auf die Idee? Überprovisionierung hin oder her, das ist eindeutig viel zu viel! Es sei denn es sind kleine Linux Installationen mit 512MB RAM.

Auch: 11 (Windows??) VMs auf nem 16GB Host? Wer kam denn auf die Idee? Überprovisionierung hin oder her, das ist eindeutig viel zu viel! Es sei denn es sind kleine Linux Installationen mit 512MB RAM.

Das hast Du jetzt falsch verstanden, der TE hat sich aber auch maximal umständlich ausgedrückt.

Nicht der Host hat 16GB RAM, sondern die Filerserver VM.

Ich habe mir mal die Mühe gemacht und überschlgsweise (nicht exakt) die einzelnen VMs aufaddiert und komme auf ~140 GB provisioniertes RAM auf 11 VMs + Host verteilt. Der Host hat 256 GB RAM zur Verfügung.

Also, wie oben bereits gesagt, einfach mal der Fileserver VM bspw. 32GB oder mehr RAM zuweisen.

Gruß

cykes

Nicht der Host hat 16GB RAM, sondern die Filerserver VM.

Ich habe mir mal die Mühe gemacht und überschlgsweise (nicht exakt) die einzelnen VMs aufaddiert und komme auf ~140 GB provisioniertes RAM auf 11 VMs + Host verteilt. Der Host hat 256 GB RAM zur Verfügung.

Also, wie oben bereits gesagt, einfach mal der Fileserver VM bspw. 32GB oder mehr RAM zuweisen.

Gruß

cykes

Moin,

wie schon vermutet, ist das Ganze falsch konfiguriert.

Und wofür hat der Host diese Reserve? Falls mal ein Riegel kaputt geht? Oder anders ausgedrückt: Du verschwendest die Hälfte des Speichers. 51% liegen dauerhaft brach. Du könntest auch die Hälfte der Riegel rausnehmen und anderweitig verbauen. Das würde für die Maschine keinen Unterschied machen.

Wie schon mehrfach gesagt: Das ist viel zu wenig. Gönn' dem Teil mal 64Gig und er wird auch nicht mehr auslagern.

Ich wette darauf, dass man das nicht muss. Lange genug warten und das Problem erledigt sich von selbst. Aber welcher User will schon ein halbes Stündchen auf seine Datei warten?

Na bei einem Fileserver wird das wohl der Prozess Fileserver sein.

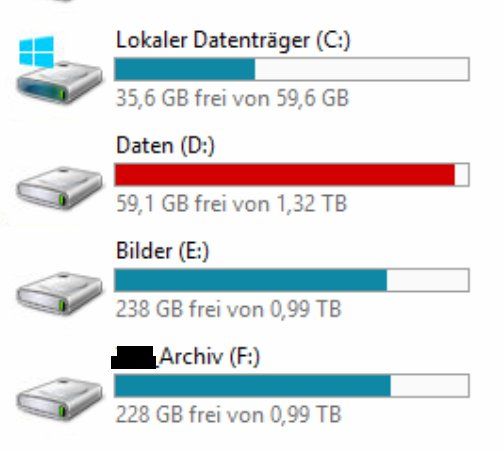

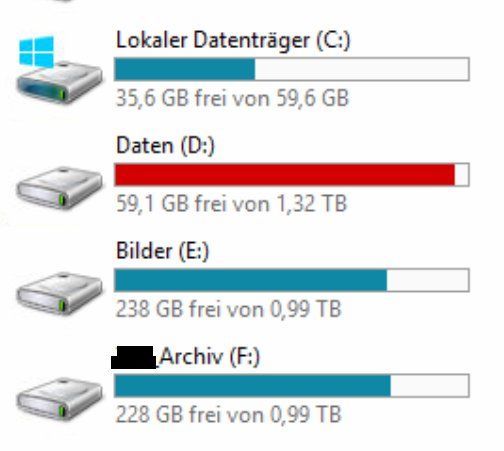

Also hast Du rund 1,3TB Daten auf dem Fileserver und wunderst Dich, warum er mit nur 16Gig RAM anfängt auszulagern? Wieviele User greifen denn da so zu?

Wieso gibt es hier so eine krasse diverse bei der Speicherplatzbelegung einer VM ?

Na weil es Server gibt, die wenig brauchen (ein DC z. B.), und anderen, die ganz viel brauchen (Fileserver, WSUS, große DBs).

Wenn Du nicht weißt, was das für Daten auf Deinem Fileserver sind und welche Datenmengen zu erwarten sind, dann solltest Du Dich ernsthaft fragen, ob das administrieren eines solchen Servers der richtige Job für Dich ist.

Ja und? Ich kannte mal einen, der hat Spielfilme digital geschnitten. Der hatte einen Platten-Cluster von 128TB. Es kommt immer auf die Aufgabe an.

Warum? Warum wird der Datastore des Fileservers auf drei Subsysteme verteilt? Warum nicht alle Daten auf einem System?

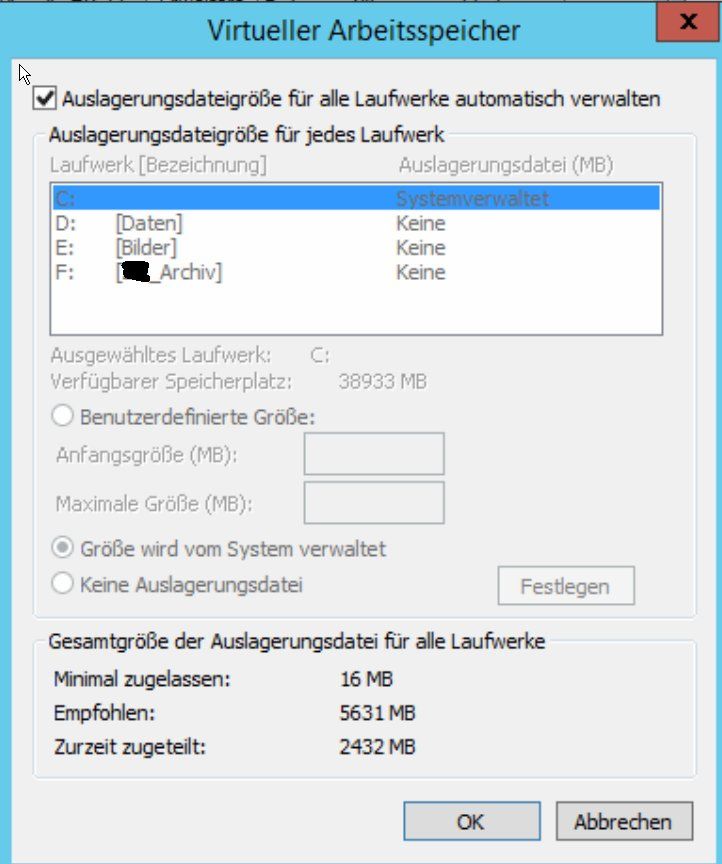

Noch ein eklatanter Fehler bei der Konfiguration des Fileservers:

1. Die Auslagerungsdatei bleibt nie auf dem Systemlaufwerk.

2. Die Auslagerungsdatei bekommt eine feste Größe (genauso groß wie das physische RAM).

Liebe Grüße

Erik

wie schon vermutet, ist das Ganze falsch konfiguriert.

Zitat von @blaub33r3:

Auf dem ESXI laufen 11 VMs

Das ESXi läuft mit Version 6.0.0 aktuell.

Arbeitsspeicher ist aktuell mit 49% ausgelastet => Host hat also selbst genügend Resserve!

Arbeitsspeichergröße 262015,50MB

Auf dem ESXI laufen 11 VMs

Das ESXi läuft mit Version 6.0.0 aktuell.

Arbeitsspeicher ist aktuell mit 49% ausgelastet => Host hat also selbst genügend Resserve!

Arbeitsspeichergröße 262015,50MB

Und wofür hat der Host diese Reserve? Falls mal ein Riegel kaputt geht? Oder anders ausgedrückt: Du verschwendest die Hälfte des Speichers. 51% liegen dauerhaft brach. Du könntest auch die Hälfte der Riegel rausnehmen und anderweitig verbauen. Das würde für die Maschine keinen Unterschied machen.

VM 4 - 16389 MB (ProblemMaschine)

Wie schon mehrfach gesagt: Das ist viel zu wenig. Gönn' dem Teil mal 64Gig und er wird auch nicht mehr auslagern.

VM4 = FileServer, der die heftigen Spikes (Seiten/Sekunde - Spikes) hat und danach seinen Geist abgibt. (man muss virtuellen seinen Stecker ziehen)

Ich wette darauf, dass man das nicht muss. Lange genug warten und das Problem erledigt sich von selbst. Aber welcher User will schon ein halbes Stündchen auf seine Datei warten?

Über Perfmon habe ich mich nun etwas schlau gemacht und den Parameter gefunden. Aber dann ist mir klar geworden,

dass ich die Werte ja vom Monitor eigentlich schon habe, und ich eben wissen müsste, WELCHER Prozess hier Daten

zwischen dem Arbeitsspeicher und der Auslagerungsdatei hin und her scheffelt.

dass ich die Werte ja vom Monitor eigentlich schon habe, und ich eben wissen müsste, WELCHER Prozess hier Daten

zwischen dem Arbeitsspeicher und der Auslagerungsdatei hin und her scheffelt.

Na bei einem Fileserver wird das wohl der Prozess Fileserver sein.

VM 4

1,4 TB von 3,4 TB

1,4 TB von 3,4 TB

Also hast Du rund 1,3TB Daten auf dem Fileserver und wunderst Dich, warum er mit nur 16Gig RAM anfängt auszulagern? Wieviele User greifen denn da so zu?

Wieso gibt es hier so eine krasse diverse bei der Speicherplatzbelegung einer VM ?

Na weil es Server gibt, die wenig brauchen (ein DC z. B.), und anderen, die ganz viel brauchen (Fileserver, WSUS, große DBs).

Wofür braucht man so viel TB.

Wenn Du nicht weißt, was das für Daten auf Deinem Fileserver sind und welche Datenmengen zu erwarten sind, dann solltest Du Dich ernsthaft fragen, ob das administrieren eines solchen Servers der richtige Job für Dich ist.

Habe nun erfahren, es gibt auch VM bis 64 TB

Ja und? Ich kannte mal einen, der hat Spielfilme digital geschnitten. Der hatte einen Platten-Cluster von 128TB. Es kommt immer auf die Aufgabe an.

Die VM4 hat 4 Festplatten, die auf folgende DataStores liegen

(Speichertyp: Thick-ProvsionLazy-Zeroed)

vHDD1 -> 60 GB Datastore_File

vHDD2 -> 1,322 GB Datastore_File

vHDD3 -> 1 TB Datastore_Y

vHDD4 -> 1 TB Datastore_Z

(Speichertyp: Thick-ProvsionLazy-Zeroed)

vHDD1 -> 60 GB Datastore_File

vHDD2 -> 1,322 GB Datastore_File

vHDD3 -> 1 TB Datastore_Y

vHDD4 -> 1 TB Datastore_Z

Warum? Warum wird der Datastore des Fileservers auf drei Subsysteme verteilt? Warum nicht alle Daten auf einem System?

P.S. die virtuelle Auslagerungsdatei erscheint mir zu knapp bemessen, zu XP Zeiten hieß es mal 3x Größer der physische Ram müsse es sein.

Kann es sein, dass das hier auch zu Problemen kommen könnte?

Kann es sein, dass das hier auch zu Problemen kommen könnte?

Noch ein eklatanter Fehler bei der Konfiguration des Fileservers:

1. Die Auslagerungsdatei bleibt nie auf dem Systemlaufwerk.

2. Die Auslagerungsdatei bekommt eine feste Größe (genauso groß wie das physische RAM).

Liebe Grüße

Erik

Moin,

Na, wer solche Admins hat, braucht keine Schadsoftware mehr.

OK.

Das wäre aber nicht so schön. Nehmen wir mal an, dass Du ein modernes SATA-System hast, das die Daten mit ca. 300MB/s also 2.400Mbit/s überträgt. Dein Netz hat eine Geschwindigkeit von 1Gbit/s oder 1000Mbit/s. Das Netz arbeitet also nur halb so schnell wie das Festplattensubsystem. Was muss der Fileserver (FS) also tun? Er muss die Daten, die von der Platte kommen, zwischenspeichern oder auf denglisch cachen. Wo tut er das wohl?

Ich hab es noch nie erklärt bekommen, und administrieren tue ich ihn nicht direkt, ich möchte das Problem lösen und etwas lernen.

Achso. Deine Admins kriegen das Problem nicht in den Griff und Du willst wissen, warum.

Was ich erkenne, dass die DataStores entsprechend der Ihnen zugeteilten Volumens benannt wurden. Man hat sich also hier ein Konzept überlegt, den Speicherplatz so bewusst anzuordnen. Spricht da etwas gegen? Ein Datastore wäre natürlich ein zentralistischer Ansatz.

OK, kann man so machen. Würde ich aber nie so tun. Schließlich gibt es ja Verzeichnisse.

"Die Auslagerungsdatei vom System muss auf der selben Festplatte liegen, da es sonst zur Instabilität kommt."

Quelle: largo-art.de/windows-10-auslagerungsdatei-richtig-einstellen/

Das höre ich wirklich zum ersten Mal und ich mache das schon seit ca. 30 Jahren. Ich habe, seit es sie gibt, die Auslagerungsdatei immer auf eine andere Partition und nach Möglichkeit sogar auf ein eigenes Subsystem gelegt und damit noch nie Probleme gehabt. Mir wäre auch kein technischer Grund bekannt, der zu Instabilitäten führen könnte.

Ich habe, seit es sie gibt, die Auslagerungsdatei immer auf eine andere Partition und nach Möglichkeit sogar auf ein eigenes Subsystem gelegt und damit noch nie Probleme gehabt. Mir wäre auch kein technischer Grund bekannt, der zu Instabilitäten führen könnte.

Nö, das hat was mit der Mechanik der Platten und der Aufteilung der Partitionen zu tun. Du hast eine Systemplatte C:. Im laufenden Betrieb eines Servers passiert da nicht viel. Beim Systemstart wird, das Betriebssystem geladen, dann die Dienste und dann ist Ruh. Allenfalls werden noch ein paar temporäre Dateien geschrieben und geladen.

Auf einem FS finden die Schreib-/Lese-Vorgänge auf der Datenpartition statt. Wenn der Arbeitsspeicher nun volläuft, was man bei einem Server tunlichst vermeiden sollte, und die Auslagerungsdatei liegt auf einer anderen Partition, dann werden die Wege, die der Schreib-/Lese-Kopf zurücklegen muss, lang. D. h. die Latenz, die durch diesen Vorgang entsteht, wird groß. Liegt die Auslagerungsdatei auf derselben Partition, sieht das schon besser aus. Liegt sie auf einem anderen Subsystem, müssen die Schreib-/Lese-Köpfe gar nicht mehr bewegt werden, sondern können bleiben, wo sie sind, es sei denn, das System ist stark fragmentiert.

Letzteres ist auch der Grund dafür, warum man einen festen Wert für die Auslagerungsdatei festlegt. Dann hat man sie nämlich an einem Stück. Lässt man die Datei dynamisch, dann fängt Windows erst einmal ganz klein an (16MB!). Dann schreibt es weiter Daten auf die Platte. Evtl. landen diese Daten hinter der Auslagerungsdatei. Jetzt muss ausgelagert werden und die kleine Datei reicht nicht mehr aus. Also muss Windows erst freien Speicher allozieren. Den findet es aber nur an einer anderen Stelle. Da werden die Daten dann hingeschrieben und die Auslagerungsdatei fragmentiert, d. h. sie verteilt sich quer über die ganze Partition. Beides macht den Vorgang noch langsamer als er sowieso schon ist.

Letzteres, wie Du sicherlich schon aus dem eben Gesagten geschlossen hast.

Oh, das könnte auch ein Grund sein. Ich gehe mal davon aus, dass NTFS das Dateisystem ist. Bei diesem System müssen 10% der Partition leer sein. Der Grund dafür ist, dass NTFS dynamisch defragmentiert. D. h. ständig werden die Daten so hin- und hergeschoben, dass der Zugriff möglichst schnell erfolgen kann. Dazu braucht NTFS diese 10%. Sind die nicht vorhanden, dann kann NTFS wirklich grottenlahm werden. Vielleicht sollte mal wieder jemand aufräumen.

Liebe Grüße

Erik

Zitat von @blaub33r3:

Okay er bekommt 64, wenn ich den Admin überzeuge ;) Genug Ressourcen gibt es.

Wie kommt man mit einer Milchmädchen Rechnung zur Bewältigungslösung von 64GB RAM?

AdminKollegen haben mir letzten mal erklärt bei nem FileServer sogar 2GB reichen täten. Glaube hier herrscht ne allgemine Wissenlücke..^^

Okay er bekommt 64, wenn ich den Admin überzeuge ;) Genug Ressourcen gibt es.

Wie kommt man mit einer Milchmädchen Rechnung zur Bewältigungslösung von 64GB RAM?

AdminKollegen haben mir letzten mal erklärt bei nem FileServer sogar 2GB reichen täten. Glaube hier herrscht ne allgemine Wissenlücke..^^

Na, wer solche Admins hat, braucht keine Schadsoftware mehr.

Auf dem FileServer greifen 25MA zu, dort liegen auch ihre persönlichen Verzeichnisse.

OK.

Wird der RAM vom FileServer genutzt wenn die User auf seine Daten zugreifen? Ich habe gehört, dass es unabhängig ist, wie viele Leute auf den FS zugreifen, und dass der RAM eine untergeordnete Rolle daher "spiele". Dachte daher immer, dass die Daten direkt in den RAM des Users geladen wird (straight vom Storage?durchgeschleust wird ohne Zwischengespeichert zu werden)

Das wäre aber nicht so schön. Nehmen wir mal an, dass Du ein modernes SATA-System hast, das die Daten mit ca. 300MB/s also 2.400Mbit/s überträgt. Dein Netz hat eine Geschwindigkeit von 1Gbit/s oder 1000Mbit/s. Das Netz arbeitet also nur halb so schnell wie das Festplattensubsystem. Was muss der Fileserver (FS) also tun? Er muss die Daten, die von der Platte kommen, zwischenspeichern oder auf denglisch cachen. Wo tut er das wohl?

Wenn Du nicht weißt, was das für Daten auf Deinem Fileserver sind und welche Datenmengen zu erwarten sind, dann solltest Du Dich ernsthaft fragen, ob das administrieren eines solchen Servers der richtige Job für Dich ist.

Ich hab es noch nie erklärt bekommen, und administrieren tue ich ihn nicht direkt, ich möchte das Problem lösen und etwas lernen.

Achso. Deine Admins kriegen das Problem nicht in den Griff und Du willst wissen, warum.

Warum? Warum wird der Datastore des Fileservers auf drei Subsysteme verteilt? Warum nicht alle Daten auf einem System?

Was ich erkenne, dass die DataStores entsprechend der Ihnen zugeteilten Volumens benannt wurden. Man hat sich also hier ein Konzept überlegt, den Speicherplatz so bewusst anzuordnen. Spricht da etwas gegen? Ein Datastore wäre natürlich ein zentralistischer Ansatz.

OK, kann man so machen. Würde ich aber nie so tun. Schließlich gibt es ja Verzeichnisse.

Noch ein eklatanter Fehler bei der Konfiguration des Fileservers:

1. Die Auslagerungsdatei bleibt nie auf dem Systemlaufwerk.

2. Die Auslagerungsdatei bekommt eine feste Größe (genauso groß wie das physische RAM).

1. Die Auslagerungsdatei bleibt nie auf dem Systemlaufwerk.

2. Die Auslagerungsdatei bekommt eine feste Größe (genauso groß wie das physische RAM).

"Die Auslagerungsdatei vom System muss auf der selben Festplatte liegen, da es sonst zur Instabilität kommt."

Quelle: largo-art.de/windows-10-auslagerungsdatei-richtig-einstellen/

Das höre ich wirklich zum ersten Mal und ich mache das schon seit ca. 30 Jahren.

Die Auslagerung des System C:\ muss auf Partition D:\ stattfinden, weil beide Volumes sich ein gemeinsames DataStore(Festplatte) teilen. Richtig?

Nö, das hat was mit der Mechanik der Platten und der Aufteilung der Partitionen zu tun. Du hast eine Systemplatte C:. Im laufenden Betrieb eines Servers passiert da nicht viel. Beim Systemstart wird, das Betriebssystem geladen, dann die Dienste und dann ist Ruh. Allenfalls werden noch ein paar temporäre Dateien geschrieben und geladen.

Auf einem FS finden die Schreib-/Lese-Vorgänge auf der Datenpartition statt. Wenn der Arbeitsspeicher nun volläuft, was man bei einem Server tunlichst vermeiden sollte, und die Auslagerungsdatei liegt auf einer anderen Partition, dann werden die Wege, die der Schreib-/Lese-Kopf zurücklegen muss, lang. D. h. die Latenz, die durch diesen Vorgang entsteht, wird groß. Liegt die Auslagerungsdatei auf derselben Partition, sieht das schon besser aus. Liegt sie auf einem anderen Subsystem, müssen die Schreib-/Lese-Köpfe gar nicht mehr bewegt werden, sondern können bleiben, wo sie sind, es sei denn, das System ist stark fragmentiert.

Letzteres ist auch der Grund dafür, warum man einen festen Wert für die Auslagerungsdatei festlegt. Dann hat man sie nämlich an einem Stück. Lässt man die Datei dynamisch, dann fängt Windows erst einmal ganz klein an (16MB!). Dann schreibt es weiter Daten auf die Platte. Evtl. landen diese Daten hinter der Auslagerungsdatei. Jetzt muss ausgelagert werden und die kleine Datei reicht nicht mehr aus. Also muss Windows erst freien Speicher allozieren. Den findet es aber nur an einer anderen Stelle. Da werden die Daten dann hingeschrieben und die Auslagerungsdatei fragmentiert, d. h. sie verteilt sich quer über die ganze Partition. Beides macht den Vorgang noch langsamer als er sowieso schon ist.

Gebe ich den festen Bereich von 1 MB von16000MB an oder von 16000 bis 16000, dass eine 16GB Auslagerungsdatei "full" entsteht?

Letzteres, wie Du sicherlich schon aus dem eben Gesagten geschlossen hast.

Im Anhang seht ihr die derzeitige Speichernutzung/Verteilung

Oh, das könnte auch ein Grund sein. Ich gehe mal davon aus, dass NTFS das Dateisystem ist. Bei diesem System müssen 10% der Partition leer sein. Der Grund dafür ist, dass NTFS dynamisch defragmentiert. D. h. ständig werden die Daten so hin- und hergeschoben, dass der Zugriff möglichst schnell erfolgen kann. Dazu braucht NTFS diese 10%. Sind die nicht vorhanden, dann kann NTFS wirklich grottenlahm werden. Vielleicht sollte mal wieder jemand aufräumen.

Liebe Grüße

Erik