Erfahrungen mit Deduplizierung unter Hyper-V

Moin,

wir nutzen in verschiedene Inselnetzwerke Microsoft Hyper-V für Server Virtualisierung. Nun wird auf ein paar Servern in absehbarer Zeit der Speicherplatz für virtuelle Maschinen ausgehen. Diverse Anforderungen wurden bereits pausiert bzw. verschoben. Aber das geht nicht mehr lange gut. Die zusätzlichen Festplatten sind bestellt. Aber die Lieferung wird vermutlich erst in 5-6 Monate erfolgen.

Nun steht die Idee im Raum auf den betroffenen Hosts temporär das Feature Deduplizierung zu installieren und konfigurieren. Gibt es hier jemand, der das Feature Deduplizierung auf Hyper-V produktiv einsetzt und damit die eine oder andere Erfahrung dazu schreiben kann?

Grüße,

Dani

P.S. In der aktuellen Fassung der Dokumentation gibt es für das Vorhaben erst einmal keine Unterstützung durch Microsoft. Ist mir bekannt und bewusst.

wir nutzen in verschiedene Inselnetzwerke Microsoft Hyper-V für Server Virtualisierung. Nun wird auf ein paar Servern in absehbarer Zeit der Speicherplatz für virtuelle Maschinen ausgehen. Diverse Anforderungen wurden bereits pausiert bzw. verschoben. Aber das geht nicht mehr lange gut. Die zusätzlichen Festplatten sind bestellt. Aber die Lieferung wird vermutlich erst in 5-6 Monate erfolgen.

Nun steht die Idee im Raum auf den betroffenen Hosts temporär das Feature Deduplizierung zu installieren und konfigurieren. Gibt es hier jemand, der das Feature Deduplizierung auf Hyper-V produktiv einsetzt und damit die eine oder andere Erfahrung dazu schreiben kann?

Grüße,

Dani

P.S. In der aktuellen Fassung der Dokumentation gibt es für das Vorhaben erst einmal keine Unterstützung durch Microsoft. Ist mir bekannt und bewusst.

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 2669537976

Url: https://administrator.de/forum/erfahrungen-mit-deduplizierung-unter-hyper-v-2669537976.html

Ausgedruckt am: 24.07.2025 um 04:07 Uhr

22 Kommentare

Neuester Kommentar

Moin Dani,

wenn es um normale Dateiablage geht, dann spricht in vielen Fällen nichts gegen Deduplizierung,

vor allem wenn die Zugriffsperformance nicht im Vordergrund steht.

Im Bereich des Backups, ist das Feature auch hin und wieder nützlich.

Bei Datenbanken und oder latenzkritischen Anwendungen, würde ich definitiv die Finger

von der Deduplizierung lassen.

Beste Grüsse aus BaWü

Alex

wenn es um normale Dateiablage geht, dann spricht in vielen Fällen nichts gegen Deduplizierung,

vor allem wenn die Zugriffsperformance nicht im Vordergrund steht.

Im Bereich des Backups, ist das Feature auch hin und wieder nützlich.

Bei Datenbanken und oder latenzkritischen Anwendungen, würde ich definitiv die Finger

von der Deduplizierung lassen.

Beste Grüsse aus BaWü

Alex

Moin,

bei einem Hyper-V Host ist die dedub Ausbeute sehr gering. Es sei denn ihr kopiert die Maschinen trocken und legt diese nebeneinander ab (vermutlich).

Die Performance Einbußen sehe ich gar nicht als großes Manko da dies als Job läuft nach Zeitplan quasi nach doppelten Dateien sucht. Bei Ausführung ist die Laufwerkslast dann natürlich größer.

Ich habe sowas auch mal zum testen gemacht, es hatte keine wirklich Vorteile. Der Rückbau hat dafür Tage gedauert da dies nur über einen PS Befehl möglich ist, außer man leg das Laufwerk natürlich neu an.

Laut dem Beitrag hier:

virtualizationreview.com/articles/2014/05/13/deduplication-hyper ...

Soll es etwas bringen, kann ich aber höchstens unter einer VDI Umgebung nachvollziehen.

Laut diesem hier:

serverfault.com/questions/565745/server-2012-deduplication-run-o ...

Ist die Dedublizierung von vhd und vhdx gar nicht möglich.

Gruß

Spirit

bei einem Hyper-V Host ist die dedub Ausbeute sehr gering. Es sei denn ihr kopiert die Maschinen trocken und legt diese nebeneinander ab (vermutlich).

Die Performance Einbußen sehe ich gar nicht als großes Manko da dies als Job läuft nach Zeitplan quasi nach doppelten Dateien sucht. Bei Ausführung ist die Laufwerkslast dann natürlich größer.

Ich habe sowas auch mal zum testen gemacht, es hatte keine wirklich Vorteile. Der Rückbau hat dafür Tage gedauert da dies nur über einen PS Befehl möglich ist, außer man leg das Laufwerk natürlich neu an.

Laut dem Beitrag hier:

virtualizationreview.com/articles/2014/05/13/deduplication-hyper ...

Soll es etwas bringen, kann ich aber höchstens unter einer VDI Umgebung nachvollziehen.

Laut diesem hier:

serverfault.com/questions/565745/server-2012-deduplication-run-o ...

Ist die Dedublizierung von vhd und vhdx gar nicht möglich.

Gruß

Spirit

Moin Spirit,

als ich die oberen Zeilen gelesen habe, konnte ich das mit dem Job, sprich, keine Echtzeitdeduplizierung zuerst gar nicht glauben. Nachdem ich nun online etwas nachgeforscht habe, muss ich es glauben, muss aber über den Dedup-Kindergarten von MS jedoch kräftig schmunzeln.

docs.microsoft.com/en-us/windows-server/storage/data-deduplicati ...

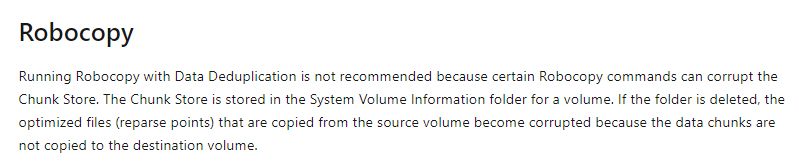

Und Robocopy darf man auf einem MS deduplitierten Volume, so wie es aussieht auch nicht verwenden und dass,

obwohl der Dedup als Job läuft.

🙊🙈

🙊🙈

Ich habe diverse Analysen hinter mir, wo einschleichende und zum Teil sehr massive Performanceprobleme, sich auf Dedup der entsprechenden SAN's zurückführen liessen. Daher nutzen wir dieses Feature nicht aktiv bei Kundensystemen, obwohl die meisten der verwendeten SAN's, Dedup sogar in Echtzeit beherrschen.

Beste Grüsse aus BaWü

Alex

Die Performance Einbußen sehe ich gar nicht als großes Manko da dies als Job läuft nach Zeitplan quasi nach doppelten Dateien sucht. Bei Ausführung ist die Laufwerkslast dann natürlich größer.

als ich die oberen Zeilen gelesen habe, konnte ich das mit dem Job, sprich, keine Echtzeitdeduplizierung zuerst gar nicht glauben. Nachdem ich nun online etwas nachgeforscht habe, muss ich es glauben, muss aber über den Dedup-Kindergarten von MS jedoch kräftig schmunzeln.

docs.microsoft.com/en-us/windows-server/storage/data-deduplicati ...

Und Robocopy darf man auf einem MS deduplitierten Volume, so wie es aussieht auch nicht verwenden und dass,

obwohl der Dedup als Job läuft.

Ich habe sowas auch mal zum testen gemacht, es hatte keine wirklich Vorteile. Der Rückbau hat dafür Tage gedauert da dies nur über einen PS Befehl möglich ist, außer man leg das Laufwerk natürlich neu an.

Ich habe diverse Analysen hinter mir, wo einschleichende und zum Teil sehr massive Performanceprobleme, sich auf Dedup der entsprechenden SAN's zurückführen liessen. Daher nutzen wir dieses Feature nicht aktiv bei Kundensystemen, obwohl die meisten der verwendeten SAN's, Dedup sogar in Echtzeit beherrschen.

Beste Grüsse aus BaWü

Alex

Hallo Alex,

wenn du noch etwas mehr schmunzeln möchtest kannst ja mal hier hineinschauen:

Fileserver Indizierung geht nicht mit DFS?

Für einen Standalone Archivserver kann man das also anwerfen.

Sobald es ein wenig Komfort haben soll, wird von Dedup in Nebensätzen immer abgeraten.

Zitat von @MysticFoxDE:

als ich die oberen Zeilen gelesen habe, konnte ich das mit dem Job, sprich, keine Echtzeitdeduplizierung zuerst gar nicht glauben. Nachdem ich nun online etwas nachgeforscht habe, muss ich es glauben, muss aber über den Dedup-Kindergarten von MS jedoch kräftig schmunzeln.

als ich die oberen Zeilen gelesen habe, konnte ich das mit dem Job, sprich, keine Echtzeitdeduplizierung zuerst gar nicht glauben. Nachdem ich nun online etwas nachgeforscht habe, muss ich es glauben, muss aber über den Dedup-Kindergarten von MS jedoch kräftig schmunzeln.

wenn du noch etwas mehr schmunzeln möchtest kannst ja mal hier hineinschauen:

Fileserver Indizierung geht nicht mit DFS?

Für einen Standalone Archivserver kann man das also anwerfen.

Sobald es ein wenig Komfort haben soll, wird von Dedup in Nebensätzen immer abgeraten.

Zitat von @Dani:

Nun steht die Idee im Raum auf den betroffenen Hosts temporär das Feature Deduplizierung zu installieren und konfigurieren. Gibt es hier jemand, der das Feature Deduplizierung auf Hyper-V produktiv einsetzt und damit die eine oder andere Erfahrung dazu schreiben kann?

Nun steht die Idee im Raum auf den betroffenen Hosts temporär das Feature Deduplizierung zu installieren und konfigurieren. Gibt es hier jemand, der das Feature Deduplizierung auf Hyper-V produktiv einsetzt und damit die eine oder andere Erfahrung dazu schreiben kann?

Moin,

empfohlen wird Dedup ja nur für Fileserver Shares, VDI und DPM. Man kann es zwar auch für andere Hyper-V Workloads nutzen, sollte aber vorher mit DDPEval prüfen ob es überhaupt ein sinnvolles Resultat liefern würde.

/Thomas

Hi,

habe ich lange Zeit eingesetzt unter Server 2016 mit NTFS auf SSDs.

Heute würde ich das eher mit ReFS machen, wäre mir aber auch neu. Auf Festplatten, gerade wenn es temporär ist, würde ich es nicht ausschließen, mir aber zweimal überlegen.

Das Deduplizierungspotenzial ist je nach Art der VMs erheblich, denn die Merkmale von VDI-Umgebungen liegen ja auch in anderen Konstellationen vor: Viele gleiche OS- und Software-Daten und freier Speicherplatz in den VHDs.

Für sich genommen läuft das stabil und performant. Backup und Restore müsst ihr natürlich klären und vor allem testen, das kann Probleme machen.

Grüße

Richard

habe ich lange Zeit eingesetzt unter Server 2016 mit NTFS auf SSDs.

Heute würde ich das eher mit ReFS machen, wäre mir aber auch neu. Auf Festplatten, gerade wenn es temporär ist, würde ich es nicht ausschließen, mir aber zweimal überlegen.

Das Deduplizierungspotenzial ist je nach Art der VMs erheblich, denn die Merkmale von VDI-Umgebungen liegen ja auch in anderen Konstellationen vor: Viele gleiche OS- und Software-Daten und freier Speicherplatz in den VHDs.

Für sich genommen läuft das stabil und performant. Backup und Restore müsst ihr natürlich klären und vor allem testen, das kann Probleme machen.

Grüße

Richard

Sers,

wie sehen die HV Cluster bei dir von der Storage Seite aus, @Dani?

S2D?

iSCSI/FC SAN?

Clustered Storage Spaces (SAS JBODs & HBAs)? CSV direkt oder SOFS?

Grüße,

Philip

wie sehen die HV Cluster bei dir von der Storage Seite aus, @Dani?

S2D?

iSCSI/FC SAN?

Clustered Storage Spaces (SAS JBODs & HBAs)? CSV direkt oder SOFS?

Grüße,

Philip

Zitat von @c.r.s.:

Das Deduplizierungspotenzial ist je nach Art der VMs erheblich, denn die Merkmale von VDI-Umgebungen liegen ja auch in anderen Konstellationen vor: Viele gleiche OS- und Software-Daten und freier Speicherplatz in den VHDs.

Das Deduplizierungspotenzial ist je nach Art der VMs erheblich, denn die Merkmale von VDI-Umgebungen liegen ja auch in anderen Konstellationen vor: Viele gleiche OS- und Software-Daten und freier Speicherplatz in den VHDs.

Da stimme ich zu, ich würde das aber nicht auf Betriebssystemebene machen lassen, vor allem nicht mit "Containerdateien" wie VHDx Festplatten.

Sowas gehört meiner Meinung nach auf Basis des Storage erledigt bspw. über ein SAN wie eine NetApp.

Zitat von @dertowa:

Da stimme ich zu, ich würde das aber nicht auf Betriebssystemebene machen lassen, vor allem nicht mit "Containerdateien" wie VHDx Festplatten.

Sowas gehört meiner Meinung nach auf Basis des Storage erledigt bspw. über ein SAN wie eine NetApp.

Da stimme ich zu, ich würde das aber nicht auf Betriebssystemebene machen lassen, vor allem nicht mit "Containerdateien" wie VHDx Festplatten.

Sowas gehört meiner Meinung nach auf Basis des Storage erledigt bspw. über ein SAN wie eine NetApp.

Das sind Äpfel und Birnen. Wenn ein deduplizierungsfähiges SAN vorhanden ist, würde man es nicht auf dem Host machen, klar. In einem HCI-Stack macht es der Host und es ist auch dafür gedacht.

Weil Du oben einen "Archivserver" ansprichst: Ich sehe das genau umgekehrt. Abseits der Virtualisierung, auf File-Servern würde ich Deduplizierung allenfalls für "heiße" Daten einsetzen, wenn es unbedingt erforderlich ist. Spätestens auf Archivservern braucht man ein Instrument der Integritätsprüfung und hat dazu unter Windows nur ReFS-Integrity-Streams zur Verfügung. Deduplizierung geht damit eigentlich nur in Verbindung mit Storage-Spaces, denn wenn ReFS Fehler nicht über Paritätsdaten korrigieren kann und fehlerhafte Daten ggf. dedupliziert sind, können kleinste Fehler einen großen Wiederherstellungsbedarf auslösen.

Irgendwie hab ich an der Anforderung was nicht verstanden. Dedup ist ein Feature für den Windows Fileserver, nicht für Hyper-V. Heißt, wenn ihr das auf euren Fileservern die innerhalb Hyper-V laufen, installiert, wird höchstwarscheinlich ein guter Batzen Dateien dedupliziert werden können, dann müsst ihr aber auch die virtuellen Festplatten verkleinern, was oft dank Fragmentierung im Nachhinein nicht mehr möglich ist. Heißt ihr müsstet die VHDs neu erstellen, dafür muss natürlich auch genug Speicherplatz vorhanden sein.

Auf Hyper-V Ebene würd das Dedup Feature so gut wie gar nichts bewirken, da kaum gleiche Daten vorhanden sind, aber ob das gefragt war weiß ich jetzt nicht.

Ansonsten wie schon dertowa erwähnt hat, iScsi ist immer eine Möglichkeit kurzfristig eine NAS oder was in der Art anzubinden, darauf basiert sogar unsere komplette Speicherlandschaft.

Auf Hyper-V Ebene würd das Dedup Feature so gut wie gar nichts bewirken, da kaum gleiche Daten vorhanden sind, aber ob das gefragt war weiß ich jetzt nicht.

Ansonsten wie schon dertowa erwähnt hat, iScsi ist immer eine Möglichkeit kurzfristig eine NAS oder was in der Art anzubinden, darauf basiert sogar unsere komplette Speicherlandschaft.

Zitat von @rzlbrnft:

Auf Hyper-V Ebene würd das Dedup Feature so gut wie gar nichts bewirken, da kaum gleiche Daten vorhanden sind, aber ob das gefragt war weiß ich jetzt nicht.

Auf Hyper-V Ebene würd das Dedup Feature so gut wie gar nichts bewirken, da kaum gleiche Daten vorhanden sind, aber ob das gefragt war weiß ich jetzt nicht.

Die Deduplizierung erfolgt auf Blockebene, da sind sehr viele gleiche Daten vorhanden, solange die VHDs nicht verschlüsselt sind.

Angenommen, du brauchst 20 gleiche IIS-Webserver, die 40 GB (identisches System und Web-Root, etwas Logs) auf 100 GB VHDs belegen, also 800 GB dynamische VHDs oder 2 TB fixed. Die Deduplizierung wird das schätzungsweise auf rund 100 GB drücken, und zwar unabhängig davon ob fixed oder dynamisch. Natürlich muss bedacht werden, dass z.B. das Einspielen von Updates auf allen VMs zwischen zwei Dedup-Zyklen den belegten Speicherplatz vorübergehend um das Volumen aller 20 Disk-Modifikationen anwachsen lassen wird.

Unter der Annahme, dass die VMs am Ende als VHDX auf einem oder mehreren CSV liegen (wie auch immer das angebunden ist):

Understanding the state of your Cluster Shared Volumes

Der entscheidende Punkt an der Nummer:

Während ein Dedup-Prozess läuft - egal ob Optimization, Scrubbing, GarbageCollection oder Unoptimization - ist die Datei exklusiv auf einem Host geöffnet. Die weiteren Hosts greifen dann via "File System Redirected Mode" zu.

Sprich: Lass die Dedup Prozesse vom Host der höchsten IO Last durchführen. Dann schmerzt die höhere IO Latenz weniger ;)

Ansonsten:

Hyper-V VDI Optimierung als Dedup Modus verwenden, und nachträglich das Mindestalter der Dateien auf 0 Tage reduzieren.

Grüße,

Philip

Understanding the state of your Cluster Shared Volumes

Der entscheidende Punkt an der Nummer:

Während ein Dedup-Prozess läuft - egal ob Optimization, Scrubbing, GarbageCollection oder Unoptimization - ist die Datei exklusiv auf einem Host geöffnet. Die weiteren Hosts greifen dann via "File System Redirected Mode" zu.

Data deduplication occurs on a per file basis. Therefore, when a file on a CSV volume is deduped, all I/O for that file will occur in File System Redirected mode. I/O for the file will not be cached in the CSV Block Cache – it will instead be cached in the Deduplication Cache. For the remaining non-deduped files, CSV will be in direct mode. The state of the CSV will be reflected as being in Direct mode.

Hatte ich zuletzt auch so auf einem 2012R2 HV Cluster mit Clustered Storage Spaces so erlebt. Damals auf NTFS Basis. Ob es mit ReFS identisch funktioniert kann ich dir nicht sagen.Sprich: Lass die Dedup Prozesse vom Host der höchsten IO Last durchführen. Dann schmerzt die höhere IO Latenz weniger ;)

Ansonsten:

Hyper-V VDI Optimierung als Dedup Modus verwenden, und nachträglich das Mindestalter der Dateien auf 0 Tage reduzieren.

Grüße,

Philip

Moin Philip,

😨 ... CSV und ReFS ... 😱

community.spiceworks.com/topic/2286588-please-do-not-use-refs-fo ...

Kann ich jetzt nicht wirklich empfehlen.

Beste Grüsse aus BaWü

Alex

Nachtrag:

Habe mich doch richtig erinnert, dass ich das auch schon hier in deutsch gepostet habe.

Warum ihr keine ReFS Formatierung für CSVs verwenden solltet, die von einem SAN bereitgestellt werden

Ob es mit ReFS identisch funktioniert kann ich dir nicht sagen.

😨 ... CSV und ReFS ... 😱

community.spiceworks.com/topic/2286588-please-do-not-use-refs-fo ...

Kann ich jetzt nicht wirklich empfehlen.

Beste Grüsse aus BaWü

Alex

Nachtrag:

Habe mich doch richtig erinnert, dass ich das auch schon hier in deutsch gepostet habe.

Warum ihr keine ReFS Formatierung für CSVs verwenden solltet, die von einem SAN bereitgestellt werden

Zitat von @rzlbrnft:

Meines Erachtens sind das doch zwei gegenläufige Aussagen. Was stimmt denn nun? Blockbasiert oder Filebasiert?

Zitat von @c.r.s.:

Die Deduplizierung erfolgt auf Blockebene, da sind sehr viele gleiche Daten vorhanden, solange die VHDs nicht verschlüsselt sind.

Die Deduplizierung erfolgt auf Blockebene, da sind sehr viele gleiche Daten vorhanden, solange die VHDs nicht verschlüsselt sind.

Zitat von @psannz:

Der entscheidende Punkt an der Nummer:

Während ein Dedup-Prozess läuft - egal ob Optimization, Scrubbing, GarbageCollection oder Unoptimization - ist die Datei exklusiv auf einem Host geöffnet. Die weiteren Hosts greifen dann via "File System Redirected Mode" zu.

Der entscheidende Punkt an der Nummer:

Während ein Dedup-Prozess läuft - egal ob Optimization, Scrubbing, GarbageCollection oder Unoptimization - ist die Datei exklusiv auf einem Host geöffnet. Die weiteren Hosts greifen dann via "File System Redirected Mode" zu.

Data deduplication occurs on a per file basis.

Meines Erachtens sind das doch zwei gegenläufige Aussagen. Was stimmt denn nun? Blockbasiert oder Filebasiert?

Nö. Passt komplett zusammen.

Die Deduplizierung erfolt in Blöcken. Standardmäßig in 32kB Blöcken. Das lässt sich je Volume einstellen.

Bei der Optimierung werden Dateien immer am Stück verarbeitet, sprich in 32kB Scheibchen aufgeteilt und verarbeitet.

Warum am Stück je Datei? Was würde passieren, wenn während der Optimierung einer Datei (auf dem CSV) von einem anderen Host in die eben jene Datei geschrieben wird? Datenverlust passiert. Drum schnappt sich der für den Dedup Prozess zuständige Host während der Verarbeitung die exklusiven Rechte an der Datei. Entsprechende Anfragen von Dritt-Hosts werden auf ihn umgeleitet, Schreibanfragen werden entsprechend so verarbeitet, dass die Zurodnungstabelle der Blöcke der Datei weiterhin konsistent ist.

Wenn das ganze nicht je Datei, sondern wild je Block auf dem Volume passieren würde, dann hättest du eine chaotische Umleitung von IO-Zugriffen, da für jeden Block der exklusive Zugriff bzw. der Umleitende Zugriff aktiviert und im Cluster kommuniziert werden müsste.

Sers Dani,

Die Schedules für die aktiven Prozesse kannst du auch über die Aufgabenverwaltung steuern. Tasks sollten dort automatisch hinterlegt sein.

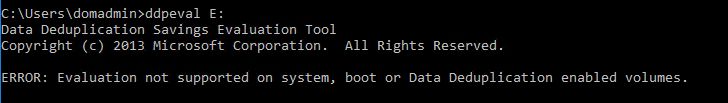

Hast du mal ddpeval.exe durchlaufen lassen, um zu sehen wieviel du damit einsparen wirst? Kannst einfach die Binaries von einem System mit aktivierter Dedup Funktion auf den Hyper-V kopieren und per CLI aufrufen (ddpeval.exe z , geht sogar von einem Drittsystem aus, sofern die Bandbreite ausreicht.

, geht sogar von einem Drittsystem aus, sofern die Bandbreite ausreicht.

Brauchst du nicht wirklich. Lass es einfach im Hintergrund laufen. Wenn es mit IOPS eng wird deaktivierst du die Hintergrundoptimierung.

Die Regulären Optimierungs, Scrubbing und GarbageCollection Tasks sollten täglich laufen, speziell Scrubbung, reicht absolut es Nachts laufen zu lassen.

Zitat von @Dani:

@psannz

klasse, dann einfach den Dedup aktivieren. Bitte auf den Hyper-V VDI Modus achten, und mit set-dedupvolume sicherstellen, dass MinimumFileAgeDays = 0 ist, und VHDX, AVHD, VHD und all die anderen VM Dateitypen nicht von der Optimierung ausgeschlossen sind.@psannz

wie sehen die HV Cluster bei dir von der Storage Seite aus, @Dani?

Kein HV Cluster, kein Storge. Es handelt sich jeweils um einen Hyper-V Server mit LocalStorage.Die Schedules für die aktiven Prozesse kannst du auch über die Aufgabenverwaltung steuern. Tasks sollten dort automatisch hinterlegt sein.

Hast du mal ddpeval.exe durchlaufen lassen, um zu sehen wieviel du damit einsparen wirst? Kannst einfach die Binaries von einem System mit aktivierter Dedup Funktion auf den Hyper-V kopieren und per CLI aufrufen (ddpeval.exe z

Während ein Dedup-Prozess läuft - egal ob Optimization, Scrubbing, GarbageCollection oder Unoptimization - ist die Datei exklusiv auf einem Host geöffnet.

Korrekt. Die Idee ist, in einem Wartungsfenster die VMs herunterzufahren. Anschließend Deduplizierung laufen lassen und die VMs wieder hochfahren. Je nachdem wie groß der Gewinn von Speicherplatz ist und wie viel Daten sich ändern, wird der Vorgang eben alle x Wochen wiederholt.Die Regulären Optimierungs, Scrubbing und GarbageCollection Tasks sollten täglich laufen, speziell Scrubbung, reicht absolut es Nachts laufen zu lassen.