ESXi 7 Hauptspeicher nicht erreichbar

Moin Moin,

ich habe im Moment ein großes Problem.

Wie es scheint, ist meine SSD (neu ca. 1 Monat alt) welche nur als Boot Medium des Host dient, nicht mehr erreichbar.

Um die SSD in Richtung TBW zu schonen, nutze ich diese nur zum Booten oder um mal eine ISO zu speichern, aber nur wenn der Platz auf andern Platten langsam knapp wird oder die andere SSD mit den VM's gerade zu stark belastet wird.

Die SSD für den Host hat auch einen Datenspeicher (datastore1), darauf liegt wie oben beschrieben eigentlich nichts, vielleicht 2 GB von ca. 330 GB und ein paar zwequetschte.

Ich wollte gerade eben auf eine der wenigen Windows Maschinen, welche auf einer anderen SSD liegt, zugreifen.

Die VM reagierte langsam, bis hin zu gar nicht, also wollte ich diese Neustarten.

Nach dem Neustart blieb die RDP Sitzung schwarz, erst nach knapp 15 Minuten baute sich langsam Windows auf und ich bekam ein Bild, jedoch konnte ich nur den Task-Manager öffnen, nicht einmal der Windows-Explorer ging.

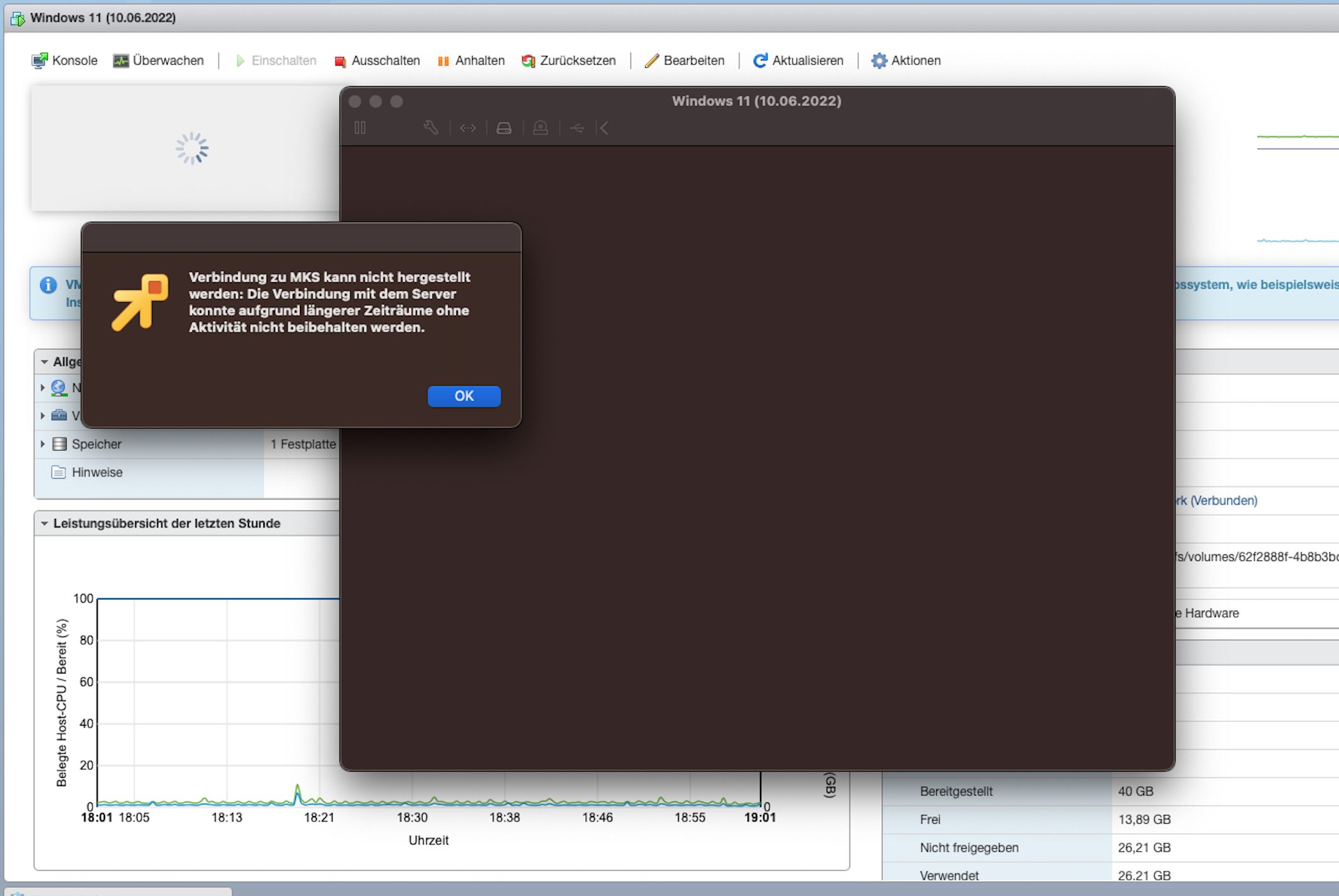

Also wollte ich direkt über den Host per VMware Remote Console auf die VM gucken, jedoch kam es nach ca. 10 Minuten zu einer Zeitüberschreitung und an der Config des Host konnte ich auch nichts ändern, bzw. aufrufen.

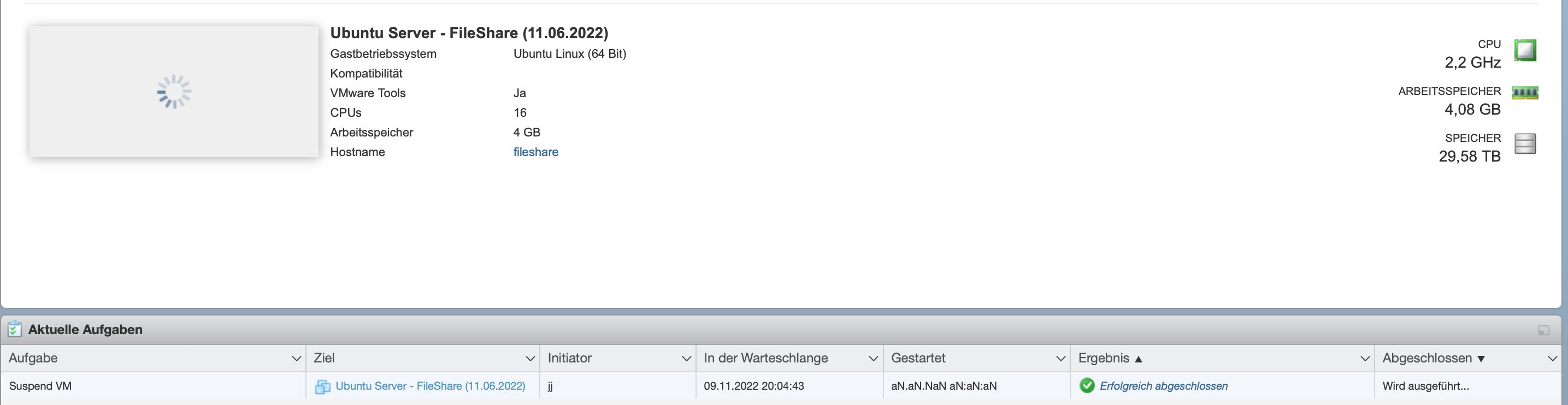

[bild 1]

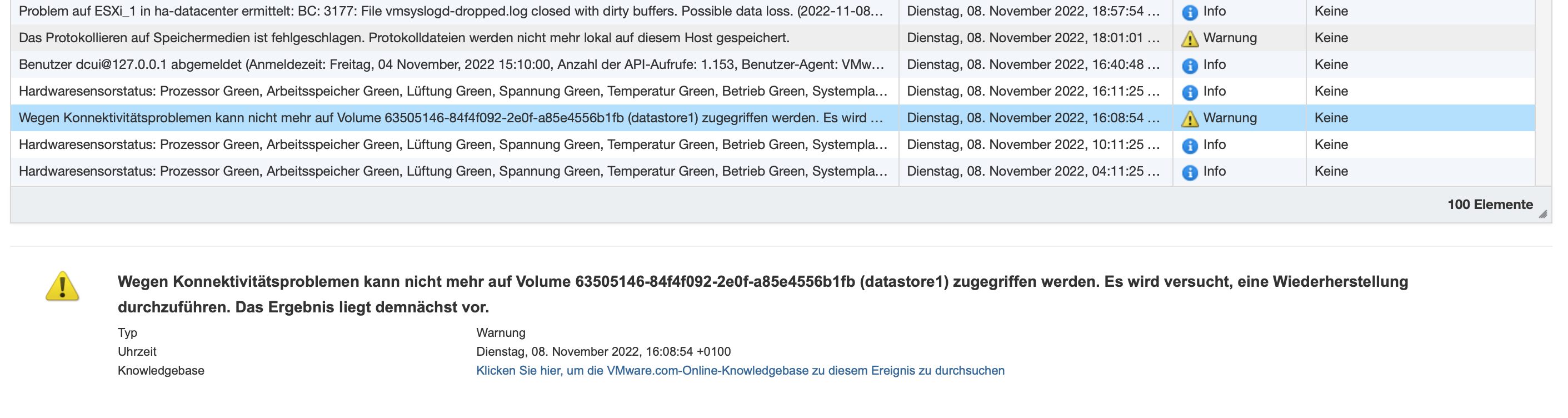

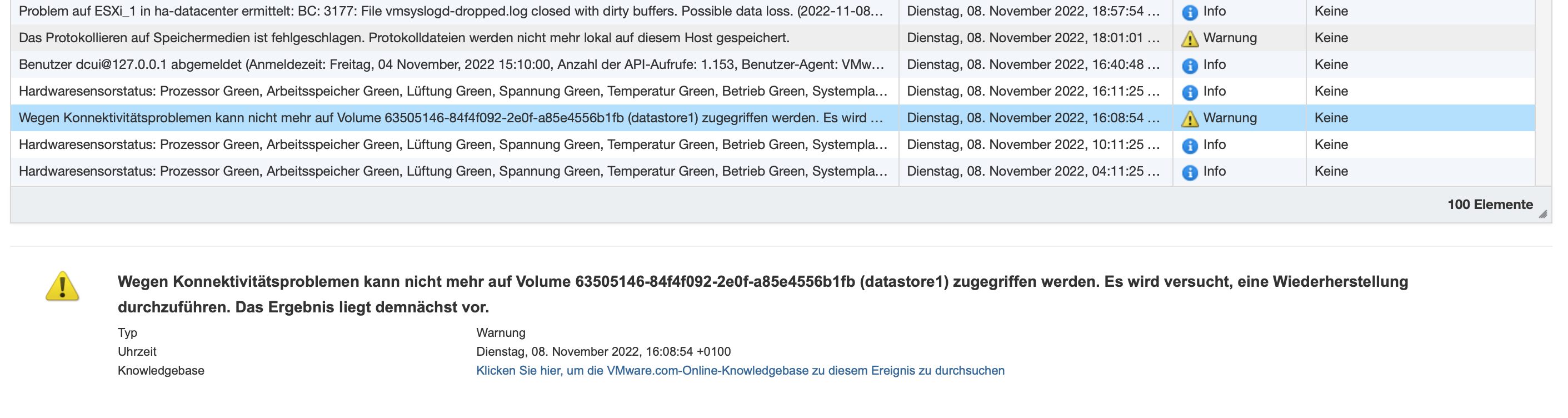

Also habe ich in die Überwachung -> Ereignisse geguckt und sehe da:

Danach kam noch eine Meldung:

Davor und danach ist alles in Ordnung, also in den Ereignissen.

Jedoch denke ich, dass es nur eine Frage der Zeit ist, bis der Host mir den Pinken Bildschirm mit einer Fehlermeldung anzeigt und alle VM's abstürzen.

Ich habe gerade versucht eine VM anzuhalten, das funktioniert jedoch nicht mehr.....

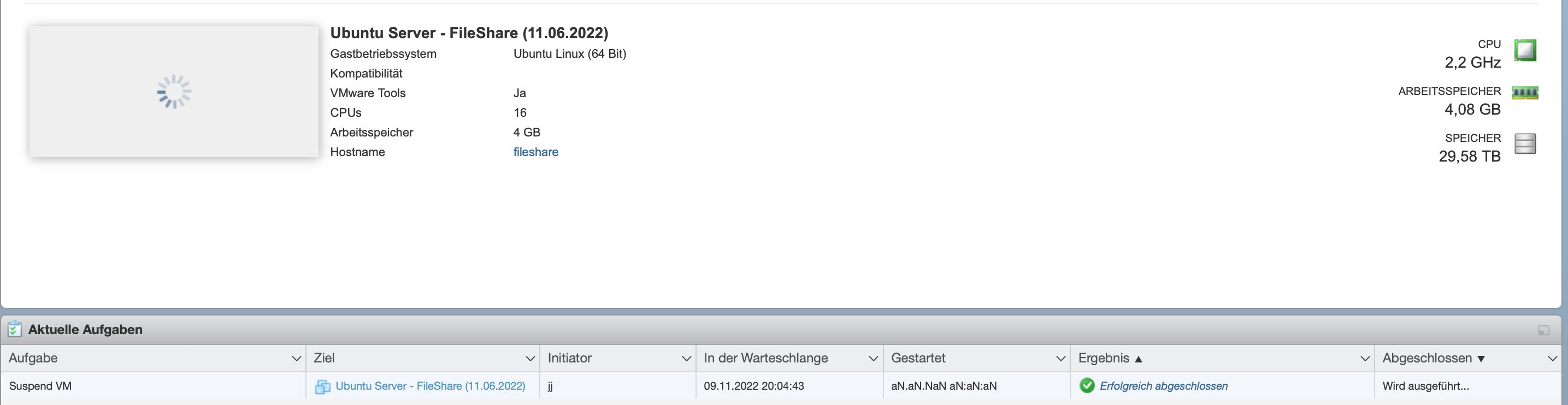

Er sagt gestartet, aber die VM ist noch über SSH erreichbar und arbeitet, im Log steht unter Gestartet "aN.aN.NaN aN:aN:aN" was sehr beruhigend ist.

[bild 4]

Ich habe jetzt nach ca. 10 Minuten angefangen die VM's per SSH ordnungsgemäß herunterzufahren, auf der Seite des ESXi laufen sie angeblich noch.

Ich werde den Host gleich herunterfahren und die Kontakte der PCIE SSD mal vorsichtig mit einem Tuch "berühren" und sie danach wieder einbauen.

Er lief jetzt 4 Tage am stück, davor hatte ich einen Standard SATA Controller eingebaut mit mehreren Festplatten, wie man an der Speichergröße des FileShares sehen kann. (Sie wurden direkt eingebunden, ohne datastore etc.)

Kennt jemand das Problem und kann mir sagen woran das lag?

Liebe Grüße

// Nachtrag

Die Bilder verschieben sich leider, Sorry

So der host wurde neugestartet und scheint erstmal wieder zu laufen.

Die Windows VM rennt auch wieder.

Die SSD mit den VM's hatte/hat noch 103 GB Frei, RAM waren auch noch so 8GB von 80GB frei, Prozessor war so zu 60-70 % ausgelastet, was aber normal ist.

Die SSH Console des Hosts nimmt jetzt auch wieder befehle entgegen.

Achso und nein, der Host hat keine VM angehalten, die zwei Windows Maschinen sind hart weggeknallt

Warte mal, ich nutze "vmkfstools" um die Festplatten hart mit der VM zu verbinden.

Also in SSH "vmkfstools -z /vmfs/devices/disks/t10.ATA_____Festplatten_______ID /vmfs/volumes/datastore1/vmdk/Festplatten_ID.vmdk", diese zeigt ja auf die datastore1 SSD, also die vom Host Boot SSD.

Werden alle Bytes einmal auf die vom Host SSD und dann auf die richtige Fesplatte geschrieben?

Wenn ja, habe ich das problem gefunden....

Werde das ganze mal auf eine andere SSD verschieben.

ich habe im Moment ein großes Problem.

Wie es scheint, ist meine SSD (neu ca. 1 Monat alt) welche nur als Boot Medium des Host dient, nicht mehr erreichbar.

Um die SSD in Richtung TBW zu schonen, nutze ich diese nur zum Booten oder um mal eine ISO zu speichern, aber nur wenn der Platz auf andern Platten langsam knapp wird oder die andere SSD mit den VM's gerade zu stark belastet wird.

Die SSD für den Host hat auch einen Datenspeicher (datastore1), darauf liegt wie oben beschrieben eigentlich nichts, vielleicht 2 GB von ca. 330 GB und ein paar zwequetschte.

Ich wollte gerade eben auf eine der wenigen Windows Maschinen, welche auf einer anderen SSD liegt, zugreifen.

Die VM reagierte langsam, bis hin zu gar nicht, also wollte ich diese Neustarten.

Nach dem Neustart blieb die RDP Sitzung schwarz, erst nach knapp 15 Minuten baute sich langsam Windows auf und ich bekam ein Bild, jedoch konnte ich nur den Task-Manager öffnen, nicht einmal der Windows-Explorer ging.

Also wollte ich direkt über den Host per VMware Remote Console auf die VM gucken, jedoch kam es nach ca. 10 Minuten zu einer Zeitüberschreitung und an der Config des Host konnte ich auch nichts ändern, bzw. aufrufen.

[bild 1]

Also habe ich in die Überwachung -> Ereignisse geguckt und sehe da:

Wegen Konnektivitätsproblemen kann nicht mehr auf Volume 63505146-84f4f092-2e0f-a85e4556b1fb (datastore1) zugegriffen werden. Es wird versucht, eine Wiederherstellung durchzuführen. Das Ergebnis liegt demnächst vor.

Typ Warnung

Uhrzeit Dienstag, 08. November 2022, 16:08:54 +0100

Knowledgebase Klicken Sie hier, um die VMware.com-Online-Knowledgebase zu diesem Ereignis zu durchsuchen

[bild 2]Danach kam noch eine Meldung:

Das Protokollieren auf Speichermedien ist fehlgeschlagen. Protokolldateien werden nicht mehr lokal auf diesem Host gespeichert.

Typ Warnung

Uhrzeit Dienstag, 08. November 2022, 18:01:01 +0100

Knowledgebase Klicken Sie hier, um die VMware.com-Online-Knowledgebase zu diesem Ereignis zu durchsuchen

[bild 3]Davor und danach ist alles in Ordnung, also in den Ereignissen.

Jedoch denke ich, dass es nur eine Frage der Zeit ist, bis der Host mir den Pinken Bildschirm mit einer Fehlermeldung anzeigt und alle VM's abstürzen.

Ich habe gerade versucht eine VM anzuhalten, das funktioniert jedoch nicht mehr.....

Er sagt gestartet, aber die VM ist noch über SSH erreichbar und arbeitet, im Log steht unter Gestartet "aN.aN.NaN aN:aN:aN" was sehr beruhigend ist.

[bild 4]

Ich habe jetzt nach ca. 10 Minuten angefangen die VM's per SSH ordnungsgemäß herunterzufahren, auf der Seite des ESXi laufen sie angeblich noch.

Ich werde den Host gleich herunterfahren und die Kontakte der PCIE SSD mal vorsichtig mit einem Tuch "berühren" und sie danach wieder einbauen.

Er lief jetzt 4 Tage am stück, davor hatte ich einen Standard SATA Controller eingebaut mit mehreren Festplatten, wie man an der Speichergröße des FileShares sehen kann. (Sie wurden direkt eingebunden, ohne datastore etc.)

Kennt jemand das Problem und kann mir sagen woran das lag?

Liebe Grüße

// Nachtrag

Die Bilder verschieben sich leider, Sorry

So der host wurde neugestartet und scheint erstmal wieder zu laufen.

Die Windows VM rennt auch wieder.

Die SSD mit den VM's hatte/hat noch 103 GB Frei, RAM waren auch noch so 8GB von 80GB frei, Prozessor war so zu 60-70 % ausgelastet, was aber normal ist.

Die SSH Console des Hosts nimmt jetzt auch wieder befehle entgegen.

Achso und nein, der Host hat keine VM angehalten, die zwei Windows Maschinen sind hart weggeknallt

Warte mal, ich nutze "vmkfstools" um die Festplatten hart mit der VM zu verbinden.

Also in SSH "vmkfstools -z /vmfs/devices/disks/t10.ATA_____Festplatten_______ID /vmfs/volumes/datastore1/vmdk/Festplatten_ID.vmdk", diese zeigt ja auf die datastore1 SSD, also die vom Host Boot SSD.

Werden alle Bytes einmal auf die vom Host SSD und dann auf die richtige Fesplatte geschrieben?

Wenn ja, habe ich das problem gefunden....

Werde das ganze mal auf eine andere SSD verschieben.

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 4565191304

Url: https://administrator.de/forum/esxi-7-hauptspeicher-nicht-erreichbar-4565191304.html

Ausgedruckt am: 16.07.2025 um 17:07 Uhr

12 Kommentare

Neuester Kommentar

Moin,

ESXi, genau wie Windows, hyper-V, Linux, etc, ist empfindlich was die Storages angeht.

Wenn ein Storage nicht mehr sauber funktioniert kommt es zu all den von Dir beschriebenen Symptomen.

Das kann sowohl an SSD/HDD, Kabeln, Mainboard, BIOS, Netzteil liegen.

Auch eine neue SSD kann nach 1 Tag kaputt gehen.

Dafür gibt es RAID oder Ersaztmodelle.

Ich verwende bei kleinen Kunden WD Green 120GB M2 SATA SSDs für ESXi zum booten.

Darauf passiert ja nichts. Früher viel mit USB Sticks oder SD-Karten. Damit hatte ich nie Probleme.

Außerdem gibt es Backups wenn mal was kaputt geht.

Austauschen, ggf. Backup einspielen, fertig.

Wenn Du Zeit hast, kannst Du den Fehler ja suchen gehen.

Stefan

ESXi, genau wie Windows, hyper-V, Linux, etc, ist empfindlich was die Storages angeht.

Wenn ein Storage nicht mehr sauber funktioniert kommt es zu all den von Dir beschriebenen Symptomen.

Das kann sowohl an SSD/HDD, Kabeln, Mainboard, BIOS, Netzteil liegen.

Auch eine neue SSD kann nach 1 Tag kaputt gehen.

Dafür gibt es RAID oder Ersaztmodelle.

Ich verwende bei kleinen Kunden WD Green 120GB M2 SATA SSDs für ESXi zum booten.

Darauf passiert ja nichts. Früher viel mit USB Sticks oder SD-Karten. Damit hatte ich nie Probleme.

Außerdem gibt es Backups wenn mal was kaputt geht.

Austauschen, ggf. Backup einspielen, fertig.

Wenn Du Zeit hast, kannst Du den Fehler ja suchen gehen.

Stefan

Grade ESXi macht ja kaum was auf dem eigenen Storage, es reicht also ein wirklich schlichtes, kleines, und auch langsames Storage, es sollten aber natürlich keine VMs drauf liegen.

Du schreibst aber gar nichts zur Hardware, welche SSD? Was ist das für ein Server? Reden wir hier über einen Eigenbau oder was mit Kompatibilitätslisten oder eventuell Hardware Support?

Du schreibst aber gar nichts zur Hardware, welche SSD? Was ist das für ein Server? Reden wir hier über einen Eigenbau oder was mit Kompatibilitätslisten oder eventuell Hardware Support?

Die Bilder verschieben sich leider, Sorry

Nein. Du hast es leider versäumt die FAQs zu lesen! Ansonsten wäre dir nicht entgangen bei eingebetteten Bilder das „+“ zu klicken an der Stelle im Kontext wo die Bilder hinsollen.So werden sie lediglich am Ende des Threads ohne jeden Textbezug angefügt.

Aber du hast ja immer den „Bearbeiten“ Knopf um diesen Fauxpas auch nachträglich noch zu korrigieren. 😉

Zitat von @ButterBot:

Ich habe schon gemerkt das ESXi's sehr anfällig für Festplatten oder RAM Fehler sind, hatte dieses Jahr schon so viele purple screen of death.

? Ich nutze schon seit über 10 Jahren ESXi auf Fujitsu Severn, Workstations und normalen PCs.Ich habe schon gemerkt das ESXi's sehr anfällig für Festplatten oder RAM Fehler sind, hatte dieses Jahr schon so viele purple screen of death.

Ich hatte orginal 3 purple screen of death.

2 wegen eines defekten RAM Moduls kurz hintereinander (was das IPMI schon angezeigt hatte) und 1 mal aus unbekannten Gründen. Grundsätzlich läuft ESXi viel stabiler als Windows. Nur die Linux-Web-Server sind vergleichbar.

Ach ja, ESXi ist ja im Prinzip ein Linux

Ich habe hier bei einem exKunden einen uralten ESXi (ca. 9 Jahre alt). Aktuelle Laufzeit 1.250 Tage seit dem letzten Reboot.

Also Dinge wie übertakten würde ich bei einem Serversystem nicht machen wollen aber ich denke hier liegt das Problem wirklich eher am Speicher selbst oder am Controller. Also auf jeden Fall Firmware aktuell machen und ggf. einfach mal einen anderen Speicher als Boot Laufwerk probieren, so wählerisch ist ESXi nicht.

Also Erfahrung habe ich da keine aber außer Fehlermeldungen glaube ich nicht das ESXi ein Problem damit hat.

Hast du die VMware Tools in der VM eingerichtet? Es gibt einen Parameter devices.hotplug in der Config der VM unter

Erweitert \ Konfigurationsparameter \ Konfiguration bearbeiten \ Konfigurationsparameter hinzufügen

Ich weiß nur das mir unter Win 2012R2 die HDDs immer zum Auswurf angeboten wurden, daher habe ich den auf FALSE stehen Eventuell kannst du Hotplug mit dem Controller in die VM weiter reichen...

Eventuell kannst du Hotplug mit dem Controller in die VM weiter reichen...

Hast du die VMware Tools in der VM eingerichtet? Es gibt einen Parameter devices.hotplug in der Config der VM unter

Erweitert \ Konfigurationsparameter \ Konfiguration bearbeiten \ Konfigurationsparameter hinzufügen

Ich weiß nur das mir unter Win 2012R2 die HDDs immer zum Auswurf angeboten wurden, daher habe ich den auf FALSE stehen