Intel-E810 QSFP28 to Mikrotik QSPF+ mit 40Gbit Verbindung

Hallo Zusammen,

wir haben folgende Situation:

Wir haben einen Server mit einer Intel E810-CQDA2.

Diese Karte hat 2xQSFP28 Ports.

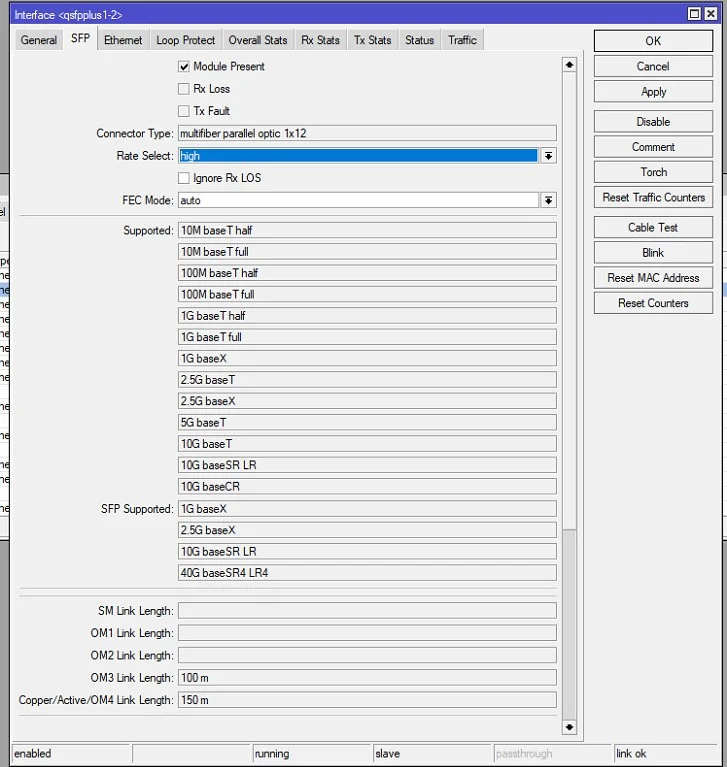

In den Ports sind die folgenden Module verbaut: 36281 ( fs.com/products/36281.html )

Auf der Gegenseite haben wir einen Mikrotik Switch CRS326-24S+2Q+RM ( mikrotik.com/product/crs326_24s_2q_rm ).

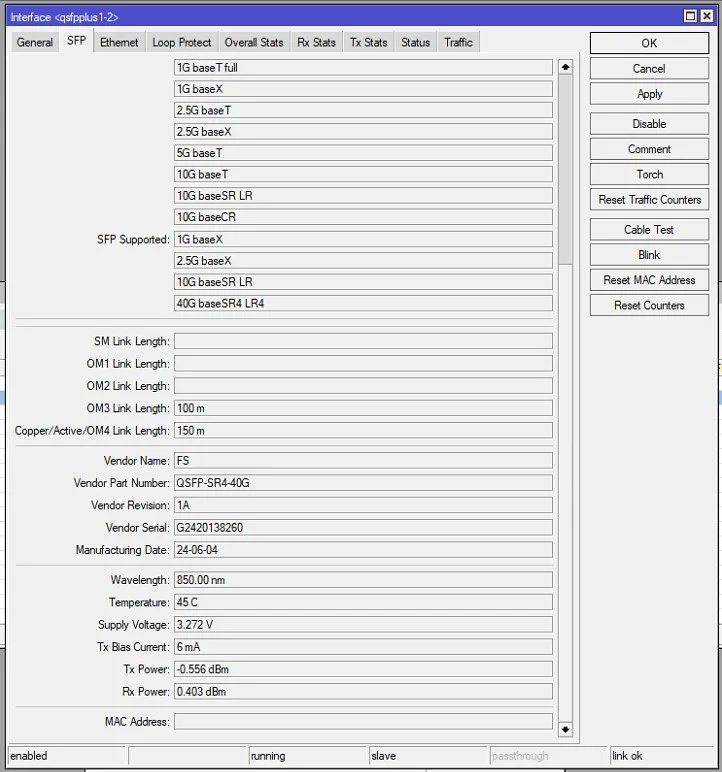

Dieser hat 2xQSFP+ Ports. Verbaut sind dort folgende Module: 84681 ( fs.com/products/84681.html )

Verbunden sind die Ports mit folgendem Kabel: 130658 ( fs.com/products/130658.html )

Dir Firmware der Intel Netwerkkarte am Server hat die aktuellste Firmware (4.60).

Unser Problem ist nun, dass wir nur 10G als Verbindung bekommen, und nicht 40G.

Kann einer sagen, ob dies mit der Intel Karte möglich ist? Wir finden dort keine Möglichkeit, diese auf 40G einzustellen. Braucht es dafür DAC Kabel ?

Oder benötigen wir spezielle Treiber für die Intel Karte?

Über jede Hilfe wären wir dankbar!

wir haben folgende Situation:

Wir haben einen Server mit einer Intel E810-CQDA2.

Diese Karte hat 2xQSFP28 Ports.

In den Ports sind die folgenden Module verbaut: 36281 ( fs.com/products/36281.html )

Auf der Gegenseite haben wir einen Mikrotik Switch CRS326-24S+2Q+RM ( mikrotik.com/product/crs326_24s_2q_rm ).

Dieser hat 2xQSFP+ Ports. Verbaut sind dort folgende Module: 84681 ( fs.com/products/84681.html )

Verbunden sind die Ports mit folgendem Kabel: 130658 ( fs.com/products/130658.html )

Dir Firmware der Intel Netwerkkarte am Server hat die aktuellste Firmware (4.60).

Unser Problem ist nun, dass wir nur 10G als Verbindung bekommen, und nicht 40G.

Kann einer sagen, ob dies mit der Intel Karte möglich ist? Wir finden dort keine Möglichkeit, diese auf 40G einzustellen. Braucht es dafür DAC Kabel ?

Oder benötigen wir spezielle Treiber für die Intel Karte?

Über jede Hilfe wären wir dankbar!

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 669581

Url: https://administrator.de/forum/intel-e810-qsfp28-to-mikrotik-qspf-mit-40gbit-verbindung-669581.html

Ausgedruckt am: 24.07.2025 um 05:07 Uhr

24 Kommentare

Neuester Kommentar

Braucht es dafür DAC Kabel ?

Sehr wahrscheinlich nicht.Alle diese 40G SR4 Optiken sind Breakout fähig.

cisco.com/c/en/us/products/collateral/interfaces-modules/transce ...

D.h. wenn das entsprechende Endgerät es supportet kann man so einen 40G SR4 Port in den Breakout Mode versetzen was dann 4 separate 10G Ports erzeugt. Auf dem Switch z.B. um mit einem 40G Port reine 10G Endgeräte wie Server/Switches etc. zu versorgen.

Es ist anzunehmen das einer deiner Endgeräte die QSFP Optik in den Breakout Mode versetzt und so nur 10G aktiviert. Du musst also herausfinden wer da der Verursacher ist. Mikrotik scheidet da aus da sie keinen Breakout Mode supporten.

Das kannst du auch temporär einmal selber testen indem du im Mikrotik mal ein 40G Loop steckst über beide 40G Ports. RSTP verhindert hier Böses aber du kannst über den Port Status sehen ob die MT Switchports physisch einen 40G Port herstellen. Das verifiziert das Kabel und QSFP Optiken OK sind.

Der Mikrotik macht übrigens kein Vendor Checking so das hier auch alle anderen QSFP SR4 Optiken von der Stange rennen wie z.B. dieser hier. 😉

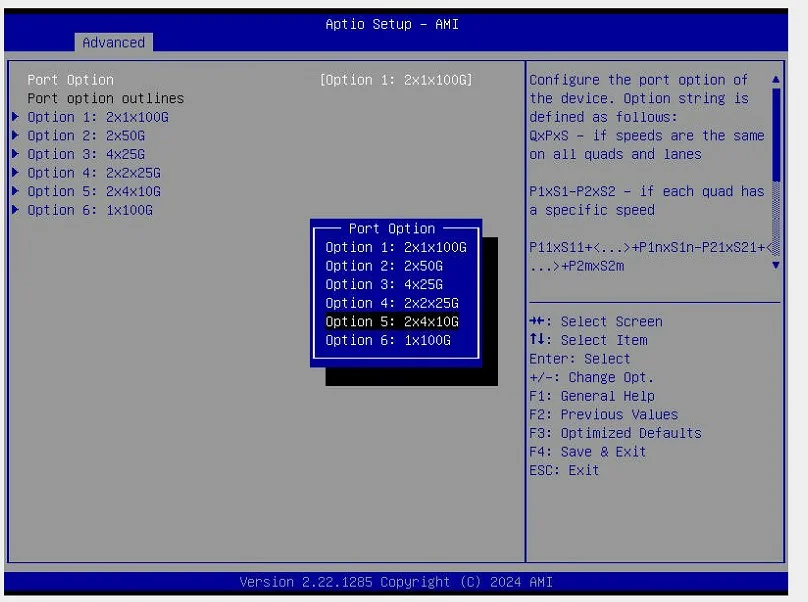

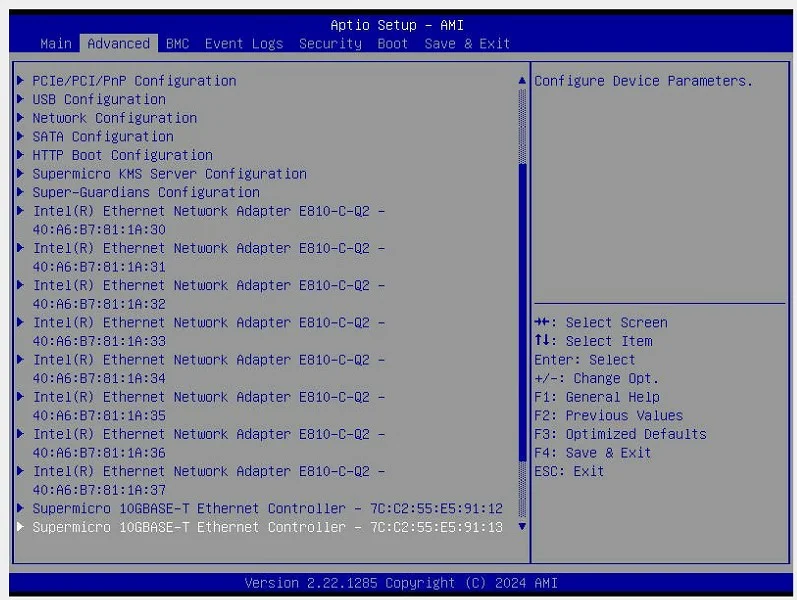

Vermutlich ist es die Intel Seite wo du im Adapter Setup einmal checken musst ob dort ggf. Breakout aktiviert ist die dann 4mal 10G Ports aktiviert. Intel erwähnt dazu ein "Port Configuration Tool":

intel.com/content/www/us/en/download/19436/ethernet-port-configu ...

Aktelle Treiber auf der Intel Seite:

intel.de/content/www/de/de/products/sku/192558/intel-ethernet-ne ...

Alternative aber teurer ist moderne MMF BiDi QSFP Optiken zu verwenden die mit klassischem Duplex LC Patchkabeln statt MTP funktionieren und kein Breakout kennen.

Glückwunsch! 👏 👍

Obwohl "2x4x10G" erstmal falsch klingt weil das ja das Breakout auf 4mal 10G Ports aktiviert was du ja eben nicht willst. Vermutlich hast du das also DEaktiviert damit die Karte 2mal 40 Gig macht mit 2 einzelnen 40 Gig Interfaces. 🤔

Eine einfache SR4 QSFP Optik mit MTP wie die oben genannte rennt hier fehlerlos in einem Mikrotik zu Cisco und Ruckus ICX Switches. Und das natürlich mit einer 40 Gig "Fat Pipe"! 😉

Obwohl "2x4x10G" erstmal falsch klingt weil das ja das Breakout auf 4mal 10G Ports aktiviert was du ja eben nicht willst. Vermutlich hast du das also DEaktiviert damit die Karte 2mal 40 Gig macht mit 2 einzelnen 40 Gig Interfaces. 🤔

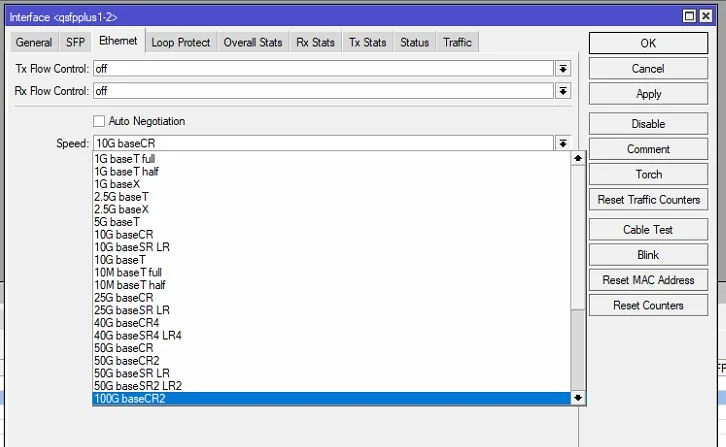

Nur wenn dort das erste Interface des QSFP Ports manuell auf 10G einstellen, anstatt auto Negotiation, bekommen wir diesen.

Bei (Q)SFP Ports am Mikrotik größer 1G sollte man generell nie irgendwelche Negotiation wählen sondern den Port immer auf feste Speed und Duplex Werte stellen die zur im Port verwendeten Optik passen. (Q)SFP Optiken supporten bekanntlich keine Autonegotiation!Eine einfache SR4 QSFP Optik mit MTP wie die oben genannte rennt hier fehlerlos in einem Mikrotik zu Cisco und Ruckus ICX Switches. Und das natürlich mit einer 40 Gig "Fat Pipe"! 😉

Vielen Dank

Immer gerne! 😊

Moin @aqui,

so wie @Pharaun das beschreibt, hat er eher eine 4 x 10G als eine 1x 40G Verbindung aufgebaut, was nicht wirklich ein und dasselbe ist.

Gruss Alex

P.S.

By the way, eine E810 ist auch nicht gleich E810, denn die E810-CQDA2 liefert über ihre

QSFP28 per Breakout 10 x 10G, zumindest über den ersten Port. 🙃

Obwohl "2x4x10G" erstmal falsch klingt weil das ja das Breakout auf 4mal 10G Ports aktiviert was du ja eben nicht willst. Vermutlich hast du das also DEaktiviert damit die Karte 2mal 40 Gig macht mit 2 einzelnen 40 Gig Interfaces. 🤔

Nur wenn dort das erste Interface des QSFP Ports manuell auf 10G einstellen, anstatt auto Negotiation, bekommen wir diesen.

so wie @Pharaun das beschreibt, hat er eher eine 4 x 10G als eine 1x 40G Verbindung aufgebaut, was nicht wirklich ein und dasselbe ist.

Gruss Alex

P.S.

By the way, eine E810 ist auch nicht gleich E810, denn die E810-CQDA2 liefert über ihre

QSFP28 per Breakout 10 x 10G, zumindest über den ersten Port. 🙃

hat er eher eine 4 x 10G als eine 1x 40G Verbindung aufgebaut, was nicht wirklich ein und dasselbe ist.

Das ist üblicher Standard bei SR4 Optiken die das Signal auf 4mal 10Gig verteilen. Es ist aber keinesfalls sowas wie ein LAG, da nur die L1 Signalisierung (VCSEL) verteilt ist. Der Datenfluss stellt sich aus Sicht des Switches dar wie eine reine 40G "fat Pipe". Es ist also ein natives 40G Interface sofern kein Breakout verwendet wird.

Moin @aqui,

ich fürchte, du übersiehst da eine Kleinigkeit und zwar die folgende.

Das Problem des TO's liegt leider ganz woanders und das was jetzt kommt, wird ihm glaube ich auch nicht wirklich gefallen ... er hat sich nämlich entweder die falschen NIC's oder die falschen Switche gekauft, je nachdem wie man es sieht. 😬

Und zwar können die Intel E810 NIC's ...

ark.intel.com/content/www/us/en/ark/products/series/184846/intel ...

... entweder 1GbE oder 10GbE oder 25GbE oder 50GbE oder gar 100GbE abliefern, aber eben kein natives 40GbE, denn das können nur die folgenden Intel NIC's ...

ark.intel.com/content/www/us/en/ark/products/series/96044/intel- ...

... . 😉

Sprich, damit der TO nativ 40GbE nutzen kann, muss er entweder die NIC's tauschen oder einen anderen Switch kaufen, der 50G QSFP+ Ports bereitstellt, wie die Cisco Nexus 9300-Serie oder z.B. Broadcom N8560-32C.

Meine Kristallkugel sagt mir jedoch, dass es eher andere NIC's als 50G Switche werden. 🙃

Gruss Alex

Das ist üblicher Standard bei SR4 Optiken die das Signal auf 4mal 10Gig verteilen. Es ist aber keinesfalls sowas wie ein LAG, da nur die L1 Signalisierung (VCSEL) verteilt ist. Der Datenfluss stellt sich aus Sicht des Switches dar wie eine reine 40G "fat Pipe". Es ist also ein natives 40G Interface sofern kein Breakout verwendet wird.

ich fürchte, du übersiehst da eine Kleinigkeit und zwar die folgende.

Dort kann man unter NIC Configuration dann die "Port Option" konfigurieren mit "2x4x10G".

Kaum war das umgestellt hat man sowohl im BIOS als auch im Windows dann logischerweise 4 Interfaces pro NIC Port.

Kaum war das umgestellt hat man sowohl im BIOS als auch im Windows dann logischerweise 4 Interfaces pro NIC Port.

Das Problem des TO's liegt leider ganz woanders und das was jetzt kommt, wird ihm glaube ich auch nicht wirklich gefallen ... er hat sich nämlich entweder die falschen NIC's oder die falschen Switche gekauft, je nachdem wie man es sieht. 😬

Und zwar können die Intel E810 NIC's ...

ark.intel.com/content/www/us/en/ark/products/series/184846/intel ...

... entweder 1GbE oder 10GbE oder 25GbE oder 50GbE oder gar 100GbE abliefern, aber eben kein natives 40GbE, denn das können nur die folgenden Intel NIC's ...

ark.intel.com/content/www/us/en/ark/products/series/96044/intel- ...

... . 😉

Sprich, damit der TO nativ 40GbE nutzen kann, muss er entweder die NIC's tauschen oder einen anderen Switch kaufen, der 50G QSFP+ Ports bereitstellt, wie die Cisco Nexus 9300-Serie oder z.B. Broadcom N8560-32C.

Meine Kristallkugel sagt mir jedoch, dass es eher andere NIC's als 50G Switche werden. 🙃

Gruss Alex

Wenn ich über die 4 Interfaces ein SET Team mache, was aktue.l nun auch so ist

Nein, das ist dann eine ganz andere Welt! Wie @MysticFoxDE schon richtig sagt wird dann das Breakout aktiviert und du hast dann 4 einzelne 10G Interfaces und darüber arbeitet dann ein LACP LAG.Damit hast du dann keine 40Gig "Fat Pipe" mehr also einen einzigen nativen 40Gig Link, sondern machst eine Hash basierte Link Aggregation (LAG) über 4 mal 10Gig Einzellinks.

Performancetechnisch ist das deutlich schlechter, da Daten immer nur sessionbasierend mit 10Gig übertragen werden. Es findest nur eine mehr oder minder bessere Auslastung/Verteilung über diese 10G Memberlinks statt. Dies hängt im Hohen Maße dann von deiner Adressentropie im Netz ab. All die Nachteile eines LAG im Vergleich zu einem Einzellink mit der Bandbreite.

Das sind also de facto keine echten 40G sondern nur viele verteilte Sessions auf 10Gig. Sicher NICHT dass was du mit der Anschaffung der 40G erreichen wolltest?!

Moin @Pharaun,

nein, das ist leider nicht mal ansatzweise dasselbe, wie wen du einen nativen 40G Uplink hast.

Ja, leider eine ganze Menge, für einen grossteil davon kannst du jedoch nichts, da dieses Thema vor allem von Microsoft sowohl schlampig umgesetzt als auch dokumentiert ist. 😭

Ich versuche mal ein paar wesentliche Dinge auszuzählen.

Wenn man bei einem Hyper-V oder auch VMware, den VM-Datenverkehr mit NIC's => 10G abfertigen und dabei auch nur ansatzweise deren mögliche Bandbreite erreichen möchte, dann führt KEIN Weg an VMQ und SR-IOV, oder RDMA vorbei.

Bei einem SET Team, bei dem mehrere >= 10G NIC's verwendet werden, sollte man laut Microsoft selbst den Loadbalancer auf "HyperVPort" umstellen, wodurch den VM's dann aber nur noch max. die Geschwindigkeit einer einzelnen NIC zur Verfügung steht. 🙃

Und damit du beim SET überhaupt auch nur ansatzweise selbst 10G sauber hinbekommst, musst du sowohl die NIC, als auch den vSwitch als auch die vNIC, noch ordentlich nachoptimieren. 😔

Das geht und zwar nur mit einem Interface, sprich, so wie du es eigentlich ursprünglich haben wolltest. 😉

Ähm, ja, das ist fürchte ich bisher nur das "Warm-Up" vom "Warm-Up", den bisher habe ich Hyper-V noch gar nicht angesprochen und da wird es leider noch so um einiges gruseliger.

Aber, um das mal ordentlich zu belegen, muss ich zuerst eine Saubere "Baseline" mit ohne den ganzen Feature-Krampf mal machen und da NTTTCP ja nicht wirklich das macht was man ihm sagt, muss ich die ganzen bisherigen Messungen nun mit iPerf machen, was jedoch auch nicht ganz so einfach ist, da iPerf wiederum nicht 1:1 dasselbe wie, theoretisch zumindest, NTTCP machen kann. 😔😭

Gruss Alex

ja de facto wohl die falsche NIC (Da wurde so genau auch nicht drüber nachgedacht seitens der Person, die den Server konzipiert hat)e. Aber jetzt tatsächlich mal doof gefragt, wo sollte da das Problem sein?

Wenn ich über die 4 Interfaces ein SET Team mache, was aktue.l nun auch so ist, sind doch trotzdem de facto 40Gibt/s nutzbar ?

Wenn ich über die 4 Interfaces ein SET Team mache, was aktue.l nun auch so ist, sind doch trotzdem de facto 40Gibt/s nutzbar ?

nein, das ist leider nicht mal ansatzweise dasselbe, wie wen du einen nativen 40G Uplink hast.

Oder übersehe ich irgendwas?

Ja, leider eine ganze Menge, für einen grossteil davon kannst du jedoch nichts, da dieses Thema vor allem von Microsoft sowohl schlampig umgesetzt als auch dokumentiert ist. 😭

Ich versuche mal ein paar wesentliche Dinge auszuzählen.

Wenn man bei einem Hyper-V oder auch VMware, den VM-Datenverkehr mit NIC's => 10G abfertigen und dabei auch nur ansatzweise deren mögliche Bandbreite erreichen möchte, dann führt KEIN Weg an VMQ und SR-IOV, oder RDMA vorbei.

Bei einem SET Team, bei dem mehrere >= 10G NIC's verwendet werden, sollte man laut Microsoft selbst den Loadbalancer auf "HyperVPort" umstellen, wodurch den VM's dann aber nur noch max. die Geschwindigkeit einer einzelnen NIC zur Verfügung steht. 🙃

Und damit du beim SET überhaupt auch nur ansatzweise selbst 10G sauber hinbekommst, musst du sowohl die NIC, als auch den vSwitch als auch die vNIC, noch ordentlich nachoptimieren. 😔

Auf der anderen Seite wüsste ich gar nicht, ob es mit einer 40Gbit Karte zusammen mit dem Mikrotik gehen würde, denn dieser zeigt ja so oder so 4 Interfaces an. Ich wüsste nicht wie man diesen so einstellen könnte, dass er als "ein" Interface aggiert?

Das geht und zwar nur mit einem Interface, sprich, so wie du es eigentlich ursprünglich haben wolltest. 😉

PS: @MysticFoxDE , Ich verfolge sehr gespannt deinen Beitrag zu NICs unter Server 2025 ;)

Ähm, ja, das ist fürchte ich bisher nur das "Warm-Up" vom "Warm-Up", den bisher habe ich Hyper-V noch gar nicht angesprochen und da wird es leider noch so um einiges gruseliger.

Aber, um das mal ordentlich zu belegen, muss ich zuerst eine Saubere "Baseline" mit ohne den ganzen Feature-Krampf mal machen und da NTTTCP ja nicht wirklich das macht was man ihm sagt, muss ich die ganzen bisherigen Messungen nun mit iPerf machen, was jedoch auch nicht ganz so einfach ist, da iPerf wiederum nicht 1:1 dasselbe wie, theoretisch zumindest, NTTCP machen kann. 😔😭

Gruss Alex

Moin @aqui,

😬 ... also das davor passt nicht ganz, da SET kein LACP supportet, aber, selbst ohne LACP, würde ich mich der folgenden Aussage ...

... trotzdem komplett anschliessen.

Gruss Alex

Nein, das ist dann eine ganz andere Welt! Wie @MysticFoxDE schon richtig sagt wird dann das Breakout aktiviert und du hast dann 4 einzelne 10G Interfaces und darüber arbeitet dann ein LACP LAG.

Damit hast du dann keine 40Gig "Fat Pipe" mehr also einen einzigen nativen 40Gig Link, sondern machst eine Hash basierte Link Aggregation (LAG) über 4 mal 10Gig Einzellinks.

Damit hast du dann keine 40Gig "Fat Pipe" mehr also einen einzigen nativen 40Gig Link, sondern machst eine Hash basierte Link Aggregation (LAG) über 4 mal 10Gig Einzellinks.

😬 ... also das davor passt nicht ganz, da SET kein LACP supportet, aber, selbst ohne LACP, würde ich mich der folgenden Aussage ...

Performancetechnisch ist das deutlich schlechter, da Daten immer nur sessionbasierend mit 10Gig übertragen werden. Es findest nur eine mehr oder minder bessere Auslastung/Verteilung über diese 10G Memberlinks statt. Dies hängt im Hohen Maße dann von deiner Adressentropie im Netz ab. All die Nachteile eines LAG im Vergleich zu einem Einzellink mit der Bandbreite.

Das sind also de facto keine echten 40G sondern nur viele verteilte Sessions auf 10Gig. Sicher NICHT dass was du mit der Anschaffung der 40G erreichen wolltest?!

Das sind also de facto keine echten 40G sondern nur viele verteilte Sessions auf 10Gig. Sicher NICHT dass was du mit der Anschaffung der 40G erreichen wolltest?!

... trotzdem komplett anschliessen.

Gruss Alex

Moin @Pharaun,

Einzellunk ... auch gut. 🙃

Ist aber nicht ganz richtig, denn eine 4 GHz Kern kann im Vergleich zu einem 1GHz Kern oder von mir aus auch vier davon, eine einzelne Aufgabe normalerweise um Faktor 4 viel schneller rechnen und bei den NIC's sieht es bei vor allem sequentiellen Workloads, meist sehr ähnlich aus. 😉

Wie ich schon in dem Post davor geschrieben habe, bei >= 10G, wird seitens Microsoft eigentlich nur der "HyperVPort" Algorithmus empfohlen.

Wie schon @aqui zuvor geschrieben hat, 1x40G fühlt sich in den meisten Fällen ganz anders an, wie 4x10G, das letztere ist eher wie mit 4 oder mehr Gummis übereinander. 🙃

Gruss Alex

Hier muss meines erachtens ja nicht ein Einzellunk mit hoher Bandbreite vorhanden sein, da sowieso viele Session von den VMs aufgemacht werden.

Einzellunk ... auch gut. 🙃

Zumindest würde ich das so sehen.

Ist aber nicht ganz richtig, denn eine 4 GHz Kern kann im Vergleich zu einem 1GHz Kern oder von mir aus auch vier davon, eine einzelne Aufgabe normalerweise um Faktor 4 viel schneller rechnen und bei den NIC's sieht es bei vor allem sequentiellen Workloads, meist sehr ähnlich aus. 😉

Was ich mir allerdings Frage, ob man als Hash Algorythmus im SET Team dann eher auf Hyper-V Port oder Dynamic stellen sollte.

Was wäre hier die Empfehlung von eurer Seite?

Was wäre hier die Empfehlung von eurer Seite?

Wie ich schon in dem Post davor geschrieben habe, bei >= 10G, wird seitens Microsoft eigentlich nur der "HyperVPort" Algorithmus empfohlen.

Auf dem Server werden gemischte Anwendungsfälle sein, unter anderem TS Umgebung, SQL Server, und weitere Branchenanwendungen in jeweils eigenen VMs. insgesamt vermutlich so ca 10-15 VMs.

Wie schon @aqui zuvor geschrieben hat, 1x40G fühlt sich in den meisten Fällen ganz anders an, wie 4x10G, das letztere ist eher wie mit 4 oder mehr Gummis übereinander. 🙃

Gruss Alex

Moin @Pharaun,

ich muss gestehen, dass ich mich zumindest praktisch, nicht wirklich mit Mikrotik auskenne und irgend einen der Billigheimer, kann @aqui soweit ich mich erinnern kann, auch nicht leiden, aber ja, wir bekommen das schon irgendwie noch geklärt. 😉

Gruss Alex

Das habe ich schon verstanden, aber im Mikrotik sind es ja auch 4 Interfaces. Kann man das im TiK anpassen oder wie soll das auf der TiK Seite dann korrekt sein?

Das wäre für mich die Frage der Fragen in diesem Bezug...

Das wäre für mich die Frage der Fragen in diesem Bezug...

ich muss gestehen, dass ich mich zumindest praktisch, nicht wirklich mit Mikrotik auskenne und irgend einen der Billigheimer, kann @aqui soweit ich mich erinnern kann, auch nicht leiden, aber ja, wir bekommen das schon irgendwie noch geklärt. 😉

Gruss Alex

Die LAG Geschichte im Mikrotik ist im Tutorial erklärt:

Mikrotik Link Aggregation

Ist mehr oder minder typisch wie alle Switch Hersteller das machen.

Mikrotik Link Aggregation

Ist mehr oder minder typisch wie alle Switch Hersteller das machen.

dann wäre für mich die Frage wie das am TiK funktioniert?

Ahhsoo, sorry missverstanden. 🙈Da das ein natives 40G Interface ist musst du da nix machen. In den physischen Port Setups ggf. fest 40Gig Fulldup einstellen, QSFP rein, fertisch.

Da es ein natives 40Gig Interface ist und kein Multispeed kannst du dir das Speed und Duplex Setting auch sparen. Die Optik rennt im Default dann als "Fat Pipe" mit 40G.

Mit der einfachen Optik von oben und einem Cisco 9000er bzw. Ruckus ICX als Gegenüber kommt hier sofort ein nativer 40Gig Link zustande mit dem SR4. Übrigens auch mit einem BiDi QSFP und LC Kabel.

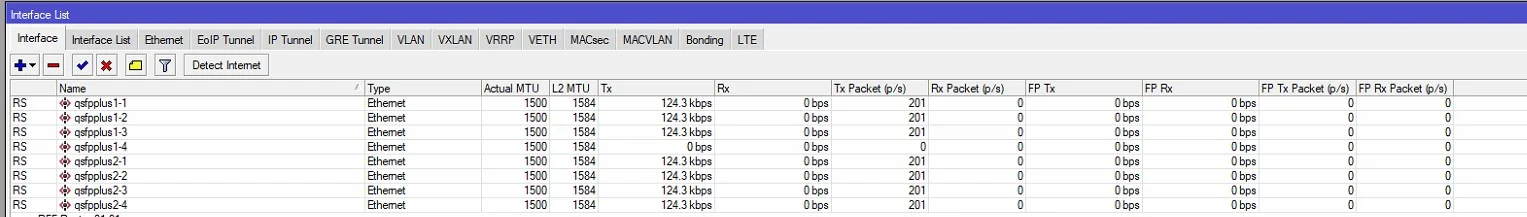

Das heißt, obwohl im Tik dann 4 Interfaces für jeden QSFP Port angezeigt werden

Nein, das ist dann falsch. Wenn 4 Interfaces angezeigt werden hat da ja jemand schon Breakout konfiguriert mit 4mal 10Gig. Dann splittet sich ein QSFP Port in 4mal 10G Interfaces. Genau das was du ja nicht willst.Es darf nur ein Interface pro QSFP Slot angezeigt werden. So wie es ist wenn der Switch ohne Default Konfig gebootet wird.

Moin @Pharaun,

das trifft aber nicht wirklich generell für QSFP28 zu, den dieses kann grundsätzlich per "multilane serial interface" nicht nur in 4 x 25G Mode betrieben werden, sondern auch im 10 x 10G Mode und theoretisch ist sogar N x XG möglich.

Ich wollte dir übrigens vorhin noch als Alternative zu dem NIC-Tausch noch den "CRS520-4XS-16XQ-RM" empfehlen ...

mikrotik.com/product/crs520_4xs_16xq_rm#fndtn-testresults

... welcher mit 16 100G Ports von den Kosten her sehr überschaubar ist. Jedoch habe ich beim prüfen seiner Specs zum Glück noch rechtzeitig gesehen, dass die 16 x 100G Ports dieses Switches, neben nativem 100G auch 2x50G oder 1x40G oder 4x25G oder 4x10G oder 4x1G, aber leider KEIN 1x50G und auch kein 10x10G unterstützen. 🙃

Oh oh, ich fürchte, dieser Beitrag ist wahrscheinlich nur der Beginn einer ganz neuen Problemkette. 😬

Gruss Alex

Es sind bei Mikrotik wohl immer die 4 Interfaces zu sehen:

Und dann kommt wohl drauf, was man hat und die Konfiguration entsprechend anpasst. Für 40G Singe Link wird dann allerdings nur das erste Interface konfiguriert und die anderen 3 bleiben unbeachtet.

Details siehe hier:

help.mikrotik.com/docs/spaces/ROS/pages/220233794/MikroTik+wired ...

In RouterOS, QSFP+ and QSFP28 interfaces are designed to handle high-speed data transmission by utilizing multiple channels. Each QSFP+ or QSFP28 interface is divided into four sub-interfaces, each corresponding to a transmission channel necessary for proper operation.

Und dann kommt wohl drauf, was man hat und die Konfiguration entsprechend anpasst. Für 40G Singe Link wird dann allerdings nur das erste Interface konfiguriert und die anderen 3 bleiben unbeachtet.

Details siehe hier:

help.mikrotik.com/docs/spaces/ROS/pages/220233794/MikroTik+wired ...

das trifft aber nicht wirklich generell für QSFP28 zu, den dieses kann grundsätzlich per "multilane serial interface" nicht nur in 4 x 25G Mode betrieben werden, sondern auch im 10 x 10G Mode und theoretisch ist sogar N x XG möglich.

Ich wollte dir übrigens vorhin noch als Alternative zu dem NIC-Tausch noch den "CRS520-4XS-16XQ-RM" empfehlen ...

mikrotik.com/product/crs520_4xs_16xq_rm#fndtn-testresults

... welcher mit 16 100G Ports von den Kosten her sehr überschaubar ist. Jedoch habe ich beim prüfen seiner Specs zum Glück noch rechtzeitig gesehen, dass die 16 x 100G Ports dieses Switches, neben nativem 100G auch 2x50G oder 1x40G oder 4x25G oder 4x10G oder 4x1G, aber leider KEIN 1x50G und auch kein 10x10G unterstützen. 🙃

Oh oh, ich fürchte, dieser Beitrag ist wahrscheinlich nur der Beginn einer ganz neuen Problemkette. 😬

Gruss Alex