Klonvorgang sehr langsam - Proxmox

Moin liebe Admins!

Mein Proxmox Server greift auf einen Shared-Storage zu mit 4 NVME im RAIDz1.

Proxmxo und Storage Server sind Dell PowerEdge R730 mit jeweils 128GB RAM und 2x 14 Core CPUs.

Per FIO erhalte ich auf dem Storage folgende Werte:

Run status group 0 (all jobs):

WRITE: bw=14.7GiB/s (15.8GB/s), 208MiB/s-270MiB/s (218MB/s-283MB/s), io=443GiB (476GB), run=30001-30193msec

Run status group 0 (all jobs):

READ: bw=33.9GiB/s (36.4GB/s), 313MiB/s-839MiB/s (328MB/s-880MB/s), io=1019GiB (1094GB), run=30001-30069msec

Die Server sind mit 25Gbit verbunden.

Wenn ich nun eine 32GB VM klone, dauert es zwischen 1,30min - 1,58min und das erscheint mir etwas langsam, da ich bei einem Full-HDD-RAIDz1 (mit ZLOG) ähnliche Geschwindigkeiten erhalte...

Was denkt ihr darüber?

Habt ihr ggf. eine Idee wie ich den Klonvorgnag beschleunigen kann?

Nachtrag:

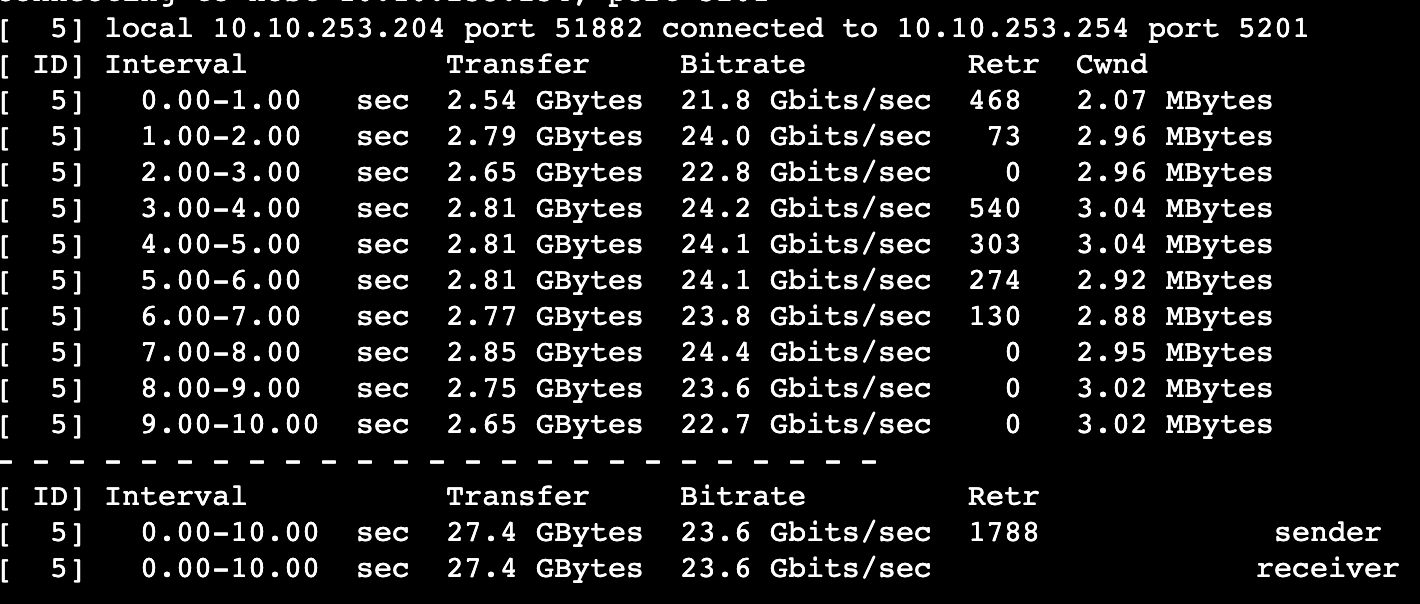

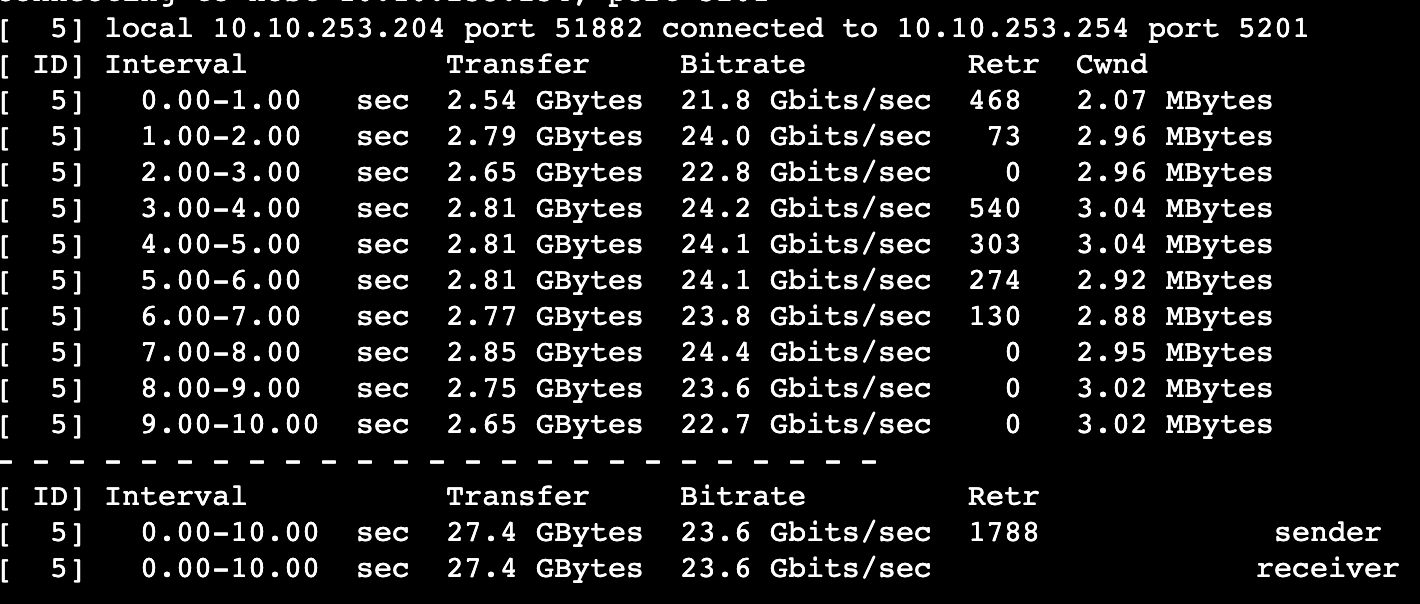

iperf3 als Screenshot

Nachtrag 2:

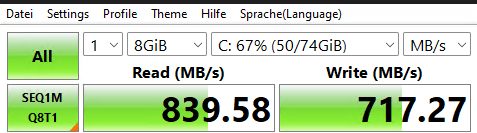

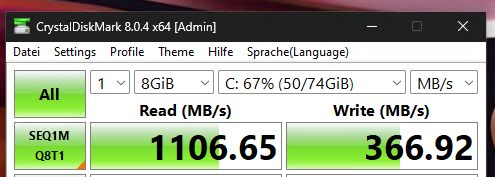

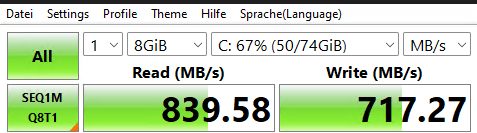

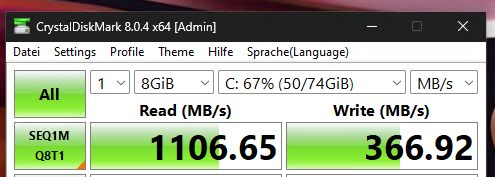

Anbei findet ihr Screenshots von einer Windows VM einmal auf dem HDD-Array (RaidZ1) und einmal auf dem NVME-Array(Auch RaidZ1).

Beide Werte stammen von dem selben Servern, nur andere VM Storages. HDD ist deutlich schneller im Lesen und NVME ist zwar langsamer im Lesen aber dafür sind Read/Write recht ausgeglichen im Vergleich zum HDD Array.

Das kann doch nicht das beste in Sachen NVME Performance sein...

Beste Grüße und schöne Pfingsten

Mein Proxmox Server greift auf einen Shared-Storage zu mit 4 NVME im RAIDz1.

Proxmxo und Storage Server sind Dell PowerEdge R730 mit jeweils 128GB RAM und 2x 14 Core CPUs.

Per FIO erhalte ich auf dem Storage folgende Werte:

Run status group 0 (all jobs):

WRITE: bw=14.7GiB/s (15.8GB/s), 208MiB/s-270MiB/s (218MB/s-283MB/s), io=443GiB (476GB), run=30001-30193msec

Run status group 0 (all jobs):

READ: bw=33.9GiB/s (36.4GB/s), 313MiB/s-839MiB/s (328MB/s-880MB/s), io=1019GiB (1094GB), run=30001-30069msec

Die Server sind mit 25Gbit verbunden.

Wenn ich nun eine 32GB VM klone, dauert es zwischen 1,30min - 1,58min und das erscheint mir etwas langsam, da ich bei einem Full-HDD-RAIDz1 (mit ZLOG) ähnliche Geschwindigkeiten erhalte...

Was denkt ihr darüber?

Habt ihr ggf. eine Idee wie ich den Klonvorgnag beschleunigen kann?

Nachtrag:

iperf3 als Screenshot

Nachtrag 2:

Anbei findet ihr Screenshots von einer Windows VM einmal auf dem HDD-Array (RaidZ1) und einmal auf dem NVME-Array(Auch RaidZ1).

Beide Werte stammen von dem selben Servern, nur andere VM Storages. HDD ist deutlich schneller im Lesen und NVME ist zwar langsamer im Lesen aber dafür sind Read/Write recht ausgeglichen im Vergleich zum HDD Array.

Das kann doch nicht das beste in Sachen NVME Performance sein...

Beste Grüße und schöne Pfingsten

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 41518739573

Url: https://administrator.de/forum/klonvorgang-sehr-langsam-proxmox-41518739573.html

Ausgedruckt am: 07.07.2025 um 15:07 Uhr

16 Kommentare

Neuester Kommentar

Mahlzeit.

Die Server sind mit 25Gbit verbunden.

Wie angebunden? NFS, SMB, iSCSi?

Wenn ich nun eine 32GB VM klone, dauert es zwischen 1,30min - 1,58min und das erscheint mir etwas langsam, da ich bei einem Full-HDD-RAIDz1 (mit ZLOG) ähnliche Geschwindigkeiten erhalte...

Das klingt erst einmal doch nicht so schlecht. Es müssen ja Operationen seitens Proxmox durchgeführt werden. Für das Erstellen der VM und deren virtuellen Festplatte etc. wird ja auch etwas Zeit benötigt.

Habt ihr ggf. eine Idee wie ich den Klonvorgnag beschleunigen kann?

Wie sieht es aus bei einer größeren VM?

Mal ein anderes Protokoll zur Verbindung gewählt?

Das kann doch nicht das beste in Sachen NVME Performance sein...

NVMe ist hier auch mit Sicherheit nicht der Flaschenhals.

Bin leider kein Proxmox Experte und kann somit keine Einstellungen vorschlagen, welche hier beschleunigen könnten.

Gruß

Marc

Moin...

Mein Proxmox Server greift auf einen Shared-Storage zu mit 4 NVME im RAIDz1.

oha...

Was denkt ihr darüber?

Habt ihr ggf. eine Idee wie ich den Klonvorgnag beschleunigen kann?

nun, der Clonvorgang braucht ja auch auch CPU zeit und Verwaltung im Proxmox!

da gibbet welche mit 1 GiB/s bis 7 GiB/s... also was hast du da verbaut, mit welchem Adapter?

wie sind die angebunden?

Frank

Mein Proxmox Server greift auf einen Shared-Storage zu mit 4 NVME im RAIDz1.

Proxmxo und Storage Server sind Dell PowerEdge R730 mit jeweils 128GB RAM und 2x 14 Core CPUs.

Per FIO erhalte ich auf dem Storage folgende Werte:

Run status group 0 (all jobs):

WRITE: bw=14.7GiB/s (15.8GB/s), 208MiB/s-270MiB/s (218MB/s-283MB/s), io=443GiB (476GB), run=30001-30193msec

Run status group 0 (all jobs):

READ: bw=33.9GiB/s (36.4GB/s), 313MiB/s-839MiB/s (328MB/s-880MB/s), io=1019GiB (1094GB), run=30001-30069msec

Die Server sind mit 25Gbit verbunden.

du mein LAN?Per FIO erhalte ich auf dem Storage folgende Werte:

Run status group 0 (all jobs):

WRITE: bw=14.7GiB/s (15.8GB/s), 208MiB/s-270MiB/s (218MB/s-283MB/s), io=443GiB (476GB), run=30001-30193msec

Run status group 0 (all jobs):

READ: bw=33.9GiB/s (36.4GB/s), 313MiB/s-839MiB/s (328MB/s-880MB/s), io=1019GiB (1094GB), run=30001-30069msec

Die Server sind mit 25Gbit verbunden.

Wenn ich nun eine 32GB VM klone, dauert es zwischen 1,30min - 1,58min und das erscheint mir etwas langsam, da ich bei einem Full-HDD-RAIDz1 (mit ZLOG) ähnliche Geschwindigkeiten erhalte...

was eigentlich ok ist!Was denkt ihr darüber?

Habt ihr ggf. eine Idee wie ich den Klonvorgnag beschleunigen kann?

Das kann doch nicht das beste in Sachen NVME Performance sein...

was sind das für NVMEs genau?da gibbet welche mit 1 GiB/s bis 7 GiB/s... also was hast du da verbaut, mit welchem Adapter?

wie sind die angebunden?

Moin...

wie kommst du auf 25G?

Read 3500 MB/s - Write 3000 MB/s

ja... fein, aber was genau für NVMes?`also Hersteller und Typ?

das ASUS teil ist jedenfalls nix für einen Server, und rennt auch nicht überall!

was für einen Server hast du, und was für Nics sind dort verbaut?

Liebe Grüße

Frank

Zitat von @WildDog:

Hallo an alle

wie genau... das scheint mir eher 10 Gbit zu sein, bei deinen werten!Hallo an alle

Die Server sind mit 25Gbit verbunden.

Per NFS aber eigentlich meinte ich an einen 25G Ubiquiti Aggregation Pro Switch...wie kommst du auf 25G?

Das Ziel soll es sein, die Zeit pro Klonvorgang deutlich zu reduzieren. Egal ob ich RAIDz1 oder sogar die NVMes als Stripes setze, die Zeiten verbessern sich nicht. Selbst wenn man eine zusätzliche Proxmox VM auf dem Storage Server (TrueNAS ist Baremetal) installiert und die NIC als Bridge einrichtet, verbessert sich da nichts.

das wären werte für 10 GBit!Wie sieht es aus bei einer größeren VM?

Unverändert, er kommt laut TrueNAS auf max 600 MiB/s...was sind das für NVMEs genau?

da gibbet welche mit 1 GiB/s bis 7 GiB/s... also was hast du da verbaut, mit welchem Adapter?

wie sind die angebunden?

da gibbet welche mit 1 GiB/s bis 7 GiB/s... also was hast du da verbaut, mit welchem Adapter?

wie sind die angebunden?

Read 3500 MB/s - Write 3000 MB/s

Als Adapter habe ich sowohl die ASUS Hyper M.2 (x16 3.0) als auch dual x8 PCIe Adapter ausprobiert, in verschiedenen Servern und zu verschiedensten Config-Varianten...

1m32sec. bestes Ergebnis...

ok M2... ich bin jetzt mal U2 oder U3 ausgegangen.... also scheinst du Consumer Hardware zu nutzen!1m32sec. bestes Ergebnis...

das ASUS teil ist jedenfalls nix für einen Server, und rennt auch nicht überall!

was für einen Server hast du, und was für Nics sind dort verbaut?

Liebe Grüße

Frank

Moin,

ist dort die gleiche Hardware verbaut also Server, Adapter und M2?

wenn du von freigabe zur freigabe (Server zu Server) kopierst, sind die werte dann besser?

wie sind auf dem anderen System die Clon zeiten?

Frank

Das würde allerdings die anderen beiden Adapter mit gleicher Geschwindigkeit nicht erklären

ist dort die gleiche Hardware verbaut also Server, Adapter und M2?

wenn du von freigabe zur freigabe (Server zu Server) kopierst, sind die werte dann besser?

wie sind auf dem anderen System die Clon zeiten?

Frank

Moin,

Gruß,

Dani

Die Frag verstehe ich nicht.. Proxmox greift per NFS auf den Storage (TrueNAS) zu und der Klonvorgang findet durch Proxmox statt...

Es findet sowohl der Lese- als auch Schreibvorgang auf dem Storage statt. Ich würde exemplarisch einmal die zu klonende VM lokal auf einem Storage des Proxmox ablegen und anschließend nochmals den Klonvorgang starten. Hast du dann bessere Werte?Gruß,

Dani

Wie Frank und ich schonmal bemerkten, Proxmox braucht ja auch ein paar Gedenksekunden für den Klonvorgang.

Ich habe daheim XCP-NG auf einem Minisforum HM90 mit AMD 4900HS CPU und zwei Crucial MX500 1 TB SATA SSD im RAID 1 laufen. Da hat gestern ein Klonvorgang einer 50 GB Linux VM 55 Sekunden gebraucht.

Nichtsdestotrotz lesen sich deine angegebenen Zeiten als durchaus passabel.

Wie lange dauert der Vorgang denn bei einer größeren VM (> 200 GB)? Wenn du dann die Gigabyte/Sekunden vergleichst, müssten ja ähnliche Werte herauskommen.

Gruß

Marc

Ich habe daheim XCP-NG auf einem Minisforum HM90 mit AMD 4900HS CPU und zwei Crucial MX500 1 TB SATA SSD im RAID 1 laufen. Da hat gestern ein Klonvorgang einer 50 GB Linux VM 55 Sekunden gebraucht.

Nichtsdestotrotz lesen sich deine angegebenen Zeiten als durchaus passabel.

Wie lange dauert der Vorgang denn bei einer größeren VM (> 200 GB)? Wenn du dann die Gigabyte/Sekunden vergleichst, müssten ja ähnliche Werte herauskommen.

Gruß

Marc

Moin,

Ich würde stupide und simpel anfangen. Lokale SSD im Proxmox. Am Besten in einem M2 Slot, welcher mit der CPU verbunden ist und das Gleiche im Storage. So dass du kein ZFS, kein Sharing, etc. hast. Werden die Werte so besser?

Gruß,

Dani

Korrekt, die zeitgleichen Reads / Writes hab ich auch erst verdächtigt allerdings sollte bei den FIO Werten ja trotzdem mehr als 500-600 MB/s rumkommen... Ich hab auf die schnelle nur eine SSD zur Hand gehabt um es auf dem Proxmox zu testen und da habe ich bei 3 Klonvorgängen 1min49sek, 2min11sek und 1min53sek also auch nicht sehr viel anders als die Werte (1min30sek - 1min58sek) die ich mit dem NVMe Array über die 25 Gbit Leitung hab...

wie sieht es denn mit der Anbindung der SSDs aus. Du oben von Adaptern gesprochen hast. Bedeutet das, dass 2,3,4 SSDs an einem PCI Express Port hängen? Mit ZFS hast du in der Konstellation noch eine weitere Bremse.Ich würde stupide und simpel anfangen. Lokale SSD im Proxmox. Am Besten in einem M2 Slot, welcher mit der CPU verbunden ist und das Gleiche im Storage. So dass du kein ZFS, kein Sharing, etc. hast. Werden die Werte so besser?

Gruß,

Dani

Moin,

Gruß,

Dani

Ich schätze also, wie auch @Vision2015 meinte, dass hier Proxmox selbst der Flaschenhals ist.

hast mal während des Vorgangs auf die Summery Page in der UI des Proxmox geschaut. Hast du evtl. IO Delay auf der CPU?Gruß,

Dani