10 gb Netzwerk deutlich zu langsam

Hallo,

hab hier einen Server umgebaut und ihm ein Supermicro X10dri-t verpasst.

Soweit so gut.

Allerdings ist das 10 gb/sek Netzwerk deutlich zu langsamm.

laut ipref3 komm ich "nur" auf ca 3,3 gb/sek

am anfang hatte ich nur ca 2,8. Nach dem rumspielen mit tcp optimicer und laden von Windows defaults ca 3,3 gb/sek mit tcp optimicer und optimal nur noch 2,5 gb/sek

ipref3 auf das LAN (zweite 10 gb/sek NIC) der VM läuf auch nur mit ca 2,8 gb/sek

Bios Defaults hab ich geladen und zusätzlich "Above 4G Decoding" aktiviert brachte aber keine besserung (nur das die Grafikarte nur noch 8 Farben und 640x480 anzeigt und sich nicht mehr verändern läst)

Das Netzwerk sieht so aus

Server Supermicro X10dri-t

Switch HP Office Connet 1850

Client Threadripper MSI Creator

Es werden 10 gb/sek links zum Switch aufgebaut. Das tcp optimicer "Windows defaults" hab ich am Server und PC laufen lassen.

Wenn ich daten vom Raid5 auf meinen PC copiere fängt das mit 100 MB/sek an und steigert sich dann auf ca 200-220 MB/sek.

Mach ich mit hdtunte einen benchmark test des Raid ist das lesen bei ca 350-400 MB/sek

Hab auch mit dem einstellungen von docs.microsoft.com/de-de/windows-server/networking/technologies/ ...

rumgespielt (Server und PC immer die gleichen einstellungen) aber mit tcp optimicer und "windows defaults" läuft es bis jetzt am besten und ich finde den Fehler nicht

Wenn ich das nach dincloud.com/blog/tuning-windows-get-15x-speeds-on-large-file-co ... mache wird es noch schlechter

hat da jemand noch einen Tip für mich?

hab hier einen Server umgebaut und ihm ein Supermicro X10dri-t verpasst.

Soweit so gut.

Allerdings ist das 10 gb/sek Netzwerk deutlich zu langsamm.

laut ipref3 komm ich "nur" auf ca 3,3 gb/sek

am anfang hatte ich nur ca 2,8. Nach dem rumspielen mit tcp optimicer und laden von Windows defaults ca 3,3 gb/sek mit tcp optimicer und optimal nur noch 2,5 gb/sek

ipref3 auf das LAN (zweite 10 gb/sek NIC) der VM läuf auch nur mit ca 2,8 gb/sek

Bios Defaults hab ich geladen und zusätzlich "Above 4G Decoding" aktiviert brachte aber keine besserung (nur das die Grafikarte nur noch 8 Farben und 640x480 anzeigt und sich nicht mehr verändern läst)

Das Netzwerk sieht so aus

Server Supermicro X10dri-t

Switch HP Office Connet 1850

Client Threadripper MSI Creator

Es werden 10 gb/sek links zum Switch aufgebaut. Das tcp optimicer "Windows defaults" hab ich am Server und PC laufen lassen.

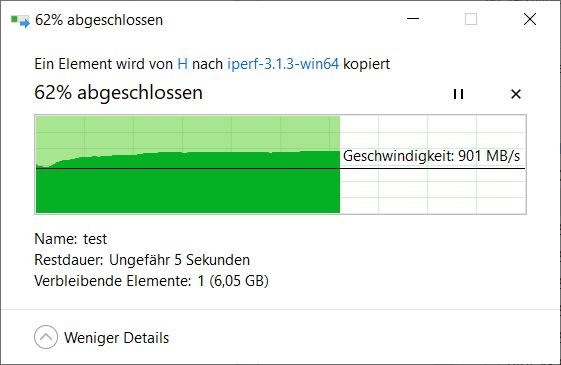

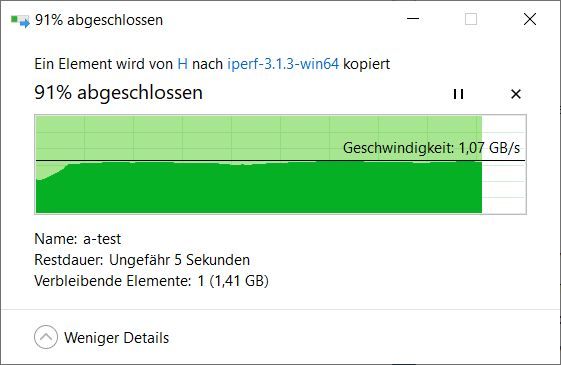

Wenn ich daten vom Raid5 auf meinen PC copiere fängt das mit 100 MB/sek an und steigert sich dann auf ca 200-220 MB/sek.

Mach ich mit hdtunte einen benchmark test des Raid ist das lesen bei ca 350-400 MB/sek

Hab auch mit dem einstellungen von docs.microsoft.com/de-de/windows-server/networking/technologies/ ...

rumgespielt (Server und PC immer die gleichen einstellungen) aber mit tcp optimicer und "windows defaults" läuft es bis jetzt am besten und ich finde den Fehler nicht

Wenn ich das nach dincloud.com/blog/tuning-windows-get-15x-speeds-on-large-file-co ... mache wird es noch schlechter

hat da jemand noch einen Tip für mich?

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 789658102

Url: https://administrator.de/forum/10-gb-netzwerk-deutlich-zu-langsam-789658102.html

Ausgedruckt am: 04.08.2025 um 06:08 Uhr

27 Kommentare

Neuester Kommentar

Moin,

Was für Daten kopierst du? Viele kleine Files, nur große oder bunt gemischt?

Gruß

C.C.

Was für Daten kopierst du? Viele kleine Files, nur große oder bunt gemischt?

Gruß

C.C.

Mach ich mit hdtunte einen

Ist das was Unanständiges oder Diskriminierendes ??Wichtig auch zu wissen WIE die Verbindung auf den Switch gemacht wurde ob mit DAC/Twinax oder LWL via SFP+ oder mit 10G Base T (RJ-45) ?

Letzteres bietet nicht verlässlich sicher 10G, weil es je nach Kabelqualität und Länge Autonegotiation nutzt. 10G ist bei RJ-45 nur auf sehr kurzen Distanzen gegeben. Server sollte man also deshalb niemals mit 10G Base T anbinden sondern immer mit SFP+.

Jumbo Framing ist wie oben schon richtig gesagt zwingend.

Desweiteren solltest du mal einen Back to Back Test machen also die beiden iPerf3 Maschinen ohne Switch direkt mit einem Kabel verbinden und checken was die nackt ohne Switch Infrastruktur schaffen.

Bedenken sollte man auch das der HP Switch eine einfache überbuchte Kiste ist. Die bietet keine native 10G Verbindung auf die Backplane (ASIC) sondern ein 4fach Sharing.

Was sonst noch im Server ist spielt für den iPerf3 oder NetIO Test keinerlei Rolle, denn die generieren die Testlast sinnvollerweise direkt auf der NIC. SMB Tests sind deshalb immer kontraproduktiv weil es zum Ersten ein sehr ineffizientes Protokoll ist mit überwiegend kleinen Paketen die Billigswitches wie dem obigen übertraspazieren und zum Zweiten immer auch andere Komponenten mit involvieren. Ein Test mit iPerf3 oder NetIO ist daher immer erheblich sinnvoller um zu checken was die eigentliche, reine Netzwerk Infrastruktur an Netto Durchsatz mit TCP oder UDP schafft.

Was passiert eingentlich mit Clients bei den JumboFrames nicht aktiviert ist

Hat keinerlei Einfluß.de.wikipedia.org/wiki/Path_MTU_Discovery

Lesen und verstehen !

der switch hat nur rj45

Schlechte, da ungeeignete HW Wahl dann für 10 Gig Server ! Ändern sich die Werte wenn du iPerf3 mal nur mit den Defaults betreibst iperf3.exe -c 192.168.0.103 ?

Die Werte sind ja unter alle Kanone und so mies das da ja noch ein 1 Gig Switch mit LAGs besser ist !

Der letzte Test zeigt ja aber auch das es der Switch selber scheinbar nicht ist.

Boote zur Sicherheit nochmal ein Live Linux wie Ubuntu oder Knoppix vom USB Stick und teste das nochmal. Nicht das dir die Kartentreiber da einen Streich spielen.

Man kann hier nur hoffen das du dir Treiber der NIC Chipsatzhersteller verwendet hast und nicht die embeddeten ?!

Sieht in der Tat nach einen 10G Base T Negotiation Problem aus. Die typische Problematik bei 10G über RJ-45.

Hast du alternativ mal ein Cat 6 Crossover_Kabel verwendet um ggf. MDI-X Problemen aus dem Weg zu gehen ?

Moin,

Damit ist ja eigentlich schon alles gesagt, Bottleneck im Storage.

Besorg dir SAS SSDs, SATA ist physikalisch auch auf 6GBit/s limitiert, da wirst du mit deinen SSDs auch nicht wirklich mehr rausholen (sieht man ja an den Tests).

Ansonsten noch am Controller alle Settings prüfen ask.adaptec.com/app/answers/detail/a_id/17474/~/smart-adapter--- ...

VG

Mach ich mit hdtunte einen benchmark test des Raid ist das lesen bei ca 350-400 MB/sek

Damit ist ja eigentlich schon alles gesagt, Bottleneck im Storage.

Besorg dir SAS SSDs, SATA ist physikalisch auch auf 6GBit/s limitiert, da wirst du mit deinen SSDs auch nicht wirklich mehr rausholen (sieht man ja an den Tests).

Ansonsten noch am Controller alle Settings prüfen ask.adaptec.com/app/answers/detail/a_id/17474/~/smart-adapter--- ...

Sieht in der Tat nach einen 10G Base T Negotiation Problem aus

Wieso? Er schafft >110MBit/s, dann ist der Link mit 10GBit/s ausgehandelt und fertig.VG

Er schafft ja auch Back to Back ganz ohne Switch nur armselige 3 GBits/s. Den Switch kann man damit wohl erstmal nicht verantwortlich machen auch wenn er nicht optimal ist.

Kabelage oder Treiber Problem. Ein Linux Test mit iperf3 wäre mal sinnvoll... 3 Gbit/s ist mehr als schwach. Das können ja sogar Realtek Chipsets besser.

Kabelage oder Treiber Problem. Ein Linux Test mit iperf3 wäre mal sinnvoll... 3 Gbit/s ist mehr als schwach. Das können ja sogar Realtek Chipsets besser.

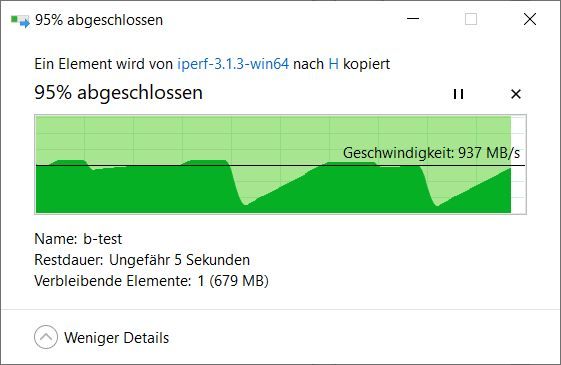

von Knoppix PC zu Knoppix Server 9,90 gb/sek

Das spricht ja eine mehr als deutliche Sprache !!!Es liegt also NICHT per se an der Hardware, Verkabelung oder Infrastruktur sondern rein nur an Winblows, seinen Treibern und den "Verschlimmbesserungen".

9,9 Gig wäre auch der zu erwartende Wert bei Intel und Mellanox.

wieso das ganze Zeug aktiviert ist wenn es das ganze nur langsamer macht

Ist halt Winblows und das weiss wohl nur MS selber.

ich habe ebenfalls das selbe Problem.

Ich habe aber parallel dazu noch einen Failover cluster am laufen, und wenn ich da eine Live Migration mache - nutzt der konstant 9.9Gbs. das ist eine zwei port x550 karte, hab zum testen nur den einen port genutz. wenn ich jetzt aber eine Datei vom einem zum anderen Knoten kopiere, komme ich ebenfalls auf nur magere 3.3Gbs. Server 2019, aktueller Patchlevel. Identische Treibereinstellungen der beiden Ports.

ich habe in errinnerung, dass ich vor einigen jahren problemlos mit über 1GB/s daten kopiert habe...irgendwas hat entweder MS da ganz schön verbockt, oder aber intel mit den Treibern...

Ich habe aber parallel dazu noch einen Failover cluster am laufen, und wenn ich da eine Live Migration mache - nutzt der konstant 9.9Gbs. das ist eine zwei port x550 karte, hab zum testen nur den einen port genutz. wenn ich jetzt aber eine Datei vom einem zum anderen Knoten kopiere, komme ich ebenfalls auf nur magere 3.3Gbs. Server 2019, aktueller Patchlevel. Identische Treibereinstellungen der beiden Ports.

ich habe in errinnerung, dass ich vor einigen jahren problemlos mit über 1GB/s daten kopiert habe...irgendwas hat entweder MS da ganz schön verbockt, oder aber intel mit den Treibern...

interessannt wäre es jetzt zu wissen, ob das wiedermal nur intel netzwerkkarten betrifft, oder auch Mellanox oder andere...also um das mal einzugrenzen obs am Treiber liegt vom Hersteller, oder am Windows.

Weil Linux/Knoppix ist ja ein anderes OS und damit auch andere Treiber...aber gut zu wissen dass es durch den test sich auf die Software beschränkt

Weil Linux/Knoppix ist ja ein anderes OS und damit auch andere Treiber...aber gut zu wissen dass es durch den test sich auf die Software beschränkt

Hallo und danke für die Anregungen hier, lange nicht mehr nachgesehen im Netz und gleich schon was gefunden.

Und eine Bitte: könnt ihr das mit mehr Instanzen auch nochmal testen bsw: iperf3.exe -c 10.10.12.2 -w 1M -P 8

viele Grüsse

ulti

PS:

[SUM] 0.00-10.01 sec 10.6 GBytes 9.07 Gbits/sec sender

[SUM] 0.00-10.01 sec 10.6 GBytes 9.07 Gbits/sec receiver

sieht erstmal gut aus ist aber eine Connect x3 Karte mit Direkt Verbindung unter 40G und Server 2016,

Ist also auch zu langsam.

Und eine Bitte: könnt ihr das mit mehr Instanzen auch nochmal testen bsw: iperf3.exe -c 10.10.12.2 -w 1M -P 8

viele Grüsse

ulti

PS:

[SUM] 0.00-10.01 sec 10.6 GBytes 9.07 Gbits/sec sender

[SUM] 0.00-10.01 sec 10.6 GBytes 9.07 Gbits/sec receiver

sieht erstmal gut aus ist aber eine Connect x3 Karte mit Direkt Verbindung unter 40G und Server 2016,

Ist also auch zu langsam.