Beste Dateisysteme aus eure Sicht

Moin meine lieben,

vor ein paar Tagen ist mir etwas aufgefallen. Meine Ext4 Partitionen welche ich bis heute über alles liebe machen mir etwas weniger Speicher als NTFS Partitionen auf den gleichen Platten.

Ja Ext4 reserviert Für System immer etwas Platz. Doch das kann man mit "tune2fs -m 0 /dev/sdx" aufheben. Und doch sind die ext4 Partitionen kleiner als eine NTFS Partition. Welche sogar nach gleichem Prinzip angelegt wurde.

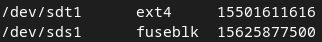

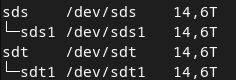

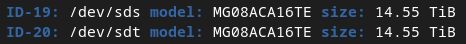

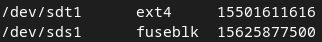

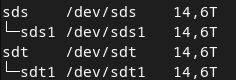

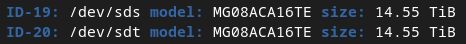

Manch einer würde sagen "ach komm auf die ein paar Bytes kommt es nicht drauf an." Grundsätzlich würde ich das auch so sagen, aber bei 16 TB 100 GB weniger macht schon aua... und hier mein Vergleich.

Ich würde jetzt gleich mir noch mal btrfs angucken. Wobei so wie ich btrfs bis jetzt verstanden habe, verbraucht es viel Speicher für Wiederherstellung.

Was benutzt Ihr für Partitionen für wichtige und unwichtige Daten SSD oder HDD am liebsten? Und vor allem warum?

Viele Grüße

Ich

vor ein paar Tagen ist mir etwas aufgefallen. Meine Ext4 Partitionen welche ich bis heute über alles liebe machen mir etwas weniger Speicher als NTFS Partitionen auf den gleichen Platten.

Ja Ext4 reserviert Für System immer etwas Platz. Doch das kann man mit "tune2fs -m 0 /dev/sdx" aufheben. Und doch sind die ext4 Partitionen kleiner als eine NTFS Partition. Welche sogar nach gleichem Prinzip angelegt wurde.

Manch einer würde sagen "ach komm auf die ein paar Bytes kommt es nicht drauf an." Grundsätzlich würde ich das auch so sagen, aber bei 16 TB 100 GB weniger macht schon aua... und hier mein Vergleich.

Ich würde jetzt gleich mir noch mal btrfs angucken. Wobei so wie ich btrfs bis jetzt verstanden habe, verbraucht es viel Speicher für Wiederherstellung.

Was benutzt Ihr für Partitionen für wichtige und unwichtige Daten SSD oder HDD am liebsten? Und vor allem warum?

Viele Grüße

Ich

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 1326468895

Url: https://administrator.de/forum/beste-dateisysteme-aus-eure-sicht-1326468895.html

Ausgedruckt am: 02.08.2025 um 08:08 Uhr

11 Kommentare

Neuester Kommentar

Du suchst also nicht das "beste" Dateisystem, sondern das "platzsparendste" Dateisystem.

bei 16 TB 100 GB weniger macht schon aua...

Überhaupt nicht, weil 100GB im Vergleich zu 16TB überhaupt nicht auffallen, das ist nicht einmal 1%. Solltest du wirklich 15.9TB voll bekommen, hast du ganz andere Probleme. Hier solltest überlegen ein Dateisystem zu wählen, das dir mehr Datensicherheit, Snapshotmöglichkeiten oder Migrationsmöglichkeiten bietet z.B. ZFS.,

Das "beste" Dateisystem ist immer vom OS abhängig. Also logische Schlussfolgerung, zFS

Moin,

Die Frage es müßig. "Das beste" an sich gibt es ncht, sondern man muß immer dazusagen, nach welcher Metrik man das mißt.

Du hast nur ein einziges Kriterium genannt, nömlich das Verhältnis "Nutzbarer" Platz gegebüber "Rohkapazität", allerdigns nur das was als "frei" angezeigt wird. das berücksichtigt aber nicht, wie gut das Dateisystem mit kleinen oder großen Dateien umgehen kann und welche Blockgrößen es verwendet und ungenutzte "Blockteile" ggf. für mehrere Dateien verwendet werden usw.

Aber Abseits all dieser Überlegungen:

Man sollte ein Dateisystem nie zu 100% füllen, sondern eher 10% davon freilassen. Bei SSDs, weil die dann zu langsam werden, bei HDDs, weil dann die Fragmentierung zuschlägt und die auch langsam werden.

Wenn Du nun bei 18TB "nur" 100GB verlierst, ist das völlig belanglos, weil die Probleme, die Du bekommst, wenn Du das Filessystem "vollmachst" größer sind als der verlorene Platz.

lks

PS: Wie große sind denn die Dateien mit denen Du die Platte füllen willst? Viele kleine oder einige Große? Man kann z.B. ext4 daraufhin optimieren, ob es große oder kleine Dateien beherbergen soll.

PPS: Wenn Du die Daten möglichst "dicht auf die Platte packen willst, nimm cpio pder tar auf das raw device. Dann veschwendest Du keinen Platz.

P3s: rwmj.wordpress.com/2009/11/08/filesystem-metadata-overhead/

Die Frage es müßig. "Das beste" an sich gibt es ncht, sondern man muß immer dazusagen, nach welcher Metrik man das mißt.

Du hast nur ein einziges Kriterium genannt, nömlich das Verhältnis "Nutzbarer" Platz gegebüber "Rohkapazität", allerdigns nur das was als "frei" angezeigt wird. das berücksichtigt aber nicht, wie gut das Dateisystem mit kleinen oder großen Dateien umgehen kann und welche Blockgrößen es verwendet und ungenutzte "Blockteile" ggf. für mehrere Dateien verwendet werden usw.

Aber Abseits all dieser Überlegungen:

Man sollte ein Dateisystem nie zu 100% füllen, sondern eher 10% davon freilassen. Bei SSDs, weil die dann zu langsam werden, bei HDDs, weil dann die Fragmentierung zuschlägt und die auch langsam werden.

Wenn Du nun bei 18TB "nur" 100GB verlierst, ist das völlig belanglos, weil die Probleme, die Du bekommst, wenn Du das Filessystem "vollmachst" größer sind als der verlorene Platz.

lks

PS: Wie große sind denn die Dateien mit denen Du die Platte füllen willst? Viele kleine oder einige Große? Man kann z.B. ext4 daraufhin optimieren, ob es große oder kleine Dateien beherbergen soll.

PPS: Wenn Du die Daten möglichst "dicht auf die Platte packen willst, nimm cpio pder tar auf das raw device. Dann veschwendest Du keinen Platz.

P3s: rwmj.wordpress.com/2009/11/08/filesystem-metadata-overhead/

Daß man Dateisysteme nicht über grob 80% oder so füllen soll, ist eine uralte Daumenregel.

Daß man SSDs im Sinne der Lebensdauer erst recht nicht ausreizen soll, sollte sich auch rumgesprochen haben.

Einst, als HDDs wirklich teuer waren, konnte der Unterschied zw. FAT und HPFS bie schmalem Beutel schon wehtun (speziell wenn man mit Dualboot eh schon verdoppelte Anforderungen hatte) und obendrein hatten damalige PCs erst mal nur 2 PATA-Kanäle.

Eine Debatte bzgl. dem Verschnitt der EXT2/3/4-Versionen (Größe der Verwaltungsstrukturen, Blockgröße, reservierte inodes, interne und externe Fragmentierung usw.) ist bei embedded Systemen mit echt knappen Ressourcen ein Optimierungskriterium, aber bei einer 16TB-Bestückung?

Das beste FS? Wenn man es einmal erlebt hat: ZFS. Ob es für einen kleineren Server oder gar Desktop Sinn macht - will ich damit nicht behaupten, aber erste Distributionen haben verstanden, daß man es nicht ideologisch (Lizenz) ignorieren darf.

EXT4 ist ein guter Kompromiß für viele Zwecke und wenn der Verschnitt wirklich stört, kann man beim Formatieren doch einiges anpassen, bis hin zur Blockverwaltung per Extents statt Tabellen.

Leider wurde Reiser4 nie spruchreif (obwohl in vielen Aspekten weit voraus) und Reiser3 ist auch EOL.

In Nischen können Exoten wie XFS, JFS und Reiser3 immer noch Sinn machen, weil sie bei der Verwaltung extrem vieler kleiner Dateien nicht in die Knie gehen (Mailserver) - den Faktor kann man auch mit SSDs nur bedingt erschlagen, weil CPU-lastig.

Da kommt man um anwendungsspezifische Erfahrungswerte und Benchmarks nicht herum.

ad FAT12 - Scherz, oder?!? Was unfähigeres hat es nie gegeben (wahrscheinlich nicht einmal der originale Vorläufer von CPM). Selbst Mikrocontroller packen schon zweckmässigere Dateiverwaltung als die FAT als Symbol der Betriebssystemsteinzeit, designed für 5 1/4 Floppies.

Daß man SSDs im Sinne der Lebensdauer erst recht nicht ausreizen soll, sollte sich auch rumgesprochen haben.

Einst, als HDDs wirklich teuer waren, konnte der Unterschied zw. FAT und HPFS bie schmalem Beutel schon wehtun (speziell wenn man mit Dualboot eh schon verdoppelte Anforderungen hatte) und obendrein hatten damalige PCs erst mal nur 2 PATA-Kanäle.

Eine Debatte bzgl. dem Verschnitt der EXT2/3/4-Versionen (Größe der Verwaltungsstrukturen, Blockgröße, reservierte inodes, interne und externe Fragmentierung usw.) ist bei embedded Systemen mit echt knappen Ressourcen ein Optimierungskriterium, aber bei einer 16TB-Bestückung?

Das beste FS? Wenn man es einmal erlebt hat: ZFS. Ob es für einen kleineren Server oder gar Desktop Sinn macht - will ich damit nicht behaupten, aber erste Distributionen haben verstanden, daß man es nicht ideologisch (Lizenz) ignorieren darf.

EXT4 ist ein guter Kompromiß für viele Zwecke und wenn der Verschnitt wirklich stört, kann man beim Formatieren doch einiges anpassen, bis hin zur Blockverwaltung per Extents statt Tabellen.

Leider wurde Reiser4 nie spruchreif (obwohl in vielen Aspekten weit voraus) und Reiser3 ist auch EOL.

In Nischen können Exoten wie XFS, JFS und Reiser3 immer noch Sinn machen, weil sie bei der Verwaltung extrem vieler kleiner Dateien nicht in die Knie gehen (Mailserver) - den Faktor kann man auch mit SSDs nur bedingt erschlagen, weil CPU-lastig.

Da kommt man um anwendungsspezifische Erfahrungswerte und Benchmarks nicht herum.

ad FAT12 - Scherz, oder?!? Was unfähigeres hat es nie gegeben (wahrscheinlich nicht einmal der originale Vorläufer von CPM). Selbst Mikrocontroller packen schon zweckmässigere Dateiverwaltung als die FAT als Symbol der Betriebssystemsteinzeit, designed für 5 1/4 Floppies.

Warum keine 100%? Das ist eigentlich Anwender-Grundwissen:

Tatsächlich ist Linux tatsächlich noch relativ geschickt darin, eine sogar übervolle Partition vorübergehend noch im RAM aktiv zu halten, aber je nach Zweck/Inhalt wird jedes System irgendwann giftig reagieren: Es werden ja nicht nur die sichtbaren Dateien geschrieben, sondern auch temporäre Blöcke allokiert und gelöscht, und wenn sämtliche Strukturen oder aber Blöcke voll sind, werden sich die zugehörigen Algorithmen und Systemfunktionen irgendwann verschlucken, und das möglicherweise auch für andere Partitionen, kurz: das OS wird instabil, abgesehen davon, daß die Allokationsalgorithmen schon >90% herumstückeln müssen, um die letzten kleinen freien Blöcke zu nutzen, und etwaige Auto-Defragmentierung hat auch immer weniger Spielraum.

Kurz: Die einzigen FS die man 100% voll machen sollte, sind ISO/UFS und solche für Flash-ROMs, weil die dann sowieso RO oder "mostly RO" gemountet werden.

Daß ZFS per Fuse langsamer ist bzw. ZFS generell seine Leistung aus viel RAM zieht, ist nicht neu, aber als FS ist es mit seinem Funktionsumfang der Konkurrenz in vielen Punkten weit voraus und mit Abstand das bestgetestete. Die Vorteile kann man kaum aufzählen.

Ubuntu erlaubt mit ein paar Tricks, die die Lizenz-Ideologie umgeht, auch das direkte Nachinstallieren des ZFS als dkms.

Generell würd ich den Vergleichstest von 2013 nur als groben Ausgangspunkt nehmen. Da hat sich an vielen Fronten was getan:

BtrFs ... ist der kleine Bruder (immerhin auch seit einiger Zeit "aus gleichem Haus"), der versucht, alles nachzumachen, aber etwas schlanker, nur die Berichte sind punkto Zuverlässigkeit durchwachsen. Wenn schon, dann nur jene Features nutzen, die sich laut Praxisberichten als rock-solid erwiesen haben.

JFS ist ein Abkömmling von OS/2 / HPFS, hat also einen ehrwürdigen Stammbaum bei IBM (so wie XFS von SGI/Irix stammt). Wenn man sich seinen persönlichen Praxis-Testbenchmark zusammenstellt, wird man schnell sehen, ob es dafür konkurrenzfähig ist.

Jeder in der Liste hat eigene Stärken und Schwächen und in manchen Spezialanwendungen ist der Favorit schon einmal überraschend.

Fragmentierung ist grundsätzlich eine Frage des Allokationsalgorithmus und den hätte man sogar bei FAT/NTFS deutlich besser lösen können. FS mit Baumverwaltung tun sich tendenziell leichter, wenn es drum geht, best-fit oder so zu implementieren. Bei hohem Füllgrad fragmentiert aber JEDER Kandidat.

Tatsächlich ist Linux tatsächlich noch relativ geschickt darin, eine sogar übervolle Partition vorübergehend noch im RAM aktiv zu halten, aber je nach Zweck/Inhalt wird jedes System irgendwann giftig reagieren: Es werden ja nicht nur die sichtbaren Dateien geschrieben, sondern auch temporäre Blöcke allokiert und gelöscht, und wenn sämtliche Strukturen oder aber Blöcke voll sind, werden sich die zugehörigen Algorithmen und Systemfunktionen irgendwann verschlucken, und das möglicherweise auch für andere Partitionen, kurz: das OS wird instabil, abgesehen davon, daß die Allokationsalgorithmen schon >90% herumstückeln müssen, um die letzten kleinen freien Blöcke zu nutzen, und etwaige Auto-Defragmentierung hat auch immer weniger Spielraum.

Kurz: Die einzigen FS die man 100% voll machen sollte, sind ISO/UFS und solche für Flash-ROMs, weil die dann sowieso RO oder "mostly RO" gemountet werden.

Daß ZFS per Fuse langsamer ist bzw. ZFS generell seine Leistung aus viel RAM zieht, ist nicht neu, aber als FS ist es mit seinem Funktionsumfang der Konkurrenz in vielen Punkten weit voraus und mit Abstand das bestgetestete. Die Vorteile kann man kaum aufzählen.

Ubuntu erlaubt mit ein paar Tricks, die die Lizenz-Ideologie umgeht, auch das direkte Nachinstallieren des ZFS als dkms.

Generell würd ich den Vergleichstest von 2013 nur als groben Ausgangspunkt nehmen. Da hat sich an vielen Fronten was getan:

BtrFs ... ist der kleine Bruder (immerhin auch seit einiger Zeit "aus gleichem Haus"), der versucht, alles nachzumachen, aber etwas schlanker, nur die Berichte sind punkto Zuverlässigkeit durchwachsen. Wenn schon, dann nur jene Features nutzen, die sich laut Praxisberichten als rock-solid erwiesen haben.

JFS ist ein Abkömmling von OS/2 / HPFS, hat also einen ehrwürdigen Stammbaum bei IBM (so wie XFS von SGI/Irix stammt). Wenn man sich seinen persönlichen Praxis-Testbenchmark zusammenstellt, wird man schnell sehen, ob es dafür konkurrenzfähig ist.

Jeder in der Liste hat eigene Stärken und Schwächen und in manchen Spezialanwendungen ist der Favorit schon einmal überraschend.

Fragmentierung ist grundsätzlich eine Frage des Allokationsalgorithmus und den hätte man sogar bei FAT/NTFS deutlich besser lösen können. FS mit Baumverwaltung tun sich tendenziell leichter, wenn es drum geht, best-fit oder so zu implementieren. Bei hohem Füllgrad fragmentiert aber JEDER Kandidat.

Zitat von @OIOOIOOIOIIOOOIIOIIOIOOO:

Ext4 ist so toll, dass eine Fragmentierung nahe zu unmöglich ist.

Ext4 ist so toll, dass eine Fragmentierung nahe zu unmöglich ist.

wenn Du es voll genug machst, passiert das da auch.

Allerdigns hat ext4 Mechanismen, die es on the fly defragmentieren sollen. Das merkt man dann allerdings auch an der Performance.

Ich habe hier mehrere "Datengräber" (8TB aufwärts bis zu 20TB) auf die ich temporäre Backups von draufknalle. Sobald man über 95% kommt merkt man die deutlich nachlassende Performance. bei 99% wird es noch schlimmer. Ich nutze trotzdem ext4, weil es stabil und auch "leicht zu reparieren" ist.

lks