Setup eines Hyper-V Clusters mit SAN

Hallo miteinander,

nachdem ich längere Zeit immer wieder Basteleien an meinem Homelab durchgeführt habe und jetzt mal eine richtige Infrastruktur möchte, ist meine Frage wie ich das ganze korrekt angehe. (Aktuell für jedes Netz am Server eine einzelne NIC und keine VLANs :/)

Ich habe bisher noch nie ein Hyper-V-Cluster aufgebaut, deshalb die Frage hier.

Ich habe meine Ausbildungs als FiSi letztes Jahr beendet, da haben wir immer Hyper-V verwendet, deshalb möchte ich das gerne weiter nutzen. Da hatten wir aber nie Failover-Cluster sondern immer einzelne Hyper-V Hosts und auch kein Nic Teaming o.ä.

Hier vorweg mein Setup:

Bestehende Domäne und viele VMs auf zwei Standalone Server verteilt

opnSense

-> 4x 10GBit Uplink an Core Switch (Dell X4012)

Nun zur sonstigen Server-Hardware:

2 x HP DL360 Gen9 Virtualisierungshosts

1 x HP DL360 Gen9 als SAN (ich möchte kein S2D nutzen)

(mit 2x externem HP D2700 Festplatten Enclosure für 2,5" SAS, in Zukunft evtl. noch ein D2600 für 3,5" als Datengrab wenn dann mehr Bedarf entstehen sollte)

-> Auf dem SAN-Server würde ich dann Windows Server installieren (separates RAID), mehrere RAIDs für verschiedene VMs machen. 1 x reines SSD RAID (VM-Betriebssysteme, RAID10), 1 x SAS 2,5" RAID (wahrscheinlich auch RAID10) für VMs die mehr Speicher, aber trotzdem hohe Geschwindigkeiten brauchen, in Zukunft eben evtl. ein weiteres Enclosure

Hier noch eine Frage, ob das so korrekt ist, zum externen SAS

Ich würde mir einen HP P841 Raid Controller besorgen und gern an die beiden Enclosures anschließen. Jetzt steht in den HP Quickpsecs, dass der Controlle in Kombi mit dem Enclosure unterstützt ist, soweit so gut.

Ich würde gern Multi Domain nutzen und den RAID Controller mit dem Enclosure verbinden. Beim P841 steht 16 Channels, super, er hat gesamt 4 mini SAS HD Anschlüsse.

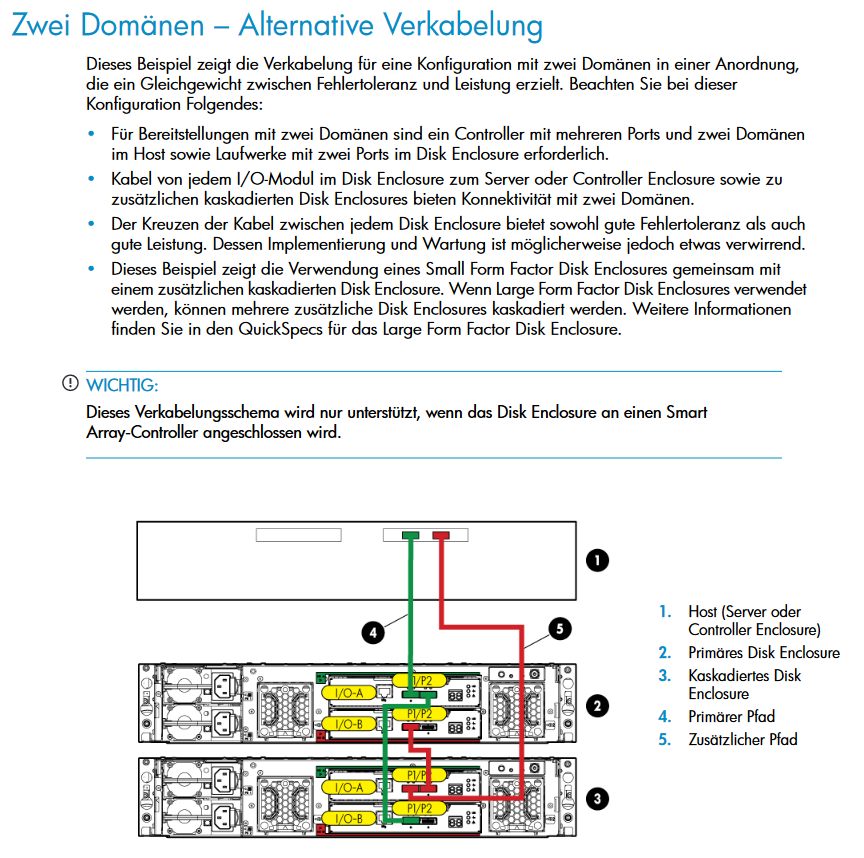

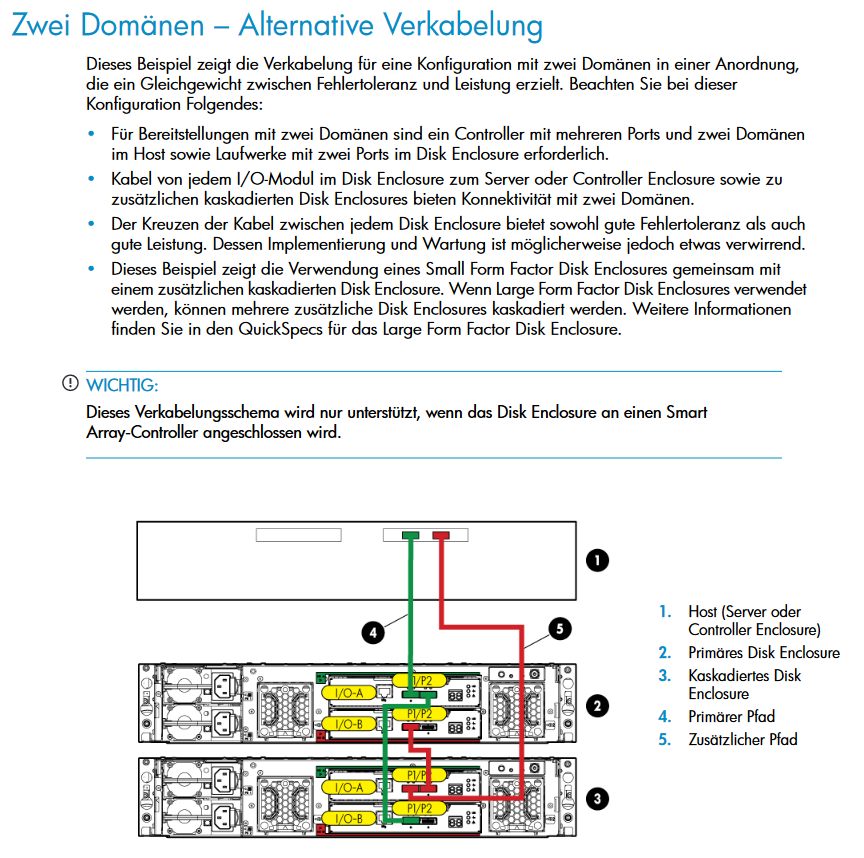

Also meine Idee ist es so zu machen wie hier zu sehen:

(Quelle: uli-ludwig.de/mediafiles/Sonstiges/HP-StorageWorks-D2600-2700-Ha ..)

(Quelle: uli-ludwig.de/mediafiles/Sonstiges/HP-StorageWorks-D2600-2700-Ha ..)

Oder ich beiße in den sauren Apfel und kaufe mir die neueren Enclosures mit 12G SAS (200€ statt 80€)

Ich habe nämlich die Befürchtung, dass so die Anbindung nicht sonderlich schnell sein wird, da mir ja im Endeffekt gesamt nur 12G übrigbleiben (2x6GB SAS vom SAN-Server zu den Enclosures) was rechnerisch 1.500MB/s sind und somit nicht so prickelnd wäre.

1 x DL380 Gen9 Backupserver

Windows Server mit Veeam Backup & Replication

-> Wie müsste ich den denn dann korrekt anbinden, ich sichere bisher meine einzelnen Hyper-V Hosts mit Veeam im LAN, aber wie läuft das beim Cluster? Extra Anbindung je Host? Separates VLAN welches Zugriff ins Management-Netz der Hyper-Vs bekommt?

So, nun mein bisheriger Plan für das Setup.

SAN-Server mit Windows installieren, RAIDs konfigurieren

2 x Virtualisierungsserver mit Windows Server installieren, Hyper-V installieren

Nun die wichtigen Fragen:

Wie richte ich das Cluster ein?

Für System Center und den Virtual Machine Manager braucht man ja Lizenzen, oder kann man das umgehen? (hust hust)

Ich würde das SAN an die Virtualisierungshosts mit je 1x40G QSFP anbinden.

Wie mach ich das korrekt? Ich schätze mal iSCSI, kann ich da von jedem Host dann eine Verbindung herstellen? Habe mal gelesen, empfohlen wird nur von einem Client auf ein iSCSI Target zuzugreifen.

Oder dann via Scale Out File Server, habe ich aber bisher auch noch keine Erfahrung mit und nur mal im Zusammenhang mit Hyper-V Clustern gehört.

Wie viele Netzwerkverbindungen sollte ich denn haben (und welche Geschwindigkeit)? Also zwischen den Hyper-V-Servern?

Dafür hätte ich eh schon integriert 4x1G RJ45 und würde sonst je Server eine weitere Karte mit je 2x40GB Ports (1 x für SAN Anbindung, einmal zwischen Hyper-V Servern) einbauen. Oder wären hier mehr NICs mit je 10G sinnvoll?

SAN dann halt für Management + Internet ne extra NIC.

Dafür würde ich auf der opnSense einen Trunk konfigurieren und dann an den Core-Switch anbinden als VLAN-Trunk (wahrsch. LAG) -> extra NIC mit untagged VLAN für Management + Internetzugang?

Außerdem die Frage, wie die VMs / Hyper-V Hosts dann ins Netzwerk kommen.

Für die VMs dann wahrscheinlich ein NIC Team bestehend aus 2x10G Anbindungen zum Switch. -> Kann darüber der Hyper-V-Host theoretisch auch ins Netzwerk statt ner extra NIC (für Management + Internet)?

Optimalerweise hat jemand einen vollen Setup Guide / mehrere einzelne parat, ich hab leider nichts wirklich allumfassenders gefunden bzgl. Setup und Best Practices.

Fragen über Fragen und ich hoffe auf euer Wissen und Erfahrung 😁

Und ich weiß, da ist viel Unwissen dabei, habe so etwas halt (leider) noch nie aufsetzen dürfen / können.

Grüße und Danke im voraus

Max

nachdem ich längere Zeit immer wieder Basteleien an meinem Homelab durchgeführt habe und jetzt mal eine richtige Infrastruktur möchte, ist meine Frage wie ich das ganze korrekt angehe. (Aktuell für jedes Netz am Server eine einzelne NIC und keine VLANs :/)

Ich habe bisher noch nie ein Hyper-V-Cluster aufgebaut, deshalb die Frage hier.

Ich habe meine Ausbildungs als FiSi letztes Jahr beendet, da haben wir immer Hyper-V verwendet, deshalb möchte ich das gerne weiter nutzen. Da hatten wir aber nie Failover-Cluster sondern immer einzelne Hyper-V Hosts und auch kein Nic Teaming o.ä.

Hier vorweg mein Setup:

Bestehende Domäne und viele VMs auf zwei Standalone Server verteilt

opnSense

-> 4x 10GBit Uplink an Core Switch (Dell X4012)

Nun zur sonstigen Server-Hardware:

2 x HP DL360 Gen9 Virtualisierungshosts

1 x HP DL360 Gen9 als SAN (ich möchte kein S2D nutzen)

(mit 2x externem HP D2700 Festplatten Enclosure für 2,5" SAS, in Zukunft evtl. noch ein D2600 für 3,5" als Datengrab wenn dann mehr Bedarf entstehen sollte)

-> Auf dem SAN-Server würde ich dann Windows Server installieren (separates RAID), mehrere RAIDs für verschiedene VMs machen. 1 x reines SSD RAID (VM-Betriebssysteme, RAID10), 1 x SAS 2,5" RAID (wahrscheinlich auch RAID10) für VMs die mehr Speicher, aber trotzdem hohe Geschwindigkeiten brauchen, in Zukunft eben evtl. ein weiteres Enclosure

Hier noch eine Frage, ob das so korrekt ist, zum externen SAS

Ich würde mir einen HP P841 Raid Controller besorgen und gern an die beiden Enclosures anschließen. Jetzt steht in den HP Quickpsecs, dass der Controlle in Kombi mit dem Enclosure unterstützt ist, soweit so gut.

Ich würde gern Multi Domain nutzen und den RAID Controller mit dem Enclosure verbinden. Beim P841 steht 16 Channels, super, er hat gesamt 4 mini SAS HD Anschlüsse.

Also meine Idee ist es so zu machen wie hier zu sehen:

Oder ich beiße in den sauren Apfel und kaufe mir die neueren Enclosures mit 12G SAS (200€ statt 80€)

Ich habe nämlich die Befürchtung, dass so die Anbindung nicht sonderlich schnell sein wird, da mir ja im Endeffekt gesamt nur 12G übrigbleiben (2x6GB SAS vom SAN-Server zu den Enclosures) was rechnerisch 1.500MB/s sind und somit nicht so prickelnd wäre.

1 x DL380 Gen9 Backupserver

Windows Server mit Veeam Backup & Replication

-> Wie müsste ich den denn dann korrekt anbinden, ich sichere bisher meine einzelnen Hyper-V Hosts mit Veeam im LAN, aber wie läuft das beim Cluster? Extra Anbindung je Host? Separates VLAN welches Zugriff ins Management-Netz der Hyper-Vs bekommt?

So, nun mein bisheriger Plan für das Setup.

SAN-Server mit Windows installieren, RAIDs konfigurieren

2 x Virtualisierungsserver mit Windows Server installieren, Hyper-V installieren

Nun die wichtigen Fragen:

Wie richte ich das Cluster ein?

Für System Center und den Virtual Machine Manager braucht man ja Lizenzen, oder kann man das umgehen? (hust hust)

Ich würde das SAN an die Virtualisierungshosts mit je 1x40G QSFP anbinden.

Wie mach ich das korrekt? Ich schätze mal iSCSI, kann ich da von jedem Host dann eine Verbindung herstellen? Habe mal gelesen, empfohlen wird nur von einem Client auf ein iSCSI Target zuzugreifen.

Oder dann via Scale Out File Server, habe ich aber bisher auch noch keine Erfahrung mit und nur mal im Zusammenhang mit Hyper-V Clustern gehört.

Wie viele Netzwerkverbindungen sollte ich denn haben (und welche Geschwindigkeit)? Also zwischen den Hyper-V-Servern?

Dafür hätte ich eh schon integriert 4x1G RJ45 und würde sonst je Server eine weitere Karte mit je 2x40GB Ports (1 x für SAN Anbindung, einmal zwischen Hyper-V Servern) einbauen. Oder wären hier mehr NICs mit je 10G sinnvoll?

SAN dann halt für Management + Internet ne extra NIC.

Dafür würde ich auf der opnSense einen Trunk konfigurieren und dann an den Core-Switch anbinden als VLAN-Trunk (wahrsch. LAG) -> extra NIC mit untagged VLAN für Management + Internetzugang?

Außerdem die Frage, wie die VMs / Hyper-V Hosts dann ins Netzwerk kommen.

Für die VMs dann wahrscheinlich ein NIC Team bestehend aus 2x10G Anbindungen zum Switch. -> Kann darüber der Hyper-V-Host theoretisch auch ins Netzwerk statt ner extra NIC (für Management + Internet)?

Optimalerweise hat jemand einen vollen Setup Guide / mehrere einzelne parat, ich hab leider nichts wirklich allumfassenders gefunden bzgl. Setup und Best Practices.

Fragen über Fragen und ich hoffe auf euer Wissen und Erfahrung 😁

Und ich weiß, da ist viel Unwissen dabei, habe so etwas halt (leider) noch nie aufsetzen dürfen / können.

Grüße und Danke im voraus

Max

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 52105406372

Url: https://administrator.de/forum/setup-eines-hyper-v-clusters-mit-san-52105406372.html

Ausgedruckt am: 30.07.2025 um 21:07 Uhr

8 Kommentare

Neuester Kommentar

Moin @PrieserMax,

das mit dem Teaming würde ich dir auch bei einem Cluster nicht empfehlen, da es nicht wirklich gut läuft, vor allem bei => 10G. 😔

Berücksichtige schon mal bitte, dass insbesondere ein 24/7 Betrieb dieser Hardware, alleine stromtechnisch schnell mal mehrere hundert Euros pro Monat kosten kann.

Nimm lieber ein Linux, das stellt Storage auf jeden Fall viel effizienter bereit wie ein Windows.

Warum das denn?

Bei unseren Kunden laufen duzende VM's auf derselben LUN und dass, bei mehreren hundert Usern.

Nimm RAID5, RAID10 ist Geldverschwendung.

Wenn du einen anständigen RAID-Controller benutzt, dann hast du auch bei einem RAID5 noch gute bis sehr gute Leistung.

Ähm, nicht so ganz, den die von dir vorher angesprochenen "mini SAS HD Anschlüsse" (SFF-8644), stellen pro Anluss nicht nur 1 x SAS12G zur Verfügung, sondern 4 x SAS12G = 48G. 😉

Respektive, 24G bei SFF-8088 (SAS 6G).

Ein SAN installiert man nicht wirklich unter einem Windows, vor allem dann nicht, wenn man Performance haben möchte! Oder hast du schon jemals ein namenhaften SAN-Hersteller gesehen, der auf seine SAN's ein Windows drauf packt?

Und falls jetzt jemand mir hier mit S2D kontern möchte ... vorsichtig ... Füchse können manchmal auch kräftig zubeissen.

Und warum glaubst du, dass du für ein Hyper-V Cluster ein System Center und oder den Virtual Machine Manager benötigst?

Und was die Lizenzen angeht ... 🤧 ... Microsoft ActionPack ... 🤧. 😉

Also ein Windows SAN und dann per iSCSI an die Nodes weiter ... ähm ... ja, das ist so, als würdest du zwei Durchlauferhitzer mit einem sehr bescheidenen Wirkungsgrad, hintereinander schalten.

Sprich, ja, irgendwie würde es schon funktionieren nur halt eben nicht wirklich performant und auch nicht wirklich effizient. 😔

In dem du dir z.B. eine gebrauchte P2000 holst und diese am besten per SAS oder FC an deine beiden Nodes anbindest. 😉

Das mit der Geschwindigkeit kommt auf deine Anforderungen an, ansonsten würde ich bei einem Hyper-V Node immer 4 getrennte NIC's empfehlen.

1 x VM Datenverkehr

1 x Management

1 x Backup

1 x Cluster Datenverkehr

Vergiss bei einem G9 bitte gleich die NIC's mit >10G, den die bekommst du damit nicht wirklich "ausgelutscht".

community.spiceworks.com/t/the-windows-horror-story-season-001-n ...

😔

Sprich, lieber separat und ohne Teaming, vor allem bei =>10G.

Für dein Vorhaben wird es fürchte ich kein und vor allem vollen Setup Guide geben, da es schon etwas "ungewöhnlich" ist.

Mach dir kein Kopf, als ITler wirst du noch oft genug im kalten Wasser landen, selbst wenn du ein alter IT-Hase/Fuchs bist. Mit zunehmender Erfahrung, kommst du mit der Zeit jedoch schneller aus dem kalten Wasser wieder raus und kannst auch effektiver dein Fell wieder ausschütteln. 😉🤪

Gruss Alex

und auch kein Nic Teaming o.ä.

das mit dem Teaming würde ich dir auch bei einem Cluster nicht empfehlen, da es nicht wirklich gut läuft, vor allem bei => 10G. 😔

Nun zur sonstigen Server-Hardware:

2 x HP DL360 Gen9 Virtualisierungshosts

1 x HP DL360 Gen9 als SAN (ich möchte kein S2D nutzen)

(mit 2x externem HP D2700 Festplatten Enclosure für 2,5" SAS, in Zukunft evtl. noch ein D2600 für 3,5" als Datengrab wenn dann mehr Bedarf entstehen sollte)

2 x HP DL360 Gen9 Virtualisierungshosts

1 x HP DL360 Gen9 als SAN (ich möchte kein S2D nutzen)

(mit 2x externem HP D2700 Festplatten Enclosure für 2,5" SAS, in Zukunft evtl. noch ein D2600 für 3,5" als Datengrab wenn dann mehr Bedarf entstehen sollte)

Berücksichtige schon mal bitte, dass insbesondere ein 24/7 Betrieb dieser Hardware, alleine stromtechnisch schnell mal mehrere hundert Euros pro Monat kosten kann.

-> Auf dem SAN-Server würde ich dann Windows Server installieren (separates RAID)

Nimm lieber ein Linux, das stellt Storage auf jeden Fall viel effizienter bereit wie ein Windows.

mehrere RAIDs für verschiedene VMs machen.

Warum das denn?

Bei unseren Kunden laufen duzende VM's auf derselben LUN und dass, bei mehreren hundert Usern.

1 x reines SSD RAID (VM-Betriebssysteme, RAID10),

Nimm RAID5, RAID10 ist Geldverschwendung.

1 x SAS 2,5" RAID (wahrscheinlich auch RAID10) für VMs die mehr Speicher, aber trotzdem hohe Geschwindigkeiten brauchen, in Zukunft eben evtl. ein weiteres Enclosure

Wenn du einen anständigen RAID-Controller benutzt, dann hast du auch bei einem RAID5 noch gute bis sehr gute Leistung.

Ich habe nämlich die Befürchtung, dass so die Anbindung nicht sonderlich schnell sein wird, da mir ja im Endeffekt gesamt nur 12G übrigbleiben (2x6GB SAS vom SAN-Server zu den Enclosures) was rechnerisch 1.500MB/s sind und somit nicht so prickelnd wäre.

Ähm, nicht so ganz, den die von dir vorher angesprochenen "mini SAS HD Anschlüsse" (SFF-8644), stellen pro Anluss nicht nur 1 x SAS12G zur Verfügung, sondern 4 x SAS12G = 48G. 😉

Respektive, 24G bei SFF-8088 (SAS 6G).

SAN-Server mit Windows installieren, RAIDs konfigurieren

Ein SAN installiert man nicht wirklich unter einem Windows, vor allem dann nicht, wenn man Performance haben möchte! Oder hast du schon jemals ein namenhaften SAN-Hersteller gesehen, der auf seine SAN's ein Windows drauf packt?

Und falls jetzt jemand mir hier mit S2D kontern möchte ... vorsichtig ... Füchse können manchmal auch kräftig zubeissen.

2 x Virtualisierungsserver mit Windows Server installieren, Hyper-V installieren

Nun die wichtigen Fragen:

Wie richte ich das Cluster ein?

Nun die wichtigen Fragen:

Wie richte ich das Cluster ein?

Für System Center und den Virtual Machine Manager braucht man ja Lizenzen, oder kann man das umgehen? (hust hust)

Und warum glaubst du, dass du für ein Hyper-V Cluster ein System Center und oder den Virtual Machine Manager benötigst?

Und was die Lizenzen angeht ... 🤧 ... Microsoft ActionPack ... 🤧. 😉

Ich würde das SAN an die Virtualisierungshosts mit je 1x40G QSFP anbinden.

Also ein Windows SAN und dann per iSCSI an die Nodes weiter ... ähm ... ja, das ist so, als würdest du zwei Durchlauferhitzer mit einem sehr bescheidenen Wirkungsgrad, hintereinander schalten.

Sprich, ja, irgendwie würde es schon funktionieren nur halt eben nicht wirklich performant und auch nicht wirklich effizient. 😔

Wie mach ich das korrekt?

In dem du dir z.B. eine gebrauchte P2000 holst und diese am besten per SAS oder FC an deine beiden Nodes anbindest. 😉

Wie viele Netzwerkverbindungen sollte ich denn haben (und welche Geschwindigkeit)? Also zwischen den Hyper-V-Servern?

Das mit der Geschwindigkeit kommt auf deine Anforderungen an, ansonsten würde ich bei einem Hyper-V Node immer 4 getrennte NIC's empfehlen.

1 x VM Datenverkehr

1 x Management

1 x Backup

1 x Cluster Datenverkehr

Dafür hätte ich eh schon integriert 4x1G RJ45 und würde sonst je Server eine weitere Karte mit je 2x40GB Ports (1 x für SAN Anbindung, einmal zwischen Hyper-V Servern) einbauen. Oder wären hier mehr NICs mit je 10G sinnvoll?

Vergiss bei einem G9 bitte gleich die NIC's mit >10G, den die bekommst du damit nicht wirklich "ausgelutscht".

Für die VMs dann wahrscheinlich ein NIC Team bestehend aus 2x10G Anbindungen zum Switch. -> Kann darüber der Hyper-V-Host theoretisch auch ins Netzwerk statt ner extra NIC (für Management + Internet)?

community.spiceworks.com/t/the-windows-horror-story-season-001-n ...

😔

Sprich, lieber separat und ohne Teaming, vor allem bei =>10G.

Optimalerweise hat jemand einen vollen Setup Guide / mehrere einzelne parat, ich hab leider nichts wirklich allumfassenders gefunden bzgl. Setup und Best Practices.

Für dein Vorhaben wird es fürchte ich kein und vor allem vollen Setup Guide geben, da es schon etwas "ungewöhnlich" ist.

Und ich weiß, da ist viel Unwissen dabei, habe so etwas halt (leider) noch nie aufsetzen dürfen / können.

Mach dir kein Kopf, als ITler wirst du noch oft genug im kalten Wasser landen, selbst wenn du ein alter IT-Hase/Fuchs bist. Mit zunehmender Erfahrung, kommst du mit der Zeit jedoch schneller aus dem kalten Wasser wieder raus und kannst auch effektiver dein Fell wieder ausschütteln. 😉🤪

Gruss Alex

Moin @PrieserMax,

na ja, das sind immerhin 8760 kWh/Jahr und bei ~25 Cent pro kWh macht das im Jahr eine stolze Summe von 2.190,0 €. 😔

Zudem generiert eine solche Anlage auch ordentlich Abwärme, die du ja auch irgendwie im Griff haben solltest.

Lieber das hier ...

ebay.de/itm/133330756982

... sprich einen SAS variante, denn bei dieser hast du pro Controller Richtung Nodes eine theoretische Bandbreite von 4 x 4 x 6G = 96G. Bei der 8G FC Variante hast pro Controller aber nur 2 x 8G = 16G. 😉

Für die P2000 G3 benötigst du meine ich ein D2700 Enclosure, die sind aber auch nicht wirklich sehr teuer.

servershop24.de/hp-d2700-enclosure/a-110704/

Bei HP Komponenten kann ich dir leider nur bedingt helfen, da wir selber keine HPE Server/SAN's verkaufen, sondern nur bei Bedarf supporten.

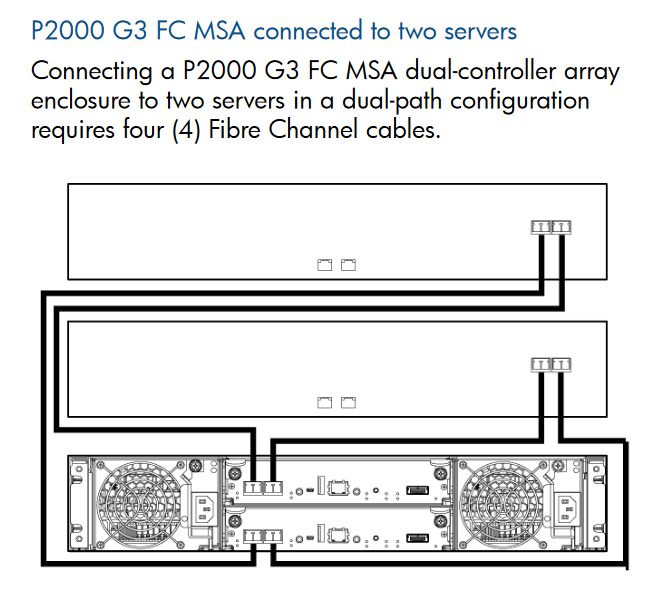

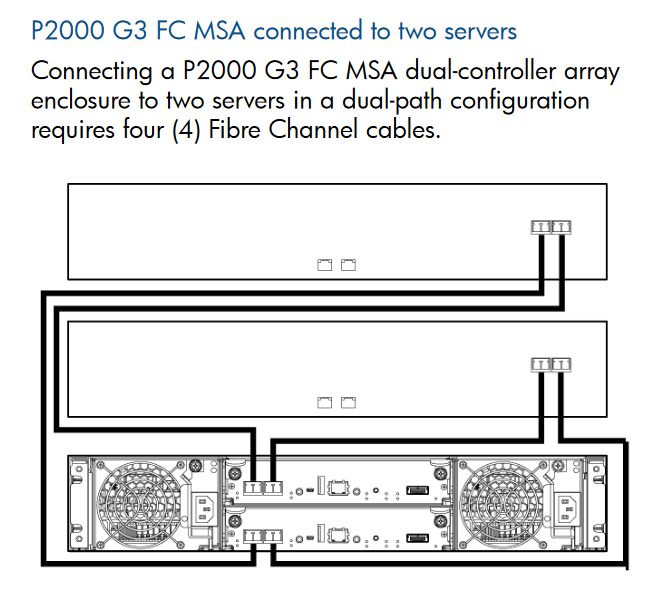

Wenn du die FC variante nimmst, dann ja, bei der SAS Variante solltest du jeden Contoller aber auch mindestens einmal mit den entsprechenden Hosts verbinden.

oder SAS HBA's.

Server 1 FC Port 1 kommt an Controller 1 FC Port 1

Server 1 FC Port 2 kommt an Controller 2 FC Port 1

Server 2 FC Port 1 kommt an Controller 1 FC Port 2

Server 2 FC Port 2 kommt an Controller 2 FC Port 2

Und bei SAS ist das im Grunde dasselbe.

Du konfigurierst auf der P2000 ein RAID, darauf eine LUN, diese mapst du an die SAS Ports und schon siehst du die LUN als lokalen Datenträgern auf den entsprechenden Servern. 😉

By the Way, zum Booten der Hyper-V Nodes bitte eigene Boot-SSD's benutzen und nicht die Nodes über ein LUN/SAN booten.

Nicht viel anders wie auch einen lokalen Datenträger.

Ich mag vSAN's generell nicht, weil die sich performancetechnisch, nicht wirklich mit einem erwachsenen Enterprise SAN messen können. 😔

Ja und zwar ganz sicher, denn bei den duzenden von Hyper-V Clustern die ich die letzten XX Jahre aufgesetzt habe, habe ich die bisher auch noch nicht wirklich benötigt. 🙃

Na ja, die 437,99 € für eine P2000 G3 finde ich jetzt nicht wirklich teurer wie deine Variante,

vor allem wenn man berücksichtigt, dass du bei deiner Variante noch die entsprechende Serverlizenz benötigst und diese auch nicht wirklich HA, sprich, ausfallsicher ist. Denn wenn bei deinem bisherigen Konzept der "Storageserver" abraucht, dann steht das gesamte System.

Die P2000 ist jedoch ein HA SAN, sprich wenn dort eine Komponente abraucht, dann läuft im Normalfall das System dennoch weiter, weil sämtliche Kritischen Komponenten redundant, sprich, mindestens doppelt vorhanden sind. 😉

Für solche Dinge wie du sie vorhast, sprich Storage für ein Hypervisor-System, kann ich guten Gewissens nur ein ein anständiges Block SAN empfehlen und dieses entweder per SAS oder FC an die Nodes anbinden.

NAS Geräte verwenden wir wenn überhaupt dann nur für Backups und das binden wir mittlerweile auch überwiegend per SMB und nicht per iSCSI an.

Wie schon geschrieben, iSCSI ist bei weitem nicht so effizient wie FC oder SAS.

Doch das geht, es wird jedoch seitens MS nicht offiziell supportet. 🙃

Gruss Alex

Ja, das ist mir bewusst. Ich habe es mit mal grob ausgerechnet, ich wäre dann bei ca. 1kW die Stunde

na ja, das sind immerhin 8760 kWh/Jahr und bei ~25 Cent pro kWh macht das im Jahr eine stolze Summe von 2.190,0 €. 😔

Zudem generiert eine solche Anlage auch ordentlich Abwärme, die du ja auch irgendwie im Griff haben solltest.

Lieber das hier ...

ebay.de/itm/133330756982

... sprich einen SAS variante, denn bei dieser hast du pro Controller Richtung Nodes eine theoretische Bandbreite von 4 x 4 x 6G = 96G. Bei der 8G FC Variante hast pro Controller aber nur 2 x 8G = 16G. 😉

Und kann ich dann extern mit einem D2600 erweitern.

Für die P2000 G3 benötigst du meine ich ein D2700 Enclosure, die sind aber auch nicht wirklich sehr teuer.

servershop24.de/hp-d2700-enclosure/a-110704/

Bei HP Komponenten kann ich dir leider nur bedingt helfen, da wir selber keine HPE Server/SAN's verkaufen, sondern nur bei Bedarf supporten.

Wie sollte ich das dann an die Server anbinden?

Also zu jedem Server mit 2x8GB FC?

Also zu jedem Server mit 2x8GB FC?

Wenn du die FC variante nimmst, dann ja, bei der SAS Variante solltest du jeden Contoller aber auch mindestens einmal mit den entsprechenden Hosts verbinden.

Entsprechende FC Karten besorgen, nur wo muss ich dann an an die Controller. Überkreuz?

oder SAS HBA's.

Server 1 FC Port 1 kommt an Controller 1 FC Port 1

Server 1 FC Port 2 kommt an Controller 2 FC Port 1

Server 2 FC Port 1 kommt an Controller 1 FC Port 2

Server 2 FC Port 2 kommt an Controller 2 FC Port 2

Und bei SAS ist das im Grunde dasselbe.

Und wie binde ich es dann an den HV Hosts ein?

Du konfigurierst auf der P2000 ein RAID, darauf eine LUN, diese mapst du an die SAS Ports und schon siehst du die LUN als lokalen Datenträgern auf den entsprechenden Servern. 😉

By the Way, zum Booten der Hyper-V Nodes bitte eigene Boot-SSD's benutzen und nicht die Nodes über ein LUN/SAN booten.

(Unten spreche ich weiterhin von meinem bisherigen Plan ohne "richtiges" SAN)

Verbindung physisch wie hier:

Aber wie muss ich die dann im OS einbinden?

Aber wie muss ich die dann im OS einbinden?

Verbindung physisch wie hier:

Nicht viel anders wie auch einen lokalen Datenträger.

Ja, S2D ist auch gar nicht mein Geschmack. Im Geschäft haben wir VMware mit vSAN, das rennt aber sagenhaft.

Ich mag vSAN's generell nicht, weil die sich performancetechnisch, nicht wirklich mit einem erwachsenen Enterprise SAN messen können. 😔

Danke, dann brauch ich es auf jeden Fall nicht

Ja und zwar ganz sicher, denn bei den duzenden von Hyper-V Clustern die ich die letzten XX Jahre aufgesetzt habe, habe ich die bisher auch noch nicht wirklich benötigt. 🙃

Die P2000 ist halt schon recht teuer, deshalb lieber über einen Server + Enclosures.

Na ja, die 437,99 € für eine P2000 G3 finde ich jetzt nicht wirklich teurer wie deine Variante,

vor allem wenn man berücksichtigt, dass du bei deiner Variante noch die entsprechende Serverlizenz benötigst und diese auch nicht wirklich HA, sprich, ausfallsicher ist. Denn wenn bei deinem bisherigen Konzept der "Storageserver" abraucht, dann steht das gesamte System.

Die P2000 ist jedoch ein HA SAN, sprich wenn dort eine Komponente abraucht, dann läuft im Normalfall das System dennoch weiter, weil sämtliche Kritischen Komponenten redundant, sprich, mindestens doppelt vorhanden sind. 😉

Wie oben gerade von mir erwähnt, was würdest du denn ansonsten empfehlen? Statt iSCSI SMB/NFS? Oder was anderes im gesamten, eben ggf. unter Linux.

Für solche Dinge wie du sie vorhast, sprich Storage für ein Hypervisor-System, kann ich guten Gewissens nur ein ein anständiges Block SAN empfehlen und dieses entweder per SAS oder FC an die Nodes anbinden.

NAS Geräte verwenden wir wenn überhaupt dann nur für Backups und das binden wir mittlerweile auch überwiegend per SMB und nicht per iSCSI an.

Also wären dann meine NICs (je Virtualisierungshost):

1 x Anbindung SAN via 40G QSFP+

😬 ... aber ja OK, irgendwie würde das schon funktionieren, aber nicht wirklich mit 40G. 🙃1 x VM Datenverkehr via 10G SFP+ zu Switch

👍1 x Management via 1G RJ45 an Switch

👍1 x Cluster Datenverkehr via 40G QSFP+ zwischen den HV Hosts

👍 und 10G reicht da vollkommen aus.1 x Backup via 10G SFP+ an Backupserver

👍In dem Fall die 40G nur aus Preisleistung heraus. Die kosten nämlich nicht mal 20€ das Stück (siehe: ebay.de/itm/235564113679)

Wie schon geschrieben, iSCSI ist bei weitem nicht so effizient wie FC oder SAS.

vor allem laut den Infos in deinem Beitrag geht ja bei einem SET-Team keine VM mit V1-NIC, Mensch Microsoft...

Doch das geht, es wird jedoch seitens MS nicht offiziell supportet. 🙃

Gruss Alex

Und kann ich dann extern mit einem D2600 erweitern.

Für die P2000 G3 benötigst du meine ich ein D2700 Enclosure, die sind aber auch nicht wirklich sehr teuer.

servershop24.de/hp-d2700-enclosure/a-110704/

Der Unterschied zwischen DS27000 bzw. DS2600 ist lediglich der Formfaktor der HDD´s.

Normalerweise sollte eigentlich jedes NORMALE Diskshelf funktionieren.

Wobei jetzt die richtigen Storage Shelfs wie z.b. aus der 3 Par Serie nicht funktionieren.

Die DS sind ja "nur" dumme JBOD´s

Moin @Mr-Gustav,

ja, dennoch wird das D2600 bei der MSA nicht als explizit als kompatibel angegeben, schein aber dennoch mit einer solchen zu funktionieren.

community.hpe.com/t5/msa-storage/p2000-g3-with-additional-d2600- ...

🙃

Theoretisch ja, insbesondere bei den A-Brands, kannst du das praktisch jedoch meistens eher knicken.

Gruss Alex

Der Unterschied zwischen DS27000 bzw. DS2600 ist lediglich der Formfaktor der HDD´s.

ja, dennoch wird das D2600 bei der MSA nicht als explizit als kompatibel angegeben, schein aber dennoch mit einer solchen zu funktionieren.

community.hpe.com/t5/msa-storage/p2000-g3-with-additional-d2600- ...

🙃

Normalerweise sollte eigentlich jedes NORMALE Diskshelf funktionieren.

Theoretisch ja, insbesondere bei den A-Brands, kannst du das praktisch jedoch meistens eher knicken.

Gruss Alex