Tipps und Hinweise zum Neukauf Netzwerktechnik

Hallo Gemeinde,

in meinem Unternehmen laufen die Planungen für eine schrittweise Erneuerung der Netzwerktechnik.

Zuerst sollen die Coreswitche und später nach und nach die Etagenswitche erneuert werden.

Zukunftsorientiert möchten wir gleich auf 10G aufrüsten. Es wird vermutlich bei der Firma Netgear bleiben, speziell folgende Modelle stelle ich mir vor:

- NETGEAR M7300 (Bzw. M7100) als Backboneswitch

- NETGEAR M5300 als Etagenswitche mit 10G Uplink.

Nun steht die Frage der Verbindung des Backbones mit den Etagenswitchen. Ich hätte diese Verbindung gern FDAC-Kabeln und nicht mit TP-Kabeln, auf Grund der besseren Latenz. Chefe ist natürlich skeptisch, da es auch um einige Mehrkosten geht.

Vielen Dank schonmal Vorab!

Gruß Clemens

in meinem Unternehmen laufen die Planungen für eine schrittweise Erneuerung der Netzwerktechnik.

Zuerst sollen die Coreswitche und später nach und nach die Etagenswitche erneuert werden.

Zukunftsorientiert möchten wir gleich auf 10G aufrüsten. Es wird vermutlich bei der Firma Netgear bleiben, speziell folgende Modelle stelle ich mir vor:

- NETGEAR M7300 (Bzw. M7100) als Backboneswitch

- NETGEAR M5300 als Etagenswitche mit 10G Uplink.

Nun steht die Frage der Verbindung des Backbones mit den Etagenswitchen. Ich hätte diese Verbindung gern FDAC-Kabeln und nicht mit TP-Kabeln, auf Grund der besseren Latenz. Chefe ist natürlich skeptisch, da es auch um einige Mehrkosten geht.

- Wie seht ihr die Sache (Wie habt ihr es gelöst)?

- Wie kann ich am besten vor Chefe argumentieren?

Vielen Dank schonmal Vorab!

Gruß Clemens

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 266934

Url: https://administrator.de/forum/tipps-und-hinweise-zum-neukauf-netzwerktechnik-266934.html

Ausgedruckt am: 02.06.2025 um 08:06 Uhr

32 Kommentare

Neuester Kommentar

Hallo Clemens,

Wie soll Dein Core aufgebaut sein ?

Wo sind Deine Server angebunden ?

Wie viele Etagenverteiler hast Du ?

Wie viele Ports per Etage ?

Welche Entfernung ist vom Core zum Etagenverteiler gegeben ?

Welche Kabel sind da verlegt ? Cat.5 cat.6, LWL ????

Welche Probleme habt Ihr da im Moment ?

Warum Netgear ? (Kennst Du schon, Keine Lust was neue zu lernen ???)

Warum 10Gbit/s zur Etage ?

Was läuft in den Etagen ? CAD, Filme bearbeiten ??

Nur weil es schnell ist, muss nicht jeder 10 Gbit/s zu Etage haben ?

Und die wichtigste Frage:

Wie hoch ist das Budget ?

Bitte keine Antwort à la So wenig wie möglich

Gruß

Anton

Wie soll Dein Core aufgebaut sein ?

Wo sind Deine Server angebunden ?

Wie viele Etagenverteiler hast Du ?

Wie viele Ports per Etage ?

Welche Entfernung ist vom Core zum Etagenverteiler gegeben ?

Welche Kabel sind da verlegt ? Cat.5 cat.6, LWL ????

Welche Probleme habt Ihr da im Moment ?

Warum Netgear ? (Kennst Du schon, Keine Lust was neue zu lernen ???)

Warum 10Gbit/s zur Etage ?

Was läuft in den Etagen ? CAD, Filme bearbeiten ??

Nur weil es schnell ist, muss nicht jeder 10 Gbit/s zu Etage haben ?

Und die wichtigste Frage:

Wie hoch ist das Budget ?

Bitte keine Antwort à la So wenig wie möglich

Gruß

Anton

Ich hätte diese Verbindung gern FDAC-Kabeln und nicht mit TP-Kabeln, auf Grund der besseren Latenz.

Das Layer 1 Medium bestimmt doch niemals die Latenz ! Und überhaupt... NG als Billighersteller mit den schlechtesten Werten überhaupt da ist es ja völlig Latte ob man bei den eh sehr miesen Werten dann nich 2 oder 2 µS Latenz mehr hat oder nicht. Das Argument ist bei dem Hersteller mit klassischer Store and Forward Technologie in den Switches ja so oder so sinnfrei.Wenns wenigstens Cut Through Maschinen wären hätte man das diskutieren können...

Es ist völlig unerheblich ob das 10GBaseT (Cat), DAC Kabel oder Fiber ist in der Beziehung. Fiber oder DAC wäre natürlich die etwas "professionellere" Lösung allerdings ist das eher kosmetisch gesehen.

Da ihr so oder so auf 10G Billigswitches der untersten Kategorie setzt muss man den Aufwand mit den DAC oder Fiber Kabeln nicht treiben und dann eher Cat 7 nehmen sofern ihr keine Längenprobleme bekommt.

Profunde Argumente gegenüber dem Chef sind da dann schwierig. Er sollte sich eher mal generell fragen ob er sein Unternehmenbackbone mit Billigswitches eines Herstellers für Consumer Produkte ausstatten will.

OK, ist natürlich auch eine Frage der Netzgöße. Bei einem Popelnetz mit 3 Switches und extrem wenig Anforderungen an die Netzwerkfunktionen ist es auch egal was man da reinschraubt. Da tuts dann auch Longshine und D-Link.

Ist letztlich so oder so immer das gleiche denn dort sind Standard Custom ASICs drin die von Accton in Taiwan zusammengekloppt werden und NG, D-Link, Longshine und Co bäppeln da nur ihre Logos drauf.

Hallo clemens-der-vierte,

und willkommen auf Administrator.de!

im Portfolio und zu dem ProSafe M6100 gibt es eben auch Blades mit 10 GBit/s Modulen.

Landschaft um kostengünstig Geräte, SAN/NAS und Server mittels 10 GBit/s anzubinden.

Ich würde allerdings bei den neuen Switchen darauf achten das sie stapelbar sind

oder gleich in einem Chassis integriert werden können. Der neue M6100 ist da eventuell

auch gleich das Mittel der Wahl, denn dadurch entfallen die SFP+ Module für Uplinks,

die Stapelmodule und DAC Kabel!

Gegenüber der 5400 ZL Serie von HP bekommt man eine deutlich höhere Portdichte

und hat preislich eine recht gut erkennbaren Unterschied.

Gegenüber Cisco wird man sogar mit einem höheren Powerbudget und einer günstigeren

Lizenzpolitik belohnt.

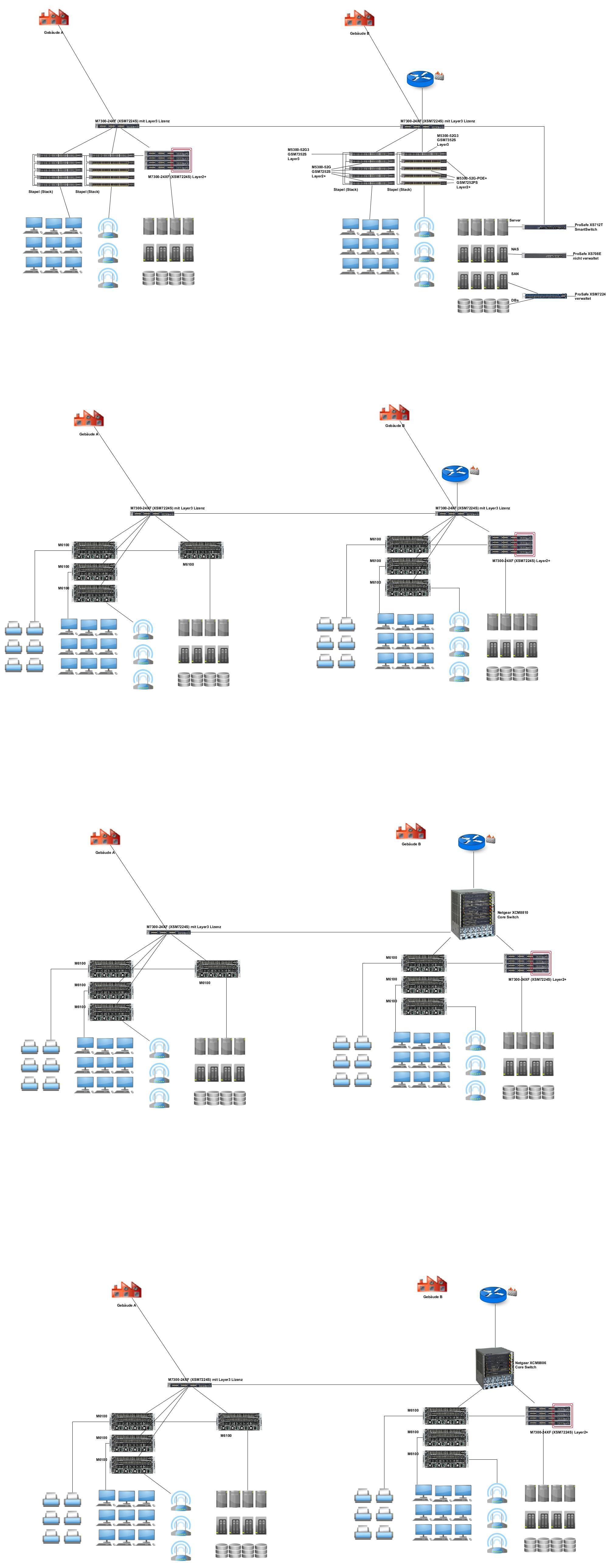

Ich habe Dir mal eine kleine Zeichnung dazu gemacht wo verschiedene Switche der

aktuellen Serien und Generationen enthalten sind, klar die kann man auch mischen.

Denn wenn Du nichts zu dem Budget aussagst und nicht einmal den Namen des Core

Switches hier nennst ist das für uns auch schwer zu etwas zu raten.

Gruß

Dobby

und willkommen auf Administrator.de!

in meinem Unternehmen laufen die Planungen für eine schrittweise Erneuerung der

Netzwerktechnik.

Da bietet Netgear zur Zeit gerade die passenden Switche für das KMU Umfeld an.Netzwerktechnik.

Zuerst sollen die Coreswitche und später nach und nach die Etagenswitche erneuert werden.

Kennst Du schon den neuen ProSafe M6100 von Netgear?Zukunftsorientiert möchten wir gleich auf 10G aufrüsten. Es wird vermutlich

bei der Firma Netgear bleiben, speziell folgende Modelle stelle ich mir vor:

Vernünftig, denn zur Zeit hat Netgear genau auf den KMU Bereich zugeschnittene Switchmodellebei der Firma Netgear bleiben, speziell folgende Modelle stelle ich mir vor:

im Portfolio und zu dem ProSafe M6100 gibt es eben auch Blades mit 10 GBit/s Modulen.

- NETGEAR M7300 (Bzw. M7100) als Backboneswitch

- NETGEAR M5300 als Etagenswitche mit 10G Uplink.

Eine gute Wahl und genau dieses Angebot richtet sich doch auch an die KMU- NETGEAR M5300 als Etagenswitche mit 10G Uplink.

Landschaft um kostengünstig Geräte, SAN/NAS und Server mittels 10 GBit/s anzubinden.

Ich würde allerdings bei den neuen Switchen darauf achten das sie stapelbar sind

oder gleich in einem Chassis integriert werden können. Der neue M6100 ist da eventuell

auch gleich das Mittel der Wahl, denn dadurch entfallen die SFP+ Module für Uplinks,

die Stapelmodule und DAC Kabel!

Gegenüber der 5400 ZL Serie von HP bekommt man eine deutlich höhere Portdichte

und hat preislich eine recht gut erkennbaren Unterschied.

Gegenüber Cisco wird man sogar mit einem höheren Powerbudget und einer günstigeren

Lizenzpolitik belohnt.

Ich habe Dir mal eine kleine Zeichnung dazu gemacht wo verschiedene Switche der

aktuellen Serien und Generationen enthalten sind, klar die kann man auch mischen.

Denn wenn Du nichts zu dem Budget aussagst und nicht einmal den Namen des Core

Switches hier nennst ist das für uns auch schwer zu etwas zu raten.

Gruß

Dobby

Belege DU doch erstmal warum ein simpler Draht oder eine Glasfaser auf dem Layer 1 die Paket Latenz in einem Switch verändern sollte !

Das ist doch Unsinn.

Das ist doch Unsinn.

Welche Modelle würdest du denn empfehlen die Cut Trough beherschen?

Sorry, aber das willst du nicht wirklich wissen. Wenn du einen NG Preishorizont hast und dein Chef schon bei billigen FDAC Kabeln weint, sind diese Switches davon meilenweit entfernt.

OK aber die Zeit die die Elektronen durch die SFP Optik brauchen und die Photonen dann durch die Faser ist nicht mehr relevant messbar und stehen in keinerlei Verhältnis zu Billiger Hardware die mit lahmer Store and Forward Technik bei 10 Gig arbeitet.

Wenn du schon so rumreitest auf Latenzen, dann hast du doch erstmal HIER ein gravierendes Problem.

Das ist so als wenn du dir eine wunderbare Autobahn mit 4 Spuren zum Autorennen gebaut hast und dann mit einem Kettcar an den Start gehst weil das geld für den Porsche nicht gereicht hat.

Allein die System Latenzen im Switch sind mehrere Zehnerpotenzen höher als das was durch ein paar Meter Kabel oder Faser rennt. Das sagt einem schon der gesunde Physikerverstand...

Deshalb ist es vollkommen irrelvant was für eine Infrastruktur Kupfer oder Glas verwendet wird.

Wenn du schon so rumreitest auf Latenzen, dann hast du doch erstmal HIER ein gravierendes Problem.

Das ist so als wenn du dir eine wunderbare Autobahn mit 4 Spuren zum Autorennen gebaut hast und dann mit einem Kettcar an den Start gehst weil das geld für den Porsche nicht gereicht hat.

Allein die System Latenzen im Switch sind mehrere Zehnerpotenzen höher als das was durch ein paar Meter Kabel oder Faser rennt. Das sagt einem schon der gesunde Physikerverstand...

Deshalb ist es vollkommen irrelvant was für eine Infrastruktur Kupfer oder Glas verwendet wird.

@aqui: YMMD :D

@to Wenn es dir um UltraLowLatenz geht schaue dir mal die VDX Serien von Brocade an, die sind allerdings auch Meilenweit von der NG Preis-Schiene weg, damit kannst auch direkt STP aus dem Backbone Bereich tilgen (Zauberwort: TRILL Protokoll bei Brocade)

Im allgemeinen kannst die Brocade Geräte (ab ICX6450 auch 10Gb) über Twinax Kabel stacken, die kosten auch nicht viel, zu dem kannst auch Optiken/Kabel von 3. Anbietern verwenden. Für 2 Geräte dann das Layer3 Image drauf, VRRP/MRP, oder was man gerne haben möchte, einstellen und bei Bedarf auch BGP (sofern benötigt).

Die Schematische Darstellung von @108012 trifft es schon recht passent, wie man das aufbauen kann (Hersteller ist jetzt Geschmacksache), eine hohe Portdichte zu einem akzeptablen Preis erreichst eher durch Stacking wie durch Modulswitche. Vorteil bei den Modulswitchen ist halt, dass die Backplane in Summe größer ist.

@SlainteMhath : wenn schon neue Glafaserleitungen dann bitte MM als OM4 oder direkt SM OS2 , wir verlegen nur noch SM Leitungen damit wir spätere Leistungsspitzen >10Gb auch abfangen können. Die Mehrkosten durch den Einsatz von SM rechtfertigen die Möglichkeit später auch mal 10Gb >500m oder 40Gb einzusetzen (wenn man jetzt eh schon auf 10Gb geht) - die Erfahrung habe ich im letzten Jahr gemacht, wo wie 2 MM OM3 Leitungen >400m aus den Leerrohren ziehen mussten und dann SM eingezogen/geblasen wurde damit die 10Gb Links geschaltet werden konnten.

, wir verlegen nur noch SM Leitungen damit wir spätere Leistungsspitzen >10Gb auch abfangen können. Die Mehrkosten durch den Einsatz von SM rechtfertigen die Möglichkeit später auch mal 10Gb >500m oder 40Gb einzusetzen (wenn man jetzt eh schon auf 10Gb geht) - die Erfahrung habe ich im letzten Jahr gemacht, wo wie 2 MM OM3 Leitungen >400m aus den Leerrohren ziehen mussten und dann SM eingezogen/geblasen wurde damit die 10Gb Links geschaltet werden konnten.

Just my 2 Cent

@clSchak

@to Wenn es dir um UltraLowLatenz geht schaue dir mal die VDX Serien von Brocade an, die sind allerdings auch Meilenweit von der NG Preis-Schiene weg, damit kannst auch direkt STP aus dem Backbone Bereich tilgen (Zauberwort: TRILL Protokoll bei Brocade)

Im allgemeinen kannst die Brocade Geräte (ab ICX6450 auch 10Gb) über Twinax Kabel stacken, die kosten auch nicht viel, zu dem kannst auch Optiken/Kabel von 3. Anbietern verwenden. Für 2 Geräte dann das Layer3 Image drauf, VRRP/MRP, oder was man gerne haben möchte, einstellen und bei Bedarf auch BGP (sofern benötigt).

Die Schematische Darstellung von @108012 trifft es schon recht passent, wie man das aufbauen kann (Hersteller ist jetzt Geschmacksache), eine hohe Portdichte zu einem akzeptablen Preis erreichst eher durch Stacking wie durch Modulswitche. Vorteil bei den Modulswitchen ist halt, dass die Backplane in Summe größer ist.

@SlainteMhath : wenn schon neue Glafaserleitungen dann bitte MM als OM4 oder direkt SM OS2

Just my 2 Cent

@clSchak

Hallo zusammen,

@clSchak

Also ohne STP im Backbone kein Alleinstellungsmerkmal von Brocade.

Das konnte Nortel (Accelar 8600) schon lange und Avaya kann es heute noch immer.

Mann kann dieses Netz auch mit Avaya VSP 4000, VSP 7000, VSP 8000 im Core und mit mit ERS3549 oder ERS 4800 im Edge bauen.

Und anstatt TRILL würde ich lieber shortest path bridging verwenden wollen, aber ich denke, das ist bei diesem Netz etwas oversized.

Gruß

Anton

@clSchak

Also ohne STP im Backbone kein Alleinstellungsmerkmal von Brocade.

Das konnte Nortel (Accelar 8600) schon lange und Avaya kann es heute noch immer.

Mann kann dieses Netz auch mit Avaya VSP 4000, VSP 7000, VSP 8000 im Core und mit mit ERS3549 oder ERS 4800 im Edge bauen.

Und anstatt TRILL würde ich lieber shortest path bridging verwenden wollen, aber ich denke, das ist bei diesem Netz etwas oversized.

Gruß

Anton

Also ohne STP im Backbone kein Alleinstellungsmerkmal von Brocade.

Wer denn noch außer Cisco ??Das konnte Nortel (Accelar 8600) schon lange und Avaya kann es heute noch immer.

Völliger Quatsch und technischer Unsinn !Das bezog sich einzig und allein auf das Splitting von LACP Links, da hatten und haben die mal eine proprietäre Lösung für Split Trunking.

Fairerweise muss man aber sagen das die die ersten mit dieser innovativen Lösung waren und lange Zeit auf die Einzigen. Das können alle anderen mittlerweisle aber nun auch.

Mit Stacks hat sich das so oder so fast erledigt.

Hier geht es aber um eine voll-, oder teilvermaschte Backbone Infrastruktur ohne Spanning Tree für das diese LACP Funktion völlig unbrauchbar ist.

Also erstmal lesen und dann antworten...

Und anstatt TRILL würde ich lieber shortest path bridging verwenden wollen

Warum ? Weil Avaya kein Trill kann ?? Was sollte der Vorteil sein ? SPB und Trill machen faktisch das gleiche wobei Trill ein paar mehr Vorteile hat aber nur minimal.Mal ehrlich Avaya ist ein absoluter Nischenplayer der im Bereich RZ Netzwerke keinerlei relevante Rolle spielt (wobei hier "richtige" Netze gemeint sind und nicht solche mit 2 NetGear Switches und 4 Servern) und steht ja nun nicht gerade für Innovationen im Bereich Netzwerktechnik. Die können tolle Telefonanlagen bauen und verwursten den Rest der Nortel Pleite...mehr aber auch nicht.

Mal ganz abgesehen davon das sie Broadcom und Marvell Standardchips in ihren Switch Produken nutzen also auch da noch nichtmal was eigenes sondern Barebones mit ihrem Firmen Bäppel drauf

TO Wenn es dir um UltraLowLatenz geht schaue dir mal die VDX Serien von Brocade an,

Der XSM7224S von Netgear liefert <1,8 usec das ist doch in Ordnung oder nicht?die sind allerdings auch Meilenweit von der NG Preis-Schiene weg, damit kannst auch

direkt STP aus dem Backbone Bereich tilgen (Zauberwort: TRILL Protokoll bei Brocade)

Der Netgear kann dafür Distributed LAG und das ist meines Erachtens besser denn mit nurdirekt STP aus dem Backbone Bereich tilgen (Zauberwort: TRILL Protokoll bei Brocade)

einem LWL Kabel wird er die bestimmt nicht verbinden wollen. Und die Kosten belaufen sich

auf ~6.500 € mit der Layer3 Lizenz.

Im allgemeinen kannst die Brocade Geräte (ab ICX6450 auch 10Gb) über Twinax Kabel

stacken, die kosten auch nicht viel, zu dem kannst auch Optiken/Kabel von 3.

Anbietern verwenden.

Der XSM7224S hat 24 x SFP+ Ports und 4 x 10 GbE Ports.stacken, die kosten auch nicht viel, zu dem kannst auch Optiken/Kabel von 3.

Anbietern verwenden.

Für 2 Geräte dann das Layer3 Image drauf, VRRP/MRP,

Das kann der Netgear XSM7224S aber auch.Also so wie ich das hier heraus gelesen habe sollte das hier mit zwei XSM7224S und

drei Chassis alles erledigt sein. Das kostet sicher alles Geld ist aber auch nach und nach

umzusetzen.

Gruß

Dobby

.......Was mir daran fehlt ist die Redundanz.

Das muss man natürlich auch wissen, das Ihr das alles redundantbraucht.

Die 7300er Backbone Switche sind in jedem Fall ein Single-Point-of-Failure.

Hier mal unsere aktuelle Struktur:

Das kommt auf Dein Portemonnaie anHier mal unsere aktuelle Struktur:

Vor einiger Zeit gab es den 7300er noch als Starter Kit für ~9.000 € aber die Aktion

ist nun vorbei und man kann sie auch noch für ~12.000 € erwerben und hat immer

noch gegenüber dem original Preis von ~16.500 € gespart.

Netgear Starter Kit 1 Netgear Starter Kit 2 (PoE)

Man kann bis zu 4 XSM7224S zu einem Stapel (Stack) zusammen fassen

auch wenn sie als Core genutzt werden, also Redundanz ist schon da nur

das liebe Geld ist meist knapp.

Gruß

Dobby

: Quellenhinweis- und Bildquellen : Netgear Deutschland

Hallo @108012

durch das TRILL von BC kann ja so viele Kabel zum anderen Switch stecken wie du magst ohne LACP oder STP einstellen zu müssen das ist ja der Vorteil daran, die Switche belasten jede verfügbare Leitung gleichmäßig du hast keine Leitung "tot" liegen (wenn z.B. 2 Leitungen zur Verbindung der beiden Switche hast - oder 1+ x LACP Trunkts weil du unbedingt 24 x 10Gb zwischen den Switche benötigst, das Protokoll handelt das dann aus) - du könntest dir damit theoretisch einen Ring bauen ...das ist der Vorteil von (bei Brocade) TRILL.

das ist ja der Vorteil daran, die Switche belasten jede verfügbare Leitung gleichmäßig du hast keine Leitung "tot" liegen (wenn z.B. 2 Leitungen zur Verbindung der beiden Switche hast - oder 1+ x LACP Trunkts weil du unbedingt 24 x 10Gb zwischen den Switche benötigst, das Protokoll handelt das dann aus) - du könntest dir damit theoretisch einen Ring bauen ...das ist der Vorteil von (bei Brocade) TRILL.

PS

Die Kisten haben allerdings mit dem aktuelle FW Stand den riesen Nachteil: 5-10 Minuten Bootzeit bis die Ports aktiv sind (und das bei "FastBoot" Optionen) das ist selbst der ranzigste ESXi auf einem USB1.0 Stick schneller gebootet ...

durch das TRILL von BC kann ja so viele Kabel zum anderen Switch stecken wie du magst ohne LACP oder STP einstellen zu müssen

PS

Die Kisten haben allerdings mit dem aktuelle FW Stand den riesen Nachteil: 5-10 Minuten Bootzeit bis die Ports aktiv sind (und das bei "FastBoot" Optionen) das ist selbst der ranzigste ESXi auf einem USB1.0 Stick schneller gebootet ...

Das liegt immer am Anbieter ob man nur die originalen SFP's verwenden darfst/kannst oder nicht. Viele Hersteller lehnen dann auch erst einmal Support ab (leisten den dann aber trotzdem). Einige haben eine Vendorlock auf den SFP's, d.h. die funktionieren dann nur mit den "originalen" Modulen (sind eh oft Finisar oder ähnliche).

Auf dem freien Markt gibt es aber auch Hersteller die dir SFPs mit entsprechender Vendor ID liefern zu bedeutend günstigeren Preisen wie es der Hersteller macht (bei Brocade sitzen da mal schnell 50-80% Ersparnis drin, wenn freie SFP's nimmt).

Und zu deiner Frage: ja du musst jeden EDGE/Access Switch mit dem Core verbinden, am besten mit 2 Leitungen, wobei jede auf einen anderen Switch im Stack geht (an 2 unterschiedlichen Geräten reicht hier aus, wenn dir mehr wie ein Gerät zur gleichen Zeit um die Ohren fliegt hast sicherlich andere Probleme), damit schaffst du schon eine sehr hoher Ausfallsicherheit, wenn die Geräte dann auch noch alle 2 Netzteile oder über eine PSU Einheit eine zweite Stromversorgung bekommen umso besser. Man kann das noch weiter ausbauen in dem man den Stack in 2 Brandabschnitte splittet und dann jeweils eine Verbindung zum einen Core und dann eine zu 2. Core zieht... Ausbaumöglichkeiten gibt es sehr viele - denk an die USV's die du dann auch benötigst, zusätzlich eine managebare PDU Schiene um ggf. mal einen Switch im Stack rebooten zu können wenn der nicht mehr reagiert

- denk an die USV's die du dann auch benötigst, zusätzlich eine managebare PDU Schiene um ggf. mal einen Switch im Stack rebooten zu können wenn der nicht mehr reagiert

Auf dem freien Markt gibt es aber auch Hersteller die dir SFPs mit entsprechender Vendor ID liefern zu bedeutend günstigeren Preisen wie es der Hersteller macht (bei Brocade sitzen da mal schnell 50-80% Ersparnis drin, wenn freie SFP's nimmt).

Und zu deiner Frage: ja du musst jeden EDGE/Access Switch mit dem Core verbinden, am besten mit 2 Leitungen, wobei jede auf einen anderen Switch im Stack geht (an 2 unterschiedlichen Geräten reicht hier aus, wenn dir mehr wie ein Gerät zur gleichen Zeit um die Ohren fliegt hast sicherlich andere Probleme), damit schaffst du schon eine sehr hoher Ausfallsicherheit, wenn die Geräte dann auch noch alle 2 Netzteile oder über eine PSU Einheit eine zweite Stromversorgung bekommen umso besser. Man kann das noch weiter ausbauen in dem man den Stack in 2 Brandabschnitte splittet und dann jeweils eine Verbindung zum einen Core und dann eine zu 2. Core zieht... Ausbaumöglichkeiten gibt es sehr viele

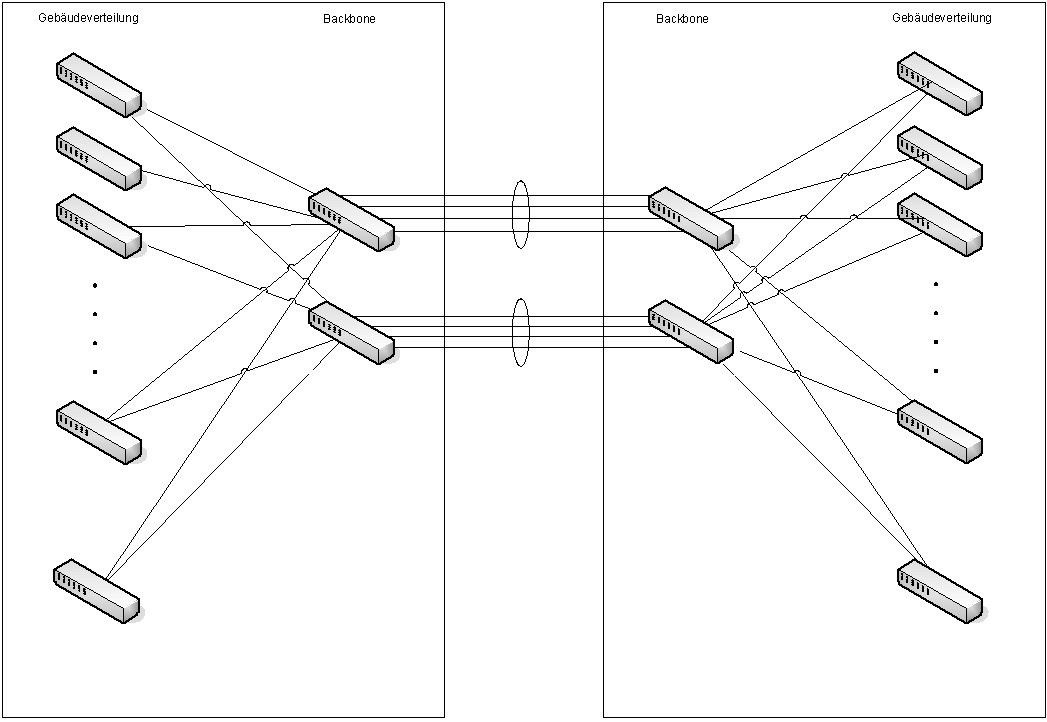

Zu der zweiten Grafik habe ich noch ein paar Fragen:

In meinem Fall ist die Verbindung der Etagenswitche zu dem jeweils anderen

Coreswitch nicht möglich, da es sich um zwei Gebäude handelt, die per LWL-Kabel

Verbunden sind (Verbindung der Backbones). D.h. jeder Etagenswitch muss dann

an die Backbones darüber gehen.

Ja genau so verhält es sich, man nimmt ein paar Switche und stapelt diese im RingIn meinem Fall ist die Verbindung der Etagenswitche zu dem jeweils anderen

Coreswitch nicht möglich, da es sich um zwei Gebäude handelt, die per LWL-Kabel

Verbunden sind (Verbindung der Backbones). D.h. jeder Etagenswitch muss dann

an die Backbones darüber gehen.

zu einem Stapel (Stack) zusammen und dieser Stapel muss dann auf jeden Fall an

den einen XSM7224S oder auch zwei XSM7224S angeschlossen werden, aber

egal ob zwei oder vier XSM7224S benutzt werden, als Core, kann man natürlich

auch diese zu einem Stapel mit maximal 4 XSM7224S zusammen fassen!

Jenachdem was für eine Portdichte benötigt wird. Lokal (pro Gebäude)

kann man diese dann auch via 10 GbE Ports (Kupfer) stapeln und behält

noch recht viele SFP+ zur Anbindung über.

Das Stacking der Etagenswitche bringt doch "nur" einen Performancesteigerung bei der

Kommunikation innerhalb des Stacks (40G anstatt 10G ohne Stack), oder?

- Man spart Ports!Kommunikation innerhalb des Stacks (40G anstatt 10G ohne Stack), oder?

- Man steigert den Durchsatz!

- Man verringert den Ausfall (Ring/Stack)

- Man vermindert den Konfigurationsaufwand.

Ich muss deshalb trotzdem (um volle redundanz zu haben)

jeden Etagenswitch mit dem Core verbinden, oder?

- Man kann die Etagenswitche (Access Switche) zu einem Stapel zusammen fassenjeden Etagenswitch mit dem Core verbinden, oder?

und dann nur einen Switch mit dem Core verbinden oder aber mehrere bis hin zu allen

Switchen des Stapels (Stack) mit dem Core Switch verbinden und sogar noch die

Stapel untereinander verbinden, eben so viel Redundanz man braucht.

Und noch eine andere Frage: Ist SFP-Modul gleich SFP-Modul?

Also sind die Module Herstellerübergreifen kompatibel?

Es kann sein aber es ist meist nicht der Fall! Die SFP TransceiverAlso sind die Module Herstellerübergreifen kompatibel?

können mittels einer Software im ROM dazu gezwungen werden nur

mit den eigenen Switchen zu funktionieren und es gibt natürlich auch

SFP(+) Transceiver die an vielen Switchen funktionieren bis hin zu

Transceivern von so genannten Drittherstellern die zu fast allem

kompatibel sind.

Noch etwas was mir aufgefallen ist;

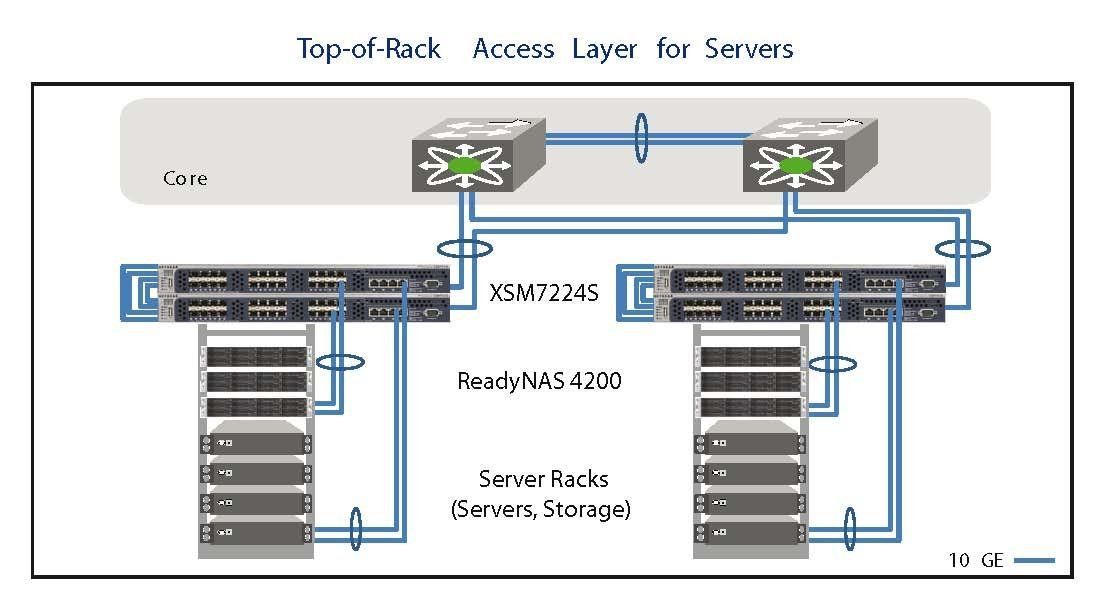

- Dieser Switch (XSM7224) kann sowohl zur Anbindung für SAN, NAS oder Server

benutzt werden (Layer2+) oder aber mittels der Layer3 Lizenz als "kleiner" Core Switch

genutzt werden, aber obwohl dieser ein Store and Forward Switch ist, liegen die Latenzen

bei <1,8 usec und das sollte dicke reichen für ein kleines bzw. ein mittleres Unternehmen,

also einem aus dem so genannten KMU Umfeld.

Gruß

Dobby

Hallo noch mal,

an diesen Stack anbinden oder aber auch direkt an die Core Switches anbinden

oder aber extra Layer2+ Switche benutzen die man nur zur Serveranbindung

benutzt, so wie in dem ersten Bild von mir, erste Zeichnung (ganz oben) in

Gebäude A!

zurück sichern, fertig.

Gruß

Dobby

In meinem Fall würde ich 2 Stacks (pro Gebäude) a 8x 24 Port Swtiche

(gleich welcher Hersteller) benötigen. Wo würdet IHR in meinem Fall die

Servertechnik anbinden?

In dem ersten Bild von mir Zeichnung 1 (von oben) Gebäude A.(gleich welcher Hersteller) benötigen. Wo würdet IHR in meinem Fall die

Servertechnik anbinden?

Logischerweise wäre es innerhalb des Stacks die schnellste Verbindung,

dass ist aber aufgrund der 2 Häuser und verteilten Server nicht möglich.

Wenn Du pro Haus einen Stapel (Stack) anlegst kann man die Server direktdass ist aber aufgrund der 2 Häuser und verteilten Server nicht möglich.

an diesen Stack anbinden oder aber auch direkt an die Core Switches anbinden

oder aber extra Layer2+ Switche benutzen die man nur zur Serveranbindung

benutzt, so wie in dem ersten Bild von mir, erste Zeichnung (ganz oben) in

Gebäude A!

Dann also am besten an die Backbones?

Ist auch eine Möglichkeit.Und allgemein zum Stack:

- Was passiert wenn ein Switch dazwischen sich "aufhängt"?

Ist dieser dann einfach im Betrieb zu tauschen? Bzw. Firmwareupdates...

Einstellungen sichern, Firmware aufspielen und dann die Einstellungen- Was passiert wenn ein Switch dazwischen sich "aufhängt"?

Ist dieser dann einfach im Betrieb zu tauschen? Bzw. Firmwareupdates...

zurück sichern, fertig.

Gruß

Dobby

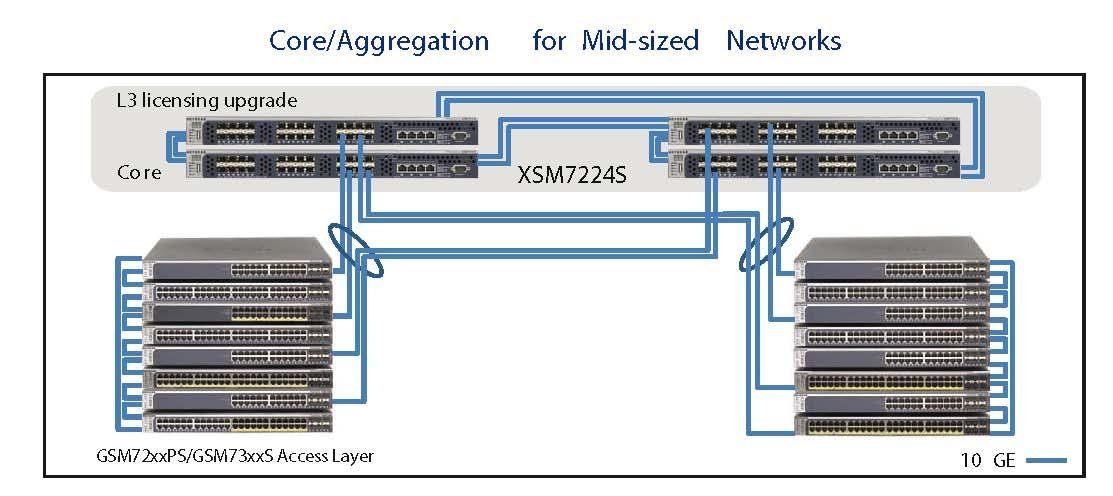

Wobei mich der Sinn bei 8 x 24P Switche im Stack nicht erschließt - kannst du da nicht besser 4 x 48P nehmen? Im Endeffekt hast dann sogar mehr Ports frei und brauchst im Backbone weniger Uplinkports....

@clemens-der-vierte spätestens wenn man nach ISO9001 zertifiziert wird muss/sollte man das haben, erleichtert es ungemein wenn man 2 RZ aufweisen kann, wir haben auch 2, wobei im 2. nur das Backup und ein kleiner Teil der IT steht - halt nur das was für einen Notbetrieb notwendig ist (DB Server, Exchange Storage usw.).

@clemens-der-vierte spätestens wenn man nach ISO9001 zertifiziert wird muss/sollte man das haben, erleichtert es ungemein wenn man 2 RZ aufweisen kann, wir haben auch 2, wobei im 2. nur das Backup und ein kleiner Teil der IT steht - halt nur das was für einen Notbetrieb notwendig ist (DB Server, Exchange Storage usw.).

Wobei mich der Sinn bei 8 x 24P Switche im Stack nicht erschließt - kannst du da nicht besser 4 x

48P nehmen? Im Endeffekt hast dann sogar mehr Ports frei und brauchst im Backbone weniger

Uplinkports....

Dem schließe ich mich auch an, also die GSM7252S und GSM7252PS Switche kommen sogar48P nehmen? Im Endeffekt hast dann sogar mehr Ports frei und brauchst im Backbone weniger

Uplinkports....

mit 52 Ports daher weil sie 2 SFP+ Ports extra zur Verfügung stellen und an denen kann man dann

die Server anbinden oder aber auch damit die Uplinks zum Core gestalten.

Schau Dir mal das Bild Nr. 1 von mir genau an, dort sind auch noch kleinere Switche mit Namen

abgebildet die extra zur günstigen Anbindung von Servern, SAN und NAS angedacht sind!

Die Switche haben auch GbE RJ45 Ports für die man keine SFP+ Transceiver benötigt.

und die 10 GbE Netzwerkkarten für Server kommen auch günstiger.

XS 708E ~750 €

8 GbE Ports Switch - nicht verwaltet

XS 712T ~1.600 €

12 GbE Ports Smart Switch

XSM7224 ~5.200 €

24 GbE Ports Switch - verwaltet

und mittels dieser Switche werden die Server dann eben an den Stack

oder gleich an einen der Core Switche angebunden.

Gruß

Dobby

Klar betrifft es dann 48 Personen, aber der Verwaltungsaufwand, Stromverbrauch, Downtime bei Patches einspielen, USV's (größere müssen her), abgegebene Wärme usw. ist viel größer. Die Wahrscheinlichkeit das dir ein Switch ausfällt geht fast gegen null.

Wie auch schon vorab von mir beschrieben verlierst bei jedem Switch mindestens 2 Ports für den Uplink - macht bei 8 Switche = 16P und bei 4 Switchen nur 8 Ports, du kannst dann die Geräte im Core kleiner machen und evtl. dann dort eine Leistungsklasse höher gehen...Und Switchports "brach" liegen zu lassen ist pure Geldverschwendung, ich kaufe ja auch kein 196 Port Modularswitch wenn ich nur 50 Ports benötige (nicht auf deinen Fall bezogen )

)

Die Begründung mit dem Ausfall ist unberechtigt, klar kann das passieren, aber dann müsstest auch jeden Platz 2 x ausstatten, da kannst besser ein Gerät im Schrank liegen haben (haben wir von jedem Core und Aggregations Switch, bzw. unser Hardwarelieferant hält die "teuren Kisten" vor, so dass wir in max 2h ein neues Gerät haben).

Du kannst natürlich alles im Netz kaufen und dann evtl. 10% sparen, aber der Preis ist nicht immer entscheidend, wenn wir planen FW Updates zu fahren und einen vollständigen Versionssprung machen, bekommen wir Hardware zu testen gestellt usw. - aber egal das gehört hier nicht her

Wie auch schon vorab von mir beschrieben verlierst bei jedem Switch mindestens 2 Ports für den Uplink - macht bei 8 Switche = 16P und bei 4 Switchen nur 8 Ports, du kannst dann die Geräte im Core kleiner machen und evtl. dann dort eine Leistungsklasse höher gehen...Und Switchports "brach" liegen zu lassen ist pure Geldverschwendung, ich kaufe ja auch kein 196 Port Modularswitch wenn ich nur 50 Ports benötige (nicht auf deinen Fall bezogen

Die Begründung mit dem Ausfall ist unberechtigt, klar kann das passieren, aber dann müsstest auch jeden Platz 2 x ausstatten, da kannst besser ein Gerät im Schrank liegen haben (haben wir von jedem Core und Aggregations Switch, bzw. unser Hardwarelieferant hält die "teuren Kisten" vor, so dass wir in max 2h ein neues Gerät haben).

Du kannst natürlich alles im Netz kaufen und dann evtl. 10% sparen, aber der Preis ist nicht immer entscheidend, wenn wir planen FW Updates zu fahren und einen vollständigen Versionssprung machen, bekommen wir Hardware zu testen gestellt usw. - aber egal das gehört hier nicht her

Und aus welchem Grund dann die 8 x 24P - der Sinn erschließt sich mir einfach nicht, wenn Ihr ohnehin Ersatzgeräte vor Ort habt ist ein Ausfall ja eher marginal zu betrachten. Anschaffungs- sowie laufende Kosten sind bei der 24er Variante auf jeden Fall höher.

@108012

deine gelisteten Preise, ist das pro Stück oder Summe? Wenn das pro Stück ist, würde ich Cisco, Brocade oder vergleichbares kaufen, die bekommst günstiger

@108012

deine gelisteten Preise, ist das pro Stück oder Summe? Wenn das pro Stück ist, würde ich Cisco, Brocade oder vergleichbares kaufen, die bekommst günstiger