Datendeduplizierung Windows Server - wie sinnvoll?

Hallo zusammen,

da hier sicherlich ein paar Microsoft-Experten sind, habe ich mal eine Frage zur Datendeduplizierung unter Windows Server (2019).

Die Datendeduplizierung habe ich auf einem File-Server aktiviert, weil ich gehofft habe etwas Speicher einzusparen und weil die Beschreibung von Microsoft vielversprechend war.

Auf dem Laufwerk mit den Freigaben waren ca. 100 GB an Daten. Nachdem die Datendeduplizierung aktiviert wurde, erhöhte sich der verbrauchte Speicherplatz auf dem Laufwerk im Laufe der Jahre auf über 250 GB. Da dachte ich schon, die haben aber fleißg gearbeitet. Da ich jetzt an dem System etwas ändern musste, habe ich vorher nochmal eine manuelle Datensicherung angestoßen. Ganz klassisch und unkomprimiert. Stuzig wurde ich dadurch, dass diese Sicherung nur 103 GB hatte. Daraufhin habe ich mir das Volume näher angeschaut und festgestellt, dass der Ordner System Volume Information ca. 174 GB hatte und die anderen drei Freigabeordner gerade mal 77 GB.

Das Alter in Tagen, ab dem dedupliziert werden sollte war auf 7 eingestellt. Rest default.

Klar, 77 GB sind deutlich weniger als 100 GB. Aber wenn für knapp 25GB "Ersparnis" weitere 174 GB in einem anderen Ordner angelegt werden, dann wirkt die Datendeduplizierung doch reichlich sinnfrei, oder?

Habt Ihr auch solche Erfahrungen gemacht? Wo war möglicherweise mein Gedankenfehler/ Konfigurationsfehler?

Schon einmal Danke für Eure Hinweise!

Gruß

pcs

da hier sicherlich ein paar Microsoft-Experten sind, habe ich mal eine Frage zur Datendeduplizierung unter Windows Server (2019).

Die Datendeduplizierung habe ich auf einem File-Server aktiviert, weil ich gehofft habe etwas Speicher einzusparen und weil die Beschreibung von Microsoft vielversprechend war.

Auf dem Laufwerk mit den Freigaben waren ca. 100 GB an Daten. Nachdem die Datendeduplizierung aktiviert wurde, erhöhte sich der verbrauchte Speicherplatz auf dem Laufwerk im Laufe der Jahre auf über 250 GB. Da dachte ich schon, die haben aber fleißg gearbeitet. Da ich jetzt an dem System etwas ändern musste, habe ich vorher nochmal eine manuelle Datensicherung angestoßen. Ganz klassisch und unkomprimiert. Stuzig wurde ich dadurch, dass diese Sicherung nur 103 GB hatte. Daraufhin habe ich mir das Volume näher angeschaut und festgestellt, dass der Ordner System Volume Information ca. 174 GB hatte und die anderen drei Freigabeordner gerade mal 77 GB.

Das Alter in Tagen, ab dem dedupliziert werden sollte war auf 7 eingestellt. Rest default.

Klar, 77 GB sind deutlich weniger als 100 GB. Aber wenn für knapp 25GB "Ersparnis" weitere 174 GB in einem anderen Ordner angelegt werden, dann wirkt die Datendeduplizierung doch reichlich sinnfrei, oder?

Habt Ihr auch solche Erfahrungen gemacht? Wo war möglicherweise mein Gedankenfehler/ Konfigurationsfehler?

Schon einmal Danke für Eure Hinweise!

Gruß

pcs

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 63964564881

Url: https://administrator.de/forum/datendeduplizierung-windows-server-wie-sinnvoll-63964564881.html

Ausgedruckt am: 13.07.2025 um 22:07 Uhr

5 Kommentare

Neuester Kommentar

Hi,

ich hab das testweise auf einem Hyper-V Host eingerichtet, und bei 750GB belegten Daten hat er dann nach einiger Zeit 220GB "eingespart" . . . das ist da schon interessant.

Bin dabei Erfahrungswerte zu sammeln, im Internet findet man leider viel Widersprüchliches... Ob auf Hyper-V oder nicht, die einen sagen "JA", die anderen "auf keinen Fall"

Der Test hat gezeigt es kann einiges bringen.

Die Frage nun, in dem Hyper-V gibts ein DC/FS auf dem um die 500GB Daten vorhanden sind.

Sicherlich schon alleine viele Duplikate von Dateien..

Sollte/Kann man dort auch die Deduplizierung installieren/aktivieren?

Welche Nachteile/Probleme können sich aus der Dedup ergeben?

ich hab das testweise auf einem Hyper-V Host eingerichtet, und bei 750GB belegten Daten hat er dann nach einiger Zeit 220GB "eingespart" . . . das ist da schon interessant.

Bin dabei Erfahrungswerte zu sammeln, im Internet findet man leider viel Widersprüchliches... Ob auf Hyper-V oder nicht, die einen sagen "JA", die anderen "auf keinen Fall"

Der Test hat gezeigt es kann einiges bringen.

Die Frage nun, in dem Hyper-V gibts ein DC/FS auf dem um die 500GB Daten vorhanden sind.

Sicherlich schon alleine viele Duplikate von Dateien..

Sollte/Kann man dort auch die Deduplizierung installieren/aktivieren?

Welche Nachteile/Probleme können sich aus der Dedup ergeben?

Ich hatte das mal auf nem 2016er Fileserver und am Ende mehr Probleme als das es geholfen hat. Warum auch immer, hat sich die Deduplizierung aufgehängt und ließ sich dann leider nicht mehr richtig starten.

Viel Ärger für ein bisschen Speicherplatz gewinn.

Wenn man dann z.B. im Hintergrund ein Storagesystem hat, welches von sich aus dedupliziert, dann bringt das eh nix das zusätzlich auf Windows Ebene zu machen.

Viel Ärger für ein bisschen Speicherplatz gewinn.

Wenn man dann z.B. im Hintergrund ein Storagesystem hat, welches von sich aus dedupliziert, dann bringt das eh nix das zusätzlich auf Windows Ebene zu machen.

Moin,

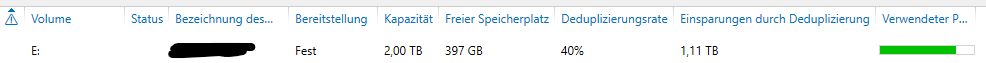

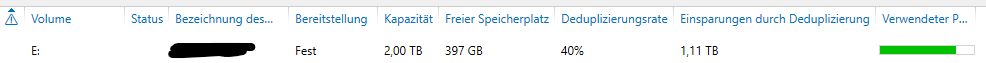

läuft auf einem unserer Fileserver seit etwa 2 Jahren problemlos (Win Server 2016, NTFS auf RAID-5)

2 TB Partition ist mit ~2,7 TB belegt, und immer noch ~400GB frei!

Keine Probleme beim Wiederherstellen von Backups über Dell NetWorker.

Die Deduplizierung basiert auf einzelnen Blöcken, und nicht auf Dateien. Bedeutet es müssen nicht zwangsweise gleiche Dateien sein, sondern gleiche Datei-"Abschnitte", die bereits dedupliziert werden können.

Um zu testen, wie viel die Deduplizierung einsparen könnte, kann man DDPEval verwenden

-Thomas

läuft auf einem unserer Fileserver seit etwa 2 Jahren problemlos (Win Server 2016, NTFS auf RAID-5)

2 TB Partition ist mit ~2,7 TB belegt, und immer noch ~400GB frei!

Keine Probleme beim Wiederherstellen von Backups über Dell NetWorker.

Die Deduplizierung basiert auf einzelnen Blöcken, und nicht auf Dateien. Bedeutet es müssen nicht zwangsweise gleiche Dateien sein, sondern gleiche Datei-"Abschnitte", die bereits dedupliziert werden können.

Um zu testen, wie viel die Deduplizierung einsparen könnte, kann man DDPEval verwenden

-Thomas