Neuer HyperV mit zwei VM und extrem langsam

Hallo,

ich habe hier einen neuen Server mit dieser Konfig

- Windows 2019

- 2 VM's Windows 2019 (je 16 GB RAM, 4 CPU's)

- XEON E-2124 CPU

- 48 GB RAM

- 2x 2TB SAS 7.2k Platten (RAID1)

- LSI MEGA RAID Controller

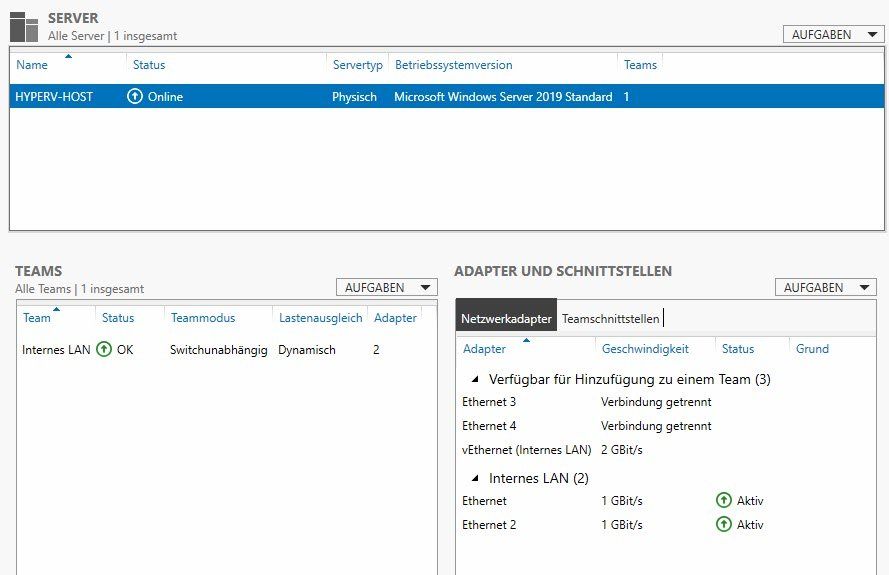

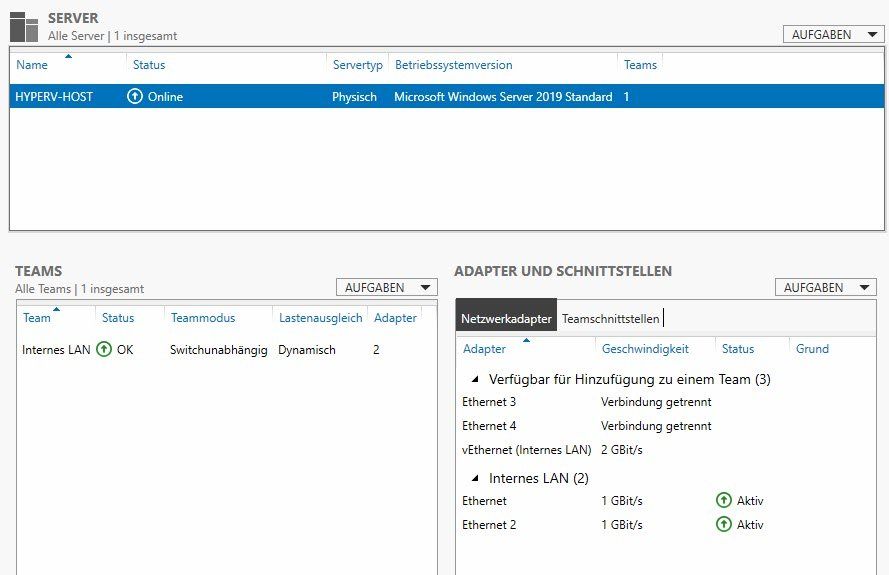

- 2 LAN-Port über den Servermanager als dyna. TEAM konfiguriert

- GDATA Business Client (VM-Dateien ausgeschlossen)

Die beiden Windows 2019 VM's machen eigentlich nur Fileservices. Es gibt keine Domäne

Das Problem ist, daß der Zugriff auf die Daten sehr langsam ist (Zuvor stand da ein alter WIndows 7 PC als Server).

Hat ggf. jemand eine Idee warum der Zugriff so extrem lansam ist?

Die Integrationsdienste sind in den VM Einstellungen alle aktiviert, weiß aber nicht ob die sonst noch irgendwo zu aktivieren.

Gruß, Herry

ich habe hier einen neuen Server mit dieser Konfig

- Windows 2019

- 2 VM's Windows 2019 (je 16 GB RAM, 4 CPU's)

- XEON E-2124 CPU

- 48 GB RAM

- 2x 2TB SAS 7.2k Platten (RAID1)

- LSI MEGA RAID Controller

- 2 LAN-Port über den Servermanager als dyna. TEAM konfiguriert

- GDATA Business Client (VM-Dateien ausgeschlossen)

Die beiden Windows 2019 VM's machen eigentlich nur Fileservices. Es gibt keine Domäne

Das Problem ist, daß der Zugriff auf die Daten sehr langsam ist (Zuvor stand da ein alter WIndows 7 PC als Server).

Hat ggf. jemand eine Idee warum der Zugriff so extrem lansam ist?

Die Integrationsdienste sind in den VM Einstellungen alle aktiviert, weiß aber nicht ob die sonst noch irgendwo zu aktivieren.

Gruß, Herry

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 498641

Url: https://administrator.de/forum/neuer-hyperv-mit-zwei-vm-und-extrem-langsam-498641.html

Ausgedruckt am: 24.07.2025 um 11:07 Uhr

34 Kommentare

Neuester Kommentar

War recht ausführlich bis auf die NIC. Es gibt ein paar Karten die mit HyperV so ihre Problemchen haben, z.B. etliche Modelle von Broadcom.

Den Fall hatte ich schonmal, die wollten einfach nicht performant Daten bereitstellen. Nach einem Austausch gegen eine Intel Server NIC rannte dann alles problemlos.

Oder zweite Option, die Festplatten sind noch am Raid Wiederaufbau oder eine davon tut nicht so wie sie soll.

Den Fall hatte ich schonmal, die wollten einfach nicht performant Daten bereitstellen. Nach einem Austausch gegen eine Intel Server NIC rannte dann alles problemlos.

Oder zweite Option, die Festplatten sind noch am Raid Wiederaufbau oder eine davon tut nicht so wie sie soll.

Moin,

nö, SAS - halt aber nicht die Allerschnellsten

Ich weiss jetzt nicht, was sich an den Systemanforderungen zwischen 2008R2 und 2019 so geändert hat, aber bei mir laufen auf zwei Hyper-V-Büchsen mit jeweils 32 Gbyte, einem E3-1240 sowie 7,2k-SATA Platten 2 respektive 3 Windows VM ziemlich fluffig. Und die CPU sollte ja nicht schneller sein als das o.g. Teil ...

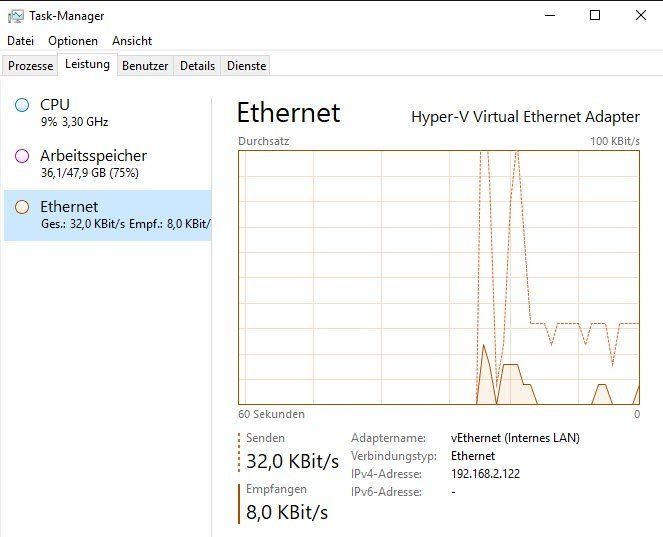

Warum schaust Du nicht erst einmal, was genau da an Last auf den CPU liegt, was an RAM verwendet wird, wie die HDD ausgelastet sind, was da an traffic rübergeht ...

auch 'ne spannende Konfiguration, wenn die CPU nur 4 Kerne + HT bietet . Der Hypervisor braucht ja nix zum Rechnen

. Der Hypervisor braucht ja nix zum Rechnen  - ist aber sicher nicht die Ursache.

- ist aber sicher nicht die Ursache.

Schau erst mal in Ruhe ... ich vermute aber auch eher ein Netzwerkproblem (watt sacht eigentlich das event-log?)

LG, Thomas

SATA Platten

nö, SAS - halt aber nicht die Allerschnellsten

Ich weiss jetzt nicht, was sich an den Systemanforderungen zwischen 2008R2 und 2019 so geändert hat, aber bei mir laufen auf zwei Hyper-V-Büchsen mit jeweils 32 Gbyte, einem E3-1240 sowie 7,2k-SATA Platten 2 respektive 3 Windows VM ziemlich fluffig. Und die CPU sollte ja nicht schneller sein als das o.g. Teil ...

Hat ggf. jemand eine Idee warum der Zugriff so extrem lansam ist?

Warum schaust Du nicht erst einmal, was genau da an Last auf den CPU liegt, was an RAM verwendet wird, wie die HDD ausgelastet sind, was da an traffic rübergeht ...

2 VM's Windows 2019 (je 16 GB RAM, 4 CPU's)

auch 'ne spannende Konfiguration, wenn die CPU nur 4 Kerne + HT bietet

Schau erst mal in Ruhe ... ich vermute aber auch eher ein Netzwerkproblem (watt sacht eigentlich das event-log?)

LG, Thomas

nö, SAS - halt aber nicht die Allerschnellsten

SAS mit 7.2k sind i.d.R nur NL-SAS oder eben umgemodelte SATA - dabei muss man sagen, SATA ist ja nicht schlecht, aber wenn man es einsetzt, muss einem eben auch klar sein, dass SATA-Spindeln nicht die Leistung von SAS oder gar SATA-SSDs bringen. Wie bereits niedergelegt, das System ist nicht gleichmäßig ausbalanciert.

Hi

Was für ein Switch hängt den an dem HyperV ?

Ist der fürs Teaming geeignet / konfiguriert ?

Hast du das teaming mal aufgelöst und ohne probiert bzw ein Kabel mal abgezogen ob es dann schneller wird?

Hast du mal ein paar Dateien direkt auf den HyperV Host kopiert oder heruntergezogen ?

Wie ist hier die preformance ?

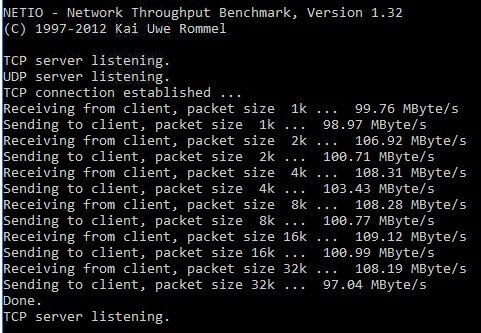

Mal NetIO oder so verwendet um die Netzwerkperformance zu messen ?

Mit freundlichen Grüßen Nemesis

Was für ein Switch hängt den an dem HyperV ?

Ist der fürs Teaming geeignet / konfiguriert ?

Hast du das teaming mal aufgelöst und ohne probiert bzw ein Kabel mal abgezogen ob es dann schneller wird?

Hast du mal ein paar Dateien direkt auf den HyperV Host kopiert oder heruntergezogen ?

Wie ist hier die preformance ?

Mal NetIO oder so verwendet um die Netzwerkperformance zu messen ?

Mit freundlichen Grüßen Nemesis

Hi,

der XEON E-2124 hat doch nur 4 Core und das ohne HT.

ark.intel.com/content/www/de/de/ark/products/134856/intel-xeon-e ...

Wenn Du da jetzt 2 VM's mit je 4 vCPU parallel betreibst, dann ist es klar, dass der Host in die Knie geht. 4 VM's á 2 vCPU wären zwar rein mathematisch die gleiche Überbuchung wie 2x 4 vCPU, würden aber höchstwahrscheinlich trotzdem besser laufen.

Also reduziere die Anzahl vCPU je VM auf 2.

Oder?

E.

der XEON E-2124 hat doch nur 4 Core und das ohne HT.

ark.intel.com/content/www/de/de/ark/products/134856/intel-xeon-e ...

Wenn Du da jetzt 2 VM's mit je 4 vCPU parallel betreibst, dann ist es klar, dass der Host in die Knie geht. 4 VM's á 2 vCPU wären zwar rein mathematisch die gleiche Überbuchung wie 2x 4 vCPU, würden aber höchstwahrscheinlich trotzdem besser laufen.

Also reduziere die Anzahl vCPU je VM auf 2.

Oder?

E.

Zitat von @Akcent:

Die CPU tümpelt aber doch vor sich hin und meiner Info nach sollten die Einstellungen auch so passen. Ich teste das aber gerne mal.

Das ist ja das Gemeine daran. Das sieht man nicht in der CPU-Auslastung sondern in deren Verfügbarkeit. Unter VMware würde man jetzt die cpuready-Werte prüfen. Keine Ahnung, welcher Performance-Counter dem bei Windows Hyper-V entspricht.Die CPU tümpelt aber doch vor sich hin und meiner Info nach sollten die Einstellungen auch so passen. Ich teste das aber gerne mal.

Zitat von @emeriks:

Zitat von @Akcent:

Die CPU tümpelt aber doch vor sich hin und meiner Info nach sollten die Einstellungen auch so passen. Ich teste das aber gerne mal.

Das ist ja das Gemeine daran. Das sieht man nicht in der CPU-Auslastung sondern in deren Verfügbarkeit. Unter VMware würde man jetzt die cpuready-Werte prüfen. Keine Ahnung, welcher Performance-Counter dem bei Windows Hyper-V entspricht.Die CPU tümpelt aber doch vor sich hin und meiner Info nach sollten die Einstellungen auch so passen. Ich teste das aber gerne mal.

Bei Windows 10 hat man da mittlerweile einen Prozess dafür erfunden. Nennt sich vmmem.

Kann jetzt aber nicht testen wie sich das mit dem Server 2019 verhält. Den perfmon sollte es aber noch geben, der zeigt es korrekt.

Moin,

generell würde ich niemanden empfehlen, sowohl den Host als auch die VMs auf einem bzw den gleichen RAID1 zu betreiben.

Das gibt imho bei 2019 generell Performanceprobleme, sofern man administrativ dort mal ein wenig tätig wird. Im normalen Betrieb sollte das aber nicht auffallen (wobei ich das noch nie mit 7,2k HDDs gemacht habe).

Deaktiviere in der Netzwerkkarte mal die ""Warteschlagen für virtuelle Computer" und schaue, ob es dann besser wird.

Gruß

generell würde ich niemanden empfehlen, sowohl den Host als auch die VMs auf einem bzw den gleichen RAID1 zu betreiben.

Das gibt imho bei 2019 generell Performanceprobleme, sofern man administrativ dort mal ein wenig tätig wird. Im normalen Betrieb sollte das aber nicht auffallen (wobei ich das noch nie mit 7,2k HDDs gemacht habe).

Deaktiviere in der Netzwerkkarte mal die ""Warteschlagen für virtuelle Computer" und schaue, ob es dann besser wird.

Gruß

Hallo Akcent,

ich habe vielleicht noch 2 Ansätze, die mir beim Hyper-V schon mal geholfen haben.

Stelle auf jeden Fall die Energieeinstellungen des Hyper-V auf "Höchstleistung". Des weiteren habe ich die Erfahrung gemacht, dass manche Intel-Karten die Teaming-Funktion von Windows nicht mögen. Hier ist die Intelsoftware die bessere Wahl um ein Teaming herzustellen.

VG Karsten

ich habe vielleicht noch 2 Ansätze, die mir beim Hyper-V schon mal geholfen haben.

Stelle auf jeden Fall die Energieeinstellungen des Hyper-V auf "Höchstleistung". Des weiteren habe ich die Erfahrung gemacht, dass manche Intel-Karten die Teaming-Funktion von Windows nicht mögen. Hier ist die Intelsoftware die bessere Wahl um ein Teaming herzustellen.

VG Karsten

Hallo,

folgendes fällt mir auf:

1. Extremes Overprovisioning der CPUs (4 Cores) und dann noch doppelt vergeben!

2. 16 GiB RAM für einen Fileserver?

Hast Du das gleich so gemacht, oder sukzessive erhöht, wegen Performanceproblemen?

Bei Virtualisierung gibt es eine Regel, die heißt soviel wie möglich und so so wenig wie nötig.

Sprich ich hätte 2 vCPUs und 4-8 GiB RAM pro VM gegeben. Wobei bei einem Fileserver sind die IOs wichtig und nicht der Arbeitsspeicher.

Also Platten (SAS, oder gar Fibre Channel) und Netzwerk.

Gruss Penny.

folgendes fällt mir auf:

1. Extremes Overprovisioning der CPUs (4 Cores) und dann noch doppelt vergeben!

2. 16 GiB RAM für einen Fileserver?

Hast Du das gleich so gemacht, oder sukzessive erhöht, wegen Performanceproblemen?

Bei Virtualisierung gibt es eine Regel, die heißt soviel wie möglich und so so wenig wie nötig.

Sprich ich hätte 2 vCPUs und 4-8 GiB RAM pro VM gegeben. Wobei bei einem Fileserver sind die IOs wichtig und nicht der Arbeitsspeicher.

Also Platten (SAS, oder gar Fibre Channel) und Netzwerk.

Gruss Penny.

Zitat von @Penny.Cilin:

Bei Virtualisierung gibt es eine Regel, die heißt soviel wie möglich und so so wenig wie nötig.

´Bei Virtualisierung gibt es eine Regel, die heißt soviel wie möglich und so so wenig wie nötig.

Die Regel heißt "So viel wie nötig, so wenig wie möglich." Just saying...

Ich würde erstmal einen Test mit NetIO machen und den ganzen CPU/HDD Kram außen vor lassen.

/Thomas

Zitat von @hansdampf:

Habe so etwas ähnliches nur das bei mir im Ressourcenmonitor bei der Festplatte immer 100% mit max. Aktivität läuft...

Habe so etwas ähnliches nur das bei mir im Ressourcenmonitor bei der Festplatte immer 100% mit max. Aktivität läuft...

Dann liegt das Problem eher an der eingesetzten Storage Hardware, z.B. Controller Treiber oder HDDs direkt. Würde das Problem am Netzwerk liegen könnte der Prozess die Fesplatten gar nicht auslasten da schon vorher zu wenig Bandbreite durchkommt.

Würde mal lokal testen was der Speicher an IOs hergibt mit einem Benchmark, z.B. CrystalDiskMark.