Sicherung bei großen VMs mit Veeam

Moin zusammen,

ich hatte letztens bei einem Kunden das Problem, dass eine schnelle File Rücksicherung nicht mehr möglich war, da die VM des Fileservers so groß war, dass es alleine um den Sicherungsjob zu öffnen schon ca. 1 Std gebraucht hat. Jetzt Frage ich mich, wie ich hier am Besten vorgehe bei der Sicherung, um auch mal schnell eine Datei wieder zurücksichern zu können, falls Ihr da eine Möglichkeit kennt.

Umfeld:

- VMware

- VM mit 6 Platten die zusammen ca. 20 TB haben

- Sicherung mit Veeam Backup & Replication -> inkrementelle Sicherung (Die Sicherungsdatei hat ca. 16 TB + die inkrementellen Sicherungen)

Kenn Ihr da eine Methode? Das dauert alles so ewig, weil Veeam hier ja die Sicherung von 16TB erst mal reinladen muss in den FLR. Dazu musste ich sogar in die Registry eingreifen und den InactiveFLRSessionTimeout hochstellen, da sonst einfach irgendwann der Prozess wieder abgebrochen wurde :D

Oder ist hier die generell gängigste Methode auch einfach mal über einen zweiten Fileserver sich Gedanken zu machen?

ich hatte letztens bei einem Kunden das Problem, dass eine schnelle File Rücksicherung nicht mehr möglich war, da die VM des Fileservers so groß war, dass es alleine um den Sicherungsjob zu öffnen schon ca. 1 Std gebraucht hat. Jetzt Frage ich mich, wie ich hier am Besten vorgehe bei der Sicherung, um auch mal schnell eine Datei wieder zurücksichern zu können, falls Ihr da eine Möglichkeit kennt.

Umfeld:

- VMware

- VM mit 6 Platten die zusammen ca. 20 TB haben

- Sicherung mit Veeam Backup & Replication -> inkrementelle Sicherung (Die Sicherungsdatei hat ca. 16 TB + die inkrementellen Sicherungen)

Kenn Ihr da eine Methode? Das dauert alles so ewig, weil Veeam hier ja die Sicherung von 16TB erst mal reinladen muss in den FLR. Dazu musste ich sogar in die Registry eingreifen und den InactiveFLRSessionTimeout hochstellen, da sonst einfach irgendwann der Prozess wieder abgebrochen wurde :D

Oder ist hier die generell gängigste Methode auch einfach mal über einen zweiten Fileserver sich Gedanken zu machen?

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 574113

Url: https://administrator.de/forum/sicherung-bei-grossen-vms-mit-veeam-574113.html

Ausgedruckt am: 31.07.2025 um 08:07 Uhr

19 Kommentare

Neuester Kommentar

Moin.

windowspro.de/andreas-wienhusen/schattenkopien-vorgaengerversion ...

Keine Ahnung, ob Veeam da beim Backup ein Problem mit hat. Beim DPM muss VSS auf dem gleichen Volume konfiguriert werden, auf dem auch die Files selbst liegen, sonst knallt's beim Backup. Aber prinzipiell geht das Wiederherstellen einzelner Dateien mit Previous Versions verdammt schnell. Und du könntest das sogar die User selbst machen lassen (klappte in der Vergangenheit nach kurzer Schulung recht gut).

Das Aufsplitten auf zwei Fileserver will gut überlegt sein, vor allem, wenn sich dadurch die Anzahl der Netzlaufwerke/die Laufwerksbuchstaben bei den Usern ändern. So banal das klingen mag, ein solches Vorgehen hat schon mehrfach zu Diskussionen geführt, es wurde zum Politikum: "Die doofe IT ändert etwas an _meinem!_ System, das geht ja mal gar nicht". Technisch gesehen wäre es sicherlich sinnvoll.

Cheers,

jsysde

Zitat von @TIM589:

[...]Jetzt Frage ich mich, wie ich hier am Besten vorgehe bei der Sicherung, um auch mal schnell eine Datei wieder zurücksichern zu können[...]

Previous Versions?[...]Jetzt Frage ich mich, wie ich hier am Besten vorgehe bei der Sicherung, um auch mal schnell eine Datei wieder zurücksichern zu können[...]

windowspro.de/andreas-wienhusen/schattenkopien-vorgaengerversion ...

Keine Ahnung, ob Veeam da beim Backup ein Problem mit hat. Beim DPM muss VSS auf dem gleichen Volume konfiguriert werden, auf dem auch die Files selbst liegen, sonst knallt's beim Backup. Aber prinzipiell geht das Wiederherstellen einzelner Dateien mit Previous Versions verdammt schnell. Und du könntest das sogar die User selbst machen lassen (klappte in der Vergangenheit nach kurzer Schulung recht gut).

Das Aufsplitten auf zwei Fileserver will gut überlegt sein, vor allem, wenn sich dadurch die Anzahl der Netzlaufwerke/die Laufwerksbuchstaben bei den Usern ändern. So banal das klingen mag, ein solches Vorgehen hat schon mehrfach zu Diskussionen geführt, es wurde zum Politikum: "Die doofe IT ändert etwas an _meinem!_ System, das geht ja mal gar nicht". Technisch gesehen wäre es sicherlich sinnvoll.

Cheers,

jsysde

Hallo,

Schattenkopie hilft nicht immer und nicht überall.

Ich verwende es bei allen Kunden und schaue auch zuerst ob man nicht da eine Datei oder Verzeichnis herbekommt.

In der Regel so mit 10% der Gesamtkapazität.

Aber (oder zumindest mein Aber):

Ein Cryptotrojaner verschlüsselt z.B. alle Deine Dateien weil er das ganze Wochenende dazu Zeit hatte.

Dann muss der Speicherplatz für die Schattenkopien auch mindestens 20TB groß sein. Er schmeist sonst ältere Dateien raus wenn er neue (verschlüsselte) hinzufügt.

Zu Veeam

Wiederherstellen einer ganzen VM

Ich habe noch keine VM wiederhergestellt mit 20TB, aber zumindest ein paar TB sind kein Problem.

Mit dem Instant-Recovery kann man die VM auch direkt aus dem Backup starten.

Wiederherstellen einer Datei

Ja, das kann ich mir vorstellen. Das Problem dürfte aber weniger die Größe von 20TB sein, sondern dass es vermutlich 2.000.000.000 Dateien sind. Das Starten der VM aus dem Backup könnte hier schneller sein.

Schattenkopie hilft nicht immer und nicht überall.

Ich verwende es bei allen Kunden und schaue auch zuerst ob man nicht da eine Datei oder Verzeichnis herbekommt.

In der Regel so mit 10% der Gesamtkapazität.

Aber (oder zumindest mein Aber):

Ein Cryptotrojaner verschlüsselt z.B. alle Deine Dateien weil er das ganze Wochenende dazu Zeit hatte.

Dann muss der Speicherplatz für die Schattenkopien auch mindestens 20TB groß sein. Er schmeist sonst ältere Dateien raus wenn er neue (verschlüsselte) hinzufügt.

Zu Veeam

Wiederherstellen einer ganzen VM

Ich habe noch keine VM wiederhergestellt mit 20TB, aber zumindest ein paar TB sind kein Problem.

Mit dem Instant-Recovery kann man die VM auch direkt aus dem Backup starten.

Wiederherstellen einer Datei

Ja, das kann ich mir vorstellen. Das Problem dürfte aber weniger die Größe von 20TB sein, sondern dass es vermutlich 2.000.000.000 Dateien sind. Das Starten der VM aus dem Backup könnte hier schneller sein.

Hallo,

wenn Du agentenbasiert sicherst, könnte man die Freigabeordner auf mehrere Jobs aufteilen.

Gruß,

Jörg

wenn Du agentenbasiert sicherst, könnte man die Freigabeordner auf mehrere Jobs aufteilen.

Gruß,

Jörg

Moin,

mich würde mal interessieren, wie lange die Sicherung läuft.

Das Tempo beim Mounten Deiner Sicherungskette hängt nicht nur von den Kettengliedern ab, sondern auch vom Medium auf dem gespeichert wird und auf dem gemountet werden soll.

Wenn Du auf Band sicherst, wundere ich mich nicht, dass der Krempel erst mal vollständig rübergeschaufelt werden muss.

mich würde mal interessieren, wie lange die Sicherung läuft.

Das Tempo beim Mounten Deiner Sicherungskette hängt nicht nur von den Kettengliedern ab, sondern auch vom Medium auf dem gespeichert wird und auf dem gemountet werden soll.

Wenn Du auf Band sicherst, wundere ich mich nicht, dass der Krempel erst mal vollständig rübergeschaufelt werden muss.

Mahlzeit.

Fürs Protokoll: Meine Erfahrungen besagen, dass genau diese Kombi meist die Hauptursache für Performance-Probleme ist. Ohne Details zu kennen ist das natürlich hier nicht belastbar; bitte nur als allgemeinen Gedanken verstehen...

Cheers,

jsysde

Fürs Protokoll: Meine Erfahrungen besagen, dass genau diese Kombi meist die Hauptursache für Performance-Probleme ist. Ohne Details zu kennen ist das natürlich hier nicht belastbar; bitte nur als allgemeinen Gedanken verstehen...

Cheers,

jsysde

Zitat von @TIM589:

Die Medium sowie Netzwerkgeschwindigkeit wird nicht das Problem sein das ist alles auf Gbit und auf eine NAS. Außerdem ist ja eh nur ein Vollbackup da und dann nur noch kleine inkrementelle Backups, damit ist der Job innerhalb kürzester Zeit durch.

Die Medium sowie Netzwerkgeschwindigkeit wird nicht das Problem sein das ist alles auf Gbit und auf eine NAS. Außerdem ist ja eh nur ein Vollbackup da und dann nur noch kleine inkrementelle Backups, damit ist der Job innerhalb kürzester Zeit durch.

Gigabit ist bei der Größe nicht wirklich schnell. Ich bevorzuge Direct Access an SAN und Sicherung per 10 Gigabit. Denn das Gigabit ist da schon der Flaschenhals.... und wenn du dann noch ein langsames NAS hast hört es auf

Servus.

Naja, prinzipiell muss ein NAS nix schlechtes sein - wenn man nicht so ein 2-Bay-Teil aus der Krabbelkiste beim Discounter nimmt.

10G-Anbindung, ggf. iSCSI, brauchbare CPU und ausreichend RAM sowie entsprechende Plattenkapazität kosten halt meist mehr, als Kunden landläufig mit dem Begriff "NAS" assoziieren. Wenn kein 10G möglich ist, dann zumindest ein Trunk aus mind. 2x1G, um hier keinen Flaschenhals zu haben - bei Datenbeständen in TB-Größen ist 1G am Ende des Tages genau das.

Cheers,

jsysde

Naja, prinzipiell muss ein NAS nix schlechtes sein - wenn man nicht so ein 2-Bay-Teil aus der Krabbelkiste beim Discounter nimmt.

10G-Anbindung, ggf. iSCSI, brauchbare CPU und ausreichend RAM sowie entsprechende Plattenkapazität kosten halt meist mehr, als Kunden landläufig mit dem Begriff "NAS" assoziieren. Wenn kein 10G möglich ist, dann zumindest ein Trunk aus mind. 2x1G, um hier keinen Flaschenhals zu haben - bei Datenbeständen in TB-Größen ist 1G am Ende des Tages genau das.

Cheers,

jsysde

Moin FA-jka,

hast du schon jemals einen 16TB+ Dateibestand agentenbasiert gesichert?

Das ist alles andere als eine Gute Idee, da die Backupzeiten dadurch explodieren würden, alleine schon dadurch, weil agentenbasiert z.B. kein CBT verfügbar ist. 😉

Grüsse aus BaWü

Alex

wenn Du agentenbasiert sicherst, könnte man die Freigabeordner auf mehrere Jobs aufteilen.

hast du schon jemals einen 16TB+ Dateibestand agentenbasiert gesichert?

Das ist alles andere als eine Gute Idee, da die Backupzeiten dadurch explodieren würden, alleine schon dadurch, weil agentenbasiert z.B. kein CBT verfügbar ist. 😉

Grüsse aus BaWü

Alex

Moin TIM589,

16+ TB an Daten ist jetzt nicht so erschreckend, aber auf einer Maschine ist das schon ein riesen Brocken und auch der Hauptgrund für dein Problem.

Aber du bist nicht der Einzige, der mit solchen Fällen zu kämpfen hat, das kann ich dir auf jeden Fall bestätigen.

Eine sehr gute Lösung um auf grösseren Dateiservern eine (Einzel)Dateiwiederherstellung schnell zu gewährleisten, sind wie schon vorgeschlagen die Schattenkopien. Helfen nicht immer, aber sehr sehr häufig.

Wenn ich viele Einzeldateien wiederherstellen muss, dann verwende ich öfters auch den Trick, dass ich die Gesamte VHD oder VHDX an einen anderen Ort wiederherstelle und diese dann zusätzlich an den bestehenden Server als neue Platte hinzufüge und dann per Hand die Daten zurückschaufle. Kann in der einen oder anderen Konstellation viel schneller laufen, als über den Filelevelrestore, setzt aber genügend freien Platz voraus.

Theoretisch könntest du durch die Indexierung der Backupdaten die Wiederherstellung im Filelevelrestore-Modus deutlich verbessern, aber das würde ich dir bei dieser Dattengrössen nicht mal ansatzweise empfehlen. Zum einen verlängert sich durch die Indexierung der zur sichernden Daten, die Backupzeit in Summe gewaltig. Zum anderen belegen die Daten die bei der Indexierung erzeugt werden extrem viel Platz in der SQL DB von Veeam. Wenn du Veeam auf SQL Express (Standard bei Veeam) aufgesetzt hast, dann ist deine Veeam-DB bei deinen Datenbeständen bereits nach der ersten Sicherung beim 10GB Limit angekommen.

Ich denke kaum, dass sich dein Problem nur durch einen Trick lösen lässt, aber es ist generell machbar. Als erstes würde ich dir vorschlagen die Schattenkopien zu aktivieren, dies ist mit einem sehr überschaubaren Aufwand realisiert und bring schon Mal wirklich sehr viel.

Als nächstes solltest du dir überlegen ob du die Daten nicht auf mehrere Server verteilen kannst.

Kleinere VMs lassen sich viel schneller sichern und auch wiederherstellen.

Dieser Schritt ist aber nicht ganz ohne. Ich unterstütze gerade selbst bei einer Fileserverumstellung von einem ähnlich grossen Datenbestand, der bei dem Kunden über die letzten +- 20 Jahre historisch gewachsen ist. Es ist schon mitunter lustig zu sehen wie die Daten gewachsen sind, aber spassig ist diese ganze Angelegenheit dennoch nicht. Im Gegenteil, es ist im Nachgang nicht immer ganz einfach alles Nachzuvollziehen, vor allem wenn die Mitarbeiter, die sich die vorherige Struktur ausgedacht haben nicht mehr im Unternehmen tätig sind und du bei jedem zweiten Ordner nur zu hören bekommst „das war vor meiner Zeit, da kenne ich mich nicht aus“. 😭

So hart das Ganze auch ist, es muss am Ende des Tages gemacht werden.

Ich habe noch kein Unternehmen erlebt, das aktuell weniger Daten generiert wie in der Vergangenheit. Im Gegenteil der Bedarf an Speicherplatz wächst meinem Gefühl nach nicht mal linear, sondern exponentiell. Wenn du nicht rechtzeitig handelst, dann kommst du später vielleicht in die Bredouille, dass sich der Fileserver in einer annehmbaren Zeit, sich gar nicht mehr sichern lässt oder dass in einem Notfall die Wiederherstellung inakzeptabel lange dauert. Habe beides schon miterleben dürfen, ist alles andere als schön, vor allem wenn die Hütte gerade brennt.

Grüsse aus BaWü

Alex

16+ TB an Daten ist jetzt nicht so erschreckend, aber auf einer Maschine ist das schon ein riesen Brocken und auch der Hauptgrund für dein Problem.

Aber du bist nicht der Einzige, der mit solchen Fällen zu kämpfen hat, das kann ich dir auf jeden Fall bestätigen.

Eine sehr gute Lösung um auf grösseren Dateiservern eine (Einzel)Dateiwiederherstellung schnell zu gewährleisten, sind wie schon vorgeschlagen die Schattenkopien. Helfen nicht immer, aber sehr sehr häufig.

Wenn ich viele Einzeldateien wiederherstellen muss, dann verwende ich öfters auch den Trick, dass ich die Gesamte VHD oder VHDX an einen anderen Ort wiederherstelle und diese dann zusätzlich an den bestehenden Server als neue Platte hinzufüge und dann per Hand die Daten zurückschaufle. Kann in der einen oder anderen Konstellation viel schneller laufen, als über den Filelevelrestore, setzt aber genügend freien Platz voraus.

Theoretisch könntest du durch die Indexierung der Backupdaten die Wiederherstellung im Filelevelrestore-Modus deutlich verbessern, aber das würde ich dir bei dieser Dattengrössen nicht mal ansatzweise empfehlen. Zum einen verlängert sich durch die Indexierung der zur sichernden Daten, die Backupzeit in Summe gewaltig. Zum anderen belegen die Daten die bei der Indexierung erzeugt werden extrem viel Platz in der SQL DB von Veeam. Wenn du Veeam auf SQL Express (Standard bei Veeam) aufgesetzt hast, dann ist deine Veeam-DB bei deinen Datenbeständen bereits nach der ersten Sicherung beim 10GB Limit angekommen.

Ich denke kaum, dass sich dein Problem nur durch einen Trick lösen lässt, aber es ist generell machbar. Als erstes würde ich dir vorschlagen die Schattenkopien zu aktivieren, dies ist mit einem sehr überschaubaren Aufwand realisiert und bring schon Mal wirklich sehr viel.

Als nächstes solltest du dir überlegen ob du die Daten nicht auf mehrere Server verteilen kannst.

Kleinere VMs lassen sich viel schneller sichern und auch wiederherstellen.

Dieser Schritt ist aber nicht ganz ohne. Ich unterstütze gerade selbst bei einer Fileserverumstellung von einem ähnlich grossen Datenbestand, der bei dem Kunden über die letzten +- 20 Jahre historisch gewachsen ist. Es ist schon mitunter lustig zu sehen wie die Daten gewachsen sind, aber spassig ist diese ganze Angelegenheit dennoch nicht. Im Gegenteil, es ist im Nachgang nicht immer ganz einfach alles Nachzuvollziehen, vor allem wenn die Mitarbeiter, die sich die vorherige Struktur ausgedacht haben nicht mehr im Unternehmen tätig sind und du bei jedem zweiten Ordner nur zu hören bekommst „das war vor meiner Zeit, da kenne ich mich nicht aus“. 😭

So hart das Ganze auch ist, es muss am Ende des Tages gemacht werden.

Ich habe noch kein Unternehmen erlebt, das aktuell weniger Daten generiert wie in der Vergangenheit. Im Gegenteil der Bedarf an Speicherplatz wächst meinem Gefühl nach nicht mal linear, sondern exponentiell. Wenn du nicht rechtzeitig handelst, dann kommst du später vielleicht in die Bredouille, dass sich der Fileserver in einer annehmbaren Zeit, sich gar nicht mehr sichern lässt oder dass in einem Notfall die Wiederherstellung inakzeptabel lange dauert. Habe beides schon miterleben dürfen, ist alles andere als schön, vor allem wenn die Hütte gerade brennt.

Grüsse aus BaWü

Alex

Guten Morgen,

wir hatten ähnliche Fälle, daher mal grundsätzlich die Frage in die Runde. Kann man generell davon ausgehen das Schattenkopien und auch Datenduplizierung für einen Fileserver die richtigen Features sind, letzteres hatte in meinem Fall knapp über 20% Speicherplatz gebracht.

wir hatten ähnliche Fälle, daher mal grundsätzlich die Frage in die Runde. Kann man generell davon ausgehen das Schattenkopien und auch Datenduplizierung für einen Fileserver die richtigen Features sind, letzteres hatte in meinem Fall knapp über 20% Speicherplatz gebracht.

Hallo,

Im Gegenteil - agentenbasierte Sicherungen lassen sich nicht nur wesentlich granularer steuern, sondern profitieren natürlich auch von inkrementellen und differentiellen Sicherungen. Weiterhin gibt es gerade bei derartig großen Freigaben häufig statische Bereiche, die nicht zeitkritisch wiederhergestellt werden (müssen) und via einmaliger Sicherung und zusätzlicher Archivierung abgefrühstückt werden können.

Mit anderen Worten: Mein Beitrag ist eine Anregung - was letztendlich "eine gute Idee" ist, lässt sich ohne Kenntnis der Daten und der damit verbundenen technischen und organisatorischen Prozesse nicht beantworten. Dem Verfasser des Beitrages ging es übrigens genau darum, derartige Anregungen zu sammeln.

Gruß,

Jörg

Zitat von @MysticFoxDE:

Moin FA-jka,

hast du schon jemals einen 16TB+ Dateibestand agentenbasiert gesichert?

Das ist alles andere als eine Gute Idee, da die Backupzeiten dadurch explodieren würden, alleine schon dadurch, weil agentenbasiert z.B. kein CBT verfügbar ist. 😉

Moin FA-jka,

wenn Du agentenbasiert sicherst, könnte man die Freigabeordner auf mehrere Jobs aufteilen.

hast du schon jemals einen 16TB+ Dateibestand agentenbasiert gesichert?

Das ist alles andere als eine Gute Idee, da die Backupzeiten dadurch explodieren würden, alleine schon dadurch, weil agentenbasiert z.B. kein CBT verfügbar ist. 😉

Im Gegenteil - agentenbasierte Sicherungen lassen sich nicht nur wesentlich granularer steuern, sondern profitieren natürlich auch von inkrementellen und differentiellen Sicherungen. Weiterhin gibt es gerade bei derartig großen Freigaben häufig statische Bereiche, die nicht zeitkritisch wiederhergestellt werden (müssen) und via einmaliger Sicherung und zusätzlicher Archivierung abgefrühstückt werden können.

Mit anderen Worten: Mein Beitrag ist eine Anregung - was letztendlich "eine gute Idee" ist, lässt sich ohne Kenntnis der Daten und der damit verbundenen technischen und organisatorischen Prozesse nicht beantworten. Dem Verfasser des Beitrages ging es übrigens genau darum, derartige Anregungen zu sammeln.

Gruß,

Jörg

Moin,

Nur für den Fileserver betrachtet können beide Features sehr nützlich sein.

Jedoch sollte man bei DeDub aufpassen, dass es auch nur auf dem Fileserver läuft und nicht schon auf dem SAN/Storage aktiviert ist auf dem sich z.B. auch Datenbank- und oder Applikationsserver befinden. Dann geht der Schuss schnell nach hinten los, da durch DeDub die Performance je nach System gravierend beeinflusst werden kann. Steht beim Dateiserver die Performance im Vordergrund, so würde ich auf DeDub auf jeden Fall verzichten.

Grüsse aus BaWü

Alex

wir hatten ähnliche Fälle, daher mal grundsätzlich die Frage in die Runde. Kann man generell davon ausgehen das Schattenkopien und auch Datenduplizierung für einen Fileserver die richtigen Features sind, letzteres hatte in meinem Fall knapp über 20% Speicherplatz gebracht.

Nur für den Fileserver betrachtet können beide Features sehr nützlich sein.

Jedoch sollte man bei DeDub aufpassen, dass es auch nur auf dem Fileserver läuft und nicht schon auf dem SAN/Storage aktiviert ist auf dem sich z.B. auch Datenbank- und oder Applikationsserver befinden. Dann geht der Schuss schnell nach hinten los, da durch DeDub die Performance je nach System gravierend beeinflusst werden kann. Steht beim Dateiserver die Performance im Vordergrund, so würde ich auf DeDub auf jeden Fall verzichten.

Grüsse aus BaWü

Alex

Moin Stefan,

ich glaube nicht, dass hier jemand vor hat sein gesamten Backupkonzept nur auf Schattenkopien aufzubauen, das wäre auch meiner Ansicht nach nicht besonders Klug.

Schattenkopien eignen sich jedoch hervoragend um die alltäglichen Rücksicherungsanfragen der Anwender zu bedienen.

Wenn Schattenkopien richtig eingerichtet, reglementiert und die Anwender bez. der Nutzung auch geschult sind, dann sinkt bei vielen alltäglichen Wiederherstellungsanfragen

der Anwender, der Aufwand für den Admin auf 0, weil die Anwender die Daten schlichtweg selber zurückhollen können ohne den Admin hierfür zu belästigen. 😀

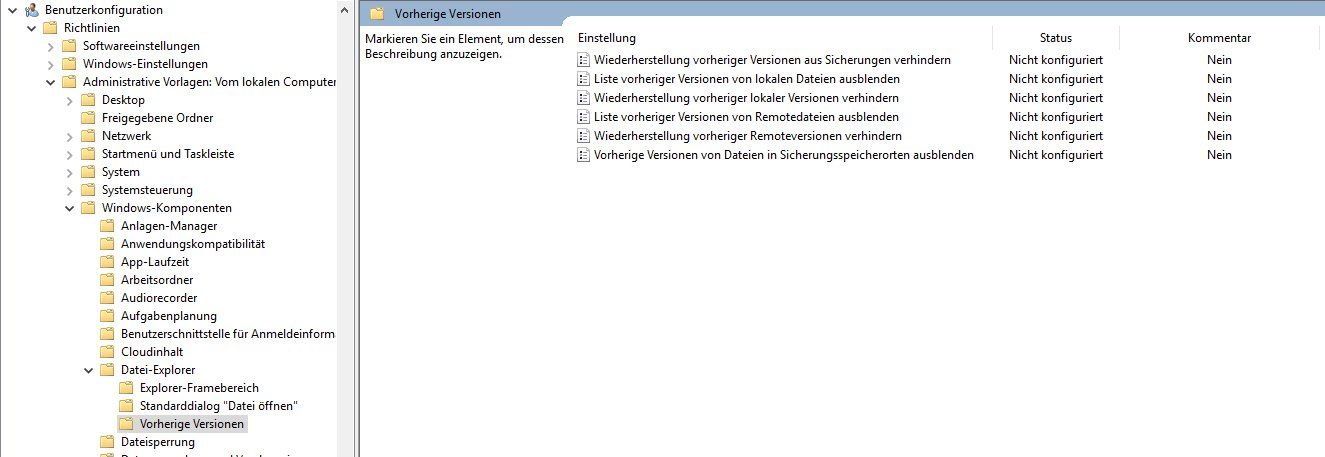

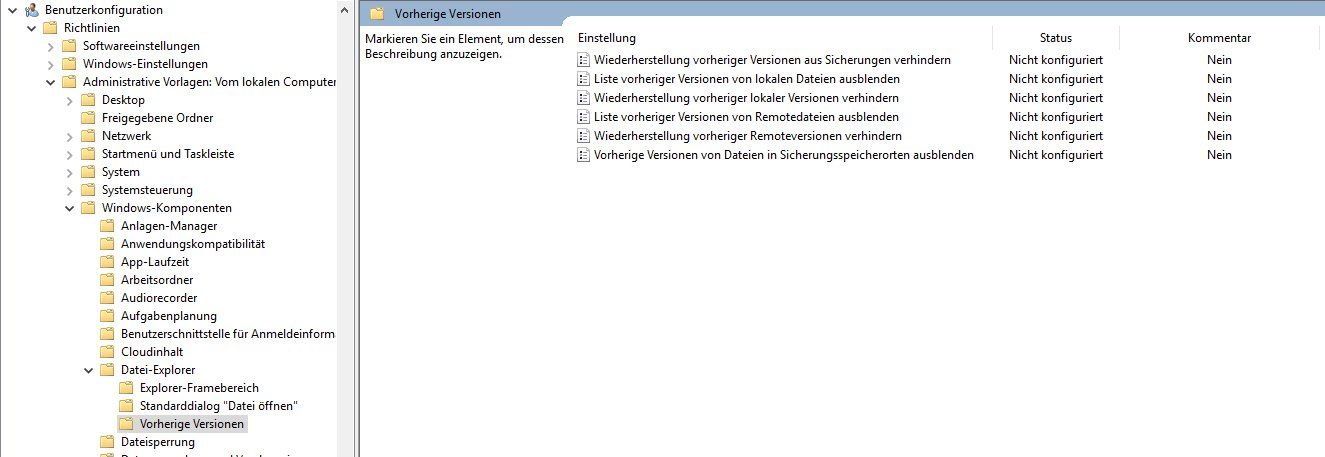

Aber vorsicht, nach dem Aktivieren der Schattenkopien können alle User über das Kontextmenü "Vorherige Versionen" des Dateiexplorers ältere Dateien wiederherstellen. Nicht jeder Administrator ist glücklich darüber, wenn die User "Backups" selbst zurückspielen können. Manchmal ist diese Sorge unberechtigt und manchmal gibt es tatsächlich User die diese Macht nicht haben dürfen. Sei es zu ihrem eigenen Schutz oder zum Schutz Anderer. 🙃

Die Einschränkungen können sehr einfach über die folgenden GPOs definiert werden.

Gegen Verschlüsselungstrojaner und sonstiges Mistvieh helfen die Schattenkopien nur sehr bedingt bis gar nicht.

Wenn sich der "Schädling" mit einem Adminaccount bis zu dem Fileserver durchfrisst, dann deaktiviert dieser sehr wahrscheinlich vor der Verschlüsselung eh die Schattenkopien. Falls die Backupdaten nicht ausreichend geschützt sind, dann löscht er vorher auch noch kurz das Backup und dann wird es richtig lustig. Wegen genau so einem Mist durfte ich schon vor über drei Jahren das erste Mal ausrücken. 🤢🤮

Das Unternehmen hat es zum Glück mit leichten Schrammen überstanden, weil wir bei diesem genau ein Monat vor der Attacke Veeam Backup implementiert haben. Sowohl die Hyperv-Cluster-Verwaltungsumgebung als auch der Veeam Server und auch die Backups selbst wurden von uns, in eigene abgeschottete Netze implementiert, welche vom produktiven Netz des Kunden vollständig getrennt waren und dank dessen nicht kompromittiert werden konnten. 48 Stunden später waren >100 VMs mit einer Kapazität von mehr als 50TB, dank Veeam und einigen Überstunden wieder vollständig funktionsfähig. 😀

Somit würde ich das folgende Sonntagssprüchle reissen.

Schattenkopie ist gut,

Veeam Backup ist besser,

am Ende des Tages,

ist beides gemeinsam,

meistens jedoch am besten. 😎

Grüsse aus BaWü

Alex

wegen Schattenkopien hatte ich oben schon beschrieben.

Für einen Verschlüsselungstrojaner benötigt man 100% der Kapazität.

Für einen Verschlüsselungstrojaner benötigt man 100% der Kapazität.

ich glaube nicht, dass hier jemand vor hat sein gesamten Backupkonzept nur auf Schattenkopien aufzubauen, das wäre auch meiner Ansicht nach nicht besonders Klug.

Schattenkopien eignen sich jedoch hervoragend um die alltäglichen Rücksicherungsanfragen der Anwender zu bedienen.

Wenn Schattenkopien richtig eingerichtet, reglementiert und die Anwender bez. der Nutzung auch geschult sind, dann sinkt bei vielen alltäglichen Wiederherstellungsanfragen

der Anwender, der Aufwand für den Admin auf 0, weil die Anwender die Daten schlichtweg selber zurückhollen können ohne den Admin hierfür zu belästigen. 😀

Aber vorsicht, nach dem Aktivieren der Schattenkopien können alle User über das Kontextmenü "Vorherige Versionen" des Dateiexplorers ältere Dateien wiederherstellen. Nicht jeder Administrator ist glücklich darüber, wenn die User "Backups" selbst zurückspielen können. Manchmal ist diese Sorge unberechtigt und manchmal gibt es tatsächlich User die diese Macht nicht haben dürfen. Sei es zu ihrem eigenen Schutz oder zum Schutz Anderer. 🙃

Die Einschränkungen können sehr einfach über die folgenden GPOs definiert werden.

Gegen Verschlüsselungstrojaner und sonstiges Mistvieh helfen die Schattenkopien nur sehr bedingt bis gar nicht.

Wenn sich der "Schädling" mit einem Adminaccount bis zu dem Fileserver durchfrisst, dann deaktiviert dieser sehr wahrscheinlich vor der Verschlüsselung eh die Schattenkopien. Falls die Backupdaten nicht ausreichend geschützt sind, dann löscht er vorher auch noch kurz das Backup und dann wird es richtig lustig. Wegen genau so einem Mist durfte ich schon vor über drei Jahren das erste Mal ausrücken. 🤢🤮

Das Unternehmen hat es zum Glück mit leichten Schrammen überstanden, weil wir bei diesem genau ein Monat vor der Attacke Veeam Backup implementiert haben. Sowohl die Hyperv-Cluster-Verwaltungsumgebung als auch der Veeam Server und auch die Backups selbst wurden von uns, in eigene abgeschottete Netze implementiert, welche vom produktiven Netz des Kunden vollständig getrennt waren und dank dessen nicht kompromittiert werden konnten. 48 Stunden später waren >100 VMs mit einer Kapazität von mehr als 50TB, dank Veeam und einigen Überstunden wieder vollständig funktionsfähig. 😀

Somit würde ich das folgende Sonntagssprüchle reissen.

Schattenkopie ist gut,

Veeam Backup ist besser,

am Ende des Tages,

ist beides gemeinsam,

meistens jedoch am besten. 😎

Grüsse aus BaWü

Alex

Moin Alex,

vielen Dank für das Feedback.

vielen Dank für das Feedback.