Hyper V Server 2019, Gast Server 2016, Intel X722, langsame ext. Netzwerkanbindung

Hallo Community,

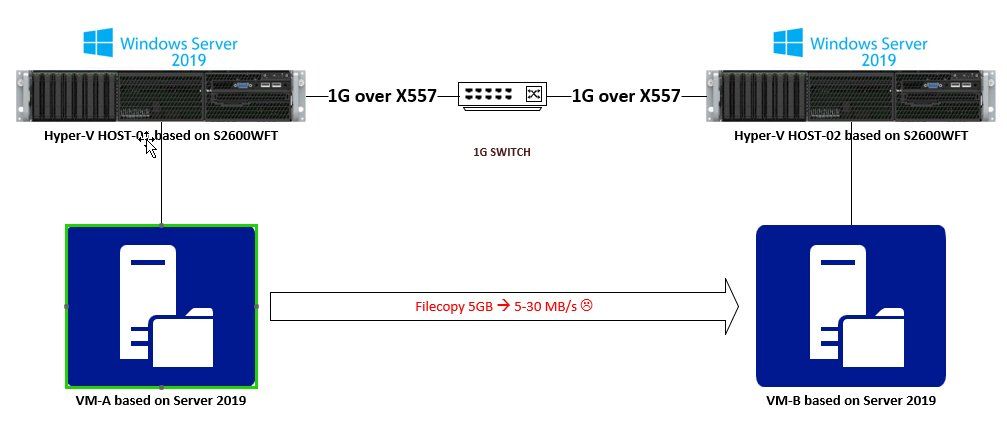

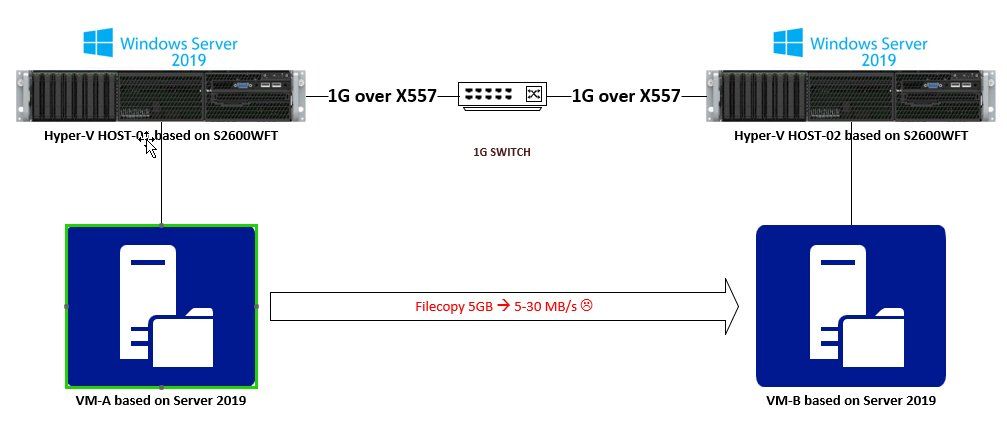

ich habe hier ein Problem mit extrem langsamen Netzwerkanbindungen von mehreren VM. Hardware sind zwei fast identische neue Maschinen (MB Supermicro X11SPM-F mit 2x 1 GB Intel X722 onBoard NIC und sep. IPMI, Intel Xeon Silver 4110, 96 GB RAM, lokales SSD Storage, soweit schön) auf denen je Windows Server 2019 Std. mit aktivierter Hyper V Rolle als Host installiert ist. Treiber sind erstmal alle original vom Hersteller was Supermicro halt so bereit stellt (Intel MB Chipsatz, Intel Pro 23.2 u.a.). Die Maschinen haben eine sep. IPMI NIC, die erste X722 NIC von dem Server verwende ich für das Hyper V Verwaltungsinterface, die zweite als HV Switch für die ext. Anbindung aller VM. Wenn ich Windows Server 2019 Std. in einer VM installiere ist alles gut, alles läuft wie es laufen soll. Wenn ich Windows Server 2016 Std. oder Server 2008R2 Std. in einer VM auf dem Host installiere haben diese VM nur je eine sehr sehr langsame Anbindung an die Aussenwelt. Ich hab das alles mal mit iperf getestet. Zwischen den VM ist die Transferrate wie gewünscht (iperf. knapp 10 GBit/s), von den VM zum Host auch (da das extern über einen Switch geht nur rd. 1 GBit/s, wenn ich einen HV Switch an das Verwaltungsinterface binde dann auch schneller), zu physischen Computern nach aussen hin im realen Netzwerk komme ich bei der einen Maschine aber nur auf 5-10 MBit/s und bei der anderen auf 20-120 MBit/s mit stark schwankender Tendenz - je nachdem. Der verwendete HW Switch ist entweder mal ein D-Link DGS 1210-28 oder ein HP 2510G-24, blank und nahezu unkonfiguriert, was halt grad so rumliegt. Mir geht ein klein wenig die Zeit aus weil beide Maschinen produktiv gehen sollen. Die erste steht schon vor Ort und dort ist mir das erst aufgefallen als ich von einem vorh. Server Daten migrieren wollte, das dauert ewig. Die andere noch bei mir im Labor und mit der habe ich nun schon einiges probiert: mehrfach Windows Server 2019 und 2016 auf dem Host installiert (meist wirklich neu von null an), div. VM installiert (Gen 1 und Gen 2), div. Intel Netzwerkkartentreiberversionen für die X722 installiert (23.0, 23.2, 23.4, aktuell 23.5), deren physische Zuordnungen hin und her geändert und auch an deren Parametern rumgespielt (Stichworte Flusssteuerung, VMQ, Lange send Offload v2 u.a. auf dem Host und in den VM), Hyper V Rolle deaktiviert und aktiviert. Ich habe die letzten Tage schon einige umfangreiche Installationsorgien hinter mir um das Problem einzukreisen - insbes. da das ändern der Intel NIC Treiber immer mit dem Löschen des HV Switches und Neustart des Hosts verbunden ist. Nur das BIOS des MB habe ich derzeit noch in Ruhe gelassen da dort meiner Meinung nach nichts für dieses Problem relevante einzustellen ist. Dabei kommt u.a. auf dem 2019 Host immer mal wieder das Problem auf dass ich keinen virt. Switch mit ext. Anbindung erstellen kann (Stichwort Hyper V Rolle deinstallieren, netcfg -d, Neustart, Hyper V Rolle aktivieren, alles neu einrichten ...) - aber das nur am Rande.

Letztendlich hat das alles mehr oder weniger nichts gebracht. Derzeitiges Fazit: sobald auf dem Host ein Server 2019 als Hyper V läuft auf dem in einer VM kein Server 2019 läuft (habe es mit Server 2016 und 2008R2 probiert) dann ist die Netzwerkanbindung dieser VM nach aussen über die Intel X722 extrem langsam. CPU Leistung steigt nicht, keine Fehlerpakete am Hardware Switch, es kommt halt einfach zu wenig an. Ich weiss auch spontan nicht wonach ich weiter suchen sollte und wo da der Flaschenhals ist (Paketgrößen?, Jumbo Pakete sind aber überall deaktiviert). Läuft auf dem Host Server 2016 als Hyper V funktioniert alles wie gewünscht. Das Problem habe ich z.Z. temporär gelöst indem ich eine weitere separate physische PCIe NIC (eine einfache Intel i210) eingebaut habe, an diese einen eigenen HV Switch gebunden und alle VM über diesen laufen lasse. Sobald ich die 2016er VM über einen HV Switch wieder über die onBoard NIC Intel X722 nach aussen anbinde haben externe PC die o.g. schlechte Netzwerkanbindung. Mit dem HV Switch der i210 geht das schnell wie gewünscht.

Meine Fragen: kennt jemand dieses Problem in dieser Konstellation (HV 2019, Intel NIC X722, HV Gast 2016)? Gibt es eine Lösung oder hat jemand weitere Ansätze zur Suche?

ich habe hier ein Problem mit extrem langsamen Netzwerkanbindungen von mehreren VM. Hardware sind zwei fast identische neue Maschinen (MB Supermicro X11SPM-F mit 2x 1 GB Intel X722 onBoard NIC und sep. IPMI, Intel Xeon Silver 4110, 96 GB RAM, lokales SSD Storage, soweit schön) auf denen je Windows Server 2019 Std. mit aktivierter Hyper V Rolle als Host installiert ist. Treiber sind erstmal alle original vom Hersteller was Supermicro halt so bereit stellt (Intel MB Chipsatz, Intel Pro 23.2 u.a.). Die Maschinen haben eine sep. IPMI NIC, die erste X722 NIC von dem Server verwende ich für das Hyper V Verwaltungsinterface, die zweite als HV Switch für die ext. Anbindung aller VM. Wenn ich Windows Server 2019 Std. in einer VM installiere ist alles gut, alles läuft wie es laufen soll. Wenn ich Windows Server 2016 Std. oder Server 2008R2 Std. in einer VM auf dem Host installiere haben diese VM nur je eine sehr sehr langsame Anbindung an die Aussenwelt. Ich hab das alles mal mit iperf getestet. Zwischen den VM ist die Transferrate wie gewünscht (iperf. knapp 10 GBit/s), von den VM zum Host auch (da das extern über einen Switch geht nur rd. 1 GBit/s, wenn ich einen HV Switch an das Verwaltungsinterface binde dann auch schneller), zu physischen Computern nach aussen hin im realen Netzwerk komme ich bei der einen Maschine aber nur auf 5-10 MBit/s und bei der anderen auf 20-120 MBit/s mit stark schwankender Tendenz - je nachdem. Der verwendete HW Switch ist entweder mal ein D-Link DGS 1210-28 oder ein HP 2510G-24, blank und nahezu unkonfiguriert, was halt grad so rumliegt. Mir geht ein klein wenig die Zeit aus weil beide Maschinen produktiv gehen sollen. Die erste steht schon vor Ort und dort ist mir das erst aufgefallen als ich von einem vorh. Server Daten migrieren wollte, das dauert ewig. Die andere noch bei mir im Labor und mit der habe ich nun schon einiges probiert: mehrfach Windows Server 2019 und 2016 auf dem Host installiert (meist wirklich neu von null an), div. VM installiert (Gen 1 und Gen 2), div. Intel Netzwerkkartentreiberversionen für die X722 installiert (23.0, 23.2, 23.4, aktuell 23.5), deren physische Zuordnungen hin und her geändert und auch an deren Parametern rumgespielt (Stichworte Flusssteuerung, VMQ, Lange send Offload v2 u.a. auf dem Host und in den VM), Hyper V Rolle deaktiviert und aktiviert. Ich habe die letzten Tage schon einige umfangreiche Installationsorgien hinter mir um das Problem einzukreisen - insbes. da das ändern der Intel NIC Treiber immer mit dem Löschen des HV Switches und Neustart des Hosts verbunden ist. Nur das BIOS des MB habe ich derzeit noch in Ruhe gelassen da dort meiner Meinung nach nichts für dieses Problem relevante einzustellen ist. Dabei kommt u.a. auf dem 2019 Host immer mal wieder das Problem auf dass ich keinen virt. Switch mit ext. Anbindung erstellen kann (Stichwort Hyper V Rolle deinstallieren, netcfg -d, Neustart, Hyper V Rolle aktivieren, alles neu einrichten ...) - aber das nur am Rande.

Letztendlich hat das alles mehr oder weniger nichts gebracht. Derzeitiges Fazit: sobald auf dem Host ein Server 2019 als Hyper V läuft auf dem in einer VM kein Server 2019 läuft (habe es mit Server 2016 und 2008R2 probiert) dann ist die Netzwerkanbindung dieser VM nach aussen über die Intel X722 extrem langsam. CPU Leistung steigt nicht, keine Fehlerpakete am Hardware Switch, es kommt halt einfach zu wenig an. Ich weiss auch spontan nicht wonach ich weiter suchen sollte und wo da der Flaschenhals ist (Paketgrößen?, Jumbo Pakete sind aber überall deaktiviert). Läuft auf dem Host Server 2016 als Hyper V funktioniert alles wie gewünscht. Das Problem habe ich z.Z. temporär gelöst indem ich eine weitere separate physische PCIe NIC (eine einfache Intel i210) eingebaut habe, an diese einen eigenen HV Switch gebunden und alle VM über diesen laufen lasse. Sobald ich die 2016er VM über einen HV Switch wieder über die onBoard NIC Intel X722 nach aussen anbinde haben externe PC die o.g. schlechte Netzwerkanbindung. Mit dem HV Switch der i210 geht das schnell wie gewünscht.

Meine Fragen: kennt jemand dieses Problem in dieser Konstellation (HV 2019, Intel NIC X722, HV Gast 2016)? Gibt es eine Lösung oder hat jemand weitere Ansätze zur Suche?

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 396761

Url: https://administrator.de/forum/hyper-v-server-2019-gast-server-2016-intel-x722-langsame-ext-netzwerkanbindung-396761.html

Ausgedruckt am: 07.07.2025 um 14:07 Uhr

177 Kommentare

Neuester Kommentar

Moin,

da du schon vieles versucht hast, würde ich mich hier direkt an den Hersteller oder den Lieferanten wenden.

Da diese Server anscheinend neu und für den produktiven Einsatz vorgesehen sind, gehe ich davon aus, dass du diese unter einem Wartungsvertrag hast. Wie lange ist dort die Reaktionszeit?

Gruß

maxblank

da du schon vieles versucht hast, würde ich mich hier direkt an den Hersteller oder den Lieferanten wenden.

Da diese Server anscheinend neu und für den produktiven Einsatz vorgesehen sind, gehe ich davon aus, dass du diese unter einem Wartungsvertrag hast. Wie lange ist dort die Reaktionszeit?

Gruß

maxblank

Hmm.

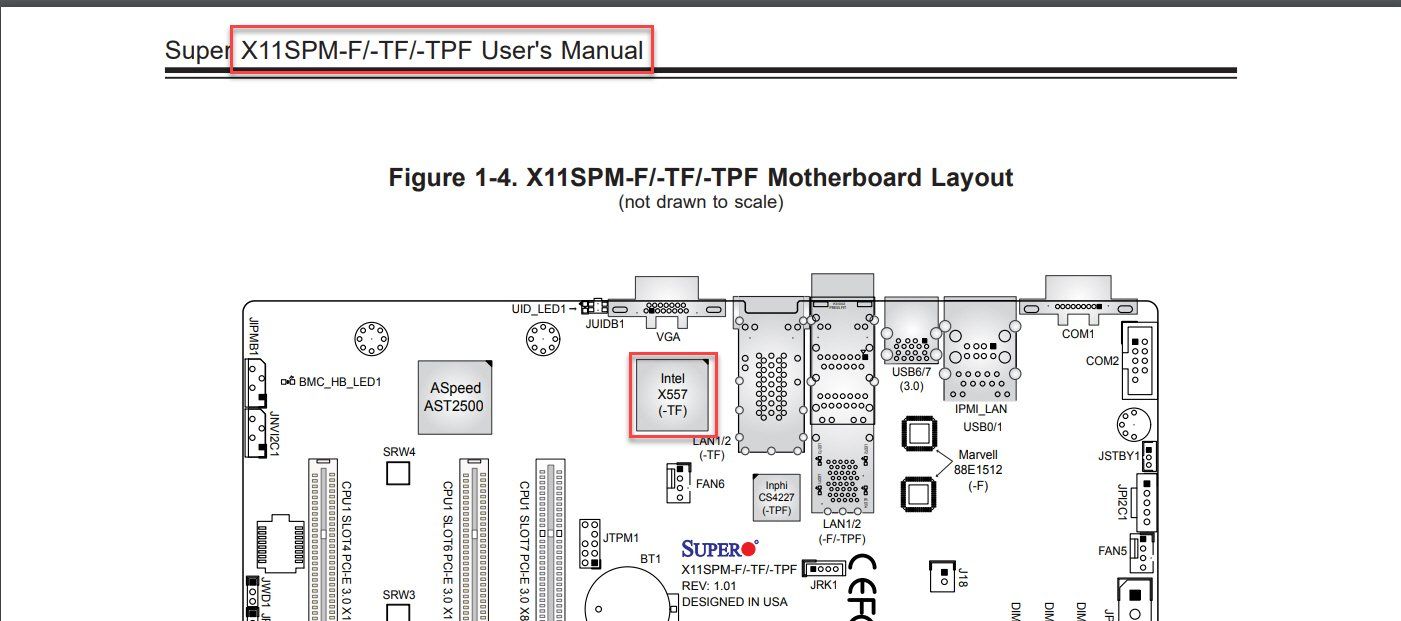

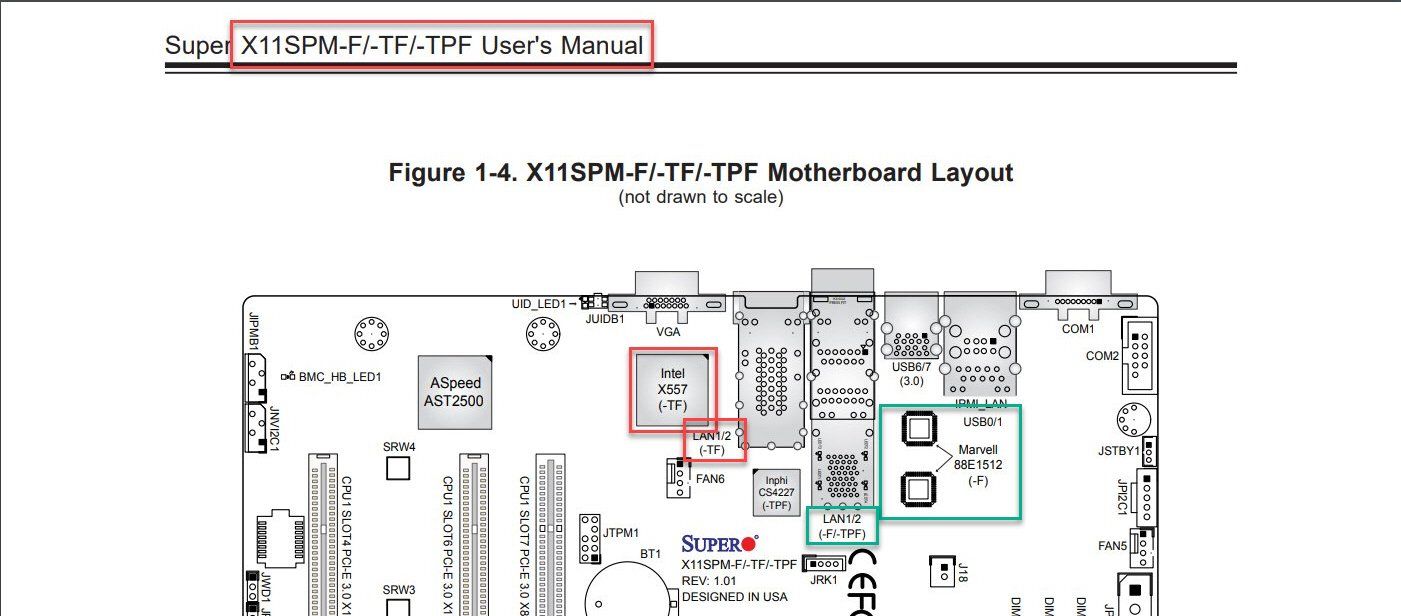

Hier steht das Teil [X11SPM-F] hätte zwei 1GbE Marvel Controller, keine Intel.

supermicro.com/products/motherboard/Xeon/C620/X11SPM-F.cfm

Dual LAN with 1GbE with Marvell® 88E1512

Gruß A.

Btw. Server 2019 produktiv nutzen? Da würde ich das Ding erst mal noch mind. ein Jahr reifen lassen bis zumindest die gröbsten Schnitzer behoben sind, denn davon gibt es nach meiner Evaluation der letzten Build noch einige.

Hier steht das Teil [X11SPM-F] hätte zwei 1GbE Marvel Controller, keine Intel.

supermicro.com/products/motherboard/Xeon/C620/X11SPM-F.cfm

Dual LAN with 1GbE with Marvell® 88E1512

Gruß A.

Btw. Server 2019 produktiv nutzen? Da würde ich das Ding erst mal noch mind. ein Jahr reifen lassen bis zumindest die gröbsten Schnitzer behoben sind, denn davon gibt es nach meiner Evaluation der letzten Build noch einige.

OK, da hat Supermicro tatsächlich etwas in der Doku geschlampt, siehe

vmware-forum.de/viewtopic.php?t=32808

Das OS reift beim Kunden, nicht anders wie bei den Client OS.. Deswegen bei Virtualisierung besser gleich zur Bewährtem greifen.

vmware-forum.de/viewtopic.php?t=32808

Aber so ein Problem allein schon beim Hyper V finde ich nicht lustig.

Gerade bei der Hyper-V Rolle machen sich die meisten Unzulänglichkeiten beim 2019er bemerkbar.Das OS reift beim Kunden, nicht anders wie bei den Client OS.. Deswegen bei Virtualisierung besser gleich zur Bewährtem greifen.

Zitat von @137846:

OK, da hat Supermicro tatsächlich etwas in der Doku geschlampt, siehe

vmware-forum.de/viewtopic.php?t=32808

Das OS reift beim Kunden, nicht anders wie bei den Client OS..

OK, da hat Supermicro tatsächlich etwas in der Doku geschlampt, siehe

vmware-forum.de/viewtopic.php?t=32808

Aber so ein Problem allein schon beim Hyper V finde ich nicht lustig.

Gerade bei der Hyper-V Rolle machen sich die meisten Unzulänglichkeiten beim 2019er bemerkbar.Das OS reift beim Kunden, nicht anders wie bei den Client OS..

Findest du? Seit dem letzten Update läuft das auf meinen Testsystemen sehr gut. Mittlerweile 5 Systeme 24/7 aktiv.

Welche Probleme siehst du da?

Aber: Anscheinend wird von VMware 6.7 auch (noch) abgeraten ;) also nicht besser.

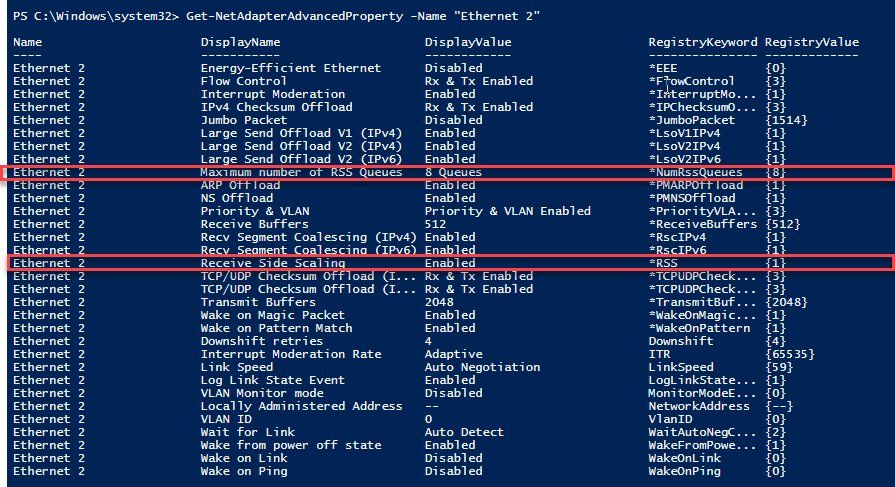

kurz zusammengefaßt einer der 30 Parameter der Netzwerkkarte (die Detaileinstellungen im Gerätemanager) im Gast paßt wohl nicht zu den physischen Fähigkeiten des Intel NIC X722

2016 hat nen Bug der in 2019 vielleicht auch drin ist - es aktiviert einige Features an der Netzwerkkarte wie z.B. das RSS oder noch ein paar weitere "Offloading" Optionen, die auf physischen Karten dann Teile des TCP-IP Protokolls in Hardware umsetzen wie z.B. Checksum Prüfungen oder Hashberechnungen. Ich hatte gerad nen Kunden am Rohr, der auf 2016 Terminalserver eine Roundtrip Latency von sage und schreibe 2000 ms hatte, dabei waren Client und Server keine 2 km voneinander entfernt. Bei 2008R2 lag er bei 17 ms.

ICh hatte neulich auch mal ein 2016 auf ESX installiert, und mit Defaulteinstellungen war das Netz langsam bis unbenutzbar, dann VMware Tools installiert aber nicht viel besser geworden... Unter 2012 R2 auf demselben Host gingen dann Downloads bei MS so wusch mit Maximalbandbreite des CDN von Microsoft (ca. 120 Mbit) ... ich hab sogar die Ports getauscht konnte aber keinen finden der daran schuld war. Und stellt man aber auf 2012 R2 und dem E1000E Treiber das RSS ein, dann bricht der Download dramatisch ein und acuh die VMware Tools halfen zunächst nicht.... das ist aber in aktuellen VMware Tools dann gefixt.

2016 hat nen Bug der in 2019 vielleicht auch drin ist - es aktiviert einige Features an der Netzwerkkarte wie z.B. das RSS oder noch ein paar weitere "Offloading" Optionen, die auf physischen Karten dann Teile des TCP-IP Protokolls in Hardware umsetzen wie z.B. Checksum Prüfungen oder Hashberechnungen. Ich hatte gerad nen Kunden am Rohr, der auf 2016 Terminalserver eine Roundtrip Latency von sage und schreibe 2000 ms hatte, dabei waren Client und Server keine 2 km voneinander entfernt. Bei 2008R2 lag er bei 17 ms.

ICh hatte neulich auch mal ein 2016 auf ESX installiert, und mit Defaulteinstellungen war das Netz langsam bis unbenutzbar, dann VMware Tools installiert aber nicht viel besser geworden... Unter 2012 R2 auf demselben Host gingen dann Downloads bei MS so wusch mit Maximalbandbreite des CDN von Microsoft (ca. 120 Mbit) ... ich hab sogar die Ports getauscht konnte aber keinen finden der daran schuld war. Und stellt man aber auf 2012 R2 und dem E1000E Treiber das RSS ein, dann bricht der Download dramatisch ein und acuh die VMware Tools halfen zunächst nicht.... das ist aber in aktuellen VMware Tools dann gefixt.

Ich bekomme morgen eine X722 in die Finger, dann mach ich hier auch mal ein paar Tests um das nachzustellen.

Gruß A.

Gruß A.

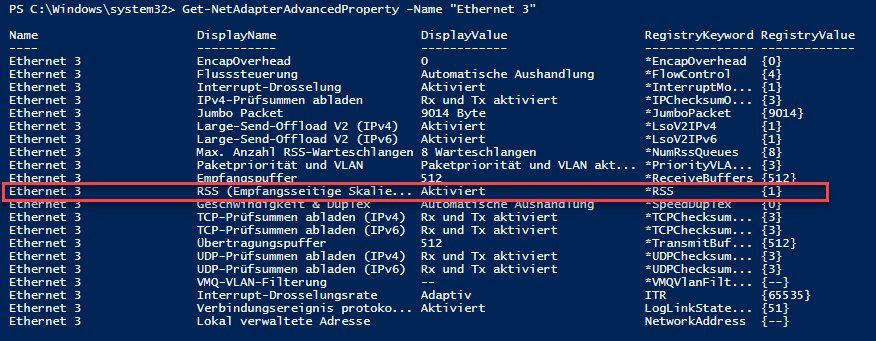

Also, ich habe das ganze hier mal mit einem SM Board mit X722 NIC nachgestellt (hatten wir hier noch auf Ersatz-Lager liegen):

Also k.A. was da bei dir dazwischen funkt und du beim Aufsetzen anders machst.

Gruß A.

- Server 2019 Datacenter mit allen verfügbaren Updates (nur Hyper-V als Rolle)

- Gast jeweils mit fest zugewiesenen 4GB RAM und 2 vCPUs

- Sowohl beim Gast mit Server 2016 Datacenter (alle Updates), als auch Server 2008R2 (mit allen Updates) laufen die NICs sehr nah am theroetischen Max. durchschn. 950MBit/s (netio) über einen CISCO SG350-52 Switch auf einen Windows 10 1809 Client mit 1GB Intel-NIC. VM Gen 1. oder 2. machten dabei keinen Unterschied.

- Treiber von Intel ist der letzte verfügbare 23.5, Anpassungen an den NICs sowohl am Hosts als auch am Gast waren nicht nötig.

Also k.A. was da bei dir dazwischen funkt und du beim Aufsetzen anders machst.

Gruß A.

hilf dir selbst.

Und ab und zu auch anderen Darf man das zurück geben, wie gesagt, genau an dem Punkt - hilf dir selbst.

Moin...

Updates ?

allerdings finde ich dein Unterfangen, einen Hyper-V auf basis des 2019er nutzen zu wollen, doch sehr gewagt... ich traue dem braten nicht....

Mehrfach von Null an neu installiert, zuletzt nahezu nichts mehr auf dem Host und in den VM eingerichtet. Problem war reproduzierbar immer wieder da.

hast du auch die VM´s neu installiert?

Frank

Zitat von @bonbastler:

Danke, schön zu wissen dass es auch anders geht. Hilft mir halt nicht weiter. Ich hab das von MS freigegebene 2019er ISO SW_DVD9_Win_Server_STD_CORE_2019_64Bit_German_DC_STD_MLF_X21-96583.ISO aus dem MS Partner Portal genommen.

und welche Build version hast du nach der Installation genau....Danke, schön zu wissen dass es auch anders geht. Hilft mir halt nicht weiter. Ich hab das von MS freigegebene 2019er ISO SW_DVD9_Win_Server_STD_CORE_2019_64Bit_German_DC_STD_MLF_X21-96583.ISO aus dem MS Partner Portal genommen.

Updates ?

allerdings finde ich dein Unterfangen, einen Hyper-V auf basis des 2019er nutzen zu wollen, doch sehr gewagt... ich traue dem braten nicht....

Mehrfach von Null an neu installiert, zuletzt nahezu nichts mehr auf dem Host und in den VM eingerichtet. Problem war reproduzierbar immer wieder da.

hast du auch die VM´s neu installiert?

Frank

Moin...

hm...

warum solle es ein 2019er Hyper-V Host werden?

nutze doch den ESXI 6.5.... mach es besser gleich richtig!

Ja, auch die VM wurden oft neu installiert, aber ich gebe zu: nur bei jeder 2. Neuinstallation des Host, abhängig von den Spielereien die ich an den NIC in den VM durchgeführt habe.

na ja... das sollte schon mit den grundeinstellungen klappen....

hast du mal eine ander NIC in dein Blech geklemmt?

hast du den Server bestellt für 2019.. was sagt der Hersteller dazu? support?

Das ist selbstverständlich. Ich gebe wenn ich kann immer zurück. Vor allem dann wenn ich wirklich mal irgendwo frage und - wie so oft - keine Lösung kurzfristig gefunden wird dann schreibe ich zumindest wenn ich eine finde diese nachträglich noch dazu. Falls andere vor dem Problem stehen hilft das denen - ist die Hoffnung.

Frank

hm...

warum solle es ein 2019er Hyper-V Host werden?

nutze doch den ESXI 6.5.... mach es besser gleich richtig!

Ja, auch die VM wurden oft neu installiert, aber ich gebe zu: nur bei jeder 2. Neuinstallation des Host, abhängig von den Spielereien die ich an den NIC in den VM durchgeführt habe.

hast du mal eine ander NIC in dein Blech geklemmt?

hast du den Server bestellt für 2019.. was sagt der Hersteller dazu? support?

Das ist selbstverständlich. Ich gebe wenn ich kann immer zurück. Vor allem dann wenn ich wirklich mal irgendwo frage und - wie so oft - keine Lösung kurzfristig gefunden wird dann schreibe ich zumindest wenn ich eine finde diese nachträglich noch dazu. Falls andere vor dem Problem stehen hilft das denen - ist die Hoffnung.

Frank

Naja dann wurde ich mal sagen, entweder ihr schaut was ihr mit den Systemen macht oder ihr ordert bei den grossen ein entsprechendes system. Da du hier nun schon tagelang und zog Installationen durch hast dürfte es so langsam billiger sein sich nach einer alternative um zuschauen.

Vielleicht geht es momentan einfach nicht aufgrund eines anderen problems, dass gerade gar nicht mit der nicht zusammenhängt, aber die Leistung frisst.

Vielleicht geht es momentan einfach nicht aufgrund eines anderen problems, dass gerade gar nicht mit der nicht zusammenhängt, aber die Leistung frisst.

Moin...

nun sag das mal nicht... wir machen das schon über 25 Jahre....

also doch ein problem....

natürlich kann jerder Hans und Franz einen Server zusammenschustern, darum geht es nicht- es geht darum zu wissen wie, mit was der Server rennt... und vor allem warum!

das wissen fehlt leider bei den meisten....

nutze in zukunft lieber das Server Board Intel S2600BPS...

witzig finde ich auch, das du bei der 2019er Hyper-V kiste bleiben willst, obwohl dir fast jeder davon abraten würde...

Frank

nun sag das mal nicht... wir machen das schon über 25 Jahre....

Wir können dieses Blech exakt so auch von einem der Großen bauen lassen, das sind Standardkomponenten, die sind auch bei denen in dieser Kombination zertifiziert (weiss ich), das wird dann halt ein BTO System - kein Problem.

und für was zertifiziert? Server 2019.. ESXI? mit welcher Firmware / Bios Version... mit welchen einstellungen?also doch ein problem....

natürlich kann jerder Hans und Franz einen Server zusammenschustern, darum geht es nicht- es geht darum zu wissen wie, mit was der Server rennt... und vor allem warum!

das wissen fehlt leider bei den meisten....

Dann bieten dieser Hersteller des BTO Systems den Support und ich würde tagelang und irgendwann auch kostenpflichtig mit denen telefonieren. Könnten wir machen. Ist grad nicht. Die beiden Systeme sind schon da.

tja.. etwas support wäre nicht schlecht... nutze in zukunft lieber das Server Board Intel S2600BPS...

witzig finde ich auch, das du bei der 2019er Hyper-V kiste bleiben willst, obwohl dir fast jeder davon abraten würde...

Frank

moin..

du solltest aber schon wissen, das die Intel S2600 Serie euch für dein Formfaktor zu erwerben ist!

ich verstehe nicht, warum sich die "assemblierer" aufregen, wenn ihnen gesagt wird, das ist Bockmist, was du da machst...

was ist für dich am Intel S2600 MB so schlecht als Empfehlung? weil du dann den Supermicro Schrott auf halde liegen hast?

Frank

Generell 2019 zertifiziert, die sind noch dabei.

sagt ja schon alles....es könnte sein, oder vieleicht!du solltest aber schon wissen, das die Intel S2600 Serie euch für dein Formfaktor zu erwerben ist!

Tja Frank, ich finde das nicht witzig, das gleitet ab

das glaube ich dir gerne, den du verkaufst nicht supportete systeme, selbst für dein MB gibbet keine Server 2019 Treiber... aber gut, windows 10 ist ja schon mal ein anfang.ich verstehe nicht, warum sich die "assemblierer" aufregen, wenn ihnen gesagt wird, das ist Bockmist, was du da machst...

was ist für dich am Intel S2600 MB so schlecht als Empfehlung? weil du dann den Supermicro Schrott auf halde liegen hast?

Der Abteilung welche die Hardware beim Hersteller zertifiziert war recht überrascht von dem Problem und stellen....(tlw. erfolgreich) nach.

aha... dann sollte "Der Abteilung" dir besser mal vorschlagen, ein MB zu verbauen, was für deine zwecke auch 100% geeignet ist...Wir reden noch mit anderen und können das auch.

anscheinend nicht beim Bestellen....Frank

LIeber bonbastler,

wenn du von uns nichts hören willst, dann musst du hier nicht verweilen und auch keine Kommentare oder Fragen abgeben. So Unrecht hat Frank mit seinen Statements nicht. Gut, bzgl. Vmware und Hyper-V da is' er halt einfach ein Kind von VMware, soll er sein, ist OK. Aber grundsätzlich hockst du(!) auf dem Problem, nicht wir. Wie immer gilt: Bist du mit dem Service im Forum nicht zufrieden, kaufe dir direkten Service (per Geldbetrag X) ein. Dem kannst du dann auch (bedingt) Vorschreiben, wie und was er zu melden hat.

Viele Grüße,

Christian

wenn du von uns nichts hören willst, dann musst du hier nicht verweilen und auch keine Kommentare oder Fragen abgeben. So Unrecht hat Frank mit seinen Statements nicht. Gut, bzgl. Vmware und Hyper-V da is' er halt einfach ein Kind von VMware, soll er sein, ist OK. Aber grundsätzlich hockst du(!) auf dem Problem, nicht wir. Wie immer gilt: Bist du mit dem Service im Forum nicht zufrieden, kaufe dir direkten Service (per Geldbetrag X) ein. Dem kannst du dann auch (bedingt) Vorschreiben, wie und was er zu melden hat.

Viele Grüße,

Christian

Hallo Bonbastler,

wenn du wirklich eine Lösung (oder gar mehrere) hast, dann pack diese hier ins Forum, denn auch wenn man die Lösung nun selbst erarbeitet hat, gehört das zum guten Ton, diese zu publizieren. Anders sieht es ggf. nur aus, wenn man dritte dafür bezahlt hat eine Lösung zu erarbeiten, das negierst du aber indirekt.

Viele Grüße.

PS: Bitte certifiedit.net

wenn du wirklich eine Lösung (oder gar mehrere) hast, dann pack diese hier ins Forum, denn auch wenn man die Lösung nun selbst erarbeitet hat, gehört das zum guten Ton, diese zu publizieren. Anders sieht es ggf. nur aus, wenn man dritte dafür bezahlt hat eine Lösung zu erarbeiten, das negierst du aber indirekt.

Viele Grüße.

PS: Bitte certifiedit.net

Moin @ alle Mitleidenden,

habe die letzte und diese Woche einige Tage in das selbe Problem ungeplant investieren müssen. 😰

Kurz vor der Verzweiflung habe ich vor einigen Stunden dann aber einen Durchbruch gehabt. 😌

Zusammenfassung:

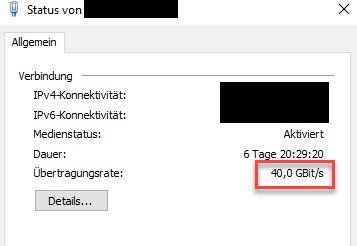

Das Problem tritt nur in Verbindung mit X722 & 1G UPLINK & HV2019 & VM < WIN 2019 auf.

Nun zur Lösung / Workaround:

Ich habe nun in jeden Server für 1G Uplinks eine zusätzliche, dualport I350 basierte Netzwerkkarte für je ~ 150,- verbaut

und siehe da die VMs bringen per SMB wieder 112 - 113 MBs. 🙏😃🤪

Mit aktiviertem SR-IOV & VMQ.

intel.de/content/www/de/de/ethernet-products/gigabit-server-adap ...

Es liegt somit definitiv am X722, der im Kern ein 10-40G Chipsatz ist, 1G kann dieser nur aus Kompatibilitätsgründen.

Ob das Problem auch mit einem 10G Uplink passiert, kann ich noch nicht sagen, aber in spätestens 2-3 Wochen,

da bekommt einer der Besitzer einen neuen ARUBA-Core mit 10G.

Werde auch den Intel Support noch stressen, wird aber erst nächste Woche was werden.

Ich bin jetzt erst mal glücklich, dass ich den neuen HV-Cluster, welcher am Freitag beim Kunden mit 1G Uplinks in Betrieb gehen wird,

nicht in einer Nacht und Nebelaktion, auf 2016 downgraden muss. Die 300,- für die beiden Adapter sind bei einem Systempreis von 50K (incl. SAN) für mich persönlich erst einmal vollkommen irrelevant.

Grüsse aus BaWü

Alex

habe die letzte und diese Woche einige Tage in das selbe Problem ungeplant investieren müssen. 😰

Kurz vor der Verzweiflung habe ich vor einigen Stunden dann aber einen Durchbruch gehabt. 😌

Zusammenfassung:

Das Problem tritt nur in Verbindung mit X722 & 1G UPLINK & HV2019 & VM < WIN 2019 auf.

Nun zur Lösung / Workaround:

Ich habe nun in jeden Server für 1G Uplinks eine zusätzliche, dualport I350 basierte Netzwerkkarte für je ~ 150,- verbaut

und siehe da die VMs bringen per SMB wieder 112 - 113 MBs. 🙏😃🤪

Mit aktiviertem SR-IOV & VMQ.

intel.de/content/www/de/de/ethernet-products/gigabit-server-adap ...

Es liegt somit definitiv am X722, der im Kern ein 10-40G Chipsatz ist, 1G kann dieser nur aus Kompatibilitätsgründen.

Ob das Problem auch mit einem 10G Uplink passiert, kann ich noch nicht sagen, aber in spätestens 2-3 Wochen,

da bekommt einer der Besitzer einen neuen ARUBA-Core mit 10G.

Werde auch den Intel Support noch stressen, wird aber erst nächste Woche was werden.

Ich bin jetzt erst mal glücklich, dass ich den neuen HV-Cluster, welcher am Freitag beim Kunden mit 1G Uplinks in Betrieb gehen wird,

nicht in einer Nacht und Nebelaktion, auf 2016 downgraden muss. Die 300,- für die beiden Adapter sind bei einem Systempreis von 50K (incl. SAN) für mich persönlich erst einmal vollkommen irrelevant.

Grüsse aus BaWü

Alex

Moin Frank,

da muss ich dir widersprechen.

Wir verbinden die Server immer über 10G Kupfer zum Core.

Zum einen ist es eine Budgetfrage. Eine LWL Verbindung kostet bei DACs mind. 100,- mehr und bei GBICs + Kabel kommst man locker auf ~ 500,- mehr pro Verbindung.

(ich weis, dass es weit günstiger geht, aber nicht wenn mann auf Kompatibilität und Zertifizierung achtet)

Zum Anderen kommt der Faktor Kompatibilität hinzu, der bei LWL nicht zu unterschätzen ist, besonders beim Einsatz von DACs.

Bei Kupfer hingegen gibt es keine Kompatibilitätsprobleme, höchstens Qualitätsprobleme bei den Patchkabeln.

Core zum Verteiler (>25m) binden wir bei 10G wiederum immer über LWL ab.

Grüsse aus BaWü

Alex

da muss ich dir widersprechen.

Wir verbinden die Server immer über 10G Kupfer zum Core.

Zum einen ist es eine Budgetfrage. Eine LWL Verbindung kostet bei DACs mind. 100,- mehr und bei GBICs + Kabel kommst man locker auf ~ 500,- mehr pro Verbindung.

(ich weis, dass es weit günstiger geht, aber nicht wenn mann auf Kompatibilität und Zertifizierung achtet)

Zum Anderen kommt der Faktor Kompatibilität hinzu, der bei LWL nicht zu unterschätzen ist, besonders beim Einsatz von DACs.

Bei Kupfer hingegen gibt es keine Kompatibilitätsprobleme, höchstens Qualitätsprobleme bei den Patchkabeln.

Core zum Verteiler (>25m) binden wir bei 10G wiederum immer über LWL ab.

Grüsse aus BaWü

Alex

Moin,

Zum einen ist es eine Budgetfrage. Eine LWL Verbindung kostet bei DACs mind. 100,- mehr und bei GBICs + Kabel kommst man locker auf ~ 500,- mehr pro Verbindung.

(ich weis, dass es weit günstiger geht, aber nicht wenn mann auf Kompatibilität und Zertifizierung achtet)

Zum Anderen kommt der Faktor Kompatibilität hinzu, der bei LWL nicht zu unterschätzen ist, besonders beim Einsatz von DACs.

Bei Kupfer hingegen gibt es keine Kompatibilitätsprobleme, höchstens Qualitätsprobleme bei den Patchkabeln.

Core zum Verteiler (>25m) binden wir bei 10G wiederum immer über LWL ab.

Grüsse aus BaWü

Alex

Frank

da muss ich dir widersprechen.

Wir verbinden die Server immer über 10G Kupfer zum Core.

ich sag ja nicht, das es nicht geht... sondern nur das es ziemlich warm wird... Wir verbinden die Server immer über 10G Kupfer zum Core.

Zum einen ist es eine Budgetfrage. Eine LWL Verbindung kostet bei DACs mind. 100,- mehr und bei GBICs + Kabel kommst man locker auf ~ 500,- mehr pro Verbindung.

(ich weis, dass es weit günstiger geht, aber nicht wenn mann auf Kompatibilität und Zertifizierung achtet)

Zum Anderen kommt der Faktor Kompatibilität hinzu, der bei LWL nicht zu unterschätzen ist, besonders beim Einsatz von DACs.

Bei Kupfer hingegen gibt es keine Kompatibilitätsprobleme, höchstens Qualitätsprobleme bei den Patchkabeln.

Core zum Verteiler (>25m) binden wir bei 10G wiederum immer über LWL ab.

Grüsse aus BaWü

Alex

Moin Bonbastler,

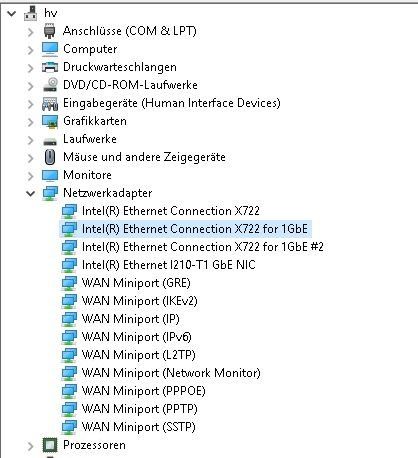

du solltest deinen Post im Bezug auf den X722 Adapter korrigieren, ich fürchte du bist hier auf denselben Irrtum reingefallen wie ich selber.

Deine Annahme, dass du ein Problem mit einem X722 NIC hast, stammt bestimmt daher, weil der Gerätemanager dir das vorgaukelt.

Leider gibt es bei Intel schon seit Längerem einen „BUG“ welcher bei der Installation der Treiber entweder den falschen Treiber installiert und oder den NIC falsch benennt. ☹

Auszug Readme

---

"Incorrect branding strings

Devices based on the Intel(R) Ethernet Controller X550 and Intel Ethernet

Controller X700 series may display incorrect branding strings in Windows Device Manager. This issue does not affect the functionality of the device. This issue only affects Microsoft* Windows Server* 2016."

---

In meinem Fall wurden die X557 Onboard-NICs ebenfalls als X722er erkannt.

Dein Board dürfte alleine schon aufgrund des Releasedatums (<2018) keine X722er NICs haben.

Der X722er Chipsatz wurde erst 2018 gelauncht.

Habe diesbezüglich vor einer Woche ein Supportcase bei Intel eröffnet, bisher gab es jedoch keine brauchbaren Neuigkeiten. ☹

Halte die Mannschaft auf dem laufenden sobald was Neues reinkommt.

Grüsse aus BaWü

Alex

du solltest deinen Post im Bezug auf den X722 Adapter korrigieren, ich fürchte du bist hier auf denselben Irrtum reingefallen wie ich selber.

Deine Annahme, dass du ein Problem mit einem X722 NIC hast, stammt bestimmt daher, weil der Gerätemanager dir das vorgaukelt.

Leider gibt es bei Intel schon seit Längerem einen „BUG“ welcher bei der Installation der Treiber entweder den falschen Treiber installiert und oder den NIC falsch benennt. ☹

Auszug Readme

---

"Incorrect branding strings

Devices based on the Intel(R) Ethernet Controller X550 and Intel Ethernet

Controller X700 series may display incorrect branding strings in Windows Device Manager. This issue does not affect the functionality of the device. This issue only affects Microsoft* Windows Server* 2016."

---

In meinem Fall wurden die X557 Onboard-NICs ebenfalls als X722er erkannt.

Dein Board dürfte alleine schon aufgrund des Releasedatums (<2018) keine X722er NICs haben.

Der X722er Chipsatz wurde erst 2018 gelauncht.

Habe diesbezüglich vor einer Woche ein Supportcase bei Intel eröffnet, bisher gab es jedoch keine brauchbaren Neuigkeiten. ☹

Halte die Mannschaft auf dem laufenden sobald was Neues reinkommt.

Grüsse aus BaWü

Alex

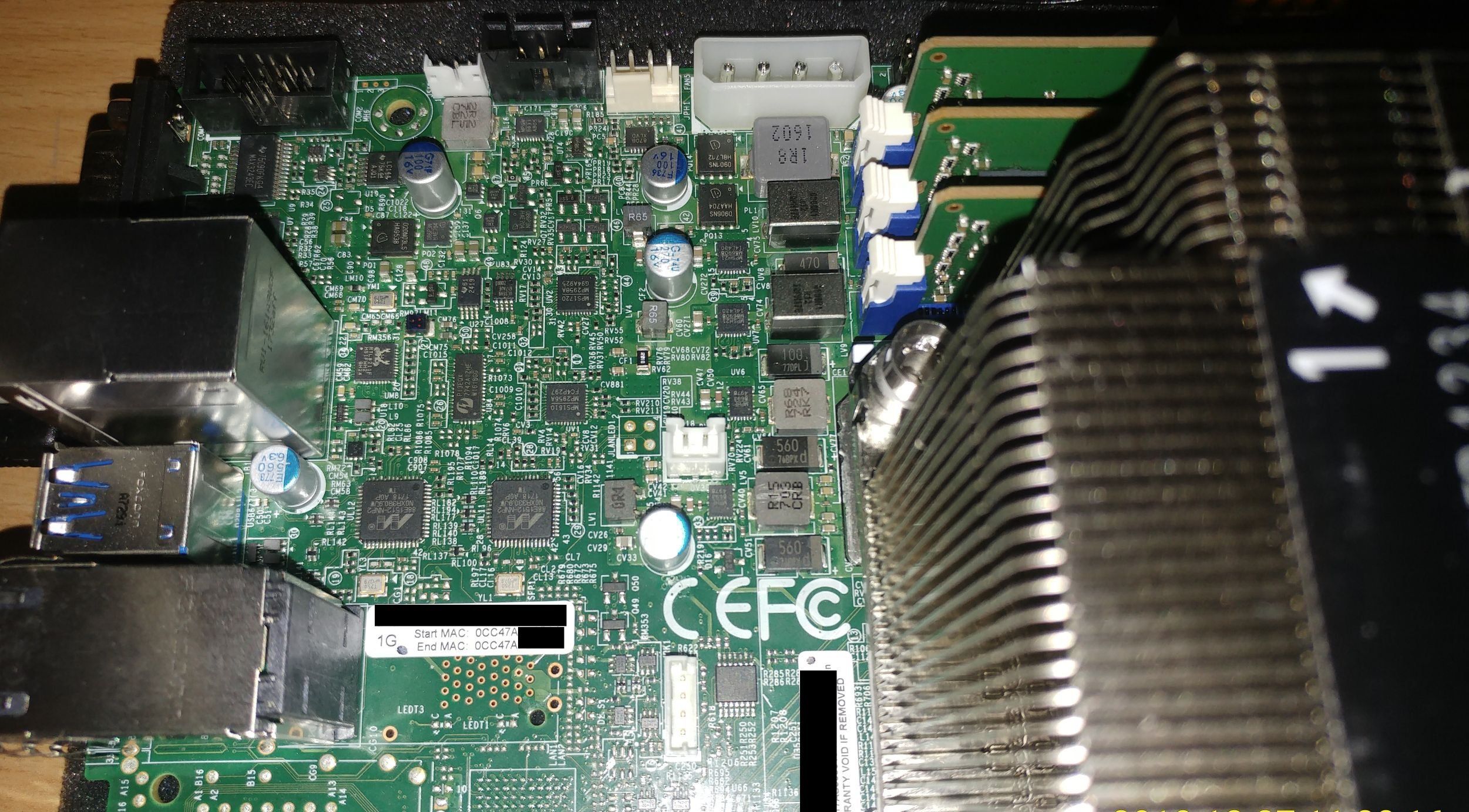

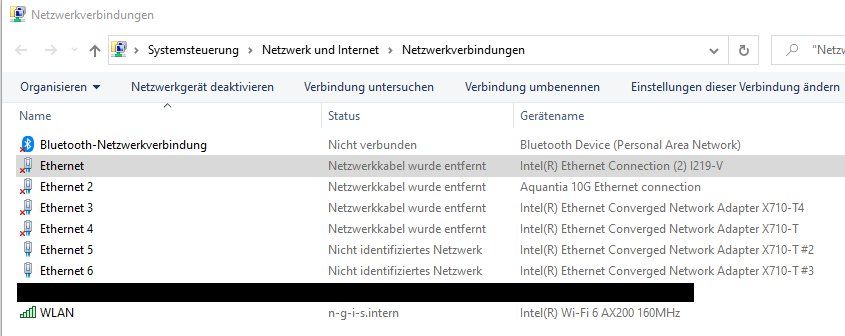

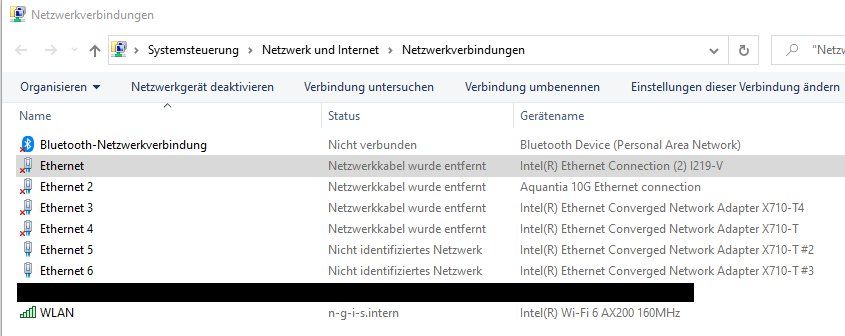

Moin Bon,

bin es auch nicht.

Habe die Marvell's entdeckt, siehe aktualisiertes Bild.

Bin kein SuperMicro Experte, wir arbeiten mit Intel Hardware.

Nun verstehe ich aber nicht wie du das mit "Hardware sind zwei fast identische neue Maschinen (MB Supermicro X11SPM-F mit 2x 1 GB Intel X722 onBoard NIC“ meinst, onBoard habe ich nichts von X722er entdeckt und deswegen geschrieben.

---

Ist aber auch zweitrangig, wenn du mit optionalen X722er NICs auch das Problem hast, dann hat der Treiber wahrscheinlich generell einen "Schuss" unabhängig ob mit falsch erkannten X557er oder mit richtigen X722er.

Interessant ...

Grüsse aus BaWü

Alex

bin es auch nicht.

Habe die Marvell's entdeckt, siehe aktualisiertes Bild.

Bin kein SuperMicro Experte, wir arbeiten mit Intel Hardware.

Nun verstehe ich aber nicht wie du das mit "Hardware sind zwei fast identische neue Maschinen (MB Supermicro X11SPM-F mit 2x 1 GB Intel X722 onBoard NIC“ meinst, onBoard habe ich nichts von X722er entdeckt und deswegen geschrieben.

---

Ist aber auch zweitrangig, wenn du mit optionalen X722er NICs auch das Problem hast, dann hat der Treiber wahrscheinlich generell einen "Schuss" unabhängig ob mit falsch erkannten X557er oder mit richtigen X722er.

Interessant ...

Grüsse aus BaWü

Alex

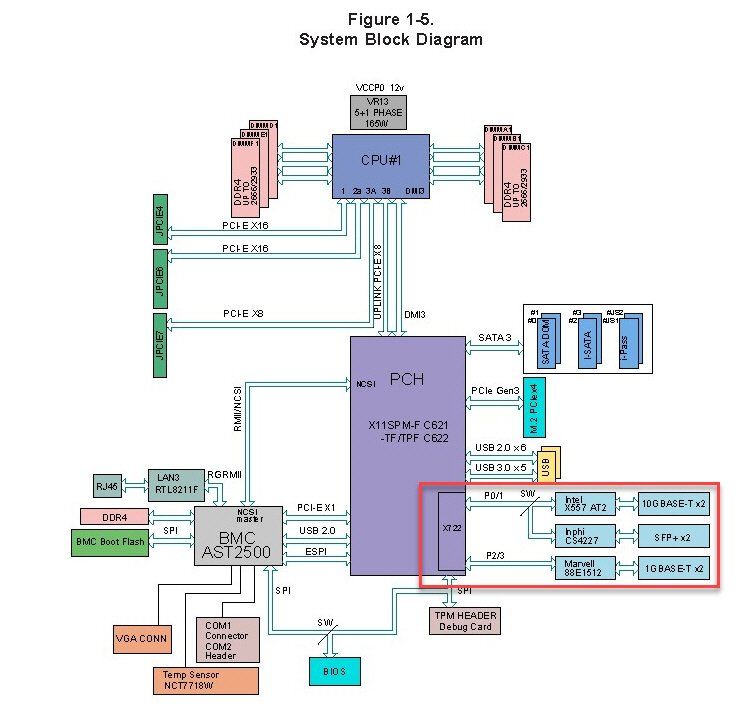

Moin Bon,

der Groschen ist soeben glaube ich gefallen.

Bei den OnboardNICs steckt die Funktionalität/Logik im Chipsatz (C621/X722), die X557/Marvell's übernehmen hierbei lediglich die physikalische Verbindungsschicht.

Ähnlich wie bei einem SFP/SFP+ Switch, die Funktionalität/Logik sitzt im Switch, die Verbindungschicht übernimmt der jeweilige GBIC.

Richtig verstanden?

Gruss Alex

der Groschen ist soeben glaube ich gefallen.

Bei den OnboardNICs steckt die Funktionalität/Logik im Chipsatz (C621/X722), die X557/Marvell's übernehmen hierbei lediglich die physikalische Verbindungsschicht.

Ähnlich wie bei einem SFP/SFP+ Switch, die Funktionalität/Logik sitzt im Switch, die Verbindungschicht übernimmt der jeweilige GBIC.

Richtig verstanden?

Gruss Alex

Moin Bon,

zurück zu der Problematik.

Wenn ich nun alles zusammenlege, dann entsteht das Problem nur bei der folgenden Konstellation.

HV-OS: 2019

VM-OS: irrelevant (konnten das Problem mit 2012R2/2016/2019 nachstellen)

V-Switch nach extern über X722(LOGIK) und 1G Uplink.

Die verwendete physikalische Übertragungschicht (X557 oder Marvell) ist dabei irrelevant.

Bei Verwendung eines "eigenständigen" Adapters basierend auf I350, treten hingegen keine Probleme auf.

???

Gruss Alex

zurück zu der Problematik.

Wenn ich nun alles zusammenlege, dann entsteht das Problem nur bei der folgenden Konstellation.

HV-OS: 2019

VM-OS: irrelevant (konnten das Problem mit 2012R2/2016/2019 nachstellen)

V-Switch nach extern über X722(LOGIK) und 1G Uplink.

Die verwendete physikalische Übertragungschicht (X557 oder Marvell) ist dabei irrelevant.

Bei Verwendung eines "eigenständigen" Adapters basierend auf I350, treten hingegen keine Probleme auf.

???

Gruss Alex

Moin Bon,

das mit HV 2019 & VM 219 kann ich nur zum Teil bestätigen.

VM 2019 --> HV 2019 --> 1G SWITCH --> Client W10 konnte ich keine Probleme feststellen.

Jedoch bei VM 2019 --> HV 2019 --> 1G SWITCH --> HV 2019 --> VM 2019 sehr wohl.

Die Lösung mit dem I350 setzen wir aktuell auch bei allen aktuellen Systemen mit 1G Switchen dahinter ein.

Ich habe vor 1,5 Wochen einen Supportcase bei Intel eröffnet und gebeten das ganze im Lab mal nachzustellen, siehe Anhang.

Bei allem was ich bisher gelesen habe, sollte die Lösung meines Problems auch deines beseitigen.

Bleibt nun abzuwarten.

Grüsse aus BaWü

Alex

P.S. Die Jungs vom Intel Support haben von mir auch den Link zu diesem Post hier bekommen.

das mit HV 2019 & VM 219 kann ich nur zum Teil bestätigen.

VM 2019 --> HV 2019 --> 1G SWITCH --> Client W10 konnte ich keine Probleme feststellen.

Jedoch bei VM 2019 --> HV 2019 --> 1G SWITCH --> HV 2019 --> VM 2019 sehr wohl.

Die Lösung mit dem I350 setzen wir aktuell auch bei allen aktuellen Systemen mit 1G Switchen dahinter ein.

Ich habe vor 1,5 Wochen einen Supportcase bei Intel eröffnet und gebeten das ganze im Lab mal nachzustellen, siehe Anhang.

Bei allem was ich bisher gelesen habe, sollte die Lösung meines Problems auch deines beseitigen.

Bleibt nun abzuwarten.

Grüsse aus BaWü

Alex

P.S. Die Jungs vom Intel Support haben von mir auch den Link zu diesem Post hier bekommen.

Hi Bon,

habe Update, siehe Mail die ich gerade an den Intel Support geschickt habe.

---

Hi Christian,

it’s a little bit cracy.

We prepare these week a new system for a customer.

The hardware is the same like the systems before, the only differences are a bunch of microsoft updates for the MS server 2019 and

a new version of the chipset driver.

Now, we can’t reproduce the issue!?!

The last day’s we try some different configurations.

HV was always MS Server 2019

VMQ & SRIOV are both enabled (BIOS, NIC, V-SWITCH, VM).

VM: MS Server 2019 MS Server 2019 112 – 113 MB’s

VM: MS Server 2016 MS Server 2016 112 – 113 MB’s

VM: MS Server 2012R2 MS Server 2012R2 112 – 113 MB’s

At the moment we, check the whole configuration (BIOS/OS/HV), to make sure that everything corresponds to the previous system.

---

Grüsse aus BaWü

Alex

habe Update, siehe Mail die ich gerade an den Intel Support geschickt habe.

---

Hi Christian,

it’s a little bit cracy.

We prepare these week a new system for a customer.

The hardware is the same like the systems before, the only differences are a bunch of microsoft updates for the MS server 2019 and

a new version of the chipset driver.

Now, we can’t reproduce the issue!?!

The last day’s we try some different configurations.

HV was always MS Server 2019

VMQ & SRIOV are both enabled (BIOS, NIC, V-SWITCH, VM).

VM: MS Server 2019 MS Server 2019 112 – 113 MB’s

VM: MS Server 2016 MS Server 2016 112 – 113 MB’s

VM: MS Server 2012R2 MS Server 2012R2 112 – 113 MB’s

At the moment we, check the whole configuration (BIOS/OS/HV), to make sure that everything corresponds to the previous system.

---

Grüsse aus BaWü

Alex

Moin Bon,

wenn ich etwas anfasse, dann richtig.

"Das Problem tritt ja nicht in der Kommunikation der VM untereinander innerhalb des Host über den HV Switch auf sondern zu 'beliebigen' Clients (physisch und virtuell) nach außen über die NIC."

Wir haben immer mit 2 HVs getestet.

HV01(2019) mit VM 2019 <--> Hardwareswitch <--> HV02(2019) mit VM 2019

HV01(2019) mit VM 2016 <--> Hardwareswitch <--> HV02(2019) mit VM 2016

HV01(2019) mit VM 2012R2 <--> Hardwareswitch <--> HV02(2019) mit VM 2012R2

Das müsste, wenn ich mich nicht täusche, auch dein Szenario abdecken.

Gruss Alex

wenn ich etwas anfasse, dann richtig.

"Das Problem tritt ja nicht in der Kommunikation der VM untereinander innerhalb des Host über den HV Switch auf sondern zu 'beliebigen' Clients (physisch und virtuell) nach außen über die NIC."

Wir haben immer mit 2 HVs getestet.

HV01(2019) mit VM 2019 <--> Hardwareswitch <--> HV02(2019) mit VM 2019

HV01(2019) mit VM 2016 <--> Hardwareswitch <--> HV02(2019) mit VM 2016

HV01(2019) mit VM 2012R2 <--> Hardwareswitch <--> HV02(2019) mit VM 2012R2

Das müsste, wenn ich mich nicht täusche, auch dein Szenario abdecken.

Gruss Alex

Moin Bon,

kam gerade vom Intel Support rein.

---

Hello Alexander,

Thank you for the update in regards to the experience on your end.

We also noticed that the new updates from Microsoft have some impact on our current configurations but in some different scenarios.

We will still continue and try to replicate the issue and see what results we will get over the testing period.

When we get some details we will let you know for sure.

At the same time, if you find out some details on your side, we would be very tankful for additional feedback.

Once again thank you in advance.

---

Lag vielleicht doch nicht an Intel sondern an MS. 😀

Wünsche allen ein schönes Wochenende.

Ich tauche jetzt ab . 😎🤪🤘🏿

Gruss Alex

kam gerade vom Intel Support rein.

---

Hello Alexander,

Thank you for the update in regards to the experience on your end.

We also noticed that the new updates from Microsoft have some impact on our current configurations but in some different scenarios.

We will still continue and try to replicate the issue and see what results we will get over the testing period.

When we get some details we will let you know for sure.

At the same time, if you find out some details on your side, we would be very tankful for additional feedback.

Once again thank you in advance.

---

Lag vielleicht doch nicht an Intel sondern an MS. 😀

Wünsche allen ein schönes Wochenende.

Ich tauche jetzt ab . 😎🤪🤘🏿

Gruss Alex

Moin Bon,

wir haben das System noch bin Anfang nächster Woche.

Wir testen noch das NIC-Teaming und wenn das gut geht dann ist der Fisch für uns geputzt.

Mit welchen Clients hattest du bis jetzt Probleme?

Wir testen unser Setup nochmals mit Win10 Workstation gegen HV2019 und VM2016 & VM2012R2.

Gebe dir Bescheid, sobald die Tests durch sind.

Gruss Alex

wir haben das System noch bin Anfang nächster Woche.

Wir testen noch das NIC-Teaming und wenn das gut geht dann ist der Fisch für uns geputzt.

Mit welchen Clients hattest du bis jetzt Probleme?

Wir testen unser Setup nochmals mit Win10 Workstation gegen HV2019 und VM2016 & VM2012R2.

Gebe dir Bescheid, sobald die Tests durch sind.

Gruss Alex

Moin Bon,

sind durch mit den Tests. 😀🤘🏿

(Anwortmail an Intel)

---

Hi Christian,

today we test the last part, NIC-Teaming (2 x 1Gbit/s), it works fine.

HV01(2019) with VM 2019 <--> Hardwareswitch <--> HV02(2019) with VM 2019 112-113MB/s

HV01(2019) with VM 2016 <--> Hardwareswitch <--> HV02(2019) with VM 2016 112-113MB/s

HV01(2019) with VM 2012R2 <--> Hardwareswitch <--> HV02(2019) with VM 2012R2 112-113MB/s

HV01(2019) with VM 2019 <--> Hardwareswitch <--> Workstation W10 112-113MB/s

HV01(2019) with VM 2016 <--> Hardwareswitch <--> Workstation W10 112-113MB/s

HV01(2019) with VM 2012R2 <--> Hardwareswitch <--> Workstation W10 112-113MB/s

I think our problem is solved. 😀

MS Update ???

Best regards

Alex

---

Gruss Alex

sind durch mit den Tests. 😀🤘🏿

(Anwortmail an Intel)

---

Hi Christian,

today we test the last part, NIC-Teaming (2 x 1Gbit/s), it works fine.

HV01(2019) with VM 2019 <--> Hardwareswitch <--> HV02(2019) with VM 2019 112-113MB/s

HV01(2019) with VM 2016 <--> Hardwareswitch <--> HV02(2019) with VM 2016 112-113MB/s

HV01(2019) with VM 2012R2 <--> Hardwareswitch <--> HV02(2019) with VM 2012R2 112-113MB/s

HV01(2019) with VM 2019 <--> Hardwareswitch <--> Workstation W10 112-113MB/s

HV01(2019) with VM 2016 <--> Hardwareswitch <--> Workstation W10 112-113MB/s

HV01(2019) with VM 2012R2 <--> Hardwareswitch <--> Workstation W10 112-113MB/s

I think our problem is solved. 😀

MS Update ???

Best regards

Alex

---

Gruss Alex

Hallo zusammen,

interessanter Post. So ähnlich habe ich es auch, aber mit einer ganz einfachen Konfiguration, keine VMs, kein „Schnickschnack“, simply Dateitransfer, kein Teaming:

- verschiedene Windows 10 Rechner

- Win2016 Server (Intel)

- Win2019 Server (AMD)

- Netgear 10G switch

- Alle Asus 10G Karte RJ45

- Alle Treibereinstellungen probiert, danach wieder auf Standard gestellt

Aufgabe: Einfach nur eine 24GB Datei vom Server laden.

Win2016 Server -> Windows 10 Rechner konstant 500MByte/sec

Windows 10 RechnerA -> Windows 10 RechnerB konstant 1,09GByte/sec (nvme)

Win2019 Server -> Windows 10 Rechner unberechenbar, startet teilweise bei 500MB/sec, dann drop auf 360KB/sec . Oder „startet“ gleich mit 360KB/Sec.

Bin mit meinem Latein am Ende. Problem scheint doch auf Server2019 fokussiert zu sein. Vielleicht im Zusammenspiel mit AMD.

Update: Es liegt nicht an der Asus Karte, Bei Verwendung einer Intel Karte dasselbe Problem...

interessanter Post. So ähnlich habe ich es auch, aber mit einer ganz einfachen Konfiguration, keine VMs, kein „Schnickschnack“, simply Dateitransfer, kein Teaming:

- verschiedene Windows 10 Rechner

- Win2016 Server (Intel)

- Win2019 Server (AMD)

- Netgear 10G switch

- Alle Asus 10G Karte RJ45

- Alle Treibereinstellungen probiert, danach wieder auf Standard gestellt

Aufgabe: Einfach nur eine 24GB Datei vom Server laden.

Win2016 Server -> Windows 10 Rechner konstant 500MByte/sec

Windows 10 RechnerA -> Windows 10 RechnerB konstant 1,09GByte/sec (nvme)

Win2019 Server -> Windows 10 Rechner unberechenbar, startet teilweise bei 500MB/sec, dann drop auf 360KB/sec . Oder „startet“ gleich mit 360KB/Sec.

Bin mit meinem Latein am Ende. Problem scheint doch auf Server2019 fokussiert zu sein. Vielleicht im Zusammenspiel mit AMD.

Update: Es liegt nicht an der Asus Karte, Bei Verwendung einer Intel Karte dasselbe Problem...

Ich habe/hatte auch das Problem, dass jegliche VM (wie von @MysticFoxDE beschrieben) einen schlechten Durchsatz hatte.

Nachdem ich auf den 2019er VMs den Panda Virenschutz deinstallierte, funktionierten diese zumindest ohne Probleme.

Problem bei den 2010R2er VMs bleibt jedoch bestehen.

Alles was ich bisher probierte, brachte nichts:

Habe dann Tests mit einer 14,99€ "teuren" Realtek USB GbE Family gemacht. Und voilà: alles funktioniert.

Keine Ahnung ob es am Treiber oder an den Einstellungen hakt. Aber kann bestätigen, dass es hier definitiv Probleme gibt.

@MysticFoxDE:

was hat denn der Intel-Support dir nun geantwortet? Wie wollen die denn weiter vorgehen?

Grüße

Patrick

Nachdem ich auf den 2019er VMs den Panda Virenschutz deinstallierte, funktionierten diese zumindest ohne Probleme.

Problem bei den 2010R2er VMs bleibt jedoch bestehen.

Alles was ich bisher probierte, brachte nichts:

- aktuellen Treiber installiert

- aktuelle Firmware von Lenovo installiert

- Panda Virenschutz deinstalliert

- VMQ deaktiviert (ist bei 1GBit NICs ja sowieso nicht standardmäßig aktiviert)

- Flußsteuerung und Puffergrößen auf die empfohlenen Einstellungen von Intel gesetzt (klick)

- Direkt in den VM-Einstellungen die "Warteschlange für virtuelle Computer" deaktiviert

- IPsec-Taskabladung deaktiviert

- RSC deaktiviert (klick)

- Large send offload deaktiviert

- TCP- und UDP-Prüfsummenabladung deaktiviert (sowohl auf physischer als auch auf virtueller NIC)

- Upgrade der VM von Gen1 auf Gen2 (klick)

- ...

Habe dann Tests mit einer 14,99€ "teuren" Realtek USB GbE Family gemacht. Und voilà: alles funktioniert.

Keine Ahnung ob es am Treiber oder an den Einstellungen hakt. Aber kann bestätigen, dass es hier definitiv Probleme gibt.

@MysticFoxDE:

was hat denn der Intel-Support dir nun geantwortet? Wie wollen die denn weiter vorgehen?

Grüße

Patrick

Hi Patrick,

wir können das Problem nicht mehr reproduzieren.

Nach mehrfacher Prüfung entspricht die Konfiguration des jetzigen "Labs" exakt der Konfiguration, der vorherigen Systeme.

Der einzige Unterschied ist der Patchlevel des 2019er Servers, die jetzige Lab ist auf dem allerneusten Stand gegen MS Updates, nicht WSUS.

---

VMQ deaktiviert (ist bei 1GBit NICs ja sowieso nicht standardmäßig aktiviert)

Flußsteuerung und Puffergrößen auf die empfohlenen Einstellungen von Intel gesetzt (klick)

Direkt in den VM-Einstellungen die "Warteschlange für virtuelle Computer" deaktiviert

IPsec-Taskabladung deaktiviert

RSC deaktiviert (klick)

Large send offload deaktiviert

TCP- und UDP-Prüfsummenabladung deaktiviert (sowohl auf physischer als auch auf virtueller NIC)

---

Hatten wir früher auch gemacht, ist aber nicht mehr notwendig, zumindest nicht bei unserem Szenario.

Grüsse aus BaWü

Alex

wir können das Problem nicht mehr reproduzieren.

Nach mehrfacher Prüfung entspricht die Konfiguration des jetzigen "Labs" exakt der Konfiguration, der vorherigen Systeme.

Der einzige Unterschied ist der Patchlevel des 2019er Servers, die jetzige Lab ist auf dem allerneusten Stand gegen MS Updates, nicht WSUS.

---

VMQ deaktiviert (ist bei 1GBit NICs ja sowieso nicht standardmäßig aktiviert)

Flußsteuerung und Puffergrößen auf die empfohlenen Einstellungen von Intel gesetzt (klick)

Direkt in den VM-Einstellungen die "Warteschlange für virtuelle Computer" deaktiviert

IPsec-Taskabladung deaktiviert

RSC deaktiviert (klick)

Large send offload deaktiviert

TCP- und UDP-Prüfsummenabladung deaktiviert (sowohl auf physischer als auch auf virtueller NIC)

---

Hatten wir früher auch gemacht, ist aber nicht mehr notwendig, zumindest nicht bei unserem Szenario.

Grüsse aus BaWü

Alex

Danke für deine Rückmeldung.

Das soll nun einer noch verstehen...

Grüße

Patrick

Zitat von @MysticFoxDE:

Der einzige Unterschied ist der Patchlevel des 2019er Servers, die jetzige Lab ist auf dem allerneusten Stand gegen MS Updates, nicht WSUS.

Bei mir auch alles aktuell (ohne WSUS) und trotzdem genau die gleichen Symptome wie ihr sie hattet (und scheinbar nun bei euch behoben sind).Der einzige Unterschied ist der Patchlevel des 2019er Servers, die jetzige Lab ist auf dem allerneusten Stand gegen MS Updates, nicht WSUS.

Das soll nun einer noch verstehen...

Grüße

Patrick

Moin Patrick,

bei uns sind die Probleme momentan in Verbindung mit einem NEUEN System nicht mehr nachvollziehbar.

Zumindest nicht, wenn unsere Adapter mit 1G laufen, mit 10G habe ich diese bisher nicht getestet, da keiner unserer Kuden 10G zum Client betreibt.

Die bisherigen 3 Systeme die wir auf 2019 ausgeliefert haben, sind alle mit i350 er nachgerüstet worden und laufen seit dem mit 1G reibungslos.

Versuch mal den folgenden Trick.

Gehe in den Gerätemanager und deinstalliere alle X722 Adapter, danach Hardwareerkennung (Nach geänderter Hardware suchen) ausführen und die Adapter anschliessend neu konfigurieren. Ist lästig, aber ich habe da so eine Vermutung die auf der folgenden jüngsten Erfahrung beruht.

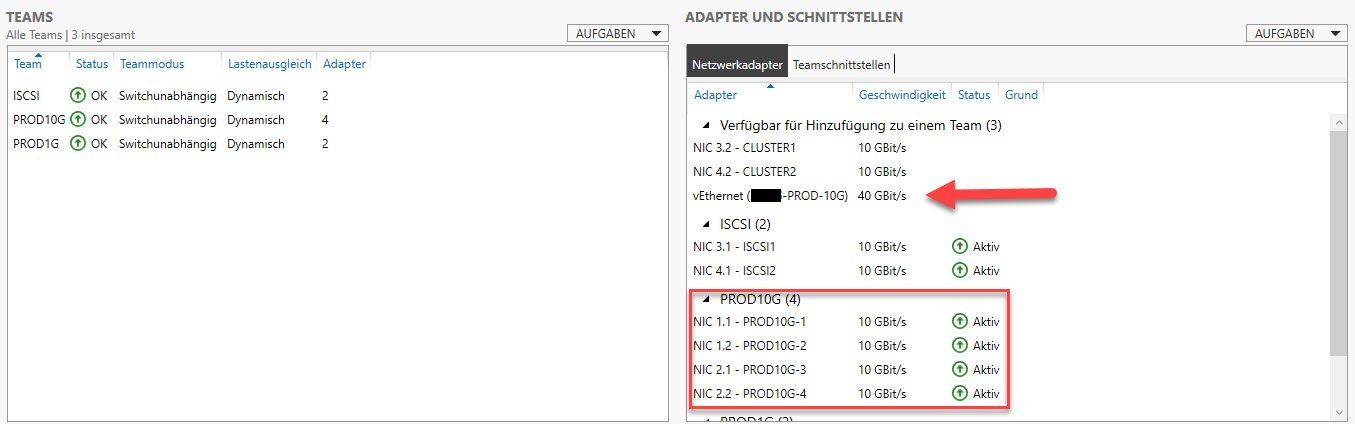

Bei den Tests, die wir die letzten Tage gemacht haben, wurde unter anderem auch ein vierfach Teaming getestet.

Das Ergebnis war OK, aber als ich zwei der vier NICs wieder aus dem Team geschmissen habe, konnte ich dieselben nicht mehr in ein neues Team hinzufügen, die NICs waren über den Servermanager nicht mehr sichtbar (wir nutzen MS-Teaming (Modus --> Switchunabhängig), nicht Intel-Teaming). Die NICs waren erst nach der oben beschriebenen Prozedur über den Servermanager wieder konfigurierbar.

Ich schätze MS muss noch ein paar BUGs mehr beseitigen ... ☹

Wir deaktivieren ferner auf allen Adaptern IPv6, wollte ich nur der Vollständigkeit halber erwähnen.

Grüsse aus BaWü

Alex

bei uns sind die Probleme momentan in Verbindung mit einem NEUEN System nicht mehr nachvollziehbar.

Zumindest nicht, wenn unsere Adapter mit 1G laufen, mit 10G habe ich diese bisher nicht getestet, da keiner unserer Kuden 10G zum Client betreibt.

Die bisherigen 3 Systeme die wir auf 2019 ausgeliefert haben, sind alle mit i350 er nachgerüstet worden und laufen seit dem mit 1G reibungslos.

Versuch mal den folgenden Trick.

Gehe in den Gerätemanager und deinstalliere alle X722 Adapter, danach Hardwareerkennung (Nach geänderter Hardware suchen) ausführen und die Adapter anschliessend neu konfigurieren. Ist lästig, aber ich habe da so eine Vermutung die auf der folgenden jüngsten Erfahrung beruht.

Bei den Tests, die wir die letzten Tage gemacht haben, wurde unter anderem auch ein vierfach Teaming getestet.

Das Ergebnis war OK, aber als ich zwei der vier NICs wieder aus dem Team geschmissen habe, konnte ich dieselben nicht mehr in ein neues Team hinzufügen, die NICs waren über den Servermanager nicht mehr sichtbar (wir nutzen MS-Teaming (Modus --> Switchunabhängig), nicht Intel-Teaming). Die NICs waren erst nach der oben beschriebenen Prozedur über den Servermanager wieder konfigurierbar.

Ich schätze MS muss noch ein paar BUGs mehr beseitigen ... ☹

Wir deaktivieren ferner auf allen Adaptern IPv6, wollte ich nur der Vollständigkeit halber erwähnen.

Grüsse aus BaWü

Alex

Moin Hub22019,

welche Hardware benutzt du für die Server, Mainboard/CPU?

Welchen Storagetyp hat der Server HHD/SSD, SATA/SAS/NVME?

"Win2016 Server -> Windows 10 Rechner konstant 500MByte/sec"

"Win2019 Server -> Windows 10 Rechner unberechenbar, startet teilweise bei 500MB/sec, dann drop auf 360KB/sec . Oder „startet“ gleich mit 360KB/Sec"

???

Es ist etwas kurios, dass bei dir beide, sowohl der 2016er als auch der 2019er spacken ...

Hast du evtl. einseitig Jumboframe eingestellt?

VLAN, Routing dazwischen?

Je mehr Infos um so besser.

Gruss Alex

welche Hardware benutzt du für die Server, Mainboard/CPU?

Welchen Storagetyp hat der Server HHD/SSD, SATA/SAS/NVME?

"Win2016 Server -> Windows 10 Rechner konstant 500MByte/sec"

"Win2019 Server -> Windows 10 Rechner unberechenbar, startet teilweise bei 500MB/sec, dann drop auf 360KB/sec . Oder „startet“ gleich mit 360KB/Sec"

???

Es ist etwas kurios, dass bei dir beide, sowohl der 2016er als auch der 2019er spacken ...

Hast du evtl. einseitig Jumboframe eingestellt?

VLAN, Routing dazwischen?

Je mehr Infos um so besser.

Gruss Alex

Hallo Alex,

hatte nun hier einen thread aufgemacht:

10GBE Filetransfer vom Windows2019 server aus funktioniert nicht

Server2016 Microserver gen8: Sata ssd 6g

Server2019 Microserver gen10: Sata ssd 6g

PCs: nvme

Jumbo überall eingestellt.

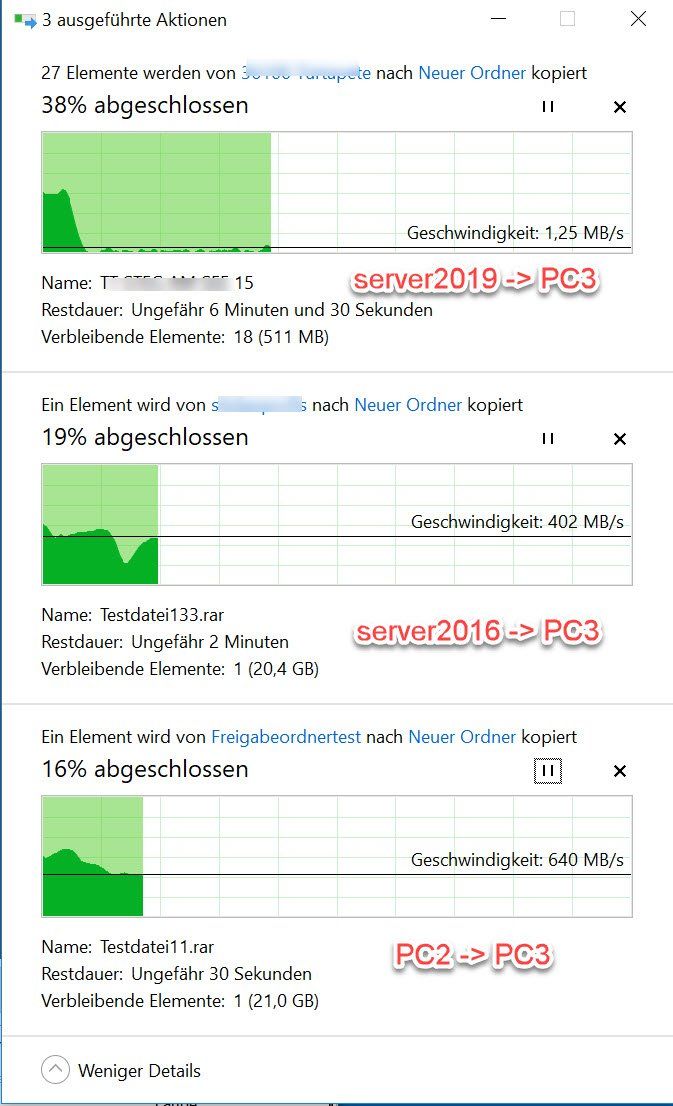

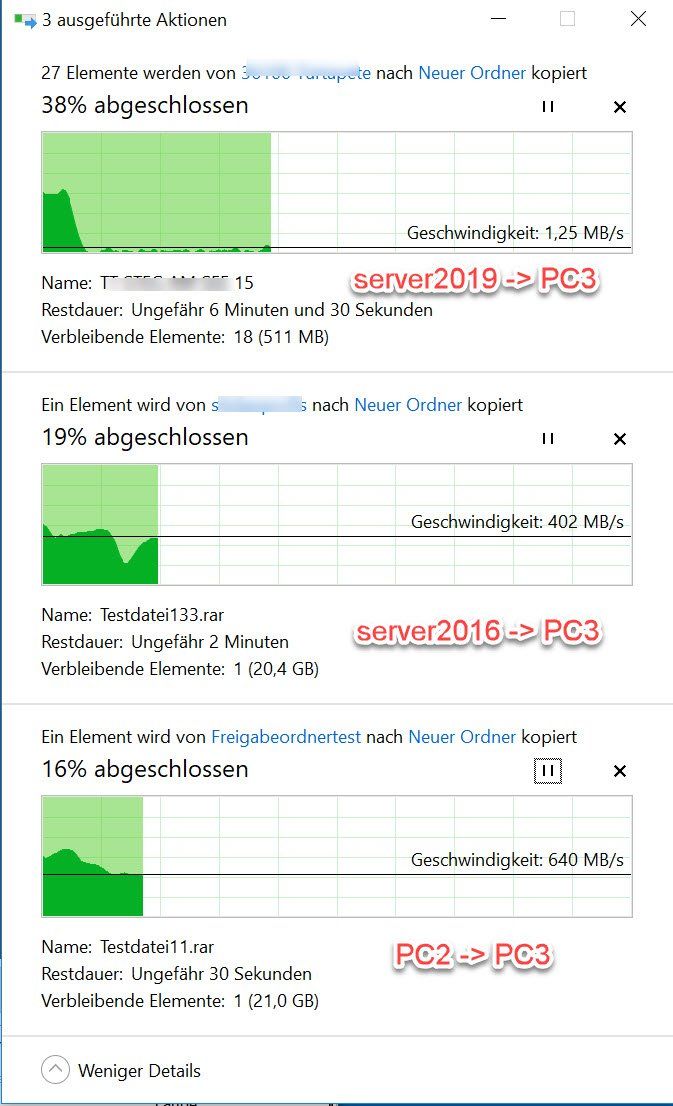

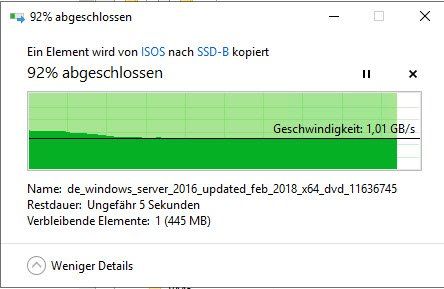

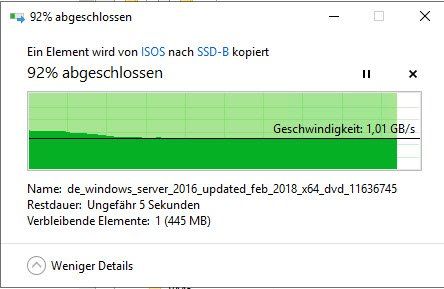

Auf dem folgenden Screenshot sieht man auf einen Blick das Problem. Dabei habe ich die beiden unteren Kopiervorgänge gestartet, als beim oberen schon seit 20 Sekunden bei 300kb/sec herumgedümpelt wird. WTF...

Am besten bitte im anderen Thread antworten

hatte nun hier einen thread aufgemacht:

10GBE Filetransfer vom Windows2019 server aus funktioniert nicht

Server2016 Microserver gen8: Sata ssd 6g

Server2019 Microserver gen10: Sata ssd 6g

PCs: nvme

Jumbo überall eingestellt.

Auf dem folgenden Screenshot sieht man auf einen Blick das Problem. Dabei habe ich die beiden unteren Kopiervorgänge gestartet, als beim oberen schon seit 20 Sekunden bei 300kb/sec herumgedümpelt wird. WTF...

Am besten bitte im anderen Thread antworten

Moin Patrick,

Moin Badger,

wenn Ihr auf dem 2019er Server noch etwas RAM übrig habt, so probiert bitte das folgende.

Generiert bitte mit dem folgenden Tool eine RAM-DISK.

sourceforge.net/projects/imdisk-toolkit/

Freigabe drauf und den Test wiederholen.

Ergebnis ???

---

Um bei einem MS Server die vollen Transferraten zu erreichen, sollte man ferner immer die Energieoptionen auf "Hochleistung" setzen!!!

Bei einem 2019er hätte ich euch noch den folgenden Trick.

CMD mit Adminrechten aufmachen und dann die folgenden beiden Befehle ausführen.

1. "powercfg -duplicatescheme e9a42b02-d5df-448d-aa00-03f14749eb61"

2. "powercfg.exe -setactive 9d69a0c6-32fb-4d7a-b235-e37b7d0111c0"

3. Unter Energieeinstellungen nachsehen. 😉🤪

Diese Einstellung muss sowohl auf dem HV als auch auf der VM gemacht werden.

Grüsse aus BaWü

Alex

Moin Badger,

wenn Ihr auf dem 2019er Server noch etwas RAM übrig habt, so probiert bitte das folgende.

Generiert bitte mit dem folgenden Tool eine RAM-DISK.

sourceforge.net/projects/imdisk-toolkit/

Freigabe drauf und den Test wiederholen.

Ergebnis ???

---

Um bei einem MS Server die vollen Transferraten zu erreichen, sollte man ferner immer die Energieoptionen auf "Hochleistung" setzen!!!

Bei einem 2019er hätte ich euch noch den folgenden Trick.

CMD mit Adminrechten aufmachen und dann die folgenden beiden Befehle ausführen.

1. "powercfg -duplicatescheme e9a42b02-d5df-448d-aa00-03f14749eb61"

2. "powercfg.exe -setactive 9d69a0c6-32fb-4d7a-b235-e37b7d0111c0"

3. Unter Energieeinstellungen nachsehen. 😉🤪

Diese Einstellung muss sowohl auf dem HV als auch auf der VM gemacht werden.

Grüsse aus BaWü

Alex

Moin Hub22019,

ergänzend zu dem zuletzt geprosteten.

Du musst unbedingt sicherstellen, dass deine Storage-Hardware die 1GB/s bei einem "single thread / single task" auch packt.

Das bekommen im Normalfall nur PCIe/NVME SSDs hin oder ein leistungsfähiges SAN am Server.

Mit (6G)SATA SSDs wirst du das ohne einen RAID-Verbund 100% nicht hinbekommen.

Wir verwenden in unseren Servern P4800X von Intel als Bootlaufwerke und das angeschlossenen AllFlash-SAN ist auch sehr leistungsfähig,

beide packen bei "single thread" locker > 1000 MB/s.

Grüsse aus BaWü

Alex

ergänzend zu dem zuletzt geprosteten.

Du musst unbedingt sicherstellen, dass deine Storage-Hardware die 1GB/s bei einem "single thread / single task" auch packt.

Das bekommen im Normalfall nur PCIe/NVME SSDs hin oder ein leistungsfähiges SAN am Server.

Mit (6G)SATA SSDs wirst du das ohne einen RAID-Verbund 100% nicht hinbekommen.

Wir verwenden in unseren Servern P4800X von Intel als Bootlaufwerke und das angeschlossenen AllFlash-SAN ist auch sehr leistungsfähig,

beide packen bei "single thread" locker > 1000 MB/s.

Grüsse aus BaWü

Alex

Danke allen - ganz besonders @MysticFoxDE - für eure Hilfe.

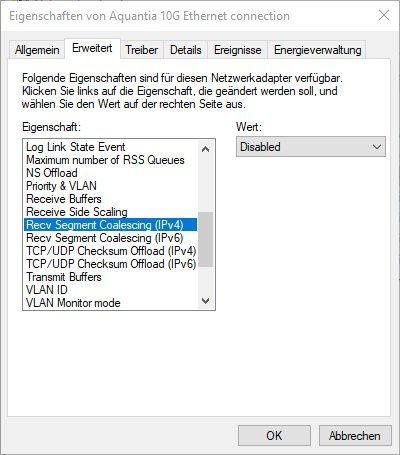

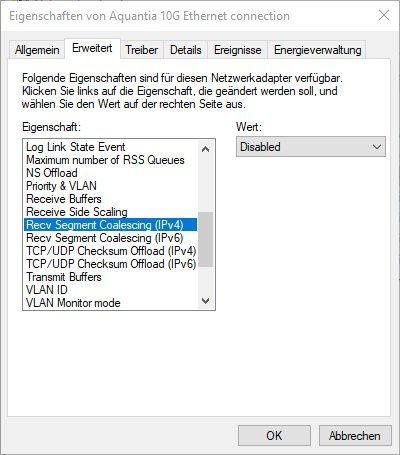

Ich konnte nun das Problem lösen. Im Lenovo Forum brachte mir ein User den entscheidenden Hinweis:

Es muss dabei wirklich RSC auf der NIC abgeschaltet werden. Das deaktivieren von RSC am vSwitch löste bei mir das Problem nicht!

@bonbastler:

War dies evt. auch bei deinem Problem die Lösung?

Grüße

Patrick

Ich konnte nun das Problem lösen. Im Lenovo Forum brachte mir ein User den entscheidenden Hinweis:

After trying different drivers, firmware, etc. the only solution I finally found was this:

In the Driver -> Advanced for the NIC:

Recv Segment Coalescing (IPv4) - set to Disabled

Recv Segment Coalescing (IPv6) - set to Disabled

In the Driver -> Advanced for the NIC:

Recv Segment Coalescing (IPv4) - set to Disabled

Recv Segment Coalescing (IPv6) - set to Disabled

Es muss dabei wirklich RSC auf der NIC abgeschaltet werden. Das deaktivieren von RSC am vSwitch löste bei mir das Problem nicht!

@bonbastler:

War dies evt. auch bei deinem Problem die Lösung?

Grüße

Patrick

Auch diesbezüglich noch zur Info:

Wenn der Server 2019 ist, kam es bei mir prinzipiell nicht zu einem Problem. Außer Panda war installiert.

Seit ich RSC deaktiviert habe, funktioniert es auch mit installiertem Panda beträchtlich besser.

Patrick

Wenn der Server 2019 ist, kam es bei mir prinzipiell nicht zu einem Problem. Außer Panda war installiert.

Seit ich RSC deaktiviert habe, funktioniert es auch mit installiertem Panda beträchtlich besser.

Patrick

Hi Patrick,

vielen Dank für diese sehr interessante Info, werde diese im Auge behalten.

Habe soeben das Lab-System welches morgen ausgeliefert wird nochmals hochgefahren und die Einstellungen geprüft,

bei uns sind die Optionen auf "Enabled" ohne Performanceeinbussen. ?!?

Aber dennoch sehr Cool, nun weis ich ja wo ich drehen muss, falls doch welche auftauchen. 👍

Nochmals herzlichen Dank für das Teilen der Lösung.

Gruss Alex

vielen Dank für diese sehr interessante Info, werde diese im Auge behalten.

Habe soeben das Lab-System welches morgen ausgeliefert wird nochmals hochgefahren und die Einstellungen geprüft,

bei uns sind die Optionen auf "Enabled" ohne Performanceeinbussen. ?!?

Aber dennoch sehr Cool, nun weis ich ja wo ich drehen muss, falls doch welche auftauchen. 👍

Nochmals herzlichen Dank für das Teilen der Lösung.

Gruss Alex

Hallo!

Ich möchte hier gerne Einsteigen und unsere Erfahrung teilen:

System: Fujitsu 2540M5 mit 2x X710 10G Karten.

Hyper-V Rolle installiert. Eine 10G Karte als Taggen Uplink für die VM's.

Wir haben angefangen VMs von einem 2012R2 zu migrieren. Das Ganze lief 2 Wochen einwandfrei.

Vor einigen Tagen fingen die Performance Probleme der VMs an:

Datendurchsatz meist unter 22MB/s - oftmals um die 3MB/s. Teilweise lassen sich Dateien nicht öffnen, oder Verbindungen zu einer Oracle DB brechen ab.

Was ich beobachten konnte: Das Kopieren einer ISO Datei mit 1GB hat auf die VM's (2008, 2008R2 und 2012R2) einen Durchsatz von 3MB/s.

2019er VM's bringen allerdings den vollen Durchsatz!

Wir haben dann die internen RJ45 als virtual Switch konfiguriert. Es handelt sich hier um X722 Karten.

Hier zeigt sich exakt das selbe Verhalten.

Kopiere ich nun aber über die 10G Karte, als auch über die 1G Karte direkt auf den Hyper-V Host, habe ich wieder vollen Durchsatz.

Mir scheinen die NIC Treiber OK zu sein. Es scheint mir als gäbe es massive Probleme zwischen den VM's kleiner 2019 und dem virtual Switch.

Wir haben jetzt angefangen und migrieren zurück auf 2012R2 um die Firma am laufen zu halten.

Testweise haben wir das Oracle System und einen Fileserver auf einen 2012R2 Hyper-V zu schieben. Ebenfalls mit den 10G Karten: Voller Durchsatz. Die Maschinen laufen rund.

Matt

Ich möchte hier gerne Einsteigen und unsere Erfahrung teilen:

System: Fujitsu 2540M5 mit 2x X710 10G Karten.

Hyper-V Rolle installiert. Eine 10G Karte als Taggen Uplink für die VM's.

Wir haben angefangen VMs von einem 2012R2 zu migrieren. Das Ganze lief 2 Wochen einwandfrei.

Vor einigen Tagen fingen die Performance Probleme der VMs an:

Datendurchsatz meist unter 22MB/s - oftmals um die 3MB/s. Teilweise lassen sich Dateien nicht öffnen, oder Verbindungen zu einer Oracle DB brechen ab.

Was ich beobachten konnte: Das Kopieren einer ISO Datei mit 1GB hat auf die VM's (2008, 2008R2 und 2012R2) einen Durchsatz von 3MB/s.

2019er VM's bringen allerdings den vollen Durchsatz!

Wir haben dann die internen RJ45 als virtual Switch konfiguriert. Es handelt sich hier um X722 Karten.

Hier zeigt sich exakt das selbe Verhalten.

Kopiere ich nun aber über die 10G Karte, als auch über die 1G Karte direkt auf den Hyper-V Host, habe ich wieder vollen Durchsatz.

Mir scheinen die NIC Treiber OK zu sein. Es scheint mir als gäbe es massive Probleme zwischen den VM's kleiner 2019 und dem virtual Switch.

Wir haben jetzt angefangen und migrieren zurück auf 2012R2 um die Firma am laufen zu halten.

Testweise haben wir das Oracle System und einen Fileserver auf einen 2012R2 Hyper-V zu schieben. Ebenfalls mit den 10G Karten: Voller Durchsatz. Die Maschinen laufen rund.

Matt

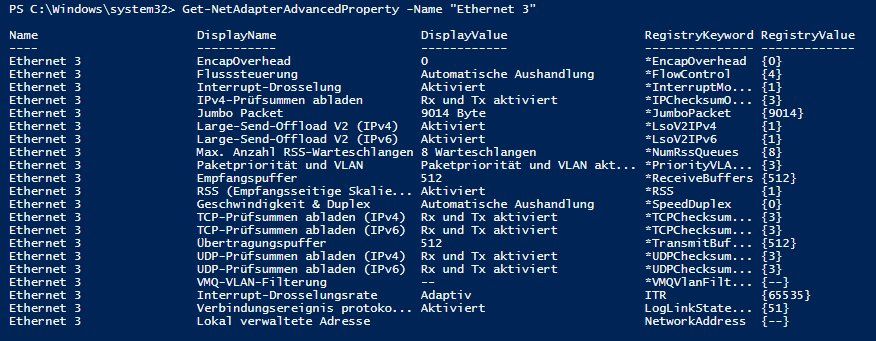

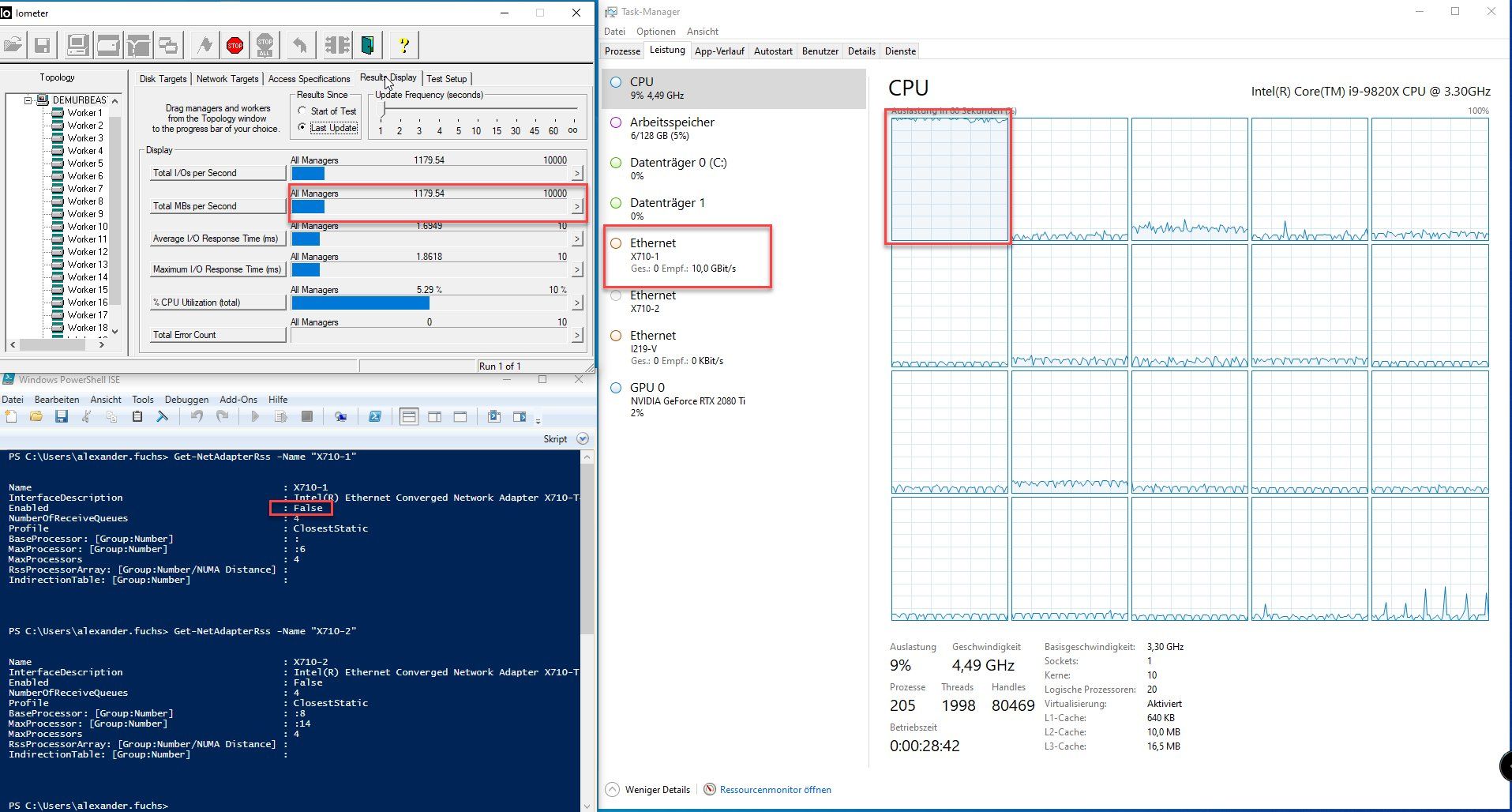

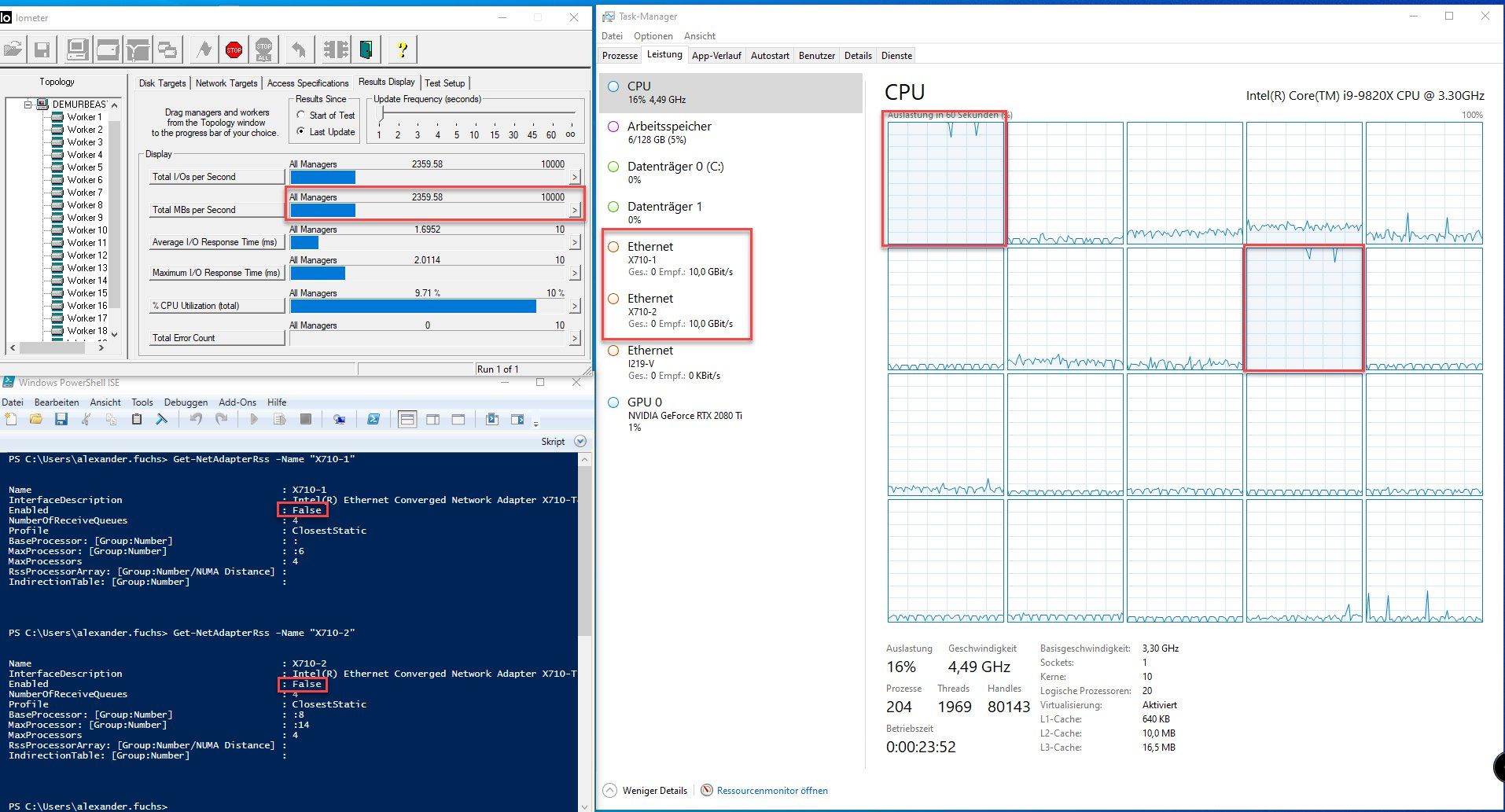

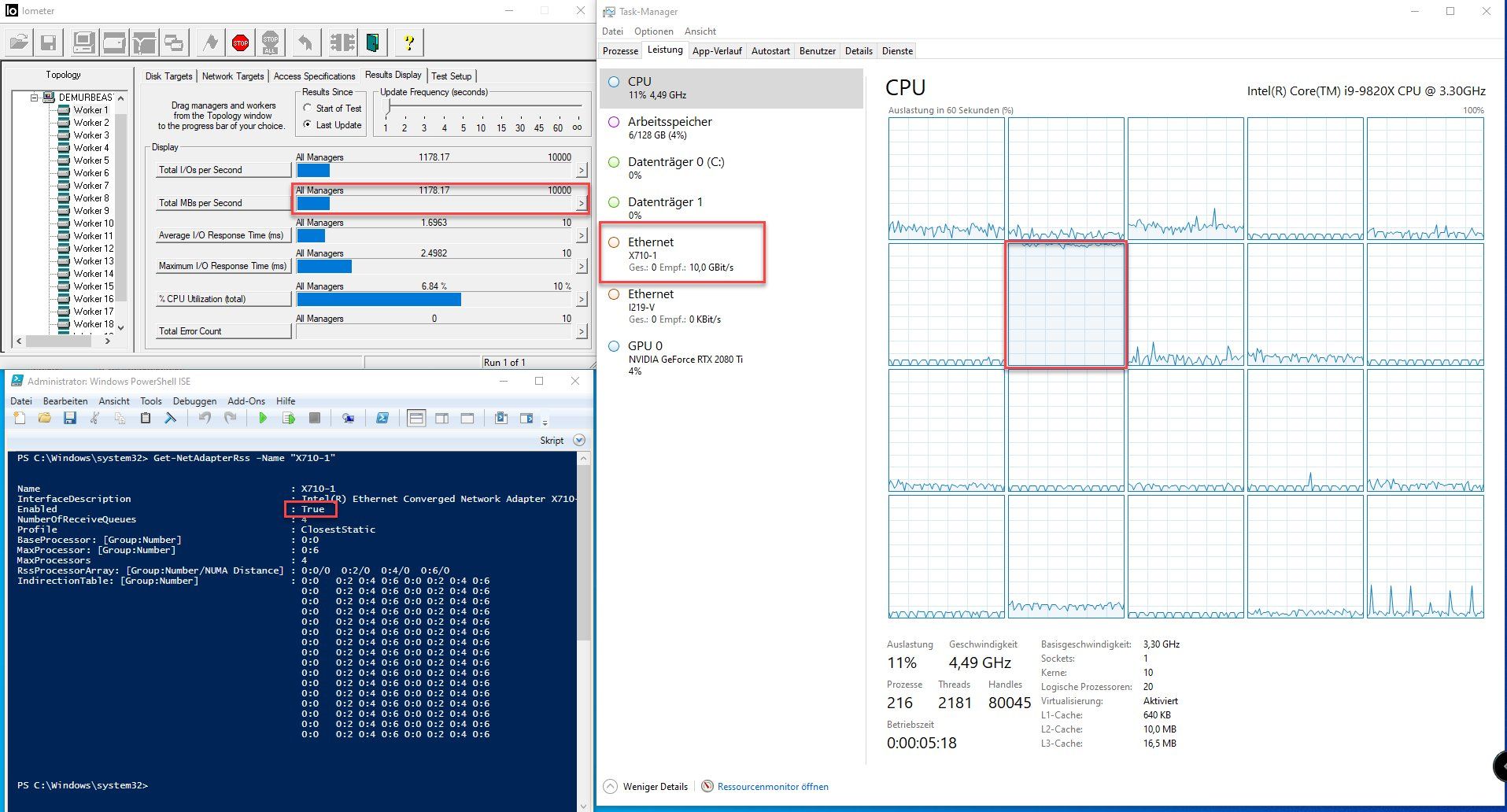

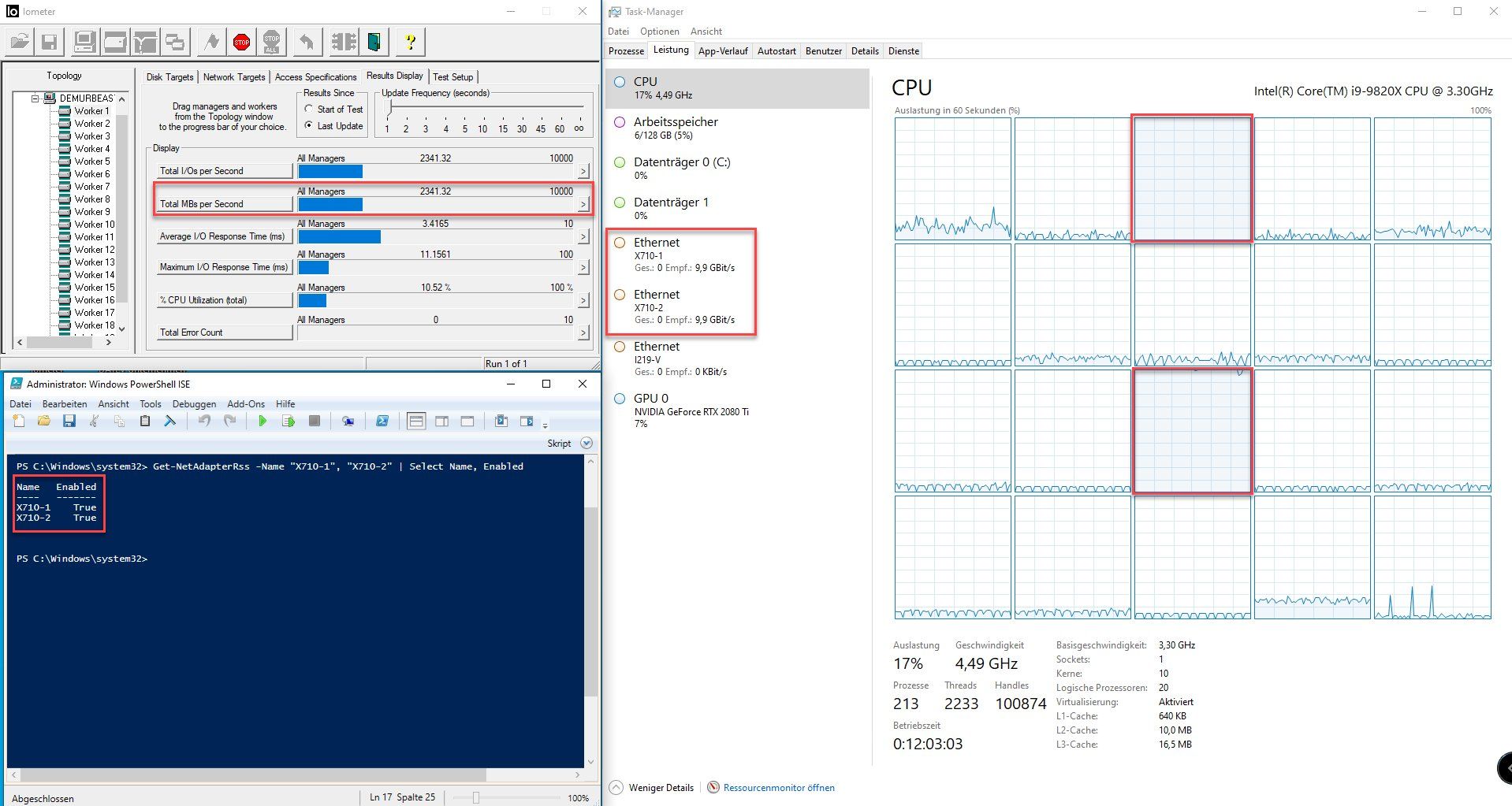

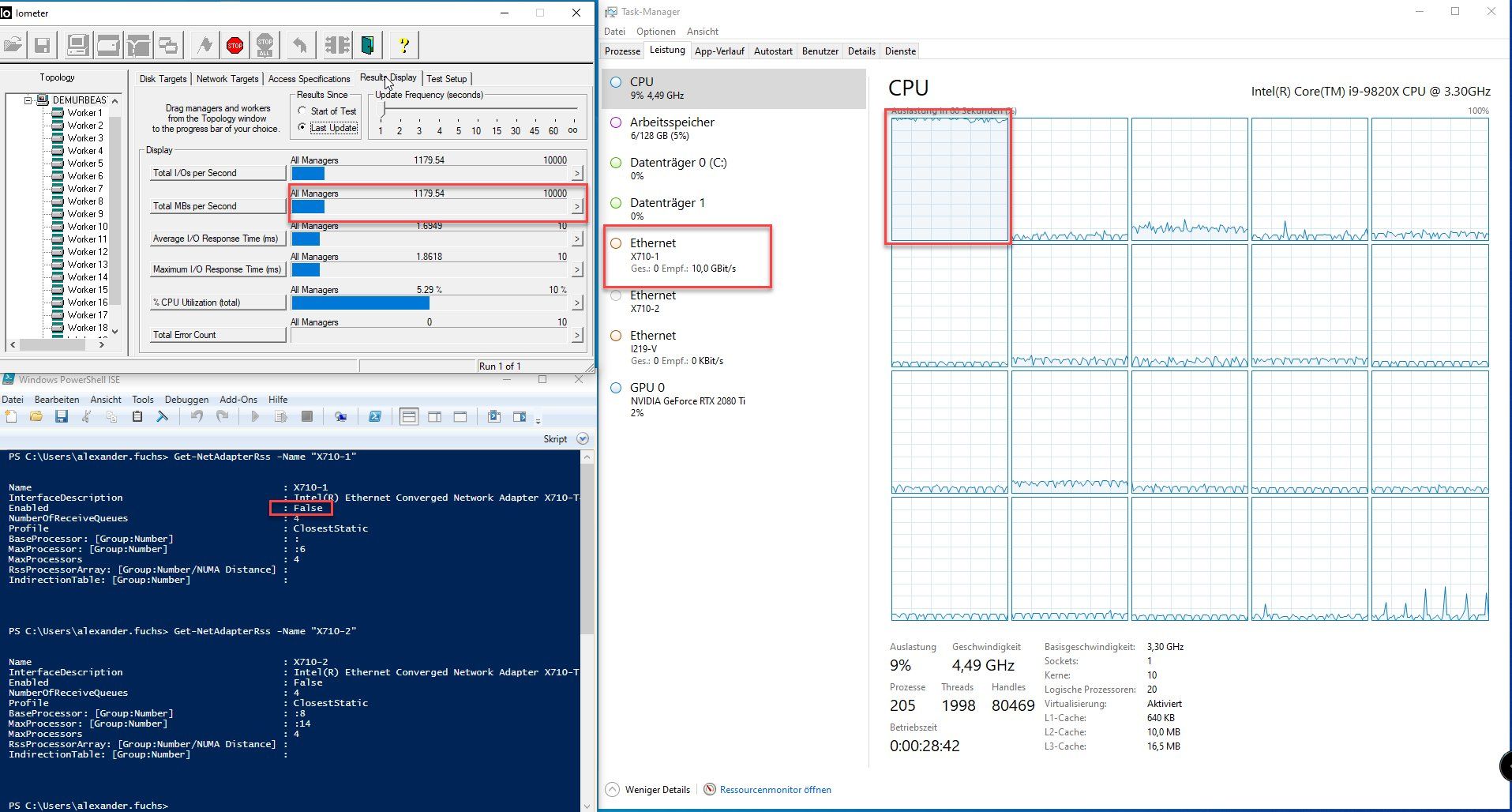

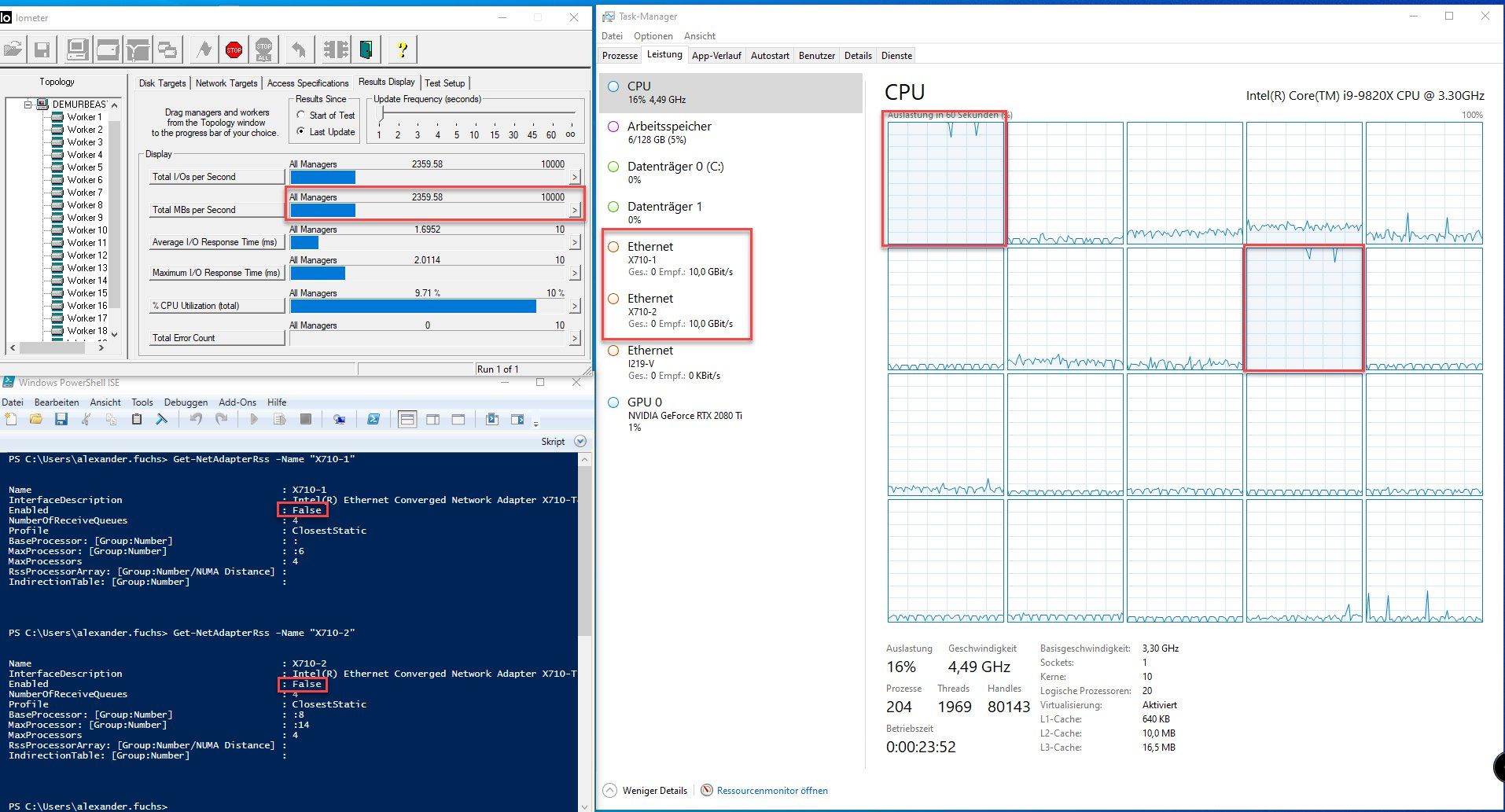

!!! Heureka !!!

Moin Leidensgenossen,

habe das Problem gefunden und auch gleich gelöst, kein Witz.

Nun zur ganzen Geschichte.

Wir haben die letzten Monate diverse HV Systeme ohne Probleme von 2012R2 und 2016 auf 2019 umgestellt. Alle Upgrades sind ohne Probleme verlaufen, bis auf das Letzte.

Bei der letzten Umstellung hatten wir im Anschluss wieder massiv mit Performanceproblemen zu kämpfen. Zurückgerudert sind wir nicht, ich habe kurzerhand drei I350 Adapter aus dem Lager geholt und die drei HVs damit bestückt und schon konnte der Kunde auch mit 2019 ohne nennenswerte Einbussen weiter arbeiten. Keine Sorge das ist jetzt nicht die Lösung.

Nun begann eine längere Suchaktion. Ich verglich akribisch die Einstellungen der NICs und konnte absolut nichts finden, was das Problem erklären würde. Diverse Konfigurationen wurden ausprobiert, mal mit, mal ohne VMQ, SR-IOV, RSS, RSC & Co. KG. Alle Versuche das Problem über die Erweiterten Einstellungen der NICs zu lösen, brachten entweder keine Besserung oder verschlimmbesserten die Lage.

Das Licht ging mir auf, als ich letztes Wochenende mal wieder exzessiv getestet habe.

Ich verschob auf einen Kundensystem alle für eine bestimmte Applikation relevanten Server auf denselben HV incl. Terminalserver. Dann stellte ich alle VM-Netzwerkadapter vom dem funktionierenden vSwitch mit 1G Uplinks (vSwitch1G) auf den vSwitch mit den 10G Uplinks (vSwitch10G) um, und sofort brach die Applikationsperformace mehr als nur spürbar ein.

Moment, dachte ich mir, das kann doch jetzt doch gar nicht sein. Die gesamte Kommunikation läuft nun nur noch über den vSwitch der von der Host-CPU gehandelt wird, da haben die NICs doch noch gar nichts mit dem Traffic zu tun.

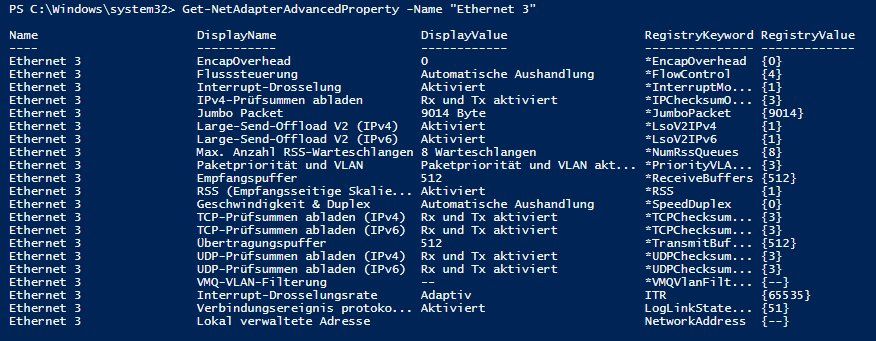

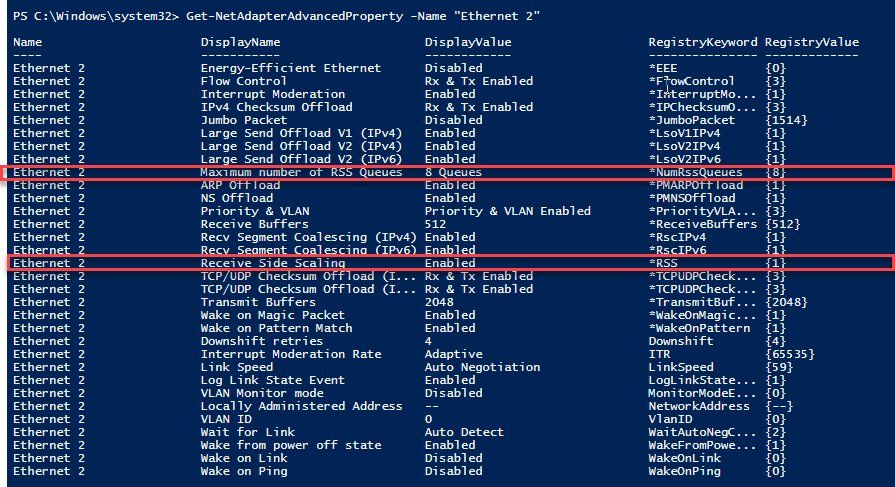

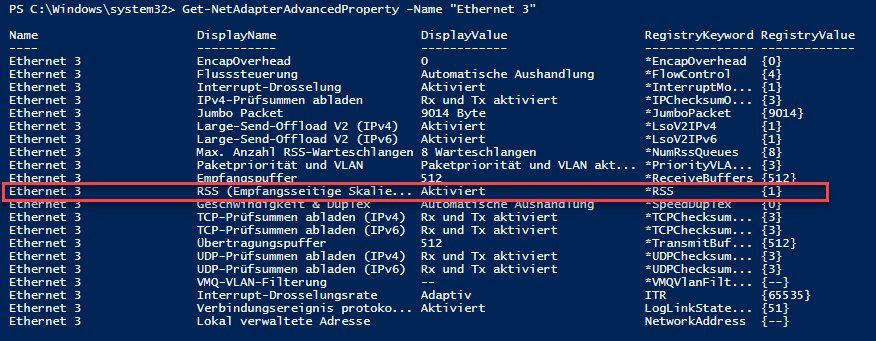

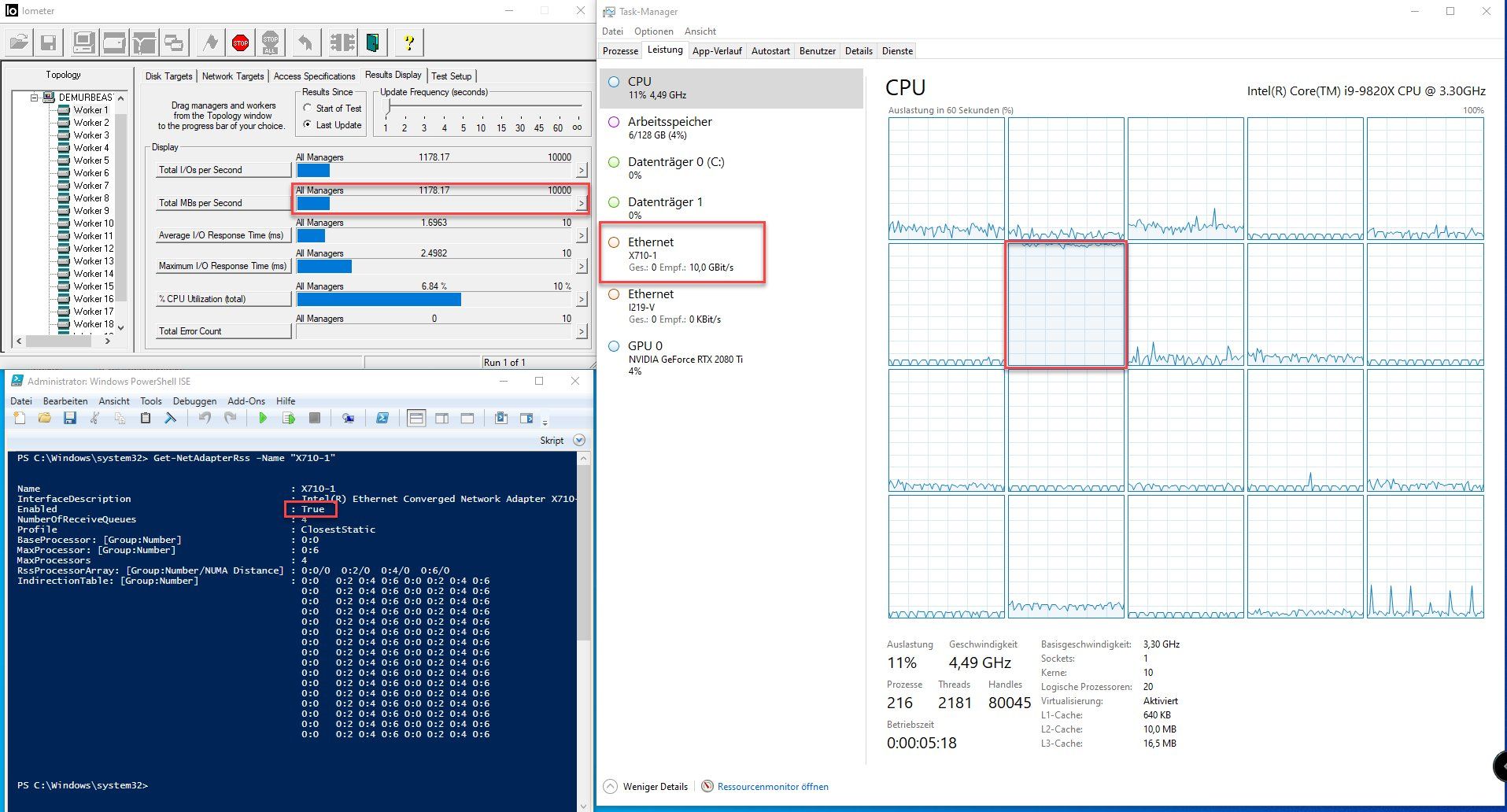

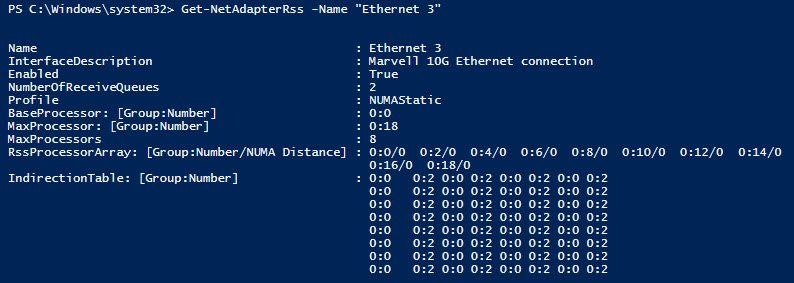

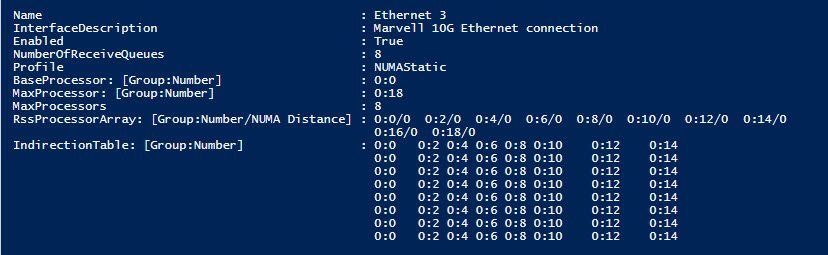

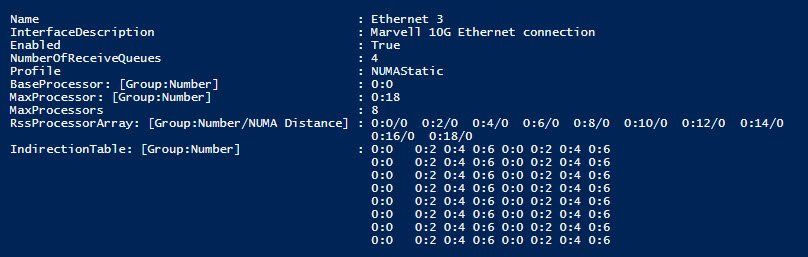

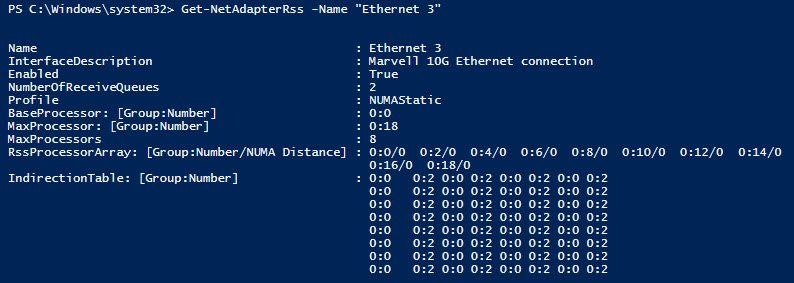

Schnell PowerShell geöffnet und die Konfig des vSwitches abgefragt.

Get-VMSwitch -Name „NAME_VSWITCH“ | format-list

Und dann dasselbe Spielchen auf ein paar anderen HV 2019er Kundensystem, wo uns keine Performanceprobleme bekannt sind und schon war das Übel ersichtlich. Der vSwitch wurde an ein paar Stellen, mit absolut falschen Parametern generiert.

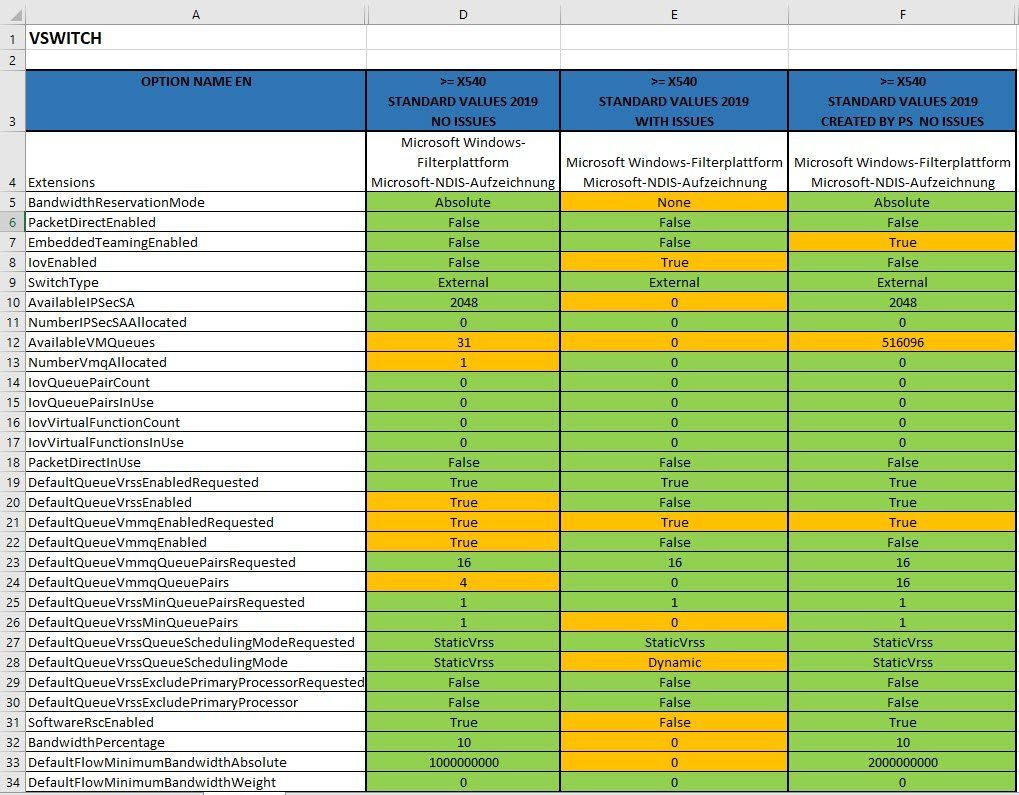

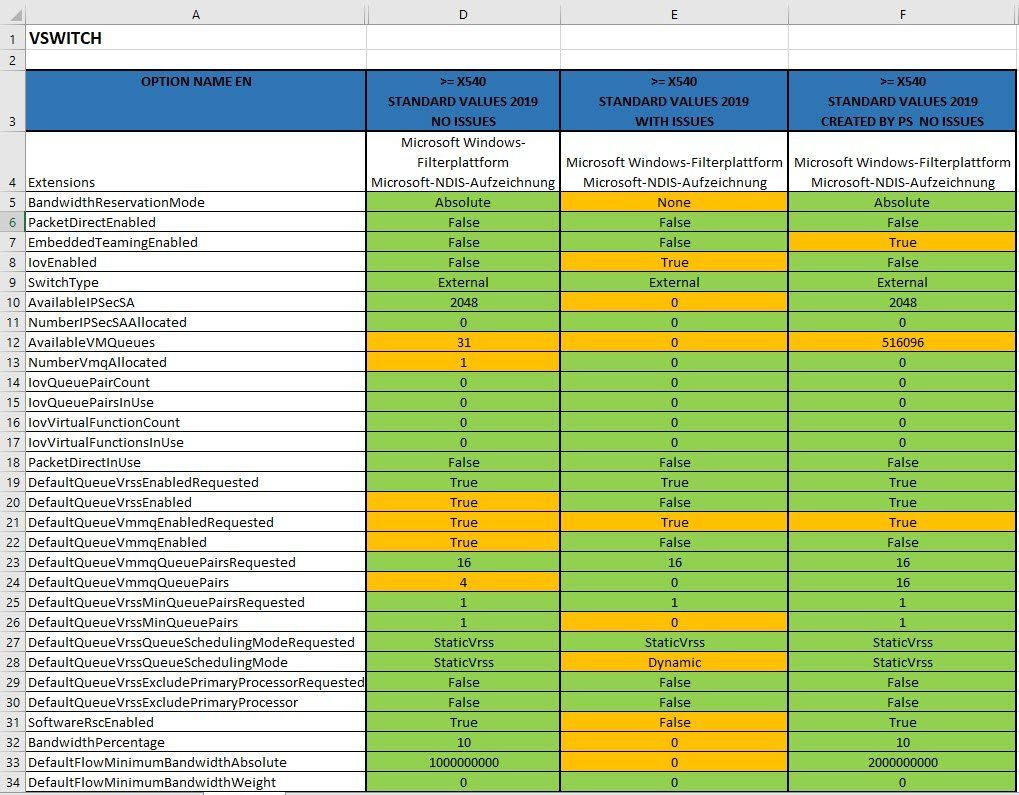

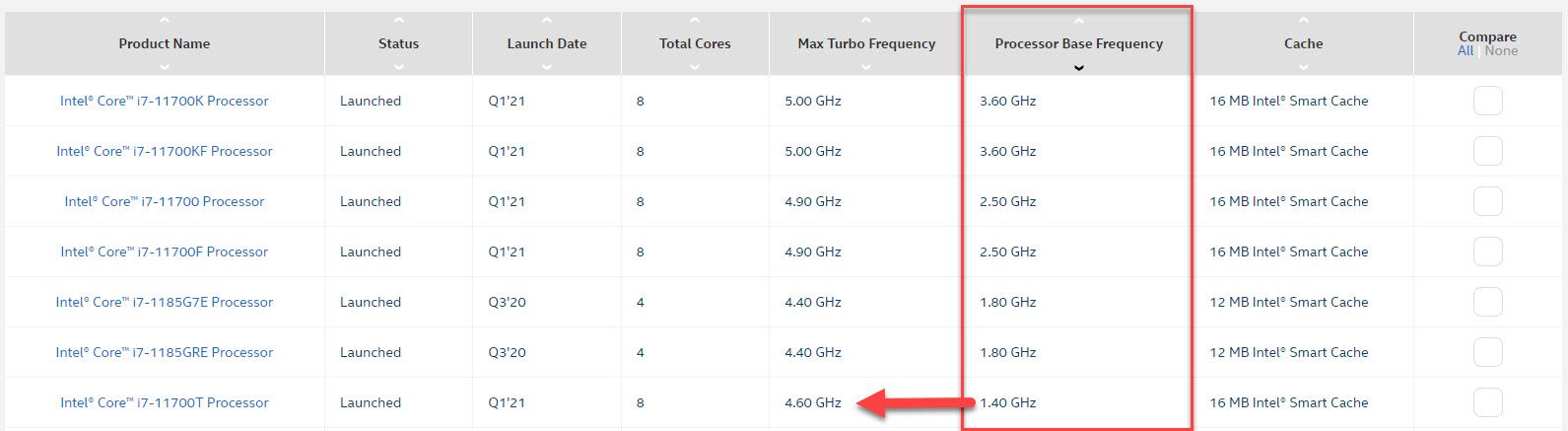

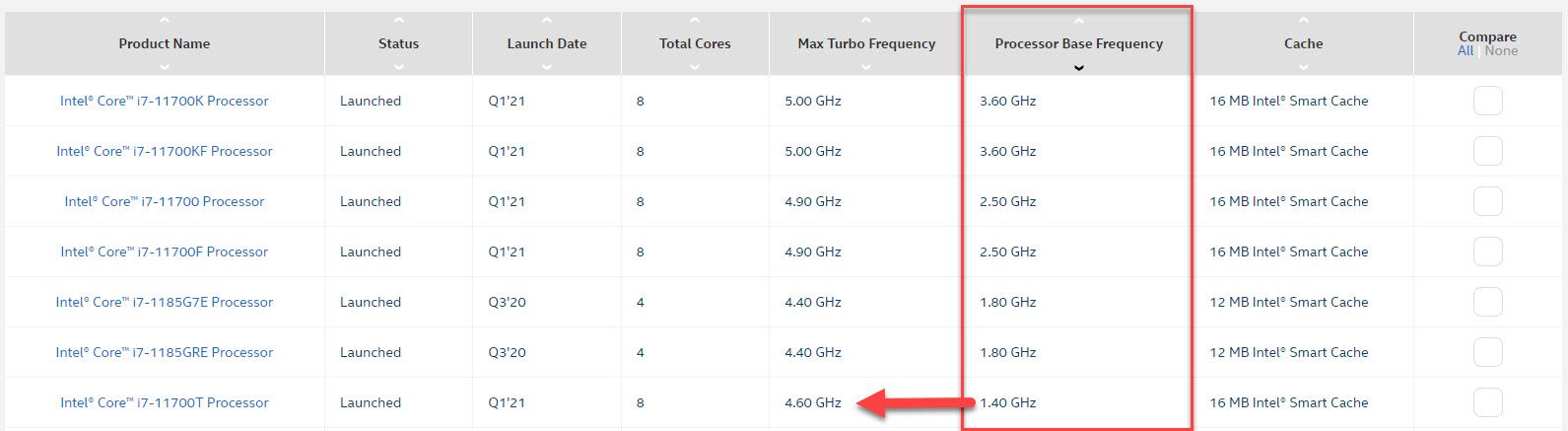

Ich habe zur besseren Übersicht die Werte in eine Tabelle reingeklopft.

Ich sage nur "BandwidthReservationMode"

Wer mehr wissen möchte, einfach Google mit folgender Anfrage quälen "BandwidthReservationMode bug"

Gibt es anscheinend schon seit 2012, aber warum das jetzt ausgerechnet mit den INTEL >= X540er und HV 2019er vermehrt auftritt, habe ich noch nicht raus gefunden.

Nun war die Lösung nur noch einen Katzensprung entfernt.

Ich habe den vorherigen fehlerhaften vSwitch gelöscht und per PowerShell mit dem folgenden Befehl einen neuen angelegt.

New-VMSwitch -Name " NAME_VSWITCH " -MinimumBandwidthMode Absolute -NetAdapterName "NIC 1.1 - PROD 10G" -AllowManagementOS $false

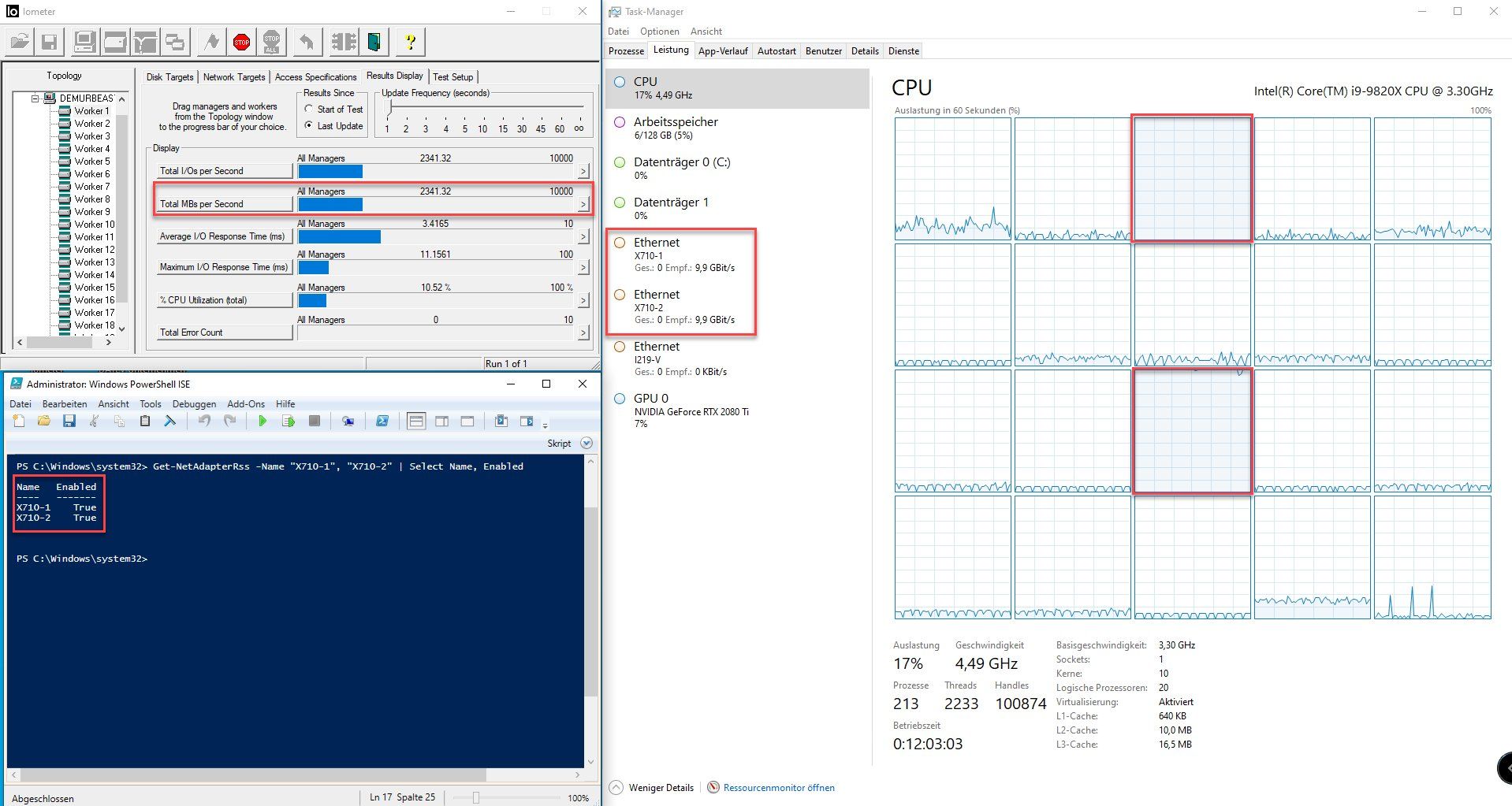

Falls jemand Multilinks benutzt, dann muss er diese nicht mehr vorher im OS vorkonfigurieren, das klappt ab HV 2016 direkt auf dem vSwitch.

Dazu die folgende beiden Befehle ausführen.

New-VMSwitch -Name "NAME_VSWITCH" -MinimumBandwidthMode Absolute -NetAdapterName

"NAME_NIC_1", "NAME_NIC_2" -EnableEmbeddedTeaming $true -AllowManagementOS $false

Set-VMSwitchTeam -Name "DESIG-PROD-10G-BIUL" -LoadBalancingAlgorithm Dynamic

Und schon war der Fisch geputzt. 😊

Habe heute Nachmittag die Bestätigung von Kunden bekommen, dass die Änderungen gefruchtet haben. Es sind seit der Umstellung keine Performanceeinbussen auf dem vSwitch mit den X722er und X540er mehr aufgetreten. 🥳

Der Vollständigkeit halber, die jetzige Konfig läuft ohne VMQ, SR-IOV, RSS, wir werden die genannten Features nun kontrolliert nach und nach aktivieren und schauen was passiert.

Ich halte diesbezüglich auf dem Laufenden.

Ich bin mir aber 100% sicher, dass das Problem an dem vSwitch lag. Wir haben noch ein weiteres 2019er System, welches Ende 2018 mit X722er ausgeliefert wurde und im Nachgang mit 1G (I350) nachgerüstet wurde, da die Performance nicht passte. Auch dort ist der vSwitch vom OS bei der Konfiguration per GUI falsch generiert worden.

Grüsse aus BaWü

Alex

Moin Leidensgenossen,

habe das Problem gefunden und auch gleich gelöst, kein Witz.

Nun zur ganzen Geschichte.

Wir haben die letzten Monate diverse HV Systeme ohne Probleme von 2012R2 und 2016 auf 2019 umgestellt. Alle Upgrades sind ohne Probleme verlaufen, bis auf das Letzte.

Bei der letzten Umstellung hatten wir im Anschluss wieder massiv mit Performanceproblemen zu kämpfen. Zurückgerudert sind wir nicht, ich habe kurzerhand drei I350 Adapter aus dem Lager geholt und die drei HVs damit bestückt und schon konnte der Kunde auch mit 2019 ohne nennenswerte Einbussen weiter arbeiten. Keine Sorge das ist jetzt nicht die Lösung.

Nun begann eine längere Suchaktion. Ich verglich akribisch die Einstellungen der NICs und konnte absolut nichts finden, was das Problem erklären würde. Diverse Konfigurationen wurden ausprobiert, mal mit, mal ohne VMQ, SR-IOV, RSS, RSC & Co. KG. Alle Versuche das Problem über die Erweiterten Einstellungen der NICs zu lösen, brachten entweder keine Besserung oder verschlimmbesserten die Lage.

Das Licht ging mir auf, als ich letztes Wochenende mal wieder exzessiv getestet habe.

Ich verschob auf einen Kundensystem alle für eine bestimmte Applikation relevanten Server auf denselben HV incl. Terminalserver. Dann stellte ich alle VM-Netzwerkadapter vom dem funktionierenden vSwitch mit 1G Uplinks (vSwitch1G) auf den vSwitch mit den 10G Uplinks (vSwitch10G) um, und sofort brach die Applikationsperformace mehr als nur spürbar ein.

Moment, dachte ich mir, das kann doch jetzt doch gar nicht sein. Die gesamte Kommunikation läuft nun nur noch über den vSwitch der von der Host-CPU gehandelt wird, da haben die NICs doch noch gar nichts mit dem Traffic zu tun.

Schnell PowerShell geöffnet und die Konfig des vSwitches abgefragt.

Get-VMSwitch -Name „NAME_VSWITCH“ | format-list

Und dann dasselbe Spielchen auf ein paar anderen HV 2019er Kundensystem, wo uns keine Performanceprobleme bekannt sind und schon war das Übel ersichtlich. Der vSwitch wurde an ein paar Stellen, mit absolut falschen Parametern generiert.

Ich habe zur besseren Übersicht die Werte in eine Tabelle reingeklopft.

Ich sage nur "BandwidthReservationMode"

Wer mehr wissen möchte, einfach Google mit folgender Anfrage quälen "BandwidthReservationMode bug"

Gibt es anscheinend schon seit 2012, aber warum das jetzt ausgerechnet mit den INTEL >= X540er und HV 2019er vermehrt auftritt, habe ich noch nicht raus gefunden.

Nun war die Lösung nur noch einen Katzensprung entfernt.

Ich habe den vorherigen fehlerhaften vSwitch gelöscht und per PowerShell mit dem folgenden Befehl einen neuen angelegt.

New-VMSwitch -Name " NAME_VSWITCH " -MinimumBandwidthMode Absolute -NetAdapterName "NIC 1.1 - PROD 10G" -AllowManagementOS $false

Falls jemand Multilinks benutzt, dann muss er diese nicht mehr vorher im OS vorkonfigurieren, das klappt ab HV 2016 direkt auf dem vSwitch.

Dazu die folgende beiden Befehle ausführen.

New-VMSwitch -Name "NAME_VSWITCH" -MinimumBandwidthMode Absolute -NetAdapterName

"NAME_NIC_1", "NAME_NIC_2" -EnableEmbeddedTeaming $true -AllowManagementOS $false

Set-VMSwitchTeam -Name "DESIG-PROD-10G-BIUL" -LoadBalancingAlgorithm Dynamic

Und schon war der Fisch geputzt. 😊

Habe heute Nachmittag die Bestätigung von Kunden bekommen, dass die Änderungen gefruchtet haben. Es sind seit der Umstellung keine Performanceeinbussen auf dem vSwitch mit den X722er und X540er mehr aufgetreten. 🥳

Der Vollständigkeit halber, die jetzige Konfig läuft ohne VMQ, SR-IOV, RSS, wir werden die genannten Features nun kontrolliert nach und nach aktivieren und schauen was passiert.

Ich halte diesbezüglich auf dem Laufenden.

Ich bin mir aber 100% sicher, dass das Problem an dem vSwitch lag. Wir haben noch ein weiteres 2019er System, welches Ende 2018 mit X722er ausgeliefert wurde und im Nachgang mit 1G (I350) nachgerüstet wurde, da die Performance nicht passte. Auch dort ist der vSwitch vom OS bei der Konfiguration per GUI falsch generiert worden.

Grüsse aus BaWü

Alex

Hallo,

vielen Dank für deine Ausführliche Antwort.

Habe bei mir dasselbe Problem, die vSwitch Einstellungen sind allerdings korrekt.

3x HyperV Host(s), welche von 2016 auf 2019 upgegradet worden sind.

Geschwindigkeit bricht bei mir extrem bei kleineren Dateien ein. Einzelne große Dateien stellen kein Problem dar.

Weiße ich der VM die 1GB Nic zu, ist die Geschwindigkeit wie gewünscht...

Bei mir sind allerdings folgende 10GB NICs verbaut:

1x Intel 82599 10GB

1x Intel X520

1x Intel X710

VMQ = deaktiviert

Falls es noch weitere Ideen gibt, bitte ich darum

Danke

vielen Dank für deine Ausführliche Antwort.

Habe bei mir dasselbe Problem, die vSwitch Einstellungen sind allerdings korrekt.

3x HyperV Host(s), welche von 2016 auf 2019 upgegradet worden sind.

Geschwindigkeit bricht bei mir extrem bei kleineren Dateien ein. Einzelne große Dateien stellen kein Problem dar.

Weiße ich der VM die 1GB Nic zu, ist die Geschwindigkeit wie gewünscht...

Bei mir sind allerdings folgende 10GB NICs verbaut:

1x Intel 82599 10GB

1x Intel X520

1x Intel X710

VMQ = deaktiviert

Falls es noch weitere Ideen gibt, bitte ich darum

Danke

Sorry falsch formuliert.

Die Server haben zusätzlich zu den 10GB NICs jeweils Broadcom GB (onboard).

Meine VMs haben nun einen vSwitch via den 1GB Karten, hier gibts keine Performance-Probleme.

Sobald ich die 10GB vSwitch verwende bricht die Geschwindigkeit ein.

Kann man sehr gut mit Kopiervorgängen testen.

liebe Grüße

Die Server haben zusätzlich zu den 10GB NICs jeweils Broadcom GB (onboard).

Meine VMs haben nun einen vSwitch via den 1GB Karten, hier gibts keine Performance-Probleme.

Sobald ich die 10GB vSwitch verwende bricht die Geschwindigkeit ein.

Kann man sehr gut mit Kopiervorgängen testen.

liebe Grüße

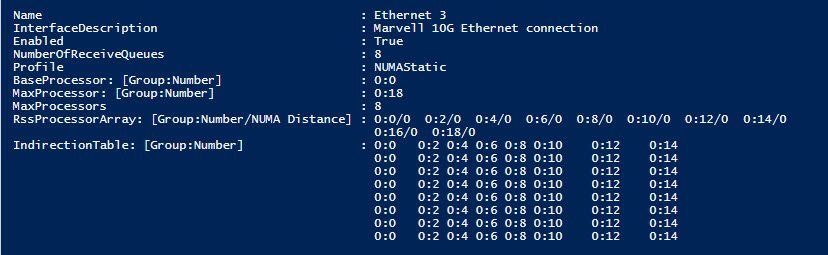

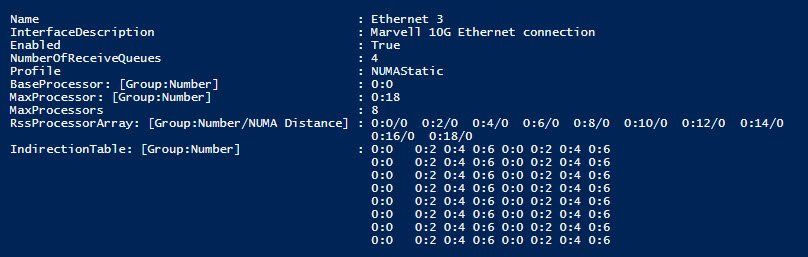

Moin MasterSP,

ich habe die Vermutung, dass es entweder am RSS oder am RSC liegt, hatte Zuletzt aber absolut keine Zeit das Thema weiter zu verfolgen.

---

In der aktuellen Readme des 24.2 habe ich die folgenden interessanten Einträge gefunden.

Unexpected CPU utilization

You may see one CPU reaching 90%-100% utilization if the RSS Load Balancing

Profile is set to NUMAScalingStatic. Setting the RSS Load Balancing Profile to

ClosestProcessor should correctly balance the CPU load. This issue affects

devices based on the Intel(R) Ethernet Controller X722 in systems running

Microsoft* Windows Server* 2019.

RSS Load Balancing Profile Advanced Setting

Setting the "RSS load balancing profile" Advanced Setting to "ClosestProcessor"

may significantly reduce CPU utilization. However, in some system

configurations (such as a system with more Ethernet ports than processor

cores), the "ClosestProcessor" setting may cause transmit and receive failures.

Changing the setting to "NUMAScalingStatic" will resolve the issue.

Multicast routing table is not automatically set up

The multicast routing table for the Intel(R) Ethernet Virtual Function 700

Series driver is not automatically set up and the virtual machine will not

receive multicast traffic. Manually adding the multicast routing will resolve

the issue.

Reduced or erratic receive performance

Intel(R) 7500 chipset-based systems may experience degraded receive

performance. Increasing receive descriptors to 1024 will resolve the issue.

Disabling C-states in the system BIOS will also resolve the issue.

CPU utilization higher than expected

Setting RSS Queues to a value greater than 4 is only advisable for large web

servers with several processors. Values greater than 4 may increase CPU

utilization to unacceptable levels and have other negative impacts on system

performance.

VLANs are not supported on VMQ enabled adapters and teams

If you create a VLAN on a VMQ enabled adapter, the VMQ setting will

automatically be set to disabled. The same will happen if you create a VLAN on

a team whose member adapters have VMQ enabled.

Reduced Large Send Offload performance

Large Send Offload (LSO) and IPSec Offload are not compatible. LSO is

automatically disabled when IPSec Offload is enabled. This may reduce the

performance of non-IPSec traffic. Confining all of your IPSec traffic to one

port and enabling IPSec Offload only on that port may mitigate this issue. On

Microsoft Windows 8.1 and Server 2012 and later, devices based on the 82576,

82599, and X540 controllers are not affected by this issue.

Network stack will not enable RSC

If Intel Data Center Bridging (DCB) is installed (FCoE, iSCSi, or both), the

network stack will not enable Receive Segment Coalescing (RSC)

---

werde mich die Tage wieder dran klemmen (müssen).

Grüsse aus Murrhardt

Alex

ich habe die Vermutung, dass es entweder am RSS oder am RSC liegt, hatte Zuletzt aber absolut keine Zeit das Thema weiter zu verfolgen.

---

In der aktuellen Readme des 24.2 habe ich die folgenden interessanten Einträge gefunden.

Unexpected CPU utilization

You may see one CPU reaching 90%-100% utilization if the RSS Load Balancing

Profile is set to NUMAScalingStatic. Setting the RSS Load Balancing Profile to

ClosestProcessor should correctly balance the CPU load. This issue affects

devices based on the Intel(R) Ethernet Controller X722 in systems running

Microsoft* Windows Server* 2019.

RSS Load Balancing Profile Advanced Setting

Setting the "RSS load balancing profile" Advanced Setting to "ClosestProcessor"

may significantly reduce CPU utilization. However, in some system

configurations (such as a system with more Ethernet ports than processor

cores), the "ClosestProcessor" setting may cause transmit and receive failures.

Changing the setting to "NUMAScalingStatic" will resolve the issue.

Multicast routing table is not automatically set up

The multicast routing table for the Intel(R) Ethernet Virtual Function 700

Series driver is not automatically set up and the virtual machine will not

receive multicast traffic. Manually adding the multicast routing will resolve

the issue.

Reduced or erratic receive performance

Intel(R) 7500 chipset-based systems may experience degraded receive