Netzwerksaufbau bei nahezu auschließlichem Zugriff auf NAS bzw. Server

Hallo zusammen,

in unserem kleinen Büro (6 Arbeitsplätze, Netzwerkdrucker, Netzwerkplotter, NAS) stellen immer mehr Softwarefirmen ihre Programme auf eine Art Datenbank um. Eine Art Datenbank aus diesem Grunde, weil kein richtiger Datenbankserver läuft, aber die Dateien wohl entsprechend verwaltet werden. (Ich vermute wie bei Access).

Damit erhöht sich der Zugriff auf das NAS (Diskstation) deutlich und die Performance pro PC geht in den Keller.

Die Rechengeschwindigkeit einiger Programme steigt um den Faktor 4, wenn ich das Projekt lokal auf der SSD liegen habe.

Das ist aber nicht möglich, da eben gleichzeitig an dem Projekt gearbeitet werden muss und es durch die Datenbankstruktur nur geht, wenn sie zentral zugänglich ist.

Ich will gar nicht an die Performance eines lokalen Betriebs erreichen, aber wir brauchen mehr Grundgeschwindigkeit.

Jetzt zu meiner eigentlichen Frage:

Wir sitzen ja in unterschiedlichen Räumen mit bis zu 3 Mann in einem Raum.

Bis jetzt läuft in jeden Raum ein Netzwerk Cat 6 Kabel und wird dort mittels Switch verteilt.

Jetzt war die Überlegung auf einen zentralen Switch zu wechseln und eben ein Kabel bis zu jedem PC zu legen.

Da das NAS selbst aber auch nur per GBit angeschlossen ist, bleibt der Flaschenhals ja trotzdem bestehen.

Ergo macht das ganze doch nur sinn, wenn die Verbindung Switch/NAS mit stärkeren Leitung angeschlossen ist, oder?

Natürlich muss man auch über die Leistungsfähigkeit des NAS nachdenken, damit es die Daten auch so schnell liefern kann.

Gibt es dazu Anhaltspunkte oder mache ich noch grundsätzliche Überlegungsfehler?

Bin für jeglichen Hinweis dankbar.

in unserem kleinen Büro (6 Arbeitsplätze, Netzwerkdrucker, Netzwerkplotter, NAS) stellen immer mehr Softwarefirmen ihre Programme auf eine Art Datenbank um. Eine Art Datenbank aus diesem Grunde, weil kein richtiger Datenbankserver läuft, aber die Dateien wohl entsprechend verwaltet werden. (Ich vermute wie bei Access).

Damit erhöht sich der Zugriff auf das NAS (Diskstation) deutlich und die Performance pro PC geht in den Keller.

Die Rechengeschwindigkeit einiger Programme steigt um den Faktor 4, wenn ich das Projekt lokal auf der SSD liegen habe.

Das ist aber nicht möglich, da eben gleichzeitig an dem Projekt gearbeitet werden muss und es durch die Datenbankstruktur nur geht, wenn sie zentral zugänglich ist.

Ich will gar nicht an die Performance eines lokalen Betriebs erreichen, aber wir brauchen mehr Grundgeschwindigkeit.

Jetzt zu meiner eigentlichen Frage:

Wir sitzen ja in unterschiedlichen Räumen mit bis zu 3 Mann in einem Raum.

Bis jetzt läuft in jeden Raum ein Netzwerk Cat 6 Kabel und wird dort mittels Switch verteilt.

Jetzt war die Überlegung auf einen zentralen Switch zu wechseln und eben ein Kabel bis zu jedem PC zu legen.

Da das NAS selbst aber auch nur per GBit angeschlossen ist, bleibt der Flaschenhals ja trotzdem bestehen.

Ergo macht das ganze doch nur sinn, wenn die Verbindung Switch/NAS mit stärkeren Leitung angeschlossen ist, oder?

Natürlich muss man auch über die Leistungsfähigkeit des NAS nachdenken, damit es die Daten auch so schnell liefern kann.

Gibt es dazu Anhaltspunkte oder mache ich noch grundsätzliche Überlegungsfehler?

Bin für jeglichen Hinweis dankbar.

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 657739

Url: https://administrator.de/forum/netzwerksaufbau-bei-nahezu-auschliesslichem-zugriff-auf-nas-bzw-server-657739.html

Ausgedruckt am: 23.07.2025 um 22:07 Uhr

24 Kommentare

Neuester Kommentar

Hallo,

leider fehlen in Deiner Beschreibung wichtige Angaben.

Was für ein NAS wird eingesetzt? (Modell, Bezeichnung, RAM-Ausstattung)

Was für Datenträger werden auf dem NAS eingesetzt? (Typ, Modell, Bezeichnung)

Wofür wird das NAS eingesetzt? Nur SMB-Freigabe? Auch DC? Weitere Dienste?

Liegen Netwzerk-Tests mt iperf vor?

Was für Switche werden eingesetzt?(Modell, Bezeichnung)

Gibt es einen zentralen Switch und in jedem Raum nochmal einen kaskadierten Switch?

Welche Ausstattung haben die PCs/ Laptops? Wie sind die angebunden?

Was für ein Betriebssystem wird auf den Clients eingesetzt? (Windows, Linux, MacOS X?)

Was für eine Datenbanksoftware wird eingesetzt?

Was für Software wird sonst noch eingesetzt?

Wenn das NAS und die Clients keine schnellere Verbindung besitzen, liegt dort ein (theoretischer) Flaschenhals.

(Lokale) SSDs sind natürlich von den Zugriffszeiten deutlich schneller als eine Festplatte. Ein NAS wird mit SSDs allerdings auch deutlich flotter, da die reaktionszeit verkürzt wird.

Wie läuft Eure Datensicherung?

Gruß

its

leider fehlen in Deiner Beschreibung wichtige Angaben.

Was für ein NAS wird eingesetzt? (Modell, Bezeichnung, RAM-Ausstattung)

Was für Datenträger werden auf dem NAS eingesetzt? (Typ, Modell, Bezeichnung)

Wofür wird das NAS eingesetzt? Nur SMB-Freigabe? Auch DC? Weitere Dienste?

Liegen Netwzerk-Tests mt iperf vor?

Was für Switche werden eingesetzt?(Modell, Bezeichnung)

Gibt es einen zentralen Switch und in jedem Raum nochmal einen kaskadierten Switch?

Welche Ausstattung haben die PCs/ Laptops? Wie sind die angebunden?

Was für ein Betriebssystem wird auf den Clients eingesetzt? (Windows, Linux, MacOS X?)

Was für eine Datenbanksoftware wird eingesetzt?

Was für Software wird sonst noch eingesetzt?

Zitat von @Ghent74:

Die Rechengeschwindigkeit einiger Programme steigt um den Faktor 4, wenn ich das Projekt lokal auf der SSD liegen habe.

Da das NAS selbst aber auch nur per GBit angeschlossen ist, bleibt der Flaschenhals ja trotzdem bestehen.

Ergo macht das ganze doch nur sinn, wenn die Verbindung Switch/NAS mit stärkeren Leitung angeschlossen ist, oder?

Per GBit erreicht man max. 120 MB/s (inkl. Overhead), netto ca. 112 MB/s.Die Rechengeschwindigkeit einiger Programme steigt um den Faktor 4, wenn ich das Projekt lokal auf der SSD liegen habe.

Da das NAS selbst aber auch nur per GBit angeschlossen ist, bleibt der Flaschenhals ja trotzdem bestehen.

Ergo macht das ganze doch nur sinn, wenn die Verbindung Switch/NAS mit stärkeren Leitung angeschlossen ist, oder?

Wenn das NAS und die Clients keine schnellere Verbindung besitzen, liegt dort ein (theoretischer) Flaschenhals.

(Lokale) SSDs sind natürlich von den Zugriffszeiten deutlich schneller als eine Festplatte. Ein NAS wird mit SSDs allerdings auch deutlich flotter, da die reaktionszeit verkürzt wird.

Gibt es dazu Anhaltspunkte oder mache ich noch grundsätzliche Überlegungsfehler?

Ein NAS kann nicht immer einen Server ersetzen. (Stichwort: Falsche Erwartungshaltung.)Wie läuft Eure Datensicherung?

Gruß

its

Die meisten NAS Systeme haben heute mindesten 2 Netzwerk Anschlusse und bieten die Option diese als 802.3ad LACP LAG auf einem Switch zu bündeln, was dann schon einmal einen Verdopplung der Bandbreite bei dir bringen würde. Wenigstens etwas...

Langfristig gesehen ist es aber besser ein NAS mit 10Gig Ports zu beschaffen zumindestens mindestens aber eins mit N Base T Multigigabit Ports und dann auch mit mindestens 2 Netzwerk Ports um diese redundant über einen LAG anzubinden.

Da was NAS, wie du selber schreibst, ja immer wichtiger wird ist es in jedem Falle anzuraten den zentralen Switch als 2 Full Stack Modelle zu beschaffen (z.B. Ruckus ICX 7150, Cisco SG350-X usw.) und das NAS dann mit dem LACP LAG auf diese 2 Stack Switches zu verteilen. So hast du Switch und gleichzeitg Link Redundanz auf das NAS.

Aber wie Kollege @IT-Spezi oben schon richtig schreibt ist deine Beschreibung zu oberflächlich für eine wirklich zielführende Hilfe.

Langfristig gesehen ist es aber besser ein NAS mit 10Gig Ports zu beschaffen zumindestens mindestens aber eins mit N Base T Multigigabit Ports und dann auch mit mindestens 2 Netzwerk Ports um diese redundant über einen LAG anzubinden.

Da was NAS, wie du selber schreibst, ja immer wichtiger wird ist es in jedem Falle anzuraten den zentralen Switch als 2 Full Stack Modelle zu beschaffen (z.B. Ruckus ICX 7150, Cisco SG350-X usw.) und das NAS dann mit dem LACP LAG auf diese 2 Stack Switches zu verteilen. So hast du Switch und gleichzeitg Link Redundanz auf das NAS.

Aber wie Kollege @IT-Spezi oben schon richtig schreibt ist deine Beschreibung zu oberflächlich für eine wirklich zielführende Hilfe.

was den Einsatz von Switches notwendig machte.

Eigentlich gibt es für so etwas schon lange kleine Kabelkanal Switches !! aber wie lange hält dann die SSD?

Sehr lange, denn in moderen QNAP und Sysnology NAS arbeiten diese nur als Cache. Sie puffern also die Daten zwischen, die dann auf mechanische Platten geschrieben werden. Das können sogar deren billigste Privat- oder SoHo Modelle. Du warst vermutlich lange Zeit nicht auf deren Produktseiten, kann das sein ?Ist das zu optimistisch gedacht?

Jein. Aber 40Gig dürfte aber für die Anzahl der User sicherlich etwas übertrieben sein. Du katapultierst dich dann sowohl bei der Switch- als auch NAS Hardware gleich in 5stellige Preisbereiche. Das wäre sicher etwas übers Ziel hinausgeschossen.10G Switches und NAS sollten reichen. Wenn man diese mit einem LACP LAG bündelt kannst du auch eine 20Gig oder 404 Gig Verbindung problemlos realisieren.

keinen wirklichen Unterschied zwischen lokalem Betrieb und Netzwerkbetrieb bei sich im Hause spürt.

Das stimmt ganz sicher wenn man NAS und Netzwerk Infrastruktur entsprechend ausrüstet.

Das eigentliche Problem ist das wir gar nicht wissen ob die Bandbreite deines Netzwerkes sich überhaupt negativ auf deine Performance auswirkt. Ich würde bei der Suche ganz anders vorgehen:

1) Was passiert wenn du Abends im Büro alleine mit der Anwendung arbeitest, gibt es einen Geschwindigkeitsunterschied? Netzwerk setzt sich aus zwei Faktoren zusammen, Bandbreite und Latenz. Ich bezweifle doch stark das ihr eine derartige Killeraplikation mit einer so kleinen NAS am anderen Ende fahrt.

2) Neben Netzwerk gibt es ja noch die Leistungsfähigkeit des NAS, die häufig noch vor dem Netzwerk bremst. Zum Beispiel kann eine banale Einstellung, die die Festplatten in den Ruhemodus versetzt, schon eine signifikante Auswirkung haben, Oder die CPU ist zu schwach oder zu viele Zugriffe finden parallel statt. Das Netzwerk kannst du fast schon komplett ausschließen wenn du dich mit deiner Workstation direkt an das Kabel zum Hauptswitch hängst und ohne andere Mitnutzer mit 1 GbE auf die NAS zugreifen kannst.

3) Was ist das für eine Software und was für eine "Art" der Datenbank, ist das wirklich Access? - Vielleicht gibt es hier auch ein Setup mit einem MSSQL Express als DB, dann würde ich erstmal in Richtung Server anstelle einer NAS gucken.

1) Was passiert wenn du Abends im Büro alleine mit der Anwendung arbeitest, gibt es einen Geschwindigkeitsunterschied? Netzwerk setzt sich aus zwei Faktoren zusammen, Bandbreite und Latenz. Ich bezweifle doch stark das ihr eine derartige Killeraplikation mit einer so kleinen NAS am anderen Ende fahrt.

2) Neben Netzwerk gibt es ja noch die Leistungsfähigkeit des NAS, die häufig noch vor dem Netzwerk bremst. Zum Beispiel kann eine banale Einstellung, die die Festplatten in den Ruhemodus versetzt, schon eine signifikante Auswirkung haben, Oder die CPU ist zu schwach oder zu viele Zugriffe finden parallel statt. Das Netzwerk kannst du fast schon komplett ausschließen wenn du dich mit deiner Workstation direkt an das Kabel zum Hauptswitch hängst und ohne andere Mitnutzer mit 1 GbE auf die NAS zugreifen kannst.

3) Was ist das für eine Software und was für eine "Art" der Datenbank, ist das wirklich Access? - Vielleicht gibt es hier auch ein Setup mit einem MSSQL Express als DB, dann würde ich erstmal in Richtung Server anstelle einer NAS gucken.

Zitat von @Ghent74:

Als NAS läuft eine Diskstation DS716+II (Celeron N3160, 1.6 GHz, 2 GB) die mit Sicherheit zu schwach auf der Brust sein wird und auch die Festplatten nicht schnell genug sein werden. Der Austausch ist auch kein Thema. Nur will ich halt nicht dort dann ein Monster installieren, was nicht ausgelastet werden kann, daher auch die Frage der Netzwerkanbindung.

Das NAS wird zusätzlich nur noch als Domainencontroller eingesetzt.

Eine richtige Datenbank läuft darauf nicht.

Zumindest für ein Gigabit-Netzwerk ist das NAS gut gerüstet. Sogar bei aktivierter Verschlüsselung. Bei Datenbanken kommt es aber auch auf die Zugriffszeiten an. Leider schreibst Du nichts zu den Festplatten. Vermutlich würde ein Tausch gegen SSDs Dein Problem schon lösen, da die Zugriffszeiten deutlich niedriger sind. Davon profitieren sogar (Access-)Datenbanken. Auch wenn der Durchsatz bei max. 112 MByte/s liegt, so wäre die Reaktionszeit deutlich verkürzt. Und auch der Datendurchsatz bei kleineren Dateien deutlich höher.Als NAS läuft eine Diskstation DS716+II (Celeron N3160, 1.6 GHz, 2 GB) die mit Sicherheit zu schwach auf der Brust sein wird und auch die Festplatten nicht schnell genug sein werden. Der Austausch ist auch kein Thema. Nur will ich halt nicht dort dann ein Monster installieren, was nicht ausgelastet werden kann, daher auch die Frage der Netzwerkanbindung.

Das NAS wird zusätzlich nur noch als Domainencontroller eingesetzt.

Eine richtige Datenbank läuft darauf nicht.

Alle Clients sind Windows10Pro per Netzwerkkabel angebunden und die Software ist halt Spezialsoftware für unsere Branche.

Wenn dem so ist, was schlägt der Hersteller der Software vor. Gibt's da irgendwelche Vorgaben?Die Client Netzwerkkarten (Onboard) haben einen Intel Chip, da die wohl besser sein sollen als die Realtek!?

Ich denke aktuell ist der Flaschenhals die Diskstation.

Da Du aber ein kaskadiertes Netzwerk hast, sieh Dir nochmal die Switche an. Bei einigen Kunden habe ich schon veraltete 100-MBit Geräte gesehen, an denen wiederum ein Gigabit-Switch hing. ("Ist halt so gewachsen.") Manchmal musste ich auch feststellen, dass die CAT-Verkabelung fehlerhaft war, z.B. waren nur 4 Adern aufgelegt. Prüfe auch das einmal. Man wundert sich soch manchmal sehr, was da bei "gewachsenen" System (ohne ITler) alles so entstehen kann.Ich denke aktuell ist der Flaschenhals die Diskstation.

Ich wollte evtl. auf ein System mit SSD Cacheplatte wechseln, aber wie lange hält dann die SSD?

Das hängt natürlich von der Last ab. Synology läßt den Cache leider immer zu 99% vollaufen, so das das Wear-Leveling der SSD nicht mehr funktioniert. Daher sterben die bei denen leider etwas schneller. Ich würde Dir da eher einen Misch-Betrieb mit SSDs als "Hot"-Volume für häufig genutze Daten und ein "Cold"-Volume mit Festplatten für weniger genutzte Daten empfehlen. Die SSDs würden dann auch länger leben. Achte nur darauf, dass sie maximal zu 2/3 gefüllt sind.Habe gelesen, dass die schon nach einem halben Jahr hin sein können.

Bei Firmen mit hohem Durchsatz kann das schon mal vorkommen. Aber bei nur 6 Arbeitsplätzen? Da müsstet Ihr pro Tag mehrere Terrabyte durchjagen.Wir haben, denke ich, viele kleine Zugriffe auf das Dateisystem und nicht den einen großen Strom, wie beim Videoschnitt und ähnlichem.

Gerade dann würden SSDs im NAS Sinn machen.Trotzdem möchte ich für die Zukunft gerüstet sein.

Nie verkehrt.Daher ging meine Überlegung hin zu einem zentralen Gbit Switch der einen oder zwei zusätzliche Ports mit 40 Gbit z.B. besitzt an die ich dann das NAS bzw. einen Server anschließen kann.

Und jetzt Kanonen auf Spatzen. 10 GBit würde schon etwas bringen, wenn alle Endgeräte das Unterstützen. Eine 40 GBit Karte, also QSFP+, wird nur von Servern oder Switchen unterstützt. Windows 10 kann mit dem "Q" (Quad) nichts anfangen und bleibt bei einem Kanal hängen, also SFP+. Dem Client fehlt da einfach ein Feature, welche Microsoft nur für Server vorsieht.

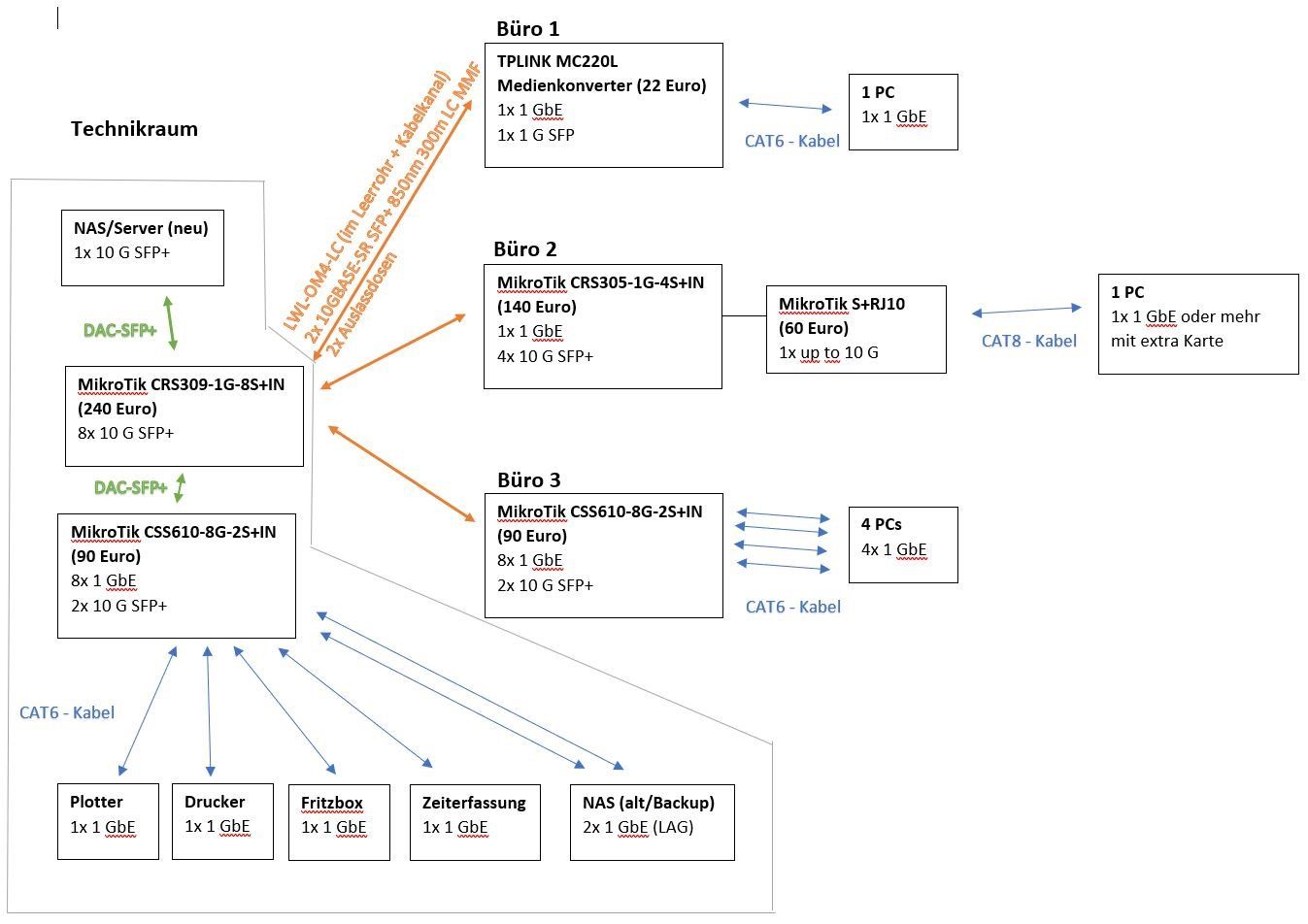

Eine günstige Aufrüstung (, wenn es die Verkabelung hergibt,) könntest Du mit SFP+ Karten und Switchen von MicroTik erreichen.

MikroTik CRS305-1G-4S+IN

MikroTik CRS309-1G-8S+IN

MikroTik CRS312-4C+8XG-RM

Ist das zu optimistisch gedacht? Oder braucht es das nicht, weil das NAS / der Server trotzdem der Flaschenhals sein wird aufgrund der Zugriffe?

Versuche auch mal einen Netzwerktest (z.B. mit iperf) zu machen.

Unserer Softwarehersteller (von dem die Hauptsoftware kommt, die wir einsetzen) sagt z.B., dass er keinen wirklichen Unterschied zwischen lokalem Betrieb und Netzwerkbetrieb bei sich im Hause spürt. Das kann stimmen, oder auch nicht bzw. können die ja weiß Gott was für ein Netz da betreiben...

Hilft Dir leider auch nicht wirklich weiter. Aber eine Empfehlung für die Systemanforderungen müsste der doch machen können.Gruß

its

Zitat von @Ghent74:

Wow, wieder ein ausführlicher Kommentar von dir IT-Spezi.

Vielen Dank dafür schon mal.

Zu den fehlenden Angaben:

Als Festplatten laufen im NAS 2 WD Red 2,0 TB Platten. Genaue Bezeichnung: wd20efrx-68euzn0

Die Festplatten sind zur Hälfte gefüllt. Als RAID ist das Synology Hybrid RAID SHR eingestellt.

Als Dateisystem ext4.

Herzlichen Glückwunsch, das sind die Platten, die Synology als nicht kompatibel eingestuft hat.Wow, wieder ein ausführlicher Kommentar von dir IT-Spezi.

Vielen Dank dafür schon mal.

Zu den fehlenden Angaben:

Als Festplatten laufen im NAS 2 WD Red 2,0 TB Platten. Genaue Bezeichnung: wd20efrx-68euzn0

Die Festplatten sind zur Hälfte gefüllt. Als RAID ist das Synology Hybrid RAID SHR eingestellt.

Als Dateisystem ext4.

synology.com/de-de/compatibility?search_by=products&model=DS ...

Es handelt sich um SMR-Festplatten, weitere Details hier:

computerbase.de/2020-06/nas-festplatten-synology-wd-red-smr-inko ...

Software Hersteller:

Empfiehlt Windows Server und bietet auch nur dafür Support an.

Wieso läuft das dann auf einem nicht unterstützten NAS?Empfiehlt Windows Server und bietet auch nur dafür Support an.

SSD als Cache:

Also keine SSD als Cache, wie man sie in manche DS jetzt einbauen kann?

Sondern lieber gleich "nur" SSDs?

Ja. Man verteilteinfach nur die Daten nach Priorität. Daten, die täglich im Zugriff sind packst Du auf die SSDs. Andere Daten, wie z,B. ISOs, alte Projekte, alte Filme usw. auf die Festplatten.Also keine SSD als Cache, wie man sie in manche DS jetzt einbauen kann?

Sondern lieber gleich "nur" SSDs?

Der SSD-Cache macht nur Sinn, wenn Du die Kapazität der großen Platten unbedingt (täflich) brauchst und das beschleunigen willst. (Oder nie Aufräumen willst.) Problematisch ist, wenn der SSD-Cache defekt ist, dann muss das gesamte Volume gerettet werden, was momentan über den Support von Synology zu erledigen wäre.

10GBit:

Wie schon gesagt, könnte ich die Verkabelung durchaus neu machen.

Was halt nicht gehen wird ist, dass ich jedes Endgerät direkt zu einem zentralen Switch führen kann.

Das gibt das Leerrohr denke ich nicht her. Auch ist es mit der Erweiterbarkeit (weiteres Gerät/Arbeitsplatz in einem Raum) schwer zu realisieren, da dann wieder ein Kabel dazu kommt. Ich werde also um ein kaskadiertes Netzwerk nicht drum rum kommen. Die Verbindung "Masterswitch" / Slave- oder Raumswitch muss dann zumindest etwas fetter ausgelegt werden.

Also Verbindung der Switches untereinander und zum NAS über 10Gbit (bei einem neuen NAS) und der Rest halt weiterhin als Gbit.

Oder zumindest wie aqui sagte via LACP.

Wenn das Gebäude wirklich nicht mehr her gibt (kann ich mir kaum vorstellen, da es auch Brüstungskanäle und Kabelkanäle gibt), dann kannst Du zur Not über (d)ein CAT6 Kabel bis zu 55 m 10GBASE-T laufen lassen.

Einfach ein MikroTik CRS309 oder CRS312 als Haupt-Switch und CRS305er als Raum-Verteiler einsetzen.

Schöner wäre eine strukturierte (direkte) Verkabelung nur über den Haupt-Switch, aber das andere funktioniert auch.

Frag mal Deinen Elektriker.

iperf:

Du meinst iperf als Dockercontainer auf die DS und dann den Test laufen lassen?

Geschwindigkeitstest:

Ich habe vor Feierabend noch ein paar "Tests" gemacht. War sonst keiner auf dem Netzwerk und hab meinen PC direkt mit dem Switch des NAS verbunden.

Ergebnis: Wenn ich eine große Datei kopiere, dann erreiche ich so 650-800 Mbit, wobei auf der DS weder CPU noch Festplatten, etc. gemäß Ressourcenmonitor ausgelastet waren.

Beim "normalen" Betrieb mit unserer Rechensoftware erreiche ich nicht mal 80 Mbit, obwohl dort während der Berechnung des Systems laut Anzeige auch lange Schreib und Lesevorgänge vonstatten gehen. Es friert mir das Programm sogar ab und zu für ein paar Sekunden ein.

Das müssten dann extrem viele und kurze Schreib/Lesevorgänge sein, dass das System einfach nicht auf Geschwindigkeit kommt. Auch hier habe ich wieder null Ausschläge auf der DS.

Tausch die Platten (ambesten gegen SSDs), wenn Ihr nicht so ein riesen Datenvolumen habt.

Bedenke aber, dass der Software-Hersteller nicht umsonst einen Server empfiehlt.

Als Backupstrategie fahre ich stündlich ein Backup auf eine externe USB Festplatte. Quasi als Datensicherung für versehentliche Fehllöschungen. Jeden Abend gibt es ein Vollbackup in die Cloud und jeden Freitag ein Vollbackup auf eine weitere externe Festplatte, die dann zuhause aufbewahrt wird.

Ich hoffe, das Cloud-Backup ist verschlüsselt. Auch wenn die Datenträger außerhalb der Firma aufbewahrt werden, sollten sie verschlüsselt sein. (Stell Dir nur mal vor, die Datensicherung stiehlt jemand aus dem Auto.)Gruß

its

Zitat von @Ghent74:

Windows-Server:

Ich denke, dass eine Diskstation nicht in diese Kategorie gehört. Sicherlich mag ein Windows-Server noch besser sein, aber eigentlich nutzt das Programm den Server rein als Speicherort. Da läuft sonst keine zusätzliche Software serverseitig.

Solange es Support gibt...Windows-Server:

Ich denke, dass eine Diskstation nicht in diese Kategorie gehört. Sicherlich mag ein Windows-Server noch besser sein, aber eigentlich nutzt das Programm den Server rein als Speicherort. Da läuft sonst keine zusätzliche Software serverseitig.

Umrüstung auf SSD:

Da die aktuelle Diskstation nur ein 2-Bay ist, bräuchte ich also dann 2x 2TB SSDs.

Irgendwelche Empfehlungen?

Alternativ steht immer noch die Anschaffung einer neueren DS oder halt eines Servers im Raum.

Kann das Dateiformat ext4 auch zu den Performanceproblemen beitragen?

Nein. Siehe Benchmark hier:Kann das Dateiformat ext4 auch zu den Performanceproblemen beitragen?

computerbase.de/2015-12/synology-ds716-plus-test/3/#abschnitt_bt ...

Netzwerkkabel:

Der Flaschenhals sind halt die Leerrohre, die die Räume untereinander verbinden (über den Fußboden).

Da kann ich auch nicht mal so einfach durch die Wand ein größeres Loch bohren lassen.

obo.de/produkte/gebaeudeinstallation/produkthighlights/geraeteei ...

obo.de/anwendungen/architekten/offene-bruestungskanaele/

obo.de/anwendungen/architekten/verdeckte-bruestungskanaele/

Letztere kann man noch "cool" mit einem LED-Streifen ausrüsten. Frag mal Euren Elektriker.

Ansonsten leider kaskadieren. (Da die die Fehlersuche erschwert und alle angeschlossenen Geräte nur über eine Leitung laufen, sollte man so etwas eigentlich vermeiden. Aber bei 10GB fällt das weniger ins Gewicht. Wäre halt nur eine Billig-Lösung.)

Iperf:

Iperf liefert von PC zu PC 891Mbit/s als Mittelwert. Die PCs hingen an dem Switch, an dem auch das NAS hängt.

Passt einigermaßen. Was für ein Switch?Iperf liefert von PC zu PC 891Mbit/s als Mittelwert. Die PCs hingen an dem Switch, an dem auch das NAS hängt.

Gruß

its

Flur, Teeküche, etc.) dass da nichts möglich ist.

Immer Glasfaser nehmen und Kabelkanal_Switches (Nexans, Microsens usw.) verwenden.Das ist üblicher Standard bei Kabelkanälen mit FTTO Technik und beantwortet dann auch gleich deine Frage nach der "Glasfasertechnik".

Kann da unter Umständen 1 Gbit LAG sogar schneller sein als eine 10 Gbit?

Nein niemals ! LACP LAGs sind immer basierend auf einem Hashing Verfahren je nach Mac oder IP Adresse. Sie können Prinzip bedingt also immer nur einen einzigen der gebündelten Links benutzen. Die Bandbreite bleibt also immer fest bei 1 Gig nur die Kapazität bzw. Auslastung wird größer da sich die Mac oder IP Partner auf 2 (oder mehr) Links des LACP LAGs verteilen. Das aber nur wenn entsprechend Mac oder IP Entropie im Netz vorhanden ist sonst nicht. Die Verteilung ist durch das Hashing niemals homogen auf solchen LAGs.Eine "Fat Pipe" ist also in jedem Falle immer besser als LAGs. Siehe dazu auch diverse Threads im Forum:

Symantec Backup Exec 2010 R3 - Netzwerk-Teaming für größeren Durschsatz

Grunsatzfrage LAG

Link Aggregation zur Speederhöhung zwischen 2 Switches herstellen

Motherboard mit 2 Onboard LAN Anschlüssen

Traffic am Server auf 2 NICs verteilen

Kann man einen Server zur Performacesteigerung mit 2 Netzwerkkarten parallel an einem Switch betreiben? Wenn ja mit welcher Konfiguration ?

Bonding mit Broadcom - SLB

Link Aggregation - Frage zur Hash Configuration

Zudem ist eine Cat7 Vernetzung für 10Gig Backbone Infrastruktur generell nicht gut. Abgesehen vom sehr hohen Stromverbrauch und dadurch bedingter starker Erwärmung der aktiven Komponenten, basiert 10G Base T auf einem Negotiation Verfahren was die 10G nur auf sehr kurzen Cat Kabellängen garantiert. Gibt es Knicks, zu kleine, Biegeradien oder schlechte Stecker kann die Datenrate drastisch sinken. Aus diesem Grunde ist eine Cat Verkabelung für eine Switch Infrastruktur wegen der unkalkulierbaren Datenraten immer kontraproduktiv und wenig empfehlenswert !

Hier solltest du wenn immer möglich zu LWL greifen (OM3 oder OM4 mit 50µ Multimode Faser). Besonders in deinem Falle wäre das sehr vorteilhaft weil du nur sehr begrenzten Verlege Platz hast. Für 2 Cat Kabel könntest du locker mindestens 6 bis 10 LWL Duplex Kabel verlegen und wärst so erheblich besser gerüstet was den Bandbreiten Ausbau mit verlässlichen Datenraten anbetrifft. Verlegekosten Cat oder LWL sind identisch heutzutage.

Die Entscheidung für Cat Verkabelung ist in deinem speziellen Fall nicht wirklich zielführend und geht eher in die falsche Richtung was Zukunftsfähigkeit anbetrifft. Aber egal...

Da führt man die Leute dann aber schnell in die Irre.

Nicht Netzwerker die den Standard gelesen haben... Ab dem Switch würde ich ja eh wieder mit Kupferkabel arbeiten

Du meinst zu den Endgeräte Clients ? Na ja wenn du an dem Switch 5 Endgeräte dran hast wären das worst case 5 Gig. Wenn das Mac/IP Hashing die nun auf einen 1 Gig Link zwingt hast du nichts gewonnen. Die frage die sich dann stellt ist mit welchem Überbuchungsgrad du leben kannst. Bei geringer Auslastung spielt das sicher nicht so eine große Rolle. Die Kardinalsfrage ist aber wie sich das dann in Zukunft entwickelt bei dir. Steigen deine Anforderungen in puncto Bandbreite bist du sehr schnell wieder da wo du jetzt schon bist.Aber ich denke dafür sind dann die Einzelkomponenten zu teuer, oder?

Nicht zwingend. Den Switch mit 8 mal 10G SFP Ports gibts für schlappe 250 Euro:varia-store.com/de/produkt/99561-mikrotik-crs309-1g-8s-in-cloud- ...

Das verteilst du dann auf einen kleinen 10G Kupferswitch:

varia-store.com/de/produkt/102402-css610-8g-2s-in-cloud-smart-sw ...

2 dieser Switches könntest du, wie du oben beschreibst, kaskadieren an einer LWL Faser mit 10Gig so das du 16 Kupferports mit 1G und 10G LWL Backbone angebunden hast. Mal der 8 Ports auf dem Core sind das 128 Endgeräte die man sehr performant mit einem 10Gig Backbone verbindet. Viel mehr als du brauchst mit deinen 6 Plätzen.

10G SFP+ Transceiver kosten auch nicht mehr die Welt: fs.com/de/products/74668.html?attribute=106&id=219226

Wenn du einen 10G Port nicht bestückst am Core klemmst du da mit 10G dein NAS drauf.

Damit wärst du für kleines Geld bestens gerüstet mit einem 10Gig Backbone auf verlässlichen und skalierbarem LWL.

@aqui hat da vollkommen recht. 10GBase-T verbraucht mehr Strom und erzeugt mehr Abwärme. LWL wäre da die sparsamere Wahl. Das aber 10GBase-T so superempfindlich ist, wie @aqui beschreibt, kann ich aus der Praxis heraus nicht behaupten. CAT7A ist aber aus meiner Sicht ein minimalvorraussetzung. Schlechte/ billige Patchkabel und schlecht aufgelegte Endpunkte machen da die größten Probleme. Es muss also sorgfältig(er) gearbeitet werden. LWL-Kabel sind hingegen oft "monkeyproof", da sie fertigkonfektioniert geliefert werden. Nur noch ein paar Stecker zusammen und fertig. (Man spart also damit Zeit und Geld, weil das Auflegen entfällt.) Und so teuer sind LWL-Kabel auch nicht mehr. Die kaskadierten Switches würdest Du dann über SFP+ laufen lassen. Allerdings, wenn Du einen Knick in LWL-Kabel hast, dann wars das. Enge Biegeradien sind da nicht möglich.

LWL scheint vielleicht auf den ersten Blick teurer, aber wenn man das Gesamt-Paket inkl. Switch und Transceivern und Auflegekosten sieht, dann realitiviert sich das ganz schnell im Vergleich zu CAT mit RJ45. Und sollte man sich entgegen der Empfahlung doch für CAT-Kabel entscheiden, dann sollte man heute mind. CAT8 verlegen. Aber es spricht viel für LWL.

10GB Switche von MikroTik sind deutlich günstiger und würden Deinen Ansprüchen sicherlich gerecht werden.

Ansonsten hier mal eine kleine Aufstellung:

SFP+

mikrotik.com/product/crs305_1g_4s_in

mikrotik.com/product/crs309_1g_8s_in

mikrotik.com/product/crs317_1g_16s_rm

SFP+ Modul auf RJ45 10GB

mikrotik.com/product/s_rj10

(Natürlich kannst Du auch 1GB Geräte über einen güsntigeren SFP ohne + Tranceiver anschließen.)

RJ45 10Gbase-T

mikrotik.com/product/crs312_4c_8xg_rm

Andere Hersteller (noch bezahlbar)

qnap.com/de-de/product/qsw-m408-4c

dl.ubnt.com/qsg/US-16-XG/

netgear.de/business/products/switches/smart/xs708t.aspx

(Die Liste hat natürlich keinen Anspruch auf Vollständigkeit.)

Natürlich kannst Du noch auf andere Hersteller, z.B. Cisco zurückgreifen, nur bei denen sind 10GB deutlich teurer. Ist natürlich auch davon abhängig, was Du vorhast und welche Features Du benötigst.

Mikrotik bekommst Du z.B. bei omg.de/ oder deren Distri-Sparte distribution.allnet.de/

Gruß

its

LWL scheint vielleicht auf den ersten Blick teurer, aber wenn man das Gesamt-Paket inkl. Switch und Transceivern und Auflegekosten sieht, dann realitiviert sich das ganz schnell im Vergleich zu CAT mit RJ45. Und sollte man sich entgegen der Empfahlung doch für CAT-Kabel entscheiden, dann sollte man heute mind. CAT8 verlegen. Aber es spricht viel für LWL.

10GB Switche von MikroTik sind deutlich günstiger und würden Deinen Ansprüchen sicherlich gerecht werden.

Ansonsten hier mal eine kleine Aufstellung:

SFP+

mikrotik.com/product/crs305_1g_4s_in

mikrotik.com/product/crs309_1g_8s_in

mikrotik.com/product/crs317_1g_16s_rm

SFP+ Modul auf RJ45 10GB

mikrotik.com/product/s_rj10

(Natürlich kannst Du auch 1GB Geräte über einen güsntigeren SFP ohne + Tranceiver anschließen.)

RJ45 10Gbase-T

mikrotik.com/product/crs312_4c_8xg_rm

Andere Hersteller (noch bezahlbar)

qnap.com/de-de/product/qsw-m408-4c

dl.ubnt.com/qsg/US-16-XG/

netgear.de/business/products/switches/smart/xs708t.aspx

(Die Liste hat natürlich keinen Anspruch auf Vollständigkeit.)

Natürlich kannst Du noch auf andere Hersteller, z.B. Cisco zurückgreifen, nur bei denen sind 10GB deutlich teurer. Ist natürlich auch davon abhängig, was Du vorhast und welche Features Du benötigst.

Mikrotik bekommst Du z.B. bei omg.de/ oder deren Distri-Sparte distribution.allnet.de/

Gruß

its

Als nächsten wollte ich das alles mal aufzeichnen, zusammenstellen und präsentieren.

Sehr vernünftig !Als LWL Kabel MM oder SM?

Inhouse immer MM nach OM3 besser OM4 Standard. SM kann man manchen aber die Optiken und damit die Folgekosten sind unnötig hoch. Du solltest SM inhouse nur verlegen wenn du Längen > 500 Meter hast.Es gibt allerdings auch MM Verlegekabel wo 2 oder 4 SM Fasern mit drin sind. Sowas kann man machen wenn man wie gesagt Längen > 500 Meter hat sonst lohnt SM nicht.

oder im Kabelkanal eine Auslassdose setzen

Immer mit Dose alles andere ist sehr schlecht wegen der Gefahr einer Beschädigung.dass ich mit solchen Kupplungen das LWL Kabel verlängern kann?

Das siehst du genau richtig !spricht doch nichts dagegen diese direkt bis in den PC zu führen, oder?

Da spricht absolut nichts dagegen !Allerdings solltest du dann keine teure Karte in den PC setezn sondern immer mit einem Medienwandler arbeiten:

reichelt.de/medienkonverter-fast-ethernet-sc-lc-multimode-tplink ...

Damit bist du erheblich flexibler und musst nicht am PC oder Laptop fummeln und kannst immer deren meist fest eingebauten Kupfer Ports nutzen !

Büro1: SFPs können kein Autosensing Speeds muss man statisch einstellen. SFP+ Steckplätze können generell beide Optiken aufnehmen also 10G Optiken und 1G Optiken.

SFP Steckplätze sind aber immer nur 1 Gig only. 10G Optiken funktionieren darin nicht auch wenn der Fromfaktor stimmt.

Für 10G Modeinenkonverter (also SFP+) guckst du hier:

fs.com/de/c/ethernet-media-converter-1037?10g=21782

Die 10G Medienkonverter können alle auch 100Mbit, 1Gig, 2.5Gig, 5Gig und 10Gig Optiken und der Kupferport macht 10/100/1000 Mbit

fs.com/de/products/101477.html

Damit kannst du dann alles abdecken.

Die 1Gig Medienkonverter können nur 100 Mbit und 1 Gig Optiken.

fs.com/de/c/ethernet-media-converter-1037?1g=21853

SFP Steckplätze sind aber immer nur 1 Gig only. 10G Optiken funktionieren darin nicht auch wenn der Fromfaktor stimmt.

Für 10G Modeinenkonverter (also SFP+) guckst du hier:

fs.com/de/c/ethernet-media-converter-1037?10g=21782

Die 10G Medienkonverter können alle auch 100Mbit, 1Gig, 2.5Gig, 5Gig und 10Gig Optiken und der Kupferport macht 10/100/1000 Mbit

fs.com/de/products/101477.html

Damit kannst du dann alles abdecken.

Die 1Gig Medienkonverter können nur 100 Mbit und 1 Gig Optiken.

fs.com/de/c/ethernet-media-converter-1037?1g=21853